Материалы по тегу: hpc

|

09.04.2025 [00:49], Алексей Степин

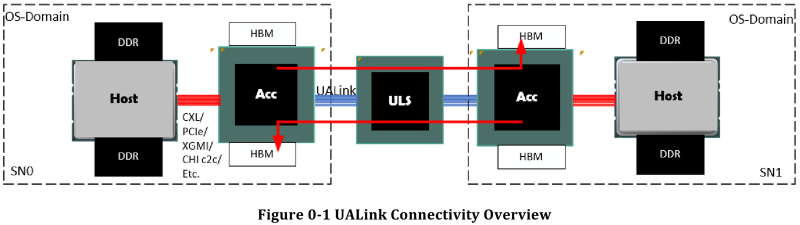

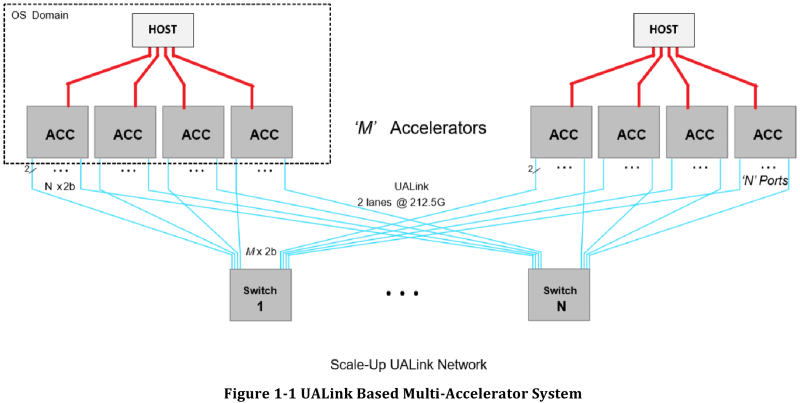

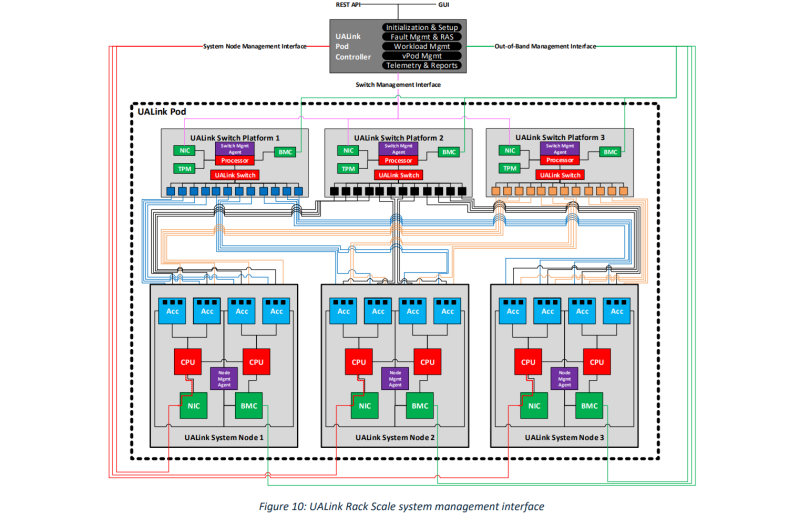

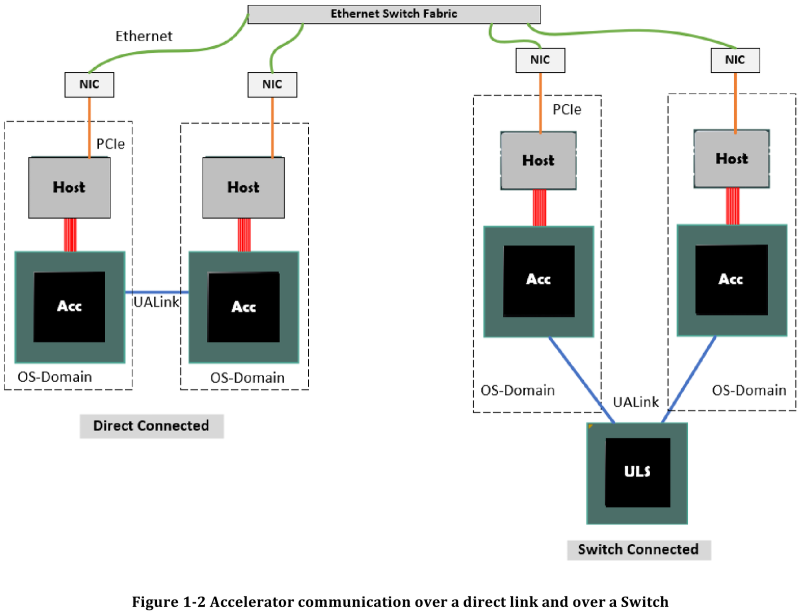

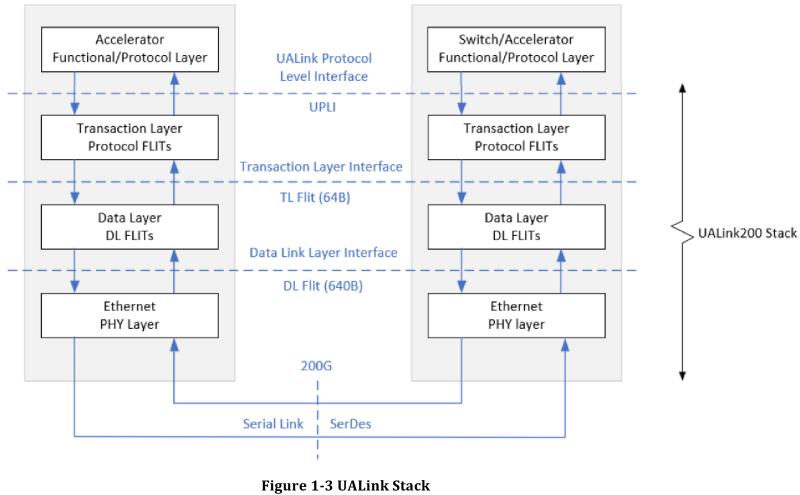

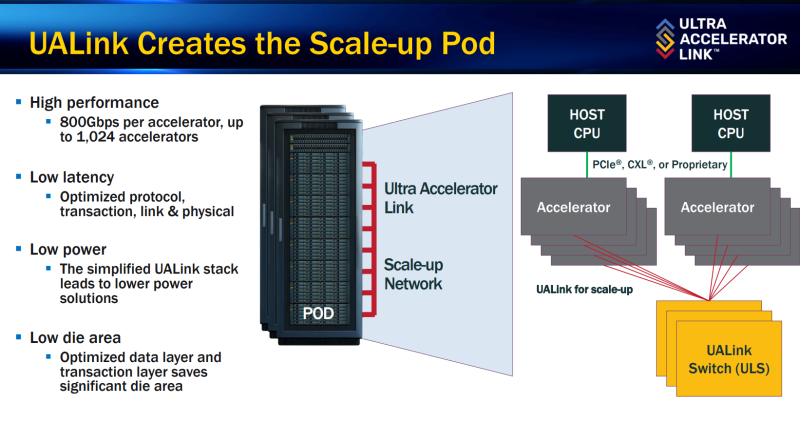

Все против NVIDIA: представлена открытая альтернатива NVLink — интерконнект UALink 200G 1.0Консорциум UALink, в состав которой входят AMD, AWS, Astera Labs, Cisco, Google, HPE, Intel, Meta✴ и Microsoft, опубликовала первые спецификации на разрабатываемую в рамках альянса более доступную альтернативу проприетарным решениям NVIDIA. Интерконнект UALink призван заменить в первую очередь NVLink и во многом опирается на AMD Infinity Fabric, хотя пока что по скоростям составляет конкуренцию скорее Ethernet и InfiniBand. Консорциум Ultra Accelerator Link был сформирован в конце прошлого года с целью создания высокоскоростного интерконнекта с низкими задержками, базирующегося на открытых технологиях. Речь здесь не только о приверженности открытым стандартам, но и о солидном потенциальном куске рынка — только за прошедший финансовый год сетевое подразделение NVIDIA выручило $13 млрд.

Источник здесь и далее: UALink Появление более доступной и открытой альтернативы теоретически должно пошатнуть позиции последней в этом секторе, а также позволить разработчикам HPC-систем и ИИ-кластеров избежать жёсткой привязки к одному вендору. В том числе речь идёт о возможности организации сети UALink, включающей в себя GPU и ускорители разных поставщиков. Упор в первой версии стандарта сделан на общий доступ к памяти ускорителей с высокой скоростью, низкими задержками и простыми атомарными операциями Впервые опубликованные спецификации описывают стандарт UALink 200G 1.0. В основе лежит коммутируемая сеть с пропускной способностью 200 Гбит/с на каждую линию, во многом наследующая AMD Infinity Fabric, но дополненная разработками других участников альянса. Максимальное количество линий на один ускоритель может достигать четырёх, что позволяет поднять пропускную способность до 800 Гбит/с. Поддерживается бифуркация. Размер кластера в данной версии стандарта UALink ограничен 1024 узлами, не считая коммутаторов. При этом гарантируются линейные скорости на уровне соответствующих версий Ethernet, но c энергопотреблением от трети до половины от аналогичного показателя последних, при времени отклика на уровне коммутируемых вариантов PCI Express. Задержка от порта к порту должна составить менее 100 нс, на уровне коммутаторов UASwitch — 100–150 нс. Для сравнения: NVLink 5/6 позволяет объединить до 576 ускорителей в одном домене со скоростью до 0,9–1,8 Тбайт/с на ускоритель. Также предусмотрена совместная работа с Ethernet в составе GPU-кластера, где хост-процессоры общаются между собой посредством традиционной сети (в том числе Ultra Ethernet), а ускорители могут использовать либо прямое, либо коммутируемое подключение UALink. Передача данных осуществляется словами длиной 680 байт: 640-байт флит-пакеты + 40 байт накладных расходов на упреждающую коррекцию ошибок (FEC) и кодирование 256B/257B. Реализованы механизмы доступа к удалённой памяти, но когерентность на аппаратном уровне не поддерживается, также имеются различия на подуровне PCS (Physical coding sublayer). На физическом уровне используется стандарт IEEE 802.3dj: 200GBASE-KR1/CR1, 400GBASE-KR2/CR2 и 800GBASE-KR4/CR4. Имеющиеся ретаймеры для Ethernet также совместимы с UALink. Спецификации UALink 200G 1.0 доступны на сайте проекта. Глава консорциума UALink, Кёртис Боумен (Kurtis Bowman) настроен оптимистично и говорит примерно о 18 месяцах до появления первых аппаратных решений, что на полгода быстрее типичных сценариев воплощения спецификаций «в железо». Тем временем, альянс уже начал работу над второй версией UALink, использующей стек технологий 400G.

08.04.2025 [13:29], Сергей Карасёв

Eviden создаст для Сербии суперкомпьютер стоимостью €36 млнВласти Сербии, по сообщению ресурса Datacenter Dynamics, заключили контракт с Eviden (подразделение Atos Group) на создание нового суперкомпьютера. Речь идёт о приобретении системы BullSequana последнего поколения, которая будет поставлена к концу текущего года. Технические подробности проекта пока не раскрываются. Отмечается лишь, что контракт с Eviden является частью более широкого соглашения стоимостью €50 млн, подписанного между правительствами Сербии и Франции. Из этой суммы €36 млн пойдёт непосредственно на создание суперкомпьютера. Оставшаяся часть средств будет потрачена на ИИ-инициативы в таких сферах, как здравоохранение, энергетика, транспорт и государственное управление. На сегодняшний день, как отмечается, Сербия эксплуатирует как минимум один неназванный НРС-комплекс, созданный NVIDIA и размещённый в государственном дата-центре в Крагуеваце (столица административного региона Шумадия). Система, запущенная в декабре 2021 года, обошлась в €30 млн. В перспективе в модернизацию этого суперкомпьютера планируется инвестировать €40 млн, что позволит поднять его производительность в семь раз.

Источник изображения: Правительство Сербии Глава сербского управления по IT и электронному правительству Михайло Йованович (Mihailo Jovanovic) заявил, что новый суперкомпьютер, поставкой которого займётся Eviden, будет насчитывать «в 20 раз больше чипов, чем [нынешняя] система NVIDIA», и получит почти в 30 раз больше памяти. Какие именно чипы имеются в виду, Йованович уточнять не стал. Работа над государственным ЦОД в Крагуеваце стоимостью €30 млн началась в 2019 году, а открытие состоялось в 2020-м. Дата-центр состоит из двух объектов общей площадью около 14 тыс. м2 — это примерно в пять раз больше по сравнению с прежней ЦОД-площадкой в Белграде. Комплекс в Крагуеваце соответствует стандарту Tier IV: он предоставляет услуги хостинга для предприятий и правительственных структур.

06.04.2025 [14:05], Сергей Карасёв

Начато создание европейского суперкомпьютера Daedalus с производительностью 89 ПфлопсЕвропейское совместное предприятие по развитию высокопроизводительных вычислений (EuroHPC JU) сообщило о подписании соглашения с компанией НРЕ на создание суперкомпьютера Daedalus, который расположится в Греции и будет интегрирован с ИИ-фабрикой Pharos. Контракт с НРЕ заключён при участии Национальной инфраструктуры исследований и технологий GRNET S.A. в Афинах. Общая стоимость создания Daedalus оценивается в €36 млн. Из этой суммы 35 % предоставит EuroHPC JU, а остальные 65 % будут привлечены в рамках Национального плана восстановления и обеспечения устойчивости «Греция 2.0». В проекте также участвуют Кипр, Черногория и Северная Македония, вошедшие в специально сформированный консорциум Daedalus. Производительность нового суперкомпьютера составит более 89 Пфлопс (FP64). С таким показателем быстродействия в ноябрьском рейтинге мощнейших суперкомпьютеров мира TOP500 комплекс Daedalus мог бы занять 17-е или 18-е место. Для НРС-платформы предусмотрено применение возобновляемых источников энергии и передовых систем охлаждения, которые значительно повысят энергетическую эффективность. Суперкомпьютер Daedalus станет доступен в начале 2026 года широкому кругу пользователей по всей Европе, включая научное сообщество, промышленную сферу и государственный сектор. Машина расположится в новом дата-центре в здании бывшей электростанции Технологического культурного парка Лаврион Национального технического университета Афин (NTUA). Доступ к вычислительным ресурсам комплекса будет совместно управляться EuroHPC JU и консорциумом Daedalus пропорционально их инвестициям. Ожидается, что Daedalus ускорит научные достижения Европы в различных областях, включая ИИ, медицину, метеорологию, анализ больших данных и разработку интеллектуальных транспортных систем. В декабре 2024 года консорциум EuroHPC выбрал площадки для первых европейских ИИ-фабрик (AI Factory): они разместятся в Финляндии, Германии, Греции, Италии, Люксембурге, Испании и Швеции. Аналогичные комплексы также появятся в Австрии, Болгарии, Франции, Германии, Польше и Словении.

05.04.2025 [10:36], Сергей Карасёв

Европейский суперкомпьютер Discoverer получил обновление в виде NVIDIA DGX H200Европейское совместное предприятие по развитию высокопроизводительных вычислений (EuroHPC JU) объявило о модернизации суперкомпьютера Discoverer, установленного в Софийском технологическом парке в Болгарии. Обновленная НРС-система получила название Discoverer+. Комплекс Discoverer, построенный на платформе BullSequana XH2000, был введён в эксплуатацию в 2021 году. Изначальная конфигурация включала 1128 вычислительных узлов, каждый из которых содержит два 64-ядерных процессора AMD EPYC 7H12 поколения Rome. Производительность (FP64) достигала 4,52 Пфлопс с пиковым значением в 5,94 Пфлопс. С такими показателями система находится на 221-й позиции в ноябрьском рейтинге мощнейших суперкомпьютеров мира TOP500. В рамках модернизации добавлен GPU-раздел на основе четырёх модулей NVIDIA DGX H200. Каждый из них содержит восемь ускорителей H200 и два процессора Intel Xeon Platinum 8480C поколения Sapphire Rapids с 56 ядрами (до 3,8 ГГц). Модули обладают быстродействием до 32 Пфлопс каждый в режиме FP8. Кроме того, обновлённый комплекс получил Lustre-хранилище вместимостью 5,1 Пбайт, систему хранения Weka ёмкостью 273 Тбайт и дополнительную ИБП-систему.

Источник изображения: EuroHPC JU Как отмечается, Discoverer стал первым суперкомпьютером EuroHPC, прошедшим серьёзную модернизацию с момента своего первоначального запуска. После наращивания мощностей комплекс планируется использовать для крупномасштабных проектов в области ИИ, таких как обучение нейронных сетей, создание цифровых двойников сложных объектов и пр. В декабре 2024 года консорциум EuroHPC выбрал площадки для первых европейских ИИ-фабрик (AI Factory): они расположатся в Финляндии, Германии, Греции, Италии, Люксембурге, Испании и Швеции. Кроме того, такие объекты планируется создать в Австрии, Болгарии, Франции, Германии, Польше и Словении. Эти площадки станут частью высококонкурентной и инновационной экосистемы ИИ в Европе.

29.03.2025 [10:11], Алексей Степин

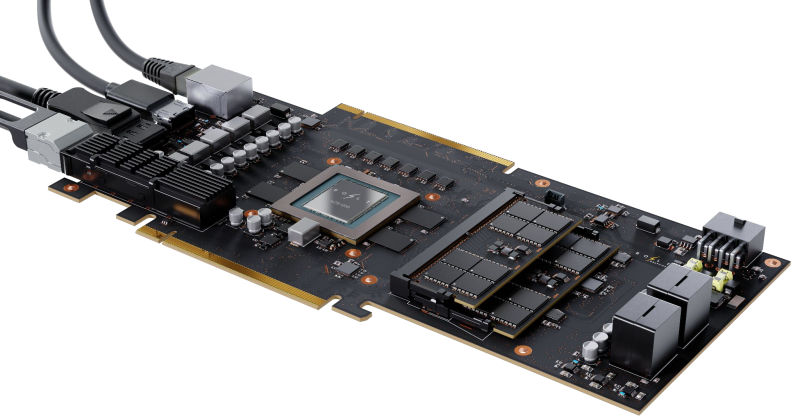

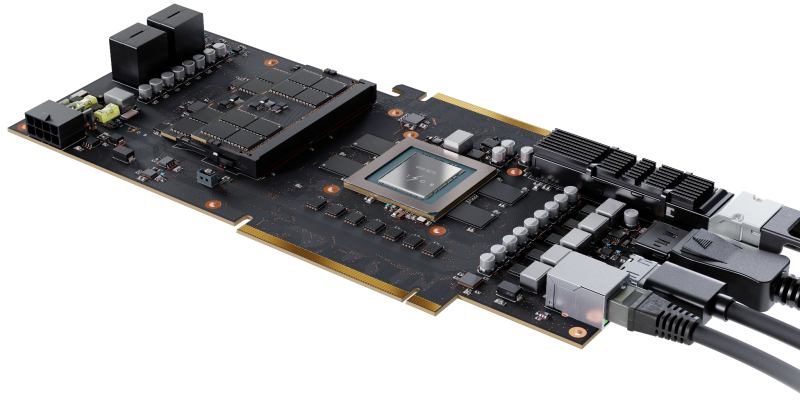

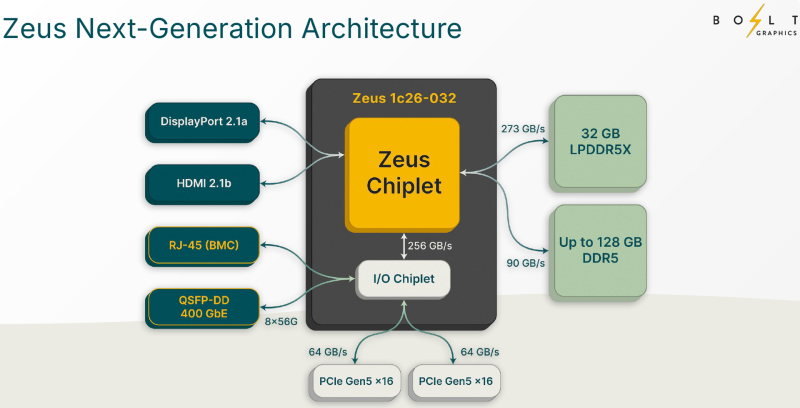

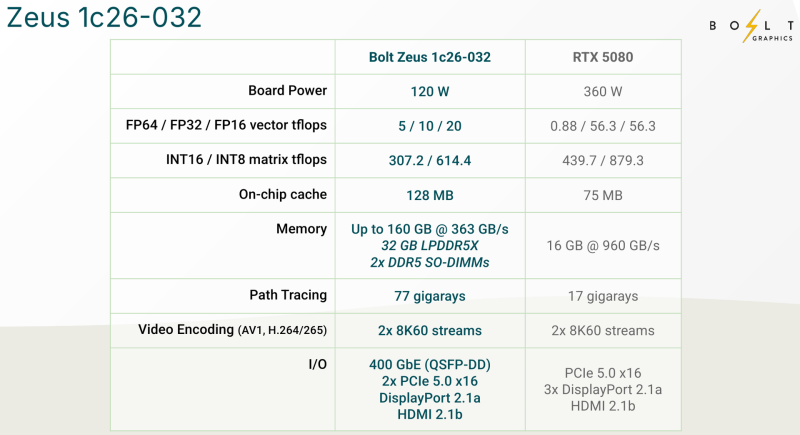

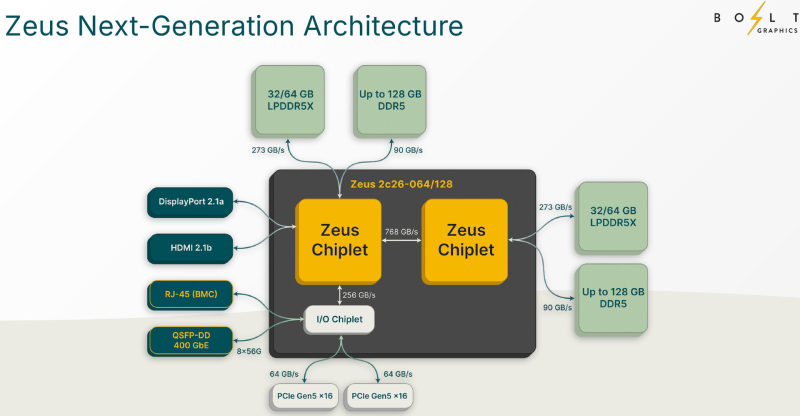

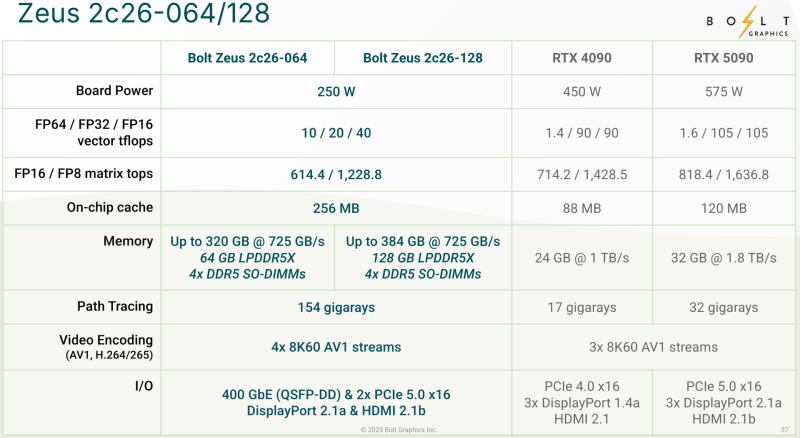

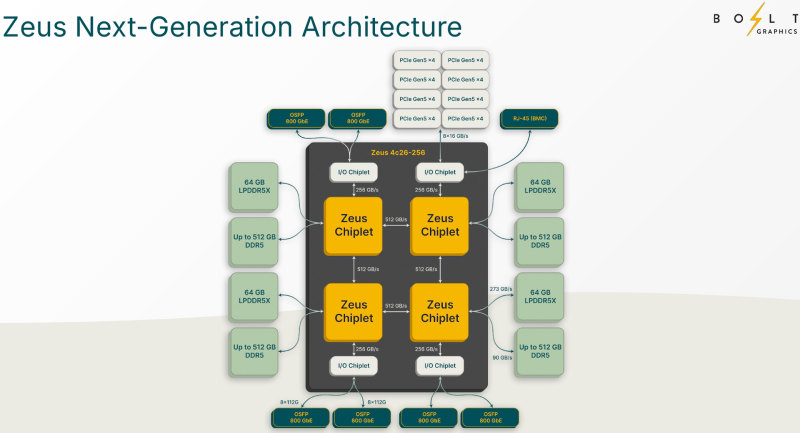

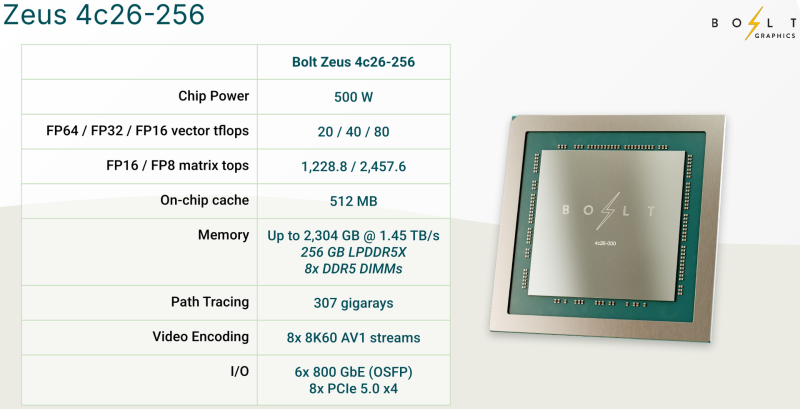

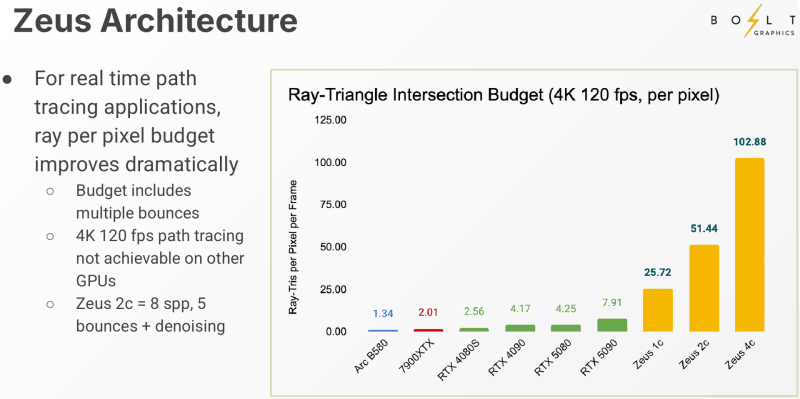

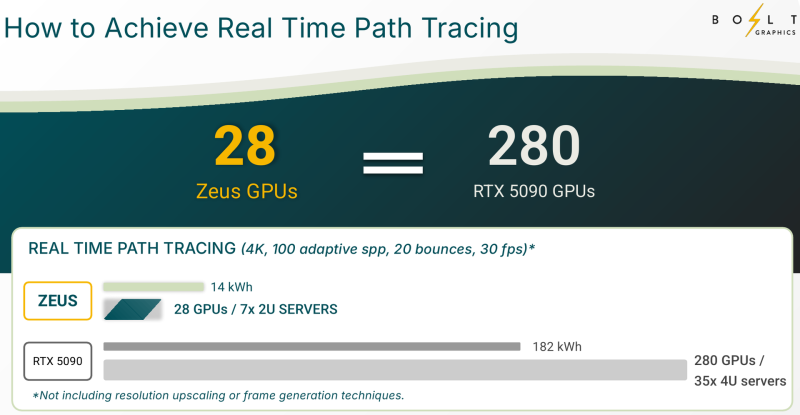

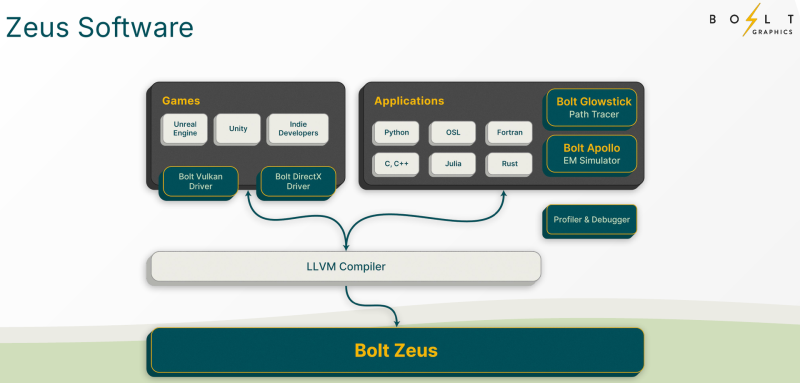

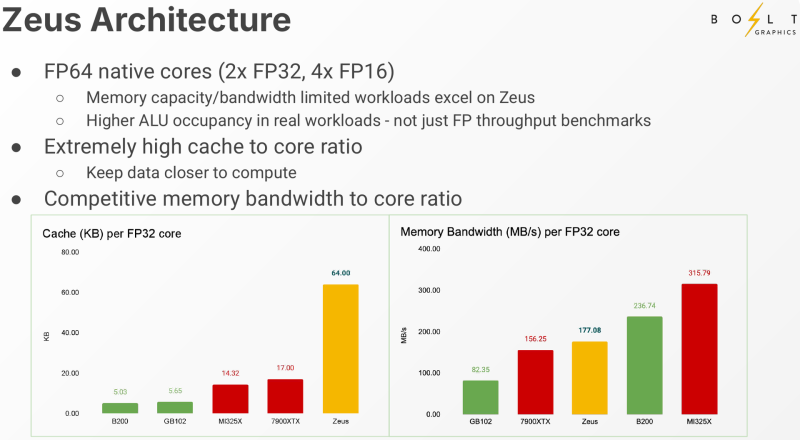

Bolt Graphics анонсировала универсальную видеокарту со слотами SO-DIMM, которая может потягаться с RTX 5080Все современные графические ускорители предлагаются с жёстко заданным при производстве объёмом видеопамяти, а в наиболее производительных моделях память типа HBM вообще интегрирована на одной с основным кристаллом подложке. Однако требования к объёму памяти в последнее время растут быстрее, а за дополнительный объём вендор просят всё больше. Кардинально иной подход предлагает компания Bolt Graphics, недавно анонсировавшая серию ускорителей Zeus. Несмотря на «ИИ-пандемию», Bolt Graphics в своём анонсе не делает упор на искусственный интеллект, а называет Zeus первым GPU, специально созданным для целей HPC, рендеринга, трассировки лучей и даже компьютерных игр. Что интересно, в основе Zeus лежит не некая закрытая архитектура: скалярная часть нового GPU построена на базе спецификации RISC-V RVA23, векторная представлена FP64 ALU на базе несколько модифицированной RVV 1.0. Прочие функции реализованы путём кастомных расширений и отдельных блоков-ускорителей. Все они пользуются общим кешем объёмом 128 Мбайт. Дополняет картину блок телеметрии и внутренний интерконнект для общения с другими вычислительным блоками. Используется чиплетный подход. Базовый «строительный блок» Zeus 1c26-032 включает GPU-чиплет, который соединён с 32 Гбайт набортной памяти LPDDR5x (273 Гбайт/с) и контроллером внешней памяти DDR5 (90 Гбайт/с), т.е. при желании можно установить ещё 128 Гбайт RAM (два модуля SO-DIMM). В GPU-чиплет встроены контроллеры DisplayPort 2.1a и HDMI 2.1b, а с внешним миром он общается посредством IO-чиплета, с которым он соединён 256-Гбайт/с каналом. IO-чиплет предлагает необычный набор портов. Помимо сразу двух интерфейсов PCIe 5.0 x16 (64 Гбайт/с каждый) имеется выделенный порт RJ-45 для BMC и 400GbE-порт QSFP-DD. Наконец, есть аппаратный блок видеокодирования, способный справиться с двумя потоками 8K@60 AV1/H.264/H.265. Заявленный уровень производительности в векторных FP64/FP32/FP16-вычислениях составляет 5/10/20 Тфлопс, а в матричных INT16/INT8 — 307,2/614,4 Топс. Аппаратный блок ускорения лучей (path tracing) выдаёт до 77 гигалучей. Для сравнения: NVIDIA RTX 5090 способна выдавать 32 гигалуча, а FP64-производительность составляет 1,6 Тфлопс. В то же время в расчётах пониженной точности актуальные решения NVIDIA всё равно быстрее Zeus 1c26-032. Однако у новинки есть важное преимущество — её уровень TDP составляет всего 120 Вт. Второй интерфейс PCIe 5.0 x16 можно использовать для прямого объединения двух карт. Вариант ускорителя с двумя чиплетами носит название Zeus 2c26-064/128, а с четырьмя — 4c26-256. Последние числа обозначают объём распаянной памяти LPDDR5X. Что касается расширяемой памяти, то количество доступных разъёмов SO-DIMM также зависит от модели и составляет до восьми, так что во флагманской конфигурации базовые 256 Гбайт LPDDR5x можно дополнить аж 2 Тбайт DDR5. Производительность с увеличением количеств GPU-чиплетов растёт практически пропорционально, но есть некоторые другие нюансы. Так, в Zeus 2c26-064 и Zeus 2c26-128 (оба варианта имеют TDP 250 Вт) есть только один IO-чиплет, а GPU-чиплеты объединены шиной со скоростью 768-Гбайт. Zeus 4c26-256 имеет сразу четыре I/O чиплета в составе, которые дают восемь контроллеров PCIe 5.0 x4 (один чиплет, совокупно 32 линии) и шесть 800GbE-портов OSFP (три чиплета). Между собой GPU-чиплеты объединены шиной со скоростью 512-Гбайт/с. Каждый из них соединён с собственным IO-чиплетом на скорости 256 Гбайт/с. Теплопакет флагмана составляет 500 Ватт, ускоритель, если верить Bolt Graphnics, развивает 20 Тфлопс в режиме FP64, почти 2500 Топс на вычислениях FP8 и способен обрабатывать до 307 гигалучей. Разработчики явно заложили в своё детище широкие возможности кластеризации, о чём свидетельствует наличие мощной сетевой подсистемы. Поддерживаются как скромные конфигурации из двух GPU, соединённых непосредственно по Ethernet 400GbE, так и масштабные системы уровня стойки, содержащей 80 плат Zeus 4c26-256, соединённых как с коммутатором, так и напрямую друг с другом. Такой кластер потребляет 44 кВт, но зато способен обеспечивать запуск крупных физических симуляций или обучение ИИ моделей за счёт огромного массива общей памяти, составляющего 160 Тбайт. Вычислительная производительность такого кластера достигает 1,6 Пфлопс в режиме FP64 и 196 Попс в режиме FP8. Одной из особенностей новинок является трассировщик лучей Glowstick, способный работать в режиме реального времени практически во всех современных пакетах 3D-моделирования или видеоредактирования, таких как Maya, 3ds Max, Blender, SketchUp, Houdini и Nuke. Он будет дополнен фирменной библиотекой Bolt MaterialX, содержащей более 5000 текстур высокого качества. А благодаря поддержке стандарта OpenUSD он сможет легко интегрироваться в любую цепочку рендеринга и пост-обработки. Также запланирован электромагнитный симулятор Bolt Apollo. Обещаны фирменные драйверы Vulkan/DirectX и SDK с использованием LLVM. Ранний доступ к комплектам разработчика Bolt Graphics наметила на IV квартал текущего года. В III квартале 2026 года должны появиться 2U-серверы на базе Zeus, а массовые поставки серверов и PCIe-карт начнутся не ранее IV квартала того же года. Пока сложно сказать, насколько хорошо новая архитектура себя проявит, но если верить предварительным тестам Zeus, выигрыш в сравнении с существующими ускорителями существенен, особенно в энергопотреблении.

23.03.2025 [14:08], Сергей Карасёв

Итальянский суперкомпьютер Leonardo будет интегрирован с квантовым компьютером IQM Radiance на 54 кубитаИтальянский суперкомпьютерный центр Cineca объявил о заключении соглашения с компанией IQM Quantum Computers на поставку самого мощного в стране квантового вычислительного комплекса. Речь идёт о системе IQM Radiance в конфигурации с 54 кубитами. Cineca является одним из крупнейших вычислительных центров Италии. Некоммерческий консорциум состоит из 69 итальянских университетов и 21 национальной исследовательской организации. Своей задачей консорциум ставит поддержку итальянского научного сообщества путём предоставления суперкомпьютеров и инструментов визуализации. Монтаж IQM Radiance планируется осуществить в IV квартале нынешнего года. Это будет первый локальный квантовый компьютер на площадке Cineca в Болонье. Суперкомпьютерный центр намерен использовать новую систему для оптимизации квантовых приложений, квантовой криптографии, квантовой связи и квантовых алгоритмов ИИ. Комплекс IQM Radiance 54 будет интегрирован с вычислительной системой Leonardo, которая является одним из самых быстрых суперкомпьютеров в мире. В ноябрьском рейтинге TOP500 эта машина занимает девятое место с теоретической пиковой производительностью 306,31 Пфлопс. В основу суперкомпьютера положены платформы Atos BullSequana X2610 и X2135. Система построена в рамках сотрудничества EuroHPC, которое сейчас занято развёртыванием сети европейских квантовых компьютеров и ИИ-фабрик. Компания IQM Quantum Computers основана в Хельсинки (Финляндия) в 2018 году. Она поставляет полнофункциональные квантовые компьютеры и специализированные решения для HPC, научно-исследовательских институтов, университетов и предприятий. Ранее IQM заявляла, что к выпуску готовится версия Radiance со 150 кубитами, которую планировалось представить в I квартале 2025 года.

18.03.2025 [10:05], Сергей Карасёв

ExxonMobil развернёт суперкомпьютер Discovery 6 с суперчипами NVIDIA GH200Американская ExxonMobil, одна из крупнейших в мире нефтяных компаний, представила проект высокопроизводительного вычислительного комплекса Discovery 6. Этот суперкомпьютер планируется использовать для поддержания работы передовых систем 4D-сейсморазведки. Комплекс создаётся в партнёрстве с НРЕ и NVIDIA. В основу системы ляжет платформа HPE Cray Supercomputing EX4000. Будут задействованы 4032 суперчипа NVIDIA GH200 Grace Hopper. В состав Grace Hopper входят 72-ядерный Arm-процессор NVIDIA Grace, до 480 Гбайт LPDDR5x и ускоритель NVIDIA H100 с 96 или 144 Гбайт HBM3(e). Говорится об использовании интерконнекта HPE Slingshot. Отмечается, что по производительности новый суперкомпьютер примерно в четыре раза превзойдёт предшественника — систему Discovery 5, введённую в эксплуатацию в ноябре 2022 года. Этот комплекс использует платформу HPE Cray EX235n с 32-ядерными процессорами AMD EPYC 7543 и ускорителями NVIDIA A100 SXM4. В ноябрьском рейтинге TOP500 машина Discovery 5 занимала 46-ю позицию с пиковой производительностью 30,99 Пфлопс. Таким образом, быстродействие Discovery 6, как ожидается, будет находиться на уровне 120 Пфлопс. Для создаваемого суперкомпьютера предусмотрено использование высокоэффективной системы прямого жидкостного охлаждения (DLC). Благодаря запуску Discovery 6 ExxonMobil рассчитывает сократить время обработки сложных сейсмических данных с месяцев до недель. Это поможет повысить эффективность разведки месторождений нефти и газа, что приведёт к увеличению добычи ресурсов с меньшими капиталовложениями. Завершить монтаж Discovery 6 планируется в I половине текущего года.

13.03.2025 [15:55], Руслан Авдеев

ESA запустила суперкомпьютер Space HPC для европейских космических исследованийЕвропейское космическое агентство (ESA) запустило суперкомпьютерную платформу ESA Space HPC, специально разработанную для развития космических исследований и технологий в Евросоюзе. Открытие нового объекта состоялось на территории принадлежащего ESA центра ESRIN в Италии, сообщает HPC Wire. ESA Space HPC обеспечит поддержку исследований и развития технологий в рамках всех программ ESA, обеспечивая учёным и малому и среднему бизнесу из стран Евросоюза доступ к вычислительным мощностям. Инициатива призвана развить использование высокопроизводительных вычислений (HPC) в аэрокосмическом секторе ЕС, она станет основой для более масштабных инициатив в будущем. Как сообщается на сайте проекта, Space HPC построен при участии HPE. Суперкомпьютер включает порядка 34 тыс. ядер процессоров Intel и AMD последних поколений, 156 Тбайт RAM, 108 ускорителей NVIDIA H100, All-Flash подсистему хранения ёмкостью 3,6 Пбайт и пропускной способностью 500 Гбайт/с, а также 400G-интерконнект InfiniBand. Общая пиковая производительность кластера составляет 5 Пфлопс (FP64). Space HPC использует прямое жидкостное охлаждение, а PUE системы не превышает 1,09. Избыточное тепло отправляется на нужды отопления кампуса. Локальная солнечная электростанция обеспечивает более половины энергетических нужд кластера. Представители итальянских властей заявили, что технологические инновации в космическом секторе являются приоритетом для обеспечения безопасности и «стратегической автономии», а также будут способствовать конкурентоспособности европейской промышленности. Также отмечено, что местный аэрокосмический хаб Lazio стал домом для 250 компаний и играет ключевую роль в развитии авионики, электроники, радаров, спутниковых технологий и материаловедения. В руководстве ESA отметили потенциал Space HPC для инноваций в космической индустрии Евросоюза. Новый объект обеспечит агентству гибкую суперкомпьютерную инфраструктуру для исследований и разработок, тестирования и бенчмаркинга, поддержки программ ESA и промышленных предприятий. Доступ к вычислениям будет иметь и малый и средний бизнес, стартапы и т.п. Также отмечается, что дебют Space HPC наглядно продемонстрировал, ESA не только берёт ресурсы у государств-участников, но и много может дать им взамен. Утверждается, что одной из ключевых сфер деятельности, где требуются HPC-платформы, для ESA является наблюдение за Землёй. Новые мощности обеспечат управление наблюдениями, разработку новых приложений и сервисов. Space HPC будет поддерживать сложные нагрузки, включая моделирование, инженерные симуляции, обучение ИИ-моделей, аналитику данных и визуализацию, а также прочие эксперименты, которые помогут снизить риски будущих космических проектов. Это позволит ESA повысить финансовую эффективность проектов и обеспечит возможность обмена данными между разными программами агентства. В конце 2024 года сообщалось, что в 2025 году в Евросоюзе появится сразу семь ИИ-фабрик EuroHPC, а в середине минувшего февраля появилась информация, что Евросоюз направит €200 млрд на развитие ИИ, чтобы не отстать от США и Китая в этой сфере. В прошлом году было отмечено, что реализация миссий NASA задерживается из-за устаревших и перегруженных суперкомпьютеров.

12.03.2025 [20:37], Владимир Мироненко

Евросоюз потратит €240 млн на создание трёх RISC-V чиплетов для суперкомпьютеров в рамках проекта DARE

eurohpc

hardware

hpc

risc-v

европа

ии

импортозамещение

инвестиции

суперкомпьютер

ускоритель

финансы

чиплеты

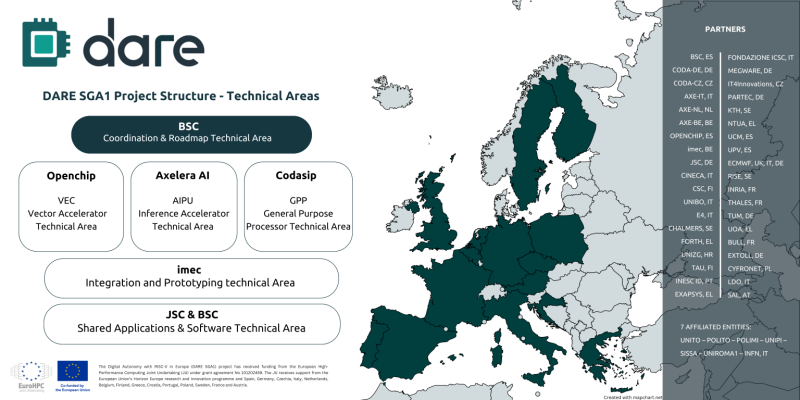

Digital Autonomy with RISC-V in Europe (DARE), крупнейший проект по разработке чипов из когда-либо финансируемых Европейским союзом, созданный с целью укрепления технологического суверенитета Европы в области высокопроизводительных вычислений (HPC) и искусственного интеллекта (ИИ), официально начал первый этап DARE SGA1, на реализацию которого выделено €240 млн ($262 млн), сообщается на сайте проекта. Европа и Китай делают ставку на RISC-V. Финансирование инициативы обеспечат 38 участников, включая ИТ-компании, исследовательские институты и университеты по всей Европе. Проект поддерживается EuroHPC JU и координируется Барселонским суперкомпьютерным центром (BSC-CNS). Последний имеет богатый опыт разработки чипов RISC-V и суперкомпьютерных систем. Половина инвестиций в проект DARE будет предоставлена Европейской комиссией через EuroHPC, а другая половина поступит напрямую от европейских партнёров, включая €34 млн от Министерства науки, инноваций и университетов Испании. Рассчитанный на три года DARE SGA1 является первым этапом шестилетней инициативы DARE. Цель — создание полноценного независимого европейского суперкомпьютерного программно-аппаратного стека для HPC и ИИ, включая чипы, системы на основе чиплетов и ПО. Инициатива направлена на удовлетворение стратегической потребности Европы в цифровом суверенитете и получения полного контроля над критической вычислительной инфраструктурой. Проектом DARE SGA1 предусмотрена разработка трёх чиплетов на основе архитектуры RISC-V, каждый из которых будет выполнять критически важную функцию в вычислениях HPC и ИИ:

В дополнение к указанным компаниям в качестве технических лидеров названы imec и Юлихский исследовательский центр (JÜLICH Supercomputing centre, JSC), которые будут продвигать ключевые инновации в рамках проекта. Помимо координации усилий, BSC также возглавит разработку планов и будет участвовать в разработке программных и аппаратных решений. Изготавливаться чиплеты будут по технологии CMOS с использованием современных техпроцессов. Axelera получит на разработку до €61 млн при условии выполнения различных задач в течение следующих трёх лет, рассказал ресурсу EE Times генеральный директор Axelera Фабрицио дель Маффео (Fabrizio del Maffeo). Хотя нынешний чип Axelera Metis AIPU предназначен для периферийных систем, дель Маффео сказал, что разрабатываемый в рамках DARE продукт на основе чиплетов не несёт кардинальные изменения, речь скорее о масштабировании. Codasip в прошлом году анонсировала 64-бит чип X730 на базе RISC-V с архитектурной защитой CHERI. По данным The Next Platform, за последнее десятилетие компания привлекла $34,6 млн общего финансирования, включая средства в рамках различных инициатив ЕС, а также посевной раунд в размере $2,5 млн в 2016 году и раунд A в размере $10 млн в 2018 году.

12.03.2025 [14:45], Сергей Карасёв

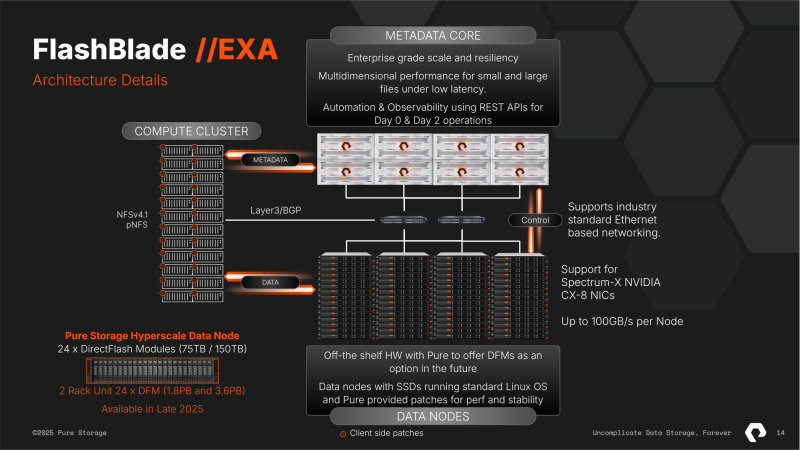

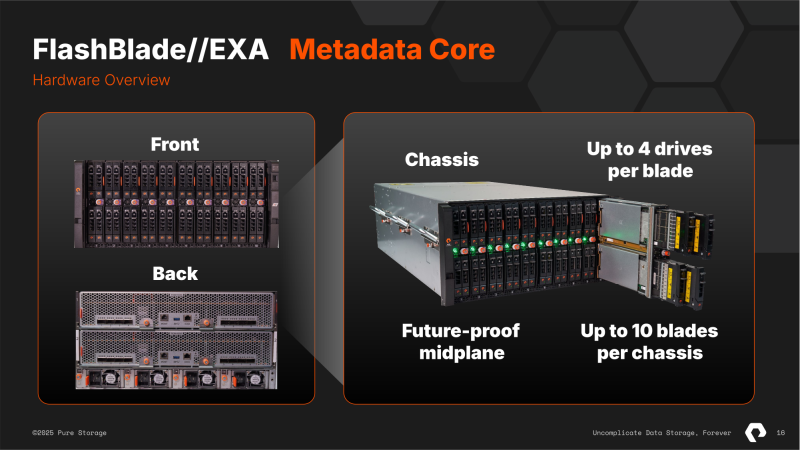

10+ Тбайт/с: Pure Storage представила высокопроизводительную All-Flash СХД FlashBlade//EXA для ИИ и НРСКомпания Pure Storage анонсировала систему FlashBlade//EXA: это, как утверждается, самая производительная на сегодняшний день платформа хранения данных, разработанная специально для наиболее требовательных нагрузок ИИ и HPC. Отмечается, что стандартные СХД оптимизированы для традиционных сред HPC с предсказуемыми операциями. Такие системы разрабатываются с прицелом на масштабирование «чистой производительности». Однако современные нагрузки ИИ являются гораздо более сложными и многомодальными: они предусматривают обработку данных разного типа — текстов, изображений и видео — одновременно на десятках тысяч ускорителей. Из-за этого возникает необходимость в оптимизации обработки метаданных наряду с масштабированием производительности. FlashBlade//EXA, по заявлениям Pure Storage, устраняет узкие места традиционных СХД в плане работы с метаданными. Архитектура новой платформы даёт возможность масштабировать ресурсы для обработки обычных данных и метаданных независимо друг от друга. Эффективная обработка метаданных имеет решающее значение для поддержания высокой производительности, надёжности и эффективности в крупномасштабных средах ИИ. Сегмент метаданных Metadata Core в составе FlashBlade//EXA может объединять от 1 до 10 5U-шасси с десятью blade-узлами в каждом. В каждом узле размещается от одного до четырёх фирменных 37.5-Тбайт модуля DFM. Ещё 2U приходится на пару XFM (External Fabric Modules), которые дают 16 подключений 400GbE. Metadata Core работает с фирменной ОС Purity//FB, общается напрямую с GPU-кластером (NFSv4.1 over TCP) и управляет потоками данных между узлами хранения и кластером (NFSv3 over RDMA). Узлы хранения Data Node обладают неограниченной масштабируемостью. Причём эти узлы могут быть самыми обычными x86-серверами любых вендоров. Каждый такой узел должен содержать 32-ядерный CPU, 192 Гбайт RAM, от 12 до 16 NVMe SSD (PCIe 4.0/5.0) вместимостью до 61,44 Тбайт, а также пару 400GbE NIC. Архитектура платформы предусматривает использование сетевых адаптеров NVIDIA ConnectX, коммутаторов Spectrum, компонентов LinkX и пр. Система FlashBlade//EXA обеспечивает производительность свыше 10 Тбайт/с на операциях чтения в одном пространстве имён. В результате, организации могут значительно ускорить процессы обучения ИИ-моделей и инференса, максимально используя потенциал GPU-ускорителей. Это также способствует снижению временных и финансовых затрат на решение ресурсоёмких задач. По-видимому, именно это решение компания и предлагает гиперскейлерам. У самой Pure Storage есть тестовая конфигурация из 300 узлов, которая показывает производительность на уровне 30 Тбайт/с. |

|