Материалы по тегу: c

|

02.07.2025 [08:35], Руслан Авдеев

Arm-чипы захватывают рынок, но до доминирования в ЦОД им пока далекоСерверы на базе Arm-чипов стремительно набирают популярность — в 2025 году их поставки должны вырасти на 70 %. Тем не менее, этого не хвататит, чтобы к концу года добиться планируемого Arm Holdings охвата рынка в 50 %, сообщает The Register. Аналитики IDC утверждают, что Arm-серверы пользуются массовым спросом в основном благодаря стоечным системам вроде NVIDIA GB200 NVL72. В новейшем отчёте Worldwide Quarterly Server Tracker эксперты IDC подсчитали, что в текущем году на Arm-серверы придётся 21,1 % от общего объёма мировых поставок. Ожидается, что поставки серверов с хотя бы одним ИИ-ускорителем вырастут на 46,7 %, на них придётся в текущем году около половины рыночной стоимости. Всего за три года, по оценкам IDC, рынок серверов должен вырасти втрое благодаря гиперскейлерам и облачным провайдерам. В целом рынок серверов достиг в I квартале 2025 года $95,2 млрд, увеличившись год к году на 134,1 %. В результате IDC повысила прогноз на год до $366 млрд, на 44,6 % выше год к году — исторический максимум для данного сегмента. При этом поставки «стандартных» x86-серверов должны вырасти в 2025 году на 39,9 % до $283,9 млрд. При этом доля AMD непрерывно растёт. Сегмент альтернативных систем вырастет на 63,7 % год к году, а их общий прогнозируемый объём составит $82 млрд. По прогнозам IDC, наибольший рост, на 59,7 % год к году ожидается в США. К концу 2025 года на данный рынок будет приходиться почти 62 % общей выручки от продаж серверов. Ещё одной точкой роста является Китай. IDC прогнозирует рост на 39,5 % — более 21 % квартального дохода во всём мире. Регионы EMEA и Латинская Америка могут рассчитывать на 7 % и 0,7 % соответственно, а Канаду, вероятно, ожидает спад на 9,6 % из-за некой «очень крупной сделки» 2024 года. В IDC подчёркивают, что спрос на большие вычислительные мощности для ИИ, вероятно, сохранится — эволюция от старых чат-ботов к рассуждающим моделям и агентному ИИ потребует роста производительности на несколько порядков, особенно для инференса.

01.07.2025 [09:02], Владимир Мироненко

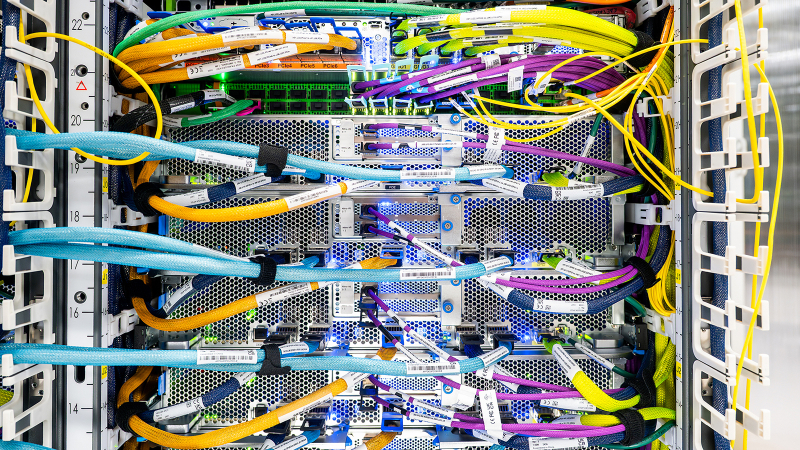

Крупнейший в истории AWS ИИ-суперкомпьютер Project Rainier охватит несколько ЦОД, но будет экологичнымВ настоящее время Amazon Web Services (AWS) занимается строительством ИИ-суперкомпьютера Project Rainier. Проект, охватывающий несколько ЦОД в США, по своим масштабам не похож ни на что, что когда-либо пыталась реализовать AWS. Этот огромный уникальный суперкомпьютер разработан для создания и работы ИИ-моделей следующего поколения. Партнёром AWS в реализации проекта выступает ИИ-стартап Anthropic, который будет использовать новый ИИ-кластер для создания и развёртывания будущих версий LLM Claude. У компаний довольно тесные отношения, а появление Project Rainier снизит зависимость Anthropic и AWS от дефицитных ускорителей NVIDIA, которых не хватает и для собственных нужд Amazon. «Rainier обеспечит в пять раз больше вычислительной мощности по сравнению с крупнейшим в настоящее время кластером Anthropic», — сообщил Гади Хатт (Gadi Hutt), директор по разработке и проектированию продуктов Annapurna Labs, подразделения AWS по разработке чипов. Чем больше вычислений вложить в обучение Claude, тем умнее и точнее будет модель. «Мы создаём вычислительную мощность в масштабах, которых никогда не было раньше, и мы делаем это с беспрецедентной скоростью и гибкостью», — подчеркнул Хатт. Сообщается, что Project Rainier спроектирован как огромный кластер EC2 UltraCluster, состоящий из серверов UltraServers с Trainium2. Trainium2 — ИИ-ускоритель собственной разработки Amazon, предназначенный для обучения ИИ-моделей. UltraServer — новый тип вычислительной системы, которая объединяет четыре физических сервера, каждый из которых содержит 16 ускорителей Trainium2, взаимодействие между которыми осуществляется с помощью интерконнекта NeuronLinks (кабели синего цвета на фото). Связь между компонентами суперкомпьютера реализуется на двух критических уровнях: NeuronLinks обеспечивают высокоскоростные соединения внутри UltraServer, в то время как DPU Elastic Fabric Adapter (EFA) объединяет UltraServer внутри ЦОД и между ЦОД. Этот двухуровневый подход позволяет максимизировать скорость в местах, где в этом больше всего есть потребность, сохраняя гибкость масштабирования в рамках нескольких дата-центров. Эксплуатация и обслуживание такого огромного вычислительного кластера отличается повышенной сложностью. И в данном случае надёжность системы имеет первостепенное значение. Именно здесь подход компании к разработке оборудования и ПО действительно выходит на первый план, говорит компания. Благодаря тому, что AWS сама занимается разработкой оборудования, она может контролировать каждый аспект технологического стека, от мельчайших компонентов чипа до ПО и архитектуры самого ЦОД. Это также позволяет ускорить внедрение технологий и снизить затраты при внедрении ИИ. «Когда у вас есть полная картина, от чипа до ПО и самих серверов, вы можете проводить оптимизацию там, где это имеет наибольший смысл», — говорит директор по инжинирингу Annapurna Labs Рами Синно (Rami Sinno). «Иногда лучшим решением может быть перепроектирование того, как подаётся питание серверов, или переписывание ПО, которое всё координирует. Это может происходить и одновременно. Поскольку у нас есть обзор всего на каждом уровне, мы можем быстро устранять неполадки и внедрять инновации гораздо быстрее», — добавил он. Вместе с тем, по словам Amazon, внедрение мощной ИИ-инфраструктуры будет достаточно экологичным. Вся электроэнергия, потребляемая Amazon, включая её ЦОД, в 2023 году была полностью компенсирована закупками из возобновляемых источников энергии. В течение последних пяти лет Amazon была крупнейшим корпоративным покупателем возобновляемой энергии в мире. Компания инвестирует миллиарды долларов в ядерную энергию и использование аккумуляторов, а также в финансирование масштабных проектов возобновляемой энергии по всему миру. Amazon по-прежнему намерена добиться нулевого уровня выбросов углерода к 2040 году. И Project Rainier ей в этом поможет. В прошлом году AWS объявила, что будет развёртывать новые компоненты, которые объединяют достижения в области питания и охлаждения, не только в строящихся, но и в существующих ЦОД. Их использование, как ожидается, позволит снизить потребление энергии механизмами до 46 % и сократить выбросы парниковых газов при производстве бетона на 35 %. Новые объекты для Project Rainier будут включать в себя различные усовершенствования для повышения энергоэффективности и экологичности с акцентом на сокращение потребления водных ресурсов и использованию забортного воздуха для охлаждения. Например, в ЦОД в округе Сент-Джозеф (St. Joseph), штат Индиана, с октября по март ЦОД вообще не будут использовать воду для охлаждения, а с апреля по сентябрь питьевая вода будет нужна только в течение нескольких часов в день. Amazon не уточняет, о каком именно кампусе идёт речь, но уже известно, что компания строит в Индиане дата-центр, который будет потреблять энергии как половина населения штата. Благодаря инженерным инновациям AWS является лидером отрасли по эффективности использования воды, заявляет компания. На основании результатов недавнего исследования Национальной лаборатории Лоуренса в Беркли, посвящённого эффективности использования воды в ЦОД, отраслевой стандартный показатель составляет 0,375 л/кВт·ч, тогда как у AWS он равен всего 0,15 л/кВт·ч. Компания улучшила этот параметр на 40 % по сравнению с 2021 годом.

30.06.2025 [11:11], Сергей Карасёв

Албания присоединилась к европейской суперкомпьютерной программе EuroHPC JUЕвропейское совместное предприятие по развитию высокопроизводительных вычислений (EuroHPC JU) сообщило о том, что Албания стала 36-м государством — участником проекта. Соответствующее решение принято по итогам 49-го заседания совета управляющих EuroHPC. Отмечается, что Албания принимает активное участие в программе Европейского союза по исследованиям и инновациям с 2008 года. Доступ к вычислительным ресурсам EuroHPC предоставляется научно-исследовательским институтам, государственным органам и промышленным предприятиям Албании. Теперь эта страна становится полноправным участником EuroHPC. Албанские специалисты смогут подавать заявки на исследовательские и инновационные инициативы EuroHPC JU, финансируемые в рамках программы Horizon Europe. Кроме того, Албания сможет внести свой вклад в развёртывание так называемых европейских фабрик ИИ — EuroHPC AI Factories. В 2025 году такие площадки появятся в Финляндии, Германии, Греции, Италии, Люксембурге, Испании и Швеции. В целом, EuroHPC JU курирует создание 13 фабрик ИИ по всей Европе, которые будут предоставлять ресурсы малым и средним компаниям, а также стартапам. Албания присоединилась к другим странам — членам EuroHPC JU, которые участвуют в программе Horizon Europe и при этом не входят в Европейский союз. Среди них — Исландия, Черногория, Северная Македония, Норвегия, Сербия, Турция и Великобритания. В целом, EuroHPC активно развивает инфраструктуру высокопроизводительных вычислений в Европе. В рамках инициативы на сегодняшний день развёрнуты десять НРС-систем. Три из суперкомпьютеров EuroHPC входят в десятку самых мощных НРС-комплексов мира: это Jupiter в Германии, который занимает 4-е место в июньском списке ТОР500, а также LUMI в Финляндии (9-я строка) и Leonardo в Италии (10-е место). Подписано соглашение с французским национальным агентством высокопроизводительных вычислений (GENCI) о размещении второго в Европе (после Jupiter) суперкомпьютера экзафлопсного класса — системы Alice Recoque. Кроме того, EuroHPC JU формирует европейскую инфраструктуру квантовых вычислений. В частности, в конце 2024 года была начата подготовка к созданию передовых сетей, которые соединят суперкомпьютеры, квантовые компьютеры и дата-центры Евросоюза. Вместе с тем Юлихский суперкомпьютерный центр в Германии (JSC) получил 100-кубитный квантовый компьютер на нейтральных атомах. EuroHPC также развернёт в Европе специализированные индустриальные суперкомпьютеры.

30.06.2025 [09:52], Руслан Авдеев

CoreWeave снова пытается купить оператора ЦОД Core Scientific, от которого зависит бизнес компанииCoreWeave рассчитывает купить оператора ЦОД Core Scientific, клиентом которого она является. От Core Scientific зависит работа облачной платформы CoreWeave, сообщает Silicon Angle. CoreWeave впервые попыталась купить оператора год назад, предложив $1 млрд, но в итоге стороны несколько раз продляли и расширяли контракты. Это партнёрство может сыграть злую шутку, поскольку сам факт тесного сотрудничества с CoreWeave поднимает цену Core Scientific — акции оператора на фоне сообщений о сделке уже выросли в цене на 30 %. Впрочем, и сама CoreWeave за это время значительно выросла и даже вышла на биржу. Core Scientific была основана в 2017 году для майнинга биткоинов. На биржу она вышла в начале 2022 года, но всего через несколько месяцев подала заявку о банкротстве, чтобы избежать полной ликвидации компании, обойдясь её реструктуризацией. В январе 2024 года Core Scientific вышла из банкротства и переключилась на создание и эксплуатацию ИИ ЦОД. Приблизительно в то же время она заключила первую сделку с CoreWeave. Изначально CoreWeave арендовала 15 МВт ЦОД в Остине (Техас), но с тех пор договор расширили до 590 МВт на шести площадках. Как сообщают в самой Core Scientific, её контракты с облачным провайдером должны принести более $10 млрд в следующие 12 лет. Это довольно внушительная сумма, поэтому CoreWeave, возможно, попытается профинансировать покупку акциями, чтобы не увеличивать долговую нагрузку. На конец декабря 2024 года компания имела около $8 млрд долгов, но с тех пор рефинансировала часть долга. Если сделка по покупке Core Scientific будет закрыта, это будет уже второе крупное приобретение CoreWeave с начала 2025 года. Ранее компания купила за $1,7 млрд поставщика ИИ-инструментов Weights & Biases за $1,7 млрд и интегрировала его решения в своё облако. Сейчас CoreWeave работает над обновлением как программных средств, так и инфраструктуры. В апреле 2025 года компания объявила о скором доступе к тысячам ускорителей NVIDIA Blackwell B200.

29.06.2025 [21:11], Сергей Карасёв

Таёжное облако: ИИ-кластер Northern Data Njoerd вошёл в рейтинг TOP500

h100

hardware

hpc

hpe

intel

northern data

nvidia

sapphire rapids

xeon

великобритания

ии

облако

суперкомпьютер

Немецкая компания Northern Data Group, поставщик решений в области ИИ и НРС, объявила о том, что её система Njoerd вошла в июньский рейтинг мощнейших суперкомпьютеров мира TOP500. Этот вычислительный комплекс, расположенный в Великобритании, построен на платформе HPE Cray XD670. Машина Njoerd попала на 26-е место списка TOP500. Она объединяет 244 узла, каждый из которых содержит восемь ускорителей NVIDIA H100. В общей сложности задействованы примерно 28,5 млн ядер CUDA. Кроме того, в составе системы используются процессоры Intel Xeon Platinum 8462Y+ (32C/64C, 2,8–4,1 ГГц, 300 Вт). Применён интерконнект Infiniband NDR400. FP64-производительность Njoerd достигает 78,2 Пфлопс, а теоретическое пиковое быстродействие составляет 106,28 Пфлопс. При рабочих нагрузках ИИ суперкомпьютер демонстрирует производительность 3,86 Эфлопс в режиме FP8 и 1,93 Эфлопс в режиме FP16. Заявленный показатель MFU (Model FLOPs Utilization) при предварительном обучении современных больших языковых моделей (LLM) находится на уровне 50–60 %. Таким образом, как утверждается, система Njoerd на сегодняшний день представляет собой наиболее эффективный кластер H100 подобного размера, оптимизированный для ресурсоёмких рабочих нагрузок ИИ и HPC. Суперкомпьютер входит в состав Taiga Cloud — одной из крупнейших в Европе облачных платформ, ориентированных на задачи генеративного ИИ. Эта вычислительная инфраструктура использует на 100 % безуглеродную энергию. Показатель PUE варьируется от 1,15 до 1,06. Доступ к ресурсам предоставляется посредством API или через портал самообслуживания. Одним из преимуществ Taiga Cloud компания Northern Data Group называет суверенитет данных.

Источник изображения: Northern Data Group

27.06.2025 [23:45], Владимир Мироненко

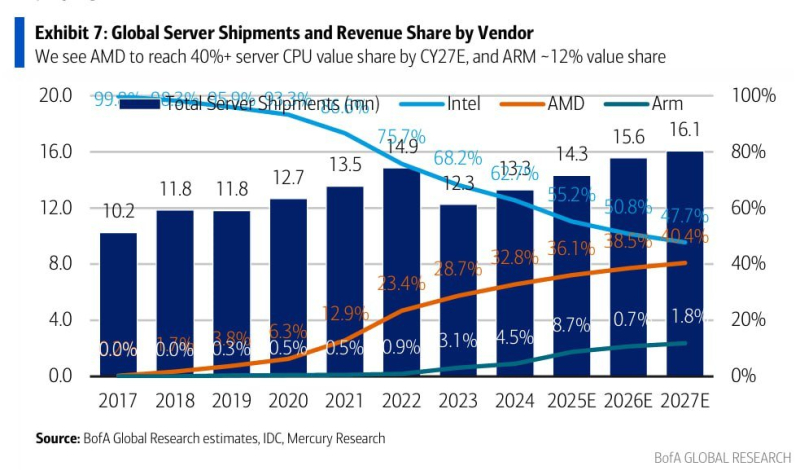

Intel скоро «догонит» AMD по доле рынка серверных процессоровУспехи AMD в разработке серверных процессоров EPYC на фоне проблем Intel с запуском некоторых поколений Xeon привели к постоянному росту в последние годы доли рынка серверных процессоров AMD, причём как по количеству единиц, так и по выручке, пишет ресурс HardwareLuxx. Впрочем, и AMD, и Intel уже угрожает Arm. В последнем отчёте Bank of America отмечается, что если в 2017 году доля рынка Intel составляла почти 100 %, в то время как процессоры AMD и Arm на нём практически, то в 2024 году доля AMD на рынке серверных процессоров составила около 33 % (и продолжает расти), а доля рынка Intel сократилась почти до 63 %. Переломный момент наступил после появления архитектуры AMD Zen и проблем Intel с переводом Xeon на более тонкие техпроцессы. К концу 2022 года доля рынка AMD превысила отметку в 20 %, в то время как доля Intel впервые упала ниже 75 %. Согласно оценкам Bank of America, основанным на данных IDC и Mercury Research, доля AMD на рынке серверных процессоров вырастет в 2025 году примерно до 36 %, в то время как доля Intel снизится примерно до 55 %. Также растёт конкуренция со стороны серверных процессоров с архитектурой Arm, поскольку поставщики облачных услуг ищут более энергоэффективные и экономичные варианты, а совокупная стоимость владения (TCO) в ЦОД становится все более важным фактором. Прогнозируется, что в следующем году на них будет приходиться примерно 9 % рынка серверных процессоров. В 2027 году, как ожидается доля рынка AMD может достичь 40 %, а доля Intel упадет ниже 50 %. Доля процессоров с Arm-архитектурой может составить от 10 до 12 %. Сама Arm Holdings намерена уже до конца этого занять половину рынка чипов для ЦОД, куда, впрочем, входят не только CPU. SoftBank, владеющая крупнейшей долей в Arm Holdings, решила приобрести разработчики серверных Arm-процессоров Ampere Computing. С 2028 года ожидается, что AMD и Intel будут в равных условиях. Следует отметить, что речь идёт о доле рынка исходя из выручки, то есть о продажах в денежном выражении, а не в количественном. Доход AMD в основном приносят высокопроизводительные многоядерные процессоры, в то время как Intel по-прежнему выпускает различные недорогие чипы. Как полагают аналитики, эта тенденция вряд ли изменится. AMD демонстрирует устойчивое развитие в серверном сегменте и готовит процессоры Venice, в то время как Intel пытается переломить ситуацию с помощью серии Xeon 6.

27.06.2025 [16:15], Владимир Мироненко

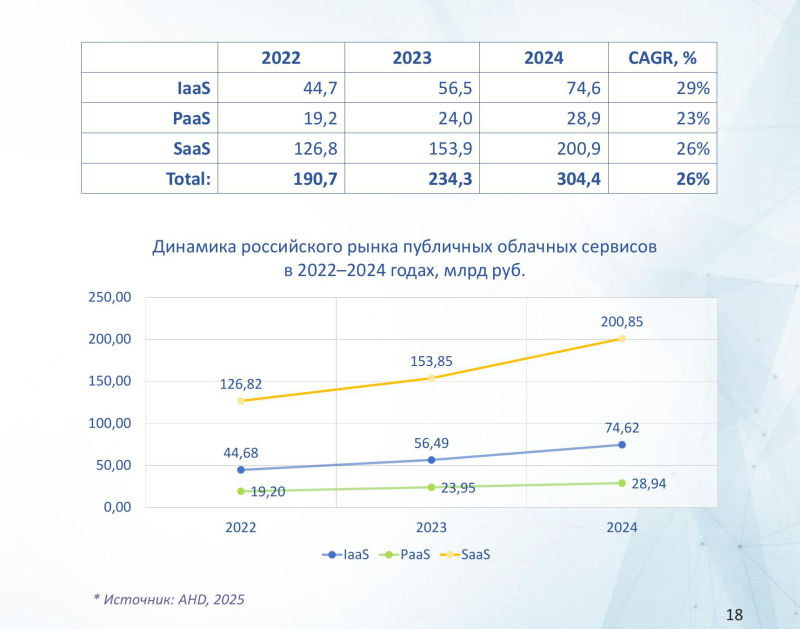

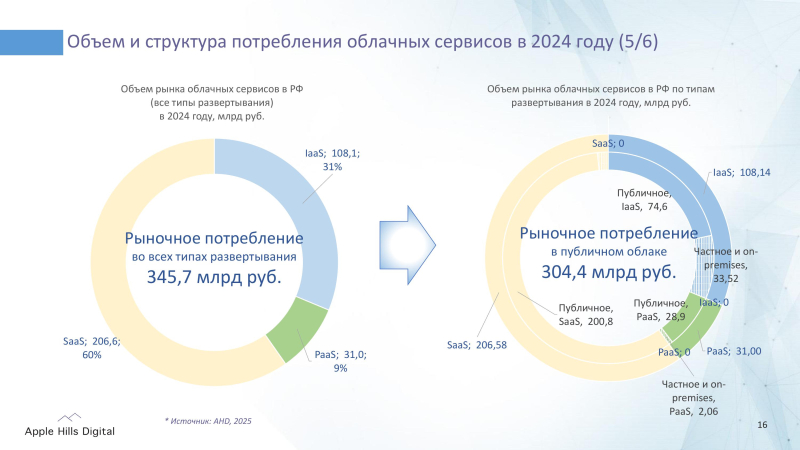

Инфраструктура в публичном облаке России ежегодно увеличивается почти на третьВ период с 2022 по 2024 год на российском рынке облачных сервисов среди наиболее динамично развивающихся сегментов рынка следует отметить инфраструктуру в публичном облаке (IaaS) со среднегодовым темпом роста (CAGR) в размере 29 %, сообщается в исследовании компании Apple Hills Digital проведенном по методологии IDC, которое было дополнено экспертным анализом от VK Tech. Особенно активно растёт спрос на услуги GPU-accelerated server — в среднем за год на 39,3 % — на фоне роста числа задач в области машинного обучения, обработки больших данных и аналитики. Как ожидается, подсегмент GPU-accelerated server сохранит высокие темпы и в дальнейшем — его CAGR в период с 2024 по 2029 год превысит 26 %. За это время российский рынок публичных IaaS увеличится более чем в 2,3 раза до 170,8 млрд руб. в 2029 году. Среднегодовой темп роста (CAGR) рынка за этот период составит 18,1 %. В исследовании проведён анализ рынка облачных сервисов как в публичном облаке, так и в гибридных моделях использования — в частных облаках (Private Cloud), которые могут быть развёрнуты у провайдера и заказчика (on-premise). В 2024 году объём потребления в частных облаках (Private Cloud и On-Premise Cloud) превысил 40 млрд руб., составив 12 % всего рынка облачных сервисов. Реагируя на спрос, ведущие российские провайдеры вывели на рынок решения для развёртывания облачных сервисов в закрытых средах, соответствующих требованиям к информационной безопасности и запросу регулятора. Сегмент PaaS в России развивается медленнее других сегментов. Его доля рынка публичных облачных сервисов в 2024 году составила лишь 9 % или 28,9 млрд руб., что более чем вдвое ниже доли PaaS на мировом рынке публичных облачных сервисов, которая, согласно данным IDC, составляет 20 %. Основная причина этого заключается в отсутствии полноценной замены многим иностранным платформенным продуктам, что ограничивает развитие сегмента и в целом замедляет эволюцию российского рынка облачных сервисов, хотя российские провайдеры уже предлагают отдельные ML-Ops решения. Согласно прогнозу аналитиков, с 2024 по 2029 год российский рынок публичных PaaS увеличится более чем в 3 раза до 89 млрд руб. в 2029 году. Среднегодовой темп роста (CAGR) за этот период составит 25,1 %. Исследователи отметили, что на объём российского рынка влияет распространение в России практики внутреннего потребления облачных сервисов, которое рассматривается отдельно от рыночного потребления. На долю внутреннего потребления в 2024 году пришлось около 12 % от общего потребления облачных сервисов в России или 47 млрд руб., на рыночное потребление — 88 % или 345,7 млрд руб. Общий объём потребления облачных сервисов в РФ включая сегменты IaaS, PaaS и SaaS составил 392,7 млрд руб. Внутреннее потребление развито в сегментах PaaS (до 30 %) и IaaS (25 %), что свидетельствует о высоком технологическом уровне и преимуществах в ресурсах крупных групп с собственными облачными платформами и цифровыми инфраструктурами. Apple Hills Digital отмечает, что российский рынок облачных сервисов находится под влиянием крупных финансовых и технологических групп, рост внутреннего потребления облачных сервисов в которых опережает темпы его развития. Также отмечается рост интереса к облачным сервисам в частных облаках провайдера и on-premise для повышения надёжности, безопасности и независимости ИТ инфраструктуры крупных заказчиков. VK Tech активно развивает VK Cloud в направлении платформенных сервисов, предлагая решения как публичного, так и частного облака. В 2024 году выручка её направления облачной платформы выросла на 82,3 % год к году до 5,8 млрд руб.

27.06.2025 [11:49], Сергей Карасёв

HPE анонсировала серверы ProLiant Compute Gen12 на базе AMD EPYC TurinКомпания HPE представила серверы ProLiant Compute DL325 и DL345 поколения Gen12, оптимизированные для рабочих нагрузок с интенсивным использованием памяти, таких как виртуализация и периферийные вычисления. В основу новинок положена аппаратная платформа AMD EPYC Turin. Серверы 12-го поколения на базе Intel Xeon 6 компания представила зимой. Поставки систем будут организованы в июле нынешнего года. Тогда же, по-видимому, будт раскрыты полные характеристики новинок. Пока известно, что модель ProLiant Compute DL325 Gen12 выполнена в форм-факторе 1U. Она имеет односокетную конфигурацию с возможностью использования воздушного и жидкостного охлаждения. Доступны 24 слота для модулей оперативной памяти, а максимально поддерживаемый объём ОЗУ составляет 6 Тбайт.

Источник изображений: HPE Сервер будет предлагаться в различных конфигурациях, в том числе с возможностью установки до четырёх однослотовых GPU. Есть два разъёма OCP NIC 3.0 SFF. Во фронтальной части расположены отсеки для SFF-накопителей: в частности, предусмотрено исполнение с восемью посадочными местами для таких устройств. Сзади находятся порты USB, гнездо RJ45 для сетевого кабеля, аналоговый интерфейс D-Sub. Упомянуты средства управления HPE Integrated Lights-Out (HPE iLO 7). Говорится о защите от будущих кибератак, основанных на квантовых вычислениях.  Вариант ProLiant Compute DL345 Gen12, по сути, представляет собой модификацию DL325 в формате 2U. Ключевые характеристики остались прежними: один разъём для процессора EPYC Turin (до 192 вычислительных ядер), 24 слота для модулей ОЗУ и два разъёма OCP NIC 3.0 SFF. При этом предоставляются более широкие возможности в плане формирования подсистемы хранения данных и установки карт расширения. Прочие технические характеристики серверов пока не раскрываются.

25.06.2025 [11:20], Сергей Карасёв

SSSTC выпустила SATA SSD серии CVD для интенсивной записиКомпания Solid State Storage Technology Corporation (SSSTC) анонсировала SSD семейства CVD, оснащённые интерфейсом SATA-3. Накопители оптимизированы для приложений с интенсивной и продолжительной записью информации. Это могут быть системы видеонаблюдения и видеопроизводства, потоковой передачи данных, автомобильные регистраторы и т.п. Устройства представлены в форм-факторах M.2 2280 и SFF. В обоих случаях вместимость может составлять 128, 256 и 512 Гбайт, а также 1 и 2 Тбайт. Применены чипы флеш-памяти 3D TLC NAND — изделия Kioxia BiCS FLASH пятого поколения. Скорость последовательного чтения информации достигает 500 Мбайт/с, скорость последовательной записи — 260 Мбайт/с. Величина IOPS при произвольных чтении и записи блоками по 4 Кбайт — до 50 тыс. и 75 тыс. соответственно. Накопители способны выдерживать свыше одной полной перезаписи в сутки (1 DWPD) на протяжении трёх лет. Средняя заявленная наработка на отказ (MTBF) превышает 3 млн часов. Диапазон рабочих температур простирается от 0 до +85 °C. В устройствах реализована фирменная технология SSSTC Direct Write, специально разработанная для рабочих нагрузок с интенсивной записью. Система обеспечивает запись данных непосредственно в TLC, устраняя зависимость от кеша SLC. В результате, обеспечиваются стабильная производительность (предотвращается падение скорости) и низкие задержки. По заявлениям разработчика, даже при непрерывной записи видео в высоком разрешении в режиме 24/7 накопители демонстрируют устойчивую производительность. В новинках реализована поддержка шифрования AES-256 и TCG Opal. Средства Power Loss Protection (PLP) обеспечивают сохранность данных при внезапном отключении питания. Массовое производство накопителей серии CVD уже началось.

24.06.2025 [16:15], Руслан Авдеев

400-кВт ЦОД Deep Green будет отапливать бассейн развлекательного центра в МанчестереDeep Green, внедряющая небольшие дата-центры при бассейнах, намерена развернуть объект близ Манчестера (Великобритания). Компания разместит оборудование на 400 кВт на площади 150 м2 в развлекательном центре Move Urmston в районе Урмстон (Urmston, Большой Манчестер), сообщает Datacenter Dynamics. Тепло дата-центра будет использоваться для подогрева воды. Система будет использовать комбинацию прямого жидкостного охлаждения и воздушное охлаждение. ЦОД получит восемь стоек мощностью до 60 кВт каждая, размещённых в контейнере. Целевой PUE — не более 1,2. В Deep Green подчеркнули, что ЦОД не просто обеспечит развлекательный центр теплом на десятки тысяч фунтов, но и позволить сократить углеродные выбросы на сотни тонн. Deep Green размещает HPC-серверы в местах, где их тепло можно будет использовать в полной мере. Само тепло предлагается пользователям, в том числе плавательным бассейнам, бесплатно. Деятельность Deep Green началась в 2023 году, первое вычислительное оборудование было размещено в развлекательном центре в Эксмуте (Exmouth, Девон). Клиентами Deep Green уже являются британский облачный провайдер Civo и постпродакшн-компания Dirty Looks. Инвестором Deep Green является британская коммунальная компания Octopus Energy. На сайте компании сообщается, что у неё уже есть один действующий объект, три в стадии строительства и один — в стадии планирования.

Источник изображения: David Romualdo/unsplash.com Уже действует объект DG03 в Суиндоне (Swindon, Уилтшир) на 1,1 МВт. Описываемый выше 400-кВт ЦОД DG01 в Манчестере пока строится, как и ещё один объект на 500 кВт — DG02 в Йорке (York, Норт-Йоркшир). Более крупный 4-МВт ЦОД возводится в Брэдфорде (Bradford, Уэст-Йоркшир). Ещё один объект на 20 МВт планируется построить в Линкольне (Lincoln, Линькольншир), но официальных подробностей пока немного. Также планируется дата-центр DG06 мощностью более 20 МВт, который расположится в Лансинге, столице американского штата Мичиган. Всего Deep Green намерена развернуть 300 МВт в Европе и США. Схожие решения создаёт французская компания Qarnot. В Великобритании производитель «цифровых бойлеров» Heata и облачный оператор Civo уже предлагают устанавливать серверы для отопления зданий. А Aventuur планирует обогревать аквапарк в Новой Зеландии теплом дата-центра, питающегося от солнечных элементов. При этом ещё в 2023 году сообщалось, что на практике такие решения дороги, а иногда и вовсе бессмысленны. |

|