Лента новостей

|

14.06.2025 [17:04], Владимир Мироненко

Scale AI получила от Meta✴ более $14 млрд, но потеряла гендиректора и рискует лишиться крупных контрактов с Gooogle, Microsoft, OpenAI и xAIИИ-стартап Scale AI, занимающийся подготовкой, оценкой и разметкой данных для обучения ИИ-моделей, объявил о крупной инвестиционной сделке с Meta✴, по результатм которой его рыночная стоимость превысила $29 млрд. Сделка существенно расширит коммерческие отношения Scale и Meta✴. Также её условиями предусмотрен переход гендиректора Scale AI Александра Ванга (Alexandr Wang) и ещё ряда сотрудников в Meta✴. Вместо Ванга, который останется в совете директоров стартапа, временно исполняющим обязанности гендиректора Scale AI назначен Джейсон Дроги (Jason Droege), директор по стратегии, имеющий «20-летний опыт создания и руководства знаковыми технологическими компаниями, включая Uber Eats и Axon». Представитель Scale AI уточнил в интервью ресурсу CNBC, что Meta✴ вложит в компанию $14,3 млрд, в результате чего получит в ней 49-% долю акций, но без права голоса. «Мы углубим совместную работу по созданию данных для ИИ-моделей, а Александр Ванг присоединится к Meta✴ для работы над нашими усилиями по созданию суперинтеллекта», — рассказал представитель Meta✴. Переманивая Ванга, который не имея опыта в R&D, сумел с нуля создать крупный бизнес в сфере ИИ, гендиректор Meta✴ Марк Цукерберг (Mark Zuckerberg) делает ставку на его организаторские способности, полагая, что укрепить позиции Meta✴ в сфере ИИ под силу опытному бизнес-лидеру, больше похожему на Сэма Альтмана (Sam Altman), чем на учёных, стоящих у руля большинства конкурирующих ИИ-лабораторий, пишет Reuters. Инвестиции в Scale AI станут вторыми по величине в истории Meta✴ после приобретения WhatsApp за $19 млрд. Однако сделка может оказаться не совсем выгодной для Scale AI, предупреждает Reuters, поскольку многие компании, являющиеся клиентами Scale AI, могут отказаться от дальнейшего сотрудничества из-за опасений по поводу того, что Ванг, оставаясь в совете директоров стартапа, будет предоставлять Meta✴ внутреннюю информацию о приоритетах конкурентов. Представитель Scale AI заверил, что инвестиции Meta✴ и переход Ванга не повлияют на клиентов стартапа, и что Meta✴ не будет иметь доступа к его какой-либо деловой информации или данным. Тем не менее, по словам источников Reuters, Google, один их крупнейших клиентов Scale AI, планирует разорвать отношения со стартапом. Источники сообщили, что Google планировала потратить $200 млн только в этом году на услуги Scale AI по подгтовке и разметке данных людьми. После объявления о сделке поисковый гигант уже провёл переговоры с несколькими конкурентами Scale AI. Scale AI получила в 2024 году размере $870 млн, из них около около $150 млн от Google, утверждают источники. По их словам, другие крупные клиенты, включая Microsoft, OpenAI и xAI, тоже планируют отказаться от услуг Scale AI. Официальных подтверждений этой информации пока не поступало. А финансовый директор OpenAI заявил в пятницу, что компания, которой источники тоже приписывают намерение отказаться от услуг Scale AI, продолжит работать со стартапом, как с одним из своих многочисленных поставщиков данных.

14.06.2025 [15:40], Руслан Авдеев

AWS переведёт ещё 100 дата-центров на использование очищенных сточных вод для охлажденияAmazon намерена увеличить количество ЦОД, использующих для охлаждения очищенные сточные воды, с 20 до 120. Реализация новой инициативы будет проводиться до 2030 года, сообщает Datacenter Dynamics. Как заявляют в компании, только в США ежегодно можно будет экономить около 2 млн м3 питьевой воды. Поскольку отработанная вода постепенно накапливает бактерии и накипь, её обрабатывают с помощью химикатов, что обычно делает её непригодной для употребления людьми после отвода с территории дата-центров. Сколько именно индустрии ЦОД требуется чистой воды, доподлинно никто не знает, но, по некоторым оценкам, речь идёт о многих миллионах кубических метров ежегодно. Сейчас AWS использует в ЦОД оборотную воду вместо питьевой на 20 объектах, 16 из которых находятся в Вирджинии (США), а ещё четыре — в Санта-Кларе (Santa Clara) в Калифорнии. Полученный опыт распространят на другие кампусы в Вирджинии, Джорджии и Миссисипи. Всего у Amazon есть более 100 активных ЦОД по всему миру, ещё десятки строятся. Компания управляет более чем 37 облачными регионами и 117 зонами доступности. Как минимум четыре новых региона и дюжина зон доступности готовится к вводу в эксплуатацию. В 2020 году Amazon заявила, что стала первым оператором ЦОД, получившим «добро» на использование очищенной воды в системе прямого испарительного охлаждения в совместном проекте с Loudoun Water. Сточные воды ЦОД проходят трёхступенчатую очистку, устраняющую 99 % загрязнений. После того, как восстановленная вода проходит через систему охлаждения, она снова очищается и используется. Процесс повторяется до тех пор, пока очистка становится невозможной. Компания заявляет, что испарительные системы могут использовать в некоторых случаях на 85 % меньше воды, чем традиционные. В некоторых локациях вроде Швеции и Ирландии AWS использует фрикулинг — благодаря холодному воздуху снаружи можно применять очень мало воды или не использовать её вовсе. AWS обещала стать «водно-положительной» (т.е. потреблять меньше чистой воды, чем возвращать в окружающую среду) к 2030 году. К 2023 году компания выполнила план на 41 % плана, а в 2024 году — уже на 53 %. Предполагается, что новая инициатива компании снизит давление на локальные водоносные системы, но не в ущерб активно развивающимся ИИ ЦОД. Amazon утверждает, что её объекты в среднем тратят 0,15 л на кВт∙ч (для сравнения: европейские ЦОД было предложено ограничить показателем 0,4 л/кВт∙ч). Планы AWS вполне объяснимы. Совсем недавно появилась информация, что компания намерена продолжить активное расширение инфраструктуры ИИ ЦОД, поэтому возобновляемые ресурсы, вероятно, будут иметь для неё большое значение. В апреле сообщалось, что доступ к чистой воде становится одной из главных забот для операторов ИИ ЦОД. По данным Google, 22 % всей воды, используемой в её ЦОД (за исключением морской), приходится на очищенные сточные воды и другие непригодные для питья источники, а около трети кампусов применяют фрикулинг или другие непитьевые ресурсы. Google признаёт, что её дата-центры в среднем потребляют более 1700 м3/день, но к 2030 году компания планирует отдавать на 20 % больше чистой воды, чем использует. К 2030 году водно-положительной намерена стать и Microsoft. Компания уже несколько использует очищенные сточные воды в своих ЦОД в Сан-Хосе (Калифорния), Куинси (Вашингтон), в Техасе и Сингапуре. Apple очищает сточные воды для своего дата-центра в Орегоне. Компания намерена восполнять 100 % воды, используемой в её работе в местах с неблагоприятными природными условиями к 2030 году. Кроме того, Apple внедрила методы очистки воды с применением растительности, что снижает использование химикатов. Стать водно-положительной к 2030 году намерена и Meta✴.

14.06.2025 [00:52], Владимир Мироненко

Oracle пообещала построить больше облачных ЦОД, чем все конкуренты вместе взятыеАмериканская корпорация Oracle сообщила финансовые результаты IV квартала и всего 2025 финансового года, закончившегося 31 мая 2025 года. Выручка выросла на 11 % в годовом исчислении в IV квартале до $15,9 млрд при консенсус-прогнозе аналитиков, опрошенных LSEG, в размере $15,59 млрд. После публикации квартального отчёта акции Oracle выросли в четверг на 14 % до $201,38, впервые превысив отметку в $200, сообщило агентство Reuters. Чистая прибыль (GAAP) выросла до $3,43 млрд или $1,19 на разводнённую акцию с $3,14 млрд или $1,11 на разводнённую акцию годом ранее. Скорректированная чистая прибыль (Non-GAAP) за квартал равняется $4,88 млрд или $1,70 на разводнённую акцию, что выше консенсус-прогноза от LSEG в размере $1,64 на разводнённую акцию. В I квартале 2026 финансового года Oracle ожидает получить скорректированную прибыль (Non-GAAP) на акцию в размере $1,46–1,50 при росте выручки в диапазоне от 12 до 14 %. Аналитики, опрошенные LSEG, ожидают $1,48 скорректированной прибыли на акцию и $14,96 млрд выручки, что подразумевает рост год к году на 12,4 %. Выручка за IV финансовый квартал от облачных сервисов и поддержки лицензий выросла на 14 % до $11,7 млрд (74 % всей выручки), превысив консенсус-прогноз аналитиков, опрошенных StreetAccount, в размере $11,59 млрд. Выручка от лицензирования облачных и локальных продуктов увеличилась на 8 % до $2,01 млрд, превысив консенсус-прогноз StreetAccount в размере $1,82 млрд. Также увеличились, хотя и незначительно, продажи оборудования — на 1 % до $850 млн, но сократилась выручка от сервисов — на 2 % до $1,35 млрд. Между тем компания заявила, что её оставшиеся обязательства по исполнению (RPO), отражающие объём невыполненных работ, выросли на 41 % до $138 млрд.

Источник изображения: NVIDIA Что касается итогов за 2025 финансовый год, то выручка Oracle увеличилась на 8 % до $57,4 млрд. Доходы от облачных сервисов и поддержки лицензий выросли на 12 % до $44,02 млрд, выручка от лицензирования облачных и локальных продуктов выросла на 2 % до $5,20 млрд. Чистая прибыль (GAAP) за год составила $12,44 млрд или $4,34 на разводнённую акцию, а скорректированная чистая прибыль (Non-GAAP) — $17,28 млрд или $6,03 на разводнённую акцию. Генеральный директор Oracle Сафра Кац (Safra Catz) сообщила, что выручка от облачной инфраструктуры должна увеличиться в 2026 финансовом году более чем на 70 % (уже сейчас рост +52 % в отчётном квартале). Компания прогнозирует более $67 млрд выручки в 2026 финансовом году, что превышает консенсус-прогноз аналитиков от LSEG в размере $65,18 млрд. По словам Кац, компания намерена увеличить целевой показатель выручки в размере $104 млрд, установленный ею в сентябре прошлого года на 2029 финансовый год.

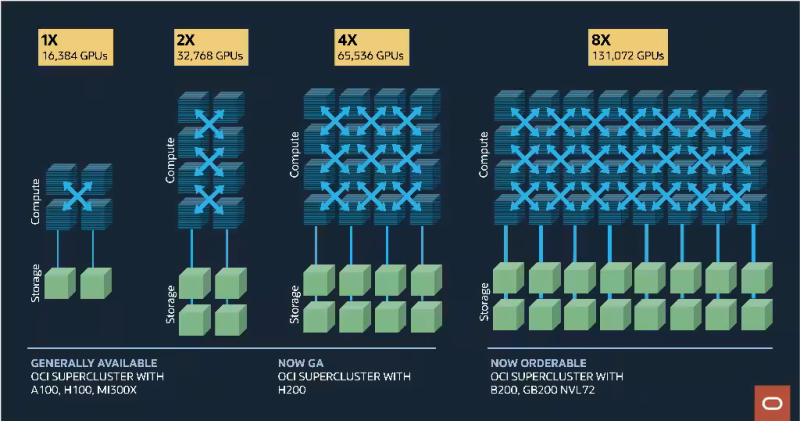

Источник изображения: Oracle Также гендиректор Oracle отметила, что капитальные затраты в 2025 финансовом году превысили $21 млрд по сравнению с менее чем $7 млрд в 2024 финансовом году, и в 2026 году должны превысить $25 млрд. «Мы делаем многое, чтобы снизить наши капитальные затраты, — сообщил председатель и технический директор Oracle Ларри Эллисон (Larry Ellison). — Но даже если мы это сделаем, капитальные затраты вырастут, потому что спрос сейчас кажется почти ненасытным». «Я никогда не видел ничего даже отдалённо похожего», — добавил он. Эллисон сообщил, что в настоящее время у компании 23 действующих ЦОД MultiCloud и ещё 47 будут построены в течение следующих 12 месяцев. «Мы ожидаем, что трёхзначный рост выручки MultiCloud продолжится в 2026 финансовом году. Выручка от Oracle Cloud@Customer выросла на 104 % по сравнению с прошлым годом. У нас 29 действующих выделенных ЦОД Oracle Cloud@Customer, и ещё 30 будут построены в 2026 финансовом году. Общий доход от Oracle Cloud Infrastructure вырос на 62 % в IV квартале», — рассказал технический директор. Он добавил, что доход от баз данных MultiCloud в облаках Amazon, Google и Azure вырос на 115 % по сравнению с предыдущим кварталом. Он также сообщил, что недавно Oracle получила заказ от неназванного клиента на всю доступную облачную ёмкость. «Мы никогда раньше не получали такого заказа, — цитирует Эллисона ресурс SiliconANGLE. — Мы сделали всё возможное, чтобы предоставить им необходимую ёмкость». Однако позже он отметил, что китайский интернет-ретейлер Temu, принадлежащий PDD Holdings, согласился перенести большой объём рабочих нагрузок в облачную инфраструктуру Oracle. Эллисон отметил, что сделка с Temu не имеет ничего общего с ИИ, чтобы продемонстрировать, что Oracle преуспевает по нескольким направлениям, включая её флагманскую базу данных, пишет The Register. Напомним, что Oracle сотрудничает с OpenAI, SoftBank Group и базирующейся в Абу-Даби MGX в проекте Stargate, в рамках которого, как ожидается, будет израсходовано в течение следующих пяти лет более $500 млрд на создание инфраструктуры ИИ ЦОД. Примечательно, что Сафра Кац оговорилась, что формально совместное предприятие Stargate всё ещё не создано. В частности, Softbank отложила инвестиции из-за новых пошлин США. Поэтому есть вероятность, что последние сделки Oracle в сфере ЦОД фактически также окажутся связаны со Stargate. В любом случае Stargate позволит частично оправдать рост капитальных расходов Oracle. Сам же Эллисон пообещал построить больше облачных ЦОД, чем все конкуренты вместе взятые.

13.06.2025 [23:52], Руслан Авдеев

И нашим, и вашим: Talen всё-таки поставит 1,92 ГВт энергии с АЭС дата-центрам AWS, но опосредованноAmazon внесла поправки в условия сделки с Talen Energy, предусматривавшей закупки энергии с АЭС Susquehanna для питания дата-центров AWS в Пенсильвании. Это случилось после того, как регулятор заблокировал предыдущую сделку, напоминает The Register. В среду компания объявила, что подписала с Amazon новом соглашение о покупке энергии (PPA) на 1,92 ГВт до 2042 года. В рамках сделки также будет изучена возможность строительства на площадке малых модульных реакторов (SMR) и финансирование модернизации Susquehanna для увеличения мощности АЭС. Критически важной деталью сделки является пункт о поддержке работы дата-центров AWS «в регионе». Дело в том, что Cumulus, дочерняя структура Talen, построила кампус ЦОД практически на территории АЭС, чтобы запитать его напрямую от станции. Amazon объявила о покупке кампуса Cumulus в марте 2024-го. В сделку включалось ISA (специальное соглашение), оговаривавшее поставки энергии из Susquehanna напрямую объекту Cumulus. Но попытка увеличить поставляемую кампусу мощность вызвала протесты местных коммунальных компаний. Они заявили регулятору Federal Energy Regulatory Commission (FERC), что ISA обеспечит Cumulus преимущество при поставках электричества, в результате чего другие клиенты Susquehanna могут столкнуться с менее стабильным энергоснабжением. В FERC согласились с доводами, и сделка была заблокирована. Talen неоднократно пыталась оспорить в суде решение FERC, но, похоже, в конце концов сдалась. Новое соглашение с AWS, по словам Talen, вообще не требует разрешения регулятора. Главная причина, вероятно, в том, что теперь Amazon будет получать 1,92 ГВт не напрямую и не только для кампуса Cumulus. Вместо этого энергия АЭС будет поступать в общую сеть, откуда её и будет получать AWS, причём фактически не только от Susquehanna. Для IT-гиганта это идеальное время для вложений. Губернатор Пенсильвании Джош Шапиро (Josh Shapiro) объявил в прошлый понедельник, что Amazon планировала вложить в создание облачных и ИИ-мощностей в штате не менее $20 млрд — как в округе Люцерн (Luzerne), где как раз и находится Susquehanna, так и в округе Бакс (Bucks), также обслуживаемым этой АЭС. В Talen заявили, что сделка с Amazon станет для неё стабильным источником доходов на долгое время. Похожие сделки с операторами АЭС заключили Meta✴ и Microsoft. Google пока, похоже, делает ставку на SMR.

13.06.2025 [02:20], Владимир Мироненко

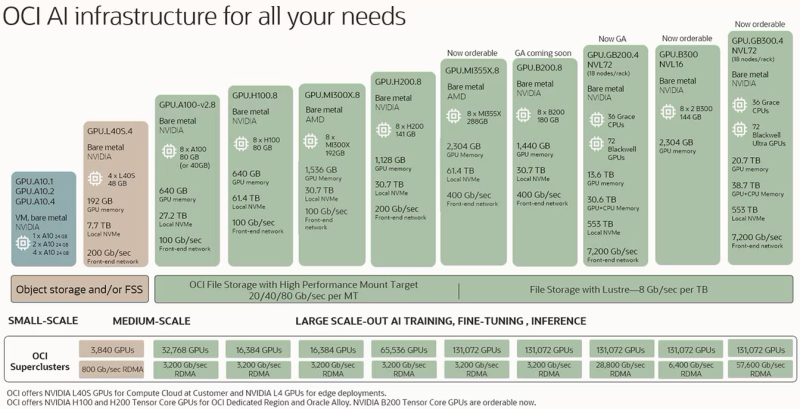

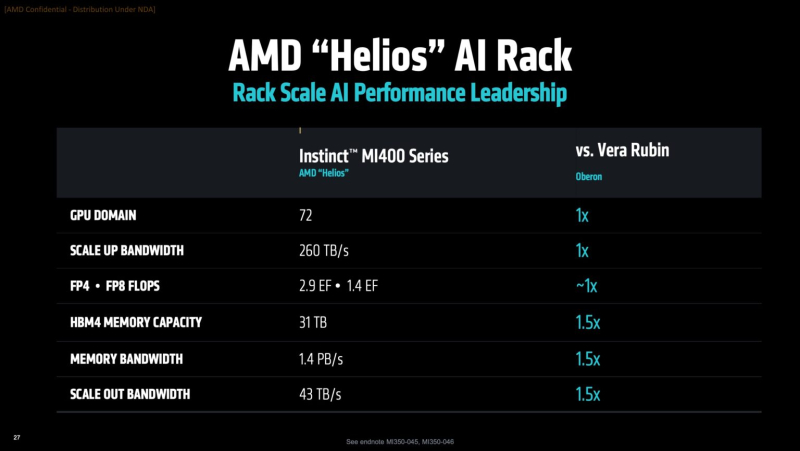

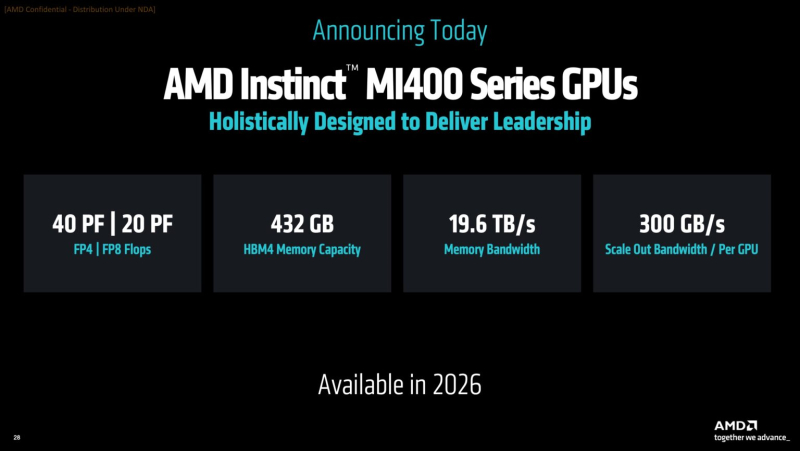

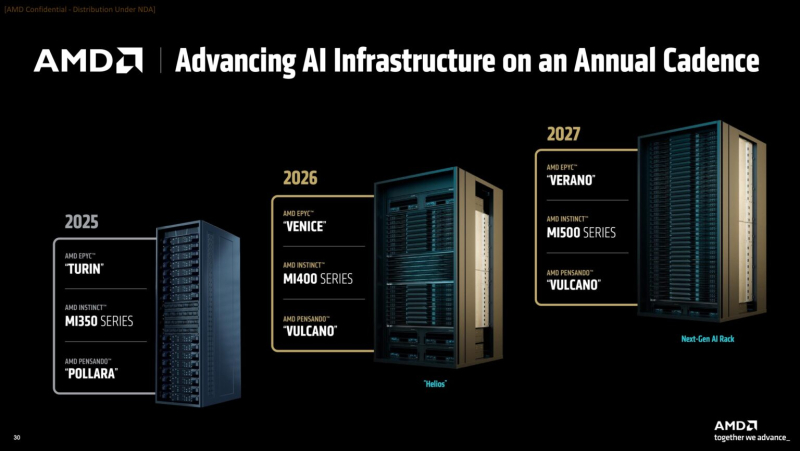

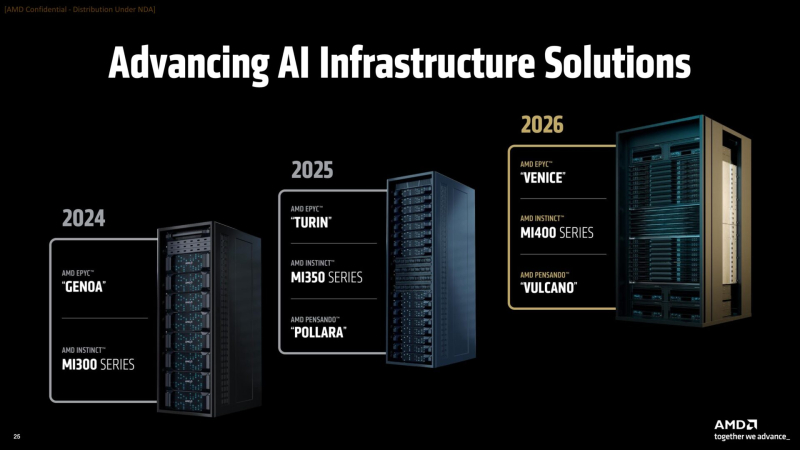

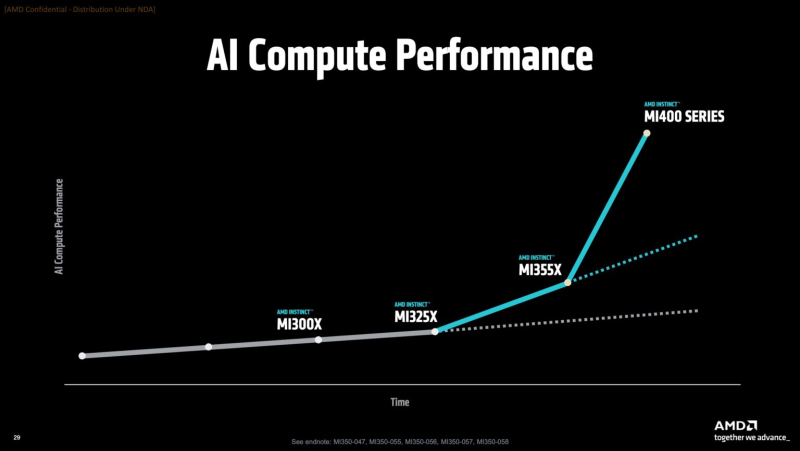

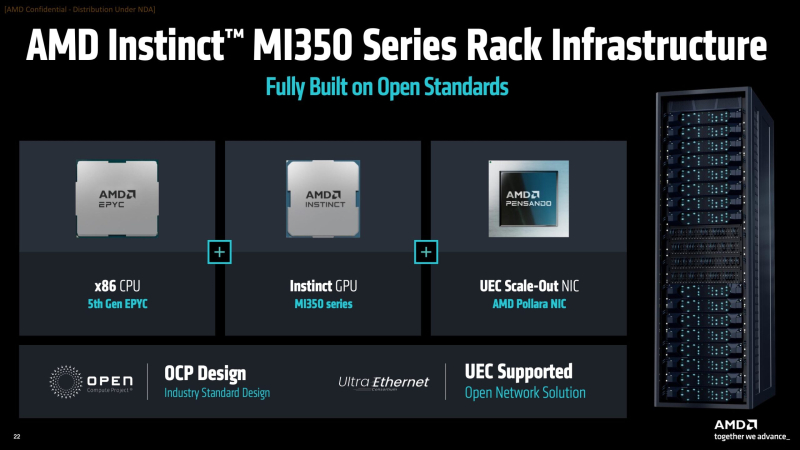

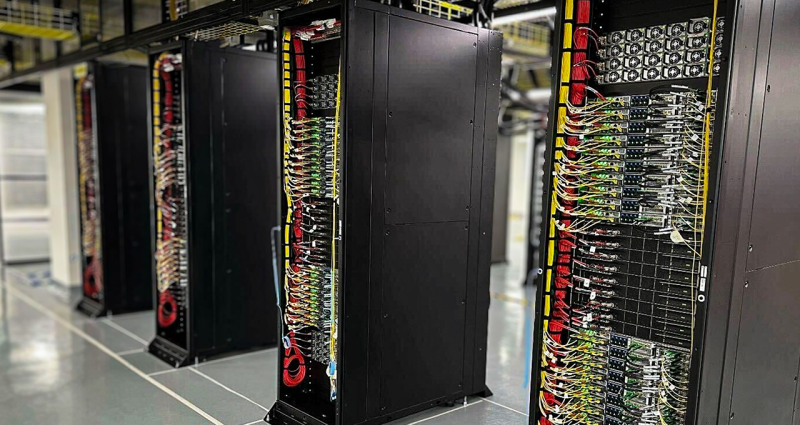

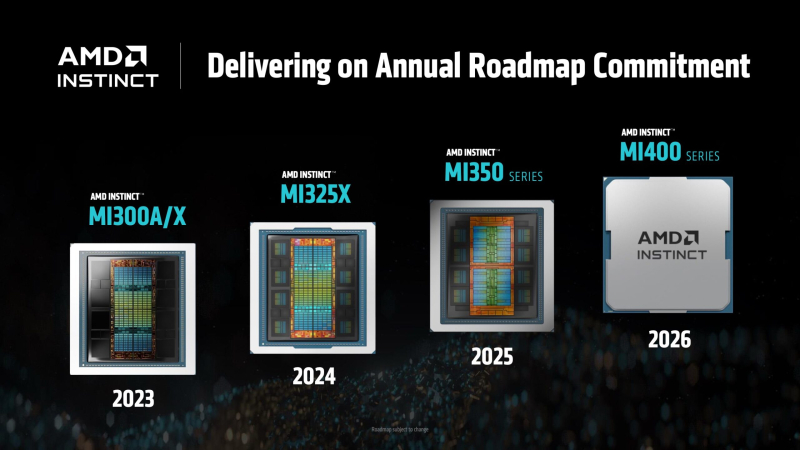

AMD готовит ИИ-стойки Helios AI двойной ширины с Instinct MI400, AMD EPYC Venice и 800GbE DPU Pensando VulcanoВместе с анонсом ускорителей MI350X и MI355X также рассказала о планах на ближайшее будущее, включая выпуск ускорителей серий MI400 (Altair) в 2026 году и MI500 (Altair+) в 2027 году, а также решений UALink, Ultra Ethernet, DPU Pensando и стоечных архитектур, которые послужат основой ИИ-кластеров. Так, AMD анонсировала новую архитектуру Helios AI с стойками двойной ширины, которая объединит процессоры AMD EPYC Venice с ядрами Zen 6, ускорители Instinct MI400 и DPU Vulcano. Благодаря приобретению ZT Systems компания смогла существенно ускорить разработку и интеграцию решений уровня стойки — Helios AI появятся уже в 2026 году. Как сообщает DataCenter Dynamics, Эндрю Дикманн (Andrew Dieckmann), корпоративный вице-президент и генеральный менеджер AMD по ЦОД рассказал перед мероприятием, что решение об увеличении ширины стойки было принято в сотрудничестве с «ключевыми партнёрами» AMD, поскольку предложение должно соответствовать «правильной точке проектирования между сложностью, надёжностью и предоставлением преимуществ производительности». По словам AMD, это позволит объединить тысячи чипов таким образом, чтобы их можно было использовать как единую систему «стоечного масштаба». «Впервые мы спроектировали каждую часть стойки как единую систему», — заявила генеральный директор AMD Лиза Су (Lisa Su) на мероприятии, пишет CNBC. Дикманн заявил, что Helios предложит на 50 % больше пропускной способности памяти и на 50 % больше горизонтальной пропускной способности (по сравнению с NVIDIA Vera Rubin), поэтому «компромисс [за счёт увеличения ширины стойки] был признан приемлемым, поскольку крупные ЦОД, как правило, ограничены не квадратными метрами, а мегаваттами». Как указано в блоге компании, «Helios создана для обеспечения вычислительной плотности, пропускной способности памяти, производительности и горизонтального масштабирования, необходимых для самых требовательных рабочих ИИ-нагрузок, в готовом к развёртыванию решении, которое ускоряет время выхода на рынок». Helios представляет собой сочетание технологий AMD следующего поколения, включая:

AMD отказалась сообщить стоимость анонсированных чипов, но, по словам Дикманна, ИИ-ускорители компании будут дешевле и в эксплуатации, и в приобретении в сравнении с чипами NVIDIA. «В целом, есть существенная разница в стоимости приобретения, которую мы затем накладываем на наше конкурентное преимущество в производительности, поэтому выходит значительная, исчисляемая двузначными процентами экономия», — сказал он. AMD ожидает, что общий рынок ИИ-чипов превысит к 2028 году $500 млрд. Компания не указала, на какую долю общего пирога она будет претендовать — по оценкам аналитиков, в настоящее время у NVIDIA более 90 % рынка. Обе компании взяли на себя обязательство выпускать новые ИИ-чипы ежегодно, а не раз в два года, что говорит о том, насколько жёстче стала конкуренция и насколько важны передовые ИИ-технологии для гиперскейлеров. AMD сообщила, что её чипы Instinct используются семью из десяти крупнейших игроков ИИ-рынка, включая OpenAI, Tesla, xAI и Cohere. По словам AMD, Oracle планирует предложить своим клиентам кластеры с более чем 131 тыс. ускорителей MI355X. Meta✴ сообщила, что уже использует AMD-кластеры для инференса Llama и что она планирует купить серверы с чипами AMD следующего поколения. В свою очередь, представитель Microsoft сказал, что компания использует чипы AMD для обслуживания ИИ-функций чат-бота Copilot.

13.06.2025 [00:15], Владимир Мироненко

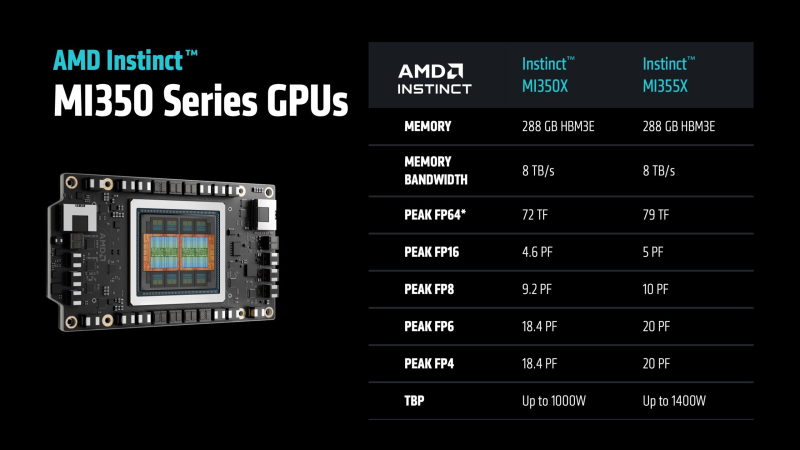

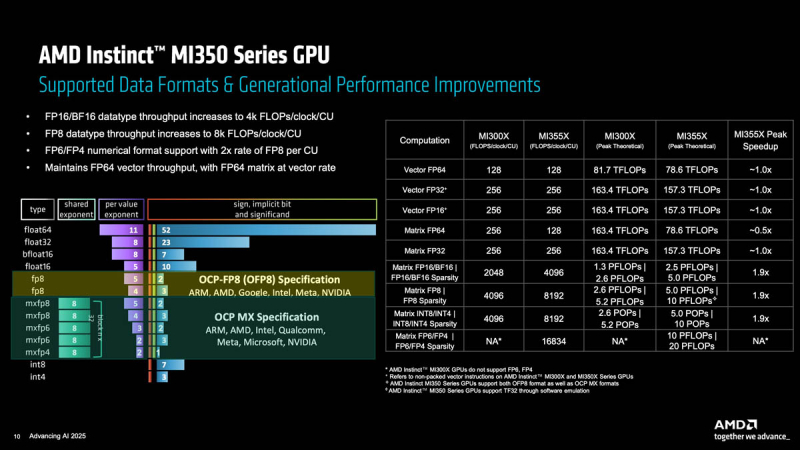

Ускорители AMD Instinct MI355X с архитектурой CDNA 4 потребляют 1400 ВтAMD представила ускоритель Instinct MI355X для ИИ- и HPC-нагрузок, демонстрирующий значительный рост производительности в задачах инференса, но вместе с тем почти удвоенное энергопотребление по сравнению с MI300X 2023 года выпуска, сообщил ресурс ComputerBase. Есть и чуть более простая версия MI350X, менее требовательная к питанию и охлаждению. AMD Instinct MI350X (Antares+) основан на оптимизированной архитектуре CDNA 4, отличающейся эффективной поддержкой новых форматов вычислений, в чём AMD ранее не была сильна. В дополнение к FP16 новый ускоритель поддерживает не только FP8, но также FP6 и FP4, которые актуальны для ИИ-нагрузок, особенно инференса. AMD во многом позиционирует Instinct MI350X как ускоритель для инференса, что имеет смысл, поскольку масштабирование MI350X по-прежнему ограничено лишь восемью ускорителями (UBB8), что снижает их конкурентоспособность по сравнению с ускорителями NVIDIA. Впрочем, для т.н. думающих моделей масштабирование тоже важно, что уже сказалось на продажах MI325X.

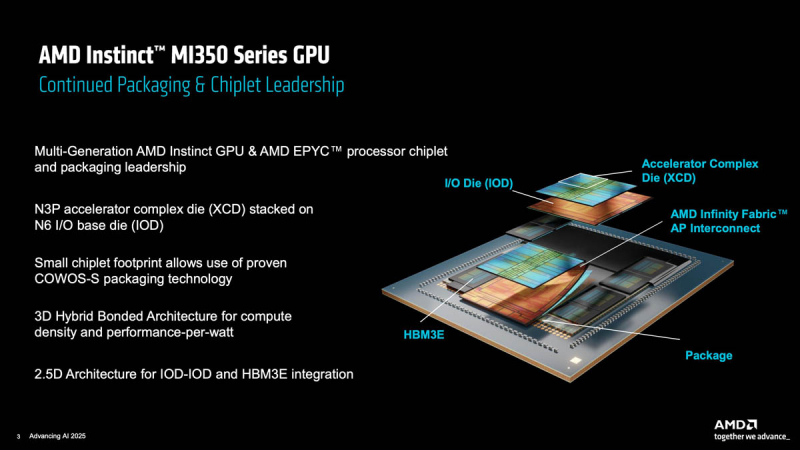

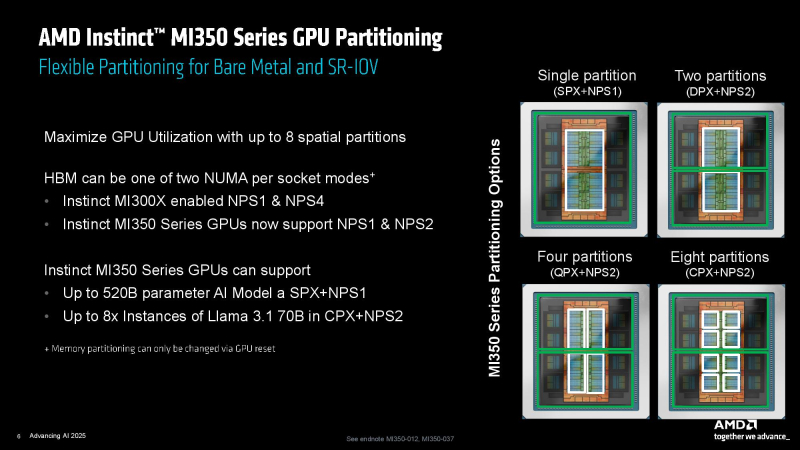

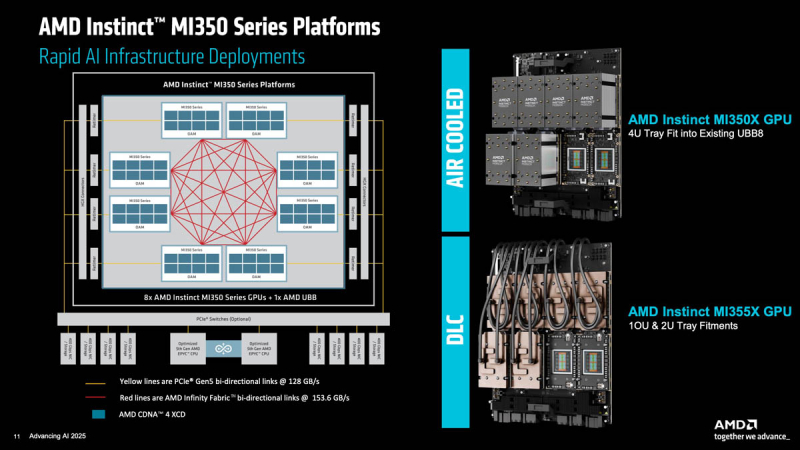

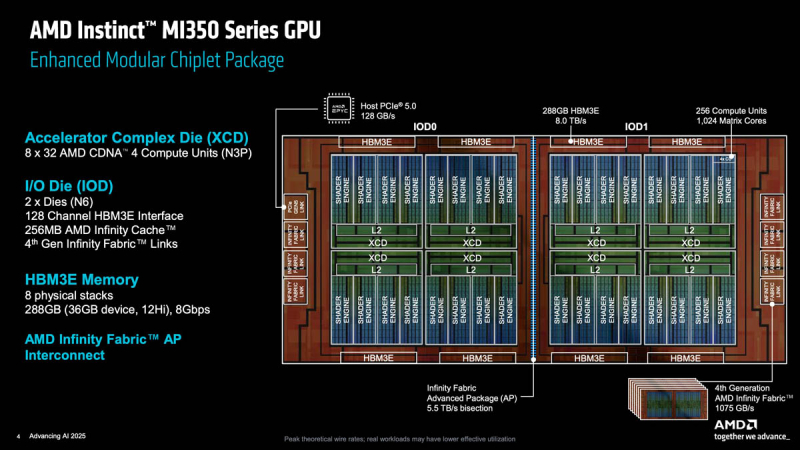

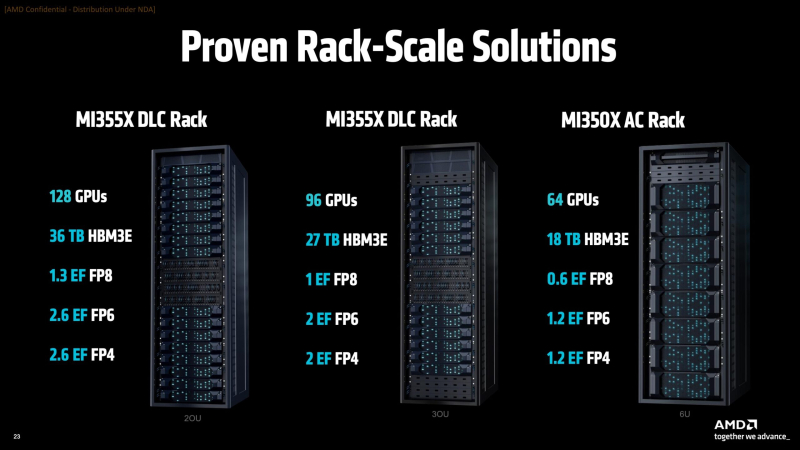

Источник изображений: AMD via ServeTheHome Серия ускорителей AMD Instinct MI350X включает две модели: стандартный ускоритель Instinct MI350X мощностью 1000 Вт, который всё ещё можно использовать с системами воздушного охлаждения, а также более производительный Instinct MI355X до 1400 Вт, рассчитанный исключительно на работу с СЖО. Впрочем, AMD считает, что некоторые из её клиентов смогут использовать воздушное охлаждение для MI355X, пишет Tom's Hardware. В случае СЖО в одну стойку можно упаковать до 16 узлов (128 ускорителей MI355X), а в случае воздушного охлаждения — до 8 узлов (64 ускорителя MI350X). Для вертикального масштабирования предполагается использование UALink, для горизонтального — Ultra Ethernet. Оба ускорителя будут поставляться с 288 Гбайт памяти HBM3E с пропускной способностью до 8 Тбайт/с. Сообщается, что ускоритель MI350X обладает максимальной производительностью в операциях FP4/FP6 в размере 18,45 Пфлопс, тогда как MI355X — до 20,1 Пфлопс. То есть обе модели серии Instinct MI350X превосходят ускоритель NVIDIA B300 (Blackwell Ultra), который с производительностью 15 FP4 Пфлопс. Что интересно, для векторных FP64-вычислений AMD сохранила тот же уровень производительности, что был у MI300X, а матричные FP64-вычисления стали почти вдвое медленнее. Тем не менее, это всё равно лучше, чем почти 30-кратное снижение скорости FP64-расчётов при переходе от B200 к B300. Если сравнивать производительность новых чипов с предшественником, то производительность MI350X в вычислениях с точностью FP8 составляет около 9,3 Пфлопс, в то время как у MI355X, как сообщается, этот показатель составляет 10,1 Пфлопс, что значительно выше, чем 5,22 Пфлопс у Instinct MI325X (во всех случаях речь идёт о разреженных вычислениях). MI355X также превосходит NVIDIA B300 на 0,1 Пфлопс в вычислениях FP8. Формально разница между MI350X и MI355X не так велика, но на практике она может достигать почти 20 % из-за возможности более долго поддерживать частоты при наличии СЖО. В целом, по словам AMD, в ИИ-тестах MI350X/MI355X быстрее MI300X в 2,6–4,2 раза в зависимости от задачи и до 1,3 раз быстрее (G)B200, но при этом значительно дешевле последних. Компоновка MI350X/MI355X напоминает компоновку MI300X. Есть восемь 3-нм (TSMC N3P) XCD-чиплетов, лежащих поверх двух 6-нм (N6) IO-тайлов (IOD) и обрамлённых восемью стеками HBM3E. Переход к двум IOD повлиял и на NUMA-домены, поскольку теперь память можно поделить только пополам. А вот вычислительных инстансов может быть до восьми. Используется комбинированная 3D- и 2.5D-компоновка чиплетов, причём для связи IOD, т.е. двух половинок всего чипа, используется шина Infinity Fabric AP с пропускной способностью 5,5 Тбайт/с. Каждый XCD содержит 36 CU, из которых активно только 32 (для повышения процента годных чипов), и общий L2-кеш объёмом 4 Мбайт. Все XCD подключены к Infinity Cache объёмом 256 Мбайт. Для связи с внешним миром есть один интерфейс PCIe 5.0 x16 (128 Гбайт/с) и семь линий Infinity Fabric (1075 Гбайт/с), которые как раз и позволяют объединить восемь ускорителей по схеме каждый-с-каждым. Технический директор AMD Марк Пейпермастер (Mark Papermaster) заявил, что отрасль продолжит разрабатывать всё более мощные процессоры и ускорители для суперкомпьютеров, чтобы достичь производительности зеттафлопсного уровня примерно через десятилетие. Однако этот рост будет достигаться ценой резкого увеличения энергопотребления, поэтому суперкомпьютер с производительностью такого уровня будет потреблять примерно 500 МВт — половину того, что вырабатывает средний реактор АЭС. Для поддержания роста производительности пропускная способность памяти и масштабирование мощности тоже должны расти. Согласно расчётам AMD, пропускная способность памяти ускорителя должна более чем удваиваться каждые два года, чтобы сохранить соотношение ПСП к Флопс. Это потребует увеличения количества стеков HBM на один ускоритель, что приведёт к появлению более крупных и более энергоёмких ускорителей и модулей. Instinct MI300X имел пиковую мощность 750 Вт, Instinct MI355X имеет пиковую мощность 1400 Вт, в 2026–2027 гг., по словам Пейпермастера, нас ждут ускорители мощностью 1600 Вт, а в конце десятилетия — уже 2000 Вт. У чипов NVIDIA энергопотребление ещё выше — ожидается, что у ускорителей Rubin Ultra с четырьмя вычислительными чиплетами энергопотребление составит до 3600 Вт. На фоне растущего энергопотребления суперкомпьютеры и ускорители также быстро набирают производительность. Согласно презентации AMD на ISC 2025, эффективность производительности увеличилась с примерно 3,2 ГФлопс/Вт в 2010 году до примерно 52 Гфлопс/Вт к моменту появления экзафлопсных систем, таких как Frontier. Поддержание такого темпа роста производительности потребует удвоения энергоэффективности каждые 2,2 года, пишет Tom's Hardware. Прогнозируемая система зетта-класса потребует эффективность на уровне 2140 Гфлопс/Вт, т.е. в 41 раз выше, чем сейчас. AMD считает, что для значительного повышения производительности суперкомпьютеров через десятилетие потребуется не только ряд прорывов в архитектуре чипов, но и прорыв в области памяти и интерконнектов.

12.06.2025 [09:59], Владимир Мироненко

Безопасность операционных систем в контексте искусственного интеллекта обсудят на конференции OS DAY 2025

software

ии

информационная безопасность

исп ран

мероприятие

операционная система

россия

сделано в россии

XII научно-практическая конференция OS DAY «Изолированные среды исполнения в современных ОС» состоится в Москве 19–20 июня 2025 года. Центральной темой для обсуждения на ней станут современные методы построения изолированных сред исполнения в операционных системах. В конференции примут участие специалисты в области системного программирования, создатели российских операционных платформ, их коллеги-разработчики, заказчики российского ПО и представители регулирующих органов. Они будут обсуждать методики разграничения полномочий, технологии защиты от компьютерных атак, способы оптимизации вычислительных ресурсов, различные аспекты изоляции и другие актуальные вопросы системного программирования. В ходе OS DAY 2025 состоится круглый стол «Безопасность операционных систем в контексте искусственного интеллекта». Его участники обсудят, какие вызовы возникают сегодня в связи с широким применением технологий ИИ в программировании, какие можно обозначить проблемы, ожидающие российскую ИТ-отрасль, и каковы могут быть пути их разрешения. Будут затронуты темы операционных систем как платформ для развития ИИ, использования искусственного интеллекта в разработке ОС, другие актуальные задачи системного программирования, связанные с широким проникновением ИИ в сферу разработки ПО. Участники круглого стола

Параллельно с основной программой OS DAY 2025 пройдет выставка технологий, где российские производители операционных систем представят новейшие решения в области системного ПО. Конференцию организует консорциум OS DAY: ИСП РАН, «Лаборатория Касперского», НТП «Криптософт», «Открытая мобильная платформа», «Базальт СПО», «Ред Софт», «НТЦ ИТ РОСА» и НИЦ «Институт имени Н.Е. Жуковского». Конференция проводится при поддержке: РАН, ФСТЭК России, ВИНИТИ РАН, РЭУ им. Г.В. Плеханова, АРПП «Отечественный софт», НП «РУССОФТ». Время и место проведения: 19–20 июня 2025 года, РЭУ им. Г.В. Плеханова. Адрес: Москва, ул. Большая Серпуховская, д. 11, корпус 9, этаж 8, «Точка-кипения РЭУ». Для участия просьба зарегистрироваться на сайте https://osday.ru. Регистрация на очное участие заканчивается 14 июня. Зарегистрированным участникам, выбравшим формат онлайн, будет предоставлен доступ на адрес электронной почты, указанный при регистрации. По дополнительным вопросам просьба обращаться: Анна Новомлинская, исполнительный директор OS DAY, an@ispras.ru. Научно-практическая конференция OS DAY проводится в России ежегодно с 2014 г. Это место консолидации российских разработчиков операционных платформ и поиска перспектив для совместной деятельности. Задачи конференции – определить перспективные направления и технологии в сфере разработки операционных систем, обозначить главные вызовы современной ИТ-отрасли и помочь разработчикам, производителям и заказчикам обменяться опытом. Организует конференцию консорциум OS DAY, в который входят: ИСП РАН, АО «Лаборатория Касперского», НТП «Криптософт», «Открытая мобильная платформа», «Базальт СПО», «РЕД СОФТ», НТЦ ИТ РОСА и НИЦ «Институт имени Н.Е. Жуковского». Целью создания сообщества организаторов было определить задачи и возможности России в области разработки операционных платформ, выделить перспективные технологии, обменяться опытом, обозначить вызовы ИТ-отрасли и направления движения.

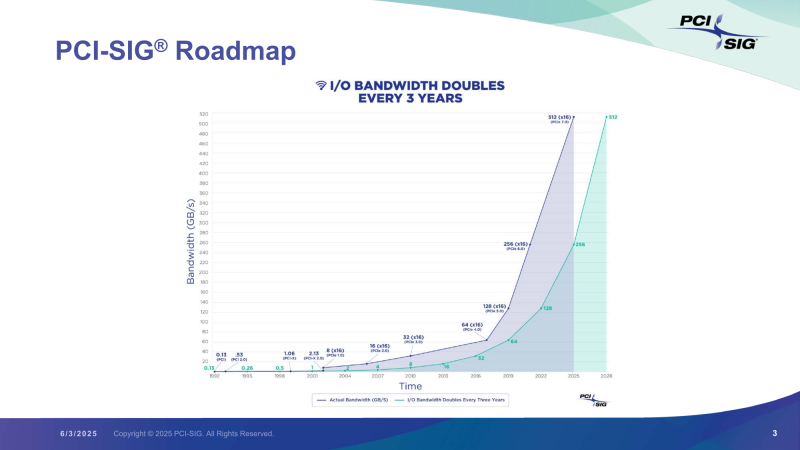

11.06.2025 [23:59], Игорь Осколков

Представлена финальная спецификация PCI Express 7.0Консорциум PCI-SIG официально объявил о релизе спецификаций PCI Express 7.0 версии 1.0. Базовые характеристики интерфейса изменений не претерпели: «сырая» скорость 128 ГТ/с на линию, которая конвертируется в 512 Гбайт/с в двустороннем режиме в конфигурации x16; кодирование PAM4; поддержка Flit-режима; универсальность и обратная совместимость с предыдущими версиями PCIe; повышенная энергоэффективность; расширенная коррекция ошибок и т.д. Новый стандарт ориентирован на решения с интенсивным обменом данными, которым требуются низкая задержка, высокая скорость и повышенная надёжность: ИИ-платформы, 800G-сети, облака гиперскейлеров, квантовые системы и т.п. Впрочем, как и стандарты прошлого поколения, PCIe 7.0 сохранит гибкость, предоставляя 11 различных профилей, которые охватывают весь спектр возможных применений интерфейса, от мобильных платформ до HPC-систем. Консорциум придерживается выбранного темпа выпуска спецификаций — каждые три года появляется новый стандарт, который, по мнению PCI-SIG, всегда чуть опережает текущие потребности индустрии. Здесь есть два важных момента. Во-первых, PCI-SIG не пытается добиться максимально возможной скорости (за NVLink уже не угнаться), а старается дать максимум скорости по приемлемой цене. Во-вторых, уже сейчас разработчики IP говорят о возможных проблемах насыщения данными даже одной линии PCIe 7.0 в некоторых приложениях и сложностях физической и логической реализации нового интерфейса. Впрочем, до появления первых реальных продуктов с поддержкой PCIe 7.0 ещё долго. На 2027 год запланирован старт предварительного «тестирования на соответствие» (FYI, First Year Inventory Compliance Program), так что внедрение нового стандарта начнётся не раньше 2028 года. Внедрение PCIe 6.0, представленного ещё в январе 2022 года, тоже только-только начинается и займёт ещё год-два. Анонсированная почти два года назад оптическая версия PCIe продолжает разрабатываться. В PCIe 7.0 и PCIe 6.4 впервые были добавлены спецификации ретаймеров, которые позволят передавать сигнал PCIe по оптоволокну. Это позволит сделать интерконнект на базе PCIe значительно компактнее, чем при использовании традиционных медных соединений, а также позволит эффективно вывести PCIe за пределы узла. Впрочем, пока что речь идёт скорее о масштабах стойки или нескольких, а не целого ЦОД.

11.06.2025 [18:02], Андрей Крупин

Структура «Ростеха» приобрела 30-% долю в уставном капитале «Ред Софт»Входящая в государственную корпорацию «Ростех» компания «РТ-Ред» приобрела 30 % в уставном капитале разработчика программных продуктов «Ред Софт» в рамках соглашения о сотрудничестве, направленном на укрепление технологического суверенитета в IT-сфере и продвижение отечественного ПО на внутреннем и внешнем рынках. Сумма сделки не называется. «Ред Софт» ведёт деятельность с 2014 года и занимается разработкой решений для корпоративного сегмента. В числе ключевых продуктов компании: операционная система «Ред ОС», система управления базами данных «Ред база данных», система управления виртуализацией серверов и рабочих станций «Ред виртуализация», система централизованного управления IT-инфраструктурой «Ред Адм», платформа для быстрой разработки информационных систем различных классов «Ред Платформа» и прочие решения. В числе заказчиков разработчика — госкорпорации, органы государственной власти, коммерческие предприятия из различных отраслей экономики.

Источник изображения: пресс-служба госкорпорации «Ростех» / rostec.ru Сообщается, что основным направлением сотрудничества компаний станет совместное развитие экосистемы инфраструктурных и прикладных решений «Ред Софт», создание комплексной линейки импортозамещающих решений в области корпоративного программного обеспечения и программно-аппаратных комплексов, повышающих эффективность бизнес-процессов. «Партнёрство с «Ростехом» позволит «Ред Софт» ускорить темпы развития продуктового портфеля, реализовать новые масштабные проекты вместе с технологическими партнёрами, а также предложить российскому и международному рынку больше эффективных решений, в том числе превосходящих зарубежные аналоги. Новый уровень сотрудничества будет способствовать дальнейшему достижению целей импортозамещения в сфере IT, формированию условий для повышения темпов экономического роста и достижения Россией лидирующих позиций в области высоких технологий», — отметил генеральный директор «Ред Софт» Максим Анисимов.

11.06.2025 [16:12], Руслан Авдеев

OpenAI неожиданно заключила соглашение с Google CloudOpenAI планирует использовать вычислительные мощности Google Cloud. Несмотря на то, что OpenAI в сфере ИИ является прямым конкурентом Google, она намерена использовать эту облачную платформу, чтобы удовлетворить свои потребности в вычислительных ресурсах и диверсифицировать ресурсы, сообщает Reuters. Издание ссылается на информацию трёх источников, отмечая, что соглашение является неожиданным, поскольку подразделение DeepMind компании Google напрямую соперничает с OpenAI в сфере искусственного интеллекта, а ChatGPT с его новыми функциями представляет угрозу поисковым сервисам Google. Последняя, тем не менее предоставит, OpenAI дополнительные вычислительные мощности, чтобы помочь компании обучать и эксплуатировать свои ИИ-модели. Пока нет данных, станет ли OpenAI использовать фирменные TPU Google или будет применять в облаке только ускорители NVIDIA. В OpenAI и Microsoft не комментируют новость. Ранее Microsoft выступала эксклюзивным поставщиком облачных услуг ИИ-стартапу благодаря ранним инвестициям в компанию, но спрос на вычислительные мощности у OpenAI продолжал расти, опережая возможности Microsoft. Поэтому последняя отказалась от эксклюзивного сотрудничества с некоторыми условиями.

Источник изображения: Growtika/unsplash.com OpenAI объявила о проекте Stargate стоимостью $500 млрд в начале текущего года — компания действует в партнёрстве с SoftBank, Oracle и MGX из ОАЭ. Первый кампус строится в Абилине (Abilene, Техас). Предполагается, что Oracle купит для него около 400 тыс. ускорителей NVIDIA GB200. Изучается возможность и строительства кампусов Stargate в других местах, в том числе в ОАЭ. В мае 2025 года OpenAI уже подписала облачное соглашение с CoreWeave на сумму $4 млрд, это стало развитием более ранней сделки с компанией на сумму $11,9 млрд. На этой неделе компания TD Cowen выступила с предположением, что Oracle ищет в США 5 ГВт ЦОД-мощностей для OpenAI, и это помимо общего проекта Stargate. По данным источников Reuters, ранее OpenAI пыталась заключить сделку с Google Cloud, но ей помешали обязательства перед Microsoft. |

|