Лента новостей

|

30.09.2021 [16:15], Сергей Карасёв

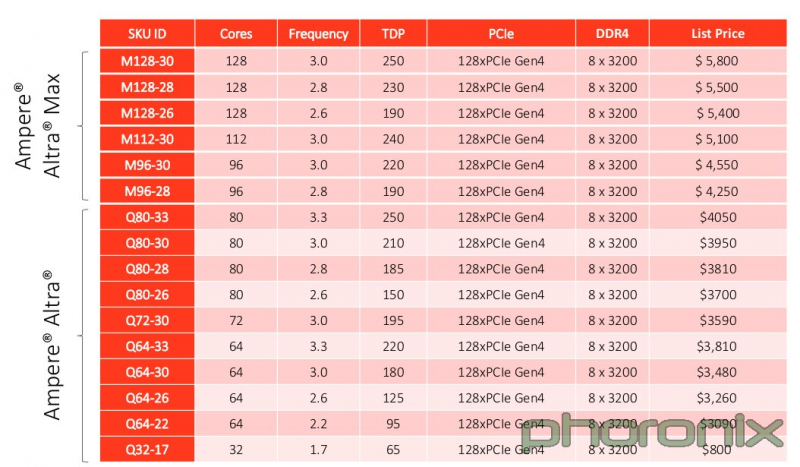

128-ядерный Arm-процессор Ampere Altra Max оказался на треть дешевле флагманских Xeon и EPYCРесурс Phoronix раскрыл стоимость многоядерных процессоров Ampere Altra Max, предназначенных для использования в высокопроизводительных серверах. Наблюдатели отмечают, что эти изделия, насчитывающие до 128 вычислительных ядер, предлагаются по цене ниже флагманских серверных чипов Intel Xeon и AMD EPYC. Arm-процессоры Ampere Altra Max M128-30 с частотой 3,0 ГГц изготавливаются по 7-нм технологии и предлагают 128 линий PCIe 4.0 и восемь каналов оперативной памяти DDR4-3200. Тесты Phoronix показывают, что в целом ряде задач чипы Ampere Altra Max M128-30 могут вполне конкурировать со старшими моделями Intel Xeon Ice Lake и AMD EPYC Milan. Итак, сообщается, что цена Ampere Altra Max M128-30 составляет $5800. Для сравнения: чип Intel Xeon Platinum 8380 сейчас предлагается за $8099, тогда как AMD EPYC 7763 стоит $8600. Процессор Ampere Altra Q80-30 с 80 вычислительными ядрами можно приобрести по цене $3950, а самая младшая 32-ядерная модель Ampere Altra Q32-17 стоит всего $800. Правда, надо учитывать, что всё это рекомендованные цены, а у AMD с Intel намного больше возможностей по их снижению для конечных заказчиков.

25.09.2021 [17:29], Руслан Авдеев

На Аляске появился быстрый беспроводной интернет на базе Facebook✴ TerragraphСложный рельеф и суровый климат Аляски создают серьёзные трудности при обеспечении пользователей стабильным быстрым интернетом-соединением. С распространением пандемии и переходом многих жителей на удалённую работу потребность в устойчивых соединениях только выросла. На помощь местным жителям пришёл провайдер Alaska Communications с беспроводной технологией Terragraph, разработанной Facebook✴ Connectivity. Провайдер использует оборудование компании Cambium Networks, получившего лицензию от Facebook✴ на использование Terragraph в своих решениях. Технология использует спектр 60 ГГц и позволяет наладить быструю связь значительно дешевле, чем обходится прокладка под землёй кабельных соединений. Многие интернет-провайдеры штата уже убедились, что в местных суровых условиях прокладывать кабели конечным потребителям не только дорого, но и долго. Если же возникает обрыв, установить его местонахождение и устранить поломку очень сложно, особенно зимой. Cambium Networks предоставляет беспроводные решения на основе Terragraph — от Пинанга в Малайзии до Пуэрто-Рико.

tech.fb.com Facebook✴ Connectivity разработала Terragraph, намереваясь расширить доступность стабильного беспроводного интернет-соединения в регионах с плохим или отсутствующим соединением. Лицензии на технологию выдаются партнёрам по всему миру — производители оборудования и провайдеры могут сосредоточить усилия на её внедрении вместо проведения собственных разработок. Первая фаза развёртывания на Аляске планируется с использованием клиентских узлов cnWave 60 ГГц производства Cambium Networks, обеспечивающих скорость передачи данных до 1 Гбит/с для 6500 локаций. «Доступный, надёжный высокоскоростной интернет сегодня отсутствует на рынке Аляски. Поэтому мы здесь — для того, чтобы обеспечить местным жителям связь с тем, что наиболее важно для них», — говорит вице-президент по маркетингу Alaska Communications Бет Барнс (Beth Barnes). Вместо использования кабельных соединений, Terragraph полагается на ячеистую mesh-топологию, в которой клиентские беспроводные узлы размером с книгу размещаются на уже существующих объектах вроде крыш или телефонных столбов. Отдельные узлы не только обеспечивают интернетом конкретные дома, но и передают сигнал другим аналогичным узлам, находящимся в зоне досягаемости. Структура mesh-сетей предусматривает многочисленные альтернативные пути соединения между узлами, поэтому связь в сети остаётся стабильной почти в любых условиях. Для сравнения, обрыв связи на «последней миле» кабельного соединения требует обязательного ремонта, иначе доступ к Интернету прервётся.

tech.fb.com Местные жители уже начали пользоваться преимуществами Terragraph. Даже тем, кому по роду деятельности приходится пересылать очень большие файлы, теперь доступны по-настоящему быстрые соединения. По данным некоторых пользователей, скорость соединения выросла почти в 100 раз в сравнении с проводными решениями, применявшимися прежде: на отправку файла чуть более 10 Гбайт уходит около 10 минут. Из-за низкой плотности населения на Аляске связь имеет ещё большее значение, чем в густонаселённых регионах. Например, Аляска в 2,5 раза больше Техаса или в 77 раз больше Нью-Джерси, при этом здесь приходится приблизительно по одному человеку на 2,5 км2. Если трудно предоставить высокоскоростное интернет-соединение даже населению городов вроде Анкориджа, то ещё труднее обеспечить связь за пределами городов. При этом в период пандемии критически важно оставаться на связи. До конца текущего года Terragraph намерены использовать в 6500 локациях по всему штату, а скоро в Alaska Communications планируется обеспечить и более широкое распространение технологии. В следующие несколько лет сервис появится в новых районах вблизи Анкориджа, а также Фэрбенксе, Джуно, на Кенайском полуострове.

22.09.2021 [21:16], Алексей Степин

Выпущена тестовая партия европейских высокопроизводительных RISC-V процессоров EPI EPAC1.0Наличие собственных высокопроизводительных процессоров и сопровождающей их технической инфраструктуры — в современном мире вопрос стратегического значения для любой силы, претендующей на первые роли. Консорциум European Processor Initiative (EPI), в течение долгого времени работавший над созданием мощных процессоров для нужд Евросоюза, наконец-то, получил первые весомые плоды. О проекте EPI мы неоднократно рассказывали читателям в 2019 и 2020 годах. В частности, в 2020 году к консорциуму по разработке мощных европейских процессоров для систем экза-класса присоединилась SiPearl. Но сегодня достигнута первая серьёзная веха: EPI, насчитывающий на данный момент 28 членов из 10 европейских стран, наконец-то получил первую партию тестовых образцов процессоров EPAC1.0.

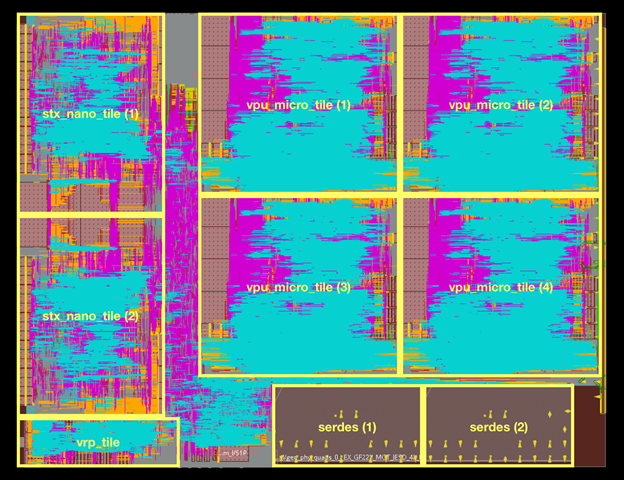

Источник изображений: European Processor Initiative (EPI) По предварительным данным, первичные тесты новых чипов прошли успешно. Процессоры EPAC имеют гибридную архитектуру: в качестве базовых вычислительных ядер общего назначения в них используются ядра Avispado с архитектурой RISC-V, разработанные компанией SemiDynamics. Они объединены в микро-тайлы по четыре ядра и дополнены блоком векторных вычислений (VPU), созданным совместно Барселонским Суперкомпьютерным Центром (Испания) и Университетом Загреба (Хорватия).

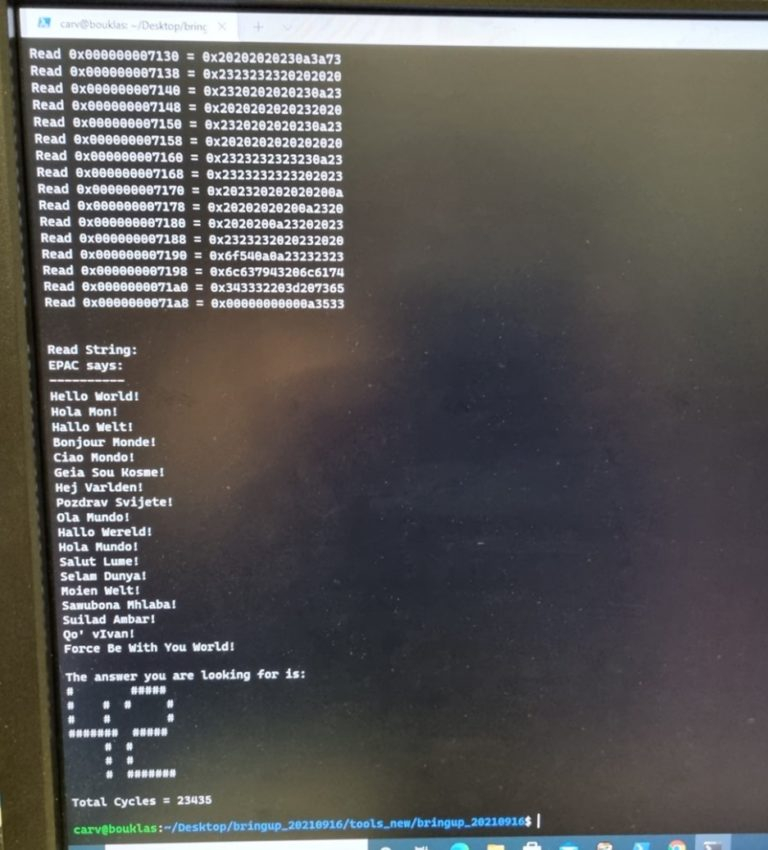

Строение кристалла EPAC1.0 Каждый такой тайл содержит блоки Home Node (интерконнект) с кешем L2, обеспечивающие когерентную работу подсистем памяти. Имеется в составе EPAC1.0 и описанный нами ранее тензорно-стенсильный ускоритель STX, к созданию которого приложил руку небезызвестный Институт Фраунгофера (Fraunhofer IIS). Дополняет картину блок вычислений с изменяемой точностью (VRP), за его создание отвечала французская лаборатория CEA-LIST. Все ускорители в составе нового процессора связаны высокоскоростной сетью, использующей SerDes-блоки от EXTOLL.  Первые 143 экземпляра EPAC произведены на мощностях GlobalFoundries с использованием 22-нм техпроцесса FDX22 и имеют площадь ядра 27 мм2. Используется упаковка FCBGA 22x22. Тактовая частота невысока, она составляет всего 1 ГГц. Отчасти это следствие использования не самого тонкого техпроцесса, а отчасти обусловлено тестовым статусом первых процессоров. Но новорожденный CPU жизнеспособен: он успешно запустил первые написанные для него программы, в числе прочего, ответив традиционным «42» на главный вопрос жизни и вселенной. Ожидается, что следующее поколение EPAC будет производиться с использованием 12-нм техпроцесса и получит чиплетную компоновку.

09.09.2021 [14:49], Владимир Мироненко

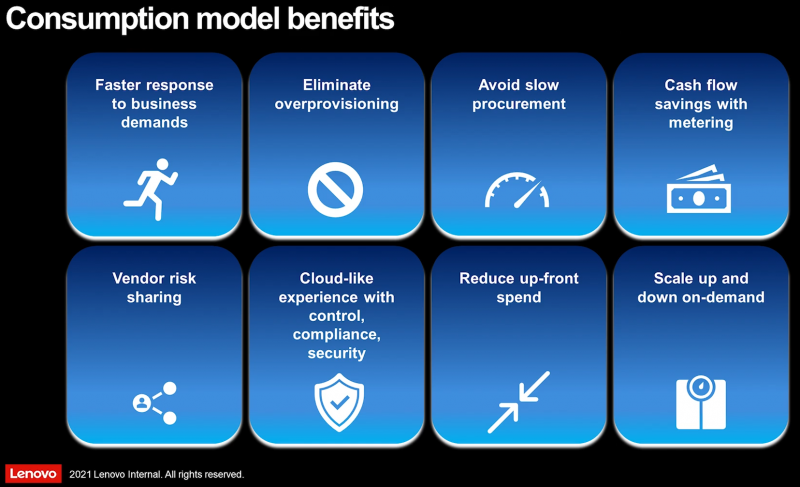

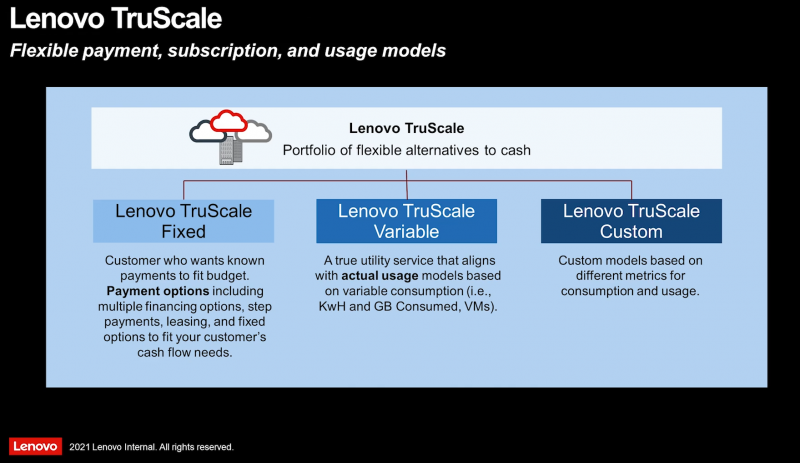

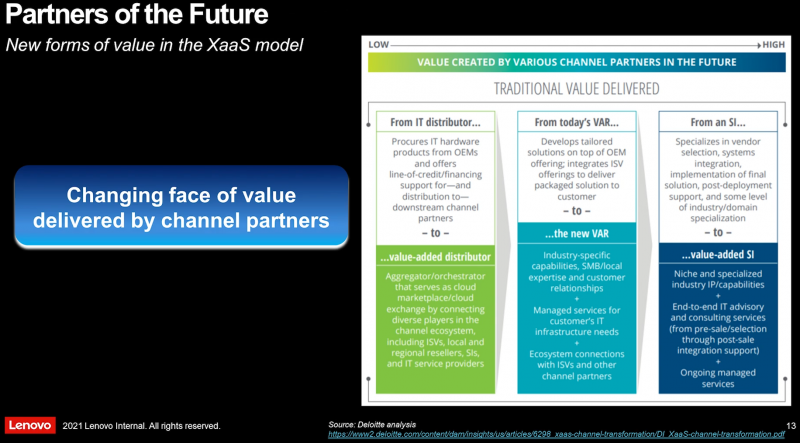

Lenovo представила TruScale, обновлённое портфолио решений всё-как-сервисКомпания Lenovo представила на ежегодном мероприятии Tech World решение «всё-как-услуга» (XaaS) — сервис Lenovo TruScale. С его помощью Lenovo объединила все свои предложения «как-услуга» в единое целое. Сервис выходит далеко за рамки исключительно инфраструктурных решений, позволяя создать комплексное — от мобильных устройств до облака — и индивидуализированное предложение для конкретного заказчика в рамках единой подписки. «Lenovo TruScale воплощает в себе трансформацию компании в новой реальности — удовлетворение растущего глобального спроса на более продвинутые технологии в условиях новой эры гибридного режима работы и обучения», — отмечено в пресс-релизе компании. Lenovo TruScale представляет собой гибкую платформу «всё как услуга», позволяющую компаниям сохранять конкурентоспособность и предлагающую изменяемую облачную модель с возможностью выбора подходящих условий оплаты обслуживания, оборудования и необходимого перечня услуг. Согласно исследованиям Gartner, IDC и Lenovo Market Intelligence, скорость роста рынка предложений по модели «как-услуга» вчетверо выше по сравнению с общим рынком ИТ-услуг. Аналитики прогнозируют, что через три года на такую модель придётся 12% расходов на корпоративные x86-серверы и более половины затрат на новые корпоративные СХД. В целом, если верить отчётам компаний, программы вроде Dell APEX, HPE Greenlake или Cisco Plus действительно являются достаточно привлекательными для клиентов. Поскольку Lenovo в рамках TruScale отходит от исключительно инфраструктурных решений, компания отдельно подчеркнула наличие нового предложения устройство-как-услуга (DaaS), которое охватывает оборудование для конечных пользователей вместе с lifecycle-услугами, поддержкой и подходящим финансированием для снижения общей стоимости. В рамках новой платформы компания сотрудничает с ведущими партнёрами по инфраструктуре: Deloitte, VMWare и Intel, а также партнёрами по безопасности DaaS Absolute Software и SentinelOne. На мероприятии Lenovo Tech World 21 компания более подробно рассказала о ряде новых (и обновлённых) продуктов в составе TruScale: «кремний-по-запросу» от Intel (динамическое изменения числа доступных ядер CPU), STaaS-решения Infinite Storage, VDI для мобильных и десктопных клиентов на базе продуктов Nutanix и т.д. В развитии TruScale Lenovo, как и прежде, будет во многом полагаться на канальных партнёров.

08.09.2021 [19:31], Алексей Степин

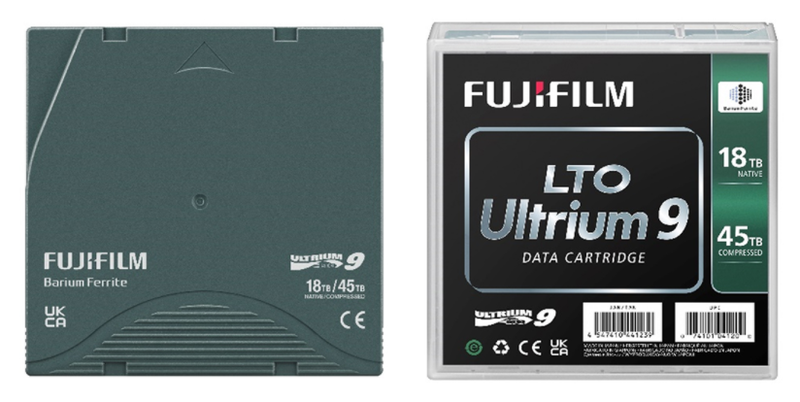

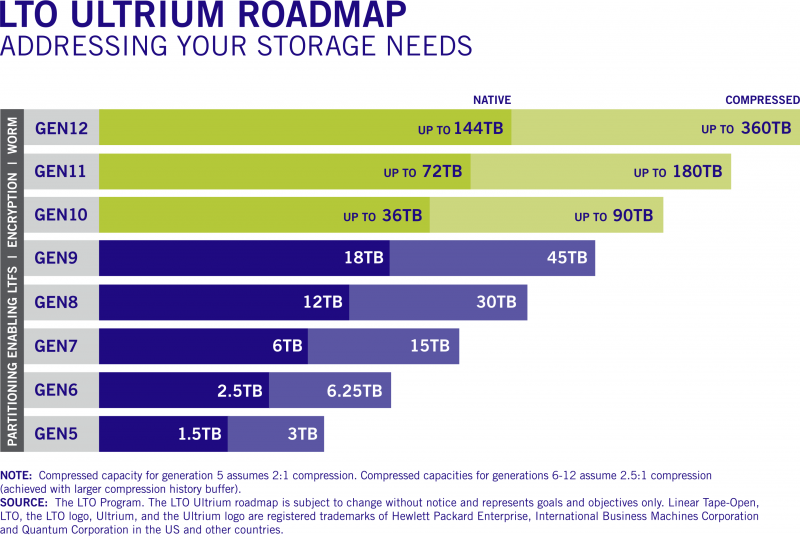

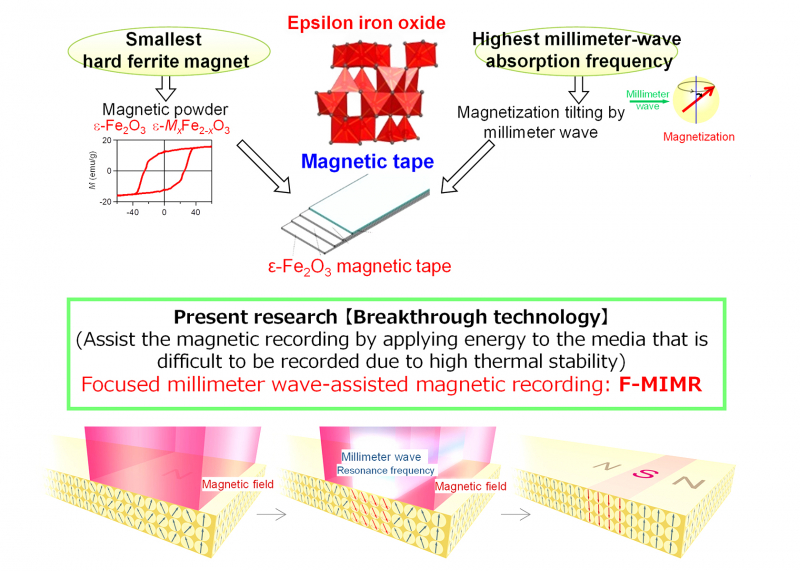

Fujifilm и HPE представили ленточные картриджи LTO-9 ёмкостью 45 ТбайтЛенточные накопители и библиотеки остаются одним из самых популярных вариантов для «холодного» хранения больших объёмов данных, и новые технологии в этой сфере продолжают активно развиваться. Компании Fujifilm и HPE объявили о выпуске ленточных картриджей LTO-9 Ultrium, эффективная ёмкость которых достигает 45 Тбайт. Правда, эта цифра относится к режиму со сжатием данных, «чистая» же ёмкость LTO-9 составляет 18 Тбайт. Для сравнения, картриджи LTO-8 могут хранить до 12 и 30 Тбайт несжатых и сжатых данных соответственно, Хотя налицо паритет с традиционными HDD, темпы прироста ёмкости LTO замедлились: так, при переходе от седьмого поколения к восьмому «чистый» объём вырос вдвое (с 6 до 12 Тбайт), а сейчас мы видим лишь 50% прирост. Тем не менее, в будущем планируется вернуться к удвоению ёмкости в каждом новом поколении. Скорость передачи данных LTO-9 в сравнении c LTO-8 выросла, но ненамного: с 360/750 Мбайт/с до 440/1000 Мбайт/с в режимах без сжатия и со сжатием соответственно.  В новых картриджах Fujifilm используется лента на основе феррита бария (BaFe), покрытие формируется с использованием фирменной технологии NANOCUBIC. Компания заявляет о 50 годах стабильного хранения данных с использованием новой ленты. HPE пока что ограничилась коротким сообщением о выходе RW- и WORM-картриджей. Quantum анонсировала приводы LTO-9, а IBM объявила о совместимости ПО Spectrum Archive с новым стандартом. Наконец, Spectra Logic сообщила о поддержке нового стандарта в своих ленточных библиотеках. Ленточные накопители, пожалуй, являются своеобразными патриархами в мире систем хранения данных — магнитная лента использовалась ещё в первых компьютерах IBM. Однако даже сегодня именно они могут похвастаться одной из самых больших ёмкостей в пересчёте на единицу носителя, а кроме того, имеют и ряд других достоинств, например, повышенную надёжность хранения данных за счёт «пассивного» характера хранения записанной информации.

В будущем темпы роста ёмкостей картриджей LTO будут восстановлены Также ленточные библиотеки могут похвастаться меньшей стоимостью владения, нежели HDD-фермы или облачные хранилища. Среди областей применения ленточных накопителей и библиотек называется сценарий защиты данных от «шифровальщиков» и вымогательства, поскольку при необходимости уцелевшую копию можно просто восстановить с картриджа. Однако при современных объёмах данных даже скорость 3,6 Тбайт/час может оказаться недостаточно быстрой.

Петабайтные ёмкости потребуют перехода от феррита бария к эпсилон-ферриту железа (ɛ-Fe2O3) Тем не менее, развитие LTO не останавливается. В экспериментальных устройствах ещё в конце 2020 года была достигнута ёмкость 580 Тбайт, а уже 2021 году было объявлено уже о разработке лент и накопителей, способных хранить до 2,5 Пбайт сжатых данных. Так что говорить о смерти ленточных накопителей не приходится, хотя пандемия и повлияла отрицательно на объёмы продаж оборудования LTO.

08.09.2021 [19:00], Алексей Степин

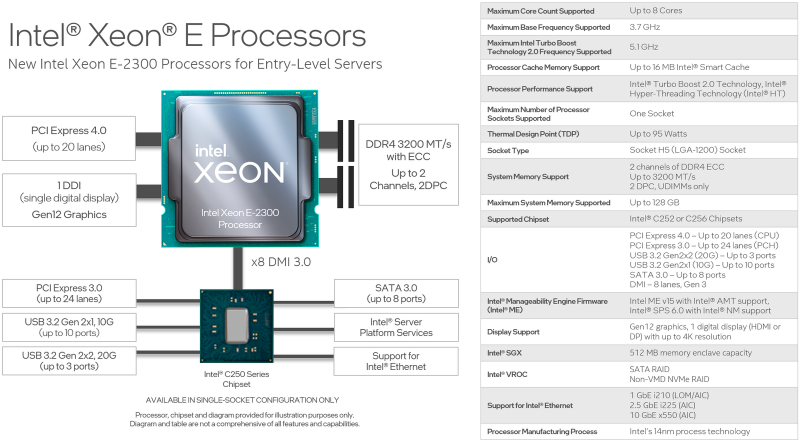

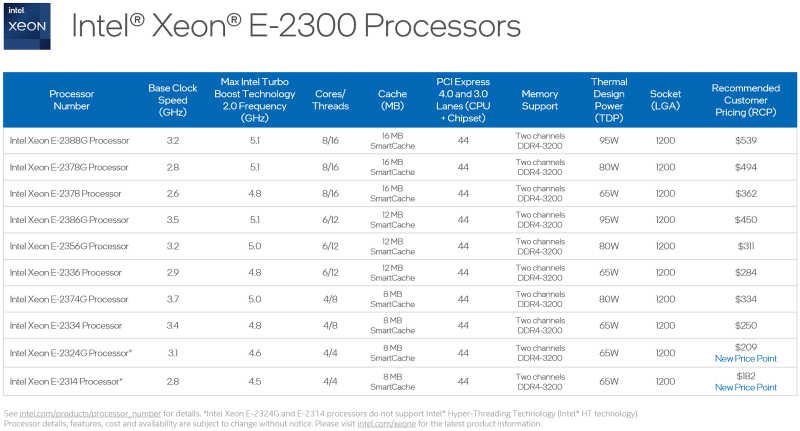

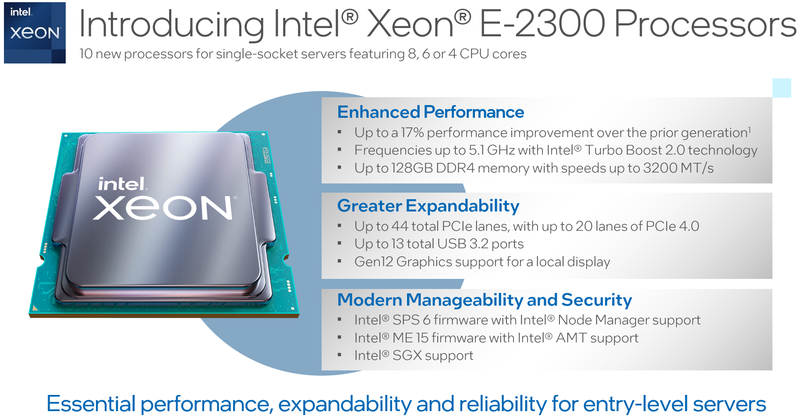

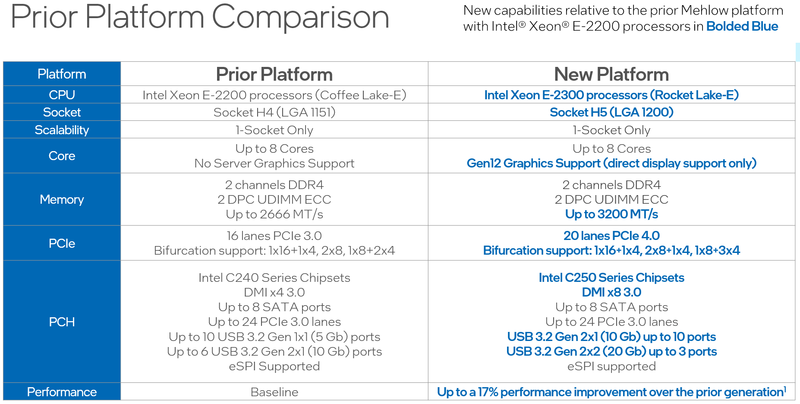

Intel представила процессоры Xeon E-2300: Rocket Lake-E для серверов и рабочих станций начального уровняВ современном мире нагрузки на процессор год от года становятся всё сложнее и объёмнее, и не только крупные ЦОД нуждаются в архитектурных новшествах и новых наборах инструкций — малому бизнесу также требуются чипы нового поколения. Корпорация Intel ответила на это выпуском новых процессоров Xeon серии E-2300 и соответствующей платформы для них. Новинки стали быстрее и получили долгожданную поддержку PCI Express 4.0. Платформа Xeon E-2x00 не обновлялась достаточно давно: процессоры серии E-2200 были представлены ещё в 2019 году. На тот момент это был действительно прорыв в сегменте чипов Intel начального уровня — они впервые получили до 8 ядер Coffee Lake-S, а поддерживаемый объём памяти вырос с 64 до 128 Гбайт. Однако на сегодня таких возможностей уже может оказаться недостаточно: у E-2200 нет AVX-512 с VNNI, шина PCIe ограничена версией 3.0, а графическое ядро HD Graphics P630 и по меркам 2019 года быстрым назвать было нельзя.

Источник изображений: Intel 10 новых процессоров Xeon E-2300, анонсированных Intel сегодня, должны заполнить пустующую нишу младших бизнес-решений. Нововведений в новой платформе не так уж мало, как может показаться на первый взгляд, ведь максимальное количество процессорных ядер у Xeon E-2300 по-прежнему восемь. Однако их максимальная частота выросла до 5,1 ГГц. Изменился процессорный разъём, теперь это LGA1200.  Ядра 11-го поколения Rocket Lake-E (Cypress Cove) по-прежнему используют 14-нм техпроцесс, но оптимизированная микроархитектура позволила Xeon E-2300 быть быстрее соответствующих моделей предыдущего поколения на 17%, и это без учёта качественных нововведений — теперь у них есть AVX-512 с поддержкой инструкций VNNI, ускоряющих работу нейросетей. Нововведения касаются и вопросов информационной безопасности, в которой малый бизнес нуждается не меньше крупного. Как и «большие» Xeon на базе Ice Lake-SP, процессоры Xeon E-2300 получили «взрослую» поддержку защищённых анклавов SGX объёмом до 512 Мбайт, что существенно выше максимально доступных для прошлого поколения Xeon E 64 Мбайт. Максимальный объём памяти остался прежним, но скорость подросла — до 128 Гбайт DDR4-3200 ECC UDIMM в двух каналах (2DPC). Весьма важно также появление нового графического ядра с архитектурой Xe-LP. Конечно, высокой 3D-производительности от него ждать не стоит, но даже в этом оно на шаг впереди устаревшей архитектуры. К этому стоит добавить поддержку HDMI 2.0b и DP 1.4a, аппаратное декодирование 12-бит HEVC и VP9 и 10-бит AV1, а также кодирование в 8-бит AVC и 10-бит HEVC и VP9. Поддержка PCIe 4.0 пришла и на платформу Xeon E — новые процессоры могут предложить 20 линий PCIe 4.0, причём с поддержкой бифуркации. Ещё 24 линии PCIe 3.0 включает чипсет серии C250. В нём же имеется поддержка 8 портов SATA-3 и USB 3.2 Gen 2x2 — до трёх портов со скоростью 20 Гбит/с. Сетевая часть может быть реализована как на базе недорогих чипов i210, так и более производительных i225 (2,5 Гбит/с) или x550 (10 Гбит/с).  В новой серии, как уже было сказано, представлено 10 процессоров, стоимостью от $182 до $539 и теплопакетами от 65 до 95 Вт. Лишь две младшие модели в списке не имеют поддержки Hyper-Threading. Все Xeon E-2300 располагают встроенным движком Manageability Engine 15 и поддержкой Intel Server Platform Services 6, облегчающей развёртывание и удалённое управление. Свои решения на базе новой платформы представят все ведущие производители серверного оборудования.

08.09.2021 [17:40], Владимир Мироненко

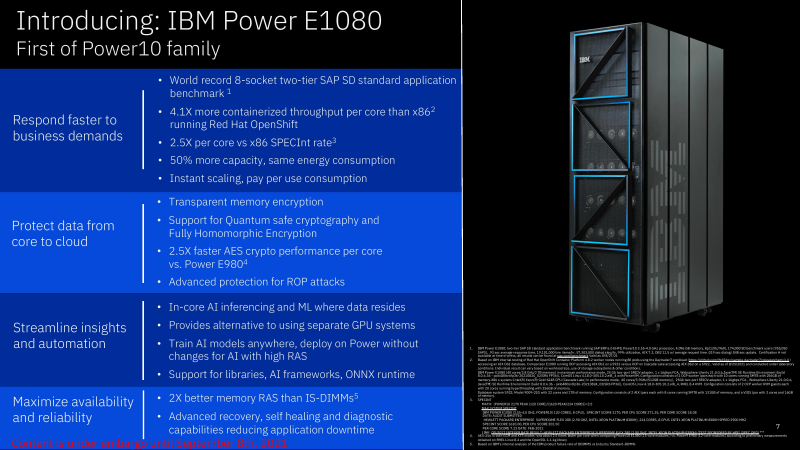

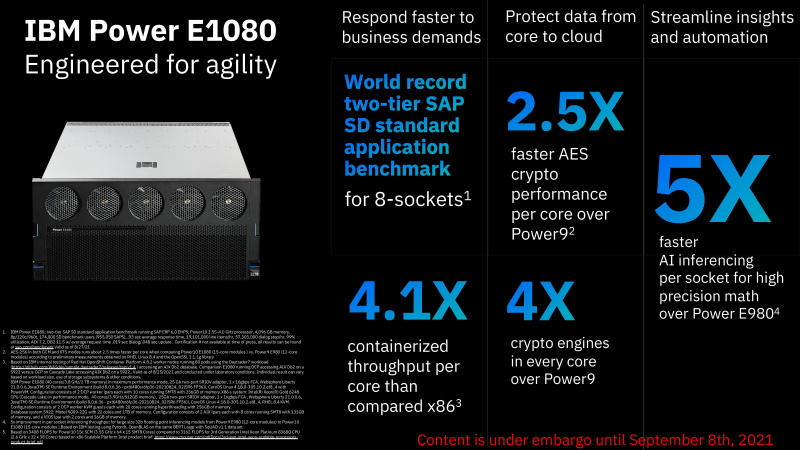

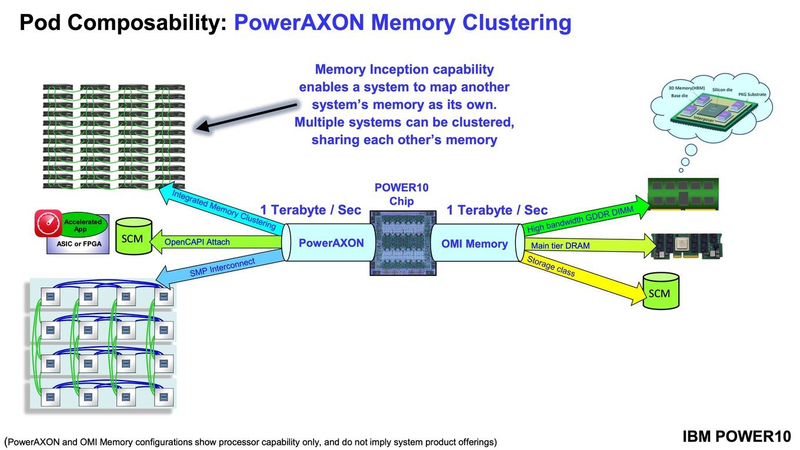

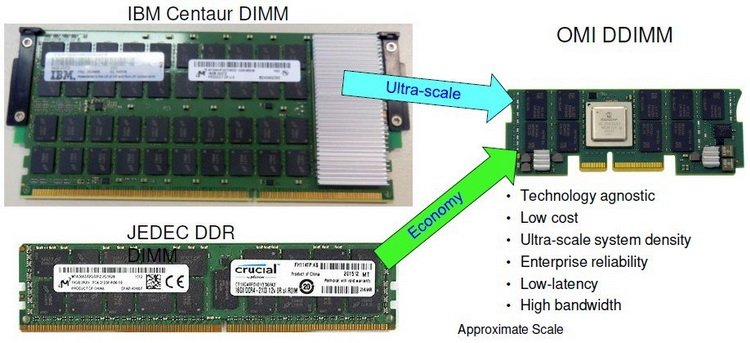

IBM представила серверы E1080: 16 CPU POWER10, 240 ядер, 1920 потоков, 64 Тбайт RAM и 224 PCIe-слота в одной системеIBM объявила о выходе нового поколения серверов IBM POWER E1080 на базе 7-нм чипа POWER10. Это первая коммерческая система на новых процессорах IBM, представленных на прошлогодней конференции Hot Chips и использующих архитектуру POWER v3.1. IBM POWER E1080 предназначен для удовлетворения спроса на надёжные гибридные облачные среды. E1080 представляет собой четырёхсокетный сервер с процессорами POWER10. На текущий момент компания предлагает CPU c 10, 12 или 15 ядрами (ещё одно «запасное» ядро отключено), тогда как у POWER9 число ядер не превышало 12. На каждое ядро приходится 2 Мбайт L2-кеша и 8 Мбайт — L3 (до 120 Мбайт общего кеша на CPU). Для систем на базе E1080 поддерживается масштабирование до четырёх узлов, то есть можно получить 16 процессоров, 240 ядер, 1920 потоков, 64 Тбайт RAM и 224 PCIe-слота. Отличительной чертой новинок является поддержка SMT8, то есть обработка до 120 потоков на процессор. По сравнению с POWER9 производительность новых CPU выросла на 20% на поток и на 30% на ядро, а в пересчёте на Вт она выросла трёхкратно. А четыре 512-бит матричных движка и восемь 128-бит SIMD-блоков повысили скорость INT8-операций в 20 и более раз.  Память тоже новая — буферизированная OMI DDR4 DDIMM, которая, по словам компании, отличается повышенной надёжностью и отказоустойчивостью в сравнении с традиционными DDIMM. На один сервер приходится 64 слота с поддержкой до 16 Тбайт RAM с поддержкой технологии прозрачного шифрования памяти (Transparent Secure Memory Encryption, TSME), которая в 2,5 раза быстрее по сравнению с IBM POWER9. Заявленная пропускная способность составляет 409 Гбайт/с на ядро.  И для OMI, и для OpenCAPI используется шина PowerAXON (1 Тбайт/с), которая позволяет подключать к системе различные типы памяти (можно адресовать до 2048 Тбайт в рамках одного кластера), накопители, ускорители и т.д. Также в самой системе доступно четыре слота для NVMe SSD и 8 слотов PCIe 5.0. К E1080 можно подключить до четырёх полок расширения с 12 слотами PCIe 5.0 в каждой. По данным IBM, благодаря E1080 установлен «мировой рекорд производительности: это первая система, достигшая 955 000 SAPS (SAP Application Performance Standard, в стандартном тесте приложений SAP SD в восьмипроцессорной системе — значительно больше, чем у альтернативной архитектуры x86, 2x на сокет (и) до 4 раз больше возможностей на ядро с E1080 (по сравнению с Intel)».  IBM заявила, что повышение производительности на ядро и увеличение количества ядер в системе означает значительное сокращение занимаемой серверами площади и энергопотребления. В тематическом исследовании неназванного клиента компания сообщила, что 126 серверов на чипах Intel, обслуживающих СУБД Oracle, были заменены тремя E980 на базе POWER9 и, по прогнозам, их можно будет заменить на два E1080. В результате потребляемая мощность упадёт со 102 до 20 кВт, а количество требуемых лицензий сократится с 891 (для системы Intel) до 263 (для E1080). Новинка имеет в 4,1 раза более высокую по сравнению с x86-серверами пропускную способность контейнеризированных приложений OpenShift, а также целостность архитектуры и гибкость в гибридной облачной среде для повышения универсальности и снижения расходов без рефакторинга приложений. А по сравнению с IBM POWER E980v рост производительности и масштабируемости составил до 50% с одновременным снижением энергопотребления. Кроме того, E1080 предлагает новые функции RAS для расширенного восстановления, самовосстановления и диагностики, а также усовершенствования для гибридного облака, включая первый в индустрии поминутный контроль использования ПО Red Hat, в том числе OpenShift и Red Hat Enterprise Linux. У IBM POWER E1080 также имеется возможность мгновенного масштабирования с помощью POWER Private Cloud with Dynamic Capacity, что позволит платить только за использованные ресурсы. Среди прочих преимуществ своего решения IBM отмечает наличие надёжной экосистемы независимых поставщиков ПО, бизнес-партнёров и поддержки для E1080. Кроме того, IBM анонсировала многоуровневый сервис POWER Expert Care, призванный обеспечить защиту от продвинутых киберугроз, а также согласованное функционирование аппаратного и программного обеспечения и более высокую эксплуатационную готовность систем.

01.09.2021 [23:58], Андрей Галадей

Ветераны индустрии основали стартап Ventana для создания чиплетных серверных процессоров RISC-VСтартап Ventana Micro Systems, похоже, намерен перевернуть рынок серверов. Компания заявила о разработке высокопроизводительных процессоров на архитектуре RISC-V для центров обработки данных. Первые образцы фирменных CPU будут переданы клиентам во второй половине следующего года, а поставки начнутся в первой половине 2023 года. При этом процессоры получат чиплетную компоновку — различные модули и кристаллы на общей подложке. Основные процессорные ядра разработает сама Ventana, а вот остальные чиплеты будут создаваться под нужды определённых заказчиков. CPU-блоки будут иметь до 16 ядер, которые, как обещается, окажутся быстрее любых других реализаций RV64. Использование RISC-V позволит разрабатывать сверхмощные решения в рекордные сроки и без значительного бюджета. Ядра будут «выпекаться» на TSMC по 5-нм нормам, но для остальных блоков могут использовать другие техпроцессы и фабрики.  Ventana будет следить за процессом их создания и упаковывать до полудюжины блоков в одну SoC. Для соединения ядер, кеша и других компонентов будет использоваться фирменная кеш-когерентная шина, которая обеспечит задержку порядка 8 нс и скорость передачи данных 16 Гбит/с на одну линию. Основными заказчиками, как ожидается, станут гиперскейлеры и крупные IT-игроки, которым часто требуется специализированное «железо» для ЦОД, 5G и т.д. Сегодня Ventana объявила о привлечении $38 млн в рамках раунда B. Общий же объём инвестиций составил $53 млн. Компания была основана в 2018 году. Однако это не совсем обычный стартап — и сами основатели, и команда являются настоящими ветеранами индустрии. Все они имеют многолетний опыт работы в Arm, AMD, Intel, Samsung, Xilinx и целом ряде других крупных компаний в области микроэлектроники. Часть из них уже имела собственные стартапы, которые были поглощены IT-гигантами.

31.08.2021 [20:34], Игорь Осколков

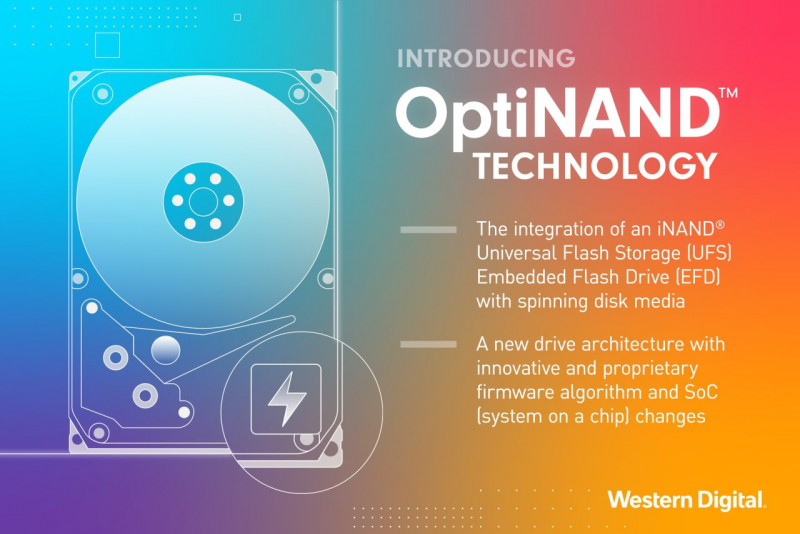

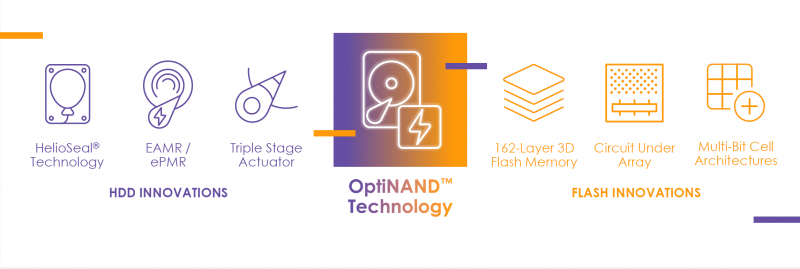

Western Digital анонсировала «концептуально новые» жёсткие диски с технологией OptiNAND: 20+ Тбайт без SMRWestern Digital анонсировала технологию OptiNAND, которая, по её словам, полностью меняет архитектуру жёстких дисков и вместе с ePMR открывает путь к созданию накопителей ёмкостью более 20 Тбайт (от 2,2 Тбайт на пластину) даже при использовании CMR — вплоть до 50 Тбайт во второй половине этого десятилетия. OptiNAND предполагает интеграцию индустриального UFS-накопителя серии iNAND непосредственно в HDD. Но это не просто ещё один вариант NAND-кеша. Увеличение ёмкости одной пластины происходит благодаря повышению плотности размещения дорожек, что, правда, на современном этапе развития жёстких дисков требует различных ухищрений: заполнение корпуса гелием, использование продвинутых актуаторов, применение новых материалов, требующих энергетической поддержки записи (MAMR, HAMR и т.д.). Вместе с тем механическая часть накопителей не столь «тонка» и подвержена различным колебаниям, которые могут повлиять на запись и считывание столь плотно упакованных дорожек.  При производстве жёстких дисков делается калибровка и учёт этих ошибок в позиционировании головки (RRO, repeatable run out), а данные (речь идёт о гигабайтах) обычно записываются непосредственно на пластины, откуда и считываются во время работы накопителя. В случае OptiNAND эти мета✴-данные попадают во флеш-память, позволяя высвободить место. Правда, пока не уточняется, насколько это значимо на фоне общей ёмкости пластины. Второй важный тип мета✴-данных, который теперь попадает в iNAND, — это информация о произведённых операциях записи. При повышении плотности размещения риск того, что запись на одну дорожку повлияет на данные в соседней, резко увеличивается. Поэтому, опираясь на данные о прошлых записях, жёсткий диск периодически перезаписывает данные соседних дорожек для повышения сохранности информации. В старых накопителях одна такая операция приходилась примерно на 10 тыс. записей, в современных — на менее, чем на 10 записей. Причём учёт ведётся именно на уровне дорожек. iNAND же позволяет повысить точность отслеживания записей до секторов, что, в свою очередь, позволяет разнести операции перезаписи в пространстве и времени, снизив общую нагрузку на накопитель и повысив плотность размещения дорожек без ущерба для производительности, поскольку надо тратить меньше времени на «самообслуживание». Наконец, быстрая и ёмкая UFS (вплоть до 3.1) позволяет сохранить в 50 раз больше данных и мета✴-данных из DRAM в сравнении с жёсткими дисками без OptiNAND в случае аварийного отключения накопителя и в целом повысить его производительность, причём в независимости от того, включено ли кеширование записи или нет. Кроме того, новый слой памяти позволяет лучше оптимизировать прошивку под конкретные задачи — будут использоваться 162-слойные TLC-чипы от Kioxia, которые можно настроить в том числе на работу в режиме SLC. Western Digital планирует использовать OptiNAND в большинстве серий своих жёстких дисков, предназначенных для облаков и гиперскейлеров, корпоративных нужд (Gold), систем видеонаблюдения (Purple) и NAS (Red). Первые образцы 20-Тбайт накопителей (CMR + ePMR) с OptiNAND уже тестируются избранными клиентами компании. А вот о потребительских решениях пока ничего сказано не было.

28.08.2021 [00:16], Владимир Агапов

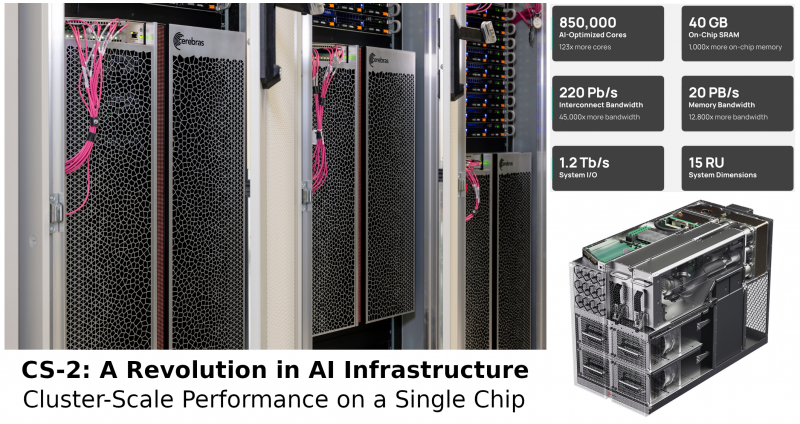

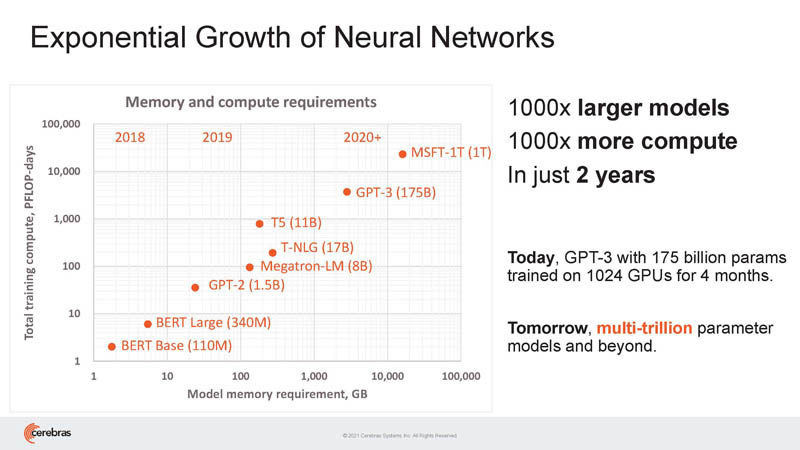

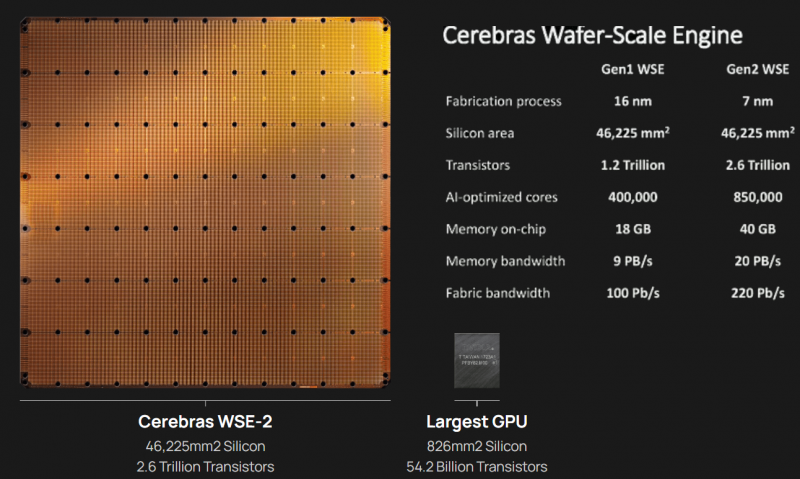

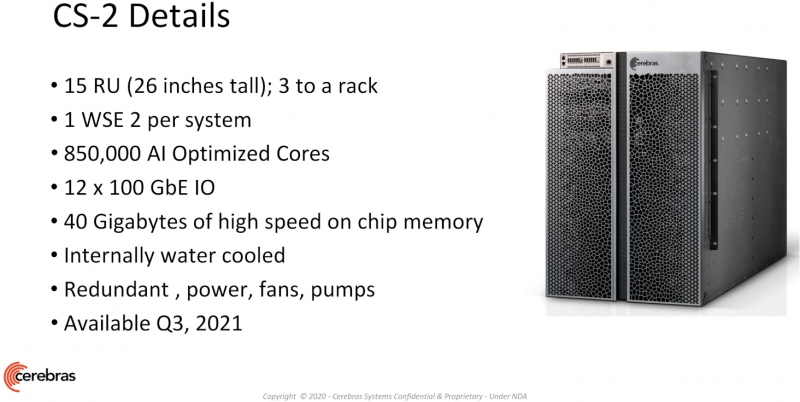

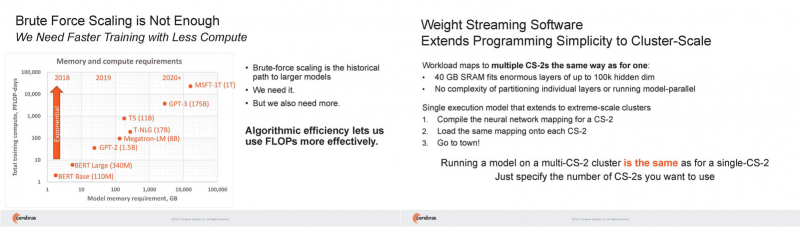

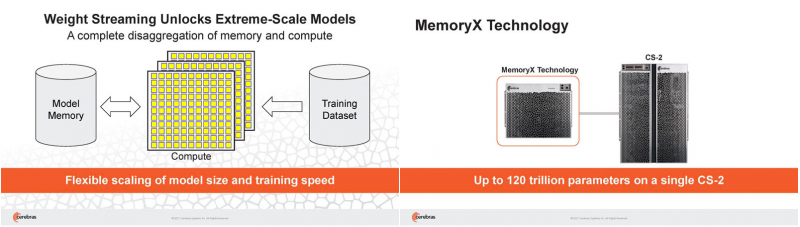

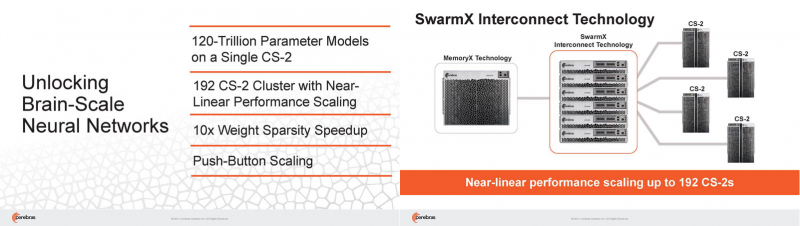

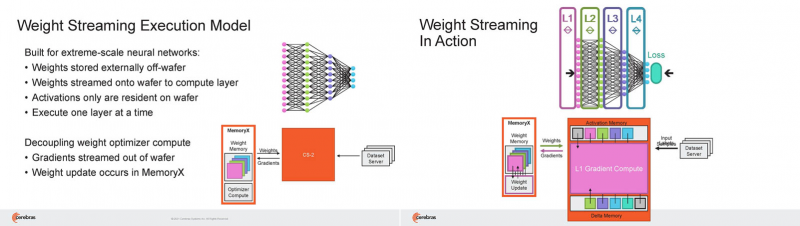

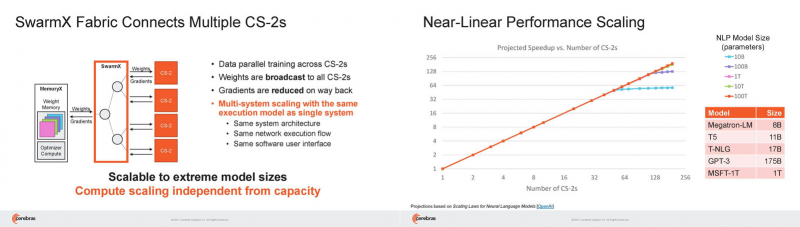

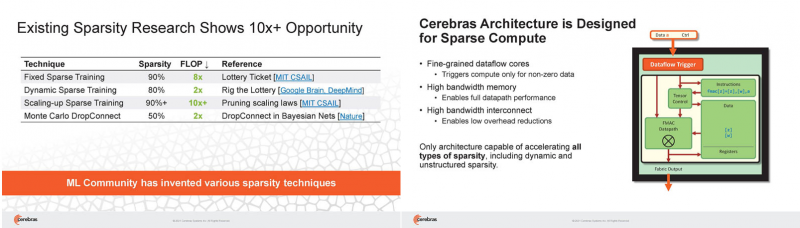

Кластер суперчипов Cerebras WSE-2 позволит тренировать ИИ-модели, сопоставимые по масштабу с человеческим мозгомВ последние годы сложность ИИ-моделей удваивается в среднем каждые два месяца, и пока что эта тенденция сохраняется. Всего три года назад Google обучила «скромную» модель BERT с 340 млн параметров за 9 Пфлоп-дней. В 2020 году на обучение модели Micrsofot MSFT-1T с 1 трлн параметров понадобилось уже порядка 25-30 тыс. Пфлоп-дней. Процессорам и GPU общего назначения всё труднее управиться с такими задачами, поэтому разработкой специализированных ускорителей занимается целый ряд компаний: Google, Groq, Graphcore, SambaNova, Enflame и др. Особо выделятся компания Cerebras, избравшая особый путь масштабирования вычислительной мощности. Вместо того, чтобы печатать десятки чипов на большой пластине кремния, вырезать их из пластины, а затем соединять друг с другом — компания разработала в 2019 г. гигантский чип Wafer-Scale Engine 1 (WSE-1), занимающий практически всю пластину. 400 тыс. ядер, выполненных по 16-нм техпроцессу, потребляют 15 кВт, но в ряде задач они оказываются в сотни раз быстрее 450-кВт суперкомпьютера на базе ускорителей NVIDIA. В этом году компания выпустила второе поколение этих чипов — WSE-2, в котором благодаря переходу на 7-нм техпроцесс удалось повысить число тензорных ядер до 850 тыс., а объём L2-кеша довести до 40 Гбайт, что примерно в 1000 раз больше чем у любого GPU. Естественно, такой подход к производству понижает выход годных пластин и резко повышает себестоимость изделий, но Cerebras в сотрудничестве с TSMC удалось частично снизить остроту этой проблемы за счёт заложенной в конструкцию WSE избыточности. Благодаря идентичности всех ядер, даже при неисправности некоторых их них, изделие в целом сохраняет работоспособность. Тем не менее, себестоимость одной 7-нм 300-мм пластины составляет несколько тысяч долларов, в то время как стоимость чипа WSE оценивается в $2 млн. Зато система CS-1, построенная на таком процессоре, занимает всего треть стойки, имея при этом производительность минимум на порядок превышающую самые производительные GPU. Одна из причин такой разницы — это большой объём быстрой набортной памяти и скорость обмена данными между ядрами. Тем не менее, теперь далеко не каждая модель способна «поместиться» в один чип WSE, поэтому, по словам генерального директора Cerebras Эндрю Фельдмана (Andrew Feldman), сейчас в фокусе внимания компании — построение эффективных систем, составленных из многих чипов WSE. Скорость роста сложности моделей превышает возможности увеличения вычислительной мощности путём добавления новых ядер и памяти на пластину, поскольку это приводит к чрезмерному удорожанию и так недешёвой системы. Инженеры компании рассматривают дезагрегацию как единственный способ обеспечить необходимый уровень производительности и масштабируемости. Такой подход подразумевает разделение памяти и вычислительных блоков для того, чтобы иметь возможность масштабировать их независимо друг от друга — параметры модели помещаются в отдельное хранилище, а сама модель может быть разнесена на несколько вычислительных узлов CS, объединённых в кластер. На Hot Chips 33 компания представила особое хранилище под названием MemoryX, сочетающее DRAM и флеш-память суммарной емкостью 2,4 Пбайт, которое позволяет хранить до 120 трлн параметров. Это, по оценкам компании, делает возможным построение моделей близких по масштабу к человеческому мозгу, обладающему порядка 80 млрд. нейронов и 100 трлн. связей между ними. К слову, флеш-память размером с целую 300-мм пластину разрабатывает ещё и Kioxia. Для обеспечения масштабирования как на уровне WSE, так и уровне CS-кластера, Cerebras разработала технологию потоковой передачи весовых коэффициентов Weight Streaming. С помощью неё слой активации сверхкрупных моделей (которые скоро станут нормой) может храниться на WSE, а поток параметров поступает извне. Дезагрегация вычислений и хранения параметров устраняет проблемы задержки и узости пропускной способности памяти, с которыми сталкиваются большие кластеры процессоров. Это открывает широкие возможности независимого масштабирования размера и скорости кластера, позволяя хранить триллионы весов WSE-2 в MemoryX и использовать от 1 до 192 CS-2 без изменения ПО. В традиционных системах по мере добавления в кластер большего количества вычислительных узлов каждый из них вносит всё меньший вклад в решение задачи. Cerebras разработала интерконнект SwarmX, позволяющий подключать до 163 млн вычислительных ядер, сохраняя при этом линейность прироста производительности. Также, компания уделила внимание разрежённости, то есть исключения части незначимых для конечного результата весов. Исследования показали, что должная оптимизации модели позволяет достичь 10-кратного увеличения производительности при сохранении точности вычислений. В CS-2 доступна технология динамического изменения разрежённости Selectable Sparsity, позволяющая пользователям выбирать необходимый уровень «ужатия» модели для сокращение времени вычислений. «Крупные сети, такие как GPT-3, уже изменили отрасль машинной обработки естественного языка, сделав возможным то, что раньше было невозможно и представить. Индустрия перешла к моделям с 1 трлн параметров, а мы расширяем эту границу на два порядка, создавая нейронные сети со 120 трлн параметров, сравнимую по масштабу с мозгом» — отметил Фельдман. |

|