Лента новостей

|

21.02.2024 [21:18], Руслан Авдеев

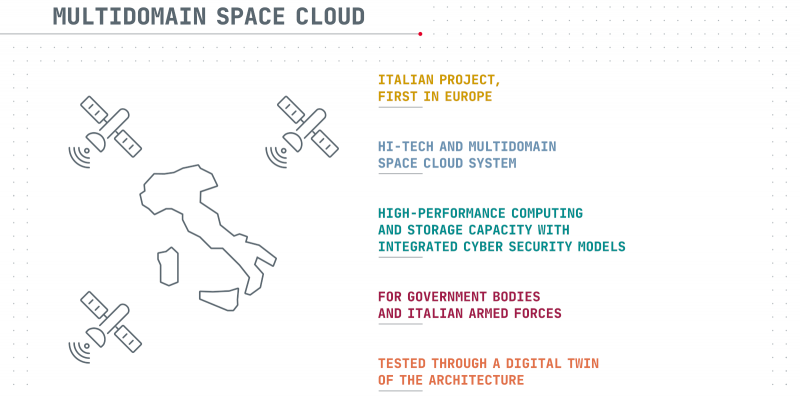

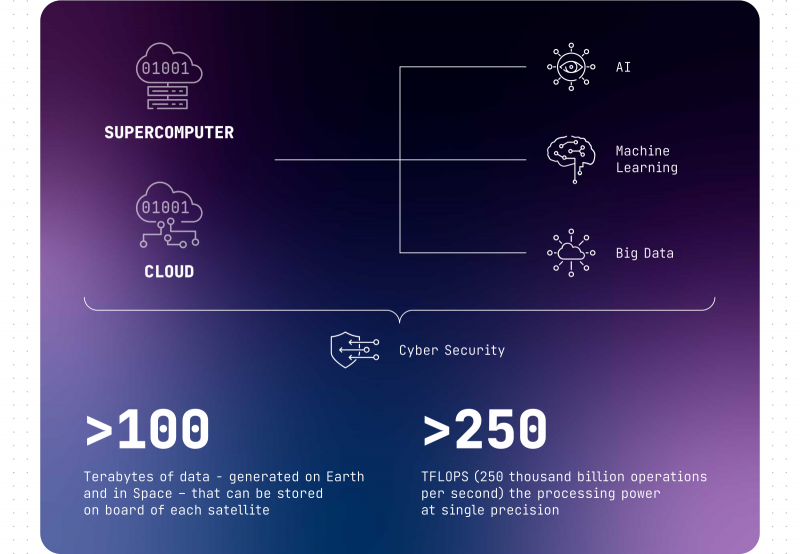

Итальянские военные захотели создать группировку спутников-суперкомпьютеровМинистерство обороны Италии изучает возможность формирования «военно-космического облака» и поручила поддерживаемому государством подрядчику Leonardo проверить концепцию. По данным The Register, проект Military Space Cloud Architecture (MILSCA) предполагает формирование архитектуры, обеспечивающей правительство и вооружённые силы высокопроизводительными вычислениями и хранилищами данных в космосе. План предусматривает создание группировки спутников, каждый с FP32-производительностью 250 Тфлопс и хранилищем ёмкостью не менее 100 Тбайт данных. Ещё 100 Тбайт будет зарезервировано на Земле. Все ресурсы будут связаны друг с другом для поддержки выполнения задач, касающихся ИИ и анализа данных. Фактически речь идёт о гигантском, разнесённом в пространстве суперкомпьютерном кластере. Для сравнения — в состав кластера HPE Spaceborne-2 на МКС входит ускоритель NVIDIA T4 с FP32-производительностью 8 Тфлопс. В Leonardo обещают быструю обработку данных на орбите и утверждают, что коммуникации будут менее уязвимы, чем наземные. Пользователи получат гарантированный доступ к телеком-услугам, данным наблюдения за Землёй, а также навигационным сведениям в любое время в любой части планеты. Кроме того, группировка послужит важным «бэкапом» для наземных центров, если с теми что-то случится. Leonardo и её совместные предприятия Telespazio и Thales Alenia Space изучат в ближайшие пару лет целесообразность создания такой группировки. В ходе первой фазы исследований участники проекта определятся с архитектурой всей системы, а в ходе второй попытаются провести симуляцию группировки с помощью «цифрового двойника» на суперкомпьютере Davinci-1. Она поможет заранее выявить потенциальные проблемы и оценить зоны покрытия. Оборудование потребует специальной защиты от космической радиации. Также предстоит решить вопросы энергоснабжения и терморегулирования. Кроме того, придётся по возможности минимизировать массу оборудования, доставляемого в космос. Дело осложняется тем, что для получения заданных характеристик придётся использовать достаточно горячие чипы, выполненные по тонким техпроцессам. Leonardo не впервые просят оценить перспективы космических вычислений. В 2022 году совместное предприятие Thales Alenia Space, созданное Leonardo и французской Thales, наняли для оценки перспектив космических ЦОД в рамках исследовательской программы Horizon Europe. Правда, на тот момент речь шла об экопроекте, а не группировке военного назначения. Недавно компания Axiom Space также заявила, что построит и выведет на орбиту ЦОД для поддержки миссий своей коммерческой космической станции. Компания намеревалась снизить зависимость от наземных сервисов. Blue Ring тоже планирует предоставлять вычисления в космосе. Наконец, Lonestar Data Holdings привлекает средства для постройки ЦОД на Луне.

21.02.2024 [17:22], Сергей Карасёв

Softline создала облачного провайдера «Инферит Облако» на базе двух дата-центровРоссийская компания «Инферит» (ГК Softline) сообщила о формировании облачного провайдера для предоставления инфраструктурных и IT-сервисов. В основу платформы под названием «Инферит Облако» положены собственное оборудование «Инферит Техника» и открытое ПО OpenStack. Системы клиентов могут быть развёрнуты на российской платформе виртуализации zVirt компании Orion Soft, которая является технологическим партнёром «Инферита». «Инферит Облако» базируется на двух ЦОД. Это дата-центр «Инферит» во Фрязино, в особой экономической зоне «Исток»: площадка рассчитана на размещение 500 серверов. Кроме того, задействован ЦОД неназванного партнёра. В рамках проекта «Инферит Облако» планируется предоставлять широкий набор услуг, включая публичные и частные сервисы, комплексные решения в области безопасности и телекоммуникаций.

Источник изображения: pixabay.com Публичная инфраструктура включает IaaS, облачные и приватные серверы, сетевые системы, службы резервного копирования и аварийного восстановления данных. К числу телекоммуникационных решений относятся каналы L2, выделенные каналы интернет-доступа, публичные IP-адреса и аренда ВОЛС. За безопасность отвечают инструменты защиты от DDoS-атак, межсетевой экран для веб-приложений (WAF), Anti-bot и CESP (защита электронной почты). Предусмотрены средства миграции IT-инфраструктуры заказчика в «Инферит Облако». В рамках проекта достигнуты договорённости о сотрудничестве с крупными игроками отечественного IT-рынка. В дальнейшем возможности платформы «Инферит Облако» будут расширяться. Планируется запуск новых сервисов, включая решения для разработчиков, ИИ-системы, S3-хранилище и маркетплейс SaaS-продуктов. Кроме того, появится личный кабинет клиента и партнёра, что позволит максимально автоматизировать управление облачной инфраструктурой, визуализировать данные, управлять доступом и ресурсами, получать круглосуточную техническую поддержку.

21.02.2024 [16:23], Владимир Мироненко

ГК «Солар» анонсировала программу CYBER STAGE для поддержки российских стартапов и разработок в области информационной безопасности

software

импортозамещение

информационная безопасность

разработка

россия

ртк-солар

сделано в россии

стартап

ГК «Солар» представила при участии отраслевых экспертов первую в России комплексную программу поддержки предпринимателей в области информационной безопасности и смежных направлений CYBER STAGE, призванную оказать поддержку ИБ-стартапам, а также содействие российским разработкам, сформировать конкурентную среду на рынке кибербезопасности России и насытить рынок решениями и возможностями для выстраивания комплексных решений кибербезопасности для защиты российских организаций. Создатели СYBER STAGE планируют привлечь до конца 2025 года не менее 1,5 млрд руб. финансирования для ИБ-проектов и вывести на рынок до 10 новых продуктов. Программой предусмотрено создание Advisory Board — сообщества ИТ-лидеров, нацеленного на развитие бизнеса, технологий и помощь в привлечении финансирования ИБ-стартапов, в которое вошли Дмитрий Гадарь (CISO «Тинькофф»), Антон Карпов (CISO VK), Вячеслав Касимов (CISO МКБ), Сергей Демидов (CISO Московской Биржи), Давид Мартиросов (CEO Basis). Предполагается, что присутствие в Advisory Board экспертов по ИТ и ИБ из числа крупнейших компаний страны даст молодым проектам возможность начать работу с B2E/B2B/B2G-сегментами. ГК «Солар» отметила, что крупные компании неохотно работают со стартапами. Согласно данным опроса 84 компаний сегментов B2E/B2B/B2G, сейчас со стартапами работает только 13 % из числа респондентов. Отмечается, что бизнес готов работать со стартапами на продвинутой или финальной стадии разработки, однако добраться до них без внешней помощи стартапы не могут. CYBER STAGE нацелена на решение широкого круга задач: от создания удобной платформы взаимодействия участников рынка ИБ и смежных направлений до стимулирования запуска принципиально новых проектов в пустующих или недостаточно обеспеченных продуктами и сервисами нишах ИБ и повышения уровня привлекательности ИБ для ИТ-предпринимателей. В этому году в рамках программы будут проходить ежемесячные питч-сессии, также запланирована подготовка не менее пяти проектов к привлечению финансирования. Уже в ближайшие два года проект намерен показать видимые результаты. В CYBER STAGE предусмотрены и традиционные форматы акселерации: менторство, работа с технологиями и ресурсное сопровождение (обучение, помощь в упаковке продукта, содействие в привлечении венчурных инвестиций). По словам авторов программы, к участникам будут предъявляться минимальные требования. Стартап должен иметь основную команду, продукт, направленный на решение задач или на улучшение комплексных сервисов и продуктов в сфере ИБ, и находиться на стадии прототипа и выше. По итогам оценки он получает рекомендации и предложения по направлениям сотрудничества. По данным ГК «Солар», в России на начало 2024 года было зарегистрировано 230 ИБ-бизнесов, что составляет менее 2,3 % от всего количества ИБ-проектов в мире, равного 9874. Доля российского рынка ИБ в мировом составляет 1 %, хотя он растёт с опережением мировых темпов. В 2023 году российский рынок ИБ увеличился на 15 % год к году, достигнув около 145 млрд руб. По данным ГК «Солар», в России ежегодно появляется 20–30 новых проектов в сфере информационной безопасности как в форме стартапов, так и продуктовых команд внутри крупных корпораций, вендоров, ИТ-групп.

21.02.2024 [15:35], Сергей Карасёв

MTS AI создала российскую большую языковую модель для анализа документов и звонковКомпания MTS AI, дочерняя структура МТС, разработала большую языковую модель (LLM) MTS AI Chat. Она, как утверждается, позволяет решать широкий спектр задач — от генерации и редактирования текстов до суммирования и анализа информации. Новая LLM ориентирована на корпоративный сектор. Среди сфер применения называются подбор персонала, маркетинг, обслуживание клиентов, подготовка финансовой документации и проверка отчётности, генерация обучающих материалов и пр. На базе MTS AI Chat могут создаваться внутренние системы поиска, чат-боты для ответов на вопросы, рекомендательные сервисы и пр.

Источник изображения: pixabay.com Как отмечает «Коммерсантъ», ссылаясь на информацию, полученную от МТС, в текущем виде LLM поддерживает только текстовые запросы, но компания работает над версией, которая сможет распознавать изображения и видеоматериалы. Кроме того, готовится сервис генерации и автодополнения программного кода. Участники рынка полагают, что при обучении модели MTS AI могла использовать обезличенные данные, которые собирают другие подразделения группы. В настоящее время LLM предлагается для развёртывания на оборудовании заказчика, но в перспективе ожидается выход публичной редакции. Пользователи смогут применять модель для составления должностных инструкций, извлечения информации из документов, формирования выжимок телефонных разговоров и пр. Нужно отметить, что собственные LLM создают и другие российские компании. Так, системный IT-интегратор «Норбит» недавно анонсировал модель Norbit GPT, также ориентированную на корпоративных клиентов. Она предназначена для генерации текстов, обобщения информации, обработки и анализа данных, а также для подготовки ответов на обращения пользователей в службу поддержки.

21.02.2024 [15:31], Руслан Авдеев

Евросоюз озаботится безопасностью подводных интернет-кабелейВесьма вероятно, что Евросоюзу придётся выделить средства на защиту сети своих подводных кабелей с учётом предложений, подготовленных Еврокомиссией. Datacenter Dynamics сообщает, что последняя разработала меры по повышению надёжности региональной кабельной инфраструктуры. План включает меры защиты кабелей ЕС или кабельных проектов, входящих в зону европейских интересов (CPEI). Рекомендации комиссии поощряют разработку или значительное усовершенствование подводной инфраструктуры CPEI в соответствии с законами Евросоюза. По статистике подводные цифровые магистрали обеспечивают передачу 97 % международного интернет-трафика, поэтому многие страны учитывают высокий риск повреждения соответствующей инфраструктуры или диверсий. Термин CPEI связан с проектами, реализуемыми правительствами стран совместно с частными инвесторами. В Еврокомиссии предлагают создать группу экспертов, которые определят, какие именно проекты стратегически являются наиболее важными для Европы и как их можно усовершенствовать и защитить. Рекомендации комиссии предполагают принятие мер по обеспечению соответствия инфраструктурных операторов строжайшим стандартам безопасности (включая военным стандартам там, где это необходимо). Средства могут выделить из фондов уже существующих в Евросоюзе программ вроде Европейского инвестиционного банка, но допускается и привлечение частного бизнеса. В отдельном докладе Euractiv предполагается, что ЕС мог бы запретить сотрудничество с «поставщиками, отнесёнными к группе высокого риска» при прокладке новых подводных кабелей. В частности, речь идёт о китайских техногигантах вроде Huawei (её подразделения NHM Tech) и ZTE, на которые и могут наложить запреты и ограничения. Среди других европейских стран защитой подводных интернет-кабелей и силовой инфраструктуры уже озаботились Великобритания и Норвегия.

21.02.2024 [15:17], Андрей Крупин

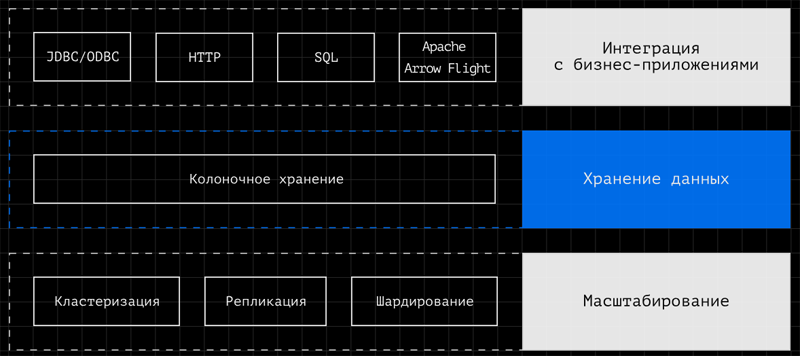

VK представила гибридную СУБД Tarantool Column StoreКомпания VK объявила о выпуске системы управления базами данных Tarantool Column Store, построенной с использованием In-Memory-технологий и предназначенной для транзакционно-аналитической обработки данных в реальном времени. Tarantool Column Store является гибридной СУБД с поддержкой как колоночного, так и строчного хранения и обработки данных. Продукт обладает высокопроизводительным векторизованным многопоточным движком выполнения запросов SQL и интегрируется с бизнес-приложениями с помощью JDBC/ODBC/ADBC и HTTP. Платформа может масштабироваться путём кластеризации, репликации и шардирования. Встроенные механизмы сжатия данных в оперативной памяти, а также возможность использования СХД для их архивирования позволяют работать с массивами данных, не помещающимися в оперативную память.

Архитектура Tarantool Column Store (источник изображения: tarantool.io) «Традиционно в IT-инфраструктуре бизнеса транзакционные и аналитические системы отделены друг от друга. Большие потоки данных приходится переносить в витрину или хранилище. После этого информацию можно анализировать, не замедляя операционные процессы. Это снижает актуальность данных и полученных инсайтов, а также увеличивает издержки бизнеса. In-Memory СУБД Tarantool Column Store обеспечивает гибридную обработку транзакций и аналитических запросов в одной системе, отвечая современным вызовам», — комментирует Николай Карлов, директор инновационных проектов VK Tech. СУБД Tarantool Column Store зарегистрирована в реестре отечественного ПО. Решение совместимо с российскими операционными системами Astra Linux, «Ред ОС» и «Альт».

21.02.2024 [14:45], Владимир Мироненко

OLDI Computers представила серверное оборудование Н3С и собственный ПАК для мониторинга серверовКомпания OLDI Computers провела конференцию, на которой представила серверное оборудование компании Н3С, а также программно-аппаратный комплекс для обеспечения безопасности процессов и их мониторинга. В ходе мероприятия топ-менеджеры OLDI Computers рассказали о текущих ориентирах компании, производственных мощностях, о развитии серверного направления, а также об уникальной разработке ПАК. В частности, был продемонстрирован четырёхпроцессорный сервер на базе Intel Xeon Sapphire Rapids, предоставленный H3C в качестве образца выпускаемой продукции для ознакомления. Это производительная и современная 4U-платформа с чипами актуального поколения, пока ещё редко встречающегося на российском рынке. Программно-аппаратный комплекс (ПАК) OLDI Computers — это контроллер сбора и контроля параметров, устанавливаемый внутри сервера, разработанный совместно с ГК Матрикс. ПАК представляет собой систему сбора информации о вычислительном устройстве. Идея его создания пришла в связи с потребностью большого числа государственных и коммерческих предприятий максимально обезопасить имеющуюся ИТ-инфраструктуру. Сейчас при поддержке зарубежных партнёров OLDI Computers осуществляет поставки комплектующих и платформ, поддерживает гарантийные обязательства, а также выполняет техническую поддержку и лицензирование. «Сегодня мы выпускаем оборудование под конфигурации любой сложности. Это современное компьютерное оборудование для офисных задач и домашнего использования, прошедшее в процессе производства стадии конструирования нашими техническими специалистами, а также сборку на нашем высокотехнологичном производстве», — сообщила компания.

21.02.2024 [14:45], Руслан Авдеев

£131 млн вместо заявленных £20 млн: «катастрофическая» ERP-система Oracle для Бирмингема требует всё больше и больше денегОпубликованный по результатам встречи Городского совета Бирмингема документ свидетельствует о том, что властям понадобятся ещё десятки миллионов фунтов стерлингов, чтобы наладить работу ERP-системы Oracle, внедрение которой началось уже довольно давно. По данным Computer Weekly, очередная встреча по проблеме должна состояться 27 февраля. Ранее крупнейший муниципалитете Европы оказался на грани банкротства из-за неудачных попыток внедрения ERP Oracle Fusion вместо продукта SAP. Несмотря на затраченные ресурсы, для доработки потребуется ещё £45 млн. Представитель совета уже называл систему Oracle «катастрофической». Если начиналось всё довольно оптимистично, то в итоге стоимость реализации выросла с £20 млн до £100 млн (на деле выделено £86 млн), а теперь для решения проблем дополнительно потребуется почти половина от уже потраченной суммы. С начала работы системы в апреле 2022 года наблюдались серьёзные проблемы с процессами и интерфейсами, а также с возможностью предоставлять «значимые отчёты». В частности, система до сих пор некорректно отчитывается о транзакциях и для исправления ошибок нужно немало ручной работы. В результате закрытие финансовой отчётности 2023 года пришлось отложить минимум на шесть месяцев. Под вопросом и корректное прогнозирование, которое тоже потребует дополнительных расходов. Для приведения дел в порядок уже определяли «дедлайн», но соблюсти сроки так и не смогли. £45 млн потребуется потратить в течение двух лет — без учёта текущих операционных расходов на системы Oracle. При этом продолжающиеся проблемы возникают на фоне того, что город фактически является банкротом и нуждается в увеличении налогов. Представитель совета уже назвал финансовое положение «неустойчивым», поскольку в 2024/25 фискальном году дефицит бюджета составит £225,9 млн, а в 2025/26 году — £67,4 млн, что значительно больше, чем ожидалось ранее.

21.02.2024 [13:50], Сергей Карасёв

Supermicro представила ИИ-серверы для периферийных вычисленийКомпания Supermicro анонсировала новые серверы, предназначенные для развёртывания ИИ-приложений на периферии. Дебютировали системы с процессорами Intel Xeon Emerald Rapids, поддерживающие установку различных ускорителей NVIDIA, включая H100. Одной из новинок стал сервер SYS-621C-TN12R семейства CloudDC, выполненный в форм-факторе 2U. Он рассчитан на установку двух чипов Xeon в исполнении Socket E (LGA-4677) с показателем TDP до 350 Вт. Доступны 16 слотов для модулей DDR5-5600 суммарным объёмом до 4 Тбайт. Для ускорителей типоразмера FHHL доступны два слота PCIe 5.0 x16. Есть 12 отсеков для LFF-накопителей NVMe/SATA/SAS и два коннектора для SSD формата M.2 2280 с интерфейсом PCIe 5.0 x4.

Источник изображений: Supermicro Представлен и 1U-сервер SYS-111E-FWTR высокой плотности. Допускается использование одного процессора Xeon в исполнении Socket E с величиной TDP до 350 Вт и восьми модулей DDR5-5600 (до 2 Тбайт). Имеются два слота PCIe 5.0 x16 FHFL, один слот PCIe 5.0 x16 LP, один коннектор M.2 22110/2280 (PCIe 3.0 x2; NVMe) и два посадочных места для SFF-накопителей с интерфейсом SATA-3. Данная модель, как отмечается, подходит для широкого спектра сетевых и периферийных приложений. Схожими характеристиками обладает компактный сервер SYS-E403-13E-FRN2T в форм-факторе блочного ПК: это устройство поддерживает монтаж трёх ускорителей PCIe 5.0 x16 FHFL. Ещё одна новинка — сервер SYS-211E-FRN2T сверхмалой глубины, составляющей 300 мм. От двух предыдущих моделей он отличается тем, что снабжён двумя коннекторами для SSD типоразмера M.2 2280/22110 (NVMe), а слоты расширения выполнены по схеме 1 × PCIe 5.0 x16 или x8 HHHL, 1 × PCIe 5.0 x8 HHHL и 2 × PCIe 5.0 x16 FHHL.  Универсальная система SYS-211SE-31D, в свою очередь, представляет собой трёхузловой сервер стандарта 2U. Каждый узел допускает установку одного чипа Xeon в исполнении Socket E, восьми модулей DDR5-5600, двух ускорителей PCIe 5.0 x16 FHHL, одной карты PCIe 5.0 x16 HHHL и двух модулей M.2 2280/22110 (NVMe). Наконец, дебютировал компактный IoT-сервер SYS-E300-13AD с поддержкой одного процессора Intel Core в исполнении LGA-1700 с величиной TDP до 65 Вт. Предусмотрены два слота для модулей памяти DDR4-3200 суммарным объёмом до 64 Гбайт, один разъём PCIe 5.0 x16 для низкопрофильной карты расширения, одно посадочное место для SFF-накопителя SATA, по одному коннектору М.2 E-Key 2230 (PCIe 3.0 x1 / USB2.0) и М.2 M-Key 2280 (PCIe 4.0 x4; NVMe). Все анонсированные серверы оборудованы воздушным охлаждением.

21.02.2024 [13:46], Сергей Карасёв

RISC-V по-русски: «Микрон» начала продажи микроконтроллера «MIK32 Амур»Компания «Микрон» (входит в ГК «Элемент») сообщила о начале массовых продаж первого полностью отечественного микроконтроллера на открытой архитектуре RISC-V — изделия «MIK32 Амур». Новинка доступна у официальных дилеров и непосредственно на заводе производителя. Решение предназначено для устройств промышленной автоматизации, Интернета вещей (IoT), беспроводной периферии, интеллектуальных сетей, охранных систем, сигнализации, телеметрии, мониторинга, умного дома, управления климатом и освещением и других инфраструктурных систем. В состав «MIK32 Амур» входят ядро RISC-V, однократно программируемая память (ПЗУ на 256 бит), ОЗУ ёмкостью 16 Кбайт, а также ПЗУ (EEPROM; 8 Кбайт). Есть 12-битные АЦП и ЦАП с частотой дискретизации до 1 МГц, датчик температуры, часы реального времени с поддержкой полного календаря. Поддерживается подключаемая внешняя память программ (QSPI Flash) объёмом до 16 Мбайт. Упомянуты интерфейсы SPI, I2C, UART. Реализованы 16- и 32-разрядные таймеры с поддержкой ШИМ, захвата/сравнения сигналов. Диапазон рабочих температур простирается от -40 до +85 °C. Имеется аппаратная поддержка крипто-алгоритмов ГОСТ 34.12–2018 и AES-128.

Источник изображения: «Микрон» Среди преимуществ микроконтроллера производитель выделяет полный цикл производства в России, стабильность поставок и независимость от ограничений на импорт высокотехнологичной продукции, отсутствие зарубежной интеллектуальной собственности и минимальную стоимость среди российских аналогов. Доступна отладочная микроконтроллерная платформа на основе RISC-V. «Микроконтроллер MIK32 Амур — наша первая микросхема общепромышленного применения на архитектуре RISC-V. Тестирование и отладка успешно пройдены, микросхема в серии, и теперь MIK32 Амур доступен у всех дистрибуторов АО "Микрон", в том числе в розничной продаже — у компании "Теллур Электроникс". Действует единая матрица цен для всех дилеров АО "Микрон", основанная на объёме годовой квоты потребителя», — отмечает директор по продуктам АО «Микрон». |

|