Материалы по тегу: ии

|

11.12.2025 [12:38], Сергей Карасёв

«Карманный ИИ-суперкомпьютер» Tiiny AI Pocket Lab справляется с LLM, насчитывающими до 120 млрд параметровАмериканский стартап Tiiny AI представил устройство AI Pocket Lab: это, как утверждается, самый компактный в мире персональный суперкомпьютер для задач ИИ. Он способен работать с большими языковыми моделями (LLM), насчитывающими до 120 млрд параметров: при этом не требуется подключение к облачным сервисам. Устройство заключено в корпус с размерами 142 × 80 × 25,3 мм, а вес составляет около 300 г. Применён процессор с 12 вычислительными ядрами на архитектуре Armv9.2. Кроме того, задействован нейромодуль dNPU. Общий объём памяти LPDDR5X составляет 80 Гбайт, из которых 32 Гбайт приходится на CPU и 48 Гбайт — на dNPU. В оснащение входит SSD вместимостью 1 Тбайт. Типовое энергопотребление находится на уровне 65 Вт.

Источник изображений: Tiiny AI Суммарная заявленная ИИ-производительность достигает 190 TOPS: из них примерно 30 TOPS обеспечивает CPU, ещё 160 TOPS — блок dNPU. Компьютер ориентирован прежде всего на локальную работу с моделями, насчитывающими от 10 до 100 млрд параметров: подобные решения, как утверждается, удовлетворяют более чем 80% реальных потребностей. Устройство может поддерживать такие функции, как многоэтапное рассуждение, глубокое понимание контекста, агенты ИИ, генерация контента и безопасная обработка конфиденциальной информации без необходимости подключения к удалённым серверам.  Tiiny AI Pocket Lab поддерживает быструю установку популярных открытых ИИ-моделей, включая OpenAI GPT-OSS, Llama, Qwen, DeepSeek, Mistral и Phi. При этом могут развертываться различные ИИ-агенты, например, OpenManus, ComfyUI, Flowise, Presenton, Libra, Bella и SillyTavern. Среди потенциальных пользователей компьютера названы разработчики, исследователи, создатели контента, учащиеся и пр. Новинка будет демонстрироваться в следующем месяце на выставке электроники CES 2026.

10.12.2025 [23:59], Андрей Крупин

МГТУ им. Н. Э. Баумана запустил производство специального оптического волокнаМосковский государственный технический университет имени Н. Э. Баумана сообщил о запуске на территории вуза производственной площадки по серийному выпуску специального оптического волокна — ключевого материала для сенсорных, лазерных и высокоточных измерительных систем. Специализированное оборудование для производства оптического волокна размещено в корпусе «Квантум-парк». Ключевым элементом комплекса является башня вытяжки — вертикальная установка высотой 15 метров, в которой преформа нагревается до температуры размягчения, после чего вытягивается в волокно толщиной до сотен микрон. В процессе контролируются температура, скорость вытяжки, геометрия волокна и параметры защитного покрытия. В вытяжной системе МГТУ им. Н. Э. Баумана задействованы автоматизированные системы управления, обеспечивающие стабильность параметров и высокую точность изготовления продукции.

Источник изображения: пресс-служба МГТУ им. Н. Э. Баумана / bmstu.ru Пусконаладочные работы по запуску производственной площадки были выполнены при участии специалистов Института радиотехники и электроники РАН им. В. А. Котельникова, что обеспечило формирование необходимых компетенций для создания отечественных аппаратных и программных решений в волоконно-оптической области. Что касается размещённой в Бауманке вытяжной системы, то она, по заверениям конструкторов и разработчиков, по техническим характеристикам не уступает зарубежным аналогам. Специальное оптическое волокно в коммерческих объёмах сегодня производят лишь несколько российских организаций. Появление собственной башни вытяжки в МГТУ им. Н. Э. Баумана позволит ежегодно выпускать несколько тысяч километров специального волокна, говорится в заявлении пресс-службы технического университета.

10.12.2025 [20:02], Владимир Мироненко

Intel договорилась о покупке разработчика ИИ-ускорителей SambaNova за $1,6 млрд, но не окончательноРесурсу Wired стало известно о подписании Intel соглашения о покупке ИИ-стартапп SambaNova Systems. Финансовые условия соглашения, которое носит предварительный характер и не имеет обязательной силы, не разглашаются. Впервые о заинтересованности Intel в приобретении стартапа сообщил Bloomberg в конце октября. На тот момент переговоры находились на ранней стадии. Согласно данным ресурса, сумма предполагаемой сделки составляла менее $5 млрд. Что примечательно, генеральный директор Intel Лип-Бу Тан (Lip-Bu Tan) в настоящее время является исполнительным председателем и инвестором SambaNova Systems, сообщили источники The New York Times, знакомые с ситуацией. И он рассказывал о предложениях SambaNova на встречах как минимум с одним крупным клиентом Intel, компанией Dell. Intel Capital, которую сейчас выделяют в отдельную компанию, также инвестировала в SambaNova Systems. Ещё один инвестор SambaNova, японская SoftBank Group, также является крупным инвестором Intel. SambaNova Systems была основана в 2017 году в Пало-Альто (Palo Alto, Калифорния, США) Кунле Олукотуном (Kunle Olukotun), Родриго Ляном (Rodrigo Liang) и Кристофером Ре (Christopher Ré). Олукотун и Ре — профессора Стэнфордского университета. Лян ранее был топ-менеджером в Oracle. По данным PitchBook, к началу 2025 года компания привлекла $1,14 млрд инвестиций. В частности, в 2020 году она получила $250 млн от BlackRock, Intel Capital, венчурной фирмы GV и других инвесторов, а её оценка выросла до $2,5 млрд. В 2021 году SambaNova была оценена в $5 млрд после раунда финансирования в размере $676 млрд, возглавляемого фондом SoftBank Vision Fund 2. С тех пор предполагаемая оценка стартапа снизилась. По данным The Information, BlackRock снизила стоимость своих акций SambaNova на 17 % за последний год. Это, вероятно, сделало компанию целью для Intel, наряду с тем фактом, что Intel отстаёт от остальной части индустрии чипов в производстве ИИ-чипов, отметил Wired. Разработки купленной когда-то Habana едва продаются, а после отказа от Ponte Vecchio, проблем с запуском Falcon Shores и неопределённостью относительно Jaguar Shores у Intel практически не осталось «больших» ускорителей. О сделке с Nervana в компании предпочитают не вспоминать. SambaNova разрабатывает ИИ-ускорители на основе реконфигурируемого блока обработки данных (Reconfigurable Dataflow Unit, RDU). 5-нм ускоритель SN40L, представленный более двух лет назад, имеет 1040 ядер RDU, обеспечивающих производительность до 653 Тфлопс в режиме BF16. Он оснащён 520 Мбайт SRAM, 64 Гбайт HBM3 с внешним DDR5-массивом объёмом 1,5 Тбайт для размещения LLM. Компания фактически отказалась от попыток конкурировать с NVIDIA в задачах обучения ИИ. Вслед за Groq она переключилась на инференс и поставку готовых ИИ-платформ вместо продажи ускорителей. UPD 13.12.2025: по данным Bloomberg, переговоры между компаниями значительно продвинулись — Intel готова приобрести SambaNova за $1,6 млрд с учётом долгов последней. Если сделка состоится, она станет первой крупной покупкой «синих» под руководством Лип-Бу Тана.

10.12.2025 [18:14], Руслан Авдеев

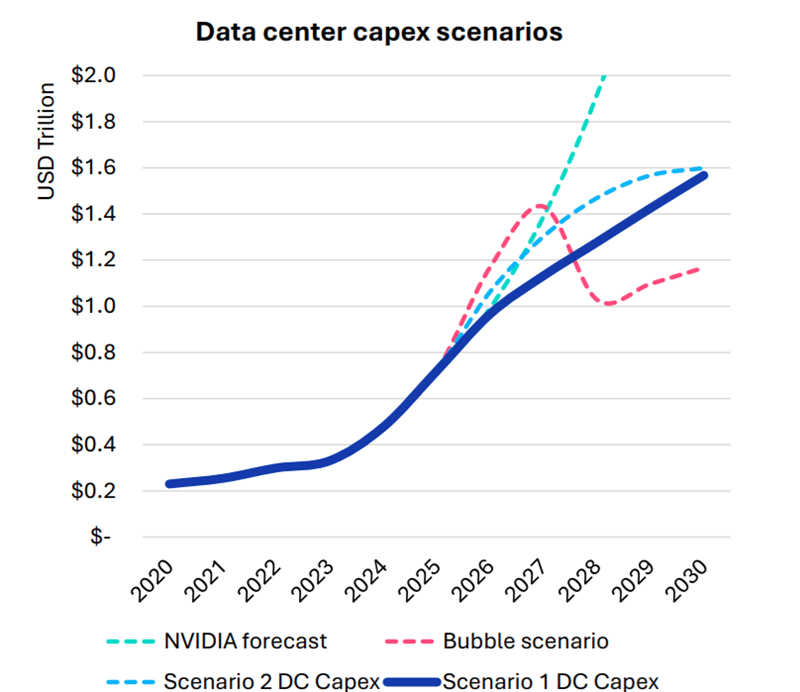

Omdia: капитальные затраты на ЦОД вырастут до $1,6 трлн к 2030 году — если раньше не лопнет ИИ-пузырьСогласно прогнозам аналитиков Omdia, капитальные затраты на дата-центры будут расти на 17 % ежегодно до 2030 года. В итоге они достигнут $1,6 трлн, а ограничения в цепочках поставок вызовут рост цен на компоненты вычислительной инфраструктуры. В своём последнем обзоре рынка облаков и дата-центров (Cloud and Data Center Market Snapshot) компания сообщила, что инвестиции в ИИ-инфраструктуру продолжают расти быстрыми темпами, хотя разговоры о том, что на рынке формируется готовый лопнуть пузырь, не утихают. Впрочем, уровень внедрения ИИ пока остаётся относительно низким, в будущем ожидается, что вырастет как количество пользователей, так и средняя интенсивность использования ими ИИ-инструментов. В то же время ИИ-модели становятся всё более громоздкими и используют больше вычислительных ресурсов для инференса. В результате операторы наращивают производительность инфраструктуры. Вместе с этим растёт потребление электроэнергии, увеличивается энергетическая плотность серверов, стоек и самих дата-центров. Окупятся ли все эти гигантские инвестиции, никто пока точно сказать не может. Bain & Company полагает, что к 2030 году доходы отрасли должны вырасти до $2 трлн/год, чтоб окупить прогнозируемый уровень инвестиций. Окупаемость затрат под вопросом как для поставщиков услуг, так и для пользователей. Как сообщает The Register, на днях представители ряда технологических компаний заявили, что ИИ — не пузырь, не находя аналогий с крахом «доткомов».

Источник изображения: Omdia Omdia рассмотрела четыре сценария развития рынка:

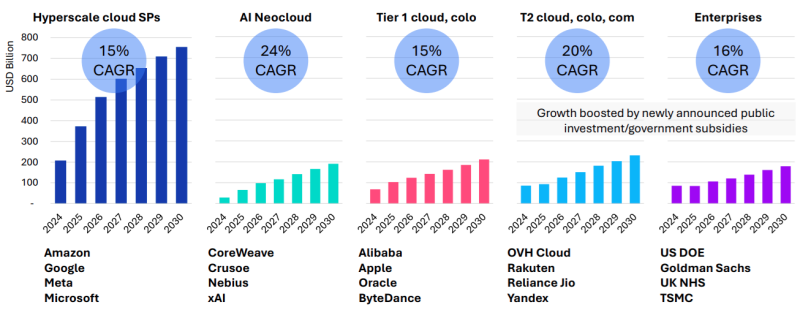

Рост расходов на ЦОД обусловлен и увеличением поставок серверов, цикл обновления которых начался в 2025 году и продолжится 6–8 кварталов. Ранее Omdia сообщала, что крупные операторы ЦОД, в основном гиперскейлеры, откладывали замену серверов разных типов. Новые серверы способны заменить оборудование сразу нескольких поколений. При этом ожидается, что к 2030 году серверы с Blackwell будут ещё в ходу. Рост инвестиций ожидается во всех сегментах, включая ниши неооблаков (CoreWeave, Nebius, xAI и др.), колокейшн-провайдеров первого и второго уровней, гиперскейлеров и корпоративных пользователей.

Источник изображения: Omdia Ограничения в цепочках поставок ведут к росту стоимости некоторых компонентов, например, памяти. По данным источников The Register, это, вероятно, приведёт к росту цен на серверы на 15 %. Omdia утверждает, что новые ЦОД, вероятно, будут проектироваться не так, как сегодня — спрос на ИИ приводит к быстрой смене внутренней инфраструктуры. Это касается всех компонентов, от микросхем до серверов и стоек, систем терморегуляции, распределения энергии, резервного питания и др. В докладе имеются рекомендации на будущее как для вендоров, так и для пользователей. Кроме того, Omdia прогнозирует, что, несмотря на спекуляции относительно ИИ-пузыря, быстрое внедрение ИИ-технологий и инвестиции продолжатся, а мощности по-прежнему будут в дефиците.

10.12.2025 [14:27], Руслан Авдеев

«Сверхзвуковая» газовая турбина Boom Superpower запитает ИИ ЦОДBoom Supersonic, занимающаяся строительством коммерческих сверхзвуковых самолётов, представила газовую турбину Superpower мощностью 42 МВт. Она предназначена для генерации электроэнергии для дата-центров, а первым покупателем стала Crusoe, строящая ИИ ЦОД для проекта OpenAI Stargate, которая заказала 29 турбин Superpower общей мощностью 1,22 ГВт. По имеющимся данным, портфолио заказов на Superpower превышает $1,25 млрд. Дополнительно Boom привлекла $300 млн новых инвестиций в ходе раунда серии B, возглавленного Darsana Capital Partners. Также в нём приняли участие Altimeter Capital, ARK Invest, Bessemer Venture Partners, Robinhood Ventures и Y Combinator. Boom Supersonic объявила, что выручка от продажи турбин Superpower поможет профинансировать сертификацию сверхзвукового пассажирского самолёта Overture, а также разработку двигателя Symphony. Он будет использоваться как в самолёте, так и в генераторах. Сегодня портфолио заказов Boom на пассажирские самолёты составляет 130 ед., в т.ч. для United, American и Japan Airlines. Испытания ключевых компонентов двигателя начнутся в 2026 году на площадке Boom в Колорадо. В компании подчёркивают, что сверхзвуковые технологии стали не только решением для быстрых полётов, но и «ускорителем» ИИ-решений. В турбине Superpower применяются те же ключевые решения, что и в двигателе Symphony. В том числе применяются материалы, готовые работать в экстремальных режимах, и архитектура высокого давления, доработанная для стабильной работы даже во время пиковых температурных нагрузок. В отличие от многих других турбин авиационного типа, Superpower обеспечивает мощность 42 МВт даже при температуре окружающей среды выше 43,3 °C, говорит компания. Турбина работает без воды и может быть размещена в контейнере, что позволяет эксплуатировать её в удалённых регионах. Boom рассчитывает выйти к концу десятилетия на выпуск турбин общей мощностью более 4 ГВт/год. По данным Converge! Digest, Boom Supersonic занимается разработкой сверхзвуковых пассажирских самолетов с 2014 года. Она начинала с концепт-проектов Overture и создания демонстрационного образца XB-1. После того, как традиционные поставщики силовых установок отказали в разработке двигателя под требования компании, она начал реализацию собственной программы Symphony в 2022 год. Superpower — попытка монетизировать «ядро» своего высокотемпературного двигателя на раннем этапе его разработки, тем самым снизив зависимость от внешнего финансирования. Если компании удастся масштабировать поставки турбин и выдержать график испытаний авиадвигателя Symphony в 2026 году, стратегия создания двигателя двойного назначения может стать промежуточным этапом на пути окончательной сертификации авиалайнера Overture. Благодаря этому Boom Energy сможет войти в число немногих компаний, одновременно пытающихся создать и коммерческий самолёт нового поколения, и развивать масштабируемый бизнес по созданию энергетических решений для промышленности и ЦОД. Crusoe работает и с другими компаниями, применяющими сходные технологии. Ещё в июле появилась новость, что она заказала у GE Vernova 29 газовых турбин LM2500XPRESS для ИИ ЦОД Stargate. Они построены на основе авиационных двигателей General Electric LM2500, адаптированных для наземного использования. ProEnergy поступает ещё проще, адаптируя десятки старых авиадвигателей к работе на земле.

10.12.2025 [13:37], Руслан Авдеев

Экоактивисты призвали США немедленно остановить строительство всех ИИ ЦОДАктивисты более 230 организаций из США подписали воззвание к местным конгрессменам, призывая ввести мораторий на строительство дата-центров. Они утверждают, что нынешний бум представляет огромную экологическую и социальную угрозу, сообщает The Register. В открытом письме Конгрессу США активистами Food & Water Watch выражено недовольство тем, что расширение ЦОД, вызванное ростом интереса к ИИ, требует большего количества энергии. Это ведёт к росту выбросов парниковых газов, истощению водных ресурсов и росту цен на электричество для рядовых потребителей. Представители организаций, оставивших подписи под письмом, утверждают, что совокупно представляют интересы миллионов жителей 50 штатов США. Конгресс призывают приостановить строительство новых дата-центров до тех пор, пока не примут адекватные меры по защите населения и окружающей среды от уже наносимого ущерба. Сегодня инвестиции в ЦОД достигли исторического максимума, их основным драйвером является ИИ. По оценкам Omdia, к концу 2025 года мировые затраты на дата-центры превысят $657 млрд, это почти вдое больше, чем два года назад — лидером остаются США. В одной только Вирджинии мощность ЦОД гиперскейлеров превышает мощность дата-центров всего Китая или Европы целиком. Во II половине 2024 года эти ЦОД потребовали вдвое больше энергии, чем в предыдущие шесть месяцев. Потребление воды ЦОД за последние пять лет выросло почти на ⅔. За дополнительные генерирующие мощности и сопутствующую инфраструктуру придётся платить простым американцам. Ранее эксперты уже предупреждали о том, что к 2030 году счета на электричество в США могут вырасти на 70 %. Кроме того, в ноябре выяснилось, что некоторые штаты не сообщают своим гражданам о субсидиях, выделяемых для привлечения новых ИИ-компаний, т.е. фактически финансирование осуществляется за счёт налогоплательщиков. Более того, строительство новых ЦОД ведёт к увеличению выбросов парниковых газов — Microsoft и Google открыто признают, что за последние десять лет уровень загрязнения атмосферы вырос несмотря на обещания добиться нулевых выбросов к концу десятилетия. Спрос на электричество уже спровоцировал возрождение интереса к угольной энергетике — не самого экобезопасного способа получать электричество. Кроме того, проблему усугубляют ЦОД с собственными генерирующими мощностями, например, кластеры xAI. И таких объектов будет всё больше и больше.

Источник изображения: Jan Kopřiva/unsplash.com В Food & Water Watch подчёркивают, что взрывной рост индустрии больших данных является по-настоящему экзистенциальной угрозой для сообществ, не готовых справиться с колоссальными экологическими и экономическими трудностями, создаваемыми дата-центрами. Единственным разумным действием называется остановка бесконтрольного расширения отрасли ЦОД, чтобы сделать передышку и оценить потенциальный вред. Тем временем американские власти соревнуются с Китаем за первенство в сфере ИИ и победить в гонке США смогут, только если будут инвестировать в вычислительные мощности ещё больше. Некоторые политики прямо заявляют, что настоящая экзистенциальная угроза — не изменение климата, а возможность проиграть в «гонке вооружений» в сфере ИИ, если мощностей будет недостаточно. США пообещали устранить препятствия для подключения ЦОД к источникам электроэнергии, а в октябре экономисты отмечали, что инвестиции в ИИ — единственное, что удерживает экономику США от рецессии. При этом в индустрии ЦОД прекрасно осознают, что гигантские проекты по нраву далеко не всем. Впрочем, участники индустрии согласны не в том, что отрасли нужны перемены, а в том, что общественность стоит лучше информировать о настоящей работе дата-центров, отраслях, зависящих от ИИ и др. — люди должны воспринимать ЦОД как объекты, необходимые как вода или электричество.

10.12.2025 [13:18], Сергей Карасёв

«Гравитон» представил SmartNIC SNC-QSFP2-SH01 с FPGA, 100GbE-портами и слотом SO-DIMMКомпания «Гравитон», российский производитель вычислительной техники, анонсировала сетевой адаптер SNC-QSFP2-SH01 класса SmartNIC, предназначенный для использования в дата-центрах. Устройство обеспечивает аппаратное ускорение различных сетевых функций. В основу решения положена неназванная ПЛИС, которая насчитывает свыше 1 млн логических ячеек и содержит более 50 Мбит встроенной блочной памяти. Адаптер может нести на борту до 32 Гбайт оперативной памяти DDR4. Также упоминается отечественный центральный микроконтроллер первого уровня. Карта оснащена двумя 100GbE-портами QSFP28, что, впрочем, видится избыточным, поскольку используемое подключение PCIe 3.0 x8 не способно «прокачать» столько трафика. За охлаждение отвечают радиатор и вентилятор тангенциального типа. Заявлена поддержка библиотек DPDK и совместимость с платформами Linux и Windows Благодаря возможности реконфигурирования FPGA адаптер может использоваться для решения широкого спектра задач. Среди них названы ускорение работы облачных сервисов, виртуализация, проверка сетевых пакетов по их содержимому (DPI) для регулирования и фильтрации трафика, межсетевые экраны нового поколения (NGFW). Изделие также может применяться в комплексных решениях в сфере кибербезопасности для поиска и устранения угроз в сетевом трафике.

Источник изображения: «Гравитон» «Использование архитектуры на базе ПЛИС позволило нам создать устройство, которое не просто передаёт пакеты, а берёт на себя ресурсоёмкие вычисления: от балансировки нагрузки до глубокой инспекции пакетов. Мы предлагаем рынку мощный инструмент, который поможет оптимизировать работу облачных сервисов и систем информационной безопасности, высвобождая ресурсы CPU для прикладных задач», — говорит «Гравитон».

10.12.2025 [12:56], Руслан Авдеев

Сплошные «спекулянты»: ЦОД резервируют избыточные мощности электросетей, не пуская остальных потребителейДата-центры мешают подключениям к электросетям новых потребителей энергии. Дело в том, что они «резервируют» гораздо больше мощностей, чем это действительно необходимо, сообщает The Register со ссылкой на доклад Uptime Institute. Выяснилось, что энергопотребление ЦОД со временем меняется мало, а заметное изменение спроса обычно связано с расширением бизнеса. При этом операторы регулярно «резервируют» избыточные мощности для потенциального роста в будущем. Это блокирует доступ к фактически свободным в текущий момент мощностям другим пользователям. При этом операторы энергосетей не могут расширять инфраструктуру без разрешения регуляторов, а процесс рассмотрения заявок довольно длительный. Мощности же между клиентами распределяются строго по очереди. В результате застройщики ЦОД резервируют мощности, которые могут не потребоваться никогда, на всякий случай запрашивают побольше, чтобы компенсировать возможный рост проектов в будущем. Проблемы обостряются из-за электрификации транспорта и промышленности. Особую роль играют ИИ ЦОД, поскольку, в отличие от обычных, у них есть времена пиковых нагрузок с частыми, весьма большими колебаниями мощности. При этом ИИ ЦОД всё чаще поддерживаются на государственном уровне, хотя есть и позитивные примеры. Так, власти Великобритании представили пакет реформ в рамках проекта Delivering AI Growth Zones, где исключаются т.н. спекулятивные заявки на присоединение — такие заявки были одобрены, отменять их заявитель не собирается, но и ввод объектов в эксплуатацию не происходит. При этом правительство подтвердило, что счета за электричество для частных лиц вырастут, чтобы помочь финансированию расширения электросетей. В США принимают собственные меры. Министерство энергетики (DoE) страны ввело правило, ограничивающее сроки рассмотрения обращений о подключении до 60 дней. Также вводятся залоги и штрафы за отзыв заявок для борьбы со спекулятивными проектами. Теперь приоритет отдаётся заявителям, согласным на возможное сокращение энергопотребления — уменьшить или временно прекратить его можно будет при необходимости стабилизации энергосети. Ускорить доступ к сетям могут гибкие соглашения, в рамках которых пользователи соглашаются с управлением спросом и выполняют технические требования, например — о мониторинге в режиме реального времени со стороны оператора сети. В отчёте Uptime Institute также предупреждает, что ЦОД могут терять от 10 % ёмкости своих источников бесперебойного питания (ИБП) из-за «заблокированной» мощности, когда электрическая инфраструктура построена, но фактически не используется IT-оборудованием или вспомогательными системами. В целом аналитики предсказуемо пришли к выводу, что на фоне роста нагрузки на электросети по всему миру операторы дата-центров должны стремиться к эффективному использованию зарезервированных мощностей. Им рекомендуется привлекать операторов электросетей, чтобы минимизировать возможные проблемы, и рассматривать заключение гибких соглашений, позволяющих ускорить доступ в местностях с перегруженной энергетической инфраструктурой.

10.12.2025 [12:42], Владимир Мироненко

По итогам IPO «Базис» привлёк 3 млрд рублей, а оценка капитализации составила 18 млрд рублей«Базис», российский разработчик ПО управления динамической ИТ-инфраструктурой, объявил об успешном проведении первичного публичного предложения (IPO), в рамках которого он привлёк 3 млрд руб. при оценке рыночной капитализации в размере 18 млрд руб. Всего было реализовано 27,52 млн акций по цене 109 руб., то есть по верхней части утверждённого ценового диапазона предложения. Следует отметить, что это было первое IPO в отечественной софтовой отрасли за последний год. 39 % акций было предложено институциональным инвесторам, 61 % — розничным инвесторам. Цена IPO была установлена действующими миноритарными акционерам, которые сохранили по завершению первичного размещения участие в акционерном капитале группы. Мажоритарный акционер РТК-ЦОД (контролируется ПАО «Ростелеком») не продавал принадлежащие ему акции, сохранив долю в 50,3 % в капитале «Базиса». По итогам IPO доля акций «Базиса» в свободном обращении (free-float) составит 16,7 % от акционерного капитала. Торги акциями «Базиса» на Московской Бирже под тикером BAZA и ISIN RU000A10CTQ0 начнутся 10 декабря в 16:00 по московскому времени. Акции включены в котировальный список второго уровня Московской Биржи. В рамках механизма стабилизации до 10 % от общего количества акций в рамках объёма предложения (2,752 млн акций) могут быть приобретены на открытом рынке в период до 30 дней с момента начала торгов. Агентом по стабилизации выступает ООО «ВТБ Капитал Трейдинг». По словам гендиректора «Базиса», спрос со стороны институциональных и розничных инвесторов подтвердил доверие к стратегии группы, качеству продуктовой экосистемы и потенциалу рынка: «Наш фокус — импортоопережение и международная экспансия: мы видим значимый потенциал на рынках Латинской Америки и Африки, где востребованы надёжные и конкурентоспособные технологические платформы».

10.12.2025 [10:42], Сергей Карасёв

«Гравитон» выпустил Edge-сервер С2062И на платформе «Тундра» с чипами Intel Xeon Cascade Lake-SPРоссийский производитель вычислительной техники «Гравитон» сообщил о доступности сервера С2062И семейства Edge, предназначенного для решения различных задач на периферии. Устройство, в частности, подходит для создания систем обеспечения безопасности, IoT-платформ, телекоммуникационных решений и пр. Сервер, о подготовке которого впервые сообщалось ещё в 2024 году, выполнен в форм-факторе 2U на платформе «Тундра»: задействована материнская плата собственной разработки типоразмера E-ATX на наборе логики Intel C621. Допускается установка двух процессоров Intel Xeon поколения Cascade Lake-SP в исполнении LGA 3647. Доступны 16 слотов для модулей оперативной памяти DDR4 суммарным объёмом до 2 Тбайт. Устройство оснащено пятью слотами PCIe 3.0 х16 и одним разъёмом PCIe 3.0 x8.

Источник изображений: «Гравитон» Во фронтальной части располагаются шесть отсеков для SFF-накопителей SATA/SAS с возможностью горячей замены. Есть контроллер Aspeed AST2500, четыре сетевых порта 1GbE и выделенный сетевой порт управления 1GbE. На лицевой панели, помимо пяти гнёзд RJ45, находятся четыре порта USB 3.0, аналоговый интерфейс D-Sub и последовательный порт.  Сервер оборудован съёмной передней панелью с противопылевым фильтром. Установлены два блока питания с резервированием мощностью 800 Вт. Устройство оптимизировано для работы в условиях ограниченного пространства. Говорится о совместимости с различными отечественными операционными системами, включая RedOS, «Альт Линукс», Astra Linux и др. Модель С2062И внесена в реестр Минпромторга России. |

|