Материалы по тегу: ии

|

12.12.2025 [17:21], Руслан Авдеев

Никаких закладок: NVIDIA анонсировала новое ПО для мониторинга и продления жизни ИИ-ускорителей в ЦОД

dcim

nvidia

open source

software

амортизация

ии

мониторинг

охлаждение

цод

электропитание

энергоэффективность

NVIDIA разрабатывает новое открытое ПО, благодаря которому операторы ЦОД смогут получать более подробные данные о тепловом состоянии и иных параметрах работы ИИ-ускорителей. Предполагается, что это поможет решать проблемы, связанные с перегревом оборудования и его надёжностью, увеличив его срок службы и производительность. NVIDIA отдельно подчёркивает, что телеметрия собирается только в режиме чтения без слежки за оборудованием, а в ПО нет «аварийных выключателей» и бэкдоров. Да и в целом использование новинки опционально. ПО обеспечивает операторам ЦОД доступ к мониторингу потребления энергии, загрузки, пропускной способности памяти и других ключевых параметров в масштабах всего парка ускорителей. Это помогает выявлять на ранних стадиях риски и проблемные компоненты и условия работы, отслеживать использование ИИ-ускорителей, их конфигурации и ошибки. Детализированная телеметрия становится всё важнее для планирования и управления масштабными инфраструктурами, говорит компания. ПО позволит:

Такой мониторинг особенно важен на фоне недавнего отчёта учёных Принстонского университета, в котором сообщается, что интенсивные тепловые и электрические нагрузки способны сократить срок службы ИИ-чипов до года-двух, хотя обычно предполагается, что они способны стабильно проработать до трёх лет. Современные ускорители потребляют 700 Вт и более, а высокоплотные системы — от 6 кВт. Из-за этого формируются зоны перегрева, происходят колебания энергопотребления и растёт риск деградации интерконнектов в высокоплотных стойках. Телеметрия, позволяющая оценить потребление энергии в реальном времени, состояние интерконнектов, систем воздушного охлаждения и др. позволяет перейти от реактивного мониторинга к проактивному проектированию. Рабочие нагрузки можно размещать с учётом теплового режима, быстрее внедрять СЖО или гибридные системы охлаждения, оптимизировать работу сетей с уменьшением тепловыделения. Также ПО может помочь операторам ЦОД выявлять скрытые ошибки, вызванные несоответствием версий прошивки или драйверов. Благодаря этому можно повысить общую стабильность парка ускорителей. Кроме того, без задержек передаваемые данные об ошибках и состоянии компонентов могут значительно сократить среднее время восстановления работы и упростить анализ причин сбоев. Соответствующие данные могут влиять на решения о тратах на инфраструктуру и стратегию её развития на уровне предприятия.

Источник изображения: NVIDIA Как заявляют в Gartner, современный ИИ представляет собой «энергоёмкого и сильно нагревающегося монстра», разрушающего экономику и принципы работы ЦОД. В результате, предприятиям нужны специальные инструменты мониторинга и управления для того, чтобы ситуация не вышла из-под контроля. В ближайшие годы использование подобных решений, вероятно, станет обязательным. Кроме того, прозрачность на уровне всего парка оборудования становится необходимой для обоснования роста бюджетов на ИИ-инфраструктуру. По словам экспертов, такие программные инструменты позволяют оптимизировать капитальные и операционные затраты на ЦОД и инфраструктуру, запланированные на ближайшие годы. «Каждый доллар и каждый ватт» должны быть учтены при эффективном использовании ресурсов.

12.12.2025 [15:43], Владимир Мироненко

В МФТИ изучили альтернативы ИИ-ускорителям NVIDIA — китайские Moore Threads и MetaX оказались неплохиВ связи с прекращением поставок в Россию ускорителей NVIDIA, ограничениями на загрузку драйверов и отсутствием их техподдержки Институт искусственного интеллекта МФТИ провёл исследование рынка альтернативных ускорителей, включая продукты китайских производителей Moore Threads и MetaX с целью оценки их способности обеспечить полный цикл работы современных ИИ-моделей. Исследование включало анализ архитектурных особенностей ускорителей, драйверов, совместимости с фреймворками и тестирование под нагрузкой при работе с LLM, инференсом, задачами компьютерного зрения и распределённых вычислений. Проведена оценка скорости и воспроизводимости вычислений, устойчивости при росте нагрузки и стабильности поведения моделей на разных типах ускорителей. Исследователи пришли к выводу, что ускорители Moore Threads s4000 и MetaX C500 могут применяться в широком спектре сценариев, обеспечивая стабильный запуск популярных LLM, корректную работу современных фреймворков, предсказуемую производительность и устойчивость работы при длительных нагрузках. В отдельных типах вычислений альтернативные ускорители не уступали или даже обгоняли NVIDIA A100. Особое внимание было уделено возможности работы альтернативных ускорителей в составе вычислительных узлов и кластеров. Разработанный стек ПО позволяет эффективно распределять ресурсы, объединять мощности для работы с крупными моделями и создавать кластерные конфигурации, сообщили в МФТИ. В МФТИ планируют и дальше тестировать новые поколения ускорителей, расширив перечень поддерживаемых моделей, а также намерены подготовить отраслевые рекомендации для создания автономной ИИ-инфраструктуры. На основе исследования в МФТИ был создан Центр компетенций по решениям, не зависящим от NVIDIA, который объединяет лучшие инженерные практики, методики тестирования, оптимизированные конфигурации и опыт взаимодействия с поставщиками. Он будет оказывать помощь компаниям в подборе оборудования, проведении нагрузочного тестирования под конкретные задачи, настройке вычислительных цепочек, а также может сопровождать платформы в процессе эксплуатации.

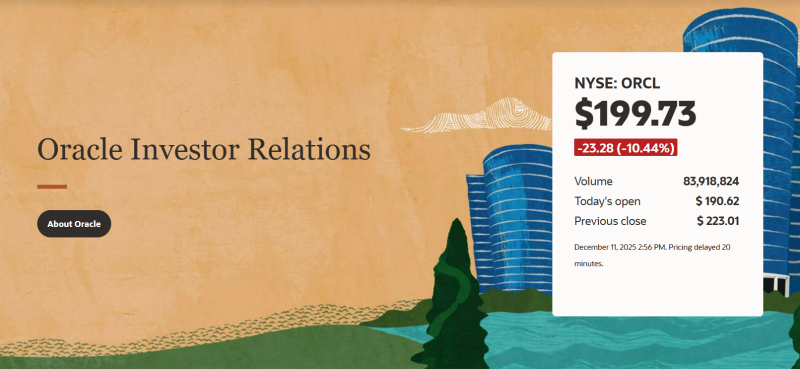

12.12.2025 [00:25], Владимир Мироненко

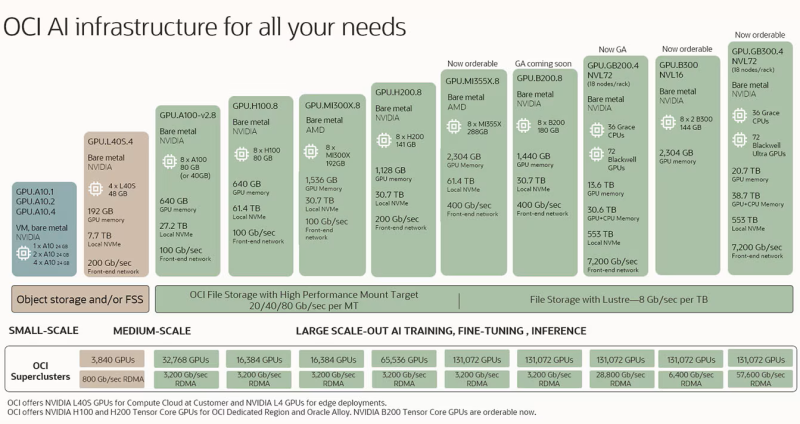

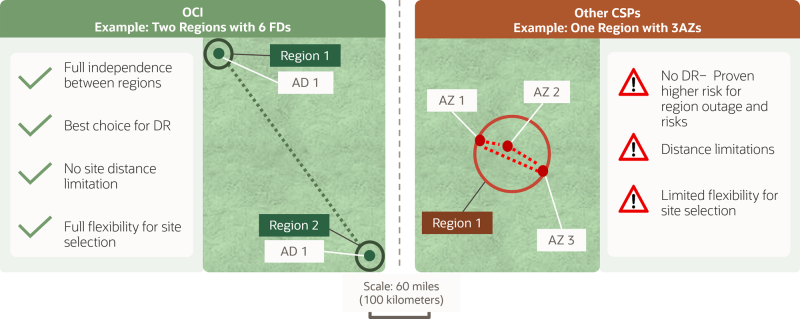

Акции Oracle показали рекордное с 2001 года падение, потянув за собой других игроков ИИ-рынкаOracle объявила результаты за II квартал 2026 финансового года, завершившегося 30 ноября. Выручка и операционная прибыль компании не оправдали ожиданий аналитиков. При этом компания повысила прогноз по расходам, что усилило опасения инвесторов по поводу её возможностей извлечь выгоду из огромного спроса ИИ-индустрии на вычислительные мощности, отметил The Wall Street Journal. В связи с этим её акции упали более чем на 11 % на внебиржевых торгах, показав в итоге самое серьёзное падение в течение дня с 2001 года. По итогам торгов в среду акции потеряли примерно треть от своей пиковой стоимости в сентябре, когда акции компании показали рекордный за 26 лет рост. Падение акций Oracle подтолкнули к падению акции других участников рынка. Акции AMD и NVIDIA упали примерно на 1 % каждая, а акции облачного провайдера CoreWeave снизились более чем на 3 % (по данным CNBC). Компания сообщила о скорректированной прибыли (Non-GAAP) за II квартал в размере $2,26 на разводнённую акцию, что значительно выше целевого показателя Уолл-стрит в $1,64 на акцию согласно консенсус-прогнозу LSEG. Вместе с тем выручка компании, несмотря на рост на 14 % по сравнению с аналогичным периодом прошлого года, до $16,06 млрд, оказалась ниже прогноза аналитиков в $16,21 млрд. Чистая прибыль (GAAP) увеличилась до $6,14 млрд, или $2,10 на разводнённую акцию, с $3,15 млрд, или $1,10 годом ранее. Выручка от облачных услуг составила $7,98 млрд, что превысило консенсус-прогноз аналитиков, опрошенных StreetAccount, в $7,92 млрд. Выручка от облачной инфраструктуры (OCI IaaS) составила $4,1 млрд, увеличившись на 68 %. Выручка от облачных приложений (OCI SaaS) равна $3,9 млрд (+11 %). Выручка от интегрированных облачных решений (SaaS) — $1,1 млрд (+18 %), выручка от NetSuite Cloud ERP (SaaS) — $1 млрд (+13 %). Выручка от разработки ПО снизилась на 3 % до $5,88 млрд, что ниже среднего прогноза аналитиков в $6,06 млрд. Продажи оборудования выросли на 7 % до $776 млн, сервисы принесли компании $1,43 млрд (+7 %). Oracle рассчитывает повысить маржинальность OCI на 30–40 %. Объём оставшихся обязательств по контрактам (RPO) вырос год к году на 438 % до $523 млрд, что выше среднего прогноза аналитиков в $501,8 млрд (согласно данным StreetAccount). Рост был вызван «новыми обязательствами от Meta✴, NVIDIA и др. компаний», сообщил в пресс-релизе главный финансовый директор Oracle Дуг Керинг (Doug Kehring). По его словам, с учётом новых обязательств, Oracle теперь планирует капитальные затраты на весь год в размере около $50 млрд, по сравнению с $35 млрд по состоянию на сентябрь. Капзатраты за 2025 финансовый год составили $21,2 млрд. Для сравнения: годовые капзатраты AWS ожидаются на уровне $125 млрд, Google — $91–$93 млрд, Meta✴ — $70–$72 млрд (а в перспективе $600 млрд), Microsoft — $80 млрд (и до $120 млрд в 2026 финансовом году), а у Alibaba Cloud, не имеющей свободного доступа к передовым ускорителям NVIDIA — $16 млрд. Здесь учитываются несколько разные периоды, но порядок затрат виден. Объявление в сентябре о том, что портфель заказов Oracle вырос до $455 млрд, привело к резкому росту акций компании. Однако с тех пор их цена упала из-за опасений по поводу уровня риска, который Oracle берёт на себя, развивая свою инфраструктуру. По данным The Register, в ноябре Oracle акции упали на 23 % — в начале месяца они стоили около $250, а в конце — около $200. Керинг попытался успокоить инвесторов, пояснив, что у компании имеется доступ к капиталу из нескольких источников, включая государственные облигации, банки и частные рынки долгового финансирования. «Кроме того, существуют и другие варианты финансирования через клиентов, которые могут предоставлять свои собственные чипы для установки в наших ЦОД, и поставщиков, которые могут сдавать свои чипы в аренду, а не продавать их», — пояснил он, добавив, что оба варианта позволяют Oracle синхронизировать её платежи с поступлениями средств и занимать значительно меньшие суммы, чем предполагают большинство аналитиков. Кроме того, Oracle отличается от «большой тройки» гиперскейлеров тем, что занимается строительством и развёртыванием ЦОД преимущественно после подтверждения обязательств клиентов. Следует отметить, что это была первая квартальная конференция по финансовым итогам с участием новых со-генеральных директоров Oracle, Клея Магуйрка (Clay Magouyrk) и Майка Сицилии (Mike Sicilia), которые заняли этот пост после ухода Сафры Кац (Safra Catz) в сентябре. В своём выступлении Сицилия отметил появление новых крупных клиентов облака OCI, в том числе Airbus, Deutsche Bank, LSEG, Panasonic, Canon и Rubrik. Аналитик Valoir Ребекка Веттеманн (Rebecca Wettemann) назвала в интервью ресурсу SiliconANGLE весьма показательным то, что он счёл необходимым подчеркнуть такое количество успешных сделок с клиентами. «Рынок был очень обеспокоен чрезмерной зависимостью Oracle от OpenAI и других проектов в области ИИ с точки зрения RPO и прогнозов, поэтому этот список успешных сделок с клиентами и ускорения роста приложений демонстрирует некоторое долгожданное разнообразие, что, безусловно, является позитивным фактором», — пояснила она. Веттеманн назвала хорошей новостью для Oracle и её стратегии капитальных затрат увеличение капвложений, поскольку она пытается занять центральное место в буме ИИ. Некоторые инвесторы обеспокоены огромным долгом, который она взяла на себя для своих инвестиций. Значительная часть портфеля заказов Oracle приходится на OpenAI Group PBC, которая обязалась потратить более $300 млрд на облачные инфраструктурные сервисы Oracle в течение следующих пяти лет. «Чем дольше портфель заказов остается невостребованным, тем выше риск того, что Oracle не сможет его монетизировать, или же ландшафт ИИ изменится настолько, что некоторые клиенты не смогут выполнить свои обязательства», — сообщила Веттеманн. Аналитик Constellation Research Хольгер Мюллер (Holger Mueller) отметил, что некоторые инвесторы могли заметить, что рост выручки Oracle происходит за счёт значительных затрат, что приводит к снижению прибыльности по мере увеличения объёмов продаж. Вместе с тем он согласился с финансовым директором по поводу того, что долг, который Oracle берёт на себя, не является проблемой. «При процентных платежах в размере приблизительно $1 млрд долговая нагрузка более чем управляема для компании», — сказал аналитик. Комментируя продажу доли в Ampere, основатель Oracle Ларри Эллисон (Larry Ellison) сказал, что решение было принято, потому что, по его мнению, больше нет смысла продолжать проектировать, производить и использовать собственные микросхемы в своих ЦОД. «Компания привержена политике чиповой нейтральности, — сказал он. — Нам необходимо быть готовыми и иметь возможность использовать любые чипы, которые захотят приобрести наши клиенты». В свою очередь, Клей Магуйрк отметил, что у Oracle более 211 действующих и планируемых облачных регионов по всему миру. Кроме того, компания наполовину завершила строительство 72 мультиоблачных ЦОД, которые будут интегрированы в облака Amazon, Google и Microsoft. «Наш бизнес по мультиоблачным базам данных — самый быстрорастущий бизнес: во II квартале он вырос на 817 %», — сказал он. Также следует обратить внимание на слова Майка Сицилии о том, что у компании «огромные преимущества перед конкурентами в области приложений». «Обучение ИИ и продажа моделей ИИ — это очень крупный бизнес, но мы считаем, что существует еще большая возможность — внедрение ИИ в самые разные продукты», — сообщил Сицилия. — Oracle находится в уникальном положении для внедрения ИИ во все три уровня наших программных продуктов: ПО для облачных ЦОД, ПО для автономных баз данных и аналитики, а также ПО для приложений. Все три направления Oracle уже достаточно масштабны — ИИ сделает их всё лучше и масштабнее». В III финансовом квартале Oracle ожидает скорректированную прибыль (Non-GAAP) на акцию в размере от $1,70 до $1,74 и рост выручки на 19-21 %. Консенсус-прогноз LSEG предполагает прибыль на акцию в размере $1,72 и выручку в размере $16,87 млрд, что подразумевает рост год к году на 19 %.

11.12.2025 [22:26], Андрей Крупин

«Рег.ру» вывел на рынок приватного ИИ-ассистента для работы с конфиденциальными даннымиРаботающая на рынке хостинга, доменов и облачных решений компания «Рег.ру» сообщила о доступности клиентам приватного ИИ-ассистента, реализованного по модели HaaS (Hardware as a Service). Новый продукт призван закрыть потребность бизнеса в использовании генеративного ИИ там, где развёртывание в публичном облаке невозможно из-за нормативных требований или внутренних политик безопасности. В отличие от облачной версии, где ресурсы выделяются из общего пула, приватный ИИ-ассистент функционирует в полностью изолированном контуре. «Рег.ру» берет на себя техническую поддержку инфраструктуры с широким ассортиментом предустанавливаемых open-source ИИ-моделей. Донастройку и интеграцию решения под конкретные бизнес-задачи организации могут выполнять самостоятельно или с привлечением партнёров-интеграторов.

Источник изображения: Steve Johnson / unsplash.com Решение поставляется в виде серверных машин с ускорителями NVIDIA (включая решения H100 и H200 с 80 и 141 Гбайт памяти соответственно, а также карты серий A100, L40S и A6000), на которых размещается образ на базе платформы Ollama с предустановленными ИИ-моделями и веб-интерфейсом. Серверы поддерживают установку до 8 GPU, комплектуются производительными CPU, оперативной памятью до 4 Тбайт и NVMe-накопителями. Архитектура сервиса позволяет проводить аттестацию для соответствия строгим стандартам, включая ФЗ-152 «О персональных данных» и требования ФСТЭК России.

11.12.2025 [17:33], Андрей Крупин

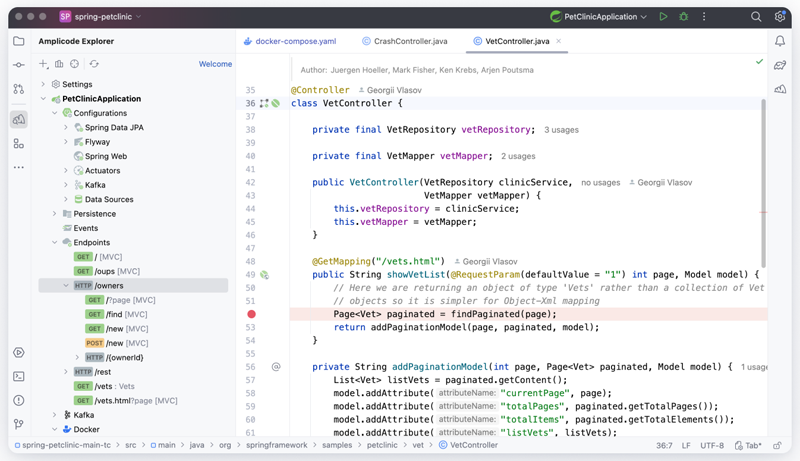

Состоялся анонс OpenIDE Pro — корпоративной версии российской интегрированной среды разработки«Группа Астра», Axiom JDK и Haulmont анонсировали выпуск корпоративной версии отечественной интегрированной среды разработки OpenIDE Pro. Релиз решения ожидается в первом квартале 2026 года. Продукт создаётся как расширенная платформа для компаний, которым необходимы расширенная функциональность, обслуживание по SLA и выделенная техническая поддержка. OpenIDE Pro станет дальнейшим развитием открытой версии Community Edition, которая была выпущена в апреле 2025 года. Особенностью корпоративной редакции среды разработки станет расширенная поддержка языков и платформ. Продукт получит углубленную поддержку Go, охватывающую анализ кода, навигацию, рефакторинг и интеграцию со сборочными инструментами. Для Java станут доступными дополнительные возможности профилирования и анализа приложений. Существенно улучшится работа с JavaScript и TypeScript, что сделает среду удобной для мультистековых команд. В области фронтенд- и веб-разработки OpenIDE Pro обеспечит улучшенную поддержку современных фреймворков, включая React, Vue и Angular, а также предложит встроенные инструменты для Next.js. Разработчики смогут запускать и отлаживать фронтенд-приложения непосредственно из IDE, без дополнительных внешних инструментов.

Источник изображения: openide.ru В составе OpenIDE Pro также будут представлены Database Client для работы с запросами, схемами и данными и HTTP Client — для тестирования API и интеграционных сценариев. Для JVM-процессов будет реализовано встроенное профилирование, позволяющее анализировать поведение приложений в реальном времени. Отдельное внимание будет уделено расширению поддержки Spring на базе Amplicode Pro, которая позволит генерировать Spring Boot-проекты по корпоративным шаблонам, проектировать доменную модель в визуальной форме, автоматически создавать сущности, сервисы, DTO, контроллеры и CRUD-функциональность, а также значительно улучшит навигацию по JPA-сущностям и интеграцию со Spring-инфраструктурой. OpenIDE создаётся с учётом требований по локальному исполнению и отсутствию зависимости от зарубежной инфраструктуры. Все процессы сборки, обновления и хранения данных полностью локализованы. Исходный код пользователей не передаётся во внешние облака, что актуально для организаций с повышенными требованиями к информационной безопасности. Разработка ведётся на базе доверенной российской сборки Java Axiom JDK с помощью российской платформы работы с кодом GitFlic.

11.12.2025 [16:45], Руслан Авдеев

Катар создаёт национальную ИИ-компанию Qai по примеру ОАЭ и Саудовской АравииКатар создаёт собственную национальную компанию для разработки ИИ-технологий и инвестиций в ИИ-проекты. В этом страна присоединится к соседним ОАЭ и Саудовской Аравии, также вкладывающих в ИИ национальные ресурсы, сообщает Bloomberg. Структура, получившее имя Qai, станет дочерним подразделением Катарского инвестиционного управления (Qatar Investment Authority), активы которого составляют $524 млрд. Предполагается, что новая компания будет инвестировать в инфраструктуру ИИ в самом Катаре, и по всему миру, а также предоставлять желающим доступ к HPC и набору связанных инструментов. Пока не уточняется, о каких инструментах идёт речь и сколько средств выделят новой компании. Главой Qai станет бывший член совета директоров Doha Venture Capital и сотрудник канцелярии премьер-министра страны. Он уже заявил, что компания займётся разработкой «надёжных» ИИ-систем. Богатые углеводородами государства Персидского залива активно инвестируют во всевозможные технологии, пытаясь диверсифицировать источники доходов в своих экономиках. В последнее время они пользуются ажиотажем, связанным с ИИ-сервисами, стремясь заработать на чат-ботах, дата-центрах, полупроводниках и энергетике для обеспечения их работы. ОАЭ и Саудовская Аравия запустили многомиллиардные инвестиционные фонды для вложения средств в ИИ-стартапы и создали собственные организации, возглавляющие эти инициативы: G42 в ОАЭ и Humain в Саудовской Аравии. Инвестиционный фонд Катара десятилетиями инвестировал в западные бизнесы и недвижимость от Нью-Йорка до Лондона, недавно средства выделили для нескольких стартапов из Кремниевой долины. В сентябре страна потратилась на поддержку Anthropic в рамках проекта по привлечению $13 млрд для финансирования ИИ-лаборатории.

Источник изображения: Popup Agency/unspalsh.com По словам, сейчас необходимо предоставить инструменты для внедрения ИИ отдельным лицам, корпоративным и иным пользователям и обеспечить доверие к работе искусственного интеллекта. Помимо США и Китая очень немногим странам удалось создать собственные передовые ИИ-модели. Поэтому власти многих государств обеспокоены тем, что сложные ИИ-системы недостаточно «прозрачны» для понимания и контроля. Qai заявила, что не будет заниматься разработкой ИИ-моделей самостоятельно. Вместо этого будет вестись работа над оценкой и коммерциализацией ИИ и связанных технологий вроде ИИ-агентов. Ближний Восток уже весьма привлекателен для ИИ-компаний, включая OpenAI и Microsoft, желающих использовать деньги и дешёвую энергию региона для организации своих вычислений. В ноябре США одобрили продажу десятков тысяч ИИ-ускорителей в ОАЭ (компании G42) и Саудовской Аравии (Humain), несмотря на опасения западных политиков, не желающих попадания технологий в Китай. Катару нужна будет лицензия, чтобы покупать наиболее современные чипы у компаний NVIDIA, AMD и др.

11.12.2025 [14:15], Руслан Авдеев

OpenAI заключила с Deutsche Telecom соглашение о многолетнем сотрудничестве в сфере ИИDeutsche Telecom (DT) заключила стратегическое многолетнее соглашение о партнёрстве с OpenAI. Компании намерены внедрять передовые ИИ-технологии в экосистеме компании, включая внутренние процессы и клиентские сервисы. Пилотные программы стартуют в I квартале 2026 года, сообщает блог IEEE ComSoc. DT намерена внедрить ChatGPT Enterprise в масштабах всей компании, используя ИИ для оптимизации ключевых функций, включая:

Партнёрство способно подкрепить стремление DT стать одним из лидеров европейской облачной ИИ-инфраструктуры, особое внимание уделяется достижению цифрового суверенитета. В числе предыдущих инициатив компании можно отметить создание Sovereign Cloud в 2021 году силами подразделения T-Systems и Google Cloud. В начале 2025 года был предложен пакет T Cloud Suite, обеспечивавший доступ к суверенным публичным, частным и ИИ-облакам с использованием гибридной инфраструктуры. При поддержке NVIDIA начато строительство Industrial AI Cloud в Мюнхене, запуск которого запланирован на I квартал 2026 г. По мнению экспертов, интеграция ИИ-технологий OpenAI усилит позиции DT в роли поставщика полного стека решений для корпоративных клиентов, от связи и ЦОД до специализированного ПО. Эксперты подчёркивают, что ИИ ЦОД в Германии и Европе не особенно много, благодаря чему операторы уровня DT и другие компании могут развиваться в этой нише, не опасаясь сильной конкуренции. В США ИИ ЦОД значительно больше, но попытки телеком-операторов конкурировать с гиперскейлерами на рынке ЦОД провалились. При этом масштаб проектов в США значительно больше.

Источник изображения: Deutsche Telekom По словам представителя Tekonyx, интеграция продуктов OpenAI позволит использовать инструменты разработки на основе ChatGPT для создания проприетарных информационных систем — Operational Support Systems (OSS) и Business Support Systems (BSS), связанных с техническим обеспечением работы сети и бесперебойности бизнес-процессов. Ожидается, что это откроет новые источники дохода, благодаря предложению edge-вычислений корпоративным клиентам, отраслевых ИИ-решений для медицины, ретейла и производства, интегрированных частных 5G-сетей и ИИ-пакетов для промышленных логистических хабов. Подчёркивается, что телеком-операторы могут сыграть значительную роль в организации инференса на периферии, а также хостинге специализированных моделей, которые стоит эксплуатировать поблизости от источника пользовательских данных. Более того, такие операторы будут обеспечивать связью неооблачных провайдеров уровня CoreWeave, Lambda Labs, Digital Ocean, Vast.AI и др. Поэтому OpenAI стремится заранее занять нишу сотрудничества с телеком-бизнесом. По словам других экспертов, такая модель партнёрства особенно перспективна для европейских операторов: Orange, Telefonica и др. При этом воспроизведение модели требует крупных инвестиций и масштабов развёртывания. Новое сотрудничество переводит DT из статуса пользователя ИИ в статус партнёра по разработке. В то же время OpenAI организует взаимодействие и с другими операторами — в Евросоюзе, США, Индии, Южной Корее и др. Например, компания имеет соглашения различного рода с T-Mobile US, SK Telecom, Circles, Rakuten, Orange, Jio и Airtel. Имея более 261 млн клиентов мобильных сервисов по всему миру, Deutsche Telekom имеет мощную основу для масштабного внедрения ИИ. Новое партнёрство с OpenAI знаменует переход компании от пилотных проектов к крупномасштабным продуктам, приносящим пользу всем абонентам.

11.12.2025 [14:05], Руслан Авдеев

Microsoft инвестирует в Индию $17,5 млрд для масштабирования ИИ-инфраструктурыКомпания Microsoft заявила о крупных инвестициях в ИИ-инфраструктуру в размере $23 млрд, большая часть из этих средств предназначена Индии — IT-гигант делает ставку на один из самых быстрорастущих рынков цифровых проектов в мире, сообщает Reuters. Доля индийских инвестиций составит $17,5 млрд — это крупнейшие вложения компании в азиатском регионе. Они станут развитием двухлетнего инвестиционного проекта объёмом $3 млрд. Новый, четырёхлетний план вступает в силу в 2026 году и обеспечит Microsoft самое масштабное присутствие на местном рынке облачных вычислений. Хотя момент не самый удачный из-за некоторой напряжённости между Нью-Дели и Вашингтоном, возникшей из-за торговых пошлин и зашедших в тупик переговорах о торговой сделке. Благодаря наличию в стране порядка 1 млрд интернет-пользователей и обилию IT-специалистов высокой квалификации Индия стала ключевым регионом для американских капиталовложений, техногиганты охотно инвестируют миллиарды долларов в развитие ИИ в стране. Соответствующие ЦОД стали для Индии шансом воспользоваться экономическим бумом на рынке высоких технологий, учитывая то, что её возможности по производству полупроводников пока ограничены. Так или иначе, Microsoft заявила, что новый кампус ЦОД в Хайдарабаде (Hyderabad) станет крупнейшим облачным регионом компании в Индии, включающим три зоны доступности. Как ожидается, его введут в эксплуатацию в середине 2026 года. Также компания расширит три действующих региона в Ченнаи, Хайдарабаде и Пуне. Правда, по данным Datacenter Dynamics, регион в Мумбаи переведён в статус т.н. «reserved access region» с ограниченным доступом. Дополнительно она удвоила январское обещание обучить 20 млн жителей Индии навыкам работы с ИИ до конца десятилетия. Компания интегрирует возможности Azure OpenAI в местные платформы e-Shram и National Career Service (NCS), оптимизируя подбор вакансий, способствуя развитию навыков и др. для более чем 310 миллионов работников. Microsoft также заявила, что инвестирует CA$7,5 млрд ($5,42 млрд) в Канаду в следующие два года. Новые облачные мощности должны ввести в эксплуатацию во II половине 2026 года. Это часть общего плана инвестиций Microsoft в Канаду в объёме CA$19 млрд в 2023–2027 гг. В частности, компания намерена расширить предложение Azure Local в стране. Кроме того, Microsoft взаимодействует с ИИ-стартапом Cohere для предложения передовых ИИ-моделей компании на платформе Azure. В ноябре сообщалось о планах компании инвестировать $10 млрд в ИИ-инфраструктуру в Португалии, а также $15 млрд в ОАЭ. Как прогнозирует консалтинговая компания Colliers, к 2030 году общая мощность ЦОД в Индии вырастет более чем втрое и составит порядка 4,5 ГВт. В Индии на Microsoft работает более 22 тыс. человек, в Канаде — около 5,3 тыс. В октябре Google объявила о намерении инвестировать в строительство ИИ ЦОД в штате Андхра-Прадеш (Andhra Pradesh) $15 млрд за пять лет, это станет крупнейшим вложением гиганта в стране. В январе AWS объявила о намерении вложить в страну $8,3 млрд, а теперь Amazon увеличила инвестиции до $30,5 млрд. В целом, как сообщает Reuters, ожидается, что Microsoft и другие американские облачные провайдеры только в 2025 году более $400 млрд на ИИ-проекты и ЦОД по всему миру.

11.12.2025 [14:05], Руслан Авдеев

Amazon инвестирует $35 млрд в Индию к 2030 году для инноваций в сфере ИИ и создания рабочих местAmazon объявила о намерении вложить более $35 млрд в индийские подразделения компании до 2030 года в дополнение к уже потраченным здесь $40 млрд. Новые инвестиции направят на масштабирование активности и три стратегически важных направления: цифровизацию на основе ИИ, рост экспорта и создание рабочих мест. В отчёте Keystone Strategy говорится, что инвестиции $40 млрд (в т.ч. выплаты сотрудникам и деньги на развитие инфраструктуры) сделали компанию крупнейшим зарубежным инвестором в стране, крупнейшим «катализатором» экспорта с помощью электронной торговли, и одним из ключевых создателей рабочих мест в Индии. Значительные средства затрачены на создание физической и цифровой инфраструктуры, в т.ч. пунктов обслуживания, логистических сетей, дата-центров и инфраструктуры цифровых платежей. По данным Keystone, Amazon оцифровала более 12 млн малых предприятий, помогла увеличению объёма экспорта с помощью электронной коммерции на сумму $20 млрд, а в 2024 году обеспечила порядка 2,8 млн прямых и косвенных рабочих мест в различных отраслях индийской экономики, включая технологическую сферу, логистику, службы поддержки и др. с медицинским страхованием и обучением. В Amazon утверждают, что влияние компании в стране выходит за рамки прямого трудоустройства сотрудников, она обеспечивает рабочие места в сфере упаковки, логистики и сопутствующих технологий, а также даёт возможность развития на своей торговой площадке тысячам малых предприятий. В 2030 году количество прямых и косвенных рабочих мест увеличится до 3,8 млн благодаря расширению бизнеса как самой Amazon, так и растущих сетей пунктов обслуживания и сервисов доставки — одновременно поддерживаются и смежные отрасли. Совокупный объём экспорта, связанный с электронной коммерцией, к 2030 году должен вырасти в четыре раза до $80 млрд.

Источник изображения: pavan gupta/unsplash.com Благодаря дополнительным вложениям $35 млрд Amazon намерена ускорить цифровую трансформацию в стране, укрепить местную инфраструктуру и поддержать инновации. Инвестиции соответствуют приоритетам Индии и направлены на расширение возможностей ИИ, улучшение логистики, поддержку роста малого бизнеса и создание новых рабочих мест. Программа Amazon по внедрению ИИ во все сферы жизни должна помочь преобразовать цифровое пространство страны, поддерживая заявленную государством концепцию «ИИ для всех». К 2030 году Amazon намерена обеспечить преимущества ИИ 15 млн малых предприятий — продавцы на платформе Amazon.in уже используют ИИ-инструменты Seller Assistant, Next Gen Selling и др. Опыт покупок для сотен миллионов покупателей планируется улучшить с помощью инструментов Lens AI (визуальный поиск), интерактивных покупок с помощью Rufus и многоязычных интерфейсов. Также планируется предоставить 4 млн школьников возможности обучиться навыкам работы с ИИ и познакомить их с карьерными возможностями в технологической сфере. Программа включает разработку учебной программы, посвящённой ИИ, экскурсии в технологические компании, практические занятия в «ИИ-песочнице» и обучение самих преподавателей. Инициатива напрямую поддерживает цели Национальной образовательной политики Индии от 2020 года. О том, сколько именно средств выделят на ИИ-инфраструктуру, включая ЦОД AWS, не сообщается. В начале 2025 года AWS выделила $8,3 млрд только на строительство одного облачного региона — AWS Asia-Pacific в Мумбаи (Mumbai). Регион работает с 2016 года, к 2022 году компания инвестировала в него $3,7 млрд. В 2022 году она запустила облачный регион в Хайдарабаде (Hyderabad). Обязательство потратить $8,3 млрд на ЦОД в Мумбаи — часть более обширного инвестиционного плана, в рамках которого AWS намеревалась потратить в Индии $12,7 млрд. Также компания планирует инвестировать $7 млрд в течение 14 лет в облачный регион в Хайдарабаде. Последние новости об Amazon появились вскоре после того, как Microsoft объявила о планах потратить $17,5 млрд на ИИ-инфраструктуру в Индии к 2030 году. В октябре 2025 года Google подтвердила о реализации проекта по строительству кампуса ЦОД в штате Андхра-Прадеш (Andhra Pradesh), планируется потратить $15 млрд за пять лет.

11.12.2025 [12:38], Сергей Карасёв

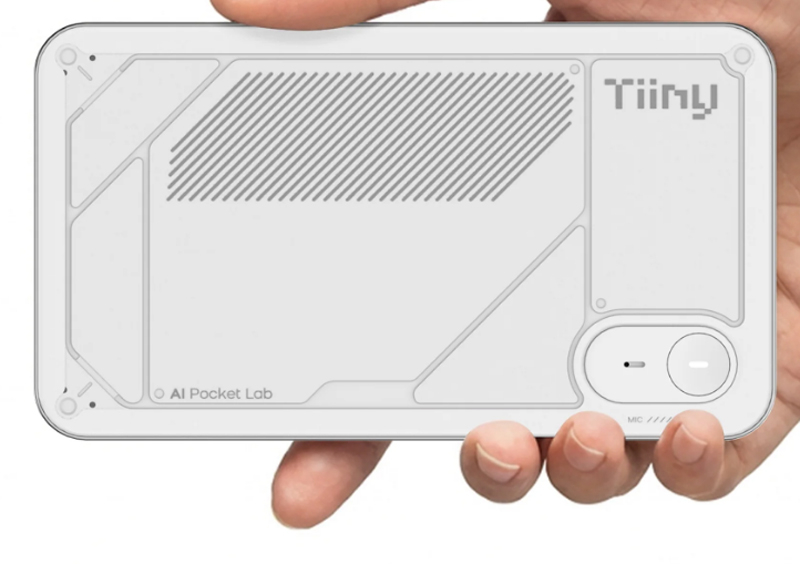

«Карманный ИИ-суперкомпьютер» Tiiny AI Pocket Lab справляется с LLM, насчитывающими до 120 млрд параметровАмериканский стартап Tiiny AI представил устройство AI Pocket Lab: это, как утверждается, самый компактный в мире персональный суперкомпьютер для задач ИИ. Он способен работать с большими языковыми моделями (LLM), насчитывающими до 120 млрд параметров: при этом не требуется подключение к облачным сервисам. Устройство заключено в корпус с размерами 142 × 80 × 25,3 мм, а вес составляет около 300 г. Применён процессор с 12 вычислительными ядрами на архитектуре Armv9.2. Кроме того, задействован нейромодуль dNPU. Общий объём памяти LPDDR5X составляет 80 Гбайт, из которых 32 Гбайт приходится на CPU и 48 Гбайт — на dNPU. В оснащение входит SSD вместимостью 1 Тбайт. Типовое энергопотребление находится на уровне 65 Вт.

Источник изображений: Tiiny AI Суммарная заявленная ИИ-производительность достигает 190 TOPS: из них примерно 30 TOPS обеспечивает CPU, ещё 160 TOPS — блок dNPU. Компьютер ориентирован прежде всего на локальную работу с моделями, насчитывающими от 10 до 100 млрд параметров: подобные решения, как утверждается, удовлетворяют более чем 80% реальных потребностей. Устройство может поддерживать такие функции, как многоэтапное рассуждение, глубокое понимание контекста, агенты ИИ, генерация контента и безопасная обработка конфиденциальной информации без необходимости подключения к удалённым серверам.  Tiiny AI Pocket Lab поддерживает быструю установку популярных открытых ИИ-моделей, включая OpenAI GPT-OSS, Llama, Qwen, DeepSeek, Mistral и Phi. При этом могут развертываться различные ИИ-агенты, например, OpenManus, ComfyUI, Flowise, Presenton, Libra, Bella и SillyTavern. Среди потенциальных пользователей компьютера названы разработчики, исследователи, создатели контента, учащиеся и пр. Новинка будет демонстрироваться в следующем месяце на выставке электроники CES 2026. |

|