Материалы по тегу: ии

|

19.05.2025 [11:24], Сергей Карасёв

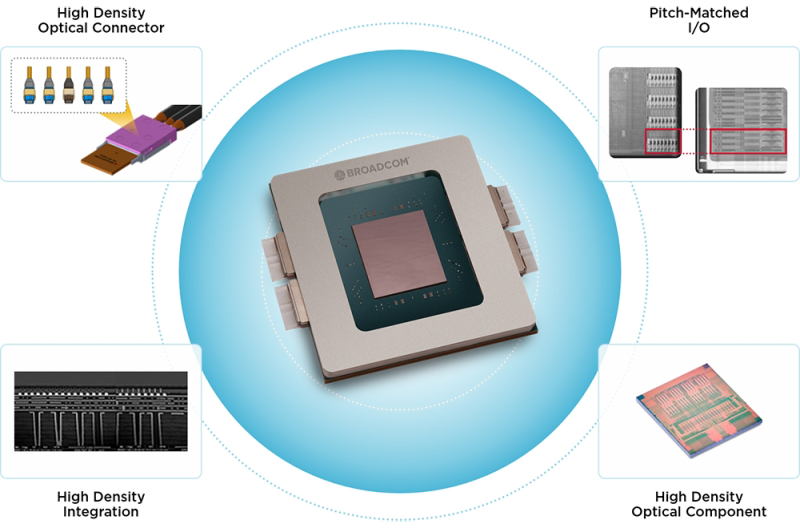

Broadcom представила оптический CPO-интерконнект третьего поколения со скоростью 200G на линиюКомпания Broadcom анонсировала платформу CPO (Co-Packaged Optics — интегрированная оптика) третьего поколения для создания оптического интерконнекта с высокой пропускной способностью. Решение ориентировано на инфраструктуры ИИ с большой нагрузкой и возможностью масштабирования. Broadcom начала активное развитие направления CPO в 2021 году, анонсировав чипсет первого поколения Tomahawk 4-Humboldt. Затем последовало решение второго поколения Tomahawk 5-Bailly (TH5-Bailly) со скоростью передачи данных 100 Гбит/с на линию. В настоящее время организовано массовое производство таких продуктов. Они, как утверждается, обеспечивают бесшовную интеграцию оптических и электрических компонентов для повышения производительности при снижении энергопотребления. Решения Broadcom CPO третьего поколения поддерживают оптические соединения с пропускной способностью 200 Гбит/с на линию. Интерконнект может применяться в инфраструктурах, насчитывающих более 512 узлов, которые предназначены для обучения крупных моделей ИИ и инференса. Технология, как отмечается, призвана решить проблемы пропускной способности, мощности и задержки, возникающие на фоне увеличения количества параметров ИИ-моделей. В число партнёров Broadcom по экосистеме CPO входят Corning Incorporated, Delta Electronics, Foxconn Interconnect Technology, Micas Networks и Twinstar Technologies. В частности, Delta Electronics организовала производство коммутаторов Ethernet TH5-Bailly 51.2T CPO в форм-факторе 3RU, которые доступны в конфигурациях с воздушным и жидкостным охлаждением. А Micas Networks предлагает сетевую коммутационную систему TH5-Bailly, обеспечивающую экономию электроэнергии более чем на 30 % по сравнению с решениями с традиционными подключаемыми модулями. Вместе с тем Broadcom уже разрабатывает решения CPO четвёртого поколения, которые обеспечат пропускную способность до 400 Гбит/с на линию.

19.05.2025 [08:49], Владимир Мироненко

На одном ИИ не выедешь: США рискуют потерять лидерство в HPC

hardware

hpc

top500

государство

дефицит

ии

кадры

квантовые вычисления

обучение

прогноз

разработка

суперкомпьютер

сша

ускоритель

финансы

энергоэффективность

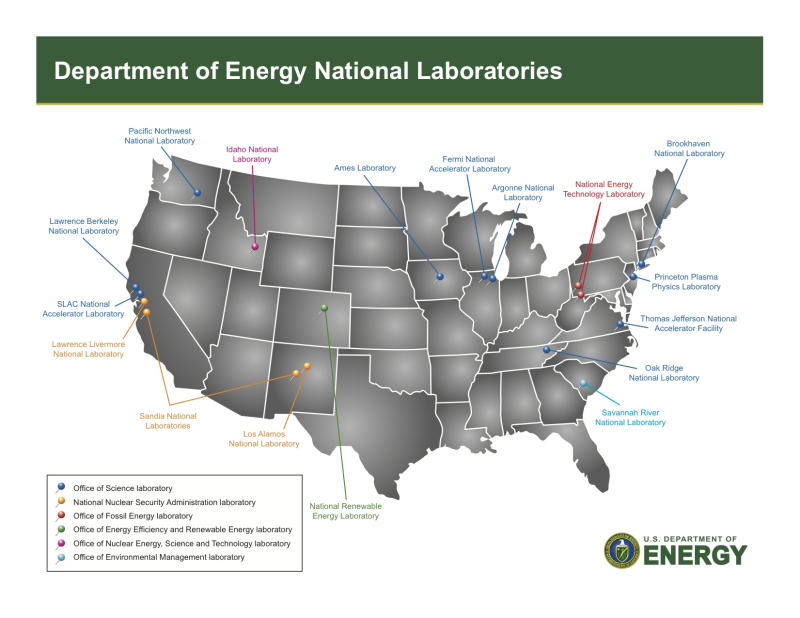

Проблемы, связанные с высокопроизводительными вычислениями (HPC), угрожают инновациям в США, утверждает Джек Донгарра (Jack Dongarra), лауреат премии А. М. Тьюринга и один создателей рейтинга самых мощных суперкомпьютеров в мире TOP500, чьи разработки и реализации многих библиотек, включая EISPACK, LINPACK, BLAS, LAPACK и ScaLAPACK, сыграли важную роль в продвижении HPC. В статье, опубликованной The Conversation, Донгарра рассказал о прогрессе HPC и проблемах с инновациями в США. Учёный отметил, что HPC являются одной из самых важных технологий в современном мире, позволяющей решать различные задачи — от прогнозирования погоды до поиска новых лекарств и обучения ИИ-моделей, которые слишком сложны или слишком велики для обычных компьютеров. Сейчас HPC находятся на переломном этапе, и выбор, который правительство США, исследователи и технологическая отрасль делают сегодня, может повлиять на будущее инноваций, национальной безопасности и мирового лидерства, предупреждает Донгарра. Используя тысячи и даже миллионы чипов с передовыми системами памяти и хранения для быстрого перемещения и сохранения огромных объёмов данных, HPC-платформы позволять выполнять чрезвычайно подробные симуляции и вычисления, говорит Донгарра. Важность HPC ещё больше возросла с развитием ИИ-технологий, требующих огромных вычислительных мощностей для обучения. «В результате ИИ и HPC теперь тесно сотрудничают, подталкивая друг друга вперёд», — отметил учёный. По словам Донгарра, сегмент HPC находится под большим давлением, чем когда-либо, с более высокими требованиями к системам по скорости, данным и энергопотреблению. Также он отметил, что HPC сталкиваются с некоторыми серьёзными техническими проблемами. Донгарра назвал одной из ключевых проблем разрыв между производительностью чипов и подсистем памяти. «Представьте себе, что у вас есть сверхбыстрый автомобиль, но вы застряли в пробке — мощность бесполезна, если дорога не может с ней справиться», — говорит учёный. Точно так же подсистемы памяти не способны «прокормить» вычислительные блоки, которые простаивают, что отражается на эффективности всей вычислительной системы. Ещё одна проблема HPC — энергопотребление. Закон масштабирования Деннарда, согласно которому с уменьшением размеров транзистора уменьшается и энергопотребление при росте производительности, прекратил своё действие в 2006 году. Теперь, чем мощнее компьютеры, тем больше они потребляют энергии. Чтобы исправить это, исследователи ищут новые способы проектирования как аппаратного, так и программного обеспечения HPC. Также существует проблема с типами производимых чипов, отметил учёный. Сейчас индустрия чипов в основном сосредоточена на ИИ, который отлично работает с вычислениями с низкой точностью. Однако для многих научных приложений по-прежнему требуется FP64-вычисления. В частности, NVIDIA сделала ставку исключительно на ИИ, поэтому FP64-производительность новейших GB300 почти в 30 раз меньше, чему GB200. У AMD, по слухам, в следующем поколении Instinct будет сразу два варианта ускорителей MI430X с поддержкой FP64 и MI450X, полностью лишённый тензорных ядер с FP64. Но и она может сделать ставку только на ИИ. Если производители прекратят выпускать чипы, которые требуются учёным, это негативно отразится на выполнении важных исследований. Таким образом тенденции в производстве полупроводников и коммерческие приоритеты могут разниться с потребностями научного сообщества, а отсутствие специализированного оборудования может помешать прогрессу в исследованиях. Можно попытаться создавать специализированные чипы для HPC, но это дорого и сложно. Исследователи, тем не менее, изучают возможность применения новых конструкций для изготовления чипов, включая чиплеты, чтобы сделать их более доступными. В прошлом у США было преимущество в области HPC благодаря государственному финансированию, поддержке и открытости разработок, но теперь многие страны вкладывают значительные средства в HPC в стремлении снизить зависимость от иностранных технологий и выйти на лидирующие позиции в таких областях, как моделирование климата и персонализированная медицина. В Европе развивают программу EuroHPC, у Японии есть собственный суперкомпьютер Fugaku (а скоро будет ещё один), а у Китая — целая серия «автохтонных» машин. Правительства стран понимают, что HPC являются ключом к их национальной безопасности, экономической мощи и научному лидерству, отметил Донгарра, подчеркнув, что у США всё ещё нет чёткого долгосрочного плана на будущее. Другие страны развивают это направление быстро, а без национальной стратегии США рискуют отстать, предупредил он: «Национальная стратегия США должна включать финансирование создания новых машин и обучение людей их использованию. Она также должна включать партнёрство с университетами, национальными лабораториями и частными компаниями. Самое главное, что план должен быть сосредоточен не только на оборудовании, но и на ПО и алгоритмах, которые делают HPC полезными», — заявил учёный. Он отметил, что некоторые шаги в этом направлении уже предприняты, включая принятие в 2022 году «Закона о чипах и науке» (CHIPS and Science Act) и создание управления, которое поможет превратить научные исследования в реальные продукты. В 2025 году также была сформирована целевая группа Vision for American Science and Technology, призванная объединить некоммерческие организации, академические круги и промышленность для помощи правительству в принятии решений. Кроме того, получили развитие квантовые вычисления. Но они пока находятся на ранних стадиях и, скорее всего, будут дополнять, а не заменять традиционные HPC. Поэтому важно продолжать инвестировать в оба вида вычислений. Донгарра назвал это правильными шагами, но они не решат проблему поддержки HPC в долгосрочной перспективе. Помимо краткосрочного финансирования и инвестиций в инфраструктуру, учёный предложил:

Донгарра отметил, что HPC — это больше, чем просто быстрые суперкомпьютеры. Это основа научных открытий, экономического роста и национальной безопасности. Если США примут предложенные меры, то можно гарантировать, что HPC продолжат поддерживать инновации в течение десятилетий.

17.05.2025 [16:05], Сергей Карасёв

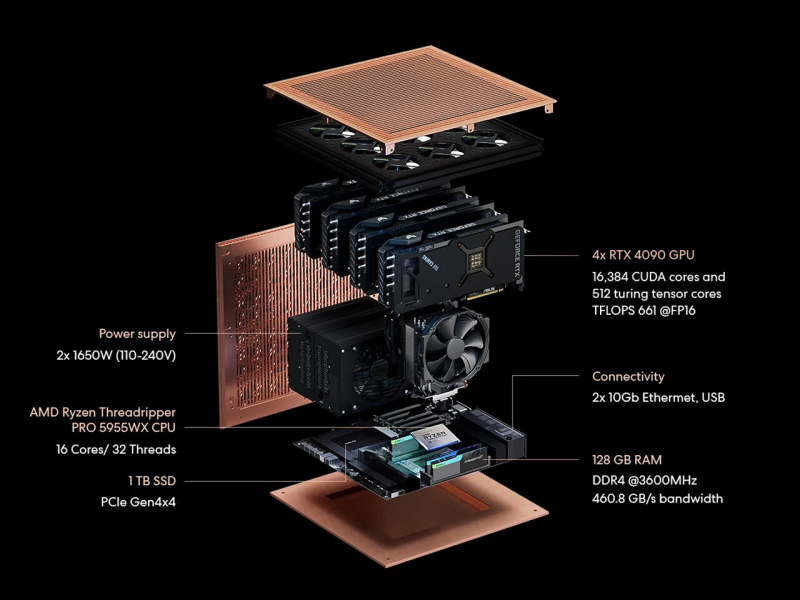

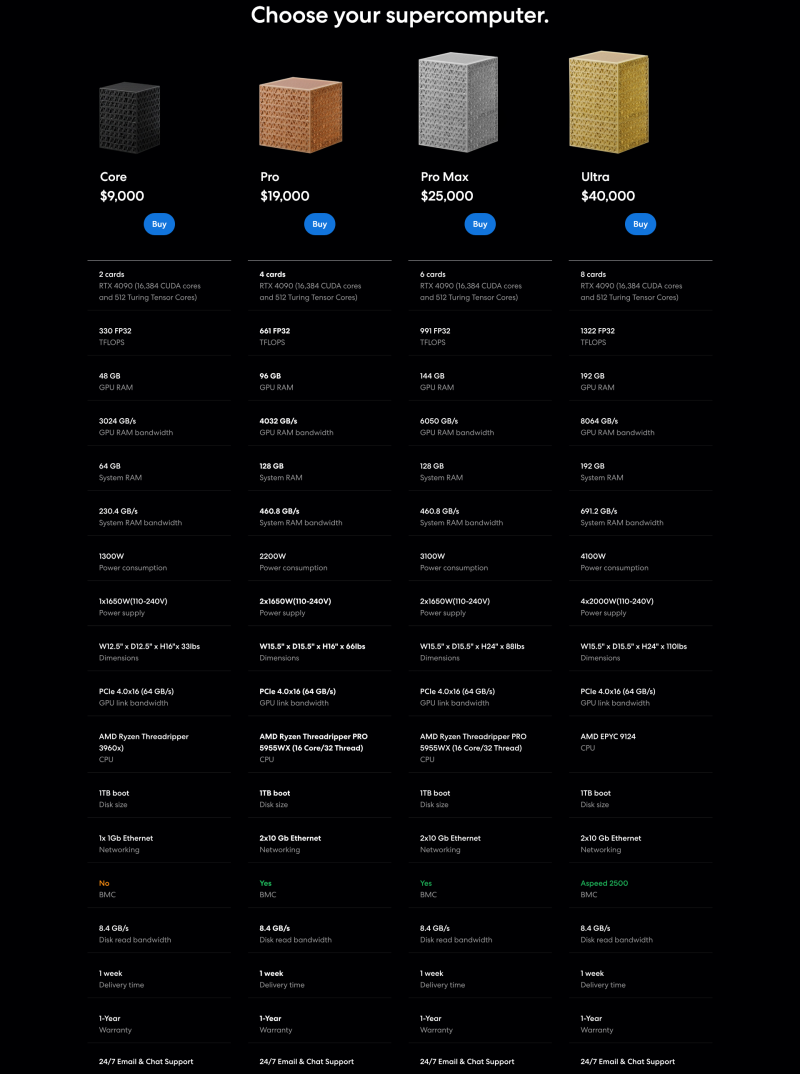

Autonomous представила рабочую станцию Brainy для ИИ-задачКомпания Autonomous анонсировала мощную рабочую станцию Brainy, ориентированную на задачи машинного обучения и нагрузки ИИ. Утверждается, что новинка подходит для работы с большими языковыми моделями (LLM), насчитывающими до 70 млрд параметров. При этом пользователи могут добиться значительной экономии средств по сравнению с арендой облачных GPU, говорит компания. Рабочая станция предлагается в четырёх модификациях — Core, Pro, Pro Max и Ultra. Они несут на борту соответственно два, четыре, шесть и восемь ускорителей NVIDIA GeForce RTX 4090 Ada (16 384 ядра CUDA; 24 Гбайт GDDR6X с 384-бит шиной), а производительность ИИ на операциях FP32 достигает 330 Тфлопс, 661 Тфлопс, 991 Тфлопс и 1,32 Пфлопс. Младшая модель Brainy Core располагает процессором AMD Ryzen Threadripper 3960X (24C/48T; 3,8–4,5 ГГц), 64 Гбайт системной памяти, одним блоком питания мощностью 1650 Вт, загрузочным SSD вместимостью 1 Тбайт, а также сетевым контроллером 1GbE. Стоит такая версия $9000. Ступенью выше располагается модификация Brainy Pro, за которой идёт Brainy Pro Max: они предлагаются по цене $19 000 и $25 000. Обе снабжены чипом Ryzen Threadripper Pro 5955WX (16C/32T; 4,0–4,5 ГГц), 128 Гбайт оперативной памяти, SSD на 1 Тбайт, двухпортовым сетевым адаптером 10GbE, контроллером ВМС и двумя блоками питания мощностью 1650 Вт. Самая мощная версия рабочей станции — Brainy Ultra — обойдётся в $40 000. Она укомплектована процессором AMD EPYC 9124 Genoa (16C/32C; 3,0–3,7 ГГц), 192 Гбайт ОЗУ, SSD ёмкостью 1 Тбайт, контроллером Aspeed AST 2500, двухпортовым сетевым адаптером 10GbE и четырьмя блоками питания мощностью 2000 Вт каждый. При этом все конфигурации не выглядят достаточно сбалансированными. Например, у Pro Max системной памяти меньше, чем VRAM, но хотя бы остаются свободные линии PCIe для подключения накопителей с данными. Кроме того, RTX 4090 не имеет поддержки NVLink Bridge, так что каждая карта работает независимо.

16.05.2025 [18:25], Руслан Авдеев

Обойдёмся без Microsoft: OpenAI заключила сделку с CoreWeave на $4 млрдКомпания CoreWeave заключила очередную сделку с OpenAI на сумму $4 млрд до 2029 года. По данным Bloomberg, в недавнем финансовом отчёте компания отчиталась о новом соглашении «с крупным предприятием в сфере ИИ», но имя партнёра не называлось. Ранее компании OpenAI уже подписала с CoreWeave сделку на $11,9 млрд, предусматривающую использование вычислительных мощностей последней. Эта сделка не вошла в перечень текущих обязательств CoreWeave (RPO). Партнёрство двух компаний поможет CoreWeave диверсифицировать клиентскую базу, а OpenAI — сократить зависимость от Microsoft, а также собственного ИИ-проекта Stargate с участием SoftBank и Oracle. Впрочем, дело несколько сложнее, потому что якорным заказчиком CoreWeave, обеспечивающим 62 % выручки, была сама Microsoft, которая арендовала ресурсы в интересах OpenAI. Вторым по величине клиентом была NVIDIA. Ходили слухи, что в Microsoft намерены сократить расходы, но в CoreWeave информацию опровергали — ранее речь шла о контракте стоимостью $10 млрд. Ранее эксклюзивным поставщиком облачных сервисов для OpenAI была Microsoft, вложившая в компанию с 2019 года $19 млрд, но в 2024 году было объявлено, что OpenAI будет работать и с Oracle, правда, при посредничестве той же Microsoft. По данным Datacenter Dynamics, после анонса Stargate компании «выяснили отношения» и Microsoft получила почётное звание «ключевого первоначального технологического партнёра», но не получила доли в бизнесе в отличие от Oracle, SoftBank и арабской MGX. Microsoft подтвердила, что партнёрство более не является эксклюзивным, хотя у компании остаётся право «преимущественного выбора» (ROFR). В начале мая The Financial Times заявляла, что условия сотрудничества пересматриваются, а основные разговоры ведутся о том, какую долю должна получить в капитале OpenAI компания Microsoft в обмен на прошлые инвестиции. Источники заявляют также и о пересмотре условий контракта, заключённого компаниями ещё в 2019 году. По имеющимся данным, Microsoft готова отказаться от части доли в будущей коммерческой компании в обмен на доступ передовым к технологиям OpenAI, разработанным после 2030 года, когда текущий контракт закончится. Как сообщают некоторые источники, во многом проблема связана с «высокомерием» OpenAI, желающей денег, но также требующей не вмешиваться в рабочие процессы — Microsoft якобы должна радоваться самому факту такого сотрудничества. Впрочем, по словам близкого к OpenAI источника, Microsoft по-прежнему заинтересована в превращении последней в коммерческую структуру, хотя впереди предстоят сложные переговоры.

16.05.2025 [16:54], Анжелла Марина

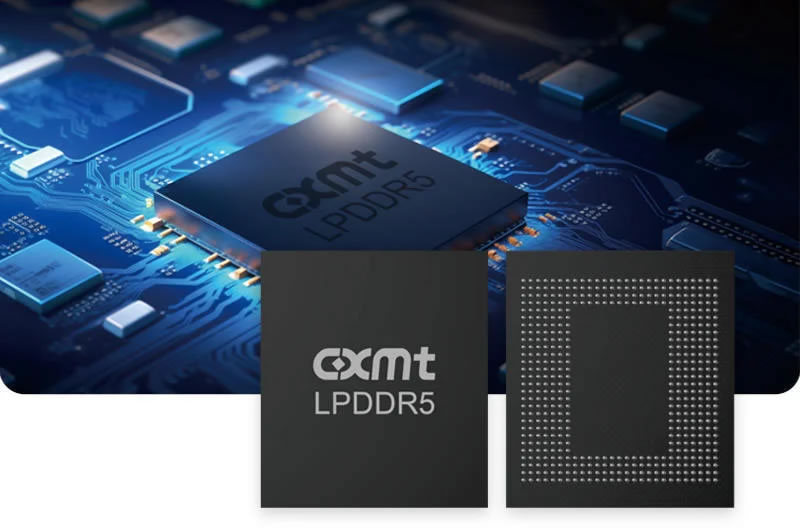

США готовят санкции против китайских производителей памяти CXMT, YMTC и других чипмейкеровАдминистрация США рассматривает возможность включения нескольких китайских компаний по производству чипов в «чёрный список» экспортного контроля. Среди них — производитель памяти CXMT, а также дочерние структуры крупнейших китайских чипмейкеров SMIC и YMTC. Такое положение дел ограничит для этих компаний доступ к американским технологиям, поскольку поставки без специальной лицензии станут невозможны. Решение пока не принято из-за разногласий внутри администрации. Часть чиновников считает, что санкции могут сорвать переговоры по торговой сделке между США и Китаем, которые недавно договорились о временном снижении пошлин на 90 дней. Однако другие, как пишет Financial Times, настаивают на жёстких мерах, напоминая, что республиканцы критиковали предыдущую администрацию за слишком мягкую политику в отношении КНР. Особое внимание США привлекает компания CXMT, которая активно наращивает долю на мировом рынке чипов памяти DRAM и разрабатывает высокопроизводительную память HBM, критически важную для ИИ-нагрузок. В Вашингтоне опасаются, что передовые технологии могут быть использованы Китаем для модернизации военного потенциала, включая разработку гиперзвукового оружия и моделирование ядерных испытаний.

Источник изображения: cxmt.com Если компании попадут в «чёрный список», это станет очередным шагом США по ограничению доступа Китая к передовым полупроводниковым технологиям, а американские компании не смогут поставлять им оборудование и компоненты без сложного процесса согласования. Ранее аналогичные меры уже применялись против SMIC и YMTC. Китайские компании пока не прокомментировали ситуацию. В посольстве КНР в США заявили, что «решительно выступают против злоупотребления Вашингтоном концепцией национальной безопасности и искусственных ограничений в торговле», назвав такие действия попыткой подавить технологическое развитие Китая. Белый дом и Министерство торговли США отказались от официальных комментариев. Однако эксперты считают, что решение может быть принято в ближайшие недели, что увеличит напряжённость в американо-китайских отношениях.

16.05.2025 [14:45], Руслан Авдеев

США готовы разрешить ОАЭ импортировать миллионы ускорителей NVIDIA для постройки одного из крупнейших в мире ИИ ЦОДСША заключили с ОАЭ предварительное соглашение, разрешающее последним импортировать 500 тыс. самых современных ИИ-ускорителей NVIDIA ежегодно. По словам двух источников Reuters, поставки начнутся уже в этом году, что ускорить строительство Эмиратами ИИ ЦОД. По оценкам, это позволит создать в Абу-Даби один из крупнейших в мире ИИ-кампусов площадью 25,9 км2 и мощностью 5 ГВт. По словам источников, соглашение о поставке ускорителей должно действовать как минимум до 2027 года, но не исключено, что срок его действия продлят и до 2030-го. Проект предусматривает поставку пятой части всех чипов (около 100 тыс. штук в год) компании G42, а остальные разделят между американскими компаниями, работающими в сфере ИИ, вроде Microsoft (которая сама связана с G42) и Oracle. Не исключено, что последняя будет строить в ОАЭ дата-центры. Соглашение ещё может измениться — по некоторым данным, оно находится на стадии обсуждения и оппозиция ему имеется даже в самом правительстве США. Предыдущая администрация США подготовила ограничения на поставки передовых ИИ-ускорителей в большую часть стран мира — отчасти для того, чтобы не допустить их перепродажу в Китай. Новая администрация отменила столь жёсткие ограничения, вредящие американскому бизнесу.

Источник изображения: Darcey Beau/unspalsh.com Турне нынешнего президента США по странам Персидского залива уже привело к заключения сделок с организациями Саудовской Аравии на сумму $600 млрд. На сегодня большинство вычислительных ИИ-мощностей в мире развёрнуты в США и Китае, но если все предлагаемые в регионе Персидского залива сделки увенчаются успехом, он может стать третьим «центром силы» для ИИ-вычислений в мире. Долями в G42 владеют Фонд национального благосостояния Абу-Даби Mubadala, правящая семья ОАЭ и американская частная инвестиционная компания Silver Lake, а её председателем является советник по национальной безопасности ОАЭ и брат президента ОАЭ шейх Тахнун ибн Шахбут Аль Нахайян (Tahnoon bin Zayed Al Nahyan). В числе прочего предварительное соглашение направлено на продвижение ЦОД в США. Пока в нём указано, что для каждого объекта, построенного G42 в ОАЭ, компания обязуется построить аналогичный ЦОД в США. По словам одного из источников, что именно будет называться «передовым» ИИ-чипом, будет решать отдельная рабочая группа, которую создадут позже, вместе с разработкой условий обеспечения безопасности. По словам одного из источников, речь идёт о новейших чипах NVIDIA поколения Blackwell. Также не исключается, что предусмотрены поставки чипов NVIDIA Rubin, которые производительнее тех и других и ещё не появились в продаже.

16.05.2025 [14:13], Руслан Авдеев

Tencent санкциями не напугать: китайский IT-гигант накопил достаточно ИИ-ускорителей для обучения моделей в течение многих летКитайский IT-гигант Tencent уверен, что накопил достаточно высокопроизводительных ускорителей для обучения новых ИИ-моделей в течение многих лет. Отчасти это объясняют тем, что в КНР нашли более эффективные способы работы с ИИ-нагрузками, чем в США, сообщает The Register. В ходе подведения финансовых итогов I квартала 2025 года президент Tencent Мартин Лау (Martin Lau), объявил, что у компании «довольно большой запас чипов», которые компания успела приобрести до новых ограничений со стороны Соединённых Штатов. Часть будет использоваться для приложений, которые принесут «немедленную прибыль» — вроде рекламных и рекомендательных систем. Часть пойдёт на обучение ещё нескольких поколений LLM с использованием передовых методов, позволяющих использовать минимально возможное количество ускорителей. Сообщается, что в последние месяцы в КНР стали отходить от американской концепции «масштабирования», согласно которой обучающий кластер надо постоянно увеличивать — хороших результатов можно добиться и без этого, в том числе на этапе пост-обучения. По словам Лау, агентный и рассуждающий ИИ требуют больше ускорителей сам по себе, но оптимизация ПО поможет ещё больше повысить эффективность инференса. Поэтому Tencent намерена вкладываться в повышение эффективности использования доступных ресурсов — например, обучение более мелких моделей для более узких задач, требующих меньше мощностей.

Источник изображения: chen zy/unsplash.com Как заявил Лау, компания рассматривает и альтернативы недоступным более ускорителям NVIDIA. Потенциально компания может использовать и другие ускорители и аппаратные решения, включая ASIC-модули и даже обычные GPU в некоторых случаях, в том числе для более мелких моделей. Высказывания Лау предполагают, что попытки США заблокировать экспорт высокопроизводительных ускорителей в Китай не принесли ожидавшихся результатов — вместо этого Tencent добилась прогресса в оптимизации и инновациях. Несколько противоречат оптимистичным заявлениям Лау высказывания генерального директора Tencent Пони Ма (Pony Ma), который подчеркнул, что облачный бизнес фактически подразумевает перепродажу мощностей ускорителей, поэтому сейчас для компании, на фоне дефицита, это направление стало менее приоритетным. Другими словами, дефицит всё же имеется. В любом случае на данный момент компания находится в превосходном состоянии. За I квартал выручка выросла на 13 % год к году до $25,1 млрд, а валовая прибыль — на 20 % до $14 млрд. Компания насчитывает 1,4 млрд активных пользователей Weixin и WeChat ежемесячно, а новая рекламная платформа на базе ИИ только улучшает показатели. Компания является не только рекламным посредником, но и активно занимается стримингом видео и аудио, а доходы от её игр в последнее время резко выросли.

Источник изображения: Donald Wu/unsplash.com Пока торговая война между США и Китаем смешала планы многих бизнесов, но Лау предлагает подождать и посмотреть на результаты в следующем квартале. По его словам, правительство оказывает большую поддержку, что компенсирует новые высокие тарифы. В своё время китайский стартап DeepSeek сумел доказать, что в мире ИИ можно добиться больших результатов относительно малыми средствами. Хотя позже выяснилось, что экономичность его моделей не так высока, как утверждалось, американское технологическое превосходство всё равно было поставлено под вопрос.

16.05.2025 [08:38], Владимир Мироненко

Qualcomm возвращается на рынок серверных процессоровQualcomm Technologies возвращается на рынок серверных процессоров. Это подтверждает меморандум о взаимопонимании, подписанный компанией и ИИ-стартапом Humain, принадлежащим Суверенному фонду Саудовской Аравии, с целью «запуска ИИ ЦОД, предложения гибридного ИИ на периферии и в облаке, а также сервисов “от облака до периферии” в Королевстве Саудовская Аравия и за его пределами». Меморандум о взаимопонимании был подписан в ходе Саудовско-американского инвестиционного форума в Эр-Рияде. Ранее о партнёрстве с Humain объявили NVIDIA, AMD и AWS, а также Cisco. В документе закреплено обязательство Qualcomm «разработать и поставлять современные ИИ-решения и CPU для ЦОД». Также стороны планируют интегрировать семейство арабских больших языковых моделей Humain (ALLaM, совместно разработанных с SDAIA) с широкой экосистемой периферийных ИИ-устройств на базе процессоров Qualcomm, предоставляя возможности гибридного ИИ-инференса от облака до периферии для широкого спектра устройств. В дальнейшем компании будут сотрудничать с Министерством связи и информационных технологий Саудовской Аравии (MCIT) с целью создания в Саудовской Аравии Центра проектирования полупроводниковых технологий мирового класса. Согласно документу, Qualcomm и Humain намерены «разработать и построить передовые ИИ ЦОД в Саудовской Аравии, предназначенные для предоставления высокоэффективных масштабируемых гибридных решений ИИ-инференса от облака до периферии (cloud-to-edge) для местных и международных клиентов на основе решений Qualcomm». Также партнёры планируют ускорить использование инфраструктуры за счет применения процессоров Snapdragon и Dragonwing. Ранее Qualcomm и Cerebras договорились об использовании ускорителей Cloud AI для инференса, в том числе в интересах заказчиков из Саудовской Аравии. Qualcomm и Humain заявили, что их ЦОД и экосистема предназначены для предоставления как государственным, так и корпоративным организациям доступа к высокопроизводительной и энергоэффективной облачной ИИ-инфраструктуре на основе CPU, а также cloud-to-edge сервисам. Согласно пресс-релизу, эти предложения позволят развёртывать ИИ-решения, которые могут делать прогнозы и принимать решения в реальном времени, а также значительно повышать доступность и ценность передовых приложений с поддержкой ИИ.

Источник изображения: Qualcomm Слухи о планируемом Qualcomm возврате к разработке серверных процессоров курсируют длительное время. В 2017 году компания выпустила 10-нм 48-ядерные чипы Centriq 2400, но затем отменила проект в 2019 году. Позже компания приобрела стартап Nuvia, который разрабатывал серверные Arm-процессоры. Qualcomm использовала наработки Nuvia в процессорах Snapdragon для компьютеров на базе Windows. Слухи разгорелись с новой силой, когда в начале года Qualcomm наняла Сайлеша Коттапалли (Sailesh Kottapalli) в качестве старшего вице-президента. Ранее он был главным архитектором серверных процессоров Xeon. Теперь Qualcomm не скрывает своих намерений. Она разместила на сайте вакансии, связанные с разработкой серверных процессоров, включая «архитектора управления питанием сервера», «архитектора ПО для управления питанием и температурой серверных SoC» и «архитектора серверной платформы». Причём, как отметил ресурс Computer Base, каждая вакансия сопровождается примечанием: «Команда Qualcomm Data Center разрабатывает высокопроизводительное и энергоэффективное серверное решение для ЦОД». На форуме JPMorgan финансовый директор и главный операционный директор Акаш Палхивала (Akash Palkhiwala) заявил, что у компании есть «ведущий в мире процессор» и NPU. «Изменения, которые происходят в ЦОД, очевидно, связаны с переходом к инференсу, который становится всё более важным, как и низкое энергопотребления, и именно здесь Qualcomm на высоте», — отметил Палхивала, добавив, что компания использует имеющиеся технологии в будущих серверных процессорах.

15.05.2025 [23:28], Татьяна Золотова

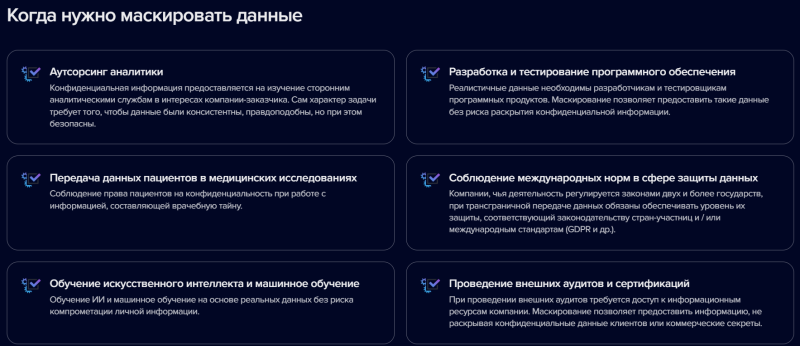

«Гарда Маскирование» теперь можно использовать для работы с документами граждан КазахстанаПроизводитель ИБ-продуктов ГК «Гарда» обновила программное решение «Гарда маскирование». Теперь систему можно применять для работы с документами граждан Казахстана. Об этом сообщает пресс-служба компании. «Гарда маскирование» обезличивает персональные данные для защиты от утечек при передаче их третьим лицам. Решение распознает чувствительные сведения в исходной базе данных и создает ее копию, в которой реальная информация подменяется фиктивными, но правдоподобными значениями. Среди основных функций системы разработчики называют автоматическое выявление критической информации в массиве данных, гибкую настройку параметров маскирования, автоматический анализ структуры СУБД. Также есть ролевая модель и разграничение прав доступа, замена персональных данных и чувствительной информации, сохранение форматов и структуры данных. По сути, продукт, удаляя критичную информацию, позволяет избежать штрафов, юридических рисков и обеспечить соответствие требованиям 152-ФЗ. Одним запросом можно найти в базах компании все данные, связанные с конкретным человеком, и затем удалить их. Для обработки документов граждан Казахстана (паспортные данные, полисы, налоговые номера) в решении были адаптированы механизмы сканирования и маскирования. Система упрощает миграцию данных и настройку новых инсталляций, также есть поддержка импорта и экспорта шаблонов сканирования между разными экземплярами системы. По данным специалистов «Гарды», 39 % отечественных компаний удаляют персональные данные вручную, проводя поиск по базам, хранилищам и на рабочих местах. При этом сертифицированными программными средствами пользуются только в 3 % компаний. Операторы ПДн обязаны удалять сведения личного характера по истечении срока хранения в течение 30 дней, а по заявлению субъекта ПДн — в течение семи дней (ч. 3 ст. 20 Закона «О персональных данных» № 152-ФЗ в обновленной редакции).

15.05.2025 [21:27], Андрей Крупин

Почтовый сервер RuPost дополнился расширенными средствами мониторинга и системой трассировки писемРоссийский разработчик «РуПост» (входит в «Группу Астра») представил новый релиз почтового сервера RuPost 3.3. RuPost представляет собой коммуникационное решение корпоративного класса, отвечающее всем требованиям современной организации любого масштаба. Продукт поддерживает кластеризацию, миграцию данных и одновременную работу с Microsoft Exchange, взаимодействие со службами каталогов ALD Pro, Active Directory, FreeIPA, а также оснащён средствами балансировки нагрузки, самодиагностики и мониторинга целостности конфигураций почтовых компонентов. Платформа RuPost подходит для решения задач импортозамещения. Программный комплекс включён в реестр Минцифры России и входит в дорожную карту «Цифровое рабочее место сотрудника».

Источник изображения: rupost.ru В RuPost версии 3.3 разработчики существенно расширили возможности мониторинга компонентов программного комплекса. В частности, стал доступен комплексный мониторинг баз данных, включающий информацию о размерах, состоянии кластера Patroni и текущих подключениях. Также были реализованы средства мониторинга подключений и работоспособности серверов LDAP и усовершенствованы механизмы протоколирования работы RuPost и его окружения. Администраторы могут оперативно получать сводки о состоянии системы за счёт централизованного сбора журналов со всех узлов кластера и их вывода в отдельную вкладку «Логи» панели управления. В числе прочего обновлённый почтовый сервер получил систему трассировки писем, позволяющую отслеживать маршрут электронной корреспонденции, и кардинально переработанный механизм репликации данных. Дополнительно в состав RuPost были включены инструменты контроля изменений важных атрибутов учётных записей пользователей в LDAP, которые позволяют IT-службам своевременно выявлять и анализировать попытки изменения ключевых параметров доступа из внешних систем. Также реализована возможность приёма и обработки входящих писем-приглашений, что упрощает работу с документами и повышает эффективность корпоративного документооборота. |

|