Материалы по тегу: i

|

22.01.2026 [17:40], Руслан Авдеев

OpenAI представила программу Stargate Community для налаживания добрососедских отношений с местными жителямиКомпания OpenAI, объявившая о намерении создать «общий искусственный интеллект» (AGI) на благо всего человечества, намерена организовать работу таким образом, чтобы в ходе достижения этой цели её кампусы приносили пользу местным жителям. С этой целью компания представила программу Stargate Community, способствующую развитию экономики и созданию рабочих мест в регионах присутствия. В рамках инициативы Stargate компания задалась целью нарастить инфраструктуру ИИ в США до 10 ГВт к 2029 году. Первый объект в Абилине (Abilene, Техас) уже работает, новые объекты строятся по всей стране. С момента запуска в январе 2025 года, партнёры по Stargate анонсировали несколько проектов большой мощности по всему миру. В сентябре были анонсированы планы построить пять кампусов ЦОД в Техасе, Нью-Мексико, Висконсине и Мичигане общей мощностью 5,5 ГВт. ИИ уже приносит ощутимую пользу, помогая сотням людей в вопросах здоровья и обеспечения общего благополучия, говорит OpenAI. В будущем каждая площадка Stargate будет иметь собственный план Stargate Community, подготовленный с учётом местных проблем. По словам компании, добиться результатов можно, только будучи «хорошими соседями». Компания намерена компенсировать свои энергопотребности таким образом, что это не будет приводить к росту тарифов на электричество для местных жителей, строя энергохранилища, оплачивая создание генерирующих мощностей и модернизацию электросетей, разрабатывая режимы гибкого эгнергопотребления и др. Так, в Висконсине Oracle и Vantage совместно с WEC Energy Group развивают генерирующие мощности и полностью берут на себя расходы на энергетическую инфраструктуру нового объекта, чтобы все затраты на энергосети для ИИ ЦОД не перекладывались на обычных потребителей. В Мичигане Oracle и Related Digital взаимодействуют с DTE Energy в вопросе использования существующих энергоресурсов, дополненных новым аккумуляторным хранилищем, оплаченным проектом. Наконец, в Техасе принадлежащая SoftBank компания SB Energy рассчитывает построить новые генерирующие мощности и системы хранения энергии, чтобы обеспечить большую часть потребностей местного кампуса Stargate на 1,2 ГВт. OpenAI также приветствует инициативу Microsoft Community-First AI Infrastructure Plan, распространяющуюся на строящиеся для OpenAI кампусы, в рамках которой компания тоже пообещала сохранить стабильные тарифы на электроэнергию для обычных граждан, стать водноположительной, обучать и создавать рабочие места для местных жителей, а также направлять средства на социальные нужды и поддерживать местные НКО. В OpenAI тоже придерживаются подхода, при котором используются замкнутые или использующие мало питьевой воды системы охлаждения. Власти Абилина утверждают, что местный кампус будет потреблять в год вдвое меньше, чем город использует за день. Такие же решения внедряются в кампусах Stargate в других локациях, а в Висконсине не менее $175 млн направят на местную инфраструктуру и проекты восстановления водных ресурсов. В Абилине же откроется первая OpenAI Academу для подготовки специалистов в области ИИ ЦОД, от строителей до управляющих. Несмотря на все попытки OpenAI и партнёров, а также указы правительства, у экспертов и общественности сохраняются опасения, что крупные ИИ ЦОД приведут к росту цен на электричество. Вызывает обеспокоенность и вероятное использование природного газа для энергоснабжения объектов Stargate. В марте 2025 года сообщалось, что Crusoe, ответственная за строительство ЦОД в Абилине, заказала газовые турбины общей мощностью 4,5 ГВт для питания сети ЦОД.

20.01.2026 [13:02], Руслан Авдеев

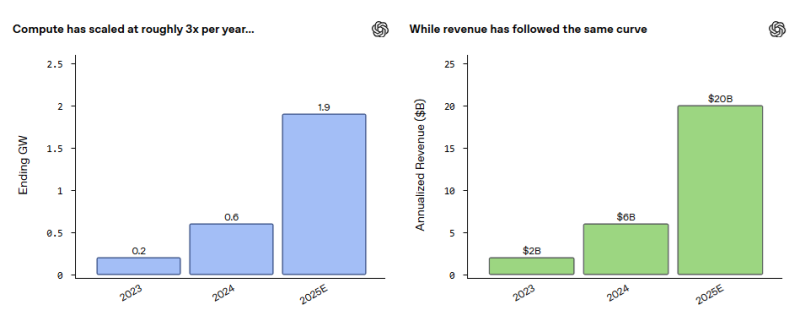

Мощность ИИ ЦОД OpenAI утроилась в 2025 году, достигнув 1,9 ГВтOpenAI Group PBC раскрыла информацию о финансовых показателях и ходе строительства дата-центров. По последним данным, её годовой регулярный доход (ARR), поступающий в основном от подписок, достиг в 2025 году $20 млрд. Для сравнения, в 2024 году он составлял $6 млрд, а годом ранее — $2 млрд. Мощность ЦОД выросла с 200 МВт до 1,9 ГВт, сообщает Silicon Angle. Синхронный рост доходов и вычислительных мощностей приблизительно на порядок за последние три года — не случайность. Представитель компании объявил, что OpenAI увязывает инвестиции в ЦОД по мере роста OpenAI с учётом достигнутых результатов и показателей спроса. Это позволяет избежать инвестиций в будущее, не обеспеченных реальными доходами.

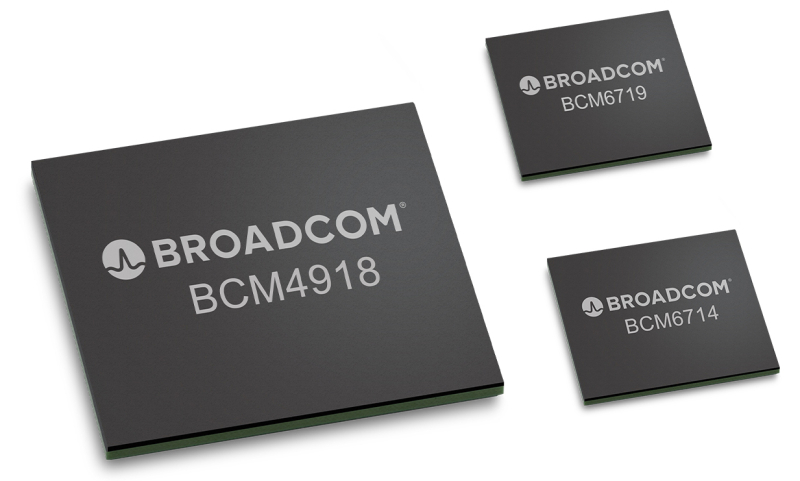

Источник изображения: Jonathan Kemper/unsplash.com В OpenAI заявили, что компания работает не только над расширением ИИ-инфраструктуры, но и над тем, чтобы сделать её более экономически эффективной. Так, OpenAI снизила стоимость инференса до менее $1 за миллион токенов, отчасти благодаря комбинированному использованию оборудования разных типов. Сообщается, что передовые модели обучаются на наиболее производительном оборудовании, а масштабные нагрузки инференса приходятся на более дешёвую инфраструктуру. О каких именно чипах для недорогой инфраструктуры идёт речь, пока не сообщалось, но не исключено, что компания на деле использует такие же дорогие новейшие ускорители, как и при обучении. Дело в том, что самые производительные ИИ-чипы являются и самыми экономически эффективными. Поиск способов снизить стоимость оборудования в будущем, вероятно, станет даже большим приоритетом для OpenAI. В сентябре появилась информация, что компания закончит 2025 год с убытками $8 млрд, на $1,5 млрд выше, чем ожидалось изначально. В 2026 году, по некоторым оценкам, убытки составят $17 млрд. Некоторые источники свидетельствуют, что попытки компании разработать кастомные чипы и строить дата-центры — часть плана по снижению стоимости инфраструктуры. В 2025 году OpenAI подписала соглашение с Broadcom на $10 млрд о разработке собственных ИИ-ускорителей. Отдельно компания работает с подконтрольным SoftBank Group бизнесом SB Energy над строительством дата-центров Stargate на основе индивидуального проекта. Последние данные топ-менеджеров компании позволяют составить представление о долгосрочных планах обеспечения роста выручки. В частности предполагается, что на рынке ИИ будут развиваться новые модели монетизации. Речь идёт о «лицензировании, соглашениях на основе интеллектуальной собственности и ценообразовании, ориентированном на результат». Ещё один важнейший компонент стратегии роста OpenAI — реклама. В OpenAI подчёркивают, что планы развития компании также отдают приоритет использованию ИИ-агентов и прочим инструментам автоматизации рабочих процессов. Компания, как утверждается, акцентирует внимание на помощи пользователям в автоматизации задач в самых разных сферах. Ещё один приоритет — обеспечение моделям более длинного контекста диалогов.

18.01.2026 [16:14], Руслан Авдеев

От телекома до солнечной энергетики: Евросоюз собирается изгнать китайские технологии из своей критической инфраструктурыБрюссельские бюрократы предлагают постепенно вытеснить оборудование китайского производства из критической инфраструктуры Евросоюза. Для этого компаниям из КНР вроде Huawei и ZTE намерены запретить участвовать в создании телекоммуникационных сетей, солнечных электростанций и сканеров систем безопасности, сообщает The Financial Times. Новые меры планируют принять в рамках обновлённой политики, касающейся безопасности и технологий, в попытке снизить зависимости от компаний США и «высокорисковых» бизнесов Китая — некоторые политики считают, что те могут поставить под угрозу конфиденциальные данные европейцев. В США использование оборудования Huawei и других компаний в телеком-сетях давно запрещено, тогда как в странах Евросоюза отказ носит скорее добровольный характер. В сопровождении к раннему проекту предложенного закона Cybersecurity Act (он всё ещё может быть изменён) ранее подчёркивалось, что «фрагментированные» национальные решения доказали свою неэффективность в масштабах всего европейского рынка. Точные сроки теперь уже принудительного вытеснения китайского бизнеса будет зависеть от оценки сопутствующих рисков. В расчёт также примут стоимость и доступность альтернативных решений. Прежние рекомендации принимались к исполнению в ЕС весьма неравномерно, некоторые страны Евросоюза по-прежнему полагаются на «высокорисковых» поставщиков. Так, в 2025 году Испания подписала контракт на €12 млн с Huawei на поставки оборудования для хранения материалов прослушки, одобренной местными судебными органами, правоохранительными органами или спецслужбами. Еврокомиссия инициировала расследования в отношении производителей поездов и ветрогенераторов, а в 2024 году провела рейды в офисах компании Nuctech, занимающейся производством охранного оборудования. Стоит отметить, что сегодня более 90 % установленных в Евросоюзе солнечных панелей — китайского производства. Представители индустрии также отмечают отсутствие приемлемых альтернатив с учётом того, что ЕС одновременно должен снизить зависимость как от китайских, так и от американских поставщиков. Телеком-операторы уже предупредили о росте цен для клиентов, который будет вызван новыми запретами. Законопроект будет рассмотрен Европарламентом и странами ЕС по отдельности. Высока вероятность, что предложенные временные рамки внедрения запретов вызовут негативную реакцию некоторых членов союза. Более того, предложение может столкнуться с противодействием групп лоббистов. Так, в SolarPower Europe, представляющей европейскую «солнечную» промышленность, Huawei является полноправным участником благодаря производству инверторов. В ноябре Пекин заявил, что попытка Еврокомиссии отказаться от использования технологий Huawei и ZTE нарушит «рыночные принципы и правила честной конкуренции». Министерство иностранных дел отметило, что факты свидетельствуют, что в нескольких странах отказ от качественного и безопасного оборудования из КНР не только сдерживает развитие технологий в самих странах, но и привозит к большим финансовым потерям.

17.01.2026 [13:07], Сергей Карасёв

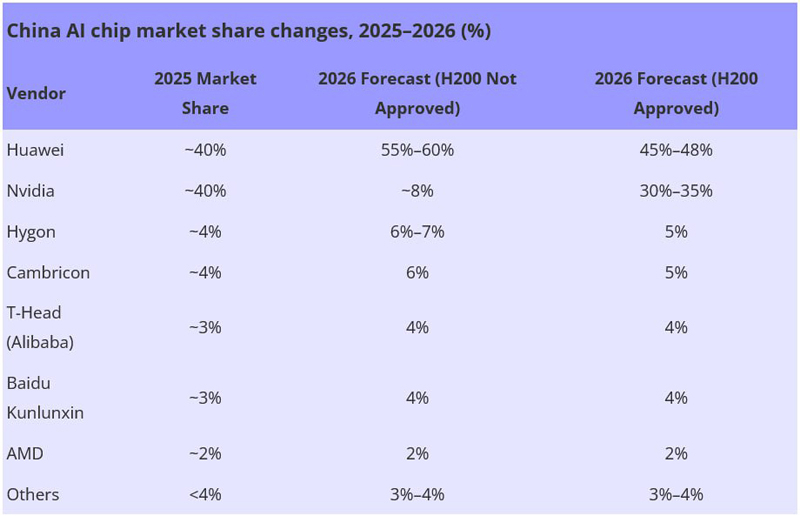

Huawei сравняла долю с NVIDIA на китайском рынке ИИ-чиповРезкий рост спроса на вычислительные мощности, геополитическое давление и ограничения в цепочках поставок приводят к трансформации китайского рынка ИИ-ускорителей. По оценкам Bernstein, которые приводит ресурс DigiTimes, позиции в КНР резко укрепила компания Huawei, которой удалось сравнять свою долю с NVIDIA. Объём сектора ИИ-чипов в Китае по итогам 2025 года достиг приблизительно $20,4 млрд. Примерно по 40 % от этой суммы, или по $8,16 млрд, приходится на Huawei и NVIDIA. Годом ранее доля Huawei составляла одну треть от показателей NVIDIA. Таким образом, сообща эти две компании контролируют около 80 % китайского рынка ИИ-ускорителей, что эквивалентно $16,32 млрд. Если не рассматривать двух лидеров, рынок ИИ-чипов в КНР является сильно фрагментированным. Так, Hygon и Cambricon занимают примерно по 4 %, при этом Hygon выигрывает от совместимости с архитектурой x86. T-Head Semiconductor, принадлежащая Alibaba, и Kunlunxin (Baidu) занимают по 3 % отрасли. Ещё около 2 % приходится на AMD. Все прочие игроки вместе взятые, включая Zixiao (Tencent), MetaX, Moore Threads и Biren, контролируют менее 4 % отрасли.

Источник изображения: DigiTimes Аналитики полагают, что в случае запрета поставок в Китай ускорителей H200 доля NVIDIA на местном рынке в 2026 году может сократиться до 8 %. При этом Huawei, как ожидается, укрепит позиции до 55–60 %. Если же поставки H200 в КНР будут одобрены, NVIDIA может занять 30–35 %, а Huawei — 45–48 %. При этом суммарная доля всех прочих игроков будет колебаться в пределах 24–27 %. По словам самой NVIDIA, запрет поставок ускорителей в Китай был большой ошибкой. В целом, считают эксперты, китайский рынок ИИ-чипов в период с 2023-го по 2028 году будет демонстрировать среднегодовой темп роста в сложных процентах (CAGR) на уровне 50 %. В результате, его объём за этот период увеличится с $11 млрд до $88 млрд.

16.01.2026 [16:57], Руслан Авдеев

Moody’s: несмотря на отсутствие явной прибыли, триллионные инвестиции в ИИ-инфраструктуру и не думают прекращатьсяВызванный развитием ИИ бум строительства ЦОД, похоже, не спешит идти на спад. При этом опасения возникновения «пузыря» на рынке и того, что вся «конструкция» рухнет от недостатка инвестиций, не особенно усиливаются, сообщает The Register со ссылкой на аналитику Moody’s. В отчёте Moody’s 2026 Outlook прогнозируется сохранение текущих тенденций. При этом спрос на вычислительные мощности продолжит расти из-за растущих же требований ИИ, облачных площадок и интернет-сервисов. Согласно имеющимся оценкам, чтобы обеспечить прогнозируемый рост вычислительных мощностей, до конца десятилетия потребуется не менее $3 трлн инвестиций (данные подтверждает JLL), включая расходы на строительство зданий, IT-инфраструктуры и реализацию связанных энергетических проектов, необходимых для обеспечения работы ЦОД. Тем не менее, эксперты обеспокоены ограниченными возможностями электросетей и проблемами со строительством новых ЦОД. Также отмечается, что получение реальных доходов становится «всё важнее в экосистеме ИИ» — это необходимо, чтобы слухи о возможных «пузырях» потеряли остроту. Поднятые вопросы далеко не новы. В мае 2025 года McKinsey & Company предупреждала, что огромные суммы на ИИ выделяются лишь на основе прогнозов спроса, т.е. всего лишь предположениях, пусть и обоснованных. Агентство прогнозировало, что к 2030 году инвестиции в ИИ ЦОД перевалят за $5 трлн. В MIT полагают, что 95 % корпоративных пользователей всё ещё не получили отдачи от вложений в ИИ, а Moody’s заявляет, что циклические сделки, при которых деньги циркулируют между ограниченным кругом компаний, включая OpenAI и Microsoft, уже пугают инвесторов.

Источник изображения: Arron Choi/unsplash.com Капитальные затраты шести крупнейших американских игроков — Microsoft, Amazon, Alphabet, Oracle, Meta✴ и CoreWeave — приблизились к $400 млрд в 2025 году и, вероятно, достигнут $500 млрд в 2026-м и $600 млрд в 2027-м. Пика общий объём инвестиций должен достигнуть в 2029 году, после чего в 2030 году вложения начнут сокращаться. Строительство новых ЦОД обходится всё труднее, во многом из-за ограниченного доступа к электроэнергии на большинстве рынков, не готовых удовлетворить такие скачки спроса. Moody’s отмечает, что в некоторых регионах общественность всё активнее противится строительству ЦОД, опасаясь, что те будут потреблять слишком много электричества и воды, а также повлияют на коммунальные платежи. При этом остаются регионы с «благоприятными законами», которые продолжат привлекать инвестиции. В 2025 году, например, Великобритания объявила о создании «зон роста» ИИ (AI Growth Zones) с упрощением бюрократических формальностей.

Источник изображения: Imagine Buddy/unsplash.com По мере того, как растут риски, от застройщиков требуют всё более быстрой реализации проектов, чтобы крупные арендаторы могли как можно быстрее наращивать IT-мощности. Этому мешает дефицит квалифицированных рабочих, строительных материалов и оборудования, из-за чего растут затраты. В отчёте подчёркивается, что некоторые арендаторы уже готовы к рискам, которых раньше старались избежать. Например, речь идёт о доступности электричества и коммунальных услуг и др. факторах. Moody's подчеркивает риски «круговых сделок» OpenAI, в ходе которых компания заключила соглашения на гигаватты новых мощностей ЦОД и другие активы стоимостью сотни миллиардов долларов. В основном финансирование этих активов зависит от долгосрочных договоров аренды с компаниями уровня Microsoft и Oracle, но растущая роль OpenAI в экосистеме ИИ создаёт нарастающий кредитный риск, зависящий от успеха компании. В своём последнем квартальном отчёте OpenAI сообщила о чистом убытке более $11,5 млрд. Недавно аналитики DC Byte назвали основные тренды рынка ЦОД в 2026 году: всё больше проектов ЦОД не доходят до стадии строительства, правительства всё активнее влияют на скорость реализации проектов, капитал всё больше расходуется на ранних стадиях реализации проектов, что повышает риски для инвесторов. Кроме того, рост рынка больше не завязан на крупнейшие ИИ-хабы вроде Северной Вирджинии или Сингапура и всё чаще участники рынка отдают предпочтение регионам с более стабильным энергоснабжением и прозрачными нормативами застройки.

16.01.2026 [13:56], Руслан Авдеев

Наобещали с три кампуса: к Oracle подан коллективный иск из-за непрозрачных условий финансирования мегапроекта для OpenAIПротив Oracle подан коллективный иск от группы недовольных держателей облигаций. Последние утверждают, что потеряли деньги, поскольку компания ввела их в заблуждение относительно того, сколько средств ей потребуется для финансирования своих инфраструктурных ИИ-проектов, сообщает Tom’s Hardware со ссылкой на Reuters. В частности, истцы заявляют, что компания сообщала, что ей «могут» понадобиться дополнительные заёмные средства тогда, когда уже запланировала эмиссию очередной партии облигаций. По имеющимся данным, Oracle продала векселя и облигации на сумму $18 млрд 25 сентября 2025 года для поддержки инфраструктурной сделки с OpenAI на $300 млрд. Тем не менее инвесторы были весьма удивлены, что она выпустила новые облигации на сумму $38 млрд приблизительно двумя месяцами спустя. Как заявляется в иске, рынок очень быстро и негативно отреагировал на увеличение долгов Oracle, расценив дополнительные обязательства по ценным бумагам как увеличившийся кредитный риск компании. Из-за этого первоначальная серия облигаций и векселей упала в цене и теперь продаётся, как ценные бумаги компаний с более низким рейтингом. Держатели ценных бумаг во главе с пенсионным фондом Ohio Carpenters’ Pension Plan утверждают, что в сопроводительных документах к первоначальным облигациям сообщалось, что компания лишь рассматривает возможность дополнительных займов. Истцы уверены, что Oracle уже знала на тот момент, что выпустит новую, значительно более крупную партию ценных бумаг для финансирования масштабирования своего бизнеса. По словам истцов, Oracle и некоторые из её топ-менеджеров, как и 16 банков, выступивших андеррайтерами кредита, несут ответственность в соответствии с Законом о ценных бумагах (Securities Act) 1933 года. В то время как эксперты раз за разом повторяли о возможности появления пузыря на рынке ИИ, Oracle агрессивно занимала средства для финансирования своих планов в этой сфере. Когда компания запустила раунд привлечения средств в сентябре 2025 года на $18 млрд, спрос на ценные бумаги был так высок, что в четыре раза превысил предложение. Но уже через три месяца инвесторы зарегистрировали потерю на ценных бумагах $1,3 млрд. И хотя S&P и Moody's всё ещё присваивают компании рейтинги инвестиционного уровня, оценка на уровнях BBB или Baa2 лишь немногим отличается от «мусорной». Более того, рейтинговые агентства могут пересмотреть оценки в зависимости от уровня рисков, которые компания принимает на себя. Масштабное строительство ИИ-площадок требует миллиардов, если не триллионов долларов инвестиций. Это, вероятно, не особенно большая проблема в случае с компаниями уровня Microsoft, Meta✴ и Amazon, имеющих большие резервы и способных без особенного напряжения вкладывать в строительство огромные суммы. Компаниям поменьше нередко требуется стороннее финансирование с помощью векселей и облигаций, продажи акций и др. в разных комбинациях. Более того, многие, действующие в сфере ИИ компании участвуют в сети перекрёстных инвестиций, проектов, продаж и займов, поэтому крах даже одной из них может означать катастрофический коллапс всей экосистемы.

15.01.2026 [18:19], Сергей Карасёв

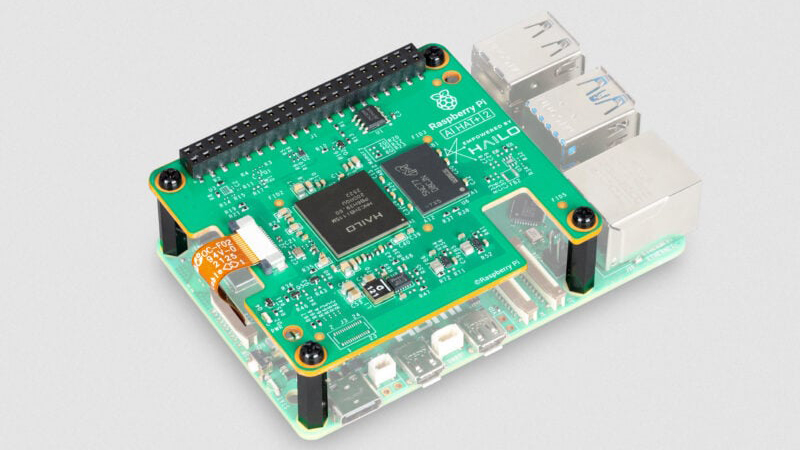

Модуль AI HAT+ 2 добавляет к Raspberry Pi 5 ИИ-ускоритель Hailo-10HКомпания Raspberry Pi анонсировала специализированный модуль расширения AI HAT+ 2, позволяющий использовать одноплатный компьютер Raspberry Pi 5 для ИИ-инференса. Новинка уже доступна для заказа по ориентировочной цене $130. Ранее Raspberry Pi выпустила ИИ-модуль AI HAT+, который в зависимости от модификации оснащается ускорителем Hailo-8 (26 TOPS) или Hailo-8L (13 TOPS). Такие изделия предназначены прежде всего для инференса. Решение Raspberry Pi AI HAT+ 2, в свою очередь, спроектировано под генеративный ИИ. В основу новинки положен ускоритель Hailo-10H, который позволяет использовать большие языковые модели (LLM), визуально-языковые модели (VLM) и другие модели генеративного ИИ локально. Чип функционирует в тандеме с 8 Гбайт LPDDR4/4X. Заявленная ИИ-производительность достигает 40 TOPS на операциях INT4. Для задач, основанных на машинном зрении, таких как распознавание объектов, оценка позы и сегментация сцены, производительность AI HAT+ 2 приблизительно эквивалентна быстродействию ранее выпущенного ИИ-модуля на базе Hailo-8.

Источник изображения: Raspberry Pi При подключении модуля операционная система Raspberry Pi OS автоматически обнаруживает ускоритель и переносит на него поддерживаемые задачи ИИ. Поначалу для изделия будут доступны следующие LLM: DeepSeek-R1-Distill, Qwen2.5-Coder, Qwen2.5-Instruct и Qwen2 (все с 1,5 млрд параметров), а также Llama3.2 (с 1 млрд параметров). В дальнейшем будут предложены более крупные модели.

15.01.2026 [12:40], Сергей Карасёв

Infineon представила чипы Airoc ACW741x с поддержкой Wi-Fi 7, Bluetooth LE 6.0 и Thread для IoT-оборудованияКомпания Infineon Technologies AG анонсировала чипы беспроводной связи серии Airoc ACW741x, предназначенные для применения в оборудовании интернета вещей (IoT). Изделия могут использоваться в технике для умного дома, IP-камерах, маршрутизаторах, концентраторах и пр. Чипы Airoc ACW741x объединяют в одном решении контроллер Bluetooth LE 6.0 и радиомодуль с поддержкой Wi-Fi 7 с возможностью работы в полосах 2,4/5/6 ГГц. Реализована технология Wi-Fi 7 Multi-Link (MLO), которая позволяет одновременно использовать несколько частотных диапазонов для повышения надёжности и пропускной способности, а также снижения задержек. Новинки используют архитектуру с каналами 20 МГц. Изделия поддерживают стандарт 802.15.4/Thread для беспроводных сетей с низким энергопотреблением и ячеистой топологией. Благодаря совместимости со стандартом Matter в единую сеть могут объединяться IoT-устройства разных производителей. Утверждается, что новые чипы обеспечивают до 15 раз меньшее энергопотребление в режиме ожидания по сравнению с конкурирующими решениями, что особенно важно в случае устройств, получающих питание от батареи. Упомянута функция канального зондирования Bluetooth 6.0 Channel Sounding: она обеспечивает возможность определения расстояния и местоположения устройств с точностью до сантиметра. Технология Wi-Fi Sensing на базе стандарта 802.11bf позволяет оборудованию Wi-Fi работать в качестве датчиков, способных определять присутствие и количество людей, их перемещения и даже жесты. Достигается это путём анализа отражений и искажений сигналов беспроводной связи. Чипы ACW741x выполнены в корпусе QFN. Диапазон рабочих температур в зависимости от модификации простирается от -40 до +85 °C или от -40 до +105 °C. Поставки образцов изделий уже начались.

15.01.2026 [01:05], Игорь Осколков

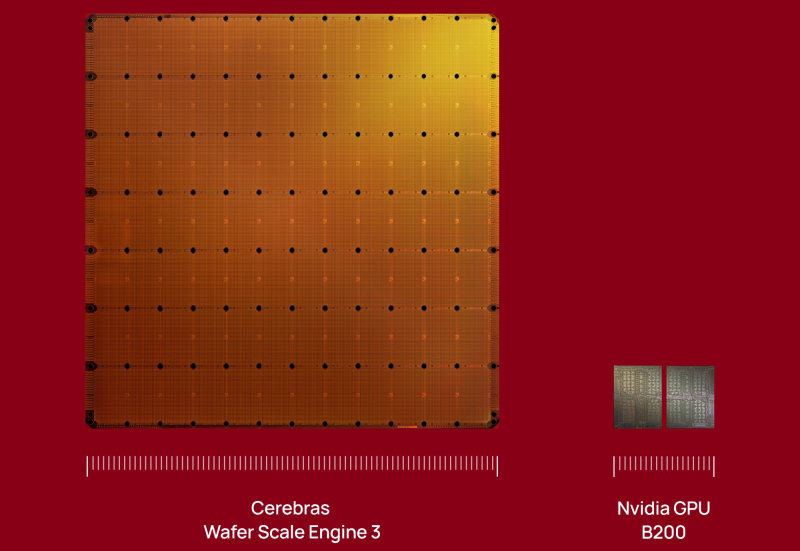

$10 млрд за 750 МВт ИИ-мощностей: OpenAI подписала сделку с CerebrasOpenAI подписала многолетнее соглашение с разработчиком царь-ускорителей Cerebras, который до 2028 поставит 750 МВт вычислительных мощностей. По данным CNBC, сумма сделки превышает $10 млрд. Идёт ли речь о продаже ИИ-ускорителей или предоставлении сервисов инференса, пока не уточняется. «Вычислительная стратегия OpenAI заключается в создании отказоустойчивого портфеля, в рамках которого для различных рабочих нагрузок подбираются подходящие системы», — сообщила OpenAI, отметив высокую скорость инференса решений Cerebras, что ускорит генерацию ответов, обеспечит более естественное взаимодействие и позволит масштабировать использование ИИ в реальном времени для гораздо большего числа людей. OpenAI использует комбинацию ускорителей AMD и NVIDIA, а также строит гигантские ЦОД на базе решений последней в рамках проекта Stargate. Кроме того, OpenAI сотрудничает с Google, у которой есть ускорители TPU, а также разрабатывает собственные ИИ-чипы в партнёрстве с Broadcom. Наконец, компания может повлиять на разработку нового поколения фирменных ускорителей Microsoft Maia. AWS тоже не прочь дать OpenAI свои ИИ-ускорители Trainium, но пока компании договорились лишь о масштабной аренде чипов NVIDIA. Примечательно, что OpenAI ещё в 2017 году раздумывала, не купить ли Cerebras при участии Tesla, глава которой Илон Маск (Elon Musk) тогда всё ещё работал в OpenAI. На тот момент Cerebras было всего два года, а свой первый ускоритель WSE она представила только в 2019 году. Серьёзную поддержку компании оказала G42 из ОАЭ, но в итоге Cerebras оказалась от неё слишком зависима, так что сделка с OpenAI сыграет компании на руку в преддверии всё откладывающегося выхода на биржу.

14.01.2026 [14:16], Сергей Карасёв

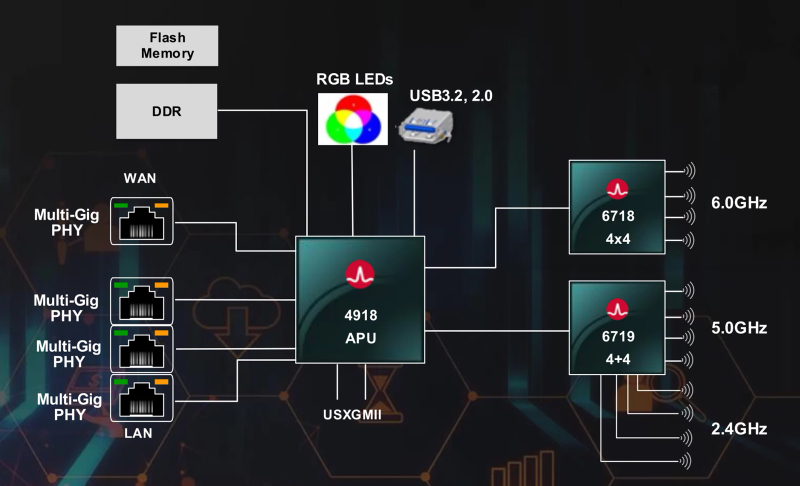

Broadcom представила чипы для точек доступа Wi-Fi 8Компания Broadcom анонсировала чипы нового поколения, предназначенные для создания точек доступа стандарта Wi-Fi 8. Дебютировали двухдиапазонные (2,4/5 ГГц) модули BCM6714 и BCM6719, а также процессор BCM4918 APU (Accelerated Processing Unit). Изделия BCM6714 и BCM6719 выполнены на основе трёхдиапазонного чипа Broadcom BCM6718 Wi-Fi 8, однако в отличие от последнего не поддерживают работу в полосе 6 ГГц. Новинки получили различные функции оптимизации энергопотребления. Предусмотрен встроенный усилитель мощности для диапазона 2,4 ГГц. Чипы имеют разную конфигурацию антенн: 4 × 4 для 2,4 ГГц и 4 × 4 для 5 ГГц у BCM6719 и 3 × 3 для 2,4 ГГц и 4 × 4 для 5 ГГц у BCM6714. В обоих случаях реализован аппаратный телеметрический движок, который в режиме реального времени собирает информацию о состоянии сети: эти данные затем могут быть использованы ИИ-моделью на периферии для повышения качества обслуживания, улучшения безопасности и снижения эксплуатационных расходов. В свою очередь, процессор BCM4918 APU объединяет четыре ядра с архитектурой Armv8 для задач общего назначения и движок Broadcom Neural Engine (BNE), предназначенный для ускорения операций, связанных с ИИ и машинным обучением. Реализованы два интерфейса USB и четыре контроллера PCIe. Упомянуты поддержка безопасной загрузки и расширенного шифрования, а также ускорение криптографических протоколов. Процессор BCM4918 APU можно комбинировать с чипами BCM6718 и BCM6714/BCM6719 для создания экономичных точек доступа Wi-Fi 8. Пробные поставки новых изделий уже начались. |

|