Материалы по тегу: hardware

|

18.08.2025 [14:09], Владимир Мироненко

OpenAI намерена потратить триллионы долларов на ИИ-инфраструктуру, но для начала их надо где-то найтиГенеральный директор OpenAI Сэм Альтман (Sam Altman) рассчитывает, что со временем компания потратит на создание ИИ-инфраструктуры триллионы долларов — однако нужно найти способ привлечь такие средства для реализации его планов, пишет Bloomberg. «Следует ожидать, что OpenAI потратит триллионы долларов на строительство ЦОД в “недалёком будущем”», — заявил Альтман журналистам в ходе брифинга. Он добавил, что «кучка экономистов» назовёт это безрассудством, на что будет ответ: «Знаете что? Позвольте нам заниматься своим делом». По словам Альтмана, стартап разрабатывает новый способ финансирования. «Мы можем разработать очень интересный новый вид инструмента для финансов и вычислений, который мир ещё не изобрел», — сказал он. Ранее было объявлено, что в течение четырёх лет на инфраструктурный проект Stargate будет израсходовано $500 млрд, но Альтман предполагает выйти далеко за рамки этой суммы. Альтман также сообщил, что видит параллели между нынешним инвестиционным ажиотажем в области ИИ и пузырём доткомов в конце 1990-х годов. По его словам, в обоих случаях «умные люди» были «чрезмерно воодушевлены» новой технологией. Но в каждом случае, по его мнению, эта технология была «реальной» и в конечном итоге должна была оказать долгосрочное влияние на деловой мир и общество. Глава OpenAI заявил, что считает развитие ИИ-технологий самым важным событием за очень долгое время, отметив, что «общество в целом» вряд ли пожалеет об огромных инвестициях в ИИ, но также признал, что считает некоторые текущие оценки стартапов «безумными» и «иррациональными»: «Кто-то на этом обожжётся». Несмотря на то, что OpenAI «потратит много денег», в конечном итоге это окупится и принесёт «огромную прибыль», пообещал Сэм Альтман: «Для нас очень разумно продолжать инвестировать прямо сейчас». Планы OpenAI также включают первичное публичное размещение акций в будущем, но Альтман отказался назвать конкретные сроки проведения IPO. «Я думаю, что когда-нибудь нам, вероятно, придётся выйти на биржу», — сказал гендиректор, отметив, что он не очень «хорошо подходит» для должности гендиректора публичной компании. В настоящее время OpenAI завершает сложную корпоративную реструктуризацию, которая продолжается уже несколько месяцев, отмечает Bloomberg.

18.08.2025 [12:58], Сергей Карасёв

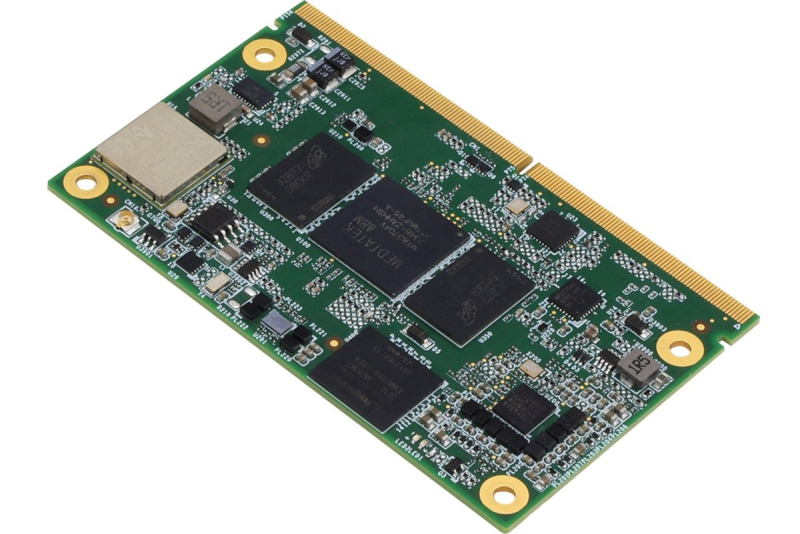

AAEON представила вычислительные модули на IoT-платформе MediaTek GenioКомпания AAEON анонсировала вычислительные SMARC-модули uCOM-M700 и uCOM-M510, предназначенные для использования в коммерческой и индустриальной сферах. Новинки могут применяться, в частности, для реализации человеко-машинных интерфейсов. Изделие uCOM-M700 выполнено на чипе MediaTek Genio 700 (MT8390). Этот процессор объединяет два ядра Arm Cortex-A78 с тактовой частотой до 2,2 ГГц и шесть ядер Arm Cortex-A55 с частотой до 2 ГГц. В оснащение входит графический блок Arm Mali-G57 MC3 GPU с производительностью до 4 TOPS. В свою очередь, uCOM-M510 использует процессор MediaTek Genio 510 (MT8370) с аналогичной конфигурацией вычислительных ядер, но максимальной частотой для обоих кластеров в 2 ГГц. Графический узел Arm Mali-G57 MC2 GPU обеспечивает производительность в 3,2 TOPS. Модели могут нести на борту до 8 Гбайт оперативной памяти LPDDR4. Предусмотрен накопитель eMMC 5.1 вместимостью 16 Гбайт с возможностью расширения до 32, 64 и 128 Гбайт. Поддерживаются интерфейсы HDMI 2.0, DP 1.4 (4К × 2К @ 60 Гц), eDP 1.2 (две линии) и MIPI-DSI (четыре линии), 1GbE, USB 3.0 (×1) и USB 2.0 (×5), UART, I2S, PCIe 2.0, MIPI CSI (×2), SPI (×1), I2C (×5) и пр. Вычислительные модули имеют размеры 82 × 50 мм. Диапазон рабочих температур простирается от 0 до +60 °C. Кроме того, предлагаются версии с расширенным температурным диапазоном — от -40 до +85 °C. Заявлена совместимость с Yocto 4.0 (ядро 5.15), Ubuntu, Android 14, Debian 13 (по запросу).

18.08.2025 [11:55], Руслан Авдеев

ИИ поможет Rolls-Royce стать самым дорогим бизнесом ВеликобританииRolls-Royce сделала ставку на малые модульные ядерные реакторы (SMR). Ожидается, что это поможет удовлетворить спрос на электроэнергию со стороны ИИ ЦОД. По словам руководства компании, эта стратегия может вывести промышленного гиганта в лидеры Лондонской фондовой биржи, сообщает eWeek. На сегодня она подписала с правительством Великобритании соглашение о строительстве первых трёх SMR, каждый из которых рассчитан на выработку 470 МВт электричества. Также Rolls-Royce намерена построить шесть аналогичных реакторов в Чехии, общая мощность которых составит 3 ГВт. Возможно, будут построены и два реактора в Швеции. Кроме того, SMR компании запитают нидерландские ЦОД Equinix. По прогнозам Международного энергетического агентства (IEA), к 2050 году мировой рынок SMR может составить около £500 млрд ($678) из-за огромных энергетических потребностей ИИ. В Rolls-Royse заявили, что спрос со стороны владельцев дата-центров способствовал пятидесятипроцентному росту её полугодовой прибыли. В июле компания сообщила, что спрос на её резервные генераторы для ЦОД очень высок, заказы год к году выросли на 85 %. Ожидается рост выручки в сегменте генерации энергии в среднесрочной перспективе приблизительно на 20 % ежегодно. По оценкам компании, к 2050 году миру потребуется 400 SMR, а стоимость каждого составит до £2,2 млрд ($3 млрд), хотя со временем она будет снижаться по мере роста производства. В Rolls-Royse рассчитывают занять лидирующие позиции на рынке, благо компания уже поставляет реакторы схожей конструкции для многочисленных атомных подводных лодок.

Источник изображения: Rolls-Royce Объём рынка оценивается в триллионы долларов, при этом в компании рассчитывают на превращение в самый дорогой бизнес Великобритании — у неё есть потенциал обогнать AstraZeneca, HSBC, Shell, Unilever и British American Tobacco. Отмечается, что подразделение Rolls-Royce SMR опережает конкурентов на полтора года в плоскости соблюдения всех европейских нормативных требований. Обладая преимуществами «первопроходца», компания имеет все шансы стать мировым лидером в сфере технологий SMR и создать ключевую экологически чистую технологию Великобритании «на экспорт». Вместе с тем глава Rolls-Royce признаёт, что SMR — непроверенная технология, поскольку ни одного коммерческого реактора такого типа не запущено. Кроме того, хотя такие реакторы должны строиться быстрее традиционных АЭС, высока вероятность, что они всё равно окажутся дорогими, ядерных отходов от них будет не меньше, а обеспечить их безопасность будет сложнее. Более того, энергоёмкие ЦОД, часто строящиеся в засушливых районах, сами по себе потребляют немало воды. SMR же могут дать дополнительную нагрузку на системы водоснабжения, что только усугубит проблему. Тем не менее, техногиганты готовы вкладывать немалые средства в развитие SMR-разработок, пытаясь обеспечить ИИ «чистой» энергией. Google поддерживает проект Kairos Power, являющийся частью федеральной инициативы на $300 млн. Meta✴ подписала контракт на 20 лет с Constellation, предполагающий поставки электроэнергии АЭС Clinton в Иллинойсе, энергокомпания изучает возможность строить SMR на этой площадке. Amazon (AWS) заключила три соглашения, поддерживающие строительство SMR в США. В целом Google, Meta✴ и Amazon также пообещали поддержать глобальные усилия по наращиванию втрое атомных мощностей к 2050 году, призвав ускоренно внедрять новые реакторы в энергетическом секторе.

18.08.2025 [10:10], Руслан Авдеев

Rio AI City: Рио-де-Жанейро станет ИИ-городом при поддержке NVIDIA и OracleВласти Рио-де-Жанейро (Бразилия) анонсировали стратегическое партнёрство с Oracle и NVIDIA. Мэр мегаполиса Эдуардо Паес (Eduardo Paes) объявил о реализации проекта Rio AI City, который призван превратить город в один из главным мировых центров в сфере ИИ, сообщает Datacenter Dynamics. Ведутся переговоры и с другими крупными компаниями. По мнению Паеса, Рио станет ИИ-столицей Бразилии, куда «все захотят». Город закупит оборудование NVIDIA и вычислительные мощности у Oracle. NVIDIA подписала меморандум о взаимопонимании с местной мэрией, предусматривающей покупку ускорителей для ИИ-модели, которую муниципалитет собирается внедрять в рамках проекта Rio AI City. Ещё одно соглашение предусматривает участие в проекте Oracle. Сегодня Oracle управляет в Бразилии двумя облачными регионами — в Сан-Паулу и его окрестностях. Регион Brazil East открыли в 2020 году, а регион Brazil Southeast в соседнем муниципалитете Виньеду — в 2021 году. Rio AI City будет реализован под руководством компании Elea Data Centers, которая строит гигаваттный кампус к западу от Рио, где у неё уже имеется действующий ЦОД RJO1 — он станет первым дата-центром проекта, хотя действует ещё с Олимпийских игр 2016 года. В Elea Data Centers подчеркнули, что многостороннее партнёрство позволяет сделать шаг к реализации проекта Rio AI City — это проект с надёжной инфраструктурой и «чистой» энергией, готовый привлечь таланты и компании, которые станут формировать будущую цифровую эру Бразилии. Завершение строительства 80-МВт RJO2 запланировано на 2026 год. После него будут построены RJO3 и RJO4, которые добавят кампусу ещё 120 МВт. Уже к 2027 году мощность проекта может вырасти до 1,5 ГВт, а к 2032 году — до 3,2 ГВт, благодаря чему Rio AI City превратится в один из крупнейших ЦОД в мире. Впрочем, за это звание ещё придётся побороться.

18.08.2025 [08:59], Руслан Авдеев

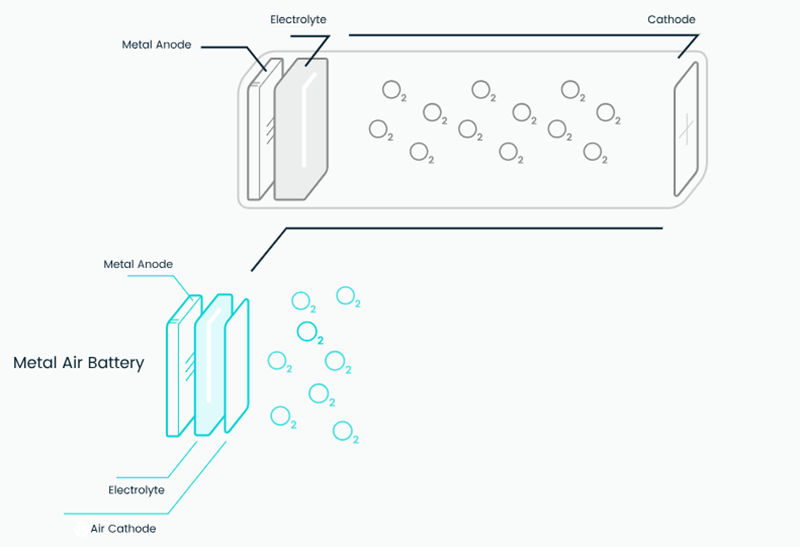

Необычные воздушно-алюминиевые генераторы Phinergy пропишутся в ЦОД СШАРазрабатывающая энергетические решения израильская компания Phinergy заключила соглашение с американской электротехнической компанией Rosendin для развёртывания инновационных воздушно-алюминиевые генераторов (AAG) в американских ЦОД, сообщает Datacenter Dynamics. Phinergy была основана в 2009 году, а в 2021 году вышла на IPO в Тель-Авиве. В марте того же года было создано совместное предприятие с Indian Oil для развития систем «воздух-алюминий» в Индии. Rosendin, базирующаяся в Калифорнии, заключила несколько партнерских соглашений в секторе ЦОД для поддержки интеграции систем хранения энергии на базе аккумуляторов и и иных технологий. В рамках партнёрства предлагается замена резервных дизель-генераторов критически важных объектов на AAG Phinergy, которые позволяют генерировать энергию практически без вредных выбросов (в первую очередь CO2), если не считать отработавшие химические компоненты. Алюминиево-воздушные батареи — это первичный химический источник питания, где алюминий (анод) окисляется кислородом воздуха, который восстанавливается на катоде. Такая батарея имеет высокую энергоёмкость, но перезарядить её от другого источника тока невозможно — после того, как алюминий будет израсходован, её нужно заменять. Ключевое преимущество AAG заключается в высокой ёмкости и вместе с тем лёгкости батарей. По словам Phinergy, её AAG способны обеспечить приблизительно 10 МВт∙ч/м3, а дизельное топливо — 4 МВт∙ч. При этом обещано, что AAG будут дешевле дизеля.

Источник изображения: Phinergy Phinergy ориентируется на дата-центры как на ключевых потребителей своих решений и утверждает, что её батареи способны обеспечить отказоустойчивую работу ЦОД гиперскейл-уровня в течение нескольких дней. В компании подчёркивают, что сотрудничество с Rosendin станет новым этапом для масштабирования воздушно-алюминиевой технологии в секторе ЦОД, одном из самых быстрорастущих энергетических рынков. В Rosendin же заявляют, что новое решение отвечает растущей потребности ЦОД в надёжном, безуглеродном энергоснабжении в связи с расширением рынка дата-центров. Технология Phinergy также была выбрана европейской организацией Net Zero Innovation Hub for Data Centers, куда входят Data4, Google, Microsoft, Vertiv и Schneider Electric, выбрал её в качестве ключевой технологии для ускорения перехода к ЦОД с нулевыми выбросами. Это позволит компании масштабироваать свои системы резервного питания до мегаваттного уровня и ускорить их развёртывание. Современным ИИ ЦОД действительно требуются гигантские системы резервного питания.

17.08.2025 [18:08], Руслан Авдеев

Google потратит $9 млрд на развитие облачной и ИИ-инфраструктуры в Оклахоме — часть пойдёт на обучение электриковКомпания Google взяла обязательство вложить $9 млрд в расширение собственной облачной и ИИ-инфраструктуры на территории штата Оклахома (США). Инвестиции направят на развитие кампуса ЦОД в Стиллуотере (Stillwater) и расширение уже имеющегося объекта в Прайоре (Prior), сообщает Datacenter Dynamics. Часть выделенных средств будет потрачена на программы образования и развития персонала. В марте 2025 года стало известно, что Google подала заявку на строительство кампуса ЦОД в Стиллоутере. Тогда было объявлено, что на него потратят $3 млрд, а площадь кампуса составит более 160 га. Подробных данных о кампусе нет, но согласно проекту плана экономического развития от августа 2024 года, предполагается построить до шести зданий, каждое площадью почти 29 тыс. м2. На каждом этапе строительства предполагается строить по одному ЦОД. Объект в Прайоре Google анонсировала ещё в 2007 году, запуск состоялся в 2011-м. С тех пор дата-центр регулярно расширялся. Университет Оклахомы (University of Oklahoma) и Университет штата Оклахома (Oklahoma State University) готовы участвовать в инициативе Google AI for Education Accelerator. В её рамках можно будет получить сертификаты Google Career Certificates, а также доступ к бесплатным курсам обучения ИИ-навыкам. Также Google финансирует в Оклахоме национальную программу обучения, созданную для подготовки квалифицированных электриков — Electrical Training Alliance.

Источник изображения: Gerson Repreza/unsplash.com Ранее Оклахома никогда не считалась крупным рынком ЦОД и сопутствующих технологий. Среди недавно анонсировавших проекты ЦОД в Оклахоме — компании Cerebras, Damac и CoreWeave с Core Scientific. По слухам, кампус площадью около 138 га готовит и Meta✴. Также есть данные, что в мае подана заявка на строительство кампуса площадью более 200 га в Талсе (Tulsa), но что за компания стоит за проектом, не разглашается.

17.08.2025 [14:15], Сергей Карасёв

Inspur разработала СЖО для мегаваттных стоек с 3-кВт ИИ-ускорителямиКитайская компания Inspur Information представила передовую систему двухфазного жидкостного охлаждения для ИИ-платформ следующего поколения, таких как суперускоритель Metabrain SD200. Решение может использоваться для отвода тепла от серверных стоек мегаваттного класса. Inspur отмечает, что из-за стремительного развития ИИ наблюдается тенденция к повышению плотности вычислений. Это приводит к быстрому увеличению энергопотребления стоек с серверным оборудованием. Различные компании, такие как Aligned, JetCool и CyrusOne, разрабатывают решения для стоек мощностью 300 кВт, тогда как крупные ЦОД-операторы и гиперскейлеры готовятся к появлению мегаваттных установок. В таких условиях возможностей стандартных систем охлаждения становится недостаточно. Двухфазная СЖО Inspur способна охлаждать кристаллы мощностью более 3000 Вт, тогда как показатель теплосъёма превышает 250 Вт на квадратный 1 см2. Благодаря изоляции хладагента предотвращается коррозия, что сводит к минимуму риск коротких замыканий, снижает износ и отказы компонентов, говорит компания. Ключевыми преимуществами новой СЖО названы надёжность и долговечность, отсутствие утечек, простота эксплуатации, безопасная работа IT-оборудования, а также уменьшение общей стоимости владения по сравнению с другими аналогичными решениями. При разработке системы специалистам Inspur Information удалось преодолеть узкие места управления температурой и давлением фазового перехода, а также решить проблемы дисбаланса потока и перегрева во время скачков нагрузки: утверждается, что в конфигурации с 200 чипами отклонение распределения потока составляет менее 10 %, а разница температур — менее 2 °C. Применяется специально разработанный хладагент низкого давления, который безопасен для окружающей среды. Несмотря на отсутствие риска утечки, рабочее давление системы составляет менее 1 МПа.

16.08.2025 [15:16], Сергей Карасёв

Inspur представила суперускоритель Metabrain SD200 для ИИ-моделей с триллионами параметровКитайская компания Inspur создала суперускоритель Metabrain SD200 для наиболее ресурсоёмких задач ИИ. Система, как утверждается, может работать с моделями, насчитывающими более 1 трлн параметров. Платформа Metabrain SD200 объединяет 64 карты в единый суперузел с унифицированной памятью. В основу положены открытая архитектура 3D Mesh и проприетарные коммутаторы Open Fabric Switch. Иными словами, ускорители на базе GPU, распределённые по разным серверам, объединяются посредством высокоскоростного интерконнекта в единый домен. Суперускоритель предоставляет доступ к 4 Тбайт VRAM и 64 Тбайт основной RAM. Благодаря этому возможен одновременный запуск четырёх китайских ИИ-моделей с открытым исходным кодом, включая DeepSeek R1 и Kimi K2. Кроме того, поддерживается совместная работа нескольких ИИ-агентов в режиме реального времени. Для Metabrain SD200 заявлена низкая задержка при передаче данных, которая исчисляется «сотнями наносекунд». В распространённых сценариях инференса, предполагающих обработку небольших пакетов данных, по величине задержки система превосходит распространённые отраслевые решения. В составе новой платформы задействованы средства оптимизации. В частности, инструмент Smart Fabric Manager автоматически формирует оптимальные маршруты данных на основе характеристик нагрузки. Metabrain SD200 совместим с распространёнными фреймворками, такими как PyTorch, vllm и SGLang: благодаря этому возможен быстрый перенос существующих моделей и ИИ-агентов без необходимости переписывать программный код с нуля. Таким образом, значительно снижается стоимость миграции. В целом, реализованная технология удалённого vGPU позволяет ускорителям, распределённым по разным серверам, взаимодействовать столь же эффективно, как если бы они находились на одном хосте. При этом достигается восьмикратное расширение адресного пространства, что обеспечивает полную загрузку ресурсов и эффективную работу даже при использовании ИИ-моделей с триллионами параметров.

16.08.2025 [14:45], Сергей Карасёв

Dell представила ИИ-серверы PowerEdge R7725 и R770 на базе NVIDIA RTX Pro 6000 Blackwell Server EditionКомпания Dell анонсировала серверы PowerEdge R7725 и PowerEdge R770 в форм-факторе 2U, построенные на аппаратной платформе AMD и Intel соответственно. Новинки оснащаются ускорителями NVIDIA RTX Pro 6000 Blackwell Server Edition. Модель PowerEdge R7725 может нести на борту два процессора AMD EPYC 9005 (Turin), а также до 6 Тбайт оперативной памяти DDR5-6400 в виде 24 модулей. Доступны до восьми слотов PCIe 5.0 x8 или x16. При этом возможна установка двух GPU-ускорителей. Сервер предлагает различные варианты исполнения подсистемы хранения данных с фронтальным доступом: 12 × LFF SAS/SATA, 8/16/24 × SFF SAS/SATA, 16 × SFF SAS/SATA + 8 × U.2/NVMe или 8/16/32/40 × EDSFF E3.S. Имеется выделенный сетевой порт управления 1GbE, а дополнительно предлагается установка адаптеров с поддержкой 1GbE, 10GbE, 25GbE, 100GbE и 400GbE. В свою очередь, вариант PowerEdge R770 комплектуется двумя чипами Intel Xeon 6 Granite Rapids с производительными Р-ядрами или Xeon 6 Sierra Forest с энергоэффективными Е-ядрами. Реализованы 32 слота для модулей оперативной памяти DDR5-6400 суммарным объёмом до 8 Тбайт. Предлагается широкий набор опций в плане установки накопителей в лицевой и тыльной частях корпуса, включая 24 × SFF SAS/SATA и 40 × EDSFF E3.S. Система может быть укомплектована четырьмя картами OCP NIC 3.0 (вплоть до 400GbE). Есть слоты PCIe 5.0 x8 и x16. Серверы поддерживают воздушное и прямое жидкостное охлаждение (DLC). Мощность блоков питания с сертификатом 80 Plus Titanium достигает 3200 Вт. Заявлена совместимость с Canonical Ubuntu Server LTS, Windows Server (Hyper-V), Red Hat Enterprise Linux, SUSE Linux Enterprise Server и VMware ESXi.

15.08.2025 [18:15], Руслан Авдеев

Саудовская center3 потратит $10 млрд на ЦОД общей мощностью 1 ГВтКомпания center3 из Саудовской Аравии, принадлежащая STC (Saudi Telecom) и занимающаяся строительством дата-центров, к 2030 году намерена довести мощность своих ЦОД до 1 ГВт — в дополнение к уже потраченным на дата-центры $3 млрд будут инвестированы ещё $10 млрд, сообщает Datacenter Dynamics. Center3, основанная в 2022 году, является дочерней структурой STC. Компания строит и эксплуатирует в Саудовской Аравии за её пределами, в том числе в Бахрейне, около 20 дата-центров. Согласно её планам, общая установленная мощность к 2027 году должна достичь 300 МВт. Подробности о том, как именно компания намерена инвестировать $10 млрд и где именно разместятся новые дата-центры, пока не разглашаются.

Источник изображения: SALEH/unsplash.com По словам генерального директора center3 Фахада Аль-Хаджери (Fahad AlHajeri), речь идёт не просто о расширении портфолио дата-центров, но и о создании условий для развития цифровой экономики будущего. Как заявил глава компании, выбор мощности в 1 ГВт закладывает основу для ИИ-проектов, облачных вычислений и выполнения рабочих нагрузок гиперскейл-уровня. Это гарантирует Саудовской Аравии и всему региону создание инфраструктуры мирового класса, которая позволит пробиться в мировые лидеры в ходе следующей волны глобальных инноваций. В 2024 году компания расширила кампус ЦОД Khurais Riyadh в Эр-Рияде, увеличив его мощность на 9,6 МВт. В августе 2024 года Oracle объявила о размещении своего облачного региона в дата-центре center3. В ЦОД center3 размещается и облачный регион Huawei. В октябре center3 объявила о партнёрстве с саудовским строителем дата-центров DataVolt. |

|