Материалы по тегу: h200

|

08.07.2025 [17:09], Владимир Мироненко

Российский суперкомпьютер «Говорун» получил два узла «РСК Экзастрим ИИ» с NVIDIA H100 и фирменной СЖО

emerald rapids

h100

h200

hpc

intel

nvidia

sapphire rapids

xeon

россия

рск

сделано в россии

сервер

суперкомпьютер

ГК РСК продемонстрировала 2U-узел (912 × 508 × 88 мм) собственной разработки «РСК Экзастрим ИИ» на базе восьми ускорителей NVIDIA H100 с прямым жидкостным охлаждением. Два таких узла были установлены в суперкомпьютере «Говорун» в Дубне. «РСК Экзастрим ИИ» включает:

«РСК Экзастрим ИИ» имеет локальную подсистему хранения «тёплых данных», сетевую подсистему с доступом на основе технологии GPUDirect. Также есть возможность расширения ресурсов путём подключения дополнительных пар ускорителей или системы внешнего хранения данных на базе пула JBOF, подключаемой напрямую. Производительность «РСК Экзастрим ИИ» составляет до 208 Тфлопс (FP64). При установке 21 сервера в шкаф «РСК Экзастрим» пиковая производительность достигает 4,26 Пфлопс (FP64). Сервер отличается высокой энергоэффективностью, сверхвысокой плотностью монтажа и надёжной работой. Он может использоваться для решения ресурсоёмких задач в области машинного обучения и ИИ, создания мощных вычислительных ресурсов облачных провайдеров и в частных облаках и т.д.

Источник изображений: РСК Два узла «РСК Экзастрим ИИ» были установлены в суперкомпьютере «Говорун» в Лаборатории информационных технологий им М.Г. Мещерякова Объединенного института ядерных исследований (ЛИТ ОИЯИ) в Дубне в рамках нового этапа модернизации, проведенной силами специалистов ГК РСК и лаборатории. Как сообщается, новые серверы «РСК Экзастрим ИИ» уникальны и были сконструированы и изготовлены для СК «Говорун» с учётом его архитектурных особенностей. При этом пиковая FP64-производительность GPU-компоненты суперкомпьютера «Говорун» выросла на 36 % и достигла 1,4 Пфлопс, пиковая суммарная FP64-производительность суперкомпьютера теперь составляет 2,2 Пфлопс. Характеристики серверов «РСК Экзастрим ИИ», установленных в ОИЯИ:

В конце 2024 года было проведено расширение СХД суперкомпьютера «Говорун», после чего её ёмкость увеличилась до 10 Пбайт. В СХД вычислительного комплекса ОИЯИ были добавлены два узла хранения данных RSC Tornado AFS ёмкостью 1 Пбайт каждый. Обновленная модификация СХД RSC Tornado AFS включает серверную плату на базе процессоров Intel Xeon Sapphire Rapids, а также коммутатор с интерфейсом PCIe 4.0, что позволило установить по два адаптера интерконнекта с пропускной способностью 200 Гбит/с каждый.  СХД RSC Tornado AFS поддерживает технологию GPUDirect Storage (GDS), которая обеспечивает прямую передачу данных между локальным или удалённым хранилищем и памятью ускорителя. Две СХД, установленные ранее специалистами РСК в суперкомпьютере «Говорун» входят в мировой рейтинг IO500 самых высокопроизводительных системам хранения данных. В суперкомпьютере «Говорун» используются интегрированный программный комплекс «РСК БазИС 4» и модуль «РСК БазИС СХД» (включены в Реестр российского ПО). Микроагентная архитектура «РСК БазИС 4» обеспечивает функционирование объектов системы, позволяя также взаимодействовать с ними. «РСК БазИС» в сочетании с аппаратными платформами РСК позволяет создавать гиперконвергентные решения для HPC и эффективной обработки больших объёмов данных.

23.06.2025 [11:58], Сергей Карасёв

Подземный суперкомпьютер Olivia стал самым мощным в НорвегииВ Норвегии введён в эксплуатацию самый мощный в стране суперкомпьютер — система Olivia, созданная корпорацией HPE. Комплекс расположен в дата-центре Лефдаль (Lefdal Mine Datacenter, LMD) на базе бывшего рудника, а для его охлаждения используется холодная вода из близлежащего фьорда. Машина построена на платформе HPE Cray Supercomputing EX (EX254n). В её состав входят 252 узла, каждый из которых содержит два 128-ядерных процессора AMD EPYC 9745 (Turin). В сумме это даёт 64 512 CPU-ядер. Кроме того, задействован GPU-кластер с 76 узлами, оснащёнными четырьмя гибридными суперчипами NVIDIA GH200: таким образом, в общей сложности применены 304 ускорителя. Используется интерконнект HPE Slingshot 11. За хранение данных отвечает система HPE Cray ClusterStor E1000 вместимостью 5,3 Пбайт. В текущей конфигурации GPU-кластер Olivia обладает производительностью 13,2 Пфлопс (FP64) и пиковым быстродействием 16,8 Пфлопс. При этом энергопотребление составляет 219 кВт. Таким образом, машина демонстрирует производительность в 60,274 Гфлопс/Вт. В июньском рейтинге мощнейших суперкомпьютеров мира TOP500 GPU-комплекс Olivia располагается на 117-й позиции, тогда как в списке самых энергоэффективных суперкомпьютеров GREEN500 он занимает 22-ю строку. CPU-блок Olivia занимает 271-е место в рейтинге с фактической и пиковой FP64-производительностью 4,25 и 4,95 Пфлопс соответственно. Olivia эксплуатируется государственной компанией Sigma2. Применять суперкомпьютер планируется для проведения исследований в различных областях, включая изменения климата, здравоохранение, ИИ и пр. Суперкомпьютер обладает возможностями для дальнейшего расширения. В частности, количество ядер CPU может быть увеличено до 119 808. Кроме того, могут быть добавлены ещё 224 ускорителя.

11.06.2025 [09:11], Владимир Мироненко

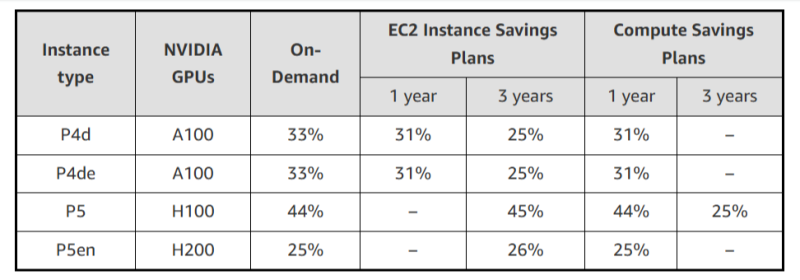

AWS резко снизила стоимость EC2-инстансов с ускорителями NVIDIA, но только для старых моделейAWS объявила об очередном снижении тарифов на GPU-инстансы, которое, по словам компании, стало регулярной практикой благодаря активной работе над снижением расходов. Впрочем, в период острого дефицита вычислительных мощностей в последние год-два, когда использование ускорителей даже для внутренних нужд было резко ограничено, компания наверняка заработала достаточно, чтобы неоднократно окупить закупку и обслуживание соответствующего «железа». На прошлой неделе была снижена до 45 % стоимость использования инстансов EC2 на базе ускорителей NVIDIA, включая семейства P4 (P4d и P4de на базе A100) и P5 (P5 и P5en на базе H100 и H200 соответственно). Снижение стоимости тарифов On-Demand и Savings Plan распространяется на все регионы, где доступны эти инстансы. На On-Demand — с 1 июня, на Savings Plan — после 4 июня. Savings Plans предлагает гибкую модель ценообразования с низкими ценами на использование вычислений в обмен на обязательство по постоянному объёму использования (измеряется в $/час) в течение 1 года или 3 лет. AWS предлагает два типа Savings Plans:

Чтобы обеспечить повышенную доступность по сниженным ценам, AWS предоставляет масштабируемую ёмкость в рамках тарифа On-Demand для:

Также теперь AWS предлагает инстансы Amazon EC2 P6-B200 в рамках тарифа Savings Plan для поддержки крупномасштабных развёртываний, которые стали доступны 15 мая 2025 года при запуске только через EC2 Capacity Blocks для машинного обучения. Инстансы EC2 P6-B200 на базе ускорителей NVIDIA Blackwell обеспечивают обработку широкого спектра рабочих нагрузок, но особенно хорошо подходят для крупномасштабного распределённого обучения и ИИ-инференса, отметила AWS.

20.05.2025 [12:05], Сергей Карасёв

В Казахстане заработает самый мощный суперкомпьютер в Центральной АзииМинистерство цифрового развития, инноваций и аэрокосмической промышленности Республики Казахстан (МЦРИАП) сообщило о том, что в страну доставлены узлы нового НРС-комплекса, который после сборки и запуска станет самым мощным суперкомпьютером в Центральной Азии. Система будет смонтирована в новом дата-центре МЦРИАП класса Tier III. Напомним, Минцифры Казахстана, АО «Фонд национального благосостояния «Самрук-Қазына» и компания Presight AI Ltd. из ОАЭ подписали соглашение о создании суперкомпьютера в феврале 2024 года. Проект реализуется в рамках Концепции развития искусственного интеллекта до 2029 года и является одним из ключевых этапов формирования современной ИТ-инфраструктуры Казахстана. Доставленная в республику система представляет собой первый в истории центральноазиатского региона суперкомпьютерный кластер. В его основу положены ускорители NVIDIA H200 на архитектуре Hopper. Заявленная производительность достигает примерно 2 Эфлопс (на операциях ИИ). Более подробные технические характеристики машины пока не раскрываются.

Источник изображения: NVIDIA Ресурсы суперкомпьютера будут доступны всем участникам рынка. Мощности НРС-комплекса, в частности, смогут использовать стартапы для обучения нейросетей, университеты для проведения фундаментальных и прикладных исследований, а также научные центры и компании, внедряющие ИИ в бизнес-процессы. МЦРИАП подчеркивает, что запуск суперкомпьютера станет важным этапом в реализации послания президента страны по созданию собственной цифровой инфраструктуры и развитию национальной ИИ-экосистемы. В рамках проекта Казахстан впервые выстроил механизм ввоза высокотехнологичного оборудования без пошлин и НДС. Кроме того, во время официального визита в Казахстан наследного принца Абу-Даби, шейха Халеда бин Мохаммеда бин Зайда Аль Нахайяна состоялось открытие зарубежного офиса компании Presight (G42) в Астане. Новый офис, расположенный на территории «Экспо», выполняет функцию регионального хаба в Центральной Азии. В перспективе планируется формирование ситуационного центра, который станет интеллектуальным ядром городской инфраструктуры Астаны. Передовая платформа обеспечит мониторинг и принятие решений в различных областях, включая энергетику, общественную безопасность и управление городской инфраструктурой. «Это стратегически важный шаг в построении цифровой инфраструктуры страны. Он укрепит цифровой суверенитет Казахстана и лидирующую позицию в регионе по развитию технологий ИИ и привлечению глобальных IT-игроков», — говорит министр цифрового развития, инноваций и аэрокосмической промышленности Республики Казахстан Жаслан Мадиев.

19.05.2025 [23:55], Владимир Мироненко

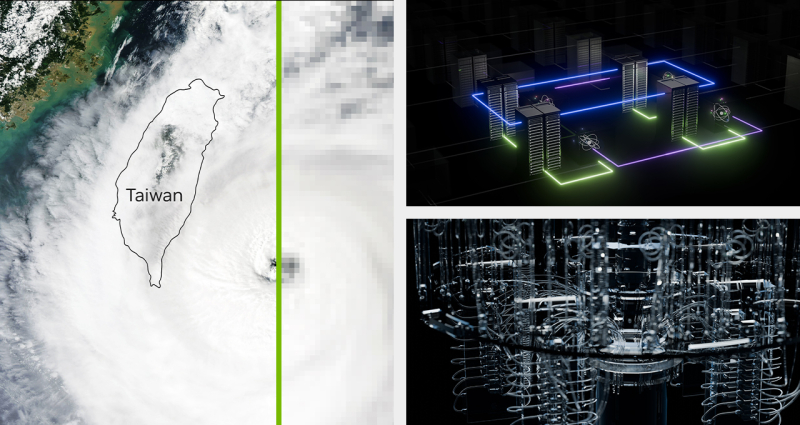

NVIDIA построит на Тайване новую штаб-квартиру и развернёт два ИИ-суперкомпьютераNVIDIA построит в ближайшем будущем на Тайване новую штаб-квартиру, а также два ИИ-суперкомпьютера. Об этом сообщил гендиректор американской компании Дженсен Хуанг (Jensen Huang), подтвердив свою приверженность Тайваню как глобальному технологическому центру, пишет The Financial Times. Хуан отдал должное Тайваню, «крупнейшему региону по производству электроники в мире», назвав его «центром компьютерной экосистемы». Строительством первого ИИ-суперкомпьютера на базе 10 тыс. ускорителей Blackwell займётся Big Innovation Company, «дочка» Foxconn, в сотрудничестве с NVIDIA и при поддержке тайваньского правительства. Стоимость суперкомпьютера, который будут использоваться в технологической экосистеме Тайваня, составит сотни миллионов долларов. В числе клиентов будущего суперкомпьютера Хуанг назвал TSMC, ключевого производственного партнёра NVIDIA, которая будет использовать его вычислительные мощности для исследований и разработки новых процессов создания чипов. Второй ИИ-суперкомпьютер построит ASUS в интересах Национального HPC-центра NCHC (National Center for High-Performance Computing). Он будет ориентирован на исследование климата, разработку квантовых технологий, создание LLM и иную R&D-деятельность. Система будет в восемь раз мощнее суперкомпьютера Taiwania 2, в создании которого также принимала участие ASUS. Новинка получит узлы HGX H200 (всего 1700 ускорителей), две стойки GB200 NVL72, а также HGX B300, объединённые интерконнектом Quantum InfiniBand. Кроме того, NCHC планирует установить системы DGX Spark и развернуть облачный HGX-кластер. «Мы растём за пределы нашего текущего офиса [на Тайване]», — заявил Хуан, демонстрируя видео приземления футуристического космического корабля и его последующей трансформации в дизайн новой штаб-квартиры Constellation («Созвездие»), строительство которой начнется в ближайшее время в Бэйтоу (Beitou), районе Тайбэя. Дженсен Хуанг также представил интерконнект NVLink Fusion, который позволит объединить решения NVIDIA с решениями конкурентов. Таким способом компания надеется закрепить свою технологию в качестве решения для базовой инфраструктуры. «Ничто не радует меня больше, чем, когда вы покупаете всё у NVIDIA… но мне доставляет огромную радость, если вы просто покупаете что-то у NVIDIA», — пошутил он. На вопрос о возможности создания NVIDIA нового чипа для Китая, который бы соответствовал последним экспортным ограничениям США, Хуанг заявил, что компания «оценивает, как лучше всего выйти на китайский рынок», отметив, что дальнейшие модификации H20 невозможны. Вместе с тем NVIDIA рассматривает возможность перепроектирования своих чипов с учётом новых ограничений, чтобы продолжать продавать их в Китае. На прошлой неделе стало известно о планах NVIDIA построить новый исследовательский центр в Шанхае в знак своей приверженности Поднебесной. Хуанг добавил, что «нет никаких доказательств контрабанды каких-либо ИИ-чипов» в Китай. Из-за опасений по поводу нелегальных поставок передовых чипов NVIDIA в Китай американские законодатели потребовали в прошлом месяце от компании предоставить отчёт о продажах её продукции в Китае и Юго-Восточной Азии.

28.04.2025 [14:48], Сергей Карасёв

ИИ-суперкомпьютер в чемодане — GigaIO Gryf обеспечит производительность до 30 ТфлопсКомпания GigaIO объявила о доступности системы Gryf — так называемого ИИ-суперкомпьютера в чемодане, разработанного в сотрудничестве с SourceCode. Это сравнительно компактное устройство, как утверждается, обеспечивает производительность ЦОД-класса для периферийных развёртываний. Первая информация о Gryf появилась около года назад. Устройство выполнено в корпусе с габаритами 228,6 × 355,6 × 622,3 мм, а масса составляет примерно 25 кг. Система может эксплуатироваться при температурах от +10 до +32 °C. Конструкция предусматривает использование модулей Sled четырёх типов: это вычислительный узел Compute Sled, блок ускорителя Accelerator Sled, узел хранения Storage Sled и сетевой блок Network Sled. Доступны различные конфигурации, но суммарное количество модулей Sled в составе Gryf не превышает шести. Плюс к этому в любой комплектации устанавливается модуль питания с двумя блоками мощностью 2500 Вт. Узел Compute Sled содержит процессор AMD EPYC 7003 Milan с 16, 32 или 64 ядрами, до 512 Гбайт DDR4, системный SSD формата M.2 (NVMe) вместимостью 512 Гбайт и два порта 100GbE QSFP56. Блок Storage Sled объединяет восемь накопителей NVMe SSD E1.L суммарной вместимостью до 492 Тбайт. Модуль Network Sled предоставляет два порта QSFP28 100GbE и шесть портов SFP28 25GbE. За ИИ-производительность отвечает модуль Accelerator Sled, который может нести на борту ускоритель NVIDIA L40S (48 Гбайт), H100 NVL (94 Гбайт) или H200 NVL (141 Гбайт). В максимальной конфигурации быстродействие в режиме FP64 достигает 30 Тфлопс (3,34 Пфлопс FP8), а пропускная способность памяти — 4,8 Тбайт/с.

Источник изображения: GigaIO Архитектура новинки обеспечивает возможность масштабирования путём объединения в единый комплекс до пяти экземпляров Gryf: в общей сложности можно совместить до 30 модулей Sled в той или иной конфигурации. Заказы на Gryf уже поступили со стороны Министерства обороны США, американских разведывательных структур и пр.

05.04.2025 [10:36], Сергей Карасёв

Европейский суперкомпьютер Discoverer получил обновление в виде NVIDIA DGX H200Европейское совместное предприятие по развитию высокопроизводительных вычислений (EuroHPC JU) объявило о модернизации суперкомпьютера Discoverer, установленного в Софийском технологическом парке в Болгарии. Обновленная НРС-система получила название Discoverer+. Комплекс Discoverer, построенный на платформе BullSequana XH2000, был введён в эксплуатацию в 2021 году. Изначальная конфигурация включала 1128 вычислительных узлов, каждый из которых содержит два 64-ядерных процессора AMD EPYC 7H12 поколения Rome. Производительность (FP64) достигала 4,52 Пфлопс с пиковым значением в 5,94 Пфлопс. С такими показателями система находится на 221-й позиции в ноябрьском рейтинге мощнейших суперкомпьютеров мира TOP500. В рамках модернизации добавлен GPU-раздел на основе четырёх модулей NVIDIA DGX H200. Каждый из них содержит восемь ускорителей H200 и два процессора Intel Xeon Platinum 8480C поколения Sapphire Rapids с 56 ядрами (до 3,8 ГГц). Модули обладают быстродействием до 32 Пфлопс каждый в режиме FP8. Кроме того, обновлённый комплекс получил Lustre-хранилище вместимостью 5,1 Пбайт, систему хранения Weka ёмкостью 273 Тбайт и дополнительную ИБП-систему.

Источник изображения: EuroHPC JU Как отмечается, Discoverer стал первым суперкомпьютером EuroHPC, прошедшим серьёзную модернизацию с момента своего первоначального запуска. После наращивания мощностей комплекс планируется использовать для крупномасштабных проектов в области ИИ, таких как обучение нейронных сетей, создание цифровых двойников сложных объектов и пр. В декабре 2024 года консорциум EuroHPC выбрал площадки для первых европейских ИИ-фабрик (AI Factory): они расположатся в Финляндии, Германии, Греции, Италии, Люксембурге, Испании и Швеции. Кроме того, такие объекты планируется создать в Австрии, Болгарии, Франции, Германии, Польше и Словении. Эти площадки станут частью высококонкурентной и инновационной экосистемы ИИ в Европе.

18.03.2025 [10:05], Сергей Карасёв

ExxonMobil развернёт суперкомпьютер Discovery 6 с суперчипами NVIDIA GH200Американская ExxonMobil, одна из крупнейших в мире нефтяных компаний, представила проект высокопроизводительного вычислительного комплекса Discovery 6. Этот суперкомпьютер планируется использовать для поддержания работы передовых систем 4D-сейсморазведки. Комплекс создаётся в партнёрстве с НРЕ и NVIDIA. В основу системы ляжет платформа HPE Cray Supercomputing EX4000. Будут задействованы 4032 суперчипа NVIDIA GH200 Grace Hopper. В состав Grace Hopper входят 72-ядерный Arm-процессор NVIDIA Grace, до 480 Гбайт LPDDR5x и ускоритель NVIDIA H100 с 96 или 144 Гбайт HBM3(e). Говорится об использовании интерконнекта HPE Slingshot. Отмечается, что по производительности новый суперкомпьютер примерно в четыре раза превзойдёт предшественника — систему Discovery 5, введённую в эксплуатацию в ноябре 2022 года. Этот комплекс использует платформу HPE Cray EX235n с 32-ядерными процессорами AMD EPYC 7543 и ускорителями NVIDIA A100 SXM4. В ноябрьском рейтинге TOP500 машина Discovery 5 занимала 46-ю позицию с пиковой производительностью 30,99 Пфлопс. Таким образом, быстродействие Discovery 6, как ожидается, будет находиться на уровне 120 Пфлопс. Для создаваемого суперкомпьютера предусмотрено использование высокоэффективной системы прямого жидкостного охлаждения (DLC). Благодаря запуску Discovery 6 ExxonMobil рассчитывает сократить время обработки сложных сейсмических данных с месяцев до недель. Это поможет повысить эффективность разведки месторождений нефти и газа, что приведёт к увеличению добычи ресурсов с меньшими капиталовложениями. Завершить монтаж Discovery 6 планируется в I половине текущего года.

04.03.2025 [11:10], Сергей Карасёв

SoftBank, ZutaCore и Foxconn представили стоечную систему с ИИ-серверами на базе NVIDIA H200 и двухфазной СЖОКомпании ZutaCore, Hon Hai Technology Group (Foxconn) и SoftBank объявили о внедрении двухфазной технологии прямого жидкостного охлаждения (DLC) в ИИ-сервер с ускорителями NVIDIA H200. Утверждается, что это первая подобная реализация на рынке. Двухфазная DLC-система ZutaCore служит для отвода тепла от CPU, GPU, микросхем памяти и других критичных компонентов в серверах. Данное решение по сравнению с традиционными средствами охлаждения позволяет снизить энергопотребление дата-центра и повысить общую эффективность. В результате сокращаются выбросы вредных газов в атмосферу. Система ZutaCore использует специальную охлаждающую пластину, которая находится в контакте с CPU, GPU и другими элементами сервера с большим тепловыделением. Применяется диэлектрическая жидкость с низкой температурой кипения: при нагреве происходит фазовый переход из жидкого в газообразное состояние. Эффективное охлаждение достигается благодаря многократному испарению и конденсации.

Источник изображений: ZutaCore При этом температура жидкости может поддерживаться на более высоком уровне, чем в обычных системах с водяным охлаждением, что повышает эффективность отвода тепла, говорится в пресс-релизе. Кроме того, снижается нагрузка на насос, что способствует сокращению энергопотребления. Использование диэлектрического состава предотвращает серьезные повреждения сервера в случае протечки. В рамках партнёрства Foxconn разработала ИИ-сервер на базе NVIDIA H200 с двухфазной DLC-системой ZutaCore. В свою очередь, SoftBank создала серверную стойку, предназначенную для максимально эффективного охлаждения оборудования посредством двухфазной DLC-технологии. Эта ORv3-стойка совместима с 21″ и 19″ серверами. Источники питания и основная проводка сосредоточены в задней части для обеспечения безопасности эксплуатации и повышения удобства обслуживания.

27.02.2025 [12:33], Сергей Карасёв

Cisco представила MGX-сервер UCS C845A M8 на базе AMD EPYC 9005 Turin с поддержкой восьми PCIe-ускорителей NVIDIAКомпания Cisco анонсировала сервер UCS C845A M8 для рабочих нагрузок ИИ, построенный на модульной архитектуре NVIDIA MGX. Устройство поддерживает установку от двух до восьми ускорителей NVIDIA H200 NVL, H100 NVL и L40S), а также адаптеров NVIDIA BlueField-3 SuperNIC и ConnectX-7. Новинка выполнена в форм-факторе 4U с применением аппаратной платформы AMD EPYC 9005 Turin: максимальная конфигурация включает два 96-ядерных процессора EPYC 9655. Доступны 32 слота для модулей DDR5-4400/5200. Система может нести на борту два загрузочных SSD формата M.2 с интерфейсом SATA вместимостью 960 Гбайт каждый, а также до 20 накопителей E1.S NVMe. Предусмотрены пять слотов PCIe 5.0 x16 для сетевых 400G-адаптеров типоразмера FHHL: один для внешней сети, четыре для внутренней сети кластера. Задействовано воздушное охлаждение. За питание отвечают четыре блока мощностью 3200 Вт с возможностью горячей замены. Имеется слот OCP 3.0 под сетевую карту Intel X710-DA2 с двумя портами 10GbE для управления. По заявлениям Cisco, при разработке модели UCS C845A M8 особое внимание было уделено конструкции системы: говорится об улучшенной прокладке кабелей для оптимального воздушного потока и упрощении обслуживания, включая замену компонентов.

Источник изображения: Cisco В зависимости от количества установленных GPU и объема памяти сервер подходит для решения таких задач, как обучение и тонкая настройка ИИ-моделей, аналитика и визуализация данных, приложения НРС, проектирование и моделирование, обработка естественного языка, разговорный ИИ, рендеринг, облачные приложения и пр. В качестве потенциальных покупателей названы крупные предприятия, научно-исследовательские институты, государственные учреждения и облачные провайдеры. |

|