Материалы по тегу: c

|

02.08.2023 [09:59], Сергей Карасёв

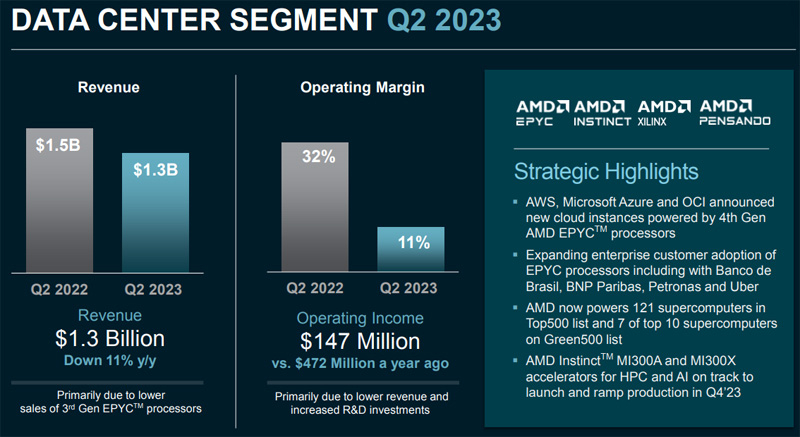

Слабый спрос на EPYC уронил квартальную выручку AMD в сегменте ЦОД на 11 %Компания AMD отрапортовала о работе во второй четверти 2023 финансового года, закрытой 1 июля. Выручка за трёхмесячный период составила $5,36 млрд против $6,55 млрд годом ранее. Таким образом, зафиксировано падение приблизительно на 18 %. Впрочем, результат оказался выше прогнозов сторонних аналитиков. Во II квартале 2023 года AMD показала чистую прибыль в размере $27 млн в соответствии с общепризнанными принципами бухгалтерского учёта (GAAP). Это на 94 % меньше прошлогоднего показателя, когда компания заработала $447 млн. Прибыль в пересчёте на одну ценную бумагу за год сократилась с $0,27 до $0,02.

Источник изображения: AMD В сегменте дата-центров квартальная выручка оказалась на уровне $1,3 млрд, что на 11 % меньше прошлогоднего результата, равного $1,5 млрд. В AMD это связывают со слабым спросом на процессоры EPYC в корпоративном сегменте. Компания уточнила, что заметно упал спрос на EPYC третьего поколения, но выручка от реализации процессоров четвёртого поколения последовательно почти удвоилась. Компания отмечает, что на сегодняшний день в глобальном масштабе доступны более 670 облачных инстансов на чипах AMD, а до конца года их станет 900. Компания начала пробные поставки ускорителей Instinct MI300A и MI300X операторам НРС-платформ, облачным клиентам и заказчикам, развивающим ИИ-решения. Говорится, что в течение последнего времени AWS, Alibaba, Microsoft Azure и OCI запустили инстансы на основе процессоров EPYC Genoa. Решения AMD применяются в 121 суперкомпьютере из рейтинга Top500 и в 7 из 10 ведущих систем из списка Green500. А компания Cerebras представила облачный ИИ-суперкомпьютер Condor Galaxy 1, оснащенный более чем 70 тыс. процессорных ядер AMD EPYC Milan.

01.08.2023 [10:02], Сергей Карасёв

Esperanto готовит универсальный чип ET-SoC-2 на базе RISC-V для задач НРС и ИИСтартап Esperanto Technologies, по сообщению ресурса HPC Wire, готовит новый чип с архитектурой RISC-V, ориентированный на системы высокопроизводительных вычислений (НРС) и задачи ИИ. Изделие получит обозначение ET-SoC-2. Нынешний чип ET-SoC-1 объединяет 1088 энергоэффективных ядер ET-Minion и четыре высокопроизводительных ядра ET-Maxion. Решение предназначено для инференса рекомендательных систем, в том числе на периферии. Чип ET-SoC-2 будет включать в себя новые высокопроизводительные ядра CPU на базе RISC-V с векторными расширениями. Точные данные о производительности не раскрываются, но говорится, что изделие обеспечит быстродействие с двойной точностью более 10 Тфлопс. Архитектура ET-SoC-2 предполагает совместную работу сотен и тысяч чипов для организации платформ НРС. При этом Esperanto делает упор на энергетической эффективности своих решений.

Источник изображения: Esperanto Technologies По словам Дейва Дитцеля (Dave Ditzel), генерального директора Esperanto, чипы RISC-V смогут взять на себя функции и CPU, и GPU при обработке ресурсоёмких приложений, в частности, машинного обучения. Процессоры RISC-V отстают по производительности от чипов x86 и Arm, хотя разрыв постепенно сокращается. Дитцель сказал, что стойки с чипами ET-SoC-1 могут обеспечить производительность в петафлопсы. Однако проблема с внедрением RISC-V заключается в слабо развитой экосистеме ПО.

29.07.2023 [09:52], Сергей Карасёв

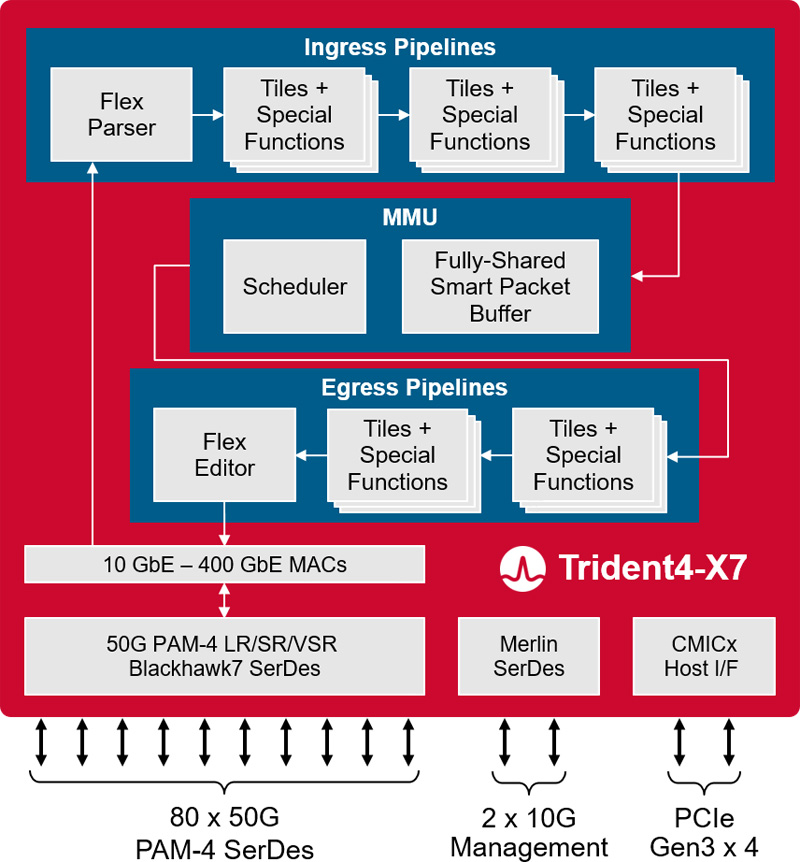

Broadcom представила платформу Trident 4-X7 для 400GbE-коммутаторовКомпания Broadcom анонсировала платформу StrataXGS Trident 4 BCM56690 (Trident 4-X7), предназначенную для создания коммутаторов нового поколения с поддержкой 400GbE. Полностью программируемый чип обеспечивает пропускную способность до 4 Тбит/с. Изделие Trident 4-X7 обеспечивает поддержку подключения 400GbE в инфраструктурах Spine/Fabric следующего поколения, которые проникают из облаков в корпоративные дата-центры. Утверждается, что энергопотребление в расчёте на порт 100GbE снижается вдвое по сравнению с существующими решениями.

Источник изображения: Broadcom Платформа Trident 4-X7 предоставляет аппаратные функции для аналитики, диагностики и телеметрии, которые помогут облачным провайдерам автоматизировать многие операции в ЦОД. Это позволяет повысить надёжность при одновременном снижении эксплуатационных расходов. Возможность программирования даёт возможность настраивать чип под нужны конкретного оператора дата-центра. Решение поддерживает сетевую архитектуру 50G ToR (Top of Rack) в конфигурации 48 × 50G + 8 × 200G или 48 × 50G + 4 × 400G. При производстве чипа применяется технология 7-нм класса. Среди прочих преимуществ разработчик выделяет:

27.07.2023 [14:09], Сергей Карасёв

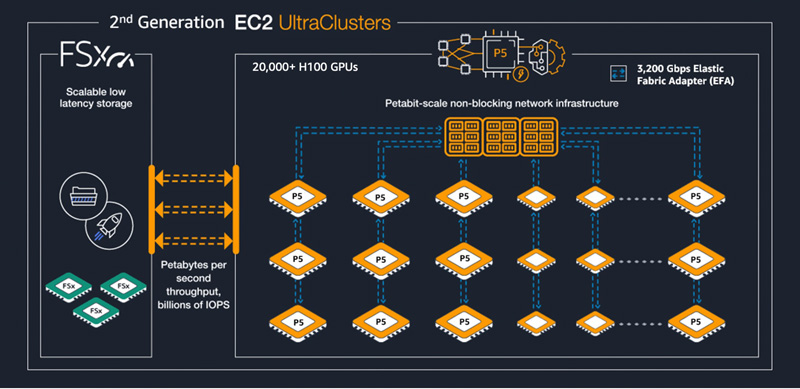

AWS запустила инстансы EC2 P5 на базе NVIDIA H100 для масштабных ИИ-задачОблачная платформа AWS официально объявила о доступности инстансов EC2 P5, которые предназначены для работы с большими языковыми моделями и генеративным ИИ. Благодаря масштабируемости производительность кластеров P5 может достигать 20 Эфлопс (точность вычислений не указана), что позволит решать самые сложные вычислительные задачи. О подготовке инстансов EC2 P5 сообщалось в марте нынешнего года. В основу положены ускорители NVIDIA H100, количество которых в составе кластеров EC2 UltraClusters второго поколения может превышать 20 тыс. Каждый инстанс P5 оснащён восемью ускорителями NVIDIA H100. Задействованы процессоры AMD EPYC Milan, а количество vCPU достигает 192. Общий объём системной памяти равен 2 Тбайт; локальное хранилище включает восемь SSD вместимостью 3,84 Тбайт каждый. Используются адаптеры AWS Elastic Fabric Adapter (EFA) второго поколения с низкой задержкой, агрегированной скоростью передачи данных 3200 Тбит/с и поддержкой NVIDIA GPUDirect RDMA.

Источник изображения: AWS Заявленная производительность в расчёте на инстанс достигает 16 Пфлопс FP8 и 8 Пфлопс FP16. Утверждается, что при использовании EC2 P5 время тренировки моделей машинного обучения сокращается в шесть раз по сравнению с инстансами AWS предыдущего поколения. В настоящее время доступ к EC2 P5 предоставляется в регионах US East (Северная Вирджиния) и US West (Орегон).

27.07.2023 [13:05], Сергей Карасёв

AIC представила двухконтроллерную СХД HA401-TU: 24 × SAS-3 и Intel Xeon Ice Lake-SPКомпания AIC анонсировала СХД HA401-TU, предназначенную для решения ресурсоёмких бизнес-задач. Новинка выполнена в форм-факторе 4U. В основу легла аппаратная платформа Intel Xeon Ice Lake-SP. Решение представляет собой сервер хранения с двумя контроллерами (Active–Active), каждый из которых содержит плату AIC Tucana с чипсетом Intel C621A. В общей сложности доступны 16 слотов для модулей оперативной памяти DDR4-3200/2933 (L)RDIMM, по восемь на узел (1DPC). Контроллеры общаются между собой посредством 1GbE-подключения, PCIe NTB или SAS. Во фронтальной части СХД расположены 24 отсека для LFF-накопителей с интерфейсом SAS-3, обслуживаемых чипом Broadcom 35x48. Допускается горячая замена. Опционально в тыльной части у каждого из узлов могут быть предусмотрены два посадочных места для SFF-накопителей. Кроме того, допускается установка двух внутренних модулей M.2 M-Key 2280.

Источник изображения: AIC Каждый из узлов располагает тремя слотами PCIe 4.0 х16 HHHL (LP), двумя слотами PCIe 4.0 х8 HHHL (LP) и разъёмом OCP 3.0. В оснащение входят контроллер Aspeed AST2500, адаптеры Realtek RTL8211E GbE и Intel I210 GbE. Есть два порта USB 3.0 (в расчёте на узел) и разъём D-Sub. Питание обеспечивают два блока мощностью 1200 Вт с сертификатом 80+ Platinum. В системе охлаждения задействованы восемь вентиляторов 60 × 38 мм. Диапазон рабочих температур — от 0 до +35 °C. Сервер имеет габариты 438 × 705 × 174,5 мм.

26.07.2023 [11:29], Сергей Карасёв

В Японии появится новый суперкомпьютер для генеративного ИИМинистерство экономики, торговли и промышленности Японии (METI), по сообщению ресурса Datacenter Dynamics, реализует проект по созданию нового суперкомпьютера, предназначенного для генеративного ИИ. Его ресурсы будут доступны через облачную платформу местным компаниям, которые ведут разработки в соответствующей сфере. Вычислительный комплекс расположится в новом исследовательском центре Японского национального института передовых технических наук и технологии (AIST). На создание этой площадки METI предоставит финансирование в размере $226 млн. Центр будет специализироваться на суперкомпьютерных и квантовых технологиях.

Источник изображения: AIST Подробности о проекте не раскрываются. По имеющейся информации, строящийся вычислительный комплекс получит более 2 тыс. ускорителей NVIDIA. В создании системы принимают участие специалисты Sakura Internet. Ввод суперкомпьютера в эксплуатацию запланирован на 2024 год. Нынешний суперкомпьютер AIST под названием AI Bridging Cloud Infrastructure (ABCI) используется примерно 3000 компаний и организаций. В текущем рейтинге Тор500 он занимает 24-е место с производительностью приблизительно 22 Пфлопс. Но этой системе не хватает ресурсов для работы с генеративным ИИ. Будущий вычислительный комплекс обеспечит примерно в 2,5 раза более высокое быстродействие.

26.07.2023 [08:51], Сергей Карасёв

IDC: спрос на сетевые облачные услуги IaaS быстро растётКомпания IDC обнародовала прогноз по глобальному рынку облачных сетевых сервисов на базе IaaS. Аналитики полагают, что в ближайшие годы данный сектор будет быстро расти на фоне продолжающейся цифровой трансформации предприятий. Согласно прогнозам, по итогам 2023 года объём этого рынка достигнет $19,4 млрд. В период до 2026-го ожидается показатель CAGR (среднегодовой темп роста в сложных процентах) на уровне 27,9 %. IDC относит к сетевым IaaS-сервисам решения в публичных облаках, предоставляемые и масштабируемые по запросу. При этом выделяются пять ключевых сегментов: прямые подключения к облакам и между облаками, облачный WAN, ADCaaS (балансировщики), сервисные mesh-сети и облачные VPN. В 2022 году пять ведущих поставщиков IaaS — Amazon Web Services (AWS), Microsoft, Google, Alibaba и Tencent — также были лидерами на рынке сетевых IaaS-услуг. В совокупности они заняли 85,7 % данного рынка, а на долю AWS пришлось более половины расходов. Крупнейшим сегментом рынка являются облачные подключения, на которые приходится более половины всей выручки. Аналитики полагают, что значение CAGR в данной области до 2026 года составит 21,1 %. Второй по величине технологический сегмент, облачный WAN, по прогнозам, станет самой быстрорастущей категорией с показателем CAGR в 112,3 %. Сервисные сети покажут среднегодовой темп прироста на уровне 68,2 %. В сегментах ADCaaS и VPN ожидается показатель CAGR в 17,5 % и 11,8 % соответственно.

26.07.2023 [01:05], Руслан Авдеев

Индия закупается суперкомпьютерами для метеорологов из-за «чрезвычайно неустойчивых» климатических условийИндийские метеорологи ожидают важное пополнение IT-парка. По данным DataCenter Dynamics, чтобы они моли делать более точные метеорологические прогнозы и моделировать погодные и климатические процессы, было решено установить два новых суперкомпьютера производительностью 10 и 18 Пфлопс соответственно. Уже имеющиеся кластеры Pratyush (4 Пфлопс) и Mihir (2,8 Пфлопс) продолжат свою работу совместно с новыми машинам в рамках миссии Monsoon Phase 3. Ожидаемая дата ввода первого будущего суперкомпьютера в эксплуатацию пока не называется, как и его достоверные спецификации. Вторая же машина, судя по всему, одна из двух, на которые Индия недавно оформила заказ — общая мощность систем составит около 18 Пфлопс, хотя данные в разных источниках не вполне совпадают. По данным местных чиновников, решение о покупке новых суперкомпьютеров вызвано «чрезвычайно неустойчивыми» климатическими условиями. Новые аппаратные мощности позволят увеличить разрешающую способность при картографировании климатических изменений с 12×12 км до 6×6 км. Одна из машин будет использоваться для краткосрочных прогнозов, вторая — для более долгосрочного моделирования.

25.07.2023 [15:09], Сергей Карасёв

TACC получит 10-Пфлопс суперкомпьютер Stampede3 на базе Intel Max и 400G Omni-PathТехасский центр передовых вычислений (TACC) при Техасском университете в Остине (США) анонсировал НРС-комплекс Stampede3, на создание которого Национальный научный фонд (NSF) выделил $10 млн. Новый суперкомпьютер станет последователем систем Stampede (2012 год) и Stampede2 (2017 год). В состав Stampede3 войдут 560 узлов на базе двух 56-ядерных процессоров Intel Xeon Max с 64 Гбайт встроенной памяти HBM2e. Это в сумме даст почти 63 тыс. вычислительных ядер общего назначения, а пиковая производительность составит около 4 Пфлопс (FP64). Кроме того, Stampede3 будет включать в себя 10 серверов Dell PowerEdge XE9640, содержащих 40 ускорителей Intel Max (Ponte Vecchio). Примечательно, что новые CPU-узлы не будут оснащаться DDR5. Если памяти на ядро для некоторых задач будет не хватать, то их перенесут на другие узлы — в составе Stampede3 будут повторно задействованы 224 узла Stampede2 с двумя 40-ядерными процессорами Intel Xeon Ice Lake-SP и 256 Гбайт RAM. Более того, к ним присоединятся 1064 узла системы Stampede2, каждый из которых содержит два чипа Intel Xeon Skylake-SP с 24 ядрами и 192 Гбайт памяти.

Источник изображения: TACC Фактически TACC теперь полностью избавилась от Xeon Phi и сохранила часть узлов от старых систем в новой машине, а некоторые пустила на создание склада запчастей. В общей сложности Stampede3 объединит 1858 вычислительных узлов, содержащих более 140 000 процессорных ядер и свыше 330 Тбайт памяти. Пиковая производительность составит почти 10 Пфлопс. Ещё одна интересная особенность суперкомпьютера — использование новейшего 400-Гбит/с интерконнекта Omni-Path. Точнее, часть старых систем останется с 100G Omni-Path, хотя коммутаторы будут обновлены. То есть Cornelis Networks сдержала обещание, пропустив поколение OPA-200 и сразу перейдя к созданию OPA-400. Кроме того, суперкомпьютер получит полностью новое All-Flash (QLC) хранилище VAST вместимостью 13 Пбайт и скоростью доступа 450 Гбайт/с, тоже на базе серверов Dell. СХД придёт на замену Lustre-хранилищу. Узлы Stampede3 будут поставлены осенью нынешнего года, а на полную мощность суперкомпьютер заработает в начале 2024-го. Комплекс станет частью вычислительной экосистемы ACCESS Национального научного фонда.

24.07.2023 [15:28], Сергей Карасёв

Лиза Су: доля AMD на рынке серверных процессоров превысила 25 %Генеральный директор AMD Лиза Су (Lisa Su) рассказала об успехах компании на рынке процессоров для серверов. По её словам, позиции AMD продолжают укрепляться, а доля превысила 25 % в общемировом объёме отгрузок серверных чипов, передаёт DigiTimes. Заявленные Результаты превзошли ожидания аналитиков DigiTimes Research, которые прогнозировали, что доля компании по итогам 2023 года превысит 20 %, а доля Arm-изделий в серверном сегменте окажется на уровне 8 %. По оценкам Mercury Research, рыночная доля AMD в сегменте процессоров для серверов выросла с 10,7 % в начале 2022-го до 17,6 % в конце прошлого года, тогда как доля Intel упала с 89,3 % до 82,4 %. Общая доля AMD на мировом CPU-рынке (за исключением изделий IoT и кастомизированных решений) поднялась с 23,3 % в 2021 году до 29,6 % в 2022-м, в то время как доля Intel сократилась с 76,7 % до 70,4 %.

Источник изображения: AMD AMD готовится вывести на рынок гибридное решение Instinct MI300 — самый крупный и сложный чип компании. «MI300 — самый сложный продукт в мире, мы не смогли бы сделать его без партнёрства с TSMC», — отметила госпожа Су, тем самым опровергнув слухи о том, что AMD может перенести производство ИИ-чипов исключительно на мощности Samsung Electronics. |

|