Материалы по тегу: c

|

05.12.2024 [16:14], Сергей Карасёв

Запущен британский Arm-суперкомпьютер Isambard 3 с суперчипами NVIDIA GraceВ Великобритании введён в эксплуатацию суперкомпьютер Isambard 3, предназначенный для ресурсоёмких приложений ИИ и задач НРС. Реализация проекта обошлась приблизительно в £10 млн, или примерно $12,7 млн. Машина пришла на смену комплексу Isambard 2, который отправился на покой в сентябре нынешнего года. Система Isambard 3 создана в рамках сотрудничества между исследовательским консорциумом GW4 Alliance, в который входят университеты Бата, Бристоля, Кардиффа и Эксетера, а также компаниями HPE, NVIDIA и Arm. Суперкомпьютер назван в честь британского инженера Изамбарда Кингдома Брюнеля, внесшего значимый вклад в Промышленную революцию. Полностью технические характеристики Isambard 3 не раскрываются. Известно, что в основу машины положены 384 суперпроцессорами NVIDIA Grace со 144 ядрами (2 × 72) Arm Neoverse V2 (Demeter), общее количество которых превышает 55 тыс. Задействована высокопроизводительная СХД HPE, которая обеспечивает расширенные IO-возможности с интеллектуальным распределением данных по нескольким уровням. Благодаря этому достигается эффективная обработка задач с интенсивным использованием информации, таких как обучение моделей ИИ. Известно также, что в составе комплекса применяется фирменный интерконнект HPE Slingshot, а в качестве внутреннего интерконнекта служит технология NVLink-C2C, которая в семь раз быстрее PCIe 5.0. Каждый узел суперкомпьютера содержит один суперчип Grace и сетевой адаптер Cassini с пропускной способностью до 200 Гбит/с. Объём системной памяти составляет 2 × 120 Гбайт (240 Гбайт). Отмечается, что Isambard 3 демонстрирует в шесть раз более высокую производительность и в шесть раз лучшую энергоэффективность по сравнению с Isambard 2. Пиковое быстродействие FP64 у Isambard 3 достигает 2,7 Пфлопс при энергопотреблении менее 270 кВт. Применять новый суперкомпьютер планируется для таких задач, как проектирование оптимальной конфигурации ветряных электростанций на суше и воде, моделирование термоядерных реакторов, исследования в сфере здравоохранения и пр. Суперкомпьютер расположен в автономном дата-центре с системой самоохлаждения HPE Performance Optimized Data Center (POD) в Национальном центре композитов в Научном парке Бристоля и Бата. Там же ведётся монтаж ИИ-комплекса Isambard-AI стоимостью £225 млн ($286 млн), который должен стать самым быстрым и мощным суперкомпьютером в Великобритании. Проект Isambard-AI реализуется в несколько этапов. Первая фаза предполагает монтаж 42 узлов, каждый из которых несёт на борту четыре суперчипа NVIDIA GH200 Grace Hopper и 4 × 120 Гбайт памяти для CPU (доступно 460 Гбайт — по 115 Гбайт на CPU), а также 4 × 96 Гбайт памяти для GPU (H100). В ходе второй фазы будут добавлены 1320 узлов, насчитывающих в сумме 5280 суперчипов NVIDIA GH200 Grace Hopper. Кроме того, в состав Isambard 3 входит экспериментальный x86-модуль MACS (Multi-Architecture Comparison System), включающий сразу восемь разновидностей узлов на базе процессоров AMD EPYC и Intel Xeon нескольких поколений, часть из них также имеет ускорители AMD Instinct MI100 и NVIDIA H100/A100. Все они объединены 200G-интерконнектом HPE Slingshot.

03.12.2024 [10:00], Сергей Карасёв

Астрофизики Японии получили суперкомпьютер Aterui III на базе Intel Xeon MaxЦентр вычислительной астрофизики Национальной астрономической обсерватории Японии (NAOJ) объявил о вводе в эксплуатацию суперкомпьютера NS-06 Aterui III на платформе HPE Cray XD2000. Новый НРС-комплекс планируется применять в качестве «лаборатории теоретической астрономии» для исследования широкого спектра астрофизических явлений. Архитектура Aterui III предполагает применение модулей двух типов — System M с высокой пропускной способностью памяти (3,2 Тбайт/с на узел, что в 12,5 раза больше, чем у Aterui II) и System P с большим объёмом памяти (512 Гбайт в расчёте на узел, в 1,3 раза больше по сравнению с Aterui II). Все узлы оснащены двумя процессорами Intel Xeon Sapphire Rapids. В частности, задействованы 208 узлов System M с чипами Xeon CPU Max 9480 (56C/112T; 1,9–3,5 ГГц; 350 Вт). Таким образом, суммарное количество ядер достигает 23 296. Каждый узел несёт на борту 128 Гбайт памяти, а её совокупный объём составляет 26,6 Тбайт. Общая пропускная способность — 665 Тбайт/с. Кроме того, в состав Aterui III включены 80 узлов System P с парой процессоров Xeon Platinum 8480+ (56C/112T; 2,0–3,8 ГГц; 350 Вт). В общей сложности применяются 8960 ядер и 40,96 Тбайт памяти с суммарной пропускной способностью 98,24 Тбайт/с (614 Гбайт/с на узел). В целом, суперкомпьютер использует 288 узлов с 32 256 ядрами CPU. Кластер на базе System M обеспечивает производительность на уровне 1,4 Пфлопс, сегмент на основе System P — около 0,57 Пфлопс. Общее быстродействие НРС-комплекса достигает почти 2 Пфлопс.

02.12.2024 [11:39], Сергей Карасёв

Один из модулей будущего европейского экзафлопсного суперкомпьютера JUPITER вошёл в двадцатку самых мощных систем мираЮлихский исследовательский центр (FZJ) в Германии объявил о достижении важного рубежа в рамках проекта JUPITER (Joint Undertaking Pioneer for Innovative and Transformative Exascale Research) по созданию европейского экзафлопсного суперкомпьютера. Введён в эксплуатацию JETI — второй модуль этого НРС-комплекса. Напомним, контракт на создание JUPITER заключён между Европейским совместным предприятием по развитию высокопроизводительных вычислений (EuroHPC JU) и консорциумом, в который входят Eviden (подразделение Atos) и ParTec. Суперкомпьютер JUPITER создаётся на базе модульного дата-центра, за строительство которого отвечает Eviden. Система JUPITER получит, в частности, энергоэффективные высокопроизводительные Arm-процессоры SiPearl Rhea1 с HBM. Кроме того, в состав машины входят узлы с NVIDIA Quad GH200, а общее количество суперчипов GH200 Grace Hopper составит почти 24 тыс. Узлы объединены интерконнектом NVIDIA Mellanox InfiniBand. Запущенный модуль JETI (JUPITER Exascale Transition Instrument) обладает FP64-производительностью 83,14 Пфлопс, тогда как пиковый теоретический показатель достигает 95 Пфлопс. С такими результатами эта машина попала на 18-ю строку нынешнего рейтинга мощнейших суперкомпьютеров мира TOP500. В составе JETI задействованы в общей сложности 391 680 ядер. Энергопотребление модуля равно 1,31 МВт. Отмечается, что JETI обеспечивает примерно одну двенадцатую от общей расчётной производительности машины JUPITER. Попутно JETI занял шестое место в рейтинге энергоэффективных систем Green500. Ожидается, что после завершения строительства суммарное быстродействие JUPITER на операциях обучения ИИ составит до 93 Эфлопс, а FP64-производительность превысит 1 Эфлопс. Затраты на создание комплекса оцениваются в €273 млн, включая доставку, установку и обслуживание НРС-системы.

01.12.2024 [11:08], Сергей Карасёв

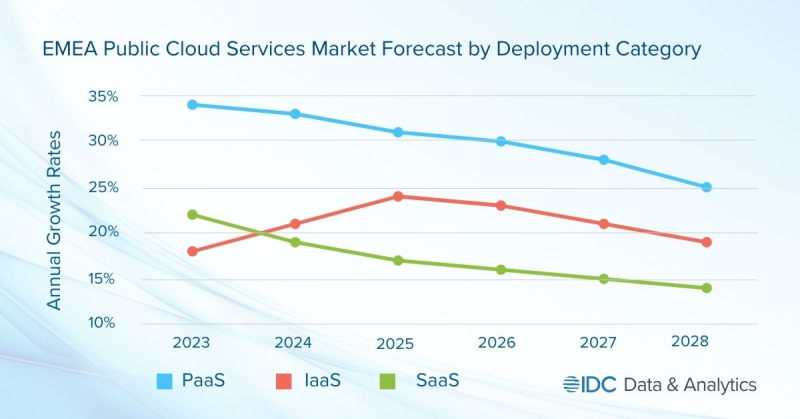

Объём рынка публичных облаков в регионе EMEA в 2024 году превысит $200 млрдКомпания International Data Corporation (IDC) обнародовала прогноз по рынку публичных облачных услуг в регионе EMEA, который включает Европу, Ближний Восток и Африку. Отрасль демонстрирует стремительный рост, что объясняется быстрым внедрением ИИ, в то числе сервисов генеративного ИИ, а также расширением инфраструктур ведущих облачных провайдеров. По оценкам, в 2024 году объём отрасли превысит $200 млрд, достигнув приблизительно $203 млрд. Аналитики IDC учитывают затраты в области публичных услуг SaaS, PaaS и IaaS. Первый из этих сегментов, который включает SaaS-приложения и SaaS-SIS (SaaS в области системных инфраструктур), обеспечивает наибольшую выручку — 64,4 % в общем объёме рынка ЕМЕА. Отмечается, что из-за своего размера и зрелости SaaS демонстрирует самые медленные темпы роста среди облачных услуг всех типов. Наиболее высокий показатель CAGR (среднегодовой темп роста в сложных процентах) прогнозируется в категории PaaS — 29,3 % в период 2023–2028 гг. В сегменте IaaS это значение ожидается на уровне 21,6 %. С субрегиональной точки зрения Западная Европа доминирует на рынке EMEA с долей около 80 % в общем объёме рынка. Далее следуют Ближний Восток и Африка (MEA), а также Центральная и Восточная Европа (CEE). Основные инвестиции в сегменте публичных облаков приходятся на Германию, Великобританию, Францию и Италию. Ключевыми игроками в регионе являются Google, Amazon, Microsoft и Oracle. Аналитики IDC считают, что глобальные технологические компании продолжат вкладывать средства в ИИ, что обеспечит дальнейший рост рынка. Величина CAGR в регионе EMEA прогнозируется на уровне 20,0 %: таким образом, к 2028-му затраты могут подняться до $415,1 млрд.

29.11.2024 [10:15], Сергей Карасёв

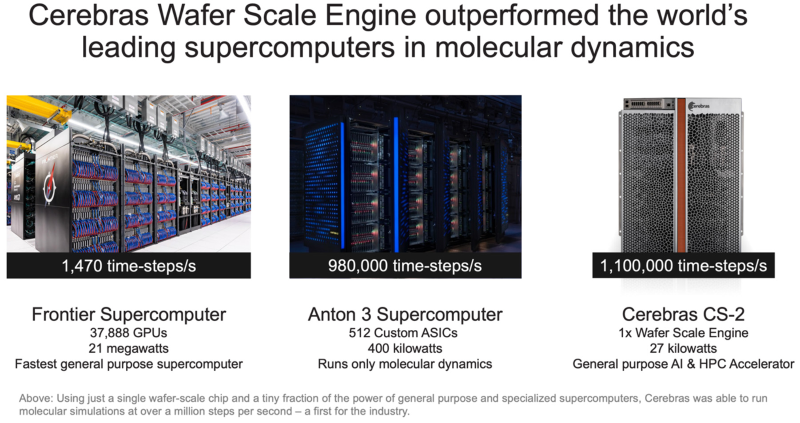

Система Cerebras с ускорителями WSE установила рекорд в молекулярной динамике, превзойдя суперкомпьютер FrontierАмериканский стартап Cerebras Systems, специализирующийся на создании чипов для систем машинного обучения и других ресурсоёмких задач, объявил об установлении нового мирового рекорда производительности в области молекулярной динамики. В эксперименте приняли участие Сандийские национальные лаборатории (SNL), Ливерморская национальная лаборатория имени Лоуренса (LLNL) и Лос-Аламосская национальная лаборатория (LANL) в составе Министерства энергетики США (DOE). Вычисления выполнялись на системе, оснащённой фирменными ускорителями Cerebras Wafer Scale Engine (WSE). Говорится, что впервые в истории молекулярной динамики исследователи достигли результата более 1 млн шагов моделирования в секунду (timesteps per second, TPS). В частности, показано значение на уровне 1,1 млн TPS на платформе Cerebras CS-2, оборудованной чипами WSE-2, которые насчитывают 850 тыс. тензорных ядер и несут на борту 40 Гбайт памяти SRAM. Для сравнения: в случае суперкомпьютера экзафлопсного класса Frontier, который в нынешнем рейтинге TOP500 занимает второе место, результат составляет 1470 TPS. Таким образом, система Cerebras обеспечивает 748-кратный выигрыш в быстродействии на задачах молекулярной динамики. При этом энергопотребление комплекса Cerebras составляет 27 кВт против 21 МВт у Frontier. Кроме того, комплекс Cerebras превзошел Anton 3 — самый мощный в мире специализированный суперкомпьютер для молекулярной динамики. Anton 3 использует 512 кастомных ASIC, а его энергопотребление находится на уровне 400 кВт. Показатель быстродействия Anton 3 достигает 980 тыс. TPS. То есть, система Cerebras показывает выигрыш примерно в 20 %. Предполагается, что ускорители Cerebras предоставят качественно новые возможности для исследований в различных областях, включая разработку материалов следующего поколения, перспективных лекарственных препаратов и решений в сфере возобновляемой энергетики. Нужно отметить, что ранее Сандийские национальные лаборатории запустили ИИ-систему Kingfisher на чипах Cerebras WSE-3. А сама компания Cerebras развернула «самую мощную в мире» ИИ-платформу для инференса.

28.11.2024 [14:47], Руслан Авдеев

США впервые с 2001 года пересмотрят правила лицензирования подводных интернет-кабелей для защиты национальных интересовАмериканская Федеральная комиссия по связи (FCC) впервые за 22 года пересмотрит правила лицензирования подводных кабелей. Ведомство одобрило т.н. «Уведомление о предложении регулирования» (Notice of Proposed Rulemaking) для того, чтобы повысить уровень безопасности и защиты подводной инфраструктуры, а также упростить процесс лицензирования, сообщает Datacenter Dynamics. Сейчас процесс регулирования деятельности в соответствующей сфере весьма сложен — для получения лицензий необходимо подавать заявки сразу нескольким федеральным регуляторам США. FCC намерена упростить этот процесс, но вместе с тем ужесточить правила отчётности. Так, предлагается ввести обязательные отчёты для прокладчиков кабелей каждые три года или же сократить срок действия их лицензий с 25 лет до более короткого периода. Американский регулятор делает акцент на обеспечении национальной безопасности. Например, FCC также предложила обязать операторов, имеющих право на ведение международного телеком-бизнеса, подавать заявки на продление соответствующих разрешений в FCC. Дополнительно FCC работает над механизмом устранения из американских сетей связи телеком-оборудования, которое регулятор сочтёт опасным или хотя бы «рискованным». Речь идёт о первом пересмотре правил работы с подводными кабелями с 2001 года. На сегодня функционируют 84 кабельные системы, получившие лицензии FCC. Текущая суммарная ёмкость кабелей лицензиатов превышает 5,3 Пбит/с, к ним планируется добавить ещё 6,8 Пбит/с. Безопасность кабелей по разным причинам стала весьма актуальной темой. Помимо инцидентов в Красном море, из-за которых пострадала связь Азии с Европой, были и другие случаи, в частности — обрыв кабелей у берегов Вьетнама и Тайваня и недавний инцидент в Балтийском море.

28.11.2024 [10:32], Сергей Карасёв

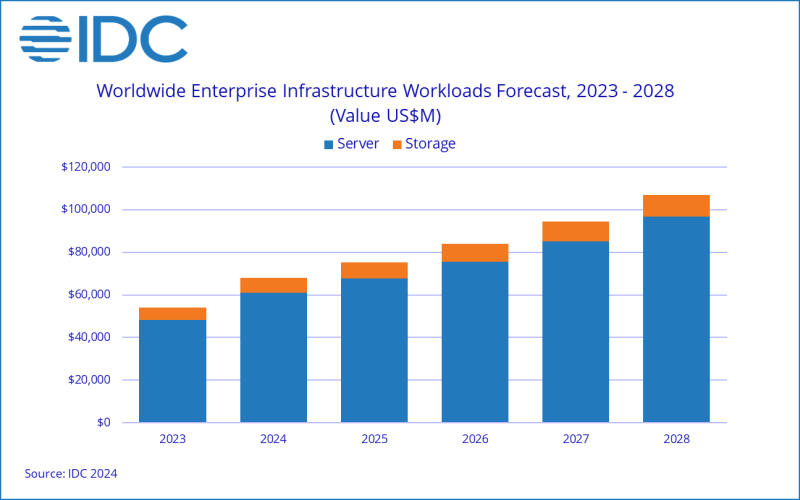

IDC: мировые расходы на ИИ-инфраструктуру превысят $100 млрд к 2028 годуКомпания International Data Corporation (IDC) обнародовала свежий прогноз по глобальному рынку инфраструктур для приложений ИИ. Отрасль переживает стремительный рост, что обусловлено активным внедрением ИИ и машинного обучения в самых разных сферах. Аналитики учитывают отгрузки серверов и СХД для задач ИИ. По оценкам, в I полугодии 2024-го продажи соответствующего оборудования достигли в денежном выражении $31,8 млрд. Это на 37 % больше по сравнению с показателем за аналогичный период 2023 года. При этом основную часть выручки обеспечили ИИ-серверы — приблизительно 89 % в общем объёме затрат. В исследовании отмечается, что в I половине 2024 года инфраструктура ИИ, развёрнутая в облачных и общедоступных средах, обеспечила 65 % от суммарных продаж. Операторы ЦОД и гиперскейлеры вкладывают значительные средства в расширение своих мощностей. На серверы с ИИ-ускорителями пришлось 58 % от общих расходов на серверную инфраструктуру ИИ, а рост в годовом исчислении зафиксирован на уровне 63 %. IDC прогнозирует, что к 2028 году затраты на ИИ-серверы превысят 60 % от суммарных расходов в соответствующем сегменте. При этом показатель CAGR (среднегодовой темп роста в сложных процентах) прогнозирует в размере 19 % на протяжении пяти лет. Сегмент СХД в I полугодии 2024-го показал рост на 36 % в годовом исчислении, при этом 56 % расходов пришлось на облачные развёртывания. США лидируют на мировом рынке ИИ-инфраструктур с долей почти 50 %. Далее следуют Китай (23 %), Азиатско-Тихоокеанский регион (16 %) и EMEA (10 %). В течение следующих пяти лет, как прогнозирует IDC, Азиатско-Тихоокеанский регион будет демонстрировать показатель CAGR около 20 %, США — 16 %, EMEA — 13 %, Китай — 11 %. К 2028 году, как ожидается, мировые расходы на инфраструктуру ИИ достигнут $107 млрд, при этом серверы, развёрнутые в облачных средах, обеспечат 75 % выручки.

27.11.2024 [17:31], Владимир Мироненко

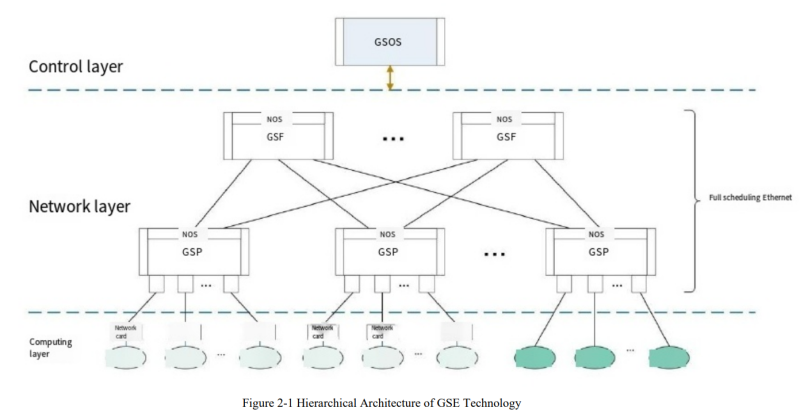

Китайцы создали Ethernet для ИИ- и HPC-кластеровНа прошлой неделе китайские технологические гиганты объявили о выпуске чипа для поддержки технологии Global Scheduling Ethernet, предназначенной для сетевого протокола, который должен обеспечить запуск приложений ИИ и других требовательных рабочих нагрузок, сообщил ресурс The Register. Как полагает ресурс, China Mobile является движущей силой этой технологии, поскольку ещё в 2023 году она опубликовала описание технической структуры GSE Ethernet. Цель китайского проекта совпадает с задачей, поставленной консорциумом Ultra Ethernet Consortium (UEC) — оптимизировать Ethernet для приложений ИИ и HPC. В UEC входят Intel, AMD, HPE, Arista, Broadcom, Cisco, Meta✴ и Microsoft. Протокол Ethernet создавался без учёта сегодняшних рабочих нагрузок и при его использовании сложно организовать пути для трафика, перемещающегося по очень большим и загруженным сетям, что приводит к высоким задержкам. В «Белой книге» China Mobile указаны похожие задачи, которые возможно решить с помощью таких методов, как контейнеры пакетов фиксированного размера и «динамическая глобальная очередь планирования», которая не привязана к физическим портам, но учитывает состояние порта целевого устройства перед организацией оптимального соединения с использованием таких способов, как многопутевая доставка (multi-path spraying). Кстати, UEC тоже считает перспективным этот способ. На прошлой неделе китайские СМИ сообщили, что в разработке чипа, который делает GSE Ethernet реальностью, участвовало более 50 провайдеров облачных услуг, производителей оборудования, производителей микросхем и университетов внутри и за пределами Китая. Согласно сообщениям, можно предположить, что GSE Ethernet уже развёрнут в кластере из тысячи серверов в ЦОД China Mobile, где он, по-видимому, обеспечил существенное улучшение производительности сети во время обучения большой языковой модели. Если Китай решил создать и использовать собственную версию Ethernet для некоторых приложений — и его крупные технологические компании готовы её применять — это означает, что членам UEC будет сложнее ориентироваться на китайский рынок (и страны, где доминируют китайские поставщики), пишет The Register. А несколько лет назад Huawei предложила отказаться от TCP/IP в пользу разработанного ей стека New IP.

27.11.2024 [11:48], Сергей Карасёв

El Dorado, младший брат самого мощного в мире суперкомпьютера El Capitan, вошёл в двадцатку TOP500Сандийские национальные лаборатории (SNL) Министерства энергетики США (DOE) объявили о том, что новый НРС-комплекс El Dorado занял 20-е место в свежем рейтинге самых мощных суперкомпьютеров мира TOP500, обнародованном на конференции SC24. На вершине ноябрьского списка TOP500 находится машина El Capitan, построенная специалистами HPE Cray. Эта система демонстрирует FP64-быстродействие на уровне 1,742 Эфлопс в тесте Linpack (HPL), а пиковый теоретический показатель достигает 2,746 Эфлопс. Основой El Capitan служит платформа HPE Cray Shasta на базе AMD Instinct MI300A. Отмечается, что комплекс El Dorado, по сути, приходится младшим братом El Capitan. Машина El Dorado меньше по масштабу, но архитектурно идентична лидеру рейтинга TOP500. Система построена компанией HPE на платформе Cray EX4000: в общей сложности задействованы 384 узла на основе Instinct MI300A. Суммарное количество ядер составляет 383 040. Используется интерконнект HPE Slingshot-11. Вычислительные узлы используют прямое жидкостное охлаждение. Производительность El Dorado достигает 68,02 Пфлопс, а теоретическое пиковое быстродействие находится на отметке 95,29 Пфлопс. Суперкомпьютер фактически представляет собой мощную тестовую площадку для создания, тестирования и подготовки программного кода перед запуском на машине экзафлопсного класса El Capitan. Кроме того, El Dorado позволит осуществлять определённые научно-исследовательские и опытно-конструкторские работы.

25.11.2024 [20:50], Руслан Авдеев

Amazon вложит ещё $4 млрд в Anthropic и снизит её зависимость от NvidiaКомпания Amazon (AWS) раскрыла планы удвоить инвестиции в Anthropic, доведя их до $8 млрд. Объявление о новых вложениях было сделано через год после того, как гиперскейлер сообщил о выделении стартапу $4 млрд, сообщает Silicon Angle. На тот момент главный конкурент OpenAI назвал AWS своим ключевым облачным провайдером. С новой сделкой роль AWS в обучении моделей Anthropic только усилится. Anthropic представила свою наиболее передовую модель Claude 3.5 Sonnet в прошлом месяце — это улучшенная версия большой языковой модели (LLM) той же серии, дебютировавшей несколько месяцев назад. Новая Claude 3.5 Sonnet лучше предшественницы в выполнении некоторых задач, включая написание кода. Она также обошла OpenAI GPT-4o в нескольких бенчмарках. Anthropic предлагает свои LLM через сервис Amazon Bedrock, обеспечивающий доступ к управляемым ИИ-моделям. Расширенное сотрудничество обеспечит пользователям ранний доступ к функции, позволяющей настраивать модели Claude с использованием кастомных датасетов. Также планируется поддержать друг друга в разработках. Anthropic будет использовать ИИ-ускорители Trainium и Inferentia для внутренних задач. В компании подчеркнули, что задействуют ускорители для крупнейших базовых моделей. В то же время специалисты Anthropic поддержат AWS в разработке новых чипов Tranium. Стек ПО Neutron включает компилятор, оптимизирующий ИИ-модели для работы на инстансах Tranium, и некоторые другие инструменты. Компания также работает над низкоуровневыми программными ядрами, распределяющими задачи между вычислительными ядрами ускорителей. Последний раунд финансирования Anthropic состоится через два месяца после того, как OpenAI привлекла рекордные для стартапа $6,6 млрд. Также она получила кредитную линию на $4 млрд от группы банков. OpenAI, оцениваемая в $157 млрд, будет инвестировать средства в ИИ-исследования и вычислительную инфраструктуру. |

|