Материалы по тегу: c

|

12.12.2024 [17:36], Сергей Карасёв

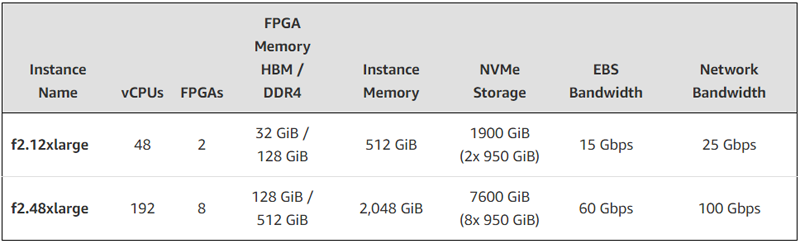

FPGA + EPYC: AWS представила AMD-инстансы EC2 F2 с процессорами Milan и ПЛИС Virtex UltraScale+Облачная платформа AWS анонсировала инстансы второго поколения с FPGA на борту. Экземпляры EC2 F2 ориентированы на решение задач в области геномики, обработки мультимедийных материалов, больших данных, спутниковой связи, компьютерных сетей, моделирования кремниевых чипов и видеотрансляций в реальном времени. В новых инстансах применяются FPGA AMD Virtex UltraScale+ HBM VU47P. Эти изделия содержат 2,852 млн логических ячеек и 9024 DSP. Заявленная ИИ-производительность достигает 28 TOPS при вычислениях INT8. Кроме того, в состав EC2 F2 входят процессоры AMD EPYC поколения Milan. Новые инстансы доступны в вариантах f2.12xlarge и f2.48xlarge — с 48 и 192 vCPU и 2 и 8 FPGA соответственно. Каждая ПЛИС оперирует 16 ГиБ памяти HBM и 64 ГиБ памяти DDR4. Таким образом, в случае f2.12xlarge используется в сумме 32 ГиБ HBM и 128 ГиБ DDR4, а в случае f2.48xlarge — 128 ГиБ и 512 ГиБ соответственно.

Источник изображения: AWS Конфигурация f2.12xlarge включает 512 ГиБ системной памяти и два накопителям NVMe SSD суммарной вместимостью 1900 ГиБ. Пропускная способность сетевого подключения составляет 25 Гбит/с, пропускная способность EBS-томов — 15 Гбит/с. У экземпляра f2.48xlarge объём памяти составляет 2048 ГиБ, общая вместимость NVMe SSD — 7600 ГиБ. Пропускная способность сетевого подключения и EBS-томов достигает 100 Гбит/с и 60 Гбит/с соответственно. Для этого экземпляра предусмотрена поддержка AWS Cloud Digital Interface (CDI) для надёжной передачи несжатого видео (задержка между инстансами заявлена на уровне 8 мс).

11.12.2024 [23:47], Владимир Мироненко

BadRAM: для обхода защиты виртуальных машин в процессорах AMD EPYC достаточно оборудования стоимостью всего $10

amd

cpu

ddr4

ddr5

dram

epyc

hardware

виртуализация

информационная безопасность

уязвимость

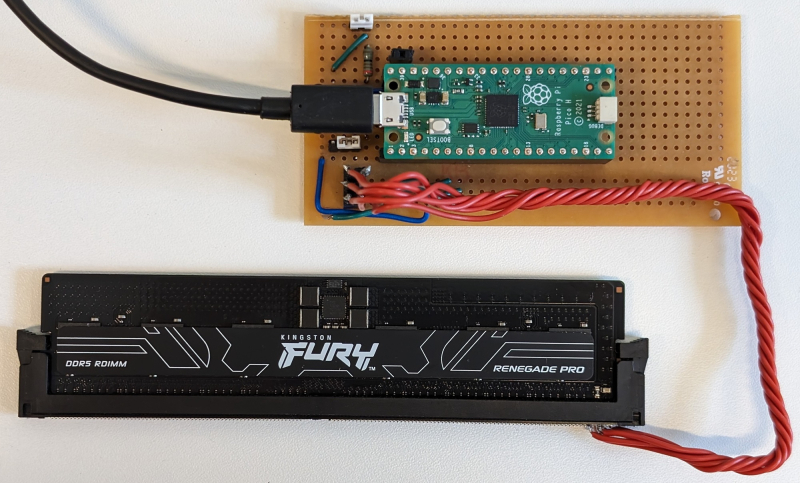

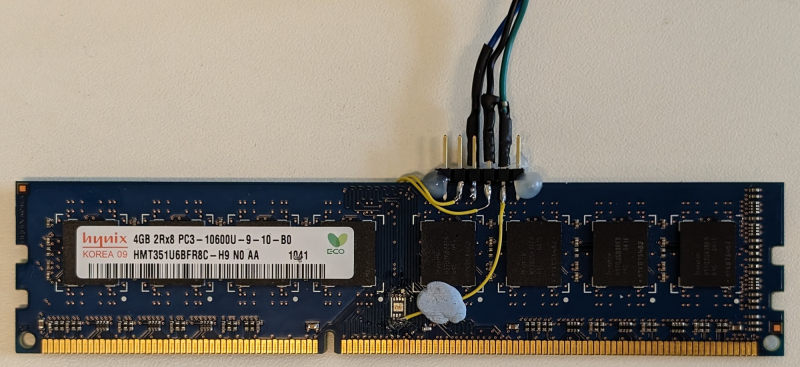

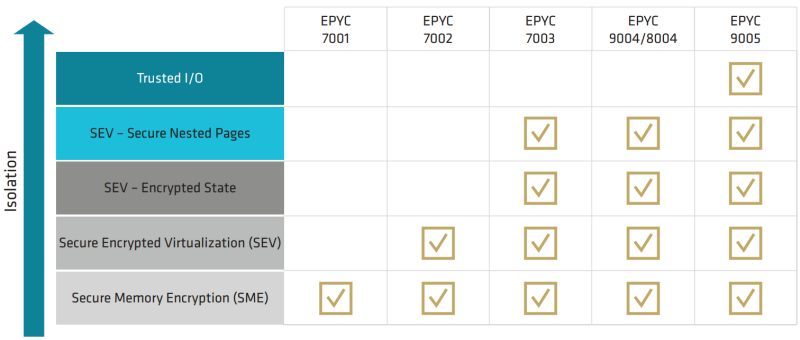

шифрование

Исследователи Лёвенского католического университета (Бельгия), Любекского университета (Германия) и Бирмингемского университета (Великобритания) обнаружили, что система защиты виртуальных машин от атак с использованием вредоносного гипервизора AMD SEV-SNP (Secure Nested Paging), не так безопасна, как утверждает разработчик, пишет The Register. Технологии Secure Encrypted Virtualization (SEV) предоставляют доверенную среду исполнения (TEE), призванную обеспечить защиту виртуальных машин от незаконных попыток вмешательства со стороны тех, кто имеет доступ к оборудованию ЦОД. Механизм SEV-SNP реализован в процессорах AMD EPYC, начиная с 7003 (Milan). Аналогичные механизмы есть и у конкурентов: Intel Software Guard Extensions (SGX) и Trusted Domain Extensions (TDX), а также Arm Confidential Compute Architecture (CCA). Все эти технологии отвечают за шифрование памяти и изоляцию ресурсов. Исследователи разработали способ обхода SEV-SNP, который они назвали BadRAM (CVE-2024-21944 и AMD-SB-3015). Для атаки требуется оборудование стоимостью около $10, включая Raspberry Pi Pico, разъём DDR и батарею на 9 В. Атака BadRAM требует наличие физического доступа к оборудованию. Она основана на манипуляциях с чипом SPD (Serial Presence Detect), который передаёт данные о модуле DDR4/DDR5 во время загрузки системы. Манипулируя SPD, злоумышленники создают адреса-фантомы для физической памяти, благодаря которым можно незаметно получить доступ к данным в виртуальной машине. «Мы удваиваем видимый в системе объём DIMM, чтобы обмануть контроллер памяти CPU и заставить его использовать дополнительные «фантомные» биты адресации, — объясняют авторы исследования. — Два разных физических адреса теперь ссылаются на одно и то же местоположение DRAM». С помощью таких фантомов злоумышленники могут обойти защиту памяти, раскрывая конфиденциальные данные или вызывя сбои. BadRAM позволяет подделать критически важные отчёты удалённой аттестации и вставлять необнаруживаемые бэкдоры в любую виртуальную машину, защищённую SEV-SNP. Атака может быть реализована и без физического доступа к оборудованию, поскольку некоторые поставщики DRAM оставляют чип SPD разблокированным, что противоречит спецификациям JEDEC. Авторы исследования обнаружили по крайней мере два DDR4-модуля Corsair без должной защиты SPD. Память DDR3 тоже может быть взломана путём замены чипа SPD. «BadRAM полностью подрывает доверие к технологии защищённой зашифрованной виртуализации AMD (SEV-SNP), которая широко используется крупными поставщиками облачных услуг, включая Amazon AWS, Google Cloud и Microsoft Azure», — сообщил The Register Джо Ван Балк (Jo Van Bulck), профессор лаборатории DistriNet на кафедре компьютерных наук KU Leuven. Исследователи отметили, что решения SGX и TDX Intel не имеют такой уязвимости, поскольку в них реализованы контрмеры против создания псевдонимов (alias) памяти. Arm CCA, судя по спецификации, тоже не имеет проблем, но для проверки этого у исследователей не было коммерческих чипов. Полный доклад об атаке исследователи планируют представить в мае 2025 года на конференции IEEE Symposium on Security and Privacy. Исследователи уведомили AMD о найденных проблемах в феврале 2024 года. «AMD рекомендует использовать модули памяти, которые блокируют SPD, а также следовать передовым практикам в области физической безопасности систем. AMD также выпустила обновления прошивок защиты от уязвимости», — сообщили в AMD ресурсу The Register в ответ на просьбу прокомментировать публикацию исследователей.

11.12.2024 [11:37], Сергей Карасёв

OnLogic представила индустриальный мини-компьютер ML100G-42 на базе AMD Ryzen 8040Компания OnLogic анонсировала компактный компьютер ML100G-42, ориентированный на коммерческое и промышленное применение. Устройство может использоваться на производствах, в системах индустриальной автоматизации, в секторе логистики и поставок продукции и пр. В основу новинки положена аппаратная платформа AMD: задействован процессор Ryzen 7 8840U (8 ядер; 16 потоков; до 5,1 ГГц) с графическим контроллером AMD Radeon 780M (RDNA3) и NPU XDNA. Чип довольствуется пассивным охлаждением, а ребристая поверхность алюминиевого корпуса компьютера выполняет функции радиатора для отвода тепла. Объём оперативной памяти DDR5-5600 может достигать 96 Гбайт (2 × 48 Гбайт).

Источник изображения: OnLogic Новинка способна нести на борту два SSD формата M.2 с интерфейсом PCIe 4.0 (NVMe) вместимость до 2 Тбайт каждый. При необходимости может быть добавлен ИИ-ускоритель Hailo в виде модуля М.2. Кроме того, предусмотрен дополнительный слот M.2 2230 E-key (PCIe x1 / USB 2.0) для адаптера Wi-Fi. В оснащение входят сетевые контроллеры 2.5 GbE и 1GbE. Во фронтальной части расположены порт USB 3.2 Gen2 Type-A, два разъёма USB4 Type-C (с поддержкой DP1.4a), стандартное аудиогнездо на 3,5 мм. Сзади сосредоточены два интерфейса HDMI, два гнезда RJ-45 для сетевых кабелей, два порта USB 2.0 и DC-гнездо для подачи питания. Опционально могут быть добавлены два последовательных порта RS-232. Габариты составляют 142 × 61,5 × 107 мм. Возможен монтаж на стену и DIN-рейку, а также установка при помощи крепления VESA. Диапазон рабочих температур — от 0 до +50 °C. Гарантирована совместимость с Red Hat Linux и Ubuntu. Цена начинается примерно с $1300.

10.12.2024 [12:19], Руслан Авдеев

Запас карман не тянет: Huawei получила более 2,5 дециллионов IPv6-адресовКомпания Huawei получила в своё распоряжение 2 596 148 429 267 413 814 265 248 164 610 048 адресов IPv6 — более 2,5 дециллионов (один дециллион — 1033). Столько выделил китайскому техногиганту азиатский интернет-регистратор Asia Pacific Network Information Center (APNIC), сообщает The Register. Это своего рода рекорд для APNIC. Для удовлетворения потребностей Huawei регистратор обратился к организации Internet Assigned Numbers Authority (IANA), контролирующей распределение адресов по всему миру. Для удовлетворения запроса APNIC запросила второй блок /12. Он состоит из более 83 дециллионов адресов. Впрочем, на долю Huawei приходится лишь подмножество — блок /17. Всего пространство IPv6 вмещает более 340 ундециллионов адресов (340∙1036), но многие зарезервированы или не могут использоваться по разным причинам. Хотя выделенное Huawei количество адресов выглядит невероятно большим, но в общем объёме адресного пространства оно практически теряется. Конечно, у компании вряд ли когда-нибудь будет такое количество устройств для подключения. Впрочем, даже если из общего числа будут использоваться далеко не все, можно предположить, что у компании большие планы. По данным APNIC, в Huawei намерены использовать выделенные IPv6 для «глобального внедрения облачных сервисов и CDN».

Истчоник изображения: engin akyurt/unsplash.com Сейчас Китай активно продвигает использование устройств Интернета вещей. Пара миллиардов из них уже функционирует, а в ближайшие годы их число должно вырасти до 30 млрд. Huawei Cloud управляет 33 облачными регионами, поэтому в его распоряжении имеется немало физических устройств и виртуальных машин. Впрочем, имеющихся в запасе компании адресных ресурсов теперь с лихвой хватит на покрытие её потребностей. Фактически даже если бы каждое интернет-устройство на Земле получило бы адрес IPv6, Huawei не смогла бы потратить и малой доли своих невообразимых ресурсов. Примечательно, что буквально в ноябре главный научный сотрудник APNIC (Asia Pacific Network Information Centre) Джефф Хьюстон (Geoff Huston) заявил, что перспективы перехода на протокол IPv6 не особенно привлекательны из-за меняющейся структуры сети. По словам эксперта, переход от IPv4 к IPv6 не обеспечит принципиально новых функциональных возможностей. Однако некоторые всё равно запасаются адресами. Так, в октябре прошлого года американский регистратор ARIN выделил банку Capital One блок 2630::/16. Банк получил вдвое больше адресов, чем Huawei, отмечает The Register.

09.12.2024 [23:27], Руслан Авдеев

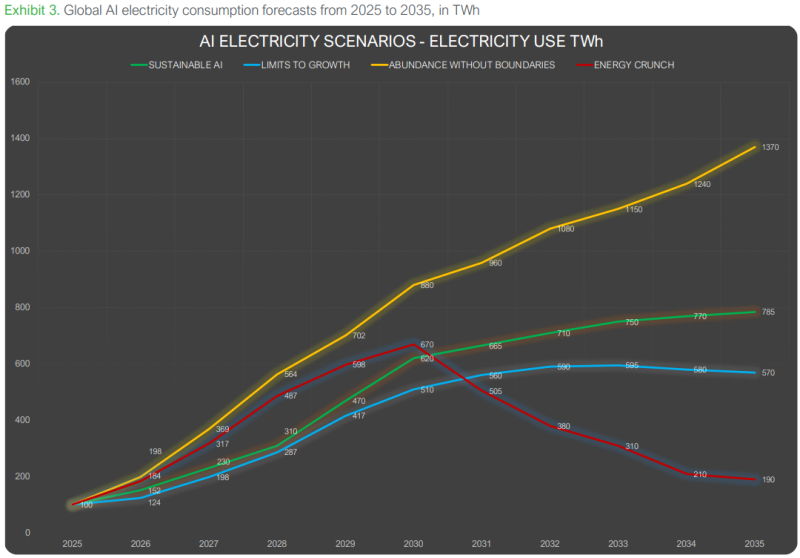

От изобилия до кризиса: Schneider Electric опубликовала прогнозы влияния ИИ на энергопотреблениеКомпания Schneider Electric опубликовала два доклада подведомственного Sustainability Research Institute (SRI), связанные с воздействием искусственного интеллекта (ИИ) на обеспечение экоустойчивости, в частности, на потребление электроэнергии, сообщает Inside HPC. Первый материал, Artificial Intelligence and Electricity: A System Dynamics Approach, изучает четыре возможных сценария развития потребления энергии в связи с ИИ в следующие десять лет. С учётом растущей обеспокоенности экспертов растущим потреблением ИИ-систем, представители SRI и Университета Твенте (Нидерланды) построили динамическую модель системы, предсказывающую различные сценарии спроса на электричество в связи с ИИ — это позволит разрабатывать стратегии устойчивого развития ИИ и схемы минимизации воздействия на окружающую среду в связи с его прогрессом. Эти сценарии не являются «предсказаниями» — скорее инструментами для понимания комплексных факторов, формирующих наше будущее: от действительно устойчивого развития ИИ до более радикальных вариантов будущего вплоть до энергетических кризисов вследствие эволюции ИИ-систем в начале 2030-х годов. Доклад также содержит рекомендации для законотворцев и лиц, принимающих решения, по выбору пути, сочетающем прогресс в области ИИ с экологической и энергетической устойчивостью. Второй доклад, AI-Powered HVAC in Educational Buildings: A Net Digital Impact Use Case, подготовленный SRI и Королевским мельбурнским технологическим институтом (RMIT), демонстрирует, каким образом управляемые ИИ системы отопления, вентиляции и кондиционирования воздуха (HVAC) могут повысить энергоэффективность зданий и способствовать охране окружающей среды. В докладе отмечается, что на HVAC приходится 35–65 % всего энергопотребления зданий. В ходе исследования изучались более 87 образовательных объектов в Стокгольме. С 2019 по 2023 годы было зафиксировало сокращение углеродных выбросов в CO2-эквиваленте на 64,8 тонн в год. Это примерно в 60 раз больше, чем углеродный след внедрённых в систему управления зданиями ИИ и IoT. Более того, точно такая же система в Бостоне (США) позволит снизить углеродные выбросы в семь раз в сравнении со Стокгольмом. Это показывает важность внедрения ИИ в окружениях, требующих усиленного отопления, охлаждения или кондиционирования воздуха. В ноябре сообщалось, что ИИ вообще и генеративный ИИ в частности привели к стремительному росту энергопотребления ЦОД — по прогнозам агентства Gartner, в следующие два года рост составит 160 %. В результате ожидается, что 40 % существующих ИИ ЦОД будут ограничены в энергоресурсах к 2027 году.

09.12.2024 [20:17], Руслан Авдеев

Канада потратит $2 млрд на ИИ ЦОД и суперкомпьютерыМинистр инноваций, науки и промышленности Канады Франсуа-Филипп Шампань (François-Philippe Champagne) официально заявил о старте реализации Канадской стратегии суверенных ИИ-вычислений (Canadian Sovereign AI Compute Strategy). Она предусматривает выделение до $2 млрд, сообщает HPC Wire. Предполагается, что стратегия будет способствовать достижению трёх ключевых целей:

Публичные консультации, посвящённые стратегии, проводились летом 2024 года. Были получены отзывы от более чем 1 тыс. заинтересованных сторон, в том числе от представителей науки, промышленности, общественности и др. Кроме того, власти страны приняли ряд мер по ответственному созданию и внедрению ИИ в экономику Канады, сформировав Канадский институт безопасности ИИ, подготовив Закон об искусственном интеллекте и данных (законопроект C-27) и предложив Добровольный кодекс ответственной разработки и управления передовыми системами генеративного ИИ. Все $2 млрд выделят из государственного бюджета 2024 года в рамках стратегии, удовлетворяющей кратко-, средне- и долгосрочные потребностям исследователей и разработчиков в ИИ-вычислениях. До $700 млн получат представители промышленности, академических кругов и бизнеса, занимающиеся созданием канадских ИИ ЦОД. Среди заявок на финансирование приоритет будет отдаваться высокомаржинальным проектам. До $1 млрд выделят на создание суверенной суперкомпьютерной инфраструктуры, а также безопасного ЦОД. До $300 млн выделят в Фонд доступа к ИИ-вычислениям, более подробная информация котором появится после официального старта программы весной 2025 года. В 2022–2023 гг. количество специалистов в стране выросло на 29 %, достигнув 140 тыс., причём по скорости прироста Канада занимает первое место среди стран «Большой семёрки» (G7). В Канаде работают 10 % ведущих мировых исследователей систем искусственного интеллекта. С 2019 года она также занимет первое место среди стран G7 по количеству посвящённых ИИ научных статей на душу населения. А количество поданных канадскими изобретателями патентов в области ИИ в 2022–2023 гг. увеличилось на 57 %.

09.12.2024 [13:24], Сергей Карасёв

До 132 кВт на стойку: Schneider Electric и NVIDIA разработают эталонную архитектуру охлаждения для ЦОД на основе GB200 NVL72Французская корпорация Schneider Electric, по сообщению ресурса Datacenter Dynamics, совместно с NVIDIA разрабатывает эталонную архитектуру охлаждения для дата-центров, рассчитанных на решение ИИ-задач. Речь, в частности, идёт о ЦОД с суперускорителями GB200 NVL72 (Blackwell). О том, что Schneider Electric и NVIDIA объединили усилия с целью оптимизации инфраструктуры ЦОД, стало известно в марте нынешнего года. Тогда говорилось, что стороны создадут первые в своём роде общедоступные эталонные проекты дата-центров, призванные переопределить стандарты развёртывания и эксплуатации ИИ. Как теперь стало известно, эталонный дизайн охлаждения Schneider Electric предусматривает применение специализированных блоков распределения охлаждающей жидкости (CDU), а также решений прямого жидкостного охлаждения Direct-To-Chip (DTC). Говорится, что такие системы обеспечат возможность охлаждения стоек с вычислительным оборудованием суммарной мощностью до 132 кВт. Финансовые условия сотрудничества не раскрываются. В октябре нынешнего года Schneider Electric приобрела контрольный пакет акций компании Motivair Corporation, которая специализируется на системах жидкостного охлаждения для HPC- и ИИ-платформ. Не исключено, что изделия Motivair будут применяться в составе эталонных СЖО для серверов на базе Blackwell. Апарна Прабхакар (Aparna Prabhakar), старший вице-президент подразделения электропитания Schneider, сообщила, что компания совместно с NVIDIA работает над несколькими вариантами систем охлаждения, которые можно масштабировать в зависимости от количества установленных серверов и потребляемой ими энергии. Это, как ожидается, поможет в развёртывании дата-центров нового поколения, ориентированных на ресурсоёмкие ИИ-вычисления.

08.12.2024 [23:32], Сергей Карасёв

Юлихский суперкомпьютерный центр получил 100-кубитный квантовый компьютер PasqalКомпания Pasqal поставила в Юлихский суперкомпьютерный центр в Германии (JSC) 100-кубитный квантовый компьютер на нейтральных атомах. Установка системы выполнена в рамках проекта HPCQS, реализуемого Европейским совместным предприятием по развитию высокопроизводительных вычислений (EuroHPC JU). Инициатива HPCQS (High Performance Computer and Quantum Simulator hybrid) нацелена на интеграцию квантовых систем с европейской инфраструктурой суперкомпьютеров. Это, как ожидается, позволит создать мощную вычислительную платформу для решения сложных задач в различных областях, таких как здравоохранение, энергетика, автомобилестроение, финансы, торговля и кибербезопасность. Проект HPCQS поддерживается предприятием EuroHPC JU и шестью европейскими странами — Австрией, Францией, Германией, Ирландией, Италией и Испанией. Новая система станет частью Унифицированной инфраструктуры квантовых вычислений Юлиха (Jülich UNified Infrastructure for Quantum Computing, JUNIQ). Система Pasqal использует нейтральные атомы для формирования кубитов. Такие атомы не имеют электрического заряда, благодаря чему слабо взаимодействуют с внешними электромагнитными полями — это позволяет улучшить стабильность. Атомы захватываются и манипулируются с помощью лазера, что даёт возможность проводить высокоточные квантовые операции. Кроме того, системы на базе нейтральных атомов относительно просто масштабируются. В JSC комплекс Pasqal будет сопряжён с суперкомпьютером JURECA DC. Квантовый компьютер планируется применять для выполнения сложного моделирования в физике и химии, а также для квантового машинного обучения. Нужно отметить, что весной нынешнего года JSC получил 5-кубитную систему Spark немецко-финского производителя IQM Quantum Computers. Кроме того, ранее консорциум EuroHPC объявило о планах по созданию двух дополнительных квантовых компьютеров.

06.12.2024 [17:05], Владимир Мироненко

xAI получил ещё $6 млрд инвестиций и приступил к расширению ИИ-кластера Colossus до 1 млн ускорителейСтартап xAI, курируемый Илоном Маском (Elon Musk), планирует на порядок расширить свой ИИ-кластер Colossus в Мемфисе (Теннесси, США), включающий в настоящее время 100 тыс. NVIDIA H100. Как пишет HPCwire, об этом заявил Брент Майо (Brent Mayo), старший менеджер xAI по строительству объектов и инфраструктуры. По словам Майо, стартап уже приступил к работам по расширению ИИ-кластера до не менее чем 1 млн ускорителей совместно с NVIDIA, Dell и Supermicro. Для содействия проекту xAI была создана оперативная группа под руководством главы Торговой палаты Мемфиса Теда Таунсенда (Ted Townsend), готовая оказать помощь в решении проблем в любое время суток. Проект знаменует собой крупнейшее капиталовложение в истории региона. Заявление о старте работ над расширением ИИ-кластера последовало после появления сообщений о том, что xAI удалось привлечь ещё $6 млрд инвестиций. Новые вливания могут увеличить оценку рыночной стоимости стартапа до $50 млрд. Точные цифры будут объявлены немного позже. Colossus используется для обучения моделей ИИ для чат-бота Grok, разработанного xAI, который уступает по возможностям и аудитории лидеру рынка OpenAI ChatGPT, а также Google Gemini. Стартап выпустил свою первую большую языковую модель Grok-1 в конце 2023 года, в апреле 2024 года вышла модель Grok-1.5, а Grok-2 — в августе. Colossus был построен в рекордные сроки — всего за три месяца. Гендиректор NVIDIA, Дженсен Хуанг (Jensen Huang), заявил, что «в мире есть только один человек, который мог бы это сделать». Хуанг назвал Colossus «несомненно самым быстрым суперкомпьютером на планете, если рассматривать его как один кластер», отметив, что ЦОД такого размера обычно строится три года. Активисты из числа жителей Мемфиса раскритиковали проект из-за повышенной нагрузки на местные энергосети и требований, которые ИИ-кластер предъявляет к региональной энергосистеме. «Мы не просто лидируем; мы ускоряем прогресс беспрецедентными темпами, обеспечивая при этом стабильность энергосети, используя Megapack», — заявил в ответ Брент Майо на мероприятии в Мемфисе, пишет Financial Times.

06.12.2024 [16:42], Сергей Карасёв

iGenius анонсировала Colosseum — один из мощнейших в мире ИИ-суперкомпьютеров на базе NVIDIA DGX GB200 SuperPodКомпания iGenius, специализирующаяся на ИИ-моделях для отраслей со строгим регулированием, анонсировала вычислительную платформу Colosseum. Это, как утверждается, один из самых мощных в мире ИИ-суперкомпьютеров на платформе NVIDIA DGX SuperPOD с тысячами ускорителей GB200 (Blackwell). Известно, что комплекс Colosseum располагается в Европе. Полностью характеристики суперкомпьютера не раскрываются. Отмечается, что он обеспечивает производительность до 115 Эфлопс на операциях ИИ (FP4 с разреженностью). Говорится о применении передовой системы жидкостного охлаждения. Для питания используется энергия из возобновляемых источников в Италии. По информации Reuters, в состав Colosseum войдут около 80 суперускорителей GB200 NVL72. Таким образом, общее количество ускорителей Blackwell достигает 5760. Общее энергопотребление системы должно составить почти 10 МВт. Стоимость проекта не называется. Но глава iGenius Ульян Шарка (Uljan Sharka) отмечает, что компания в течение 2024 года привлекла на развитие примерно €650 млн и намерена получить дополнительное финансирование для проекта Colosseum. При этом подчёркивается, что iGenius — один из немногих стартапов в области ИИ в Европе, капитализация которого превышает $1 млрд. iGenius планирует применять Colosseum для ресурсоёмких приложений ИИ, включая обучение больших языковых моделей (LLM) с триллионом параметров, а также работу с открытыми моделями генеративного ИИ. Подчёркивается, что создание Colosseum станет основой для следующего этапа сотрудничества между iGenius и NVIDIA в области ИИ для поддержки задач, требующих максимальной безопасности данных, надёжности и точности: это может быть финансовый консалтинг, обслуживание пациентов в системе здравоохранения, государственное планирование и пр. Модели iGenius AI, созданные с использованием платформы NVIDIA AI Enterprise, NVIDIA Nemotron и фреймворка NVIDIA NeMo, будут предлагаться в виде микросервисов NVIDIA NIM. По заявлениям iGenius, Colosseum поможет удовлетворить растущие потребности в ИИ-вычислениях. Colosseum также будет служить неким хабом, объединяющим предприятия, академические учреждения и государственные структуры. Нужно отметить, что около месяца назад компания DeepL, специализирующаяся на разработке средств автоматического перевода на основе ИИ, объявила о намерении развернуть платформу на базе NVIDIA DGX GB200 SuperPod в Швеции. DeepL будет применять этот комплекс для исследовательских задач, в частности, для разработки передовых ИИ-моделей. |

|