Материалы по тегу: c

|

10.03.2025 [12:16], Сергей Карасёв

SK Telecom займётся созданием ИИ ЦОД совместно с Elice, Schneider Electric и Giga ComputingЮжнокорейская телекоммуникационная компания SK Telecom, по сообщению Datacenter Dynamics, объявила о заключении партнёрских соглашений с Elice, Schneider Electric и Giga Computing с целью развития проектов в области ЦОД, ориентированных на ИИ. В частности, в сотрудничестве с Elice планируется развитие модульных дата-центров для ИИ. Южнокорейская Elice, основанная в 2015 году, предоставляет облачные сервисы в сфере ИИ. Elice предлагает доступ к ускорителям NVIDIA и FuriosaAI. В дальнейшем планируется использовать разработки Rebellions для машинного зрения, чат-ботов и больших языковых моделей (LLM). Кроме того, Elice создала модульный контейнерный ЦОД Elice AI Portable Modular Data Center (PMDC). Отмечается, что SK Telecom подписала меморандум о взаимопонимании (MoU) с Giga Computing и SK Enmove: стороны намерены осуществлять научно-исследовательские и опытно-конструкторские работы в сфере систем охлаждения следующего поколения для дата-центров. Речь идёт о развитии технологий прямого жидкостного охлаждения Direct-To-Chip и иммерсионного (погружного) охлаждения. В рамках партнёрства Giga Computing поделится опытом в создании передовых СЖО, тогда как SK Enmove будет поставлять охлаждающие жидкости. Аналогичное соглашение было заключен с Iceotope.

Источник изображения: Elice В свою очередь, партнёрство между SK Telecom и Schneider Electric ориентировано на разработку и внедрение MEP-систем (вентиляция, электрика, водоснабжение и водоотведение). На первом этапе стороны намерены заниматься развитием проектов в различных регионах Южной Кореи, после чего сотрудничество расширится по всему миру. Наконец, SK Telecom планирует взаимодействовать с компанией IonQ, которая специализируется на разработках в области квантовых вычислений. SK Telecom рассчитывает интегрировать квантовые технологии IonQ в свои ИИ-платформы, включая Personal AI Agent (PAA), GPUaaS (GPU-as-a-Service) и Edge AI. При этом не уточняется, будет ли SK Telecom устанавливать квантовые компьютеры IonQ, такие как Forte Enterprise и Tempo.

10.03.2025 [12:03], Сергей Карасёв

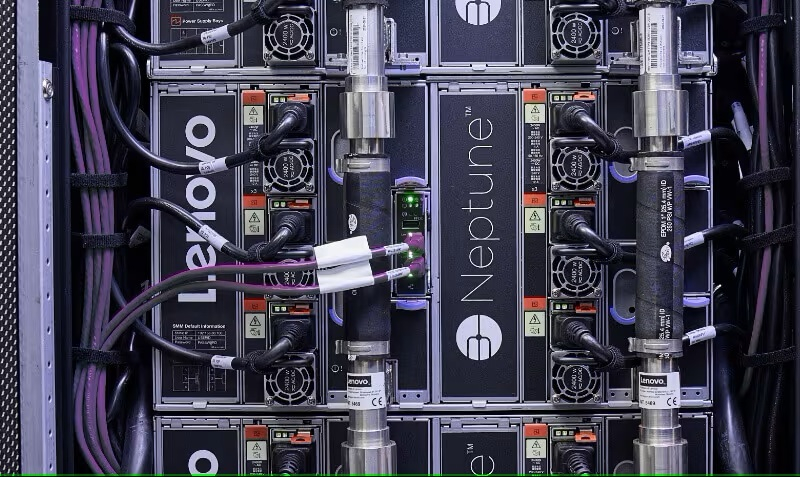

Lenovo создаст крупнейший в Индии ИИ-суперкомпьютер, который получит отечественные чипы KrutrimИндийская компания Krutrim, подразделение Ola Group, специализирующееся на технологиях ИИ, заключила партнёрское соглашение с Lenovo с целью разработки крупнейшего в Индии суперкомпьютера. Как сообщает Datacenter Dynamics, система будет использоваться в том числе для разработки большой языковой модели (LLM) Krutrim 3 с 700 млрд параметров. В ходе конференции Lenovo TechWorld India 2025 Навенду Агарвал (Navendu Agarwal), директор по информационным технологиям Ola, сообщил, что в составе нового НРС-комплекса планируется использовать фирменные чипы Krutrim, а также облачные сервисы этой компании. В дальнейшие подробности относительно технических характеристик машины Агарвал вдаваться не стал. В августе прошлого года Krutrim анонсировала чипы собственной разработки для ИИ-приложений. Это изделие Bodhi 1 для инференса и работы с LLM, процессор Sarv 1 для облачных платформ и дата-центров, поддерживающих ИИ-нагрузки, а также решение Ojas для выполнения задач на периферии. Таким образом, в составе проектируемого суперкомпьютера могут быть задействованы чипы Bodhi 1 и Sarv 1. Агарвал отмечает, что в 2028 году ожидается выход процессора Bodhi 2, который, по его словам, сможет использоваться для работы с LLM, насчитывающими до 10 трлн параметров.

Источник изображения: Lenovo Вместе с тем Krutrim сотрудничает с Arm и Untether AI с целью разработки решений нового поколения для ЦОД, которые будут применяться для настройки и инференса ИИ-моделей Krutrim. В свою очередь, Lenovo осенью 2024 года объявила о намерении организовать выпуск ИИ-серверов на индийском заводе в Пондичерри (Puducherry). Кроме того, Lenovo планирует сформировать передовую научно-исследовательскую лабораторию в Бангалоре (столица штата Карнатака на юге Индии). В целом, Lenovo готова содействовать правительственной программе по трансформации Индии в крупный центр технологических инноваций и производства.

10.03.2025 [08:52], Руслан Авдеев

К2 НейроТех: российский рынок HPC за два года вырос на 35 %К2 НейроТех сделала прогноз относительно основных трендов на российском рынке российских суперкомпьютеров. По оценкам компании, за последние два года рынок высокопроизводительных вычислений (HPC) в стране вырос на 35 % и достиг 15,8 млрд руб. Ключевую роль в этом играет развитие ИИ-систем. В 2025 году рынок HPC должен вырасти как минимум на 12 %. Согласно прогнозам компании, в РФ вырастет местное производство оборудования для ИИ-систем. Рост спроса на искусственный интеллект и вычислительные мощности ведут к распространению HPC в бизнесе. Если раньше такие вычисления применялись в основном в науке и инженерных расчётах, то теперь всё чаще их активно применяют для обработки Big Data, ИИ, машинного обучения и др. В 2024 году вложения в системы хранения данных (СХД) и платформы для высоконагруженных систем выросли на 40 %. Утверждается, что выпуск СХД и ИИ-серверов вырос на 10,5 %, госзакупки таких систем увеличились вдвое, а госкомпании потратили на оборудование для ИИ более 1,7 млрд руб. Ещё одним трендом стали модернизация и масштабирование имеющихся HPC-кластеров. Особенной популярностью стали пользоваться готовые решения «под ключ», поскольку теперь часто возникает проблема совместимости программного обеспечения и оборудования. В К2Тех заявляют, что заказчики всё чаще сталкиваются с тем, что имеющееся оборудование не способно справляться с современными задачами и масштабироваться. Ответом на это также будет развитие HPCaaS и гибридных инфраструктур, объединяющих локальные и облачные вычисления. Наконец, К2 НейроТех предрекает переход к контейнеризированным средам как альтернативе «монолитным» приложениям. Использование Kubernetes, Singularity и Slurm даёт возможность оптимально распределять нагрузки и снижать издержки на эксплуатацию HPC-инфраструктуры.

09.03.2025 [14:02], Сергей Карасёв

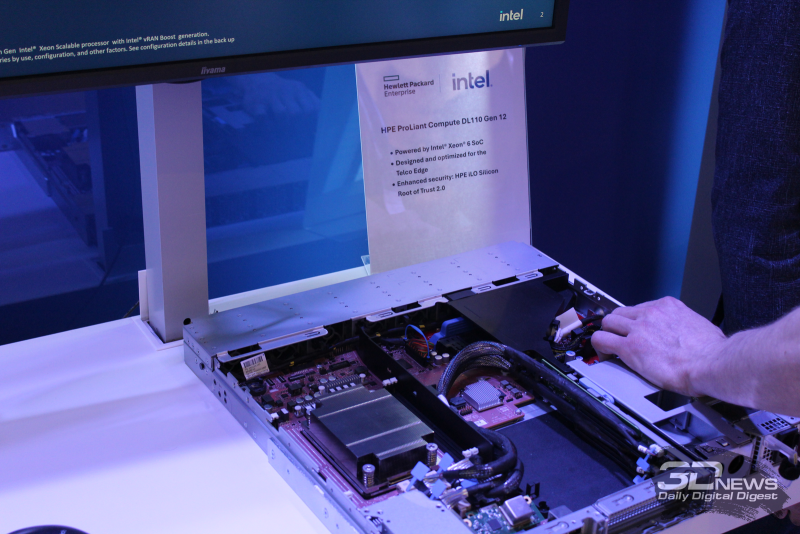

HPE представила сервер ProLiant Compute DL110 Gen12 на базе Intel Xeon Granite Rapids-DНа MWC 2025 компания HPE анонсировала сервер ProLiant Compute DL110 Gen12 для телекоммуникационных операторов. Новинка предназначена для решения различных задач на периферии, таких как виртуализованные сети радиодоступа (vRAN), приложения ИИ и пр. В основу сервера положена аппаратная платформа Intel Xeon 6 SoC (Granite Rapids-D), оптимизированная специально для сетевых и периферийных устройств. Показатель TDP варьируется от 110 до 235 Вт, турбо-частота при использовании всех ядер достигает 2,9 ГГц. Модель ProLiant Compute DL110 Gen12 выполнена в форм-факторе 1U. Полностью характеристики системы пока не раскрываются. Упомянуты функция синхронизации времени GNSS непосредственно на материнской плате и средства управления HPE iLO 7. На выставке MWC 2025 компания HPE демонстрирует ряд других серверов с процессорами AMD и Intel, а также ускорителями NVIDIA. В частности, на стенде производителя представлена машина ProLiant Compute DL384 Gen12 на базе NVIDIA GH200 NVL2. Кроме того, показана система ProLiant Compute XD680 в форм-факторе 5U: это двухпроцессорный GPU-сервер на основе Intel Xeon Emerald Rapids. Он оборудован восемью слотами HHHL PCIe 5.0, четырьмя разъёмами FHHL PCIe 5.0 и двумя слотами OCP 3.0. Возможна установка восьми накопителей SFF U.3 (NVMe). Также была показана свежая 2U-платформа ProLiant Compute DL340 Gen12. Она рассчитана на один процессор Xeon 6700 (Sierra Forest-SP или Granite Rapids-SP), установку до до 4 Тбайт RAM в виде 16 модулей DDR5-6400. Подсистема хранения может иметь несколько конфигураций: 20 × EDSFF, 8 × SFF или 12 × LFF. Поддерживаются установка шести карт расширения одинарной ширины или четырёх — двойной ширины.

Ещё один выставочный экспонат HPE — сервер ProLiant DL345 Gen11 формата 2U, который оснащается одним процессором AMD EPYC Turin. Он поддерживает до 3 Тбайт оперативной памяти DDR5-6400. В зависимости от конфигурации возможна установка до 20 накопителей LFF, до 34 устройств SFF или до 36 накопителей EDSFF. Доступны до шести слотов PCIe 5.0 х16.

07.03.2025 [15:36], Сергей Карасёв

Стартап Axelera AI анонсировал ИИ-ускоритель TitaniaНидерландский стартап Axelera AI B.V., специализирующийся на разработке ИИ-ускорителей, анонсировал решение Titania — высокопроизводительный, энергоэффективный и масштабируемый чиплет для задач инференса. Полностью технические характеристики изделия пока не раскрываются. Известно, что Titania использует проприетарную модель вычислений в памяти Digital In-Memory Computing (D-IMC). Этот подход, как заявляет Axelera AI, обеспечивает ИИ-производительность свыше 50 TOPS на ядро (эквивалентная точность FP32) и энергоэффективность на уровне 15 TOPS на 1 Вт затрачиваемой энергии. Решение Titania базируется на открытой архитектуре RISC-V. Несколько чиплетов могут быть объединены в виде модуля SiP (System-in-Package). Использование D-IMC обеспечивает практически линейную масштабируемость производительности без значительного увеличения затрат на питание и охлаждение. В качестве потенциальных областей применения Titania названы НРС-платформы, корпоративные дата-центры, робототехника, автомобилестроение и пр. Одновременно с анонсом Titania стартап Axelera AI объявил о привлечении до €61,6 млн от EuroHPC JU в рамках проекта Digital Autonomy with RISC-V for Europe (DARE). Компания Axelera AI будет поддерживать EuroHPC в области разработки суперкомпьютерной экосистемы мирового класса в Европе. В частности, стартап планирует расширять свои научно-исследовательские и опытно-конструкторские подразделения в Нидерландах, Италии и Бельгии. Отмечается также, что основанная в 2021 году компания Axelera AI за три года существования получила инвестиции на общую сумму более $200 млн.

07.03.2025 [12:15], Сергей Карасёв

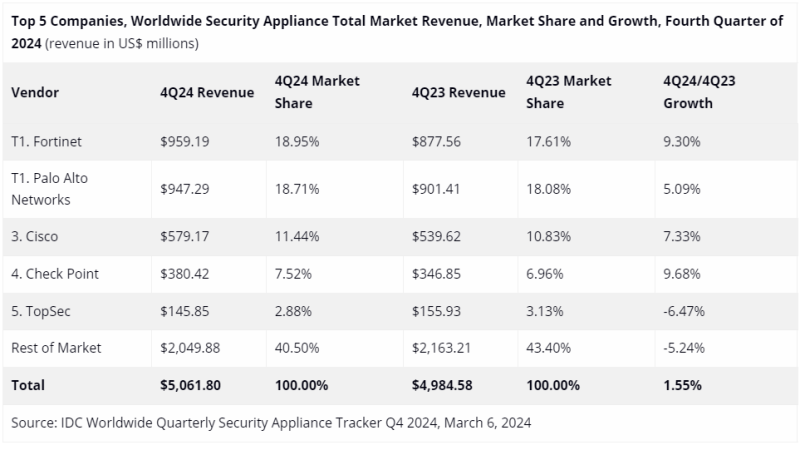

Квартальный объём мирового рынка устройств информационной безопасности достиг $5,1 млрдКомпания IDC опубликовала результаты исследования мирового рынка устройств обеспечения безопасности (Security Appliance) в IV квартале 2024 года. Объём отрасли достиг $5,1 млрд, что на $77 млн, или на 1,5 %, больше по сравнению с показателем годичной давности. Аналитики учитывают отгрузки таких продуктов, как брандмауэры, системы защиты от сетевых угроз (UTM), средства обнаружения и предотвращения вторжений (IPS) и пр. В штучном выражении квартальные поставки данного оборудования за год поднялись на 2,7 %, достигнув 1,2 млн единиц. Крупнейшим игроком глобального рынка является Fortinet с выручкой в размере $959,19 млн по итогам IV квартала 2024 года и долей 18,95 %. Годом ранее эта компания занимала 17,61 % отрасли. На втором месте располагается Palo Alto Networks, получившая $947,29 млн и укрепившая позиции с 18,08 % до 18,71 %. Замыкает тройку Cisco, у которой продажи составили $579,17 млн, а рыночная доля увеличилась в годовом исчислении с 10,83 % до 11,44 %. В пятёрку ведущих поставщиков также входят Check Point и TopSec с выручкой соответственно $380,42 млн и $145,85 млн и долями 7,52 % и 2,88 %. Все прочие производители сообща получили $2,05 млрд выручки, что соответствует 40,50 %. В исследовании сказано, что в последней четверти 2024 года наиболее высокие темпы роста показал регион ЕМЕА (Европа, Ближний Восток и Африка) — 12,4 % в годовом исчислении. При этом максимальный показатель зафиксирован в Западной Европе, где продажи поднялись на 15,4 %. Вместе с тем в Азиатско-Тихоокеанском регионе произошло падение на 4,4 %.

06.03.2025 [21:36], Владимир Мироненко

Google раскрыла детали уязвимости в процессорах AMD и опубликовала инструментарий для анализа и изменения их микрокодаСпециалисты Google Security Team сообщили детали уязвимости (CVE-2024-56161), позволяющей обойти механизм проверки цифровой подписи при обновлении микрокода в процессорах AMD на базе микроархитектуры от Zen1 до Zen4, о чём пишет ресурс OpenNet. Уязвимости присвоен рейтинг опасности CVSS 7,2 балла из 10, что говорит о серьёзности проблемы. «Неправильная проверка подписи в загрузчике исправлений микрокода CPU AMD может позволить злоумышленнику с привилегиями локального администратора загрузить вредоносный микрокод», — говорится в сообщении Google. Исследователи известили AMD об обнаруженной уязвимости 25 сентября 2024 года. Уязвимость, сделавшая возможной загрузку собственных патчей для микрокода процессоров AMD Zen 1-4, вызвана использованием для верификации вместо рекомендованных хеш-функций алгоритма CMAC, который не подходит для этого и не защищён от подбора коллизий. Компания AMD устранила уязвимость в декабрьском обновлении микрокода путём замены CMAC на криптографически стойкую хеш-функцию. Google также опубликовала под лицензией Apache 2.0 инструментарий Zentool, с помощью которого можно анализировать микрокод, манипулировать им и создавать патчи для изменения микрокода в процессорах AMD Zen. Zentool включает команды: zentool edit — редактирует параметры файлов с микрокодом, изменяет микрокод и заменяет отдельные инструкции; zentool print — выводит информацию о структурах и параметрах микрокода; zentool load — загружает микрокод в CPU; zentool resign — корректирует цифровую подпись с учётом добавленных в микрокод изменений. Также в состав Zentool входят утилиты mcas и mcop с реализациями ассемблера и дизассемблера для микрокода. Специалисты Google также подготовили руководство по микроархитектуре RISC86, применяемой в микрокоде AMD, и рекомендации по созданию собственного микрокода с пояснением, как создавать собственные процессорные инструкции, реализуемые на микрокоде RISC86, менять поведение существующих инструкций и загружать изменения микрокода в процессор.

05.03.2025 [11:14], Сергей Карасёв

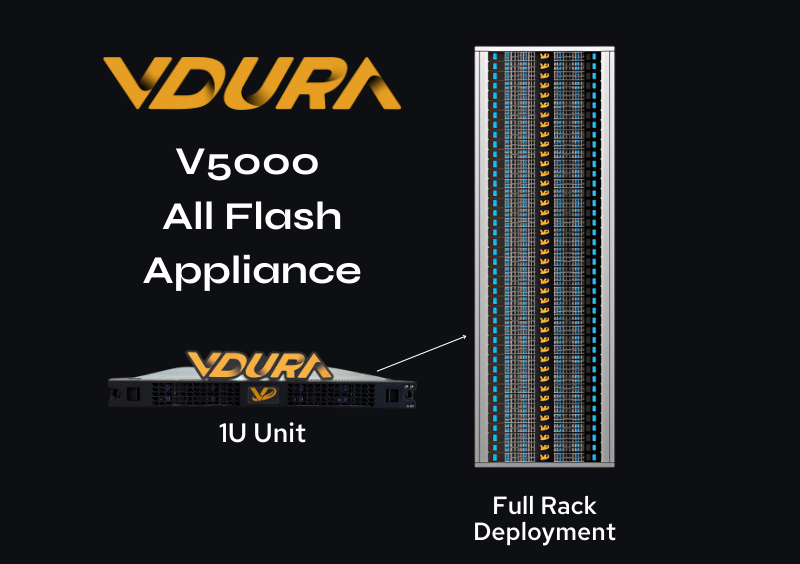

1,5 Пбайт в 1U: СХД Vdura V5000 получила All-Flash узлы F Node со 128-Тбайт NVMe QLC SSDКомпания Vdura анонсировала узел хранения данных V5000 All-Flash Appliance (F Node) типоразмера 1U, предназначенный для использования в составе платформы V5000. Изделие ориентировано на решение ресурсоёмких задач, связанных с ИИ, включая развёртывание генеративных моделей. Платформа V5000, анонсированная около трёх месяцев назад, объединяет управляющие узлы Director Node формата 1U и гибридные узлы хранения на основе SSD и HDD. Применяется фирменная программная платформа Vdura Data Platform (VDP) v11 с параллельной файловой системой PFS. Новые узлы F Node допускают установку 12 накопителей NVMe QLC вместимостью до 128 Тбайт каждый. Таким образом, суммарная «сырая» ёмкость узла достигает 1,536 Пбайт. В основу F Node положен процессор AMD EPYC 9005 Turin, функционирующий в тандеме с 384 Гбайт RAM. Задействован 400G-адаптер NVIDIA ConnectX-7 SmartNIC, обеспечивающий низкую задержку при передаче данных. Упомянуты три слота PCIe и один слот OCP 5.0. Минимальная конфигурация системы V5000 на базе All-Flash включает по три узла Director Node и F Node, которые могут масштабироваться независимо друг от друга для достижения необходимой производительности и/или вместимости. Одна стойка 42U может содержать три узла Director Node и до 39 узлов F Node, что обеспечит 59,9 Пбайт «сырой» ёмкости.

Источник изображения: Vdura В целом, как утверждается, возможно наращивание ресурсов до тысяч узлов F Node. Компания Vdura предлагает унифицированную высокопроизводительную инфраструктуру, которая способна поддерживать каждый этап жизненного цикла ИИ — от обучения модели до долгосрочного хранения данных.

05.03.2025 [09:16], Руслан Авдеев

Новые правила NRO защитят региональных интернет-регистраторов от самих себя и коллегВотчины пяти Региональных интернет-регистраторов (RIR) ожидают изменения локального и глобального уровней. Сейчас организации работают над общей политикой, которая позволит им остановить неправомерные действия одного из них — хотя сам процесс пока вызывает немало вопросов, сообщает The Register. В 2023 году организация Number Resource Organization (NRO), головной орган всех RIR, сообщила о намерении пересмотреть документ ICP-2, с 2001 года определяющий критерии формирования новых RIR. Именно на основе этого документа были сформированы RIR для Африки, Латинской Америки и Карибского бассейна, они были созданы именно на основе принятой политики. С 2005 года новых RIR не открывалось. Теперь NRO намерена пересмотреть данный документ, поскольку тот регламентирует только создание RIR, но ничего не говорит о том, что делать, если будут отмечены злоупотребления и нарушения, наносящие ущерб глобальной системе IP-адресации. В 2024 году организация предложила принципы, которым должен соответствовать регистратор — от наличия сильного управления до, например, финансовой стабильности. Впервые в документе регламентируется весь жизненный цикл RIR, от формирования до мониторинга и отмены его полномочий. Однако с новой версией документа согласны не все, так что пока ведётся его доработка, а финальный вариант должен быть готов к концу 2025 года.

Источник изображения: NRO Одной из причин, по которой NRO решило пересмотреть ICP-2, является ситуация с африканским регистратором AFRINIC (African Network Information Centre). Представителей организации обвиняли в уголовных преступлениях, а также в коррупции. С 2023 года организация стала объектом многих судебных разбирательств и не смогла назначить генерального директора и сформировать совет директоров. Впрочем, пока она продолжает выполнять свои функции, но наличие готового регламента позволило бы провести реформы. В 2024 году азиатско-тихоокеанский регистратор APNIC (Asia Pacific Network Information Center) сменил генерального директора, который тут же уволил четырёх других директоров ради экономии и упрощения структуры организации. Нынешнее правление APNIC изучает возможность продления срока своих полномочий, но с введением верхнего лимита. Кроме того, по итогам проверки APNIC были отменены делегирования 44 субъектам в Индии. Аналогичная проверка начата и в Индонезии, где под подозрение попали 1200 делегирований. Латиноамериканский регистратор (Latin American and Caribbean Internet Addresses Registry, LACNIC) также сменил генерального директора. При этом почти сразу после назначения LACNIC выявил 120 несанкционированных входов на свой портал. Позже массивы информации об учётных записях обнаружили выставленными на продажу в даркнете. С тех пор политику входа на портал ужесточили, включая обязательное использование многофакторной аутентификации (MFA). Некоторые изменения происходят и в RIPE NCC — этот RIR отвечает за Европу, Ближний Восток и часть Центральной Азии. В частности, ведутся разговоры об открытии нового офиса в Дубае. RIPE NCC также приходится довольно сложно, поскольку в его зону ответственности входят Россия, Беларусь и Иран, находящиеся под санкциями отдельных государств, что необходимо учитывать этот фактор при работе. В 2023 году основанная RIPE NCC Евразийская группа сетевых операторов (ENOG) оказалась фактически расформированной после того, как её руководство покинуло посты. Кроме того, данные RIPE тоже попали в даркнет.

23.02.2025 [12:44], Сергей Карасёв

Тайваньские производители серверов расширят мощности в ТехасеРяд тайваньских производителей электроники, в том числе серверов, по информации Reuters, намерены увеличить инвестиции в развитие своих объектов на территории американского штата Техас. Предполагается, что о соответствующих инициативах будет объявлено в мае, что совпадет с первыми 100 днями пребывания президента США Дональда Трампа (Donald Trump) у власти. Трамп раскритиковал Тайвань за перетягивание бизнеса по производству полупроводниковых чипов у США. Американский президент пригрозил пошлинами для торговых партнёров, что может нанести удар по Тайваню. На этом фоне президент Тайваня Лай Циндэ (Lai Ching-te) пообещал нарастить капиталовложения в проекты в США. В свою очередь, Ричард Ли (Richard Lee), председатель Ассоциации производителей электротехники и электроники Тайваня (TEEMA), сообщил, что власти Техаса проявляют активность в привлечении инвестиций от тайваньских компаний. По его словам, сразу несколько тайваньских поставщиков ИИ-серверов намерены расширить производственные мощности в Техасе. В частности, Foxconn, крупнейший в мире контрактный производитель электроники и основной поставщик Apple и NVIDIA, заявил, что одна из его дочерних компаний потратила $33 млн на приобретение земли и промышленных зданий в округе Харрис (Harris) в Техасе. Тайваньские Compal и Inventec, которые также производят ИИ-серверы, планируют расширить присутствие в США, и Техас рассматривается в качестве одного из наиболее предпочтительных вариантов для развёртывания производства. Inventec принадлежала доля в ZT Systems, американском разработчике и производителе серверов для гиперскейлеров. AMD купила ZT Systems в прошлом году, намереваясь со временем продать производственное направление купленной компании, чтобы не конкурировать с собственными клиентами. Одна из новых производственных площадок ZT Systems как раз находится в Техасе. |

|