Материалы по тегу: aws

|

29.12.2024 [15:25], Руслан Авдеев

AWS планирует сократить расходы на оборудование ZT Systems, покупаемой AMDAmazon Web Services (AWS) планирует сократить расходы на закупки оборудования для дата-центров у одного из ключевых поставщиков — всё больше аппаратного обеспечения гиперскейлер разрабатывает самостоятельно. Речь идёт о компании ZT Systems, которая в скором времени станет частью AMD, сообщает Business Insider. В прошлом году AWS потратила почти $2 млрд на дела с ZT Systems, разрабатывающей и выпускающей серверы и сетевые решения — об этом свидетельствует один из внутренних документов Amazon 2023 года, попавших в распоряжение журналистов. Согласно материалам AWS, компания намерена перейти на самостоятельную разработку некоторых «серверных и сетевых стоек». Эти изменения «потенциально повлияют» на сотрудничество с ZT Systems. Информацию подтвердили источники в AWS, также сообщившие, что компания снижает расходы на оборудование данного производителя. Правда, один из них уточнил, что сокращения будут происходить поэтапно, поскольку решения ZT Systems тесно интегрированы с серверами AWS. Официально в AWS утверждают, что компании продолжат сотрудничество. Правда, представитель гиперскейлера подчеркнул, что компания непреклонна в желании сократить расходы. И подход к покупкам инфраструктурных решений в этом отношении ничем не отличается. AWS считается крупнейшим облачным провайдером в мире. Несмотря на сокращение закупок у отдельных поставщиков, траты компании на оборудование вряд ли уменьшатся. Капитальные затраты Amazon должны составить в 2024 году $75 млрд. В основном средства будут направлены на развитие дата-центров. В последние годы AWS использует всё больше оборудования собственной разработки для снижения издержек, повышения эффективности и снижения зависимости от внешних поставщиков. Прочие облачные гиганты, включая Google, также разрабатывают собственные чипы и сетевое оборудование. Летом AMD согласилась приобрести ZT Systems за $4,9 млрд. Это, как ожидается, усилит её позиции в качестве поставщика решений для дата-центров. Несмотря на сокращение сотрудничества, AWS всё ещё может направлять ZT собственные разработки, чтобы та выпускала их на своих мощностях. Правда, ранее AMD сообщала, что планирует продать производственный бизнес ZT Systems после того, как сделка будет закрыта. В последние месяцы некоторые сотрудники AWS выражали обеспокоенность сотрудничеством с ZT Systems, поскольку AWS и AMD выпускают некоторые похожие продукты. Впрочем, AWS тесно сотрудничает с AMD и даже предлагает в облаках доступ к процессорам компании, но новейших ИИ-чипов последней в облачной линейке предложений Amazon пока нет. Отчасти, по данным источников, это объясняется низким спросом.

17.12.2024 [12:30], Сергей Карасёв

1920 vCPU и 32 ТиБ RAM: AWS запустила инстансы EC2 U7inh на базе суперсерверов HPEОблачная платформа AWS объявила о доступности инстансов EC2 U7inh с сертификацией SAP. Эти экземпляры, построенные на серверах HPE, предлагают клиентам мощное и эффективное решение для запуска резидентных баз данных и приложений SAP в облаке. Задействована аппаратная платформа HPE Compute Scale-up Server 3200. Применяются серверы с 16 процессорами Intel Xeon Sapphire Rapids, насчитывающими до 60 вычислительных ядер каждый. Такие машины могут нести на борту до 32 Тбайт оперативной памяти DDR5. Допускается применение накопителей SATA/SAS HDD и SATA/SAS/NVMe SSD. Новые инстансы поддерживают Amazon Linux, Red Hat Enterprise Linux и SUSE Enterprise Linux Server. Сертификация SAP гарантирует, что экземпляры соответствуют строгим требованиям к производительности, объёму памяти и другим критическим характеристикам. Говорится о возможности использования SAP Business Suite on HANA (SoH), Business Suite S/4HANA, Business Warehouse on HANA (BW), SAP BW/4HANA. Несмотря на работу в виртуализированной среде, инстансы EC2 U7inh обеспечивают производительность, сопоставимую с bare metal.

Источник изображения: HPE Конфигурация EC2 U7inh включает 1920 vCPU и 32 768 ГиБ памяти DDR5. Пропускная способность сетевого подключения составляет 200 Гбит/с, пропускная способность EBS — 160 Гбит/с. Подчёркивается, что инстансы EC2 U7inh предоставляют заказчикам высоконадёжное решение для поддержки масштабных рабочих нагрузок SAP, гарантируя бесшовную интеграцию и работу в облачной инфраструктуре AWS. Более того, возможно даже объедиение четырёх инстансов в кластер, что в сумме даёт уже 7680 vCPU и 128 ТиБ RAM.

12.12.2024 [17:36], Сергей Карасёв

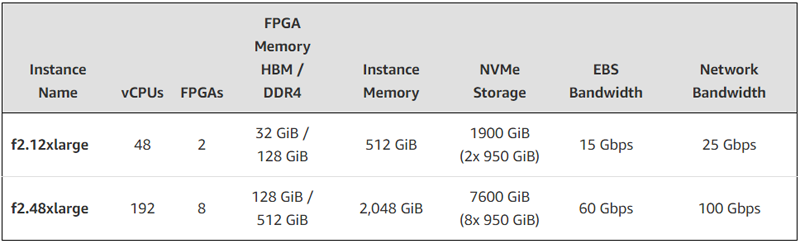

FPGA + EPYC: AWS представила AMD-инстансы EC2 F2 с процессорами Milan и ПЛИС Virtex UltraScale+Облачная платформа AWS анонсировала инстансы второго поколения с FPGA на борту. Экземпляры EC2 F2 ориентированы на решение задач в области геномики, обработки мультимедийных материалов, больших данных, спутниковой связи, компьютерных сетей, моделирования кремниевых чипов и видеотрансляций в реальном времени. В новых инстансах применяются FPGA AMD Virtex UltraScale+ HBM VU47P. Эти изделия содержат 2,852 млн логических ячеек и 9024 DSP. Заявленная ИИ-производительность достигает 28 TOPS при вычислениях INT8. Кроме того, в состав EC2 F2 входят процессоры AMD EPYC поколения Milan. Новые инстансы доступны в вариантах f2.12xlarge и f2.48xlarge — с 48 и 192 vCPU и 2 и 8 FPGA соответственно. Каждая ПЛИС оперирует 16 ГиБ памяти HBM и 64 ГиБ памяти DDR4. Таким образом, в случае f2.12xlarge используется в сумме 32 ГиБ HBM и 128 ГиБ DDR4, а в случае f2.48xlarge — 128 ГиБ и 512 ГиБ соответственно.

Источник изображения: AWS Конфигурация f2.12xlarge включает 512 ГиБ системной памяти и два накопителям NVMe SSD суммарной вместимостью 1900 ГиБ. Пропускная способность сетевого подключения составляет 25 Гбит/с, пропускная способность EBS-томов — 15 Гбит/с. У экземпляра f2.48xlarge объём памяти составляет 2048 ГиБ, общая вместимость NVMe SSD — 7600 ГиБ. Пропускная способность сетевого подключения и EBS-томов достигает 100 Гбит/с и 60 Гбит/с соответственно. Для этого экземпляра предусмотрена поддержка AWS Cloud Digital Interface (CDI) для надёжной передачи несжатого видео (задержка между инстансами заявлена на уровне 8 мс).

05.12.2024 [13:37], Сергей Карасёв

AWS представила инстансы EC2 P5en на базе NVIDIA H200 и кастомизированных чипов Intel XeonОблачная платформа AWS объявила о доступности инстансов EC2 P5en, рассчитанных на такие нагрузки, как глубокое обучение, генеративный ИИ, обработка данных в реальном времени и приложения HPC. В основу новых экземпляров положены аппаратные компоненты Intel и NVIDIA. В частности, задействованы кастомизированные процессоры Xeon Sapphire Rapids. У них все ядра могут одновременно работать на турбо-частоте 3,2 ГГц, а максимальная частота отдельных ядер достигает 3,8 ГГц. Кроме того, применяются ИИ-ускорители NVIDIA H200 и адаптеры AWS Elastic Fabric Adapter (EFA) v3 с пропускной способностью до 3,2 Тбит/с. Конфигурация инстансов EC2 P5en включает 192 vCPU, 2048 ГиБ памяти, восемь ускорителей H200 и восемь SSD вместимостью 3,84 Тбайт каждый. Пропускная способность EBS составляет 100 Гбит/с. Отмечается, что экземпляры P5en демонстрируют увеличение производительности локального хранилища до двух раз и пропускной способности EBS до 25 % по сравнению с инстансами P5 на базе NVIDIA H100.

Источник изображения: NVIDIA На сегодняшний день инстансы EC2 P5en доступны в американских регионах AWS US East (Огайо) и US West (Орегон), а также в Азиатско-Тихоокеанском регионе в Токио. Предлагаются различные тарифные опции, включая оплату по мере использования. Ранее были представлены инстансы EC2 P5e с процессорами AMD EPYC Milan, 2 ТиБ памяти, восемью ускорителями NVIDIA H200 и восемью NVMe SSD на 3,84 Тбайт каждый. У этих экземпляров пропускная способность EBS равна 80 Гбит/с.

05.12.2024 [09:13], Руслан Авдеев

AWS представила новую архитектуру ИИ ЦОД, энергоэффективную и экологичную

aws

hardware

pue

водоснабжение

дизель

ибп

ии

охлаждение

сжо

сша

цод

экология

электропитание

энергетика

энергоэффективность

AWS рассказала об инновациях, внедряемых в её ЦОД для поддержки ИИ-нагрузкок следующего поколения. По данным DataCenter Dynamics, нововведения связаны в первую очередь с электропитанием и охлаждением. Они направлены на повышение энергоэффективности дата-центров AWS. Первые ЦОД на базе новой архитектуры заработают в начале 2025 года. Новые решения в свежих новых дата-центрах компании по всему миру, а некоторые начнут применять уже на существующих объектах. В компании подчёркивают, что решения изначально спроектированы как модульные, поэтому возможная поэтапная модернизация площадок для внедрения СЖО, повышения энергоэффективности и снижения углеродного следа. Так, AWS упростит электрическую и механическую структуру новых ЦОД, чтобы облегчит их обслуживание и повысить надёжность. В частности, упростится подход к распределению энергии внутри ЦОД, а источники резервного питания будут размещаться ближе к стойкам. Это позволит повысить доступность инфраструктуры до 99,9999 % времени, а количество стоек, которых могут коснуться проблемы с энергоснабжением, снизится на 89 %. Также уменьшится количество вентиляторов для отвода горячего воздуха. Вместо этого будет применяться естественный перепад давления, что положительно скажется на энергопотреблении. Вместе с тем AWS намерено вшестеро увеличить мощность стойки в следующие два года, и ещё втрое — в будущем. Впрочем, в ИИ-серверах, где мощность ускорителей приближается к 1 кВт, без СЖО обойтись сложно. AWS готовит суперкластеры Project Rainier и Project Ceiba на базе AWS Tranium2 и NVIDIA Blackwell соответственно, поэтому она вместе с крупным производителем СЖО будет внедрять прямое жидкостное охлаждение и в новых, и в старых ЦОД. В некоторых случаях будет использоваться и гибридное охлаждение. Одним из главных плюсов новой архитектуры охлаждения является гибкость — акцент на воздушное или жидкостное охлаждение будет делаться в зависимости от потребностей оборудования и возможностей конкретных дата-центров. Заодно AWS использовала имеющиеся данные и генеративный ИИ для поиска наиболее эффективного способа размещения стоек в своих ЦОД, добавив ещё 12 % вычислительных мощностей на каждую площадку. Новая технология будет применяться как к новому оборудованию для ИИ-систем, так и для других типов техники. Также компания внедрила собственную систему управления механическими и электрическими устройствами — она поможет стандартизировать мониторинг и эксплуатацию дата-центров. Наконец, предприняты усилия по повышению экобезопасности дата-центров. AWS заявила, что новая архитектура охлаждения снизит потребление энергии на 46 % во времена пиковых нагрузок без увеличения потребления воды. Доля углеродных выбросов при производстве бетона, используемого при строительстве ЦОД, уменьшена на 35 % относительно средней по отрасли, кроме того, на 35 % сокращается потребление стали в целом, а та, что используется, поступает из электродуговых печей, а не газовых, что сокращает косвенные выбросы. Наконец, резервные генераторы AWS переведут на возобновляемое дизельное топливо. Дополнительно AWS совместно с Orbital Materials запустила пилотный проект по тестированию разработанного с помощью ИИ материала, помогающего захватывать в дата-центрах углекислый газ — речь идёт о «губке на атомном уровне», взаимодействующей только с молекулами углекислоты. Тестирование материала, три года разрабатывавшегося компаниями, начнётся в начале 2025 года. По данным Orbital, новый материал значительно дешевле аналогов. В дальнейшем стартап планирует испытать разработанные с помощью ИИ технологии для экономии воды и охлаждения чипов. DataCenter Dynamics также отмечает, что AWS впервые раскрыла показатель PUE своих дата-центров. В среднем он составляет 1,15, а самая лучшая площадка достигла 1,04. Для сравнения: у Google эти показатели составляют 1,1 и 1,06 соответственно, у Microsoft — 1,18 и 1,12 (у новых объектов). ЦОД Meta✴ в среднем имеют PUE около 1,08, а Oracle говорит об 1,15.

04.12.2024 [17:43], Сергей Карасёв

AWS построит распределённый ИИ-суперкомпьютер Project Rainier с десятками тысяч ИИ-ускорителей Trainium2Облачная платформа AWS официально представила инстансы EC2 Trn2 и Trn2 UltraServer — самые высокопроизводительные решения EC2, ориентированные на ИИ-приложения, машинное обучение и задачи инференса. В основу положены фирменные ускорители Amazon Trainium2 второго поколения. ИИ-ускорители Trainium2 содержат восемь ядер NeuronCore и 96 ГиБ памяти HBM с пропускной способностью 2,9 Тбайт/с. Ядра могут адресоваться и использоваться по отдельности или же пары физических ядер могут быть сгруппированы в один логический блок. Trainium2 обеспечивает FP8-быстродействие до 1,3 Пфлопс, а FP8-производительность в разреженных вычислениях достигает 5,2 Пфлопс. Инстансы EC2 Trn2 содержат 16 ускорителей Trainum2, связанных посредством интерконнекта NeuronLink. В сумме это даёт 128 ядер NeuronCore и 1,5 ТиБ памяти HBM с суммарной пропускной способностью 46 Тбайт/с. Производительность на операциях FP8 достигает 20,8 Пфлопс. Каждый инстанс включает 192 vCPU, 2 ТиБ памяти и адаптеры AWS Elastic Fabric Adapter (EFA) v3 на 3,2 Тбит/с. Утверждается, что инстансы Trn2 обеспечивают в четыре раза более высокую производительность, в четыре раза большую пропускную способность памяти и в три раза большую ёмкость памяти, нежели инстансы Trn1. Кроме того, экземпляры Trn2 предлагают на 30–40 % лучшее соотношение цены и производительности, чем EC2 P5e и P5en на базе GPU. Инстансы Trn2 доступны в регионе AWS US East (Огайо), а в ближайшем будущем появятся и в других зонах. В свою очередь, платформа UltraServer включает четыре инстанса Trn2 (64 ускорителя Trainum2) с интерконнектом NeuronLink с низкой задержкой. В сумме это даёт 512 ядер NeuronCore и 6 ТиБ памяти HBM с суммарной пропускной способностью 185 Тбайт/с. Быстродействие на операциях FP8 составляет 83 Пфлопс (332 Пфлопс в разреженных вычислениях). Новые узлы используют СЖО. Десятки тысяч ускорителей Trainium2 могут формировать кластеры EC2 UltraCluster. В частности, такую систему в рамках инициативы Project Rainier компания Amazon намерена создать в партнёрстве со стартапом Anthropic, который специализируются на технологиях генеративного ИИ. Интересно, что ИИ-суперкомпьютер Project Rainier будет распределённым — его узлы разместятся сразу в нескольких ЦОД. ВОЛС между дата-центрами организует Lumen. Одной из причин от попытки построить один гигантский кампус называется невозможность быстро получить достаточно энергии в одном месте, хотя у компании уже есть площадка рядом с АЭС. Недавно Amazon объявила о намерении удвоить инвестиции в Anthropic, доведя их до $8 млрд. Создание системы Rainier планируется завершить в следующем году. Ожидается, что она станет одним из крупнейших в мире вычислительных кластеров для обучения моделей ИИ. По заявлениям AWS, комплекс обеспечит в пять раз более высокую производительность по сравнению с платформой, которую Anthropic использовала до сих пор для разработки своих языковых моделей. Достанутся ли Anthropic и ресурсы ещё облачного ИИ-суперкомпьютера Project Ceiba, который получит 21 тыс. суперчипов NVIDIA Blackwell, не уточняется. Кроме того, по сообщению The Register, компания Amazon приоткрыла завесу тайны над ИИ-ускорителями следующего поколения — изделиями Trainium3. По сравнению с предшественниками они, как утверждается, обеспечат четырёхкратное увеличение быстродействия. Говорится, что Trainium3 станет первым специализированным ускорителем для ИИ и машинного обучения, созданным на основе 3-нм техпроцесса. Эффективность по сравнению с Trainium2 увеличится примерно на 40 %. Ожидается, что на коммерческом рынке изделия Trainium3 появятся в конце 2025 года.

04.12.2024 [15:44], Руслан Авдеев

Marvell перенесёт разработку чипов в облако AWS, а AWS получит от Marvell новые чипы для своих ЦОДКомпания Marvell Technology, занимающаяся полупроводниковыми инфраструктурными решениями, объявила о расширении стратегического партнёрства с Amazon Web Services (AWS). Стороны заключили соглашение сроком на пять лет, включающее сотрудничество в работе над несколькими продуктами AWS, а также использование облачной инфраструктуры техногиганта, сообщает пресс-служба Marvell. Соглашение касается широкого спектра решений Marvell, предназначенных для дата-центров. В том числе речь идёт о поставке кастомизированных ИИ-чипов для AWS, оптических и электрических DSP, PCIe-ретаймеров, оптических сетевых решениях, чипсетов для коммутаторов и др. Компетенции Marvell позволят AWS усовершенствовать собственные продукты, сетевое оборудование и СХД, добившись большей эффективности и снижения стоимости эксплуатации. Для автоматизации проектирования электроники (EDA) в Marvell приняли подход cloud first, разработка ведётся с использованием облака AWS, где компании доступны практически неограниченные вычислительные ресурсы. В Marvell уже заявили, что решения AWS EDA помогут компании быстро, гибко и безопасно масштабировать проектирование полупроводников с лучшим в своём классе временем выхода на рынок. Сотрудничество играет на руку и AWS — продукты Marvell активно используются в инфраструктуре Amazon.

03.12.2024 [05:58], Руслан Авдеев

Сдайте ваши файлы: Amazon открыла в США пункты выгрузки данных в AWSAmazon представила сервис AWS Data Transfer Terminal — пункты, где можно быстро и безопасно выгрузить большие объёмы данных в облако AWS. Первые терминалы расположены в Лос-Анджелесе и Нью-Йорке, в будущем планируется добавить пункты приёма данных и в других локациях по всему миру. Использование пунктов AWS Data Transfer Terminal позволит значительно снизить время передачи данных (не считая времени на дорогу и обратно) в хранилища S3, EFS и др. Например, можно выгрузить большие датасеты от парка беспилотных машин, видеофайлы или картографические данные для дальнейшего анализа и обработки. Также с собой можно принести носители Snowball, хотя в целом AWS постепенно сворачивает сервисы Snow по физической доставке данных в облако. Список терминалов доступен в AWS Management Console, где можно заранее назначить дату и время визита и вписать участников. В назначенный час сотрудник AWS проверит документы и проводит до отдельной комнаты, где есть патч-панель, оптоволоконный кабель и ПК. Патч-панель интегрирована в небольшую стойку, а компьютер можно использовать для контроля процесса передачи данных. Примечательно, что в целях безопасности на зданиях и в помещениях нет никаких символов AWS. Плата за гигабайты не предусмотрена, вместо этого платить придётся за время загрузки в регионы AWS. При этом доступны только те регионы, которые находятся на том же континенте, где и пользователь.

02.12.2024 [11:28], Сергей Карасёв

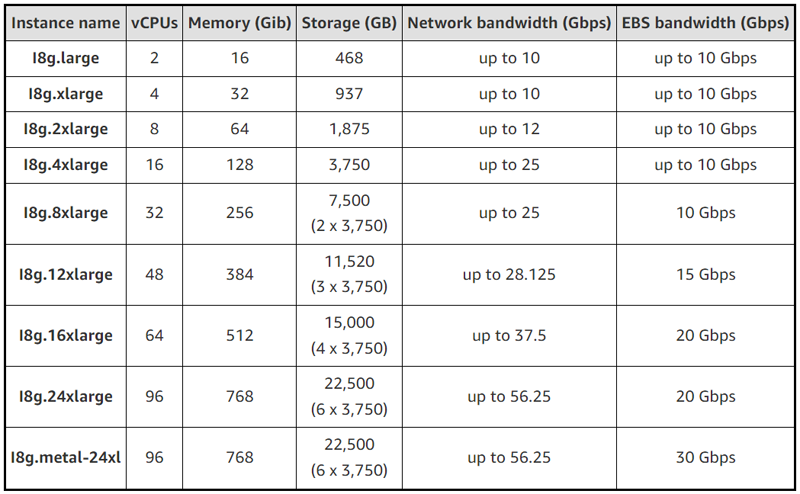

AWS запустила инстансы EC2 I8g с собственными процессорами Graviton4 и накопителями Nitro SSDОблачная платформа Amazon Web Services (AWS) анонсировала инстансы EC2 I8g, оптимизированные для хранения данных. Утверждается, что по сравнению с решениями предыдущего поколения EC2 I4g достигается прирост производительности на операциях хранения в реальном времени до 65 % в расчёте на 1 Гбайт. Инстансы EC2 I8g базируются на фирменных процессорах Graviton4, насчитывающих до 96 ядер Arm. Кроме того, впервые применены накопители AWS Nitro SSD третьего поколения, которые изготавливаются по индивидуальному заказу Amazon. Эти устройства, как утверждается, обеспечивают высокую производительность ввода-вывода, низкую задержку, минимальную изменчивость задержки и безопасность благодаря шифрованию. В зависимости от модификации инстансы EC2 I8g предлагают от 2 до 96 vCPU, а объём памяти варьируется от 16 до 768 ГиБ. Вместимость хранилища составляет от 468 Гбайт до 22,5 Тбайт. Пропускная способность сетевого подключения находится в диапазоне от 10 Гбит/с до 56,25 Гбит/с, пропускная способность EBS-томов — от 10 до 30 Гбит/с.

Источник изображения: AWS Отмечается, что инстансы I8g предназначены для рабочих нагрузок с интенсивными IO-операциями, требующими доступа к информации с минимальными задержками. Это могут быть различные базы данных, включая платформы реального времени (MySQL, PostgreSQL, Aerospike, Apache Druid, MongoDB), а также аналитика реального времени. Задействована система AWS Nitro, которая переносит функции виртуализации, хранения и сетевые операции на выделенное оборудование и ПО для повышения производительности и улучшения безопасности. Говорится о совместимости с Amazon Linux 2023, Amazon Linux 2, CentOS Stream 8 или новее, Ubuntu 18.04 или новее, SUSE 15 SP2 или новее, Debian 11 или новее, Red Hat Enterprise 8.2 или новее, CentOS 8.2 или новее, FreeBSD 13 или новее, Rocky Linux 8.4 или новее, Alma Linux 8.4 или новее и Alpine Linux 3.12.7 или новее.

25.11.2024 [20:50], Руслан Авдеев

Amazon вложит ещё $4 млрд в Anthropic и снизит её зависимость от NvidiaКомпания Amazon (AWS) раскрыла планы удвоить инвестиции в Anthropic, доведя их до $8 млрд. Объявление о новых вложениях было сделано через год после того, как гиперскейлер сообщил о выделении стартапу $4 млрд, сообщает Silicon Angle. На тот момент главный конкурент OpenAI назвал AWS своим ключевым облачным провайдером. С новой сделкой роль AWS в обучении моделей Anthropic только усилится. Anthropic представила свою наиболее передовую модель Claude 3.5 Sonnet в прошлом месяце — это улучшенная версия большой языковой модели (LLM) той же серии, дебютировавшей несколько месяцев назад. Новая Claude 3.5 Sonnet лучше предшественницы в выполнении некоторых задач, включая написание кода. Она также обошла OpenAI GPT-4o в нескольких бенчмарках. Anthropic предлагает свои LLM через сервис Amazon Bedrock, обеспечивающий доступ к управляемым ИИ-моделям. Расширенное сотрудничество обеспечит пользователям ранний доступ к функции, позволяющей настраивать модели Claude с использованием кастомных датасетов. Также планируется поддержать друг друга в разработках. Anthropic будет использовать ИИ-ускорители Trainium и Inferentia для внутренних задач. В компании подчеркнули, что задействуют ускорители для крупнейших базовых моделей. В то же время специалисты Anthropic поддержат AWS в разработке новых чипов Tranium. Стек ПО Neutron включает компилятор, оптимизирующий ИИ-модели для работы на инстансах Tranium, и некоторые другие инструменты. Компания также работает над низкоуровневыми программными ядрами, распределяющими задачи между вычислительными ядрами ускорителей. Последний раунд финансирования Anthropic состоится через два месяца после того, как OpenAI привлекла рекордные для стартапа $6,6 млрд. Также она получила кредитную линию на $4 млрд от группы банков. OpenAI, оцениваемая в $157 млрд, будет инвестировать средства в ИИ-исследования и вычислительную инфраструктуру. |

|