Материалы по тегу: .net

|

16.07.2025 [11:44], Сергей Карасёв

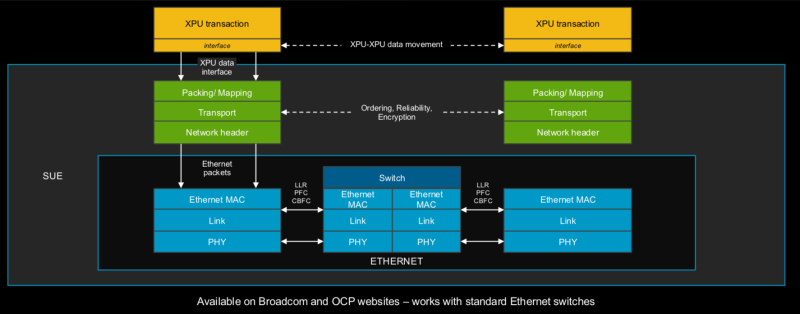

Broadcom представила 51,2-Тбит/с чип-коммутатор Tomahawk Ultra — альтернативу NVIDIA InfiniBand и NVLinkКомпания Broadcom анонсировала чип-коммутатор Tomahawk Ultra, специально разработанный для кластеров НРС и платформ ИИ. Новинка, как ожидается, составит конкуренцию InfiniBand в традиционных суперкомпьютерах, NVLink в стоечных решениях вроде NVIDIA GB200 NVL72, а также Ultra Accelerator Link (UALink) в масштабируемых системах ИИ в дата-центрах. Решение Tomahawk Ultra разработано в рамках инициативы Broadcom Scaling Up Ethernet (SUE). Утверждается, что эта технология будет поддерживать масштабируемые системы с не менее чем 1024 ускорителями ИИ. Для сравнения, NVIDIA заявляет, что её коммутационная система NVLink 5/6 позволяет объединить до 576 ускорителей в одном домене. Broadcom подчёркивает, что чип Tomahawk Ultra разработан с нуля специально для удовлетворения потребностей высоконагруженных НРС-сред и ИИ-кластеров. Новинка обеспечивает коммутационную способность 51,2 Тбит/с при размере пакетов 64 байта. Задержка составляет 250 нс, что значительно меньше, чем у коммутаторов с более высокой пропускной способностью. А общая задержка при общении XPU между собой составляет не более 400 нс. Поддерживается обработка до 77 млрд пакетов в секунду.

Источник изображений: Broadcom Основная часть трафика, передаваемого через коммутаторы Ethernet, состоит из пакетов большего размера. Поэтому при проектировании сетевого оборудования внимание уделяется прежде всего увеличению размера пакетов для оптимизации пропускной способности. Вместе с тем обмен пакетами небольшого размера широко распространен в платформах НРС/ИИ: представленная новинка Broadcom нацелена именно на такие среды.

Чип-коммутатор Tomahawk Ultra (семейство BCM78920) поддерживают 64 порта 800GbE, 128 портов 400GbE или 256 портов 200GbE. Изделие использует блоки Peregrine 106.25G PAM4 SerDes. Решение совместимо по выводам с Broadcom Tomahawk 5 (TH5). Поддерживаются функции, предназначенные для масштабируемых нагрузок ИИ и HPC, включая Link Layer Retry (LLR), Credit-based Flow Control (CBFC) и AI Fabric Headers (AFH). Кроме того, непосредственно в ASIC реализована поддержка коллективных операций вроде AllReduce and AllGather. Используются измененные заголовки Ethernet, размер которых уменьшен с 46 до 10 байт: это позволяет оптимизировать общее соотношение размера заголовка к полезной нагрузке. Упомянута совместимость с современными топологиями сетей HPC, такими как Mesh, Torus и Dragonfly. Кроме того, заявлена совместимость с Ultra Ethernet (UEC). Поставки Tomahawk Ultra уже начались.

07.07.2025 [10:15], Руслан Авдеев

DPU-революция так и не состоялась, но развитие ИИ может изменить ситуациюВ 2013 году AWS представила инстансы EC2 C3, вскользь упомянув о расширенных сетевых возможностях благодаря появлению Intel Virtual Function. Позже компания пояснила, что кастомные сетевые адаптеры позволили перенести на них часть нагрузок вроде межсетевого экрана, что высвободило ресурсы серверов. Данное решение оставалось нишевым, но развитие ИИ может всё изменить, сообщает The Register. Решение нашло отклик и у других гиперскейлеров. Они начали создавать собственные SmartNIC или DPU. Mellanox в 2017 году представила DPU BlueField, изначально предназначенный для ускорения перемещения данных All-Flash хранилищ. Чуть позже VMware начала адаптацию своего гипервизора для работы со SmartNIC, предусматривающую запуск сетевых функций на DPU. Потенциал разработки оценила и NVIDIA, которая и приобрела Mellanox, а позже — ещё и Nebulon. В 2021 году Intel вместе с Google разработала Infrastructure Processing Unit (IPU), а годом позже AMD купила разработчика DPU Pensando. В 2022 году VMware представила vSphere Distributed Services Engine, предназначенный для управления SmartNIC и реализации на них распределённого файрвола. Хотя за SmartNIC стояли ключевые игроки IT-отрасли вроде VMware, Intel, AMD и NVIDIA, у каждой из которых было немало клиентов из сферы дата-центров, никакой революции с массовым применением DPU не произошло. VMware признала, что Distributed Services Engine не получил всеобщего признания, а эксперты отрасли подчеркнули, что основными потребителями DPU являются AWS и Microsoft Azure, сдающие мощности конечным заказчикам. ⅔ развёртываний DPU и SmartNIC приходится именно на этих двух гиперскейлеров, а за пределами облачного сегмента особенного прогресса нет.

Источник изображения: Microsoft Впрочем, намечаются и новые сценарии применения DPU, например — в Ethernet-коммутаторах или даже в качестве замены CPU. Потенциально это поможет расширить клиентскую базу. Например, Cisco применяет DPU в «защитных» продуктах Hypershield и смарт-коммутаторах N9300, а первыми DPU в свои коммутаторы CX 1000 внедрила Aruba ещё в 2021 году. Но такие продукты массовыми так и не стали. Ситуацию может изменить стремительное развитие ИИ-технологий. Недавно аналитики Gartner представили «эталонную» архитектуру для работы с ИИ на периферии и в Kubernetes-средах. В обоих случаях рекомендуется использовать DPU. Аналогичный подход в архитектуре для ИИ-облаков поддерживает и NVIDIA. Red Hat тоже поддержала идею использования DPU для виртуальных коммутаторов, балансировщиков, межсетевых экранов, для оптимизации работы баз данных или аналитических нагрузок за счёт прямого взаимодействия с NVMe и даже для инференса. Так, в OpenShift скоро появится DPU Operator. Пять лет назад Fungible объявила, что DPU должны стать «третьим сокетом» наравне с CPU и GPU, а через два года она была куплена Microsoft. И ей ещё повезло, потому что, например, Kalray оказалась вынуждена продать часть своего бизнеса. Возможно, в жизни этой компании и других стартапов наступит светлая полоса — революция в сфере ИИ может привести и к революционному развитию DPU.

24.06.2025 [13:54], Владимир Мироненко

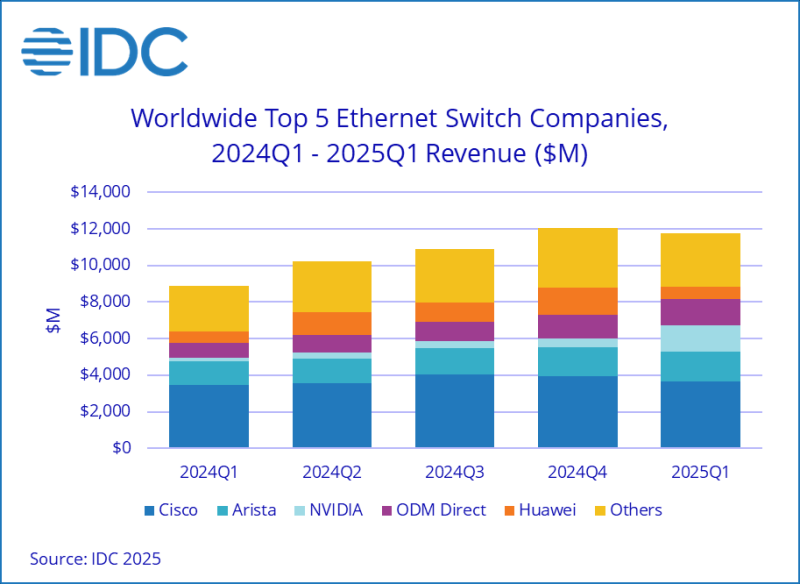

Продажи Ethernet-коммутаторов NVIDIA за год выросли на 760 % благодаря спросу на ИИIDC опубликовала отчёт о рынке Ethernet-коммутаторов по итогам I квартала 2025 года, согласно которому доход от продаж устройств составил $11,7 млрд, что на 32,3 % больше в годовом исчислении, пишет The Register. IDC утверждает, что этот бум обусловлен растущим развёртыванием «сетевой инфраструктуры с высокой пропускной способностью и малой задержкой для поддержки ИИ-нагрузок». Продажи коммутаторов 200/400GbE, которые большей частью используются в ЦОД, выросли год к году в 2,9 раза (189,7 %). Исходя из данных IDC и построенной на их основании модели ресурс The Next Platform пришёл к выводу, что сегменты 200 и 400 GbE вместе принесли около $4,5 млрд, более 18 млн портов в отчётном квартале. IDC также впервые опубликовала данные о 800GbE-коммутаторах, которые принесли $350,1 млн, что составляет 5,1 % общего объёма глобальных продаж Ethernet-коммутаторов за отчётный период. The Next Platform отметил, что IDC не сообщила о продажах Ethernet-коммутаторов стандарта 100 GbE, которые используются на рынке high-end кампусов, в корпоративных сетях и сетях поставщиков услуг, а также о продажах устройств стандарта 10 GbE, которые начали поставляться в больших объёмах в 2023 году. По оценкам The Next Platform, устройства 100 GbE принесли около $3 млрд дохода в I квартале, а коммутаторы 10 GbE — более $500 млн. Продажи устройств 2,5 GbE, 5 GbE, 25GbE и 50 GbE для использования в кампусах и на периферии составляют большую часть оставшейся суммы.

Источник изображения: NVIDIA IDC также начала отдельно отслеживать статистику NVIDIA. Выручка компании выросла год к году на 760,3 % и на 183,7 % последовательно до $1,46 млрд, что составило 12,5 % рынка коммутаторов. Доходы Cisco от продаж Ethernet-коммутаторов выросли на 4,7 % до $3,64 млрд, компания занимает чуть меньше трети рынка. При этом выручка Cisco от продаж коммутаторов для ЦОД упал на 3,2 %. Arista Networks увеличила продажи в годовом исчислении на 27,1 % до $1,63 млрд, благодаря чему её доля рынка составила 13,9 %. Продажи коммутаторов HPE, которые в основном связаны с беспроводными решениями Aruba, упали год к году на 5 %. Продажи Huawei составили $704 млн, что на 15,4 % больше в годовом исчислении, но более чем вдвое меньше, чем в предыдущем квартале. I квартал традиционно является очень слабым для Huawei. ODM-производители, в подавляющем большинстве поставляющие коммутаторы для ЦОД, в совокупности увеличили продажи до $1,41 млрд, показав рост на 67,5 % в годовом исчислении и на 18,6 % — последовательно. Продажи Ethernet-коммутаторов для ЦОД выросли в I квартале на 54,6 % до $6,92 млрд, составив 59,1 % от общего объёма продаж. В период с I квартала 2020 года по IV квартал 2022 года, когда начался бум генеративного ИИ, средняя доля рынка Ethernet-коммутаторов для ЦОД составляла 43,5 %. Это большой скачок в расходах на Ethernet для ЦОД, и он полностью связан с развёртыванием ИИ-кластеров для обучения и всё большего инференса, считают аналитики ресурса The Next Platform.

Источник изображения: IDC Часть рынка, не связанная с ЦОД, включающая устройства для кампусов и периферии, составила $4,78 млрд, увеличившись на 9,5 % год к году. Чуть больше половины этой суммы приходится на поставки коммутаторов стандарта 2,5 GbE для использования в кампусах. Лидером продаж в сегменте Ethernet-коммутаторов для ЦОД является Arista Networks, которая лидирует в этой категории с IV квартала 2023 года. Её продажи в I квартале составили $1,48 млрд, что на 26,4 % больше в годовом исчислении, обеспечив ей долю рынка в размере 21,3 %. К ней вплотную подобралась NVIDIA, увеличившая продажи до $1,46 млрд, что принесло ей долю рынка коммутаторов для ЦОД в 21,1 %. Как полагают аналитики The Next Platform, NVIDIA достаточно заключить ещё пару крупных сделок, и она опередит в этой категории сетевых устройств Arista Networks. В этом NVIDIA поможет расширение сотрудничества с Cisco, занявшей третье место в этой категории с продажами Ethernet-оборудования в $1,25 млрд, что на 17,7 % больше в годовом исчислении. ODM-производители, как уже сообщалось, увеличили выручку на 67,5 % до $1,41 млрд. В их числе около дюжины компаний, которые производят сетевое оборудование в заметных объёмах.

21.06.2025 [23:32], Сергей Карасёв

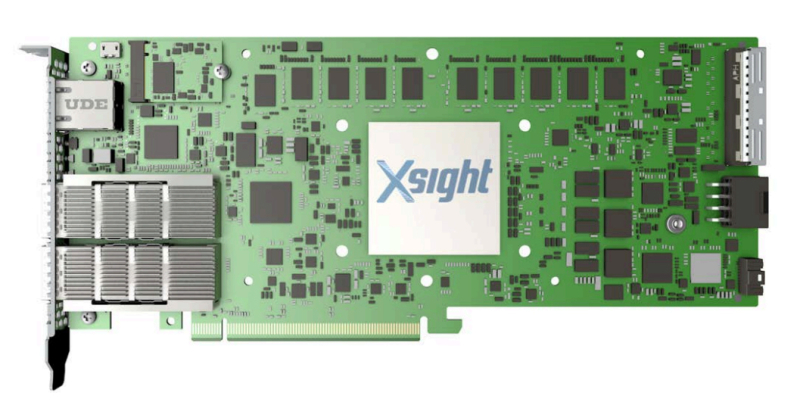

Xsight Labs выпустила DPU E1 с 64 ядрами Arm Neoverse N2 и 40 линиями PCIe 5.0Компания Xsight Labs объявила о доступности программно-определяемых «систем на чипе» (SoC) серии E1, предназначенных для создания DPU. Такие изделия могут применяться в облачных и периферийных дата-центрах, рассчитанных в том числе на ИИ-нагрузки. О подготовке решений E1 сообщалось в конце прошлого года. Для чипа предусмотрены варианты E1-32 и E1-64, конфигурация которых включает соответственно 32 и 64 ядра Arm Neoverse N2. Младшая версия имеет 16 Мбайт кеша и использует конфигурацию памяти 2 × DDR5-5200, старшая — 32 Мбайт и 4 × DDR5-5200. Доступны 40 (32+8) линий PCIe 5.0. Сетевые порты могут иметь конфигурацию 2 × 400GbE, 4 × 200GbE и 8 × 100/50/25/10GbE. На базе E1 могут создаваться карты расширения различной конфигурации. Благодаря наличию 32 программируемых линий PCIe 5.0 и восьми двухрежимных контроллеров 16 линий могут быть выделены для хост-подключения, а другие 16 линий — для подключения внешних устройств. В качестве примера приводится конфигурация с двумя портами 400GbE или возможностью подсоединения четырёх SSD с интерфейсом PCIe 5.0 х4 каждый. Кроме того, компания Xsight Labs представила 1U-систему E1-Server в форм-факторе на основе E1. Эта платформа подходит для решения таких задач, как CDN, веб-сервер, VPN, шлюз для защиты от DDoS-атак и пр. Устройство располагает четырьмя слотами для модулей памяти DDR5-5200 суммарным объёмом до 512 Гбайт и коннекторомв для SSD формата M.2. Возможна установка двух карт расширения типоразмера FHFL/FHHL/HHHL. Диапазон рабочих температур — от 0 до +35 °C.

13.06.2025 [02:20], Владимир Мироненко

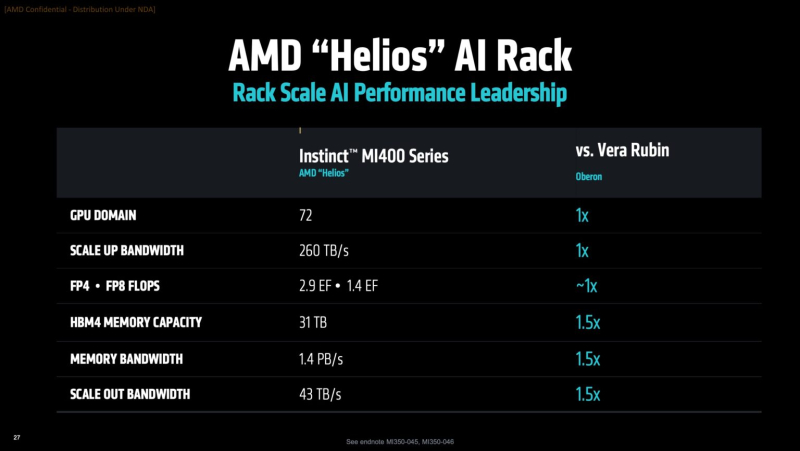

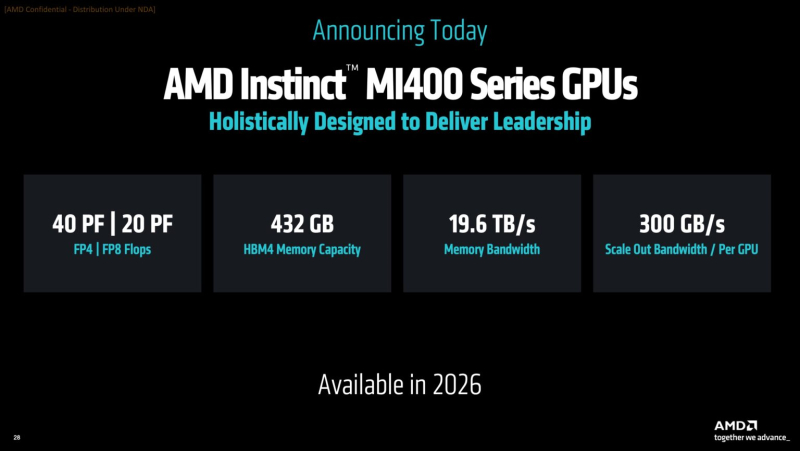

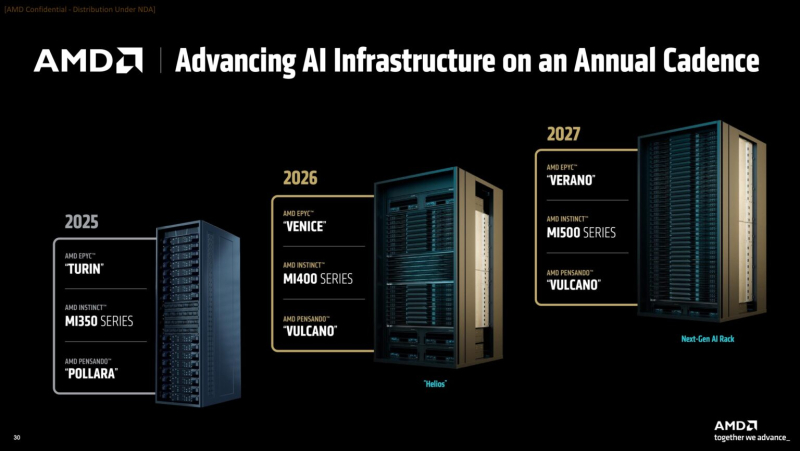

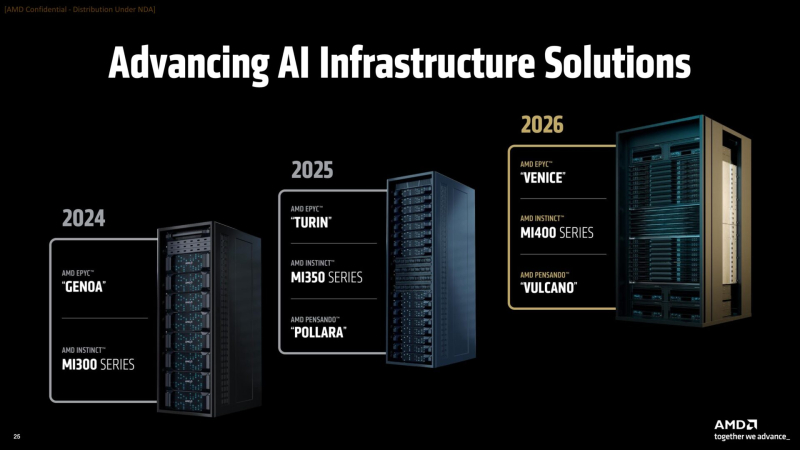

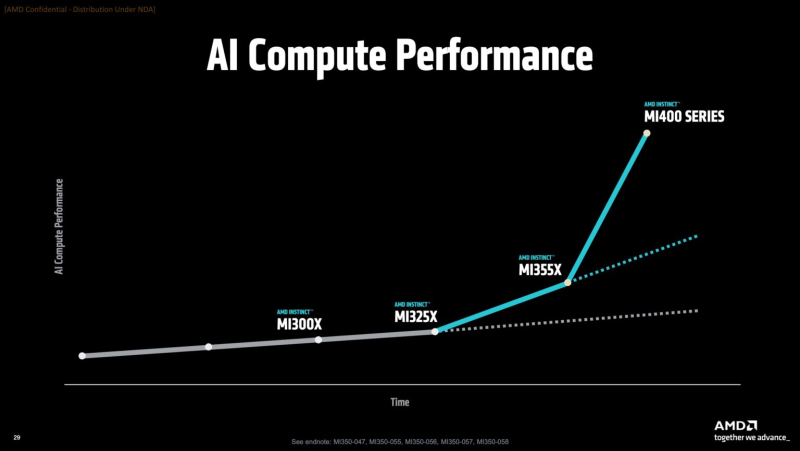

AMD готовит ИИ-стойки Helios AI двойной ширины с Instinct MI400, AMD EPYC Venice и 800GbE DPU Pensando VulcanoВместе с анонсом ускорителей MI350X и MI355X также рассказала о планах на ближайшее будущее, включая выпуск ускорителей серий MI400 (Altair) в 2026 году и MI500 (Altair+) в 2027 году, а также решений UALink, Ultra Ethernet, DPU Pensando и стоечных архитектур, которые послужат основой ИИ-кластеров. Так, AMD анонсировала новую архитектуру Helios AI с стойками двойной ширины, которая объединит процессоры AMD EPYC Venice с ядрами Zen 6, ускорители Instinct MI400 и DPU Vulcano. Благодаря приобретению ZT Systems компания смогла существенно ускорить разработку и интеграцию решений уровня стойки — Helios AI появятся уже в 2026 году. Как сообщает DataCenter Dynamics, Эндрю Дикманн (Andrew Dieckmann), корпоративный вице-президент и генеральный менеджер AMD по ЦОД рассказал перед мероприятием, что решение об увеличении ширины стойки было принято в сотрудничестве с «ключевыми партнёрами» AMD, поскольку предложение должно соответствовать «правильной точке проектирования между сложностью, надёжностью и предоставлением преимуществ производительности». По словам AMD, это позволит объединить тысячи чипов таким образом, чтобы их можно было использовать как единую систему «стоечного масштаба». «Впервые мы спроектировали каждую часть стойки как единую систему», — заявила генеральный директор AMD Лиза Су (Lisa Su) на мероприятии, пишет CNBC. Дикманн заявил, что Helios предложит на 50 % больше пропускной способности памяти и на 50 % больше горизонтальной пропускной способности (по сравнению с NVIDIA Vera Rubin), поэтому «компромисс [за счёт увеличения ширины стойки] был признан приемлемым, поскольку крупные ЦОД, как правило, ограничены не квадратными метрами, а мегаваттами». Как указано в блоге компании, «Helios создана для обеспечения вычислительной плотности, пропускной способности памяти, производительности и горизонтального масштабирования, необходимых для самых требовательных рабочих ИИ-нагрузок, в готовом к развёртыванию решении, которое ускоряет время выхода на рынок». Helios представляет собой сочетание технологий AMD следующего поколения, включая:

AMD отказалась сообщить стоимость анонсированных чипов, но, по словам Дикманна, ИИ-ускорители компании будут дешевле и в эксплуатации, и в приобретении в сравнении с чипами NVIDIA. «В целом, есть существенная разница в стоимости приобретения, которую мы затем накладываем на наше конкурентное преимущество в производительности, поэтому выходит значительная, исчисляемая двузначными процентами экономия», — сказал он. AMD ожидает, что общий рынок ИИ-чипов превысит к 2028 году $500 млрд. Компания не указала, на какую долю общего пирога она будет претендовать — по оценкам аналитиков, в настоящее время у NVIDIA более 90 % рынка. Обе компании взяли на себя обязательство выпускать новые ИИ-чипы ежегодно, а не раз в два года, что говорит о том, насколько жёстче стала конкуренция и насколько важны передовые ИИ-технологии для гиперскейлеров. AMD сообщила, что её чипы Instinct используются семью из десяти крупнейших игроков ИИ-рынка, включая OpenAI, Tesla, xAI и Cohere. По словам AMD, Oracle планирует предложить своим клиентам кластеры с более чем 131 тыс. ускорителей MI355X. Meta✴ сообщила, что уже использует AMD-кластеры для инференса Llama и что она планирует купить серверы с чипами AMD следующего поколения. В свою очередь, представитель Microsoft сказал, что компания использует чипы AMD для обслуживания ИИ-функций чат-бота Copilot.

04.06.2025 [01:00], Владимир Мироненко

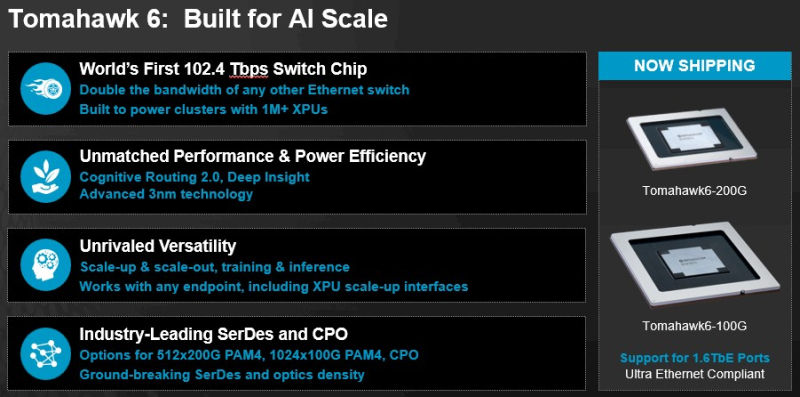

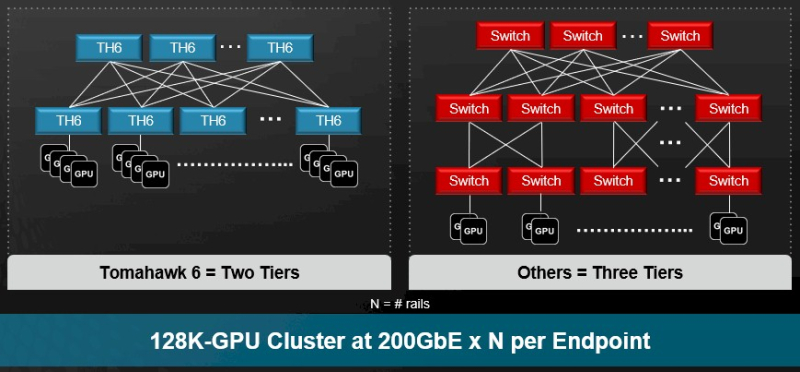

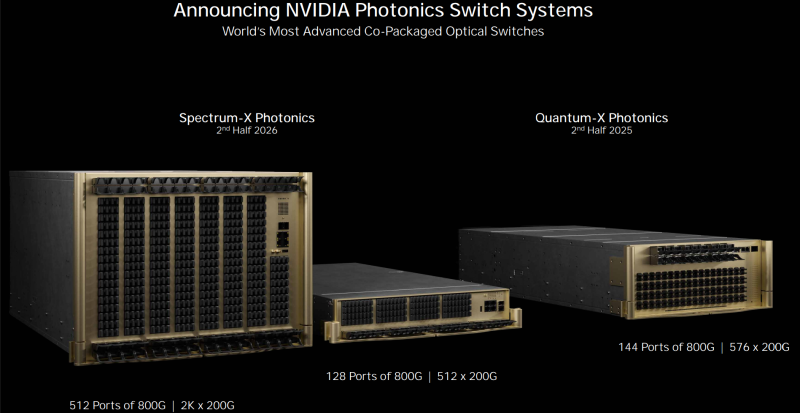

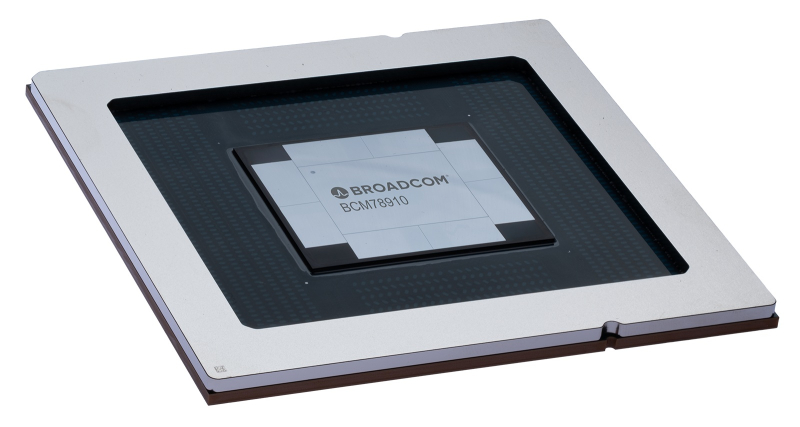

Broadcom представила самые быстрые в мире Ethernet-коммутаторы Tomahawk 6: 102,4 Тбит/с на чип и 1,6 Тбит/с на портКомпания Broadcom объявила о старте поставок серии чипов-коммутаторов Tomahawk 6 (BCM78910), первых Ethernet-коммутаторов, обеспечивающий коммутационную способность 102,4 Тбит/с, что вдвое выше возможностей Ethernet-коммутаторов, доступных на рынке. Сообщается, что благодаря невероятной возможности масштабирования, энергоэффективности и оптимизированным для ИИ функциям Tomahawk 6 нацелен на использование в крупных ИИ-кластерах. В случае вертикального масштабирования (scale-up) новинка позволяет объединить до 512 XPU в один кластер. В двухуровневых горизонтально масштабируемых (scale-out) сетях Tomahawk 6 может объединить более 100 тыс. XPU со скоростью 200GbE на каждое подключение. В целом же решение позволяет объединить до 1 млн XPU. Tomahawk 6 предлагает SerDes-блоки 100G/200G PAM с поддержкой «дальнобойных» пассивных медных подключений. Есть и вариант с интегрированными оптическими интерфейсами (CPO), который обеспечивает более высокую энергоэффективность, более низкий уровень задержки, а также повышенную стабильность работы.

Источник изображений: Broadcom Встроенная технология Cognitive Routing 2.0 автоматически выявляет перегрузки и перенаправляет потоки данных по альтернативным маршрутам, что помогает избежать узких мест в производительности. Cognitive Routing 2.0 в Tomahawk 6 включает расширенную телеметрию, динамический контроль перегрузки, быстрое обнаружение сбоев и обрезку пакетов, что обеспечивает глобальную балансировку нагрузки и адаптивное управление потоком. Эти возможности адаптированы для современных рабочих ИИ-нагрузок, включая MoE-модели, тонкую настройку, обучение с подкреплением и рассуждающие модели. «Tomahawk 6 — это не просто обновление, это прорыв, — заявил Рам Велага (Ram Velaga), старший вице-президент и генеральный менеджер подразделения Core Switching Group компании Broadcom. — Он знаменует собой поворотный момент в проектировании ИИ-инфраструктуры, объединяя самую высокую пропускную способность, энергоэффективность и адаптивные функции маршрутизации для scale-up и scale-out сетей в одной платформе». Tomahawk 6 поддерживает как стандартные топологии, например, сеть Клоза или тор, так и сети на базе фреймворка Broadcom Scale-Up Ethernet (SUE). Компания отметила, что благодаря использованию 200G SerDes коммутатор обеспечивает самую большую дальность для пассивного медного соединения, что позволяет проектировать высокоэффективную систему с малой задержкой, высочайшей надежностью и самой низкой совокупной стоимостью владения (TCO). Возможные конфигурации портов: 64 × 1.6TbE, 128 × 800GbE, 256 × 400GbE, 512 × 200GbE. Но Tomahawk 6 предлагает и конфигурацию 1024 × 100GbE, т.е. высокоплотный и экономичный интерконнект на основе Ethernet. А поддержка CPO не просто избавляет от множества трансиверов, но и существенно сокращает связанные с ними перебои, что крайне важно для гиперскейлеров. Использование Ethernet предоставляет операторам сетей значительные преимущества, позволяя им использовать единый технологический стек и согласованные инструменты во всей ИИ-инфраструктуре. Это также позволяет использовать взаимозаменяемые интерфейсы, с помощью которых облачные операторы могут динамически формировать кластеры XPU для различных рабочих нагрузок клиентов. Кроме того, Tomahawk 6 также соответствует требованиям Ultra Ethernet Consortium.

29.05.2025 [07:36], Владимир Мироненко

Российские компании по-прежнему закупают и используют сетевое оборудование ушедших вендоровЭксперты компаний «Инфосистемы Джет» и «ИКС» провели исследование с целью выяснения, насколько успешно идёт импортозамещение в сетевых инфраструктурах ЦОД крупных российских компаний и на каких решениях они строят свои сети ЦОД сегодня. В ходе исследования были проведены глубинные интервью ИТ-руководителей из 50 компаний. Более половины (62 %) из них представляли компании с ЦОД, использующими 10 и более стоек (у некоторых компаний — до 500 стоек). Ещё у 30 % респондентов ёмкость ЦОД составляет от 3 до 10 стоек. На уровне доступа для подключения серверов большая часть ЦОД респондентов применяет 10GbE и 25GbE. На уровне межкоммутаторного взаимодействия наибольшее распространение получили 40GbE и 100GbE. Более половины респондентов (60 %) для организации SAN применяет Fibre Channel. Зачастую респонденты используют оборудование нескольких вендоров — как российских, так и зарубежных:

Говоря о планах по развитию инфраструктуры, треть (34 %) респондентов сообщили о намерении и дальше закупать оборудование зарубежных вендоров, которое они используют, хотя те покинули российский рынок. При этом почти 40 % отметили проблемы, связанные с поддержкой и модернизацией используемого оборудования ушедших с рынка производителей. 16 % участников опроса сообщили о планах перейти на оборудование зарубежных вендоров, которые продолжают работать в России. Таким образом, несмотря на сложности, более половины респондентов планируют и дальше использовать в инфраструктуре ЦОД зарубежное оборудование. В числе основных недостатков сетевого оборудования отечественного производства респонденты назвали недостаточную функциональность (18 % респондентов), высокую стоимость (14 %), сильную зависимость от зарубежной элементной базы (12 %) и недостаточный уровень сервисной поддержки (12 %). Отдельно в исследовании уделили внимание тому, насколько повлияло на планы респондентов по развитию сетей в ЦОД возможное внедрение систем на базе ИИ. Подавляющее большинство респондентов (92 %) либо не изменили свои планы, либо не рассматривали этот вопрос. Лишь четыре из пятидесяти участников опроса ответили, что это отразилось на их планах. Исследователи отметили, что такие планы зависят от масштабов и специфики компаний. В «Инфосистемы Джет» сообщили, что отечественные разработчики стремятся довести функциональность своих продуктов до уровня решений ушедших вендоров, и по некоторым направлениям весьма успешно. Хотя надо иметь в виду, что зарубежные компании не стоят на месте и развивают программно-управляемые сети с ИИ. В свою очередь, в «ИКС» отметили, что исследование охватывает один из самых проблемных сегментов в части импортозамещения — коммутаторы для ЦОД, выпуск которых в России затруднён из-за использования в них высокопроизводительных специализированных микросхем. Тем не менее, решения российских производителей использует большое количество компаний. «Но передел рынка еще не завершён — несмотря на все логистические и сервисные риски, половина заказчиков собираются и дальше использовать зарубежное оборудование», — сообщил глава «ИКС».

20.05.2025 [23:49], Владимир Мироненко

Маршруты не совпали: Intel собралась продать телекоммуникационный и сетевой бизнесIntel рассматривает возможность продажи бизнеса по разработке телекоммуникационных и сетевых технологий, поскольку новый гендиректор Лип-Бу Тан (Lip-Bu Tan) продолжает избавляться от структур, которые, по его мнению, не являются критически важными для развития компании. Об этом сообщило агентство Reuters со ссылкой на свои источники. По словам информаторов агентства, Лип-Бу Тан объявил о намерении сосредоточиться на производстве чипов для ПК и ЦОД. «Это то, что мы собираемся расширять и развивать», — сказал в понедельник он топ-менеджменту на праздновании 40-летия Intel в Тайбэе, подчеркнув, что доля компании на рынке чипов для ПК составляет около 68 %, а на рынке ЦОД — 55 %. По итогам внутреннего обсуждения Intel было решено, что производство телеком-решений больше не будет вносить вклад в реализацию основной стратегии Intel. Также обсуждались перспективы сетевого бизнеса Intel, в том числе его продажа из-за жёсткого контроля Broadcom и др. игроков важнейших сегментов рынка, говорят источники. Также Intel пыталась понять, что более стратегически целесообразно — партнёрство с другой компанией или продажа доли в бизнесе. Предварительные переговоры со сторонним организациями, проявившими интерес к покупке, уже ведутся. Впрочем, пока они находятся на ранней стадии, процесс запуска торгов и оформления сделки не начинался. Но Intel всё же пообщалась с инвестиционными банками с целью выбора консультанта для процесса продажи. С нынешнего года отчётность подразделения Network and Edge Group (NEX) отражается в результатах структуры Datacenter and AI Group (DCAI). В прошлом году NEX принесло компании $5,8 млрд выручки, увеличив показатель год к году всего на 1 %. При этом данное направление последовательно сокращается. Ещё раньше, в 2023 году, под руководством гендиректора Пэта Гелсингера (Pat Gelsinger) Intel продала производство оптических трансиверов компании Jabil. Тогда же компания отказалась от развития Ethernet-коммутаторов, хотя за четыре года до этого поглотила Barefoot Networks. В 2019 году Intel неожиданно отказалась от развития интерконнекта Omni-Path, передав его Cornelis Networks. При Лип-Бу Тане Intel продала контрольный пакет акций (51 %) своего FPGA-подразделения Altera (PSG) частной инвестиционной компании SilverLake за $4,46 млрд, чтобы профинансировать усилия по выходу из кризисной ситуации. Впрочем, процесс отделения начался ещё при Гелсингере, который успел избавить Intel от Optane и NAND, собственных серверов, NUC, Pathfinder for RISC-V, IMS Nanofabricatio и ASIC для майнинга.

10.05.2025 [10:42], Сергей Карасёв

Nokia представила решение Aurelis Optical LAN для оптических локальных сетейФинская компания Nokia анонсировала решение Aurelis Optical LAN, предназначенное для построения локальных компьютерных сетей на основе оптоволокна (PON). Платформа призвана удовлетворить растущие потребности корпоративных пользователей в пропускной способности и эффективности каналов связи. По заявлениям Nokia, по сравнению с традиционными сетями Ethernet на основе медных соединений Aurelis Optical LAN предоставляет ряд существенных преимуществ. В частности, достигается снижение энергопотребления примерно на 40 %. Срок службы оптических локальных сетей превышает 50 лет. Кроме того, требуется на 70 % меньше кабелей. Всё это обеспечивает снижение совокупной стоимости владения (TCO) на 50 %. Поддерживаются стандарты 1, 10 и 25 Гбит/с с последующим масштабированием до 50 и 100 Гбит/с по мере роста нагрузок. Открытые API обеспечивают бесшовную интеграцию с существующими корпоративными средами, а расширенные функции автоматизации помогают упростить и оптимизировать обслуживание. Заявлена доступность на уровне 99,9999 %. Кроме того, говорится о высоком уровне безопасности.

Источник изображения: Nokia В семейство продуктов Aurelis входят различные оптические модемы (U-00240XP-A, U-490XP-P, U-080XP-P, U-880XP-P и др.), оптический коммутатор MF-2 Optical Switch, а также командный центр Aurelis Command Center. Коммутатор MF-2 Optical Switch выполнен в форм-факторе 2U с поддержкой АС/DC-питания. Посредством двух линейных карт с 400G-бэкплейном реализованы 16 портов 1/10/25 Гбит/с и 16 портов 1/2.5 Гбит/с с возможностью подключения до 64 оптических модемов на порт. Для аплинка, судя по всему, используются модули LMNT-A с четырьмя 10GbE-портами SFP+. В целом, новинка идентична Lightspan MF-2. По энергоэффективности платформа, как утверждается, в восемь раз превосходит сопоставимые по классу решения на основе медных кабелей. Предусмотрено резервирование питания, а доступность достигает 99,9999 %. Оптические модемы в зависимости от модификации предоставляют до 16 портов 2.5GbE и до восьми портов 10GbE. У большинства моделей имеется поддержка POE+/POE++. На сегодняшний день технология оптических локальных сетей Nokia Optical LAN используется на более чем 700 объектах по всему миру, включая отели, медицинские учреждения, университетские городки, аэропорты и др.

21.04.2025 [11:45], Сергей Карасёв

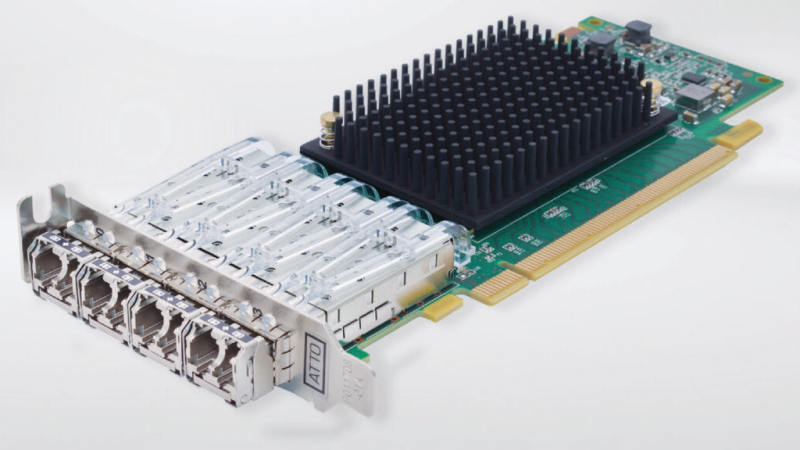

Atto представила сетевые адаптеры Celerity FC-644E с четырьмя портами FC64G и FastFrame N424 с четырьмя портами 25GbEКомпания Atto Technology анонсировала сетевые адаптеры Celerity FC-644E и FastFrame N424, рассчитанные на дата-центры. Изделия, выполненные в виде низкопрофильных карт расширения с интерфейсом PCIe 4.0 х16, ориентированы на поддержание ресурсоёмких нагрузок, таких как приложения ИИ и НРС. Celerity FC-644E относится к решениям Fibre Channel HBA седьмого поколения. Предусмотрены четыре порта 64Gb FC, что обеспечивает суммарную пропускную способность до 256 Гбит/с. Говорится о совместимости со спецификациями FC-PI-7, SFF-8431, PCI Express CEM Spec 3.0 и PCI Hot Plug spec 1.1. Изделие оборудовано системой пассивного охлаждения с радиатором. Диапазон рабочих температур — от 0 до +55 °C. Заявлена поддержка Windows, Windows Server, Linux, illumos, VMware, FreeBSD и macOS. В свою очередь, FastFrame N424 представляет собой карту SmartNIC четвёртого поколения. Она располагает четырьмя портами 25GbE SFP28. Реализована поддержка RoCE. Заявленная задержка находится на уровне 1 мкс. Фирменное программное обеспечение Atto 360 предоставляет инструменты для настройки, мониторинга и аналитики. Упомянута совместимость с Windows, Windows Server, macOS и Linux. Средства Atto Ethernet Suite для Windows и Linux упрощают установку. Сетевой адаптер может эксплуатироваться при температурах от 0 до +55 °C. На новинки предоставляется трёхлетняя гарантия. В комплект поставки входят монтажные планки стандартной и уменьшенной высоты. |

|