Лента новостей

|

16.09.2025 [16:37], Руслан Авдеев

Google сообщила об инвестициях £5 млрд в развитие ИИ в ВеликобританииAlphabet объявила об инвестициях £5 млрд ($6,8 млрд) в развитие искусственного интеллекта в Великобритании. Новость появилась как раз в то время, когда страна готовится к визиту президента США Дональда Трампа (Donald Trump), сообщает CNBC. Ожидается, что визит совпадёт с заключением череды деловых соглашений. Двухлетний план инвестиций Google, вероятно, окажет ощутимую поддержку правительству Великобритании, переживающему не лучшие времена. Американский IT-гигант объявил об открытии нового дата-центра в Уолтем-Кроссе (Waltham Cross), приблизительно в 19 км к северу от центра Лондона. В Google уверены, что объект поможет удовлетворить растущий спрос на сервисы компании с элементами ИИ. По-видимому, речь идёт о кампусе DC01 UK стоимостью £3,75 млрд ($4,9 млрд), который станет одним из крупнейших в Европе. Для кампуса уже зарезервировано 400 МВ·А, но присоединение намечено лишь на 2029 год. Как сообщают в Google, выделенная сумма позволит ежегодно создавать 8250 рабочих мест в компаниях Великобритании и будет способствовать росту экономики на £400 млрд к 2030 году. По словам местного министра финансов Рэйчел Ривз (Rachel Reeves), поступившее от Google заявление стало «мощным вотумом доверия британской экономике и прочности партнёрства с США». Инвестиции Google в Соединённом Королевстве включают финансирование своего лондонского ИИ-стартапа DeepMind. Google также заявила о сделке с британским нефтегазовым гигантом Shell для управления поставками возобновляемой энергии в Великобритании. В компании уверены, что этот альянс будет способствовать стабильности местной энергосистемы и энергетическому переходу страны. В Shell подчёркивают, что разноплановое портфолио компании в области возобновляемой энергии, доступ к аккумуляторным хранилищам и опыт торговли энергией и оптимизации её использования позволяет удовлетворять меняющиеся потребности ведущих компаний мира и поддерживать дальнейший рост рынка ЦОД. Помимо Google, о готовности инвестиций в британские ЦОД объявляют и другие игроки. Так, буквально на днях появилась информация, что в местные дата-центры вложат миллиарды долларов OpenAI и NVIDIA, а совсем недавно выяснилось, что на ЦОД в Великобритании готова потратить £500 млн инвестиционная компания BlackRock.

16.09.2025 [15:30], Сергей Карасёв

Eaton представила решение для обнаружения скачков энергопотребления в ИИ-системахАмериканская корпорация Eaton объявила о разработке, как утверждается, первого в отрасли решения для выявления значительных колебаний энергопотребления в рамках вычислительных инфраструктур, ориентированных на задачи ИИ. Как отмечается, стремительное внедрение ИИ приводит к быстрому росту нагрузки на дата-центры, а следовательно, к повышению их энергопотребления. Гиперскейлеры используют мощные серверы, оборудованные передовыми GPU и специализированными ASIC. При этом повышается вероятность непредвиденных всплесков энергопотребления из-за интенсивных вычислений, связанных с задачами ИИ. Такие скачки могут нанести серьёзный ущерб как инфраструктуре самого ЦОД, так и энергосети — в том случае, если она не рассчитана на столь значительные колебания нагрузки. Новое решение Eaton призвано решить проблему. Система реализована в виде дополнения для платформы анализа событий Eaton Power Xpert Quality (PXQ). Разработанный инструмент предназначен для обнаружения так называемых субсинхронных колебаний (SubSynchronous Oscillations, SSO) в энергосистемах дата-центров. Это колебания способны привести к перегреву трансформаторов, повреждению оборудования и другим негативным последствиям, устранение которых может потребовать значительных финансовых затрат. PXQ — это универсальная платформа для распределительных устройств, щитов и блоков распределения электроэнергии (PDU), которая использует сложную аналитику данных от периферийного оборудования для выявления и устранения проблем в электросетях. Интеграция инструмента обнаружения SSO осуществляется путём удалённого программного обновления. Eaton подчёркивает, что средства детектирования SSO позволят операторам принимать превентивные меры для минимизации негативных эффектов — до того, как скачки энергопотребления нанесут непоправимый ущерб дата-центрам и электросети.

16.09.2025 [13:21], Сергей Карасёв

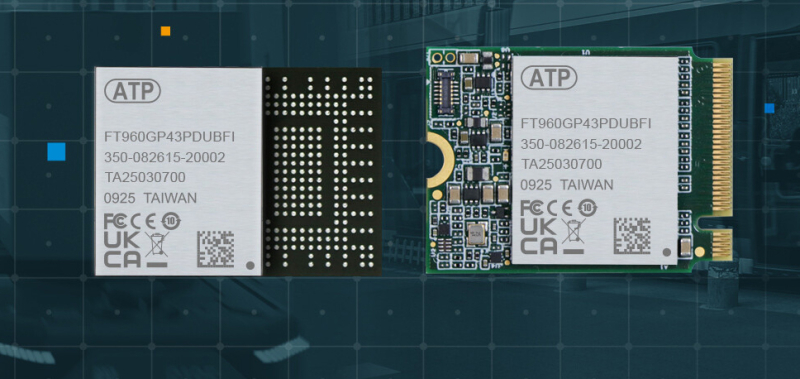

ATP выпустила индустриальные SSD серий N701/N601 вместимостью до 960 ГбайтКомпания ATP Electronics анонсировала SSD серий N701 и N601, предназначенные для использования в коммерческой и индустриальной сферах. Изделия будут предлагаться в двух вариантах исполнения — M.2 1620 Heat Sink Ball Grid Array (HSBGA) и М.2 2230. Устройства семейства N701 выполнены по технологии pSLC (pseudo Single Level Cell) с применением чипов флеш-памяти 3D TLC, а их вместимость варьируется от 80 до 320 Гбайт. В свою очередь, накопители N601 представляют собой традиционные решения 3D TLC с вариантами ёмкости от 240 до 960 Гбайт. Все новинки оснащены интерфейсом PCIe 4.0 x2. Скорость последовательного чтения информации достигает 3565 Мбайт/с, скорость последовательной записи — 3280 Мбайт/с. Показатель IOPS составляет до 630 000 при произвольном чтении и до 755 000 при произвольной записи. Говорится о поддержке шифрования AES-256 и TCG Opal 2.0. Величина MTBF (средняя наработка на отказ) — свыше 3 млн часов. SSD доступны в коммерческой (N701Pc и N601Sc) и индустриальной (N701Pi и N601Si) модификациях. В первом случае диапазон рабочих температур простирается от 0 до +70 °C, во втором — от -40 до +85 °C. Гарантированный объём записанной информации (показатель TBW) достигает 29 235 Тбайт у накопителей серии N701 и 2810 Тбайт у N601. В устройствах реализована фирменная технология Ace Thermal Throttling — интеллектуальный алгоритм теплового регулирования, который использует до 18 ступеней настройки с целью минимизации резких перепадов производительности при повышении температуры. Благодаря использованию двух линий PCIe 4.0 обеспечивается снижение энергопотребления до 20 % при обычной работе и до 40 % в режиме ожидания по сравнению с изделиями, в которых задействованы четыре линии. При этом производительность сохраняется на сопоставимом уровне.

16.09.2025 [13:19], Сергей Карасёв

Китайский регулятор обвинил NVIDIA в нарушении антимонопольного законодательства при покупке MellanoxГосударственное управление по регулированию рынка Китая (SAMR), по сообщению Datacenter Dynamics, обвинило NVIDIA в нарушении антимонопольного законодательства. Речь идёт о сделке по покупке израильского поставщика сетевого оборудования Mellanox. О намерении NVIDIA приобрести Mellanox стало известно в марте 2019 года, но осуществить слияние удалось только в апреле 2020-го, поскольку ожидалось одобрение со стороны регулирующих органов КНР. Стоимость сделки составила $6,9 млрд. Одним из условий соглашения с властями КНР было то, что NVIDIA продолжит поставлять на китайский рынок ускорители на базе GPU. Однако администрация США запрещает NVIDIA отгружать передовые продукты в Китай. Американское правительство выражает обеспокоенность тем, что китайские военные могут использовать мощные ускорители для разработки оружия. Впрочем, несмотря на экспортные ограничения, передовые продукты NVIDIA всё же поступают в Китай обходными путями. На фоне сложившейся ситуации в конце прошлого года Китай инициировал антимонопольное расследование против NVIDIA в рамках сделки по поглощению Mellanox. По заявлениям SAMR, NVIDIA нарушила антимонопольное законодательство, не выполнив в полном объёме положения, определённые регулятором при одобрении сделки. По мнению некоторых экспертов, антимонопольное расследование китайских властей в отношении NVIDIA может знаменовать собой начало реализации систематической «стратегии возмездии». Регулятор Китая может налагать штрафы в размере от 1 % до 10 % от годового объема продаж компании за предыдущий год в случае нарушения антимонопольных требований. На днях представители правительств США и Китая встретились в Мадриде с целью обсуждения торговых отношений. В частности, на повестке стоят вопросы экспортных ограничений. Однако обвинения со стороны SAMR в адрес NVIDIA могут осложнить ситуацию.

16.09.2025 [12:02], Сергей Карасёв

BlackRock вложит до £500 млн в развитие дата-центров в ВеликобританииАмериканская инвестиционная компания BlackRock, по сообщению Bloomberg, намерена вложить до £500 млн ($678 млн) в развитие инфраструктуры дата-центров в Великобритании. С этой целью в партнёрстве с Digital Gravity Partners сформировано новое совместное предприятие, получившее название Gravity Edge. По словам одного из руководителей отдела недвижимости BlackRock Томаса Мюллера-Борха (Thomas Mueller-Borja), Digital Gravity Partners будет покупать ЦОД с недоиспользованными мощностями. Речь идёт о существующих объектах, которые задействованы не в полной мере и обладают потенциалом развития. При этом партнёры не намерены заниматься созданием гиперскейл-площадок с ноля. Основной интерес для Gravity Edge представляют объекты мощностью 5–20 МВт. В частности, уже приобретена площадка для такого ЦОД на западе Лондона. На модернизацию этого дата-центра BlackRock выделит £100 млн (примерно $136 млн) из своего фонда Europe Property Fund VI с активами в размере £1,04 млрд ($1,41 млрд). Планируется повысить энергоэффективность объекта, обеспечив более высокую плотность размещения стоек. При этом будут высвобождены дополнительные мощности, которые станут доступны клиентам. Своей целью Gravity Edge ставит создание дата-центров для заказчиков, которым требуется высокопроизводительная критическая инфраструктура, разработанная для современных корпоративных сценариев использования и расположенная в непосредственной близости от крупных городов. В сентябре 2024 года BlackRock, Microsoft, инвестиционная компания Global Infrastructure Partners (GIP) и дубайский инвестор MGX создали группу Global AI Infrastructure Investment Partnership (GAIIP) для развития ИИ-инфраструктуры. На начальном этапе консорциум намерен инвестировать в ИИ-проекты более $30 млрд, а в долгосрочной перспективе — $100 млрд. Кроме того, BlackRock владеет европейским оператором дата-центров Mainova Webhouse. Нужно также отметить, что на днях стало известно о планах OpenAI и NVIDIA инвестировать «миллиарды долларов» в инфраструктуру дата-центров в Великобритании. Подробности этой инициативы пока не раскрываются.

16.09.2025 [11:53], Сергей Карасёв

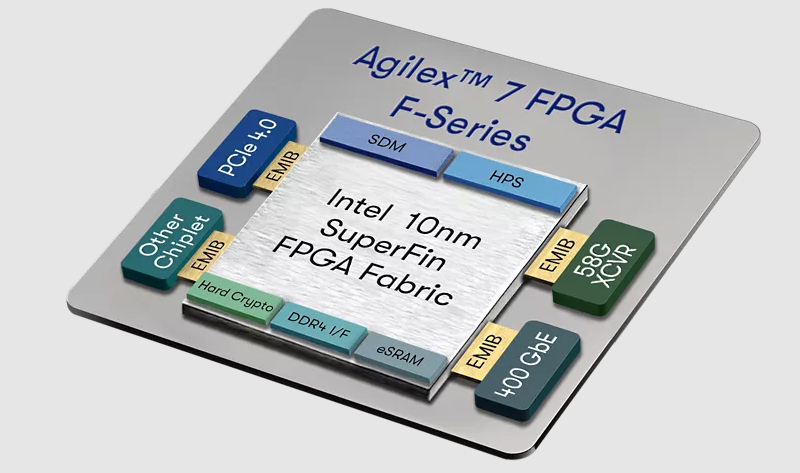

Silver Lake закрыла сделку по покупке контролирующей доли в бизнесе AlteraЧастная инвестиционная компания Silver Lake завершила сделку по приобретению контролирующей 51 % доли в структуре Altera — разработчика FPGA. Продавцом выступила корпорация Intel, которая сохранила за собой оставшиеся 49 %. Стоимость реализованного актива оценивается в $3,3 млрд. Intel купила Altera в 2015 году за $16,7 млрд, создав на её основе подразделение Programmable Solutions Group (PSG) по разработке FPGA и сопутствующего ПО. О договоре с Silver Lake по продаже контролирующей доли в бизнесе Altera было объявлено в апреле нынешнего года. Как отмечается, завершение сделки с Silver Lake превращает Altera в крупнейшего в мире независимого поставщика решений на базе FPGA. Ожидается, что благодаря операционной независимости и поддержке Silver Lake компания Altera сможет повысить гибкость деятельности, а также получит дополнительные ресурсы для ускорения разработки передовых FPGA-решений и предоставления расширенной поддержки клиентам и партнёрам по всему миру. Altera при участии Silver Lake рассчитывает укрепить позиции в ключевых секторах, включая промышленную автоматизацию, робототехнику, аэрокосмическую отрасль, оборонный сегмент, дата-центры, телекоммуникационное оборудование и периферийные ИИ-системы.

Источник изображения: Altera В 2024 финансовом году Altera получила $1,54 млрд выручки, тогда как в I половине 2025-го этот показатель составил $816 млн. В период с января по июнь включительно компания понесла операционные расходы в размере $356 млн. Продажа активов Altera происходит на фоне значительных структурных изменений в Intel и растущего финансового давления. Корпорация оказалась в сложном положении, уступив NVIDIA на рынке ИИ-ускорителей. В конце августа Intel объявила о достижении «исторического соглашения» с администрацией президента США Дональда Трампа (Donald Trump): американские власти приобретут 9,9 % долю в корпорации, а стоимость сделки составит $8,9 млрд. Это поможет Intel в расширении производства микросхем на территории США.

16.09.2025 [09:00], Владимир Мироненко

NVIDIA обязалась выкупить у CoreWeave все нераспроданные ИИ-мощности за $6,3 млрдCoreWeave подписала с NVIDIA новый контракт в рамках генерального соглашения от 10 апреля 2023 года, согласно которому чипмейкер обязуется выкупить все нераспроданные CoreWeave облачные вычислительные мощности. Контракт с начальной суммой в размере $6,3 млрд действует до 13 апреля 2032 года. Об этом стало известно из документа, направленного CoreWeave в Комиссию по ценным бумагам и биржам США (SEC). На прошлой неделе NVIDIA также заключила два соглашения с Lambda общей стоимостью $1,5 млрд об аренде собственных чипов (до 18 тыс. единиц) в течение следующих четырёх лет. На фоне этой новости акции CoreWeave выросли на 8 %, поскольку для инвесторов эта сделка означает укрепление позиций компании в качестве ключевого партнёра NVIDIA в сфере облачных вычислений и служит ей своего рода защитой в случае возможного снижения спроса на вычислительные мощности для ИИ-нагрузок, пишет Reuters. «Мы считаем это позитивным фактором для CoreWeave, учитывая опасения инвесторов относительно способности компании заполнить мощности центров обработки данных за пределами двух крупнейших клиентов (Microsoft и OpenAI)», — отметили аналитики Barclays. Точный объём вычислительных мощностей не разглашается. Ранее NVIDIA уже заключала с CoreWeave соглашения об аренде её вычислительных мощностей, став вторым по величине заказчиком неооблака. Ключевым же заказчиком (62 % выручки в 2024 году) была Microsoft, которая арендовала мощности в первую очередь для OpenAI. В свою очередь CoreWeave заключила в марте с OpenAI пятилетний контракт на сумму $11,9 млрд. Спустя пару месяцев ими было подписано дополнительное соглашение на аренду вычислительных мощностей на сумму в $4 млрд сроком до апреля 2029 года. Непростые отношения Microsoft и OpenAI потенциально могут негативно сказаться на бизнесе CoreWeave. Вместе с тем активное развитие инфраструктуры на фоне высокого спроса на ИИ-вычисления привело к рекордному росту капзатрат CoreWeave, составивших во II квартале $2,9 млрд. С целью финансовой поддержки и сопровождения проектов в сфере ИИ компания сформировала венчурное подразделение.

15.09.2025 [22:46], Андрей Крупин

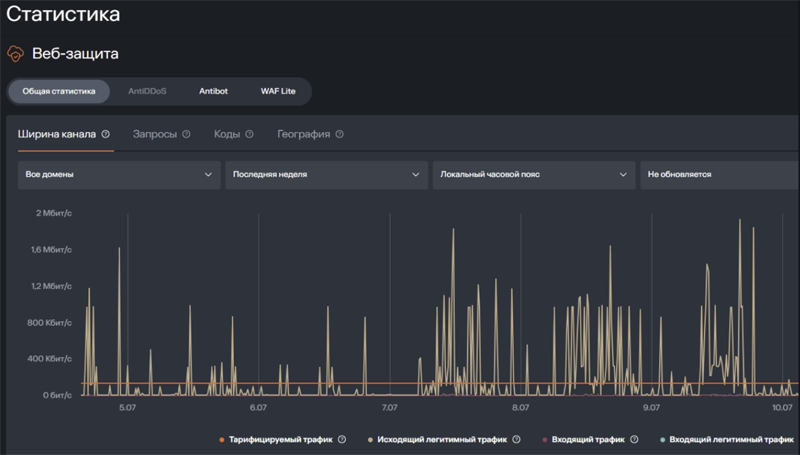

Компания «Солар» запустила бесплатную защиту от DDoS-атак для сайтов среднего и малого бизнесаКомпания «Солар» (дочернее предприятие «Ростелекома», работающее в сфере информационной безопасности) сообщила о расширении тарифной линейки системы облачной киберзащиты Solar Space и запуске бесплатной защиты от DDoS-атак для веб-площадок с посещаемостью до 5 тысяч пользователей в месяц. Бесплатный тариф предполагает доступ к входящему в состав Solar Space компоненту Web AntiDDoS, пропускная способность которого ограничена планкой в 1 Мбит/с. По словам разработчиков, этого достаточно для сайтов-визиток, блогов, онлайн-страниц для сбора заявок, небольших корпоративных ресурсов, начинающих интернет-магазинов и стартапов. Решение нейтрализует аномальные и вредоносные сетевые запросы, которые могут приводить к сбоям или недоступности веб-ресурса. Все действия системы защиты протоколируются и доступны для просмотра в личном кабинете облачного сервиса Solar Space. Там же формируются графики с отражёнными атаками.

Пользовательский интерфейс сервиса Web AntiDDoS (источник изображения: rt-solar.ru/space) Бесплатную защиту можно подключить самостоятельно в личном кабинете платформы — без привязки банковской карты. Воспользоваться услугой могут как физические и юридические лица, так и индивидуальные предприниматели, а также самозанятые. Для постановки ресурса под защиту необходимо выполнить верификацию домена (подтвердить права собственности) и произвести корректировку DNS-A-записи для перенаправления трафика с веб-сервера на центр фильтрации «Солара». Сам сервис Web AntiDDoS полностью автоматизирован и не предполагает никаких настроек. По данным экспертов «Солара», в 2024 году хакеры совершили 508 тысяч DDoS-атак на российские организации — это в два раза выше показателя годом ранее. Каждая подобная атака способна приостановить работу сайта, что может повлечь за собой переход клиентов к конкурентам и, как следствие, к недополученной прибыли. Ранее владельцы небольших веб-площадок для обеспечения бесплатной защиты от угроз использовали CDN-сервис американской компании Cloudflare, однако в ноябре 2024 года Роскомнадзор рекомендовал отечественному бизнесу отказаться от него для сохранения безопасности своих данных.

15.09.2025 [20:50], Владимир Мироненко

К структуре «Росатома» и «Т-Плюс» предъявили иски на 645 млн рублей за долги перед SAPСтруктура «Росатома», а также компания «Т-Плюс» столкнулась с исками, в которых было выдвинуто требование выплаты задолженности перед ООО САП СНГ, представлявшим интересы немецкой SAP в России. В обоих случаях иски были поданы отечественным ООО «Легат», перекупившим долги российского бизнеса перед SAP весной 2024 года, пишет «Коммерсантъ» со ссылкой на источники. В марте 2024-го SAP закрыла для российских клиентов доступ к облачным сервисам, завершив тем самым анонсированный двумя годами ранее уход их страны. В марте 2025-го истекло разрешение немецкого регулятора BAFA для на поставку в Россию ПО SAP отдельным организациям. По словам собеседников «Коммерсанта», «Легат» купила у ООО САП СНГ со «значительным дисконтом» права на долги в общей сумме свыше 2 млрд руб. Согласно картотеке арбитражных дел, в иске к «АО «Атомэнергопром» (структура «Росатома») указано требование о взыскании 571,2 млн руб. Как сообщают источники «Коммерсанта», речь идёт о задолженности «за первые два квартала 2022 года», поскольку в дальнейшем структура «Росатома» перешла на альтернативные решения. Иск был подан в мае, судебное заседание было назначено в середине августа, а следующее состоится в конце сентября. Иск к компании «Т-Плюс» на 74,3 млн руб. был подан в апреле текущего года. В обоих исках третьим лицом указано ООО САП СНГ. По мнению юристов, у «Легат» есть потенциально хорошие шансы выиграть эти дела, хотя многое зависит от того, насколько корректно была оформлена уступка права требования. Большой дисконт при переуступке прав на задолженность они объяснили незначительным по меркам SAP масштабом сделки, а также «отсутствием интереса у SAP в российской юрисдикции, включая вопрос возможности судиться в РФ». По словам экспертов, тенденция взыскания задолженностей за использование иностранного ПО становится все более распространённой, хотя это вряд ли найдёт широкое применение из-за сроков исковой давности, передаёт «Коммерсантъ». К концу 2023 года, по оценкам «Т1 интеграции» и «Ланита», на отечественные аналоги софта SAP перешло лишь 15–20 % российских компаний. В марте 2024-го, согласно данным IBS, около 28 % крупных российских компаний перешли на альтернативные импортонезависимые ERP-решения. Ещё треть предприятий приступила к процессу миграции, а треть сообщила о планах перейти на отечественные продукты в ближайшие два года. В мае прошлого года на конференции «Цифровая индустрия промышленной России» (ЦИПР) целым рядом крупных компании было объявлено о продолжении использования продуктов SAP из-за отсутствия полноценной отечественной альтернативы. В мае 2025 года сообщалось, что предложение правительства о разработке национальной ERP-системы не нашло поддержки у бизнеса, поскольку к этому времени на рынке уже появились зрелые отечественные решения.

15.09.2025 [14:48], Сергей Карасёв

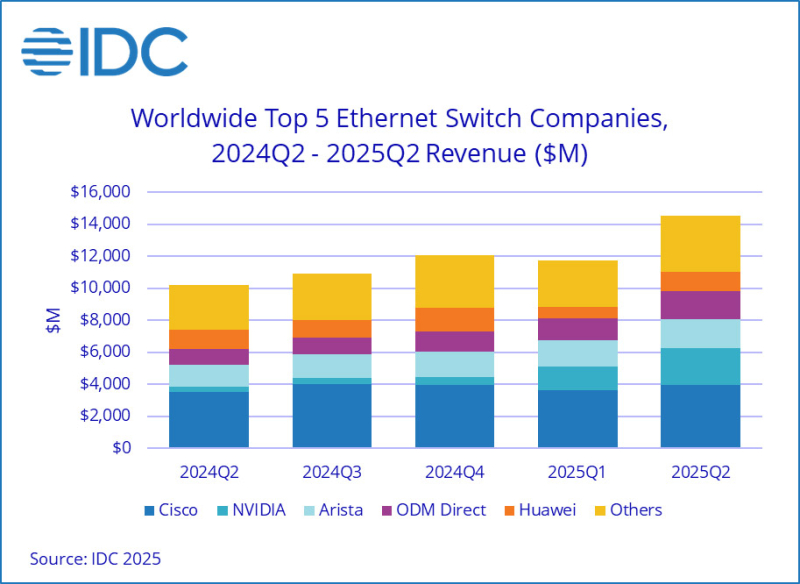

Продажи Ethernet-коммутаторов и маршрутизаторов корпоративного класса растут на фоне бума ИИКомпания International Data Corporation (IDC) обнародовала результаты исследования мирового рынка сетевого оборудования корпоративного класса во II квартале текущего года. Отрасль демонстрирует рост на фоне бума ИИ: гиперскейлеры и поставщики облачных услуг активно расширяют инфраструктуру для удовлетворения растущих потребностей в вычислительных мощностях. По оценкам, продажи Ethernet-коммутаторов в период с апреля по июнь включительно составили $14,5 млрд: это на 42,1 % больше по сравнению со II четвертью 2024 года. В сегменте решений для дата-центров выручка подскочила на 71,6 % в годовом исчислении. В данном секторе быстро укрепляет позиции компания NVIDIA, у которой продажи взлетели на 647 % — до $2,3 млрд, что обеспечило ей наибольшую рыночную долю — 25,9 %. IDC отмечает стремительный рост спроса на коммутаторы стандарта 800GbE, продажи которых поднялись на 222,1 % по сравнению с I четвертью 2025 года, а их доля в общем объёме ЦОД-рынка составила 12,8 %. Поставки коммутаторов стандартов 200/400GbE для дата-центров в годовом исчислении выросли на 175,5 %, тогда как их доля находится на уровне 49,5 %. В сегменте коммутаторов, не связанных с ЦОД, продажи за год поднялись на 12,5 %. Поставки изделий 1GbE, на которые приходится более половины выручки, выросли на 11,3 % в денежном выражении. Спрос на устройства 25/50GbE поднялся на 27,5 % год к году. С географической точки зрения в Северной и Южной Америке рынок Ethernet-коммутаторов корпоративного класса показал рост на 56,8 % в годовом исчислении. В Европе, на Ближнем Востоке и в Африке (EMEA) продажи увеличились на 33,8 %, а в Азиатско-Тихоокеанском регионе — на 24,0 %. В список ведущих мировых поставщиков коммутаторов Ethernet входят Cisco, Arista Networks, NVIDIA, Huawei и HPE Aruba Networking с долями соответственно 27,3 %, 12,6 %, 15,7 %, 8,3 % и 4,7 %. В секторе маршрутизаторов общая выручка во II квартале 2025 года достигла $3,6 млрд, что на 12,5 % больше по сравнению с аналогичным периодом предыдущего года. На поставщиков услуг пришлось 73,2 % от общего объёма данного сегмента с ростом на 13,8 % в годовом исчислении. Корпоративный сектор обеспечил 26,8 % продаж, показав прибавку в 9,1 %. В региональном разрезе объём рынка маршрутизаторов в Северной и Южной Америке вырос на 24,5 % в годовом исчислении, в Азиатско-Тихоокеанском регионе — на 11,4 %. Вместе с тем в регионе EMEA отмечено падение на 1,0 %. |

|