Лента новостей

|

15.09.2025 [13:43], Сергей Карасёв

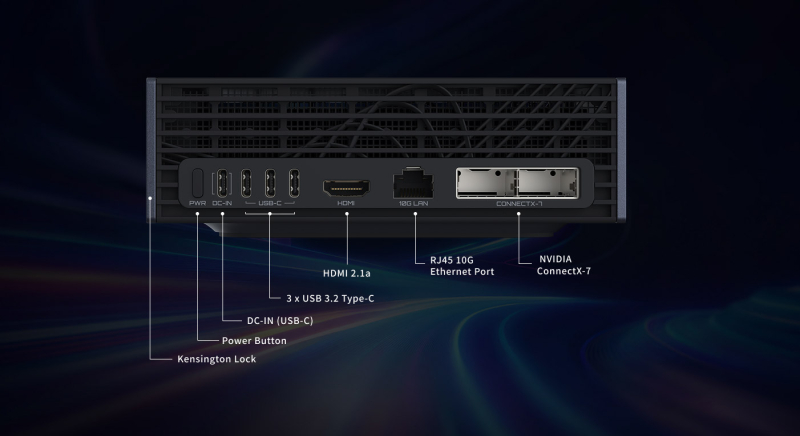

Gigabyte выпустила компактный ИИ ПК AI Top Atom на базе суперчипа NVIDIA GB10Компания Gigabyte анонсировала компактный ИИ-суперкомпьютер AI Top Atom — рабочую станцию небольшого форм-фактора, первая информация о подготовке которой появилась в мае нынешнего года на выставке Computex. Устройство может использоваться для локального запуска передовых ИИ-моделей. Новинка построена на суперчипе NVIDIA GB10 Grace Blackwell, который содержит 20-ядерный процессор Grace (10 × Arm Cortex-X925 и 10 × Arm Cortex-A725) и ускоритель Blackwell. Предусмотрено 128 Гбайт унифицированной системной памяти LPDDR5x с пропускной способностью 273 Гбайт/с. ИИ-производительность на операциях FP4 достигает 1000 TOPS. Рабочая станция оборудована контроллерами Wi-Fi 7 и Bluetooth 5.3, а также адаптерами 10GbE и NVIDIA ConnectX-7 SmartNIC. Установлен SSD с интерфейсом PCIe 5.0 (NVMe) вместимостью до 4 Тбайт. В набор разъёмов входят гнездо RJ45 для сетевого кабеля, порт USB 3.2 Gen 2x2 Type-C (PD), три порта USB 3.2 Gen 2x2 Type-C и коннектор HDMI 2.1a. Устройство заключено в корпус с размерами 150 × 150 × 50,5 мм, а масса составляет около 1,2 кг. В комплект поставки включён блок питания мощностью 240 Вт. Применяется программная платформа NVIDIA DGX OS — модификации Ubuntu, предназначенная специально для задач ИИ. Компактный ИИ-суперкомпьютер AI Top Atom допускает работу с ИИ-моделями, насчитывающими до 200 млрд параметров. Более того, посредством ConnectX-7 два таких устройства быть объединены в одну систему, что позволит запускать ИИ-модели с 405 млрд параметров. Новинка ориентирована на разработчиков ИИ, энтузиастов, исследователей и специалистов по анализу данных. Впрочем, у всех новинок на базе GB10 идентичные характеристики, а отличия между решениями разных вендоров в большей степени косметические.

15.09.2025 [12:27], Сергей Карасёв

Квартальные затраты на рынке физической инфраструктуры ЦОД приблизились к $9 млрд — продажи СЖО подскочили на 156 %По оценкам Dell'Oro Group, расходы на мировом рынке физической инфраструктуры дата-центров во II квартале текущего года достигли $8,9 млрд. Это на 18 % больше по сравнению с аналогичным периодом 2024-го, когда объём отрасли оценивался примерно в $7,5 млрд. Аналитики учитывают затраты на системы охлаждения, питания и пр. Отмечается, что основным драйвером рынка является стремительное внедрение ИИ, на фоне которого операторы ЦОД и гиперскейлеры активно наращивают вычислительные мощности. Третий квартал подряд рост расходов на инфраструктуру ЦОД в годовом исчислении превышает 10 %. В сегменте систем охлаждения зафиксирован рост на 29 % по отношению ко II четверти 2024 года. При этом продажи решений прямого жидкостного охлаждения (DLC) подскочили на 156 %. Как отмечает Dell'Oro Group, такие системы фактически становятся стандартом для крупных вычислительных кластеров ИИ. В сфере распределения энергии затраты поднялись в годовом исчислении на 26 %. Драйвером данного сектора является внедрение серверных стоек с высокой плотностью размещения оборудования для поддержания ресурсоёмких нагрузок ИИ. Выручка в секторе ИБП выросла на 13 %, достигнув $3,3 млрд. При этом наибольший спрос наблюдался в области трёхфазных решений мощностью 251 кВА и больше. В географическом плане во II квартале 2025 года лидировала Северная Америка с ростом около 23 %: затраты на строительство дата-центров в США достигли исторического максимума. В Европе, на Ближнем Востоке и в Африке (EMEA), а также в Азиатско-Тихоокеанском регионе темпы ниже, но в дальнейшем ожидается повышение рыночной активности. В мировом масштабе более 80 % роста во II квартале текущего года пришлось на гиперскейлеров и колокейшн-провайдеров, что указывает на их центральную роль в развитии ИИ ЦОД.

15.09.2025 [11:48], Сергей Карасёв

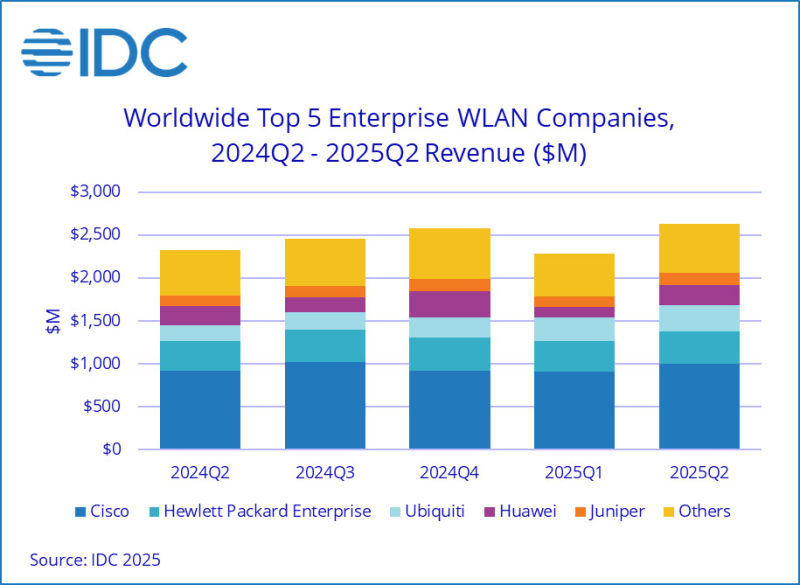

Квартальные продажи корпоративного WLAN-оборудования достигли $2,6 млрдКомпания International Data Corporation (IDC) подвела итоги исследования мирового рынка корпоративного оборудования для беспроводных локальных сетей (WLAN) во II квартале 2025 года. Продажи достигли $2,6 млрд, что на 13,2 % больше по сравнению с аналогичным периодом 2024-го, когда объем отрасли оценивался в $2,3 млрд. Драйвером рынка аналитики называют внедрение новых стандартов Wi-Fi 6E и Wi-Fi 7, которые предусматривают поддержку трёх частотных диапазонов: 2,4, 5 и 6 ГГц. На точки доступа Dependent Access Point стандарта Wi-Fi 7 во II четверти нынешнего года пришлось 21,2 % выручки против 11,8 % кварталом ранее. Ещё около 26,8 % продаж в денежном выражении обеспечили решения Wi-Fi 6E, тогда как оставшуюся часть дохода принесли устройства Wi-Fi 6. В географическом плане в Северной и Южной Америке рынок корпоративного WLAN-оборудования продемонстрировал рост на 17,0 % в годовом исчислении, благодаря увеличению отгрузок в США на 18,4 %. В Европе, на Ближнем Востоке и в Африке (EMEA) отмечена прибавка на уровне 14,7 %, тогда как в Азиатско-Тихоокеанском регионе поставки поднялись на 4,6 % в денежном выражении. В Китае при этом зафиксировано сокращение продаж на 6,6 %. Выручка Cisco увеличилась во II квартале 2025-го на 8,0 % в годовом исчислении, достигнув $996,1 млн: это обеспечило компании долю в 37,8 %. На втором месте в списке ведущих игроков находится HPE Aruba Networking с $376,3 млн и 14,3% рынка: у этой компании продажи год к году поднялись на 9,3 %. Замыкает тройку Ubiquiti с $312,4 млн и долей в 11,9 %: компания нарастила выручку на 66,8 %. Далее идёт Huawei, увеличившая продажи на 5,4 % — до $235,9 млн: компания контролирует 9,0 % рынка. На пятом месте в рейтинге располагается Juniper Networks, которая показала рост на 20,4 % в годовом исчислении — до $141,9 млн: доля компании составила 5,4 %. При этом нужно отметить, что в июле HPE закрыла сделку по покупке Juniper Networks за $14 млрд.

15.09.2025 [11:44], Сергей Карасёв

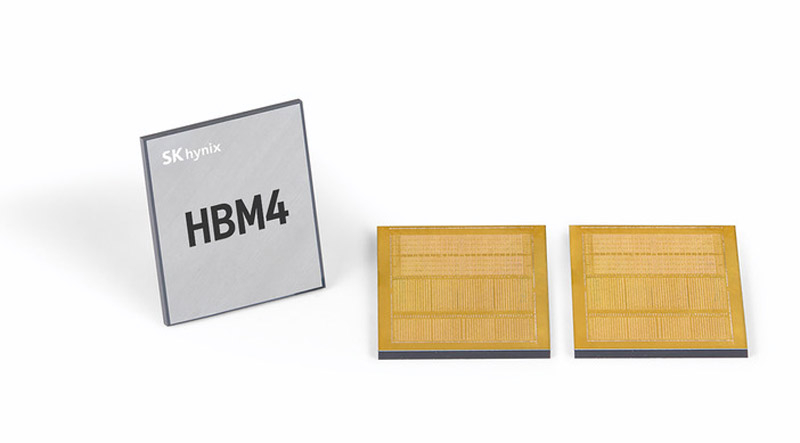

SK hynix завершила разработку памяти HBM4 для ИИ-системКомпания SK hynix объявила о том, что она первой среди участников отрасли завершила разработку памяти с высокой пропускной способностью HBM4 для ИИ-систем. В настоящее время готовится организация массового производства таких изделий. HBM4 — это шестое поколение памяти данного типа после оригинальных решений HBM, а также HBM2, HBM2E, HBM3 и HBM3E. Ожидается, что чипы HBM4 будут применяться в продуктах следующего поколения AMD, Broadcom, NVIDIA и др. Стеки памяти HBM4 от SK hynix оснащены 2048-бит IO-интерфейсом: таким образом, разрядность интерфейса HBM удвоилась впервые с 2015 года. Заявленная скорость передачи данных превышает 10 Гбит/с, что на 25 % превосходит значение в 8 Гбит/с, определённое официальным стандартом JEDEC. Пропускная способность HBM4 увеличилась вдвое по сравнению с предыдущим поколением НВМ, тогда как энергоэффективность повысилась на 40 %.

Источник изображения: SK hynix При изготовлении чипов HBM4 компания SK hynix будет применять 10-нм технологию пятого поколения (1bnm) и методику Advanced Mass Reflow Molded Underfill (MR-MUF). Последняя представляет собой способ объединения нескольких чипов памяти на одной подложке посредством спайки: сразу после этого пространство между слоями DRAM, базовым кристаллом и подложкой заполняется формовочным материалом для фиксации и защиты структуры. Технология Advanced MR-MUF позволяет выдерживать высоту HBM-стеков в пределах спецификации и улучшать теплоотвод энергоёмких модулей памяти. SK hynix не раскрывает ни количество слоёв DRAM в своих изделиях HBM4, ни их ёмкость. Как отмечает ресурс Tom's Hardware, по всей видимости, речь идёт об 12-Hi объёмом 36 Гбайт, которые будут использоваться в ускорителях NVIDIA Rubin. По заявлениям SK hynix, внедрение HBM4 позволит увеличить производительность ИИ-ускорителей на 69 % по сравнению с нынешними решениями. Это поможет устранить узкие места в обработке информации в ИИ ЦОД.

15.09.2025 [10:20], Владимир Мироненко

Oracle предоставит НАТО суверенное облако OCI

hardware

oracle

oracle cloud infrastructure

thales

конфиденциальность

миграция

нато

облако

цод

частное облако

Американская корпорация Oracle объявила о заключении контракта с Агентством связи и информации НАТО (NCIA), в рамках которого эта организация перенесет свои критически важные рабочие нагрузки в облачную инфраструктуру Oracle Cloud Infrastructure (OCI). Процесс интеграции OCI в существующую систему НАТО будет контролироваться двумя подразделениями итальянской ИТ-компании Reply — Red Reply и Shield Reply, которые специализируются на системной интеграции и облачных оборонных сервисах соответственно. Как сообщил Филиппо Риццанте (Filippo Rizzante), технический директор Reply, Red Reply и Shield Reply предоставят полный комплекс консалтинговых и управляемых услуг — от поиска и безопасного проектирования до миграции трёх устаревших ЦОД в OCI. Французская компания Thales, специализирующаяся на обороне и кибербезопасности, будет наряду с Red Reply и Shield Reply содействовать интеграции OCI в информационную систему НАТО, гарантируя сквозную безопасность данных и координируя связанную с этим миграцию рабочих нагрузок, а бельгийская телекоммуникационная компания Proximus обеспечит расширенные сетевые возможности. «OCI поможет NCIA управлять, анализировать и защищать данные, а также предоставит больше контроля и уверенности в том, где хранятся данные и выполняются рабочие нагрузки», — заявил Ричард Смит (Richard Smith), исполнительный вице-президент по технологиям и генеральный менеджер Oracle EMEA. Как сообщает Data Center Dynamics, НАТО располагает пятью кампусами и 30 пунктами прямой поддержки по всей Европе и Северной Америке. Основные пункты расположены в Брюсселе, Брен-л'Аллё и Монсе (Бельгия), Оэйраше (Португалия) и Гааге (Нидерланды), а пункты прямой поддержки включают подразделения поддержки CIS (CSU), логистические центры и наземные станции спутниковой связи, которые обеспечивают работу сетей НАТО, проведение операций по обслуживанию, учений и ИТ-инфраструктуры.

15.09.2025 [09:24], Владимир Мироненко

Считавшаяся неудачной сделка по покупке Sun в итоге сделала Oracle облачным гигантом

exadata

hardware

oracle

oracle cloud infrastructure

sun

гиперскейлер

ии

интерконнект

облако

сделка

цод

Когда в апреле 2009 года Oracle, считавшаяся на тот момент третьей в мире по величине софтверной компанией, объявила о покупке Sun Microsystems, все расценили сделку как неудачную. Покупка обошлась в $7,4 млрд ($5,6 млрд с учётом собственных средств и долгов Sun), а решение главы Oracle Ларри Эллисона (Larry Ellison) вызвало лишь один вопрос: зачем компании, занимающейся СУБД и корпоративным ПО, покупать пришедшего в упадок производителя серверов и ПО, принимая на себя бремя расходов по ведению аппаратного бизнеса? На то, чтобы ответ на него стал очевидным, ушло почти 15 лет, приводит SiliconANGLE слова аналитика Тони Баера (Tony Baer). Многие считали, что покупка Sun подорвёт финансовое положение Oracle. Основополагающий бизнес Sun по выпуску SPARC-серверов с ОС Solaris был ослаблен из-за Linux и x86 — мало кто хотел платить за наследника UNIX и дорогое «железо», так что на момент сделки Sun ежемесячно теряла $100 млн. В действительности же всё оказалось не так уж плохо. В следующем после закрытия сделки финансовом году общая выручка Oracle (по GAAP) выросла на 33 %, в основном за счёт ПО, в то время как выручка от аппаратного бизнеса снизилась всего лишь на 6 %. Вместе с тем количество развёрнутых ПАК Oracle Exadata (Oracle Database Machine) по всему миру превысило 1 тыс. Предположительно, выручка от Exadata была учтена в разделе ПО. Если ранее Exadata использовала оборудование HP, то после приобретения Sun компания больше не зависела от сторонних производителей и вскоре её слоганом для Exadata стало «инженерные системы».

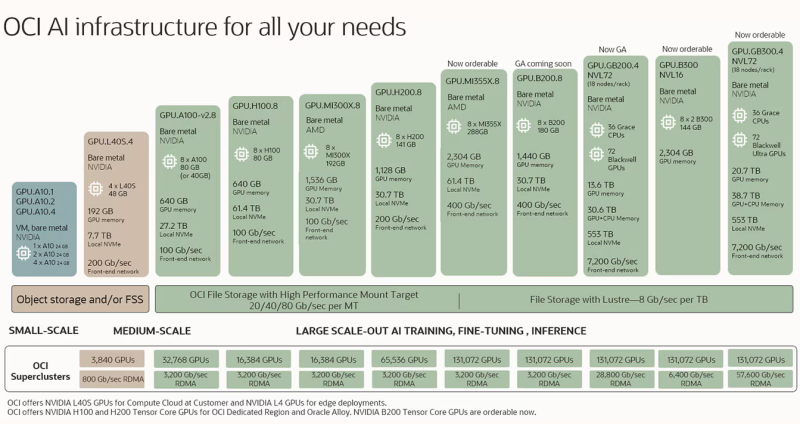

Источник изображений: Oracle Распространённое мнение сводилось к тому, что, купив Sun, Oracle выходит на серверный рынок. На самом деле, приобретение Sun привнесло в Oracle системный подход, который стал ключом не только к её растущему бизнесу по выпуску ПАК Exadata, но и к будущему облачному бизнесу, о котором компания даже не помышляла в 2009 году, отметил SiliconANGLE. Мало кто мог предсказать, что Oracle со временем станет крупным облачным провайдером. Даже сам Эллисон поначалу воспринимал эту идею скептически, назвав в 2008 году облачный бизнес «бессмыслицей». Тем не менее, в 2016 году компания запустила Oracle Cloud Infrastructure (OCI) и… всего через два года решила полностью поменять облачную архитектуру, поняв, что текущая ничем не отличается от AWS, Microsoft Azure или Google Cloud. В частности, для повышения безопасности была обеспечена полная изоляция кода и данных клиентов, а для повышения производительности и масштабируемости была упрощена топология и внедрена поддержка RDMA. Кроме того, Oracle не только опиралась на опыт Sun, но и агрессивно переманивала специалистов AWS и Azure. И хотя сейчас практически каждый гиперскейлер использует ускорители NVIDIA, только OCI может объединить их в суперкластеры из 131 тыс. чипов, а с недавних пор и ускорители AMD. Облачный сервис Oracle Exadata также выиграл: учитывая спрос клиентов и тот факт, что ни один гиперскейлер не может повторить оптимизацию RDMA-интерконнекта, которую сделала Oracle, инфраструктура Exadata теперь размещена как нативный сервис у всех трёх гиперскейлеров в их же ЦОД. За последний год выручка от баз данных MultiCloud выросла более чем в 15 раз. 10 сентября акции Oracle показали рекордный за 26 лет рост, и не столько из-за увеличения выручки, которая оказалась ниже ожиданий Уолл-стрит, сколько благодаря развитию её облачной инфраструктуры. Объём оставшихся обязательств по контрактам (RPO) компании вырос год к году на 359 % до $455 млрд. В тот же день было объявлено о сделке с Open AI на сумму в $300 млрд, вместе с которой Oracle участвует в проекте Stargate. И хотя RPO Oracle намного выше показателей её конкурентов среди гиперскейлеров, она значительно уступает им по размерам дохода, поскольку компании приходится направлять значительно большую часть средств на капитальные вложения. Существуют опасения, что ажиотаж вокруг ИИ может повторить ситуацию с пузырём доткомов. Oracle хеджирует свои риски, не покупая здания или недвижимость для облачных регионов OCI. Оборудование и инфраструктура закупаются только по факту поступления заказов, но большая ставка на одного клиента — Open AI — ставит под сомнение устойчивость её позиций, пишет SiliconANGLE. Кроме того, есть вероятность, что и заказы остальных клиентов будут реализованы в полном объёме. Тем не менее, 15 лет назад вряд ли кто бы подумал, что приобретение Sun Microsystems преобразит Oracle. Хотя в то время серверный бизнес Sun переживал упадок, у неё был системный опыт, который изменил ход событий. И в долгосрочной перспективе именно опыт Sun запустил перемены в основном бизнесе Oracle, превратив поставщика корпоративного ПО в успешного провайдера облачной инфраструктуры.

15.09.2025 [08:53], Сергей Карасёв

Biostar выпустила индустриальные компьютеры EdgeComp MS-NANX 8G/16G на базе NVIDIA Jetson Orin NXКомпания Biostar анонсировала компьютеры небольшого форм-фактора EdgeComp MS-NANX 8G/16G, предназначенные для выполнения ИИ-задач на периферии. Устройства подходят для таких приложений, как удалённый мониторинг оборудования, предиктивное обслуживание, визуальный контроль, промышленная автоматизация, системы умного города и пр. Основой компьютеров служит модуль NVIDIA Jetson Orin NX в вариантах с 8 и 16 Гбайт памяти LPDDR5. В первом случае задействованы шесть CPU-ядер Arm Cortex-A78AE, во втором — восемь. Кроме того, в состав обоих изделий входит графический блок на архитектуре NVIDIA Ampere с 1024 ядрами. ИИ-производительность на операциях INT8 (Sparse) достигает соответственно 70 и 100 TOPS. Устройства наделены слотом M.2 Key-E 2230 для адаптера Wi-Fi/Bluetooth, коннектором M.2 Key-B 3042/3052 для сотового модема 4G/5G (плюс разъём Nano SIM) и слотом M.2 Key-M 2242/2260/2280 для NVMe SSD. Присутствуют сетевые контроллеры 1GbE и 2.5GbE с опциональной поддержкой PoE. Имеются два гнезда RJ45 для сетевых кабелей, два последовательных порта (RS232/CAN и RS232/422/485), четыре порта USB 3.2 Type-A и комбинированное аудиогнездо на 3,5 мм. Компьютеры заключены в прочный корпус, ребристая верхняя часть которого выполняет функции радиатора для рассеяния тепла (применяется пассивное охлаждение). Габариты составляют 160 × 102 × 80 мм. Диапазон рабочих температур простирается от -20 до +50 °C. Питание 12–20 В подаётся через DC-разъём или 2-контактный терминальный разъём. Подчёркивается, что устройства спроектированы специально для интеграции в промышленные, коммерческие и государственные среды. Заявлена совместимость с Linux (NVIDIA Jetpack 6.2).

14.09.2025 [12:55], Сергей Карасёв

Bain Capital продала китайские ЦОД ChinData за $4 млрдАмериканская частная инвестиционная компания Bain Capital объявила о том, что её портфельная фирма WinTrix DC Group, специализирующаяся на дата-центрах, заключила соглашение о продаже 100 % доли в китайском подразделении ChinData. Сумма сделки составляет около $4 млрд. Крупнейшим клиентом компании является ByteDance, владеющая TikTok. Покупателем ЦОД-активов Bain Capital в КНР выступает консорциум во главе с китайской производственно-строительной компанией Shenzhen Dongyangguang Industry (является материнской структурой фирмы Guangdong HEC Technology Holding, которая считалась главным претендентом на приобретение бизнеса ChinData). Кроме того, в состав консорциума вошли институциональные инвесторы, включая страховые компании и китайские государственные фонды. По словам Bain Capital, заключенное соглашение является крупнейшей M&A-сделкой в истории китайской индустрии дата-центров. Это отражает интерес местных инвесторов к масштабируемой цифровой инфраструктуре нового поколения в Китае. ChinData управляет почти двумя десятками ЦОД в Китае, Малайзии и Таиланде, при этом оператором объектов за пределами КНР является дочернее предприятие Bridge Data Centers. ChinData была основана в 2015 году. Bain Capital приобрела её в 2019-м у Wangsu Science & Technology Co. и объединила с Bridge Data Centres, которая уже входила в портфель Bain. Объединённая структура вышла на биржу в 2020 году, но позднее Bain снова приватизировала ChinData в результате сделки по слиянию с дочерними предприятиями BCPE Chivalry Bidco Limited и BCPE Chivalry Merger Sub Limited. Поиском покупателя на активы ChinData компания Bain Capital занималась с марта 2024 года. Ожидается, что сделка поможет Guangdong HEC Technology Holding расширить бизнес в сфере дата-центров и укрепить положение на китайском рынке. Представители этой компании заявляют, что её опыт в области материалов для жидкостного охлаждения и технологий суперконденсаторов позволит удовлетворить потребности в высокоплотных вычислениях для ИИ.

13.09.2025 [14:01], Сергей Карасёв

Облачные Mac'и с Nitro: AWS запустила инстансы EC2 M4 Mac и M4 Pro MacОблачная платформа AWS анонсировала инстансы EC2 M4 Mac и EC2 M4 Pro Mac на основе компьютеров небольшого форм-фактора Apple Mac Mini с фирменными процессорами семейства M4. Новые экземпляры приходят на смену EC2 M2 Mac, которые были доступны с сентября 2023 года. Инстансы EC2 M4 Mac базируются на модификации Mac Mini с процессором M4. Этот чип объединяет 10 ядер CPU (четыре производительных и шесть энергоэффективных), 10 ядер GPU и 16-ядерный движок Neural Engine. Объём унифицированной памяти составляет 24 Гбайт, а её пропускная способность достигает 120 Гбайт/с. Утверждается, что на задачах сборки приложений экземпляры EC2 M4 Mac обеспечивают на 20 % более высокую производительность по сравнению с EC2 M2 Mac. В свою очередь, инстансы EC2 M4 Pro Mac используют мини-компьютеры Mac Mini с процессором M4 Pro, который содержит 12 ядер CPU (восемь производительных и четыре энергоэффективных), 16 ядер GPU и 16-ядерный движок Neural Engine. В оснащение входят 48 Гбайт унифицированной памяти с пропускной способностью до 273 Гбайт/с. По сравнению с EC2 M2 Pro Mac быстродействие на операциях сборки приложений увеличилось на 15 %.

Источник изображения: Apple Инстансы EC2 M4 Mac и EC2 M4 Pro Mac предполагают наличие локального хранилища вместимостью 2 Тбайт. Применяется система AWS Nitro, которая переносит функции виртуализации, хранения и сетевые операции на выделенное оборудование и ПО для повышения производительности и улучшения безопасности. Благодаря подключению посредством интерфейса Thunderbolt обеспечивается пропускная способность VPC (Virtual Private Cloud) до 10 Гбит/ с и пропускная способность EBS (Elastic Block Store) до 8 Гбит/с. Новые экземпляры совместимы с macOS Sonoma 15.6 и выше. Говорится о простоте интеграции с другими сервисами AWS. Инстансы EC2 M4 Mac и EC2 M4 Pro Mac уже доступны в регионах US East (Северная Вирджиния) и US West (Орегон), а в перспективе география охвата будет расширяться.

13.09.2025 [13:54], Сергей Карасёв

Затраты на строительство дата-центров в США бьют рекордыИсследование, проведённое специалистами Института Банка Америки (Bank of America Institute), говорит о том, что затраты на строительство дата-центров в США в июне нынешнего года достигли исторического максимума, составив около $40 млрд. Это на 30 % больше по сравнению с предыдущим годом, когда расходы находились на уровне $30,8 млрд. Причём в июне 2024-го отмечался рост на 50 % в годовом исчислении. Отмечается, что стремительное увеличение затрат в области ЦОД обусловлено бумом в сфере генеративного ИИ и машинного обучения. Для оптимизации больших языковых моделей (LLM) и инференса требуются огромные вычислительные ресурсы, что побуждает гиперскейлеров вкладывать десятки миллиардов долларов в соответствующую инфраструктуру. В частности, Microsoft намерена инвестировать в 2025 финансовом году до $80 млрд в создание ЦОД для задач ИИ в глобальном масштабе: более половины от этой суммы придётся на объекты в США. В свою очередь, Amazon в 2025-м вложит в расширение инфраструктуры рекордные $118 млрд. Google планирует потратить на наращивание мощностей дата-центров для поддержки ИИ около $85 млрд. Meta✴ готова выделить «сотни миллиардов долларов» на мультигигаваттные ИИ ЦОД, только в этом году уйдёт до $72 млрд. Основным сдерживающим фактором является нехватка электроэнергии. Согласно прогнозам Goldman Sachs, быстрое развитие ИИ приведёт к тому, что к 2030 году потребление энергии дата-центрами увеличится более чем вдвое. С другой стороны, говорится в исследовании BofA, повышение энергопотребления в сегменте ЦОД не отражает всю картину. Аналитики утверждают, что к 2030-му основная часть ожидаемого роста спроса на электроэнергию в США будет обусловлена такими факторами, как распространение электромобилей, отопление, перенос промышленных предприятий в новые зоны и электрификация зданий. |

|