Лента новостей

|

12.04.2024 [13:07], Сергей Карасёв

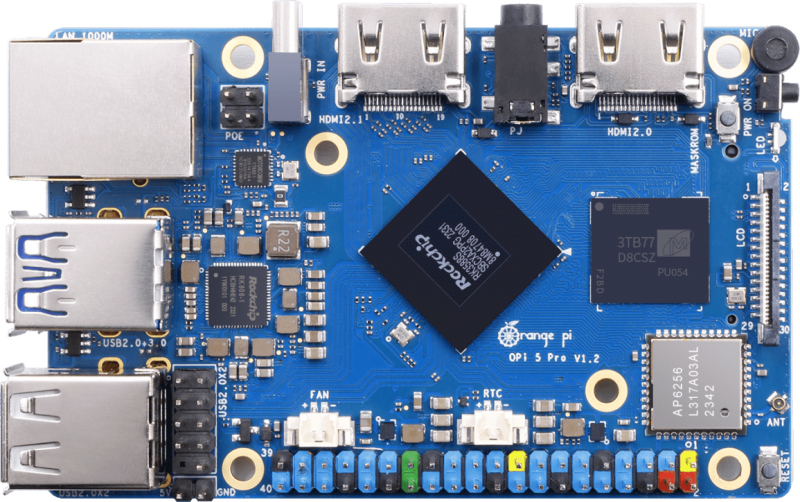

Вышел одноплатный компьютер Orange Pi 5 Pro с чипом Rockchip, 16 Гбайт ОЗУ и коннектором M.2 2280 NVMeСемейство одноплатных компьютеров Orange Pi, по сообщению ресурса CNX Software, пополнилось моделью Orange Pi 5 Pro, для которой заявлена поддержка Orange Pi OS (Droid), Orange Pi OS (Arch), Ubuntu, Debian и Android 12. Новинка подходит для создания edge-устройств, продуктов для умного дома и Интернета вещей, изделий со средствами ИИ и пр. В основу решения положен процессор Rockchip RK3588S с восемью ядрами (4 × Cortex-A76 @ 2,4 ГГц и 4 × Cortex-A55 @ 1,8 ГГц) и графическим ускорителем Arm Mali-G610 MP4 с поддержкой OpenGL ES1.1/2.0/3.2, OpenCL 2.2, Vulkan 1.2. Имеется нейропроцессорный блок (NPU) с производительностью 6 TOPS. Модуль VPU обеспечивает возможность декодирования материалов 8Kp60 H.265/AVS2/VP9/H.264/AV1 и кодирования 8Kp30 H.265/H.264. Плата имеет размеры 89 × 56 мм. Объём оперативной памяти LPDDR5 может составлять 4, 8 и 16 Гбайт. Допускается установка SSD формата M.2 2280 с интерфейсом PCIe 2.0 x1 (NVMe) или SATA, а также модуля eMMC (опционально). Есть слот для карты microSD. В оснащение входят адаптеры Wi-Fi 5 (2,4/5 ГГц) и Bluetooth 5.0, контроллер 1GbE с опциональной поддержкой PoE+. Набор разъёмов включает выходы HDMI 2.1 (вплоть до 8Kp60) и HDMI 2.0 (до 4Kp60), гнездо RJ-45 для сетевого кабеля, порт USB 3.0 и три порта USB 2.0, аудиогнездо на 3,5 мм (аудиокодек ES8388) и порт USB Type-C для подачи питания (5 В). Имеется 40-контактная колодка с поддержкой 28 × GPIO, 4 × UART, 8 × PWM, 4 × I2C, 1 × SPI, 1 × CAN и пр. Предусмотрены также коннекторы MIPI DSI (4 линии) и 2 × MIPI CSI (4 линии). Для заказа доступна старшая версия Orange Pi 5 Pro с 16 Гбайт ОЗУ: она оценена примерно в $110. Позднее выйдут модификации с 4 и 8 Гбайт памяти за $60 и $80.

12.04.2024 [13:00], Сергей Карасёв

Суд обязал AWS выплатить $525 млн за нарушение патентов в сфере облачного хранилищаСуд присяжных в США, по сообщению Datacenter Dynamics, признал облачную платформу Amazon Web Services (AWS) виновной в нарушении патентов чикагской компании Kove. За незаконное использование чужих технологий на AWS наложен штраф в размере $525 млн. Претензии Kove связаны с тем, что ответчик нарушил права на разработки, связанные с системами и методами управления хранилищем данных, а также с поиском и извлечением информации. По заявлениям Kove, AWS без разрешения применяет соответствующие технологии в сервисах S3 и DynamoDB. В 2023 году Kove направила аналогичный иск против Google — это дело в настоящее время находится на стадии рассмотрения.

Источник изображения: pixabay.com Kove подала иск против AWS в декабре 2018 года. В материалах дела упомянуты три американских патента Kove — №7,814,170, №7,103,640 и №7,233,978. Изобретателями значатся доктор Джон Овертон (John Overton) и доктор Стивен Бейли (Stephen Bailey), причём Овертон является генеральным директором Kove. В своей жалобе истцы заявляют, что технологии Kove имеют большое значение для AWS, поскольку объём данных, хранящихся в облаке Amazon, растёт в геометрической прогрессии, а её облачные сервисы столкнулись с ограничениями в плане обработки и извлечения огромных массивов информации. В 2020 году AWS выступила с опровержениями, отрицая нарушение рассматриваемых патентов и утверждая, что они якобы недействительны и, следовательно, не имеют исковой силы. Однако аргументы AWS не были учтены в суде, а на саму облачную платформу наложен штраф. Вместе с тем присяжные отклонили обвинения в том, что AWS нарушила патенты умышленно. Облачная платформа заявила, что не согласна с вердиктом, и сообщила о намерении подать апелляцию.

12.04.2024 [12:58], Сергей Карасёв

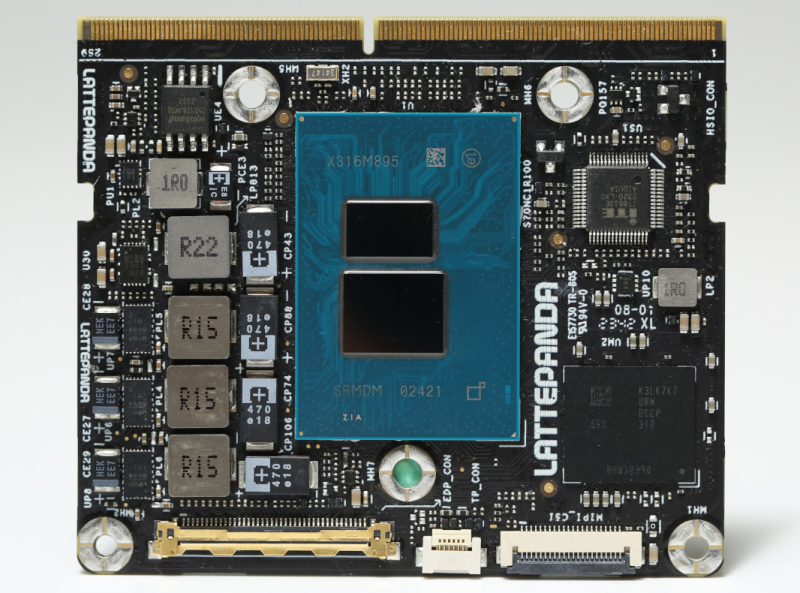

Модуль LattePanda Mu для IoT- и edge-устройств оснащён процессором Intel Alder Lake-NДебютировал вычислительный модуль (SoM) под названием LattePanda Mu на аппаратной платформе Intel Alder Lake-N. Изделие, как сообщает ресурс CNX Software, предназначено для создания IoT-устройств, edge-систем, робототехнических платформ и пр. Новинка использует нестандартный форм-фактор с размерами 69,6 × 60 мм, а для подключения служит 260-контактный разъём SO-DIMM. Задействован чип Intel Processor N100 с четырьмя ядрами (до 3,4 ГГц) и графическим ускорителем Intel HD Graphics (750 МГц). Объём оперативной памяти LPDDR5-4800 составляет 8 Гбайт. Модуль несёт на борту флеш-чип eMMC 5.1 вместимостью 64 Гбайт. Заявлена поддержка следующих интерфейсов: 2 × SATA-3, 1 × eDP 1.4, 3 × HDMI 2.0/DisplayPort 1.4, 4 × USB 3.2 Gen2 (10 Гбит/с), 8 × USB 2.0, 4 × UART, 4 × I2C, PCIe 3.0 (до 9 линий) и 64 × GPIO. Диапазон рабочих температур простирается от 0 до +60 °C. Напряжение питания — от 9 до 20 В. Команда LattePanda предоставляет для новинки драйверы Windows 10/11. При этом рекомендуется использовать дистрибутивы Linux с ядром 5.18 и выше. Для модуля LattePanda Mu разработаны интерфейсные платы Lite и Full с набором всевозможных разъёмов, включая порты USB, аудиогнёзда и коннекторы для подключения дисплеев (поддерживается вывод изображения одновременно на три монитора). Стоимость LattePanda Mu SoM составляет $139. Комплект с интерфейсной платой Lite и активным кулером обойдётся приблизительно в $190.

12.04.2024 [12:00], SN Team

OS DAY 2024: Архитектурные аспекты безопасности операционных системXI научно-практическая конференция OS DAY состоится 20–21 июня 2024 года. Она будет посвящена архитектурным и инженерным решениям в создании операционных систем, обеспечивающим безопасность программного обеспечения на различных уровнях. Помимо разработчиков российских операционных платформ в ней примут участие представители компаний-производителей аппаратных систем и компаний-заказчиков программно-аппаратных комплексов. Организатор конференции — консорциум научных институтов и компаний-вендоров ОС: ИСП РАН, «Лаборатория Касперского», НТП «Криптософт», «Открытая мобильная платформа», Группа Астра, «Базальт СПО», «РЕД СОФТ», РОСА и НИЦ «Институт имени Н.Е. Жуковского». «Различные аспекты безопасности российских операционных систем так или иначе уже обсуждали на нескольких конференциях в минувшие годы», — отметил директор ИСП РАН, председатель программного комитета OS DAY Арутюн Аветисян. — «В этом году мы решили сосредоточиться на важной теме, которую еще подробно не рассматривали в рамках OS DAY — обеспечении безопасности ОС на архитектурном уровне. Поговорим о том, какие бывают модели угроз и как их необходимо учитывать при разработке архитектуры, а также о том, какие инженерные подходы существуют для их отражения. Особенное внимание уделим вопросам аппаратной поддержки, ведь доверенной должна быть вся среда исполнения, начиная от процессора и загрузчика. Совместно разработчики загрузчиков и ОС смогут обеспечить новый уровень защиты». В последнее время эти вопросы получили критическую важность для обеспечения технологической независимости страны. Разработанные в России верифицированные средства аппаратной поддержки обеспечения безопасности помогут значительно поднять доверие к отечественным операционным системам. На два дня здание РЭУ им. Г.В. Плеханова, где состоится OS DAY 2024, станет коммуникационной площадкой для теоретиков и практиков системного программирования и разработки операционных систем, местом встречи российских разработчиков ОС, регуляторов, заказчиков, всех, кому небезразличны темы, связанные с созданием и безопасным функционированием российских операционных платформ. Оба дня будут наполнены общением, научными докладами и дискуссиями, где обсудят самые животрепещущие и актуальные вопросы российской ИТ-отрасли и направления системного программирования. «Чрезвычайно важно, что у всей этой активности есть практический результат», — подчеркнул Арутюн Аветисян. — «Вокруг конференции собралось сообщество единомышленников — представителей науки, бизнеса и образования, которые ведут совместные работы в Центре исследований безопасности системного ПО на базе ИСП РАН. Более 300 исправлений уже внесены в ядро Linux и критичные компоненты ОС». Программный комитет OS DAY до 10 мая принимает заявки на доклады по следующим темам:

Также программный комитет готов рассматривать заявки на доклады, которые не вписываются в указанную тематику, но укладываются в общее направление разработки операционных платформ и системного инструментария. Кроме того, в рамках OS DAY 2024 по традиции пройдет выставка технологий, где будут представлены решения, разработанные российскими производителями операционных систем. Конференция проводится при поддержке: РАН, ФСТЭК России, АРПП «Отечественный софт», НП «РУССОФТ». Время и место проведения конференции: 20–21 июня 2024 года, РЭУ им. Г.В. Плеханова. Адрес: Москва, ул. Большая Серпуховская, д. 11, корпус 9, этажи 7–8, «Точка-кипения РЭУ». Для участия просьба зарегистрироваться на сайте https://osday.ru. Зарегистрированным участникам, выбравшим формат онлайн, будет предоставлен доступ на адрес электронной почты, указанный при регистрации. По дополнительным вопросам просьба обращаться: Анна Новомлинская, исполнительный директор OS DAY, an@ispras.ru. Справка Научно-практическая конференция OS DAY проводится в России ежегодно с 2014 г. Это место консолидации российских разработчиков операционных платформ и поиска перспектив для совместной деятельности. Задачи конференции — определить перспективные направления и технологии в сфере разработки операционных систем, обозначить главные вызовы современной ИТ-отрасли и помочь разработчикам, производителям и заказчикам обменяться опытом. Организует конференцию консорциум OS DAY, в который входят: ИСП РАН, «Лаборатория Касперского», НТП «Криптософт», «Открытая мобильная платформа», Группа Астра, «Базальт СПО», «РЕД СОФТ», РОСА и НИЦ «Институт имени Н.Е. Жуковского». Целью создания сообщества организаторов было определить задачи и возможности России в области разработки операционных платформ, выделить перспективные технологии, обменяться опытом, обозначить вызовы ИТ-отрасли и направления движения.

11.04.2024 [22:27], Алексей Степин

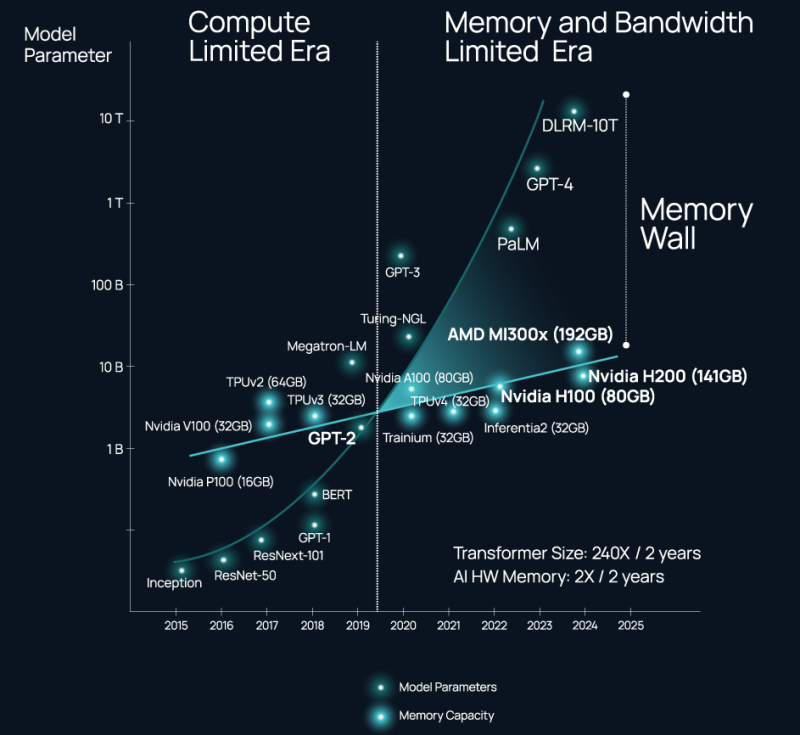

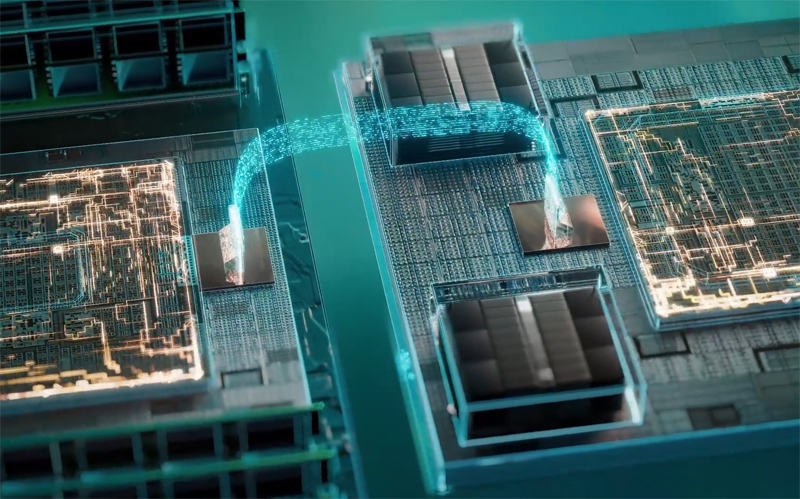

ИИ-ускорители NVIDIA являются самими дорогими в мире контроллерами памяти — Celestial AI предлагает связать оптикой HBM, DDR5 и процессорыВ 2024 году нельзя пожаловаться на отсутствие подходящего интерконнекта, если целью является «сшивка» в единую систему сотен, тысяч или даже десятков тысяч ускорителей. Есть NVIDIA NVLink и InfiniBand. Google использует оптические коммутаторы OCS, AMD вскоре выведет Infinity Fabric на межузловой уровень, да и старый добрый Ethernet отнюдь не собирается сдавать позиций и обретает новую жизнь в виде Ultra Ethernet. Проблема не в наличии и выборе подходящего интерконнекта, а в резкой потере пропускной способности за пределами упаковки чипа (т.н. Memory Wall). Да, память HBM быстра, но намертво привязана к вычислительным ресурсам, а в итоге, как отметил глава Celestial AI в комментарии изданию The Next Platform, индустрия ИИ использует ускорители NVIDIA в качестве самых дорогих в мире контроллеров памяти. Celestial AI ещё в прошлом году объявила, что ставит своей целью создание универсального «умного» интерконнекта на основе фотоники, который смог бы использоваться во всех нишах, требующих активного обмена большими потоками данных, от межкристалльной (chip-to-chip) до межузловой (node-to-node). Недавно она получила дополнительный пакет инвестиций объёмом $175 млн.

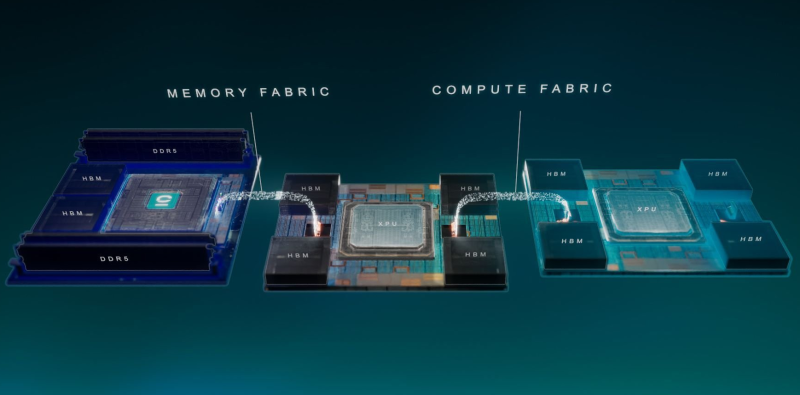

Источник изображений здесь и далее: Celestial AI Технология, названная Photonic Fabric, если верить заявлениям Celestial AI, способна в 25 раз увеличить пропускную способность и объёмы доступной памяти при на порядок меньшем энергопотреблении в сравнении с существующими системами соединений. Развивается она в трёх направлениях: чиплеты, интерпозеры и оптический аналог технологии Intel EMIB под названием OMIB. Наиболее простым способом интеграции своей технологии Celestial AI справедливо считает чиплеты. В настоящее время разработанный компанией модуль обеспечивает пропускную способность за пределами чипа на уровне 14,4 Тбит/с (1,8 Тбайт/с), а по размерам он немного уступает стандартной сборке HBM. Но это лишь первое поколение: во втором поколении Photonic Fabric 56-Гбит/с SerDes-блоки SerDes будут заменены на блоки класса 112 Гбит/с (PAM4). Поскольку речь идёт о системах с дезагрегацией ресурсов, проблему быстрого доступа к большому объёму памяти Celestial AI предлагает решить следующим образом: новый чиплет, содержащий помимо интерконнекта две сборки HBM общим объёмом 72 Гбайт, получит также поддержку четырёх DDR5 DIMM суммарным объёмом до 2 Тбайт. С использованием 5-нм техпроцесса такой чиплет сможет легко превратить HBM в быстрый сквозной кеш (write through) для DDR5. Фактически речь идёт об относительно простом и сравнительно доступном способе превратить любой процессор с чиплетной компоновкой в дезагрегированный аналог Intel Xeon Max или NVIDIA Grace Hopper. При этом латентность при удалённом обращении к памяти не превысит 120 нс, а энергозатраты в данном случае составят на порядок меньшую величину, нежели в случае с NVLink — всего 6,2 пДж/бит против 62,5 пДж/бит у NVIDIA. Таким образом, с использованием новых чиплетных контроллеров памяти становятся реальными системы, где все чипы, от CPU до сетевых процессоров и ускорителей, будут объединены единым фотонным интерконнектом и при этом будут иметь общий пул памяти DDR5 большого объёма с эффективным HBM-кешированием. По словам Celestial AI, она уже сотрудничает с некоторыми гиперскейлерами и с одним «крупным производителем процессоров». По словам руководителя Celestial AI, образцы чиплетов с поддержкой Photonic Fabric появятся во II половине 2025 года, а массовое внедрение начнется уже в 2027 году. Однако это может оказаться гонкой на выживание: Ayar Labs, другой разработчик фотоники, получившая поддержку со стороны Intel, уже показала прототип процессора с интегрированным фотонным интерконнектом. А Lightmatter ещё в декабре получила финансирование в объёме $155 млн на разработку фотонного интерпозера Passage и якобы уже сотрудничает с клиентами, заинтересованными в создании суперкомпьютера с 300 тыс. узлов. Нельзя сбрасывать со счетов и Eliyan, предлагающую вообще отказаться от технологии интерпозеров и заменить её на контроллеры физического уровня NuLink.

11.04.2024 [21:10], Сергей Карасёв

Тяжелейший путь, который того стоил: «Ростелеком» перевёл свои дата-центры на российское оборудование YADROКомпания «Ростелеком» в рамках комплексной программы импортозамещения полностью перевела свои ЦОД на отечественное оборудование. Об этом, как сообщает «Интерфакс», на форуме «Открытые инновации» объявил президент «Ростелекома». В качестве альтернативы серверам и СХД зарубежного производства выбраны решения российского производителя IT-оборудования YADRO («КНС групп»). Эта компания предлагает такие продукты, как серверы Vegman, СХД Tatlin.Unified, объектные хранилища корпоративного уровня Tatlin.Object и системы резервного копирования Tatlin.Backup. Кроме того, в ассортименте YADRO представлены 25GbE-коммутаторы Kornfeld. «Компания Yadro, с которой мы прошли тяжелейший, я бы сказал — кровавый — путь замещения серверов в наших ЦОД за последний год ценой ошибок, стрессов, круглосуточной работы. Но вот эта деятельность позволила нам на 100% отказаться от импортного оборудования, которое нам не продают, ну и по понятным причинам мы и сами не хотим покупать», — заявил Осеевский.

Источник изображения: YADRO Несмотря на то, что сам «Ростелеком» полностью отказался от зарубежного оборудования в ЦОД, говорится, что в данной сфере наблюдаются «очень серьёзные проблемы с импортозамещением». По его словам, регулирование деятельности дата-центров, это та область, которая «требует дополнительного внимания». Глава «Ростелекома» также предложил распределить по годам стоимость подключения дата-центров к электросетям, а не производить оплату сразу. Речь идёт о введении специальных тарифов для ЦОД.

11.04.2024 [17:59], Алексей Степин

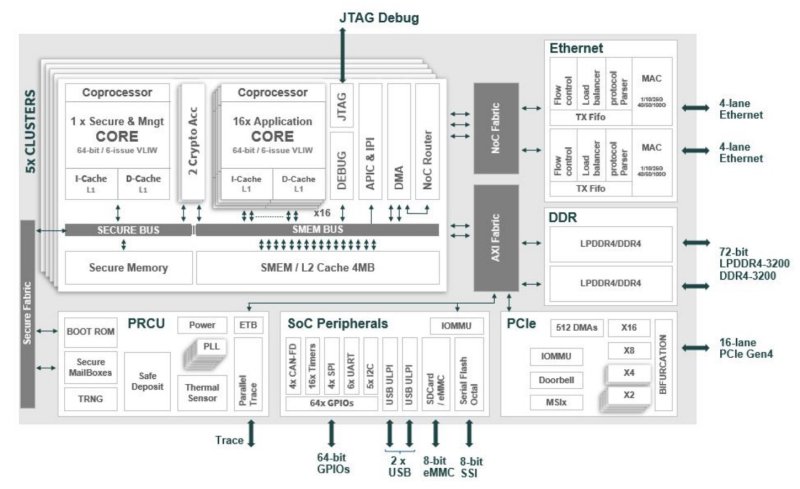

Сделано в Европе: Kalray представила ускоритель Turbocard4 для машинного зрения и обработки ИИ-данныхКомпания Kalray объявила о коммерческой доступности новых ускорителей Turbocard4 (TC4). Новинка позиционируется в качестве решения для ускорения работы систем машинного зрения, либо как акселератор «умной» индексации данных. На борту ускорителя, выполненного в формате FHFL установлено сразу четыре чипа DPU Coolidge 2 с фирменной архитектурой Kalray MPPA. Эти процессоры были анонсированы ещё летом прошлого года в качестве энергоэффективных DPU с производительностью до 1,5 Тфлопс в режиме FP32 и 50 Топс в характерном для инференса режиме INT8.

Источник изображений здесь и далее: Kalray Выбор рынков не случаен: машинное зрение сегодня является быстро растущей отраслью, в 2023 году оцененной в более чем $20 млрд, а к 2032 году эта цифра обещает вырасти до $175 млрд. Про индексацию данных для генеративного ИИ нечего и говорить — на дворе бум подобных технологий, а объёмы наборов данных постоянно растут. Такие датасеты требуют эффективной предобработки, иначе растущее время выборки нужных данных будет сдерживать производительность и обучения, и инференса. Интересно, что производятся TC4 в Европе, на французской фабрике Asteelflash, уже получившей первый заказ на сумму более $1 млн. В силу перспективности избранных направлений не следует удивляться, что европейская инициатива Kalray и Asteelflash поддержана французским правительством в рамках программы CARAIBE. Уже в 2025 году планируется довести темпы производства ускорителей TC4 с сотен до нескольких тысяч в месяц. Coolidge 2, по словам создателей, представляет собой универсальное решение на базе архитектуры VLIW. Он имеет 80 ядер с частотой до 1,2 ГГц, причём каждое ядро располагает FPU (IEEE 754-2008). Имеются оптимизации для матричных операций и трансцендентных функций. Процессор разделён на 5 кластеров по 16 ядер, каждый кластер имеет дополнительное управляющее ядро, отвечающее также за функции безопасности. Дополняет Coolidge 2 кеш объёмом 8 Мбайт, двухканальный контроллер памяти DDR4-3200 и пара интерфейсов 100GbE с поддержкой RoCE. Чип поддерживает форматы INT8, FP16, FP32 и даже FP64. Поскольку на борту Turbocard4 работает сразу четыре Coolidge 2, речь идёт о 6 Тфлопс для FP32, 100 Тфлопс для FP16 и 200 Топс для INT8 при теплопакете в районе 120 Вт. Что касается программной поддержки, Kalray сопровождает свои решения SDK, базирующимся на открытых стандартах. Поддерживаются Linux и RTOS.

11.04.2024 [17:57], Владимир Мироненко

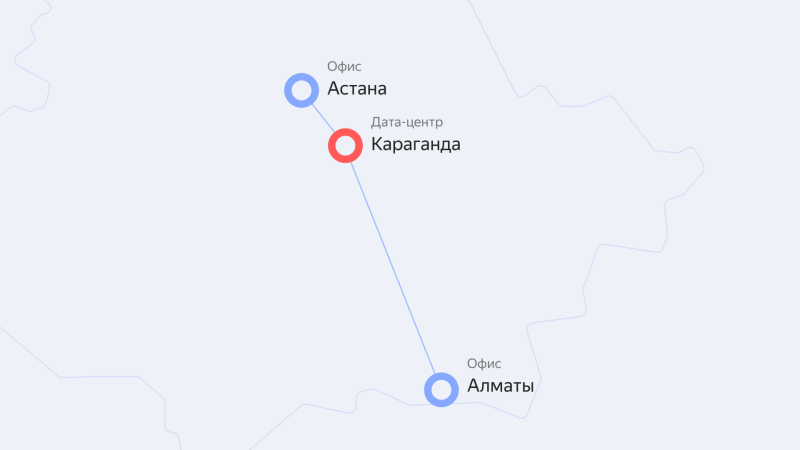

Yandex Cloud запустила облачные сервисы для пользователей в Казахстане и Центральной Азии на базе ЦОД в КарагандеОблачная платформа Yandex Cloud объявила о запуске нового региона kz1 на базе ЦОД в Казахстане, благодаря чему пользователям республики и Центральной Азии стал доступен широкий выбор облачных сервисов и технологий Yandex. Тарификация сервисов производится в тенге. А для развития IT-рынка в Казахстане компания выделила гранты 74 компаниям на сумму свыше 160 млн тенге в рамках программы Yandex Cloud Boost. Компании региона получили возможность использовать решения Yandex Cloud для хранения и обработки данных, технологии искусственного интеллекта (ИИ), машинного обучения, а также различные инструменты для разработки, тестирования и запуска собственных цифровых продуктов. ЦОД с серверной инфраструктурой находится в Караганде, а офисы компании — в Астане и Алматы. В казахстанском офисе работает команда технических специалистов и экспертов. С помощью сервиса распознавания и синтеза речи Yandex SpeechKit с поддержкой казахского и узбекского языков компании смогут создавать голосовых помощников и роботов для кол-центров. Также они смогут использовать решения для хранения, обработки и анализа данных, средства мониторинга и управления ресурсами облака, а также решения для обеспечения безопасности облачной инфраструктуры Yandex Cloud. Запуск нового региона выполнен в рамках долгосрочной стратегии развития Yandex Cloud в Казахстане и Центральной Азии. Как сообщает компания, её сервисы и решения уже используют в своей работе десятки казахстанских компаний крупного и среднего бизнеса, стартапы и организации государственного сектора, включая Kolesa Group, Technodom, Бухта, HR Messenger, TargetAI, 1Fit, Demetra и Rocket Firm.

11.04.2024 [15:23], Сергей Карасёв

Студенты США первыми в мире получили собственный ИИ-суперкомпьютер NVIDIAИнженерный колледж Технологического института Джорджии (Georgia Tech) объявил о заключении соглашения о сотрудничестве с NVIDIA с целью создания первого в мире суперкомпьютерного центра ИИ, предназначенного для обучения студентов. Проект получил название AI Makerspace. Отмечается, что AI Makerspace позволит демократизировать доступ к вычислительным ресурсам, которые традиционно были доступны только исследователям и технологическим компаниям. В рамках проекта студенты смогут использовать возможности НРС-комплекса для углубления своих навыков работы с ИИ. Это поможет в выполнении курсовых работ и позволит учащимся получить ценный практический опыт. Фактически AI Makerspace — это выделенный вычислительный кластер. В создании системы приняли участие специалисты Penguin Solutions. Применяется платформа для работы с ИИ-приложениями NVIDIA AI Enterprise. На начальном этапе в составе ИИ-суперкомпьютера задействованы 20 систем NVIDIA HGX H100, насчитывающие в общей сложности 160 ускорителей NVIDIA H100. В качестве интерконнекта применяется NVIDIA Quantum-2 InfiniBand. В рамках сотрудничества с Georgia Tech компания NVIDIA окажет поддержку студентам и преподавателям Инженерного колледжа по программе NVIDIA Deep Learning Institute (Институт глубокого обучения NVIDIA). Данная инициатива предусматривает все виды практикумов по ИИ, ускоренным вычислениям, графике, моделированию и другим современным технологиям. AI Makerspace расширяет базовую теоретическую учебную программу Georgia Tech по ИИ, предлагая студентам практическую платформу для решения реальных задач, разработки передовых приложений и реализации своих идей.

11.04.2024 [14:52], Сергей Карасёв

В России растёт спрос на мощные облачные серверы для ИИ-задачКомпания iKS-Consulting обнародовала результаты исследования российского рынка облачных инфраструктур. По оценкам, в 2023 году его объём достиг 121,4 млрд руб., что на 33,9 % больше по сравнению с предыдущим годом, когда затраты оценивались в 90,6 млрд руб. При этом, как отмечается, в России растёт спрос на услуги аренды мощных серверов, предназначенных для задач ИИ и машинного обучения. Аналитики iKS-Consulting учитывают затраты в сегментах IaaS и PaaS. Говорится, что рынок облачных услуг в РФ находится на этапе бурного роста. Однако пока ещё не сложилась устоявшаяся структура спроса и предложения, а также существуют определённые опасения со стороны потенциальных клиентов. Директор по развитию бизнеса iKS-Consulting Дмитрий Горкавенко сообщил газете «Ведомости», что доля аренды серверов для обучения моделей ИИ на российском рынке облачных услуг в 2023 году составила 5,4 %. Для сравнения: годом ранее этот показатель равнялся приблизительно 4,0 %.

Источник изображения: iKS-Consulting Общая выручка компаний от аренды таких серверов в 2023 году составила почти 6,6 млрд руб. против 3,7 млрд руб. в 2022-м. Ключевыми игроками данного направления являются Cloud.ru, «Яндекс», «Крок», «Мегaфон», Selectel и CloudМТS. По прогнозам iKS-Consulting, к 2030 году доля выручки от услуг по аренде ИИ-серверов вырастет до 8,6 %, или до 50,3 млрд руб., при общем объёме рынка в 585,1 млрд руб. В исследовании также отмечается, что по итогам 2023 года в общем объёме выручки на рынке облачных инфраструктур около 4,8 %, или 5,9 млрд руб., пришлось на услуги вычислений на суперкомпьютерах. Годом ранее показатель был в 2,5 раза ниже — примерно 2,4 млрд руб., или 2,6% от общей выручки. Основными игроками в данном сегменте стали Cloud.ru, «Яндекс» и CloudМТS. В исследовании iKS-Consulting сказано, что сегмент B2G на российском рынке облачных услуг становится всё более значимым. Это связано с развитием государственных сервисов на базе облаков и активным переводом федеральных и региональных органов власти на единую облачную платформу. |

|