Лента новостей

|

23.03.2025 [14:08], Сергей Карасёв

Итальянский суперкомпьютер Leonardo будет интегрирован с квантовым компьютером IQM Radiance на 54 кубитаИтальянский суперкомпьютерный центр Cineca объявил о заключении соглашения с компанией IQM Quantum Computers на поставку самого мощного в стране квантового вычислительного комплекса. Речь идёт о системе IQM Radiance в конфигурации с 54 кубитами. Cineca является одним из крупнейших вычислительных центров Италии. Некоммерческий консорциум состоит из 69 итальянских университетов и 21 национальной исследовательской организации. Своей задачей консорциум ставит поддержку итальянского научного сообщества путём предоставления суперкомпьютеров и инструментов визуализации. Монтаж IQM Radiance планируется осуществить в IV квартале нынешнего года. Это будет первый локальный квантовый компьютер на площадке Cineca в Болонье. Суперкомпьютерный центр намерен использовать новую систему для оптимизации квантовых приложений, квантовой криптографии, квантовой связи и квантовых алгоритмов ИИ. Комплекс IQM Radiance 54 будет интегрирован с вычислительной системой Leonardo, которая является одним из самых быстрых суперкомпьютеров в мире. В ноябрьском рейтинге TOP500 эта машина занимает девятое место с теоретической пиковой производительностью 306,31 Пфлопс. В основу суперкомпьютера положены платформы Atos BullSequana X2610 и X2135. Система построена в рамках сотрудничества EuroHPC, которое сейчас занято развёртыванием сети европейских квантовых компьютеров и ИИ-фабрик. Компания IQM Quantum Computers основана в Хельсинки (Финляндия) в 2018 году. Она поставляет полнофункциональные квантовые компьютеры и специализированные решения для HPC, научно-исследовательских институтов, университетов и предприятий. Ранее IQM заявляла, что к выпуску готовится версия Radiance со 150 кубитами, которую планировалось представить в I квартале 2025 года.

22.03.2025 [14:19], Сергей Карасёв

Seeed reComputer J3010B — мини-ПК для ИИ-задач на периферии на базе NVIDIA Jetson Orin NanoКомпания Seeed Studio, по сообщению CNX-Software, выпустила компьютер небольшого форм-фактора reComputer J3010B, предназначенный для поддержания ИИ-нагрузок на периферии. Устройство может эксплуатироваться в широком температурном диапазоне — от -10 до +60 °C. В основу новинки положена аппаратная платформа NVIDIA Jetson Orin Nano. Решение содержит процессор с шестью вычислительными ядрами Arm Cortex-A78AE с частотой до 1,5 ГГц и GPU на архитектуре NVIDIA Ampere с 16 тензорными ядрами. Доступны варианты с 512 и 1024 ядрами CUDA, оснащённые соответственно 4 и 8 Гбайт памяти LPDDR5. В первом случае заявленная ИИ-производительность достигает 34 TOPS, во втором — 67 TOPS. reComputer J3010B несёт на борту NVMe SSD вместимостью 128 Гбайт и сетевой контроллер 1GbE. Есть слот M.2 Key E для опционального модуля Wi-Fi/Bluetooth, разъём mini PCIe для модема 4G (1 × PCIe 3.0 x4/3 × PCIe 3.0 x1), 40-контактная колодка расширения, 12-контактная колодка UART, коннектор для подключения вентилятора охлаждения с ШИМ-управлением, два интерфейса камеры CSI (2 линии). В набор разъёмов входят два порта USB 3.2 Type-A и порт USB 2.0 Type-C, интерфейс HDMI 2.1, гнездо RJ45 для сетевого кабеля.

Источник изображения: Seeed Studio Размеры компьютера составляют 130 × 120 × 58,5 мм, масса — 451,9 г. Питание (9–19 В) подаётся через DC-разъём на 5,5/2,5 мм. Компания Seeed Studio заявляет, что новинка будет доступна как минимум до 2032 года. Устройство обеспечивается двухлетней гарантией. Цена reComputer J3010B составляет $505 за модель с 4 Гбайт оперативной памяти и $605 за модификацию с 8 Гбайт.

22.03.2025 [14:10], Сергей Карасёв

GL.iNet Comet — компактный IP-KVM с поддержкой Fingerbot для нажатия физических кнопокКомпания GL.iNet анонсировала компактное решение Comet GL-RM1 — устройство удалённого управления IP-KVM (Keyboard, Video, Mouse). Новинка может применяться для дистанционного включения/выключения и перезагрузки компьютеров, в том числе посредством нажатия на физические кнопки. В основу Comet положен процессор с четырьмя ядрами Arm Cortex-A7, функционирующими на частоте 1,5 ГГц. Объём оперативной памяти DDR3 составляет 1 Гбайт, встроенной флеш-памяти eMMC — 8 Гбайт. Предусмотрены сетевой порт 1GbE и интерфейс HDMI с поддержкой формата 2К (2160 × 1440@60). Заявлена возможность аппаратного кодирования материалов H.264 с задержкой 30–60 мс. Новинка располагает портом USB 2.0 Type-C для эмуляции мыши/клавиатуры, а также гнездом RJ45 для сетевого кабеля. Кроме того, имеется разъём USB 2.0 Type-A для подключения периферийных устройств, таких как Fingerbot: это специальный умный переключатель, который позволяет удалённо нажимать на физические кнопки, например, на кнопку включения питания на компьютерном корпусе. Дополнительно предлагается небольшая плата управления питанием ATX. Comet имеет размеры 80 × 60 × 17,5 мм и весит 85 г. В комплект поставки входят кабели Ethernet и USB. Питание (5 В / 2 А) подаётся через дополнительный порт USB Type-C. Заявленное энергопотребление составляет около 3 Вт. В качестве ОС применяется «лёгкая» сборка Linux с поддержкой таких функций, как удалённое управление KVM, виртуальная клавиатура, буфер обмена, настройка качества изображения, поворот экрана, передача файлов, доступ к BIOS и пр. Оформить предварительный заказ на GL.iNet Comet (GL-RM1) можно по цене $69 или $80,9 вместе с платой управления питанием ATX. В дальнейшем стоимость возрастёт до $89 и $104,9 соответственно.

21.03.2025 [23:08], Руслан Авдеев

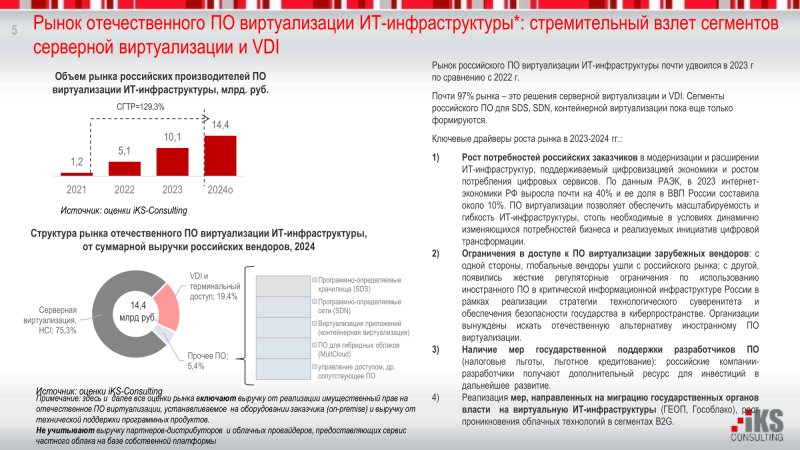

Отечественные решения серверной виртуализации захватили 60,2 % рынка РФ, но VMware не сдаётсяПродукты VMware по-прежнему востребованы на российском рынке виртуальных серверов. Хотя большая его часть это рынка уже занята российским ПО, на долю VMware всё ещё приходится 39 %, сообщают «Ведомости». В сравнении с 2021 годом число установок продуктов VMware упало на 28,4 п.п., гласит статистика 19 крупнейших облачных провайдеров России, собранная iKS-Consulting. Если раньше продукты VMware доминировали на российском рынке виртуализации, то в конце марта 2022 года лицензии компании были отозваны ФСТЭК. В то же время с января 2025 года российским организациям, имеющим объекты критической информационной инфраструктуры (КИИ), запрещено пользоваться VMware, Microsoft Hyper-V и другим зарубежным ПО. Таким образом, российские системы виртуализации активно развивались с 2022 года во многом благодаря уходу глобальных поставщиков ПО и ужесточению требований местных регуляторов, хотя, например, на коммерческие компании давление не так велико, поэтому их больше волнует отсутствие технической поддержки со стороны ушедших вендоров. В итоге доля российских решений на базе KVM с конца 2021 года по конец 2024 года выросла на треть, до 60,2 %. По предварительным оценкам iKS-Consulting, российский рынок виртуализации в 2024 году вырос до 14,4 млрд руб. 75,3 % рынка пришлось на решения для серверной виртуализации и HCI, 19,4 % — на VDI и системы терминального доступа, а ещё 5,4 % — на «прочее ПО». В целом среднегодовой прирост в ближайшие семь лет, по оценкам, составит 23 %, а в 2030 году объём рынка будет на уровне 50,4 млрд руб. По статистике 2023 года 30 % рынка (по выручке) приходилось на ПО компании «Базис», 16 % — на Orion Soft, по 10 % — на vStack и «Астра». Как заявили в «Базисе», в 2022–2023 гг. к компании обращались заказчики с требованием предоставить решения с функциональностью продуктов VMware. Компания смогла сразу удовлетворить более половины, а при вдумчивой оценке выяснялось, что большинство оставшихся требований заказчикам на самом деле не нужны. А даже те, что нужны, имеют разный приоритет. Аналогичная ситуация была и у vStack. По словам представителя «РТК-ЦОД», только массовое развёртывание и работа «в совершенно разных сценариях» с разными заказчиками и в разных отраслях позволит стать отечественному продукту зрелым. Время и реальные внедрения могут повысить доверие к продуктам — это очень важно, поскольку ПО VMware за четверть века стало эталоном в области виртуализации. По оценкам «ТМТ Консалтинг», массовый переход на российские системы виртуализации случится в 2025–2027 гг.

21.03.2025 [19:13], Руслан Авдеев

Стартап Nerdio, развивающий систему управления VDI в Microsoft Azure, привлёк $500 млн, а его капитализация выросла до $1 млрд

microsoft 365

microsoft azure

software

vdi

автоматизация

администрирование

облако

оркестрация

финансы

Стартап Nerdio Inc., обеспечивающий компаниям работу с виртуальными рабочими столами в облаке Microsoft Azure, привлёк $500 млн новых инвестиций в раунде серии C. Капитализация разработчика ПО достигла $1 млрд, что в четыре раза больше, чем два года назад, сообщает Silicon Angle. Продукты Nerdio используют 15 тыс. организаций, в 2022 году речь шла о 5 тыс. Среди клиентов — Comcast, PayPal и другие крупные компании. Платформа доступна в Azure Marketplace. В Nerdio утверждают, что это позволит избежать долгих процедур, сопровождающих корпоративные закупки ПО. Платформа может работать напрямую в облачных средах клиентов, что помогает повысить уровень безопасности. Платформа интегрирована в два VDI-сервиса Azure: AVD (Azure Virtual Desktop) и Windows 365. Nerdio обещает упростить процесс создания виртуальных рабочих столов. По данным компании, в некоторых случаях первоначальная настройка и развёртывание занимают недели. Платформа компании ускоряет процесс в отдельных случаях на 80 %. Платформа включает инструменты, которые упрощают выявление проблем с производительностью виртуальных рабочих столов, а также отключают аккаунты, демонстрирующие потенциально вредоносное поведение.

Источник изображения: Nerdio Встроенный инструмент автоматического масштабирования поможет снизить использование инфраструктуры. Эта функция позволяет автоматически назначить оборудование для выполнения задач в том объёме, в котором это действительно необходимо. В компании считают, что её ПО может снизить стоимость вычислений и хранения данных на 80 % при лучшем сценарии. Компания сохранила прибыльность и, как сообщает её пресс-служба, расширила присутствие в регионах EMEA и APAC. Теперь она намерена использовать полученные средства, чтобы нанять новых разработчиков для расширения функциональности платформы.

21.03.2025 [15:48], Руслан Авдеев

Оценка капитализации CoreWeave прямо перед IPO снизилась до $26 млрдОператор ИИ-облака CoreWeave Inc. завершил подачу заявки для IPO. Она намерена продать 49 млн акций по цене $47–$55 за каждую — всего на сумму почти $2,7 млрд. Допускается, что капитализация компании составит $26 млрд, сообщает Silicon Angle, хотя ранее говорилось о $35 млрд. Компания выбрала Morgan Stanley, Goldman Sachs и JPMorgan посредниками для выхода на биржу Nasdaq она выйдет под тикером CRWV. Сегодня CoreWeave располагает 250 тыс. ИИ-ускорителей NVIDIA в 32 дата-центрах по всему миру. Компания одной из первых предложила доступ к NVIDIA Blackwell, во многом благодаря поддержке самой NVIDIA. Представители оператора заявляют, что платформа обеспечивает лучшую производительность, чем ключевые публичные облака. Согласно документации для IPO, в облаке CoreWeave можно обучить модель Llama 3.1, использовав на 3,1 млн меньше часов работы ускорителей, чем в облаке неназванных конкурентов. Также компания обещает значительно ускорить смежные задачи вроде подготовки к обучению ИИ-моделей. Кроме того, CoreWeave разработала несколько кастомных программных инструментов для своей платформы. Функциональность инструментария и наличие огромных вычислительных мощностей помогли компании заключить контракты с ключевыми IT-бизнесами, включая OpenAI, Meta✴, IBM и Microsoft. Выручка компании в 2024 году взлетела на 737 % (годом ранее и вовсе на 1346 %), превысив $1,92 млрд. При этом около 77 % выручки 2024 году принесли Microsoft и NVIDIA. Продажи стремительно выросли после триумфального дебюта ChatGPT.

Источник изображения: CoreWeave CoreWeave активно тратит средства для сохранения лидирующих позиций, не считаясь с убытками — вплоть до покупки ускорителей в кредит под залог уже имеющихся ускорителей. В заявке CoreWeave указала, что намерена сохранить рост выручки, расширяя международное присутствие. Компания также намерена обеспечить специальные предложения для сегментов вроде банковского сектора, где ожидается рост спроса на ИИ. Также компания намерена улучшить финансовые показатели, изменив сами принципы строительства ЦОД. Пока большинство площадок компания просто арендует, но в заявке на IPO утверждается, что она «может инвестировать» в приобретение дата-центров в собственность. Представители оператора надеются, что это позволит получить больше контроля и снизить издержки на инфраструктуру. Это поможет компании эффективнее добиваться прибыльности бизнеса.

21.03.2025 [14:21], Сергей Карасёв

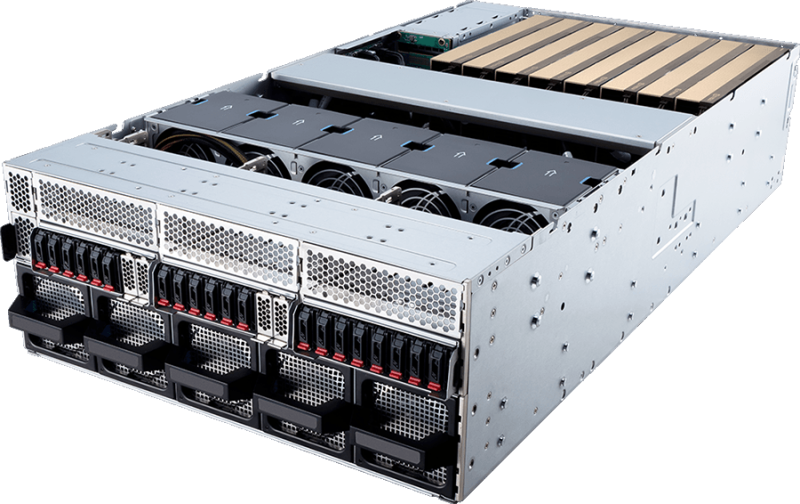

MSI представила серверы на архитектуре NVIDIA MGX с процессорами Intel Xeon 6Компания MSI анонсировала серверы CG480-S5063 и CG290-S3063 для задач ИИ и HPC, а также приложений с интенсивным использованием данных. В основу систем положены процессоры Intel Xeon 6500P и 6700P поколения Granite Rapids и модульная архитектура NVIDIA MGX. Модель CG480-S5063 выполнена в форм-факторе 4U. Возможна установка двух чипов Xeon 6 в исполнении LGA4710 с показателем TDP до 350 Вт. Доступны 32 слота для модулей DDR5-6400/8000 RDIMM/RDIMM-3DS/MRDIMM суммарным объемом до 8 Тбайт. Во фронтальной части расположены 20 отсеков для накопителей E1.S с интерфейсом PCIe 5.0 x4 (NVMe). Кроме того, есть два внутренних слота для SSD в формате М.2 2280/22110 PCIe 5.0 x2 (NVMe). В общей сложности реализованы 13 слотов PCIe 5.0 x16. Допускается применение до восьми ускорителей NVIDIA H200. Предусмотрены два сетевых порта 10GbE на базе Intel X710-AT2, выделенный сетевой порт управления 1GbE, контроллер ASPEED AST2600, порты USB 3.0/2.0 Type-A и Mini-DisplayPort. Питание обеспечивают четыре блока мощностью 3200 Вт с сертификатом 80 PLUS Titanium. Задействовано воздушное охлаждение. В свою очередь, сервер CG290-S3063 рассчитан на один процессор Xeon 6 с TDP до 350 Вт. Объем памяти DDR5-6400/8000 RDIMM/RDIMM-3DS/MRDIMM может достигать 4 Тбайт (16 слотов). Доступны восемь тыльных отсеков для SFF-накопителей, два коннектора для SSD М.2 2280/22110 с интерфейсом PCIe 5.0 x2 (NVMe), а также восемь слотов PCIe 5.0 x16. Поддерживается установка до четырёх ускорителей NVIDIA H200. В оснащение входят контроллер ASPEED AST2600, сетевой порт управления 1GbE, интерфейсы USB 3.0/2.0 Type-A и Mini-DisplayPort. Применены два блока питания мощностью 2400 Вт с сертификатом 80 PLUS Titanium и система воздушного охлаждения. Серверы могут эксплуатироваться при температурах от 0 до +35 °C.

21.03.2025 [14:17], Сергей Карасёв

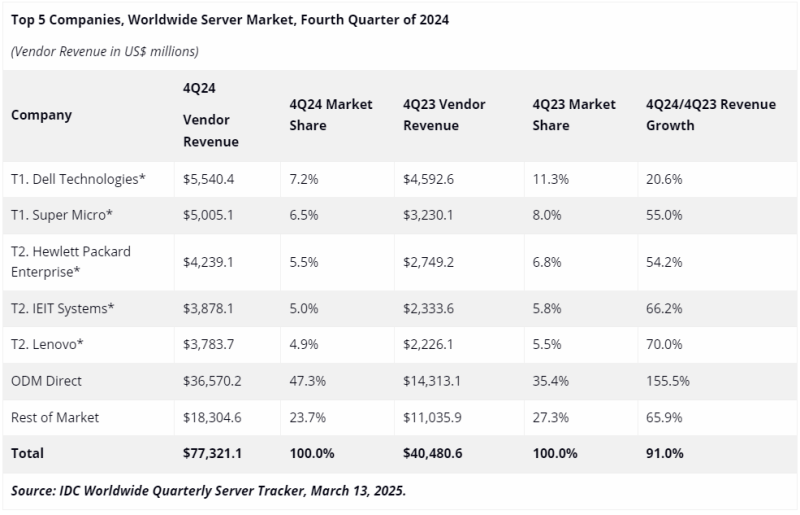

Во многом благодаря NVIDIA квартальные поставки серверов взлетели почти вдвое, достигнув рекордных $77,3 млрдКомпания International Data Corporation (IDC) подвела итоги исследования глобального серверного рынка в IV квартале 2024 года. Выручка достигла рекордных $77,3 млрд, что на 91 % больше по сравнению с последней четвертью 2023-го, когда продажи составляли $40,5 млрд. С октября по декабрь включительно серверы с архитектурой x86 принесли $54,8 млрд, что на 59,9 % больше по сравнению с аналогичным периодом 2023 года. Суммарная выручка от поставок систем с процессорами на всех других архитектурах за год взлетела на 262,1 %, достигнув $22,5 млрд. Это, в частности, указывает на быстрый рост популярности Arm-серверов. Высоким спросом продолжают пользоваться машины для ИИ-задач, оборудованные GPU-ускорителями: выручка от такого оборудования в IV квартале 2024 года поднялась на 192,6 % в годовом исчислении. В данном сегменте доминирует NVIDIA с долей более 90 % в общем объёме поставок в штучном выражении. Лидером глобального серверного рынка в последней четверти 2024-го стала Dell с продажами на уровне $5,5 млрд и долей в 7,2 % против 11,3 % годом ранее. На втором месте располагается Supermicro, у которой выручка составила $5,0 млрд, а доля снизилась в годовом исчислении с 8,0 % до 6,5 %. Замыкает тройку НРЕ с $4,2 млрд и 5,5 %: годом ранее эта компания контролировала 6,8 % отрасли. На четвёртом месте находится IEIT Systems с $3,9 млрд и 5,0 %, на пятом — Lenovo $3,8 млрд и 4,9 %. Прямые ODM-поставки обеспечили $36,6 млрд, или 47,3 % в общем объёме отрасли. На всех прочих игроков рынка пришлось $18,3 млрд, или около 23,7 %. В географическом плане Соединенные Штаты являются вторым по темпам роста регионом на рынке серверов сразу после Канады с приростом на 118,4 %, но США лидируют с долей 56 % от суммарных продаж серверов в IV квартале 2024 года, тогда как на Канаду приходится только 1,1 % продаж. В Китае выручка поднялась на 93,3 % — на КНР приходится почти четверть общемировых продаж. В Японии зафиксирован рост на 66,9 %, в Азиатско-Тихоокеанском регионе (за исключением Японии и Китая) — на 43,8 %, в регионе EMEA (Европа, Ближний Восток и Африка) — на 28,2 %, в Латинской Америке — на 7 %. В 2024 году в целом выручка на мировом рынке серверов достигла $235,7 млрд, что более чем в два раза превышает показатель 2020-го.

21.03.2025 [10:09], Владимир Мироненко

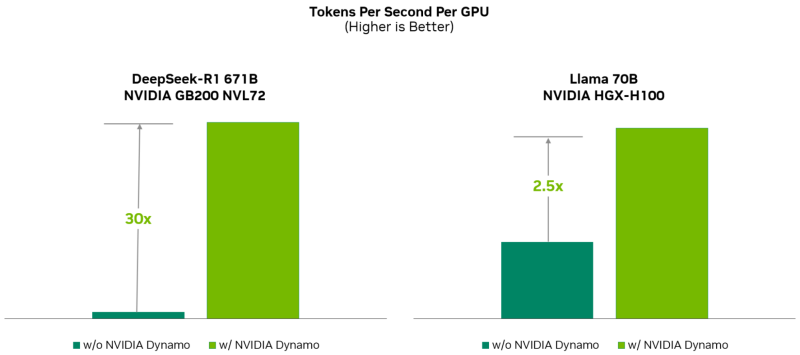

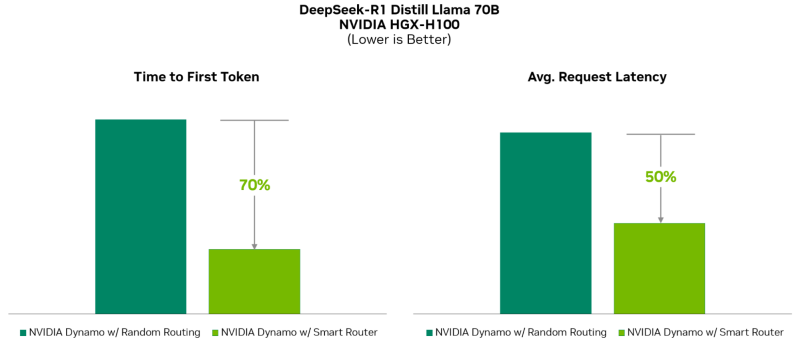

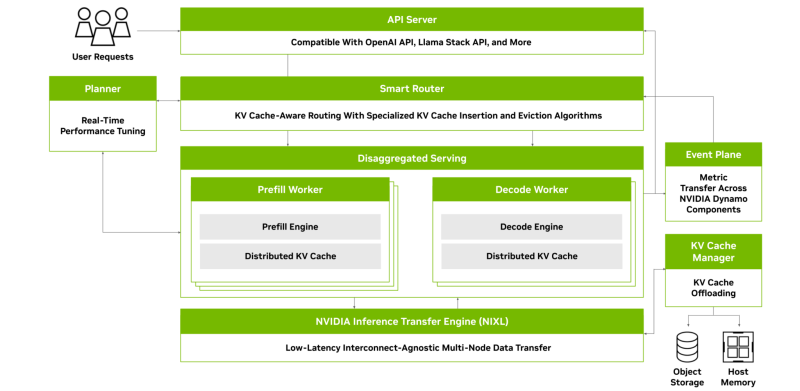

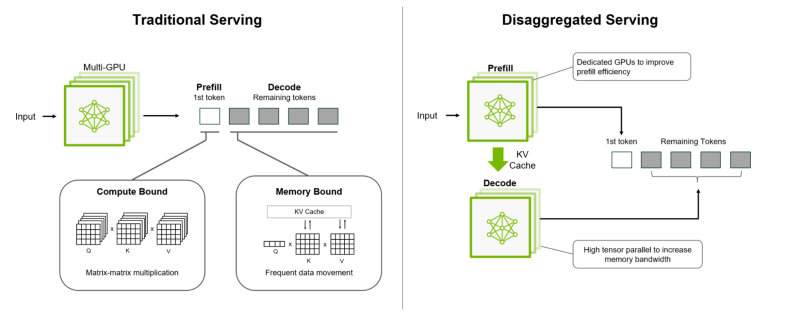

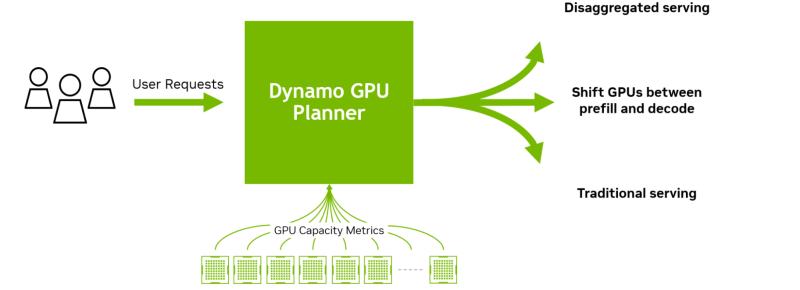

«ОС» для ИИ-фабрик: NVIDIA Dynamo ускорит инференс и упростит масштабирование рассуждающих ИИ-моделейNVIDIA представила NVIDIA Dynamo, преемника NVIDIA Triton Inference Server — программную среду с открытым исходным кодом для разработчиков, обеспечивающую ускорение инференса, а также упрощающую масштабирование рассуждающих ИИ-моделей в ИИ-фабриках с минимальными затратами и максимальной эффективностью. Глава NVIDIA Дженсен Хуанг (Jensen Huang) назвал Dynamo «операционной системой для ИИ-фабрик». NVIDIA Dynamo повышает производительность инференса, одновременно снижая затраты на масштабирование вычислений во время тестирования. Сообщается, что благодаря оптимизации инференса на NVIDIA Blackwell эта платформа многократно увеличивает производительность рассуждающей ИИ-модели DeepSeek-R1. Платформа NVIDIA Dynamo, разработанная для максимизации дохода от токенов для ИИ-фабрик (ИИ ЦОД), организует и ускоряет коммуникацию инференса на тысячах ускорителей, и использует дезагрегированную обработку данных для разделения фаз обработки и генерации больших языковых моделей (LLM) на разных ускорителях. Это позволяет оптимизировать каждую фазу независимо от её конкретных потребностей и обеспечивает максимальное использование вычислительных ресурсов. При том же количестве ускорителей Dynamo удваивает производительность (т.е. фактически доход ИИ-фабрик) моделей Llama на платформе NVIDIA Hopper. При запуске модели DeepSeek-R1 на большом кластере GB200 NVL72 благодаря интеллектуальной оптимизации инференса с помощью NVIDIA Dynamo количество генерируемых токенов на каждый ускоритель токенов увеличивается более чем в 30 раз, сообщила NVIDIA. NVIDIA Dynamo может динамически перераспределять нагрузку на ускорители в ответ на меняющиеся объёмы и типы запросов, а также закреплять задачи за конкретными ускорителями в больших кластерах, что помогает минимизировать вычисления для ответов и маршрутизировать запросы. Платформа также может выгружать данные инференса в более доступную память и устройства хранения данных и быстро извлекать их при необходимости. NVIDIA Dynamo имеет полностью открытый исходный код и поддерживает PyTorch, SGLang, NVIDIA TensorRT-LLM и vLLM, что позволяет клиентам разрабатывать и оптимизировать способы запуска ИИ-моделей в рамках дезагрегированного инференса. По словам NVIDIA, это позволит ускорить внедрение решения на различных платформах, включая AWS, Cohere, CoreWeave, Dell, Fireworks, Google Cloud, Lambda, Meta✴, Microsoft Azure, Nebius, NetApp, OCI, Perplexity, Together AI и VAST. NVIDIA Dynamo распределяет информацию, которую системы инференса хранят в памяти после обработки предыдущих запросов (KV-кеш), на множество ускорителей (до тысяч). Затем платформа направляет новые запросы на те ускорители, содержимое KV-кеша которых наиболее близко к новому запросу, тем самым избегая дорогостоящих повторных вычислений. NVIDIA Dynamo также обеспечивает дезагрегацию обработки входящих запросов, которое отправляет различные этапы исполнения LLM — от «понимания» запроса до генерации — разным ускорителям. Этот подход идеально подходит для рассуждающих моделей. Дезагрегированное обслуживание позволяет настраивать и выделять ресурсы для каждой фазы независимо, обеспечивая более высокую пропускную способность и более быстрые ответы на запросы. NVIDIA Dynamo включает четыре ключевых механизма:

Платформа NVIDIA Dynamo будет доступна в микросервисах NVIDIA NIM и будет поддерживаться в будущем выпуске платформы NVIDIA AI Enterprise.

21.03.2025 [08:56], Руслан Авдеев

NVIDIA инвестировала в CoreWeave, дала ей дефицитные ИИ-ускорители, а потом сама же арендовала ихКлиентам NVIDIA необходимо постоянно вкладывать миллиарды долларов в построение ИИ-инфраструктуры. При этом финансовая поддержка может прийти из самых неожиданных мест. Иногда — от самой NVIDIA, сообщает The Information. NVIDIA и её крупнейшим клиентам постоянно приходится искать баланс. С одной стороны, они поддерживают друг друга в краткосрочной перспективе, с другой — на длинной дистанции с NVIDIA намерены конкурировать многие гиперскейлеры. Microsoft, Meta✴, Google и Amazon (AWS) активно используют ИИ-чипы NVIDIA, одновременно пытаясь избавиться от такой зависимости и работая над собственными решениями: Maia, MTIA, TPU, Trainium и Inferentia. Поэтому NVIDIA инвестирует в т.н. неооблака (neocloud), ориентированные на предоставление ИИ-мощностей. Такие компании до некоторой степени способны стать альтернативой гиперскейлерам и вряд ли смогут разработать продукты, конкурирующие с чипами NVIDIA. К таковым относится и CoreWeave, которой NVIDIA активно помогает развиваться. В рамках подготовки к IPO компания раскрыла, что около 77 % выручки 2024 году ей принесли всего два клиента. Крупнейшим из них была Microsoft (62 %), которая к тому же обогнала по объёму закупок ускорителей NVIDIA всех ближайших конкурентов. А вот вторым по величине клиентом CoreWeave оказалась… сама NVIDIA (15 %). В начале 2023 года, когда спрос на ИИ-ускорители со стороны гиперскейлеров был фантастическим, NVIDIA сделала любопытный ход — в рамках т. н. Project Osprey она согласилась потратить в течение четырёх лет $1,3 млрд на аренду собственных чипов у CoreWeave, одновременно инвестировав в неё $100 млн. CoreWeave получила сотни тысяч современных ИИ-ускорителей и контракт с NVIDIA до августа 2027 года. NVIDIA действительно активно использует арендованные ускорители, не отвлекаясь на развёртывание ИИ ЦОД. В случае успешного выхода CoreWeave на биржу с оценкой более $30 млрд. заблаговременные инвестиции NVIDIA в акционерный капитал компании всего за два года превратятся в более чем $1 млрд. Однако для потенциальных инвесторов такое сотрудничество — повод для беспокойства, поскольку контракты с Microsoft и NVIDIA истекают в 2027–2029 гг. Подобные сделки на рынке ИИ — довольно распространённое явление. «Циклические» финансовые соглашения показывают, как деньги в отрасли уходят из компаний и возвращаются к ним же. SoftBank, намеренная стать одним из крупнейших инвесторов OpenAI, согласилась платить компании $3 млрд за использование её ИИ-продуктов. Microsoft вложила в OpenAI более $13 млрд, в результате чего получает долю в растущих доходах компании. В то же время OpenAI ежегодно выплачивает Microsoft миллиарды долларов за облачные сервисы. Amazon и Google заключили аналогичные сделки с Anthropic. Тем временем CoreWeave подпитывает расширение бизнеса за счёт долговых обязательств на $8 млрд и $15 млрд договоров долгосрочной аренды ЦОД и офисов. В своё время CoreWeave даже взяла в долг $2,3 млрд под залог ускорителей NVIDIA, чтобы купить ещё больше ускорителей NVIDIA. Пока инвесторы сомневаются, как оценивать компанию, поскольку малое количество якорных клиентов в совокупности с высокими темпами роста и большими долгами — довольно редкое явление. CoreWeave может сыграть роль и в развитии других компаний и проектов. В частности, речь идёт о намерении OpenAI подписаться на сервисы CoreWeave — пятилетний контракт на $11,9 млрд предполагает получение доли в компании. В этот период CoreWeave сможет получать дополнительные средства ежегодно, что несколько снизит её зависимость от NVIDIA и Microsoft. Однако данный контракт является лишь дополнением к контрактам с Microsoft и Oracle. Кроме того, идёт строительство ИИ ЦОД для проекта Stargate, поддерживаемого SoftBank и Oracle. Своим инвесторам OpenAI заявила, что к 2030 году Stargate обеспечит ¾ вычислительных мощностей, необходимых компании. |

|