Лента новостей

|

24.03.2025 [14:21], Руслан Авдеев

Страховка от протечек: Accelsius выплатит до $100 тыс., если её СЖО прохудится и зальёт оборудование в стойкеКомпания Accelsius, специализирующаяся на системах двухфазного жидкостного охлаждения, при поддержке одного из крупнейших в США страховщиков CNA запустила программу поддержки использования СЖО — страхование от утечек. Новая программа NeuGuard обеспечивает основные и дополнительные виды защиты и обслуживания. Как заявляет пресс-служба Accelsius, более половины респондентов (54 %) Uptime Institute в 2024 году заявили, что последний сбой оборудования обошёлся им дороже $100 тыс., а 16 % — что издержки составили более $1 млн. В рамках программы NeuGuard предлагается индивидуальная многолетняя гарантия. Предусмотрена гибкая поддержка и компенсация в объёме до $100 тыс. на стойку в случае повреждений оборудования из-за протечек СЖО Accelsius NeuCool. NeuCool изначально разрабатывалась подразделением Bell Labs компании Nokia. СЖО использует диэлектрический хладагент — он кипит в циркуляционной системе и отводит больше тепла, чем решения конкурентов, говорит компания. В самой CNA сообщают, что защита критически важной инфраструктуры важнее, чем когда-либо и индивидуальный подход страховой компании в рамках NeuGuard демонстрируют приверженность решать проблемы с учётом меняющихся потребностей индустрии ЦОД. Accelsius также предлагает гарантии на уровне ведущих мировых OEM-производителей для серверов. После тестирования и проверки ключевыми поставщиками OEM-решений вводятся гарантии на индивидуальном уровне для отдельных единиц — наряду с предложением NeuGuard.

24.03.2025 [13:14], Сергей Карасёв

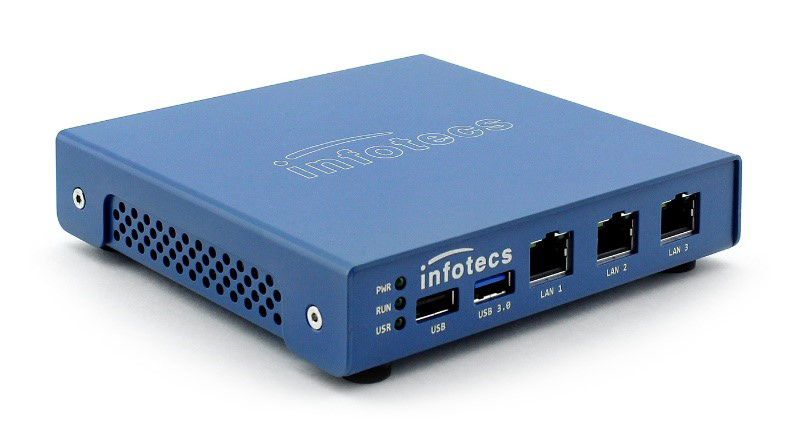

«ИнфоТеКС» выпустила шлюз безопасности ViPNet Coordinator HW50 в формате мини-компьютера«ИнфоТеКС» представила компактный шлюз безопасности ViPNet Coordinator HW50, выполненный на аппаратной платформе компании «АТБ-Электроника». Новинка предназначена для использования в небольших офисах и филиалах организаций. Шлюз построен на основе мини-компьютера «АТБ-Электроника» АТБ-АТОМ-1.3. Устройство оборудовано процессором Intel Atom E3845 поколения Bay Trail (4C/4T; 1,91 ГГц; 10 Вт), максимум 8 Гбайт оперативной памяти DDR3L-1067 (non-ECC), а также SSD формата М.2 2242 вместимостью до 256 Гбайт. Решение обеспечивает производительность в режиме шифрования (VPN) до 250 Мбит/с, в режиме межсетевого экрана — до 700 Мбит/с. Количество обслуживаемых соединений достигает 150 тыс. Устройство ViPNet Coordinator HW50 (платформа HW50 A1) располагает тремя сетевыми интерфейсами 1GbE (RJ45), портами USB 2.0 и USB 3.0, выходом HDMI и консольным портом (RJ45) для локального подключения к шлюзу. Беспроводные интерфейсы не предусмотрены. Габариты составляют 136 × 28 × 130 мм, масса — 0,4 кг. Питание подаётся через внешний адаптер. Диапазон рабочих температур простирается от 0 до +50 °C. Среднее время наработки на отказ (MTBF) — 40 тыс. часов.

Источник изображения: «ИнфоТеКС» Изделия АТБ-АТОМ-1.3 включено в Единый реестр российской радиоэлектронной продукции (ПП РФ 878). ViPNet Coordinator HW50 A1 сертифицирован во ФСТЭК России по требованиям к межсетевым экранам типа А, типа Б четвёртого класса и четвёртого уровня доверия. Завершаются работы по сертификации платформы по требованиям ФСБ России к СКЗИ класса КС3. «ИнфоТеКС» планирует добавить платформу HW50 A1 в новое поколение криптошлюзов ViPNet Coordinator HW 5, реализующих концепцию NGFW (межсетевой экран нового поколения). Кроме того, аппаратные платформы «АТБ-Электроники» рассматриваются для развития модельного ряда индустриальных шлюзов безопасности.

24.03.2025 [11:59], Руслан Авдеев

OpenAI и Meta✴ ведут переговоры с индийской Reliance Jio о сотрудничестве в сфере ИИMeta✴ и OpenAI по отдельности ведут переговоры с индийской Reliance Industries о потенциальном сотрудничестве для расширения ИИ-сервисов, сообщает The Information. Так, OpenAI хотела бы при помощи Reliance Jio расширить использование ChatGPT в Индии — об этом изданию сообщили два независимых источника, знакомых с вопросом. Более того, OpenAI обсуждала с сотрудниками сокращение стоимости подписок на платный вариант ChatGPT с $20/мес. до всего нескольких долларов. Пока неизвестно, велись ли разговоры об этом в ходе переговоров с Reliance. С последней, как утверждается, обсуждали продажу ИИ-моделей OpenAI корпоративным клиентам (через API). Также индийская компания заинтересована в локальном хостинге моделей OpenAI, чтобы данные местных клиентов будут храниться в пределах Индии. По имеющимся данным, с OpenAI и Meta✴ велись переговоры о запуске ИИ-моделей компаний в 3-ГВт ЦОД, который Reliance пока только планирует построить. Утверждается, что это будет «крупнейший дата-центр в мире» — его возведут в Джамнагаре (штат Гуджарат). Стоит отметить, что Reliance Industries является одним из крупнейших конгломератов Индии, имеющих интересы как в нефтегазовой отрасли, так и в IT и смежных отраслях, а также в сфере «зелёной» энергетики.

Источник изображения: Shivam Mistry/unsplash.com Индия в целом считается очень перспективной страной для развития инвестиций в ИИ. Например, в конце прошлого года глава NVIDIA Дженсен Хуанг (Jensen Huang) заявил, что страна должна стать одним из лидеров в области ИИ и создать собственную инфраструктуру. Тогда сообщалось, что Индия на государственном уровне обсуждает с NVIDIA совместную разработку чипов для ИИ-проектов, адаптированных к местным задачам. Также страна осваивает связанные с ИИ технологии — например, она затратит $1,2 млрд на суверенный ИИ-суперкомпьютер с 10 тыс. ускорителей и собственные LLM, а также готова покупать много ускорителей, включая ослабленные варианты, которые не достались Китаю после ужесточения американских санкций. И это далеко не все проекты, находящиеся сейчас на стадии разработки и реализации.

24.03.2025 [10:56], Сергей Карасёв

Chemours, NTT Data и Hibiya Engineering опробуют передовую жидкость для двухфазных систем погружного охлажденияКомпании Chemours, NTT Data и Hibiya Engineering объявили об объединении усилий с целью полномасштабных испытаний системы двухфазного иммерсионного (погружного) охлаждения для дата-центров. Речь идёт, в частности, об использовании специальной жидкости Chemours Opteon 2P50. Партнёры отмечают, что сектор ЦОД быстро развивается на фоне активного внедрения ИИ и НРС. Однако существует значительный разрыв между ростом энергопотребления таких объектов и повышением эффективности систем охлаждения. Сотрудничество Chemours, NTT Data и Hibiya Engineering направлено на исследование технологий охлаждения следующего поколения, которые обеспечат повышение эффективности и устойчивости дата-центров при увеличении их мощности.

Источник изображения: Chemours Проект ориентирован на тестирование Opteon 2P50 с целью последующей коммерциализации. Эта запатентованная диэлектрическая жидкость разработана специально для двухфазного иммерсионного охлаждения. Жидкость выполнена на основе гидрофторолефина (HFO) с нулевым озоноразрушающим потенциалом (ODP). Коэффициент GWP (потенциал глобального потепления), определяющий степень воздействия различных парниковых газов на глобальное потепление, равен 10 (AR6). По заявлениям разработчика, жидкость Opteon 2P50 позволяет снизить энергозатраты ЦОД на охлаждение до 90 % и уменьшить общее энергопотребление дата-центров на 40 %. Кроме того, в большинстве климатических зон Opteon 2P50 даёт возможность практически полностью исключить использование воды, а также значительно уменьшить шумовое загрязнение внутри помещений. Физическая площадь ЦОД может быть сокращена на 60 %. Плюс к этому жидкость может повторно использоваться неограниченное количество раз. В испытаниях системы двухфазного иммерсионного охлаждения на основе Opteon 2P50 примут участие различные заинтересованные стороны — от операторов дата-центров, производителей оборудования и проектно-конструкторских фирм до поставщиков ИТ-услуг и научно-исследовательских институтов.

24.03.2025 [10:45], Руслан Авдеев

Миллисекундный сбой чуть не привёл к катастрофе: 60 дата-центров мощностью 1,5 ГВт разом отключились от энергосетиКак выяснилось недавно, прошлым летом Вирджиния (США) оказалась на грани катастрофы после того, как от энергосети одновременно отключились 60 дата-центров, суммарно потреблявших 1,5 ГВт. Это вынудило операторов электросетей принимать экстренные меры, чтобы избежать масштабных отключений электричества у других потребителей в регионе, сообщает Datacenter Dynamics. Инцидент документирован, впервые о нём сообщило агентство Reuters — все ЦОД в округе Фэрфакс (Fairfax) в массовом порядке пришлось переключать на резервные генераторы из-за сбоев оборудования в энергосети. Оператору сети PJM Interconnection и местной коммунальной компании Dominion Energy пришлось экстренно сокращать объём поступающей в сеть с электростанций энергии — в противном случае системы сами отключились бы от избыточной мощности. Потенциально это могло привести к отключениям электричества во всём штате. По данным Североамериканской корпорации по надёжности электроснабжения (NERC), неполадки начались вечером 10 июля 2024 года. На 230-кВ линии электропередачи произошёл сбой оборудования защиты, что привело к нарушениям в работе всей системы. В результате на несколько миллисекунд произошла серия сбоев подачи электричества — этого оказалось достаточно, чтобы местные ЦОД временно переключились на резервные системы питания.

Источник изображения: dhahi alsaeedi/unspalsh.com Расследование NERC показало, что в случае серии сбоев в течение короткого периода времени дата-центры не переключаются обратно на основную энергосеть — это приходится делать вручную, причём в данном случае ЦОД несколько часов проработали на резервных источниках питания. Хотя напряжение «не поднялось до уровней, представляющих риск для надёжности», операторам энергосети всё равно пришлось принимать меры для сокращения подачи электричества в сеть. Более того, подобные проблемы, вероятно, в будущем станут более распространёнными, поскольку спрос на электричество для ЦОД в Вирджинии только растёт. В феврале Dominion заявляла, что теперь располагает 40 ГВт «законтрактованных» мощностей для дата-центров по состоянию на декабрь 2024 года — это на 88 % больше, чем в июле. Не исключены и другие проблемы. В NERC сообщают, что инцидент не вызвал значимых проблем с повторным подключением объектов большой ёмкости, но существует возможность возникновения проблем в будущем. В прошлом году NERC организовала специальную команду для отслеживания ситуаций с большими нагрузками и влияния на состояние энергетической инфраструктуры ЦОД и других крупных потребителей энергии. Такие потребители уже представляют проблему, а иногда и опасность для обычных жителей, т.к. они повышают риск пожаров. Сетевые операторы и энергокомпании должны принять меры для изучения вероятного влияния внезапного «выхода из сети» крупных потребителей и их повторного подключения. В NERC подчёркивают, что ЦОД становятся больше и потребляют всё больше энергии, но сеть не рассчитана на то, чтобы выдержать отключения дата-центров общей мощностью 1,5 ГВт. На каком-то этапе проблема станет неразрешимой, если ей не заниматься. Северная Вирджиния, где и произошёл сбой, признана самым ёмким рынком ЦОД в мире.

24.03.2025 [10:20], Андрей Созинов

Orion soft выпустил Termit 2.3: фокус на удобство и безопасность для КИИ, новые сценарии использованияРазработчик инфраструктурного ПО для Enterprise-бизнеса Orion soft выпустил новую версию системы терминального доступа Termit 2.3. В ней реализована возможность перенаправления смарт-карт в удаленных сессиях, многофакторной аутентификации и одновременной работы с несколькими каталогами LDAP, поддержка единого входа SSO Kerberos, а также новая роль ИБ-аудитора, разделение списка приложений и рабочих столов по типу и категориям. Новая функциональность позволяет заказчикам, в частности, субъектам КИИ, усилить защиту ключевых ИТ-систем и расширить количества сценариев применения терминального доступа. Нововведения упрощают повседневные операции, экономят время администраторов и снижают порог обучения для новых пользователей. Интерфейс Termit стал более структурированным, что помогло снизить время поиска необходимых функций.

Источник изображения: Orion soft В прошлых версиях Termit команда Orion soft реализовала поддержку российских каталогов LDAP, а теперь решение позволяет работать сразу с несколькими LDAP. Благодаря этому к терминальному серверу можно подключать одновременно разные базы пользователей. Это актуально компаниям, которым нужно объединить сотрудников из нескольких организаций или филиалов, и в случае переходного периода, когда в инфраструктуре одновременно используется служба каталогов Microsoft AD и ее отечественный аналог. Также система получила механизм упрощенной авторизации по схеме Single Sign-On (SSO) на базе протокола аутентификации Kerberos. Нововведение избавляет пользователя от необходимости повторно вводить свои реквизиты доступа. Если он уже вошел в систему, все сервисы будут доступны, пока не закончится время его сессии. Еще одно нововведение — поддержка многофакторной аутентификации (MFA) через любой доступный RADIUS-сервер. Системные администраторы могут выбрать любой дополнительный фактор, например, SMS или токен, либо оставить выбор за пользователями. Чтобы у заказчиков было больше инструментов для контроля уровня безопасности системы, разработчики также добавили в релиз Termit 2.3 новую роль «аудитор ИБ». Она дает возможность просматривать настройки и проверять их корректность. «В новом релизе Termit мы сделали акцент на безопасности и расширении количества сценариев для терминального доступа, так как ориентируем наше решение на использование в ИТ-инфраструктуре субъектов КИИ. Мы добавили новые функции авторизации, чтобы у заказчиков была возможность настроить систему в соответствии с актуальными требованиями регуляторов. Отметим также, что Termit разработан без использования Open Source. Это исключает возможность эксплуатации уязвимостей общедоступного кода, позволяет повысить безопасность бизнес-процессов и ИТ-инфраструктуры заказчиков, а также ускорить выпуск новой востребованной функциональности. Наш продукт уже в значительной степени закрывает требования к базовой функциональности терминального доступа. Мы продолжаем развивать Termit, учитывая запросы и приближаясь к полному закрытию списка основных ожиданий пользователей от платформы», — резюмирует Константин Прокопьев, лидер продукта Termit Orion soft. Следующее обновление Termit также планируется масштабным. Разработчики планируют реализовать функциональность VDI (виртуализация рабочих мест), управление перемещаемыми профилями с поддержкой различных отечественных ОС, возможность аутентификации в удаленных сессиях при помощи смарт-карт, поддержку ГОСТ шифрования трафика, возможность доступа со смартфонов и планшетов. Реклама | ООО «Орион» ИНН 9704113582 erid: F7NfYUJCUneRHUdip15e

24.03.2025 [09:03], Владимир Мироненко

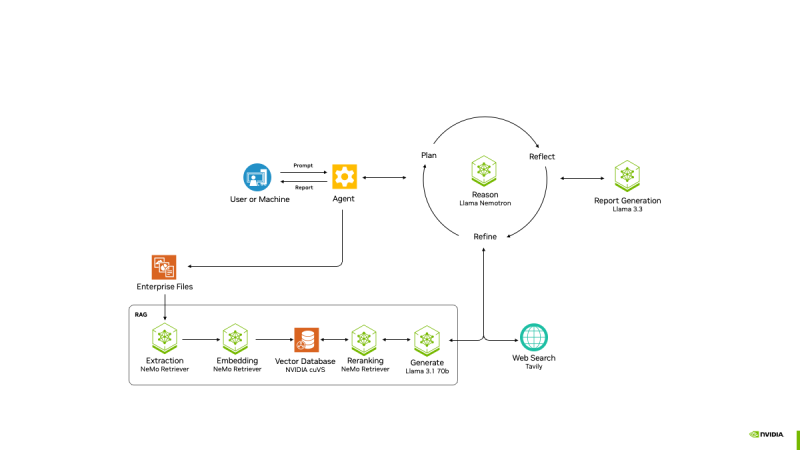

От СХД напрямую к ИИ: NVIDIA анонсировала эталонную платформу AI Data Platform для быстрого извлечения данных во время инференсаNVIDIA анонсировала NVIDIA AI Data Platform — настраиваемую эталонную архитектуру, которую ведущие поставщики смогут использовать для создания нового класса ИИ-инфраструктуры для требовательных рабочих нагрузок ИИ-инференса: корпоративных платформ хранения со специализированными ИИ-агентами, использующих ускорители, сетевые решения и ПО NVIDIA. Эти агенты помогут генерировать ответы из имеющихся данных практически в реальном времени, используя ПО NVIDIA AI Enterprise — включая микросервисы NVIDIA NIM для новых моделей NVIDIA Llama Nemotron, а также NVIDIA AI-Q Blueprint. Провайдеры хранилищ смогут оптимизировать свою инфраструктуру для обеспечения работы этих агентов с помощью ускорителей NVIDIA Blackwell, DPU BlueField, сетей Spectrum-X и библиотеки инференса с открытым исходным кодом NVIDIA Dynamo. Ведущие провайдеры платформ данных и хранилищ, включая DDN, Dell, HPE, Hitachi Vantara, IBM, NetApp, Nutanix, Pure Storage, VAST Data и WEKA, сотрудничают с NVIDIA для создания настраиваемых ИИ-платформ данных, которые могут использовать корпоративные данные для рассуждений и ответов на сложные запросы. NVIDIA Blackwell, DPU BlueField и сетевое оборудование Spectrum-X предоставляют механизм для ускорения доступа ИИ-агентов запроса к данным, хранящимся в корпоративных системах. DPU BlueField обеспечивают производительность до 1,6 раз выше, чем хранилища на базе ЦП, при этом снижая энергопотребление до 50 %, а Spectrum-X ускоряет доступ к хранилищам до 48 % по сравнению с традиционным Ethernet, применяя адаптивную маршрутизацию и контроль перегрузки, говорит NVIDIA. ИИ-агенты, созданные с помощью AI-Q Blueprint, подключаются к данным во время инференса, чтобы предоставлять более точные, контекстно-зависимые ответы. Они могут быстро получать доступ к большим объёмам информации и обрабатывать различные типы данных, включая структурированные, полуструктурированные и неструктурированные данные из нескольких источников, в том числе текст, PDF, изображения и видео. Сертифицированные партнёры NVIDIA в области СХД уже сотрудничают с NVIDIA в деле создания новых ИИ-платформ:

24.03.2025 [08:30], Владимир Мироненко

NVIDIA представила проект AI-Q Blueprint Platform для создания продвинутых ИИ-агентовПризнавая, что одних моделей, включая свежие Llama Nemotron с регулируемым «уровнем интеллекта», недостаточно для развёртывания ИИ на предприятии, NVIDIA анонсировала проект AI-Q Blueprint, представляющий собой фреймворк с открытым исходным кодом, позволяющий разработчикам подключать базы знаний к ИИ-агентам, которые могут действовать автономно. Blueprint был создан с помощью микросервисов NVIDIA NIM и интегрируется с NVIDIA NeMo Retriever, что упрощает для ИИ-агентов извлечение мультимодальных данных в различных форматах. С помощью AI-Q агенты суммируют большие наборы данных, генерируя токены в 5 раз быстрее и поглощая данные петабайтного масштаба в 15 раз быстрее с лучшей семантической точностью. Проект основан на новом наборе инструментов NVIDIA AgentIQ для бесшовного, гетерогенного соединения между агентами, инструментами и данными, опубликованном на GitHub. Он представляет собой программную библиотеку с открытым исходным кодом для подключения, профилирования и оптимизации команд агентов ИИ, работающих на основе корпоративных данных для создания многоагентных комплексных (end-to-end) систем. Его можно легко интегрировать с существующими многоагентными системами — как по частям, так и в качестве комплексного решения — с помощью простого процесса адаптации, который обеспечивает полную поддержку. Набор инструментов AgentIQ также повышает прозрачность с полной отслеживаемостью и профилированием системы, что позволяет организациям контролировать производительность, выявлять неэффективность и иметь детальное представление о том, как генерируется бизнес-аналитика. Эти данные профилирования можно использовать с NVIDIA NIM и библиотекой с открытым исходным кодом NVIDIA Dynamo для оптимизации производительности агентских систем. Благодаря этим инструментам предприятиям будет проще объединять команды ИИ-агентов в таких решениях, как Agentforce от Salesforce, поиск Atlassian Rovo в Confluence и Jira, а также ИИ-платформа ServiceNow для трансформации бизнеса, чтобы устранить разрозненность, оптимизировать задачи и сократить время ответа с дней до часов. AgentIQ также интегрируется с такими фреймворками и инструментами, как CrewAI, LangGraph, Llama Stack, Microsoft Azure AI Agent Service и Letta, позволяя разработчикам работать в своей предпочтительной среде. Azure AI Agent Service интегрирован с AgentIQ для обеспечения более эффективных агентов ИИ и оркестровки многоагентных фреймворков с использованием семантического ядра, которое полностью поддерживается в AgentIQ. Возможности ИИ-агентов уже широко используются в различных отраслях. Например, платёжная система Visa использует ИИ-агентов для оптимизации кибербезопасности, автоматизируя анализ фишинговых писем в масштабе. Используя функцию профилирования AI-Q, Visa может оптимизировать производительность и затраты агентов, максимально увеличивая роль ИИ в эффективном реагировании на угрозы, сообщила NVIDIA.

24.03.2025 [01:37], Владимир Мироненко

NVIDIA анонсировала ИИ-модели Llama Nemotron с регулируемым «уровнем интеллекта»NVIDIA анонсировала новое семейство ИИ-моделей Llama Nemotron с расширенными возможностями рассуждения. Основанные на моделях Llama с открытым исходным кодом от Meta✴ Platforms, модели от NVIDIA предназначены для предоставления разработчикам основы для создания продвинутых ИИ-агентов, которые могут от имени своих пользователей независимо или с минимальным контролем работать в составе связанных команд для решения сложных задач. «Агенты — это автономные программные системы, предназначенные для рассуждений, планирования, действий и критики своей работы», — сообщила Кари Бриски (Kari Briski), вице-президент по управлению программными продуктами Generative AI в NVIDIA на брифинге с прессой, пишет VentureBeat. «Как и люди, агенты должны понимать контекст, чтобы разбивать сложные запросы, понимать намерения пользователя и адаптироваться в реальном времени», — добавила она. По словам Бриски, взяв Llama за основу, NVIDIA оптимизировала модель с точки зрения требований к вычислениям, сохранив точность ответов. NVIDIA сообщила, что улучшила новое семейство моделей рассуждений в ходе дообучения, чтобы улучшить многошаговые математические расчёты, кодирование, рассуждения и принятие сложных решений. Это позволило повысить точность ответов моделей до 20 % по сравнению с базовой моделью и увеличить скорость инференса в пять раз по сравнению с другими ведущими рассуждающими open source моделями. Повышение производительности инференса означают, что модели могут справляться с более сложными задачами рассуждений, имеют расширенные возможности принятия решений и позволяют сократить эксплуатационные расходы для предприятий, пояснила компания. Модели Llama Nemotron доступны в микросервисах NVIDIA NIM в версиях Nano, Super и Ultra. Они оптимизированы для разных вариантов развёртывания: Nano для ПК и периферийных устройств с сохранением высокой точности рассуждения, Super для оптимальной пропускной способности и точности при работе с одним ускорителем, а Ultra — для максимальной «агентской точности» в средах ЦОД с несколькими ускорителями. Как сообщает NVIDIA, обширное дообучение было проведено в сервисе NVIDIA DGX Cloud с использованием высококачественных курируемых синтетических данных, сгенерированных NVIDIA Nemotron и другими открытыми моделями, а также дополнительных курируемых наборов данных, совместно созданных NVIDIA. Обучение включало 360 тыс. часов инференса с использованием ускорителей H100 и 45 тыс. часов аннотирования человеком для улучшения возможностей рассуждения. По словам компании, инструменты, наборы данных и методы оптимизации, используемые для разработки моделей, будут в открытом доступе, что предоставит предприятиям гибкость в создании собственных пользовательских рвссуждающих моделей. Одной из ключевых функций NVIDIA Llama Nemotron является возможность включать и выключать опцию рассуждения. Это новая возможность на рынке ИИ, утверждает компания. Anthropic Claude 3.7 имеет несколько схожую функциональность, хотя она является закрытой проприетарной моделью. Среди моделей с открытым исходным кодом IBM Granite 3.2 тоже имеет переключатель рассуждений, который IBM называет «условным рассуждением». Особенность гибридного или условного рассуждения заключается в том, что оно позволяет системам исключать вычислительно затратные этапы рассуждений для простых запросов. NVIDIA продемонстрировала, как модель может задействовать сложные рассуждения при решении комбинаторной задачи, но переключаться в режим прямого ответа для простых фактических запросов. NVIDIA сообщила, что целый ряд партнёров уже использует модели Llama Nemotron для создания новых мощных ИИ-агентов. Например, Microsoft добавила Llama Nemotron и микросервисы NIM в Microsoft Azure AI Foundry. SAP SE использует модели Llama Nemotron для улучшения возможностей своего ИИ-помощника Joule и портфеля решений SAP Business AI. Кроме того, компания использует микросервисы NVIDIA NIM и NVIDIA NeMo для повышения точности завершения кода для языка ABAP. ServiceNow использует модели Llama Nemotron для создания ИИ-агентов, которые обеспечивают повышение производительности и точности исполнения задач предприятий в различных отраслях. Accenture сделала рассуждающие модели NVIDIA Llama Nemotron доступными на своей платформе AI Refinery. Deloitte планирует включить модели Llama Nemotron в свою недавно анонсированную платформу агентского ИИ Zora AI. Atlassian и Box также работают с NVIDIA, чтобы гарантировать своим клиентам доступ к моделям Llama Nemotron.

23.03.2025 [14:14], Сергей Карасёв

Equal1 представила первый в мире стоечный квантовый сервер на базе кремния, который можно развернуть в любом ЦОДИрландский стартап Equal1, специализирующийся на квантовых вычислениях, анонсировал систему Bell-1 — это, по словам компании, первый в мире компактный квантовый сервер, построенный на кремниевом чипе. Устройство может быть легко интегрировано в существующие среды НРС для формирования платформ квантово-классических вычислений. Equal1 отмечает, что современным квантовым компьютерам необходима специализированная инфраструктура, включающая отдельные помещения и сложные системы охлаждения. Но Bell-1 может быть развёрнут в виде стойки в существующем дата-центре. Основой Bell-1 служит чип UnityQ с шестью кубитами — это так называемая квантовая система на кристалле (QSoC). Она объединяет все компоненты квантовых вычислений — средства измерения, управления, считывания и коррекции ошибок — в одном кремниевом процессоре, что, как утверждается, обеспечивает высокую точность и беспрецедентную мощность. Гибридная архитектура включает ядра Arm, ускорители ИИ и нейронные блоки. Говорится о возможности масштабирования до миллионов кубитов. Реализованный подход устраняет сложную оркестрацию между отдельными классическими и квантовыми вычислительными узлами. Стоечная система Bell-1 работает от стандартной однофазной сети напряжением 110/220 В, а энергопотребление составляет 1600 Вт, что сопоставимо с высокопроизводительным сервером на базе GPU. Рабочая температура равна 0,3 К (-272,85 °C): для её поддержания применяется полностью автономная система, включающая интегрированный компрессор, криоохладитель и вакуумный насос. При этом температура окружающей среды может находиться в диапазоне от -15 до +45 °C. Габариты квантового сервера составляют 600 × 1000 × 1600 мм, масса — приблизительно 200 кг. Equal1 утверждает, что Bell-1 знаменует собой начало эпохи реальных квантовых вычислений — Quantum Computing 2.0: это означает переход от экспериментальных машин к практическим квантовым решениям. До сих пор квантовые вычисления ограничивались преимущественно научно-исследовательскими институтами. Компания Equal1, по её словам, меняет ситуацию, предлагая «первую коммерчески жизнеспособную квантовую систему», созданную для работы в существующих дата-центрах ИИ и HPC. Предприятия смогут использовать квантовые вычисления без изменения существующей инфраструктуры ЦОД. При этом устраняются барьеры высокой сложности и стоимости. |

|