Лента новостей

|

21.03.2025 [08:15], Руслан Авдеев

NVIDIA и xAI присоединились к $30-млрд инфраструктурному ИИ-консорциуму, возглавляемому Microsoft и BlackRock

blackrock

hardware

microsoft

nvidia

xai

возобновляемая энергия

ии

инвестиции

строительство

сша

финансы

цод

энергетика

NVIDIA и xAI присоединились к консорциуму, намеренному инвестировать $30 млрд в развитие ИИ-инфраструктуры. Консорциум AI Infrastructure Partnership (AIP), ранее известный как Global AI Infrastructure Investment Partnership, был сформирован Microsoft, BlackRock, Global Infrastructure Partners (GIP, принадлежит BlackRock) и дубайской государственной инвесткомпанией MGX (создана при участии Mubadala и G42) в сентябре 2024 года, Silicon Angle. На начальном этапе консорциум намерен инвестировать в ИИ-проекты более $30 млрд, а в долгосрочной перспективе — $100 млрд. В основном речь идёт об инвестициях в дата-центры и энергетическую инфраструктуру, преимущественно в США. Консорциум сообщил, что уже привлёк значительные средства и вызвал интерес у бизнеса. До того, как NVIDIA объявила о намерении присоединиться к AIP, она выступала техническим консультантом консорциума в области ИИ ЦОД. Эту роль она сохранит. Также стало известно, что с AIP работают производитель оборудования для энергетической отрасли GE Vernova, в прошлом году отделившийся от General Electric, и крупнейшая в США коммунальная компания NextEra Energy, занимающаяся электроснабжением. Она же является крупнейшим в мире провайдером в области ветроэнергетики. GE Vernova будет работать с AIP и партнёрами над формированием цепочек поставок. NextEra Energy поможет в масштабировании критически важных и разнообразных энергетических решений для ИИ ЦОД. Некоторые из поддерживающих AIP компаний также участвуют и в других инициативах по финансированию развития ИИ-инфраструктуры. В прошлом году Microsoft с Constellation Energy Generation объявили о возобновлении работы АЭС Three Mile Island. Обновление объекта обойдётся в $1,6 млрд. После того, как тот заработает приблизительно в 2026 году, все 837 МВт пойдут на питание дата-центров Microsoft. NVIDIA параллельно участвует в проекте Stargate.

21.03.2025 [01:15], Владимир Мироненко

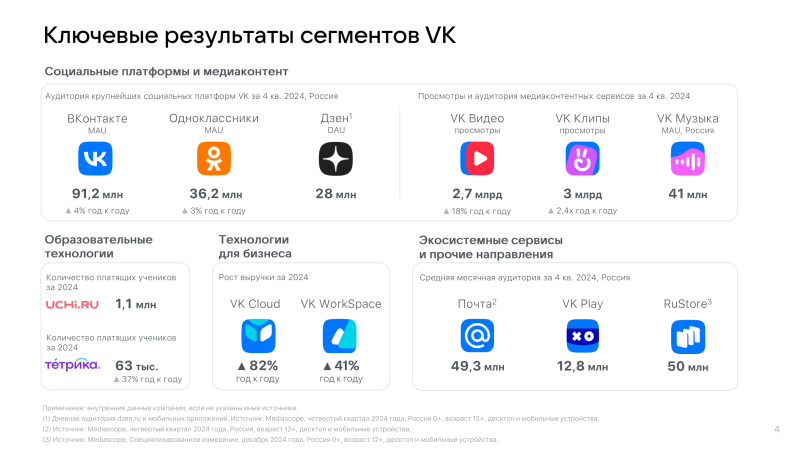

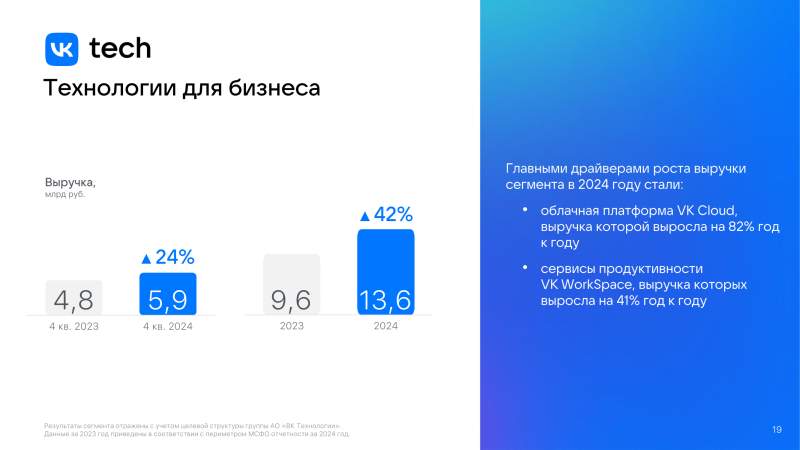

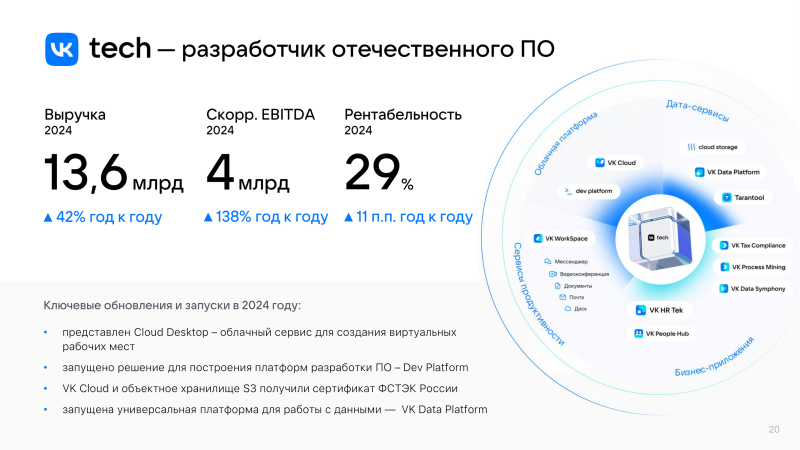

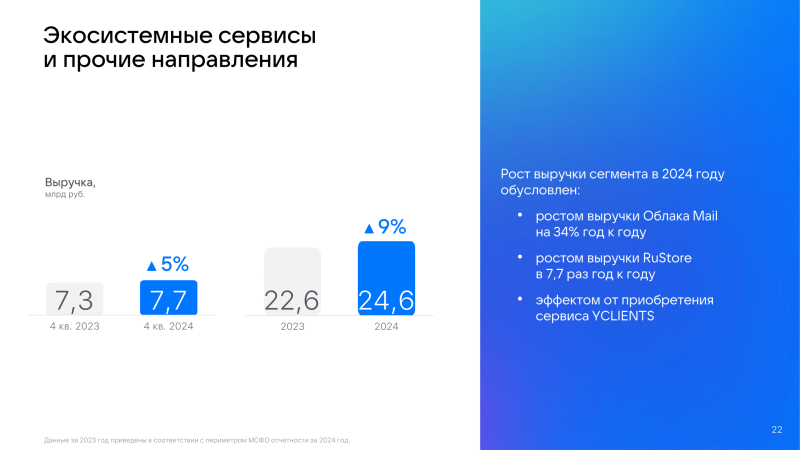

VK увеличила выручку за 2024 год на 23 %, а VK Tech — сразу на 42 %VK объявила аудированные финансовые результаты за 2024 год. Выручка компании выросла на 23 % по сравнению с 2023 годом до 147,6 млрд руб. Основным источником роста была онлайн-реклама, которая принесла компании 96,1 млрд руб. выручки, увеличившись по сравнению с предыдущим годом на 20 %. Вместе с тем выручка сегмента VK Tech увеличилась на 42 % год к году до 13,6 млрд руб., а скорректированная EBITDA выросла в 2,4 раза до 4 млрд руб. С момента выделения в отдельный сегмент в 2018 году среднегодовой рост выручки VK Tech по 2024 год составил 73 %, маржинальность по EBITDA — 29 %. Основными драйверами роста VK Tech в прошлом году были облачные сервисы платформы VK Cloud увеличившие выручку год к году на 82 % и сервисы продуктивности VK Workspace, показавшие рост выручки в 41 %. VK сообщила, что рассматривает возможность проведения первичного публичного размещения (IPO) акций VK Tech, и решение будет принято с учётом рыночной конъюнктуры. Как ожидается, это усилит потенциал развития VK Tech, а также будет способствовать узнаваемости и укреплению бренда. Выручка сегмента «Экосистемные сервисы и прочие направления», включающего сервис «Облако Mail.ru», выросла на 9 % до 24,6 млрд руб. При этом «Облако Mail.ru» увеличил выручку на 34 %. Средняя месячная аудитория сервиса в России за IV квартал 2024 года составила 21,8 млн пользователей, средняя дневная — 2,8 млн. Рост выручки от продаж единой подписки на «Почту» и «Облако Mail Space» за IV квартал составил 49 % год к году. Пользователи загрузили в «Облако Mail.ru» за три месяца 9 млрд файлов, что на 15 % больше, чем за IV квартал 2023 года. В «Облаке Mail.ru» появились тёмная тема, быстрая очистка места на устройстве и возможность кастомизации папок.

20.03.2025 [17:47], Руслан Авдеев

Crusoe расширит до 1,2 ГВт ИИ-кампус в Абилине, который, похоже, целиком достанется StargateКомпания Crusoe Energy начала вторую фазу строительства кампуса ИИ ЦОД в технопарке Lancium Clean Campus в Абилине (Abilene, Техас), который будет обслуживать ИИ-мегапроект Stargate. Предполагается, что она будет завершена в середине 2026 года, когда будут построены шесть новых зданий. Всего кампус будет включать восемь объектов. Итоговая площадь кампуса составит более 370 тыс. м2, а общая ёмкость вырастет до 1,2 ГВт. Первая фаза строительства ИИ ЦОД в Абилине стартовала в июне 2024 года. Она включает возведение двух зданий площадью более 90 тыс. м2 и ёмкостью более 200 МВт. Ожидается, что подача энергии начнётся в I половине 2025 года. OpenAI ранее заявляла о намерении управлять восемью зданиями в кампусе в Абилине. Crusoe отказалась комментировать, ведётся ли вторая фаза строительства в интересах Stargate. На этой неделе Crusoe анонсировала создание совместного предприятия на 4,5 ГВт не только для строительства ЦОД, но и для их автономного питания от газовых электростанций.

Источник изображения: Crusoe Как заявляют в Crusoe, экспансия в Абилине знаменует важную веху для ИИ-индустрии. Масштаб сконцентрированных на одной площадке вычислительных мощностей весьма примечателен — она, по оценкам, сможет разместить до 400 тыс. ускорителей. На рынке ИИ-инфраструктуры появилась новая категория — «ИИ-фабрика», позволяющая обрабатывать ИИ-нагрузки с беспрецедентными скоростью и масштабом. В Crusoe гордятся тем, что предоставляют инфраструктуру, которая будет способствовать развитию человечества. В Lancium добавляют, что управление ЦОД такого масштаба требует инноваций на уровне кампуса для обеспечения надёжности электросетей при любых нагрузках.

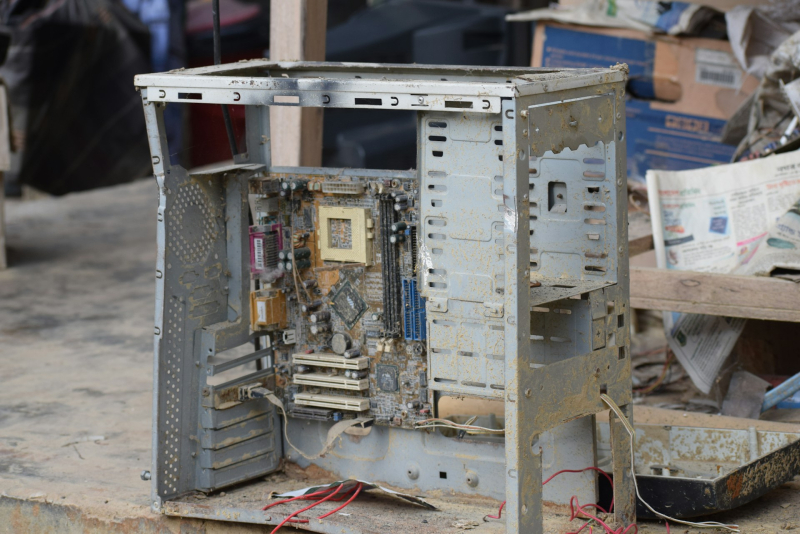

20.03.2025 [16:25], Татьяна Золотова

Почти вся ИТ-инфраструктура «Почты России» фактически «дышит на ладан», пожаловался глава госкомпанииПочти 90 % ИТ-инфраструктуры «Почты России» «дышит на ладан», а 55 % транспорта компании находится «за сроками полезного использования», сообщают «РИА Новости» со ссылкой на выступление главы ФГУП «Почта России» Михаила Волкова на расширенном заседании ИТ-комитета в Госдуме. Как заявил Михаил Волков, изношенность фондов очень большая. «Например, около 55 % нашего транспорта уже за сроками полезного использования. Что касается ИТ-инфраструктуры — 89 % фактически на ладан дышат», — был откровенен глава «Почты России». Ключевыми проблемами на 2025 год для организации ее глава называет низкий уровень заработных плат и крайняя изношенность инфраструктуры. При этом он указал, что в 2023 и 2024 годах зарплаты у специалистов основного производства повышались, но средний уровень выплат все равно в два раза ниже, чем в среднем по стране. С 2021 года уставный капитал «Почты России» был увеличен на 16,5 млрд руб. в рамках программы ее модернизации. Михаил Волков сообщил, что сейчас проходит программа модернизации и ремонта сельских отделений и совместно с Минцифры прорабатывается продление этой программы до 2030 года. Программа реализуется в соответствии с перечнем поручений Президента России. Глава «Почты России» объяснил, что организация работает над повышением операционной и финансовой эффективности: «На 36 % увеличена производительность труда, более чем на 30 % сокращены административно-управленческие расходы. И уже в 2023 году это позволило выйти на операционную прибыль, также и в 2024 году. Высокая ключевая ставка, конечно, сильно нас здесь сдерживает».

20.03.2025 [15:58], Сергей Карасёв

Supermicro анонсировала петабайтное 1U-хранилище All-Flash на базе Arm-суперчипа NVIDIA GraceКомпания Supermicro представила сервер ARS-121L-NE316R в форм-факторе 1U, на базе которого могут формироваться системы хранения данных петабайтной вместимости. В основу новинки положен суперчип NVIDIA Grace со 144 ядрами Arm Neoverse V2 и 960 Гбайт памяти LPDDR5x. Устройство оборудовано 16 фронтальными отсеками для NVMe-накопителей E3.S 1T. При использовании SSD ёмкостью 61,44 Тбайт суммарная вместимость может достигать 983 Тбайт. При этом до 40 серверов могут быть установлены в одну стойку, что обеспечит 39,3 Пбайт «сырой» ёмкости. Новинка располагает двумя внутренними посадочными местами для M.2 NVMe SSD и двумя слотами PCIe 5.0 x16 для карт типоразмера FHHL. Присутствуют сетевой порт управления 1GbE (RJ45), порт USB 3.0 Type-A и разъём mini-DP. Габариты сервера составляют 772,15 × 438,4 × 43,6 мм, масса — 19,8 кг без установленных накопителей. Питание обеспечивают два блока мощностью 1600 Вт с сертификатом 80 Plus Titanium. Применена система воздушного охлаждения с восемью съёмными вентиляторами диаметром 40 мм. Диапазон рабочих температур — от +10 до +35 °C. При необходимости сервер может быть оснащён двумя DPU NVIDIA BlueField-3 или двумя адаптерами ConnectX-8. Система подходит для поддержания рабочих нагрузок с интенсивным обменом данными, таких как ИИ-инференс, аналитика и пр. Отмечается, что при создании новинки Supermicro тесно сотрудничала с NVIDIA и WEKA (разработчик платформ хранения данных).

20.03.2025 [14:10], Татьяна Золотова

Роскомнадзор проверит, не используют ли операторы связи заграничные серверыСпециалисты Центра мониторинга и управления сетью связи общего пользования (ЦМУ ССОП) «Главного радиочастотного центра» (ГРЧЦ), который входит в Роскомнадзор (РКН), в ближайший месяц проведет плановые технические проверки использования российскими сервисами и операторами связи иностранной серверной инфраструктуры. Об этом сообщает «Интерфакс» со ссылкой на сообщение пресс-службы ведомства. Как поясняют в РКН, исследования необходимы для выработки мер по повышению устойчивости и безопасности работы упомянутых сервисов в рамках задачи обеспечения сетевого суверенитета. По данным сервиса по отслеживанию доступности сайтов и приложений Downdetector, сегодня в работе нескольких провайдеров РФ, операторов связи, мессенджеров и маркетплейсов произошел сбой. В РКН это связали с использованием иностранной серверной инфраструктуры, на которой и фиксируются сбои, сообщили «Известиям» в ведомстве. РКН порекомендовал отечественным организациям пользоваться мощностями российских хостинг-провайдеров. Согласно указу президента, с 1 января 2025 года органам государственной власти, заказчикам запрещается использовать иностранное программное обеспечение на принадлежащих им значимых объектах критической информационной инфраструктуры (КИИ). Как сообщал ранее ФСТЭК, по итогам 2024 года около 47 % из 170 российских организаций КИИ защита от киберугроз находится в критическом состоянии. Лишь у 13 % из них установлен минимальный базовый уровень защиты, а у около 40 % он относится к низким.

20.03.2025 [13:53], Руслан Авдеев

SoftBank решила купить производителя Arm-процессоров Ampere Computing за $6,5 млрдSoftBank Group подтвердила покупку производителя Arm-чипов Ampere Computing. Сделка оценивается в $6,5 млрд и, как ожидается, будет закрыта во II половине 2025 года, сообщает Silicon Angle. Оба главных акционера Ampere — Oracle и Carlyle Group — согласились продать свои доли в компании. После покупки Ampere будет действовать как независимое дочернее подразделение SoftBank, штаб-квартира компании по-прежнему останется в Санта-Кларе (Калифорния). Основанная в 2017 году бывшим вице-президентом Intel Рене Джеймс (Renee James) компания специализируется на выпуске серверных Arm-процессоров. Самой производительной моделью является AmpereOne M, поставки которого начались в декабре 2024 года. Процессор получил до 192 ядер и большую пропускную способность памяти, чем его предшественники. Также компания работает над разработкой ещё более производительного CPU Aurora который получит 512 ядер, HBM-память и выделенный ИИ-модуль.

Источник изображения: Ampere В SoftBank заявили, что покупают Ampere, в которой трудятся около 1 тыс. специалистов по полупроводникам, поскольку будущее «искусственного суперинтеллекта» требует прорывных вычислительных мощностей. Опыт Ampere в сфере чипов и HPC поможет ускорить соответствующие процессы и углубляет приверженность SoftBank к ИИ-инновациям в США. По имеющимся данным, Ampere впервые рассматривала продажу в сентябре 2024 года, позже компания наняла финансового консультанта для оценки перспектив. SoftBank выразила потенциальный интерес к покупке в январе 2025 года, а в прошлом месяце сообщалось, что переговоры о сделке идут весьма успешно. SoftBank уже является ключевым игроком на рынке чипов благодаря доле в Arm Holdings, купленной за $32 млрд в 2016 году. Arm вышла на IPO в 2023 году, но SoftBank всё ещё владеет крупнейшей долей компании. В прошлом июле SoftBank заключила сделку о покупке ещё одного производителя чипов — компании Graphcore, которая, как и Arm, базируется в Великобритании. Graphcore разрабатывает ИИ-ускорители. Сообщалось, что SoftBank может способствовать сотрудничеству Ampere и Graphcore в деле создания ИИ-серверов.

20.03.2025 [13:14], Сергей Карасёв

Micron, Samsung и SK hynix представили компактные модули памяти SOCAMM для ИИ-серверовКомпании Micron, Samsung и SK hynix, по сообщению ресурса Tom's Hardware, создали модули оперативной памяти SOCAMM (Small Outline Compression Attached Memory Modules) на основе чипов LPDDR5X. Изделия ориентированы на ИИ-системы и серверы с пониженным энергопотреблением. Модули SOCAMM имеют размеры 14 × 90 мм, что примерно в три раза меньше по сравнению с традиционными решениями RDIMM. В состав SOCAMM входят до четырёх 16-кристальных стеков памяти LPDDR5X. Изделия нового формата спроектированы специально для дата-центров, оптимизированных для приложений ИИ. Micron разработала модули SOCAMM ёмкостью 128 Гбайт, при производстве которых используется техпроцесс DRAM 1β (пятое поколение 10-нм техпроцесса). Скоростные показатели не раскрываются. Но Micron говорит о производительности на уровне 9,6 GT/s (млрд пересылок в секунду). В свою очередь, SK Hynix на конференции NVIDIA GTC 2025 представила модули SOCAMM, для которых заявлена скорость в 7,5 GT/s. Отмечается, что на оперативную память приходится значительная доля энергопотребления серверов. Например, в системах, оснащённых терабайтами DDR5, энергопотребление ОЗУ может превышать энергопотребление CPU. Компания NVIDIA учла это при разработке чипов Grace, выбрав для них память LPDDR5X, которая потребляет меньше энергии, чем DDR5. Однако в случае GB200 Grace Blackwell пришлось использовать впаянные блоки LPDDR5X, поскольку самостоятельные стандартные модули LPDDR5X не соответствовали требованиям в плане ёмкости. Изделия SOCAMM, массовое производство которых уже началось, позволяют решить данную проблему. На первом этапе модули SOCAMM будут применяться в серверах на основе суперчипов NVIDIA GB300. Но пока не ясно, станут ли решения SOCAMM отраслевым стандартом, поддерживаемым JEDEC, или останутся фирменным продуктом, разработанным Micron, Samsung, SK hynix и NVIDIA для серверов, построенных на чипах Grace и Vera.

20.03.2025 [13:07], Татьяна Золотова

«ИКС Холдинг» купил российского разработчика радиоэлектроники и телекомоборудования «Микран»Разработчик и производитель ПО и оборудования «ИКС Холдинг» завершает сделку по приобретению 100 % томского производителя радиоэлектроники и полупроводников НПФ «Микран», сообщают «Ведомости» со ссылкой на интервью с генеральным директором холдинга Алексеем Шелобковым. Сумма сделки не разглашается, но эксперты оценивают её в 10,5–15 млрд руб. АО «НПФ Микран» было создано в 1991 году. Компания обладает разработками в области радиоэлектроники, релейных систем и контрольно-измерительного оборудования, которые используются телекомоператорами и разработчиками телекоммуникационного оборудования. В 2016 году Минторг США включил «Микран» в санкционный список. Как указано в годовой отчетности «Микрана», в 2023 году выручка компании составила 7,38 млрд руб. (рост на 66 % в годовом выражении). Данные об акционерах не известны, но в феврале 2024 года «Коммерсантъ» со ссылкой на источники сообщал, что 90 % «Микрана» приобрела структура «Газпрома» – «Газпром тех». Как указано на сайте «Микрана», штат компании насчитывает более 1,6 тыс. сотрудников. Главный фокус компании — развитие на российском рынке и активное продвижение продукции в странах Ближнего Востока и СНГ. В ИТ-портфеле «ИКС холдинга» уже есть производитель вычислительной техники YADRO, разработчик решений СОРМ ГК «Цитадель», научно-исследовательская группа компаний «Криптонит», разработчик решений в области информационной безопасности ГК «Гарда» и разработчик низкоорбитальных спутниковых систем связи «Бюро 1440». Как рассказал Алексей Шелобков, холдинг развивает телекомпродукты, в том числе через приобретение активов.

20.03.2025 [01:10], Владимир Мироненко

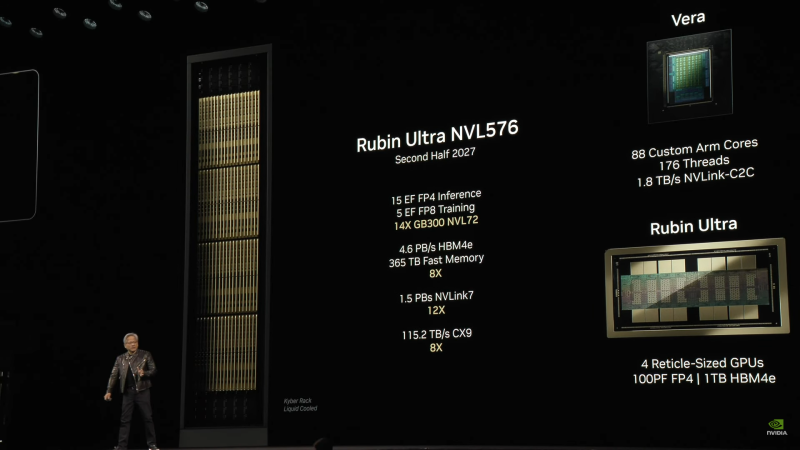

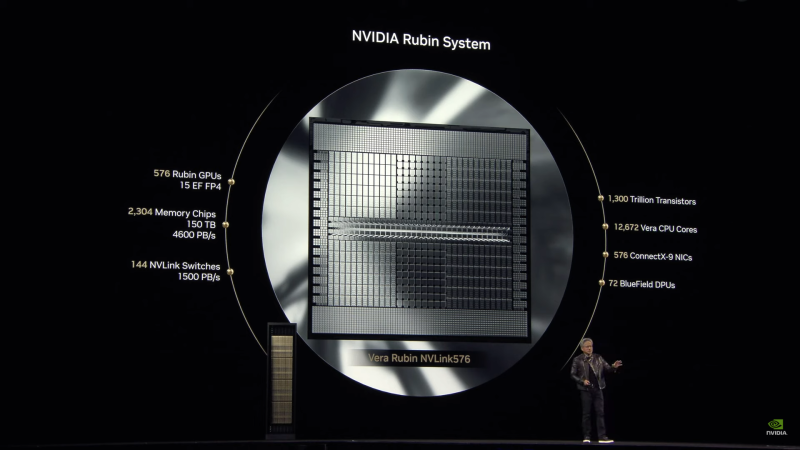

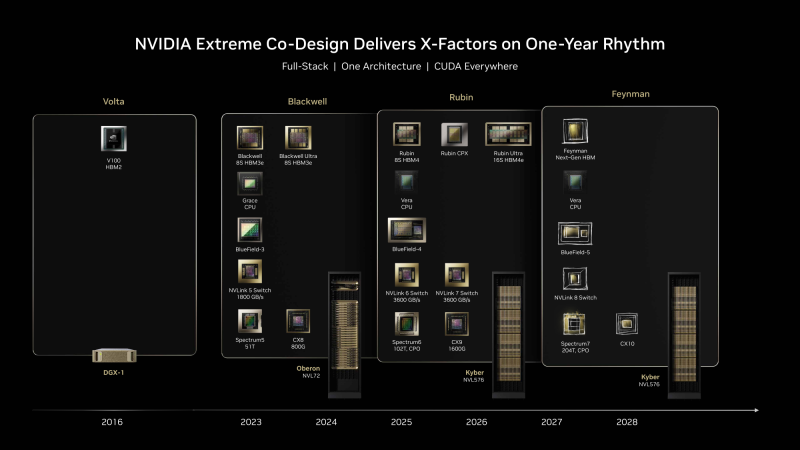

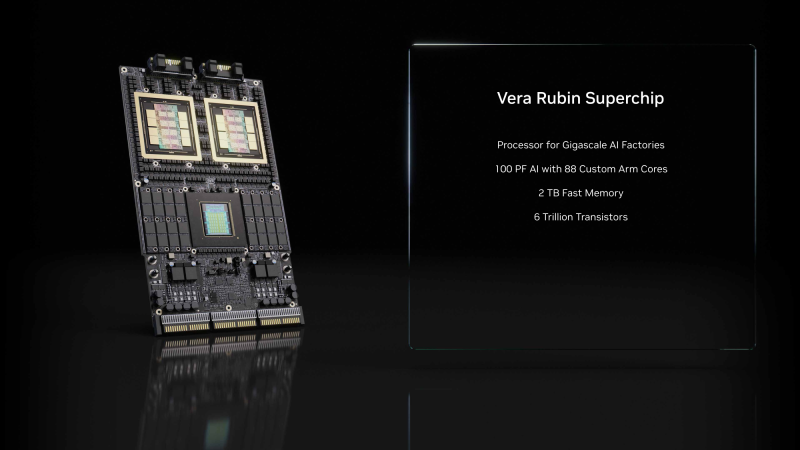

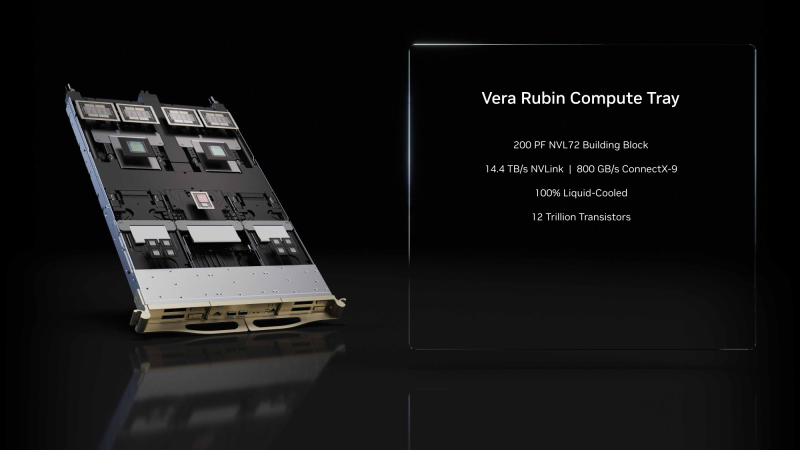

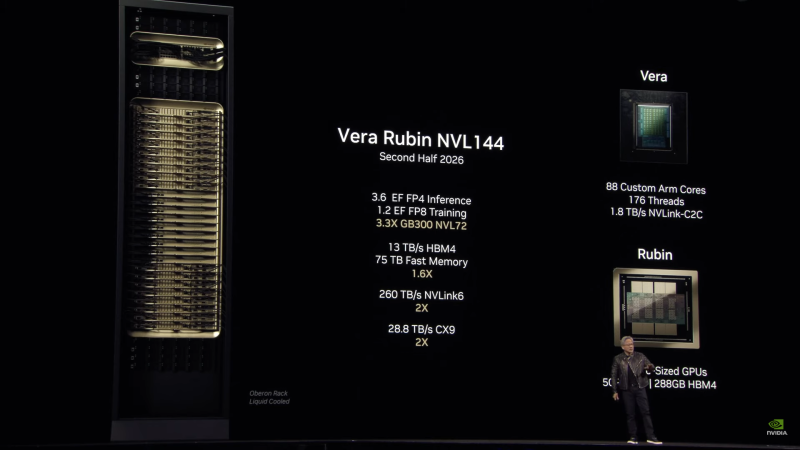

Анонсированы суперускорители на Rubin и Rubin Ultra, в которых NVIDIA не будет ошибаться в подсчётахNVIDIA анонсировала ИИ-ускорители следующего поколения Rubin, которые придут на смену Blackwell Ultra во II половине 2026 года. Выход Rubin Ultra запланирован на II половину 2027 года. Компанию им составят Arm-процессоры Vera. Серия названа в честь астронома Веры Купер Рубин (Vera Florence Cooper Rubin), известной своими исследованиями тёмной материи. NVIDIA отметила, что в названии предыдущих ускорителей была «допущена ошибка». В Blackwell каждый чип состоит из двух GPU, но, например, в названии GB200/GB300 NVL72 упоминается только 72 GPU, хотя речь фактически идёт о 144 GPU. Поэтому, начиная с Rubin компания будет использовать новую схему наименований, которая больше не учитывает количество чипов, а относится исключительно к количеству GPU. Таким образом, следующее поколение суперускорителей, упакованных в ту же стойку Oberon, что используется для Grace Blackwell, получило название Vera Rubin NVL144. Rubin во многом повторяет дизайн Blackwell, поскольку R200 всё так же включает два кристалла GPU (в составе SXM7), способных выдавать до 50 Пфлопс в вычислениях FP4 (без разреженности), и 288 Гбайт памяти в восьми стеках 12-Hi, но на этот раз уже HBM4 с общей пропускную способностью 13 Тбайт/с (2048-бит шина). Кристаллы GPU будут изготовлены по техпроцессу TSMC N3P, а компанию им составят два IO-чиплета, отвечающие за все внешние коммуникации, пишет SemiAnalysis. Всё вместе будет упаковано посредством CoWoS-L. TDP новинок не указывается.

Источник изображений: NVIDIA Чипы перейдут на интерконнект NVLink 6 со скоростью 1,8 Тбайт/с в каждую сторону (3,6 Тбайт/с в дуплексе), что вдвое выше, чем у текущего поколения NVLink 5. Аналогичным образом вырастет и коммутационная способность NVSwitch, а также NVLink C2C. Впрочем, при сохранении прежней схемы, когда один CPU обслуживает два модуля GPU, каждому из последних, по-видимому, достанется половина пропускной способности шины. Собственно процессор Vera получит 88 кастомных (а не Neoverse CSS в случае Grace) 3-нм Arm-ядра, причём с SMT, что даст 176 потоков. Каждый CPU получит порядка 1 Тбайт LPDDR-памяти и будет вдвое быстрее Grace при теплопакете в районе 50 Вт. По словам NVIDIA, VR200 NVL144 будет в 3,3 раза быстрее: 3,6 Эфлопс в FP4-вычислениях для инференса и 1,2 Эфлопс в FP8 для обучения. Суммарный объём HBM-памяти составит более 20,7 Тбайт, системной памяти — 75 Тбайт. Внешняя сеть будет представлена адаптерами ConnectX-9 SuperNIC со скоростью 1,6 Тбит/с на порт, что вдвое больше, чем у ConnectX-8, обслуживающих GB300. Во II половине 2027 года появится ускоритель Rubin Ultra (R300) с FP4-производительностью более 100 Пфлопс (без разреженности), объединяющий сразу четыре GPU, два IO-чиплета и 16 стеков HBM4e-памяти 16-Hi общим объёмом 1 Тбайт (32 Тбайт/с) в упаковке SXM8. Более того, ускорители, по-видимому, получат ещё и LPDDR-память. Процессор Vera перекочует в новую платформу без изменений, один CPU будет приходиться на четыре GPU. Внутренней шиной станет NVLink 7, которая сохранит скорость NVLink 6, зато получит вчетверо более производительные коммутатор NVSwitch. А вот внешнее подключение по-прежнему будут обслуживать адаптеры ConnectX-9. Новая стойка Kyber полностью поменяет компоновку. Узлы теперь напоминают вертикальные блейд-серверы, используемые в суперкомпьютерах. Каждый узел (VR300) будет включать один процессор Vera и один ускоритель Rubin Ultra. Всего таких узлов будет 144, что в сумме даёт 144 CPU, 576 GPU и 144 Тбайт HBM4e. Суперускоритель Rubin Ultra NVL576 будет потреблять 600 кВт и обеспечит быстродействие в 15 Эфлопс для инференса (FP4) и 5 Эфлопс для обучения (FP8). При этом упоминается, что объём быстрой (fast) памяти составит 365 Тбайт, но сколько из них достанется CPU, не уточняется. Дальнейшие планы NVIDIA включают выход во II половине 2028 года первого ускорителя на новой архитектуре Feynman, названной в честь физика-теоретика Ричарда Филлипса Фейнмана (Richard Phillips Feynman). Сообщается, что Feynman будет полагаться на память HBM «следующего поколения» и, вероятно, на CPU Vera. Это поколение также получит коммутаторы NVSwitch 8 (NVL-Next), сетевые коммутаторы Spectrum7 и адаптеры ConnectX-10. UPD: осенью компания представила соускорители Rubin CPX для масштабных задач ИИ-инференса, которые дополняют платформу Vera Rubin. Эти чипы будут доступны как в составе гибридной платформы NVIDIA Vera Rubin NVL144 CPX (144 × Rubin CPX + 144 × Rubin + 36 × Vera), так и в виде двухстоечного решения: Vera Rubin NVL144 CPX + Vera Rubin NVL144. |

|