Материалы по тегу: s

|

24.11.2023 [17:17], Сергей Карасёв

AWS всё активнее использует оборотную воду для охлаждения дата-центровОблачная платформа Amazon Web Services (AWS), по сообщению ресурса Datacenter Dynamics, переводит системы охлаждения в своих ЦОД на сточные воды. Технология уже используется примерно на 20 площадках компании, а в перспективе её внедрение расширится. Дата-центры обычно расходуют воду из питьевых источников, которая многократно циркулирует в контурах охлаждения. Из-за накопления бактерий и известкового налёта воду обрабатывают специальными химическими веществами, что делает её непригодной для дальнейшего использования в обычных бытовых целях. Точное количество питьевой воды, используемой индустрией ЦОД, неизвестно, но, по оценкам, оно исчисляется миллиардами литров в год. Новая технология AWS предполагает повторное применение сточных вод, которые проходят трехэтапный процесс очистки: при этом удаляются 99 % всех примесей и бактерий. После того, как такая вода проходит через систему охлаждения, она снова попадает на станцию очистки для прохождения следующего цикла фильтрации.

Источник изображения: AWS На сегодняшний день AWS применят комплекс очистки сточных вод в 16 дата-центрах в Вирджинии и на нескольких объектах в Санта-Кларе (Калифорния). В целом, компания управляет более чем 100 площадками по всему миру, а ещё десятки находятся в разработке. В конце 2022 года AWS заявила о намерении добиться положительного водного баланса к 2030 году: компания будет отдавать больше чистой воды, чем потреблять. Аналогичные инициативы реализуют и другие гиперскейлеры. Так, Google ранее заявляла, что использует очищенную или непитьевую воду более чем в 25 % кампусов ЦОД. Microsoft также пообещала добиться положительного водного баланса к 2030-му: корпорация использует оборотную воду в своих дата-центрах в Сан-Хосе (Калифорния), Куинси (Вашингтон), Техасе и Сингапуре. К концу десятилетия отдавать больше чистой воды, чем расходовать рассчитывает и Meta✴. А европейские дата-центры планируют снизить потребление воды до 400 мл/кВт·ч к 2040 году.

24.11.2023 [17:14], Сергей Карасёв

Лос-Аламосская национальная лаборатория внедрит обновлённые ИИ-системы SambaNovaЛос-Аламосская национальная лаборатория (LANL) Министерства энергетики США (DOE) заключила соглашение о сотрудничестве со стартапом SambaNova Systems, который специализируется на разработке ИИ-решений. Финансовые условия договора не раскрываются, но ранее стартап уже поставлял LANL свои решения. В рамках партнёрства LANL расширит применение программно-аппаратных комплексов SambaNova DataScale. Речь идёт о системе DataScale SN30, содержащей восемь ускорителей собственной разработки Cardinal SN30, суммарно имеющих 5 Гбайт SRAM и 8 Тбайт DRAM. Конфигурация комплекса может включать от одного до трёх узлов SN30. Кроме того, LANL внедрит решение SambaNova Suite для генеративного ИИ. Эта платформа предоставляет различные ИИ-модели, оптимизированные для корпоративных и государственных организаций. Они могут быть развёрнуты локально или в облаке с возможностью адаптации к собственному набору данных заказчика.

Источник изображения: SambaNova Новое многолетнее соглашение между LANL и SambaNova является расширением действующего партнёрства между сторонами. Лаборатория будет использовать технологии SambaNova для решения широкого спектра задач, связанных с ИИ и большими языковыми моделями (LLM), в том числе в интересах национальной безопасности. Отмечается, что платформа SambaNova Suite предлагает быстрый и эффективный способ развёртывания генеративного ИИ для реализации самых сложных проектов.

23.11.2023 [09:00], Сергей Карасёв

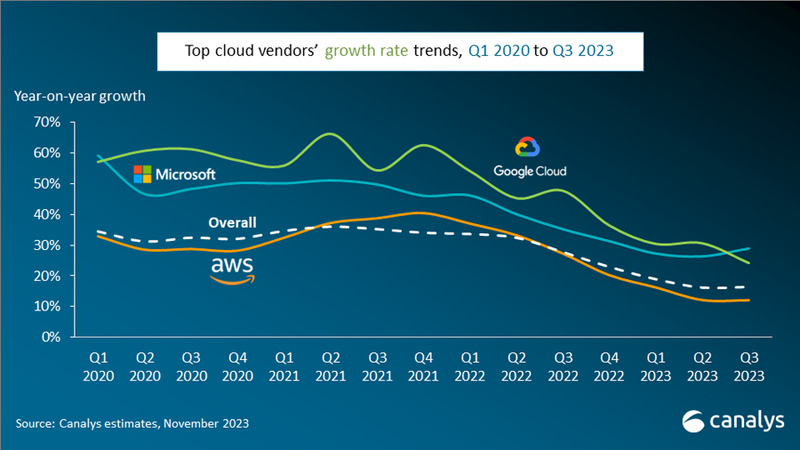

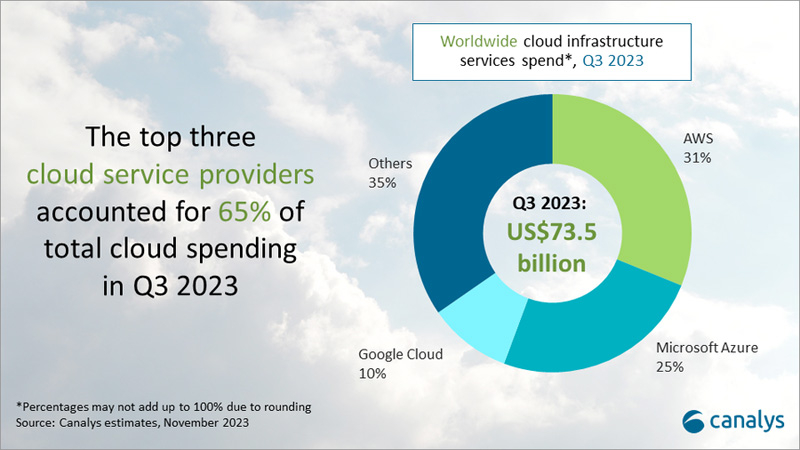

Мировой облачный рынок стабилизируется: квартальные затраты выросли на 16 %Компания Canalys представила результаты исследования глобального облачного рынка в III квартале 2023 года. Аналитики отмечают, что отрасль стабилизируется после макроэкономических потрясений, спровоцировавших сокращение расходов на IT в корпоративном секторе. С июля по сентябрь включительно мировые затраты на облачные сервисы достигли $73,5 млрд, что на 16 % больше прошлогоднего результата. Несмотря на то, что предприятия продолжают оптимизировать общие расходы, сектор облачных технологий начинает проявлять признаки устойчивости, чему отчасти способствует растущий интерес к ИИ.

Источник изображений: Canalys В III квартале 2023 года тройка крупнейших поставщиков облачных услуг — Amazon Web Services (AWS), Microsoft Azure и Google Cloud — совокупно увеличила выручку на 20 %, что больше среднего показателя по рынку в целом. На долю названных площадок пришлось 65 % от общего объёма отрасли в денежном выражении. Лидером рынка остаётся AWS с долей приблизительно 31 %. Эта платформа показала рост на уровне 12 % в годовом исчислении, что ниже общеотраслевого значения. AWS раскрыла планы по открытию новых дата-центров в Южной Корее и Малайзии в ответ на растущий спрос на облачные вычисления в этих регионах. Усилия компании по сокращению затрат и повышению эффективности привели к существенному увеличению прибыли в III квартале 2023 года.  На втором месте в рейтинге ведущих облачных провайдеров находится Microsoft Azure с долей около 25 % и ростом на 29 % по сравнению с III четвертью 2022 года. Одним из главных катализаторов для расширения бизнеса Azure стало стремительное развитие ИИ-технологий, в том числе генеративных систем. Microsoft запустила новую программу AI Cloud Partner, которая помогает партнёрам в создании и внедрении решений на основе ИИ, а также в масштабировании бизнеса. Замыкает тройку Google Cloud: доля этой платформы достигла 10 % на фоне роста на 24 % в годовом исчислении. Однако динамика оказалась ниже ожиданий, и это был первый случай, когда темпы роста Google Cloud упали ниже аналогичных показателей Microsoft Azure за последние три года.

23.11.2023 [01:50], Руслан Авдеев

Amazon задумала обучить 2 млн человек работе с ИИКомпания Amazon Web Services (AWS) представила новую инициативу AI Ready, благодаря которой она намерена привить 2 млн человек навыки работы с искусственным интеллектом (ИИ) к 2025 году. Как сообщает Silicon Angle, компания хочет обеспечить доступ к образованию в сфере ИИ всем, кто желает учиться. У компании уже есть более 80 курсов, связанных с ИИ. В компании уверены, что ИИ стал самой «преобразующей» технологией нынешнего поколения, поэтому AWS намерена раскрыть её полный потенциал для решения самых серьёзных мировых проблем. AWS создаст несколько бесплатных обучающих онлайн-курсов. Три разработаны для обучающихся без опыта программирования, а прочие предназначены для разработчиков. Большинство курсов включают материалы, помогающие ознакомиться с ИИ-сервисами самой AWS.

Источник изображения: Alexandra_Koch/pixabay.com Вводный курс Introduction to Generative Artificial Intelligence даёт представление об основных концепциях генеративного ИИ и сферах его применения. Ещё два курса для новичков связаны с более подробным изучением предмета. Один предназначен для обучения бизнес-лидеров планированию проектов в области генеративного ИИ, второй представляет собой введение в использование сервиса AWS CodeWhisperer, позволяющего писать программы с помощью речевых запросов. Пять курсов для разработчиков обещают углубленное изучение вопроса. Три связаны с коллекцией моделей Amazon Bedrock, сервисом Amazon Transcribe и набором инструментов Amazon SageMaker, которые разработчики смогут применять для создания, запуска и внедрения нейросетей. Ещё два курса для чуть более опытных слушателей посвящены тюнингу запросов к ИИ для получения оптимальных результатов и подготовке данных для обучения и внедрения ИИ-моделей. Кроме того, AWS представит ещё две программы обучения в партнёрстве с Udacity и Code.org. AWS Generative AI Scholarship предоставит стипендии старшеклассникам и студентам на общую сумму более $12 млн и доступ к разработанному AWS курсу на платформе Udacity. А Code.org получит «облачные кредиты» на сумму до $8 млн. Организация будет использовать инфраструктуру AWS для поддержки инициативы Hour of Code, призванной обучить слушателей навыкам программирования. В рамках сотрудничества AWS представит версию Hour of Code с акцентом на ИИ-навыки.

21.11.2023 [09:56], Сергей Карасёв

MSI представила GPU-серверы с жидкостным охлаждением на AMD EPYC Genoa и Intel Xeon Sapphire RapidsКомпания MSI на конференции по высокопроизводительным вычислениям SC23 представила новые серверы на процессорах AMD EPYC Genoa и Intel Xeon Sapphire Rapids. Устройства ориентированы на дата-центры и подходят для НРС-нагрузок, генеративного ИИ и других ресурсоёмких задач. Одна из новинок — платформа G4201, которая допускает установку двух чипов Xeon Sapphire Rapids и 32 модулей оперативной памяти DDR5. Этот сервер формата 4U располагает восемью слотами PCIe 5.0 x16 для ускорителей высотой в два слота, а также двумя PCIe 5.0 x16 для карт толщиной в один слот. Дебютировал также сервер G4101 типоразмера 4U. Он рассчитан на один чип EPYC Genoa (до 128 ядер; TDP до 500 Вт) и 12 модулей DDR5-4800. Возможно применение жидкостного охлаждения. Доступны четыре разъёма PCIe 5.0 х16 для трёхслотовых ускорителей и ещё два разъёма PCIe 5.0 x16. Во фронтальной части расположены отсеки для 12 накопителей U.2 NVMe или SAS/SATA (SFF). Кроме того, предусмотрены два коннектора M.2 M-Key (2280/22110, PCIe 3.0 x4/x2). Питание обеспечивают два блока мощностью 3000 Вт каждый. Ещё одна новинка — модель G3101, получившая исполнение 3U. Она допускает установку одного процессора EPYC 7002/7003 с 64 ядрами (до 300 Вт) и восьми модулей DDR4-3200. Поддерживается развёртывание СЖО. Есть шесть отсеков для SFF-накопителей с интерфейсом SATA-3 и четыре слота PCIe 4.0 x16 для карт FHFL. Предусмотрены два сетевых порта 10GbE на базе Intel X710AT2. В оснащение включены два блока питания на 1600 Вт.  Кроме того, MSI анонсировала два сервера с поддержкой Compute Express Link (CXL) — модели S1301 и S2302, оптимизированные для задач с интенсивным использованием данных. Характеристики версии S1301 формата 1U таковы: два процессора EPYC 9004 (Genoa) с 32 ядрами и TDP до 210 Вт, 24 слота для модулей DDR5-4800, два разъёма PCIe 5.0 x16 для ускорителей HHHL, 10 отсеков для накопителей E3.S CXL, два коннектора M.2 M-Key 2280 (PCIe 3.0 x2) и два блока питания мощностью 1600 Вт.  В свою очередь, сервер S2302 стандарта 2U поддерживает два чипа Xeon Sapphire Rapids (до 60 ядер; 350 Вт), 32 модуля DDR5-4800, три ускорителя PCIe 5.0 x16 FHFL и две карты PCIe 5.0 x16 HHHL. Накопители могут устанавливаться по схеме 8 × E3.S CXL и 2 × E3.S PCIe 5.0 SSD или 10 × E3.S PCIe 5.0 SSD. Применены два блока питания на 1600 Вт.

21.11.2023 [08:21], Сергей Карасёв

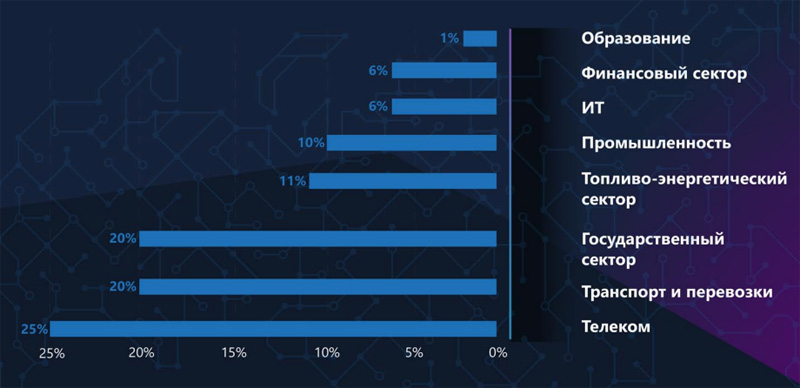

Две трети DDoS-атак в России приходится на телеком-операторов, транспорт и госсекторКомпания «Гарда» обнародовала результаты исследования, в ходе которого изучались ландшафт и особенности DDoS-атак в России в III квартале 2023 года. Аналитики зафиксировали рост интенсивности атак, реализующих TCP-флуд. В результате, увеличивается количество нападений на сервисы. В отчёте говорится, что по сравнению со II четвертью текущего года значительно выросла доля TCP SYN-флуда, достигнув 60 %. На втором месте в рейтинге наиболее распространённых DDoS-атак с показателем 20 % находится TCP ACK-флуд. UDP-флуд занимает третью позицию: при этом его доля сократилась с 27 % до 13 %. На атаки типа DNS Amplification пришлось 3 %, тогда как доля NTP Amplification упала с 9 % до 1 %.

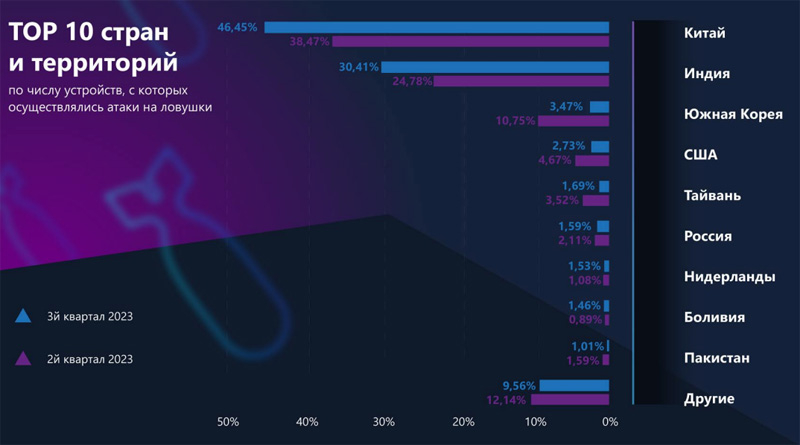

Источник изображений: «Гарда» В III квартале 2023 года с наибольшим количеством DDoS-атак столкнулись российские телекоммуникационные компании: на них пришлось приблизительно 25 % всех подобных нападений. Далее следуют сегмент транспорта/перевозок и государственный сектор с 20 % каждый. Таким образом, на эти три сферы приходится в общей сложности примерно две трети всех DDoS-атак — 65 %. Сравнительно высокие показатели отмечаются по топливно-энергетическому комплексу (11 %) и промышленности (10 %), что может говорить о попытке воздействия на сектор реальной экономики. Шестое и седьмое места занимают IT-сфера (6 %) и финансовый сектор (6 %), которые также являются традиционными целями злоумышленников. Далее идёт образование с 1 %.  В рейтинге стран, из которых атакуют российские ловушки (речь о попытках захватить управление ловушкой и расширении ботнет-сетей), по-прежнему лидирует Китай с показателем 46,45 %. Индия увеличила значение до 30,41 % (против 24,78 % во II квартале 2023 года), тогда как Южная Корея показала значительное снижение, сократив долю до 3,5 %. Далее следуют США и Тайвань — 2,7 % и 1,7 % соответственно.

21.11.2023 [00:34], Руслан Авдеев

Cerebras раскритиковала NVIDIA за «вооружение» Китая ИИ-ускорителямиГлава Cerebras Эндрю Фельдман (Andrew Feldman) подверг критике NVIDIA за попытки компании уложиться в нормы, установленные новыми экспортными ограничениями США в отношении Китая, чтобы продолжить поставки ИИ-ускорителей в Поднебесную. Как передаёт The Register, такое поведение Фельдман назвал «неамериканским» и сравнил техногиганта с торговцем ИИ-оружием. По словам Фельдмана, NVIDIA буквально единолично «вооружила» Китай, поставив огромное количество ускорителей. Хотя компания действовала в рамках закона, это не снимает с неё моральной ответственности. Сама Cerebras тоже разрабатывает чипы для систем машинного обучения и других ресурсоёмких задач, но намерена соблюдать «дух, а не букву» введённых в октябре США новых правил, ограничивающих поставки ИИ-оборудования в США. Правила и без того фактически отрезают Пекин от поставок разработанных в США передовых ускорителей, но уже ходят слухи, что NVIDIA готовит новые продукты для того, чтобы обойти и эти ограничения. Раньше она уже выпустила «ухудшенные» A800 и H800, теперь тоже попавшие под ограничения. Неанонсированные чипы H20, L20 и L2 якобы представляют собой менее производительные версии более быстрых вариантов, поставляющихся для стран, не попавших под санкции. NVIDIA уже предупреждала, что новые ограничения способны сказаться на её финансовых результатах. Вместе с тем сама Cerebras в этом году заключила контракт на $900 млн для строительства девяти ИИ-суперкомпьютеров на чипах WSE-2 для компании G42 из ОАЭ, которую неоднократно обвиняли в связях со структурами, занятых, к примеру, шпионажем в пользу властей ОАЭ. В данном случае компания не усматривает моральной дилеммы. Cerebras с самого начала приняла решение не вести дел с Китаем, а также обещает соблюдать рекомендации американских госорганов, касающиеся поставок полупроводников на Ближний Восток. Фельдман считает, что компании не должны пытаться обойти ограничения. В частности, компания отслеживала, чтобы её чипы «не поставлялись в одно место на Ближнем Востоке, чтобы вскоре исчезнуть и появиться совсем в другом, там, куда они не должны были бы поставляться». Как заявляют в Cerebras, когда вы пытаетесь обойти правила, вы выглядите «не по-американски». Конечно, обойти санкционные ограничения пытается не только NVIDIA, но и, например, Intel, которая ранее в этом году представила ухудшенную версию ускорителей Habana Gaudi для продажи на китайском рынке — правда, новейшие ограничения, похоже, не дадут поставлять в Китай и их. Некоторые сигналы о желании обойти санкции поступают и от AMD, хотя нет точных данных, когда начнутся продажи адаптированных под санкции решений и начнутся ли они вообще.

19.11.2023 [00:09], Сергей Карасёв

Huawei выпустила All-Flash СХД OceanStor Dorado 2100 с доступностью 99,9999 %Компания Huawei анонсировала СХД OceanStor Dorado 2100 типа All-Flash, рассчитанную на применение в сфере среднего и малого бизнеса (СМБ). Среди ключевых преимуществ новинки разработчик называет простоту использования, высокую надёжность и эффективность. Утверждается, что совокупная стоимость владения (TCO) решения на 30 % ниже, чем у аналогов. Huawei заявляет, что на сегодняшний день OceanStor Dorado 2100 предлагает единственную в отрасли NAS-архитектуру для СМБ с контроллерами, работающими в режиме Active–Active. Система рассчитана на круглосуточную эксплуатацию 24/7 с доступностью 99,9999 %.

Источник изображения: Huawei В одном массиве могут быть объединены до восьми контроллеров, каждый из которых оснащён 64 Гбайт кеш-памяти. Для подключения SSD служит интерфейс SAS-3. Поддерживаются накопители вместимостью от 960 Гбайт до 15,36 Тбайт. Возможно формирование массивов RAID 5/6 и RAID-TP. Максимальное количество SSD в массиве достигает 400. Говорится о совместимости с протоколами NFS, SMB/CIFS, NDMP. Реализованы порты FC8/16/32 и 1/10/25GbE. Габариты устройства составляют 447 × 410 × 86,1 мм, масса — не более 30 кг. К каждому узлу с контроллерами можно подключить до четырёх I/O-модулей. Диапазон рабочих температур — от +5 до +35 °C. Среди поддерживаемых функций упомянуты HyperSnap (мгновенные снимки), HyperReplication (удаленная репликация), HyperClone (клонирование), HyperEncryption (шифрование), HyperMetro (разнесённые массивы в режиме Active–Active), HyperCDP (защита данных), SmartCompression (сжатие) и SmartQoS.

19.11.2023 [00:03], Сергей Карасёв

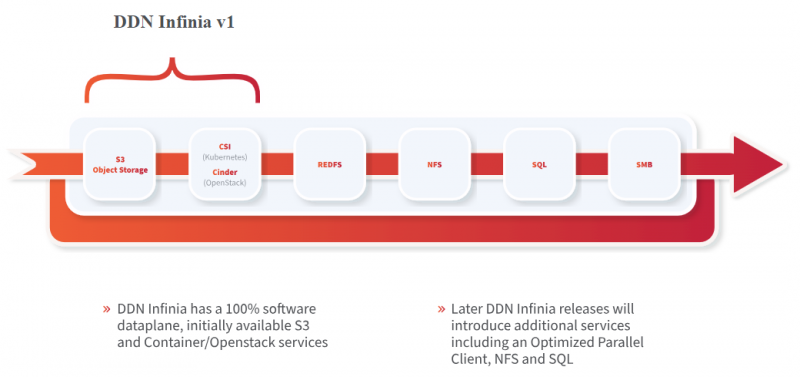

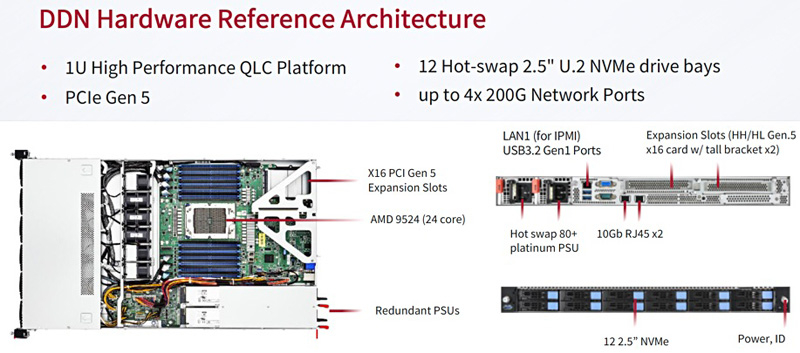

DDN представила масштабируемую All-Flash СХД Infinia для НРС и ИИКомпания DataDirect Networks (DDN), специализирующаяся на платформах хранения данных для НРС-задач, анонсировала масштабируемую СХД Infinia, разработанную в сотрудничестве с Сандийскими национальными лабораториями (SNL) Министерства энергетики США. Infinia — программно-определяемое многопротокольное решение с горизонтальным масштабированием, которое подходит для различных сценариев использования. Это могут быть сложные научные задачи, приложения ИИ, большие языковые модели и пр. Узлами системы могут быть любые серверы с процессорами Intel, Arm или AMD. Говорится, что платформа Infinia может масштабироваться до сотен петабайт. Среди ключевых преимуществ решения разработчик называет простоту управления, высокую производительность и безопасность. Референсная аппаратная платформа представляет собой 1U-узел с 24-ядерным процессором AMD EPYC Genoa. Во фронтальной части предусмотрены отсеки для 12 накопителей SFF формата U.2 (NVMe) с возможностью горячей замены. Предусмотрены два сетевых порта 10GbE и порт 1GbE (все с разъёмами RJ-45), а также слота PCIe 5.0 x16 для HHHL-адаптеров, которые могут предложить до четырёх 200G-портов.

Источник изображения: DDN / StorageNewsletter Шасси имеет габариты 680 × 450 × 44 мм и весит 22,9 кг. СХД оборудована двумя блоками питания мощностью 850 Вт с сертификатом 80 Plus Platinum. В системе воздушного охлаждения применяются шесть вентиляторов. Диапазон рабочих температур — от +10 до +35 °C.

17.11.2023 [21:46], Алексей Степин

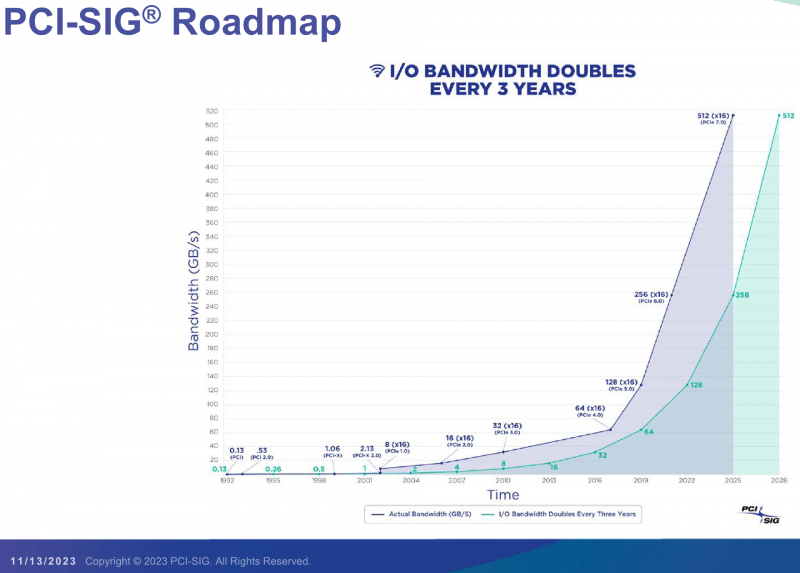

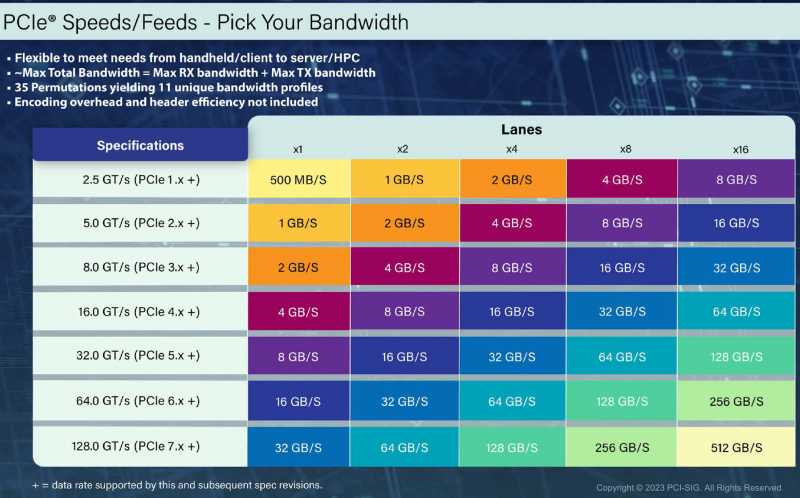

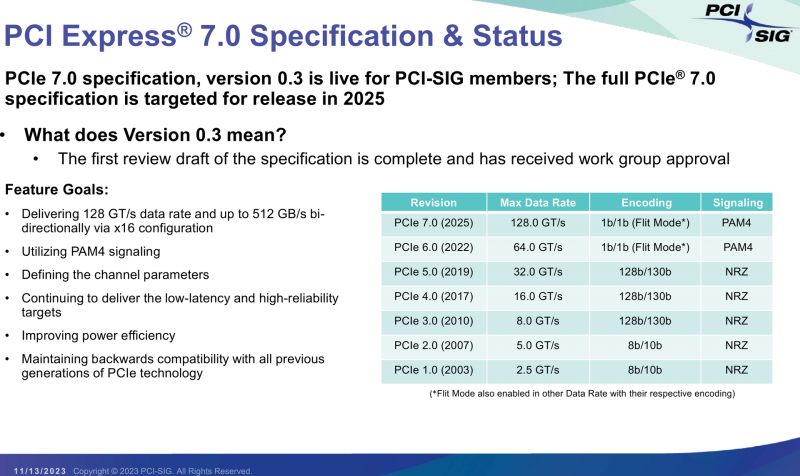

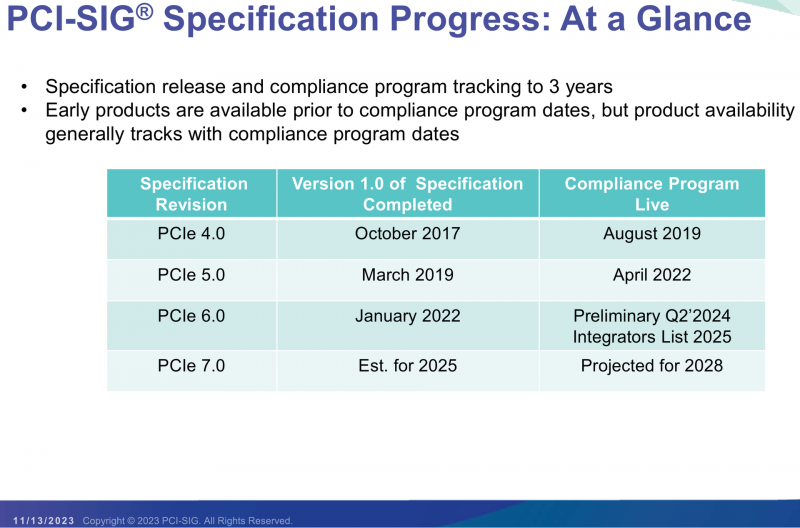

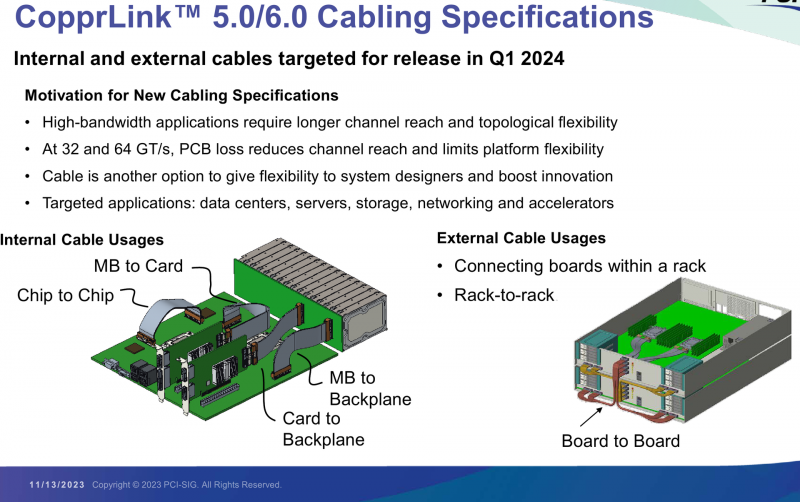

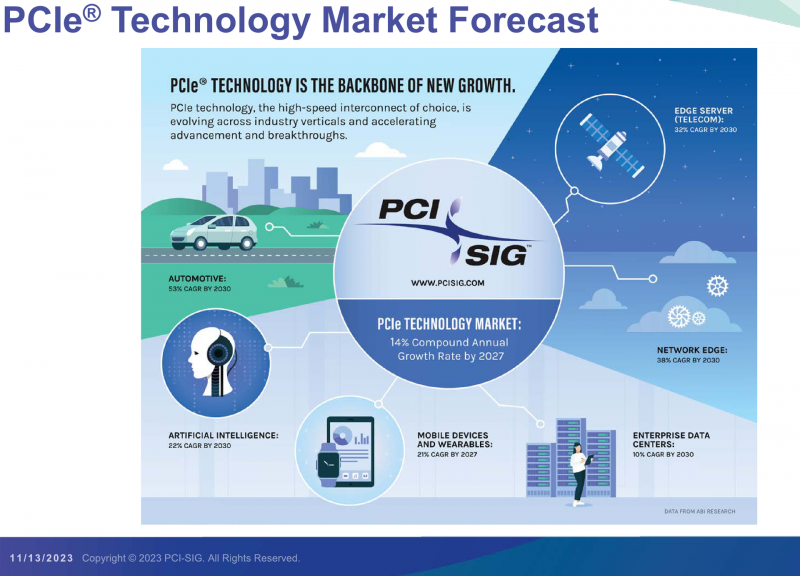

PCI-SIG выпустила предварительные спецификации PCIe 7.0 и анонсировала кабели CopprLinkОрганизация PCI Special Interest Group (PCI-SIG) рассказала о последних планах по развитию интерфейса PCI Express. В числе прочего были опубликованы сведения о новом стандарте кабелей и разъёмов CopprLink для подключений PCIe 5.0/6.0. Основанная в 1992 году организация PCI-SIG опубликовала первые спецификации PCI Express в 2003 году, а сегодня без этого интерфейса невозможно представить себе ни одну мало-мальски мощную вычислительную систему. В PCI-SIG на данный момент входит свыше 950 участников. Планы по развитию PCI Express, простирающиеся до 2028 года, показывают, что разработка новых, более производительных версий шины идёт темпами, позволяющими удовлетворить требования к скорости IO-подсистем, удваивающиеся примерно каждые 3 года. В версии PCIe 7.0 планируется довести этот показатель для x16-подключений до 512 Гбайт/с. Предварительная версия стандарта (релиз 0.3) была сформирована совсем недавно. На данный момент релиз спецификаций PCI Express 7.0 ожидается в 2025 году, а массовое появление новых продуктов на их основе запланировано на 2028 год. Впрочем, первые продукты наверняка появятся чуть раньше. Во II квартале 2024 года ожидается появление первых решений с PCIe 6.0, а массовый характер программа тестирования таких устройств на соответствие стандарту примет лишь в 2025. В августе этого года была сформирована новая рабочая группа PCI-SIG Optical Workgroup, ответственная за разработку оптического интерконнекта на базе PCI Express и взаимодействие с производителями в этой области. Задача заключается в адаптации стека технологий PCIe к оптической среде передачи данных с минимальными изменениями. Новые кабели позволят организовать соединения между стойками в пределах ЦОД в случаях, когда требуется минимальная латентность. Однако полная замена медных кабелей не планируется — оптика дополнит медь там, где нужна большая длина соединения. Поэтому PCI-SIG ведёт разработку нового стандарта электрических кабелей под общим названием CopprLink, который должен будет заменить существующие кабели OCuLink. Возможностей последних для организации внутрисистемного интерконнекта в современных условиях уже не всегда достаточно. Новые серверы и СХД требуют более высокой пропускной способности и гибкости топологии, что учитывается при разработке CopprLink. Эти кабели позволят как обеспечивать высокоскоростные подключения в пределах самих систем, так и соединять между собой шасси в пределах стойки. Разрабатываются и варианты для межстоечного соединения. Вопреки непроверенным слухам, CopprLink не поддерживает передачу сколько-нибудь мощного питания и не является заменой стандарту 12VHPWR. В настоящее время спецификации CopprLink, обеспечивающего работу на скоростях PCIe 5.0/6.0, уже достигли версии 0.9. Полноценный анонс технологии должен состояться в начале 2024 года. Технология PCI Express востребована во многих сегментах, от традиционных серверов и ПК до крупных ЦОД, телеком-платформ, ИИ-кластеров, умного транспорта и даже в мобильных и носимых устройствах. Ожидается, что в период до 2027 показатель CAGR для рынка PCIe-решений составит 14 %, а к концу периода он достинет объёма $10 млрд. Быстрее всего развитие будет идти в секторе автомобильных решений (CAGR 53 % до 2030 года), периферийных сетевых (38 %) и телекоммуникационных (32 %) платформ. |

|