Материалы по тегу: ix

|

30.10.2025 [13:51], Владимир Мироненко

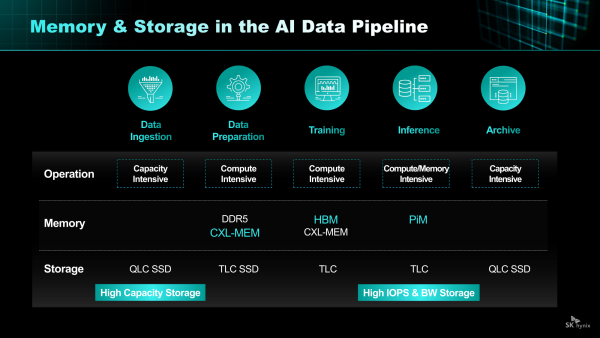

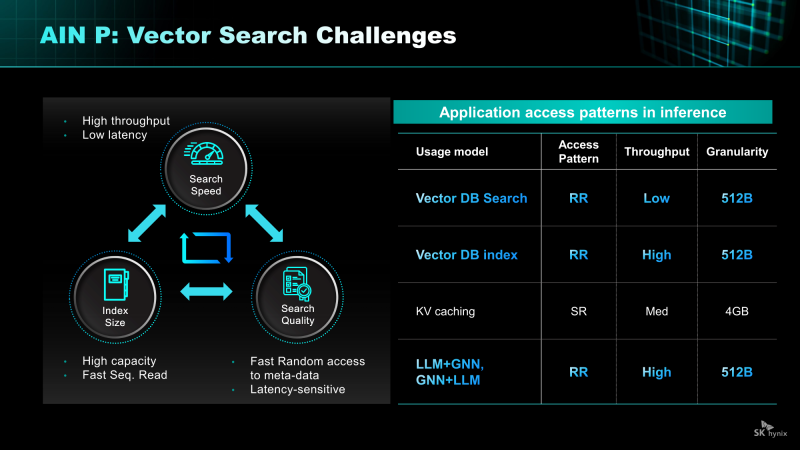

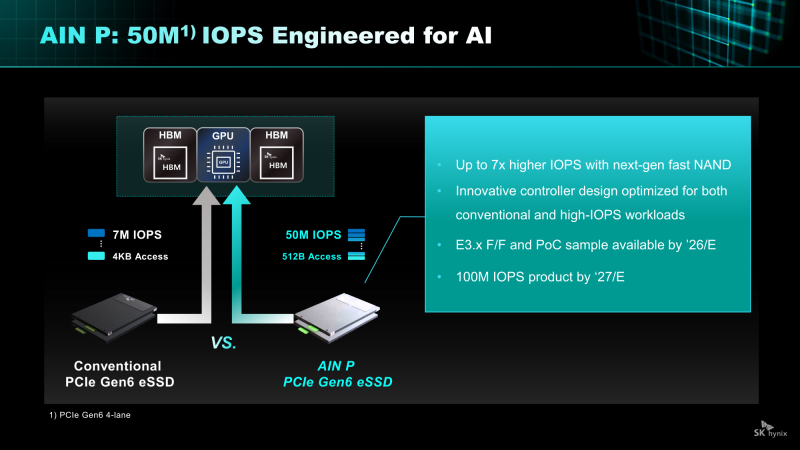

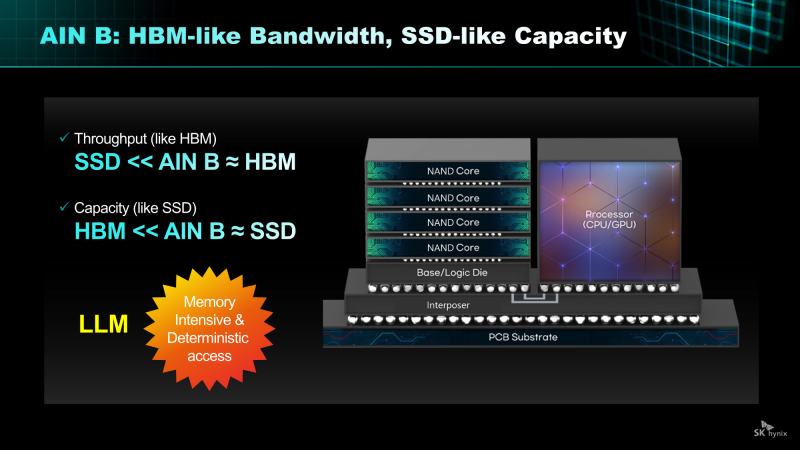

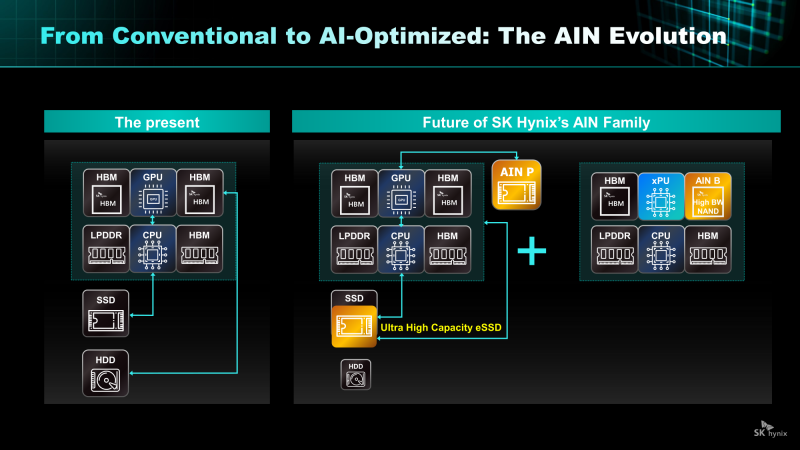

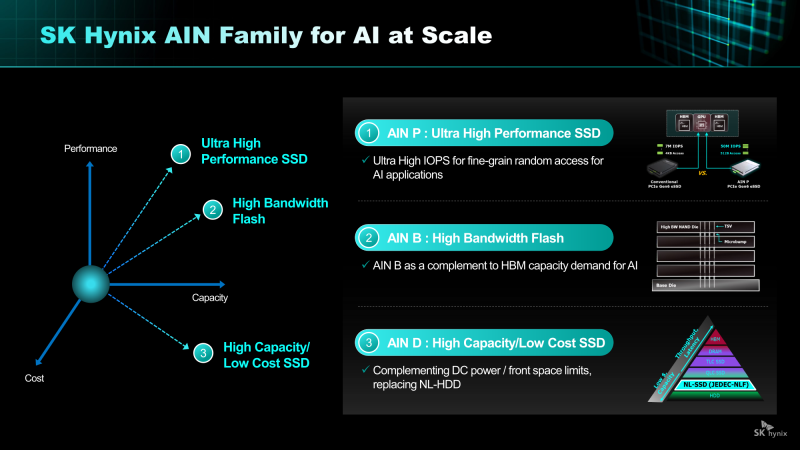

От Nearline SSD до HBF: SK hynix анонсировала NAND-решения AIN для ИИ-платформКомпания SK hynix представила стратегию развития решений хранения на базе NAND нового поколения. SK hynix заявила, что в связи с быстрым ростом рынка ИИ-инференса спрос на хранилища на базе NAND, способных быстро и эффективно обрабатывать большие объёмы данных, стремительно растёт. Для удовлетворения этого спроса компания разрабатывает серию решений AIN (AI-NAND), оптимизированных для ИИ. Семейство будет включать решения AIN P, AIN B и AIN D, оптимизированные по производительности, пропускной способности и плотности соответственно. AIN P (Performance) — это решение для эффективной обработки больших объёмов данных, генерируемых в рамках масштабных рабочих нагрузок ИИ-инференса. Продукт значительно повышает скорость обработки и энергоэффективность, минимизируя узкие места между хранилищем и ИИ-операциями. SK hynix разрабатывает NAND-память и контроллеры с новыми возможностями и планирует выпустить образцы к концу 2026 года. Как пишет Blocks & Files, накопитель AIN P, как ожидается, получит поддержку PCIe 6.0 и обеспечит 50 млн IOPS на 512-байт блоках, тогда как сейчас производительность случайного чтения и записи с 4-Кбайт блоками составляет порядка 7 млн IOPS у накопителей PCIe 6.0. То есть AIN P будет в семь раз быстрее, чем нынешние корпоративные PCIe 6.0 SSD, и, по заявлению SK hynix, достичь 100 млн IOPS можно будет уже в 2027 году. Такой SSD будет выполнен в форм-факторе EDSFF E3.x и оснащён контроллером, предназначенным для выполнения как обычных рабочих нагрузок, так и с высоким показателем IOPS. AIN D (Density) — это высокоплотное решение Nearline (NL) SSD для хранения больших объёмов данных с низкими энергопотреблением и стоимостью, подходящее для хранения ИИ-данных. Компания стремится увеличить плотность QLC SSD с Тбайт до Пбайт, создав решение среднего уровня, сочетающее в себе скорость SSD и экономичность HDD. AIN D от SK hynix как раз предназначен для замены жёстких дисков. Компания также упоминает некий стандарт JEDEC-NLF (Near Line Flash?), который пока не существует. При этом SK hynix пока не упоминает PLC NAND и не приводит данные о ёмкости AIN D. AIN B (Bandwidth) — это HBF-память с увеличенной за счёт вертикального размещения нескольких модулей NAND пропускной способностью. Ключевым в данном случае является сочетание структуры стекирования HBM с высокой плотностью и экономичностью флеш-памяти NAND. AIN B предложит большую ёмкость, чем HBM, примерно на уровне ёмкости SSD. AIN B может увеличить эффективную ёмкость памяти GPU и, таким образом, устранить необходимость покупки/аренды дополнительных GPU для увеличения ёмкости HBM, например, для хранения содержимого KV-кеша. Компания рассматривает различные стратегии развития AIN B, например, совместное использование с HBM для повышения общей ёмкости системы, поскольку стек HBF может быть совмещён со стеком HBM на одном интерпозере. SK hynix и Sandisk работают над продвижением стандарта HBF. Они провели в рамках 2025 OCP Global Summit мероприятие HBF Night, посвящённое этому вопросу. Рании компании подписали меморандум о стандартизации HBF в целях расширения технологической экосистемы. «Благодаря OCP Global Summit и HBF Night мы смогли продемонстрировать настоящее и будущее SK hynix как глобального поставщика решений памяти, процветающего на быстро развивающемся ИИ-рынке», — заявила SK hynix, добавив, что на рынке устройств хранения данных на базе NAND следующего поколения SK hynix будет тесно сотрудничать с клиентами и партнёрами, чтобы стать ключевым игроком.

26.10.2025 [14:20], Сергей Карасёв

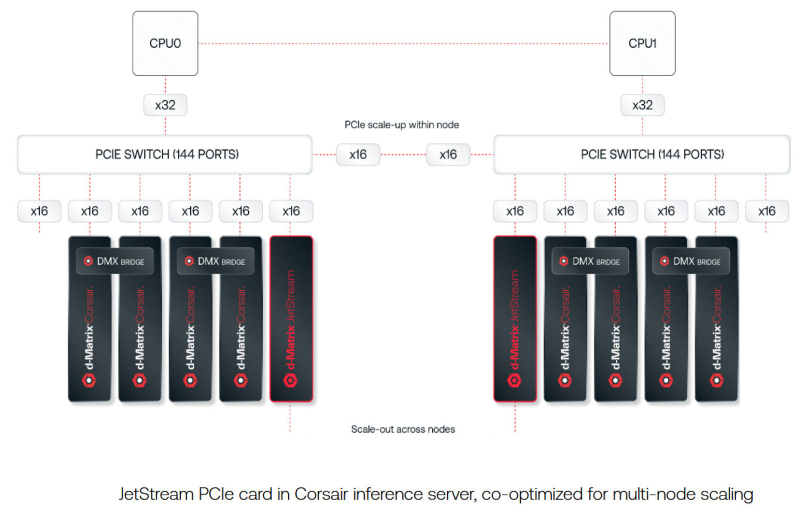

d-Matrix представила систему SquadRack для ИИ-инференса со сверхнизкой задержкойКомпания d-Matrix анонсировала систему SquadRack — стоечное решение для пакетного инференса со сверхнизкой задержкой. Это, как утверждается, первый в отрасли продукт данного класса. В его разработке приняли участие специалисты Arista, Broadcom и Supermicro. В основу SquadRack положена серверная платформа Supermicro X14 AI. Судя по изображениям, используется модель SYS-522GA-NRT, которая допускает установку двух процессоров Intel Xeon 6900 (Granite Rapids) и 24 модулей оперативной памяти DDR5-8800. Доступны 24 фронтальных отсека для SFF-накопителей U.2/U.3 (NVMe). Устройство выполнено в форм-факторе 5U. Система SquadRack предусматривает использование ускорителей d-Matrix Corsair. Их архитектура основана на модифицированных ячейках SRAM для вычислений в памяти (DIMC), работающих на скорости около 150 Тбайт/с. По заявлениям d-Matrix, решение обеспечивает непревзойдённую производительность ИИ-инференса: быстродействие достигает 2,4 Пфлопс (8-бит вычисления). Кроме того, задействованы IO-карты d-Matrix JetStream, предназначенные для распределения нагрузок инференса. Одна такая карта может обслуживать до четырёх экземпляров Corsair, обеспечивая сетевую задержку на уровне 2 мкс. Решение SquadRack также оборудовано PCIe-коммутаторами Broadcom для масштабирования в пределах одного узла. В свою очередь, связь между узлами обеспечивают коммутаторы Arista Leaf Ethernet, подключённые к картам JetStream. Применяется программный стек d-Matrix Aviator. В одну стойку могут быть установлены до восьми экземпляров SquadRack, что позволяет с высокой скоростью обрабатывать модели ИИ, насчитывающие до 100 млрд параметров. В целом, возможно масштабирование до сотен узлов в нескольких серверных стойках.

17.10.2025 [10:47], Сергей Карасёв

SK hynix показала 245-Тбайт SSD серии PS1101 для дата-центровКомпания SK hynix в ходе мероприятия Dell Technologies Forum 2025 в Сеуле (Южная Корея) продемонстрировала свои новейшие SSD, оптимизированные для высокопроизводительных серверов и дата-центров для ИИ. В частности, показаны устройства PEB110, PS1010, PS1012 и PS1101.

Источник изображения: SK hynix Особого внимания заслуживает накопитель PS1101. Это решение, выполненное в форм-факторе E3.L, вмещает 245 Тбайт информации. Новинка ориентирована на крупномасштабные ИИ ЦОД и облачные среды, где критически важны высокая плотность хранения данных и энергоэффективность. В основу SSD положены чипы флеш-памяти QLC NAND, а для подключения служит интерфейс PCIe 5.0 х4. Скоростные показатели и величина IOPS пока не раскрываются. Устройству PS1101 предстоит конкурировать с другими SSD аналогичной ёмкости, о подготовке которых уже сообщили некоторые игроки рынка. В частности, Kioxia в июле нынешнего года анонсировала накопитель серии LC9 типоразмера EDSFF E3.L, рассчитанный на хранение 245,76 Тбайт данных. Кроме того, Sandisk представила NVMe SSD UltraQLC SN670 объёмом 256 Тбайт, предназначенный для ИИ-систем и НРС-платформ. А компания Samsung проектирует SSD с интерфейсом PCIe 6.0, вместимость которых будет достигать 512 Тбайт. Возвращаясь к новинкам SK hynix, можно выделить изделие PS1012 в форм-факторе U.2, которое вмещает до 61,44 Тбайт данных. Устройство выполнено на чипах флеш-памяти QLC NAND и оснащено интерфейсом PCIe 5.0 х4. В свою очередь, модель PEB110 типоразмера E1.S имеет вместимость до 8 Тбайт: этот продукт базируется на чипах TLC NAND с подключением посредством PCIe 5.0 х4. Наконец, изделие PS1010 получило исполнение E3.S, чипы TLC NAND, интерфейс PCIe 5.0 х4 и ёмкость до 15 Тбайт.

17.10.2025 [08:46], Руслан Авдеев

Поддерживаемый Equinix разработчик малых ядерных реакторов Radiant начнёт строительство своего первого завода уже в 2026 годуАмериканская Radiant, занимающаяся разработкой малых модульных реакторов (SMR) и поддерживаемая Equinix, объявила о создании своего первого производства SMR на площадке Манхэттенского проекта в Ок-Ридже (Oak Ridge, шт. Теннеси), сообщает Datacenter Dynamics. Строительство завода R-50 стартует в начале 2026 года. Компания намерена поставить первый серийный реактор Kaleidos к 2028 году и в течение нескольких лет нарастить производство до 50 реакторов ежегодно. Сейчас Radiant работает над моделью Kaleidos, высокотемпературным реактором с газовым охлаждением, использующим топливо TRISO, гелиевый теплоноситель и призматические графические сборки. Radiant утверждает, что модульная контейнеризированная SMR-платформа может быть развёрнута всего за несколько дней. Пока компания ведёт переговоры с Комиссией по ядерному регулированию США (NRC). Не так давно она вошла в число 11 проектов программы Министерства энергетики США (DoE) по пилотному внедрению новых ядерных технологий. Компания завершила работы по основному проектированию и подготовке эксперимента для прототипа Kaleidos с целью начать лабораторные испытания уже в середине 2026 года.

Источник изображения: Radiant В августе 2025 года подписано соглашение с Equinix о поставке оператору ЦОД 20 SMR. Тогда же компания подписала контракт на сумму £4 млн ($5,1 млн) с компанией Urenco, занимающейся обогащением урана. Предполагается поставка в США высококачественного уранового топлива HALEU. Индустрия ЦОД стала одним из крупнейших инвесторов в передовые ядерные технологии. Участники полагают, что они могут стать ключевым источником энергии для обеспечения базовой мощности. За последний год с разработчиками SMR подписали соглашения Amazon, Google, Data4, Oracle, Switch и Endeavour.

01.10.2025 [18:15], Руслан Авдеев

OpenAI построит ИИ ЦОД Stargate в Южной Корее, а Samsung поможет ей создать плавучие дата-центрыOpenAI подписала с Samsung Electronics и SK hynix письмо о намерениях, предусматривающее поставку чипов памяти знаменитому ИИ-стартапу. Дополнительно сообщается о намерении построить ЦОД Stargate на юго-западе Южной Кореи при участии SK Group. Кроме того, SK Telecom создаёт независимую ИИ-компанию с инвестициями $3,5 млрд в течение пяти лет. В рамках сотрудничества южнокорейские компании планируют нарастить выпуск DRAM — до 900 тыс. пластин в месяц, которые понадобятся для передовых моделей OpenAI. Samsung и её дочерние структуры Samsung SDS, Samsung C&T (Construction and Trading) и Samsung Heavy Industries помогут в реализации проекта Stargate Korea, в том числе со строительством и эксплуатацией ЦОД, облачными сервисами, консалтингом, а также внедрением и управлением сервисами для бизнесов, желающих интегрировать ИИ-модели OpenAI в свои внутренние системы. Упоминаются даже судостроение и морское дело. В частности, сотрудничество предусматривает совместную разработку плавучих ЦОД. Подобные объекты имеют определённые преимущества перед традиционными, поскольку им не требуется свободных участков земли, лишних расходов на охлаждение и углеродные выбросы таких проектов обычно невелики. Компании также изучают возможности создания плавучих электростанций и центров управления.

Источник изображения: Mathew Schwartz/unsplash.com Проект Stargate был запущен OpenAI в январе, при содействии Oracle, SoftBank, и MGX из Абу-Даби и уже заработали его первые ЦОД. Планируется инвестировать $500 млрд в цифровую инфраструктуру в следующие четыре года для обслуживания вычислительных потребностей OpenAI. На прошлой неделе OpenAI анонсировала строительство новых ЦОД Stargate в США, включая дата-центры в Техасе, Нью-Мексико и на Среднем Западе. Планируется реализация проектов Stargate и в других странах помимо Южной Кореи, например — в Великобритании и Норвегии.

15.09.2025 [11:44], Сергей Карасёв

SK hynix завершила разработку памяти HBM4 для ИИ-системКомпания SK hynix объявила о том, что она первой среди участников отрасли завершила разработку памяти с высокой пропускной способностью HBM4 для ИИ-систем. В настоящее время готовится организация массового производства таких изделий. HBM4 — это шестое поколение памяти данного типа после оригинальных решений HBM, а также HBM2, HBM2E, HBM3 и HBM3E. Ожидается, что чипы HBM4 будут применяться в продуктах следующего поколения AMD, Broadcom, NVIDIA и др. Стеки памяти HBM4 от SK hynix оснащены 2048-бит IO-интерфейсом: таким образом, разрядность интерфейса HBM удвоилась впервые с 2015 года. Заявленная скорость передачи данных превышает 10 Гбит/с, что на 25 % превосходит значение в 8 Гбит/с, определённое официальным стандартом JEDEC. Пропускная способность HBM4 увеличилась вдвое по сравнению с предыдущим поколением НВМ, тогда как энергоэффективность повысилась на 40 %.

Источник изображения: SK hynix При изготовлении чипов HBM4 компания SK hynix будет применять 10-нм технологию пятого поколения (1bnm) и методику Advanced Mass Reflow Molded Underfill (MR-MUF). Последняя представляет собой способ объединения нескольких чипов памяти на одной подложке посредством спайки: сразу после этого пространство между слоями DRAM, базовым кристаллом и подложкой заполняется формовочным материалом для фиксации и защиты структуры. Технология Advanced MR-MUF позволяет выдерживать высоту HBM-стеков в пределах спецификации и улучшать теплоотвод энергоёмких модулей памяти. SK hynix не раскрывает ни количество слоёв DRAM в своих изделиях HBM4, ни их ёмкость. Как отмечает ресурс Tom's Hardware, по всей видимости, речь идёт об 12-Hi объёмом 36 Гбайт, которые будут использоваться в ускорителях NVIDIA Rubin. По заявлениям SK hynix, внедрение HBM4 позволит увеличить производительность ИИ-ускорителей на 69 % по сравнению с нынешними решениями. Это поможет устранить узкие места в обработке информации в ИИ ЦОД.

09.09.2025 [15:46], Сергей Карасёв

d-Matrix представила 400GbE-адаптер JetStream для объединения своих ИИ-ускорителейСтартап d-Matrix анонсировал специализированную IO-карту JetStream, предназначенную для распределения нагрузок ИИ-инференса между серверами в дата-центре. Устройство ориентировано на использование в связке с ускорителями d-Matrix Corsair, архитектура которых основана на модифицированных ячейках SRAM для вычислений в памяти (DIMC). JetStream использует стандарт Ethernet, благодаря чему обладает совместимостью с уже существующими коммутаторами. Новинка выполнена в виде платы расширения с интерфейсом PCIe 5.0 х16. Используются корзины QSFP-DD. Могут быть задействованы два 200GbE-порта со скоростью 200 Гбит/с или один 400GbE-порт. Архитектура серверов d-Matrix для ИИ-инференса предполагает установку ускорителей Corsair с DMX-мостом между каждыми двумя такими картами для обеспечения высокой пропускной способности без использования PCIe. Затем пары ускорителей объединяются посредством коммутатора PCIe. В эталонном дизайне один NIC JetStream обслуживает до четырёх экземпляров Corsair. d-Matrix утверждает, что сетевую задержку в такой конфигурации удалось сократить до 2 мкс. По заявлениям d-Matrix, карты JetStream могут применяться в существующих ЦОД без необходимости замены дорогостоящих инфраструктурных компонентов. В связке с ИИ-ускорителями Corsair и ПО d-Matrix Aviator решения JetStream способны справляться с ИИ-моделями, насчитывающими более 100 млрд параметров. При этом, как утверждает разработчик, обеспечивается в 10 раз более высокая производительность, в три раза лучшая экономическая эффективность и втрое большая энергоэффективность по сравнению с решениями на базе GPU. Энергопотребление JetStream составляет около 150 Вт. Адаптер оснащён системой охлаждения с радиатором и тепловыми трубками, которые охватывают зону QSFP-DD. Пробные поставки новинки уже начались, а массовое производство запланировано на конец текущего года.

08.09.2025 [17:26], Владимир Мироненко

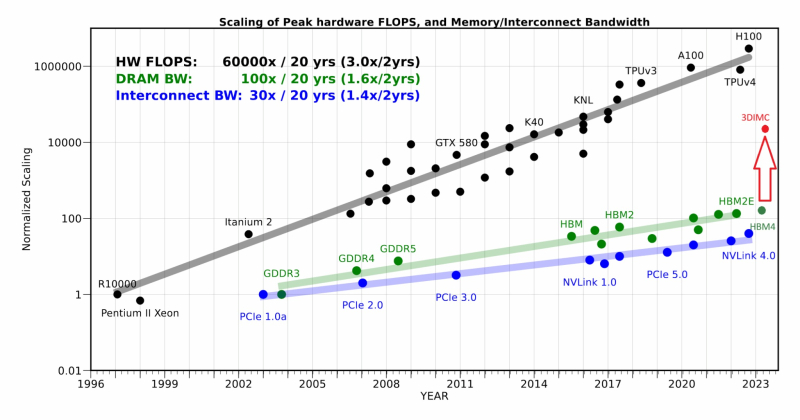

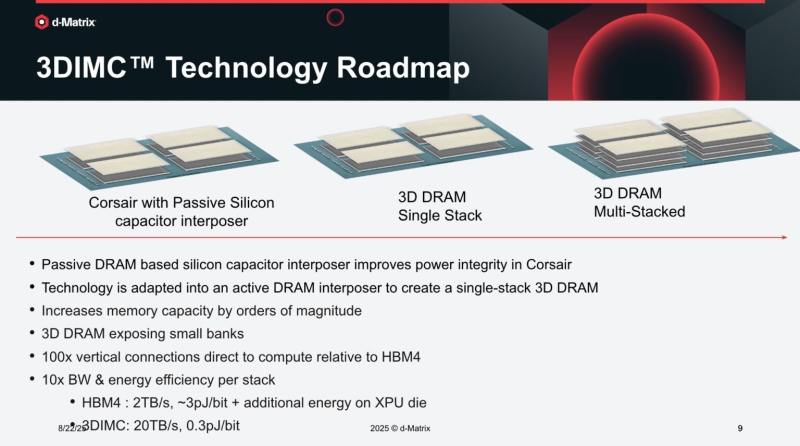

d-Matrix начала тестирование чипа Pavehawk с поддержкой 3DIMCСтартап d-Matrix объявил о разработке новой реализации технологии 3D-вычислений в памяти (3DIMC), которая обещает в 10 раз ускорить работу ИИ-моделей и в 10 раз повысить энергоэффективность по сравнению с текущим отраслевым стандартом HBM4, пишет ресурс SiliconANGLE. Технический директор Судип Бходжа (Sudeep Bhoja) сообщил в блоге, что первый чип компании с поддержкой 3DIMC, d-Matrix Pavehawk, разработка которого заняла более двух лет, сейчас проходит тестирование. В Pavehawk логический блок, изготовленный с использованием 5-нм техпроцесса TSMC, располагается поверх чипа памяти и интегрирован с ним посредством технологии F2F (face-to-face). По словам Бходжи, отраслевые тесты показывают, что производительность вычислений растёт примерно в 3 раза каждые два года, в то время как пропускная способность памяти — всего в 1,6 раза. Этот разрыв постоянно увеличивается, память уже стала узким местом в масштабировании ИИ. Компания утверждает, что простое увеличение количества ускорителей в ЦОД не решит проблему «стены памяти». HPCwire цитирует гендиректора: d-Matrix Сида Шета (Sid Sheth): «Модели быстро развиваются, и традиционные системы памяти HBM становятся очень дорогими, энергоёмкими и ограниченными по пропускной способности». По его словам, узким местом ИИ-инференса является память, а не только количество операций с плавающей запятой, но 3DIMC меняет правила игры. «Стекируя память в трёх измерениях и обеспечивая её более тесную интеграцию с вычислениями, мы значительно сокращаем задержку, увеличиваем пропускную способность и открываем новые возможности повышения эффективности», — подчеркнул он. Компания отметила, что инференс, а не обучение, быстро становится доминирующей рабочей ИИ-нагрузкой. По словам Бходжи, CoreWeave недавно заявила, что 50 % её рабочих нагрузок теперь приходится на инференс, и аналитики прогнозируют, что в течение следующих двух-трех лет инференс будет составлять более 85 % всех корпоративных рабочих ИИ-нагрузок. Он подчеркнул, что компания не занимается перепрофилированием архитектур, созданных для обучения ИИ-моделей, — она с нуля разрабатывает решения, ориентированные на инференс. Бходжа сообщил, что первые пользователи ИИ-ускорителей Corsair, среди которых есть и гиперскейлеры, и неооблака, убедились, что архитектура с упором на память может значительно повысить пропускную способность, энергоэффективность и скорость генерации токенов по сравнению с GPU. Он также отметил, что конструкция на основе чиплетов обеспечивает не только большую пропускную способность памяти, но и «невероятную» гибкость, позволяя внедрять технологии памяти нового поколения быстрее и эффективнее, чем монолитные архитектуры. Бходжа заявил, что 3DIMC на порядок увеличит пропускную способность памяти и производительность для задач ИИ-инференса и обеспечит провайдерам сервисов и предприятиям возможность масштабировать их эффективно и экономично по мере появления новых моделей и приложений. С выводом Pavehawk на рынок компания занялось созданием следующего поколения архитектуры обработки в оперативной памяти, использующей 3DMIC, под названием Raptor. «Наша архитектура следующего поколения Raptor будет включать 3DIMC и опираться на опыт, полученный нами и нашими клиентами в ходе тестирования Pavehawk. Благодаря вертикальному размещению памяти и тесной интеграции с вычислительными чиплетами, Raptor обещает преодолеть барьер в области памяти и выйти на совершенно новый уровень производительности и совокупной стоимости владения», — утверждает Бходжа. Он добавил, что, поставив требования к памяти во главу угла при разработке своих решений — от Corsair до Raptor и далее — компания гарантирует, что инференс будет быстрее, доступнее и стабильнее при масштабировании. d-Matrix провела два раунда финансирования. В раунде A в 2022 году было привлечено $44 млн, а в раунде B в 2023 году – $110 млн, что в общей сложности составляет $154 млн. Компания сотрудничает с поставщиком решений компонуемых систем GigaIO.

08.09.2025 [09:29], Сергей Карасёв

DE-CIX запустила первую в мире платформу обмена ИИ-трафикомОператор точек обмена трафиком DE-CIX объявил о запуске первой в мире специализированной платформы, призванной обеспечить высокоскоростное и надёжное взаимодействие между агентами, сетями и приложениями на базе ИИ. Инфраструктура сформирована в рамках первой фазы проекта AI Internet Exchange (AI-IX). К платформе уже подключены более 50 сетей, ориентированных на задачи ИИ. Это, в частности, провайдеры инференс-услуг и GPUaaS, а также поставщики облачных сервисов. AI-IX, как утверждается, обеспечивает отказоустойчивое и высокозащищённое соединение с низкими задержками, специально предназначенное для сценариев использования ИИ в режиме реального времени. Это могут быть мультимодальные агенты, робототехнические устройства, системы автономного вождения и пр. Платформа использует проприетарную масштабируемую систему маршрутизации. Вторая фаза проекта AI-IX предполагает поддержку Ultra Ethernet для формирования географически распределённой среды обучения ИИ. Задачей консорциума Ultra Ethernet, созданного в июле 2023 года, является разработка ИИ/HPC-интерконнекта на базе Ethernet. DE-CIX отмечает, что с появлением Ultra Ethernet меняется подход к проектированию инфраструктуры для ресурсоёмких вычислений. Становится возможным объединение географически распределённых узлов, что предоставляет компаниям новые возможности в плане создания отказоустойчивой и более экономичной частной инфраструктуры ИИ. В целом, как подчёркивает DE-CIX, пиринговые сети ИИ предлагают ряд преимуществ как для задач инференса, так и для обучения моделей. Среди них — снижение затрат, повышение безопасности, увеличение производительности и повышение гибкости.

15.08.2025 [15:58], Руслан Авдеев

Equinix подписала сразу три крупных сделки с атомными стартапами Radiant, ULC-Energy и Stellaria на поставку более 750 МВт электроэнергииEquinix, один из лидеров рынка ЦОД, расширил обязательства в области ядерной энергетики, заключив три крупных соглашения с «атомными» стартапами, в совокупности готовыми обеспечить до 774 МВт электроэнергии, сообщает Datacenter Dynamics. Первую сделку заключили с компанией Radiant, занимающейся разработкой малых модульных реакторов (SMR) в Калифорнии. Equinix обязалась приобрести 20 реакторов Kaleidos, каждый рассчитан на 1,2 МВт электрической и 3 МВт тепловой энергии. Kaleidos представляют собой высокотемпературные газоохлаждаемые реакторы на топливе TRISO, с гелиевым хладагентом и «призматическими» графитовыми блоками. Radian утверждает, что её SMR можно развернуть всего за несколько дней. Сейчас компания взаимодействует с Комиссией по ядерном урегулированию США. Основные работы по проектированию Kaleidos уже завершены, лабораторные испытания должны начаться в середине 2026 года. Также Equinix подписала соглашение о намерениях с ULC-Energy, предусматривающее закупку до 250 МВт электричества для своих ЦОД в Нидерландах. ULC-Energy — эксклюзивный партнёр британской Rolls-Royce. В 2022 году она выбрала в качестве предпочтительного варианта малый модульный реактор на лёгкой воде на 470 МВт. Сейчас эти SMR проходят процедуру оценки типового проекта совместно с регуляторами Великобритании. Первое включение в энергосеть намечено на 2030 год. Третья сделка — предварительный заказ на поставку 500 МВт в нескольких странах Европы у французского стартапа Stellaria. Stellaria основана в 2023 году Комиссией по атомной энергии и альтернативным источникам энергии Франции (CEA) и Schneider Electric, а теперь разрабатывает, по её словам, «первый в мире» реактор на расплавленных солях — Breed & Burn. Реактор на 200 МВт предполагает использование жидкого ядерного топлива с последующим сжиганием отходов в самом реакторе. Первый полнофункциональный запуск запланировали на 2029 год, старт коммерческой эксплуатации — на 2035 год. В июне 2025 года Stellaria привлекла €23 млн ($26,8 млн). В прошлом году Equinix подписала с Oklo предварительное соглашение на закупку 500 МВт от SMR Aurora Powerhouse. Таким образом, контракты Equinix теперь охватывают более 1 ГВт ядерных мощностей SMR. Кроме того, недавно было заключено соглашение , предусматривающее расширение внедрения твёрдооксидных топливных элементов Bloom Energy до более 100 МВт. Впрочем, технологии SMR изучают и другие операторы ЦОД. Только за последний год Amazon (AWS), Google, Data4, Oracle, Switch и Endeavour подписали соглашения с разработчиками малых модульных реакторов. При этом в мире пока нет ни одной действующей коммерческой версии SMR. В марте сообщалось, что Amazon, Meta✴ и Google помогут утроить мощность АЭС во всём мире к 2050 году. |

|