Материалы по тегу: hardware

|

23.03.2025 [14:08], Сергей Карасёв

Итальянский суперкомпьютер Leonardo будет интегрирован с квантовым компьютером IQM Radiance на 54 кубитаИтальянский суперкомпьютерный центр Cineca объявил о заключении соглашения с компанией IQM Quantum Computers на поставку самого мощного в стране квантового вычислительного комплекса. Речь идёт о системе IQM Radiance в конфигурации с 54 кубитами. Cineca является одним из крупнейших вычислительных центров Италии. Некоммерческий консорциум состоит из 69 итальянских университетов и 21 национальной исследовательской организации. Своей задачей консорциум ставит поддержку итальянского научного сообщества путём предоставления суперкомпьютеров и инструментов визуализации. Монтаж IQM Radiance планируется осуществить в IV квартале нынешнего года. Это будет первый локальный квантовый компьютер на площадке Cineca в Болонье. Суперкомпьютерный центр намерен использовать новую систему для оптимизации квантовых приложений, квантовой криптографии, квантовой связи и квантовых алгоритмов ИИ. Комплекс IQM Radiance 54 будет интегрирован с вычислительной системой Leonardo, которая является одним из самых быстрых суперкомпьютеров в мире. В ноябрьском рейтинге TOP500 эта машина занимает девятое место с теоретической пиковой производительностью 306,31 Пфлопс. В основу суперкомпьютера положены платформы Atos BullSequana X2610 и X2135. Система построена в рамках сотрудничества EuroHPC, которое сейчас занято развёртыванием сети европейских квантовых компьютеров и ИИ-фабрик. Компания IQM Quantum Computers основана в Хельсинки (Финляндия) в 2018 году. Она поставляет полнофункциональные квантовые компьютеры и специализированные решения для HPC, научно-исследовательских институтов, университетов и предприятий. Ранее IQM заявляла, что к выпуску готовится версия Radiance со 150 кубитами, которую планировалось представить в I квартале 2025 года.

22.03.2025 [14:19], Сергей Карасёв

Seeed reComputer J3010B — мини-ПК для ИИ-задач на периферии на базе NVIDIA Jetson Orin NanoКомпания Seeed Studio, по сообщению CNX-Software, выпустила компьютер небольшого форм-фактора reComputer J3010B, предназначенный для поддержания ИИ-нагрузок на периферии. Устройство может эксплуатироваться в широком температурном диапазоне — от -10 до +60 °C. В основу новинки положена аппаратная платформа NVIDIA Jetson Orin Nano. Решение содержит процессор с шестью вычислительными ядрами Arm Cortex-A78AE с частотой до 1,5 ГГц и GPU на архитектуре NVIDIA Ampere с 16 тензорными ядрами. Доступны варианты с 512 и 1024 ядрами CUDA, оснащённые соответственно 4 и 8 Гбайт памяти LPDDR5. В первом случае заявленная ИИ-производительность достигает 34 TOPS, во втором — 67 TOPS. reComputer J3010B несёт на борту NVMe SSD вместимостью 128 Гбайт и сетевой контроллер 1GbE. Есть слот M.2 Key E для опционального модуля Wi-Fi/Bluetooth, разъём mini PCIe для модема 4G (1 × PCIe 3.0 x4/3 × PCIe 3.0 x1), 40-контактная колодка расширения, 12-контактная колодка UART, коннектор для подключения вентилятора охлаждения с ШИМ-управлением, два интерфейса камеры CSI (2 линии). В набор разъёмов входят два порта USB 3.2 Type-A и порт USB 2.0 Type-C, интерфейс HDMI 2.1, гнездо RJ45 для сетевого кабеля.

Источник изображения: Seeed Studio Размеры компьютера составляют 130 × 120 × 58,5 мм, масса — 451,9 г. Питание (9–19 В) подаётся через DC-разъём на 5,5/2,5 мм. Компания Seeed Studio заявляет, что новинка будет доступна как минимум до 2032 года. Устройство обеспечивается двухлетней гарантией. Цена reComputer J3010B составляет $505 за модель с 4 Гбайт оперативной памяти и $605 за модификацию с 8 Гбайт.

21.03.2025 [15:48], Руслан Авдеев

Оценка капитализации CoreWeave прямо перед IPO снизилась до $26 млрдОператор ИИ-облака CoreWeave Inc. завершил подачу заявки для IPO. Она намерена продать 49 млн акций по цене $47–$55 за каждую — всего на сумму почти $2,7 млрд. Допускается, что капитализация компании составит $26 млрд, сообщает Silicon Angle, хотя ранее говорилось о $35 млрд. Компания выбрала Morgan Stanley, Goldman Sachs и JPMorgan посредниками для выхода на биржу Nasdaq она выйдет под тикером CRWV. Сегодня CoreWeave располагает 250 тыс. ИИ-ускорителей NVIDIA в 32 дата-центрах по всему миру. Компания одной из первых предложила доступ к NVIDIA Blackwell, во многом благодаря поддержке самой NVIDIA. Представители оператора заявляют, что платформа обеспечивает лучшую производительность, чем ключевые публичные облака. Согласно документации для IPO, в облаке CoreWeave можно обучить модель Llama 3.1, использовав на 3,1 млн меньше часов работы ускорителей, чем в облаке неназванных конкурентов. Также компания обещает значительно ускорить смежные задачи вроде подготовки к обучению ИИ-моделей. Кроме того, CoreWeave разработала несколько кастомных программных инструментов для своей платформы. Функциональность инструментария и наличие огромных вычислительных мощностей помогли компании заключить контракты с ключевыми IT-бизнесами, включая OpenAI, Meta✴, IBM и Microsoft. Выручка компании в 2024 году взлетела на 737 % (годом ранее и вовсе на 1346 %), превысив $1,92 млрд. При этом около 77 % выручки 2024 году принесли Microsoft и NVIDIA. Продажи стремительно выросли после триумфального дебюта ChatGPT.

Источник изображения: CoreWeave CoreWeave активно тратит средства для сохранения лидирующих позиций, не считаясь с убытками — вплоть до покупки ускорителей в кредит под залог уже имеющихся ускорителей. В заявке CoreWeave указала, что намерена сохранить рост выручки, расширяя международное присутствие. Компания также намерена обеспечить специальные предложения для сегментов вроде банковского сектора, где ожидается рост спроса на ИИ. Также компания намерена улучшить финансовые показатели, изменив сами принципы строительства ЦОД. Пока большинство площадок компания просто арендует, но в заявке на IPO утверждается, что она «может инвестировать» в приобретение дата-центров в собственность. Представители оператора надеются, что это позволит получить больше контроля и снизить издержки на инфраструктуру. Это поможет компании эффективнее добиваться прибыльности бизнеса.

21.03.2025 [14:21], Сергей Карасёв

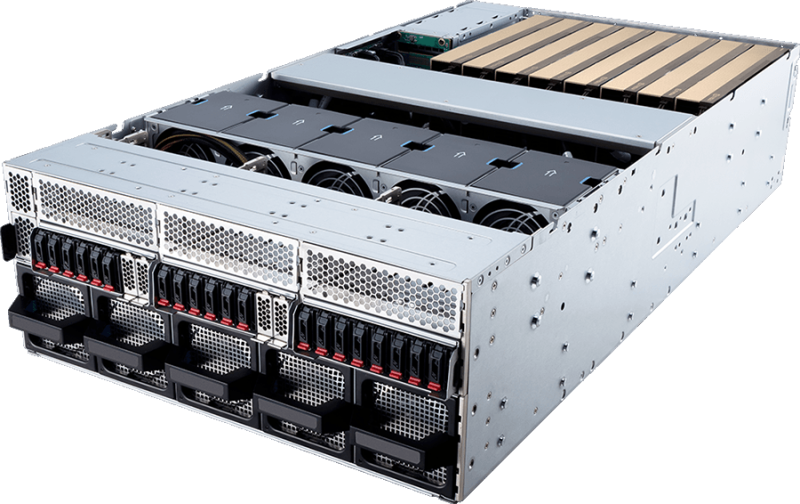

MSI представила серверы на архитектуре NVIDIA MGX с процессорами Intel Xeon 6Компания MSI анонсировала серверы CG480-S5063 и CG290-S3063 для задач ИИ и HPC, а также приложений с интенсивным использованием данных. В основу систем положены процессоры Intel Xeon 6500P и 6700P поколения Granite Rapids и модульная архитектура NVIDIA MGX. Модель CG480-S5063 выполнена в форм-факторе 4U. Возможна установка двух чипов Xeon 6 в исполнении LGA4710 с показателем TDP до 350 Вт. Доступны 32 слота для модулей DDR5-6400/8000 RDIMM/RDIMM-3DS/MRDIMM суммарным объемом до 8 Тбайт. Во фронтальной части расположены 20 отсеков для накопителей E1.S с интерфейсом PCIe 5.0 x4 (NVMe). Кроме того, есть два внутренних слота для SSD в формате М.2 2280/22110 PCIe 5.0 x2 (NVMe). В общей сложности реализованы 13 слотов PCIe 5.0 x16. Допускается применение до восьми ускорителей NVIDIA H200. Предусмотрены два сетевых порта 10GbE на базе Intel X710-AT2, выделенный сетевой порт управления 1GbE, контроллер ASPEED AST2600, порты USB 3.0/2.0 Type-A и Mini-DisplayPort. Питание обеспечивают четыре блока мощностью 3200 Вт с сертификатом 80 PLUS Titanium. Задействовано воздушное охлаждение. В свою очередь, сервер CG290-S3063 рассчитан на один процессор Xeon 6 с TDP до 350 Вт. Объем памяти DDR5-6400/8000 RDIMM/RDIMM-3DS/MRDIMM может достигать 4 Тбайт (16 слотов). Доступны восемь тыльных отсеков для SFF-накопителей, два коннектора для SSD М.2 2280/22110 с интерфейсом PCIe 5.0 x2 (NVMe), а также восемь слотов PCIe 5.0 x16. Поддерживается установка до четырёх ускорителей NVIDIA H200. В оснащение входят контроллер ASPEED AST2600, сетевой порт управления 1GbE, интерфейсы USB 3.0/2.0 Type-A и Mini-DisplayPort. Применены два блока питания мощностью 2400 Вт с сертификатом 80 PLUS Titanium и система воздушного охлаждения. Серверы могут эксплуатироваться при температурах от 0 до +35 °C.

21.03.2025 [14:17], Сергей Карасёв

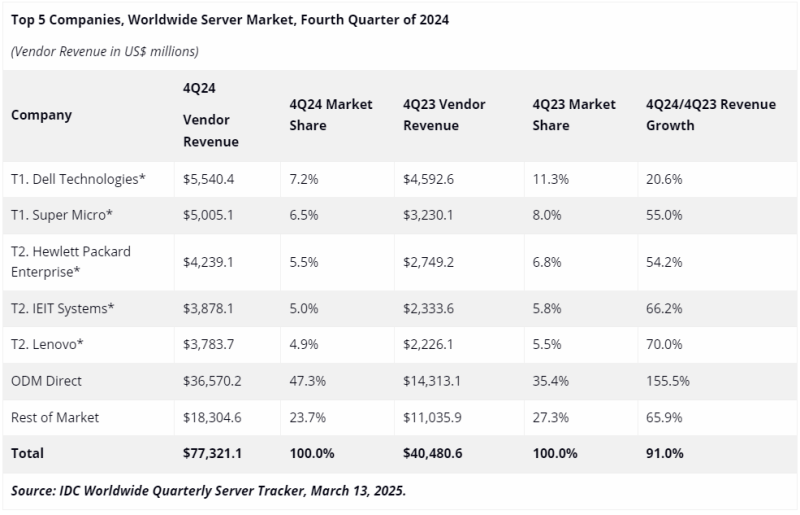

Во многом благодаря NVIDIA квартальные поставки серверов взлетели почти вдвое, достигнув рекордных $77,3 млрдКомпания International Data Corporation (IDC) подвела итоги исследования глобального серверного рынка в IV квартале 2024 года. Выручка достигла рекордных $77,3 млрд, что на 91 % больше по сравнению с последней четвертью 2023-го, когда продажи составляли $40,5 млрд. С октября по декабрь включительно серверы с архитектурой x86 принесли $54,8 млрд, что на 59,9 % больше по сравнению с аналогичным периодом 2023 года. Суммарная выручка от поставок систем с процессорами на всех других архитектурах за год взлетела на 262,1 %, достигнув $22,5 млрд. Это, в частности, указывает на быстрый рост популярности Arm-серверов. Высоким спросом продолжают пользоваться машины для ИИ-задач, оборудованные GPU-ускорителями: выручка от такого оборудования в IV квартале 2024 года поднялась на 192,6 % в годовом исчислении. В данном сегменте доминирует NVIDIA с долей более 90 % в общем объёме поставок в штучном выражении. Лидером глобального серверного рынка в последней четверти 2024-го стала Dell с продажами на уровне $5,5 млрд и долей в 7,2 % против 11,3 % годом ранее. На втором месте располагается Supermicro, у которой выручка составила $5,0 млрд, а доля снизилась в годовом исчислении с 8,0 % до 6,5 %. Замыкает тройку НРЕ с $4,2 млрд и 5,5 %: годом ранее эта компания контролировала 6,8 % отрасли. На четвёртом месте находится IEIT Systems с $3,9 млрд и 5,0 %, на пятом — Lenovo $3,8 млрд и 4,9 %. Прямые ODM-поставки обеспечили $36,6 млрд, или 47,3 % в общем объёме отрасли. На всех прочих игроков рынка пришлось $18,3 млрд, или около 23,7 %. В географическом плане Соединенные Штаты являются вторым по темпам роста регионом на рынке серверов сразу после Канады с приростом на 118,4 %, но США лидируют с долей 56 % от суммарных продаж серверов в IV квартале 2024 года, тогда как на Канаду приходится только 1,1 % продаж. В Китае выручка поднялась на 93,3 % — на КНР приходится почти четверть общемировых продаж. В Японии зафиксирован рост на 66,9 %, в Азиатско-Тихоокеанском регионе (за исключением Японии и Китая) — на 43,8 %, в регионе EMEA (Европа, Ближний Восток и Африка) — на 28,2 %, в Латинской Америке — на 7 %. В 2024 году в целом выручка на мировом рынке серверов достигла $235,7 млрд, что более чем в два раза превышает показатель 2020-го.

21.03.2025 [08:56], Руслан Авдеев

NVIDIA инвестировала в CoreWeave, дала ей дефицитные ИИ-ускорители, а потом сама же арендовала ихКлиентам NVIDIA необходимо постоянно вкладывать миллиарды долларов в построение ИИ-инфраструктуры. При этом финансовая поддержка может прийти из самых неожиданных мест. Иногда — от самой NVIDIA, сообщает The Information. NVIDIA и её крупнейшим клиентам постоянно приходится искать баланс. С одной стороны, они поддерживают друг друга в краткосрочной перспективе, с другой — на длинной дистанции с NVIDIA намерены конкурировать многие гиперскейлеры. Microsoft, Meta✴, Google и Amazon (AWS) активно используют ИИ-чипы NVIDIA, одновременно пытаясь избавиться от такой зависимости и работая над собственными решениями: Maia, MTIA, TPU, Trainium и Inferentia. Поэтому NVIDIA инвестирует в т.н. неооблака (neocloud), ориентированные на предоставление ИИ-мощностей. Такие компании до некоторой степени способны стать альтернативой гиперскейлерам и вряд ли смогут разработать продукты, конкурирующие с чипами NVIDIA. К таковым относится и CoreWeave, которой NVIDIA активно помогает развиваться. В рамках подготовки к IPO компания раскрыла, что около 77 % выручки 2024 году ей принесли всего два клиента. Крупнейшим из них была Microsoft (62 %), которая к тому же обогнала по объёму закупок ускорителей NVIDIA всех ближайших конкурентов. А вот вторым по величине клиентом CoreWeave оказалась… сама NVIDIA (15 %). В начале 2023 года, когда спрос на ИИ-ускорители со стороны гиперскейлеров был фантастическим, NVIDIA сделала любопытный ход — в рамках т. н. Project Osprey она согласилась потратить в течение четырёх лет $1,3 млрд на аренду собственных чипов у CoreWeave, одновременно инвестировав в неё $100 млн. CoreWeave получила сотни тысяч современных ИИ-ускорителей и контракт с NVIDIA до августа 2027 года. NVIDIA действительно активно использует арендованные ускорители, не отвлекаясь на развёртывание ИИ ЦОД. В случае успешного выхода CoreWeave на биржу с оценкой более $30 млрд. заблаговременные инвестиции NVIDIA в акционерный капитал компании всего за два года превратятся в более чем $1 млрд. Однако для потенциальных инвесторов такое сотрудничество — повод для беспокойства, поскольку контракты с Microsoft и NVIDIA истекают в 2027–2029 гг. Подобные сделки на рынке ИИ — довольно распространённое явление. «Циклические» финансовые соглашения показывают, как деньги в отрасли уходят из компаний и возвращаются к ним же. SoftBank, намеренная стать одним из крупнейших инвесторов OpenAI, согласилась платить компании $3 млрд за использование её ИИ-продуктов. Microsoft вложила в OpenAI более $13 млрд, в результате чего получает долю в растущих доходах компании. В то же время OpenAI ежегодно выплачивает Microsoft миллиарды долларов за облачные сервисы. Amazon и Google заключили аналогичные сделки с Anthropic. Тем временем CoreWeave подпитывает расширение бизнеса за счёт долговых обязательств на $8 млрд и $15 млрд договоров долгосрочной аренды ЦОД и офисов. В своё время CoreWeave даже взяла в долг $2,3 млрд под залог ускорителей NVIDIA, чтобы купить ещё больше ускорителей NVIDIA. Пока инвесторы сомневаются, как оценивать компанию, поскольку малое количество якорных клиентов в совокупности с высокими темпами роста и большими долгами — довольно редкое явление. CoreWeave может сыграть роль и в развитии других компаний и проектов. В частности, речь идёт о намерении OpenAI подписаться на сервисы CoreWeave — пятилетний контракт на $11,9 млрд предполагает получение доли в компании. В этот период CoreWeave сможет получать дополнительные средства ежегодно, что несколько снизит её зависимость от NVIDIA и Microsoft. Однако данный контракт является лишь дополнением к контрактам с Microsoft и Oracle. Кроме того, идёт строительство ИИ ЦОД для проекта Stargate, поддерживаемого SoftBank и Oracle. Своим инвесторам OpenAI заявила, что к 2030 году Stargate обеспечит ¾ вычислительных мощностей, необходимых компании.

21.03.2025 [08:15], Руслан Авдеев

NVIDIA и xAI присоединились к $30-млрд инфраструктурному ИИ-консорциуму, возглавляемому Microsoft и BlackRock

blackrock

hardware

microsoft

nvidia

xai

возобновляемая энергия

ии

инвестиции

строительство

сша

финансы

цод

энергетика

NVIDIA и xAI присоединились к консорциуму, намеренному инвестировать $30 млрд в развитие ИИ-инфраструктуры. Консорциум AI Infrastructure Partnership (AIP), ранее известный как Global AI Infrastructure Investment Partnership, был сформирован Microsoft, BlackRock, Global Infrastructure Partners (GIP, принадлежит BlackRock) и дубайской государственной инвесткомпанией MGX (создана при участии Mubadala и G42) в сентябре 2024 года, Silicon Angle. На начальном этапе консорциум намерен инвестировать в ИИ-проекты более $30 млрд, а в долгосрочной перспективе — $100 млрд. В основном речь идёт об инвестициях в дата-центры и энергетическую инфраструктуру, преимущественно в США. Консорциум сообщил, что уже привлёк значительные средства и вызвал интерес у бизнеса. До того, как NVIDIA объявила о намерении присоединиться к AIP, она выступала техническим консультантом консорциума в области ИИ ЦОД. Эту роль она сохранит. Также стало известно, что с AIP работают производитель оборудования для энергетической отрасли GE Vernova, в прошлом году отделившийся от General Electric, и крупнейшая в США коммунальная компания NextEra Energy, занимающаяся электроснабжением. Она же является крупнейшим в мире провайдером в области ветроэнергетики. GE Vernova будет работать с AIP и партнёрами над формированием цепочек поставок. NextEra Energy поможет в масштабировании критически важных и разнообразных энергетических решений для ИИ ЦОД. Некоторые из поддерживающих AIP компаний также участвуют и в других инициативах по финансированию развития ИИ-инфраструктуры. В прошлом году Microsoft с Constellation Energy Generation объявили о возобновлении работы АЭС Three Mile Island. Обновление объекта обойдётся в $1,6 млрд. После того, как тот заработает приблизительно в 2026 году, все 837 МВт пойдут на питание дата-центров Microsoft. NVIDIA параллельно участвует в проекте Stargate.

20.03.2025 [17:47], Руслан Авдеев

Crusoe расширит до 1,2 ГВт ИИ-кампус в Абилине, который, похоже, целиком достанется StargateКомпания Crusoe Energy начала вторую фазу строительства кампуса ИИ ЦОД в технопарке Lancium Clean Campus в Абилине (Abilene, Техас), который будет обслуживать ИИ-мегапроект Stargate. Предполагается, что она будет завершена в середине 2026 года, когда будут построены шесть новых зданий. Всего кампус будет включать восемь объектов. Итоговая площадь кампуса составит более 370 тыс. м2, а общая ёмкость вырастет до 1,2 ГВт. Первая фаза строительства ИИ ЦОД в Абилине стартовала в июне 2024 года. Она включает возведение двух зданий площадью более 90 тыс. м2 и ёмкостью более 200 МВт. Ожидается, что подача энергии начнётся в I половине 2025 года. OpenAI ранее заявляла о намерении управлять восемью зданиями в кампусе в Абилине. Crusoe отказалась комментировать, ведётся ли вторая фаза строительства в интересах Stargate. На этой неделе Crusoe анонсировала создание совместного предприятия на 4,5 ГВт не только для строительства ЦОД, но и для их автономного питания от газовых электростанций.

Источник изображения: Crusoe Как заявляют в Crusoe, экспансия в Абилине знаменует важную веху для ИИ-индустрии. Масштаб сконцентрированных на одной площадке вычислительных мощностей весьма примечателен — она, по оценкам, сможет разместить до 400 тыс. ускорителей. На рынке ИИ-инфраструктуры появилась новая категория — «ИИ-фабрика», позволяющая обрабатывать ИИ-нагрузки с беспрецедентными скоростью и масштабом. В Crusoe гордятся тем, что предоставляют инфраструктуру, которая будет способствовать развитию человечества. В Lancium добавляют, что управление ЦОД такого масштаба требует инноваций на уровне кампуса для обеспечения надёжности электросетей при любых нагрузках.

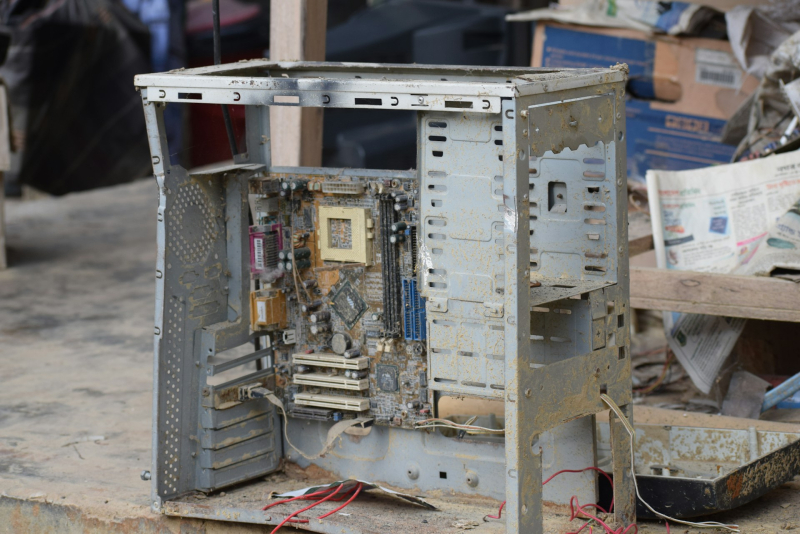

20.03.2025 [16:25], Татьяна Золотова

Почти вся ИТ-инфраструктура «Почты России» фактически «дышит на ладан», пожаловался глава госкомпанииПочти 90 % ИТ-инфраструктуры «Почты России» «дышит на ладан», а 55 % транспорта компании находится «за сроками полезного использования», сообщают «РИА Новости» со ссылкой на выступление главы ФГУП «Почта России» Михаила Волкова на расширенном заседании ИТ-комитета в Госдуме. Как заявил Михаил Волков, изношенность фондов очень большая. «Например, около 55 % нашего транспорта уже за сроками полезного использования. Что касается ИТ-инфраструктуры — 89 % фактически на ладан дышат», — был откровенен глава «Почты России». Ключевыми проблемами на 2025 год для организации ее глава называет низкий уровень заработных плат и крайняя изношенность инфраструктуры. При этом он указал, что в 2023 и 2024 годах зарплаты у специалистов основного производства повышались, но средний уровень выплат все равно в два раза ниже, чем в среднем по стране. С 2021 года уставный капитал «Почты России» был увеличен на 16,5 млрд руб. в рамках программы ее модернизации. Михаил Волков сообщил, что сейчас проходит программа модернизации и ремонта сельских отделений и совместно с Минцифры прорабатывается продление этой программы до 2030 года. Программа реализуется в соответствии с перечнем поручений Президента России. Глава «Почты России» объяснил, что организация работает над повышением операционной и финансовой эффективности: «На 36 % увеличена производительность труда, более чем на 30 % сокращены административно-управленческие расходы. И уже в 2023 году это позволило выйти на операционную прибыль, также и в 2024 году. Высокая ключевая ставка, конечно, сильно нас здесь сдерживает».

20.03.2025 [15:58], Сергей Карасёв

Supermicro анонсировала петабайтное 1U-хранилище All-Flash на базе Arm-суперчипа NVIDIA GraceКомпания Supermicro представила сервер ARS-121L-NE316R в форм-факторе 1U, на базе которого могут формироваться системы хранения данных петабайтной вместимости. В основу новинки положен суперчип NVIDIA Grace со 144 ядрами Arm Neoverse V2 и 960 Гбайт памяти LPDDR5x. Устройство оборудовано 16 фронтальными отсеками для NVMe-накопителей E3.S 1T. При использовании SSD ёмкостью 61,44 Тбайт суммарная вместимость может достигать 983 Тбайт. При этом до 40 серверов могут быть установлены в одну стойку, что обеспечит 39,3 Пбайт «сырой» ёмкости. Новинка располагает двумя внутренними посадочными местами для M.2 NVMe SSD и двумя слотами PCIe 5.0 x16 для карт типоразмера FHHL. Присутствуют сетевой порт управления 1GbE (RJ45), порт USB 3.0 Type-A и разъём mini-DP. Габариты сервера составляют 772,15 × 438,4 × 43,6 мм, масса — 19,8 кг без установленных накопителей. Питание обеспечивают два блока мощностью 1600 Вт с сертификатом 80 Plus Titanium. Применена система воздушного охлаждения с восемью съёмными вентиляторами диаметром 40 мм. Диапазон рабочих температур — от +10 до +35 °C. При необходимости сервер может быть оснащён двумя DPU NVIDIA BlueField-3 или двумя адаптерами ConnectX-8. Система подходит для поддержания рабочих нагрузок с интенсивным обменом данными, таких как ИИ-инференс, аналитика и пр. Отмечается, что при создании новинки Supermicro тесно сотрудничала с NVIDIA и WEKA (разработчик платформ хранения данных). |

|