Материалы по тегу: c

|

26.11.2025 [12:50], Сергей Карасёв

Сервер Giga Computing G4L3-ZX1 с поддержкой AMD EPYC 9005 Turin и Instinct MI355X оснащён СЖОКомпания Giga Computing, подразделение Gigabyte, анонсировала сервер G4L3-ZX1-LAT4, предназначенный для задачи ИИ и НРС. Эта мощная машина на аппаратной платформе AMD оснащена системой прямого жидкостного охлаждения (DLC), отводящей тепло и от CPU, и от GPU. Сервер выполнен в форм-факторе 4U. Он может нести на борту два процессора EPYC 9004 Genoa или EPYC 9005 Turin (до 192 вычислительных ядер) в исполнении Socket SP5 с показателем TDP до 500 Вт. Доступны 24 слота для модулей оперативной памяти DDR5-6400. Во фронтальной части находятся восемь отсеков для SFF-накопителей NVMe; кроме того, есть два внутренних коннектора M.2 2280/22110 для SSD с интерфейсом PCIe 3.0 x4 и x1. Новинка располагает восемью ускорителями AMD Instinct MI355X OAM. Предусмотрены восемь разъёмов для однослотовых карт FHHL с интерфейсом PCIe 5.0 x16 и четыре разъёма для двухслотовых карт FHHL (также PCIe 5.0 x16). Питание обеспечивают шесть блоков с резервирование мощностью 5200 Вт (сертификат 80 PLUS Titanium). Помимо СЖО, задействован ряд системных вентиляторов: 4 × 60 мм в зоне материнской платы, 4 × 80 мм в области слотов PCIe и 4 × 60 мм в лотке GPU. Диапазон рабочих температур — от +10 до +30 °C.

Источник изображения: Giga Computing Сервер оснащён двумя сетевыми портами 10GbE на основе адаптера Intel X710-AT2, выделенными сетевыми портами 1GbE во фронтальной и тыльной частях, контроллером Aspeed AST2600, двумя портами USB 3.2 Gen1 Type-A и аналоговым разъёмом D-Sub. Опционально может быть добавлен модуль TPM 2.0. Габариты сервера составляют 447 × 175,5 × 901 мм.

25.11.2025 [14:40], Руслан Авдеев

«Миссия Генезис» — США бросят силы на развитие ИИ для научных открытийВ понедельник президент США подписал указ о выполнении «Миссии Генезис» (Genesis Mission). Речь идёт о федеральной программе стимулирования инноваций с использование ИИ-технологий. Это последний из шагов нынешней администрации по продвижению и внедрению ИИ, сообщает Bloomberg. По словам представителя Белого дома, усилия направлены на оптимизацию координации исследований, проводимых правительственными ведомствами. Также предусмотрена более эффективная интеграция ИИ-инструментов для обеспечения всё новых научных прорывов. Сообщается, что для выполнения миссии будут задействовать вычислительные ресурсы национальных лабораторий Министерства энергетики для доступа к федеральным наборам данных и проведения большего количества экспериментов с применением ИИ-технологий. Предполагается, что подобные усилия могут помочь быстрее совершать научные открытия. Как сообщают источники в администрации президента, развитию суперкомпьютерных ресурсов в лабораториях министерства будут способствовать договоры с частными компаниями, включая NVIDIA, Dell, HPE и AMD. Новая инициатива, как ожидается, ускорит научные открытия в сфере материаловедения, здравоохранения и энергетики. Также в Белом доме подчёркивают необходимость инноваций для развития производства и снижения цен — это ещё один из приоритетов администрации. Заявляется, что благодаря ИИ Америка находится «на пороге научной революции».

Источник изображения: CDC/unspalsh.com Тем не менее, внедрение новых технологий может увеличить нагрузку на энергосети США. В Министерстве энергетики, наоборот, подчёркивают, что Genesis поможет противостоять росту цен на электричество, одна из конечных целей программы в энергетическом секторе — получить больше энергии и сделать сеть более эффективной, а также обратить вспять рост цен, вызвавший недовольство американских граждан. Предполагается, что сначала цены стабилизируются, а потом начнут снижаться. Ранее в ноябре об инициативе уже говорили в Белом доме. Подчёркивалось, что в администрации Трампа гонку ИИ-технологий считают столь же важной, как, в своё время, Манхэттенский проект (создание атомной бомбы). Миссию даже назвали крупнейшей мобилизацией федеральных научных ресурсов со времён программы «Аполлон», в рамках которой людей отправляли на Луну. Текущая администрация сделала развитие ИИ одним из главных приоритетов, стремясь одержать победу в гонке с Китаем и другими странами за первенство в этой сфере. Ряд указов предусматривает смягчение налогового бремени, чтобы упростить бизнесу создание ИИ-инфраструктуры и ЦОД, а союзникам — получить ключевое оборудование и программное обеспечение. Кроме того, обещана более жёсткая борьба с правительствами штатов — готовится указ, позволяющий подавать на штаты в суд за регулирование сферы ИИ — он считает его неконституционным. В июле сообщалось, что Министерство энергетики США выделило бизнесу свои земли для ускоренного строительства ЦОД и электростанций в соответствии с программой AI Action Plan, направленной на сохранение мирового лидерства в сфере ИИ.

25.11.2025 [14:05], Владимир Мироненко

AWS потратит $50 млрд на расширение облачных мощностей для правительства США: +1,3 ГВт на ИИ и HPCAmazon объявила о планах инвестировать до $50 млрд в расширение инфраструктуры ИИ и HPC для правительства США. Компания начнёт реализацию проектов в 2026 году и планирует добавить почти 1,3 ГВт вычислительной мощности в регионах AWS Top Secret, AWS Secret и AWS GovCloud (US) на всех уровнях секретности путём строительства новых ЦОД. Федеральные агентства получат расширенный доступ к комплексным ИИ-сервисам AWS, включая SageMaker, Bedrock, Nova и Anthropic Claude. Также в их распоряжение будут предоставлены ведущие модели класса open-weight foundation, ИИ-ускорители Trainium и ИИ-инфраструктура NVIDIA, что позволит им разрабатывать индивидуальные решения в области ИИ, оптимизировать большие наборы данных и повышать производительность труда, сообщила Amazon. Ранее AWS, Google, Oracle, Microsoft, xAI и др. IT-гиганты предоставили госслужбам США существенные скидки на облачные услуги в рамках программы OneGov. Это позволит государственным агентствам ускорить обработку информации и принятие решений. Интеграция ИИ с моделированием и имитацией позволит им решать за считанные часы самые сложные задачи, на которые раньше уходили недели или месяцы, а также «автоматически обнаруживать угрозы и разрабатывать планы реагирования», обрабатывая спутниковые снимки, данные датчиков и исторические закономерности в «беспрецедентном масштабе». «Наши инвестиции в специализированную правительственную инфраструктуру ИИ и облачные технологии коренным образом изменят подход федеральных агентств к использованию суперкомпьютинга, — заявил генеральный директор AWS Мэтт Гарман. — Мы предоставляем агентствам расширенный доступ к передовым возможностям ИИ, которые позволят им ускорить выполнение критически важных задач — от кибербезопасности до разработки лекарств. Эти инвестиции устраняют технологические барьеры, сдерживавшие развитие правительства, и укрепляют лидирующие позиции Америки в эпоху ИИ». Компания отметила, что этот шаг подчёркивает позицию AWS как лидера в области государственных облачных вычислений, поддерживающего более 11 тыс. государственных учреждений. AWS уже давно предоставляет правительству США выделенные облачные регионы. В 2011 году она запустила AWS GovCloud (US-West), AWS Top Secret-East — изолированное облако для секретных рабочих нагрузок — в 2014 году, AWS Secret Region — в 2017 году, с 2018 года добавила второй регион GovCloud (US-East), AWS Top Secret-West, а в октябре 2025 года — AWS Secret-West. Компания не раскрывает точное местоположение ЦОД и регионов. Как пишет Data Center Dynamics, другие страны также доверяют AWS свою самую секретную информацию. В Великобритании в 2021 году сообщили, что три британских разведывательных агентства использовали AWS для хранения совершенно секретных данных. В 2024 году AWS получила контракт стоимостью $1,3 млрд правительства Австралии на строительство ЦОД для совершенно секретной информации — спецслужбы получат возможность работы без использования открытого интернета.

24.11.2025 [15:14], Сергей Карасёв

Технологии тысячеядерного RISC-V-ускорителя Esperanto будут переданы в open sourceСтартап Ainekko, специализирующийся на разработке аппаратных и программных решений в сфере ИИ, по сообщению EE Times, приобрёл интеллектуальную собственность и некоторые активы компании Esperanto Technologies. Речь идёт о дизайне чипов, программных инструментах и фреймворке. Фирма Esperanto, основанная в 2014 году, специализировалась на создании высокопроизводительных ускорителей с архитектурой RISC-V для задач НРС и ИИ. В частности, было представлено изделие ET-SoC-1, объединившее 1088 энергоэффективных ядер ET-Minion и четыре высокопроизводительных ядра ET-Maxion. Основной сферой применения чипа был заявлен инференс для рекомендательных систем, в том числе на периферии. Однако в июле нынешнего года стало известно, что Esperanto сворачивает деятельность и ищет покупателя на свои разработки — ключевых инженеров переманили крупные компании. А продать чипы Meta✴, в чём, по-видимому, и заключался изначальный план, не удалось. Как рассказала соучредитель Ainekko Таня Дадашева (Tanya Dadasheva), её компания работает с чипами Esperanto в течение примерно полугода. Изначально компания планировала использовать чипы Esperanto для запуска своего софтверного стека. В частности, удалось перенести llama.cpp up и tinygrad. Когда стало понятно, что Esperanto вряд ли выживет, было принято решение выкупить разработки стартапа. Во всяком случае, это лучше, чем просто закрыть компанию, оставив её заказчиков ни с чем, как поступила AMD с Untether AI.

Источник изображения: Esperanto Ainekko планирует передать сообществу open source технологии Esperanto, связанные с многоядерной архитектурой RISC-V, включая RTL, референсные проекты и инструменты разработки. Предполагается, что решения Esperanto будут востребованы прежде всего в области периферийных устройств, где большое значение имеет энергоэффективность. Архитектура Esperanto, как утверждается, подходит для таких задач, как робототехника и дроны, системы безопасности, встраиваемое оборудование с ИИ-функциями и пр. Второй соучредитель Ainekko Роман Шапошник (Roman Shaposhnik) добавляет, что многоядерная архитектура Esperanto подходит не только для разработки ИИ-чипов, но и для создания «универсальной вычислительной платформы». Сама Ainekko намерена выпустить чип с восемью ядрами Esperanto и 16 Мбайт памяти MRAM, разработанной стартапом Veevx. Отмечается, что соучредитель и генеральный директор Veevx, ветеран Broadcom Даг Смит (Doug Smith), является ещё одним сооснователем Ainekko. В дальнейшие планы входит разработка процессора с 256 ядрами: по производительности он будет сопоставим с чипом Broadcom BCM2712 (4 × 64-бит Arm Cortex-A76), лежащим в основе Raspberry Pi 5, но оптимизирован для инференса.

21.11.2025 [11:14], Сергей Карасёв

Supermicro представила ИИ-сервер 10U на базе AMD Instinct MI355X с воздушным охлаждениемКомпания Supermicro анонсировала высокопроизводительный GPU-сервер AS-A126GS-TNMR, построенный на аппаратной платформе AMD. Система, выполненная в форм-факторе 10U, ориентирована на НРС-нагрузки и решение ресурсоёмких задач в сфере ИИ. Сервер может нести на борту два процессора AMD EPYC 9005 Turin или EPYC 9004 Genoa со 192 ядрами каждый (показатель TDP до 500 Вт). Доступны 24 слота для модулей оперативной памяти DDR5-6400 суммарным объёмом до 6 Тбайт. Во фронтальной части расположены десять отсеков для SFF-накопителей в конфигурации 8 × NVMe (PCIe 5.0 x4) и 2 × SATA с возможностью горячей замены. Кроме того, есть два лицевых слота для SSD формата M.2 (NVMe). В оснащение входят восемь ускорителей AMD Instinct MI355X, оборудованных 288 Гбайт памяти HBM3E с пропускной способностью до 8 Тбайт/с. Применяется интерконнект AMD Infinity Fabric. Реализовано воздушное охлаждение: спереди размещены пять вентиляторных блоков, сзади — десять (все они допускают горячую замену). Диапазон рабочих температур простирается от +10 до +35 °C.

Источник изображения: Supermicro Сервер располагает двумя сетевыми портами 10GbE RJ45 на базе контроллера Intel X710, выделенным сетевым портом управления 1GbE, двумя портами USB 3.0 Type-A, аналоговым разъёмом D-Sub, модулем TPM 2.0, восемью слотами PCIe 5.0 x16 для низкопрофильных (LP) карт расширения и двумя слотами PCIe 5.0 x16 для карт FHHL. Габариты составляют 438,8 × 449 × 843,28 мм, масса — 133 кг. Питание обеспечивают шесть блоков мощностью 5250 Вт с резервированием (3 + 3), которые имеют сертификацию 80 Plus Titanium. Поставки системы AS-A126GS-TNMR уже начались.

20.11.2025 [11:37], Сергей Карасёв

Представлен самый мощный суперкомпьютер на Ближнем Востоке — 122,8-Пфлопс система Shaheen IIIУниверситет науки и технологий имени короля Абдаллы (KAUST) в Саудовской Аравии объявил о запуске вычислительного комплекса Shaheen III. На сегодняшний день, как утверждается, это самый мощный суперкомпьютер на Ближнем Востоке: его FP64-производительность достигает 122,8 Пфлопс. Применять Shaheen III планируется для решения широкого спектра ресурсоёмких задач. Среди них названа разработка нового поколения малых и больших языковых моделей (LLM), ориентированных на арабский регион. Кроме того, суперкомпьютер поможет в создании цифрового двойника всего Аравийского полуострова — интегрированной среды моделирования, объединяющей атмосферные, океанические и земные процессы. Эта виртуальная модель будет способствовать решению комплексных проблем, таких как управление разливами нефти и оптимизация морских перевозок. В числе других задач названы оптимизация сельскохозяйственной деятельности и управления водными ресурсами, поиск передовых материалов, диагностика редких заболеваний, улучшение качества медицинской визуализации, разработка перспективных лекарственных препаратов и пр. Система создана компанией HPE на платформе Cray EX с прямым жидкостным охлаждением (DLC). В общей сложности задействованы 2800 гибридных суперчипов NVIDIA GH200 Grace Hopper с 72-ядерным Arm-процессором NVIDIA Grace и ускорителем NVIDIA H100 с 96 Гбайт памяти HBM3. Общее количество используемых ядер составляет 574 464. Применён интерконнект Slingshot-11. В качестве программной платформы используется HPE Cray OS. В ноябрьском рейтинге самых мощных суперкомпьютеров мира TOP500 система Shaheen III занимает 18-ю позицию. Её теоретическое пиковое быстродействие заявлено на уровне 155,21 Пфлопс. Энергопотребление — 1,98 МВт.

19.11.2025 [11:49], Сергей Карасёв

Второй европейский экзафлопсный суперкомпьютер Alice Recoque получит чипы AMD EPYC Venice и ускорители Instinct MI430XЕвропейское совместное предприятие по развитию высокопроизводительных вычислений (EuroHPC JU) и французско-нидерландский Консорциум Жюля Верна объявили о том, что в создании суперкомпьютера Alice Recoque примут участие компании Eviden (входит в состав Atos Group), AMD и SiPearl. О проекте Alice Recoque впервые стало известно в июне прошлого года. Это будет второй европейский суперкомпьютер экзафлопсного класса после системы JUPITER, смонтированной в Юлихском исследовательском центре (FZJ) в Германии. Соглашение о создании Alice Recoque подписано между EuroHPC JU и французским национальным агентством высокопроизводительных вычислений (GENCI). Комплекс будет смонтирован в дата-центре на территории Брюйер-ле-Шатель (Bruyères-le-Châtel), к юго-западу от Парижа. Как сообщается, в состав Alice Recoque войдут унифицированный вычислительный раздел и скалярный раздел. Основой первого послужит новая платформа Eviden BullSequana XH3500, содержащая серверы с 256-ядерными процессорами AMD EPYC Venice и ускорителями Instinct MI430X, оснащёнными 432 Гбайт памяти HBM4 с пропускной способностью 19,6 Тбайт/с. Кроме того, говорится о применении AMD FPGA и высокопроизводительной подсистемы хранения данных DDN. Суперкомпьютер объединит 94 стойки с суммарным энергопотреблением «менее 15 МВт». В свою очередь, скалярный раздел будет использовать 128-ядерные Arm-процессоры SiPearl Rhea2. Общее количество таких ядер превысит 100 тыс. В качестве интерконнекта в составе Alice Recoque планируется использовать технологию BullSequana eXascale Interconnect (BXI v3), обеспечивающую скорость передачи данных до 400 и 800 Гбит/с для CPU- и GPU-узлов соответственно. Машина получит систему прямого жидкостного охлаждения (DLC) пятого поколения (с тёплой водой) разработки Eviden для унифицированных стоек и технологию охлаждаемых дверей для скалярных стоек. Интеллектуальное программное обеспечение Eviden Argos обеспечит мониторинг в режиме реального времени и оптимизацию энергопотребления. Говорится о широком применении компонентов с открытым исходным кодом, таких как SLURM, Kubernetes, LUSTRE, Grafana и Prometheus. Монтаж суперкомпьютера Alice Recoque начнётся в 2026 году. Затраты на приобретение, доставку, установку и обслуживание системы составят €354,8 млн. EuroHPC JU предоставит половину этой суммы, ещё столько же обеспечат Франция, Нидерланды и Греция в рамках Консорциума Жюля Верна. Общие инвестиции в проект на протяжении пяти лет оцениваются в €554 млн. Использовать новый вычислительный комплекс планируется для решения сложных задач в сферах моделирования климата, разработки передовых материалов, энергетики и пр. Система также поможет в развитии европейских моделей ИИ следующего поколения и цифровых двойников для персонализированной медицины.

19.11.2025 [01:11], Владимир Мироненко

$30 млрд и 1 ГВт: Microsoft, NVIDIA и Anthropic договорились о сотрудничествеMicrosoft, NVIDIA и Anthropic объявили о стратегическом партнёрстве, которое включает ряд новых инициатив. Как сообщается, Anthropic взяла на себя обязательство приобрести вычислительные мощности Azure стоимостью $30 млрд и заключить контракт на поставку дополнительных вычислительных мощностей объёмом до 1 ГВт для обеспечения будущих потребностей в масштабировании. В рамках партнёрства NVIDIA и Microsoft также обязуются инвестировать в Anthropic до $10 и $5 млрд соответственно. Компании также расширят существующее партнёрство, чтобы обеспечить предприятиям более широкий доступ к ИИ-модели Claude. Клиенты Microsoft Azure AI Foundry смогут получить доступ к продвинутым (frontier) версиям модели Claude, включая Claude Sonnet 4.5, Claude Opus 4.1 и Claude Haiku 4.5. Это партнёрство делает Claude единственной frontier-моделью LLM, доступной во всех трёх самых известных облачных сервисах мира. Также Claude будет интегрирована в пакет Copilot, включающий GitHub Copilot, Microsoft 365 Copilot и Copilot Studio. Генеральный директор Anthropic Дарио Амодеи (Dario Amodei) отметил, что акцент Microsoft на корпоративные платформы естественным образом подходит Claude, которая часто используется в бизнес-приложениях, пишет The Wall Street Journal. В рамках стратегического партнёрства Anthropic и NVIDIA будут сотрудничать в области проектирования и инжиниринга с целью обеспечения наилучшей производительности, экономичности и общей стоимости владения для моделей Anthropic, а также оптимизации будущих архитектур NVIDIA для рабочих нагрузок Anthropic. Первоначально Anthropic будет использовать вычислительные системы NVIDIA Grace Blackwell и Vera Rubin мощностью до 1 ГВт. Аналитики Bank of America утверждают, что эти, на первый взгляд, цикличные сделки являются для лидеров отрасли способом расширить свой потенциальный целевой рынок, что «может многократно увеличить будущие выгоды». Как отметил ресурс Converge! Network Digest, с учётом нынешнего объявления портфель обязательств Microsoft в области ИИ теперь превышает $100 млрд, включая контракты с OpenAI, Inflection и Anthropic. Эти долгосрочные соглашения помогают Microsoft обосновать ускоренное строительство ИИ ЦОД, закупки электроэнергии и развёртывание ИИ-систем. Сделка также укрепляет позиции Azure по сравнению с AWS, запустившей для Anthropic ИИ-кластер Project Rainier, и Google Cloud, TPU которой также пользуется Anthropic.

18.11.2025 [10:54], Сергей Карасёв

Начался монтаж крупнейшего в США академического суперкомпьютера Horizon с ИИ-быстродействием до 80 ЭфлопсНациональный научный фонд США (NSF) объявил о начале монтажа вычислительно комплекса Horizon — крупнейшего в стране академического суперкомпьютера. Система расположится в Техасском центре передовых вычислений (TACC) при Техасском университете в Остине (UT Austin). Проект реализуется в сотрудничестве с Dell, NVIDIA, VAST Data, Spectra Logic, Versity и Sabey Data Centers. Суперкомпьютер будет развёрнут в новом дата-центре мощностью 15–20 МВт с передовым жидкостным охлаждением в Раунд-Роке (штат Техас). В основу системы лягут серверы Dell PowerEdge. Говорится об использовании процессоров NVIDIA Vera и суперчипов NVIDIA Grace Blackwell. В общей сложности будут задействованы около 1 млн CPU-ядер и примерно 4 тыс. GPU. Архитектура предусматривает использование интерконнекта NVIDIA Quantum-2 InfiniBand. Вместимость локального хранилища данных, выполненного исключительно на основе SSD, составит 400 Пбайт. Оно обеспечит пропускную способность при чтении/записи более 10 Тбайт/с. Заявленная производительность Horizon — 300 Пфлопс: это примерно в 10 раз больше по сравнению с системой Frontera, которая в настоящее время является самым мощным академическим суперкомпьютером в США. При выполнении ИИ-задач новый вычислительный комплекс обеспечит быстродействие до 20 Эфлопс на операциях BF16/FP16 и до 80 Эфлопс в режиме FP4 — более чем 100-кратный прирост по сравнению с нынешними машинами, которые эксплуатируются в американских академических кругах. При этом говорится о повышении энергетической эффективности до шести раз. Запуск Horizon запланирован на весну 2026 года. Суперкомпьютер будет использоваться для решения сложных и ресурсоёмких задач в таких областях, как биомедицина, физика, энергетика, экология и пр. В частности, система будет применяться для моделирования климата.

18.11.2025 [01:10], Игорь Осколков

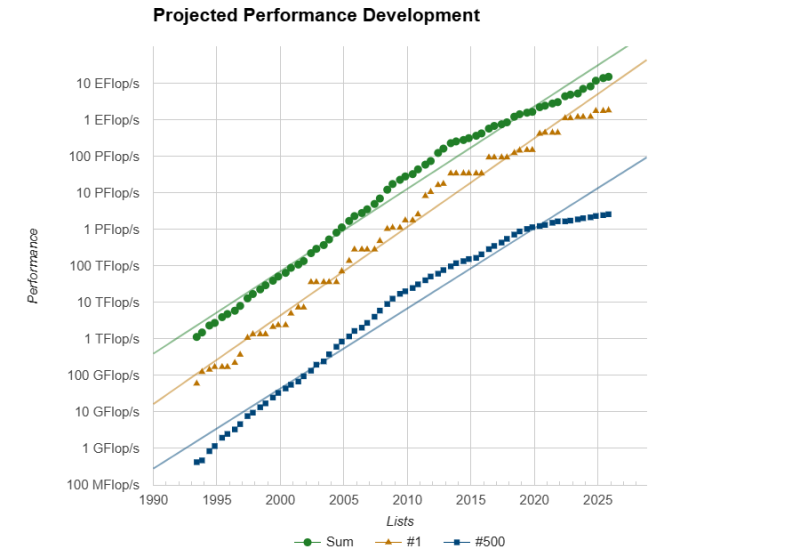

Европа присоединилась к экзафлопсному клубу с суперкомпьютером JUPITERЕвропейский суперкомпьютер JUPITER (Joint Undertaking Pioneer for Innovative and Transformative Exascale Research) в Юлихском исследовательском центре (FZJ) в Германии официально преодолел важную отметку — FP64-производительность его GPU-модуля Booster достигла ровно 1 Эфлопс при пиковой теоретической 1,227 Эфлопс. Таким образом в нынешнем рейтинге TOP500 он занял четвёртое место, совсем чуть-чуть не дотянув до суперкомпьютера Aurora с его 1,012 Эфлопс. Впервые машина попала в июньский рейтинг TOP500 с показателем 793 Пфлопс, но тогда она не была полностью готова. Официальный запуск состоялся лишь в сентябре. Впрочем, за прошедшие с момента выхода прошлого рейтинга его лидер El Capitan тоже нарастил мощность, с 1,742 Эфлопс до 1,809 Эфлопс. Frontier же остался на втором месте с показателем 1,353 Эфлопс, хотя изначально он «дотягивался» только до 1,102 Эфлопс. Таким образом, JUPITER формально стал первой публичной экзафлопсной системой за пределами США, если не брать в расчёт китайские системы, о которых КНР предпочитает не распространяться. Мощные суперкомпьютеры, не участвующие в TOP500, бывали и раньше, но вот есть ли среди них машина такого класса, остаётся только гадать. Так что если через полгода не будет развёрнут ещё какой-нибудь крупный суперкомпьютер, что вполне реально с нынешними возможностями (нео-)облаков, то JUPITER наверняка поднимется в рейтинге на строчку выше. Сейчас Booster включает порядка 6 тыс. узлов BullSequana XH3000 с 24 тыс. ускорителей GH200 в Quad-исполнении, объединённых 200G-интерконнектом InfiniBand NDR. Ещё приблизительно 5 Флопс в FP64 JUPITER получит от CPU-модуля cCuster из 1300 узлов с 2600 Arm-процессорам SiPearl Rhea1 с 80 ядрами и 64 Гбайт HBM2e. Узлы и интерконнект будут использоваться те же, что в Booster. Однако выпуск этих процессоров только-только начался, так что апгрейд будет завершён только в следующем году. TOP500 в целом в этот раз новизной технологий не блещет, отражая скорее типичный цикл обновления систем. Всего в ноябрьском рейтинге появилось 45 новых машин. Самая крупная из них — 135,4-Пфлопс CHIE-4, построенная для SoftBank на базе NVIDIA DGX B200 с InfiniBand NDR400 — занимает аж 17 позицию. Она же единственная пополнила первую десятку рейтинга HPCG с результатом 3760,55 Тфлопс, где заняла шестую позицию. Из необычных новинок можно выделить суперкомпьютер MAXIMUS-384 на 20 месте (114,5 Пфлопс), который объединил Intel Xeon Emerald Rapids и AMD Instinct MI300X. Впрочем, вторая во всём списке и уже не такая новая система с MI300X — IronMan — объединяет их с Sapphire Rapids. От России в TOP500 попали пять суперкомпьютеров (три от Яндекса и два от Сбера), которые если и обновляли с момента последнего официальной заявки на вхождение в рейтинг, то вряд ли бы стали громко и публично об этом рассказывать. Зато у соседнего Казахстана есть сразу две машины. На 86 позиции с производительностью 20,48 Пфлпос находится Alem.Cloud, на 103 — AI-Farabium с 17,93 Пфлопс. Обе системы используют сочетание Xeon Emerald Rapids, NVIDIA H200 (SXM) и 400G-интерконнект, но первая получила Ethernet, а вторая — InfiniBand NDR. В Green500 существенных изменений тоже не наблюдается. Ровно половину первой десятки занимают машины с NVIDIA GH200. В общей массе чипы NVIDIA тоже доминируют. При этом первая система без ускорителя занимает аж 105 строчку, и до 113 позиции это сплошь Fujitsu A64FX, лежащие в основе Fugaku. Всего TOP500 уже более половины машин оснащены ускорителями. Но от ожидаемого ранее уровня роста производительности весь рейтинг отстаёт на протяжении уже пяти лет. С другой стороны, и фокус сейчас сместился на ИИ, а новым кластерам некогда участвовать в ненужных для них рейтингах. |

|