Материалы по тегу: обучение

|

19.02.2026 [15:57], Руслан Авдеев

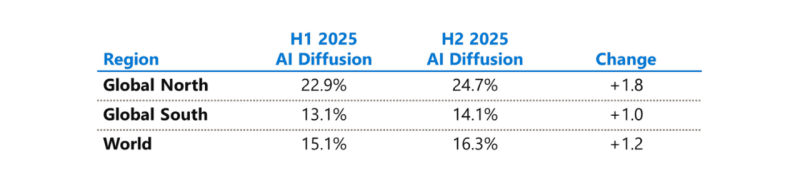

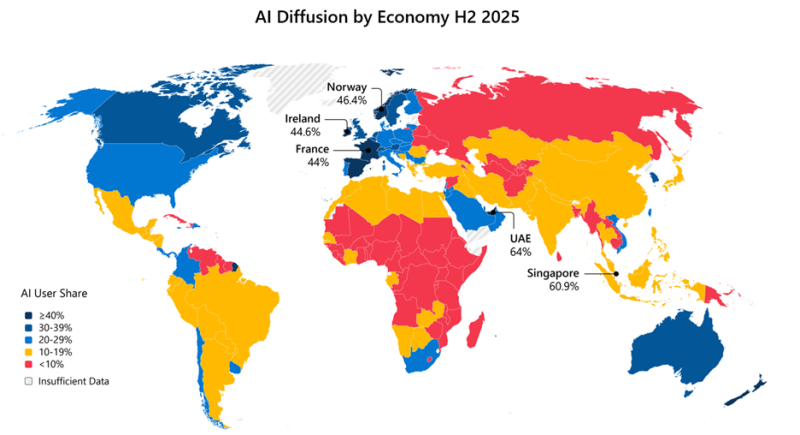

Microsoft бросилась исправлять ИИ-неравенство в мире и выделила на это $50 млрдНа недавнем мероприятии India AI Impact Summit представители Microsoft объявили, что компания готовится инвестировать к концу десятилетия $50 млрд для того, чтобы обеспечить доступ к ИИ странам Глобального Юга. Технологии искусственного интеллекта стремительно распространяются, но чрезвычайно неравномерно в мировом масштабе. В докладе Microsoft AI Diffusion Report утверждается, что в странах Глобального Севера ИИ используется вдвое активнее, чем на юге, и неравенство продолжает увеличиваться. Это сказывается не только на национальном и региональном экономическом росте, но и перспективах развития. Более века неравный доступ к электроэнергии увеличивал экономический разрыв между Глобальным Севером и Югом. С ИИ может произойти аналогичная история. Потребности в новых технологиях требуют существенных инвестиций и больших усилий правительств, частного сектора и НКО. Выделенные Microsoft $50 млрд призваны поддержать новые возможности в странах Глобального Юга. Программа развития ИИ состоит из пяти элементов:

Инфраструктура жизненно необходима для распространения ИИ, говорит компания. ИИ требует энергии, каналов связи, вычислительных мощностей. Только в последнем финансовом году Microsoft инвестировала более $8 млрд в инфраструктуру ЦОД, обслуживающую Глобальный Юг, включая Индию, Мексику, страны Африки, Южной Америки, Юго-Восточной Азии и Ближнего Востока. В первую очередь компания стремится расширить доступ в интернет 250 млн человек в макрорегионе. Microsoft заявила, что уже помогла получить доступ в интернет 117 млн человек в Африке. Инвестиции в ИИ-инфраструктуру осуществляются с учётом необходимости обеспечения местного суверенитета, хотя не так давно компания объявила, что не может обеспечить суверенитет данных в Европе из-за особенностей американского законодательства. Microsoft заявила о создании суверенного управления в публичных облаках, частных суверенных предложениях и тесном сотрудничестве с национальными партнёрами на местах. Утверждается, что в эру ИИ вся информация остаётся в руках клиентов под их полным контролем, без передачи сторонним провайдерам. При этом Глобальный Юг требует огромных инвестиций в инфраструктуру ЦОД, энергетику и связь, что крайне затруднительно без зарубежных инвестиций, в том числе со стороны техногигантов. В числе прочего для удовлетворения этих потребностей было сформировано партнёрство Trusted Tech Alliance, объединяющее 16 ведущих технологических компаний из 11 стран с четырёх континентов.

Источник изображения: Microsoft Однако ЦОД и интернет-каналы — лишь часть необходимой инфраструктуры. Не меньшее значение имеет доступ к технологиям для школ, университетов и НКО и цифровым компетенциям. В предыдущем финансовом году Microsoft инвестировала в программы для государств Глобального Юга $2 млрд, включая гранты, пожертвования, льготы и обучающие программы. В 2025 году компания запустила инициативу Microsoft Elevate, призванную к 2028 году подготовить 20 млн дипломированных специалистов с востребованными ИИ-компетенциями. В Индии компания обучила уже 5,6 млн человек, а к 2030 году намерена довести это число до 20 млн. Компания подготовит 2 млн учителей из более 200 тыс. школ и вузов, а также оснастит 25 тыс. учебных учреждений ИИ-инфраструктурой. Ещё одно направление — создание и доработка ИИ-моделей на местных языках, поскольку локальные решения пока что хуже, чем решения на английском языке. Microsoft поддержала инвестиции в инициативу LINGUA Africa (выделено $5,5 млн) по сбору языковых данных и развитие моделей для африканских языков. Дополнительно совершенствуется бенчмарк MLCommons AILuminate для индийских и азиатских языков для оценки безопасности ИИ вне англоязычной среды. Совместно с образовательными и коммерческими структурами из Индии, Японии, Кореи и Сингапура при участии Microsoft создаётся мультиязычная и мультимодальная подборка из 7 тыс. высококачественных промптов для хинди, тамильского, малайского, японского и корейского языков. Также Microsoft развивает метод Samiksha для учёта локальных языковых и культурных контекстов. Samiksha позволяет выявлять сбои, которые часто упускаются «англоцентричными» методами оценки. В Африке компания совместно с NASA, властями и др. организациями будет применять ИИ к спутниковым данным для анализа продовольственной ситуации. Технология уже отработана в Индии. В рамках Project Gecko компания развивает ИИ-технологии совместно с сообществами в Восточной Африке и Южной Азии для поддержки с/х. В том числе речь идёт о семействе моделей для распознавания речи Paza, способных работать на мобильных устройствах с шестью кенийскими языками. Ведутся работы над многоязыковыми инструментами Copilot, Multimodal Critical Thinking (MMCT) Agent для анализа видео с учётом голоса и текста, адаптацией LLM к низкоресурсным языкам (в т.ч. чичева, инуктитут, маори) и т.д.

Источник изображения: Microsoft Для ускоренного внедрения ИИ нужно понимать, где и как применяется ИИ, с каким недостатками приходится сталкиваться разработчикам, говорит Microsoft. На основе статистики публичных репозиториев GitHub и метрик Azure Foundry компания участвует в создании «рейтинга» Global AI Adoption Index Всемирного Банка. Например, индийское сообщество из 24 млн разработчиков — второе по величине на GitHub и самое быстрорастущее среди 30 ведущих экономик. С 2020 года ежегодный прирост составляет более 26 %, в 2025 году он составил более 36 %. Индийские специалисты занимают второе место в мире по вкладу в open source, использованию GitHub Education, по вкладу в публичные ИИ-проекты и др. Такие данные помогают точнее направлять инвестиции в инфраструктурные проекты, языковые технологии и на обучение. Поддержка подобных метрик помогает измерять достигнутый прогресс. Microsoft подчёркивает, что компания акцентирует внимание в вопросах внедрения ИИ на необходимости создания доступной инфраструктуры, надёжно работающих в реальном мире системах, а также технологиях, которые могут применяться с учётом местных условий. Для этого компания намерена работать с партнёрами, включая обмен данными для оценки прогресса.

04.02.2026 [15:00], Руслан Авдеев

Барнсли станет первым ИИ-городом в ВеликобританииРасположенный в Южном Йоркшире (Великобритания) Барнсли, ранее известный добычей угля и стекольным производством, станет первым в стране «технологическим городом» (Tech Town). Он будет внедрять ИИ во все сферы жизнедеятельности — от местного бизнеса до государственных услуг, сообщает The Register. Как объявило Министерство науки, инноваций и технологий (DSIT), Барнсли станет примером для всей Великобритании в деле внедрения ИИ-технологий. В DSIT утверждают, что жители городка смогут увидеть повышение качества государственных услуг, более эффективную поддержку местных школ, более быстрый доступ к медицинской помощи, а также новые возможности для трудоустройства и повышения квалификации. В министерстве подчёркивают, что на примере Барнсли намерены показать, что ИИ помогает учиться, оказывает поддержку местному бизнесу и способствует повышению качества госуслуг. На этом примере можно будет продемонстрировать, сколь полезен искусственный интеллект для всей страны. В рамках новой программы жителям города будут предоставлять бесплатное обучение в сфере ИИ и цифровых технологий в местных учебных заведениях. Дополнительно запланировано тестирование в школах и городском колледже образовательных технологий для сбора данных об их влиянии на обучение и о том, смогут ли они снизить нагрузку на местный педагогический состав.

Источник изображения: Jamie Street/unsplash.com Действующая недалеко от центра города площадка Seam Digital Campus расширяется для оказания поддержки малому бизнесу при внедрении и масштабировании новых технологий. Городской совет в рамках программы получит стартовое финансирование £500 тыс. ($683 тыс.). В числе присоединившихся к программе компаний есть Microsoft и Cisco, уделяющие, с их слов, «особое внимание» обучению ИИ-навыкам взрослых и поддержке малых и средних предприятий. Впрочем, к середине прошлого года Microsoft, не в последнюю очередь благодаря внедрению ИИ, сократила 15 тыс. сотрудников, а эксперимент по использованию ИИ британскими госслужащими в Microsoft 365 и Office 365 в целом провалился, поскольку Copilot заметного роста производительности не дал. Cisco тоже сократила около 6 тыс. человек в рамках реструктуризации с переходом на ИИ-инструменты. В целом в компаниях, внедряющих ИИ, отмечается сокращение рабочих мест, поэтому польза для жителей Барнсли не вполне очевидна. DSIT отказалось дать СМИ прямые гарантии, что повсеместное внедрение искусственного интеллекта в городе не приведёт к потере рабочих мест. Остаются без ответа и другие вопросы, включая этические нормы применения ИИ в здравоохранении или образовании. А представители городского совета заявили, что одна из ключевых задач стратегии инклюзивного экономического роста — сделать Барнсли ведущим цифровым городом Великобритании. Сегодня речь идёт об «одной из важнейших инвестиций в город за всю его историю».

Источник изображения: Maria Ilves/unsplash.com Уголь в городе больше не добывают, последние шахты там закрыли в начале 1990х гг., и масштабного появления вакансий не предвидится. По данным TechMarketView, отведённые для модернизации здравоохранения, образования и поддержки бизнеса 18 мес. могут означать, что ресурсы будут слишком сильно «распылены», что помешает добиться подлинных изменений в любой из областей. Кроме того, существует проблема доверия. Организации государственного сектора неоднократно вкладывали значительные ресурсы в технологические проекты, не получив взамен ожидаемой отдачи, поэтому на предложение о реализации очередного проекта они могут сослаться на отсутствие ресурсов, просто не желая тратить их без гарантий окупаемости. Если же медицинские учреждения, школы и др. не смогут выделить ресурсы, трансформация застопорится независимо от того, какие технологии предлагаются. TechMarketView подчёркивает, что если Барнсли не сможет добиться ощутимых успехов, это не просто помешает внедрению программы, но и вызовет скептическое отношение к инвестициям в ИИ у других регионов. Усугубляет риск отсутствие чётких показателей успеха — в условиях, когда население заинтересовано устранением выбоин на дорогах и своевременным вывозом мусора, объявление Барнсли «технологическим городом» может показаться жителям лишь отвлекающим манёвром. Внедрение новых цифровых технологий не всегда проходит успешно, в том числе в Великобритании. Так, рутинная на первый взгляд задача по смене ERP-системы в муниципалитете Бирмингема обернулась для местных властей настоящим кошмаром с катастрофическими затратами и задержками.

27.01.2026 [09:09], Руслан Авдеев

Сингапур потратит S$1 млрд на то, чтобы остаться в авангарде ИИ-прогрессаСингапур намерен потратить свыше S$1 млрд ($786 млн) на финансирование Национального плана исследований и разработок в области ИИ (NAIRD) для укрепления государственного потенциала в соответствующей сфере. По данным местного Министерства цифрового развития и информации (MDDI), финансирование будет осуществляться с 2025 по 2030 гг., сообщает Channel News Asia. Анонсированный главой MDDI Джозефин Тео (Josephine Teo) план призван поддержать укрепление амбиций страны в сфере ИИ в рамках обновлённой национальной стратегии National AI Strategy (NAIS) 2.0. В 2019 году появилась первая национальная стратегия Сингапура в сфере искусственного интеллекта, в рамках которой страна начала реализацию ИИ-проектов в области образования, здравоохранения, логистики, безопасности и др. NAIS 2.0 анонсировали в 2023 году, тогда ставилась цель более чем втрое нарастить количество специалистов в сфере ИИ (до 15 тыс. человек) и помочь Сингапуру стать лучшим регионом для ИИ-разработчиков. Нынешние инвестиции в объёме S$1 млрд — часть общих вложений Национального исследовательского фонда (NRF) Сингапура в объёме S$37 млрд в технологическое развитие страны, объявленных в декабре 2025 года. S$28 млрд на те же цели выделили годом ранее. План NAIRD предусматривает приоритетное развитие трёх направлений: фундаментальных исследований в сфере ИИ, прикладных исследований в той же области, а также поиск талантов для реализации национальной ИИ-стратегии. Для этого Сингапур построит центры исследований в сфере ИИ, в которых будут работать не только местные, но и зарубежные специалисты. По словам Тео, центры будут работать над решением долгосрочных, сложных задач. В частности, речь идёт об исследованиях и разработках в областях защиты от рисков, связанных с внедрением ИИ, и защитой от злоупотреблений такими системами. Центры будут работать и над широким кругом других смежных проблем, например, над разработкой многоцелевого искусственного интеллекта, способного решать задачи в разных сферах. В прикладной сфере новый план предусматривает укрепление потенциала для поддержки внедрения ИИ в промышленности, а также поддержку инициатив, выдвинутых исследовательскими, инновационными и корпоративными структурами. По словам властей, новый план также ориентирован на обучение «двуязычных» исследователей, владеющих и навыками в сфере ИИ, и одновременно являющихся экспертами в какой-либо области. Также Сингапур намерен создать условия для перехода от теории к практике, превращения исследования в прикладные продукты. Планируется и дальше поддерживать инициативы, направленные на поддержку интереса к ИИ-исследованиям среди молодёжи. На уровне высшего образования студентам предоставят возможность взаимодействия с ведущими научно-исследовательскими учреждениями локально и за рубежом, с расширением стипендиальных программ. Создаются и условия для поддержки преподавателей, в т.ч. речь идёт о программе приглашенных профессоров AI Visiting Professorship для обеспечения сотрудничества между местными и международными исследователями. Параллельно привлекаются и ведущие стартапы и ИИ-компании для размещения своих исследовательских команд в Сингапуре. В MDDI заявляют, что исследования в области ИИ позволят Сингапуру оставаться в авангарде в данной сфере. В 2025 году Сингапур занимал третье место в глобальном рейтинге ИИ-исследований издания The Observer, с ранжированием стран по уровню инвестиций, инноваций и внедрения ИИ. Страна уступает только США и Китаю. В последнее время в Сингапуре всё больше компаний, открывших собственные исследовательские лаборатории, включая Microsoft Research Asia и Google DeepMind. Одна из главных проблем Сингапура — острая нехватка свободной энергии и земли для ИИ ЦОД. Поэтому конкуренты не дремлют, и соседняя Малайзия уже недвусмысленно выражала желание стать главным IT-хабом региона. Собственные амбиции того же рода в регионе имеют Индонезия и Вьетнам. Попутно Сингапур всё чаще подозревают в помощи китайским компаниям в обходе санкций США.

22.01.2026 [17:40], Руслан Авдеев

OpenAI представила программу Stargate Community для налаживания добрососедских отношений с местными жителямиКомпания OpenAI, объявившая о намерении создать «общий искусственный интеллект» (AGI) на благо всего человечества, намерена организовать работу таким образом, чтобы в ходе достижения этой цели её кампусы приносили пользу местным жителям. С этой целью компания представила программу Stargate Community, способствующую развитию экономики и созданию рабочих мест в регионах присутствия. В рамках инициативы Stargate компания задалась целью нарастить инфраструктуру ИИ в США до 10 ГВт к 2029 году. Первый объект в Абилине (Abilene, Техас) уже работает, новые объекты строятся по всей стране. С момента запуска в январе 2025 года, партнёры по Stargate анонсировали несколько проектов большой мощности по всему миру. В сентябре были анонсированы планы построить пять кампусов ЦОД в Техасе, Нью-Мексико, Висконсине и Мичигане общей мощностью 5,5 ГВт. ИИ уже приносит ощутимую пользу, помогая сотням людей в вопросах здоровья и обеспечения общего благополучия, говорит OpenAI. В будущем каждая площадка Stargate будет иметь собственный план Stargate Community, подготовленный с учётом местных проблем. По словам компании, добиться результатов можно, только будучи «хорошими соседями». Компания намерена компенсировать свои энергопотребности таким образом, что это не будет приводить к росту тарифов на электричество для местных жителей, строя энергохранилища, оплачивая создание генерирующих мощностей и модернизацию электросетей, разрабатывая режимы гибкого эгнергопотребления и др. Так, в Висконсине Oracle и Vantage совместно с WEC Energy Group развивают генерирующие мощности и полностью берут на себя расходы на энергетическую инфраструктуру нового объекта, чтобы все затраты на энергосети для ИИ ЦОД не перекладывались на обычных потребителей. В Мичигане Oracle и Related Digital взаимодействуют с DTE Energy в вопросе использования существующих энергоресурсов, дополненных новым аккумуляторным хранилищем, оплаченным проектом. Наконец, в Техасе принадлежащая SoftBank компания SB Energy рассчитывает построить новые генерирующие мощности и системы хранения энергии, чтобы обеспечить большую часть потребностей местного кампуса Stargate на 1,2 ГВт. OpenAI также приветствует инициативу Microsoft Community-First AI Infrastructure Plan, распространяющуюся на строящиеся для OpenAI кампусы, в рамках которой компания тоже пообещала сохранить стабильные тарифы на электроэнергию для обычных граждан, стать водноположительной, обучать и создавать рабочие места для местных жителей, а также направлять средства на социальные нужды и поддерживать местные НКО. В OpenAI тоже придерживаются подхода, при котором используются замкнутые или использующие мало питьевой воды системы охлаждения. Власти Абилина утверждают, что местный кампус будет потреблять в год вдвое меньше, чем город использует за день. Такие же решения внедряются в кампусах Stargate в других локациях, а в Висконсине не менее $175 млн направят на местную инфраструктуру и проекты восстановления водных ресурсов. В Абилине же откроется первая OpenAI Academу для подготовки специалистов в области ИИ ЦОД, от строителей до управляющих. Несмотря на все попытки OpenAI и партнёров, а также указы правительства, у экспертов и общественности сохраняются опасения, что крупные ИИ ЦОД приведут к росту цен на электричество. Вызывает обеспокоенность и вероятное использование природного газа для энергоснабжения объектов Stargate. В марте 2025 года сообщалось, что Crusoe, ответственная за строительство ЦОД в Абилине, заказала газовые турбины общей мощностью 4,5 ГВт для питания сети ЦОД.

11.12.2025 [14:05], Руслан Авдеев

Amazon инвестирует $35 млрд в Индию к 2030 году для инноваций в сфере ИИ и создания рабочих местAmazon объявила о намерении вложить более $35 млрд в индийские подразделения компании до 2030 года в дополнение к уже потраченным здесь $40 млрд. Новые инвестиции направят на масштабирование активности и три стратегически важных направления: цифровизацию на основе ИИ, рост экспорта и создание рабочих мест. В отчёте Keystone Strategy говорится, что инвестиции $40 млрд (в т.ч. выплаты сотрудникам и деньги на развитие инфраструктуры) сделали компанию крупнейшим зарубежным инвестором в стране, крупнейшим «катализатором» экспорта с помощью электронной торговли, и одним из ключевых создателей рабочих мест в Индии. Значительные средства затрачены на создание физической и цифровой инфраструктуры, в т.ч. пунктов обслуживания, логистических сетей, дата-центров и инфраструктуры цифровых платежей. По данным Keystone, Amazon оцифровала более 12 млн малых предприятий, помогла увеличению объёма экспорта с помощью электронной коммерции на сумму $20 млрд, а в 2024 году обеспечила порядка 2,8 млн прямых и косвенных рабочих мест в различных отраслях индийской экономики, включая технологическую сферу, логистику, службы поддержки и др. с медицинским страхованием и обучением. В Amazon утверждают, что влияние компании в стране выходит за рамки прямого трудоустройства сотрудников, она обеспечивает рабочие места в сфере упаковки, логистики и сопутствующих технологий, а также даёт возможность развития на своей торговой площадке тысячам малых предприятий. В 2030 году количество прямых и косвенных рабочих мест увеличится до 3,8 млн благодаря расширению бизнеса как самой Amazon, так и растущих сетей пунктов обслуживания и сервисов доставки — одновременно поддерживаются и смежные отрасли. Совокупный объём экспорта, связанный с электронной коммерцией, к 2030 году должен вырасти в четыре раза до $80 млрд.

Источник изображения: pavan gupta/unsplash.com Благодаря дополнительным вложениям $35 млрд Amazon намерена ускорить цифровую трансформацию в стране, укрепить местную инфраструктуру и поддержать инновации. Инвестиции соответствуют приоритетам Индии и направлены на расширение возможностей ИИ, улучшение логистики, поддержку роста малого бизнеса и создание новых рабочих мест. Программа Amazon по внедрению ИИ во все сферы жизни должна помочь преобразовать цифровое пространство страны, поддерживая заявленную государством концепцию «ИИ для всех». К 2030 году Amazon намерена обеспечить преимущества ИИ 15 млн малых предприятий — продавцы на платформе Amazon.in уже используют ИИ-инструменты Seller Assistant, Next Gen Selling и др. Опыт покупок для сотен миллионов покупателей планируется улучшить с помощью инструментов Lens AI (визуальный поиск), интерактивных покупок с помощью Rufus и многоязычных интерфейсов. Также планируется предоставить 4 млн школьников возможности обучиться навыкам работы с ИИ и познакомить их с карьерными возможностями в технологической сфере. Программа включает разработку учебной программы, посвящённой ИИ, экскурсии в технологические компании, практические занятия в «ИИ-песочнице» и обучение самих преподавателей. Инициатива напрямую поддерживает цели Национальной образовательной политики Индии от 2020 года. О том, сколько именно средств выделят на ИИ-инфраструктуру, включая ЦОД AWS, не сообщается. В начале 2025 года AWS выделила $8,3 млрд только на строительство одного облачного региона — AWS Asia-Pacific в Мумбаи (Mumbai). Регион работает с 2016 года, к 2022 году компания инвестировала в него $3,7 млрд. В 2022 году она запустила облачный регион в Хайдарабаде (Hyderabad). Обязательство потратить $8,3 млрд на ЦОД в Мумбаи — часть более обширного инвестиционного плана, в рамках которого AWS намеревалась потратить в Индии $12,7 млрд. Также компания планирует инвестировать $7 млрд в течение 14 лет в облачный регион в Хайдарабаде. Последние новости об Amazon появились вскоре после того, как Microsoft объявила о планах потратить $17,5 млрд на ИИ-инфраструктуру в Индии к 2030 году. В октябре 2025 года Google подтвердила о реализации проекта по строительству кампуса ЦОД в штате Андхра-Прадеш (Andhra Pradesh), планируется потратить $15 млрд за пять лет.

21.11.2025 [14:14], Руслан Авдеев

AWS и Humain построят в Эр-Рияде кампус AI Zone, где развернут до 150 тыс. ИИ-ускорителей NVIDIA GB300 и Amazon TrainiumAWS и инвестиционная компания Humain из Саудовской Аравии объявили о планах развёртывания в кампусе AI Zone в Эр-Рияде до 150 тыс. ИИ-ускорителей. В рамках расширенного партнёрства компании намерены предоставлять вычислительные мощности и ИИ-сервисы из Саудовской Аравии клиентам со всего мира. Первый в своём роде в Саудовской Аравии кампус AI Zone будет применяться для обучения ИИ и инференса, с доступом к новейшей ИИ-инфраструктуре на основе ускорителей NVIDIA GB300 и Amazon Trainium. Клиенты смогут быстро переходить от стадии концепции к непосредственно работам, а «железо» и ПО NVIDIA будут бесшовно интегрированы с инфраструктурой и сервисами AWS. Поддержка Amazon Bedrock, AgentCore и SageMaker обеспечит клиентам немедленный доступ к базовым моделям в рамках единой платформы без необходимости управления базовой инфраструктурой. Для расширения возможностей AI Zone компания Humain присоединится к программе AWS Solution Provider Program. Это поможет реализации совместного плана, анонсированного в мае 2025 года и предусматривающего инвестиции более $5 млрд в ИИ-инфраструктуру, сервисы AWS, обучение и развитие ИИ-специалистов в Саудовской Аравии. Представитель AWS в регионе EMEA заявил, что объединяя локальный опыт и инвестиции Humain с решениями AWS в сфере ИИ, а также аппаратные решения NVIDIA, инновационную платформу Amazon Bedrock и решения для бизнес-пользователей, включая Amazon Quick Suite, партнёры создают инновационный центр мирового уровня, способный обслуживать клиентов по всему миру. AWS и Humain также ускорят внедрение ИИ в государственном и частном секторах, в том числе развитие LLM с поддержкой арабского языка, включая ALLAM, и создание единого маркетплейса ИИ-агентов для правительственных сервисов.

Истчоник изображения: backer Sha/unsplash.com Для подготовки квалифицированных кадров AWS обучит 100 тыс. граждан Саудовской Аравии работе с облачными технологиями и специфике генеративного ИИ в рамках программы Amazon Academy, отдельно планируется поддержать программу повышения квалификации для 10 тыс. женщин. Усилия направлены на подготовку кадров для «ИИ-центричной» экономики, которая, по прогнозам, к 2030 году внесёт в ВВП страны вклад в объёме $130 млрд. Подобные проекты стали возможны во многом благодаря визиту в США наследного принца Саудовской Аравии Мохаммеда бин Салмана (Mohammed bin Salman). Визит способствовал ряду соглашений американских компаний с саудовским бизнесом и Humain в частности — с участием AMD, xAI, NVIDIA и др., а также открыл дорогу для поставок в королевство передовых ИИ-чипов.

04.11.2025 [23:12], Владимир Мироненко

Microsoft инвестирует $15,2 млрд в ИИ-инфраструктуру и подготовку кадров в ОАЭВ то время как Объединённые Арабские Эмираты (ОАЭ) проводят свои ежегодные конференции по энергетике и технологиям компания Microsoft поделилась подробностями об инвестициях в эту страну, общая сумма которых за период с 2023 по 2029 год составит $15,2 млрд. «Это не деньги, собранные в ОАЭ. Это деньги, которые мы тратим в ОАЭ. И, как и везде в мире, мы сосредоточены не только на развитии нашего бизнеса, но и на содействии развитию местной экономики», — сообщил Брэд Смит (Brad Smith), заместитель председателя совета директоров и президент Microsoft. По словам Смита, в 2023–2025 гг. общий объём инвестиций Microsoft в ОАЭ составит чуть более $7,3 млрд. Эта сумма включает инвестиции в акционерный капитал G42 в размере $1,5 млрд, более $4,6 млрд капвложений в передовые ИИ-технологии и ЦОД, а также более $1,2 млрд в виде местных операционных расходов и стоимости проданных товаров. В 2026–2029 гг. компания планирует инвестировать ещё $7,9 млрд, из которых $5,5 млрд будут направлены на дальнейшее расширение инфраструктуры, а $2,4 млрд придётся на операционные расходы и продажи. Смит отметил, Microsoft была одной из немногих компаний при предыдущей администрации Белого дома США, получивших экспортные лицензии Министерства торговли на поставку ускорителей в ОАЭ, благодаря чему она накопила в стране эквивалент 21,5 тыс. NVIDIA A100. Фактически это комбинация чипов A100, H100 и H200. Он добавил, что Microsoft стала первой компанией, получившей экспортные лицензии уже при новой администрации, которые позволяют поставить в ОАЭ эквивалент 60,4 тыс. A100, хотя в данном случае это будут уже GB300. Поставки позволят начать в Абу-Даби строительство ИИ ЦОД в рамках майского соглашения между Дональдом Трампом и президентом ОАЭ шейхом Мухаммедом бен Заидом Аль Нахайяном (Mohamed bin Zayed Al Nahyan), которое было приостановлено из-за экспортных ограничений США, пишет TechCrunch . Также Microsoft активно инвестирует в формирование кадров в ОАЭ и планирует к концу 2027 года обучить 1 млн человек. Программа включает в себя повышение квалификации 120 тыс. госслужащих федеральных и местных органов власти, а также обучение 175 тыс. студентов и 39 тыс. преподавателей. Ранее в этом году компания основала в Абу-Даби Глобальный центр развития инженерии (Global Engineering Development Center) для привлечения в ОАЭ технических специалистов мирового уровня. Здесь же был открыт новый центр Microsoft AI for Good Lab, где работают исследователи, специализирующиеся на ИИ-моделях и методах постобучения. А в феврале 2025 года Microsoft, G42 и Университет искусственного интеллекта имени Мохамеда бин Заида (MBZUAI) основали в Абу-Даби Фонд ответственного будущего ИИ (RAIFF), который продвигает этические стандарты ИИ на Ближнем Востоке и в странах глобального Юга.

17.08.2025 [18:08], Руслан Авдеев

Google потратит $9 млрд на развитие облачной и ИИ-инфраструктуры в Оклахоме — часть пойдёт на обучение электриковКомпания Google взяла обязательство вложить $9 млрд в расширение собственной облачной и ИИ-инфраструктуры на территории штата Оклахома (США). Инвестиции направят на развитие кампуса ЦОД в Стиллуотере (Stillwater) и расширение уже имеющегося объекта в Прайоре (Prior), сообщает Datacenter Dynamics. Часть выделенных средств будет потрачена на программы образования и развития персонала. В марте 2025 года стало известно, что Google подала заявку на строительство кампуса ЦОД в Стиллоутере. Тогда было объявлено, что на него потратят $3 млрд, а площадь кампуса составит более 160 га. Подробных данных о кампусе нет, но согласно проекту плана экономического развития от августа 2024 года, предполагается построить до шести зданий, каждое площадью почти 29 тыс. м2. На каждом этапе строительства предполагается строить по одному ЦОД. Объект в Прайоре Google анонсировала ещё в 2007 году, запуск состоялся в 2011-м. С тех пор дата-центр регулярно расширялся. Университет Оклахомы (University of Oklahoma) и Университет штата Оклахома (Oklahoma State University) готовы участвовать в инициативе Google AI for Education Accelerator. В её рамках можно будет получить сертификаты Google Career Certificates, а также доступ к бесплатным курсам обучения ИИ-навыкам. Также Google финансирует в Оклахоме национальную программу обучения, созданную для подготовки квалифицированных электриков — Electrical Training Alliance.

Источник изображения: Gerson Repreza/unsplash.com Ранее Оклахома никогда не считалась крупным рынком ЦОД и сопутствующих технологий. Среди недавно анонсировавших проекты ЦОД в Оклахоме — компании Cerebras, Damac и CoreWeave с Core Scientific. По слухам, кампус площадью около 138 га готовит и Meta✴. Также есть данные, что в мае подана заявка на строительство кампуса площадью более 200 га в Талсе (Tulsa), но что за компания стоит за проектом, не разглашается.

14.07.2025 [09:57], Руслан Авдеев

Google Cloud обучит работе с ИИ 100 тыс. британских госслужащихПравительство Великобритании заключило соглашение с Google Cloud, предусматривающее обучение около 100 тыс. госслужащих навыкам работы с ИИ-инструментами к 2030 году, сообщает The Register. По информации The New York Times, ещё более масштабный проект намерена реализовать Microsoft, но уже в США, где компания потратит на обучение работе с ИИ $4 млрд Министерство науки, инноваций и технологий Великобритании (DIST) объявило, что Google поможет местному правительству сделать буквально из каждого десятого госслужащего «технического эксперта», что позволит реформировать государственные службы. Без этого сотням организаций госсектора пришлось бы по отдельности вести переговоры с техногигантами, что помешало бы заключить действительно выгодную сделку. Подробности соглашения не раскрываются. Вероятно, услуги будут предоставляться в рамках соглашения G-Cloud 14 на сумму £6,5 млрд ($8,77 млрд), подписанного в конце прошлого года. В январе был представлен проект «современного цифрового правительства» и сделан анонс ИИ-инструментов Humphrey для госсектора. Ожидается, что отказ от старых технологий позволит потенциально сэкономить £45 млрд ($60 млрд). Также заявлялось, что Google DeepMind будет сотрудничать с правительственными экспертами в деле внедрения и распространения новых технологий для повышения эффективности работы госсектора.

Источник изображения: Brooke Cagle/unsplash.com Компания сообщала, что намерена избавиться от устаревших контрактов, но не сообщала, от каких именно, и как в этом поможет партнёрство в сфере облачных сервисов, учитывая долгосрочный характер проектов. Также сообщается о том, что правительство столкнулось с трудностями при переговорах с поставщиками облачных услуг. В Кабинете министров посоветовали ведомствам согласовывать свои требования для получения наиболее выгодных предложений. У госслужб страны действительно есть платформы, которые работают уже около четверти века и от которых они до сих пор не могут полностью отказаться, даже после начала внедрения заменяющих их систем. Кроме того, уже несколько лет разбирательство с IT-системой Horizon, из-за ошибок в которой множество людей получили необоснованные штраф и тюремные сроки.

14.07.2025 [08:24], Руслан Авдеев

Microsoft потратит $4 млрд на обучение американцев ИИ-навыкамMicrosoft объявила, что намерена выделить более $4 млрд в виде денежных и вычислительных ресурсов, а также ИИ-инструментов на обучение миллионов американцев навыкам использования ИИ, передаёт The New York Times. Компания направит ресурсы в школы, муниципальные колледжи, технические вузы и НКО. Не так давно десятки компаний, включая Amazon, Apple, Google, Meta✴, Microsoft, Nvidia и OpenAI, подписали соглашение с Белым домом, дав обещание обеспечить школам технологии, финансирование и учебные материалы для получения навыков в сфере ИИ. Дополнительно запущена учебная программа Microsoft Elevate Academy для обучения работе с ИИ 20 млн человек, которые получат сертификаты в этой области. Попутно «Американская ассоциация учителей» с 1,8 млн участников объявил о создании национального центра обучения ИИ для педагогов, на который Microsoft, OpenAI и Anthropic выделили $23 млн. Президент Microsoft Брэд Смит (Brad Smith) объявил, что компания будет сторонником гарантированного обучения школьников страны навыкам работе с искусственным интеллектом. Пока Microsoft не уточняет, какую часть средств намерена выделить в виде грантов, а какую — в виде доступа к ИИ-сервисам Microsoft и кредитов на облачные вычисления. Одной из первых массовую программу обучения ИИ запустила Amazon — на бесплатных онлайн-курсах AI Ready предполагалось обучить 2 млн человек. Microsoft говорит, что уже она уже более 10 лет работает над повышением уровня компьютерной грамотности в школах, в том числе лоббируя связанные законы об образовании. Также компанией финансировались некоммерческие образовательные организации вроде Code.org, работавшей с десятками миллионов школьников по всему миру. Теперь, когда ИИ-инструменты могут сами генерировать программный код, технологические компании, которые раньше были крупными экспертами в области программирования, смещают фокус в сторону чат-ботов. В частности, Microsoft заявила о поддержке новой программы Code.org под названием «Час ИИ» (Hour of A.I.), которая дополнит уроки «Час кода» (Hour of Code) По словам Смита, ИИ окажет гораздо более масштабное влияние на различные профессии и сферы деятельности по сравнению с тем, как это сделало программирование. Смит подчеркнул, что адаптация к изменениям, которые несёт ИИ, должна происходить быстрее, чем это было с компьютерными технологиями в прошлом, чтобы общество и профессионалы могли эффективно реагировать на новые вызовы и возможности. |

|