Материалы по тегу: ии

|

03.09.2025 [14:11], Сергей Карасёв

Acer представила компактную ИИ-станцию Veriton GN100 за $4000 с суперчипом NVIDIA GB10Компания Acer анонсировала рабочую станцию небольшого форм-фактора Veriton GN100 AI Mini Workstation, предназначенную для решения задач в области ИИ. Новинка, в частности, обеспечивает возможность локального запуска моделей с большим количеством параметров, снижая зависимость от облачной инфраструктуры. Устройство выполнено в корпусе с габаритами 150 × 150 × 50,5 мм. Основой служит суперчип NVIDIA GB10 Grace Blackwell, который объединяет ускоритель Blackwell с тензорными ядрами пятого поколения и 20-ядерный процессор Grace (10 × Arm Cortex-X925 и 10 × Arm Cortex-A725). Заявленная ИИ-производительность достигает 1000 TOPS на операциях FP4. Новинка несёт на борту 128 Гбайт памяти LPDDR5x, а вместимость SSD формата M.2 (NVMe) может достигать 4 Тбайт (поддерживается шифрование данных). В оснащение входят адаптеры Wi-Fi 7 и Bluetooth 5.1, а также сетевой контроллер NVIDIA ConnectX-7 SmartNIC. Предусмотрены четыре порта USB 3.2 Type-C, интерфейс HDMI 2.1b и разъём RJ45 для сетевого кабеля. Весит устройство около 1,5 кг. В качестве программной платформы применяется NVIDIA DGX OS — модификации Ubuntu, адаптированная специально для работы с ИИ. Две рабочие станции Veriton GN100 AI Mini Workstation посредством ConnectX-7 могут быть объединены в одну систему, что позволит работать с ИИ-моделями, насчитывающими до 405 млрд параметров. Говорится о поддержке таких инструментов, как PyTorch, Jupyter и Ollama. Приобрести новинку можно будет по ориентировочной цене $4000 или €4000 в зависимости от региона продаж.

03.09.2025 [13:39], Руслан Авдеев

SAP инвестирует более €20 млрд в суверенное облако для поддержки европейских клиентовКрупнейший немецкий разработчик ПО — компания SAP объявила о намерении инвестировать в течение 10 лет более €20 млрд ($23,3 млрд) в свою суверенную облачную инфраструктуру в Европе, сообщает CNBC. Компания предложит IaaS на базе собственных дата-центров. Дополнительно будет представлена новая локальная опция, которая позволит пользоваться инфраструктурой SAP в дата-центрах заказчика. В Германии также будет доступно облако Delos Cloud. Цель новой инициативы — обеспечить хранение данных клиентов на территории Евросоюза для соблюдения правил защиты местных данных, включая GDPR. По словам SAP, инновации и суверенитет нераздельны. Он добавил, что европейским компаниям важно получить доступ к новейшим технологиям вроде ИИ в «контексте полного суверенитета». За последний год тема суверенитета стала особенно популярной, на фоне геополитических противоречий компаниям пришлось провести переоценку зависимости от иностранных технологий. Государства всё чаще стараются полагаться на локальную инфраструктуру, необходимую для обучения и эксплуатации ИИ. В результате AWS, Google и Microsoft объявили о новых сервисах в сфере суверенных облаков, призванных хранить европейские данные в ЕС. При этом Microsoft и Google выразили готовность защищать интересы европейских клиентов перед американским правительством.

Источник изображения: Carl Gruner/unsplash.com ЕС считает развитие ИИ одним из приоритетов региона — блок стремиться составить конкуренцию США и Китаю, от которых пока значительно отстаёт в этом отношении. Ранее Еврокомиссия рассказала о планах инвестировать €20 млрд в создание «ИИ-гигабафрик», оснащённых мощнейшими ИИ-суперкомпьютерами. В SAP объявили, что тесно участвуют в создании таких фабрик, но компания не будет в проекте ведущим партнёром. Представитель SAP добавил, что её инвестиции в объёме более €20 млрд, предусматриваемые для европейского суверенного облака, не повлияют на капитальные затраты компании на следующий год, они уже заложены в её финансовые планы. SAP является одним из ключевых европейских игроков в IT-сфере — компания стала самым дорогим публичным бизнесом в Европе. Примечательно, что ещё в июне 2025 года сообщалось, что SAP не видит смысла в строительстве Европой собственной облачной инфраструктуры в противовес американским гиперскейлерам. В конце мая появилась новость, что Евросоюз готов признать, что отказаться от американских облаков «почти невозможно», а в июле Synergy Research Group заявила, что доля европейских облачных провайдеров на местном рынке снизилась до 15 % и остаётся на этом уровне годами.

03.09.2025 [08:53], Руслан Авдеев

«Фантомные» ИИ ЦОД ещё не построены, но уже мешают энергокомпаниям СШАДата-центры США отчаянно нуждаются в электроэнергии, но пока нет точных данных, сколько их будет построено в итоге и сколько электричества им действительно необходимо. Американские коммунальные компании сообщают о взрывном росте запросов на присоединение к сетям со стороны будущих ИИ ЦОД, причём в некоторых случаях их аппетиты многократно превышает текущее энергопотребление региона, сообщает The Wall Street Journal. Так, American Electric Power (AEP), обслуживающая 11 штатов, и техасские Oncor (Sempra) с CenterPoint Energy суммарно получили от дата-центров запросы на фантастические 400 ГВт. Проблема отчасти в том, что нередко потребности одного и того же дата-центра многократно учитываются разными коммунальными службами — застройщики направляют запросы самым разным поставщикам электричества, одновременно подыскивая лучшие места для будущих ЦОД. При этом по факту многие проекты так и останутся на бумаге, поскольку на присоединение к энергосетям уходят годы, а за это время могут поменяться законы, правила зонирования и т.д. Такие объекты уже прозвали «фантомными ЦОД». Поэтому коммунальные службы не хотят рисковать, наспех строя лишние электростанции и ЛЭП, поскольку не исключено, что ИИ-бум представляет собой очередной «мыльный пузырь», платить за который придётся остальными потребителям.

Источник изображения: American Public Power Association/unsplash.com По данным Министерства труда, цены на электроэнергию по всей стране за год уже выросли на 5,5 %. Спрос на электричество в США не менялся почти 20 лет, приблизительно до 2020 года, но сейчас он растёт по всей стране примерно на 2 % в год. Во многом это связано с ажиотажем вокруг ИИ с его фантастически выросшими запросами. Быстрее всего спрос растёт в местах вроде Северной Вирджинии и Техаса, где строятся крупные ЦОД и развивается производство. Например, к концу у Oncor было 552 запроса на присоединение к сети от крупных клиентов, включая ЦОД и производственные предприятия, т.е. почти на треть больше, чем в конце марта. Пиковый уровень потребления электричества клиентами компании составляет 31 ГВт. При этом ЦОД просят ещё 186 ГВт, а промышленные предприятия — порядка 19 ГВт. Если раньше типичный запрос составлял менее 100 МВт, то сейчас этот показатель приблизился к 700 МВт. Энергосистема AEP оценивается в 37 ГВт, уже заключены соглашения ещё на 24 ГВт. При этом в очереди на рассмотрении находятся заявки на колоссальные 190 ГВт. В компании полагают, что не все проекты будут реализованы. Наконец, потребление клиентов CenterPoint Energy в районе Хьюстона (Техас) составляет чуть больше 22 ГВт, и это один из самых высоких показателей для мегаполиса США. Запросы на подключение составляют 53 ГВт, из них 25 ГВт приходится на ЦОД. При этом год назад ЦОД было нужно всего 1 ГВт. По оценкам компании, по факту понадобится лишь пятая часть запрошенных мощностей. Как сообщало в апреле Международное энергетическое агентство (IEA), энергопотребление ЦОД к 2030 году в мире вырастет более чем вдвое. В конце 2024 года появился отчёт Национальной лаборатории Лоуренса в Беркли (LBNL), где сообщалось, что в 2028 году на дата-центры США может прийтись уже 12 % энергопотребления всей страны. В конце июля 2025 года Anthropic предрекла, что к 2028 году только для ИИ в США потребуется 50 ГВт. Впрочем, ИИ-чипов может на всех и не хватить.

02.09.2025 [16:11], Руслан Авдеев

Не хочешь — заставим: правительство само определит категории объектов КИИХотя с 1 сентября 2025 года объекты критической инфраструктуры (КИИ) в России обязаны использовать только реестровое российское ПО, на деле степень готовности компаний и организаций к этому будут определять в особом порядке, сообщает РБК. Требование об использовании в информационных системах госорганов, энергетических, финансовых, транспортных, медицинских и ряда компаний другого профиля предусмотрено вступившими поправками в закон «О безопасности критической информационной инфраструктуры». Однако фактически для компаний, поднадзорных Минцифры, Банку России, Минэнерго и Минтрансу, с сентября ничего не изменилось. По словам Минцифры, сроки перехода на российское ПО определят отдельным документом не позднее 1 апреля 2026 года. ФСТЭК пока разрабатывает список из более 10 типовых отраслевых объектов КИИ. В Центробанке тоже сообщают, что перечень типовых объектов КИИ для финансовой отрасли, сопутствующие нормативные акты и порядок мониторинга выполнения требований разрабатывается правительством. В Минэнерго заявляют, что поднадзорные компании уже начали импортозамещение ПО и ПАК, причём уже сегодня на значимых объектах КИИ госорганы и госкомпании не могут использовать иностранное ПО. Перечень типовых объектов КИИ для структур, поднадзорных Минэнерго, уже проходит согласование. В Минтрансе утверждают, что работа над утверждением перечня типовых объектов КИИ и особенностей их категорирования также ведётся, как и переход на отечественное ПО и организации в госораганах и госкомпаниях. Закон о КИИ, принятый в 2017 году, касается систем, работа которых важна для безопасности и жизнедеятельности страны и населения. Владельцы КИИ обязаны определять, какие системы считать критическими, и выполнять необходимые для них требования безопасности, информируя госорганы об инцидентах и внедряя технические меры защиты. Пока каждый владелец КИИ присваивал своим объектам категорию значимости самостоятельно по уровню потенциального ущерба в случае тех или иных инцидентов с объектами. На практике, как оказалось, владельцы КИИ избегали присваивания своим объектам первой категории. С 1 сентября 2025 года обязанность категорирования объектов возложена на правительство при участии ФСБ и ЦБ. Также правительство должно определить порядок и сроки перехода объектов на отечественное ПО и оборудование, порядок взаимодействия с платформой ГосСОПКА, правила обеспечения защиты объектов путём установки IDS/IPS и ликвидации последствий компьютерных атак, а также критерии мониторинга исполнения предписаний и штрафы за их неисполнение. В основном полное импортозамещение планируется закончить к 1 января 2030 года. В феврале 2025 года сообщалось, что лишь у 13 % российских объектов КИИ есть минимальный базовый уровень защиты от киберугроз, у остальных положение гораздо хуже. В апреле появилась информация, что за срыв импортозамещения КИИ будут штрафовать и коммерческие компании.

02.09.2025 [15:38], Андрей Крупин

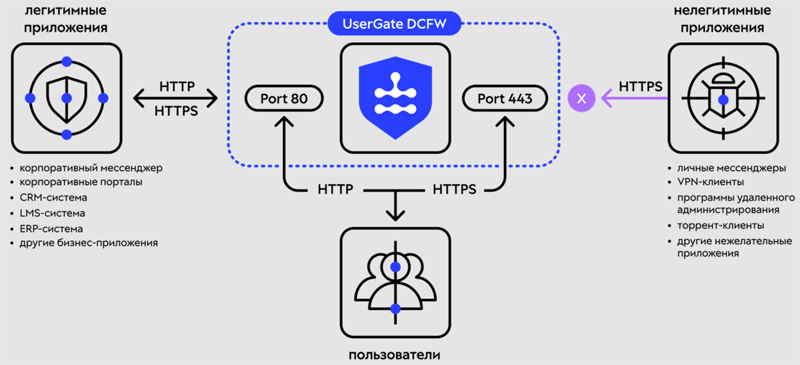

Российский NGFW уровня Enterprise: UserGate выпустила Data Center Firewall для защиты ЦОД и крупных организацийКомпания UserGate, занимающаяся разработкой решений для защиты корпоративных сетей, сообщила о выводе на рынок нового продукта — Data Center Firewall (DCFW). Созданное российским разработчиком решение относится к классу межсетевых экранов нового поколения (NGFW). Комплекс обеспечивает защиту дата-центров и сетевого периметра крупных организаций, в том числе территориально распределённых. UserGate DCFW позволяет обрабатывать до 130 тысяч правил межсетевого экрана без линейного падения производительности и поддерживает ключевые функции безопасности, необходимые для работы в сценариях защиты корпоративного периметра и ЦОД. В составе продукта представлены: межсетевой экран с контролем состояния сессий (FW L4), контроль приложений (FW L7, 1800+ приложений), предотвращение вторжений (IPS, 12000+ сигнатур), трансляция сетевых адресов (NAT). Также доступны функции создания виртуальных частных сетей для организации безопасного доступа удалённых сотрудников (RA VPN) и защищённой передачи данных между площадками (S2S VPN) по протоколу IPsec.

Принцип работы UserGate DCFW (источник изображений: usergate.com) Кроме этого, в UserGate DCFW реализованы возможности Identity Firewall для идентификации и аутентификации пользователей, объединённые под названием UserID. UserID сопоставляет IP-адреса с учётными записями при помощи различных подходов и методик вне зависимости от текущего местоположения пользователей или используемой ими ОС. Это позволяет однозначно связать пользователя и генерируемый им трафик, что повышает видимость действий конкретного пользователя и упрощает настройку политик. Поддерживаются протоколы RADIUS, TACACS+, Kerberos, NTML, мультифакторная аутентификация, интеграция со службами каталогов Microsoft Active Directory, LDAP, ALD Pro и FreeIPA. Для прозрачной аутентификации реализована поддержка сообщений RADIUS Accounting с NAS-серверов, импорт данных других серверов по syslog, импорт журналов событий контроллера домена AD через WMI, агент на контроллере домена Microsoft Active Directory, а также сборщик событий из Windows Event Collector. Для интеграции UserGate DCFW в сложные IT-инфраструктуры, свойственные крупным заказчикам, в продукте реализован широкий набор сетевых технологий: OSPF, BGP, RIP, PIM, PBR, ECMP, BFD, VLAN, VXLAN, VRF, LACP и ряд других. Поддерживается работа в кластере отказоустойчивости в режиме Active-Passive и Active-Active (до 4 нод). Возможна работа с популярными российскими балансировщиками. Управление комплексом осуществляется через веб-интерфейс (GUI) или командную строку (CLI). Для централизованного управления распределёнными инсталляциями UserGate DCFW может использоваться UserGate Management Center. Для переноса конфигураций с популярных иностранных NGFW реализованы инструменты миграции, в том числе с Check Point, FortiGate, Palo Alto, Huawei и Cisco ASA/Firepower. Для интеграции с другими средствами защиты и IT-продуктами доступен открытый документированный API и протоколы syslog, SPAN и SNMP.

ПАК UserGate NGFW F8010 UserGate DCFW поставляется в двух вариантах исполнения: в виртуальном для разворачивания на серверах заказчика (поддерживается работа со всеми популярными гипервизорами, включая VMware, zVirt, Hyper-V, KVM, «Брест» и т. д.) и в составе программно-аппаратных комплексов (ПАК). Во втором случае поддерживается работа на новых платформах UserGate E1010, E3010, F8010, а также флагманской платформе предыдущего поколения — F8000. Все платформы внесены в реестры российской продукции Минпромторга России. К началу 2026 года планируется завершить работы по поддержке платформы UserGate FG с аппаратным ускорением и гибридных устройств на её основе (G9300, G9800). UserGate DCFW сертифицирован ФСТЭК России по 4-му уровню доверия, как межсетевой экран по профилям защиты А, Б и Д 4-го класса, а также как система обнаружения вторжений уровня сети 4-го класса защиты. Это позволяет использовать продукт в АИС до класса защищённости 1Г, ЗО КИИ I категории, ИСПДн 1 го уровня защищённости, ГИС 1-го класса защищённости, АСУ ТП 1-го класса защищённости, а также ИСОП II класса. UserGate DCFW внесён в реестр ПО Минцифры России. Кроме того, ведутся работы по внесению платформ с DCFW в реестр Минцифры в качестве ПАК.

02.09.2025 [14:47], Руслан Авдеев

OpenAI построит в Индии дата-центр мощностью более 1 ГВтOpenAI намерена построить в Индии дата-центр мощностью не менее 1 ГВт. Компания ищет местных партнёров для сотрудничества в рамках нового проекта, сообщает Silicon Angle со ссылкой на Bloomberg. Кроме того, партнёров ищут и для продвижения ChatGPT на местном рынке. По предварительным оценкам, новый ИИ ЦОД сможет разместить почти 60 тыс. чипов NVIDIA B200. Пока нет данных, входит ли новый ЦОД в инициативу компании OpenAI for Countries. Программа, запущенная в 2025 году, предполагает создание ИИ ЦОД по всему миру. OpenAI уже заключила контракты на создание инфраструктуры в ОАЭ и Норвегии. Впрочем, речь идёт не только о дата-центрах. Компания предлагает помощь в запуске локальных версий ChatGPT и поддержку местных ИИ-стартапов, в том числе инвестиции в некоторые из них. В феврале 2025 года глава OpenAI Сэм Альтман (Sam Altman) встретился с представителями индийских властей, чтобы обсудить создание «недорогой» ИИ-платформы. Недавно компания запустила новый тариф ChatGPT специально для Индии — подписка ChatGPT Go стоит всего около $4,5/мес. и позволяет обрабатывать в сутки в 10 раз больше запросов, чем в бесплатной версии. Также компания намерена распространить среди местных преподавателей и студентов около 500 тыс. лицензий на использование ChatGPT. До конца года OpenAI намерена открыть офис в Нью-Дели. Создание собственного ЦОД в Индии позволит сократить задержку доступа для местных пользователей. Кроме того, такой проект способен помочь и в борьбе за местных корпоративных клиентов. Особенно это касается организаций, которым необходимо хранить данные локально, обеспечивая информационную безопасность и конфиденциальность. Данные о строительстве ЦОД в Индии появились через несколько недель после заключения соглашения с Oracle о строительстве в США дата-центра на 4,5 ГВт. В следующие четыре года OpenAI намерена ввести в эксплуатацию в США не менее 5,5 ГВт дополнительных мощностей, что обойдётся, вероятно, в $500 млрд.

01.09.2025 [23:50], Андрей Крупин

MWS Cloud в 1,5 раза увеличила мощности GPU-облака для искусственного интеллектаКомпания MWS Cloud (входит в МТС Web Services) сообщила о расширении в первом полугодии 2025 года мощностей виртуальной инфраструктуры с GPU в полтора раза. Виртуальная инфраструктура была расширена в двух московских ЦОД — в «Авантаже» и GreenBushDC, а также в дата-центре в Санкт-Петербурге. Виртуальная инфраструктура с GPU позволяет обучать и выводить в инференс любые ML-, LLM- и CV-модели. Поверх неё можно развернуть ML-платформу или платформу для инференса MWS Cloud. Доступ к ускорителям в облаках тарифицируются по принципу Pay as You Go (PAYG, оплата по мере потребления).

Источник изображения: Luke Peters / unsplash.com Новые мощности предназначены для разработчиков, data-саентистов и организаций, которые обучают сложные ML- и LLM-модели (включая генеративные нейросети), запускают инференс высоконагруженных коммерческих продуктов, разрабатывают компьютерное зрение для систем распознавания и анализа, используют ресурсоёмкие вычисления для рендеринга, симуляций и работы с большими данными. «Мы видим устойчивый рост спроса на виртуальную инфраструктуру с GPU. С начала года её потребление в облаке MWS Cloud увеличилось почти в 1,7 раза. В связи с этим мы стремимся соразмерно расширять наши облачные мощности», — отметил директор по новым продуктам MWS Cloud Алексей Кузнецов.

01.09.2025 [09:18], Руслан Авдеев

«ДолИИна» — проект 50-МВт ИИ ЦОД в Ленинградской области«ВСП Глобал» (VSP Global) и «Атомдата» (дочернее предприятие «Росатома») подписали меморандум о сотрудничестве в целях развития инфраструктуры и информационных технологий в сфере ИИ. В частности, предусмотрено создание совместного предприятия для реализации проекта «IT-кластер «ДолИИна» по строительству ИИ ЦОД в Ленинградской области рядом с городом Павловск. Также предусматривается совместная реализация ряда проектов в области, сотрудничество с ведущими вузами РФ, Российской ассоциацией искусственного интеллекта (РАИИ), отраслевыми бизнес-объединениями и т.д. Проект ЦОД предусматривает постройку пяти объектов общей мощностью 50 МВт. Предусмотрено размещение стоек мощностью от 20 до 100 кВт (с СЖО). Впрочем, помимо высоконагруженных стоек предусмотрено размещение и традиционных стоек в рамках колокации. Кампус находится в непосредственной близости от 110-кВ подстанции и, как передаёт «ИКС-МЕДИА», от магистральной газовой трубы высокого давления, что позволит задействовать газ для резервного питания объектов. Также отмечается хорошая транспортная доступность. Общая ожидаемая ёмкость ЦОД — до 3 тыс. стоек. Ожидаемый PUE — в районе 1,2, для чего, в частности, планируется задействовать адиабатическое охлаждение. Оборудование ЦОД будет по возможности российского производства. Кроме того, в составе кампуса предусмотрено общественно-деловое пространство площадью 40 тыс. м2. В ноябре 2025 года планируется получить разрешение на строительство, которое будет проводиться поэтапно. Начало работ намечено на конец 2025 года. По словам «Атомдаты», «большое количество компаний, не говоря про стартапы, не могут позволить себе GPU-кластер за миллионы долларов. А специализированной инфраструктуры, где можно было бы арендовать такой кластер, в стране практически нет». По словам VSP Global, в России есть два монополиста в области ИИ — «Сбер» и «Яндекс». Для конкуренции не хватает подходящей инфраструктуры, и «ДолИИна» должна решить эту проблему.

31.08.2025 [15:51], Руслан Авдеев

Alibaba разработала собственный ИИ-ускоритель для инференсаНа фоне нарастающего давления со стороны китайских властей, стремящихся избавиться от зависимости от ИИ-чипов NVIDIA и и других западных аналогов, Alibaba разработала собственный ИИ-ускоритель. В пятницу появились данные, что новейший чип китайского IT-гиганта ориентирован на инференс, сообщает The Register. Подразделения Alibaba T-Head довольно давно работает над собственными ИИ-решениями. В 2019 году он представила вариант Hanguang 800, но в отличие от современных моделей NVIDIA и AMD, он в первую очередь предназначен для классических ML-моделей машинного обучения (таких как ResNet), а не для современных больших языковых моделей (LLM). Утверждается, что новый чип будет справляться с более разнообразными нагрузками. В обозримом будущем для обучения Alibaba, вероятно, будет по-прежнему использовать ускорители NVIDIA. По имеющимся данным, в отличие от ускорителей Huawei Ascend, продукт Alibaba совместим с программной платформой NVIDIA, что позволяет лишь немного переработать используемый код. При этом использование инструментов CUDA не является необходимым для инференса. Alibaba, вероятно, ориентируется на более высокоуровневые варианты вроде PyTorch или TensorFlow. Так или иначе, чип придётся выпускать в Китае из-за санкций США. Кто именно займётся непосредственно выпуском не указывается, но весьма вероятно, что речь идёт о SMIC. Кроме того, Китаю запрещено продавать высокоскоростную память HBM2e и более новые версии — если они уже не интегрированы в готовый ускоритель. Это значит, что Alibaba или будет использовать «медленную» память GDDR или LPDDR, а также накопленные запасы HBM, пока не появятся собственные аналоги. Новости об очередных полупроводниках китайского производства появились на фоне призывов китайского правительства не использовать ускорители NVIDIA H20 из соображений безопасности. Впрочем, NVIDIA, которой не так давно вновь разрешили поставлять H20 в Китай, все обвинения решительно отрицает. По некоторым данным, ведётся разработка нового ускорителя семейства Blackwell, специально для Китая. Впрочем, в текущем квартале компания всё равно не рассчитывает на доходы в КНР, поскольку механизмы возобновления продажи и взимания 15-процентной экспортной пошлины ещё не отработаны. Тем временем китайские лидеры ИИ-отрасли ищут альтернативы продуктам компании. DeepSeek переориентировала свои модели на использование нового поколения китайских чипов. Компания не назвала поставщика, но, по некоторым данным, перенести обучение на Ascend не удалось. Впрочем, сама Huawei старается ускорить и инференс. Стартап Enflame, поддерживаемый Tencent, разрабатывает новый ускоритель L600, который получит 144 Гбайт (3,6 Тбайт/с) и поддержку FP8-вычислений. MetaX анонсировала модель C600 со 144 Гбайт HBM3e, но производство, вероятно, будет ограничено имеющимися резервами памяти. Наконец, Cambricon Technologies также работает над собственным ускорителем Siyuan 690, который, как ожидается, будет лучше NVIDIA H100.

31.08.2025 [15:31], Владимир Мироненко

Новый урок арифметики от NVIDIA: Дженсен Хуанг назвал фантастическую сумму капзатрат на ИИ-инфраструктуруГендиректор NVIDIA Дженсен Хуанг (Jensen Huang) сообщил в ходе отчёта за II квартал 2026 финансового года, что капзатраты четырёх крупнейших гиперскейлеров (Amazon Web Services, Google, Microsoft и Meta✴ Platforms) составят около $600 млрд в год. По его словам, эта сумма удвоилась всего за два года и является движущей силой текущего развития ИИ-инфраструктуры. Как отметил ресурс SiliconANGLE, последние квартальные отчёты гиперскейлеров, а также аналитические данные экспертов, освещающих их деятельность, говорят о том, что их совокупный прогноз капитальных затрат гораздо ниже объявленной Хуангом суммы, хотя этот показатель стремительно растёт благодаря спросу на ИИ-технологии. NVIDIA в ответ на просьбу объяснить столь большое расхождение уточнила, что эта сумма отражает общие расходы отрасли на инфраструктуру ЦОД, а не только расходы ведущих поставщиков облачных сервисов. Если говорить о планах по объёмам капзатрат на текущий год (календарный или финансовый), то гиперскейлеры прогнозируют следующее:

Согласно выводам аналитиков (Jefferies, Investing.com) по «большой тройке» с Meta✴ и Oracle прогноз капзатрат на облаке на 2025 год составляет $417 млрд, что на 64 % больше, чем годом ранее, и почти в три раза больше, чем в 2023 году. Налицо существенное расхождение между объявленными Хуангом $600 млрд и данными аналитиков, а также прогнозами самих гиперскейлеров. Возможные причины расхождения по версии SiliconANGLE:

Названная главой NVIDIA сумма в $600 млрд не подтверждается прогнозами ведущих гиперскейлеров на 2025 год и расчётами аналитиков, которые предполагают, что совокупные капзатраты составят $400–$450 млрд. Разрыв, как пишет SiliconANGLE, обусловлен как неопределённостью масштаба (что именно считается капиталовложениями у гиперскейлеров), так и намерением Хуанга подчеркнуть, что NVIDIA находится в центре ИИ-бума. NVIDIA известна порой довольно вольным обращением с цифрами и прогнозами. Это касается заявлений производительности платформ без явного указания точности и формата вычислений (так в мгновение ока появились экзафлопсные суперкомпьютеры, которые в более традиционных FP64-расчётах не сильны), учёта количества GPU в узлах (несколько лет компанию не беспокоило, что в состав одного ускорителя входило два GPU-чиплета), или отхода от привычных способов указания пропускной способности интерфейсов (для NVLink суммируется скорость передачи данных в обе стороны). |

|