Лента новостей

|

16.12.2021 [16:59], Сергей Карасёв

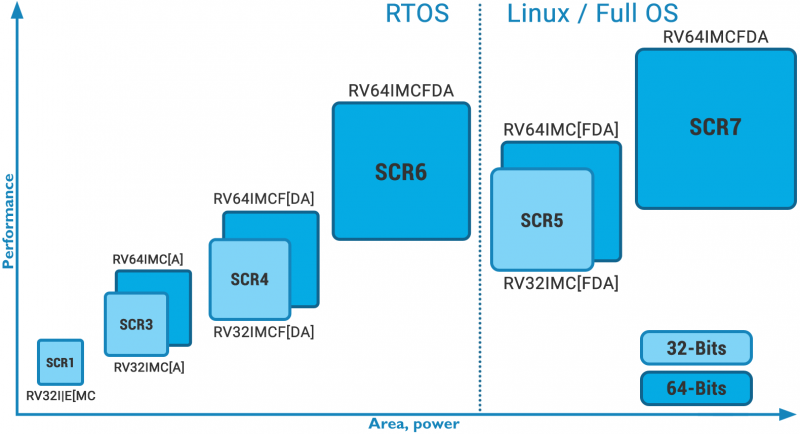

Российская компания Syntacore вошла в состав правления RISC-V InternationalRISC-V International сообщила о том, что российская компания Syntacore, подконтрольная российской же компании YADRO, получила статус премиального участника названной организации. При этом сооснователь и исполнительный директор Syntacore Александр Редькин вошёл состав правления RISC-V International. Syntacore является отечественным разработчиком микропроцессорных ядер и специализированных инструментов на архитектуре RISC-V. Компания входит в число основателей открытого международного консорциума RISC-V. Его цель заключается в разработке и продвижение одноимённой открытой архитектуры.

Изображение: Syntacore «Сегодняшний анонс ещё сильнее укрепляет наше лидирующее положение на рынке интеллектуальной собственности RISC-V в новом году и дальше. Вся наша интеллектуальная собственность полностью совместима с последней версией спецификации RISC-V», — отметил господин Редькин. Компания Syntacore является одним из лидеров экосистемы RISC-V и лицензирует микропроцессорные технологии собственной разработки на базе данной архитектуры клиентам в России и за рубежом. Продукты на основе процессорных технологий компании разрабатываются по нормам от 180 до 7 нм.

14.12.2021 [21:11], Владимир Агапов

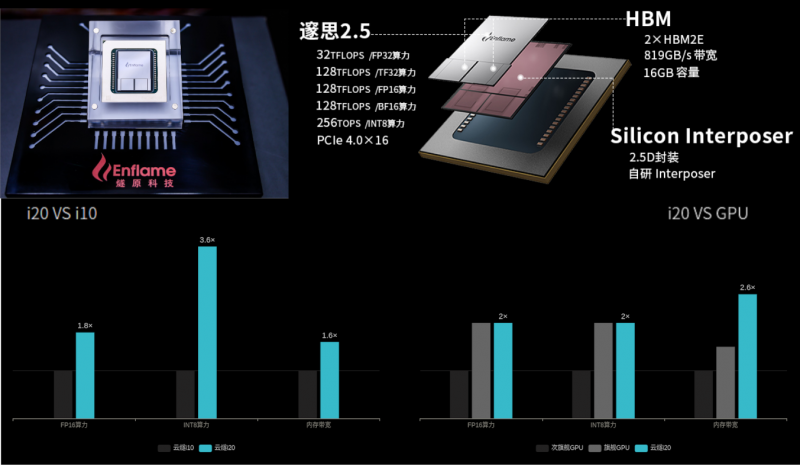

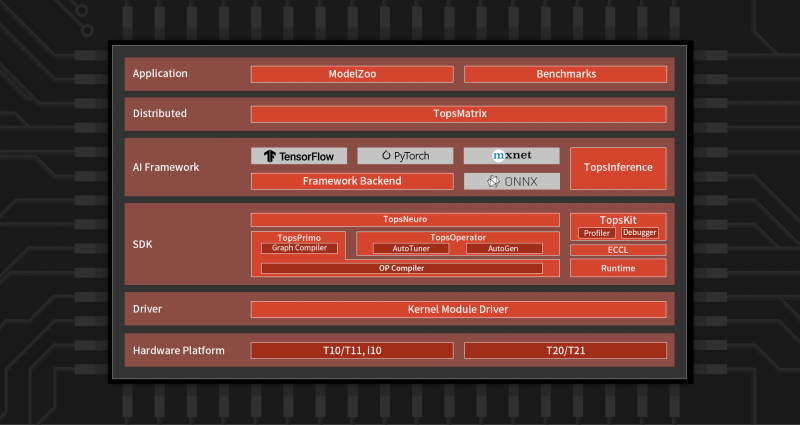

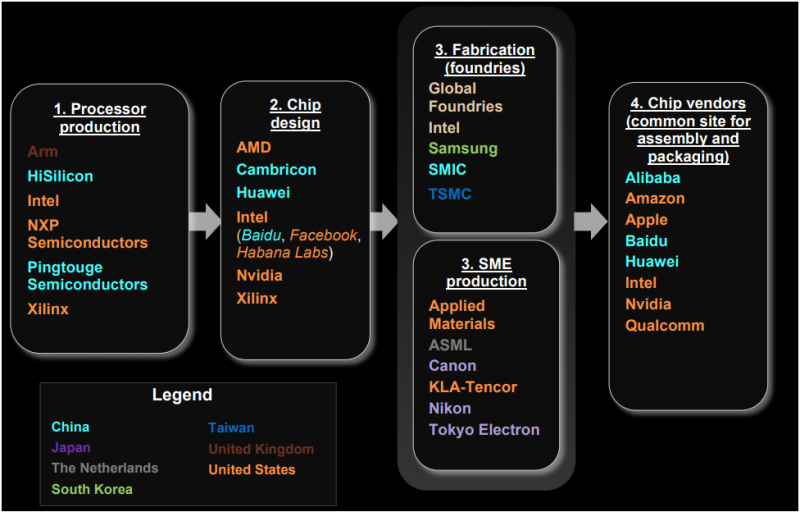

Китайская Enflame выпустила новый ИИ-ускоритель Cloudblazer Yunsui i20Компания Enflame, которая летом этого года представляла ускорители на базе второго поколения своих ИИ-чипов DTU, выпустила новый инференс-ускоритель Cloudblazer Yunsui i20 с чипом Suixi 2.5. Он изготовлен по 12-нм FinFET-техпроцессу GlobalFoundries и имеет обновлённую высокопроизводительную архитектуру вычислительных ядер GCU-CARE 2.0, благодаря чему, по словам создателей, удалось достичь эффективности, сопоставимой с массовыми 7-нм GPU. В числе ключевых особенностей новинки компания отмечает возросшую вычислительную мощность, возможность исполнения тензорных, векторных и скалярных вычислений, API для C++ и Python, а также поддержку основных фреймворков и форматов моделей (TensorFlow, PyTorch, ONNX). Комплектное ПО предоставляет гибкие возможности для миграции с поддержкой технологий виртуализации, а также многопользовательских и многозадачных окружений с безопасной изоляцией процессов. Yunsui i20 обладает 16 Гбайт памяти HBM2e с пропускной способностью до 819 Гбайт/c. Новинка поддерживает работу со всеми ключевыми форматами и предоставляет универсальную инференс-платформу, в том числе для облаков. Пиковая вычислительная FP32-производительность достигает 32 Тфлопс, TF32 (не уточняется, идёт ли речь о совместимости с NVIDIA) — 128 Тфлопс, FP16/BF16 — 128 Тфлопс, а INT8 достигает 256 Топс. По сравнению с первым поколением продуктов, Yunsui i20 увеличил FP-производительность в 1,8 раза, а INT-вычислений — в 3,6 раза. Для сравнения — у PCIe-версии NVIDIA A100 производительность в расчётах FP32, TF32, FP16/BF16 и INT8 составляет 19,5, 156, 312 и 624 Тфлопс (Топс для INT), а объём и пропускная способность памяти равны 40/80 Гбайт и 1555/1935 Гбайт/с соответственно. У AMD MI100 объём HBM2-памяти равен 32 Гбайт (1,23 Тбайт/с), а производительность FP32, FP16 и BF16 равна 46,1, 184,6 и 92,3 Тфлопс соответственно. Все три ускорителя имеют интерфейс PCIe 4.0. Значительный вклад в повышение производительности принесла оптимизация фирменного программного стека TopsRider, благодаря которой снизилась нагрузка на подсистему памяти. В результате средняя производительность исполнения моделей увеличилась в 3,5 раза, а эффективность использование вычислительной мощности — в среднем в 2 раза. Кроме того, новая модель программирования и технологии автоматизации позволяют ускорить эффективность разработки и снизить стоимость миграции моделей. В компании убеждены, что всё это сделает Yunsui i20 более конкурентноспособным решением. Благодаря технологии виртуализации, Yunsui i20 можно разделить на 6 независимых, изолированных друг от друга доменов — такое ранее предлагала только NVIDIA. Вместе с другими продуктами, которые также полностью переведены на новое поколение ИИ-ускорителей, Enflame рассчитывает получить значимую долю рынка в таких инновационных секторах как умные города и цифровое правительство, а также в традиционных отраслях вроде финансов, транспорта и энергетики, где будут востребованы более совершенные решения на основе ИИ. Несмотря на очевидные успехи, достигнутые командой Enflame и другими китайскими разработчиками — SoC от YITU Technology для глубокого обучения, IoT-чип Horizon Robotics Sunrise 2 с интегрированными ИИ-возможностями, Hanguang 800 от T-Head Semiconductor («дочка» Alibaba), серии Huawei Ascend и других — иностранные производители ИИ-чипов, по данным People's Daily, по-прежнему доминируют на китайском рынке с долей более 80%.

14.12.2021 [19:41], Алексей Степин

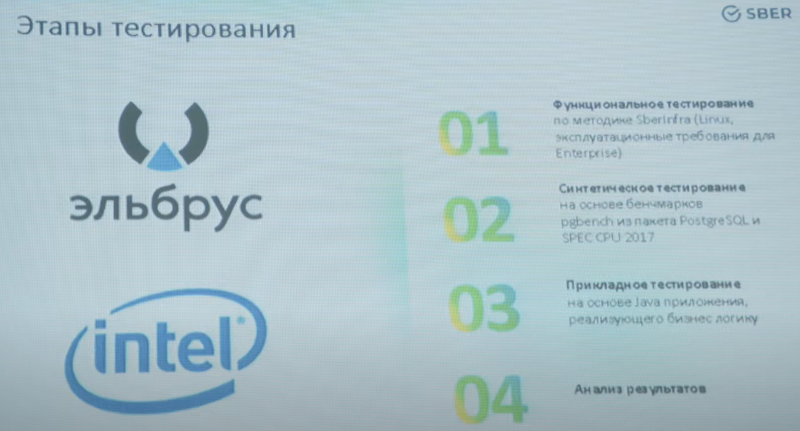

Серверы на базе «Эльбрус» не прошли тесты Сбербанка, но не всё потеряноВ рамках программы импортозамещения СберТех провёл тестирование серверов на базе процессоров Эльбрус-8С. По результатам системы признаны работоспособными, но не отвечающими предъявляемым требованиям по целому ряду параметров. Все пожелания и замечания переданы МЦСТ, разработчику Эльбрус. Банковские информационные системы — критически важная часть любого государства. Поэтому неудивительно стремление использовать в них решения собственной разработки, дабы меньше зависеть от чужих чипов и серверов. Примеры Huawei это подтверждают, но в данной заметке речь пойдёт не о китайских процессорах, а о российских. Лаборатория СберТех провела полноценное тестирование серверов на базе процессоров Эльбрус-8С, результаты которого, к сожалению, трудно назвать удовлетворительными.

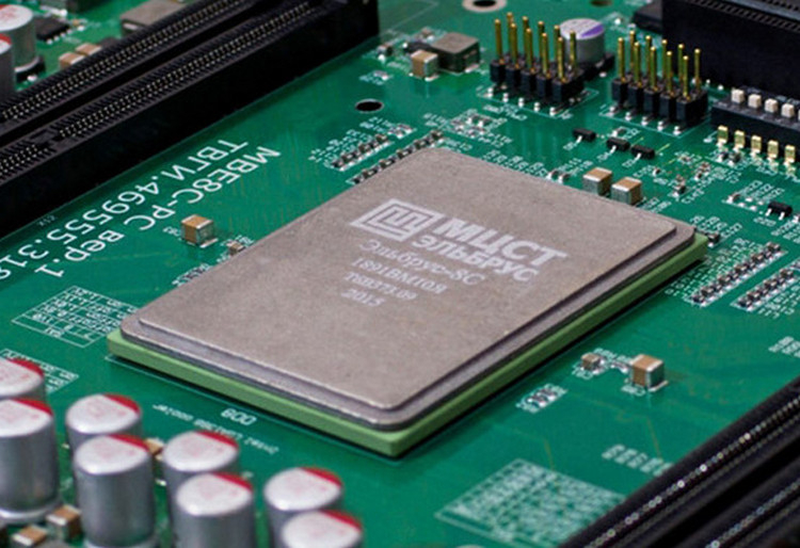

Фото: МЦСТ Это первое полномасштабное испытание процессоров Эльбрус в «полевых условиях», то есть, на уровне реальных серверов и задач, которые эти серверы должны выполнять. В испытаниях приняли участие платформы с двумя и четырьмя чипами Эльбрус-8С (VLIW, 8C/8T, 1,3 ГГц, 16 Мбайт L3-кеш, 70 Вт TDP, 28 нм). В качестве оппонентов выступили «типичные системы» на базе Intel Xeon Gold 6230 (x86-64, Cascade Lake-SP, 20C/40T, 2,1-3,9 ГГц, 27,5 Мбайт кеш, 125 Ватт TDP, 14 нм), которых в Сбере тысячи и тысячи.

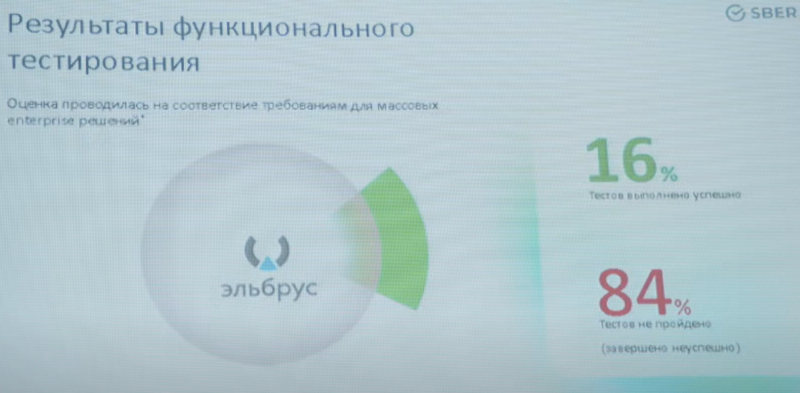

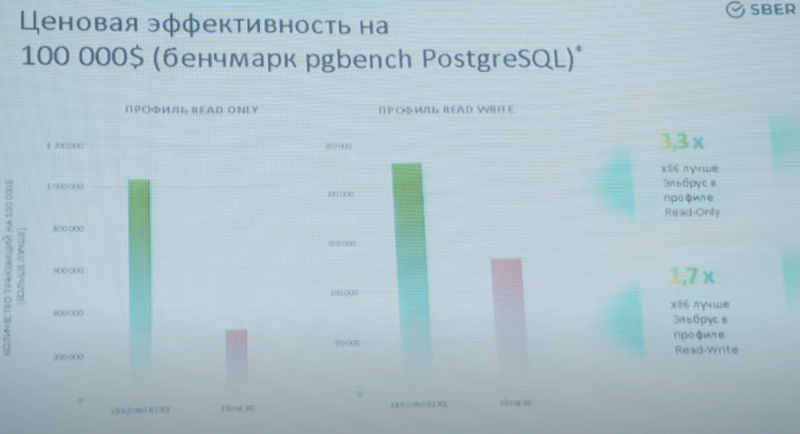

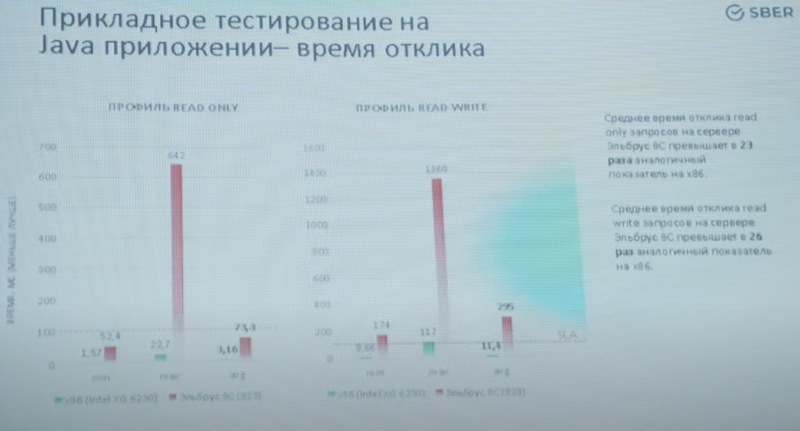

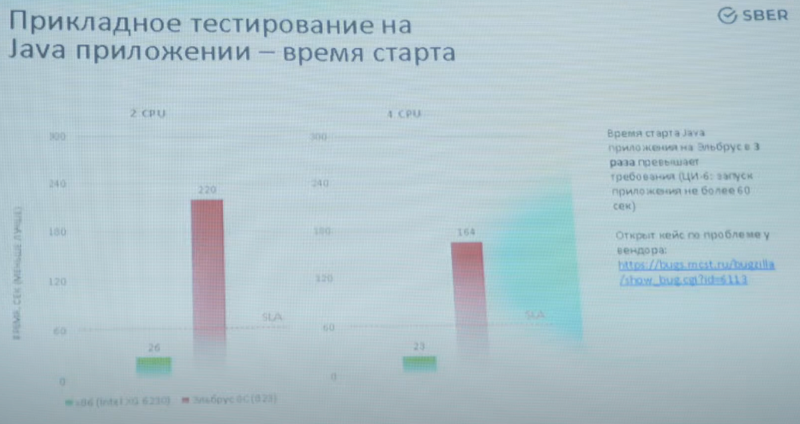

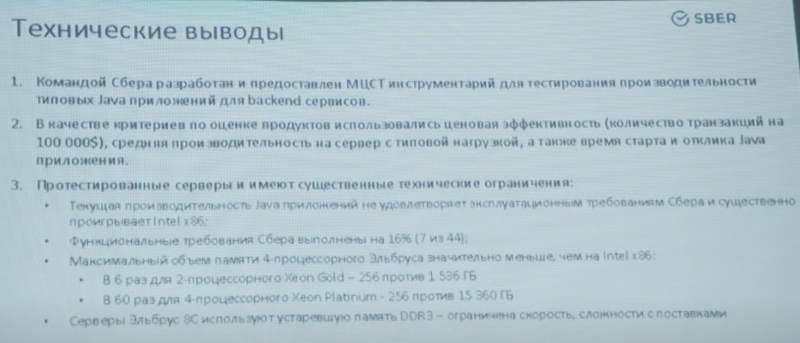

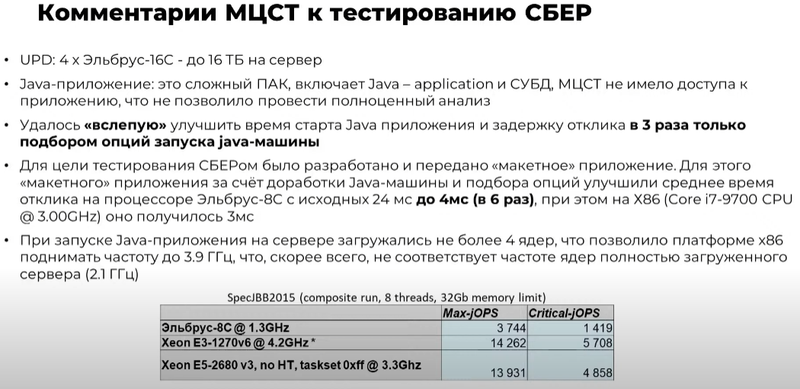

Изображения: YouTube/ElbrusTV По итогам тестирования серверы признаны работоспособными, но показавшими неудовлетворительный уровень производительности. Озвучены основные выводы: «мало памяти, медленная и устаревшая память, мало ядер, низкая тактовая частота». Особенно низкой оказалась производительность в приложениях, использующих Java.  Если в тестах PGbench/PostreSQL Xeon опередил Эльбрус в 1,7-3,3 раза, то в тестах на время отклика Java-приложения разница составила 23-26 раз. Запуск приложения, который по нормативам СберТеха должен укладываться в 60 секунд, занял у серверов Эльбрус 220 секунд в двухпроцессорном варианте и 164 секунды — в четырёхпроцессорном.  Кроме того, в рамках стандартных спецификаций компании системы на базе Эльбрус-8С смогли пройти всего по 7 параметрам из 44 предъявляемых. Если отсутствие монтажных стоечных рельсов можно отнести к «мелким претензиям», которые легко решаются, то отсутствие системы удалённого управления — недоработка весьма серьёзная, поскольку затраты на увеличение штата ИТ-специалистов окажутся непомерно велики.  Стоит, однако, отметить, что Эльбрус-8С уже устарел в рамках собственной экосистемы: МЦСТ обещает представить на тестирование усовершенствованные варианты серверов на базе Эльбрус-8СВ с более высокой частотой (1,5 против 1,3 ГГц), удвоенной производительностью в операциях над числами с плавающей запятой, а также использующие память DDR4-2400 (до 1 Тбайт на сервер) вместо окончательно устаревшей DDR3-1600. Однако массовые поставки таких серверов при заказе 1-5 тыс. единиц возможны не ранее IV квартала 2022 года при заказе в III квартале 2021 года.  Признана необходимость проведения тестов систем на базе Эльбрус под управлением ОС, сертифицированных ФСТЭК по профилю не ниже ОС.А4 (использование для обработки персональных данных и ГИС). Также отмечена необходимость введения полноценной поддержки технологий виртуализации, а не только контейнеризации.  Отметим также, что МЦСТ успешно завершила разработку Эльбрус-16С, в котором ряд фундаментальных недостатков, присущих процессорам Эльбрус-8С/8СВ успешно устранён. Новый чип будет иметь 16 ядер с возросшей до 2 ГГц частотой, восьмиканальный контроллер памяти DDR4-3200 (до 16 Тбайт на сервер), контроллер 10GbE и интегрированный контроллер PCIe 3.0 (32 линии). Последний снимает серьёзные ограничения по пропускной способности чипов Эльбрус-8C/CB к периферийным устройствам. Также с 8 до 48 Гбайт/с возрастёт скорость межпроцессорного обмена данными.  Представитель МЦСТ отметил, что низкие результаты в Java-тестах отчасти обусловлены «слепым тестированием», в котором разработчикам не были предоставлены данные, необходимые для полноценной оптимизации Java-машины. Простым подбором опций МЦСТ удалось улучшить показатели в три раза, а «макет» оптимизированного приложения СберТеха позволил сократить время отклика с 24 до 4 мс, что практически равнозначно показателям систем на базе процессоров Intel (Core i7-9700, 3 мс).

14.12.2021 [15:22], Руслан Авдеев

Восемь операторов нелегального ЦОД в бывшем бункере НАТО получили срокиВ Германии осудили восемь человек, участвовавших в работе дата-центра, использовавшегося для ведения нелегальной деятельности — от торговли наркотиками до сбыта порнографии. ЦОД располагался в бывшем бункере НАТО в городе Трабен-Трарбах — до продажи здесь работали серверы, принадлежавшие военным ведомствам. Построенный в 1970-е западногерманскими военными бункер после объединения Германии использовался, в частности, Бундесвером, а затем был продан и с 2013 года принадлежал Герману-Йохану Ксеннту (Herman-Johan Xennt), заявившему при покупке, что будет использовать помещения для создания «гражданского» дата-центра. Считается, что оператором германского ЦОД выступал нелегальный хостинг-провайдер CyberBunker, ранее уже предоставлявший мощности для преступной деятельности, которые располагались в другом бывшем бункере НАТО на территории Нидерландов. «Соинвестором» предположительно стал Джордж «Пингвин» Митчелл (George 'The Penguin' Mitchell), некогда один из самых успешных ирландских импортёров наркотиков. Ксеннт также сдавал часть помещений в голландском дата-центра нарколаборатории, где в 2002 году произошёл пожар.

Источник: conner/pixabay.com Хотя Ксеннту на тот момент не предъявили обвинений, его бизнес-лицензия была аннулирована и фактически его деятельность полностью перешла на нелегальное положение. История CyberBunker чрезвычайно заинтересовала прокуроров. К 2015 году к расследованию привлекли германское подразделение, занимающееся борьбой с киберпреступностью. Позже в том же году правоохранительные органы подключились к кабелям связи, ведущим из бункера. В незашифрованных потоках информации были обнаружены сведения о торговле наркотиками, мошеннических действиях и прочих преступлениях. Как сообщает Data Centre Dynamics, в этом дата-центре нашли пристанище всевозможные нелегальные сервисы различного назначения, включая Cannabis Road, Fraudsters, Flugsvamp, Flight Vamp 2.0, orangechemicals и второй по величине в мире «наркомаркетплейс» Wall Street Market.

Источник: reportyorym/pixabay.com Чтобы получить больше прямых доказательств, правоохранительные органы оплатили криптовалютой хостинг в CyberBunker и создали веб-сайт, похожий на площадку для проведения мошеннической лотереи, недвусмысленно давая понять владельцам дата-центра, что намерены заниматься незаконной деятельностью. В сентябре 2019 года, собрав достаточно информации из различных источников, бункер штурмовали более 600 полицейских — они знали, что все сотрудники будут вне помещений, поскольку один из них праздновал получение наследства. Были изъяты 403 сервера, 412 жёстких дисков, 65 USB-накопителей, 61 компьютер (включая ноутбуки), а также 57 смартфонов и около €100 тыс. наличными. Подозреваемых обвинили в создании и участии в преступном сообществе, при этом не удалось доказать их соучастие в совершении порядка 250 тыс. фактов нарушения закона, предположительно совершённых с помощью сайтов, которые размещались на серверах в бункере. В результате судебного разбирательства Ксеннт приговорён к пяти годам и девяти месяцам лишения свободы, семеро других фигурантов уголовного дела — к различным срокам, от четырёх лет и трёх месяцев в тюрьме до года условно.

13.12.2021 [11:30], Алексей Степин

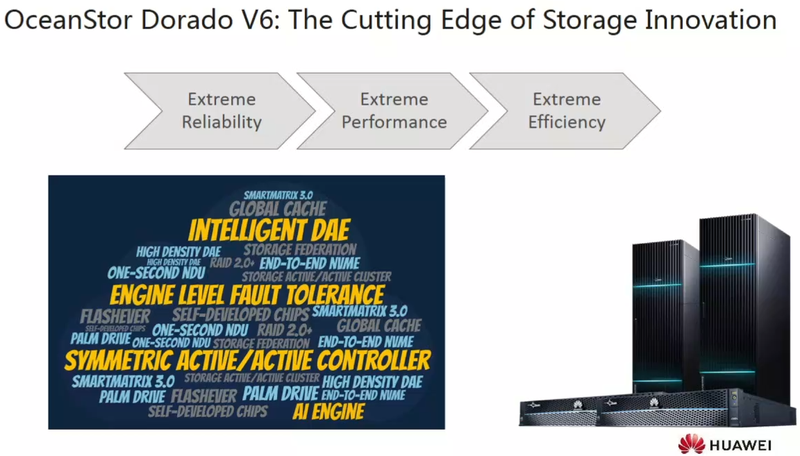

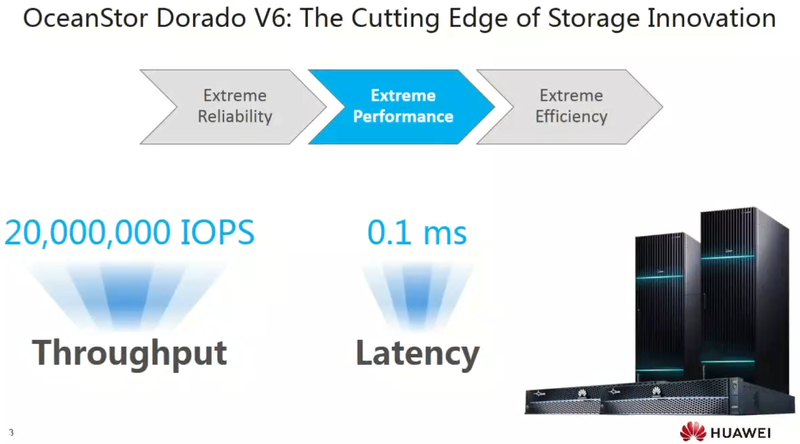

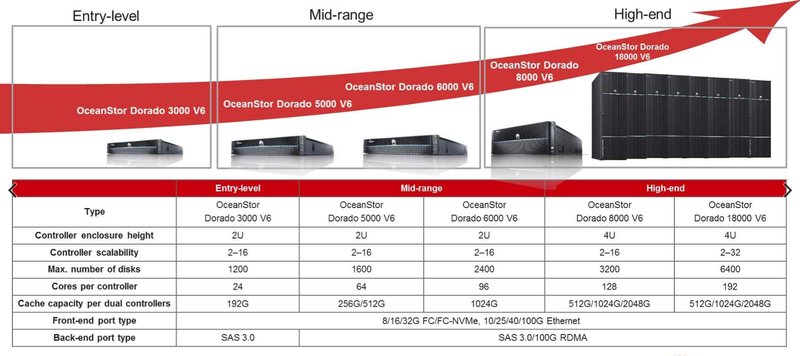

СХД Huawei OceanStor Dorado V6: для тех, кто превыше всего ценит надёжность и скоростьКомплексные программно-аппаратные решения одного производителя практически всегда превосходят похожие по параметрам, но более разнородные системы. Высокая степень интеграции и продуманная многоуровневая оптимизация всех компонентов не только позволяют добиться более высоких технических показателей, но и существенно упрощают и удешевляют внедрение и поддержку такого оборудования. Компанию Huawei можно назвать лидером в области таких решений, и особенно ярко это проявилось в шестом поколении СХД OceanStor Dorado. Их Huawei позиционирует как СХД высшего класса, обладающие не только высочайшей производительностью, но и надёжностью класса минимум «шесть девяток», то есть 99,9999%. Достаточно привести лишь один факт: Dorado 18000 V6 остаётся работоспособной при выходе семи контроллеров из восьми в каждой стойке, а также легко переживает одновременный выход из строя трёх накопителей в массиве. Для сравнения, классический RAID6 может пережить потерю лишь двух накопителей в массиве.  По результатам тестирования, проведённого Storage Performance Council в октябре 2020 года, СХД Huawei OceanStor Dorado 18000 V6 признана быстрейшим в мире флеш-хранилищем. На случайных операциях данное решение способно развивать 21 млн IOPS. Не удивительно, что разработками Huawei заинтересовались крупные финансовые организации, нуждающиеся не просто в надёжных, но и быстрых системах хранения данных. Уже 8 из 20 крупнейших мировых банков пользуются системами OceanStor Dorado и этот «клуб» будет только расти. Компания разместила на своём сайте подробный вебинар, посвящённый особенностям шестого поколения СХД OceanStor Dorado.  Высочайший уровень производительности OceanStor Dorado 18000 V6 обуславливается монолитностью и отлаженностью платформы, которая целиком построена на высокинтегрированных между собой собственных разработках Huawei в области процессоров, ускорителей и сетевых контроллеров. «Умные технологии» в шестом поколении Dorado начинаются уже на уровне отдельного накопителя.

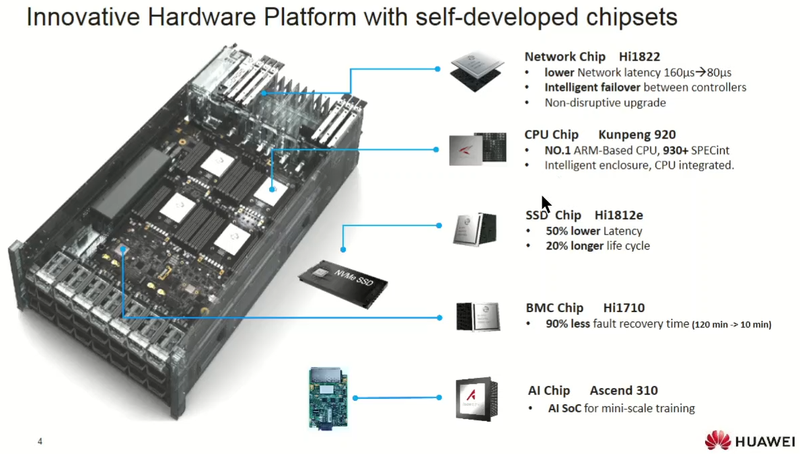

Платформа Dorado V6 целиком базируется на собственных разработках Huawei Такие SSD сами следят за износом фонда ячеек NAND, используют продвинутые методы коррекции ошибок LDPC и SmartFSP 3.0 и обеспечивают базовый уровень надёжности, поскольку контроллер Hi1812e работает с NAND как с динамическим RAID-массивом. Такие накопители на 20% долговечнее обычных и на 50% отзывчивее в плане задержек. В качестве основного процессора используется Kunpeng 920, 48-ядерный чип с архитектурой ARMv8.2, имеющий набор движков-ускорителей и собственные контроллеры SAS 3.0 и 100GbE (с RoCE, конечно). Четыре таких процессора умещаются в 1U-шасси. Им может помогать устанавливаемый дополнительно ИИ-ускоритель Ascend 310, отвечающий за обслуживание массива NVMe-накопителей и оптимизацию дисковых кешей.

Унифицированная симметричная архитектура обеспечивает предсказуемый и постоянный уровень производительности За сеть отвечает чип ASIC Hi1822, который полностью совместим с RoCE и NVMe-oF. Адаптеры на базе этого чипа могут иметь различную конфигурацию портов — от двух 25GbE SFP28 до двух 100GbE QSFP28 — и обеспечивают латентность всего лишь 80 мкс против 160 мкс у конкурентов. В дисковых полках Dorado 18000 V6 таких адаптеров несколько, заменять их можно без остановки системы. Даже контроллер управления (BMC) у СХД Huawei свой, Hi1710. Высокая интеграция всех программмно-аппаратных компонентов системы (а кто ещё может лучше знать, как задействовать весь потенциал «железа», кроме самих разработчиков) обеспечивает не только высокую производительность и надёжность, но и быстрое восстановление системы при сбоях — десятки минут для OceanStor Dorado V6 против нескольких часов у обычных СХД.

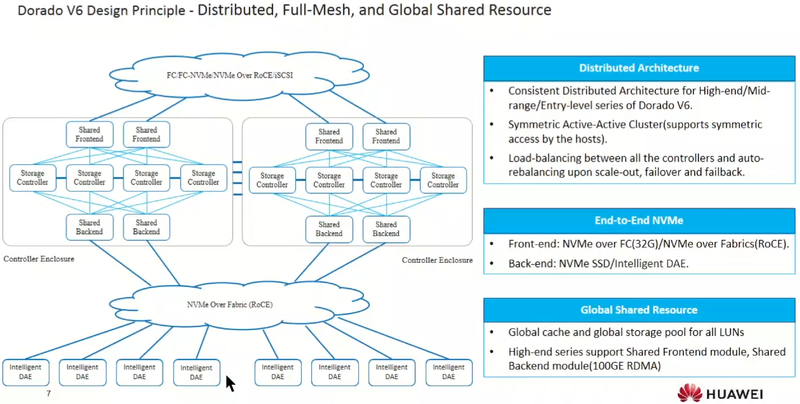

Распределённая архитектура OceanStor Dorado V6 Архитектурно OceanStor Dorado 18000 V6 представляет собой симметричную распределённую меш-сеть, в которой на уровне стоек контроллеров все компоненты соединены со всеми, что и обеспечивает беспрецедентный уровень надёжности. Компания называет эту технологию SmartMatrix. С «умными» дисковыми полками бэкенды контроллеров общаются посредством NVMe-oF, а с внешней сетью — либо через NVMe-oF/RoCE (100 Гбит/с на порт), либо через NVMe-oF/FC 32G.

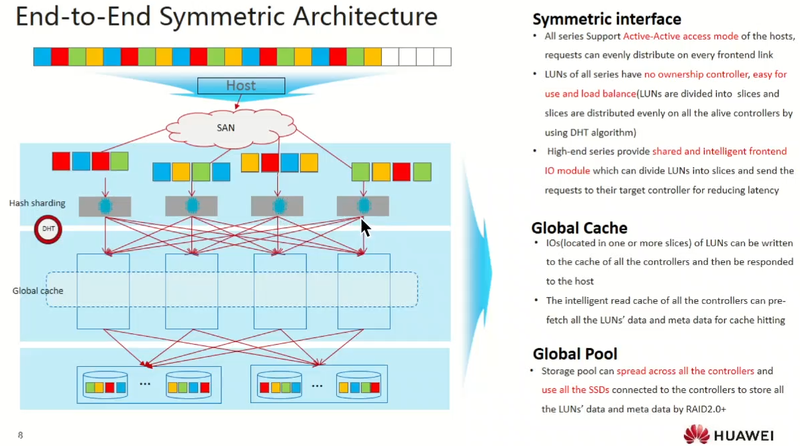

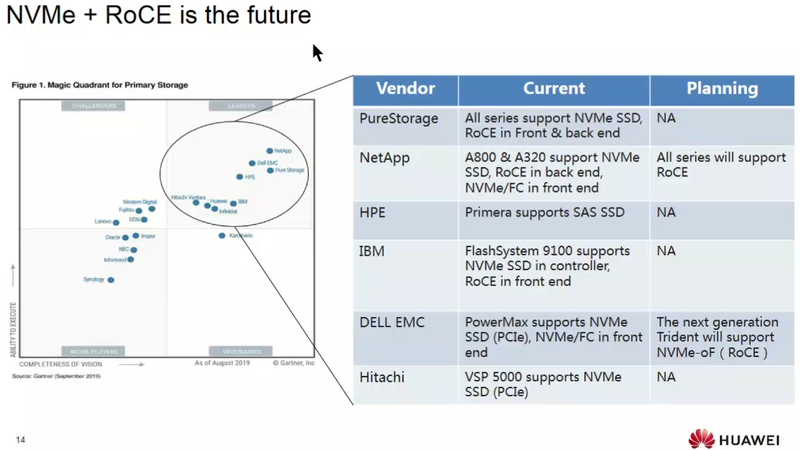

У Dorado V6 нет привилегированных контроллеров, что упрощает балансировку нагрузки Huawei вполне справедливо считает, что за сочетанием NVMe-oF и RoCE лежит будущее высокопроизводительных систем хранения данных. Данные технологии к настоящему моменту хорошо проработаны и полностью описываются стандартами, которые обеспечивают гибкость и взаимозаменяемость элементов инфраструктуры. Некоторые производители всё ещё поддерживают SAS, но время старых дисковых стандартов уходит.

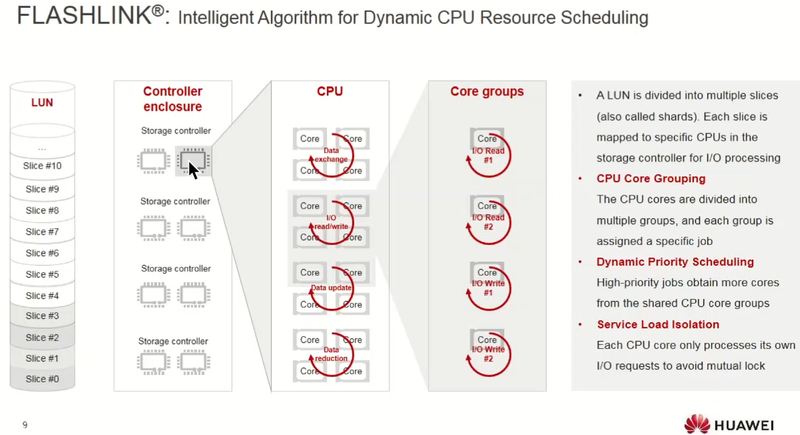

Технология Huawei FLASHLINK отвечает за распределение вычислительных ресурсов Симметрия архитектуры СХД данной серии выражена в том числе и в том, что все логические тома (LUN) не привязаны к главному контроллеру (ownership), вместо этого они «нарезаются» системой на сегменты (shards в терминологии Huawei), которые равномерно распределяются по всем активным в системе в настоящий момент контроллерам. Сами контроллеры работают с едиными пулами кеша и SSD, из которого и черпают необходимые ресурсы. За распределение обработки сегментов по процессорным ядрам отвечает фирменная технология FLASHLINK, которая работает в динамическом режиме: высокоприоритетные задачи получают больше ядер из выделенной группы. При этом каждое ядро выполняет IO-запросы только своей назначенной задачи, чтобы избежать конфликтов.

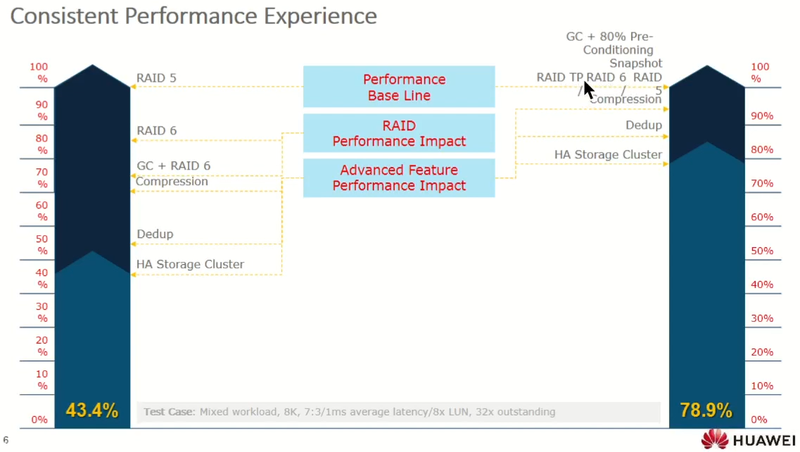

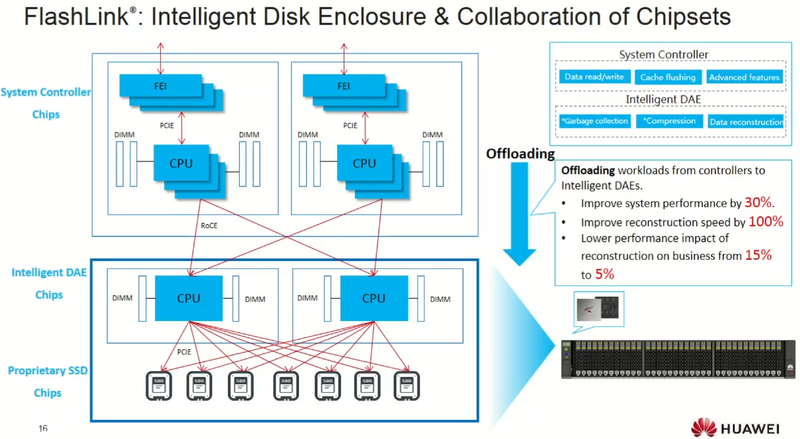

Глубокая интеграция ускорителей экономит процессорное время и ускоряет перестройку массивов Дисковые полки Dorado V6 имеют свой «интеллект» и не загружают CPU контроллеров низкоуровневыми задачами, а это позволяет, по словам разработчиков, повысить производительность СХД на 30% по сравнению с классическими архитектурами с «глупыми» полками. Этот же подход существенно ускоряет процесс восстановления данных — Huawei говорит о двукратном превосходстве в скорости, при этом влияние этого процесса на производительность СХД минимально и не превышает 5% против десятков процентов у СХД классической архитектуры. Более того, архитектура Dorado V6 такова, что производительность дисковых массивов в ней не зависит от типа используемого RAID и всегда одинаково высока как в простом режиме RAID10, так и в куда более сложных в плане нагрузки на контроллеры режимах RAID-6 или RAID-TP.

Модельный ряд и позиционирование СХД Huawei OceanStor Dorado Что касается более высокоуровневых программных компонентов, то в серии Dorado V6 все сложные процессы, от драйвера NVMe и управления пулом ресурсов до клиентских дополнений выполняются в пространстве пользователя (user space), что позволяет избежать лишних задержек, так как обращений в пространство ядра практически нет.

За NVMe и RDMA over Converged Ethernet — будущее В настоящее время Huawei предлагает заказчикам СХД нового поколения в двух вариациях: Dorado 8000 V6 и Dorado 18000 V6. Отличаются они только количеством модулей в максимальной комплектации (ну и габаритами, массой, количеством ядер в процессорах контроллера). 18000 V6 поддерживает до 32 контроллеров и до 32 Тбайт пула кеширования. Оба варианта могут работать с фронтендами 10/25/40/100GbE RoCE или FC-8/16/32G, поддерживая протоколы FC, iSCSI, NFS и CIFS. Каждый блок контроллеров может иметь до 28 IO-модулей и до 96 сетевых портов. Максимальное количество SSD в системе также одинаково и составляет 6400. Они могут работать в разных режимах RAID, включая фирменный RAID-TP, способный вынести одновременный отказ трёх накопителей. Максимальный объём флеш-хранилища составляет 98,3 Пбайт для модели Dorado 8000 V6, а у Dorado 18000 V6 он достигает 196,6 Пбайт.  Поскольку речь идёт о комплексных системах, способных обеспечить доступностью класса «шесть девяток» (99,9999%) и производительность на уровне свыше 20 млн IOPS при непревзойдённом уровне надёжности, стоимость конечной реализации вырабатывается в процессе проработки сертифицированными партнёрами Huawei проекта, создаваемого под нужды конкретного заказчика. Ознакомиться с OceanStor Dorado 8000/18000 V6 можно на сайте Huawei, там же можно найти подходящего партнёра для разработки законченного решения с учётом нужд заказчика.

10.12.2021 [12:00], Алексей Степин

Аквариус T50 D224CF: надёжный и масштабируемый сервер для любых задачКомпания «Аквариус» работает на российском рынке с 1989 года, постоянно расширяя ассортимент производимой продукции. При этом она практически не использует оборудование ОЕМ-поставщиков, 94% из всего модельного ряда устройств «Аквариус» составляют системы собственной разработки. В этом году компания сообщила о разработке двадцати новых моделей серверов и преодолела рубеж в 250 тысяч произведенных серверных устройств. Юбилейной стала флагманская модель — Aquarius T50 D224CF.  Это сервер форм-фактора 2U, располагающий серьёзными возможностями: новая модель разработана с прицелом на максимальную гибкость конфигурирования и расширения, поэтому она одинаково хорошо подойдёт как для развёртывания среды виртуализации или работы с объемными базами данных, так и для создания современной высокопроизводительной системы хранения данных. Базируется Аквариус T50 D224CF на хорошо известной и доказавшей свою надёжность платформе Intel® Xeon® Scalable (LGA 3647). Системная плата на базе чипсета Intel® C624 предусматривает установку процессоров Xeon® Scalable с этим разъёмом как первого (Skylake-SP), так и второго (Cascade Lake-SP/Refresh) поколения с теплопакетом вплоть до 205 Вт включительно. 24 слота для модулей памяти позволяют установить до 3 Тбайт оперативной памяти стандарта DDR4, а с использованием модулей Optane DCPMM этот показатель можно довести и до 6 Тбайт. Но по-настоящему интересной данную модель делает её гибкость в конфигурировании. Во-первых, она имеет 24 дисковых корзины формата 2,5″ с поддержкой SAS-3/SATA-3 и NVMe (до 16 накопителей) и опционально может оснащаться ещё 4 такими отсеками на тыльной стороне (но уже без NVMe). А поддержка одновременной работы 16 NVMe SSD делает Aquarius T50 D224CF отличной платформой для создания высокопроизводительной СХД. Во-вторых, новый сервер Аквариус может поставляться в двух конфигурациях в зависимости от адаптеров расширения:

Оба варианта прекрасно работают с любыми картами расширения, включая ускорители, периферийные и сетевые адаптеры стандартов Ethernet, InfiniBand 10/40/100 Гбит/с, а также Fibre Channel. Сервер имеет развитую систему мониторинга и удалённого управления на основе популярного контроллера ASPEED AST2500, поддерживающего стандарты IPMI 2.0 и Redfish 1.1. Контроллер имеет свой выделенный порт 1GbE.

Стапельная сборка сервера на производственном комплексе «Аквариус», город Шуя, Ивановская область Максимальная конфигурация сервера требует наличие высокоэффективной системы охлаждения, которая в данной модели состоит из 6-ти вентиляторов с ШИМ-управлением, имеющих вибропоглощающие крепления и поддерживающих горячую замену. Дополнительную отказоустойчивость системы охлаждения обеспечивает индикатор отказа. Заменять в горячем режиме можно и ряд других компонентов сервера, за исключением процессоров, что позволяет в случае неисправности сократить время простоя до минимума. За питание отвечает пара (1+1) блоков, которые, в зависимости от конфигурации, могут иметь мощность от 800 до 2000 Ватт. Базовый вариант предполагает питание от стандартной сети, опционально «Аквариус» предлагает питание от сети постоянного тока 48 В, либо высоковольтной сети 380 В. Также доступен встроенный источник бесперебойного питания. Гибкость и масштабируемость данного сервера делают его поистине универсальным решением: Аквариус T50 D224CF может применяться в облачных системах, кластерах HPC, комплексах виртуализации (в том числе для виртуальных рабочих мест, VDI), системах машинного обучения или как сервер веб-приложений. Он может стать частью комплекса ИИ, основой СХД или мощной сетевой инфраструктуры.  Компания-производитель гарантирует совместимость с широчайшим спектром операционных систем и программного обеспечения. В частности, модель сертифицирована для работы с ПО VMware, RedHat, SUSE, Microsoft Windows Server, а также протестирована на совместимость работы с ускорителями вычислений NVIDIA и российскими средствами защиты информации «Соболь» и «Аккорд». Более того, сервер может комплектоваться двумя микросхемами BIOS, предоставляя заказчику возможность переключаться между AMI BIOS и отечественной разработкой NUMA BIOS.  Аквариус T50 D224CF — это современный, высокопроизводительный сервер, который отличается гибкостью конфигурирования и широкоми возможностями расшириения системы. Именно гибкость и масштабируемость делают его действительно универсальной системой для поддержки самого широкого спектра нагрузок и формирования различных IT-систем. Стоимость нового сервера варьируется в зависимости от конфигурации, цена базового варианта стартует от 400 000 рублей. При необходимости можно получить более точную информацию на сайте компании-производителя, либо по телефону +7 (495) 729-51-50.

07.12.2021 [00:36], Алексей Степин

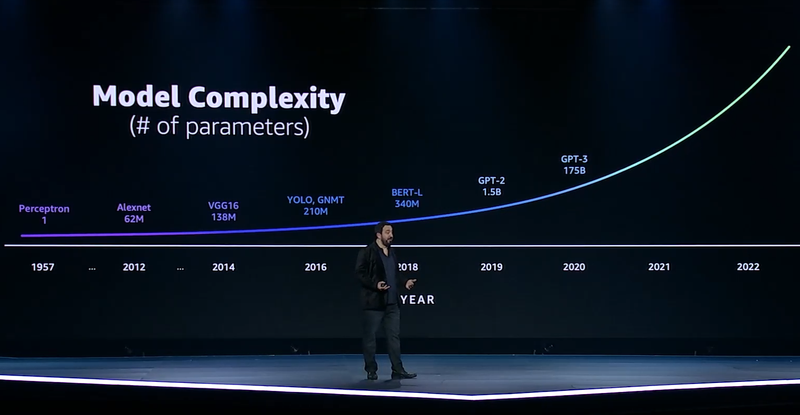

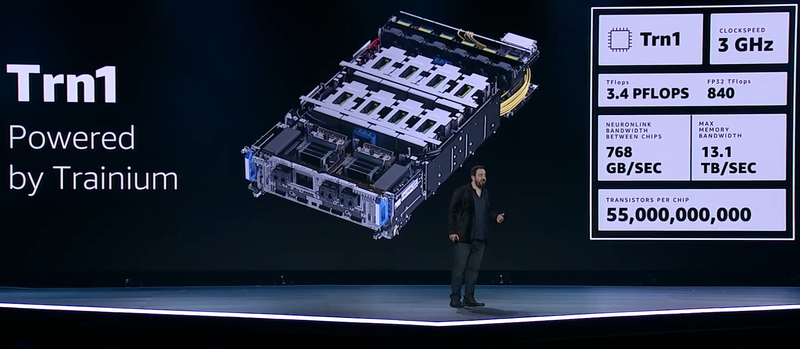

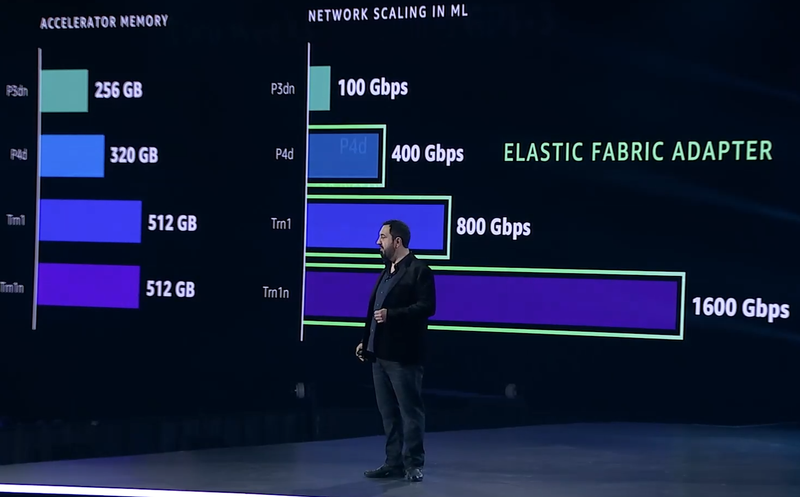

ИИ-ускорители AWS Trainium: 55 млрд транзисторов, 3 ГГц, 512 Гбайт HBM и 840 Тфлопс в FP32GPU давно применяются для ускорений вычислений и в последние годы обросли поддержкой специфических форматов данных, характерных для алгоритмов машинного обучения, попутно практически лишившись собственно графических блоков. Но в ближайшем будущем их по многим параметрам могут превзойти специализированные ИИ-процессоры, к числу которых относится и новая разработка AWS, чип Trainium. На мероприятии AWS Re:Invent компания рассказала о прогрессе в области машинного обучения на примере своих инстансов P3dn (Nvidia V100) и P4 (Nvidia A100). Первый вариант дебютировал в 2018 году, когда модель BERT-Large была примером сложности, и благодаря 256 Гбайт памяти и сети класса 100GbE он продемонстрировал впечатляющие результаты. Однако каждый год сложность моделей машинного обучения растёт почти на порядок, а рост возможностей ИИ-ускорителей от этих темпов явно отстаёт.

Сложность моделей машинного обучения будет расти всё быстрее Когда в прошлом году был представлен вариант P4d, его вычислительная мощность выросла в четыре раза, а объём памяти и вовсе на четверть, в то время как знаменитая модель GPT-3 превзошла по сложности BERT-Large в 500 раз. А теперь и 175 млрд параметров последней — уже ничто по сравнению с 10 трлн в новых моделях. Приходится наращивать и объём локальной памяти (у Trainium имеется 512 Гбайт HBM с суммарной пропускной способностью 13,1 Тбайт/с), и активнее использовать распределённое обучение.  Для последнего подхода узким местом стала сетевая подсистема, и при разработке стека Elastic Fabric Adapter (EFA) компания это учла, наделив новые инстансы Trn1 подключением со скоростью 800 Гбит/с (вдвое больше, чем у P4d) и с ультранизкими задержками, причём доступен и более оптимизированный вариант Trn1n, у которого пропускная способность вдвое выше и достигает 1,6 Тбит/с. Для связи между самими чипами внутри инстанса используется интерконнект NeuroLink со скоростью 768 Гбайт/с.

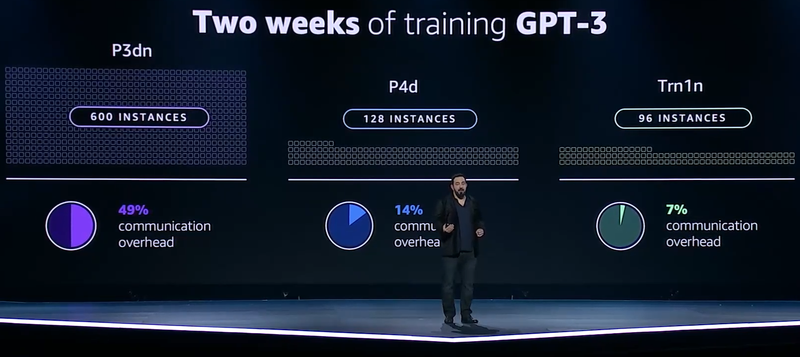

Прогресс подсистем сети и памяти в ИИ-инстансах AWS Но дело не только в возможности обучить GPT-3 менее чем за две недели: важно и количество используемых для этого ресурсов. В случае P3d это потребовало бы 600 инстансов, работающих одновременно, и даже переход к архитектуре Ampere снизил бы это количество до 200. А вот обучение на базе чипов Trainium требует всего 130 инстансов Trn1. Благодаря оптимизациям, затраты на «общение» у новых инстансов составляют всего 7% против 14% у Ampere и целых 49% у Volta.

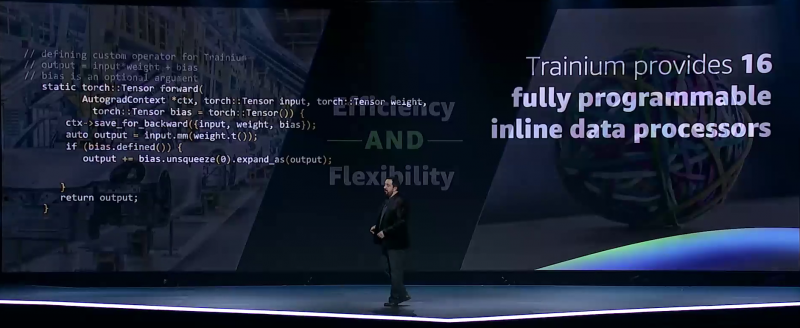

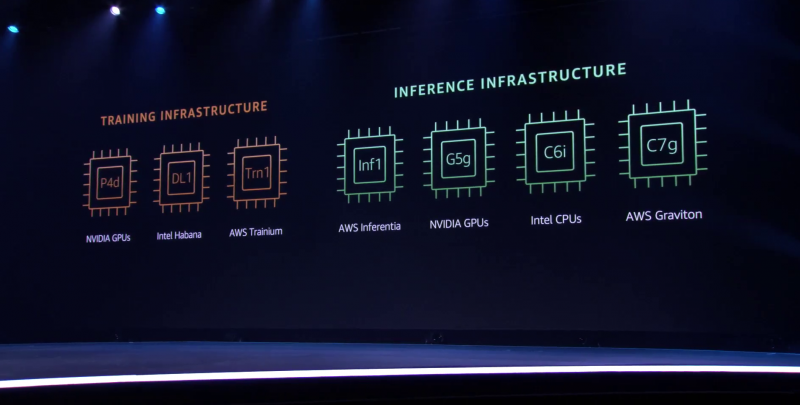

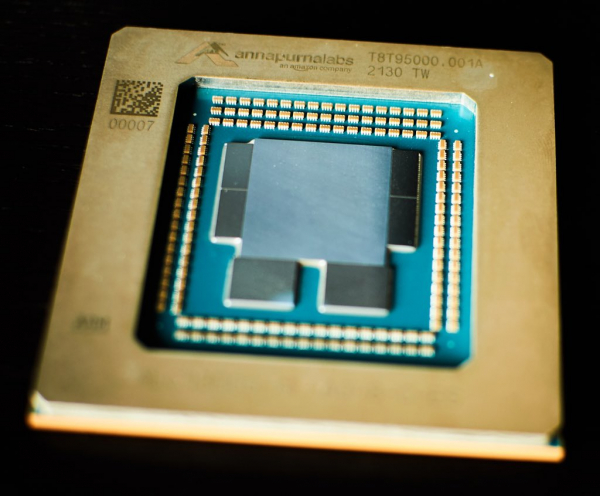

Меньше инстансов, выше эффективность при равном времени обучения — вот что даст Trainium Trainium опирается на систолический массив (Google использовала тот же подход для своих TPU), т.е. состоит из множества очень тесно связанных вычислительных блоков, которые независимо обрабатывают получаемые от соседей данные и передают результат следующему соседу. Этот подход, в частности, избавляет от многочисленных обращений к регистрам и памяти, что характерно для «классических» GPU, но лишает подобные ускорители гибкости. В Trainium, по словам AWS, гибкость сохранена — ускоритель имеет 16 полностью программируемых (на С/С++) обработчиков. Есть и у него и другие оптимизации. Например, аппаратное ускорение стохастического округления, которое на сверхбольших моделях становится слишком «дорогим» из-за накладных расходов, хотя и позволяет повысить эффективность обучения со смешанной точностью. Всё это позволяет получить до 3,4 Пфлопс на вычислениях малой точности и до 840 Тфлопс в FP32-расчётах. AWS постаралась сделать переход к Trainium максимально безболезненным для разработчиков, поскольку SDK AWS Neuron поддерживает популярные фреймворки машинного обучения. Впрочем, насильно загонять заказчиков на инстансы Trn1 компания не собирается и будет и далее предоставлять на выбор другие ускорители поскольку переход, например, с экосистемы CUDA может быть затруднён. Однако в вопросах машинного обучения для собственных нужд Amazon теперь полностью независима — у неё есть и современный CPU Graviton3, и инфереренс-ускоритель Inferentia.

04.12.2021 [03:42], Игорь Осколков

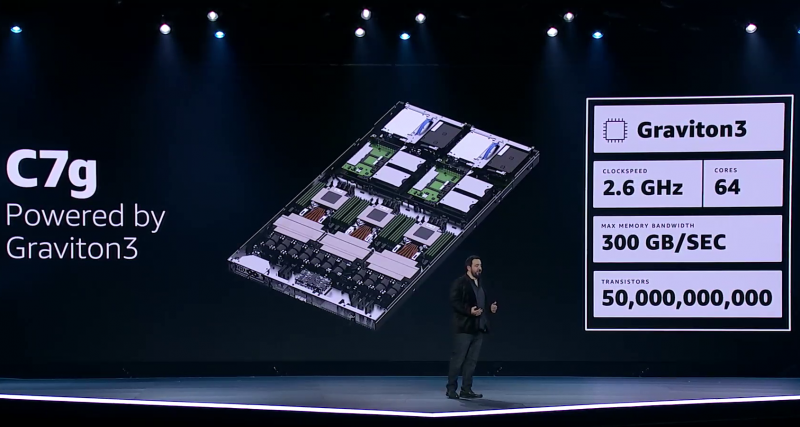

Процессор Amazon Graviton3: 64 ядра Arm, 5-нм техпроцесс, чиплетная компоновка и DDR5 с PCIe 5.0Анонсированный на днях Arm-процессор Graviton3, создававшийся специально для нужд Amazon и AWS, неожиданно оказался по ряду параметров на голову выше ещё даже не вышедших EPYC и Xeon следующего поколения. И это не самый хороший сигнал для AMD, Intel, Qualcomm и прочих производителей.

Amazon Graviton3. Фото: Ian Colle Graviton3 — первый массовый (самой Amazon и рядом избранных клиентов он используется уже не один месяц) серверный процессор с поддержкой DDR5 и PCIe 5.0. CPU выполнен по 5-нм техпроцессу TSMC и содержит примерно 55 млрд транзисторов. Для удешевления он использует BGA-корпусировку и чиплетную компоновку из семи отдельных кристаллов — два PCIe-контроллера и четыре двухканальных контроллера DDR5 вынесены за пределы собственно CPU.

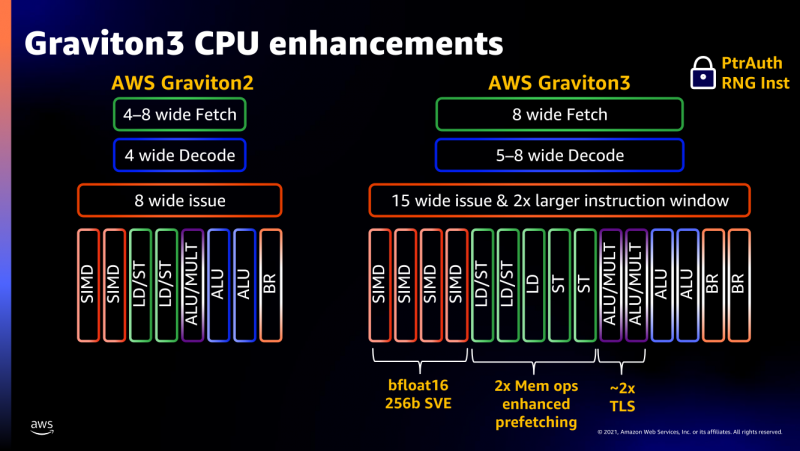

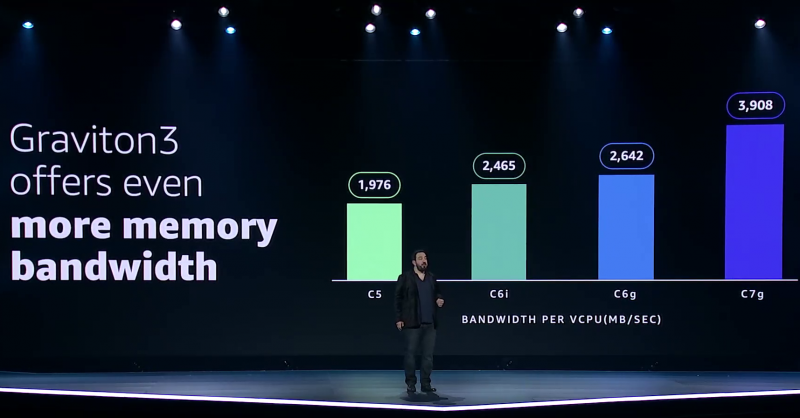

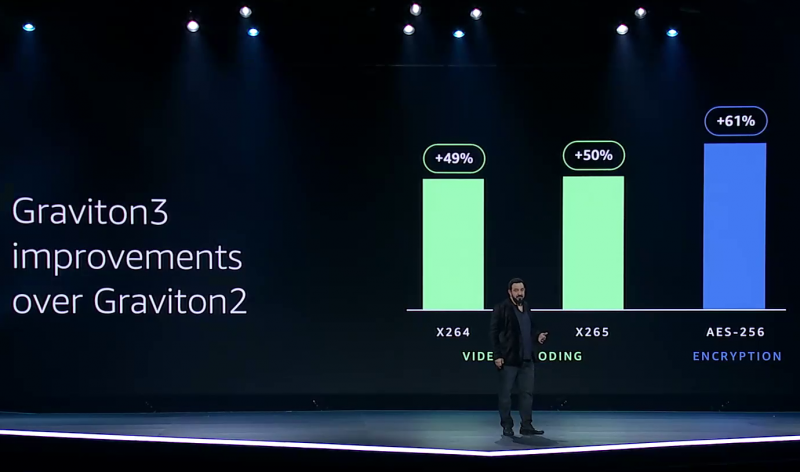

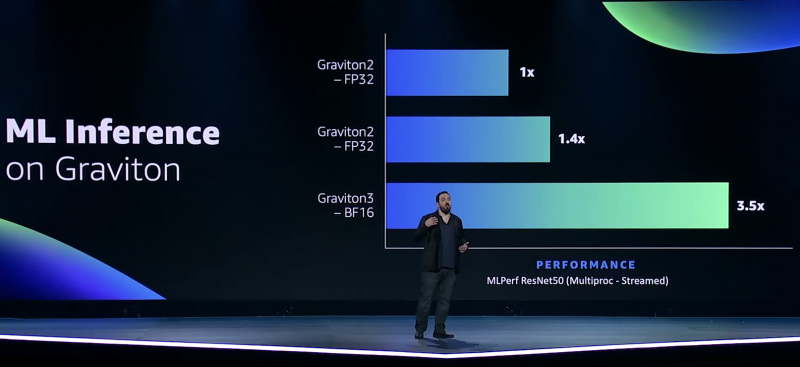

Узел EC2 C7g. Здесь и ниже изображения Amazon AWS Более того, их упаковка использует передовые решения с каналами длиной менее 55 мкм, что вдвое меньше, чем у других серверных CPU. Уменьшение длины проводников положительно сказывается на энергоэффективности, которая очень важна для любого гиперскейлера. Этим же объясняется и относительно небольшое по современным меркам число ядер (всего 64) и их частота (2,6 ГГц). Всё это позволило добиться энергопотребления примерно в 100 Вт.  Есть и ещё один важный плюс в сохранении числа ядер — переход на DDR5-4800 позволил не только достичь пиковой суммарной пропускной способности памяти в 300 Гбайт/с на чип, но и повысить реальную скорость работы с памятью каждого vCPU (фактически ядра) в полтора раза по сравнению с прошлым поколением. Та же ситуация и с PCIe 5.0 — для достижения той же пропускной способности, что ранее, нужно вдвое меньше линий.  Для удешевления используются готовые IP-блоки сторонних компаний и, судя по всему, ядра тоже несильно отличаются от референсов Arm. А вот какие именно, узнаем не сразу, поскольку Amazon явно не указала, будут ли это Neoverse V1 (Zeus) или N2 (Perseus). Вероятно, это всё же V1 (ARMv8.5-A), поскольку по описанию Graviton3 похожи именно на эту архитектуру. Новые ядра стали значительно «шире» прежних — они забирают 8 инструкций, декодируют от 5 до 8 из них и отправляют на исполнение сразу 15 инструкций. Соответственно и число исполнительных блоков по сравнению с Neoverse-N1 (Graviton2) практически удвоилось.  Кроме того, они обзавелись поддержкой 256-бит векторных инструкций SVE, что повысило не только скорость выполнения «классических» FP-операций (например, для задач медиакодирования и шифрования), но и благодаря поддержке bfloat16 позволило утверждать Amazon, что новые чипы годятся и для инференса. Среди упомянутых ранее мер защиты есть, например, принудительное шифрование оперативной памяти, изолированные кеши для каждого vCPU (ядра), аппаратная защита стека.

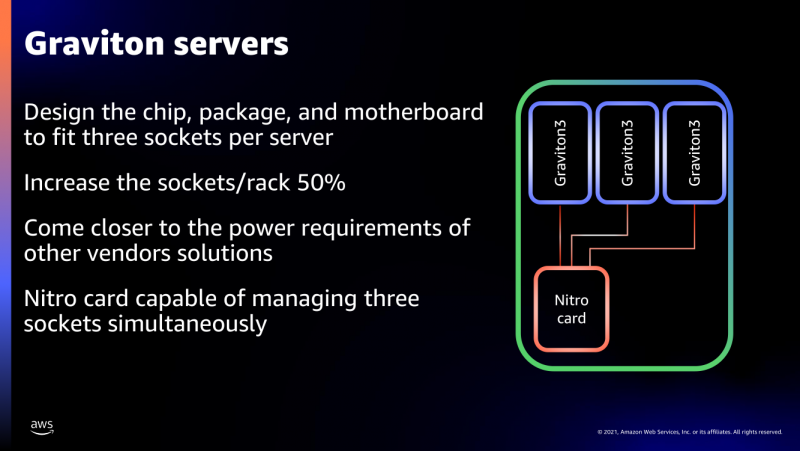

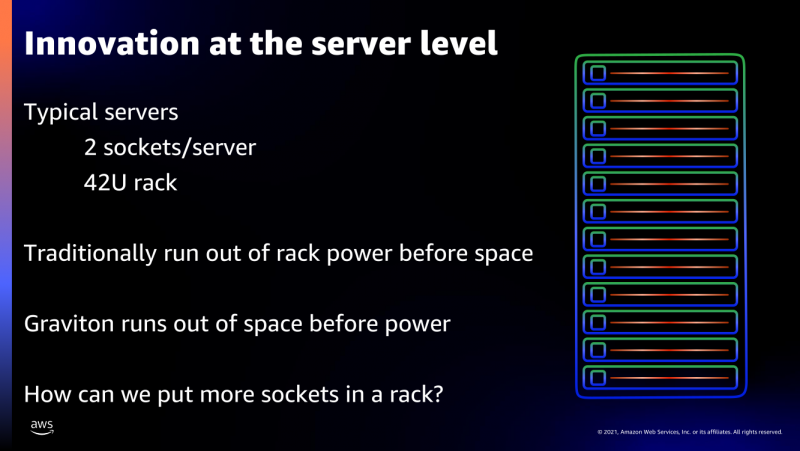

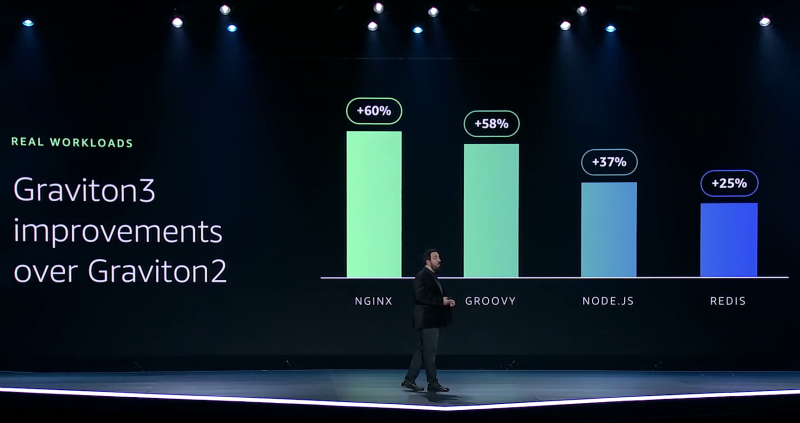

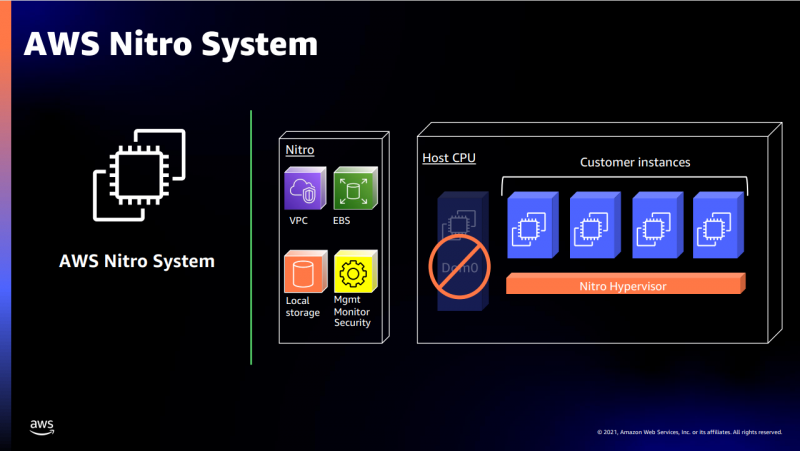

В подписи второго столбца явная опечатка В целом, средний прирост производительности Graviton3 по сравнению с Graviton2 составил 25 %, но в некоторых задачах он достигает 60 %. И всё это при сохранении того же уровня энергопотребления и тепловыделения. Всё это позволило уместить в одном 1U-узле с воздушным охлаждением сразу три процессора Graviton3. И они разительно отличаются от грядущих 128-ядерных процессоров Altra Max и EPYC Bergamo, которые Ampere и AMD позиционируют как решения для гиперскейлеров. Зато в чём-то похожи на Yitian 710 от Alibaba Cloud.  Но CPU — это лишь часть платформы, фундамент для которой несколько лет назад заложило появление чипов Nitro. Их сейчас стоило бы назвать DPU/IPU, хотя на момент их появления такого понятия, можно сказать, и не было. Nitro берёт на себя все задачи по обслуживанию гипервизора, обеспечению безопасности, работе с хранилищем и сетью и т.д., высвобождая, с одной стороны, все ресурсы CPU, памяти и SSD для обработки задачи клиента, а с другой — позволяя практически полностью дезагрегировать всю инфраструктуру.

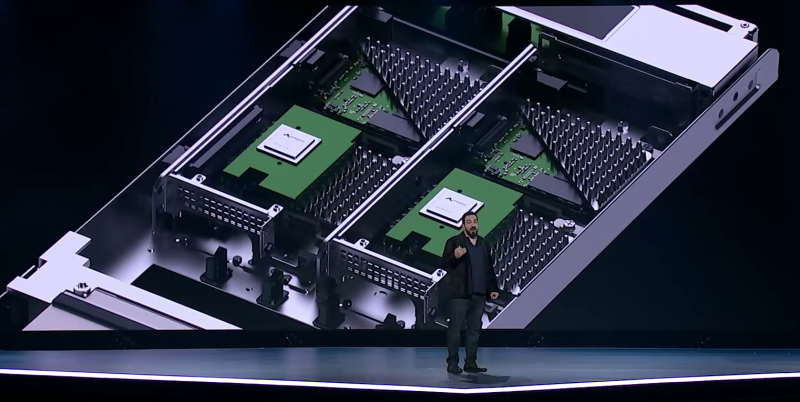

Узел с Nitro SSD Впрочем, Amazon пошла ещё дальше — теперь она самостоятельно закупает NAND-чипы и производит SSD, тоже под управлением Nitro. То есть у компании под контролем практически полный стек современных аппаратных решений: CPU, DPU, SSD, ИИ-ускорители для обучения (Trainium) и инференса (Inferentia). Она активно переносит на него собственные сервисы и предлагает их клиентам. И именно это и должно обеспокоить крупных вендоров, поскольку их решения вряд ли позволят добиться такого же уровня TCO, а гиперскейлеров, желающих перейти на аналогичную модель, немало. UPD 06.12.21: презентация новых процессоров стала доступна публично, поэтому в материал добавлены некоторые иллюстрации, а в галерее ниже приведены результаты тестов производительности.

23.11.2021 [02:10], Владимир Мироненко

Microsoft, Caterpillar и Ballard протестируют 1,5-МВт генератор на водородных топливных элементахMicrosoft объединила усилия с Caterpillar и Ballard Power Systems для тестирования резервных генераторов на водородных топливных элементах в своём дата-центре в Куинси (штат Вашингтон). Проект рассчитан на три года и нацелен на изучение возможности использования водородных топливных элементов в масштабе ЦОД. Проект частично финансируется Министерством энергетики США (DOE) в рамках инициативы H2@Scale. Caterpillar станет генеральным подрядчиком, обеспечивающим общую интеграцию всех систем, работу силовой электроники и средств управления. Ballard предоставит водородный электрогенератор на топливных элементах ClearGen-II мощностью 1,5 МВт, а Национальная лаборатория возобновляемых источников энергии (NREL) выполнит анализ его безопасности, экологичности и технико-экономических аспектов эксплуатации.

Источник изображения: Microsoft Для успешной реализации проекта необходимо решить ряд проблем. Чтобы топливные элементы обеспечивали мощность 3 МВт в течение 48 часов, требуется около 68 м3 жидкого водорода, для хранения которого требуется намного больше места, чем для дизельного топлива. Для избегания утечек требуются специальные трубопроводы, а сам водород надо хранить при температуре ниже -253 °C. Ранее Microsoft успешно испытала водородные топливные ячейки мощностью 250 кВт от Power Innovations.

16.11.2021 [03:33], Игорь Осколков

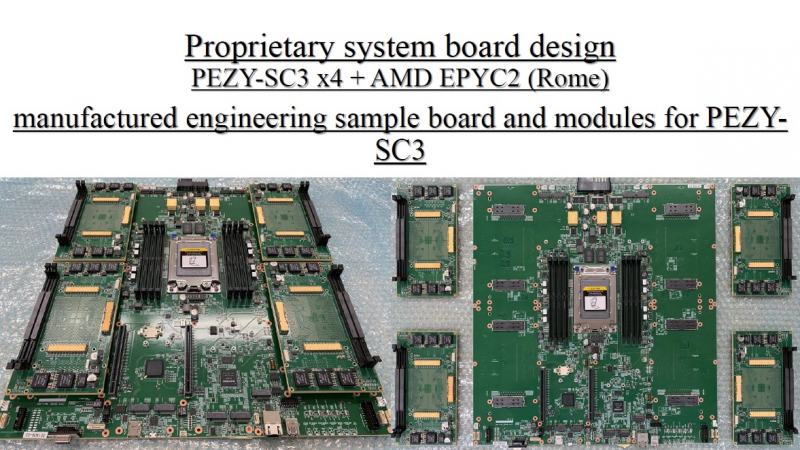

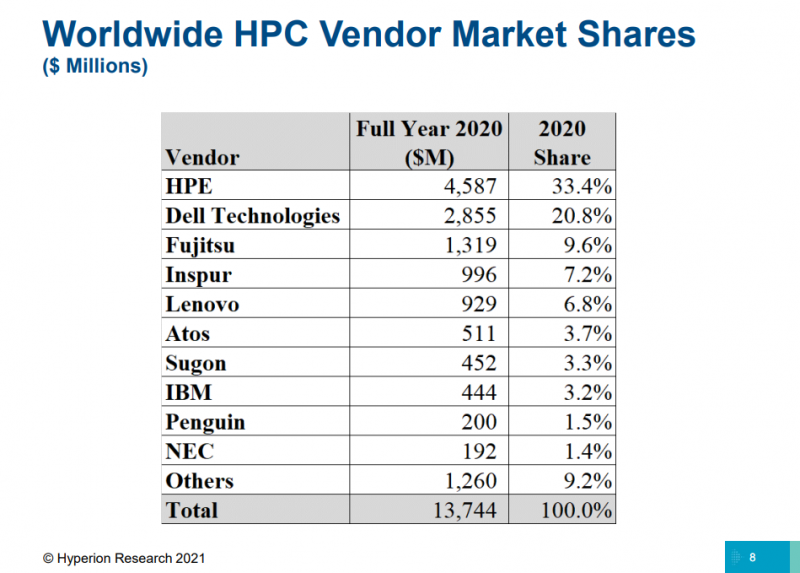

TOP500: уж ноябрь на дворе, а экзафлопса не видатьПоследняя версия публичного рейтинга самых производительных в мире суперкомпьютеров TOP500 так и осталась без экзафлопсных машин. Китай не захотел включать в него две системы такого класса и пошёл обходным путём, номинировав работы своих учёных на премию Гордона Белла — в соответствующих научных работах даны неполные характеристики машин и показатели их производительности. Поэтому лидером списка остаётся обновлённая японская система Fugaku, 7,6 млн ядер которой выдают 442 Пфлопс. И она всё ещё втрое быстрее своего ближайшего конкурента Summit. Первые результаты сборки Frontier в список попасть не успели. Всего в ноябрьском рейтинге есть порядка 70 новых систем, но, как и прежде, больше половины из них — однотипные системы Lenovo, массово устанавливаемые в Китае. На Китай вообще приходится более трети (34,6%) систем в списке. На втором месте находятся США (29,8%), а на третьем — Япония (6,4%). По суммарной производительности Топ-3 тот же, но порядок иной: США (32,5%), Япония (20,7%), Китай (17,5%). В число лидеров также входят Германия, Франция, Нидерланды, Канада, Великобритания, Южная Корея и Россия. У РФ теперь есть сразу семь машин в списке с суммарной производительностью 73,715 Пфлопс. Для сравнения — Perlmutter (5 место) после апгрейда выдаёт 70,87 Пфлопс, а у Южной Кореи тоже есть семь машин, но с чуть более высокой суммарной производительностью в 82,177 Пфлопс. К уже имевшимся в TOP500 российским системам MTS GROM (294 место), Lomonosov-2 (Ломоносов-2, 241 место) и Christofari (Кристофари, 72 место) добавились Christofari Neo (Кристофари Нео, 43 место), а также сразу три системы Яндекса: Ляпунов (Lyapunov, 40 место), Галушкин (Galushkin, 36 место) и Червоненкис (Chervonenkis, 19 место). Примечательно, что все российские системы этого года используют AMD EPYC Rome и NVIDIA A100, а также интерконнект Infininiband. Машины для МТС и Сбера сделала сама NVIDIA (это всё DGX), а вот у Яндекса путь особый. Ляпунов (12,81 Пфлопс) создан китайским Национальным университетом оборонных технологий (National University of Defense Technology, NUDT) и Inspur на базе серверов NF5488A5 (AMD EPYC 7662@2 ГГц + A100 40 Гбайт). Червоненкис (21,53 Пфлопс) и Галушкин (16,02 Пфлопс) разработаны IPE, NVIDIA и Tyan. В этих системах используются EPYC 7702 (тоже 64-ядерные с базовой частотой 2 ГГц) и более новые A100 (80 Гбайт). Среди прочих новых систем TOP500 особо выделяется Voyager-EUS2, которая замыкает Топ-10. Это ещё система на базе обновлённых инстансов Microsoft Azure ND A100 v4 с 80-Гбайт версией A100. Однако ещё одной облачной машиной уже никого не удивить, в отличие от совершенно неожиданного возврата японской PEZY, пропавшей с радаров после скандала 2017 года. Новая ZettaScaler3.0 занимает 453 место и базируется на AMD EPYC 7702P и фирменных ускорителях PEZY-SC3. В целом, последний год был удачным и для AMD, и для NVIDIA. Первая почти втрое нарастила число систем на базе EPYC — их теперь в списке 74 (или почти треть новых участников списка), если учитывать Naples/Hygon (таких систем 3). Если же смотреть более детально именно на CPU, то тут лидером всё равно остаётся Intel, хотя она и потеряла несколько процентных пунктов за последние полгода — всего 408 машин используют её процессоры. Правда, новейших Ice Lake-SP среди них всего 10, тогда как у EPYC Milan уже 17. Без акселераторов обходятся 350 суперкомпьютеров списка, зато из 150 оставшихся 143 используют различные поколения ускорителей NVIDIA. Удивительно, но ни одной системы с ускорителями AMD Instinct в ноябрьском рейтинге нет. Остальные акселераторы представлены в единичном экземпляре. И это либо устаревшие системы, либо экзотика из Китая и Японии. Последняя в лице MN-3 всё ещё лидирует по энергоэффективности в Green500. Систем с Infiniband в списке 178, с Ethernet — 242. Как обычно, по производительности систем лидирует именно IB — 44,5% против 22,4% у Ethernet. Это, к слову, несколько отличается от показателей HPC-индустрии в целом, где в количественном выражении у них практически равные доли. На Omni-Path пришлось 40 систем в TOP500, и столько же на проприетарные интерконнекты. Тут интересно разве что появление второй машины с Atos BXI V2. Среди производителей по количеству машин лидируют Lenovo (180 шт., это в основном уже упомянутые типовые развёртывания в Китае), HPE (84 шт., сюда же входит наследие Cray и SGI) и Inspur (50 шт.). По производительности картина иная, в Топ-3 входят HPE, Fujitsu (во многом благодаря Fugaku) и Lenovo. По HPC-рынку в целом, согласно данным Hyperion Research, в денежном выражении тройка лидеров включает HPE, Dell и Fujitsu (да, опять «виноват» Fugaku). |

|