Лента новостей

|

28.10.2025 [21:35], Владимир Мироненко

NVIDIA и Oracle построят для США ИИ-суперкомпьютер Solstice: 100 тыс. ускорителей Blackwell и государственно-частное партнёрствоNVIDIA объявила о новом совместном проекте с Oracle по созданию крупнейшей суперкомпьютерной системы с поддержкой ИИ в интересах Министерства энергетики США (DoE) для разработок в сфере науки. В рамках партнёрства NVIDIA и Oracle построят два суперкомпьютера — Solstice и Equinox, оснащённых 100 тыс. и 10 тыс. ускорителей NVIDIA Blackwell соответственно, которые будут объединены интерконнектом NVIDIA и обеспечат суммарную ИИ-производительность в 2,2 Зфлопс. Система Equinox будет введена в эксплуатацию в I половине 2026 года. Стоимость проекта не разглашается. Solstice будет построен с использованием новой модели государственно-частного партнёрства Министерства энергетики США, включающей инвестиции cо стороны промышленности. Сообщается, что суперкомпьютеры будут размещены в Аргоннской национальной лаборатории (ANL) Министерства энергетики США. С их помощью исследователи будут разрабатывать и обучать новые передовые ИИ-модели, включая модели рассуждений, для реализации проектов открытой науки, используя библиотеку NVIDIA Megatron-Core, а также масштабировать их с помощью программного стека для инференса NVIDIA TensorRT. Эти модели станут основой рабочих процессов агентного ИИ для научных исследований. Оба суперкомпьютера будут использоваться в рамках сотрудничества NVIDIA, ANL и DoE, повышая производительность исследований и разработок и ускоряя процесс научных открытий, которые будут осуществляться за счет государственных средств в течение десятилетия. Глава ANL, что новые суперкомпьютеры будут подключены к передовым экспериментальным установкам Министерства энергетики США, таким как усовершенствованный источник фотонов, что позволит решать самые насущные проблемы страны благодаря научным открытиям.

28.10.2025 [20:35], Сергей Карасёв

NVIDIA анонсировала DPU BlueField-4: 800G-порты, ConnectX-9, CPU Grace и PCIe 6.0NVIDIA анонсировала DPU BlueField 4, рассчитанный на использование в составе масштабных инфраструктур ИИ. Устройство оснащено 800G-портами. Новинка в этом отношении вдвое быстрее BlueField-3, дебютировавших ещё в 2021 году. NVIDIA отмечает, что ИИ-фабрики продолжают развиваться с беспрецедентной скоростью. При этом требуется обработка колоссальных массивов структурированных и неструктурированных данных. Для удовлетворения этих потребностей необходимо формирование инфраструктуры нового класса, на которую как раз и ориентирован DPU BlueField-4. Новинка использует программно-определяемую архитектуру для ускорения сетевых операций, функций безопасности и задач хранения данных. По заявлениям NVIDIA, BlueField-4 позволяет трансформировать дата-центры в безопасную интеллектуальную ИИ-инфраструктуру с высокой производительностью. BlueField-4 объединяет 64-ядерный Arm-процессор NVIDIA Grace (114 Мбайт L3-кеш), 128 Гбайт LPDDR5, 512 Гбайт SSD, сетевой адаптер NVIDIA ConnectX-9 SuperNic (1,6 Тбит/с), а также коммутатор PCIe 6.0 с 48 линиями. Новинка будет доступна в виде карты расширения (PCIe 6.0 x16) и в виде модуля для узлов VR NVL144. Утверждается, что по сравнению с BlueField-3 вычислительная производительность выросла в шесть раз. При этом возможно формирование ИИ-фабрик вчетверо большего масштаба. Кроме того, BlueField-4 поддерживает многопользовательскую сеть, быстрый доступ к данным и микросервисы NVIDIA DOCA. Задействована архитектура NVIDIA BlueField Advanced Secure Trusted Resource Architecture. Предполагается, что BlueField-4 возьмут на вооружение такие производители серверов и платформ хранения данных, как Cisco, DDN, Dell Technologies, HPE, IBM, Lenovo, Supermicro, VAST Data и WEKA. О поддержке новинки заявили Armis, Check Point, Cisco, F5, Forescout, Palo Alto Networks и Trend Micro, а также системные интеграторы Accenture, Deloitte и World Wide Technology. Интегрировать BlueField-4 в свои платформы намерены Canonical, Mirantis, Nutanix, Rafay, Red Hat, Spectro Cloud и SUSE. На рынок BlueField-4 поступит в 2026 году как часть экосистемы Vera Rubin.

28.10.2025 [17:03], Руслан Авдеев

Fermi заказала четыре больших ядерных реактора для своих ИИ ЦОД в Техасе — это крупнейший проект АЭС в США в XXI векеАмериканская Fermi Inc. заключила соглашение о строительстве четырёх крупных атомных реакторов для кампуса ЦОД в техасском городе Панхандл (Panhandle), сообщает Bloomberg. Акции компании выросли на 9 %. Примечательно, что Fermi пока не получает никакой выручки, но намерена ввязаться в строительство одного из наиболее сложных и дорогих типов электростанций. В текущем столетии в США реализован лишь один атомный проект Vogtle по строительству двух реакторов в Джорджии, но и он был завершён с перерасходом средств и значительными задержками. Fermi, одним из учредителей которой является бывший министр энергетики Рик Перри (Rick Perry), активно стремится найти гигаватты для удовлетворения быстрорастущего спроса на ИИ. Компания из Техаса основана лишь в начале текущего года, но после выхода на биржу 1 октября уже имеет капитализацию около $14 млрд.

Источник изображения: Fermi America Fermi, привлекла южнокорейскую Doosan Enerbility для помощи в запуске проекта. В частности, речь о создании корпусов реакторов, парогенераторов и иного критически важного оборудования, требующего много времени на изготовление. Ранее компания объявила о намерении установить четыре реактора Westinghouse AP1000 поколения III+ с выходной мощностью около 1,1 ГВт. Кроме того, она подписала отдельный контракт с Hyundai Engineering & Construction, которая поможет построить в Техасе «ядерный» ЦОД HyperGrid. Хотя надежды многих в США на «ядерный ренессанс» связаны с малыми модульными реакторами (SMR), стремление Fermi играть на поле «большой» атомной энергетики не ново, хотя на сегодняшний день речь идёт о самом смелом проекте. Невероятно важно перестроить всю цепочку поставок, от привлечения рабочих для строительства и эксплуатации такого важного проекта до создания энергетического оборудования в условиях глобального дефицита товаров вроде трансформаторов. Стоит отметить, что есть и другие масштабные проекты восстановления атомной энергетики в Соединённых Штатах. Constellation Energy работает над перезапуском закрытой АЭС Three Mile Island в Пенсильвании для ЦОД Microsoft, а NextEra Energy совместно с Google перезапустят АЭС в Айове.

28.10.2025 [15:58], Руслан Авдеев

Банк Англии проверит кредитование ЦОД на фоне возможного пузыря на рынке ИИБанк Англии (BOE), выполняющий функции центробанка Великобритании, инициировал расследование, касающееся вопросов кредитования дата-центров. Это сделано на фоне опасений, что обвал цены компаний, связанных с ИИ, может вызвать хаос на фондовом рынке, сообщает Datacenter Dynamics. Издание ссылается на источники Bloomberg в BOE, которые свидетельствуют, что поводом для новых мер стали многомиллиардные инвестиции в строительство дата-центров по всему миру. Хотя в основном такие проекты финансируются за счёт акционерного капитала, некоторые компании для строительства и закупок оборудования вынуждены брать в долг большие суммы. На этом фоне продолжают расти опасения по поводу формирования пузыря ИИ. Эксперты задаются и вопросом о том, какое влияние пузырь способен оказать на экономику в целом. Например, в США в 2025 году на акции ИИ-компаний из рейтинга S&P Top 500 приходилось 44 % рыночной капитализации, а прямые инвестиции в эту технологию обеспечили 1,1 % роста ВВП страны только за I полугодие. Некоторых экспертов пугает и циклический характер сделок, в которых поставщики нередко финансируют своих клиентов и наоборот. Банк Англии намерен разобраться во взаимосвязанной структуре многих сделок в ИИ-секторе, а также оценить, насколько основные расходы сместились с найма персонала на строительство инфраструктуры, что ограничило возможности альтернативного использования финансов.

Источник изображения: Francais a Londres/unspalsh.com Источники в BOE добавляют, что инвестиции, при которых деньги предоставляются взаймы под залог будущих активов (ЦОД), в создание которых вкладываются средства, могут стать сферой косвенного риска для финансовых учреждений. По статистике Bank of America, в обращении имеются ценные бумаги на $48 млрд, обеспеченные активами ЦОД и коммерческой ипотекой (CMBS) — это 61 % от общего объема рынка секьюритизации цифровой инфраструктуры на $79 млрд. Хотя Банк Англии не комментирует слухи, в своём блоге он заявил, что инвестиции в ИИ стали огромным драйвером роста ВВП США в I половине 2025 года. Подчёркивается, что пузырь доткомов в своё время привёл к умеренной рецессии в США, вызванной сокращений инвестиций в бизнес. При этом падение цен на связанные с ИИ активы может произойти совершенно ином макроэкономическом контексте. Если прогнозируемый масштаб финансируемых за счёт займов инвестиций в ИИ и связанную энергетическую инфраструктуру реализуется в течение текущего десятилетия, риски для финансовой стабильности, вероятно, возрастут. Утверждается, что банки, вероятно, окажутся под угрозой и напрямую из-за выданных ИИ-компаниям кредитов, и косвенно — через предоставление средств частным кредитным фондам и другим финансовым учреждениям, зависящим от цен на ИИ-активы. Степень риска, как и с любыми кредитами, будет зависеть от их размеров и качества.

28.10.2025 [15:02], Руслан Авдеев

SambaNova может быть выставлена на продажу — компании не удалось привлечь достаточно средствРазработчик ИИ-ускорителей SambaNova Systems изучает возможность продажи бизнеса. Компании не удалось вовремя завершить очередной рануд финансирования. По данным источников, знакомых с вопросом, она уже наняла инвестиционную компанию для контроля продажи, но переговоры продолжаются, т.ч. SambaNova всё ещё может передумать, сообщает The Information. Исполнительным председателем компании является Лип-Бу Тан (Lip-Bu Tan), нынешний глава Intel. В 2021 году капитализация компании оценивалась в $5 млрд. С момента основания SambaNova привлекла более $1,1 млрд, инвесторами выступили GV, Intel Capital, BlackRock и SoftBank Vision Fund. Издание говорит об отчёте Caplight, в котором указано, что BlackRock снизила оценочную стоимость своих акций в компании на 17 %, в результате чего общая оценка капитализации SambaNova упала до $2,4 млрд. SambaNova не прокомментировала возможную продажу, а её представитель заявил, что компания всегда оценивает стратегические возможности, поддерживающие её миссию, а также интересы владельцев. Основанная в 2017 году калифорнийская компания специализировалась на ИИ-ускорителях для обучения LLM, но в 2025 году сменила профиль на предоставление облачных ИИ-сервисов и инференс, повторив подход Groq. Последней, правда, повезло больше — она активно заключает сделки, получает инвестиции и создаёт ИИ ЦОД. У Cerebras дела идут ещё лучше, хотя и не идеально. Cerebras, Groq и SambaNova стали чуть ли не единственными компаниями, которые относительно успешно смогли конкурировать с NVIDIA и AMD на рынке «больших» ИИ-ускорителей. Последний продукт SambaNova — готовый ПАК SambaManaged на базе представленного два года назад ускорителям SN40L — популярности пока не снискал. Если SambaNova решится на продажу, она пополнит растущие ряды стартапов по выпуску ИИ-чипов, купленных за последние 12 месяцев. Так, Meta✴ объявила о покупке за неназванную сумму стартапа Rivos, занимающегося разработкой чипов на архитектуре RISC-V. Хотя сумма сделки неизвестна, ранее сообщалось, что стартап рассчитывал привлечь $500 млн с капитализацией $2 млрд. За полгода до этого южнокорейская FuriosaAI, тоже разрабатывающая ИИ-чипы, отклонила предложение Meta✴ о покупке за $800 млн. В этом году 2025 года SoftBank заявила о приобретении Ampere Computing за $6,5 млрд, а в прошлом году она приобрела разработчика ИИ-ускорителей Graphcore, у которого тоже были проблемы с финансами. Впрочем, бывают ситуации и похуже. Например, летом AMD купила команду разработчика ИИ-чипов Untether AI, но не саму компанию, которая тут же закрылась, оставив за бортом текущих клиентов стартапа. У Esperanto, создателя уникального тысячеядерного RISC-V-ускорителя, всех инженеров переманили крупные компании. Одним из возможных покупателей SambaNova называют Oracle, которая, по слухам, заинтересована именно в команде разработчиков, а не самих чипах.

28.10.2025 [12:54], Руслан Авдеев

Google и NextEra перезапустят АЭС в Айове, чтобы запитать ИИ ЦОДNextEra Energy и Google достигли соглашения о перезапуске зактрытой пять лет назад АЭС в Айове. Это ещё один признак того, что спрос на энергию для ИИ ЦОД открывает «второе дыхание» ядерной энергетике США, сообщает Reuters. 615-МВт АЭС Duane Arnold Energy Center (DAEC) близ Сидар-Рапидс (Cedar Rapids), согласно планам, возобновит работу в начале 2029 года, а Google в течение 25 лет будет закупать у неё электроэнергию. Рядом Google планирует построить до шести ЦОД. Ранее похожее соглашение заключили Microsoft и Constellation Energy. Компании возообновят работу атомной электростанции Three Mile Island в Пенсильвании для снабжения электричеством дата-центров Microsoft. Поставки начнутся даже раньше, чем планировалось. Подход Meta✴ оказался более практичным — компания получит всю энергию действующей АЭС Clinton Clean Energy Center (CCEC), но только с 2027 года, когда закончится государственное субсидирование станции. А AWS просто стала соседом действующей АЭС. Google, Microsoft, Amazon (AWS), Oracle и другие гиперскейлеры, управляющие огромной облачной инфраструктурой, также в последние месяцы заключают соглашения о покупке энергии у атомных стартапов, разрабатывающих термоядерные или малые модульные реакторы (SMR), пока отсутствующие в коммерческой эксплуатации. NextEra и Google также изучают возможность работы с новыми энергетическими технологиями.

Источник изображения: Drew Dau/unsplash.com Как сообщают в NextEra, возобновление работы Duane Arnold является важной вехой. Партнёрство с Google не только возвращает атомную энергетику в Айову, но и ускоряет развитие ядерных технологий нового поколения. Duane Arnold Energy Center — единственная атомная электростанция в Айове. Он закрылся в 2020 году после 45 лет эксплуатации. Хотя в США уже предпринимаются попытки «оживить» три АЭС, ни один из законсервированных объектов пока так и не заработал снова. В Google заявляют, что партнёрство с NextEra послужит моделью получения инвестиций, необходимых для наращивания энергетических мощностей по всей стране. Это обеспечит потребителей надёжной, чистой энергией, сохранив её доступность. Кроме того, проекты помогут создавать новые рабочие места. В целом такие проекты будут стимулировать экономику, основанную на ИИ-технологиях. В NextEra заявляют, что владелец миноритарной доли АЭС — компания Central Iowa Power Cooperative — будет покупать не нужные Google «излишки» энергии по тем же ценам, что и IT-гигант. При этом NextEra подписала соглашение о выкупе 30 % доли АЭС Duane Arnold у Central Iowa Power Cooperative и Corn Belt Power Cooperative, в результате компания станет единственным владельцем АЭС.

28.10.2025 [12:06], Сергей Карасёв

AMD продала Sanmina производственное подразделение ZT Systems и тут же сделала её ключевым партнёромКомпания AMD сообщила о закрытии сделки по продаже производственного подразделения ZT Systems: покупателем выступила американская корпорация Sanmina — поставщик услуг по производству электроники. Сумма сделки составила $3 млрд, включая денежные средства и обыкновенные акции Sanmina. AMD приобрела фирму ZT Systems весной нынешнего года, заплатив за неё $4,9 млрд. Эта компания специализируется на выпуске серверов, в том числе высокопроизводительных решений для гиперскейлеров. Говорилось, что покупка позволит объединить «ведущие в индустрии системы» и «компетенции уровня стоек» с передовыми полупроводниковыми технологиями AMD. Примерно через полтора месяца после поглощения ZT Systems корпорация AMD объявила о заключении соглашения по продаже полученных производственных активов компании Sanmina. По условиям договора, Sanmina становится приоритетным партнёром AMD по организации производства продуктов для облачных и кластерных ИИ-платформ. При этом AMD сохранит за собой команду ZT Systems, отвечающую за разработку и взаимодействие с клиентами. Предполагается, что всё это позволит укрепить экосистему ODM- и OEM-партнёров AMD. Компания Sanmina, головной офис которой находится в Сан-Хосе (Калифорния, США), насчитывает в общей сложности около 34 тыс. сотрудников в 21 стране по всему миру. По заявлениям AMD, компания является интегрированным поставщиком производственных услуг, обслуживает самые быстрорастущие сегменты глобального рынка электроники, а также предлагает комплексные решения по проектированию, производству и логистике для OEM-производителей в различных отраслях.

28.10.2025 [08:43], Сергей Карасёв

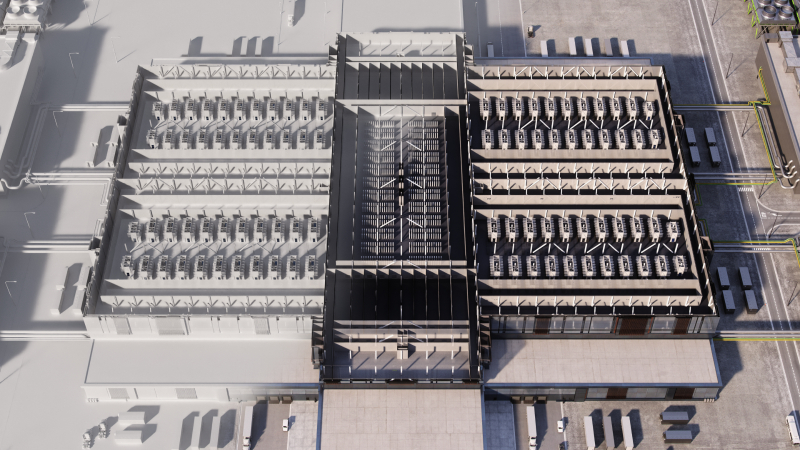

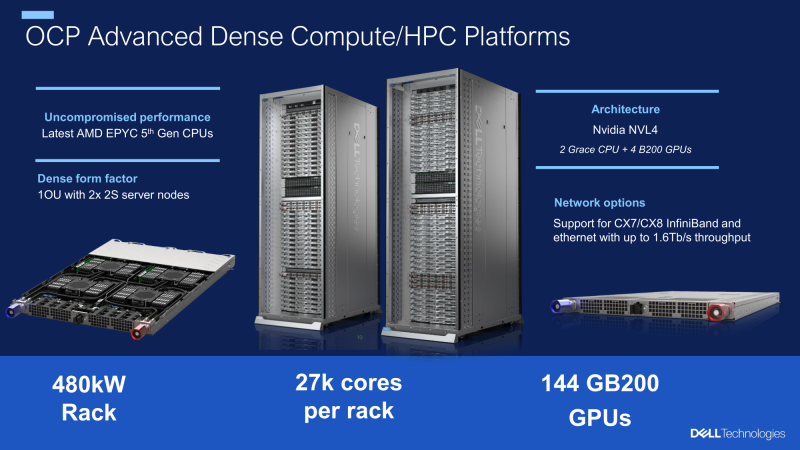

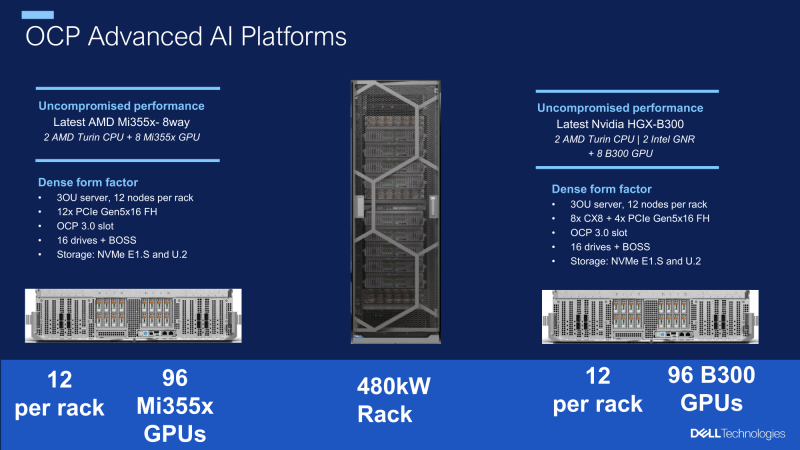

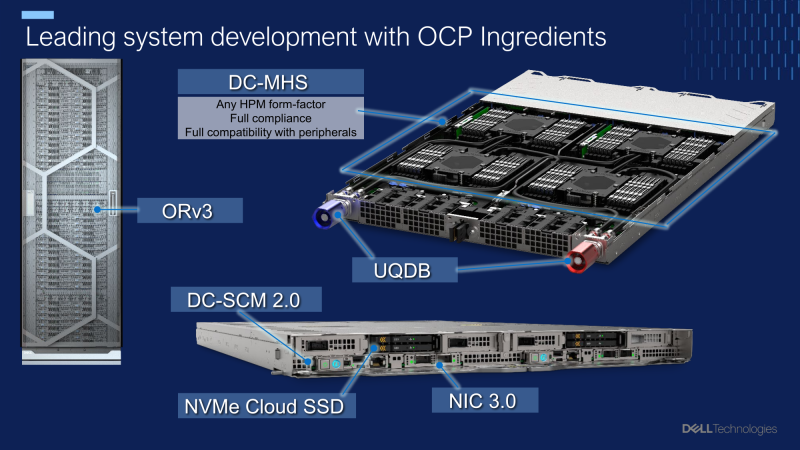

Dell разработала модульные OCP-стойки мощностью 480 кВт для ИИ-системКомпания Dell в ходе мероприятия 2025 OCP Global Summit рассказала о разработке передовых систем для ресурсоёмких нагрузок ИИ и HPC. Речь идёт, в частности, о полностью модульных архитектурах на базе открытых спецификаций, оптимизированных для жидкостного охлаждения. Ихаб Тарази (Ihab Tarazi), главный технический директор и старший вице-президент Dell Technologies, сообщил, что компания установила сотни тысяч GPU-ускорителей в кластерах, использующих оборудование на основе стандарта OCP ORv3. Благодаря достижениям в области водоблоков, термоинтерфейсов, блоков распределения охлаждающей жидкости (CDU) и быстроразъёмных коллекторов упрощается развёртывание масштабных ИИ-платформ, насчитывающих десятки тысяч GPU. Кроме того, Dell совместно с Национальной лабораторией имени Лоуренса в Беркли (LBNL) при Министерстве энергетики США (DoE) разработала модульную OCP-стойку мощностью 480 кВт с возможностью дальнейшего масштабирования до 1 МВт. Решение, ориентированное на экстремальные нагрузки ИИ, допускает установку высокопроизводительных серверов, насчитывающих в общей сложности до 27 тыс. CPU-ядер и до 144 ускорителей NVIDIA GB200. В перспективе также могут использоваться чипы AMD и NVIDIA следующего поколения, такие как Instinct MI450 и Vera Rubin. По словам Тарази, аналогичная архитектура стоек применяется в рамках суперкомпьютерной программы Техасского университета в Остине (UT Austin) и при развёртывании суверенных облаков. В целом, модульный подход обеспечивает возможность независимой модернизации вычислительных ресурсов, хранилищ и сетевых компонентов, сокращая время обновления инфраструктуры с нескольких лет до нескольких недель. Инновации в сфере СЖО повышают надёжность и удобство обслуживания платформ в рамках масштабных ИИ-кластеров.

27.10.2025 [22:50], Владимир Мироненко

Qualcomm анонсировала ИИ-ускорители AI200 и AI250 — прошлое поколение чипов популярным не стало, но компания обещала исправитьсяQualcomm Technologies представила решения нового поколения для ЦОД, оптимизированные для ИИ-инференса — стоечные суперускорители Qualcomm AI200 и AI250. После их анонса акции Qualcomm подскочили на 15 %, показав самый большой внутридневной рост за более чем шесть месяцев, сообщил Bloomberg. Ожидается, что новые решения станут новой точкой роста компании. Она демонстрировала уверенный рост прибыли в течение последних двух лет, но инвесторы отдавали предпочтение акциям других технологических компаний. Qualcomm AI200 — специализированное стоечное решение для ИИ-инференса, обеспечивающее низкую совокупную стоимость владения (TCO). Платформа оптимизирована для инференса больших языковых и мультимодальных моделей (LLM, LMM) и других ИИ-нагрузок. AI200 включает карты с 768 Гбайт LPDDR. Чип основан на NPU Hexagon, которые используются в последних поколениях Snapdragon. Qualcomm AI250 получил инновационную архитектуру, построенную на принципах предельно близкого расположения быстрой памяти к вычислительным ядрам (Near-Memory Computing, NMC), что обеспечит качественно новый уровень эффективности и производительности ИИ-инференса. По словам Qualcomm, новая архитектура обеспечивает более чем десятикратный прирост эффективной пропускной способности памяти и значительное снижение энергопотребления. Это позволит проводить дезагрегированный ИИ-инференс для более эффективного использования оборудования. Оба продукта будут предлагаться отдельно и в составе стоек с полным жидкостным охлаждением, PCIe-коммутаторами для вертикального масштабирования и Ethernet — для горизонтального, а также поддержкой конфиденциальных вычислений. Энергопотребление стойки составит 160 кВт, что ставит новинки в один ряд с GB200 NVL72. Компания отметила, что её программный ИИ-стек гиперскейл-класса, охватывающий все этапы — от прикладного уровня до системного ПО — оптимизирован для ИИ-инференса. Стек поддерживает ведущие фреймворки машинного обучения, механизмы инференса, фреймворки генеративного ИИ и методы оптимизации инференса LLM/LMM, такие как дезагрегированное обслуживание. Обещаны бесшовный перенос моделей и развёртывание моделей платформы Hugging Face в один клик посредством библиотеки Efficient Transformers и пакета Qualcomm AI Inference Suite от Qualcomm. Qualcomm отметила, что её ПО предоставляет готовые к использованию приложения и ИИ-агенты, комплексные инструменты, библиотеки, API и сервисы. Прошлое поколение ускорителей CloudAI 100 не снискало успеха во многом из-за слабой программной экосистемы. От этого же страдала и AMD, которая ускоренными темпами навёрстывает упущенное. Qualcomm AI200 и AI250 поступят в продажу в 2026 и 2027 годах соответственно. Qualcomm также сообщила, что придерживается ежегодного плана развития направления ЦОД, ориентированного на достижение лидирующей в отрасли производительности ИИ-инференса, энергоэффективности и минимальной совокупной стоимости владения (TCO). Кроме того, компания решила вернуться на рынок серверных процессоров. Первым заказчиком анонсированных решений Qualcomm станет саудовский государственный ИИ-стартап Humain, который планирует развернуть 200 МВт ИИ ЦОД на базе новых чипов, начиная с 2026 года. Ранее было заключено соглашение с Cerebras, в рамках которого планировалось использовать для инференса именно чипы Qualcomm, в том числе в Саудовской Аравии. Ещё одним крупным игроком в ИИ-сделках здесь является Groq. Qualcomm запоздало пытается занять заметную долю рынка ИИ-оборудования. Компания считает, что новые решения в области памяти и энергоэффективности, основанные на технологиях для мобильных устройств, привлекут клиентов, несмотря на относительно поздний выход на рынок. Под руководством Криштиану Амона (Cristiano Amon) компания стремится диверсифицировать бизнес, больше не полагаясь на смартфоны, рост продаж которых замедлился. Qualcomm «занимала эту нишу, не торопясь и наращивая мощь», — заявил Дурга Маллади (Durga Malladi), старший вице-президент компании. По его словам, Qualcomm ведёт переговоры со всеми крупнейшими заказчиками о развёртывании стоек на базе своего оборудования.

27.10.2025 [16:36], Руслан Авдеев

Британские власти выделят Королевской почте £2 млн на поиск улик против самой себяМинистерство бизнеса и торговли (Department for Business and Trade, DBT) Великобритании заплатит Королевской почте (Roayl mail) до £2 млн (более $2,66 млн) за поиск информации в собственных архивах — чиновники ожидают порядка 1,5 тыс. исков, связанных с требованием компенсаций от пользователей неисправного почтового ПО Capture, сообщает Computer Weekly. Цель контракта — сбор доказательств, необходимых заявителям в рамках плана компенсации ущерба Capture Redress Scheme. Он реализуется в интересах бывших начальников почтовой службы нижнего звена, пострадавших из-за некорректной работы ПО Capture. В 1990-х годах система Capture внедрялась для замены бумажной бухгалтерии. Как и в случае с забагованным ПО Fujitsu Horizon, которое пришло на смену Capture, в результате ошибок в ПО сотрудники почтовых отделений были несправедливо обвинены в растратах. Некоторым сотрудникам «повезло» дважды — они пострадали и от Capture, и от Horizon. Согласно материалам тендера, получение данных осложняется тем, что с того времени прошло порядка 30 лет. Информация о потенциальных получателях компенсаций хранится только в базах почты, поэтому для обработки заявок от пострадавших министерству необходимо заключить с ней договор, чтобы запрашивать и получать необходимые данные. Контракт заключат на пять лет, но его действие может быть прекращено, если все претензии обработают раньше. Скандал вокруг системы Capture разгорелся в начале 2024 года после широкой огласки проблем в системе Horizon. К декабрю того же года правительство пообещало финансовые компенсации и пострадавшим от Capture. В настоящее время Комиссия по пересмотру уголовных дел (Criminal Cases Review Commission) рассматривает 30 случаев, в которых обвинительные приговоры, вероятно, были вынесены на основании некорректных данных. Одна жалоба уже передана в Апелляционный суд Великобритании. По словам адвокатов пострадавших от сбоев, найти связанные с Capture улики и доказательства сложно после стольких лет. В Hudgell Solicitors «практически уверены, что установили, что в Capture могли быть ошибки, сбои и дефекты». Теперь нужно доказать, что пострадавшие действительно пользовались Capture. Для этого чрезвычайно важно, чтобы почта предоставила имеющуюся у неё информацию, а при отсутствии доказательств предпочтение должно отдаваться показаниям подзащитных, а не данным сбойной системы. Стоит отметить, что ущерб может составить миллионы фунтов. Так, от Fujitsu потребовали выплатить £300 млн пострадавшим от ПО Horizon. Почта и Fujitsu пытаются переложить ответственность друг на друга. |

|