Материалы по тегу: схд

|

18.12.2025 [09:25], Сергей Карасёв

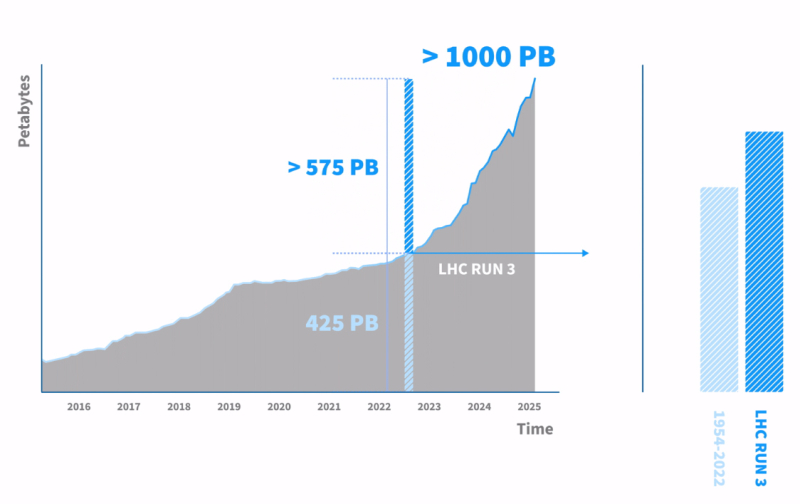

CERN накопила экзабайт данных от Большого адронного коллайдераЕвропейская организация по ядерным исследованиям (CERN) сообщила о том, что в её системе хранения данных накоплен 1 Эбайт (1 млн Тбайт) экспериментальной информации, поступившей от Большого адронного коллайдера (БАК) — крупнейшего в мире ускорителя частиц протяжённостью около 27 км, расположенного под землёй на границе Швейцарии и Франции. БАК каждую секунду сталкивает миллиарды протонов, в результате чего генерируются колоссальные потоки информации. Для её предварительной обработки используется высокоселективная система фильтрации (так называемый триггер), которая отсеивает львиную долю данных, собранных детекторами. Оставшаяся часть сведений, представляющих наибольшую ценность, поступает в хранилище CERN для последующего анализа. «Мы достигли рубежа в 1 Эбайт, что является важной вехой проекта, но на этом всё не заканчивается. Это всего лишь 10 % от того, что нам предстоит хранить и обрабатывать в последующие 10 лет», — говорит Якуб Мосцицки (Jakub Mościcki), руководитель группы хранения и управления данными в CERN. Накопление научных сведений имеет огромное значение для проекта БАК, поскольку анализ может проводиться спустя долгое время после сбора показателей — иногда через десятилетия после проведения экспериментов. Основная часть информации записывается на магнитные ленты, что обусловлено экономичностью, безопасностью и надёжностью накопителей этого типа. Для хранения 1 Эбайт данных задействованы около 60 тыс. ленточных картриджей. В настоящее время в CERN ведутся работы по модернизации Большого адронного коллайдера для использования в режиме высокой светимости (High Luminosity LHC). Такие эксперименты планируется начать в середине 2030 года: при этом ускоритель будет генерировать в 10 раз больше информации, чем в текущем виде. Соответственно на порядок возрастёт нагрузка на СХД.

15.12.2025 [17:15], Владимир Мироненко

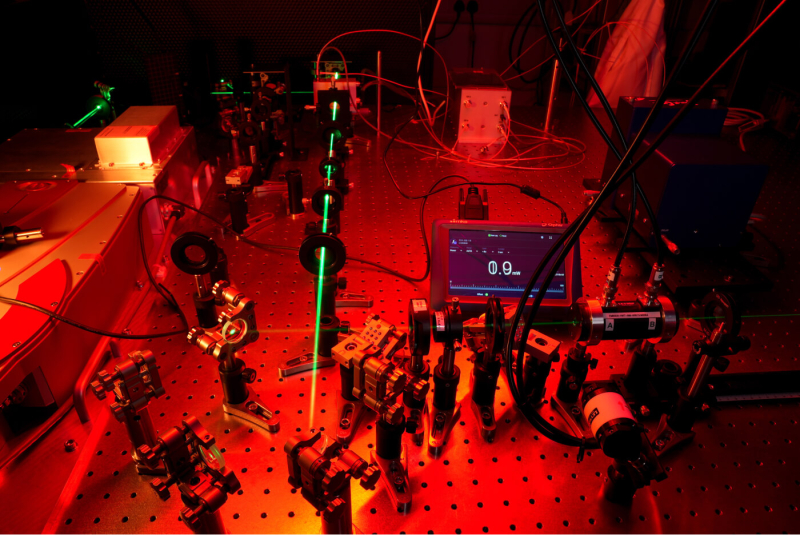

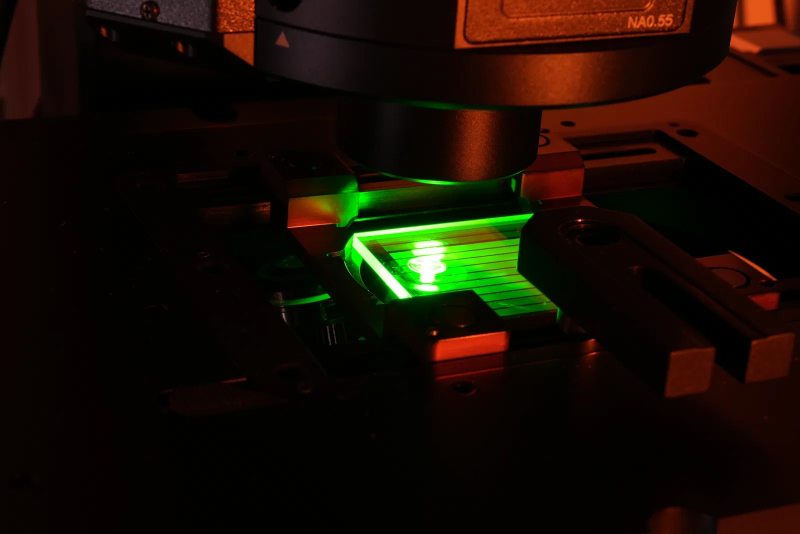

Кварцевые воксели SPhotonix позволят хранить данные миллиарды летСтартап SPhotonix из Делавэра (США), основанный в прошлом году Питером Казанским (Peter Kazansky), профессором оптоэлектроники в Университете Саутгемптона, и его сыном Ильёй (Ilya Kazansky), планирует в течение ближайших двух лет вывести на коммерческий уровень технологию 5D Memory Crystal, позволяющую хранить данные миллиарды лет. Об этом Казанский рассказал ресурсу The Register. Для хранения информации стартап предлагает использовать пластину из кварцевого стекла, данные на которой записываются с помощью крошечных вокселей — 3D-пикселей — вытравленных фемтосекундным лазером. Эти воксели обладают двулучепреломлением, то есть их характеристики преломления света изменяются в зависимости от поляризации и направления падающего света. Эта разница в ориентации и интенсивности света может быть считана в сочетании с пространственными координатами вокселя (x, y, z), что позволяет кодировать данные в пяти измерениях. 5″ стеклянная пластина может вмещать 360 Тбайт данных, обеспечивая их хранение даже при температуре 190 °С в течение 13,8 млрд лет, что соответствует предполагаемому возрасту Вселенной, если не произойдёт каких-либо катастроф, рассказал Казанский. Он отметил, что данный носитель, в первую очередь предназначен для «холодного» хранения данных, то есть данных, которые извлекаются в течение 10 и более секунд. «Статистика показывает, что от 60 до 80 % всех данных, которые в настоящее время хранятся в мире, относятся к категории “холодных”», — говорит Казанский. Существующие прототипы нового носителя информации поддерживают скорость записи около 4 Мбайт/с и скорости чтения примерно 30 Мбайт/с. По словам профессора, SPhotonix планирует в течение трёх-четырёх лет повысить скорость чтения/записи до 500 Мбайт/с, что позволит конкурировать с системами резервного копирования на ленточные носители. SPhotonix уже продемонстрировала, что носитель 5D Memory Crystal может хранить геном человека, капсулу времени Eon Ark, архив записанных разговоров 2024 и 2025 годов и игру Heroes of Might & Magic 3. Данная услуга архивирования уже доступна для бизнеса, однако для извлечения данных требуется оборудование лаборатории компании. SPhotonix планирует в течение следующих 18 месяцев выпустить портативное устройство для чтения, которое клиенты смогут использовать для чтения архивных данных. Первоначальная стоимость устройства для чтения может составить около $6 тыс., а первоначальная стоимость устройства для записи — примерно $30 тыс. Стартап сосредоточен на работе в корпоративном сегменте, ориентируясь на ЦОД гиперскейлеров и рынок B2B-приложений, требующем хранение огромных объёмов данных в течение длительного времени. В прошлом месяце SPhotonix, имеющий исследовательские центры в Великобритании и Швейцарии, объявил о привлечении $4,5 млн на развитие своей технологии для внедрения в ЦОД. По словам Казанского, эти средства позволят вывести технологию 5D Memory Crystal с уровня технологической готовности (TRL) 5 на уровень демонстрации прототипа (TRL 6). «Мы ведём переговоры со многими крупными компаниями о размещении наших прототипов в их ЦОД в течение следующих нескольких лет», — сообщил он. Компании потребуется ещё три-четыре года исследований и разработок, чтобы довести прототип до стадии производства и маркетинга, хотя благодаря последним исследованиям и открытиям уже есть чёткое понимание того, как перейти к производству, как достичь нужного уровня экономичности, говорит глава SPhotonix. Он отметил, что у SPhotonix нет планов по запуску собственного производства. «Мы — компания по лицензированию технологий. Нам нравится модель Arm Holdings. И в определённой степени нам нравится модель NVIDIA. Поэтому мы разрабатываем вспомогательные технологии, а затем собираемся сформировать своего рода консорциум, группу компаний, которые помогут нам вывести эту технологию на рынок», — рассказал Казанский.

13.12.2025 [14:31], Сергей Карасёв

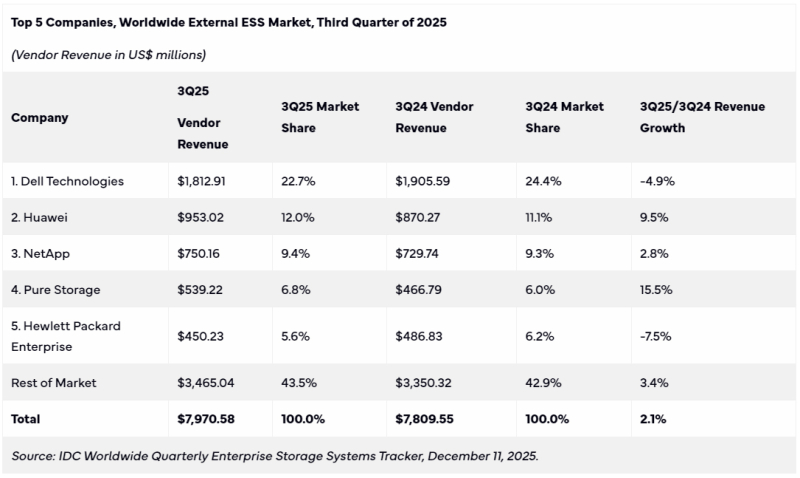

Мировой рынок СХД вырос благодаря спросу на массивы All-Flash, а выиграли от этого Pure Storage, Huawei и NetAppПо данным International Data Corporation (IDC), продажи систем хранения данных (СХД) корпоративного класса в мировом масштабе достигли $7,97 млрд по итогам III квартала текущего года. Это на 2,1 % больше по сравнению с тем же периодом 2024-го, когда объём рынка оценивался в $7,81 млрд. Наибольший рост выручки год к году показали Pure Storage (+15,5 %), Huawei (+9,5 %) и NetApp (+2,8 %), а Dell Technologies (-4,9 %) и HPE (-7,5 %) показали падение Положительная динамика показана благодаря поставкам массивов All-Flash: их продажи в годовом исчислении увеличились в деньгах на 17,6 %. Связано это с растущим спросом на высокопроизводительные системы, ориентированные на ресурсоёмкие задачи в области ИИ. Вместе с тем спрос на гибридные СХД и на решения на базе HDD уменьшился по отношению к III четверти 2024 года на 9,8 % и 6,3 % соответственно. В ценовом разрезе доминируют системы среднего класса стоимостью от $25 тыс. до $250 тыс. На такие продукты пришлось 67,5 % продаж, а их поставки увеличились год к году на 8,1 % в денежном исчислении. С другой стороны, спрос на СХД верхнего ценового диапазона (дороже $250 тыс.) снизился на 9,0 %, тогда как продажи изделий начального уровня (дешевле $25 тыс.) упали на 8,0 %. С географической точки зрения самый высокий рост отмечен в Японии, Канаде и регионе EMEA (Европа, Ближний Восток и Африка) — на 14,4 %, 12,6 % и 10,5 % соответственно. В Китае продажи поднялись на 9,5 % по отношению к III кварталу прошлого года, в Азиатско-Тихоокеанском регионе (без учёта КНР и Японии) — на 8,6 %. В Латинской Америке произошло снижение на 0,9 %, тогда как в США рынок сократился на 9,9 %. Лидером сектора является Dell Technologies с выручкой в размере $1,81 млрд и долей в 22,7 %. На втором месте располагается Huawei с $953,02 млн и 12,0 %, а замыкает тройку NetApp с $750,16 млн и 9,4%. Четвёртая строка в рейтинге досталась Pure Storage, продажи которой составили $539,22 млн, рыночная доля — 6,8 %. На пятой позиции находится НРЕ с $450,23 млн и 5,6 %. Все прочие отраслевые игроки вместе взятые получили $3,47 млрд, заняв 43,5 %.

10.12.2025 [10:10], Владимир Мироненко

Иркутский аэропорт выбрал для модернизации СХД TATLIN.FLEX.PROВ Международном аэропорту Иркутска завершили внедрение системы хранения данных TATLIN.FLEX.PRO от компании YADRO, выполненной в рамках модернизации инфраструктуры видеонаблюдения и видеоаналитики предприятия. Сообщается, что перед заказчиком стояла задача выполнить модернизацию ИТ-инфраструктуры для обработки и хранения видеоданных в условиях высокой нагрузки и требований к отказоустойчивости. Новое решение должно было обеспечить стабильную работу и хранение больших объёмов данных — 1,68 Пбайт на данный момент и до 4 Пбайт в ближайшей перспективе. После проведения детального анализа рынка заказчик выбрал платформу TATLIN.FLEX.PRO — компактное гибридное решение, разработанное для задач локального хранения и максимально адаптированное под нужды российских заказчиков. При его выборе заказчик руководствовался такими ключевыми критериями, как надёжность платформы, техническая поддержка 24/7, возможность кеширования и масштабирования, а также совместимость с имеющимся программным обеспечением и наличие в реестре российской промышленной продукции Минпромторга России. Гибридная СХД TATLIN.FLEX.PRO обеспечивает высокую гибкость конфигурирования благодаря возможности одновременного использования накопителей разных типов, а также совместима с виртуальными средами, операционными системами и инфраструктурным ПО. Также получили высокую оценку заказчиком преимущества круглосуточной технической поддержки, которая предоставляется для системы. «Решение о внедрении было принято с учётом совокупности факторов, включая технические характеристики продукта, условия сопровождения и опыт его эксплуатации на рынке. Существенную роль сыграли успешные примеры применения решения у крупных компаний в разных отраслях. Для нас было важно, что за продуктом стоит надёжный вендор с собственным производством и технической экспертизой», — отметил заместитель генерального директора по информационным технологиям АО «Международный Аэропорт Иркутск» Артем Захлебный. СХД TATLIN.FLEX.PRO позволила полностью обеспечить текущие потребности аэропорта, а также возможности для дальнейшего роста. Ближайшие планы включают масштабирование системы с учётом растущего объёма видеоданных и расширения задач аналитики. Как сообщил Сергей Воинцев, ведущий менеджер продукта компании YADRO, обновлённая версия TATLIN.FLEX.PRO создавалась в тесном взаимодействии с заказчиками. Были учтены все ключевые пожелания — от увеличения объёма накопителей до расширения функциональности системы, чтобы сделать её ещё более эффективной в сценариях, связанных с аналитикой и критичной инфраструктурой.

09.12.2025 [10:10], Владимир Мироненко

YADRO начала приём заказов на первую отечественную All-NVMe СХД TATLIN.AFAКомпания YADRO (входит в «ИКС Холдинг») объявила о старте приёма заказов на серийное производство первой в России All-NVMe СХД TATLIN.AFA, созданной для решения задач крупных корпоративных клиентов с максимальными требованиями к скорости обработки больших массивов данных. Новое решение YADRO уже внесено в Единый реестр российской радиоэлектронной продукции Минпромторга. Флагманская СХД TATLIN.AFA компании YADRO отличается рекордной производительностью и максимальной отказоустойчивостью, позволяя решать наиболее сложные задачи корпоративного уровня и обеспечивая работу с высоконагруженными критически важными приложениями, требующими непрерывной доступности и мгновенного отклика. Система поддерживает хранение и обработку сотен терабайт аналитических данных, а также подходит для задач машинного обучения и ИИ. Благодаря высокой вычислительной производительности СХД уверенно справляется с пиковыми рабочими нагрузками, обеспечивая до 2 млн IOPS и пропускную способность до 50 Гбайт/с. В основу решения положена модульная платформа YADRO TATLIN.X, обеспечивающая гибкое масштабирование, объединяя два контроллера хранения и 24 NVMe-накопителя в 2U форм-факторе. Собственная аппаратная платформа YADRO гарантирует максимальный уровень надежности и отказоустойчивости. В ней сочетаются проверенные временем технологии защиты, такие как режим работы контроллеров Symmetric Active-Active, в TATLIN.AFA с новыми решениями — дублированием аккумуляторных батарей, резервированием системных накопителей в контроллерах и поддержкой адаптеров ввода-вывода в форм-факторе OCP3. Программная часть TATLIN.AFA основана на TATLIN.OS, получившей обновление специально для нового поколения СХД. В частности, обновлённая версия T-RAID поддерживает схемы защиты до 14+2, обеспечивая высокую полезную ёмкость и надёжную работу. Егор Литвинов, директор продуктового направления TATLIN YADRO отметил, что TATLIN.AFA выводит отечественные решения в области СХД на принципиально новый уровень. Отвечая самым строгим требованиям сегодняшнего дня, система закладывает основу для масштабируемого развития наиболее требовательной ИТ-инфраструктуры в стратегически важных отраслях. Он добавил, что после запуска серийного производства компания будет последовательно развивать программные возможности флагманской СХД, чтобы максимально реализовать её преимущества для корпоративных заказчиков. Согласно утверждённой программе дальнейшего развития TATLIN.AFA, компания планирует расширение функциональности СХД, включая внедрение технологии компрессии данных, увеличение ёмкости хранения за счет добавления интеллектуальных дисковых модулей расширения с NVMe-накопителями, поддержку нового высокоскоростного протокола доступа NVMe/RoCE, а также реализацию асинхронной репликации внутри линейки систем TATLIN под управлением TATLIN.OS. Ознакомиться с техническими характеристиками новой СХД можно на официальном сайте YADRO.

08.12.2025 [10:02], Сергей Карасёв

DDN анонсировала «прорывные» хранилища данных для ИИ — из разномастных SSD и HDDКомпания DataDirect Networks (DDN) анонсировала, как утверждается, «прорывную» архитектуру хранения данных, ориентированную на системы для ресурсоёмких задач ИИ. По сравнению с другими платформами предложенное решение обеспечивает возможность существенного снижения финансовых затрат при высоком уровне производительности. DDN отмечает, что стремительное развитие ИИ приводит к повышению спроса на SSD, что, в свою очередь, провоцирует рост цен на чипы флеш-памяти NAND, а следовательно, и на твердотельные накопители. Аналитики TrendForce прогнозируют увеличение контрактных цен на изделия NAND на 5–10% только в IV квартале 2025 года. Волатильность цен на SSD и HDD нарушает сроки реализации проектов, создаёт неопределённости при планировании бюджета и ставит под угрозу развитие масштабных ИИ-платформ. DDN заявляет, что её архитектура данных помогает решить проблему. Обычные СХД, ориентированные на требовательные ИИ-нагрузки, как подчёркивает DDN, полагаются исключительно на дорогие высокопроизводительные NVMe-накопители. Архитектура DDN предполагает сочетание трёх уровней хранения — на базе SSD высокого класса, недорогих SSD и HDD. Такой подход реализован в платформах DDN EXA и Infinia. Отмечается, что предложенная архитектура позволяет задействовать ресурсы GPU-ускорителей на 90–98 % при выполнении задач, связанных с обучением больших языковых моделей (LLM), инференсом, аналитикой больших данных и НРС. При этом потребность в дорогостоящих высокопроизводительных SSD (NVMe) снижается на 35–65 %, общие капитальные затраты на организацию хранения сокращаются на 40–70 %, а эксплуатационные расходы уменьшаются на 30–60 %. Заявлена глубокая оптимизация для NVIDIA DGX, GB200, Spectrum-X, BlueField и NIM. Среди сфер применения архитектуры названы финансовый сектор, автомобилестроение и робототехника, науки о жизни, производство, государственный сегмент и суверенный ИИ.

02.12.2025 [09:39], Владимир Мироненко

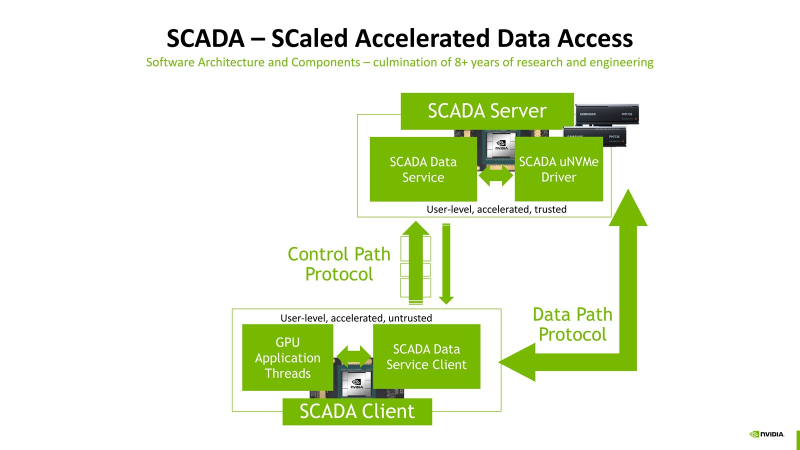

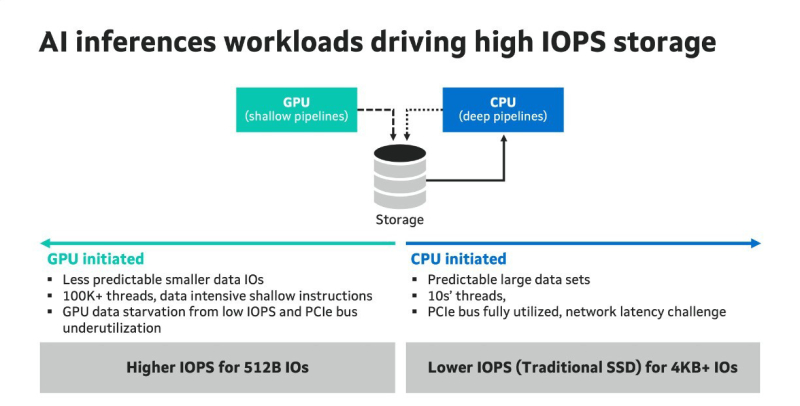

Миллионы IOPS, без посредников: NVIDIA SCADA позволит GPU напрямую брать данные у SSDNVIDIA разрабатывает SCADA (Scaled Accelerated Data Access, масштабируемый ускоренный доступ к данным) — новую IO-архитектуру, где GPU инициируют и управляют процессом работы с хранилищами, сообщил Blocks & Files. SCADA отличается от существующего протокола NVIDIA GPUDirect, который, упрощённо говоря, позволяет ускорить обмен данными с накопителями, напрямую связывая посредством RDMA память ускорителей и NVMe SSD. В этой схеме CPU хоть и не отвечает за саму передачу данных, но оркестрация процесса всё равно ложится на его плечи. SCADA же предлагает перенести на GPU и её. Обучение ИИ-моделей обычно требует передачи больших объёмов данных за сравнительно небольшой промежуток времени. При ИИ-инференсе осуществляется передача небольших IO-блоков (менее 4 Кбайт) во множестве потоков, а время на управление каждой передачей относительно велико. Исследование NVIDIA показало, что инициирование таких передач самим GPU сокращает время и ускоряет инференс. В результате была разработана схема SCADA. NVIDIA уже сотрудничает с партнёрами по экосистеме хранения данных с целью внедрения SCADA. Так, Marvell отмечает: «Потребность в ИИ-инфраструктуре побуждает компании, занимающиеся СХД, разрабатывать SSD, контроллеры, NAND-накопители и др. технологии, оптимизированные для поддержки GPU, с акцентом на более высокий показатель IOPS для ИИ-инференса. Это будет принципиально отличаться от технологий для накопителей, подключенных к CPU, где главными приоритетами являются задержка и ёмкость». По словам Marvell, в рамках SCADA ускорители используют семантику памяти при работе с накопителями. Однако сами SSD мало подходят для таких задач, поскольку не могут обеспечить необходимый уровень IOPS, когда во время инференса тысячи параллельных потоков запрашивают наборы данных размером менее 4 Кбайт. Это приводит к недоиспользованию шины PCIe, «голоданию» GPU и пустой трате циклов. В CPU-центричной архитектуре, которая подходит для обучения моделей, параллельных потоков данных десятки, а не тысячи, а блоки данных крупные — от SSD требуется высокие ёмкость и пропускная способность, а также малая задержка, поскольку свою задержку в рамках СХД также внесут PCIe и Ethernet. Внедрение PCIe 6.0 и PCIe 7.0, конечно, само по себе ускорит обмен данными, но контроллеры SSD также нуждаются в обновлении. Они должны уметь использовать возможности SCADA, иметь оптимальные схемы коррекции ошибок для малых блоков данных и быть мультипротокольными (PCIe, CXL, Ethernet). Компания Micron также участвует в разработке SCADA. В рамках SC25 Micron показала прототип SCADA-хранилища на базе платформы H3 Platform Falcon 6048 с PCIe 6.0 (44 × E1.S NVMe SSD + 6 × GPU/DPU/NIC), оснащённой 44 накопителями Micron 9650 (7,68 Тбайт, до 5,4 млн на случайном чтении 4K-блоками с глубиной очереди 512, PCIe 6.0), тремя коммутаторами Broadcom PEX90000 (144 линии PCIe 6.0 в каждом), одним процессором Intel Xeon (PCIe 5.0) и тремя ускорителями NVIDIA H100 (PCIe 5.0). Micron заявила, что система «демонстрирует линейное масштабирование производительности от 1 до 44 SSD», доходя до 230 млн IOPS, что довольно близко к теоретическому максимуму в 237,6 млн IOPS. «В сочетании с PCIe 6.0 и высокопроизводительными SSD архитектура [SCADA] обеспечивает доступ к данным в режиме реального времени для таких рабочих нагрузок, как векторные базы данных, графовые нейронные сети и крупномасштабные конвейеры инференса», — подытожила Micron.

27.11.2025 [12:16], Сергей Карасёв

Celestica выпустила JBOD-массив SD6300 на 108 накопителей для ИИ-платформКомпания Celestica анонсировала JBOD-массив SD6300 высокой плотности, ориентированный на инфраструктуры гиперскейлеров, платформы ИИ и пр. Новинка может применяться для формирования озер данных, объектных хранилищ, долгосрочного (холодного) хранения и архивирования информации. Устройство выполнено в форм-факторе 4U. Допускается установка до 108 двухпортовых накопителей стандартов LFF/SFF в конфигурации 104 × SAS-3 и 4 × SAS-4. Таким образом, могут монтировать как традиционные HDD, так и высокопроизводительные SSD. Это обеспечивает более высокую общую производительность на операциях чтения и записи, что важно при решении задач, которым требуется интенсивный обмен данными.

Источник изображения: Celestica JBOD-массив SD6300 имеет глубину 1125 мм (включая систему управления кабелями), что, как утверждает Celestica, позволяет максимально эффективно использовать имеющееся пространство в дата-центрах. Отмечается, что на сегодняшний день новинка является наиболее компактным решением в своём классе с поддержкой до 108 накопителей. Устройство располагает четырьмя интерфейсами mini-SAS HD. За охлаждение отвечают двухроторные вентиляторные блоки с резервированием. Установлены два блока питания неназванной мощности. Среди ключевых преимуществ продукта названы высокая плотность хранения в расчёте на стойку, сокращение капитальных и эксплуатационных расходов благодаря максимально эффективному использованию площади ЦОД, гибкость применения (подходит для широкого спектра задач) и удобство интеграции в IT-инфраструктуру.

24.11.2025 [09:09], Сергей Карасёв

IBM утроила вместимость СХД Storage Scale System 6000 — до 47 Пбайт на стойкуКорпорация IBM объявила о выпуске обновлённой СХД Storage Scale System 6000, предназначенной для работы с ресурсоёмкими ИИ-приложениями, а также с нагрузками, которым требуется интенсивный обмен большими объёмами информации. Платформа Storage Scale System 6000 дебютировала в конце 2024 года. Устройство типоразмера 4U оснащено двумя контроллерами, работающими в режиме «активный — активный». Применяются процессоры AMD EPYC Genoa 7642 (48C/96T; 2,3–3,3 ГГц; 225 Вт) или EPYC Embedded 9454 (48C/96T; 2,75–3,8 ГГц; 290 Вт), а максимальный объём оперативной памяти в расчёте на систему составляет 3072 Гбайт. Допускается установка 48 NVMe-накопителей. Также поддерживаются фирменные FCM-модули со сжатием на лету. Вместимость оригинальной версии достигала 2,2 Пбайт (при использовании комбинации SSD на 30 и 60 Тбайт). При подключении девяти дополнительных JBOD-массивов показатель вырастал до 15 Пбайт. Заявленная производительность — до 13 млн IOPS. Пропускная способность при чтении — до 330 Гбайт/с, при записи — до 155 Гбайт/с.

Источник изображения: IBM В случае обновлённой модификации Storage Scale System 6000 реализована поддержка QLC-накопителей вместимостью до 122 Тбайт. Кроме того, представлены новые модули расширения All-Flash Expansion Enclosure стандарта 2U, рассчитанные на 26 двухпортовых накопителей QLC. В результате, общая ёмкость СХД в конфигурации в виде стойки 42U достигает 47 Пбайт, что примерно втрое больше по сравнению с оригинальным вариантом. При этом быстродействие поднялось до 28 млн IOPS, а пропускная способность в режиме чтения — до 340 Гбайт/с. В состав All-Flash Expansion Enclosure входят DPU NVIDIA BlueField-3 (до 4 шт.). Каждый модуль расширения может обеспечить пропускную способность до 100 Гбайт/с. Решение оптимизировано для обучения больших языковых моделей, инференса, НРС-задач и пр. В продажу изделие поступит в декабре; тогда же станет доступно улучшенное ПО для СХД — IBM Storage Scale System 7.0.0.

19.11.2025 [23:59], Владимир Мироненко

Скандал в NetApp: бывший техдиректор продал разработки конкуренту и скрылся в ИсландииNetApp подала в суд на своего бывшего старшего вице-президента и технического директора Йона Торгримура Стефанссона (Jón Thorgrímur Stefánsson), обвинив его в том, что он, работая в компании и продолжая получать зарплату, тайно развивал конкурирующий бизнес, который продал прямому конкуренту за неназванную сумму всего через несколько недель после того, как покинул NetAPP. Об этом сообщил The Register. В иске, поданном NetApp 6 ноября в Окружной суд США по Среднему округу Флориды, утверждается, что Стефанссон в последние месяцы работы в компании занимался кражей интеллектуальной собственности, пытался вербовать своих коллег, а в конечном итоге обманул NetApp, присвоив её разработки, чтобы продать VAST Data свой стартап в сентябре 2025 года. Благодаря своей позиции он имел «широкий доступ» к конфиденциальным материалам компании, от фирменных инноваций до стратегических деловых отношений. Стефанссон проработал в NetApp восемь лет. Согласно иску, он «принимал непосредственное участие в разработке и интеграции облачных продуктов хранения NetApp с основными гиперскейлерами», такими как AWS, Google Cloud и Microsoft Azure, и отвечал за весь облачный портфель продуктов компании. Как и все сотрудники, имеющие доступ к конфиденциальной информации, Стефанссон подписал с NetApp «Соглашение о конфиденциальной информации, изобретениях и неразглашении» (PIIA), которое запрещает раскрытие или ненадлежащее использование конфиденциальной и служебной информации NetApp во время и после окончания трудовых отношений. В рамках соглашения Стефанссон обязался не участвовать в конфликтующих коммерческих проектах, не переманивать сотрудников или партнёров NetApp в течение как минимум года после увольнения, не рекламировать свои изобретения сотрудникам и деловым партнерам NetApp, а также передать NetApp все изобретения, разработанные им во время работы на компанию. Соглашение также обязывает подписавшего уведомлять о любых изобретениях, созданных в течение шести месяцев после окончания трудовых отношений. В иске утверждается, что каждое из этих обязательств было нарушено. Стефанссон покинул NetApp 27 июня и в течение недели создал новую компанию Red Stapler, которая была официально зарегистрирована 3 июля 2025 года. Компания работала в скрытом режиме. Стефанссон занял пост гендиректора, к нему присоединились пять бывших сотрудников и один действующий сотрудник NetApp — Эйрикур Свейнн Храфнссон (Eiríkur Sveinn Hrafnsson), который покинул NetApp лишь 31 августа 2025 года и стал вторым по величине акционером Red Stapler. А уже 9 сентября, VAST Data, один из прямых конкурентов NetApp, приобрела стартап и назначила Стефанссона генеральным директором по облачным решениям. По словам VAST Data, решения Red Stapler позволят её продуктам «легко интегрироваться в публичные облачные среды». NetApp «не верит, что Red Stapler разработала собственную облачную платформу управления и доставки данных менее чем за десять недель» с момента основания, и утверждает, что приобретённые VAST продукты фактически были её собственными технологиями. Компания сообщила, что потратила годы и десятки миллионов долларов на разработку своего Service Delivery Engine — слоя оркестрации, связывающего облака гиперскейлеров и хранилища NetApp. SDE позволяет конечным пользователям управлять всеми элементами своего хранилища данных из отдельного интерфейса, интегрируясь с любой публичной облачной платформой, пишет Forbes. Ровно это, по мнению NetApp, и предоставляет решение Red Stapler. Даже если предположить, что Стефанссон и его команда каким-то образом самостоятельно разработали технологию Red Stapler в кратчайшие сроки, соглашение PIIA всё равно требовало от него уведомить NetApp об изобретении, но он этого не сделал. В судебных документах NetApp приведены доказательства её обвинений. Во-первых, приводится текстовое сообщение бывшего сотрудника NetApp, ныне входящего в совет директоров VAST, указывающее на то, что Стефанссон согласился присоединиться к VAST в январе 2025 года, за несколько месяцев до своего ухода. Во-вторых, компания обнаружила переписку в Slack, где Стефанссон обсуждал переманивание сотрудников NetApp перед своим уходом. В частности, Стефанссон якобы спрашивал Храфнссона, есть ли у него «данные о зарплатах всех», кого они хотели бы нанять в Red Stapler. В-третьих, компания указывает на учётную запись redstapler-is на GitHub, которая, была создана не позднее 16 июня 2025 года, т.е. за 11 дней до официального ухода Стефанссона из NetApp. Это, как утверждает NetApp, свидетельствует о том, что проектирование и разработка велись, когда Стефанссон всё ещё работал в NetApp. По словам NetApp, в совокупности эти документы показывают, что Стефанссон «разрабатывал технологии и/или исходный код, а также занимался инновациями от имени другой организации», работая в компании. Когда NetApp узнала о сделке VAST в конце октября, она направила Стефанссону письменное предупреждение о нарушении прав интеллектуальной собственности (cease-and-desist letter), в котором подчёркивалось прямое дублирование его работы в NetApp и позиции гендиректора по облачным решениям VAST. В письме также подчёркивалась невозможность разработки платформы Red Stapler без использования конфиденциальной информации NetApp в столь короткие сроки. Стефанссон не ответил на письмо, после чего NetApp отправила ему второе послание, которое тоже осталось без ответа. Более того, через несколько дней после первого письма Стефанссон выставил свой дом в Орландо (Orlando) на продажу и затем покинул США, переехав, по всей видимости, в Исландию. После этого NetApp обратилась в суд, который вынес временный судебный запрет Стефанссону использовать материалы, являющиеся собственностью NetApp, участвовать в любой работе, связанной с продуктами или ПО, разработанными им в период работы в Исландии, привлекать деловых партнёров NetApp, а также уничтожать или распоряжаться документами, имеющими отношение к делу. Срок действия временного запрета истекает 26 ноября. NetApp заявила, что намерена добиваться бессрочного судебного запрета, остающегося в силе до конца судебного разбирательства. Следует также отметить, что VAST не упоминается в иске и не обвиняется NetApp в каких-либо правонарушениях. Пока речь идёт лишь о предполагаемых действиях покинувшего компанию ключевого руководителя, который случайно оказался в VAST Data, чтобы помочь в разработке конкурирующего продукта. |

|