Материалы по тегу: суперкомпьютер

|

05.04.2025 [10:36], Сергей Карасёв

Европейский суперкомпьютер Discoverer получил обновление в виде NVIDIA DGX H200Европейское совместное предприятие по развитию высокопроизводительных вычислений (EuroHPC JU) объявило о модернизации суперкомпьютера Discoverer, установленного в Софийском технологическом парке в Болгарии. Обновленная НРС-система получила название Discoverer+. Комплекс Discoverer, построенный на платформе BullSequana XH2000, был введён в эксплуатацию в 2021 году. Изначальная конфигурация включала 1128 вычислительных узлов, каждый из которых содержит два 64-ядерных процессора AMD EPYC 7H12 поколения Rome. Производительность (FP64) достигала 4,52 Пфлопс с пиковым значением в 5,94 Пфлопс. С такими показателями система находится на 221-й позиции в ноябрьском рейтинге мощнейших суперкомпьютеров мира TOP500. В рамках модернизации добавлен GPU-раздел на основе четырёх модулей NVIDIA DGX H200. Каждый из них содержит восемь ускорителей H200 и два процессора Intel Xeon Platinum 8480C поколения Sapphire Rapids с 56 ядрами (до 3,8 ГГц). Модули обладают быстродействием до 32 Пфлопс каждый в режиме FP8. Кроме того, обновлённый комплекс получил Lustre-хранилище вместимостью 5,1 Пбайт, систему хранения Weka ёмкостью 273 Тбайт и дополнительную ИБП-систему.

Источник изображения: EuroHPC JU Как отмечается, Discoverer стал первым суперкомпьютером EuroHPC, прошедшим серьёзную модернизацию с момента своего первоначального запуска. После наращивания мощностей комплекс планируется использовать для крупномасштабных проектов в области ИИ, таких как обучение нейронных сетей, создание цифровых двойников сложных объектов и пр. В декабре 2024 года консорциум EuroHPC выбрал площадки для первых европейских ИИ-фабрик (AI Factory): они расположатся в Финляндии, Германии, Греции, Италии, Люксембурге, Испании и Швеции. Кроме того, такие объекты планируется создать в Австрии, Болгарии, Франции, Германии, Польше и Словении. Эти площадки станут частью высококонкурентной и инновационной экосистемы ИИ в Европе.

23.03.2025 [14:08], Сергей Карасёв

Итальянский суперкомпьютер Leonardo будет интегрирован с квантовым компьютером IQM Radiance на 54 кубитаИтальянский суперкомпьютерный центр Cineca объявил о заключении соглашения с компанией IQM Quantum Computers на поставку самого мощного в стране квантового вычислительного комплекса. Речь идёт о системе IQM Radiance в конфигурации с 54 кубитами. Cineca является одним из крупнейших вычислительных центров Италии. Некоммерческий консорциум состоит из 69 итальянских университетов и 21 национальной исследовательской организации. Своей задачей консорциум ставит поддержку итальянского научного сообщества путём предоставления суперкомпьютеров и инструментов визуализации. Монтаж IQM Radiance планируется осуществить в IV квартале нынешнего года. Это будет первый локальный квантовый компьютер на площадке Cineca в Болонье. Суперкомпьютерный центр намерен использовать новую систему для оптимизации квантовых приложений, квантовой криптографии, квантовой связи и квантовых алгоритмов ИИ. Комплекс IQM Radiance 54 будет интегрирован с вычислительной системой Leonardo, которая является одним из самых быстрых суперкомпьютеров в мире. В ноябрьском рейтинге TOP500 эта машина занимает девятое место с теоретической пиковой производительностью 306,31 Пфлопс. В основу суперкомпьютера положены платформы Atos BullSequana X2610 и X2135. Система построена в рамках сотрудничества EuroHPC, которое сейчас занято развёртыванием сети европейских квантовых компьютеров и ИИ-фабрик. Компания IQM Quantum Computers основана в Хельсинки (Финляндия) в 2018 году. Она поставляет полнофункциональные квантовые компьютеры и специализированные решения для HPC, научно-исследовательских институтов, университетов и предприятий. Ранее IQM заявляла, что к выпуску готовится версия Radiance со 150 кубитами, которую планировалось представить в I квартале 2025 года.

18.03.2025 [10:05], Сергей Карасёв

ExxonMobil развернёт суперкомпьютер Discovery 6 с суперчипами NVIDIA GH200Американская ExxonMobil, одна из крупнейших в мире нефтяных компаний, представила проект высокопроизводительного вычислительного комплекса Discovery 6. Этот суперкомпьютер планируется использовать для поддержания работы передовых систем 4D-сейсморазведки. Комплекс создаётся в партнёрстве с НРЕ и NVIDIA. В основу системы ляжет платформа HPE Cray Supercomputing EX4000. Будут задействованы 4032 суперчипа NVIDIA GH200 Grace Hopper. В состав Grace Hopper входят 72-ядерный Arm-процессор NVIDIA Grace, до 480 Гбайт LPDDR5x и ускоритель NVIDIA H100 с 96 или 144 Гбайт HBM3(e). Говорится об использовании интерконнекта HPE Slingshot. Отмечается, что по производительности новый суперкомпьютер примерно в четыре раза превзойдёт предшественника — систему Discovery 5, введённую в эксплуатацию в ноябре 2022 года. Этот комплекс использует платформу HPE Cray EX235n с 32-ядерными процессорами AMD EPYC 7543 и ускорителями NVIDIA A100 SXM4. В ноябрьском рейтинге TOP500 машина Discovery 5 занимала 46-ю позицию с пиковой производительностью 30,99 Пфлопс. Таким образом, быстродействие Discovery 6, как ожидается, будет находиться на уровне 120 Пфлопс. Для создаваемого суперкомпьютера предусмотрено использование высокоэффективной системы прямого жидкостного охлаждения (DLC). Благодаря запуску Discovery 6 ExxonMobil рассчитывает сократить время обработки сложных сейсмических данных с месяцев до недель. Это поможет повысить эффективность разведки месторождений нефти и газа, что приведёт к увеличению добычи ресурсов с меньшими капиталовложениями. Завершить монтаж Discovery 6 планируется в I половине текущего года.

13.03.2025 [15:55], Руслан Авдеев

ESA запустила суперкомпьютер Space HPC для европейских космических исследованийЕвропейское космическое агентство (ESA) запустило суперкомпьютерную платформу ESA Space HPC, специально разработанную для развития космических исследований и технологий в Евросоюзе. Открытие нового объекта состоялось на территории принадлежащего ESA центра ESRIN в Италии, сообщает HPC Wire. ESA Space HPC обеспечит поддержку исследований и развития технологий в рамках всех программ ESA, обеспечивая учёным и малому и среднему бизнесу из стран Евросоюза доступ к вычислительным мощностям. Инициатива призвана развить использование высокопроизводительных вычислений (HPC) в аэрокосмическом секторе ЕС, она станет основой для более масштабных инициатив в будущем. Как сообщается на сайте проекта, Space HPC построен при участии HPE. Суперкомпьютер включает порядка 34 тыс. ядер процессоров Intel и AMD последних поколений, 156 Тбайт RAM, 108 ускорителей NVIDIA H100, All-Flash подсистему хранения ёмкостью 3,6 Пбайт и пропускной способностью 500 Гбайт/с, а также 400G-интерконнект InfiniBand. Общая пиковая производительность кластера составляет 5 Пфлопс (FP64). Space HPC использует прямое жидкостное охлаждение, а PUE системы не превышает 1,09. Избыточное тепло отправляется на нужды отопления кампуса. Локальная солнечная электростанция обеспечивает более половины энергетических нужд кластера. Представители итальянских властей заявили, что технологические инновации в космическом секторе являются приоритетом для обеспечения безопасности и «стратегической автономии», а также будут способствовать конкурентоспособности европейской промышленности. Также отмечено, что местный аэрокосмический хаб Lazio стал домом для 250 компаний и играет ключевую роль в развитии авионики, электроники, радаров, спутниковых технологий и материаловедения. В руководстве ESA отметили потенциал Space HPC для инноваций в космической индустрии Евросоюза. Новый объект обеспечит агентству гибкую суперкомпьютерную инфраструктуру для исследований и разработок, тестирования и бенчмаркинга, поддержки программ ESA и промышленных предприятий. Доступ к вычислениям будет иметь и малый и средний бизнес, стартапы и т.п. Также отмечается, что дебют Space HPC наглядно продемонстрировал, ESA не только берёт ресурсы у государств-участников, но и много может дать им взамен. Утверждается, что одной из ключевых сфер деятельности, где требуются HPC-платформы, для ESA является наблюдение за Землёй. Новые мощности обеспечат управление наблюдениями, разработку новых приложений и сервисов. Space HPC будет поддерживать сложные нагрузки, включая моделирование, инженерные симуляции, обучение ИИ-моделей, аналитику данных и визуализацию, а также прочие эксперименты, которые помогут снизить риски будущих космических проектов. Это позволит ESA повысить финансовую эффективность проектов и обеспечит возможность обмена данными между разными программами агентства. В конце 2024 года сообщалось, что в 2025 году в Евросоюзе появится сразу семь ИИ-фабрик EuroHPC, а в середине минувшего февраля появилась информация, что Евросоюз направит €200 млрд на развитие ИИ, чтобы не отстать от США и Китая в этой сфере. В прошлом году было отмечено, что реализация миссий NASA задерживается из-за устаревших и перегруженных суперкомпьютеров.

13.03.2025 [08:50], Руслан Авдеев

Cerebras развернёт царь-ускорители WSE-3 ещё в шести ЦОД во Франции, США и КанадеКомпания Cerebras начала установку более тысячи ИИ-систем CS-3 на базе гигантских ускорителей WSE-3 по всей Северной Америке и во Франции. Компания стремится зарекомендовать себя как поставщика одной из крупнейших и быстрейших облачных инференс-платформ, сообщает The Register. Кроме того, компания объявила о расширении сотрудничества с Hugging Face. К концу 2025 года развернёт свои ускорители в дата-центрах в Техасе, Миннесоте, Оклахоме и Джорджии, а также в Канаде и во Франции. Cerebras будет целиком владеть площадками в Оклахома-Сити (Оклахома) и Монреале (Канада), а оставшиеся объекты будут эксплуатироваться в рамках соглашения с G42 из ОАЭ. Крупнейший в США новый кластер CS-3 разместится в Миннеаполисе (Миннесота), его оснастят 512 CS-3 с общим быстродействием 64 Эфлопс (FP16). Он заработает уже во II квартале 2025 года. Cerebras давно сотрудничает с фондом G42, который активно спонсирует ИИ-стартап и является его якорным заказчиком — на G42 пришлось 83 % от всей выручки Cerebras за 2023 календарный год. Однако именно это сотрудничество привело к тому, что Cerebras вынужденно отложила IPO — власти США опасаются, что Китай получит доступ к ИИ-суперчипам Cerebras при посредничестве ОАЭ. По слухам, G42 заключила сделку с США, отказавшись от работы с Китаем в обмен на инвестиции.

Источник изображения: SNL В ближайшее время Cerebras также намерена расширить API-доступ к своим ускорителям для разработчиков, договорившись с репозиторием моделей Hugging Face. Также Cerebras выиграла контракты с Mistral AI и Perplexity. Недавно объявлено о намерении аналитической платформы AlphaSense заменить трёх поставщиков моделей с закрытым кодом на модель open source, работающую на CS-3. Летом прошлого года было объявлено о партнёрстве с Dell.

12.03.2025 [20:37], Владимир Мироненко

Евросоюз потратит €240 млн на создание трёх RISC-V чиплетов для суперкомпьютеров в рамках проекта DARE

eurohpc

hardware

hpc

risc-v

европа

ии

импортозамещение

инвестиции

суперкомпьютер

ускоритель

финансы

чиплеты

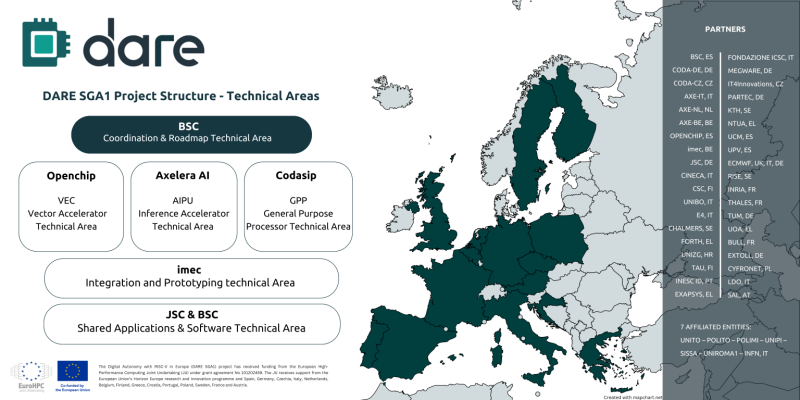

Digital Autonomy with RISC-V in Europe (DARE), крупнейший проект по разработке чипов из когда-либо финансируемых Европейским союзом, созданный с целью укрепления технологического суверенитета Европы в области высокопроизводительных вычислений (HPC) и искусственного интеллекта (ИИ), официально начал первый этап DARE SGA1, на реализацию которого выделено €240 млн ($262 млн), сообщается на сайте проекта. Европа и Китай делают ставку на RISC-V. Финансирование инициативы обеспечат 38 участников, включая ИТ-компании, исследовательские институты и университеты по всей Европе. Проект поддерживается EuroHPC JU и координируется Барселонским суперкомпьютерным центром (BSC-CNS). Последний имеет богатый опыт разработки чипов RISC-V и суперкомпьютерных систем. Половина инвестиций в проект DARE будет предоставлена Европейской комиссией через EuroHPC, а другая половина поступит напрямую от европейских партнёров, включая €34 млн от Министерства науки, инноваций и университетов Испании. Рассчитанный на три года DARE SGA1 является первым этапом шестилетней инициативы DARE. Цель — создание полноценного независимого европейского суперкомпьютерного программно-аппаратного стека для HPC и ИИ, включая чипы, системы на основе чиплетов и ПО. Инициатива направлена на удовлетворение стратегической потребности Европы в цифровом суверенитете и получения полного контроля над критической вычислительной инфраструктурой. Проектом DARE SGA1 предусмотрена разработка трёх чиплетов на основе архитектуры RISC-V, каждый из которых будет выполнять критически важную функцию в вычислениях HPC и ИИ:

В дополнение к указанным компаниям в качестве технических лидеров названы imec и Юлихский исследовательский центр (JÜLICH Supercomputing centre, JSC), которые будут продвигать ключевые инновации в рамках проекта. Помимо координации усилий, BSC также возглавит разработку планов и будет участвовать в разработке программных и аппаратных решений. Изготавливаться чиплеты будут по технологии CMOS с использованием современных техпроцессов. Axelera получит на разработку до €61 млн при условии выполнения различных задач в течение следующих трёх лет, рассказал ресурсу EE Times генеральный директор Axelera Фабрицио дель Маффео (Fabrizio del Maffeo). Хотя нынешний чип Axelera Metis AIPU предназначен для периферийных систем, дель Маффео сказал, что разрабатываемый в рамках DARE продукт на основе чиплетов не несёт кардинальные изменения, речь скорее о масштабировании. Codasip в прошлом году анонсировала 64-бит чип X730 на базе RISC-V с архитектурной защитой CHERI. По данным The Next Platform, за последнее десятилетие компания привлекла $34,6 млн общего финансирования, включая средства в рамках различных инициатив ЕС, а также посевной раунд в размере $2,5 млн в 2016 году и раунд A в размере $10 млн в 2018 году.

10.03.2025 [12:03], Сергей Карасёв

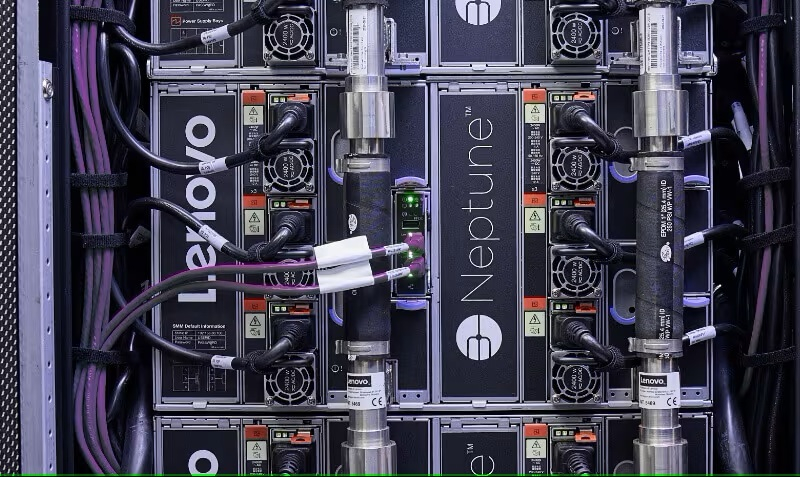

Lenovo создаст крупнейший в Индии ИИ-суперкомпьютер, который получит отечественные чипы KrutrimИндийская компания Krutrim, подразделение Ola Group, специализирующееся на технологиях ИИ, заключила партнёрское соглашение с Lenovo с целью разработки крупнейшего в Индии суперкомпьютера. Как сообщает Datacenter Dynamics, система будет использоваться в том числе для разработки большой языковой модели (LLM) Krutrim 3 с 700 млрд параметров. В ходе конференции Lenovo TechWorld India 2025 Навенду Агарвал (Navendu Agarwal), директор по информационным технологиям Ola, сообщил, что в составе нового НРС-комплекса планируется использовать фирменные чипы Krutrim, а также облачные сервисы этой компании. В дальнейшие подробности относительно технических характеристик машины Агарвал вдаваться не стал. В августе прошлого года Krutrim анонсировала чипы собственной разработки для ИИ-приложений. Это изделие Bodhi 1 для инференса и работы с LLM, процессор Sarv 1 для облачных платформ и дата-центров, поддерживающих ИИ-нагрузки, а также решение Ojas для выполнения задач на периферии. Таким образом, в составе проектируемого суперкомпьютера могут быть задействованы чипы Bodhi 1 и Sarv 1. Агарвал отмечает, что в 2028 году ожидается выход процессора Bodhi 2, который, по его словам, сможет использоваться для работы с LLM, насчитывающими до 10 трлн параметров.

Источник изображения: Lenovo Вместе с тем Krutrim сотрудничает с Arm и Untether AI с целью разработки решений нового поколения для ЦОД, которые будут применяться для настройки и инференса ИИ-моделей Krutrim. В свою очередь, Lenovo осенью 2024 года объявила о намерении организовать выпуск ИИ-серверов на индийском заводе в Пондичерри (Puducherry). Кроме того, Lenovo планирует сформировать передовую научно-исследовательскую лабораторию в Бангалоре (столица штата Карнатака на юге Индии). В целом, Lenovo готова содействовать правительственной программе по трансформации Индии в крупный центр технологических инноваций и производства.

10.03.2025 [08:52], Руслан Авдеев

К2 НейроТех: российский рынок HPC за два года вырос на 35 %К2 НейроТех сделала прогноз относительно основных трендов на российском рынке российских суперкомпьютеров. По оценкам компании, за последние два года рынок высокопроизводительных вычислений (HPC) в стране вырос на 35 % и достиг 15,8 млрд руб. Ключевую роль в этом играет развитие ИИ-систем. В 2025 году рынок HPC должен вырасти как минимум на 12 %. Согласно прогнозам компании, в РФ вырастет местное производство оборудования для ИИ-систем. Рост спроса на искусственный интеллект и вычислительные мощности ведут к распространению HPC в бизнесе. Если раньше такие вычисления применялись в основном в науке и инженерных расчётах, то теперь всё чаще их активно применяют для обработки Big Data, ИИ, машинного обучения и др. В 2024 году вложения в системы хранения данных (СХД) и платформы для высоконагруженных систем выросли на 40 %. Утверждается, что выпуск СХД и ИИ-серверов вырос на 10,5 %, госзакупки таких систем увеличились вдвое, а госкомпании потратили на оборудование для ИИ более 1,7 млрд руб. Ещё одним трендом стали модернизация и масштабирование имеющихся HPC-кластеров. Особенной популярностью стали пользоваться готовые решения «под ключ», поскольку теперь часто возникает проблема совместимости программного обеспечения и оборудования. В К2Тех заявляют, что заказчики всё чаще сталкиваются с тем, что имеющееся оборудование не способно справляться с современными задачами и масштабироваться. Ответом на это также будет развитие HPCaaS и гибридных инфраструктур, объединяющих локальные и облачные вычисления. Наконец, К2 НейроТех предрекает переход к контейнеризированным средам как альтернативе «монолитным» приложениям. Использование Kubernetes, Singularity и Slurm даёт возможность оптимально распределять нагрузки и снижать издержки на эксплуатацию HPC-инфраструктуры.

19.02.2025 [09:28], Руслан Авдеев

1,5 ГВт и 1,2 млн ускорителей: Sesterce потратит €52 млрд на ИИ-инфраструктуру во ФранцииФранцузский облачный провайдер Sesterce инвестирует €450 млн ($471,85 млн) в создание ИИ ЦОД во французском Валансе (Valençay). Дата-центр разместится в бизнес-парке Rovaltain в агломерации Valence Romans Agglo. Ожидается, что проект будет использовать 40 тыс. ускорителей для обучения и эксплуатации ИИ, сообщает пресс-служба компании. В новом ЦОД будет применяться замкнутая система водяного охлаждения, благодаря которой выделяемое оборудованием тепло можно будет использовать для отопления. Работы над проектом начнутся в сентябре 2025 года и завершатся до конца 2026 года. Размеры объекта и его мощность пока не раскрываются. Отмечается, что €450 млн — это инвестиции лишь первого этапа, а общий бюджет проекта составит €1,8 млрд ($1,89 млрд) с учётом расходов на оборудование. Новый дата-центр — часть более масштабного €109-млрд плана Франции по достижению лидерства на рынке ИИ. Кроме того, страна готовится выделить для развития ИИ 1 ГВт от атомных станций.

Источник изображения: Sesterce Всего Sesterce намерена потратить €52 млрд развернуть 1,5 ГВт мощностей и к 2030 году задействовать 1,2 млн ускорителей. Помимо развития нового ЦОД в Валансе, Sesterce намерена добавить 600 МВт двум дата-центрам в Гранд-Эсте (Grand Est) с 500 тыс. ускорителей к 2028 году, а к 2030 довести мощность до 1,2 ГВт и разместить более 1 млн ускорителей. Кроме того, компания намерена построить на юге Франции суперкомпьютер на 250 МВт с 200 тыс. ускорителей. Свой первый ЦОД компания открыла в 2018 году, а в октябре 2024 года запустила HPC-кластер в Париже. Он построен на основе серверов Dell PowerEdge XE9680, оснащённых ускорителями NVIDIA H200. В декабре того же года компаняи анонсировала строительство кластера на базе H100 в ЦОД Digital Realty в Марселе. Сейчас компания управляет 1 ГВт мощностей и использует более 100 тыс. ИИ-ускорителей, отмечает DataCenter Dynamics.

11.02.2025 [16:24], Владимир Мироненко

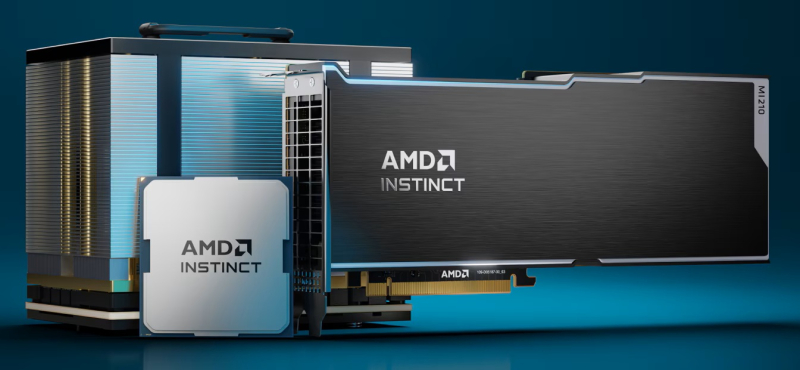

ИИ ЦОД за 20 недель: G42 и DataOne построят крупнейший во Франции суперкомьютер на чипах AMD InstinctХолдинг G42 из Абу-Даби (ОАЭ) объявил о стратегических инвестициях во Франции в партнёрстве с недавно образованной DataOne, которая сама себя называет первым в Европе оператором гига-ЦОД для ИИ. Вместе компании в кратчайшие сроки построят в Гренобле ИИ ЦОД, оснащённый ускорителями AMD Instinct. Ожидается, что объект будет полностью введён в эксплуатацию к середине 2025 года. Вычислительные возможности нового ЦОД позволят французским компаниям и учёным разрабатывать передовые модели ИИ, агентов и приложения, а также проводить различные исследования. Реализацией проекта будет заниматься компания Core42, дочернее предприятие G42, совместно с DataOne. По словам главы DataOne Шарля-Антуана Бейни (Charles-Antoine Beyney), на развёртывание крупнейшего ИИ-суперкомпьютера в Европе потребуется всего 20 недель. Для сравнения: кластер xAI Colossus был построен за 122 дня. Как заявила Лиза Су (Lisa Su), председатель и генеральный директор AMD, стратегическое сотрудничество с G42 поможет активизировать французскую экосистему ИИ, предоставив вычислительную мощность, необходимую для поддержки местных стартапов и новаторов, занимающихся передовыми разработками, которые укрепляют французскую экономику. «Работа с G42 является ещё одним примером нашей приверженности объединению открытых экосистем с ведущими в отрасли технологиями ИИ AMD, что обеспечивает возможность государственным учреждениям и частным предприятиям использовать весь потенциал ИИ», — подчеркнула Лиза Су. Инвестиции G42 входят в пакет частных инвестиций в ИИ-инфраструктуру страны на €109 млрд, анонсированный президентом Франции Эммануэле Макроном (Emmanuel Macron) в качестве ответа на представленный в США проект Stargate. Ранее было объявлено о планах ОАЭ вложить при участии фонда MGX €30–50 млрд в проект по созданию кампуса ИИ ЦОД во Франции. В G42 называют инвестиции в ИИ одним из главных направлений своей деятельности. Деятельность холдинга получила поддержку Microsoft, инвестировавшей в него $1,5 млрд. В прошлом году G42 договорился с Cerebras о строительстве в Техасе ИИ-суперкомпьютера со 173 млн ядер. |

|