Материалы по тегу: суперкомпьютер

|

11.02.2025 [13:47], Руслан Авдеев

Tesla запустила суперкомпьютер Cortex с 50 тыс. ускорителей NVIDIA H100, а общие затраты компании на ИИ уже превысили $5 млрдКомпания Tesla завершила ввод в эксплуатацию ИИ-кластера из 50 тыс. ИИ-ускорителей NVIDIA H100 в IV квартале прошлого года. В презентации для акционеров отмечалось, что кластер Cortex заработал на принадлежащем Tesla объекте Gigafactory в Остине (Техас), сообщает Datacenter Dynamics. Информация впервые появилась в отчёте компании за IV квартал и 2024 финансовый год. Новый кластер не имеет отношения к суперкомпьютеру Dojo, предназначенному для технологий автономного вождения FSD, имеющего собственную архитектуру и оснащенного кастомными чипами D1. При этом в презентации, посвящённой отчёту, Dojo не упоминается вообще. Хотя компания не уточняет, когда именно в IV квартале началось развёртывание системы, на конференции по финансовым вопросам в октябре 2024 года представитель Tesla заявил, что компания находится «на пути к развёртыванию 50 тыс. ускорителей в Техасе к концу текущего месяца». По имеющимся данным, проект реализован с опозданием, поскольку Илон Маск уволил руководителя строительством ещё в апреле, а также приказал передать xAI 12 тыс. ускорителей H100, изначально предназначавшихся Tesla.

Источник изображения: Tesla В презентации сообщается, что именно Cortex уже помог в создании «автопилота» FSD V13 (Supervised). Новая версия повысила безопасность и комфорт вождения благодаря увеличению объёма данных в 4,2 раза, повышению разрешения видеопотока, а также другим усовершенствованиям. Заодно компания сообщила о продолжении работ над программной и аппаратной частями робота Optimus, в т.ч. рук нового поколения и механизмов передвижения. Также осуществлялось обучение выполнению дополнительных задач перед началом пилотного производства в 2025 году. Что касается доходов компании в IV квартале, в конце января Илон Маск (Elon Musk) сообщил, что бизнес продолжает инвестировать в обучающую инфраструктуру за пределами штаб-квартиры в Техасе. В конце января сообщалось, что Tesla наращивает вычислительные мощности для обучения Optimus. По словам миллиардера, на обучение Optimus необходимо потратить, как минимум, в 10 раз больше ресурсов в сравнении с полноценным обучением систем автомобиля. Капитальные затраты Tesla в 2024 году составили $10 млрд, столько же компания намерена потратить в ближайшие два года, хотя большая часть затрат придётся на инфраструктуру для электромобилей. В отчёте о доходах за IV квартал упоминалось, что общие капитальные затраты компании, связанные с ИИ, включая инфраструктуру, превысили $5 млрд.

31.01.2025 [20:57], Руслан Авдеев

ИИ-модели OpenAI и суперкомпьютер Venado встанут на защиту национальной безопасности СШАЛос-Аламосская национальная лаборатория США (LANL) заключила соглашение с OpenAI об использовании моделей серии o на ИИ-суперкомпьютере Venado. Система, оснащённая суперускорителями NVIDIA GH200, среди прочего будет использоваться для исследований в сфере национальной безопасности. Новые модели способны решать всё более сложные научные задачи, в том числе прикладные. В лаборатории подчеркнули, что угрозы для страны становятся всё более сложными и актуальными, поэтому нужны новые подходы для обеспечения её безопасности. Модели OpenAI, в частности вариант o1, позволят более эффективно справляться с задачами и помогут решить некоторые насущные проблемы страны. Venado включат в защищённую секретную сеть, где его ресурсами смогут воспользоваться исследователи из Лос-Аламоса, Ливерморской национальной лаборатории (LLNL) или Сандийских национальных лабораторий (SNL). Сотрудничество этих структур Министерства энергетики США (DoE) с IT-компаниями обеспечит новые возможности для научных исследований. Сообщается, что почти во всех проектах лаборатории ИИ уже используется в том или ином качестве. Ранее LANL сотрудничала с OpenAI над повышением безопасности ИИ и оценкой «способности к рассуждению» модели o1. Теперь модели OpenAI регулярно используются национальными лабораториями в энергетических проектах, разработке новых материалов и создании квантовых алгоритмов. Использование моделей в секретной сети только расширит их возможности и позволит вносить более глубокий вклад в выполнение разных задач. Новые ИИ-модели, по словам LANL, позволят США пересмотреть сами основы научных знаний и достигнуть нового уровня технического прогресса. С их использованием можно найти новые способы лечения и профилактики заболеваний, добиться лидерства в энергетической сфере благодаря раскрытию полного потенциала природных ресурсов и преобразовать энергетическую инфраструктуру страны, лучше выявлять природные и антропогенные угрозы, от биологических до кибернетических или угроз энергосистеме — ещё до их реального возникновения. Также известно о сотрудничестве LANL и OpenAI для оценки возможностей ИИ в биологических исследованиях. Так, по данным The Register, оценивались возможности ИИ для создания биологического оружия. Впрочем, нашлось им и более мирное применение — оценка снижении угрозы ядерной войны и ядерных угроз вообще. Это не единственный из недавних примеров сотрудничества OpenAI с американским правительством. Пару дней назад компания заявила о премьере бота ChatGPT Gov — варианта корпоративной версии ChatGPT Enterprise. Предварительные испытания уже прошли в нескольких организациях для обработки «непубличных конфиденциальных данных».

30.01.2025 [08:58], Владимир Мироненко

Суперкомпьютер Aurora стал доступен исследователям со всего мираАргоннская национальная лаборатория (ANL) Министерства энергетики США объявила о доступности суперкомпьютера Aurora экзафлопсного класса для исследователей по всему миру. Как указано в пресс-релизе, благодаря широким возможностям моделирования, ИИ и анализа данных, Aurora будет способствовать прорывам в целом ряде областей, включая проектирование самолётов, космологию, разработку лекарств и исследования в сфере ядерной энергетики. Майкл Папка (Michael Papka), директор Argonne Leadership Computing Facility (ALCF), вычислительного центра Управления науки Министерства энергетики США, отметил, что уже первые проекты с использованием Aurora продемонстрировали его огромным потенциал. «С нетерпением ждём, как более широкое научное сообщество будет использовать систему для преобразования своих исследований», — заявил он. Aurora уже зарекомендовала себя как один мировых лидеров по производительности ИИ, заняв первое место в бенчмарке HPL-MxP в ноябре 2024 года, отметила ANL. Возможности машины для выполнения ИИ-задач используются учёными для открытия новых материалов для аккумуляторов, разработки новых лекарств и ускорения исследований в области термоядерной энергии. Перед его развёртыванием команда под руководством ANL продемонстрировала потенциал Aurora, используя его для обучения моделей ИИ для моделирования белков. В числе первых проектов, реализуемых с помощь Aurora, — разработка высокоточных моделей сложных систем, таких как кровеносная система человека, ядерные реакторы и сверхновые звезды. Кроме того, способность суперкомпьютера к обработке огромных наборов данных имеет решающее значение для анализа растущих потоков данных из крупных исследовательских установок, таких как Усовершенствованный источник фотонов (APS) Аргоннской национальной лаборатории, научные объекты Управления науки Министерства энергетики США (DoE) и Большой адронный коллайдер Европейской организации ядерных исследований (CERN). Чтобы гарантировать готовность Aurora к использованию для научных исследования с первого дня запуска, при его создании применили так называемое совместное проектирование. Используя этот подход, команда Aurora разработала в тандеме аппаратное и программное обеспечение для оптимизации производительности и удобства использования. Это потребовало многолетнего сотрудничества между ALCF, Intel, HPE и исследователями по всей стране, участвующими в проекте Exascale Computing Project (ECP) Министерства энергетики США и программе Aurora Early Science Program (ESP) центра. Пока велись работы по монтажу Aurora, команды ECP и ESP запускали приложения для стресс-тестирования оборудования, одновременно оптимизируя свой код для максимально эффективной работы в системе. В результате десятки научных приложений, а также широкий спектр ПО и инструментов разработки были готовы ещё до того, как Aurora ввели в строй, говорится в пресс-релизе.

19.01.2025 [22:43], Сергей Карасёв

Германия запустила «переходный» 48-Пфлопс суперкомпьютер Hunter на базе AMD Instinct MI300AЦентр высокопроизводительных вычислений HLRS при Штутгартском университете в Германии объявил о вводе в эксплуатацию НРС-системы Hunter. Этот суперкомпьютер планируется использовать для решения широко спектра задач в области инженерии, моделирования погоды и климата, биомедицинских исследований, материаловедения и пр. Кроме того, комплекс будет применяться для крупномасштабного моделирования, ИИ-приложений и анализа данных. О создании Hunter сообщалось в конце 2023 года: соглашение на строительство системы стоимостью примерно €15 млн было заключено с HPE. Проект финансируется Федеральным министерством образования и исследований Германии и Министерством науки, исследований и искусств Баден-Вюртемберга. Hunter базируется на той же архитектуре, что El Capitan — самый мощный в мире суперкомпьютер. Задействована платформа Cray EX4000, а каждый из узлов оснащён четырьмя адаптерами HPE Slingshot. Суперкомпьютер использует комбинацию из APU Instinct MI300A и процессоров EPYC Genoa. Как отмечает The Register, в общей сложности система объединяет 188 узлов с жидкостным охлаждением и насчитывает суммарно 752 APU и 512 чипов Epyc с 32 ядрами. Применена СХД HPE Cray Supercomputing Storage Systems E2000, специально разработанная для суперкомпьютеров HPE Cray. HLRS оценивает пиковую теоретическую FP64-производительность Hunter в 48,1 Пфлопс на операциях двойной точности, что практически вдвое выше, чем у предшественника Hawk. В режимах BF16 и FP8 быстродействие, как ожидается, будет варьироваться от 736 Пфлопс до 1,47 Эфлопс. При этом Hunter потребляет на 80% меньше энергии, нежели Hawk. Отмечается, что Hunter задуман как переходная система, которая подготовит почву для суперкомпьютера HLRS следующего поколения под названием Herder. Ввести этот комплекс в эксплуатацию планируется в 2027 году. Предполагается, что он обеспечит производительность «в несколько сотен петафлопс».

18.01.2025 [22:31], Владимир Мироненко

CoreWeave поставит IBM ИИ-суперкомпьютер на базе NVIDIA GB200 NVL72 для обучения моделей GraniteCoreWeave и IBM заключили соглашение о сотрудничестве, в рамках которого стартап поставит IBM один из первых своих ИИ-суперкомпьютеров на базе NVIDIA GB200 NVL72 с интерконнектом Quantum-2 InfiniBand. В качестве хранилища будет использоваться высокопроизводительная All-Flash СХД IBM Storage Scale System. IBM будет использовать облачную платформу CoreWeave для обучения семейства больших языковых моделей (LLM) Granite. Сообщается, что облачная платформа CoreWeave специально создана для обеспечения ведущей в отрасли производительности, надёжности и отказоустойчивости с безопасностью корпоративного уровня. Фирменный набор ПО и облачные сервисы предоставляют инструменты, необходимые для управления самой сложной и масштабной ИИ-инфраструктурой. В рамках соглашения о сотрудничестве клиенты CoreWeave получат доступ к платформе IBM Storage. По словам вице-президента по ИИ в IBM Research, платформа CoreWeave позволит дополнить возможности IBM при разработке передовых, производительных и экономичных моделей для поддержки корпоративных приложений и ИИ-агентов. В свою очередь, IBM Storage Scale System расширяет возможности CoreWeave. «В рамках сотрудничества мы будем использовать этот суперкомпьютер для продвижения открытых технологий, таких как Kubernetes, которые будут поддерживать вычисления ИИ в гибридной облачной среде», — добавил представитель IBM. Вероятно, IBM не хватает собственных вычислительных ресурсов — в ноябре появилась информация о том, что компания готова арендовать у AWS ИИ-ускорители за почти полмиллиарда долларов.

17.01.2025 [15:17], Владимир Мироненко

NVIDIA строит в Израиле ИИ-суперкомпьютер стоимостью $500 млнNVIDIA построит за $500 млн на севере Израиля 30-МВт научно-исследовательский суперкомпьютер на базе ускорителей Blackwell последнего поколения стоимостью около полмиллиарда долларов, сообщил The Register. Строительство кластера началось ещё в прошлом году, а закончить его планируется в I полугодии 2025 года. Кластер будет располагаться на объекте площадью 10 тыс. м2 в научно-промышленном парке Mevo Carmel недалеко от Йокнеам-Илита (Yokne'am Illit). По словам компании, он получит сотни систем Blackwell с фирменным жидкостным охлаждением, DPU BlueField-3 SuperNIC, коммутаторами Spectrum-X800 и Quantum-X800. Как полагает The Register, кластер будет использоваться NVIDIA для разработки технологий ЦОД следующего поколения. Точное количество ускорителей не указано. У NVIDIA есть несколько эталонных систем Blackwell с жидкостным охлаждением и различным количеством ускорителей. Согласно публикациям израильских СМИ, полная конфигурация нового суперкомпьютера будет включать «несколько тысяч» GPU, что позволит ему соперничать с национальным суперкомпьютером Israel-1. Israel-1 построен на 2048 ускорителях NVIDIA H100, объединённых с помощью 80 коммутаторов Spectrum-4. Суперкомпьютер имеет пиковую FP64-производительность до 137 Пфлопс, а FP8 — до 8 Эфлопс. The Register отметил, что на реализации проекта могут отразиться новые экспортные ограничения США. Согласно правилам AI Diffusion rule, Израиль относится к странам второго уровня с квотой на поставку до 50 тыс. передовых ускорителей в течение двухлетнего периода (2025–2027 гг.). Впрочем, эти правила вступят в силу через 120 дней с момента публикации, поэтому у NVIDIA в запасе достаточно времени для поставки необходимого количества ускорителей в Израиль. С учётом прочных связей Израиля с США есть большая вероятность того, что стране будет предоставлен статус National Verified End User, что увеличит лимит импорта до 320 тыс. ускорителей в течение двухлетнего периода, отметил The Register.

17.01.2025 [01:07], Алексей Степин

США готовятся к созданию суперкомпьютера нового поколения с 10 Пбайт RAMСуперкомпьютеру Crossroads (ATS-3), расположенному в Лос-Аламосской национальной лаборатории (LANL) Министерства энергетики США (DoE), не так уж много лет. Система мощностью 30 Пфлопс запущена в 2023 году, но ей уже готовится замена в лице суперкомпьютера нового поколения под кодовым названием ATS-5. Министерство энергетики совместно с Национальным управлением по ядерной безопасности (NNSA) раскрыли некоторые детали, касающиеся этого проекта. Главной задачей ATS-5 станет запуск высокоточных 3D-симуляций для оценки перспектив модернизации и поддержания в актуальном состоянии ядерного арсенала США. Симуляции со столь высокой детализацией очень сложны и относятся к классу «геройских» (hero-class). Их прогон может занимать несколько месяцев, но ATS-5 должен не только сократить это время до дней, но и обеспечить обработку нескольких таких симуляций параллельно. NNSA не сообщает о том, будет ли ATS-5 относится к системам экзафлопсного класса, но судя по употреблению термина «post-exascale system» и сложности планируемых для запуска симуляций, новый суперкомпьютер будет достаточно мощным. Известен уровень его энергопотребления — порядка 20 МВт. Для сравнения, Frontier (1,35 Эфлопс FP64) потребляет 21 МВт, а El Capitan (1,74 Эфлопс FP64) — около 30 МВт. По замыслу DoE, ATS-5 станет модульной системой со смешанной архитектурой, сфокусированной не только на HPC-задачах (FP64), но и на ИИ-сценариях с их упрощёнными форматами вычислений. Упор делается на размещении данных ближе к вычислительным узлам, увеличении объёмов памяти (в настоящее время заявлено 10,1 Пбайт) и ускорении её работы.  В качестве интерконнекта может быть применена смесь технологий InfiniBand и Ethernet, развивающая от 100 до 300 Гбайт/с в каждом направлении. Модульность означает возможность замены ускорителей и процессоров на протяжении всего срока эксплуатации ATS-5. Помимо ускорителей NVIDIA рассматривается возможность использования квантовых ускорителей, а также чипов Cerebras, Groq и SambaNova. ПО практически целиком должно быть open source, но и от CUDA при необходимости отказываться не будут. Министерство энергетики США надеется разместить контракт на постройку ATS-5 в мае текущего года. Поставки оборудования должны начаться в конце 2026 или начале 2027 гг, а ввод системы в строй намечен на август-сентябрь 2027 года. Тогда же будет выведен из строя Crossroads (ATS-3).

15.01.2025 [08:38], Руслан Авдеев

Новые ЦОД стоимостью £14 млрд помогут Великобритании превратиться в ИИ-сверхдержавуВ рамках нового плана британского правительства по развитию ИИ-проектов анонсированы инициативы по созданию ЦОД на общую сумму £14 млрд ($16,96 млрд). Так, Vantage, Nscale и Kyndryl обязались инвестировать в местную цифровую инфраструктуру и создать 13 тыс. рабочих мест. Планом предусмотрено и строительство нового ИИ-суперкомпьютера, сообщает Datacenter Dynamics. Ещё до объявления новой программы правительства об инвестициях в британские ЦОД сообщили Blackstone (£10 млрд) и DC01UK (£3,75 млрд), а также Cloud HQ, CyrusOne, CoreWeave и ServiceNow (суммарно £6,3 млрд) В рамках программы AI Opportunities Action Plan, некоторые детали которой появились ещё в ноябре, по всей стране будут созданы «Зоны роста ИИ» с приоритетным доступом к технологиям и энергии, призванные привлечь инвестиции со всего мира. Зоны станут и полигоном для энергетических проектов, связанных с ЦОД. Особая роль отведена атомной энергетике. Первую зону построят в Калхэме (графство Оксфордшир), где находится Управление по атомной энергии Великобритании и расположены кампусы AWS и CloudHQ. Оператор NScale объявил о намерении инвестировать в Великобританию £2,5 млрд ($3 млрд), где построит свой первый ИИ ЦОД в графстве Эссекс мощностью 50 МВт с возможностью расширения до 90 МВт. В компании надеются ввести дата-центр в эксплуатацию в IV квартале 2026 года, разместив в нём до 45 тыс. NVIDIA GB200 и наняв 250 постоянных сотрудников. В других графствах NScale начнёт строить модульные ЦОД во II половине 2025 года, а впоследствии будет развивать и стационарные дата-центры. Vantage Data Centers построит кампус на 10 зданий на месте бывшего автозавода Ford в Уэльсе. Речь идёт об инвестициях £12 млрд ($14,55 млрд) и создании 11,5 тыс. рабочих мест. Ещё в 2020 году Vantage приобрела Next Generation Data, управляющую дата-центрами в Уэльсе и Лондоне. Наконец, Kyndryl создаст 1 тыс. рабочих мест, связанных с ИИ, в новом технологическом центре в Ливерпуле, который построят в следующие три года. Ранее власти отнесли дата-центры к критически важной инфраструктуре (CNI) и пообещали реформировать законы о планировании, чтобы упростить строительство новых объектов. Более того, заново рассматриваются заявки, которые были отклонены. Например, в декабре дали «зелёный свет» отменённому годом ранее проекту в Бакингемшире. По словам премьер-министра Кира Стармера (Keir Starmer), индустрии ИИ нужно правительство, которое примет её сторону и не позволит упустить возможности развития. По словам министра, план сделает Великобританию мировым лидером в области ИИ, даст отрасли опору и импульс. Благодаря этому появится больше рабочих мест, больше денег у населения и, наконец, будет реформирована система государственных услуг. Подробнее о плане рассказывается на сайте самого британского правительства. Также Великобритания планирует построить ИИ-суперкомпьютер. Данных о нём пока немного, но Департамент науки, инноваций и технологий (DSIT) сообщил, что его создание — один из элементов плана по двадцатикратному увеличению вычислительных мощностей страны к 2030 году. Примечательно, что в прошлом году власти отложили реализацию HPC-проектов на £1,3 млрд, сославшись на нехватку средств. В том числе было отменено создание первого в стране экзафлопсного суперкомпьютера при Эдинбургском университете.

28.12.2024 [12:42], Сергей Карасёв

Итальянская нефтегазовая компания Eni запустила суперкомпьютер HPC6 с производительностью 478 ПфлопсИтальянский нефтегазовый гигант Eni запустил вычислительный комплекс HPC6. На сегодняшний день это самый мощный суперкомпьютер в Европе и один из самых производительных в мире: в свежем рейтинге TOP500 он занимает пятую позицию. О подготовке HPC6 сообщалось в начале 2024 года. В основу системы положены процессоры AMD EPYC Milan и ускорители AMD Instinct MI250X. Комплекс выполнен на платформе HPE Cray EX4000 с хранилищем HPE Cray ClusterStor E1000 и интерконнектом HPE Slingshot 11. В общей сложности в состав HPC6 входят 3472 узла, каждый из которых несёт на борту 64-ядерный CPU и четыре ускорителя. Таким образом, суммарное количество ускорителей Instinct MI250X составляет 13 888. Суперкомпьютер обладает FP64-быстродействием 477,9 Пфлопс в тесте Linpack (HPL), тогда как пиковый теоретический показатель достигает 606,97 Пфлопс. Максимальная потребляемая мощность системы составляет 10,17 МВА. Комплекс HPC6 смонтирован на площадке Eni Green Data Center в Феррера-Эрбоньоне: это, как утверждается, один из самых энергоэффективных и экологически чистых дата-центров в Европе. Новый суперкомпьютер оснащён системой прямого жидкостного охлаждения, которая способна рассеивать 96 % вырабатываемого тепла. ЦОД, где располагается HPC6, оборудован массивом солнечных батарей мощностью 1 МВт. Как отмечает ресурс Siliconangle, на создание суперкомпьютера потрачено более €100 млн. Применять комплекс планируется, в частности, для оптимизации работы промышленных предприятий, повышения точности геологических и гидродинамических исследований, разработки источников питания нового поколения, оптимизации цепочки поставок биотоплива, создания инновационных материалов и моделирования поведения плазмы при термоядерном синтезе с магнитным удержанием.

28.12.2024 [11:35], Сергей Карасёв

Обнародован рейтинг Тор-100 суперкомпьютеров Китая: систем экзафлопсного класса в нём нетОбщество компьютерных наук Китая обнародовало свежий рейтинг 100 самых производительных суперкомпьютеров страны. Как отмечает ресурс Tom's Hardware, власти КНР, похоже, скрывают свой истинный вычислительный потенциал. Дело в том, что в опубликованном списке Тор-100 не только нет систем экзафлопсного класса, но и не представлено ни одной новой машины за год. В тройку лидеров в 2024 году вошли те же самые гетерогенные системы (CPU + GPU), которые возглавляли рейтинг в 2023-м. На первом месте располагается комплекс, обладающий FP64-быстродействием 487,94 Пфлопс в тесте Linpack (HPL) и пиковой производительностью на уровне 620 Пфлопс. Эта система, введённая в эксплуатацию в 2023 году, насчитывает в общей сложности 15 974 400 ядер CPU.

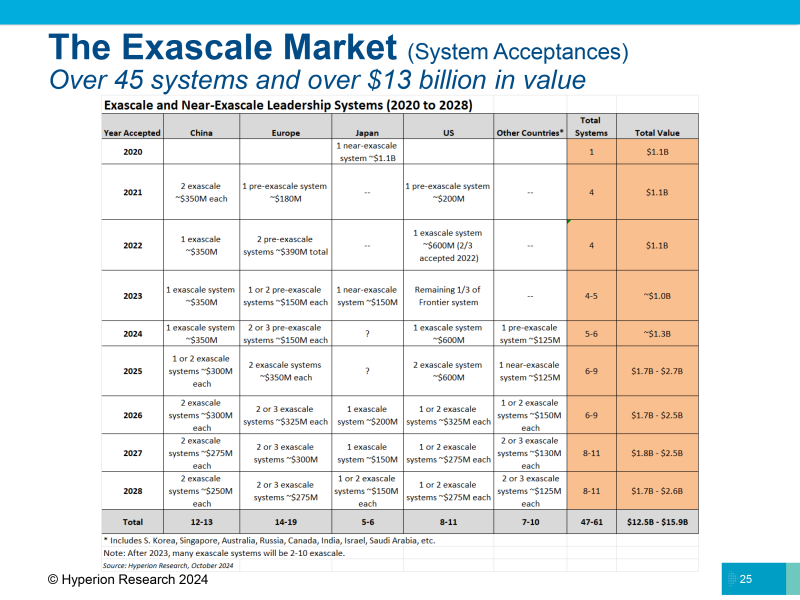

Источник изображения: Xinhua На второй позиции списка находится машина, запущенная в 2022 году: она использует 460 000 ядер CPU. Заявленное быстродействие составляет 208,26 Пфлопс, пиковое значение — 390 Пфлопс. Замыкает тройку система с 285 000 тыс. CPU-ядер, введённая в эксплуатацию в 2021-м: у неё показатели производительности достигают 125,04 и 240 Пфлопс. Фактически, как отмечается, единственное различие между списками Тор-100 суперкомпьютеров Китая от 2023 и 2024 годов заключается в их совокупной мощности, но даже этот показатель вырос незначительно — с 1,398 Эфлопс до 1,406 Эфлопс. Для сравнения: самый производительный в мире суперкомпьютер — американская система El Capitan — обладает быстродействием 1,742 Эфлопс. По косвенным признакам понятно, что у Китая есть несколько машин экзафлопсного класса. По оценкам Hyperion Research, в КНР развёрнуто уже пять подобных систем. Эти сведения официально не подтверждены, но участники рынка говорят, что китайские организации намеренно скрывают информацию о своих самых мощных НРС-системах, чтобы не спровоцировать дополнительные ограничения со стороны США. С 2021 года китайские компании не подают заявки на участие в рейтинге TOP500. |

|