Материалы по тегу: облако

|

29.04.2025 [14:44], Сергей Карасёв

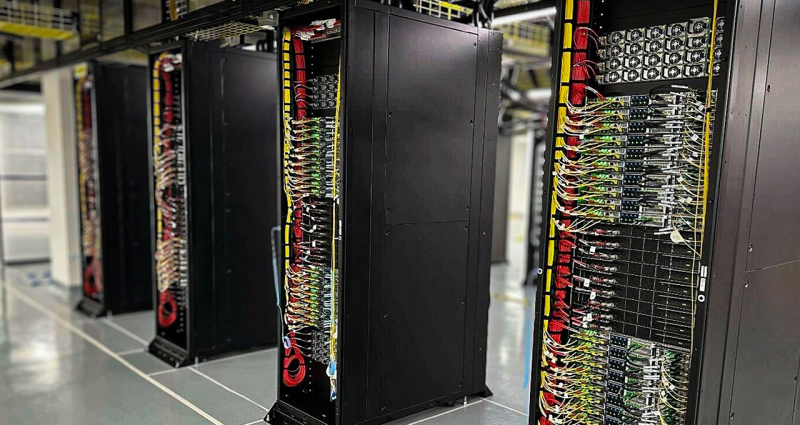

Oracle развернула в облаке суперускорители NVIDIA GB200 NVL72Корпорация Oracle ввела в эксплуатацию в своих дата-центрах первые суперускорители NVIDIA GB200 NVL72. Тысячи GPU семейства Blackwell доступны клиентам через облако NVIDIA DGX Cloud и инфраструктуру Oracle Cloud Infrastructure (OCI) для создания и запуска ИИ-агентов и «рассуждающих» моделей следующего поколения. Решение GB200 NVL72 объединяет 18 узлов 1U в одной стойке: каждый из них содержит два ускорителя GB200, что в сумме даёт 72 чипа B200 и 36 процессоров Grace. Задействована система жидкостного охлаждения. Платформа Oracle включает высокоскоростные сетевые решения NVIDIA Quantum-2 InfiniBand и Spectrum-X Ethernet. Отмечается, что Oracle планирует сформировать один из самых крупных в мире кластеров с ИИ-ускорителями поколения Blackwell. Системы OCI Supercluster смогут масштабироваться до более чем 100 тыс. GPU для удовлетворения стремительно растущих потребностей в вычислительных ресурсах для задач инференса и НРС. При этом Oracle предлагает гибкие варианты развёртывания, позволяющие клиентам использовать Blackwell через публичные, государственные и суверенные облака, а также собственные дата-центры. О намерении задействовать мощности OCI GB200 уже заявили ряд крупных клиентов. В их число входят технологические компании, корпоративные заказчики, государственные учреждения, а также региональные поставщики облачных услуг. Ранее о запуске общедоступных инстансов на основе NVIDIA GB200 NVL72 объявила компания CoreWeave, предоставляющая облачные сервисы для ИИ-задач. Кластеры Supermicro на базе NVIDIA GB200 NVL72 предложит клиентам Eviden (подразделение Atos Group). Эти суперускорители также взяла на вооружение облачная платформа Google Cloud. xAI также приступил к монтажу NVIDIA GB200 NVL72 для ИИ-кластера Colossus.

28.04.2025 [15:00], Руслан Авдеев

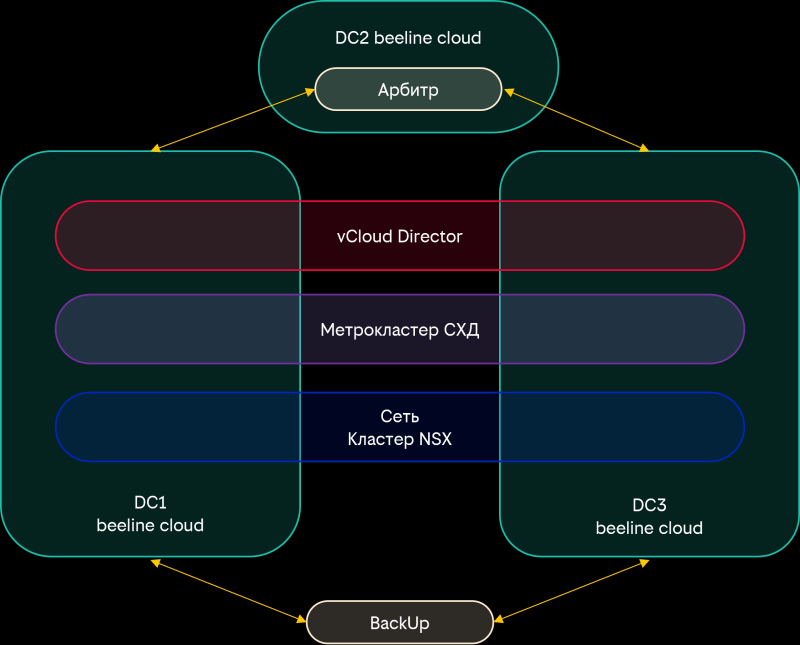

Beeline cloud объявил о доступности Cloud Compute MetroClusterОблачный оператор beeline cloud объявил о коммерческой доступности гибридной платформы Cloud Compute MetroCluster, комбинирующей преимущества частных и публичных облаков. Платформа призвана обеспечить бесперебойную работу критически важных приложений и бизнес-процессов клиентов, сообщает пресс-служба облачного провайдера. MetroCluster позволяет развёртывать IT-инфраструктуру сразу в двух московских ЦОД — данные будут немедленно дублироваться в разных хранилищах, что обеспечит максимальную отказоустойчивость. Автоматическая репликация в другой ЦОД происходит сразу при создании ВМ. Если в одном дата-центре случится авария, доступ к клиентским сервисам сохранится. При этом платформа совместима со сторонними облачными площадками и приложениями, включая и beeline cloud. Покупка оборудования для развёртывания сервисов не потребуется, инфраструктура будет обеспечена благодаря beeline cloud. Дополнительно оператор обещает гарантии повышенной безопасности благодаря хранению информации клиентов на территории России. Кроме того, инфраструктура соответствует требованиям 152-ФЗ «О персональных данных» и ГОСТ Р 56939. Предложение рассчитано на крупный и средний бизнес, в том числе банки и страховые компании, телеком-операторов и организации госсектора, а также промышленные предприятия и др. Как заявляют в beeline, MetroCluster «гарантирует 99,95% SLA по бесперебойности и снижает CAPEX за счёт оплаты по подписке без капитальных затрат». Кром того, предусмотрена поддержка миграции существующих систем, клиентами предлагается «гибкая» тарифная схема.

28.04.2025 [07:54], Сергей Карасёв

SambaNova уволила 15 % персонала и переключилась на инференс в облакеРазработчик ИИ-ускорителей SambaNova, по сообщению EE Times, проводит реорганизацию, направленную на трансформацию бизнеса. Стартап, в частности, намерен сосредоточиться на предоставлении облачных услуг в сфере ИИ, включая, ресурсы для инференса. SambaNova была основана в 2017 году. Актуальный ИИ-ускоритель компании SN40L RDU (Reconfigurable Dataflow Unit) объединяет два крупных чиплета, которые оперируют 520 Мбайт SRAM-кеша, 1,5 Тбайт DDR5 DRAM и 64 Гбайт HBM3. Восьмипроцессорная система на базе SN40L, по заявлениям SambaNova, способна запускать и обслуживать ИИ-модели с 5 трлн параметров и глубиной запроса более 256k. Осенью прошлого года SambaNova объявила о запуске самой быстрой на тот момент облачной платформы для ИИ-инференса. В этом вопросе она соревнуется с Cerebras и Groq, ещё двумя заметными стартапами, которые пытаются составить конкуренцию NVIDIA. Стоит отметить, что Groq также сменила бизнес-подход, отказавшись от продажи отдельных ускорителей в пользу оснащения целых ИИ ЦОД для инференса.

Источник изображения: SambaNova В рамках реорганизации SambaNova сократила численность персонала примерно на 15 %: уволены 77 из 500 сотрудников. Отмечается, что масштабные коммерческие ИИ-нагрузки смещаются от обучения в сторону инференса. В результате стартапы в сфере ускорителей и другого ИИ-оборудования для дата-центров переключились на предоставление обалчного доступа к LLM посредством API. «Мы оперативно переориентировались на предоставление облачных решений, которые помогают предприятиям и разработчикам развёртывать открытые ИИ-модели в масштабе. В рамках трансформации операций пришлось принять трудное решение о сокращении примерно 75 сотрудников и сместить фокус команды для поддержания следующего этапа роста», — заявили представители SambaNova.

26.04.2025 [13:12], Владимир Мироненко

Alphabet в полтора раза нарастил квартальную прибыль и подтвердил планы потратить $75 млрд на ИИ-инфраструктуруGoogle утверждает, что огромные капиталовложения в ЦОД в последние годы оказывают большее давление на её баланс из-за растущих амортизационных расходов. Несмотря на это, компания по-прежнему планирует направить в 2025 году $75 млрд на развитие ИИ-инфраструктуры, включая развёртывание и модернизацию ЦОД, пишет The Register. Подводя итоги I квартала 2025 года, финансовый директор холдинга Alphabet Анат Ашкенази (Anat Ashkenazi) сообщила, что компания за три месяца израсходовала «технической инфраструктуры» $17,2 млрд. Она отметила, что крупнейшими были «инвестиции в серверы, за которыми следуют ЦОД» для поддержки подразделений поиска, облака и DeepMind, занимающегося ИИ-технологиями. Google владеет и управляет 135 ЦОД по всему миру и прибегает к помощи поставщиков услуг колокации. Тем не менее, признала финансовый директор, компании по-прежнему не хватает мощностей, чтобы полностью удовлетворить спрос клиентов. «Мы находимся в условиях ограниченного предложения по отношению к спросу, и, учитывая, что доходы зависят от сроков развёртывания новых мощностей, мы можем наблюдать колебания темпов роста доходов от облачных технологий в зависимости от развёртывания мощностей каждый квартал», — отметила Ашкенази. Ашкенази напомнила аналитикам, что Google Cloud завершила 2024 год с превышением спроса со стороны клиентов над имеющимися у компании мощностями. И ситуация повторилась в отчётном квартале. «Мы ожидаем относительно более высокого развёртывания мощностей к концу 2025 года», — сообщила она, добавив, что капитальные затраты Google в 2024 году составили от $50 до $55 млрд, и в текущем календарном году компания намерена израсходовать по этой статье на 36–50 % больше. Ожидая всплеск заказов на облако и ИИ от корпоративных клиентов, Microsoft планирует направить $80 млрд на инфраструктуру в 2025 году, AWS — до $100 млрд, а Meta✴ — $60–65 млрд. Вместе с тем AWS и Microsoft пересмотрели часть планов по развитию ЦОД. ИИ — это всего лишь фактор в расширении цифровой империи Google, как и для Microsoft и AWS, но руководство компаний надеется, что эти затраты окупятся, отметил The Register. Недостатком строительства ЦОД является амортизация. Ашкенази сообщила, что рост амортизации составил за квартал примерно 31 % в годовом исчислении, и этот показатель вырастет в течение года. Alphabet получил в I квартале выручку в размере $90,234 млрд, что на 12 % больше, чем годом ранее, и выше консенсус-прогноза аналитиков, опрошенных LSEG, в размере $89,12 млрд. Реклама принесла холдингу $66,88 млрд, что на 8,5 % больше, чем годом ранее, когда доход от рекламы составил $61,66 млрд. Чистая прибыль Alphabet выросла на 46 % до $34,54 млрд или $2,81 на акцию при прогнозе от LSEG в размере $2,01 на акцию. Выручка облачного подразделения Google Cloud увеличилась на 24 % до $12,26 млрд, что чуть меньше прогноза аналитиков, опрошенных StreetAccount, в размере $12,27 млрд. Операционная прибыль Google Cloud выросла до $2,17 млрд с $900 млн годом ранее.

23.04.2025 [16:15], Руслан Авдеев

GPU под роспись: Amazon резко ужесточила использование дефицитных ИИ-ускорителей внутри компании в рамках Project GreenlandВ прошлом году ретейл-бизнес Amazon столкнулся с острой нехваткой ИИ-ускорителей для внутреннего пользования. Это привело к задержкам при реализации ключевых проектов. На фоне глобального бума ИИ-технологий и дефицита чипов NVIDIA компания вынужденно пересмотрела принципы доступа к ускорителям для собственных нужд, сообщает Business Insider. В июле 2024 года началась реализация т. н. Project Greenland. Фактически речь идёт о платформе для централизованного распределения ресурсов ускорителей. Платформа позволяет отслеживать их использование, перераспределяет мощности в случае простоя и даёт возможность оперативно реагировать на изменения спроса. Теперь все заявки на доступ к ускорителям подаются только через Greenland, а приоритет получают проекты с высоким уровнем возврата инвестиций (ROI), чётким графиком и заметным влиянием на снижение затрат или рост выручки. У проектов с низкой эффективностью доступ к вычислительным мощностям могут вообще отозвать в пользу более перспективных инициатив. Amazon выделила восемь принципов распределения ускорителей среди сотрудников компании:

Источник изображения: Centre for Ageing Better/unsplash.com Amazon уже активно использует искусственный интеллект в различных проектах. В числе ключевых инициатив:

По оценкам Amazon, ИИ-проекты розничного подразделения в 2024 году принесли $2,5 млрд операционной прибыли, попутно сэкономив $670 млн. В 2025 году ретейл-подразделение Amazon намерено вложить $1 млрд в ИИ-проекты розничного сегмента и увеличить расходы на облако AWS до $5,7 млрд (с $4,5 млрд в 2024 году). Если во II полугодии 2024 года розница Amazon нуждалась в более 1 тыс. дополнительных инстансов P5 с NVIDIA H100, то в 2025 году ситуация, как свидетельствуют внутренние прогнозы, должна стабилизироваться. А к концу года внутренние запросы полностью удовлетворят с помощью чипов собственной разработки Amazon Tranium, «но не раньше». Тем не менее, в Amazon не теряют бдительности, постоянно задаваясь вопросом: «Как получить больше ускорителей?».

23.04.2025 [11:00], Сергей Карасёв

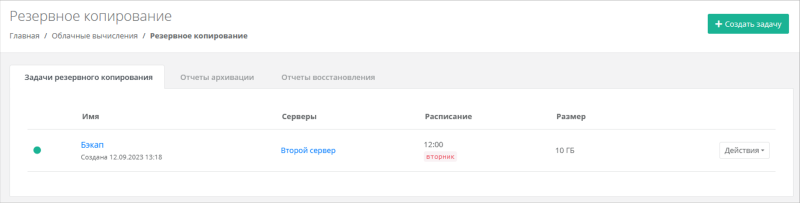

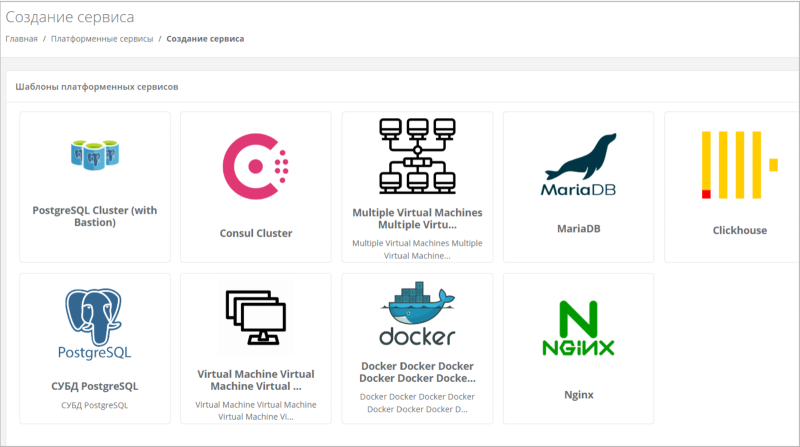

«Базис» представляет обновленный Basis Dynamix Cloud Control для комплексного управления облачной инфраструктуройКомпания «Базис», лидер российского рынка виртуализации, объявляет о выходе обновления платформы для комплексного управления облачной инфраструктурой Basis Dynamix Cloud Control. В релиз 5.1 вошло более 30 улучшений, серьёзно расширяющих возможности решения в части управления инфраструктурными (IaaS) и платформенными (PaaS) сервисами, в том числе автоматизации рутинных операций. Решение Basis Dynamix Cloud Control подходит для государственных и коммерческих организаций с разветвлённой сетью региональных офисов, для компаний со сложной инфраструктурой и большим количеством внутренних сервисов, а также для облачных провайдеров, предоставляющих сервисы по модели IaaS, PaaS, SaaS, K8SaaS. Basis Dynamix Cloud Control позволяет заказчику управлять федеральной сетью виртуальных центров обработки данных (вЦОД) из единой панели, предоставляя полный цикл управления виртуальными сервисами и инфраструктурой, возможности самообслуживания пользователей и автоматизированную систему выделения и учёта ресурсов. Стабильность инфраструктуры и сохранность данныхВ Basis Cloud Control 5.1 появились инструменты развёртывания и управления кластерами высокой доступности, что исключает простои сервисов даже при отказе отдельных узлов инфраструктуры. Дополнительную стабильность обеспечивает новый механизм контроля обязательных версий оркестратора, который автоматически проверяет совместимость компонентов, снижая таким образом риски сбоя при обновлении системы. Логи установки и обновления оркестратора теперь собираются в файл. Также в Basis Dynamix Cloud Control реализована расширенная система резервного копирования с возможностью задания конкретных дат в расписании, оптимизированы логи. Гибкое управление сетевой инфраструктуройС новой версией Basis Dynamix Cloud Control можно гибко управлять скоростью интернет-трафика для виртуальных машин — это помогает выделить нужную полосу пропускания для важных сервисов и оптимизировать затраты на каналы связи. Также добавлена балансировка UDP-трафика для крупнейших платформ виртуализации: российской Basis Dynamix Enterprise и зарубежной VMware vSphere. Запуск и управление сервисами PaaSВ Basis Dynamix Cloud Control 5.1 реализована поддержка заказа и развёртывания платформенных сервисов (PaaS) на Basis Dynamix и VMware vSphere. Спрос на такие решения в России растёт: по данным iKS-Consulting, в 2024 году сегмент PaaS увеличился на 59% до почти 33 млрд руб. и постепенно догоняет IaaS. «Платформа-как-сервис» позволяет не тратить время на развёртывание, настройку и поддержку серверов, установку ОС и т.д. Достаточно арендовать уже настроенную платформу с, например, развёрнутой базой данных или инструментами мониторинга, и можно начинать работу. Заказчикам Basis Cloud Control доступно автоматизированное управление:

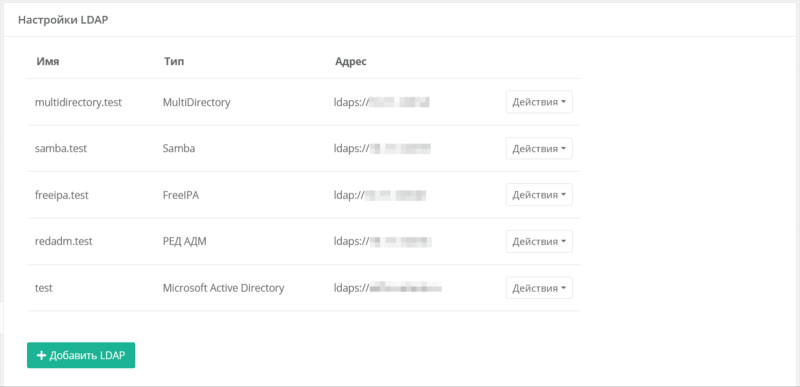

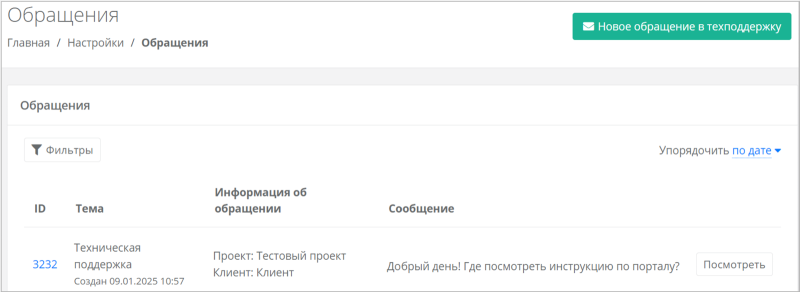

Расширенные возможности автоматизации и интеграцииОбновлённый Basis Dynamix Cloud Control предлагает несколько дополнительных инструментов автоматизации работы администратора, например, развёртывание виртуальных машин через config-drive. В целом, для облегчения работы специалистам заказчика доступны поддержка Infrastructure as Code (IaC) с помощью Terraform/OpenTofu, открытое REST API, интеграция с системами мониторинга и Telegram-ботом, а также SDK на языках Python и Go для разработки решений под индивидуальные задачи. Перечисленные инструменты позволяют значительно ускорить и упростить развёртывание сложных инфраструктур, а также интегрировать Basis Cloud Control с существующей экосистемой ИТ-решений заказчика. Усиление безопасности и контроля доступаВ релизе 5.1 реализованы отображение и управление сервисными учётными записями из интерфейса портала и автоматическое назначение тегов для учётных записей, полученных из LDAP. В целом, Basis Dynamix Cloud Control поддерживает двухфакторную авторизацию через телефон, электронную почту, одноразовый пароль и Telegram, интеграцию с LDAP (включая Active Directory, FreeIPA, Samba DC) с автоматическим назначением тегов, журналирование действий пользователей и настройку жизненного цикла логов. Это позволяет организациям обеспечить строгий контроль доступа к облачным ресурсам и соответствие требованиям информационной безопасности. Оптимизация расходов и управление ресурсамиBasis Dynamix Cloud Control 5.1 предоставляет инструменты для задания лимитов ресурсов на проекты и клиентов, гибкую тарификацию потребления ресурсов в различных временных интервалах, автоматическую генерацию отчётов с доставкой по электронной почте в форматах XLSX или CSV. Эти возможности помогают оптимизировать затраты на облачную инфраструктуру и обеспечить эффективное распределение ресурсов. Удобство администрирования и самообслуживанияУправлять запросами к технической поддержке стало проще — создан специальный раздел «Обращения», где пользователь видит все заявки и их статусы. За счёт использования шаблонов с предустановленным ПО ускорено создание новых виртуальных серверов, причём каждое подразделение теперь видит только релевантные для него шаблоны. В результате пользователи быстрее получают необходимые ресурсы, а администраторы тратят меньше времени на рутинные задачи. «Заказчиками наших инфраструктурных продуктов являются компании, реализующие крупнейшие государственные и коммерческие сервисы, которыми пользуются миллионы людей. Это накладывает на нас серьёзные обязательства в части гибкости и стабильности работы наших решений, поэтому мы уделяем этим характеристикам особое внимание. В релизе Cloud Control 5.1 мы сосредоточились на реализации кластеров высокой доступности и повышении надёжности инфраструктуры под управлением наших продуктов, чтобы минимизировать для клиентов риск сбоев и время простоя в работе сервисов», — отметил Дмитрий Сорокин, технический директор компании «Базис».

19.04.2025 [02:15], Руслан Авдеев

Linux — это дорого и сложно: AWS и Google Cloud заявили, что вырваться из экосистемы Microsoft невероятно трудно

aws

google cloud platform

microsoft

microsoft azure

software

sql server

windows server

великобритания

конкуренция

лицензия

миграция

облако

Компании, вложившие большие средства в ПО Microsoft, буквально не могут покинуть принадлежащее последней облако Azure, чтобы перейти в AWS или Google Cloud Platform вместо собственных серверов. Использовать ПО гиганта из Редмонда в облаках сторонних провайдеров из-за лицензионной политики Microsoft очень дорого, но и переписывать ПО для Linux, возможно, ещё дороже, сообщает The Register. AWS и Google пожаловались в британское Управление по конкуренции и рынкам (CMA), ведущее расследование ситуации на облачном рынке страны, что клиенты столкнулись с дилеммой — либо использовать Azure, либо платить в четыре раза больше за запуск приложений под Windows Server и SQL Server в сторонних облаках. В 2019 году Microsoft ввела систему «запретительного» лицензирования, начав требовать отдельные лицензии для работы Windows Server и SQL Server в облаках Amazon, Google и Alibaba. Простейшим решением был бы переход клиентов на Linux, но зачастую они вложили немало средств в экосистему Microsoft и выбирать им не приходится — они «очень зависимы» от Windows и других продуктов. Google жалуется на искусственно созданную Microsoft привязку к Windows Server и SQL Server — на модернизацию и перенос таких систем на Linux «уйдут годы и годы». Фактически придётся переписать все приложения, годами создававшиеся под экосистему Microsoft. По данным Google, у некоторых компаний на подобную миграцию действительно уходило по несколько лет, что сказалось на ценах для конечных пользователей. У многих организаций просто нет ресурсов для таких «реформ». Кроме того, использующие Windows Server на собственном оборудовании и желающие перебраться в облако компании из-за стоимости лицензий фактически не имеют выбора — миграция в Azure для них будет значительно дешевле, чем в другие облака. AWS также согласна с тем, что переход на Linux и другое облако для многих клиентов Azure — это очень дорогая, часто экономически неоправданная задача. По подсчётам Google, 70–80 % выручки Azure поступает от клиентов, использующих Windows Server и SQL Server. Таким образом, говорит Google, конкретно это ПО — «критически важная часть» облачного рынка. Google и AWS хотят, чтобы CMA решила вопрос с неконкурентным ценообразованием Microsoft. Британский регулятор предварительно уже решил, что такое поведение компании действительно не соответствует правилам «здорового» рынка. В самой Microsoft считают, что в удержании клиентов при переходе с on-premise в облако нет ничего противоправного. По её мнению, при подходе к ценообразованию SPLA она соблюдает баланс, прося «не слишком мало, но и не слишком много». Кроме того, компания предлагает Linux-версию SQL Server. Окончательное решение CMA должно вынести 4 июля. В числе прочих расследуемых проблем — комиссии за перенос данных (egress fees) и технические барьеры при переходе из облака в облако. В самом CMA больших проблем в этом не видят, но малые облачные провайдеры не согласны, считая, что подобные препятствия на руку лишь гиперскейлерам. Формально «штрафы» за перенос данных в другое облако «большая тройка» отменила. Вот только Amazon не требует при миграции отказываться от всех сервисов и закрывать аккаунты, а Microsoft и Google — требуют.

18.04.2025 [15:47], Владимир Мироненко

Cloud.ru представил первый в России управляемый облачный сервис для инференса ИИ-моделей — Evolution ML InferenceПровайдер Cloud.ru представил Evolution ML Inference — первый, по словам компании, в России управляемый облачный сервис для инференса больших языковых моделей (LLM), который позволит эффективно управлять вычислительными ресурсами. С его помощью клиенты смогут помимо моделей GigaChat от Cloud.ru запускать и развертывать собственные ИИ-модели, а также open source модели из библиотеки Hugging Face на базе облачных ускорителей. Это полностью управляемый сервис — пользователю достаточно настроить конфигурацию, модель и тип масштабирования, Cloud.ru предоставит доступ к мощным ускорителям, а также будет отвечать за полное администрирование и обслуживание инфраструктуры. Сервис отличается простотой и гибкостью управления, что позволяет запускать модели без необходимости сборки образа напрямую из Hugging Face, а также запускать собственные образы со своим окружением. Благодаря поддержке технологии Shared GPU, позволяющей распределять GPU-ресурсы с учётом потребления количества vRAM, необходимого для эффективной работы модели без задержек, а также с возможностью динамически перераспределять ресурсы в зависимости от текущих потребностей, сервис обеспечивает повышение утилизации мощностей в ИИ-проектах от 15 до 45 % в сравнении со сценарием, когда GPU используется целиком. Тем самым обеспечивается высокая степень адаптации и рациональное использование доступных ресурсов с одновременным запуском нескольких моделей на одном GPU. «Это делает технологию наиболее оптимальной для распределённых систем с разнородной вычислительной инфраструктурой и помогает эффективно масштабировать нагрузку», — отметила Cloud.ru. Ещё одно отличие сервиса — поддержка режима скайлирования (эффективного масштабирования), когда оплата за использование модели начисляет только с момента обращения к ней. По оценкам Cloud.ru, около 70 % заказчиков используют GPU-ресурсы, зарезервированные под инференс в процессе эксплуатации ML-моделей, менее чем на 55 %. При внедрении ИИ в большинстве случаев базой становится именно среда исполнения модели. Поэтому для рационального использования ресурсов и оптимизации затрат при обработке ИИ-нагрузок, особенно генеративного ИИ, необходима производительная инфраструктура с гибким масштабированием в реальном времени, отметил глава Cloud.ru.

18.04.2025 [15:17], Руслан Авдеев

Из-за политики США европейские пользователи задумались об уходе из американских облаковЕвропейские пользователи облачных сервисов становятся всё менее лояльны американским гиперскейлерам в условиях геополитической неопределённости — некоторые региональные европейские облака сообщают о росте спроса со стороны «соотечественников», сообщает The Register. После года «зацикливания» на ИИ-тематике, акцент сместился на обсуждение политики США. Даже до начала недавней, весьма опасной игры с пошлинами, европейские пользователи уже задавались вопросом, так ли необходимо включать базирующихся в США гиперскейлеров в свои бизнес-цепочки. По словам британского облачного провайдера CIVO, перемены происходят на удивление быстро — в компании всё ещё «ошеломлены» скоростью роста интереса к альтернативным облакам. Nextcloud говорит, что интерес к её сервисам вырос втрое, причём не только из-за действий самого президента США, но и его администрации в целом. В частности, Nextcloud обвиняет американскую сторону в «ненадёжности» и возможном росте цен из-за пошлин. Более того, на повестке появился даже фактор шпионажа — Илона Маска (Elon Musk) и департамент DOGE обвиняют в доступе к по-настоящему конфиденциальным базам (о том, что США регулярно следили даже за союзниками десятилетиями, не упоминается). Частный облачный оператор Vultr (американского происхождения) с площадками по всему миру тоже отметил рост интереса к суверенной инфраструктуре — правительства и организации желают знать, где хранятся, обрабатываются и резервируются их данные, как они используются. Теперь же опасения только усилились, поскольку нет ясности, как будут развиваться экономические отношения между сторонами. При этом уйти от гиперскейлеров непросто и на это могут уйти месяцы или даже годы, а приступать к переходу следует поэтапно, после того как найдутся альтернативные провайдеры. Впрочем, в Nextcloud сообщают, что некоторые организации, которым «по-настоящему угрожает» американский режим, запросили компанию о более быстром переходе. В Open Infrastructure Foundation подтверждают, что интерес к альтернативным облакам действительно резко вырос, хотя до этого разговоры о переходе велись годами. Ситуацию некоторые эксперты сравнили с покупкой VMware в 2023 году, когда для многих клиентов последней цена лицензий значительно выросла и отголоски до сих пор ощущаются в IT-индустрии, а многие клиенты начали лихорадочно искать альтернативы. Многие эксперты уверены, что с правильной мотивацией переход от американских гиперскейлеров вполне возможен, а мотивация именно сейчас как раз присутствует. Конечно, интерес ещё не значит, что все, выразившие его, обязательно мигрируют к европейским облачным провайдерам, но саму тенденцию уже невозможно не замечать. В октябре 2024 года сообщалось, что Евросоюзу не хватает мощностей ЦОД для обретения суверенного ИИ. Впрочем, строительством суверенных облаков для Европы занялись как гиперскейлеры вроде AWS и Microsoft, так и местные игроки, развивающие, например, суверенную платформу Virt8ra.

18.04.2025 [08:56], Руслан Авдеев

AWS: облако Azure лишится половины нагрузок, как только Microsoft ослабит политику лицензирования своего ПО

aws

google cloud platform

microsoft

microsoft azure

software

великобритания

конкуренция

лицензия

облако

По оценкам AWS, облако Microsoft Azure лишилось бы половины нагрузок корпоративных клиентов, если бы не «заградительные пошлины» на уход от редмондской компании. Заявление фигурирует в очередной жалобе Управлению по конкуренции и рынкам Великобритании (CMA) в рамках расследования Cloud Services Market Investigation, сообщает The Register. С 2019 года использование Windows Server и ряда других продуктов в облаках прямых конкурентов Microsoft вчетверо дороже, чем в Azure. Сама Microsoft не видит в этом никакой проблемы. В AWS утверждают, что такая практика лицензирования Microsoft вредит конкуренции и облачному рынку Великобритании. При этом в компании уверены, что Microsoft не имеет убедительных оправданий для подобных изменений, искусственно завышая цены. Google поддерживает AWS в данном вопросе, а заодно подала аналогичную жалобу регуляторам Евросоюза, да и в целом пытается сколачивать союзы против конкурента. AWS и Google опасаются, что более высокие цены на ПО Microsoft при использовании в чужих облаках коммерчески «привязывают» клиентов к компании. В AWS подчёркивают, что Microsoft доминирует на некоторых сегментах рынка ПО, поэтому клиенты, желающие использовать их в облаке, фактически зависимы от Azure. Кроме того, некоторые «неценовые» ограничения также мешают использовать софт компании в чужих облаках. В частности, BYOL-политика Microsoft заставляет заново покупать лицензии на уже приобретённое ПО, если у клиента появится желание перейти в отличные от Azure облака.

Источник изображения: Felix Mittermeier/unsplash.com CMA инициировало расследование ситуации на британском облачном рынке в 2023 году. Оно всё ещё продолжается, хотя предварительные выводы уже сделаны и в них Microsoft действительно признана злоупотребляющей доминирующим положением (впрочем, досталось и AWS). CMA также считает, что стратегия Microsoft даёт ей возможность «частично блокировать» AWS и Google, что вредит конкуренции. Microsoft в ответ заявила, что вмешательство CMA грубо нарушит права компании на интеллектуальную собственность и что в отрасли никто ещё не сталкивался с подобной несправедливостью. Теперь AWS утверждает то, что многие пользователи уже сегодня выбрали бы перенос ПО Microsoft в облако AWS, поскольку «хотят и могут». Возможно, 50 % таких нагрузок мигрировало бы из Azure куда-либо ещё, если бы это было экономически целесообразно. От Microsoft требуют отказаться от непомерных лицензионных сборов и других «неценовых» ограничений. Кроме того, даже клиентам Azure приходится платить больше из-за отсутствия конкуренции. Впрочем, в AWS признали, что трудно оценить, сколько клиентов остались бы в Azure, если бы имели возможность уйти, не теряя денег.

Источник изображения: Felix Mittermeier/unsplash.com Google в целом поддерживает позицию AWS и предлагают запретить Microsoft ставить неприемлемые условия лицензирования своего ПО в Google Cloud Platform, заставить отказаться от других практик привязки пользователей к своим сервисам и запретить Microsoft ограничивать третьим сторонам возможность продажи лицензий на её ПО для использования в Google Cloud. Microsoft не согласна ни с CMA, ни с конкурентами, считая, что решения регулятора об ограничениях ПО слишком расплывчаты, в том числе относительно определений того, почему вдруг прибыли AWS и Google в данном контексте посчитали слишком низкими. Кроме того, компания вовсе не против использования Windows Server и SQL Server в облаках AWS и Google, поскольку это тоже приносит деньги и важно для бизнеса. При этом в компании подчёркивают, что не хотят делать цену за использования ПО слишком низкой, но вот если бы она была чересчур высокой, то клиенты уже перешли бы на альтернативные программные платформы. По мнению Microsoft, AWS и Google зарабатывают достаточно, чтобы успешно конкурировать с ней, так что создавать им дополнительные преимущества нецелесообразно. |

|