Материалы по тегу: ии

|

12.02.2025 [18:52], Руслан Авдеев

С козырей: Франция выделит гигаватт на создание «атомного» ИИ-кластераВ попытке догнать лидеров рынка ИИ Франция намерена опереться на развитую атомную энергетику. Власти страны выделят гигаватт для нового ИИ-проекта, который, по оценкам инвесторов и правительства, обойдётся в десятки миллиардов долларов, сообщает The Wall Street Journal. В сочетании с другими проектами, в основном финансируемыми ближневосточными фондами, возможности развития ИИ-вычислений во Франции и Европе значительно расширятся. В рамках новой «атомной» инициативы к концу 2026 года будет ИИ ЦОД получит первые 250 МВт. Это позволит конкурировать с американским проектом Stargate, поддерживаемым OpenAI, SoftBank и другими компаниями. Проект в США начинается с кампуса на 200 МВт с возможностью расширения до 1,2 ГВт. По данным компании FluidStack, ответственной за новый «атомный» ИИ-кластер, строительство начнётся в III квартале 2025 года. Но пока нет гарантий, что проект будет продвигаться как задумано и получит достаточно средств и чипов. Для финансирования первого этапа будут использованы собственные средства и кредиты на сумму €10 млрд ($10,3 млрд). Также было объявлено, что ведутся переговоры с одним из крупнейших в мире разработчиков ИИ об использовании нового объекта, способного вместить порядка 120 тыс. ускорителей NVIDIA. На днях Францию посетил глава OpenAI Сэм Альтман (Sam Altman). К 2028 году количество ускорителей в кластере может вырасти до 500 тыс., а к 2030 году площадка может расшириться до 10 ГВт. Большая часть средств уйдёт на ИИ-ускорители NVIDIA. FluidStack сообщила, что находится в постоянном контакте с NVIDIA, которая якобы обещала поставить продукцию сразу, как та понадобится. Ранее также сообщалось о намерении Франция и ОАЭ вложить до €50 млрд в гигаваттный ИИ ЦОД. Всего же было объявлено об инвестициях в ИИ-сектор Франции €109 млрд. Франция располагает 57 реакторами на 18 АЭС — две трети энергии в стране вырабатывается именно ими. В 2024 году она сгенерировала приблизительно на 20 % больше электроэнергии, чем использовала сама, экспортировав избытки. Французская государственная энергоснабжающая компания EDF (Électricité de France) ещё в прошлом году объявила, что готова предоставить энергию и землю трём гигаваттным ИИ ЦОД. Если проект FluidStack реализуют, как задумано, баланс сил на рынке ИИ может частично измениться в пользу Франции и Евросоюза вообще. Некоторые европейские компании, включая французскую Mistral AI, занимаются передовыми разработками, но в целом Европа в основном отстаёт от американских и китайских компаний, хотя и попытается наверстать упущенное, направив на развитие ИИ-технологий €200 млрд. Появление экономичных, но эффективных моделей китайской DeepSeek, вызвало большие сомнения в необходимости больших кластеров чипов, что временно обрушило фондовый рынок в сфере, связанной с ИИ-проектами. Тем не менее все игроки, от Blackstone и Brookfield до самой NVIDIA сохраняют оптимизм, ожидая, что высокопроизводительным моделям понадобится ещё больше чипов и ЦОД.

12.02.2025 [00:50], Владимир Мироненко

AMD и французские атомщики вместе займутся развитием технологий для ИИ-инфраструктур будущегоAMD объявила о подписании соглашения о намерениях с французским Комиссариатом по атомной энергии и альтернативным источникам энергии (CEA) с целью совместной работы над созданием передовых технологий, компонентов и системных архитектур, которые определят будущее ИИ-вычислений. Сотрудничество позволит использовать сильные стороны обеих организаций в разработке энергоэффективных систем и технологий для вычислительной инфраструктуры следующего поколения, необходимых для поддержки самых ресурсоёмких в мире рабочих ИИ-нагрузок в различных областях — от энергетики до медицины. AMD и CEA планируют провести в 2025 году симпозиум, посвящённый будущему ИИ-вычислений, который соберёт европейских и глобальных разработчиков технологий, стартапы, суперкомпьютерные центры, университеты и политиков с целью укрепления сотрудничества в разработке современных вычислительных технологий ИИ. В CEA отметили, что сотрудничество с AMD является значительным шагом на пути к укреплению международного партнёрства в области HPC, позволяя объединить экспертные знания мирового уровня для удовлетворения растущих потребностей в обслуживании ИИ-нагрузок. В свою очередь, в AMD подчеркнули, что в сотрудничестве с CEA и ведущими французскими инженерами компания стремится приблизить передовые исследования в области ИИ к реальным приложениям, развивая системные архитектуры, которые отвечают требованиям будущих рабочих нагрузок, одновременно расширяя возможности для совместных исследований и разработок США и Франции. Большая часть электроэнергии во Франции производится АЭС, что позволяет обеспечивать внутренние потребности, а также поставлять излишки за рубеж. Франция рассматривает это как ключевой фактор для привлечения инвесторов, стремящихся развивать инфраструктуру энергоёмких ЦОД в стране. По словам президента Франции Эммануэля Макрона (Emmanuel Macron), это позволит разместить в стране 20 % всех ЦОД в мире. В понедельник Макрон объявил, что объём частных инвестиций в ИИ-сектор страны составит в ближайшие несколько лет около €109 млрд.

11.02.2025 [16:26], Руслан Авдеев

Brookfield потратит €20 млрд на ИИ-инфраструктуру во ФранцииBrookfield Asset Management намерена инвестировать во Франции €20 млрд ($20,7 млрд) в развитие дата-центров и вспомогательной ИИ-инфраструктуры. Инвестиции рассчитаны на следующие пять лет — на фоне усиливающейся конкуренции развитых стран на рынке ИИ, сообщает Bloomberg. Компания выделила €15 млрд на развитие ЦОД. Ведущим исполнителем проекта станет компания Data4, входящая в портфолио самого инвестора. Остальные средства будут потрачены на проекты ИИ-инфраструктуры — решения для передачи данных, СХД и генерацию энергии на территории Франции. В Brookfield утверждают, что Франция — прекрасное место для инфраструктуры ИИ благодаря благоприятным политическим условиям и наличию квалифицированных кадров. По словам Bloomberg, Европа отстала в гонке ИИ от США и Китая. Хотя некоторые стартапы из Франции, вроде Mistral AI SAS, привлекли значительные средства, значительными они являются только сравнении с другими европейскими коллегами, а вот конкурировать с лидерами отрасли им нелегко. Поэтому Франция развернула активную деятельность по инвестированию в ИИ-сектор — на днях было объявлено о привлечении €109 млрд. Инвестиции Brookfield входят в эту сумму.

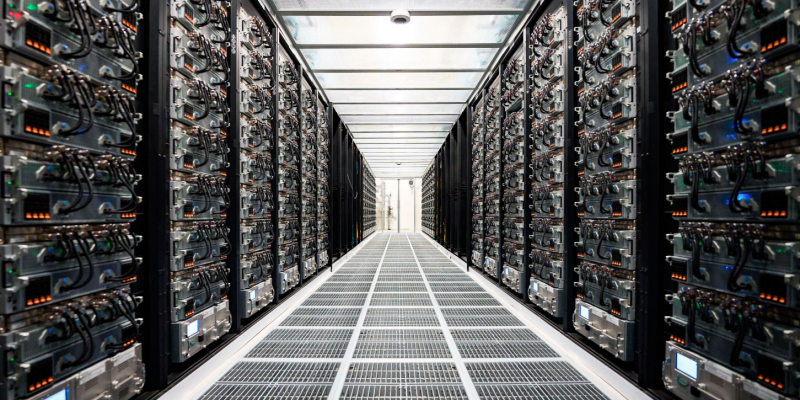

Источник изображения: Anthony Tan/unsplash.com Brookfield, открывшая представительство в Париже в декабре 2024 года, располагает в стране активами на $30 млрд и намерена увеличить их вдвое в следующие пять лет. По всему миру компания инвестировала €150 млрд в цифровую инфраструктуру, возобновляемую энергетику и производство чипов. Недавно сообщалось, что даже триумф технологий китайского стартапа DeepSeek, сумевшего обойтись малыми вычислительными ресурсами для создания эффективной ИИ-модели, не поколебал уверенности Brookfield в необходимости инвестировать в рынок ЦОД. В компании сообщили, что и ранее ожидали качественного скачка в развитии ИИ, но дата-центры по-прежнему будут востребованы за счёт расширения сфер применения искусственного интеллекта.

11.02.2025 [16:24], Владимир Мироненко

ИИ ЦОД за 20 недель: G42 и DataOne построят крупнейший во Франции суперкомьютер на чипах AMD InstinctХолдинг G42 из Абу-Даби (ОАЭ) объявил о стратегических инвестициях во Франции в партнёрстве с недавно образованной DataOne, которая сама себя называет первым в Европе оператором гига-ЦОД для ИИ. Вместе компании в кратчайшие сроки построят в Гренобле ИИ ЦОД, оснащённый ускорителями AMD Instinct. Ожидается, что объект будет полностью введён в эксплуатацию к середине 2025 года. Вычислительные возможности нового ЦОД позволят французским компаниям и учёным разрабатывать передовые модели ИИ, агентов и приложения, а также проводить различные исследования. Реализацией проекта будет заниматься компания Core42, дочернее предприятие G42, совместно с DataOne. По словам главы DataOne Шарля-Антуана Бейни (Charles-Antoine Beyney), на развёртывание крупнейшего ИИ-суперкомпьютера в Европе потребуется всего 20 недель. Для сравнения: кластер xAI Colossus был построен за 122 дня. Как заявила Лиза Су (Lisa Su), председатель и генеральный директор AMD, стратегическое сотрудничество с G42 поможет активизировать французскую экосистему ИИ, предоставив вычислительную мощность, необходимую для поддержки местных стартапов и новаторов, занимающихся передовыми разработками, которые укрепляют французскую экономику. «Работа с G42 является ещё одним примером нашей приверженности объединению открытых экосистем с ведущими в отрасли технологиями ИИ AMD, что обеспечивает возможность государственным учреждениям и частным предприятиям использовать весь потенциал ИИ», — подчеркнула Лиза Су. Инвестиции G42 входят в пакет частных инвестиций в ИИ-инфраструктуру страны на €109 млрд, анонсированный президентом Франции Эммануэле Макроном (Emmanuel Macron) в качестве ответа на представленный в США проект Stargate. Ранее было объявлено о планах ОАЭ вложить при участии фонда MGX €30–50 млрд в проект по созданию кампуса ИИ ЦОД во Франции. В G42 называют инвестиции в ИИ одним из главных направлений своей деятельности. Деятельность холдинга получила поддержку Microsoft, инвестировавшей в него $1,5 млрд. В прошлом году G42 договорился с Cerebras о строительстве в Техасе ИИ-суперкомпьютера со 173 млн ядер.

11.02.2025 [15:05], Руслан Авдеев

Илон Маск предложил купить OpenAI за $97,4 млрд, Сэм Альтман в ответ предложил купить Twitter за $9,74 млрдИнвестиционный консорциум, возглавляемый Илоном Маском (Elon Musk) предложил $97,4 млрд, чтобы выкупить некоммерческую организацию, контролирующую OpenAI. Это повышает шансы Маска в битве за компанию, сообщает The Wall Street Journal. Юрист миллиардера сообщил, что заявка на все активы НКО подана совету директоров OpenAI. Глава OpenAI Сэм Альтман (Sam Altman) в ответ предложил купить X (Twitter) за $9,74 млрд. Это может поставить крест на планах Альтмана относительно будущего OpenAI, в том числе превращения компании в коммерческую организацию и $500-млрд проекта Stargate. Маск и Альтман уже участвуют в судебной тяжбе, призванной определить путь дальнейшего развития OpenAI — Маск считает, что компании пришло время вернуться к открытости, как это было когда-то. Маск и Альтман были среди сооснователей OpenAI, которая появилась в 2015 году как «благотворительная» организация. После того, как Маск в 2019 году покинул компанию, Альтман стал генеральным директором, а OpenAI создала коммерческую дочернюю структуру, которая служит инструментом привлечения средств Microsoft и других инвесторов. Сейчас Альтман пытается превратить дочернюю структуру в самостоятельную компанию, в которой НКО владела бы лишь долей. Пока неизвестно, как будет оцениваться «некоммерческая» часть проекта. Предложение Маска задаёт высокую планку и может означать, что сам миллиардер или тот, кто будет управлять НКО, возможно, получит и контрольный пакет новой, «коммерческой» OpenAI. Не исключено, что контролируемая Маском xAI может объединиться с OpenAI после сделки. Маска поддерживают Valor Equity Partners, Baron Capital, Atreides Management, Vy Capital и 8VC, а также другие структуры. Все они готовы выделить больше средств, если кто-то предложит большую сумму за OpenAI. Маск уже подал ряд судебных исков, обвинив OpenAI в «предательстве» первоначальной миссии некоммерческого характера после создания коммерческого подразделения и, как он считает, сговора с крупнейшим инвестором Microsoft для получения доминирующих позиций на рынке ИИ. В январе представитель Маска обратился в государственные органы с просьбой открыть торги для того, чтобы определить справедливую рыночную стоимость НКО. Маск и его единомышленники опасаются, что OpenAI может сознательно занизить стоимость НКО в ходе реструктуризации. В самой OpenAI утверждают, что все обвинения Маска беспочвенны и НКО в своё время получит эквивалентную долю в коммерческой организации. В декабре компания публиковала документы, свидетельствовавшие о том, что Маск сам стремился превратить OpenAI в коммерческую организацию, но позже отказался от этой идеи, поскольку не мог получить контроль над компанией. Для Альтмана важно сохранить контроль над активами, так как это нужно для реализации масштабного ИИ-проекта Stargate, предусматривающего инвестиции в объёме $500 млрд в американские ЦОД за четыре года. Маск заявил, что у инвесторов Stargate нет столько денег, а Альтмана буквально обозвал «мошенником». OpenAI уже столкнулась с серьёзными препятствиями на пути преобразования некоммерческой организации в коммерческую. В декабре Meta✴ Platforms направила письмо генеральному прокурору Калифорнии, выразив несогласие с планом, а OpenAI увязла в переговорах с Microsoft и другими инвесторами о том, какие доли они должны получить в новой компании. Тем не менее OpenAI обещала завершить переход к концу 2026 года. После раунда финансирования в объёме $6,6 млрд в октябре 2024 года, компания была оценена в $157 млрд. Также сообщалось, что компания ведёт переговоры о дополнительном раунде финансирования на $40 млрд, который поднял бы её цену до более $300 млрд. Предполагалось, что раунд возглавит японская SoftBank с $40 млрд. По отдельности OpenAI и SoftBank пытаются привлечь миллиарды долларов для Stargate, но выполнение задач может осложниться из-за неопределённости будущего компании, связанной с заявкой Маска и его партнёров.

11.02.2025 [13:47], Руслан Авдеев

Tesla запустила суперкомпьютер Cortex с 50 тыс. ускорителей NVIDIA H100, а общие затраты компании на ИИ уже превысили $5 млрдКомпания Tesla завершила ввод в эксплуатацию ИИ-кластера из 50 тыс. ИИ-ускорителей NVIDIA H100 в IV квартале прошлого года. В презентации для акционеров отмечалось, что кластер Cortex заработал на принадлежащем Tesla объекте Gigafactory в Остине (Техас), сообщает Datacenter Dynamics. Информация впервые появилась в отчёте компании за IV квартал и 2024 финансовый год. Новый кластер не имеет отношения к суперкомпьютеру Dojo, предназначенному для технологий автономного вождения FSD, имеющего собственную архитектуру и оснащенного кастомными чипами D1. При этом в презентации, посвящённой отчёту, Dojo не упоминается вообще. Хотя компания не уточняет, когда именно в IV квартале началось развёртывание системы, на конференции по финансовым вопросам в октябре 2024 года представитель Tesla заявил, что компания находится «на пути к развёртыванию 50 тыс. ускорителей в Техасе к концу текущего месяца». По имеющимся данным, проект реализован с опозданием, поскольку Илон Маск уволил руководителя строительством ещё в апреле, а также приказал передать xAI 12 тыс. ускорителей H100, изначально предназначавшихся Tesla.

Источник изображения: Tesla В презентации сообщается, что именно Cortex уже помог в создании «автопилота» FSD V13 (Supervised). Новая версия повысила безопасность и комфорт вождения благодаря увеличению объёма данных в 4,2 раза, повышению разрешения видеопотока, а также другим усовершенствованиям. Заодно компания сообщила о продолжении работ над программной и аппаратной частями робота Optimus, в т.ч. рук нового поколения и механизмов передвижения. Также осуществлялось обучение выполнению дополнительных задач перед началом пилотного производства в 2025 году. Что касается доходов компании в IV квартале, в конце января Илон Маск (Elon Musk) сообщил, что бизнес продолжает инвестировать в обучающую инфраструктуру за пределами штаб-квартиры в Техасе. В конце января сообщалось, что Tesla наращивает вычислительные мощности для обучения Optimus. По словам миллиардера, на обучение Optimus необходимо потратить, как минимум, в 10 раз больше ресурсов в сравнении с полноценным обучением систем автомобиля. Капитальные затраты Tesla в 2024 году составили $10 млрд, столько же компания намерена потратить в ближайшие два года, хотя большая часть затрат придётся на инфраструктуру для электромобилей. В отчёте о доходах за IV квартал упоминалось, что общие капитальные затраты компании, связанные с ИИ, включая инфраструктуру, превысили $5 млрд.

11.02.2025 [11:39], Сергей Карасёв

OpenAI близка к завершению разработки своего первого ИИ-чипаКомпания OpenAI, по сообщению Reuters, в течение нескольких месяцев намерена завершить разработку своего первого чипа для ресурсоёмких ИИ-задач. Появление этого изделия, как ожидается, поможет снизить зависимость от NVIDIA, которая контролирует более 80 % мирового рынка ИИ-ускорителей. Информация о том, что OpenAI намерена заняться созданием фирменных ИИ-чипов, появилась в октябре 2023 года. Год спустя стало известно, что партнёром в рамках данного проекта выступает Broadcom, а организовать производство изделий планируется на мощностях TSMC. По данным Reuters, ИИ-ускоритель разрабатывается внутренней командой в составе примерно 40 специалистов под руководством Ричарда Хо (Richard Ho), который более года назад перешёл в OpenAI из Google, где также курировал программу по созданию ИИ-чипов. По оценкам аналитиков, стоимость разработки одной версии нового ИИ-продукта может составлять около $500 млн. Эта сумма удваивается с учётом создания сопутствующего ПО и необходимых периферийных компонентов. Ожидается, что решение OpenAI будет изготавливаться по 3-нм технологии на предприятии TSMC. На текущий год запланирована фаза Tape-out — заключительный этап проектирования интегральных схем или печатных плат перед их отправкой в производство: этот процесс предполагает перенос цифрового макета чипа на фотошаблон для последующего изготовления. Массовый выпуск изделия намечен на 2026 год. Говорится, что чип OpenAI проектируется с прицелом как на обучение, так и на запуск моделей ИИ. Однако на начальном этапе его применение в вычислительной инфраструктуре компании будет ограничено. Очевидно, это связано с необходимостью оценки эффективности и целесообразности применения новинки в большом масштабе.

10.02.2025 [22:59], Владимир Мироненко

Макрон объявил о французском ответе на американский ИИ-мегапроект Stargate с инвестициями на €109 млрдВ понедельник во Франции стартовал саммит, посвящённый ИИ — AI Action Summit. В преддверии мероприятия президент Франции Эммануэль Макрон (Emmanuel Macron) объявил о том, что объём частных инвестиций в развитие технологий ИИ в стране в ближайшие годы составит порядка €109 млрд. По словам Макрона, для Франции эта сумма, которую выделят компании из ОАЭ, США, Канады и Франции, эквивалентна затратам США в $500 млрд на развитие ИИ в рамках СП Stargate. По всей видимости он исходил из того, что численность населения Франции в пять раз меньше, чему у США. Сравнение со Stargate вызвано и тем, что, как и в американском проекте, большая часть инвестиций будет направлена на развёртывание ЦОД для работы с ИИ. Согласно данным TechCrunch, по состоянию на воскресенье было известно о примерно €83 млрд частных инвестиций в ИИ-проекты во Франции. В частности, €30–50 млрд поступит от ОАЭ при участии фонда MGX, €3 млрд — от французской телекоммуникационной компании Iliad, €10 млрд — от государственного инвестиционного банка Франции Bpifrance и €20 млрд — от канадской компании Brookfield. Как сообщает Data Center Dynamics, большая часть этой суммы — €15 млрд — будет предоставлена Brookfield своему подразделению Data4 для дальнейшего развёртывания сети ЦОД. Data4 ранее планировала увеличить мощность своих ЦОД во Франции с 375 МВт до 500 МВт, но теперь речь идёт о ещё 1 ГВт в течение следующих пяти лет. Остальная часть суммы будет направлена на улучшение инфраструктуры передачи данных, покупку оборудования и финансирование энергетических проектов. Data4 в настоящее время управляет примерно 30 ЦОД во Франции, Италии, Испании, Польше и Люксембурге. В Париже у неё три кампуса, в которых размещено 30 объектов общей мощностью 375 МВт. В своём выступлении Макрон также упомянул в качестве инвесторов программы французские компании Orange и Thales, которые пока не раскрыли объём планируемых инвестиций. Большая часть электроэнергии во Франции производится АЭС, причём больше, чем требуется стране. В понедельник французское правительство и компания Fluidstack подписали меморандум о взаимопонимании с целью строительства гигаваттного ИИ-кластера к концу 2026 года, который будет работать на «чистой» ядерной энергии, с возможностью увеличения мощности к 2028 году. На первом этапе — к 2026 году — кластер будет включать 500 тыс. ИИ-ускорителей следующего поколения. Ожидается, что специально созданный для обучения передовых моделей суперкомпьютер сделает Францию мировым центром ИИ. Также в понедельник было объявлено о партнёрстве технологической компании G42 из ОАЭ с DataOne с целью осуществления инвестиций инфраструктуру Франции. Компании планируют построить в Гренобле современный ИИ ЦОД с использованием ускорителей AMD Instinct. Ожидается, что объект будет полностью введён в эксплуатацию к середине 2025 года. Франция считает, что благодаря потенциалу своей ядерной энергетики она находится в выгодном положении для создания энергоёмких ЦОД. Поскольку Европа владеет всего 3–5 % мировой вычислительной мощности, Макрон выразил надежду в интервью CNN, что это «откроет двери» в будущее для ИИ в Европе. По его словам, этот фактор позволит построить во Франции 20 % всех ЦОД в мире. Великобритания также рассчитывает, что АЭС помогут ей стать ИИ-сверхдержавой. Впрочем, пока что анонсированные инвестиции в ИИ ЦОД здесь практически на порядок меньше.

10.02.2025 [19:33], Сергей Карасёв

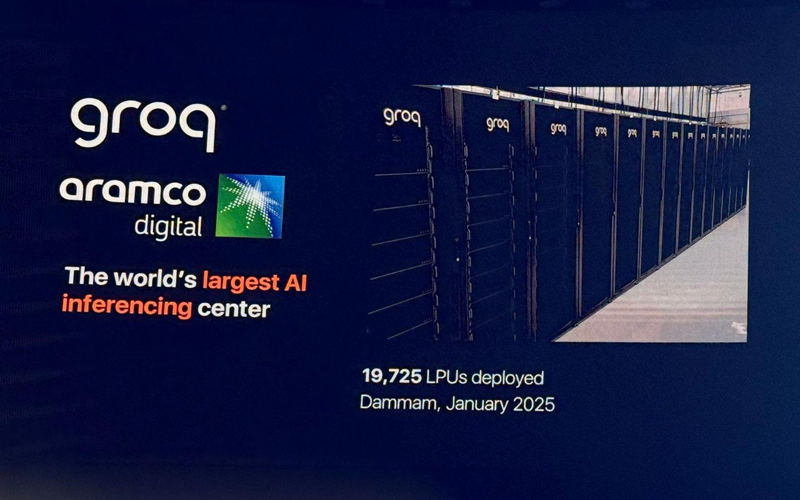

Groq развернула в Саудовской Аравии почти 20 тыс. ИИ-ускорителей LPUКомпании Groq и Aramco Digital объявили об открытии крупнейшего в Европе, на Ближнем Востоке и в Африке (EMEA) вычислительного ИИ-центра, ориентированного на задачи инференса. Площадка располагается в Даммаме в Саудовской Аравии. Groq занимается разработкой ускорителей LPU (Language Processing Unit) для работы с большими языковыми моделями (LLM). Утверждается, что они могут успешно конкурировать с ИИ-ускорителями NVIDIA, AMD и Intel. Aramco Digital, подразделение нефтегазового и химического гиганта Aramco, и Groq сообщили о намерении создать в Саудовской Аравии крупнейший в мире центр по развитию ИИ в марте 2024 года. Тогда говорилось, что Aramco Digital будет сдавать мощности Groq LPU в аренду клиентам на Ближнем Востоке. Предполагается также, что партнёрство с Groq поможет Aramco Digital вывести на рынок управляемую голосом ИИ-модель Norous.

Источник изображения: Twitter/@sundeep Как теперь сообщается, на базе нового ИИ-центра заработал облачный регион GrogCloud, включающий 19 725 LPU. Инвестиции в проект составили $1,5 млрд — совместно от Groq и Aramco Digital. Джонатан Росс (Jonathan Ross), генеральный директор Groq, сообщил, что к концу I квартала 2025 года компания развернёт сможет генерировать не менее 25 млн токенов в секунду. В перспективе планируется повышение данного показателя вплоть до 1 млрд токенов в секунду. С момента запуска GroqCloud в марте 2024 года более 800 тыс. разработчиков по всему миру начали использовать эту платформу на базе LPU Inference Engine через программный интерфейс Groq API. Облако, как утверждается, обеспечивает инференс в реальном времени с меньшей задержкой и большей пропускной способностью, чем у конкурентов. GroqCloud подходит для генеративных и разговорных приложений ИИ. В целом, Groq создаёт высокопроизводительную инфраструктуру ИИ, предназначенную для обслуживания более 4 млрд человек в Саудовской Аравии, на Ближнем Востоке, в Африке и за пределами этого региона. Сделка с Groq является частью крупномасштабного плана Vision-2030, предполагающего переход Саудовской Аравии к инновационной экономике на базе ИИ, которая призвана снизить зависимость страны от добычи нефти и газа.

10.02.2025 [16:05], Руслан Авдеев

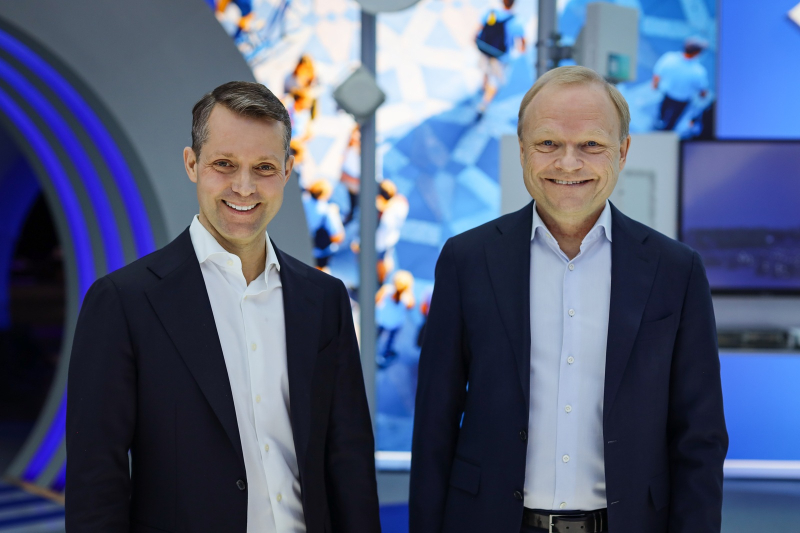

Nokia возглавит вице-президент Intel, ответственный за ИИ и ЦОДНовым генеральным директором Nokia 1 апреля 2025 года станет Джастин Хотард (Justin Hotard), исполнительный вице-президент Intel и глава направления DCAI. Компания надеется, что он усилит её позиции в области решений для ИИ ЦОД. Хотард придётся на смену Пекка Лундмарку (Pekka Lundmark), возглавлявшего Nokia с 2020 года. Лундмарк останется консультантом компании до конца 2025 года, а потом покинет её. Ранее Nokia приняла решение диверсифицировать бизнес и найти новые направления роста за пределами традиционной сферы, связанной с телекоммуникационными продуктами для операторов связи. В прошлом году Nokia купила за $2,3 млрд поставщика сетевых решений Infinera, а также избавилась от непрофильного актива Alcatel Submarine Networks (ASN) и вышла из совместного с Huawei предприятия TD Tech. Сейчас компания делает ставку на бизнес, связанный с дата-центрами. В Nokia заявляли, что ЦОД станут драйверами её роста в ближайшие годы, но совсем отказываться от традиционных телекоммуникационных решений компания не намерена. Компания подписала крупное соглашение по обновлению сетевой инфраструктуры ЦОД Microsoft и присоединилась к консорциуму Ultra Ethernet. При этом заниматься развитием собственного облака Nokia не будет. У Хотарда более 25 лет опыта работы на руководящих должностях в крупных технологических компаниях, в т.ч. Symbol Technologies, Motorola, HPE и NCR Corporation, однако в Intel он пришёл только в 2024 году. Ранее Intel покинул главный архитектор Intel Xeon Сайлеша Коттапалли (Sailesh Kottapalli), который присоединился к Qualcomm для работы над серверными Arm-процессорами. |

|