Материалы по тегу: ии

|

10.02.2025 [14:56], Андрей Крупин

Релиз «Альт Сервер» 10.4: новые инструменты для администраторов и улучшенный контроллер доменовКомпания «Базальт СПО» сообщила о выпуске обновлённой версии операционной системы «Альт Сервер» с программным комплексом «Альт Домен» 10.4. «Альт Сервер» представляет собой комплексное решение на базе Linux с широкой функциональностью, позволяющее разворачивать и поддерживать корпоративную IT-инфраструктуру предприятий, а также использовать разнообразное периферийное оборудование. Платформа зарегистрирована в реестре российского ПО, интегрирована с контроллером доменов «Альт Домен» (Samba DC и FreeIPA), совместима с экосистемой программных продуктов отечественных разработчиков и содержит необходимый инструментарий для запуска и настройки служб и сервисов в сети организации. Дистрибутив выпускается в нескольких вариантах исполнения для процессорных архитектур x86_64, aarch64 и «Эльбрус».

Источник изображения: basealt.ru/alt-server Релиз «Альт Сервер» 10.4 получил обновлённые версии ядер (5.10.233 и 6.1.124 — доступны для выбора в загрузчике), доработанный программный комплекс «Альт Домен» с расширенными функциональными возможностями, поддержкой версий групповых политик и обновлёнными модулями. Также сообщается о включении в состав дистрибутива новых инструментов для администраторов, включая контроль подключения USB-устройств, исправлении уязвимостей в коде ОС, устранении проблем с отображением интерфейса установщика на 4K-мониторах и установкой платформы на NVMe-диски с секторами 4K в режиме UEFI. Отдельное внимание было уделено повышению стабильности и надёжности работы системы. Ознакомиться с подробной информацией об операционной системе «Альт Сервер» можно в документации на сайте «Базальт СПО».

10.02.2025 [13:16], Андрей Крупин

«Ростех» представил решение для защиты объектов КИИ от программ-шифровальщиковКомпания «РТ-Информационная безопасность» (дочерняя структура госкорпорации «Ростех») представила решение «Антишифр» для противодействия атакам программ-шифровальщиков, блокирующих доступ к данным и требующих выплаты определённой суммы киберпреступникам для возвращения доступа к ценной информации. Новая разработка включена в состав созданной компанией «РТ-Информационная безопасность» защитной платформы RT Protect EDR. Благодаря интеграции с ядром операционной системы Windows на уровне драйвера «Антишифр» позволяет осуществлять анализ всех выполняемых процессов в режиме реального времени и выполнять блокирование вредоносных операций на этапе попытки их исполнения программами-шифровальщиками.

Источник изображения: «РТ-Информационная безопасность» / rt-ib.ru Новый модуль обеспечивает автоматическое принудительное завершение как отдельных вредоносных программ, функционирующих самостоятельно, так и групп приложений, работающих совместно. Кроме того, «Антишифр» проводит автоматическое сохранение важных файлов при попытке их модификации/удаления в локальное защищённое хранилище. Резервирование действует параллельно с другими защитными механизмами, благодаря чему можно восстановить важные файлы после отражения кибератаки. «Организации «Ростеха» задействованы в важнейших технологических проектах России. Практически все наши предприятия — объекты критической информационной инфраструктуры. Программы-шифровальщики представляют огромную опасность для таких компаний. Удачная кибератака может нанести удар не просто по бизнесу, принеся многомиллионные убытки, но даже по национальной безопасности. Статистика говорит, что большинство кибератак в РФ в настоящее время политически мотивированы. Их цель — не получение финансовой выгоды, например выкупа за похищенные данные, а шпионаж и диверсии. «Антишифр» усилит защиту отечественных предприятий от подобных действий», — прокомментировали выпуск нового решения в «Ростехе».

10.02.2025 [13:12], Руслан Авдеев

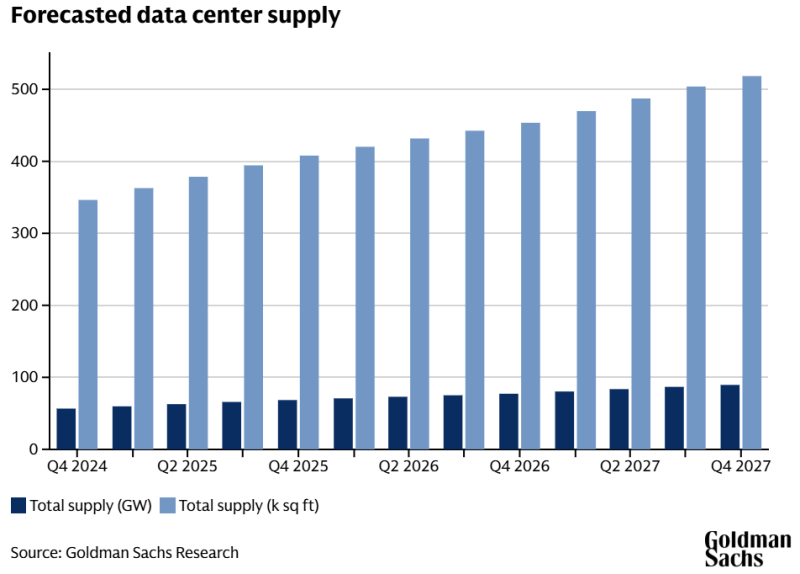

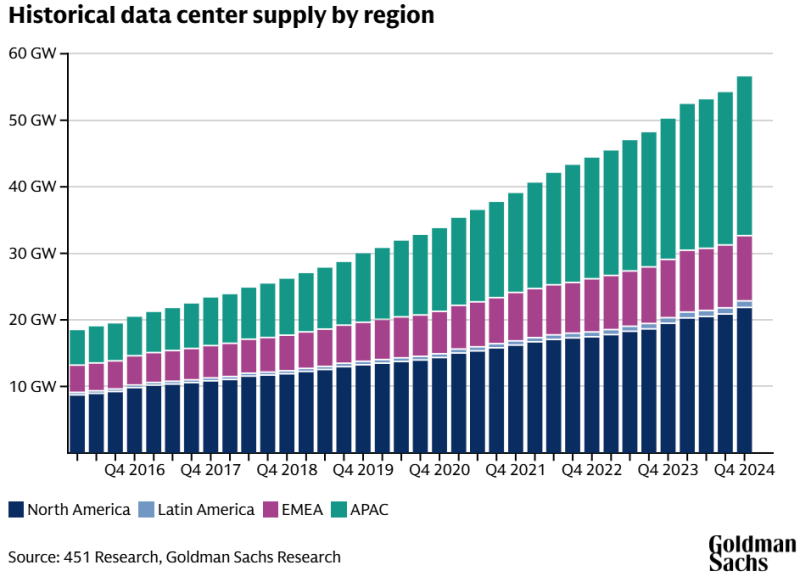

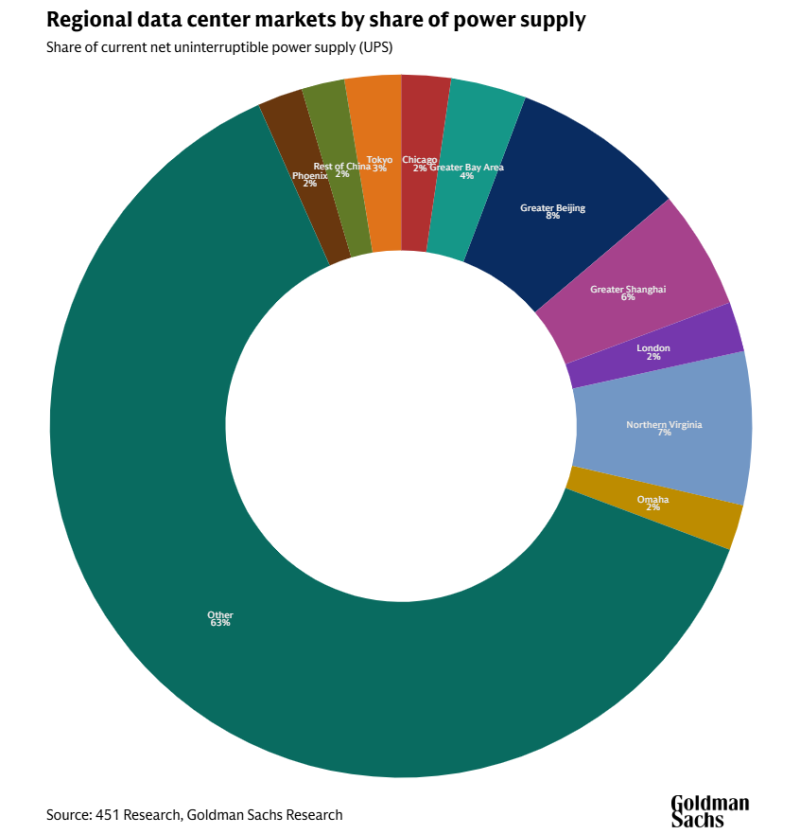

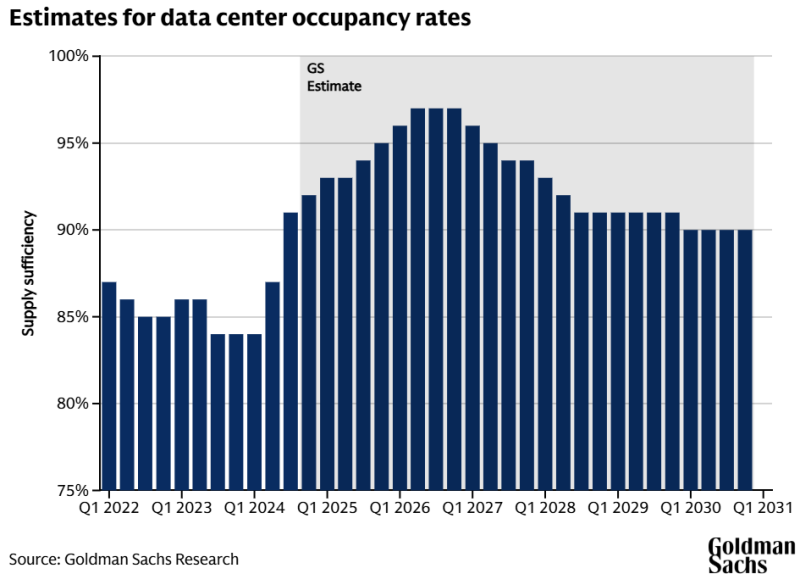

Ненасытный ИИ: энергопотребление ЦОД к 2030 году вырастет более чем вдвоеПо последним прогнозам инвестиционных банкиров Goldman Sachs, потребность ИИ в электричестве приведёт к тому, что всего через пять лет потребление энергии дата-центрами увеличится более чем вдвое. По оценкам финансистов, сегодня индустрия ЦОД в мире потребляет около 55 ГВт. Более половины (54 %) приходится на нагрузки при облачных вычислениях, на традиционные сервисы вроде серверов e-mail и хранилищ данных — ещё 32 %, а на ИИ — 14 %. Моделирование будущего спроса позволяет предположить, что уже к 2027 году он вырастет до 84 ГВт, а доля ИИ составит 27 %. На облачные нагрузки придётся около 50 %, а на традиционные нагрузки — 23 %. Если прогнозы верны, всего за пару лет потребление в энергии взлетит на 59 % и тенденция, вероятно, сохранится и в будущем. К концу 2030 года общая мощность ЦОД должна составить уже 122 ГВт — рост в 165 % в сравнении с 2023 годом. Капитальные затраты Amazon, в основном связанные с AWS, в 2025 году должны составить $100 млрд. Microsoft намерена потратить на инфраструктуру $80 млрд, Google — $75 млрд, а Meta✴ — до $65 млрд. Столь значительные средства преимущественно пойдут на развитие именно ИИ-инфраструктуры. В результате инвестиции потребуются и энергосетям, на модернизацию которых до 2030 года может потребоваться до $720 млрд — немало, но в противном случае нехватка энергии может затормозить развитие ЦОД в ряде регионов. В Goldman Sachs предупреждают, что на модернизацию ЛЭП может уйти несколько лет, что может стать «узким местом» для рынка ЦОД, если регионы не проявят достаточной инициативы. В прошлом году аналитики Bain & Co предупреждали о том, что рост энергопотребления в США способен превысить предложение буквально за пару лет, если энергетические компании не примут мер для наращивания мощностей по производству и распределению электричества. Также сообщалось, что к 2030 году американцы могут столкнуться с ростом счетов за электричество на 70 % — если необходимые меры не принять. В Goldman Sachs, рассчитывают, что в ближайшем будущем баланс спроса и предложения в отрасли ЦОД «ужесточится», а загруженность инфраструктуры ЦОД, составлявшая 85 % в 2023 году, уже в конце 2026 года превысит 95 %. В 2027 году должно начаться замедление темпов роста загруженности благодаря вводу в эксплуатацию новой инфраструктуры. Впрочем, это предположение основано на гипотезе исследователей, предполагающей, что более эффективные ИИ-модели несколько снизят потребность в инфраструктуре. В долгосрочной перспективе, если повышение эффективности приведёт к снижению уровня капитальных затрат, рынок дата-центров станет более устойчивым и будет меньше подвержен циклическим колебаниям. Будучи финансовой компанией, Goldman Sachs заинтересована как в открывающихся инвестиционных возможностях, так и в том, чтобы предупредить о возможном кризисе. Отмечается, что в выигрыше от роста спроса на ИИ окажутся крупные операторы ЦОД, обслуживающие гиперскейлеров и крупных корпоративных клиентов. В прошлом году сообщалось, что аналитики Goldman Sachs не уверены в будущем ИИ, поскольку на него тратится слишком много средств, а польза не вполне очевидна.

10.02.2025 [00:50], Владимир Мироненко

Саудовская Аравия объявила о $14,9 млрд инвестиций в ИИ-секторВ Саудовской Аравии стартовала технологическая выставка LEAP 2025. Как сообщает OneArabia, министр связи и информационных технологий Абдулла Аль-Сваха (Abdullah Alswaha) объявил, что объём инвестиций в ИИ-сектор страны со стороны компаний из разных стран составит около $14,9 млрд. Министр отметил, что они позволят активизировать развитие технологического сектора и ускорить переход к инновационной экономике, основанной на ИИ, в соответствии с целями программы «Видение – 2030» (Vision 2030), призванной снизить зависимость страны от добычи ископаемого топлива. В частности, Groq и Aramco Digital объявили об инвестициях в размере $1,5 млрд в расширение облачных вычислений на базе ИИ, чтобы вывести Саудовскую Аравию в лидеры в области ИИ. Компании планируют построить в стране крупнейший в мире центр ИИ на базе ускорителей Groq. Lenovo и компания Alat, принадлежащая Саудовскому государственному инвестиционному фонду, подтвердили планы инвестировать $2 млрд в передовой производственный центр на основе ИИ и робототехники и региональную штаб-квартиру Lenovo в Эр-Рияде. Google планирует создать центр инфраструктуры ИИ в Саудовской Аравии для удовлетворения регионального и международного спроса в ИИ-сервисах. Ранее стало известно о планах AWS потратить $5,3 млрд на создание нового облачного региона к 2026 году, а также помочь в обучении местных разработчиков. Aramco Digital, Armada и Microsoft планируют запустить в Саудовской Аравии контейнерные дата-центры для периферийных вычислений. К концу 2024 года Microsoft уже построила здесь три ЦОД — об инвестициях в размере $2,1 млрд было объявлено два года назад. Databricks выделяет $300 млн на решения Platform-as-a-Service, поддерживая разработчиков приложений и способствуя развитию экспертизы в области инжиниринга данных в стране. SambaNova сообщила о выделении $140 млн на разработку передовой инфраструктуры ИИ, что позволит укрепить роль Саудовской Аравии как регионального центра инноваций. KKR и Gulf Data Hub объявили о значительных инвестициях в развитие ЦОД — до 300 МВт новых мощностей. Salesforce инвестирует $500 млн в расширение своей платформы Hyperforce в Саудовской Аравии для обслуживания региональных клиентов. Tencent Cloud направит $150 млн в запуск своего облачного региона с интегрированными возможностями ИИ. Alibaba Cloud запускает в стране программу расширения возможностей ИИ совместно с Tuwaiq Academy и STC для обучения местных талантов передовым технологиям. Наконец, Qualcomm объявила о доступности большой языковой модели ALLaM на платформе Qualcomm Cloud AI, а также представила решение ALLaM AI PC для разработчиков.

09.02.2025 [14:12], Сергей Карасёв

Stargate по-европейски: Франция и ОАЭ вложат до €50 млрд в гигаваттный ИИ ЦОДФранция и ОАЭ, по сообщению Bloomberg, реализуют масштабный совместный проект по созданию кампуса ИИ ЦОД. Партнёрство двух стран затронет и ряд других областей, включая формирование виртуальных посольств данных для развития суверенного ИИ и облачных сервисов. О проекте объявили президент Франции Эмманюэль Макрон (Emmanuel Macron) и президент ОАЭ шейх Мухаммед бен Заид Аль Нахайян (Mohamed bin Zayed Al Nahyan). Предполагается, что суммарная мощность объектов в составе нового комплекса ЦОД будет достигать 1 ГВт. Подробности о техническом оснащении дата-центров пока не раскрываются. Известно, что в финансировании франко-эмиратского проекта примут участие несколько инвесторов, а общая сумма вложений составит от €30 млрд до €50 млрд ($31,2–$52 млрд). В частности, средства предоставит инвестиционный фонд Абу-Даби MGX (создан Mubadala и G42) стоимостью $100 млрд. О первых траншах со стороны ОАЭ будет объявлено в ходе саммита Choose France 2025. Говорится также, что в рамках сотрудничества Франция и ОАЭ намерены приобретать передовые чипы и развивать кадровое направление с целью укрепления ИИ-потенциала обеих стран. Ранее правительство Франции заявило, что определило 35 потенциальных площадок общей площадью около 1200 га для размещения ИИ ЦОД. Фонд MGX участвует и в другом мегапроекте по строительству дата-центров — Stargate. Это совместное предприятие OpenAI, Softbank и Oracle по развитию ИИ-инфраструктуры в США. На первом этапе SoftBank и OpenAI намерены вложить в Stargate по $19 млрд, тогда как Oracle и MGX внесут по $7 млрд. В перспективе общие затраты в рамках Stargate, как ожидается, достигнут $500 млрд. Иными словами, инвестиции примерно на порядок выше тех, которые намерены сделать Франция и ОАЭ.

08.02.2025 [16:08], Сергей Карасёв

Softbank намерен инвестировать $40 млрд в OpenAIЯпонский холдинг SoftBank Group, по информации CNBC, инвестирует в OpenAI до $40 млрд, а не $15–$25 млрд, как предполагалось ранее. Эти деньги будут поступать частями в течение следующих 12–24 месяцев — первый платёж запланирован уже на предстоящую весну. Недавно сообщалось, что OpenAI планирует провести раунд финансирования на $40 млрд, получив при этом оценку в $340 млрд. Предполагалось, что средства поступят от ряда инвесторов, главным из которых станет именно SoftBank. Но, судя по новым сведениям, структура раунда изменилась. Говорится, что все $40 млрд предоставит SoftBank, причём переговоры по данному вопросу близки к завершению. При этом рыночная стоимость OpenAI имеет предварительную оценку в $260 млрд, которая вырастет до $300 млрд после получения нового финансирования. Ещё в октябре 2024 года OpenAI оценивалась всего в $157 млрд. Часть привлечённых денег будет использована для выполнения обязательств OpenAI в рамках Stargate — совместного предприятия с Softbank и Oracle по развитию ИИ-инфраструктуры в США. Ранее говорилось, что на первом этапе SoftBank и OpenAI намерены вложить в Stargate по $19 млрд, тогда как в перспективе затраты на реализацию этой инициативы достигнут $500 млрд. После проведения раунда Softbank станет крупнейшим инвестором OpenAI, опередив Microsoft. В целом, японский холдинг и ИИ-стартап планомерно укрепляют партнёрские отношения. На днях SoftBank и OpenAI объявили о формировании совместного предприятия SB OpenAI для развития корпоративных ИИ-сервисов в Японии. По условиям соглашения, входящие в состав группы SoftBank компании, а также Arm Holdings будут совместно платить OpenAI $3 млрд/год. Вместе с тем OpenAI намерена поддерживать партнёрские отношения с Microsoft как минимум до 2030 года, используя облачные ресурсы Azure.

07.02.2025 [19:41], Руслан Авдеев

Crusoe Energy и Kalina Power построят в Канаде ИИ ЦОД с питанием от электростанций на природном газеДевелопер ИИ ЦОД Crusoe Energy, ответственный за строительство первых дата-центров ИИ-мегапроекта Stragate, заключил многолетнее рамочное соглашение с канадским поставщиком энергии Kalina Distributed Power (KDP) о строительство в Альберте многочисленных колокейшн-ЦОД с питанием от электростанций на природном газе, сообщает Datacenter Dynamics. KDP принадлежит Kalina Power Limited, работающей в Австралии, Китае, Канаде и США. Crusoe будет строить, владеть и управлять дата-центрами, приобретая для них электроэнергию у принадлежащих KDP электростанций суммарной мощностью 170 МВт. Также предусмотрен захват выделяемого станциями CO2. Фактически речь идёт о соглашениях о покупке энергии (PPA) минимальным сроком на 15 лет. Правда, детали о масштабах и времени строительства ЦОД пока не раскрываются. Кроме того, KDP не сообщила, когда заработают новые газовые электростанции. Как сообщается в пресс-релизе Kalina, каждый потенциальный колокейшн-проект предусматривает заключение отдельного «Соглашения о разработке» (Project Development Agreement, PDA). Каждое PDA предусматривает подписание долговременного PPA, а также оговаривает ответственность Crusoe за платежи, обеспечивающие надёжность подключения к энергосетям каждого проекта. Упомянуты три площадки KDP: Myers Energy Park на 26 га, Alsike Energy Park на 65 га и Crossfield Energy Park на 130 га. KDP ведёт переговоры о покупке ещё 117 га в Myers Energy Center, что позволит построить намного более крупный дата-центр. Выбранные площадки имеют доступ к критически важной инфраструктуре, включая ЛЭП, газопроводы и ВОЛС. Кроме того, все три используют технологии захвата и сохранения углеродных выбросов. Экологические исследования уже ведутся на площадках Myers и Alsike, а в локации Crossfield должны завершиться в 2025 году. KDP также подала запросы на самообеспечение энергией и возможность её экспорта к Alberta Electric System Operator для всех трёх объектов. Также изучается потенциал других площадок, включая Gilby Power Park и новой локации в Клермонте. Альберта, на которую приходится более половины добываемого в Канаде газа, становится всё привлекательнее для ИИ ЦОД, желающих подключиться к относительно доступной энергии газовых электростанций. Впрочем, власти провинции не совсем рады такому интересу со стороны операторов ЦОД. Они приняли закон, согласно которому дата-центры должны самостоятельно обеспечивать себя энергией и генерирующими мощностями. В результате операторы ориентируются на соглашения с местными газовыми компаниями для организации энергопоставок.

07.02.2025 [18:16], Руслан Авдеев

10 ГВт за 10 лет: Prologis намерена активнее осваивать рынок ЦОДИнвестирующий в недвижимость фонд Prologis намерен существенно увеличить своё портфолио дата-центров в ближайшие десять лет. Бизнес-гигант, известный на рынках логистики и индустриальной недвижимости, занялся ЦОД ещё в период пандемии COVID-19. Компания обычно сотрудничает со Skybox Datacenters, которая фактически отвечает за строительство объектов, сообщает Datacenter Dynamics. Построенные объекты сдаются в аренду или продаются гиперскейлерам и другим операторам ЦОД. Сегодня компания располагает 1,4 ГВт зарезервированных мощностей для ЦОД, ещё 1,6 ГВт — на «продвинутой стадии» готовности. На очереди ещё 1,5 ГВт, а в целом компания намерена освоить 10 ГВт в течение 10 лет. С прошлого года бизнесом Prologis, связанным с ЦОД, руководит соучредитель Compass Крис Кёртис (Chris Curtis). Компания располагает портфолио из 6 тыс. зданий и более 6 тыс. га земли, так что возможностей для развития нового бизнеса у компании много. Впрочем, долгосрочная стратегия пока не выработана. Пока что компания намерена оставаться девелопером и продавать объекты после строительства, вкладывая полученные средства в развитие основого бизнеса, т.е. постройку логистических объектов. Также возможно делегирование некоторым подконтрольным фондам работы именно с сегментом ЦОД. Как сообщают в Prologis, единственное, что они делать точно не будут — это держать ЦОД на своём балансе, поскольку затраты на строительство и обслуживание дата-центров очень высоки даже для столь развитой компании. Например, недавно Prologis продала чикагский ЦОД Elk Grove, построенный совместно со Skybox. Примечательно, что изначально это был логистический объект, который позднее подключили к энергетической инфраструктуре, оснастили «под ключ» и продали HMC Capital. В итоге он был передан одному из гиперскейлеров.

07.02.2025 [14:31], Владимир Мироненко

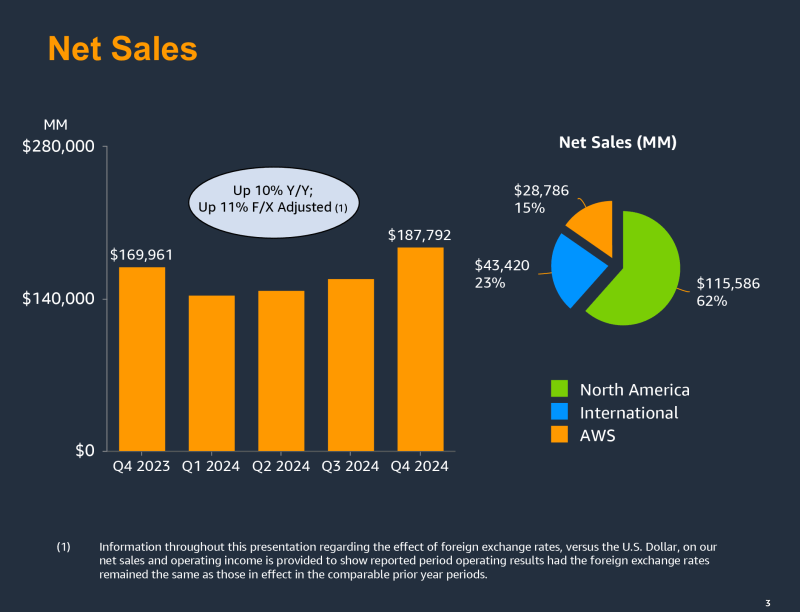

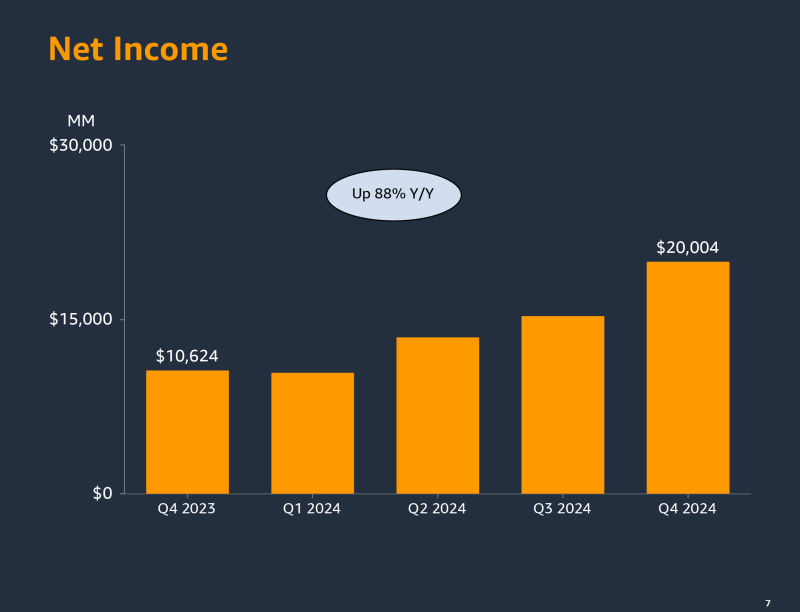

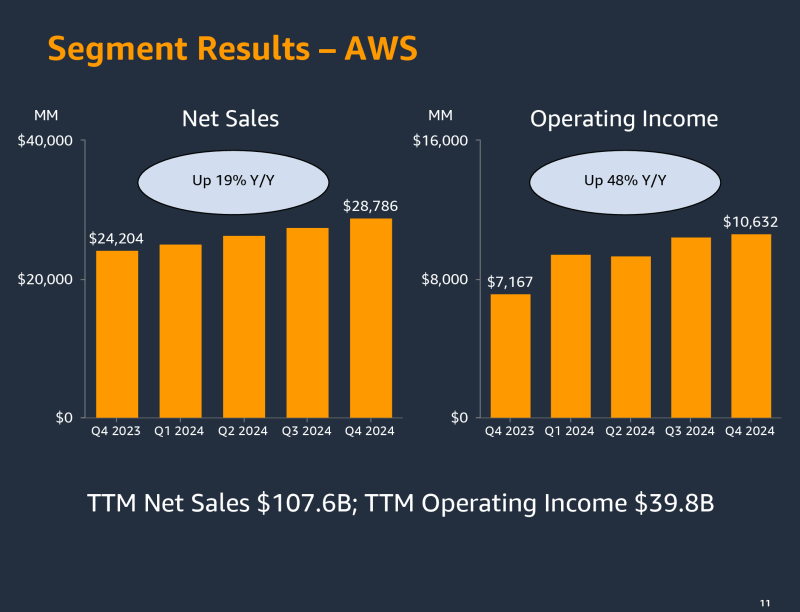

Amazon увеличит в 2025 году капзатраты на ЦОД и ИИ-ускорители до $100 млрдAmazon объявила финансовые результаты IV квартала и 2024 года в целом, завершившегося 31 декабря 2024 года. Итоги за квартал в основном превысили прошлогодние показатели и ожидания аналитиков, но слабый прогноз на I квартал 2025 года вызвал падение акций компании на внебиржевых торгах на 5 %. Слабый прогноз компания объяснила неблагоприятными валютными курсами. За 2024 год выручка Amazon составила $638,0 млрд, увеличившись на 11 % по сравнению с $574,8 млрд в 2023 году. Выручка AWS выросла на 19 % до $107,6 млрд. Операционная прибыль Amazon увеличилась до $68,6 млрд с $36,9 млрд в предыдущем году, у AWS — на 62 % до $39,8 млрд. Акции Amazon выросли на 9 % с начала 2025 года. В 2024 году их рост составил 44 % при росте Nasdaq на 29 %. Выручка Amazon в IV квартале составила $187,79 млрд, что больше результата годичной давности на 10 %, и выше консенсус-прогноза аналитиков, опрошенных LSEG, в размере $187,30 млрд. Операционная прибыль компании выросла до $21,2 млрд с $13,2 млрд годом ранее. Чистая прибыль Amazon увеличилась почти вдвое до $20,0 млрд или $1,86 на разводнённую акцию с $10,6 млрд или $1,00 на разводнённую акцию в IV квартале 2023 года при консенсус-прогнозе аналитиков от LSEG в размере $1,49 на разводнённую акцию. Amazon увеличила прибыль за счет сокращения расходов и сохранения устойчивости в высокодоходном облачном бизнесе. Операционная маржа Amazon (прибыль, оставшаяся после учёта расходов на ведение бизнеса) выросла до 11,3 % за IV квартал с 11 % в предыдущем квартале и 7,8 % в IV квартале 2023 года. Гендиректор Amazon Энди Джесси (Andy Jassy) проводит кампанию по сокращению расходов с конца 2022 года. В 2022 и 2023 годах было уволено более 27 тыс. сотрудников. Сокращение рабочих мест продолжалось в 2024 году и проводится в текущем. Выручка облачного подразделения Amazon Web Services (AWS) составила $28,79 млрд, что выше прошлогоднего результата на 19 % и соответствует консенсус-прогнозу аналитиков, опрошенных StreetAccount. Операционная прибыль подразделения выросла до $10,63 млрд с $7,17 млрд годом ранее. Выручка AWS росла в IV квартале быстрее чем годом ранее, когда рост составил 13 %, но его темпы роста по-прежнему ниже, чем у конкурентов. Для сравнения, выручка Azure и других облачных сервисов Microsoft выросла на 31 %, у Google Cloud Platform холдинга Alphabet рост составил 30 %. Компания вкладывает миллиарды долларов в ЦОД и оборудование для них, включая ускорители NVIDIA, на фоне усилившейся конкуренции на рынке ИИ. Также AWS активно развивает собственную серию ускорителей Trainium, чтобы снизить зависимость от NVIDIA — как собственную, так и своих партнёров. Капитальные затраты Amazon составили $27,83 млрд за IV квартал по сравнению с $14,59 млрд в аналогичном квартале годом ранее. За 2024 год капзатраты достигли $83 млрд. По словам финансового директора Amazon Брайана Олсавски (Brian Olsavsky), в 2025 году капзатраты вырастут до $100 млрд. Скачок расходов «в первую очередь связан с AWS, в том числе для поддержки спроса на услуги ИИ, а также с технической инфраструктурой для поддержки североамериканских и международных сегментов». Компания разработала новую архитектуру ИИ ЦОД и скорректировала планы строительства некоторых объектов. Для сравнения: Microsoft в этом году намерена потратить на инфраструктуру $80 млрд, Google — $75 млрд, а Meta✴ — до $65 млрд. Amazon прогнозирует получить в I квартале выручку в пределах от $151 до $155,5 млрд, что означает рост год к году на 5–9 %. Согласно LSEG, аналитики ожидают в текущем квартале выручку в $158,5 млрд. Слабый прогноз компания объясняет влиянием колебаний курса валюты на $2,1 млрд или 150 базисных пунктов.

07.02.2025 [11:11], Сергей Карасёв

Hitachi потратит $400 млн на инвестиции в ЦОД-проекты и ИИКомпания Hitachi объявила о формировании своего четвёртого корпоративного венчурного фонда для инвестиций в стартапы с потенциалом создания или трансформации крупных рынков, предвосхищения технологических и социальных изменений, а также стимулирования возможностей для роста. Структура получила название HV Fund. На начальном этапе капитал HV Fund составит $400 млн, что делает его крупнейшим корпоративным венчурным фондом, управляемым Hitachi. Новая структура намерена осуществлять стратегические инвестиции в стартапы, развивающие передовые цифровые решения. Речь, в частности, идёт о проектах в области дата-центров, робототехники, промышленного ИИ, распределённых энергетических систем, квантовых технологий, ядерного синтеза, наук о жизни, космоса и пр. Формирование HV Fund увеличивает общий бюджет корпоративных венчурных фондов Hitachi до $1 млрд. Организация Hitachi Ventures (HV) была основана в июне 2019 года и с тех пор управляла тремя фондами, которые в общей сложности оказали финансовую поддержку 38 стартапам. Среди них несколько достигли статуса единорога, то есть, получили рыночную оценку более $1 млрд. Hitachi Ventures имеет доли в компаниях Makersite, Captura, Archetype AI и др. Многие из стартапов, получивших инвестиции, уже сотрудничают с бизнес-подразделениями и компаниями группы Hitachi. В целом, как отмечается, под руководством Тошиаки Токунаги (Toshiaki Tokunaga), который в апреле 2025 году будет назначен на должность президента и генерального директора Hitachi, компания стремится реализовать стратегию True One Hitachi. Она подразумевает повсеместное внедрение передовых цифровых технологий для обеспечения устойчивого развития бизнеса. В рамках следующего среднесрочного плана управления, который в настоящее время разрабатывается, Hitachi намерена ускорить реализацию перспективных проектов с целью трансформации в мирового лидера в сфере социальных инноваций. Важную роль на этом пути будут играть технологии генеративного ИИ. |

|