Материалы по тегу: hardware

|

11.04.2024 [22:27], Алексей Степин

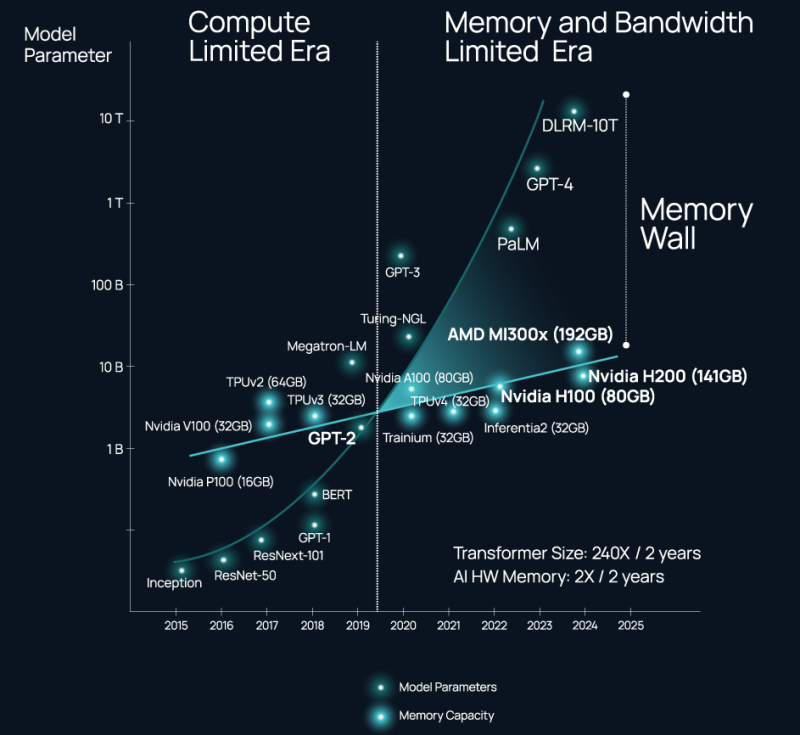

ИИ-ускорители NVIDIA являются самими дорогими в мире контроллерами памяти — Celestial AI предлагает связать оптикой HBM, DDR5 и процессорыВ 2024 году нельзя пожаловаться на отсутствие подходящего интерконнекта, если целью является «сшивка» в единую систему сотен, тысяч или даже десятков тысяч ускорителей. Есть NVIDIA NVLink и InfiniBand. Google использует оптические коммутаторы OCS, AMD вскоре выведет Infinity Fabric на межузловой уровень, да и старый добрый Ethernet отнюдь не собирается сдавать позиций и обретает новую жизнь в виде Ultra Ethernet. Проблема не в наличии и выборе подходящего интерконнекта, а в резкой потере пропускной способности за пределами упаковки чипа (т.н. Memory Wall). Да, память HBM быстра, но намертво привязана к вычислительным ресурсам, а в итоге, как отметил глава Celestial AI в комментарии изданию The Next Platform, индустрия ИИ использует ускорители NVIDIA в качестве самых дорогих в мире контроллеров памяти. Celestial AI ещё в прошлом году объявила, что ставит своей целью создание универсального «умного» интерконнекта на основе фотоники, который смог бы использоваться во всех нишах, требующих активного обмена большими потоками данных, от межкристалльной (chip-to-chip) до межузловой (node-to-node). Недавно она получила дополнительный пакет инвестиций объёмом $175 млн.

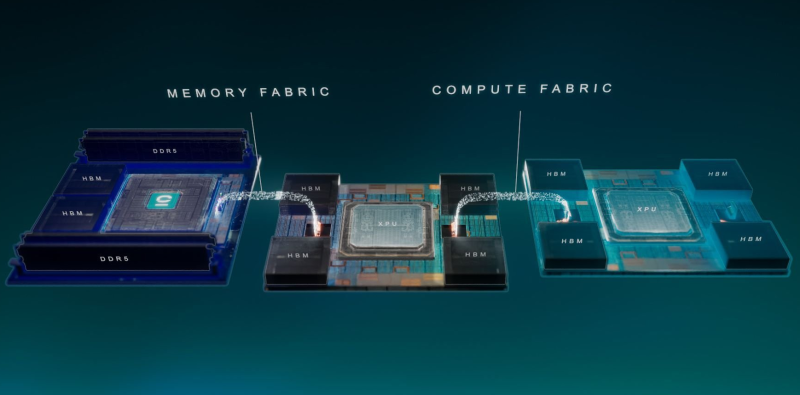

Источник изображений здесь и далее: Celestial AI Технология, названная Photonic Fabric, если верить заявлениям Celestial AI, способна в 25 раз увеличить пропускную способность и объёмы доступной памяти при на порядок меньшем энергопотреблении в сравнении с существующими системами соединений. Развивается она в трёх направлениях: чиплеты, интерпозеры и оптический аналог технологии Intel EMIB под названием OMIB. Наиболее простым способом интеграции своей технологии Celestial AI справедливо считает чиплеты. В настоящее время разработанный компанией модуль обеспечивает пропускную способность за пределами чипа на уровне 14,4 Тбит/с (1,8 Тбайт/с), а по размерам он немного уступает стандартной сборке HBM. Но это лишь первое поколение: во втором поколении Photonic Fabric 56-Гбит/с SerDes-блоки SerDes будут заменены на блоки класса 112 Гбит/с (PAM4). Поскольку речь идёт о системах с дезагрегацией ресурсов, проблему быстрого доступа к большому объёму памяти Celestial AI предлагает решить следующим образом: новый чиплет, содержащий помимо интерконнекта две сборки HBM общим объёмом 72 Гбайт, получит также поддержку четырёх DDR5 DIMM суммарным объёмом до 2 Тбайт. С использованием 5-нм техпроцесса такой чиплет сможет легко превратить HBM в быстрый сквозной кеш (write through) для DDR5. Фактически речь идёт об относительно простом и сравнительно доступном способе превратить любой процессор с чиплетной компоновкой в дезагрегированный аналог Intel Xeon Max или NVIDIA Grace Hopper. При этом латентность при удалённом обращении к памяти не превысит 120 нс, а энергозатраты в данном случае составят на порядок меньшую величину, нежели в случае с NVLink — всего 6,2 пДж/бит против 62,5 пДж/бит у NVIDIA. Таким образом, с использованием новых чиплетных контроллеров памяти становятся реальными системы, где все чипы, от CPU до сетевых процессоров и ускорителей, будут объединены единым фотонным интерконнектом и при этом будут иметь общий пул памяти DDR5 большого объёма с эффективным HBM-кешированием. По словам Celestial AI, она уже сотрудничает с некоторыми гиперскейлерами и с одним «крупным производителем процессоров». По словам руководителя Celestial AI, образцы чиплетов с поддержкой Photonic Fabric появятся во II половине 2025 года, а массовое внедрение начнется уже в 2027 году. Однако это может оказаться гонкой на выживание: Ayar Labs, другой разработчик фотоники, получившая поддержку со стороны Intel, уже показала прототип процессора с интегрированным фотонным интерконнектом. А Lightmatter ещё в декабре получила финансирование в объёме $155 млн на разработку фотонного интерпозера Passage и якобы уже сотрудничает с клиентами, заинтересованными в создании суперкомпьютера с 300 тыс. узлов. Нельзя сбрасывать со счетов и Eliyan, предлагающую вообще отказаться от технологии интерпозеров и заменить её на контроллеры физического уровня NuLink.

11.04.2024 [21:10], Сергей Карасёв

Тяжелейший путь, который того стоил: «Ростелеком» перевёл свои дата-центры на российское оборудование YADROКомпания «Ростелеком» в рамках комплексной программы импортозамещения полностью перевела свои ЦОД на отечественное оборудование. Об этом, как сообщает «Интерфакс», на форуме «Открытые инновации» объявил президент «Ростелекома». В качестве альтернативы серверам и СХД зарубежного производства выбраны решения российского производителя IT-оборудования YADRO («КНС групп»). Эта компания предлагает такие продукты, как серверы Vegman, СХД Tatlin.Unified, объектные хранилища корпоративного уровня Tatlin.Object и системы резервного копирования Tatlin.Backup. Кроме того, в ассортименте YADRO представлены 25GbE-коммутаторы Kornfeld. «Компания Yadro, с которой мы прошли тяжелейший, я бы сказал — кровавый — путь замещения серверов в наших ЦОД за последний год ценой ошибок, стрессов, круглосуточной работы. Но вот эта деятельность позволила нам на 100% отказаться от импортного оборудования, которое нам не продают, ну и по понятным причинам мы и сами не хотим покупать», — заявил Осеевский.

Источник изображения: YADRO Несмотря на то, что сам «Ростелеком» полностью отказался от зарубежного оборудования в ЦОД, говорится, что в данной сфере наблюдаются «очень серьёзные проблемы с импортозамещением». По его словам, регулирование деятельности дата-центров, это та область, которая «требует дополнительного внимания». Глава «Ростелекома» также предложил распределить по годам стоимость подключения дата-центров к электросетям, а не производить оплату сразу. Речь идёт о введении специальных тарифов для ЦОД.

11.04.2024 [17:59], Алексей Степин

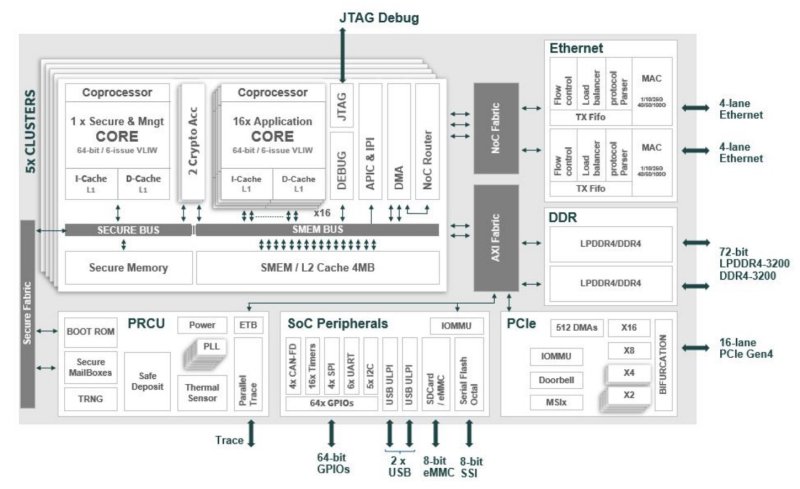

Сделано в Европе: Kalray представила ускоритель Turbocard4 для машинного зрения и обработки ИИ-данныхКомпания Kalray объявила о коммерческой доступности новых ускорителей Turbocard4 (TC4). Новинка позиционируется в качестве решения для ускорения работы систем машинного зрения, либо как акселератор «умной» индексации данных. На борту ускорителя, выполненного в формате FHFL установлено сразу четыре чипа DPU Coolidge 2 с фирменной архитектурой Kalray MPPA. Эти процессоры были анонсированы ещё летом прошлого года в качестве энергоэффективных DPU с производительностью до 1,5 Тфлопс в режиме FP32 и 50 Топс в характерном для инференса режиме INT8.

Источник изображений здесь и далее: Kalray Выбор рынков не случаен: машинное зрение сегодня является быстро растущей отраслью, в 2023 году оцененной в более чем $20 млрд, а к 2032 году эта цифра обещает вырасти до $175 млрд. Про индексацию данных для генеративного ИИ нечего и говорить — на дворе бум подобных технологий, а объёмы наборов данных постоянно растут. Такие датасеты требуют эффективной предобработки, иначе растущее время выборки нужных данных будет сдерживать производительность и обучения, и инференса. Интересно, что производятся TC4 в Европе, на французской фабрике Asteelflash, уже получившей первый заказ на сумму более $1 млн. В силу перспективности избранных направлений не следует удивляться, что европейская инициатива Kalray и Asteelflash поддержана французским правительством в рамках программы CARAIBE. Уже в 2025 году планируется довести темпы производства ускорителей TC4 с сотен до нескольких тысяч в месяц. Coolidge 2, по словам создателей, представляет собой универсальное решение на базе архитектуры VLIW. Он имеет 80 ядер с частотой до 1,2 ГГц, причём каждое ядро располагает FPU (IEEE 754-2008). Имеются оптимизации для матричных операций и трансцендентных функций. Процессор разделён на 5 кластеров по 16 ядер, каждый кластер имеет дополнительное управляющее ядро, отвечающее также за функции безопасности. Дополняет Coolidge 2 кеш объёмом 8 Мбайт, двухканальный контроллер памяти DDR4-3200 и пара интерфейсов 100GbE с поддержкой RoCE. Чип поддерживает форматы INT8, FP16, FP32 и даже FP64. Поскольку на борту Turbocard4 работает сразу четыре Coolidge 2, речь идёт о 6 Тфлопс для FP32, 100 Тфлопс для FP16 и 200 Топс для INT8 при теплопакете в районе 120 Вт. Что касается программной поддержки, Kalray сопровождает свои решения SDK, базирующимся на открытых стандартах. Поддерживаются Linux и RTOS.

11.04.2024 [15:23], Сергей Карасёв

Студенты США первыми в мире получили собственный ИИ-суперкомпьютер NVIDIAИнженерный колледж Технологического института Джорджии (Georgia Tech) объявил о заключении соглашения о сотрудничестве с NVIDIA с целью создания первого в мире суперкомпьютерного центра ИИ, предназначенного для обучения студентов. Проект получил название AI Makerspace. Отмечается, что AI Makerspace позволит демократизировать доступ к вычислительным ресурсам, которые традиционно были доступны только исследователям и технологическим компаниям. В рамках проекта студенты смогут использовать возможности НРС-комплекса для углубления своих навыков работы с ИИ. Это поможет в выполнении курсовых работ и позволит учащимся получить ценный практический опыт. Фактически AI Makerspace — это выделенный вычислительный кластер. В создании системы приняли участие специалисты Penguin Solutions. Применяется платформа для работы с ИИ-приложениями NVIDIA AI Enterprise. На начальном этапе в составе ИИ-суперкомпьютера задействованы 20 систем NVIDIA HGX H100, насчитывающие в общей сложности 160 ускорителей NVIDIA H100. В качестве интерконнекта применяется NVIDIA Quantum-2 InfiniBand. В рамках сотрудничества с Georgia Tech компания NVIDIA окажет поддержку студентам и преподавателям Инженерного колледжа по программе NVIDIA Deep Learning Institute (Институт глубокого обучения NVIDIA). Данная инициатива предусматривает все виды практикумов по ИИ, ускоренным вычислениям, графике, моделированию и другим современным технологиям. AI Makerspace расширяет базовую теоретическую учебную программу Georgia Tech по ИИ, предлагая студентам практическую платформу для решения реальных задач, разработки передовых приложений и реализации своих идей.

11.04.2024 [14:52], Сергей Карасёв

В России растёт спрос на мощные облачные серверы для ИИ-задачКомпания iKS-Consulting обнародовала результаты исследования российского рынка облачных инфраструктур. По оценкам, в 2023 году его объём достиг 121,4 млрд руб., что на 33,9 % больше по сравнению с предыдущим годом, когда затраты оценивались в 90,6 млрд руб. При этом, как отмечается, в России растёт спрос на услуги аренды мощных серверов, предназначенных для задач ИИ и машинного обучения. Аналитики iKS-Consulting учитывают затраты в сегментах IaaS и PaaS. Говорится, что рынок облачных услуг в РФ находится на этапе бурного роста. Однако пока ещё не сложилась устоявшаяся структура спроса и предложения, а также существуют определённые опасения со стороны потенциальных клиентов. Директор по развитию бизнеса iKS-Consulting Дмитрий Горкавенко сообщил газете «Ведомости», что доля аренды серверов для обучения моделей ИИ на российском рынке облачных услуг в 2023 году составила 5,4 %. Для сравнения: годом ранее этот показатель равнялся приблизительно 4,0 %.

Источник изображения: iKS-Consulting Общая выручка компаний от аренды таких серверов в 2023 году составила почти 6,6 млрд руб. против 3,7 млрд руб. в 2022-м. Ключевыми игроками данного направления являются Cloud.ru, «Яндекс», «Крок», «Мегaфон», Selectel и CloudМТS. По прогнозам iKS-Consulting, к 2030 году доля выручки от услуг по аренде ИИ-серверов вырастет до 8,6 %, или до 50,3 млрд руб., при общем объёме рынка в 585,1 млрд руб. В исследовании также отмечается, что по итогам 2023 года в общем объёме выручки на рынке облачных инфраструктур около 4,8 %, или 5,9 млрд руб., пришлось на услуги вычислений на суперкомпьютерах. Годом ранее показатель был в 2,5 раза ниже — примерно 2,4 млрд руб., или 2,6% от общей выручки. Основными игроками в данном сегменте стали Cloud.ru, «Яндекс» и CloudМТS. В исследовании iKS-Consulting сказано, что сегмент B2G на российском рынке облачных услуг становится всё более значимым. Это связано с развитием государственных сервисов на базе облаков и активным переводом федеральных и региональных органов власти на единую облачную платформу.

11.04.2024 [14:47], Сергей Карасёв

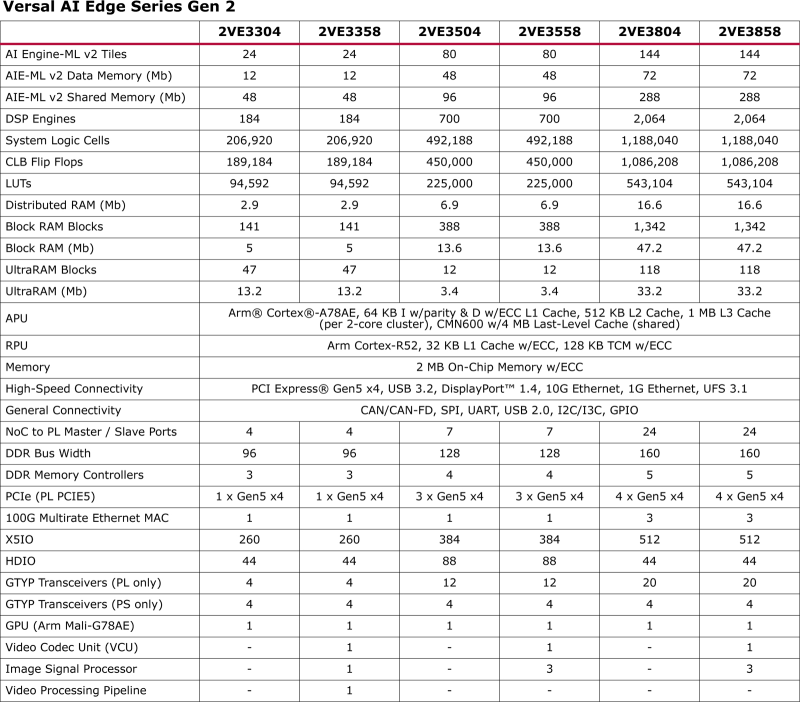

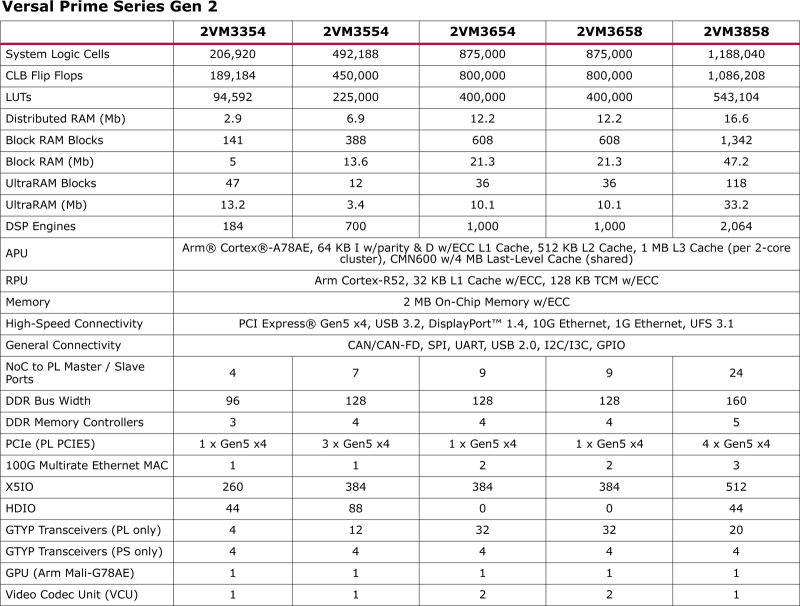

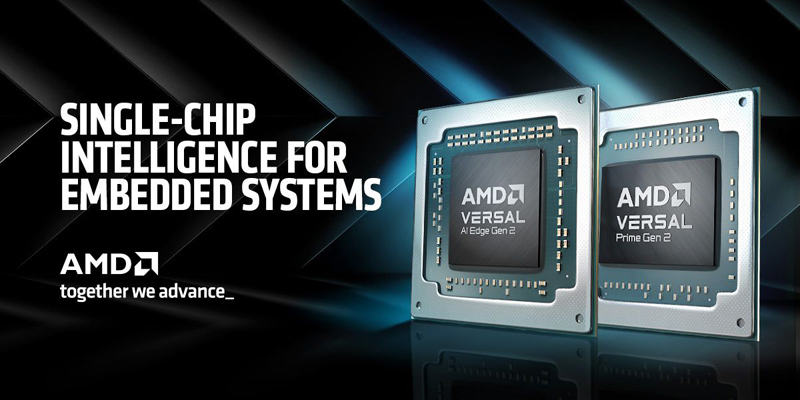

AMD представила гибридные FPGA Versal Gen 2 для встраиваемых систем с ИИКомпания AMD анонсировала так называемые адаптивные SoC семейства Versal второго поколения (Gen 2), предназначенные для встраиваемых систем со средствами ИИ. Утверждается, что чипы обеспечивают до трёх раз более высокий показатель производительности TOPS/Вт по сравнению с решениями Versal AI Edge первого поколения. Дебютировали чипы серий Versal AI Edge Gen 2 и Versal Prime Gen 2. Изделия первого семейства, как утверждается, содержат оптимальный набор блоков для решения задач на встраиваемых системах с ИИ: это предварительная обработка данных с помощью программируемой логики FPGA, инференс и постобработка с использованием ядер Arm.

Источник изображений: AMD Производительность INT8 у чипов Versal AI Edge Gen 2 в зависимости от модификации варьируется от 31 до 185 TOPS, быстродействие MX6 — от 61 до 370 TOPS. В составе процессора приложений задействованы ядра Arm Cortex-A78AE, количество которых может составлять 4 или 8. Кроме того, используются 4 или 10 ядер реального времени Arm Cortex-R52. Заявлена поддержка интерфейсов PCI Express 5.0 x4, USB 3.2, DisplayPort 1.4, 10GbE и 1GbE, UFS 3.1, CAN/CAN-FD, SPI, UART, USB 2.0, I2C/I3C, GPIO.

В свою очередь, решения Versal Prime Gen 2 предназначены для ускорения задач в традиционных встраиваемых системах, которые не работают с ИИ-приложениями. Они объединяют до восьми ядер Arm Cortex-A78AE и до 10 ядер реального времени Arm Cortex-R52. Набор поддерживаемых интерфейсов аналогичен изделиям Versal AI Edge Gen 2. Говорится о возможности многоканальной обработки видео в формате 8K. Отмечается, что новые процессоры лягут в основу систем для автомобильной, аэрокосмической и оборонной отраслей, промышленности, а также сфер машиностроения, здравоохранения, вещания и пр. Чипы позволяют разрабатывать высокопроизводительные продукты для периферийных вычислений.

11.04.2024 [13:11], Сергей Карасёв

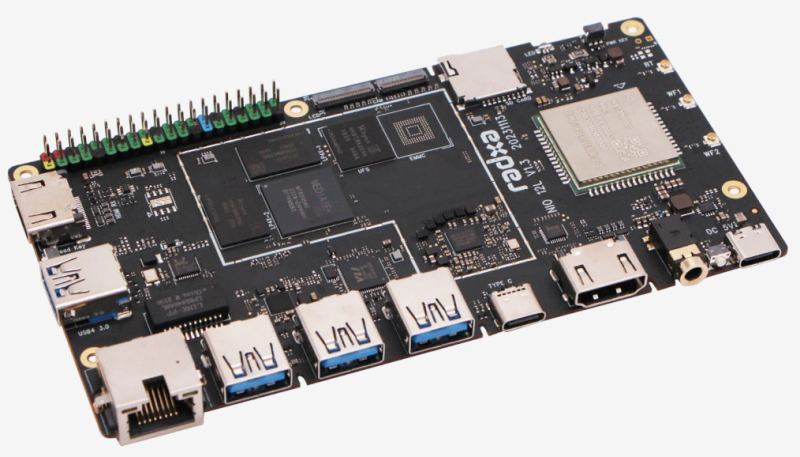

Низкопрофильный одноплатный компьютер Radxa NIO 12L с чипом Mediatek Genio 1200 получил сертификацию UbuntuКомпания Radxa, по сообщению ресурса CNX-Software, представила одноплатный компьютер NIO 12L в низкопрофильном исполнении. Новинка имеет сертификацию Ubuntu с обновлениями ПО на протяжении пяти лет и платной поддержкой на период до 10 лет. В основу решения положен чип Mediatek Genio 1200 (MT8395). Он содержит квартеты ядер Cortex-A78 (до 2,4 ГГц) и Cortex-A55 (до 2,0 ГГц), а также графический ускоритель Arm Mali-G57 MC5 с поддержкой OpenGL ES1.1, ES2.0 и ES3.2, OpenCL 1.1, 1.2 и 2.2, Vulkan 1.1 и 1.2. Предусмотрен двухъядерный ИИ-блок Cadence Tensilica VP6 с производительностью до 4 TOPS. Модуль VPU способен справляться с декодированием материалов 4Kp90 AV1/VP9/HEVC/H.264 и кодированием видео 4Kp60 HEVC/H.264. Одноплатный компьютер может нести на борту 4, 8 или 16 Гбайт оперативной памяти LPDDR4x-4266 и накопитель UFS 2.1 вместимостью 128, 256 или 512 Гбайт. Есть слот microSD, а опционально может быть задействован модуль eMMC. В оснащение входят адаптеры Wi-Fi 6 и Bluetooth 5.2, а также контроллер 1GbE с портом RJ-45. В набор разъёмов включены четыре порта USB 3.0 Type-A и порт USB 3.0 Type-C (DP), интерфейс HDMI с поддержкой видео 4Kp60, стандартное аудиогнездо на 3,5 мм. Доступна 40-контактная колодка GPIO (2 × UART, 2 × SPI, 2 × I2C, PCM/I2S, S/PDIF, PWM, ADC, 6 × GPIO). Среди прочего упомянута поддержка MIPI DSI и 2 × MIPI CSI (четыре линии). Питание (5 В) подаётся через вспомогательный разъём USB Type-C. Размеры платы составляют 140 × 75 мм. Диапазон рабочих температур — от 0 до +50 °C. Для Radxa NIO 12L заявлена совместимость с Android, Ubuntu и Yocto. Цена новинки начинается с $99.

11.04.2024 [13:04], Сергей Карасёв

«Гравитон» представил одноконтроллерные СХД с 36 отсекамиРоссийский поставщик вычислительной техники «Гравитон» анонсировал СХД серии СХ412И36БМ16Т. Новинки, как утверждается, подходят для работы с системами резервного копирования, архивного хранения, видеонаблюдения и для обработки потокового видео. Допускается применение СХД в качестве узлов хранения программно-определяемого хранилища (SDS). Устройства включены в реестр российской промышленной продукции Минпромторга. В серию вошли одноконтроллерные решения, выполненные в формате 4U. В основу положена материнская плата, разработанная и произведённая собственными силами. Использован процессор Intel Xeon Cascade Lake, дополненный 1 Тбайт оперативной памяти. СХД наделены 36 отсеками для накопителей LFF/SFF. Могут быть задействованы изделия SAS/SATA, а также NVMe (кеш). Дополнительно возможно подключение модулей расширения JBOD на 12, 24, 78 и 108 дисков. В семейство вошли модификация СХ412И36БМ16Т-РЭ (реестровый номер 5530\2\23) с ПО RAIDIX 5.2. и версия СХ412И36БМ16Т-АР (реестровый номер 5530\3\23) с ПО АРГО. Эти программные решения включены в реестр российских программ для ЭВМ и БД Минцифры России. Отмечается, что СХД предлагаются в качестве комплексного решения и имеют подтвержденную совместимость с используемым ПО. Возможна поставка системы без софта в качестве сервера хранения — это модель СХ412И36БМ16Т-0 (реестровый номер 5530\1\23).

11.04.2024 [02:16], Владимир Мироненко

Второе поколение ИИ-ускорителей Meta✴ MTIA втрое быстрее первогоКомпания Meta✴ поделилась подробностями о следующем собственных ИИ-ускорителей Meta✴ Training and Inference Accelerator. Новый чип отличается более высокой производительностью по сравнению со чипом MTIA v1, представленным в мае прошлого года, и будет играть решающую роль в обеспечении работы ИИ-моделей Meta✴. Следующее поколение крупномасштабной инфраструктуры Meta✴ рассчитано на поддержку новых продуктов и услуг в области генеративного ИИ, рекомендательных систем и передовых исследований в области ИИ. Создание нового чипа является частью инвестиций в инфраструктуру. В ближайшие годы, как ожидается, затраты в этом направлении будут расти, поскольку требования к вычислительным ресурсам для поддержки моделей будут расти вместе с усложнением последних.

Источник изображений: Meta✴ Архитектура чипа ориентирована на обеспечение «правильного баланса вычислений, пропускной способности и объёма памяти» даже при относительно небольших размерах обрабатываемых последовательностей. MTIA v2 в сравнении с MTIA v1 в 3,5 раза быстрее в обычных вычислениях и в 7 раз — в разреженных. Новый чип изготавливается по 5-нм техпроцессу TSMC и имеет габариты 25,6 × 16,4 мм (упаковка 40 × 50 мм). Ускоритель работает на частоте 1,35 ГГц, а его TDP составляет 90 Вт, тогда как 7-нм MTIA v1 работал на частоте 800 МГц и имел TDP всего 25 Вт. Готовая стоечная система вмещает до 72 ускорителей и состоит из трёх шасси с 12 платами, на каждой из которых размещено по два ускорителя. Для дальнейшего масштабирования можно добавить RDMA-сеть.  Чип состоит из 64 вычислительных элементов (PE). У каждого PE есть небольшой блок локальной памяти объёмом 384 Кбайт с ПСП 1 Тбайт/с. На весь чип приходится 256 Мбайт SRAM (2,7 Тбайт/с), а внешняя память представлена 128 Гбайт LPDDR5 (204,8 Гбайт/с). Для подключения к хосту используется интерфейс PCIe 5.0 x8 (32 Гбайт/с). При работе с матрицами чип развивает 177 (FP16/BF16) и 354 (INT8) Тфлопс, в разреженных вычислениях — вдвое больше. SIMD-блоки выдают 2,76 Тфлопс для FP32 и 5,53 Тфлопс для INT8/FP16/BF16. В векторных расчётах значения те же, только для INT8 показатель составляет уже 11,06 Тфлопс. MTIA v2 совместим с кодами, разработанными для MTIA v1. Стек MTIA ориентирован на PyTorch 2.0 и включает компилятор Triton-MTIA. Предварительные испытания MTIA v2 на четырёх ключевых ИИ-моделях компании показали, что он втрое быстрее MTIA v1 чип первого поколения. А на уровне платформы достигнуто шестикратное увеличение пропускной способности модели и рост производительности на Вт в 1,5 раза. Чипы MTIA уже развёрнуты в ЦОД компании. Правда, для обучения Meta✴ их пока не использует.

10.04.2024 [23:25], Владимир Мироненко

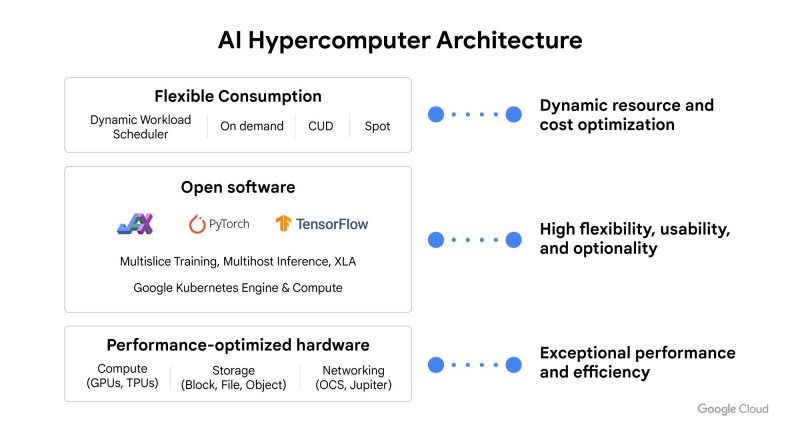

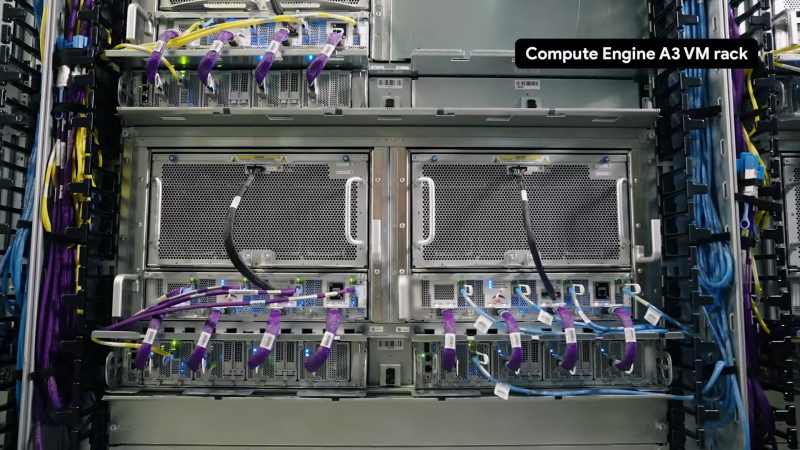

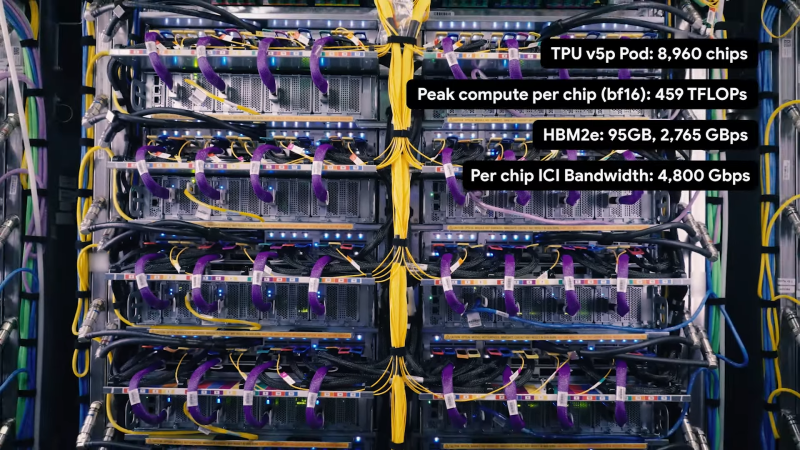

Google Cloud объявила о масштабном обновлении AI HypercomputerGoogle Cloud объявила о масштабном обновлении программно-аппаратного стека AI Hypercomputer, а также о новых инстансах на базе передовых ускорителей NVIDIA, пишет ресурс SiliconANGLE. Также компания представила обновлённую инфраструктуру хранения данных для рабочих нагрузок ИИ, базовое ПО для запуска моделей и более гибкие варианты использования ресурсов. Компания объявила о доступности TPU v5p в GKE, что позволит клиентам обучать и обслуживать ИИ-модели, работающие в крупномасштабных кластерах TPU. В качестве альтернативы клиенты также смогут использовать ускорители NVIDIA H100 в составе инстансов A3. Одним из основных преимуществ нового подсемейства A3 Mega является поддержка конфиденциальных вычислений. В Google подчеркнули важность этой функции, поскольку обработка чувствительных данных в облаке считалась слишком рискованной из-за возможной утечки. Google Cloud пообещала предоставить клиентам ускорители NVIDIA Blackwell. Обновления включают в себя доступность модуля Cloud Storage FUSE, который предоставляет файловый доступ к ресурсам облачного хранилища. По данным Google, GCS FUSE обеспечивает увеличение производительности обучения в 2,9 раза по сравнению с существующими СХД. Другие улучшения включают появление поддержки кеширования в превью Parallelstore, высокопроизводительной параллельной файловой системы, оптимизированной для нагрузок ИИ и HPC. Благодаря кешированию Parallelstore позволит сократить время обучения до 3,9 раз и повысить производительность обучения в 3,7 раза. Компания также объявила об оптимизации службы Google Cloud Filestore, ориентированной на ИИ, которая представляет собой сетевую файловую систему, позволяющую целым кластерам ускорителей получать одновременный доступ к одним и тем же данным. Ещё одно новшество — сервис Hyperdisk ML, предоставляющий блочное хранилище, доступный сейчас в качестве превью. Google Cloud сообщила, что его использование позволит ускорить загрузку модели до 12 раз по сравнению с альтернативными сервисами. Кроме того, компания представила Jetstream, новую систему инференса LLM. Это открытое решение, оптимизированное по пропускной способности и использованию памяти для ИИ-ускорителей вроде TPU. По словам компании, новинка обеспечит в три раза более высокую производительность на доллар для Gemma 7B и других открытых ИИ-моделей, а это важно, поскольку клиенты переносят свои ИИ-нагрузки в облако и им нужен экономичный, но производительный инференс. JetStream предлагает поддержку моделей, обученных с помощью JAX и PyTorch/XLA, а также включает оптимизацию для популярных открытых моделей, таких как Llama 2 и Gemma. Что касается собственно моделей, то компания представила MaxDiffusion для генерации изображений, добавила в MaxText ряд новых моделей, в том числе Gemma, GPT3, Llama 2 и Mistral. MaxDiffusion и MaxTest базируются на высокопроизводительном фреймворке JAX, который интегрирован с оптимизирующим компилятором OpenXLA. Заодно Google объявила о поддержке последней версии PyTorch — PyTorch/XLA 2.3. |

|