Материалы по тегу: hardware

|

05.12.2024 [23:55], Владимир Мироненко

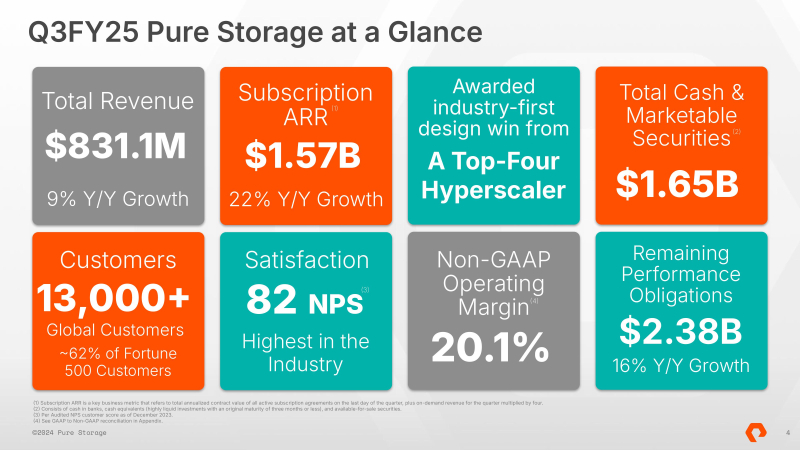

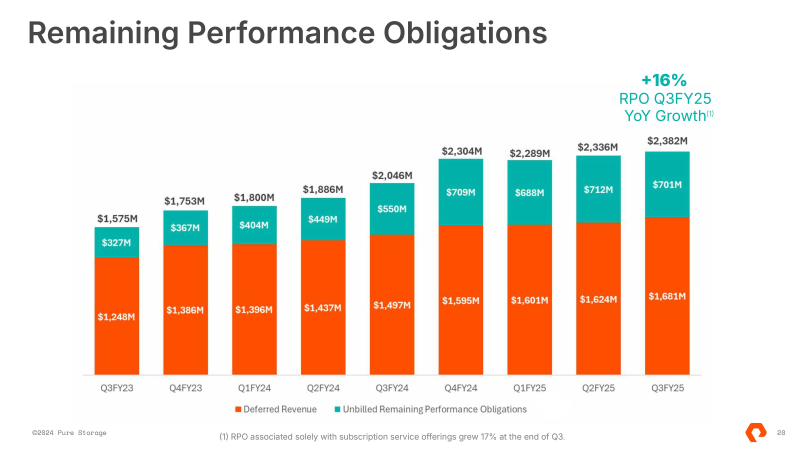

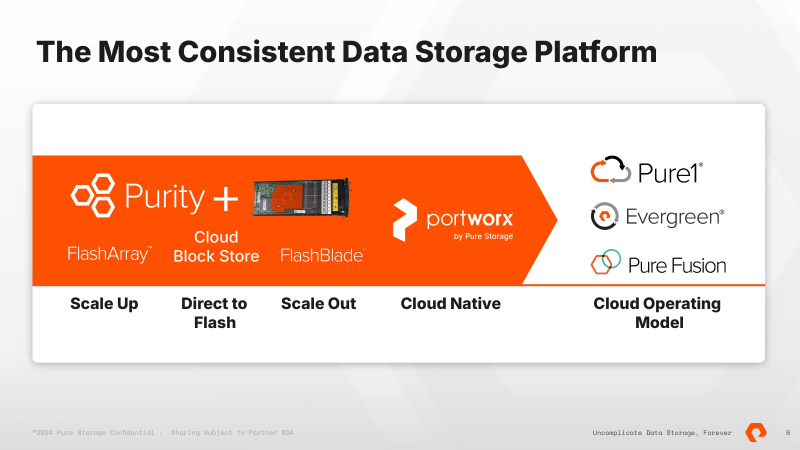

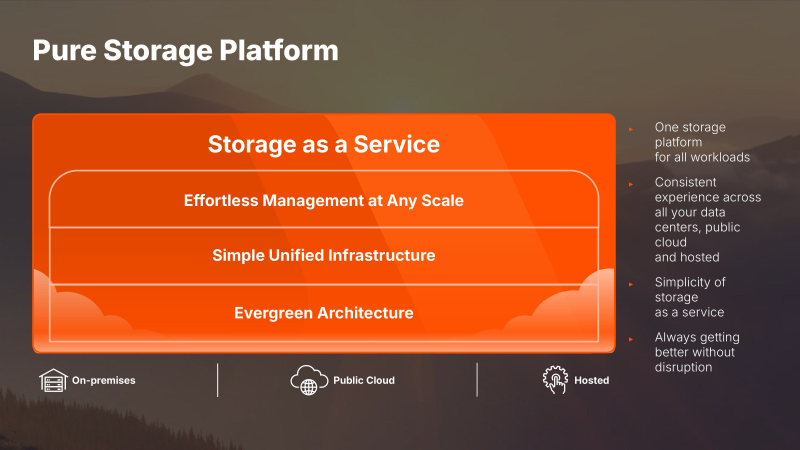

Pure Storage, намеревающаюся изжить HDD из ЦОД, стала на шаг ближе к мечте — заключены соглашения с Amazon, Microsoft, Google и Meta✴Компания Pure Storage, специализирующаяся на All-Flash СХД, объявила финансовые результаты III квартала 2025 финансового года, закончившегося 3 ноября 2024 года. Выручка компании за квартал составила $831,1 млн, превысив на 9 % показатель аналогичного периода предыдущего финансового года, а также прогноз аналитиков Уолл-стрит в размере $815 млн. Ежегодный регулярный доход (ARR) от подписки увеличился на 22 % до $1,6 млрд. Выручка от продажи продуктов осталась практически на прежнем уровне — $454,7 млн с незначительным ростом на 0,4 %. Выручка от услуг подписки равна $376,3 млн (рост год к году на 22 %). Оставшиеся обязательства по исполнению контрактов оцениваются в $2,38 млрд, что на 16 % больше в годовом исчислении. Чистая прибыль Pure Storage составила $63,6 млн, что на 9,6 % меньше год к году. Скорректированная чистая прибыль на акцию (non-GAAP) составила $0,50, превысив прогноз Уолл-стрит в размере $0,41. Количество клиентов Pure Storage выросло за квартал на 430 и теперь превышает 13 тыс., включая 62 % из списка Fortune 500, что на 60 % больше, чем год назад. Прогноз компании на текущий квартал по выручке составляет $867 млн выручки, что на 9,7 % больше, чем в предыдущем году. Pure Storage пересмотрела прогноз на весь 2025 финансовый год, который теперь составляет $3,15 млрд, что выше предыдущего показателя в $3,1 млрд. Компания ожидает ежегодный рост выручки на 11,5 %. После квартального отчёта акции Pure Storage взлетели на 24 %, чему также способствовал оптимистичный прогноз компании и информация о сделках, заключённых с гиперскейлерами. В отчёте Pure Storage сообщается о подписании лицензионных соглашений с гиперскейлерами — AWS, Azure, Google и Meta✴ — на использование Purity OS и Direct Flash Module (DFM), которые позволят ей нарастить выручку в 2027 финансовом году. По словам компании, заключению соглашений предшествовало 12 месяцев переговоров. Как отметил гендиректор Pure Storage Чарли Джанкарло (Charlie Giancarlo), «это первая в истории победа в области дизайна All-Flash хранилищ для гиперскейлеров». Он подчеркнул, что на рынок гиперскейлеров сегодня приходится 60–70 % всех жёстких дисков, купленных в мире. Джанкарло добавил, что помимо предоставления экономически эффективного хранилища данных, использование технологии Pure позволит гиперскейлерам сэкономить значительные объёмы электроэнергии и пространства в ЦОД. Компания неоднократно заявляла, что жёстким дискам нет места в современных ЦОД. «Также ожидается, что это значительно снизит частоту отказов и расходы на обслуживание, связанные с устаревшим дисковым хранилищем, при этом удвоив ожидаемый срок службы инфраструктуры хранения», — сообщил глава Pure Storage. «Наша победа в разработке свидетельствует о том, что технология DirectFlash от Pure теперь готова заменить жёсткие диски повсюду, и поставщики NAND обращают на это внимание и планируют свои возможности для выхода на этот рынок объёмом 700 Эбайт в год», — отметил Джанкарло. При этом финансовый директор Кеван Крайслер (Kevan Krysler) сообщил, что речь идёт лицензировании технологии и предоставлении услуг поддержки. То есть, продажа оборудования не включена в сделку с гиперскейлерами. Это означает, что Pure Storage получит значительно меньше выгоды от сделки, чем если бы она продала также и оборудование. «Клиент будет покупать оборудование у своего интегратор. Так что для нас это в основном лицензионные сборы, сборы за ПО и сборы за поддержку», — подтвердил Джанкарло. Как отметил ресурс Blocks & Files, «это открывает возможность для Pure повторить сделку со своими крупными корпоративными клиентами, лицензируя свою технологию для использования на сертифицированном оборудовании, купленном у интегратора. Это похоже на то, как VAST Data продает свою технологию». Pure Storage пообещала «продолжить диалоги с другими крупными гиперскейлерами» и ожидает «увеличения инвестиций в свою гипермасштабируемую линейку бизнеса в течение следующего года». На этой неделе Pure Storage представила решение Pure Storage FlashArray for AWS Outposts, которое позволит организациям модернизировать приложения, сохраняя при этом контроль в своих ЦОД. Теперь клиенты смогут легко подключать блочные тома из Pure Storage FlashArray к экземплярам EC2 на AWS Outposts, используя консоль управления AWS.

05.12.2024 [22:47], Руслан Авдеев

Дженсен Хуанг пообещал Таиланду помочь в развитии ИИ и ЦОД, но путь этот будет непростымNVIDIA намерена сотрудничать с правительством Таиланда в деле создания инфраструктуры ИИ мирового класса. При этом вызывает вопрос способность Таиланда в полной мере использовать свои сильные стороны для формирования экосистемы ИИ ЦОД, сообщает DigiTimes. 3 декабря глава NVIDIA Дженсен Хуанг (Jensen Huang) встретился с премьер-министром Таиланда Пхэтхонгтхан Чиннават (Paetongtarn Shinawatra). Стороны пришли к соглашению об углублении взаимодействия в сфере ИИ-технологий. NVIDIA будет работать с правительством над созданием ИИ-инфраструктуры мирового уровня и предоставит талантливые кадры для поддержки таиландских инициатив в области ИИ. Кроме того, компания поддержит более 50 ИИ-стартапов и вложится в университетские программы обучения ИИ-специальностям. Хуанг также посетил мероприятие первого облачного партнёра NVIDIA в Таиланде — Siam.AI Cloud. Его руководство имеет заметное политическое влияние в стране и родственные связи как с бывшим, так и с действующим премьер-министрами. Визит Хуанга рассматривается как весьма положительное для ИИ-сектора страны событие. Не исключается даже, что в перспективе она сможет конкурировать с Малайзией и Индонезией и сможет привлечь в индустрию ЦОД ещё больше инвестиций, в том числе на производство серверного оборудования. Сотрудничество с NVIDIA также должно поспособствовать более широкому внедрению ИИ в стране. Вместе с тем всё ещё есть некоторые трудности для развития ИИ-экосистемы: высокие налоги на импорт, немалые расходы на передачу данных и дорогая электроэнергия. Из-за этого страна может оказаться не особенно привлекательной для крупных ЦОД. Некоторые эксперты и вовсе уверены, что создание ЦОД не повлияет на местную промышленность и не поможет сократить расходы на местные облака. Инвестиции в дата-центры способны обеспечить рост ВВП Таиланда, но они же увеличат и потребление электричества. Исследователи считают, что Таиланд может получить выгоду от ИИ ЦОД, используя свои компетенции в области ПО и SaaS. Однако в стране не хватает талантливых кадров в сфере полупроводников, что не позволяет ей играть значимую роль в мировых цепочках поставок. О возможном визите Хуанга в Бангкок сообщалось ещё в конце октября, но масштаб инвестиций значительно меньше объёмов вложений в страну со стороны AWS, Microsoft и Google. Так или иначе, страна активно ищет инвесторов для развития местной ИИ-экосистемы и полупроводниковой отрасли.

05.12.2024 [17:55], Владимир Мироненко

Net One построит ЦОД мощностью 125 МВт на базе собственной электрогенерацииРоссийский универсальный оператор современных телекоммуникационных сервисов Net One объявил о старте строительства ЦОД мощностью 125 МВт на принадлежащей партнёру промышленной площадке в Тверской области площадью свыше 10 Га. Площадка расположена в непосредственной близости как к транспортным магистралям, так магистральным каналам операторов связи. Проект будет реализован на базе собственной электрогенерации, подкреплённой контрактом на поставку трубопроводного природного газа, объём которого позволяет обеспечить электроэнергией ЦОД мощностью 125 МВт с не менее 10 000 серверных стоек уровней TIER III/TIER IV мощностью до 20 кВт на стойку.

Источник изображения: Net One Реализация проекта пройдёт в несколько этапов. На первом этапе планируется ввод газовой и электрогенерирующей инфраструктуры номинальной мощностью 25 МВт, на строительство которой предусмотрено более 1,68 млрд руб., и строительство ЦОД на 2000 серверных стоек. Согласно заявлению гендиректора Net One, приведенному в пресс-релизе, нехватка недорогих энергомощностей на фоне растущего энергопотребления действующих ЦОД гарантирует интерес к проекту как со стороны кэптивных заказчиков и инвесторов, так и стабильный спрос на открытом рынке.

05.12.2024 [16:14], Сергей Карасёв

Запущен британский Arm-суперкомпьютер Isambard 3 с суперчипами NVIDIA GraceВ Великобритании введён в эксплуатацию суперкомпьютер Isambard 3, предназначенный для ресурсоёмких приложений ИИ и задач НРС. Реализация проекта обошлась приблизительно в £10 млн, или примерно $12,7 млн. Машина пришла на смену комплексу Isambard 2, который отправился на покой в сентябре нынешнего года. Система Isambard 3 создана в рамках сотрудничества между исследовательским консорциумом GW4 Alliance, в который входят университеты Бата, Бристоля, Кардиффа и Эксетера, а также компаниями HPE, NVIDIA и Arm. Суперкомпьютер назван в честь британского инженера Изамбарда Кингдома Брюнеля, внесшего значимый вклад в Промышленную революцию. Полностью технические характеристики Isambard 3 не раскрываются. Известно, что в основу машины положены 384 суперпроцессорами NVIDIA Grace со 144 ядрами (2 × 72) Arm Neoverse V2 (Demeter), общее количество которых превышает 55 тыс. Задействована высокопроизводительная СХД HPE, которая обеспечивает расширенные IO-возможности с интеллектуальным распределением данных по нескольким уровням. Благодаря этому достигается эффективная обработка задач с интенсивным использованием информации, таких как обучение моделей ИИ. Известно также, что в составе комплекса применяется фирменный интерконнект HPE Slingshot, а в качестве внутреннего интерконнекта служит технология NVLink-C2C, которая в семь раз быстрее PCIe 5.0. Каждый узел суперкомпьютера содержит один суперчип Grace и сетевой адаптер Cassini с пропускной способностью до 200 Гбит/с. Объём системной памяти составляет 2 × 120 Гбайт (240 Гбайт). Отмечается, что Isambard 3 демонстрирует в шесть раз более высокую производительность и в шесть раз лучшую энергоэффективность по сравнению с Isambard 2. Пиковое быстродействие FP64 у Isambard 3 достигает 2,7 Пфлопс при энергопотреблении менее 270 кВт. Применять новый суперкомпьютер планируется для таких задач, как проектирование оптимальной конфигурации ветряных электростанций на суше и воде, моделирование термоядерных реакторов, исследования в сфере здравоохранения и пр. Суперкомпьютер расположен в автономном дата-центре с системой самоохлаждения HPE Performance Optimized Data Center (POD) в Национальном центре композитов в Научном парке Бристоля и Бата. Там же ведётся монтаж ИИ-комплекса Isambard-AI стоимостью £225 млн ($286 млн), который должен стать самым быстрым и мощным суперкомпьютером в Великобритании. Проект Isambard-AI реализуется в несколько этапов. Первая фаза предполагает монтаж 42 узлов, каждый из которых несёт на борту четыре суперчипа NVIDIA GH200 Grace Hopper и 4 × 120 Гбайт памяти для CPU (доступно 460 Гбайт — по 115 Гбайт на CPU), а также 4 × 96 Гбайт памяти для GPU (H100). В ходе второй фазы будут добавлены 1320 узлов, насчитывающих в сумме 5280 суперчипов NVIDIA GH200 Grace Hopper. Кроме того, в состав Isambard 3 входит экспериментальный x86-модуль MACS (Multi-Architecture Comparison System), включающий сразу восемь разновидностей узлов на базе процессоров AMD EPYC и Intel Xeon нескольких поколений, часть из них также имеет ускорители AMD Instinct MI100 и NVIDIA H100/A100. Все они объединены 200G-интерконнектом HPE Slingshot.

05.12.2024 [14:28], Руслан Авдеев

OpenAI намерена построить в США собственные ИИ ЦОД для коммерциализации технологийКомпания OpenAI намерена построить собственные дата-центры в США в рамках плана по привлечению к своим сервисам 1 млрд пользователей и дальнейшей коммерциализации своих технологий. По словам представителя OpenAI, компания намерена получить в своё распоряжение ЦОД как для обучения, так и для инференса, сообщает Financial Times. По словам представителя компании, «чипы, данные и энергия» станут ключевыми факторами, которые помогу компании выиграть в гонке ИИ-технологий и создать AGI, потенциально соответствующий возможностям человеческого мозга или даже превосходящий его. OpenAI намерена построить кластеры ЦОД на Среднем Западе и юго-востоке США. Подробности пока не разглашаются, но подтверждается, что строительство дата-центров является частью стратегии коммерциализации ИИ-технологий компании. В своё время OpenAI была основана как некоммерческая организация, но теперь переходит к более традиционной для бизнеса корпоративной структуре. Как сообщает Financial Times, компания наняла своего первого главу по финансам и продуктам и теперь якобы рассматривает возможности интеграции рекламы в свои решения. Что касается действующей цифровой инфраструктуры OpenAI, которая ранее в этом году привлекла ещё $6,6 млрд, в основном полагается на дата-центры Microsoft Azure — именно Microsoft вложила в стартап миллиарды долларов. Недавно компания начала посматривать и на других облачных провайдеров, а в июне анонсировала партнёрство с Oracle, в рамках которого Oracle Cloud Infrastructure будет задействована для обучения ИИ-моделей (правда, тоже при посредничестве Microsoft). Запросы компании превышают мощности, которые способна предоставить ей Microsoft. Не так давно OpenAI пыталась убедить правительство США в необходимости создания 5-ГВт дата-центров, способных вместить сразу 2 млн ускорителей. Компания заявила, что это уже вопрос национальной безопасности, и даже подготовила целый ряд рекомендаций.

05.12.2024 [13:37], Сергей Карасёв

AWS представила инстансы EC2 P5en на базе NVIDIA H200 и кастомизированных чипов Intel XeonОблачная платформа AWS объявила о доступности инстансов EC2 P5en, рассчитанных на такие нагрузки, как глубокое обучение, генеративный ИИ, обработка данных в реальном времени и приложения HPC. В основу новых экземпляров положены аппаратные компоненты Intel и NVIDIA. В частности, задействованы кастомизированные процессоры Xeon Sapphire Rapids. У них все ядра могут одновременно работать на турбо-частоте 3,2 ГГц, а максимальная частота отдельных ядер достигает 3,8 ГГц. Кроме того, применяются ИИ-ускорители NVIDIA H200 и адаптеры AWS Elastic Fabric Adapter (EFA) v3 с пропускной способностью до 3,2 Тбит/с. Конфигурация инстансов EC2 P5en включает 192 vCPU, 2048 ГиБ памяти, восемь ускорителей H200 и восемь SSD вместимостью 3,84 Тбайт каждый. Пропускная способность EBS составляет 100 Гбит/с. Отмечается, что экземпляры P5en демонстрируют увеличение производительности локального хранилища до двух раз и пропускной способности EBS до 25 % по сравнению с инстансами P5 на базе NVIDIA H100.

Источник изображения: NVIDIA На сегодняшний день инстансы EC2 P5en доступны в американских регионах AWS US East (Огайо) и US West (Орегон), а также в Азиатско-Тихоокеанском регионе в Токио. Предлагаются различные тарифные опции, включая оплату по мере использования. Ранее были представлены инстансы EC2 P5e с процессорами AMD EPYC Milan, 2 ТиБ памяти, восемью ускорителями NVIDIA H200 и восемью NVMe SSD на 3,84 Тбайт каждый. У этих экземпляров пропускная способность EBS равна 80 Гбит/с.

05.12.2024 [09:13], Руслан Авдеев

AWS представила новую архитектуру ИИ ЦОД, энергоэффективную и экологичную

aws

hardware

pue

водоснабжение

дизель

ибп

ии

охлаждение

сжо

сша

цод

экология

электропитание

энергетика

энергоэффективность

AWS рассказала об инновациях, внедряемых в её ЦОД для поддержки ИИ-нагрузкок следующего поколения. По данным DataCenter Dynamics, нововведения связаны в первую очередь с электропитанием и охлаждением. Они направлены на повышение энергоэффективности дата-центров AWS. Первые ЦОД на базе новой архитектуры заработают в начале 2025 года. Новые решения в свежих новых дата-центрах компании по всему миру, а некоторые начнут применять уже на существующих объектах. В компании подчёркивают, что решения изначально спроектированы как модульные, поэтому возможная поэтапная модернизация площадок для внедрения СЖО, повышения энергоэффективности и снижения углеродного следа. Так, AWS упростит электрическую и механическую структуру новых ЦОД, чтобы облегчит их обслуживание и повысить надёжность. В частности, упростится подход к распределению энергии внутри ЦОД, а источники резервного питания будут размещаться ближе к стойкам. Это позволит повысить доступность инфраструктуры до 99,9999 % времени, а количество стоек, которых могут коснуться проблемы с энергоснабжением, снизится на 89 %. Также уменьшится количество вентиляторов для отвода горячего воздуха. Вместо этого будет применяться естественный перепад давления, что положительно скажется на энергопотреблении. Вместе с тем AWS намерено вшестеро увеличить мощность стойки в следующие два года, и ещё втрое — в будущем. Впрочем, в ИИ-серверах, где мощность ускорителей приближается к 1 кВт, без СЖО обойтись сложно. AWS готовит суперкластеры Project Rainier и Project Ceiba на базе AWS Tranium2 и NVIDIA Blackwell соответственно, поэтому она вместе с крупным производителем СЖО будет внедрять прямое жидкостное охлаждение и в новых, и в старых ЦОД. В некоторых случаях будет использоваться и гибридное охлаждение. Одним из главных плюсов новой архитектуры охлаждения является гибкость — акцент на воздушное или жидкостное охлаждение будет делаться в зависимости от потребностей оборудования и возможностей конкретных дата-центров. Заодно AWS использовала имеющиеся данные и генеративный ИИ для поиска наиболее эффективного способа размещения стоек в своих ЦОД, добавив ещё 12 % вычислительных мощностей на каждую площадку. Новая технология будет применяться как к новому оборудованию для ИИ-систем, так и для других типов техники. Также компания внедрила собственную систему управления механическими и электрическими устройствами — она поможет стандартизировать мониторинг и эксплуатацию дата-центров. Наконец, предприняты усилия по повышению экобезопасности дата-центров. AWS заявила, что новая архитектура охлаждения снизит потребление энергии на 46 % во времена пиковых нагрузок без увеличения потребления воды. Доля углеродных выбросов при производстве бетона, используемого при строительстве ЦОД, уменьшена на 35 % относительно средней по отрасли, кроме того, на 35 % сокращается потребление стали в целом, а та, что используется, поступает из электродуговых печей, а не газовых, что сокращает косвенные выбросы. Наконец, резервные генераторы AWS переведут на возобновляемое дизельное топливо. Дополнительно AWS совместно с Orbital Materials запустила пилотный проект по тестированию разработанного с помощью ИИ материала, помогающего захватывать в дата-центрах углекислый газ — речь идёт о «губке на атомном уровне», взаимодействующей только с молекулами углекислоты. Тестирование материала, три года разрабатывавшегося компаниями, начнётся в начале 2025 года. По данным Orbital, новый материал значительно дешевле аналогов. В дальнейшем стартап планирует испытать разработанные с помощью ИИ технологии для экономии воды и охлаждения чипов. DataCenter Dynamics также отмечает, что AWS впервые раскрыла показатель PUE своих дата-центров. В среднем он составляет 1,15, а самая лучшая площадка достигла 1,04. Для сравнения: у Google эти показатели составляют 1,1 и 1,06 соответственно, у Microsoft — 1,18 и 1,12 (у новых объектов). ЦОД Meta✴ в среднем имеют PUE около 1,08, а Oracle говорит об 1,15.

05.12.2024 [08:26], Владимир Мироненко

ЦОД солнечной обсерватории NASA SDO затопило — ремонт продлится до 2025 годаИз-за прорыва трубы системы охлаждения в серверной объединённого центра космических операций NASA при Стэнфордском университете (JSOC) вышло из строя оборудование, использовавшееся для обработки данных об активности Солнца, поступающих от обсерватории солнечной динамики (SDO), а также с космического зонда IRIS. Об этом сообщил ресурс Space. Из-за сильного затопления был нанесён значительный ущерб лаборатории, где размещаются серверы, «обрабатывающие и распределяющие данные с инструментов Helioseismic and Magnetic Imager (HMI) и Atmospheric Imaging Array (AIA), а также с космического аппарата IRIS», сообщили члены команды JSOC, добавив, что ремонт продлится до 2025 года. Учёные также отметили, что обработка научных данных, поступающих с HMI, AIA и IRIS, будет отложена на продолжительное время, как и доступ к архивным данным в JSOC. SDO в целом ежемесячно предоставляет около 42 Тбайт данных. Хотя данные с SDO продолжат поступать, их пока нельзя обрабатывать в режиме реального времени, что негативно отразится на возможности оценки солнечной погоды. Сообщается, что до восстановления оборудования JSOC данные с прибора HMI будут храниться в Нью-Мексико. SDO, запущенная на орбиту в 2010 году, позволяет вести наблюдения за Солнцем, уделяя особое внимание его магнитному полю, циклам активности и влиянию на Солнечную систему, и помогает учёным лучше понять, как солнечная активность влияет на жизнь на Земле. HMI и AIA — два из трёх научных инструментов SDO. Как сообщается, данный инцидент не отразился на обработке данных, собираемых третьим инструментом, Extreme Ultraviolet Variability Experiment (EVE).

04.12.2024 [17:43], Сергей Карасёв

AWS построит распределённый ИИ-суперкомпьютер Project Rainier с десятками тысяч ИИ-ускорителей Trainium2Облачная платформа AWS официально представила инстансы EC2 Trn2 и Trn2 UltraServer — самые высокопроизводительные решения EC2, ориентированные на ИИ-приложения, машинное обучение и задачи инференса. В основу положены фирменные ускорители Amazon Trainium2 второго поколения. ИИ-ускорители Trainium2 содержат восемь ядер NeuronCore и 96 ГиБ памяти HBM с пропускной способностью 2,9 Тбайт/с. Ядра могут адресоваться и использоваться по отдельности или же пары физических ядер могут быть сгруппированы в один логический блок. Trainium2 обеспечивает FP8-быстродействие до 1,3 Пфлопс, а FP8-производительность в разреженных вычислениях достигает 5,2 Пфлопс. Инстансы EC2 Trn2 содержат 16 ускорителей Trainum2, связанных посредством интерконнекта NeuronLink. В сумме это даёт 128 ядер NeuronCore и 1,5 ТиБ памяти HBM с суммарной пропускной способностью 46 Тбайт/с. Производительность на операциях FP8 достигает 20,8 Пфлопс. Каждый инстанс включает 192 vCPU, 2 ТиБ памяти и адаптеры AWS Elastic Fabric Adapter (EFA) v3 на 3,2 Тбит/с. Утверждается, что инстансы Trn2 обеспечивают в четыре раза более высокую производительность, в четыре раза большую пропускную способность памяти и в три раза большую ёмкость памяти, нежели инстансы Trn1. Кроме того, экземпляры Trn2 предлагают на 30–40 % лучшее соотношение цены и производительности, чем EC2 P5e и P5en на базе GPU. Инстансы Trn2 доступны в регионе AWS US East (Огайо), а в ближайшем будущем появятся и в других зонах. В свою очередь, платформа UltraServer включает четыре инстанса Trn2 (64 ускорителя Trainum2) с интерконнектом NeuronLink с низкой задержкой. В сумме это даёт 512 ядер NeuronCore и 6 ТиБ памяти HBM с суммарной пропускной способностью 185 Тбайт/с. Быстродействие на операциях FP8 составляет 83 Пфлопс (332 Пфлопс в разреженных вычислениях). Новые узлы используют СЖО. Десятки тысяч ускорителей Trainium2 могут формировать кластеры EC2 UltraCluster. В частности, такую систему в рамках инициативы Project Rainier компания Amazon намерена создать в партнёрстве со стартапом Anthropic, который специализируются на технологиях генеративного ИИ. Интересно, что ИИ-суперкомпьютер Project Rainier будет распределённым — его узлы разместятся сразу в нескольких ЦОД. ВОЛС между дата-центрами организует Lumen. Одной из причин от попытки построить один гигантский кампус называется невозможность быстро получить достаточно энергии в одном месте, хотя у компании уже есть площадка рядом с АЭС. Недавно Amazon объявила о намерении удвоить инвестиции в Anthropic, доведя их до $8 млрд. Создание системы Rainier планируется завершить в следующем году. Ожидается, что она станет одним из крупнейших в мире вычислительных кластеров для обучения моделей ИИ. По заявлениям AWS, комплекс обеспечит в пять раз более высокую производительность по сравнению с платформой, которую Anthropic использовала до сих пор для разработки своих языковых моделей. Достанутся ли Anthropic и ресурсы ещё облачного ИИ-суперкомпьютера Project Ceiba, который получит 21 тыс. суперчипов NVIDIA Blackwell, не уточняется. Кроме того, по сообщению The Register, компания Amazon приоткрыла завесу тайны над ИИ-ускорителями следующего поколения — изделиями Trainium3. По сравнению с предшественниками они, как утверждается, обеспечат четырёхкратное увеличение быстродействия. Говорится, что Trainium3 станет первым специализированным ускорителем для ИИ и машинного обучения, созданным на основе 3-нм техпроцесса. Эффективность по сравнению с Trainium2 увеличится примерно на 40 %. Ожидается, что на коммерческом рынке изделия Trainium3 появятся в конце 2025 года.

04.12.2024 [15:44], Руслан Авдеев

Marvell перенесёт разработку чипов в облако AWS, а AWS получит от Marvell новые чипы для своих ЦОДКомпания Marvell Technology, занимающаяся полупроводниковыми инфраструктурными решениями, объявила о расширении стратегического партнёрства с Amazon Web Services (AWS). Стороны заключили соглашение сроком на пять лет, включающее сотрудничество в работе над несколькими продуктами AWS, а также использование облачной инфраструктуры техногиганта, сообщает пресс-служба Marvell. Соглашение касается широкого спектра решений Marvell, предназначенных для дата-центров. В том числе речь идёт о поставке кастомизированных ИИ-чипов для AWS, оптических и электрических DSP, PCIe-ретаймеров, оптических сетевых решениях, чипсетов для коммутаторов и др. Компетенции Marvell позволят AWS усовершенствовать собственные продукты, сетевое оборудование и СХД, добившись большей эффективности и снижения стоимости эксплуатации. Для автоматизации проектирования электроники (EDA) в Marvell приняли подход cloud first, разработка ведётся с использованием облака AWS, где компании доступны практически неограниченные вычислительные ресурсы. В Marvell уже заявили, что решения AWS EDA помогут компании быстро, гибко и безопасно масштабировать проектирование полупроводников с лучшим в своём классе временем выхода на рынок. Сотрудничество играет на руку и AWS — продукты Marvell активно используются в инфраструктуре Amazon. |

|