Материалы по тегу: hardware

|

29.03.2025 [10:11], Алексей Степин

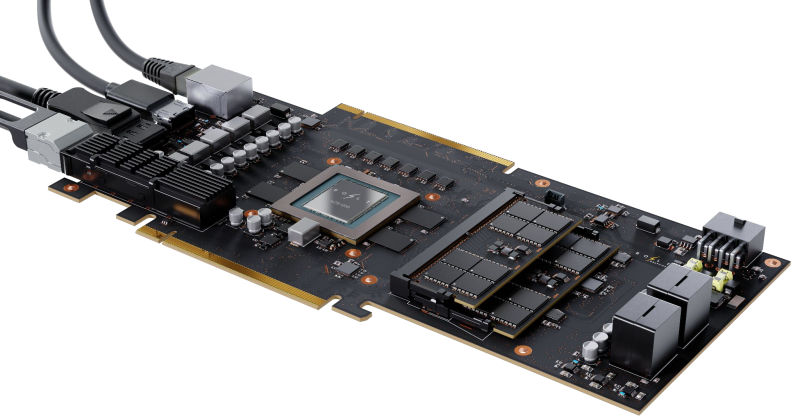

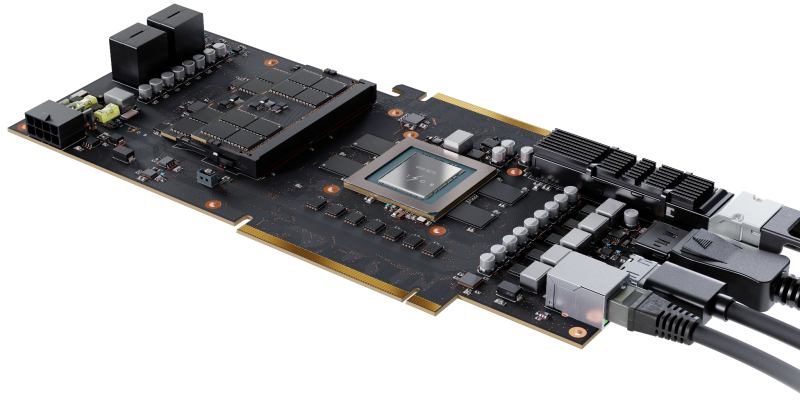

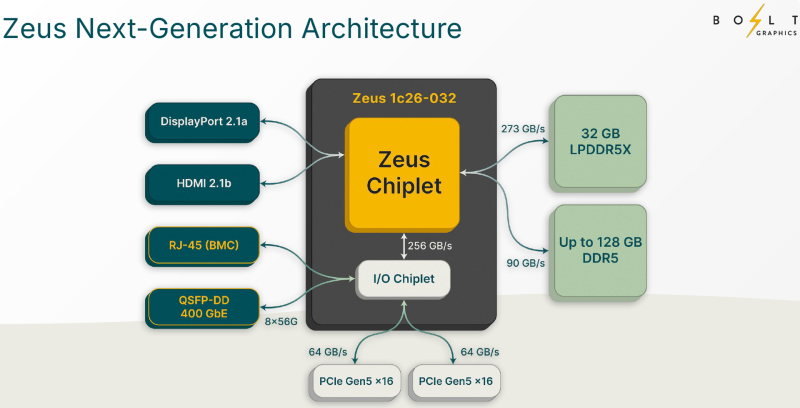

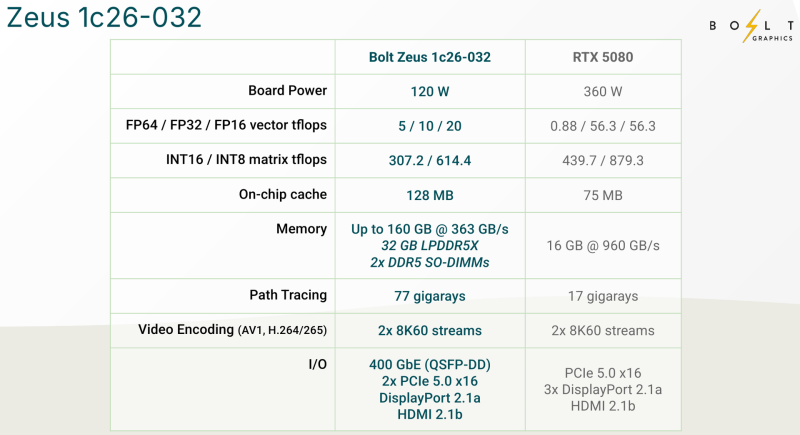

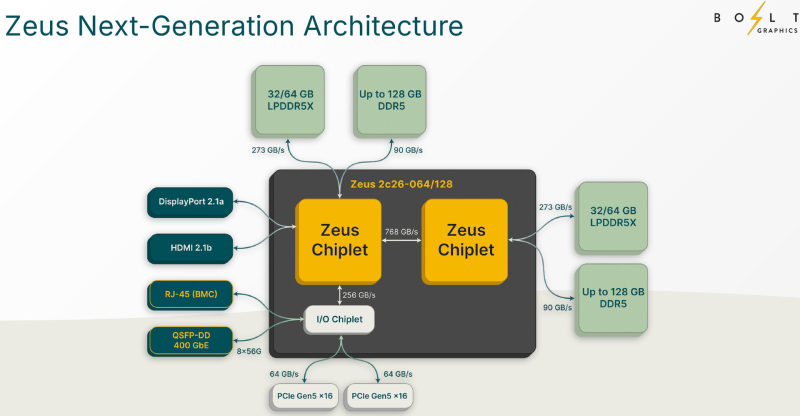

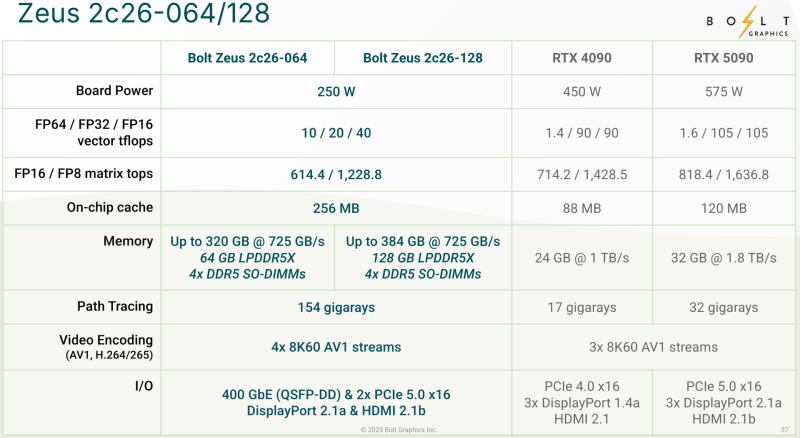

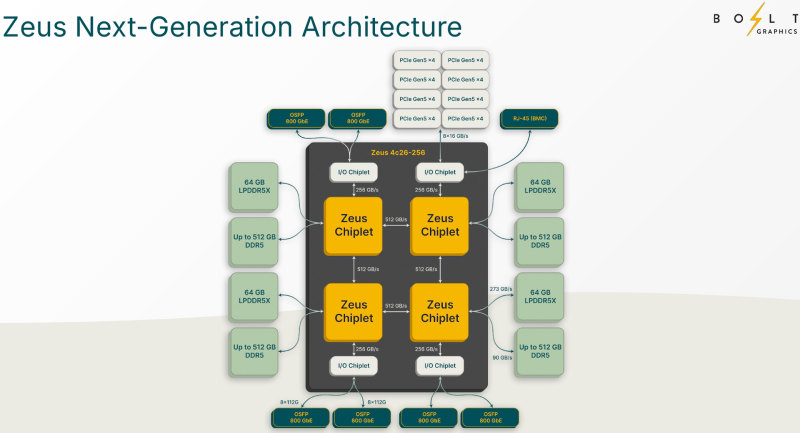

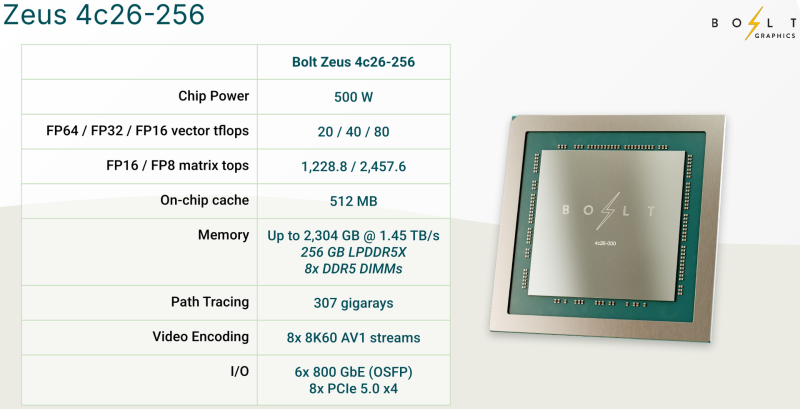

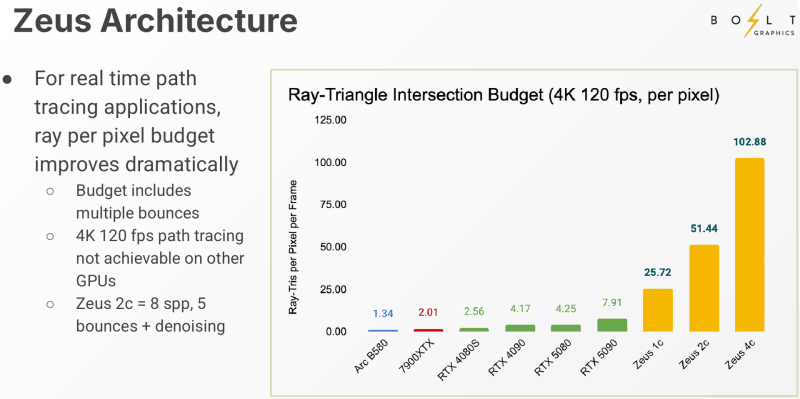

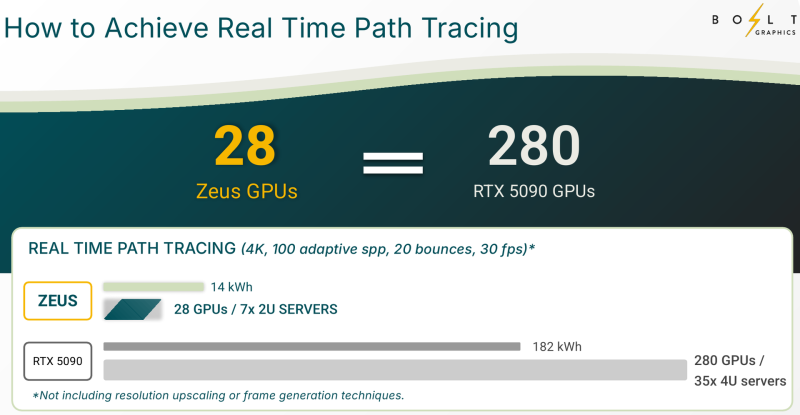

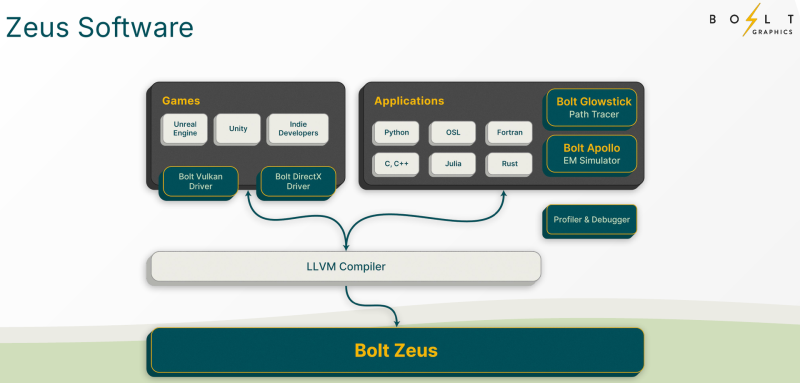

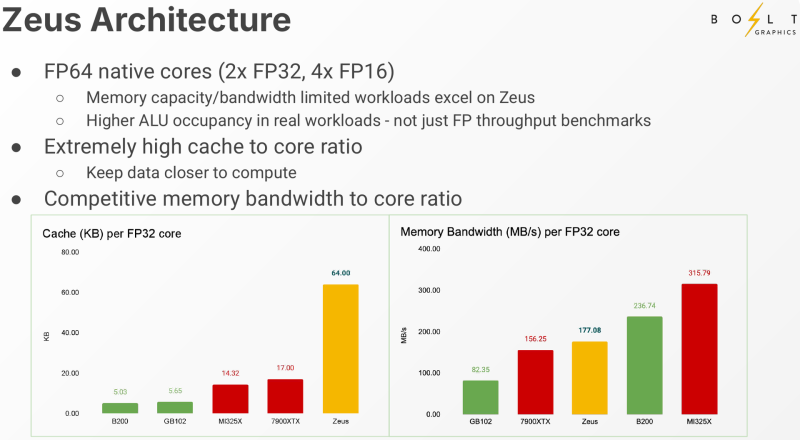

Bolt Graphics анонсировала универсальную видеокарту со слотами SO-DIMM, которая может потягаться с RTX 5080Все современные графические ускорители предлагаются с жёстко заданным при производстве объёмом видеопамяти, а в наиболее производительных моделях память типа HBM вообще интегрирована на одной с основным кристаллом подложке. Однако требования к объёму памяти в последнее время растут быстрее, а за дополнительный объём вендор просят всё больше. Кардинально иной подход предлагает компания Bolt Graphics, недавно анонсировавшая серию ускорителей Zeus. Несмотря на «ИИ-пандемию», Bolt Graphics в своём анонсе не делает упор на искусственный интеллект, а называет Zeus первым GPU, специально созданным для целей HPC, рендеринга, трассировки лучей и даже компьютерных игр. Что интересно, в основе Zeus лежит не некая закрытая архитектура: скалярная часть нового GPU построена на базе спецификации RISC-V RVA23, векторная представлена FP64 ALU на базе несколько модифицированной RVV 1.0. Прочие функции реализованы путём кастомных расширений и отдельных блоков-ускорителей. Все они пользуются общим кешем объёмом 128 Мбайт. Дополняет картину блок телеметрии и внутренний интерконнект для общения с другими вычислительным блоками. Используется чиплетный подход. Базовый «строительный блок» Zeus 1c26-032 включает GPU-чиплет, который соединён с 32 Гбайт набортной памяти LPDDR5x (273 Гбайт/с) и контроллером внешней памяти DDR5 (90 Гбайт/с), т.е. при желании можно установить ещё 128 Гбайт RAM (два модуля SO-DIMM). В GPU-чиплет встроены контроллеры DisplayPort 2.1a и HDMI 2.1b, а с внешним миром он общается посредством IO-чиплета, с которым он соединён 256-Гбайт/с каналом. IO-чиплет предлагает необычный набор портов. Помимо сразу двух интерфейсов PCIe 5.0 x16 (64 Гбайт/с каждый) имеется выделенный порт RJ-45 для BMC и 400GbE-порт QSFP-DD. Наконец, есть аппаратный блок видеокодирования, способный справиться с двумя потоками 8K@60 AV1/H.264/H.265. Заявленный уровень производительности в векторных FP64/FP32/FP16-вычислениях составляет 5/10/20 Тфлопс, а в матричных INT16/INT8 — 307,2/614,4 Топс. Аппаратный блок ускорения лучей (path tracing) выдаёт до 77 гигалучей. Для сравнения: NVIDIA RTX 5090 способна выдавать 32 гигалуча, а FP64-производительность составляет 1,6 Тфлопс. В то же время в расчётах пониженной точности актуальные решения NVIDIA всё равно быстрее Zeus 1c26-032. Однако у новинки есть важное преимущество — её уровень TDP составляет всего 120 Вт. Второй интерфейс PCIe 5.0 x16 можно использовать для прямого объединения двух карт. Вариант ускорителя с двумя чиплетами носит название Zeus 2c26-064/128, а с четырьмя — 4c26-256. Последние числа обозначают объём распаянной памяти LPDDR5X. Что касается расширяемой памяти, то количество доступных разъёмов SO-DIMM также зависит от модели и составляет до восьми, так что во флагманской конфигурации базовые 256 Гбайт LPDDR5x можно дополнить аж 2 Тбайт DDR5. Производительность с увеличением количеств GPU-чиплетов растёт практически пропорционально, но есть некоторые другие нюансы. Так, в Zeus 2c26-064 и Zeus 2c26-128 (оба варианта имеют TDP 250 Вт) есть только один IO-чиплет, а GPU-чиплеты объединены шиной со скоростью 768-Гбайт. Zeus 4c26-256 имеет сразу четыре I/O чиплета в составе, которые дают восемь контроллеров PCIe 5.0 x4 (один чиплет, совокупно 32 линии) и шесть 800GbE-портов OSFP (три чиплета). Между собой GPU-чиплеты объединены шиной со скоростью 512-Гбайт/с. Каждый из них соединён с собственным IO-чиплетом на скорости 256 Гбайт/с. Теплопакет флагмана составляет 500 Ватт, ускоритель, если верить Bolt Graphnics, развивает 20 Тфлопс в режиме FP64, почти 2500 Топс на вычислениях FP8 и способен обрабатывать до 307 гигалучей. Разработчики явно заложили в своё детище широкие возможности кластеризации, о чём свидетельствует наличие мощной сетевой подсистемы. Поддерживаются как скромные конфигурации из двух GPU, соединённых непосредственно по Ethernet 400GbE, так и масштабные системы уровня стойки, содержащей 80 плат Zeus 4c26-256, соединённых как с коммутатором, так и напрямую друг с другом. Такой кластер потребляет 44 кВт, но зато способен обеспечивать запуск крупных физических симуляций или обучение ИИ моделей за счёт огромного массива общей памяти, составляющего 160 Тбайт. Вычислительная производительность такого кластера достигает 1,6 Пфлопс в режиме FP64 и 196 Попс в режиме FP8. Одной из особенностей новинок является трассировщик лучей Glowstick, способный работать в режиме реального времени практически во всех современных пакетах 3D-моделирования или видеоредактирования, таких как Maya, 3ds Max, Blender, SketchUp, Houdini и Nuke. Он будет дополнен фирменной библиотекой Bolt MaterialX, содержащей более 5000 текстур высокого качества. А благодаря поддержке стандарта OpenUSD он сможет легко интегрироваться в любую цепочку рендеринга и пост-обработки. Также запланирован электромагнитный симулятор Bolt Apollo. Обещаны фирменные драйверы Vulkan/DirectX и SDK с использованием LLVM. Ранний доступ к комплектам разработчика Bolt Graphics наметила на IV квартал текущего года. В III квартале 2026 года должны появиться 2U-серверы на базе Zeus, а массовые поставки серверов и PCIe-карт начнутся не ранее IV квартала того же года. Пока сложно сказать, насколько хорошо новая архитектура себя проявит, но если верить предварительным тестам Zeus, выигрыш в сравнении с существующими ускорителями существенен, особенно в энергопотреблении.

29.03.2025 [10:01], Сергей Карасёв

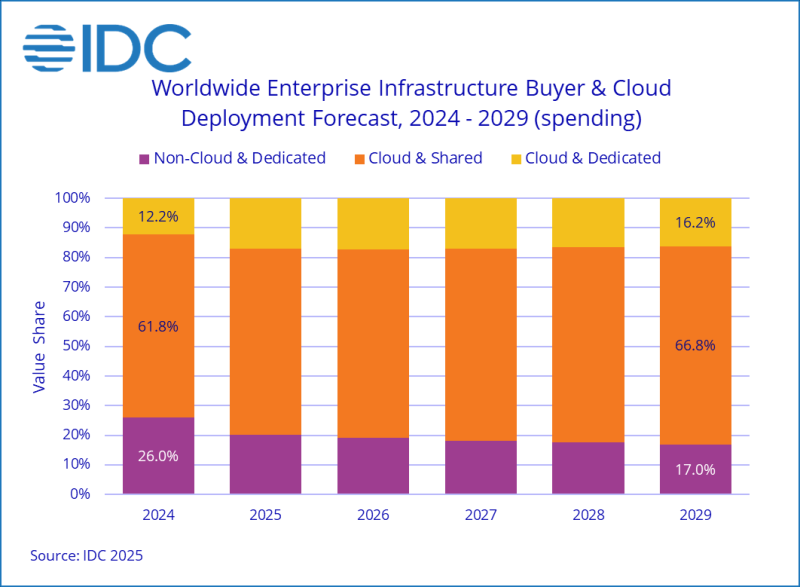

Квартальные затраты на облачную инфраструктуру выросли вдвое на фоне бума ИИПо оценкам компании International Data Corporation (IDC), мировые затраты на облачную инфраструктуру в IV квартале 2024 года достигли $67 млрд: это на 99,3 %, т.е. практически в два раза, больше по сравнению с аналогичным периодом предыдущего года. При этом необлачный сегмент показал рост на 25,8 % — до $22 млрд. Аналитики учитывают продажи серверов и СХД для выделенных и публичных облачных платформ. Главным драйвером отрасли является ИИ, в частности, «рассуждающие» модели и агенты ИИ. Облачные провайдеры активно закупают дорогостоящие системы с ускорителями на базе GPU, а также инвестируют средства в расширение сетей дата-центров. Расходы на публичную облачную инфраструктуру достигли $57 млрд в IV квартале 2024 года, увеличившись на 124,4 % по сравнению с предыдущим годом. В секторе выделенных облаков отмечен рост на 21,8 % в годовом исчислении — до $10 млрд. Таким образом, на публичные платформы пришлось 64,0 % от общих затрат. В географическом разрезе расходы на облачную инфраструктуру в последней четверти 2024 года увеличились во всех регионах. В частности, максимальный рост зафиксирован в Канаде и США — плюс 151,8 % и 125,3 % в годовом исчислении соответственно. Китай, Япония, Азиатско-Тихоокеанский регион (за исключением КНР и Японии), Западная Европа, Ближний Восток / Африка, а также Латинская Америка показали прибавку в 99,6 %, 76,2 %, 48,0 %, 36,8 %, 28,1 % и 14,3 % соответственно. В Центральной и Восточной Европе отмечено увеличение на 5,6 %. IDC прогнозирует, что в 2025 году расходы на облачную инфраструктуру поднимутся на 33,3 % по сравнению с 2024-м, составив $271,5 млрд. При этом публичные платформы покажут рост на 25,7 % в годовом исчислении — до $213,7 млрд. В сегменте выделенных облаков ожидается прибавка около 71,8 % — до $57,8 млрд. Расходы на необлачную инфраструктуру, по мнению IDC, в 2025 году снизятся на 4,9 %, составив $68,1 млрд.

28.03.2025 [18:01], Руслан Авдеев

Crusoe привлекла $225 млн на закупку чипов NVIDIA для развития облачной ИИ-инфраструктурыКомпания Crusoe получила кредитную линию в объёме $225 млн для расширения своего облака. Раунд возглавила частная кредитная структура Upper90 Capital Management, а участвовали в сборе средств British Columbia Investment Management Corporation, FS Investments, King Street Capital Management, Liberty Mutual Investments и ORIX USA, сообщает Datacenter Dynamics. Более всего Crusoe сегодня известна строительством дата-центров, также компания управляет облачным сервисом, доступным корпоративным клиентам, желающим арендовать ИИ-инфраструктуру. Привлечённые средства потратят на приобретение ИИ-ускорителей NVIDIA и вспомогательной инфраструктуры для расширения облаков оператора. В компании заявляют, что новые средства будут способствовать расширению облака Crusoe Cloud, призванного упростить и ускорить разработку ИИ для каждой компании-клиента. Давнее стратегическое партнёрство с Upper90 сыграло важную роль в масштабировании технологий Crusoe для удовлетворения спроса на облака. По данным пресс-службы Crusoe, последний раунд финансирования развивает успехи компании, достигнутые после декабрьского раунда серии D на сумму $600 млн.

Источники изображения: Alexander Grey/unsplash.com В своё время компания начинала как бизнес, занимавшийся добычей криптовалют и размещала модульные ЦОД неподалёку от нефтегазовой инфраструктуры для использования в качестве топлива для генераторов попутного природного газа. В последние годы она переключилась на работу с ИИ-инфраструктурой и строит большой ЦОД в Техасе совместно с Oracle для OpenAI, намеренной реализовать проект Stargate. Также сообщалось о совместном проекте с Chirisa и PowerHouse стоимостью $5 млрд, предусматривающем строительство ЦОД на этой территории США, в основном для CoreWeave. Наконец, совсем недавно она объявила о полном отказе от своего криптомайнингового бизнеса — оставшиеся активы проданы NYDIG. Ранее сообщалось, что Crusoe получит доступ к 4,5 ГВт электричества, вырабатываться которое будет за счёт природного газа. Проект реализован совместно с инвесторами из Engine No.1. Предполагается использовать мощности для питания новых ИИ ЦОД, некоторые из которых, возможно, построят для Stargate. Для Crusoe Cloud арендовано помещение ЦОД ICE02 в Исландии, партнёрское соглашение заключили и с Digital Realty. Стоит отметить, что Upper90 была одним из первых спонсоров Crusoe, кредит на оборудование компания предоставила последней ещё в 2019 году. В Upper90 подчеркнули, что Crusoe сегодня находится на переднем крае облачных ИИ-вычислений и решений в области экоустойчивой энергетики. Представители инвестора заявили, что заняты структурированием инновационного финансирования и гордятся углублением связей с Crusoe.

28.03.2025 [16:07], Руслан Авдеев

Public Power Corp (PPC) представила план строительства ЦОД в старых угольных шахтах ГрецииНаходящаяся в государственной собственности Греции компания Public Power Corp (PPC) представила план строительства дата-центров в закрытых шахтах, где ранее добывался бурый уголь. Эти шахты, принадлежащие PPC, расположены в области Западная Македония, сообщает Datacenter Dynamics. Проект предусматривает инвестиции в размере €5 млрд ($5,38 млрд) и включает строительство дата-центра мощностью 300 МВт на первом этапе. В компании уточнили, что в дальнейшем кампус может быть расширен до 1 ГВт. Дата-центр будет питаться от электростанции на природном газе и солнечной энергии, а также получит аккумуляторное энергохранилище (BESS) и хранилище для накопительной гидроэнергетики. PPC планирует перевести свою последнюю угольную электростанцию Ptolemaida 5 на природном газ с возможностью перехода на водород в будущем. Объявление компании последовало за заявлением о намерении полностью свернуть работу угольной электростанции к 2026 году.

Источник изображения: Pedro Henrique Santos/unsplash.com Дополнительно PPC рассчитывает построить солнечную электростанцию мощностью до 1,3 ГВт на территории шахт Amyndaio и Ptolemaida, а также установить BESS на 300 МВт и реализовать два проекта ГАЭС мощностью 320 МВт и 240 МВт. Что касается дата-центра, PPC ведёт переговоры с несколькими потенциальными партнёрами, однако их имена пока не раскрываются. В последние месяцы PPC всё активнее изучает рынок ЦОД как перспективное направление для роста. В конце прошлого года, совместно со строителем ЦОД Edgnex, компания анонсировала планы по строительству дата-центра мощностью 12,5 МВт в Афинах (Греция). Первая фаза этого проекта предполагает инвестиции в размере €150 млн ($161,5 млн) с возможностью масштабирования объекта до 25 МВт в будущем. Бывшие шахты нередко находят применение в индустрии ЦОД и смежных отраслях. Осенью 2023 года сообщалось, что итальянцы построят ЦОД Trentino Data Mine в доломитовой шахте Сан-Ромедио. В январе 2024 года появилась информация о том, что заброшенные шахты могут стать хранилищами «мусорного» тепла эдинбургского суперкомпьютера. В том же месяце — о том, что дата-центр Data Center Ridge охладят водой из заброшенных шахт. Более того, в конце 2024 года в Итальянских Альпах планировалось построить первый в Европе дата-центр в действующей шахте.

28.03.2025 [13:24], Руслан Авдеев

5 Экзабайт для ИИ: OpenAI может построить специальный дата-центр для хранения за миллиарды долларовКомпания OpenAI может построить дата-центр для хранения данных стоимостью миллиарды долларов, желая снизить зависимость от облачных провайдеров. Разработчик ChatGPT намерен закупить комплектующие и ПО для хранения 5 Эбайт, сообщает The Information. Для размещения необходимой инфраструктуры рассматривается строительство нового дата-центра, доложили журналистам анонимные источники. Впрочем, план также может быть частью стратегии по давлению на Microsoft и других облачных провайдеров для заключения с ними сделок на более выгодных условиях. Не так давно Microsoft, имеющая договорные обязательства с OpenAI, разрешила той пользоваться сторонними облаками. Руководство OpenAI, по слухам, заявило сотрудникам, что компания намерена увеличить объём доступных вычислительных ресурсов для разработчиков до конца года — без учёта ускорителей и сопутствующие инфраструктуры для работы ChatGPT и других продуктов. Также компания надеется утроить общую ёмкость ЦОД, доведя её до 2 ГВт. Сюда входят облачные серверы, которые она арендует у Microsoft. Разработка новых ИИ-моделей требует больших СХД. Если новый ЦОД будет построен, он, вероятно, будет напрямую связан с ИИ-мегапроектом Stargate, совместной инициативой OpenAI, SoftBank и Oracle, а также арабского инвестора MGX — предполагается потратить на инфраструктуру до $500 млрд. ЦОД для хранения данных стремятся строить на территории кампусов с прочей цифровой инфраструктурой, а не выделять отдельные площадки. OpenAI рассматривает возможность размещения хранилища возле объекта первой фазы проекта Stargate, который уже строится в Техасе. Как именно компания намеревается финансировать эти покупки и дополнительное строительство, пока неизвестно. В прошлом году она привлекла $6,6 млрд и теперь ожидает раунд финансирования на $40 млрд, который обеспечит ей капитализацию в $340 млрд. Microsoft была единственным облачным провайдером OpenAI с тех пор, как начала инвестировать в компанию в 2023 году, но требования к вычислительным мощностям растут так быстро, что теперь OpenAI пришлось дополнительно вести дела с Oracle и CoreWeave для обеспечения работы Stargate.

28.03.2025 [12:43], Руслан Авдеев

Только ИИ, только Stargate: Crusoe окончательно избавилась от криптобизнеса, продав его NYDIGОператор облачных проектов и ИИ ЦОД Crusoe Energy продал связанный с майнингом криптовалют бизнес, окончательно отказавшись от криптопроектов. Ранее сообщалось о намерении NYDIG приобрести бизнеса Crusoe, относящийся к добыче биткоинов, включая энергетичесие проекты Digital Flare Mitigation, однако условия сделки пока официально не разглашаются, сообщает Datacenter Dynamics. К NYDIG перейдут майнинговые ЦОД, генерирующие мощности (270 МВт) и около 135 сотрудников Crusoe. Основанная в 2018 году, Crusoe изначально размещала криптомайнинговые мощности при нефтегазовых проектах, используя природный попутный газ для питания модульных ЦОД. В компании заявляли, что такой способ использования попутного газа значительно лучше для окружающей среды, чем просто сжигание. Crusoe внедрила более 425 модульных ЦОД общей ёмкостью более 250 МВт в семи штатах США (Колорадо, Северная Дакота, Монтана, Вайоминг, Нью-Мексико, Юта и Техас), а также в Аргентине. Поработав с майнинговыми проектами, Crusoe запустила собственный облачный ИИ-сервис, заняв место в нескольких колокейшн-ЦОД — прежде, чем перейти на использование собственных стационарных объектов. Основанная в 2017 году и аффилированная с управляющей активами компанией Stone Ridge Holdings Group, NYDIG уже имеет собственный бизнес по майнингу биткоинов и предлагает связанные с криптовалютой финансовые сервисы. Stone Ridge Energy владеет и управляет в США добычей природного газа, эквивалентной более чем 10 ГВт. В NYDIG заявили, что Crusoe создала «экстраординарное» предприятие по майнингу биткоинов, продемонстрировав выдающиеся инновации, собрав лучшие кадры индустрии для решения сложных задач и использования нетронутых энергоресурсов. В настоящее время Crusoe строит крупный кампус дата-центров в Техасе совместно с Oracle для ИИ-проекта OpenAI Stargate. Для своих облачных проектов компания использует дата-центр ICE02 компании atNorth в Исландии. Также компания работает с Digital Realty, а на днях появилась новость о том, что она получит 4,5 ГВт от газовых электростанций для питания ИИ ЦОД. Как сообщается в пресс-релизе Crusoe, она продолжит расти и масштабировать свою вертикально-интегрированную ИИ-инфраструктуру, включающую оптимизированные для ИИ дата-центры, расширит ассортимент предложений в облаке Crusoe Cloud и продолжит внедрение наиболее передовых в индустрии энергетических решений для обеспечения электричеством своей инфраструктуры.

28.03.2025 [11:17], Сергей Карасёв

NVIDIA близка к приобретению облачного ИИ-провайдера Lepton AIКомпания NVIDIA, по сообщению The Information, ведёт переговоры о покупке облачного стартапа Lepton AI, который специализируется на сдаче в аренду ИИ-серверов. Стоимость сделки, как утверждается, может составить «сотни миллионов долларов». Фирма Lepton AI была основана в 2023 году: её соучредителями являются Янцин Цзя (Yangqing Jia) и Цзюньцзе Бай (Junjie Bai), бывшие исследователи лаборатории искусственного интеллекта Meta✴ Platforms. Они, в частности, принимали участие в разработке PyTorch.

Источник изображения: NVIDIA Lepton AI предоставляет облачные ресурсы, оптимизированные для различных задач ИИ, включая обучение больших языковых моделей (LLM) и инференс. Клиентам доступны разные ускорители NVIDIA, а также специальный инструмент для централизованного управления выделенными мощностями при работе одновременно с несколькими проектами. Платформа Lepton AI содержит функции для обнаружения возможных ошибок на этапе обучения LLM и всевозможных проблем технического характера, например, связанных с выделением памяти. После завершения разработки ИИ-модели клиенты могут развернуть её в облаке Lepton AI с применением инстансов, оптимизированных для задач инференса. Говорится о производительности более 600 токенов в секунду при задержках менее 10 мс. Отмечается, что Lepton AI в ходе начального раунда финансирования получила $11 млн. В число инвесторов входят CRV и Fusion Fund. На сегодняшний день штат стартапа насчитывает около 20 сотрудников. Ожидается, что приобретение Lepton AI поможет NVIDIA укрепить позиции в сегменте облачных вычислений для ИИ.

28.03.2025 [10:07], Сергей Карасёв

Власти Ямала предлагают создать в регионе масштабную инфраструктуру ЦОДГубернатор Ямало-Ненецкого автономного округа (ЯНАО) Дмитрий Артюхов, по сообщению «Интерфакса», предлагает сформировать в регионе масштабную инфраструктуру дата-центров. Это позволит удовлетворить растущий спрос на вычислительные мощности в РФ в свете стремительного развития ИИ. Нагрузка на ЦОД в России быстро увеличивается, в связи с чем наблюдается дефицит ресурсов. Кроме того, в обозримом будущем в РФ ожидается нехватка энергии для обучения ИИ-моделей: проблема может сильно ударить по Москве и Санкт-Петербургу, где сосредоточены основные мощности операторов дата-центров. Всё это приводит к увеличению стоимости размещения оборудования в российских ЦОД. В сложившейся ситуации в Минцифры поступают предложения о предоставлении регионам федеральных грантов для строительства дата-центров. Как считает Артюхов, ЯНАО хорошо подходит для создания инфраструктуры ЦОД ввиду климатических условий и доступности энергетических ресурсов. Здесь сосредоточены 50 трлн м3 запасов газа, что поможет решить проблему питания объектов, рассчитанных на ИИ-нагрузки. Артюхов подчёркивает, что строительство дата-центров в ЯНАО позволит частично отказаться от схемы, когда сжиженный газ направляется «в какую-то южнокитайскую провинцию», где используется для питания локальных ЦОД. «Вот возникает вопрос, зачем делать такую долгую цепочку перехода материи, когда, может быть, надо ЦОД построить у нас на Ямале, причём в глобальном масштабе. Центры обработки данных любят прохладу, этого у нас на Ямале достаточно», — отметил губернатор региона. По его словам, накопленная добыча газа в ЯНАО составляет 22 трлн м3. Таким образом, запасов хватит «до следующего века даже при растущем спросе». В целом, заявляет чиновник, строительство дата-центров может стать миссией арктического региона на ближайшие десятилетия.

28.03.2025 [09:48], Сергей Карасёв

CoreWeave привлекла $1,5 млрд в ходе IPO — значительно меньше, чем планировалаКомпания CoreWeave, предоставляющая облачные услуги для ИИ-задач, провела первичное публичное размещение акций (IPO) при участии Morgan Stanley, JPMorgan Chase & Co. и Goldman Sachs Group. Торги ценными бумагами на бирже Nasdaq начались 28 марта 2025 года под тикером CRWV. Изначально предполагалось, что CoreWeave продаст до 49 млн акций по цене $47–$55 за каждую, что позволило бы привлечь до $2,7 млрд. При этом рыночная капитализация компании могла составить $26 млрд. Однако по результатом IPO реализовано только 37,5 млн бумаг по $40 за штуку: в сумме это дало $1,5 млрд. Таким образом, получено примерно на 45 % меньше средств, чем планировалось. В итоге предварительная капитализация оказалась на уровне $19 млрд, причём NVIDIA купила акций на $250 млн, передаёт SiliconAngle. Ранее NVIDIA неоднократно поддерживала CoreWeave и сама пользуется услугами последней. В 2024 году более трёх четвертей выручки CoreWeave получила благодаря сотрудничеству с двумя крупнейшими клиентами. Одним из них стала корпорация Microsoft, которая обеспечила 62 % от общего годового дохода CoreWeave. Кроме того, соглашение по использованию облачной инфраструктуры CoreWeave заключила компания OpenAI: контракт стоимостью $11,9 млрд подписан на пять лет. Однако, как отмечает Bloomberg, нынешняя бизнес-модель CoreWeave с большой концентрацией выручки от обслуживания единичных заказчиков в сочетании с возросшими показателями задолженности и расходов вызвала у некоторых аналитиков вопросы относительно устойчивости компании. Более того, подчёркивается, что CoreWeave имеет существенные недостатки в своем внутреннем контроле над финансовой отчётностью. В частности, упомянута нехватка квалифицированных специалистов на соответствующих должностях. Всё это могло негативно отразиться на ходе IPO. CoreWeave была основана в 2017 году и изначально занималась майнингом криптовалют. Затем компания переориентировалась на вычисления общего назначения и хостинг проектов генеративного ИИ, а впоследствии начала предоставлять специализированные облачные ИИ-решения. На сегодняшний день CoreWeave располагает 250 тыс. ИИ-ускорителей NVIDIA более чем в 30 дата-центрах по всему миру. В число инвесторов входят Magnetar Capital, Coatue Management, Jane Street, JPMorgan Asset Management, Fidelity и Lykos Global Management.

27.03.2025 [21:42], Владимир Мироненко

Selectel увеличила выручку в 2024 году на 30 %Провайдер IT-инфраструктуры АО «Селектел» (Selectel) увеличил в 2024 году выручку примерно на 30 %, доведя её до 13 млрд руб. с 10,2 млрд руб. годом ранее, сообщил «Интерфакс» со ссылкой на информацию гендиректора компании Олега Любимова. Официальная аудированная отчётность по МСФО будет представлена компанией в начале апреля. Как отметил Любимов, рост выручки в прошлом году соответствует планам Selectel по росту бизнеса на уровне 28–30 %. Большая часть выручки компании (около 85 %), приходится на ключевой сегмент IaaS (инфраструктура как сервис), главным образом — на услугу bare metal. Сегмент IaaS также включает секторы публичного и частного облака. Остальную часть выручки компании принесли сервисы PaaS (платформа как сервис) и колокейшн. По словам Любимова, компания увеличила в 2024 году инвестиции в развитие своей инфраструктуры более чем в два раза по сравнению с 2,5 млрд руб. в 2023 году. Более половины суммы было израсходовано на IT-оборудование, а остальная часть — на инфраструктуру ЦОД.

Источник изображений: Selectel Гендиректор пояснил, что инфраструктура Selectel состоит из двух частей — инженерной, включающей здания и инженерные системы ЦОД, и IT-оборудования. На оборудование приходится гораздо больше инвестиций, чем на инженерную инфраструктуру, вложения в которую составляют в среднем 25–30 % всех инвестиций в инфраструктуру, говорит Любимов. Впрочем, в 2024 году компания увеличила объём инвестиций в инженерную инфраструктуру в связи с запуском проекта по развитию новой площадки (ЦОД) в Москве. До этого у Selectel было три площадки — две в Петербурге и одна в Москве. Инвестиции в поддержание имеющейся инфраструктуры не идут ни в какое сравнение с вложениями в развитие, поскольку отказов оборудования не так много — «это единицы процентов от выручки», говорит Любимов, подчеркнув, что серверное оборудование у компании «живёт долго». По мере использования оборудования компания снижает цену на его аренду, передавая его тем клиентам, которые менее требовательны к производительности. «И этот цикл может повторяться долго — иногда до 15 лет, пока этот сервер станет просто невыгодно поддерживать», — сообщил гендиректор. В текущем году компания планирует сохранить темп роста на уровне 30 % без учёта показателей ООО «Единая сеть» (бренды servers.ru, exepto.ru и fozzy.ru), которое Selectel приобрела в конце 2024 года. Любимов сообщил, что структура доходов не изменится — 80 % выручки планируется получить от услуг, связанных с вычислениями и хранением данных — арендой оборудования, публичным и частным облаком. «В целом наша цель — расти на уровне 30 % в год в течение длительного периода времени», — говорит он. В связи с тем, что заказчиков всё больше интересуют безопасность и удобство использования вычислительных мощностей и СХД, компания планирует заниматься разработкой и запуском дополнительных сервисов, прежде всего в области безопасности и управления IT-инфраструктурой. На дополнительные сервисы приходится небольшой объём выручки, но их наличие помогает активно продавать основные сервисы, пояснил Любимов. Также в текущем году Selectel планирует продолжить развитие направления по производству собственного серверного оборудования: «К настоящему времени разработали двухпроцессорную серверную платформу под процессоры Intel последнего актуального поколения, готовим аналогичное решение под процессоры AMD». При этом у компании нет цели заменить собственным оборудованием всё или часть используемого оборудования других производителей. В качестве преимущества собственных серверов гендиректор назвал собственную серверную операционную систему на базе Debian Linux, оптимизированную под выпускаемое оборудование, что в ряде случаев позволяет обеспечить его более высокую производительность. «Наша ОС максимально приближена к базовому дистрибутиву Linux, но оптимизирована под наше “железо” и обеспечена нашей техподдержкой», — сообщил Любимов. |

|