Материалы по тегу: ии

|

08.04.2025 [16:18], Татьяна Золотова

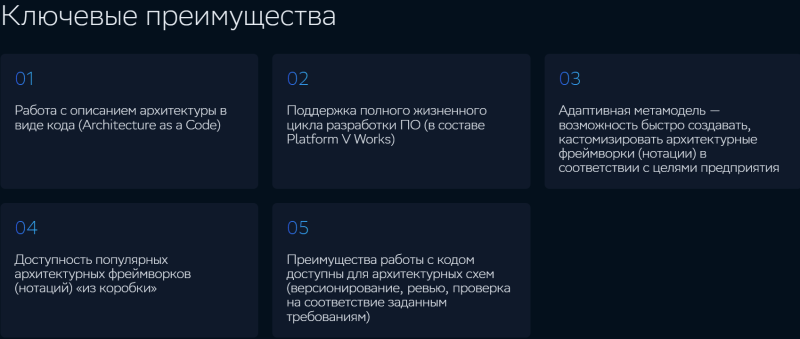

«СберТех» разработал инструмент системного проектирования архитектуры«СберТех» анонсировал инструмент для управления ИТ-архитектурой Platform V Works::Architect. Решение призвано быстро и качественно внедрять изменения в существующую ИТ-среду организации. Платформа позволяет снизить затраты и время на изменение ИТ-ландшафта за счет роста производительности архитекторов и визуализации проектирования для сокращения ошибок. Также инструмент позволяет прогнозировать стоимость изменений. Platform V Works::Architect дает возможность гибко настраивать методологию и поддерживать версионность архитектуры в соответствии с обновлениями информационных систем и программных продуктов. Она контролирует соответствия технической архитектуры и реализации, помогает находить потенциальные ошибки и несоответствия до начала программирования, позволяет создавать детально структурированные системы и управлять артефактами архитектуры. Как поясняют в компании, инструмент подходит для целостного проектирования организации по всем архитектурным слоям или моделирования ее отдельных сущностей. Platform V Works::Architect может поставляться как в виде самостоятельного решения, так и в составе инструментов для ИТ-разработки. Продукт включен в Реестр российского ПО и позволяет заместить такие продукты как Microsoft Visio, Orbus iServer, Aris Enterprise Architect, Sparx Enterprise Architect. Новый продукт входит в состав Platform V Works — платформенного решения для разработки ПО. Он позволяет оптимизировать процесс создания корпоративных информационных систем и тиражируемого программного обеспечения.

08.04.2025 [14:11], Руслан Авдеев

Meta✴ планирует потратить почти $1 млрд на ЦОД в ВисконсинеMeta✴ Platforms намерена потратить около $1 млрд на строительство кампуса ЦОД в Висконсине (США). Это лишь часть проекта IT-гиганта по наращиванию инвестиций в ИИ и облачную инфраструктуру, сообщает Bloomberg. По информации издания, в феврале штат заключил «стимулирующую» сделку с неназванной компанией, предусматривающей строительство кампуса ЦОД с многолетними инвестициями общим объёмом $837 млн. По данным источников, за проектом стоит именно Meta✴. В самом IT-гиганте информацию комментировать отказались, а представитель Wisconsin Economic Development Corporation заявил, что традиционно принято публично называть компании, с которыми заключен договор только после того, как получено официальное одобрение сделки. В последние годы ключевые IT-компании стремятся увеличить ёмкость доступных дата-центров для удовлетворения запроса на облачные вычислительные мощности, также учитывая рост сложности ИИ-моделей. Meta✴ заявила, что всего в текущем году намерена потратить до $65 млрд на инфраструктуру, основной фокус — на ИИ ЦОД, в том числе крупный кампус в Луизиане. У IT-гигант уже есть дата-центры на Среднем Западе, в том числе в Айове и в Иллинойсе.

Источник изображения: taro ohtani/unsplash.com Впрочем, инвесторы задаются вопросом — стоит ли строить новые ЦОД, особенно на фоне отказа Microsoft от некоторых своих проектов, развития семейств менее ресурсоёмких ИИ-моделей, а также потенциального негативного эффекта от пошлин, вводимых администрацией США. Meta✴ применяет ИИ во всех сферах своего бизнеса, от подбора контента в лентах пользователей соцсетей до таргетирования рекламы. Также ИИ применяется и в пользовательском оборудовании, от AR-гарнитур Meta✴ Quest до серии очков Ray-Ban Meta✴. В январе глава компании Марк Цукерберг (Mark Zuckerberg) заявил, что Meta✴, вероятно, потратит на ИИ сотни миллиардов долларов. В феврале власти города Бивер-Дам (Beaver Dam) в лице Beaver Dam Area Development Corporation сообщили, что планируют с Alliant Energy строительство ЦОД стоимостью около $500 млн. Сообщалось, что предварительно одобрены соглашения о строительстве и водоснабжении, но пока требуется разрешение центральных органов власти США. Для проекта Stargate компании OpenAI Висконсин также назван в качестве одной из локаций для строительства наряду с, например, Техасом.

08.04.2025 [13:29], Сергей Карасёв

Eviden создаст для Сербии суперкомпьютер стоимостью €36 млнВласти Сербии, по сообщению ресурса Datacenter Dynamics, заключили контракт с Eviden (подразделение Atos Group) на создание нового суперкомпьютера. Речь идёт о приобретении системы BullSequana последнего поколения, которая будет поставлена к концу текущего года. Технические подробности проекта пока не раскрываются. Отмечается лишь, что контракт с Eviden является частью более широкого соглашения стоимостью €50 млн, подписанного между правительствами Сербии и Франции. Из этой суммы €36 млн пойдёт непосредственно на создание суперкомпьютера. Оставшаяся часть средств будет потрачена на ИИ-инициативы в таких сферах, как здравоохранение, энергетика, транспорт и государственное управление. На сегодняшний день, как отмечается, Сербия эксплуатирует как минимум один неназванный НРС-комплекс, созданный NVIDIA и размещённый в государственном дата-центре в Крагуеваце (столица административного региона Шумадия). Система, запущенная в декабре 2021 года, обошлась в €30 млн. В перспективе в модернизацию этого суперкомпьютера планируется инвестировать €40 млн, что позволит поднять его производительность в семь раз.

Источник изображения: Правительство Сербии Глава сербского управления по IT и электронному правительству Михайло Йованович (Mihailo Jovanovic) заявил, что новый суперкомпьютер, поставкой которого займётся Eviden, будет насчитывать «в 20 раз больше чипов, чем [нынешняя] система NVIDIA», и получит почти в 30 раз больше памяти. Какие именно чипы имеются в виду, Йованович уточнять не стал. Работа над государственным ЦОД в Крагуеваце стоимостью €30 млн началась в 2019 году, а открытие состоялось в 2020-м. Дата-центр состоит из двух объектов общей площадью около 14 тыс. м2 — это примерно в пять раз больше по сравнению с прежней ЦОД-площадкой в Белграде. Комплекс в Крагуеваце соответствует стандарту Tier IV: он предоставляет услуги хостинга для предприятий и правительственных структур.

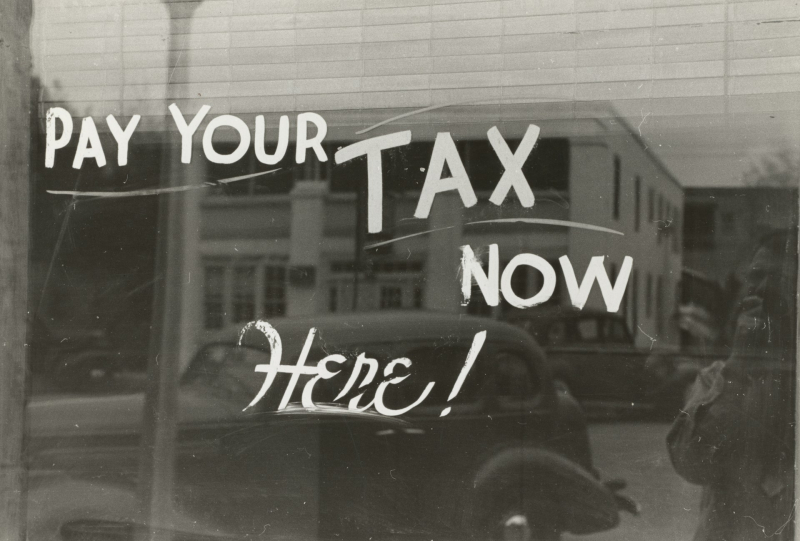

08.04.2025 [08:30], Владимир Мироненко

Поставщики памяти, накопителей и СХД в основном проиграют от торговой войны СШАВведение президентом США пошлин отразится на американских компаниях, у которых компоненты многонациональной цепочки поставок и готовая продукция импортируются в Америку, а также на цене продукции иностранных поставщиков, импортируемой в США, пишет ресурс Blocks & Files. Торговая война также затронет американских поставщиков систем хранения, экспортирующих в те страны, которые в ответ тоже повышают пошлины. Таким образом, можно говорить о трёх группах компаний, которые столкнутся с различными проблемами после роста пошлин. США назначили Китаю самую высокую пошлину в 54 %. И это не предел, поскольку в связи с решением Китая повысить в ответ пошлины на 34 % США, в свою очередь, могут повысить ставку до 104 %, пишет The Register. За Китаем следует Камбоджа с пошлиной в 49 %, Лаос — 48 %, Вьетнам — 46 %, Таиланд — 37 %, Индонезия и Тайвань — по 32 %, Индия — 27 %, Южная Корея — 26 %, Япония — 24 %, Евросоюз — 18,5 %, Филиппины — 18 %. Среди компаний, поставляющих товары в США, введение пошлин может затронуть поставщиков DRAM, NAND, SSD, лент и ленточных приводов, а также тех, кто производит контроллеры СХД и серверные процессоры. Следует учесть, что согласно приложению II Гармонизированного тарифного графика США (HTSUS), полупроводниковые чипы освобождены от пошлин, но не товары, которые содержат их в качестве компонентов. Так, Micron производит DRAM, NAND и SSD. DRAM выпускается в Бойсе (штат Айдахо), а также в Японии, Сингапуре и на Тайване. Освобождение от пошлин может применяться к чипам DRAM и NAND, но не обязательно к SSD, содержащим NAND, поскольку для них нет специального освобождения. На товары будут действовать пошлины для страны происхождения, установленные администрацией США. Samsung, производит DRAM и NAND в основном в Южной Корее, но часть NAND выпускается в Китае. Сборка SSD сосредоточена в Южной Корее, поэтому они, скорее всего, подпадают под 26-% пошлину. SK hynix, производит чипы DRAM, NAND и SSD в Южной Корее, в то время как её дочерняя компания Solidigm производит SSD в Китае. То есть на её ценах отразится 54-% пошлина на SSD из Китая и 26-% — на продукцию из Южной Кореи. Kioxia, производит NAND и SSD в Японии, при ввозе в США её продукты будут облагаться 24-% пошлиной. NAND-память SanDisk производится в Японии (совместно с Kioxia), но часть SSD выпускается на заводах в Китае, что подразумевает применение 54-% пошлины. Это означает, что SSD Kioxia, Samsung и SK hynix, могут оказаться дешевле, чем SSD Sandisk, а вот SSD Solidigm — нет.

Источник изображения: The New York Public Library / Unsplash У HDD Seagate довольно сложная и интегрированная международная цепочка поставок, включающая Китай, Таиланд, Сингапур и Малайзию. Компания производит пластины для дисков и часть самих HDD (например, Exos) в Китае, а двигатели, узлы привода головок и жёсткие диски других серий — в Таиланде. Кроме того, пластины и некоторые другие диски собираются в Сингапуре и Малайзии. Новые пошлины будут применяться при импорте дисков в США и будут зависесть от страны происхождения. Столь резкое увеличение цен из-за пошлин может вызвать шок у клиентов, отметил ресурс Blocks & Files. Western Digital собирает свои диски в Малайзии и Таиланде, и поэтому столкнётся с пошлинами в размере 24 % и 36 % соответственно. Жёсткие диски Toshiba производятся в Китае, на Филиппинах и в Японии, что подразумевает импортные пошлины США в размере 54, 18 и 24 % соответственно. Записываемые диски Blu-ray и DVD производятся в Китае, Индии, Японии и на Тайване — они точно так же будут облагаться пошлинами в зависимости от страны выпуска. IBM производит ленточные накопители, проприетарные и LTO, в Тусоне (штат Аризона), поэтому её коснутся только пошлины на любые компоненты иностранного производства, которые она будет импортировать. Fujifilm производит LTO-накопители в Бедфорде (штат Массачусетс), а Sony — в Японии, что означает 24-процентную пошлину на ввоз в США. Fujifilm — в выигрыше от ввода пошлин, а Sony — наоборот. Контроллеры хранения данных и серверные процессоры в основном производятся Intel, некоторые — компанией AMD. У Intel есть фабрики в Орегоне (Хиллсборо), Аризоне (Чандлер) и Нью-Мексико (Рио-Ранчо). Сборочные, испытательные и упаковочные мощности для CPU имеются в Израиле, Малайзии, Вьетнаме, Китае и Коста-Рике. Часть продукции выпускается завод в графстве Килдэр (Ирландия). AMD во много зависит от тайваньских фабрик TSMC. Однако обе компании, а заодно и производители Arm-чипов, пошлины не затронут. Зато экспорт в Китай подпадёт под ответные 34-% пошлины. Массивы хранения данных в основном производятся в США, где находятся все производства Dell, HPE и NetApp. А вот Hitachi Vantara производит свои хранилища в Японии, поэтому на них будет действовать 24-%. СХД Lenovo фактически являются OEM-массивами NetApp, поэтому она может избежать пошлин. СХД Infinidat выпускаются на производственных мощностях Arrow Electronics, которая имеет глобальную цепочку поставок с США в роли главного хаба. Где именно по факту производятся массивы, Infinidat не говорит. Поставщики неамериканских СХД в США столкнутся с пошлинами в зависимости от страны их базирования. Чтобы избежать этого, компании могут инвестировать в американские подразделения, хотя для многих в нынешней ситуации это может быть не очень целесообразно. Третья группа поставщиков СХД — это американские компании, экспортирующие продукцию, например, в Китай, который в ответ повышает собственные пошлины на ввоз товаров из США — с 10 апреля она составит 34 %. Одним из победителей в этой торговой войне Blocks & Files назвал Huawei, которая не поставляет товары в США.

07.04.2025 [22:47], Татьяна Золотова

«Код Безопасности»: вышла новая версия 2.7 «Континент TLS-сервер»Разработчик средств защиты информации «Код Безопасности» представил версию 2.7 системы обеспечения защищенного удаленного доступа к веб-приложениям «Континент TLS-сервер» со встроенным программным модулем WAF, защищающим от киберугроз. Как поясняют в компании, на рынке защиты веб-приложений используют два класса решений: TLS-клиенты для предоставления безопасного доступа к внутренним веб-приложениям (в том числе туннелирование TCP-трафика) и WAF (Web Application Firewall) для защиты публичных веб-приложений от атак. Новая версия объединила в себе функции SSL VPN и WAF, в том числе машинное обучение для защиты от атак, собственный сигнатурный анализатор, защиту от ботов, GeoIP, предотвращение L7 DDoS-атак, валидацию JSON, XML, MultiPart, GraphQI, HTMLXsd, YAML и HTTP, а также логирование и аудит. Также версия 2.7 поддерживает HTTP/2 в настройках прокси и портала приложений, обеспечивая более быструю и эффективную работу веб-приложений. В новой версии «Континент TLS» можно «включать» механизмы по желанию: SSL VPN и WAF работают как по отдельности, так и вместе. «Континент TLS-сервер» лицензируется по количеству одновременных подключений, в отличие от обычных VPN-клиентов, где лицензирование осуществляется по общему количеству удаленных пользователей. Обновленная версия будет проходить сертификацию во ФСТЭК и ФСБ России: по профилю защиты межсетевых экранов типа «Г» 4 класса защиты и 4 уровню доверия – для функционала WAF, а также по требованиям к СКЗИ класса КС2/КС3 – для TLS-сервера.

07.04.2025 [17:35], Татьяна Золотова

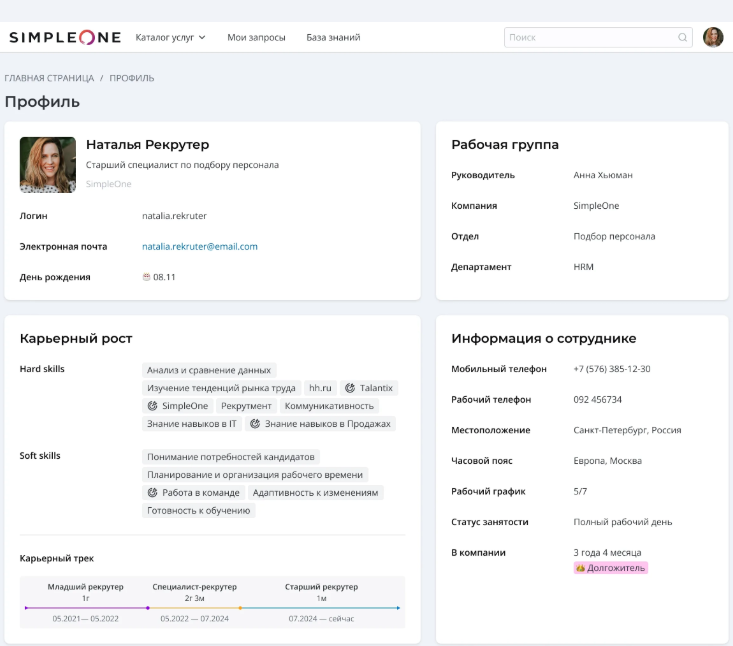

SimpleOne выпустил систему для комплексной автоматизации HR-процессовРазработчик решений для автоматизации бизнес-процессов SimpleOne (входит в корпорацию ITG) представил публичную версию продукта SimpleOne HRMS — единую цифровую среду для взаимодействия HR-департамента и сотрудников компании. Решение призвано заменить ушедшие с российского рынка бренды SAP SF и Oracle HCM. Ранее SimpleOne HRMS была доступна в демоверсии. Приложение реализовано на базе Low-code-платформы SimpleOne, включенной в Реестр российского ПО. Low-code-технология позволяет компаниям самостоятельно настраивать процессы, доступы, роли пользователей, интерфейс приложения и структуру данных под свои потребности. Доступны два варианта развертывания системы: через защищенное облако или на собственных серверах компании. Система рассчитана на управление персоналом численностью более 600 человек. SimpleOne HRMS автоматизирует процессы HR-департамента: рекрутинг, адаптация и обучение, управление эффективностью, внутренние коммуникации. Пользователи могут построить систему HR-аналитики, встроенный конструктор отчетов визуализирует данные и их обновление на дашбордах в онлайн-режиме. В решении предусмотрены инструменты постановки и учета задач HR-подразделения, включая канбан-доски и мониторинг исполнения. Сотрудники получают единый каталог HR-услуг и могут самостоятельно запрашивать кадровые документы, согласовывать отпуска и обращаться с запросами. Также в системе предусмотрены личный профиль сотрудника, в котором можно отслеживать карьерный трек и корпоративный календарь. Приложение интегрируется с платформой для развития лояльности GrandBazar.

07.04.2025 [16:37], Владимир Мироненко

MTS AI представила российского конкурента GitHub Copilot — ИИ-ассистента для разработчиков Kodify 2Компания MTS AI (дочерняя структура МТС Web Services) объявила о выходе ИИ-ассистента для разработчиков второго поколения Kodify 2. Новая версия ИИ-ассистента поддерживает 90 языков программирования, предлагая основные возможности для автоматизации и ускорения процесса разработки, включая автодополнение кода, исправление ошибок, генерацию тестов и документации, оптимизацию кода, а также преобразование текста в код. Kodify 2 с 7 млрд параметров поддерживает контекст длиной до 32 768 токенов и имеет API, совместимый OpenAI, что обеспечивает возможность интеграции с другими системами. Согласно проведённым тестам, Kodify 2 сопоставим по возможностям с лидирующим на рынке продуктом GitHub Copilot. В генерации тестов Kodify 2 выполнил задачу так же или лучше, чем GitHub Copilot, в 57 % случаев, а в преобразовании текста в код — в 48 % случаев. Тестирование проводилось методом прямого сравнения и оценки с помощью модели-судьи Claude Sonnet 3.5.

Источник изображения: MTS AI ИИ-агент Kodify используется c 2024 года командами разработки компаний из ПАО «МТС», а версия Kodify 2 будет доступна для покупки внешними заказчиками. По оценкам MTS AI, объём российского рынка ИИ-ассистентов для разработчиков в этом году составит 17,4 млрд руб., включая 13,9 млрд руб. сегмента on-premise-решений, и 3,5 млрд руб. — облачных. Доля рынка MTS AI может составить 10 %.

07.04.2025 [11:38], Руслан Авдеев

Министерство энергетики США приглашает строить ЦОД на своих землях — но могут помешать новые пошлиныВ Министерстве энергетики США (DoE) выступили с новой инициативой — власти готовы выделить собственные земли для строительства ЦОД рядом с энергогенерирующими мощностями. Представители министерства сообщают, что действуют в соответствии с указами президента, связанными с энергетикой, а также призванными устранить барьеры, мешающие развитию ИИ, сообщает The Register. Всего выбрано 16 площадок для быстрого строительства дата-центров на федеральных землях. Проблема в том, что новые тарифы, введённые самим президентом в отношении большинства стран мира, могут помешать реализации новых планов. По мнению аналитиков, техногиганты, готовые к инвестициям, могут столкнуться с серьёзными трудностями, поскольку ключевые поставщики оборудования находятся в Китае, на Тайване и в Южной Корее. Высокие пошлины повысят цены на ключевую электронику, включая смартфоны, ПК, а также оборудование ЦОД — импорт таких товаров в США составил в прошлом году около $486 млрд. По мнению экспертов DA Davidson, оборудование для ЦОД несомненно подорожает, Microsoft уже начала более сбалансированно подходить к расширению инфраструктуры ЦОД. При этом на некоторых площадках уже имеется развитая энергетическая инфраструктура, также может быть упрощено получение разрешений на создание новых энергетических объектов вроде атомных реакторов. В первую очередь речь идёт о площадках, находящихся в распоряжении лабораторий самого Министерства энергетики, в том числе Лос-Аламосской, Окриджской, Аргоннской, и др. В Министерстве заявляют, что ожидают информации от строителей ЦОД, энергокомпаний и прочих бизнесов, желающих развивать проекты. Строительство должно начаться в конце текущего года, а работоспособность некоторых объектов должны обеспечить уже к концу 2027-го. Министр энергетики Крис Райт (Chris Wright) заявил, что США жизненно важно сохранить первенство в сфере ИИ. Он сравнил текущие процессы с гонкой по созданию атомной бомбы и прямо заявил о «новом Манхэттенском проекте», заодно сообщив, что США могут и должны победить. По его словам, сейчас США принимают важные меры по использованию местных ресурсов для обеспечение революции в сфере ИИ, при этом продолжая предоставлять доступную, надёжную и безопасную энергию жителям страны. В министерстве рассчитывают содействовать государственно-частным партнёрствам в этой сфере, промышленникам предложат шанс взаимодействовать с исследовательскими лабораториями мирового класса с целью развития как энергосистем для снабжения ЦОД, так и получения оборудования для ЦОД нового поколения. Согласно докладу Национальной лаборатории им. Лоуренса в Беркли, на дата-центры в США в 2023 году пришлось около 4,4 % всего энергопотребления страны, прогнозируется, что к 2028 году речь может идти уже о 12 %. В докладе основной причиной таких высоких показателей называется развитие ИИ. По имеющимся данным, энергопотребление ЦОД с 2017 по 2023 гг. выросло более чем вдвое, во многом из-за роста использования ресурсоёмких серверов для обучения ИИ-моделей. Впрочем, спешит развивать индустрию ЦОД не только США. В январе британское правительство представило программу AI Opportunities Action Plan, предусматривающую создание «зон роста ИИ» с приоритетным доступом к энергосетям и минимизацией бюрократии при строительстве. В то же время бывший глава Google Эрик Шмидт (Eric Schmidt) с соавторами опубликовал статью «Стратегия сверхразума» (Superintelligence Strategy), в которой высказывается мнение о том, что США следует воздержаться от реализации аналога «Манхэттенского проекта» для достижения превосходства в области ИИ, поскольку это спровоцирует упреждающие киберответы со стороны, например, Китая.

07.04.2025 [10:03], Владимир Мироненко

В отрасли ЦОД готовятся к резкому росту цен на серверы из-за торговой политики ТрампаТорговая политика президента США Дональда Трампа неизбежно приведёт к росту цен на серверы для бизнеса, по крайней мере в краткосрочной перспективе, поскольку неопределённость распространяется на цепочку поставок, считают эксперты, о чём пишет The Register. Белый дом США ввёл с 5 апреля базовый тариф на весь импорт в размере 10 %. Затем с 9 апреля США добавят «взаимные тарифы» для многих стран в ответ на собственные импортные пошлины этих стран. Больше всего это ударит по крупнейшим мировым производителям технологического оборудования, включая Китай, Таиланд, Вьетнам и Тайвань. До этого Трамп заявил о намерении ввести тарифы на ввоз полупроводников, произведённых за пределами США, а также призывал установить 25-процентный сбор на импорт процессоров. По мнению экспертов, ввод тарифов на поставки чипов из Китая никак не отразится на США, чего не скажешь о Тайване, Японии или Южной Корее, где производится большая часть микросхем памяти и процессоров, используемых в тех же серверах. «Я действительно думаю, что могут быть некоторые краткосрочные последствия», — заявила глава AMD Лиза Су (Lisa Su) на прошлой неделе, добавив, что сейчас ещё слишком рано говорить о долгосрочных последствиях — для этого нужно понаблюдать, как будут развиваться события в течение следующих нескольких месяцев. На процессоры AMD приходится почти четверть всех проданных в III квартале 2024 года серверных чипов x86. При этом они производятся компанией TSMC на Тайване. HPE сообщила о предполагаемом снижении выручки во II квартале 2025 года из-за негативного влияния торговой политики Трампа на цепочки поставок. «Недавние объявления о тарифах создали неопределённость для нашей отрасли, в первую очередь затронув наш серверный бизнес», — сообщила финансовый директор HPE Мари Майерс (Marie Myers) в марте в ходе телефонной конференции с аналитиками. Она отметила, что компания работает над планами по смягчению последствий этого с помощью мер оптимизации работы цепочки поставок и изменения ценообразования. Dell заявила в ходе последнего квартального отчёта, что ей также, вероятно, придется поднять цены в связи с введением тарифов. Вице-председатель и главный операционный директор Джефф Кларк (Jeff Clarke) сообщил, что построенная компанией ведущая в отрасли цепочка поставок помогает минимизировать влияние торговых правил, тарифов на её клиентов и акционеров, но с ростом расходов цены всё же придётся скорректировать. В отличие от многих других компаний, китайский производитель Lenovo сохраняет оптимизм. Генеральный директор Lenovo Юаньцин Ян (Yuanqing Yang) заявил, что глобальное присутствие, а также гибкость и устойчивость помогут компании адаптироваться к различным сценариям. «Мы уверены, что не только сможем обеспечить свою конкурентоспособность на рынке, но и защитить нашу прибыль и производительность», — сообщил гендиректор. Комментарий компании Supermicro из США, которая поставляет серверы гиперскейлерам, был более сдержанным. «Компания активно отслеживает динамику ситуации с торговлей и тарифами, сотрудничая с государственными органами, и мы соответствующим образом сообщим о любых будущих последствиях», — заявил её представитель ресурсу The Register. По данным IDC, мировой рынок серверов за IV квартал 2024 года достиг рекордной отметки в $77,3 млрд выручки, что означает рост год к году в размере 91 %. Ресурс The Register спросил у IDC, не было ли зафиксировано какое-либо влияние объявления о введении тарифов, например, на то, что поставщики начали накапливать запасы в США, прежде чем они вступят в силу. «Пока об этом рано говорить», — ответила Лидице Фернандес (Lidice Fernandez), вице-президент группы по WW Enterprise Infrastructure. Она отметила, что несколько компаний объявили о планах открыть объекты в США, чтобы избежать пошлин, но поскольку это касается производства серверов, на это могут уйти годы. «Мы ожидаем, что растущие расходы будут переложены на конечных пользователей, и пока нет никаких признаков накопления, но это может измениться в ближайшем будущем. Компании всё ещё приспосабливаются к новой реальности», — сообщила Фернандес. В компании Omdia, отслеживающей рынок серверов и ЦОД, рассказали, что данные по продажам поставщиков за I квартал будут опубликованы только в июне, поэтому сейчас вряд ли удастся получить чёткую картину какого-либо влияния тарифов. «Мы пока не видим никаких скачков цен на рынке серверов. Цепочка поставок серверов и производство в основном находятся на Тайване, и тайваньские поставщики готовятся к этой ситуации», — говорит Манодж Сукумаран (Manoj Sukumaran), главный аналитик направления Datacenter IT. Он выразил мнение, что рост тарифов станет проблемой клиентов, а не поставщиков. «Цепочка поставок серверов стала очень сложной с появлением ИИ-серверов, которые сейчас становятся стоечными системами (например, NVL72), а пул поставщиков очень ограничен в отличие от серверов общего назначения. Кроме того, нелегко внезапно перенести производство в другую страну, и это займёт довольно много времени», — рассказал аналитик. Большую обеспокоенность экспертов вызывает неопределённость ситуации, поскольку Трамп может сегодня заявить о грядущем росте тарифов, а на следующий день отменить своё решение. Главный аналитик Synergy Research Джон Динсдейл (John Dinsdale) сказал ресурсу The Register, что неопределённость — худший аспект для большинства в отрасли. «Во многих отношениях неопределённость хуже, чем уже известные плохие новости. Поэтому я совершенно не сомневаюсь, что операторы ЦОД и поставщики соответствующего оборудования принимают меры для смягчения любых проблем, которые могут возникнуть», — сказал он.

07.04.2025 [09:25], Сергей Карасёв

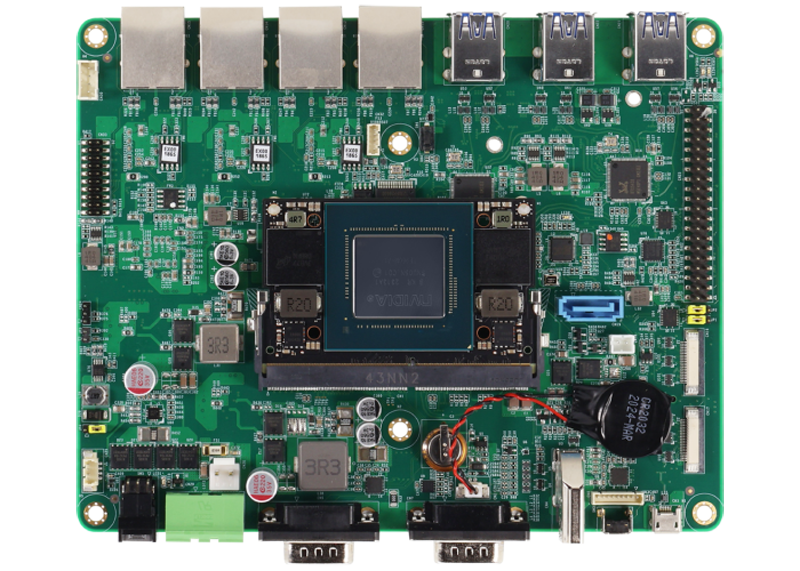

Комплект для ИИ-разработчиков AAEON NV8600-Nano содержит модуль NVIDIA Jetson Orin NanoКомпания AAEON представила под брендом UP комплект NV8600-Nano AI Developer Kit для разработчиков, создающих устройства с поддержкой ИИ. В основу новинки положен модуль NVIDIA Jetson Orin Nano Super с производительностью 67 TOPS (на операциях INT8). Названное изделие содержит процессор с шестью вычислительными ядрами Arm Cortex-A78AE и 8 Гбайт оперативной памяти LPDDR5. Присутствует GPU на архитектуре NVIDIA Ampere с 1024 ядрами CUDA и 32 тензорными ядрами. Интерфейсная плата набора NV8600-Nano AI Developer Kit располагает четырьмя сетевыми портами 1GbE с опциональной поддержкой PoE (25,6 Вт на каждый порт), шестью разъёмами USB 3.2 Gen2 Type-A, коннектором HDMI 1.4a, последовательным портом RS-232(RX/TX/GND)/422/485, SATA-разъёмом для подключения накопителя, двумя коннекторами MIPI-CSI, а также 40-контактной колодкой, совместимой с NVIDIA Jetson Orin Nano Developer Kit.

Источник изображения: AAEON На тыльной стороне платы находятся коннекторы M.2 2230 E-Key для комбинированного модуля Wi-Fi / Bluetooth, M.2 2242/3042/3052 B-Key (плюс слот для SIM-карт) для сотового модема и M.2 2280 M-Key для накопителя. Установлен NVMe SSD вместимостью 256 Гбайт. Диапазон рабочих температур простирается от -25 до +70 °C. Габариты составляют 166 × 133 мм, масса — около 190 г. В комплект поставки входят внешний адаптер питания мощностью 60 Вт, кулер с радиатором и вентилятором, а также камера Raspberry Pi Camera Module 2. Говорится о совместимости с Linux (NVIDIA Jetpack 6.0 и выше). Приобрести набор NV8600-Nano AI Developer Kit можно по ориентировочной цене $650. |

|