Лента новостей

|

02.03.2021 [13:45], Сергей Карасёв

Cisco закрыла сделку по покупке разработчика оптических компонентов AcaciaАмериканская компания Cisco, один из крупнейших в мире поставщиков сетевого оборудования, завершила сделку по поглощению Acacia Communications — разработчика оптических компонентов. Слияние позволит Cisco укрепить позиции на рынке кремниевой фотоники. Напомним, что Cisco сообщила о планах по покупке Acacia ещё в 2019 году. Тогда говорилось, что сумма сделки составит приблизительно $2,6 млрд. Однако первоначальные условия впоследствии изменились. Так, в январе нынешнего года Acacia объявила о расторжении договора с Cisco: причиной стало то, что сделка в обозначенные сроки не получила одобрения Государственного управления по регулированию рынка Китайской Народной Республики (SAMR). В свою очередь, Cisco обратилась в суд, настаивая на завершении слияния.

Источник изображения: Cisco Позднее компании смогли найти общий язык, правда, сумма сделки значительно выросла, составив $4,5 млрд. И вот теперь сообщается, что слияние завершено. Поглощение поможет Cisco расширить ассортимент продукции для построения высокоскоростных сетей передачи данных. Речь, в частности, идёт об оборудовании класса 400G и выше.

01.03.2021 [15:09], Сергей Карасёв

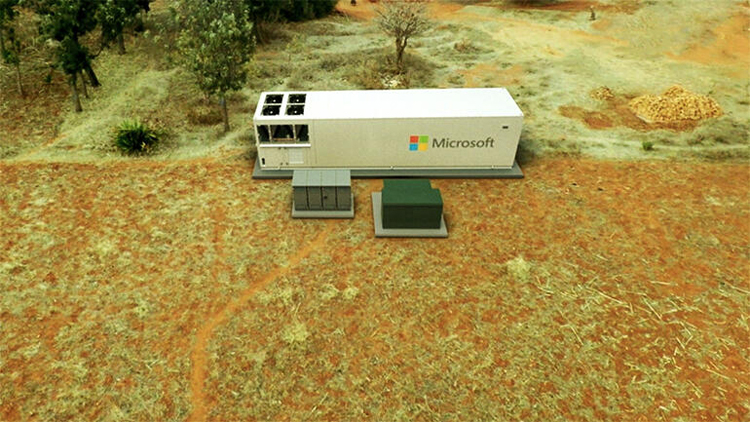

Microsoft Azure MDC: мобильное облако в 40-футовом контейнереКорпорация Microsoft начала поставки любопытного серверного решения — центра обработки данных Azure Modular Data Center (MDC), все составляющие которого заключены в стандартный 40-футовый контейнер. Такое исполнение позволяет перевозить систему на различных видах транспорта и быстро вводить в эксплуатацию. ЦОД может быть развёрнут в любом месте, где есть подходящая площадка для установки контейнера и электрическая сеть необходимой мощности. Более того, питание может подаваться от дизельных генераторов. ЦОД и всё его оборудование сконструированы так, чтобы пережить и транспортировку, и эксплуатацию в не самых благоприятных условиях.  Система позволяет получить доступ к вычислительным мощностям облака Azure. Контейнерный ЦОД может функционировать в суровом климате, обеспечивая бесперебойную работу критически важной инфраструктуры. Платформа MDC может использоваться, к примеру, в центрах гуманитарной помощи, передвижных пунктах управления, а также на территориях предприятий добывающей промышленности. MDC может работать как полностью автономно, так и в связке с «большим» облаком Azure. Причём предусмотрена возможность использования спутниковых средств связи — на случай перебоев в основном интернет-канале. Собственно говоря, именно в рамках совместного со SpaceX проекта Azure Space и были анонсированы эти ЦОД.  Внутри контейнера размещены три серверных блока, каждый из которых содержит две стойки 42U с коммутаторами и контроллерами. На каждый блок приходится 8 серверов и 48 узлов хранения. Все они работают под управлением Azure Stack Hub. Доступ к такому ЦОД предоставляется на условиях аренды, как и в случае более простых и компактных устройств серии Azure Stack Edge.

23.02.2021 [22:23], Андрей Галадей

Вышло обновление ZLUDA v2, открытой реализации CUDA для GPU IntelРанее мы уже писали об экспериментальнои проекте ZLUDA, развивающем открытую реализацию CUDA для GPU Intel, которая позволила бы нативно исполнять CUDA-приложения на ускорителях Intel без каких-либо модификаций. При этом её разработка ведётся независимо и от Intel, и от NVIDIA. Новинка построена на базе интерфейса Intel oneAPI Level Zero, и может работать на картах Intel UHD/Xe с неплохим уровнем производительности. Однако у первой версии был ряд ограничений. Вчера же вышла вторая версия, которая получила ряд улучшений. Кроме того, автор проекта объявил о переходе на модель непрерывного выпуска релизов. Основной упор в новой версии сделан на улучшение поддержки Geekbench и работы в Windows-окружении. Собственно говоря, автор прямо говорит, что оптимизация под Geekbench пока является основной целью, а другие CUDA-приложения могут не работать. Кроме того, такое ПО, запущенное с помощью ZLUDA будет работать медленнее, чем на картах NVIDIA, в силу разности архитектур GPU и необходимости эмуляции некоторых возможностей. Подробности приведены на странице проекта.

17.02.2021 [00:43], Игорь Осколков

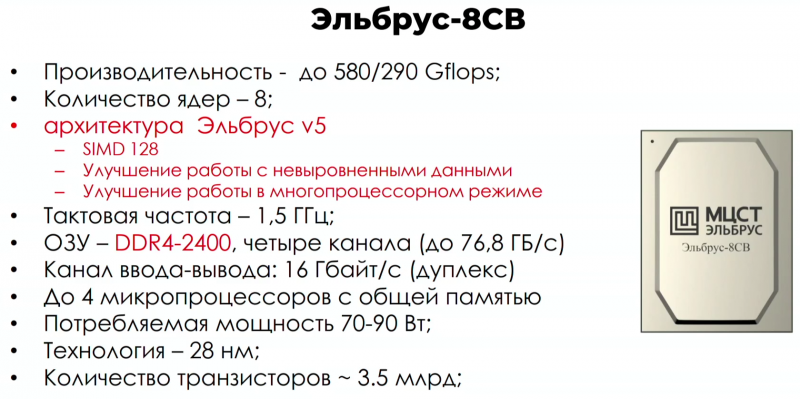

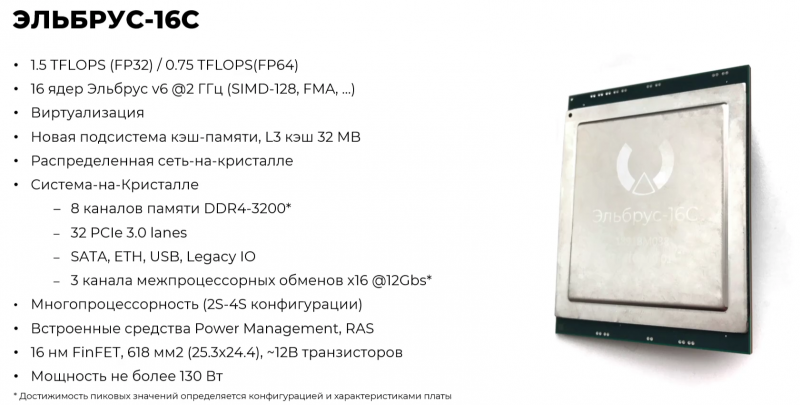

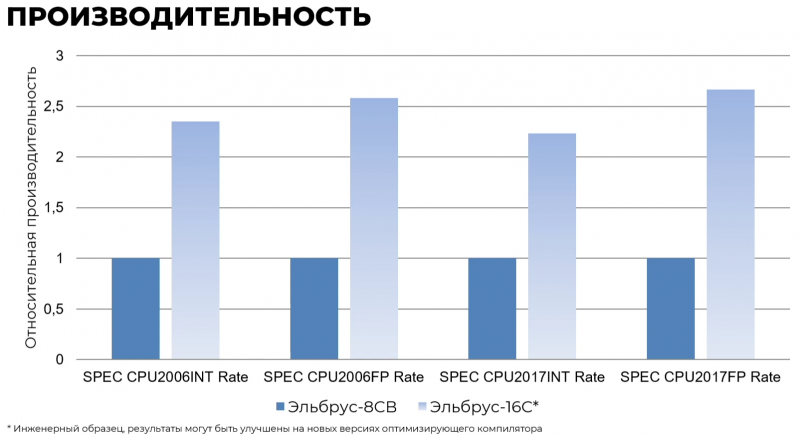

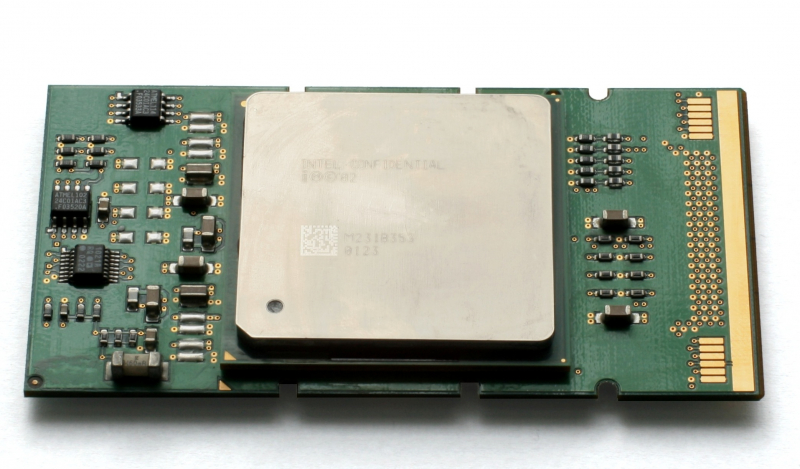

Российские процессоры Эльбрус-16С, Эльбрус-12С и Эльбрус-2С3 получат ядра шестого поколения архитектуры E2KНа мероприятии Elbrus Tech Day компания МСЦТ рассказала о текущих достижениях и планах развития серии российских процессоров Эльбрус. Сейчас наиболее современным CPU этой линейки является Эльбрус-8СВ на базе архитектуры E2K (Эльбрус 2000) пятого поколения, но в ближайшие годы появятся сразу три SoC шестого поколения: Эльбрус-16С, Эльбрус-2С3 и Эльбрус-12С. Эльбрус-8СВ является эволюционным развитием Эльбрус-8. Оба чипа используют 28-нм техпроцесс, но за счёт оптимизаций у 8СВ удалось поднять частоту, что вкупе с поддержкой широких векторных инструкций и более современного стандарта памяти дало двукратный рост теоретической пиковой производительности. Впрочем, для программ, не использующих SIMD, прирост пропорционален увеличению тактовой частоты + они всё равно выигрывают от увеличения скорости работы памяти.

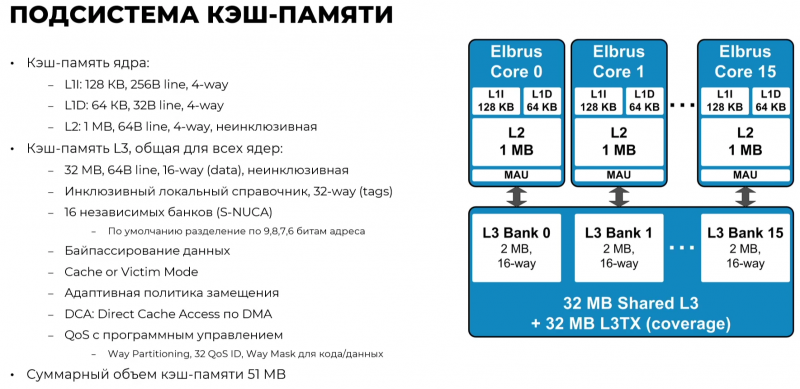

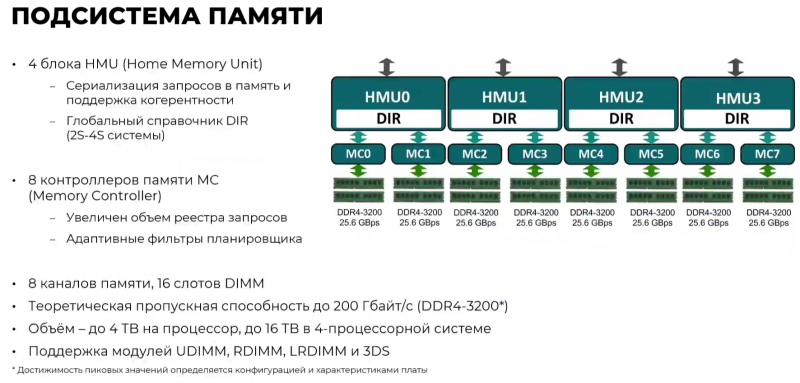

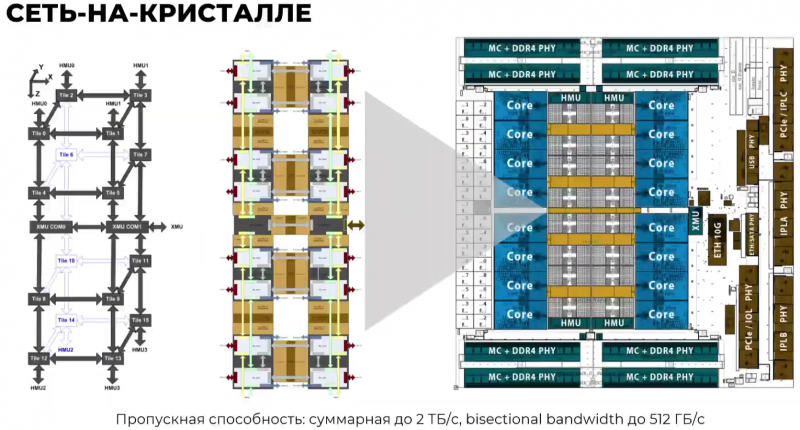

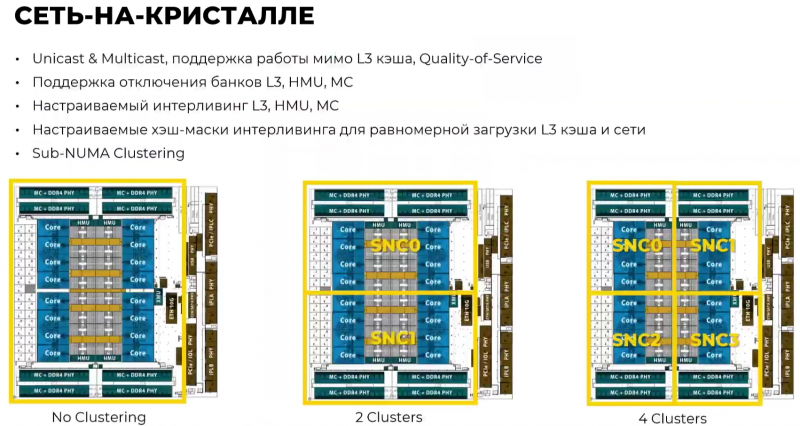

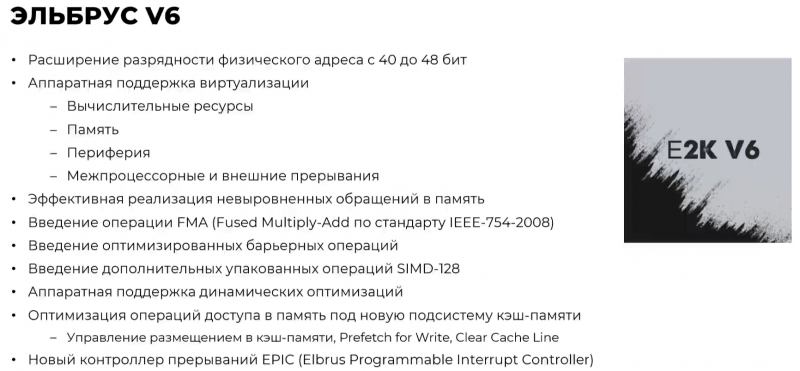

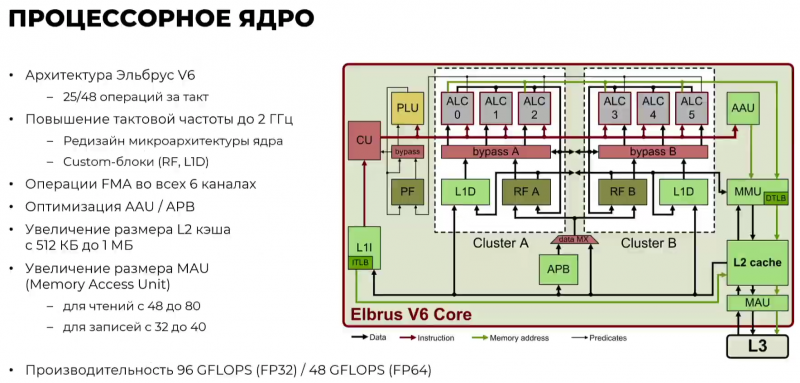

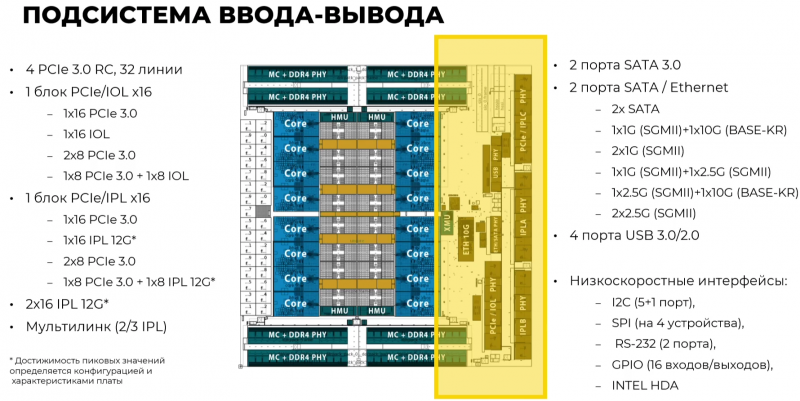

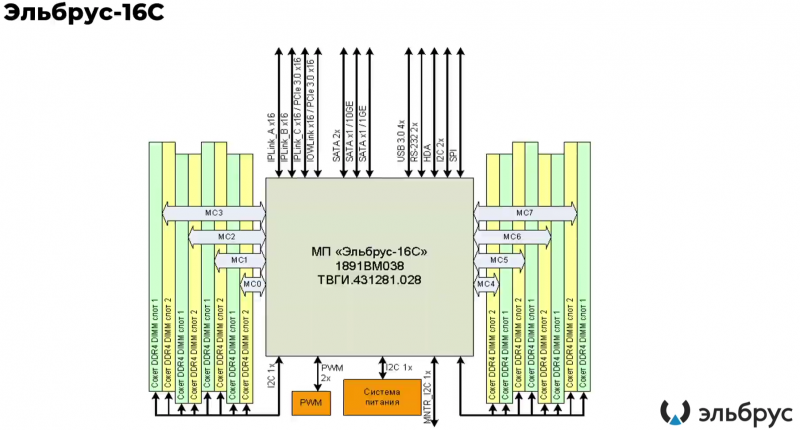

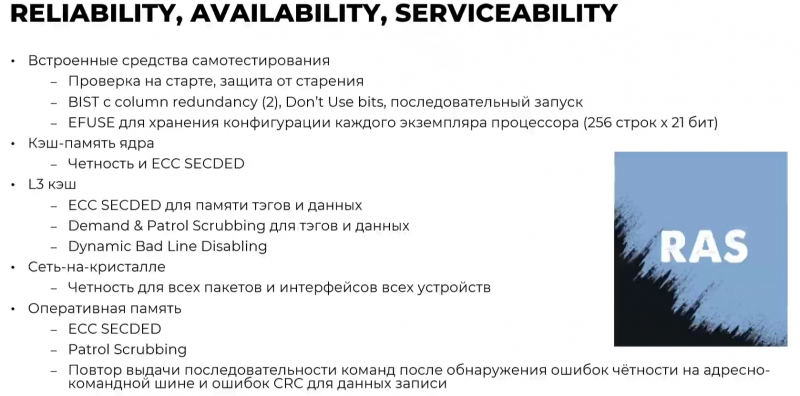

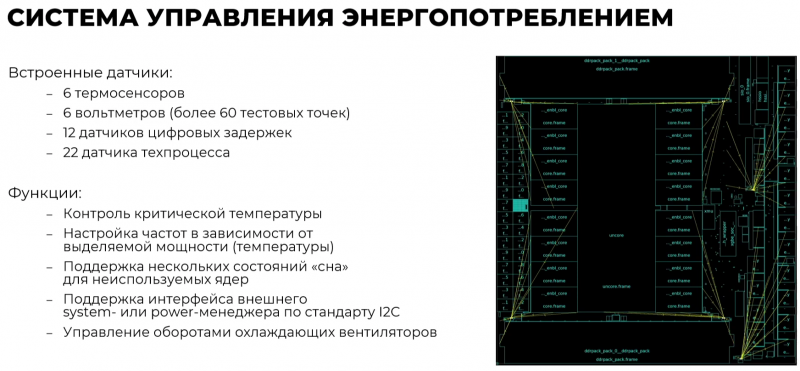

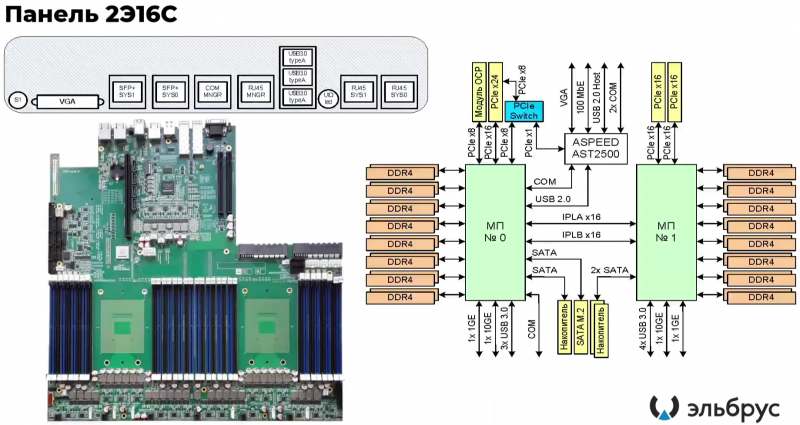

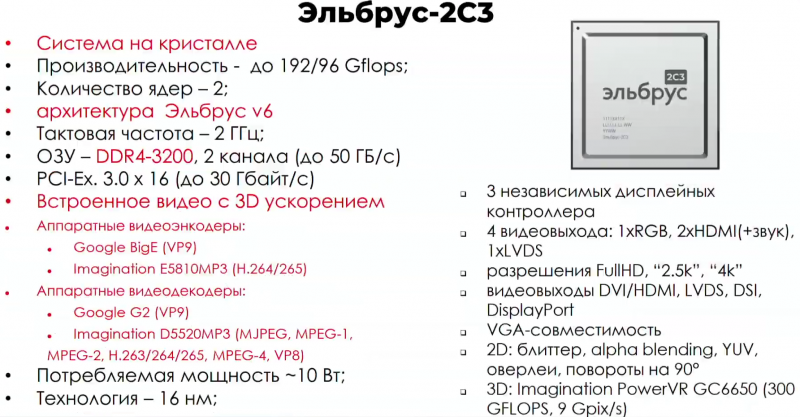

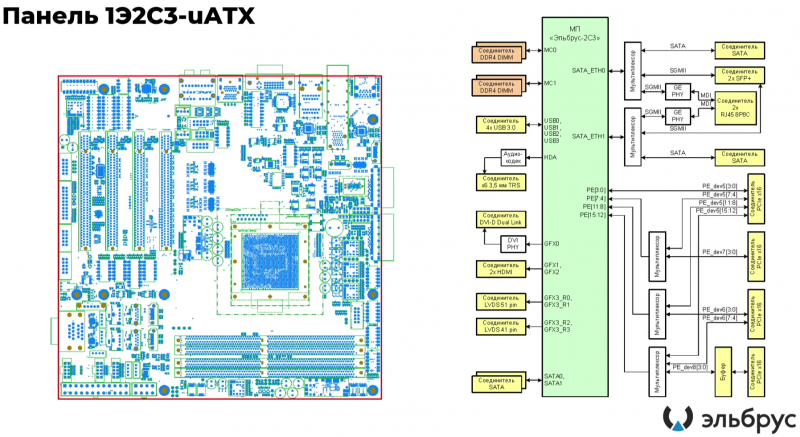

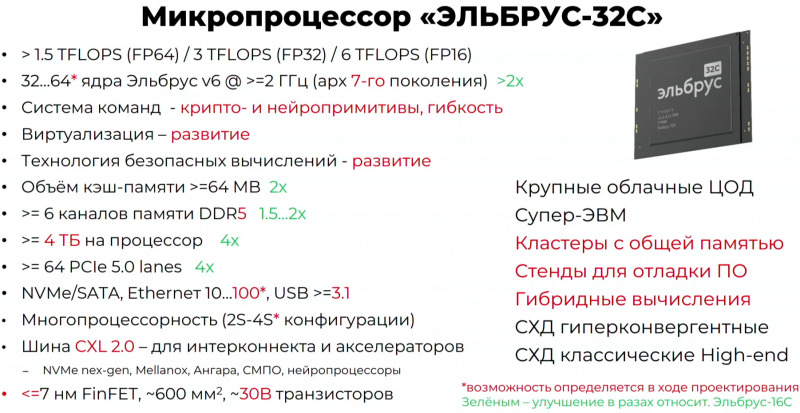

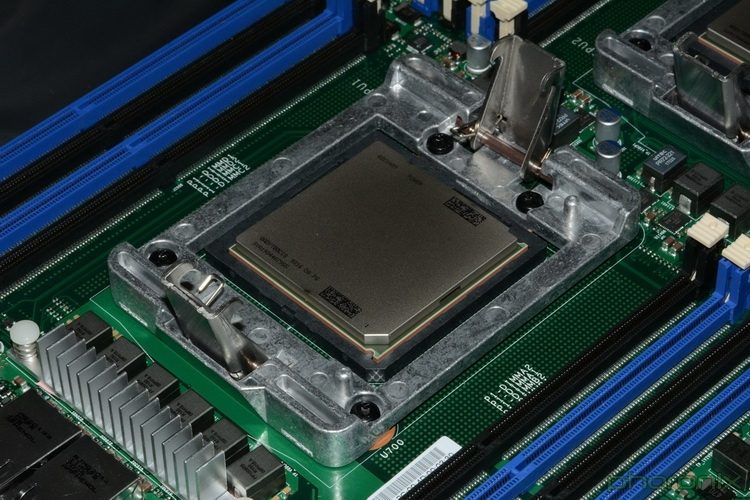

На базе этих и других процессоров компания МЦСТ разрабатывает референсные дизайны материнских плат различных форм-факторов, которые можно лицензировать для дальнейшей кастомизации. Часть партнёров компании разрабатывает собственные материнские платы и изделия на их основе. В скором времени на TSMC будет размещён заказ на изготовление очередной партии Эльбрус-8СВ объёмом 10 тыс. штук. В целом, вокруг уже имеющихся CPU сложилась достаточно заметная экосистема как аппаратных, так и программных продуктов и решений. Следующее поколение процессоров будет разнообразнее. Помимо 16-ядерного Эльбрус-16С, ориентированного на высокопроизводительные серверные системы, будет и модель попроще, которая появится позже остальных — Эльбрус-12С. Этот 12-ядерный CPU рассчитан на серверы начального уровня, а также рабочие станции. А главное отличие от 16С будет в цене. Наконец, ещё один чип, двухъядерный Эльбрус-2С3, ориентирован на мобильные системы, в том числе планшетные компьютеры. Все чипы будут изготавливаться на TSMC по 16-нм техпроцессу FinFET и будут основаны на шестом поколении архитектуры E2K. Строго говоря, это уже не процессоры, а полноценные SoC с интегрированными контроллерами для различной периферии, и для работы им не требуется внешний чип южного моста, как было ранее. В случае Эльбрус-16С площадь кристалла составляет 618 мм2 (25,3 × 24,4 мм), упакован он в корпус HFCBGA4804 с габаритами 63 × 78 мм. Кристалл содержит 12 млрд транзисторов, а его мощность не превышает 130 Вт. Значительная часть изменений в архитектуре коснулась подсистемы памяти. В частности, были увеличены размеры кешей, суммарный объём которых достиг 51 Мбайт: общий для всех L3-кеш 32 Мбайт, увеличенный до 1 Мбайт L2-кеш, L1-кеш для инструкций на 128 Кбайт + L1-кеш данных на 64 Кбайт. Контроллер памяти стал восьмиканальным, получил поддержку модулей DDR4-3200 и 2DPC, что даёт до 4 Тбайт RAM на сокет с суммарной пропускной способностью до 200 Гбайт/с. Первые инженерные образцы Эльбрус-16С, полученные в конце прошлого года, уже выдают в бенчмарке stream скорость порядка 70-80% от максимально возможной. Контроллеры попарно подключены к четырём агентам (HMU), «прикреплённым» к внутренней mesh-шине с пропускной способностью 2 Тбайт/с, объединяющей память и ядра. Чип можно разделить на два или четыре NUMA-домена, что полезно для ряда задач. Одной из таких задач является виртуализация, и в Эльбрус-16С она, наконец, стала полноценной — новые процессоры поддерживают аппаратную виртуализацию практически всех важных ресурсов, в том числе и для режима x86-трансляции, который тоже никуда не делся. Для CPU прошлых поколений всё ещё можно использовать контейнеризацию, но МЦСТ занимается и подготовкой паравиртуализированного ядра и сопутствующих компонентов, включая KVM, QEMU, libvirt и virt-manager. Для самих ядер был произведён редизайн микроархитектуры, что дало повышение скорости работы и новые возможности. В частности, появились новые SIMD-инструкции в дополнение к имеющимся, поддержка FMA по стандарту IEEE 754-2008 (требуется в современных стандартах C), динамическая оптимизация (касается планирования, что важно для VLIW), новый контроллер прерываний (необходим для виртуализации) и так далее. Пиковая теоретическая производительность ядра составляет 96 Гфлопс для вычислений одинарной точности и 48 Гфлопс — для двойной. Для всего CPU это 1,5 Тфлопс и 768 Гфлопс соответственно. Предварительные тесты показывают прирост производительности в 2-2,5 раза в сравнении с Эльбрус-8СВ, но надо помнить, что очень много зависит от оптимизаций со стороны компилятора. Само ядро хоть и стало сложнее, но оно всё равно проще, чем ядра современных x86-64 процессоров. Слабым местом новых чипов, на наш взгляд, является IO-блок. В состав SoC входят четыре root-комплекса PCIe 3.0, которые в сумме дают 32 линии. Из них 8 или 16 линий можно выделить на подключение внешнего южного моста, если не хватает того, что встроен в сам чип. Он предоставляет 2 порта SATA 3.0, 4 порта USB 3.0/2.0 и два мульти-порта, дающих или пару SATA, или пару Ethernet с максимальной конфигурацией 10GbE + 2.5GbE. Ещё 8 линий PCIe можно отдать на канал для межпроцессорной связи (IPL) в дополнение к двумя каналам, которые есть всегда. В двухсокетной системе, таким образом, можно объединить CPU двумя или тремя IPL. Правда, скорость одного такого канала составляет всего 12 Гбит/с (на инженерных образцах пока достигли 10 Гбит/с), что значительно меньше, чему у UPI или Infinity Fabric. Всего в одной системе может быть объединение до четырёх процессоров. Помимо прочего, в чипах реализованы различные RAS-функции для повышения надёжности работы. Также улучшен мониторинг процессора и управление его питанием и охлаждением. Вероятно, теперь уже все системы на базе новых CPU будут комплектоваться BMC-контроллером — ASPEED AST2500 и в перспективе AST2600 — с собственной прошивкой на базе OpenBMC и с встроенной микро-ОС, упрощающей инициализацию и работу с оборудованием. Референсный дизайн двухсокетной платы 2Э16С-SPRC появится в середине этого года, а однопроцессорной Micro-ATX — к концу. В 2022 году появятся и другие варианты двух- и четырёхсокетных систем с Эльбрус-16С, а также одно- и двухсокетные платы для Эльбрус-12С. Партнёры МЦСТ, надо полагать, тоже не будут сидеть без дела. Напомним, что формально окончание разработки Эльбрус-16С намечено на конец этого года. Для Эльбрус-2С3 и Эльбрус-12С точные сроки озвучены не были. И если 12-ядерная модель, скорее всего, очень похожа на 16-ядерную, то младший чип серии заметно от них отличается. Эльбрус-2С3 имеет всего два ядра шестого поколения с тактовой частотой 2 ГГц, два канала памяти DDR4-3200 и производительность до 192/96 Гфлопс FP32/FP64. У него есть 16 линий PCIe 3.0. В его состав входит 3D-ядро Imagination PowerVR GX6650 (300 Гфлопс), ряд (де)кодеров видео, а также 2D-ядро собственной разработки. Есть четыре видеовыхода (из них 2 HDMI) и поддержка 4K-вывода. Для этой SoC компанией в течение 2021 года будут подготовлены первые платы Micro-ATX и Mini-ITX. Характеристики будущих процессоров Эльбрус-32С пока до конца не определены, но примерные очертания будущего продукта уже есть. CPU должен иметь производительность не ниже 1,5/3/6 Тфлопс для вычислений FP64/FP32/FP16 и содержать от 32 ядер с частотой более 2 ГГц. Возможно, будет и 64 ядра седьмого поколения E2K. Объём L3-кеша должен как минимум удвоиться, а контроллер памяти, возможно, получит поддержку DDR5 объёмом не менее 4 Тбайт/сокет. Предполагается возможность работы как минимум двухсокетных конфигураций. Дальнейшее развитие могут получить виртуализация и фирменная технология безопасных вычислений с попутным добавлением новых инструкций. Уже сейчас разработчики хотят предоставить 64 линии PCIe 5.0, что открывает путь к использованию CXL 2.0. К встроенным контроллерам, помимо NVMe, без которого уже точно не обойтись, могут добавиться 100GbE и USB 3.1 или более новые. Будущие кристаллы перейдут на техпроцесс не толще 7 нм, а их площадь вырастет до 600 мм2.

10.02.2021 [17:09], Владимир Мироненко

Облако под землёй: израильский регион Oracle Cloud расположится в защищённом дата-центре на глубине 50 мСтало известно, что Oracle разворачивает новый облачный регион в Израиле. Он находится в высокозащищённом четырёхуровневом подземном объекте в Иерусалиме, где также размещена одна из наиболее засекреченных ИТ-инфраструктур страны. Облачный регион Oracle в Иерусалиме находится в разработке с прошлого года. Многопользовательский ЦОД общей площадью 460 тыс. кв. футов (42,8 тыс. м2) был построен израильским провайдером ИТ-услуг Bynet Data Communications. Израиль стал вторым облачным регионом Oracle на Ближнем Востоке. Свои первые облачные площадки в этом регионе компания запустила в прошлом году в Дубае.  Другие облачные провайдеры тоже создают ЦОД в Израиле, что стимулирует строительство большого количества новых объектов в стране. Согласно публикации израильской деловой газеты Globes, здесь планируют запустить дата-центры Amazon Web Services и Microsoft Azure. Возможным подрядчиками в реализации проекта AWS названы риэлтерская компания Azrieli Group и американский разработчик ЦОД Compass Datacenters, в котором Azrieli недавно приобрела значительную долю. Хотя подземные центры обработки данных имеются и в других регионах мира, Иерусалим, находящийся под постоянной угрозой нападения со стороны соседей Израиля, сделал выбор в пользу хранения критически важных инфраструктур под землёй по вполне очевидным причинам.

Фото: EZRA LEVY, The Jerusalem Post Согласно данным израильского сайта CTech, верхний этаж объекта Bynet находится под пятиуровневым гаражом, который, в свою очередь, размещён под 17-этажным зданием. Потолок самого верхнего уровня ЦОД сделан из «бетона с покрытием из стальных пластин, способного противостоять взрыву автомобильной бомбы». Как сообщает CTech, «каждый этап строительства и монтажа» контролировали государственные регулирующие органы во главе с национальным киберуправлением и спецслужба Шин Бет. Причина такого строгого надзора заключается в том, что Oracle — не единственный арендатор объекта. Он предназначен для размещения ИТ-инфраструктуры крупных банков, страховых и технологических компаний, а также государственных учреждений, включая оборонные. Отметим, что высокозащищённые подземные дата-центры также предлагают Cavern Technologies, Iron Mountain, Pionen, DEAC, Lefdal и др.

01.02.2021 [22:16], Алексей Степин

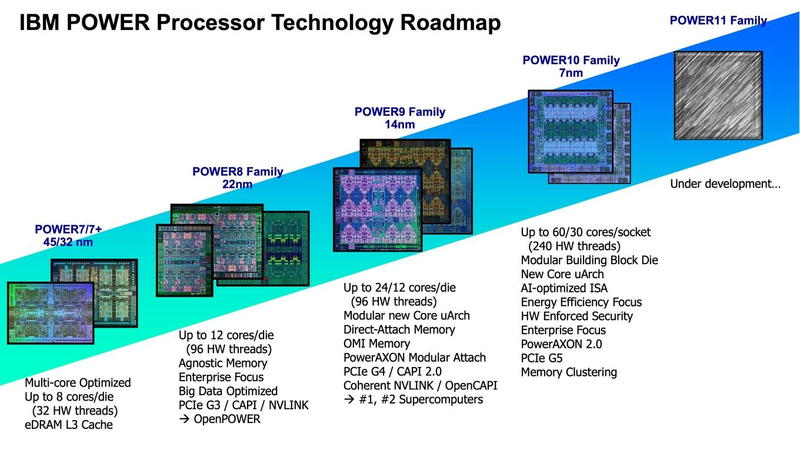

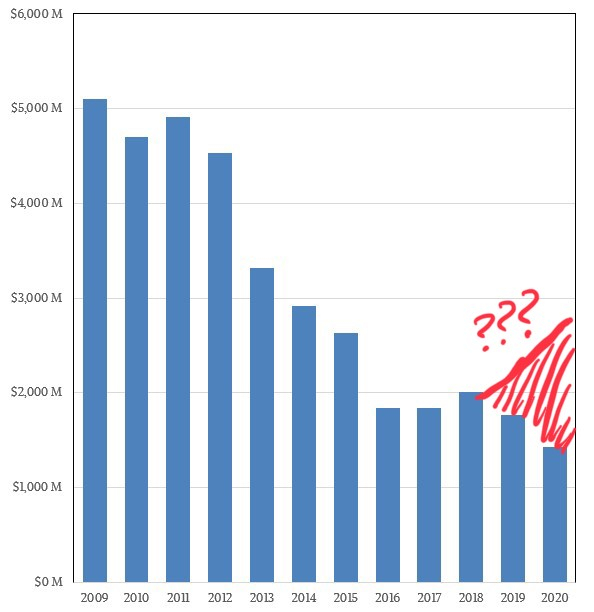

Cделка IBM и Inspur, похоже, спасает архитектуру POWER от вымиранияКогда говорят о противостоянии серверных процессоров, как правило, называют AMD и Intel, а с недавних пор ещё и ARM. Некогда крупный игрок, IBM со своими процессорами серии POWER, упоминается существенно реже, и на то есть причины — за прошедшее десятилетие дела у компании шли не слишком хорошо. Но, если верить аналитикам IT Jungle, ситуация с POWER не так проста и не так плоха. Если верить отчётам самой IBM, доходы снизились на рекордную величину за последние пять лет, упали даже продажи мейнфреймов. Доходы в сегменте аппаратного обеспечения за прошедший год у IBM упали на 18% относительно 2019 года, а у подразделения Power Systems называют даже цифру 43,3%. Однако как считают некоторые аналитики, дела в секторе серверов на базе процессоров POWER могут обстоять не так плохо, как это может показаться на первый взгляд.  Платформа IBM POWER самобытна и весьма интересна сама по себе: так, уже не новые процессоры POWER9 поддерживают четыре потока на ядро против традиционных двух у x86, а в некоторых вариантах способны работать даже в режиме SMT8. Более новые POWER10 также поддерживают восьмипоточный режим; кроме того, они работают с прогрессивным форматом оперативной памяти OMI и имеют контроллер PCI Express 5.0.

Планы развития архитектуры POWER Здесь следует немного углубиться в историю. Китайская компания Inspur, один из крупнейших среднеазиатских производителей серверного оборудования, всегда мечтала о «большом железе». В 2014 году ей удалось добиться договорённости с IBM о праве запускать фирменное ПО последней (в частности, базы данных DB2 и сервер приложений WebSphere) на 32-процессорных Itanium-системах. А месяцем позднее Inspur присоединилась к консорциуму OpenPower с целью создания серверов уже на базе архитектуры POWER. В 2017 начинается «война санкций», при этом приличного самостоятельного открытого клона POWER-процессора консорциум так и не создал. Известно, что китайская Suzhou PowerCore Technology, входящая в OpenPower, занималась адаптацией POWER под более «толстые» техпроцессы. Сейчас компания активно нанимает сотрудников и открывает новое подразделение в США. Однако чем именно она занимается и связан ли этот рост с полным открытием POWER ISA, не до конца ясно.

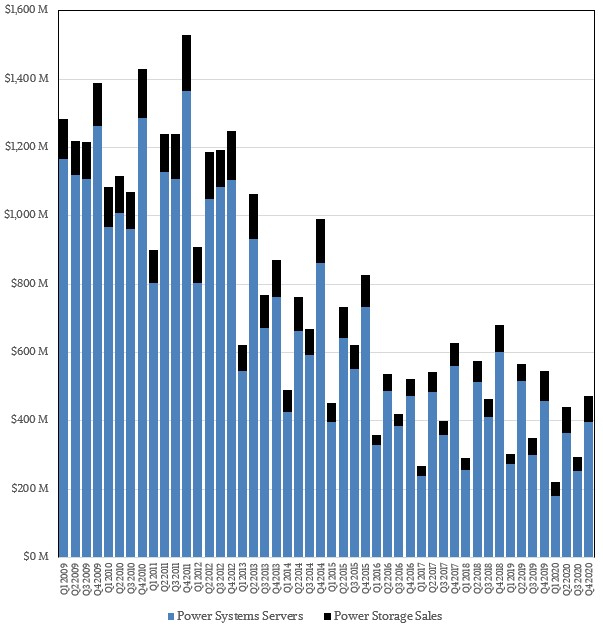

Структура продаж POWER-систем по мнению ресурса IT Jungle До ввода санкций IBM и Inspur успевают создать совместное предприятие (51% Inspur + 49% IBM), которое, что интересно, тоже называется IBM — Inspur Business Machines. Цель новой компании, в которую вложили порядка 1 млрд юаней ($150 млн) — создание мощных серверных систем на базе архитектуры POWER для крупного бизнеса. Поставками же POWER-процессоров для Inspur занималась, в частности, всё та же Suzhou. Судя по косвенным данным, сделка для Inspur оказалась весьма успешна. Кроме того, компания вообще чувствует себя отлично, поставляя также x86-серверы как малому и среднему бизнесу, так и китайским гигинтам Alibaba, Baidu и Tencent. К сентябрю 2020 года продажи Inspur составят $7,71 млрд, что на 43% больше, нежели у IBM с её $5,4 млрд.

С учётом поставок Inspur общий объём продаж POWER-серверов может выглядеть так по мнению IT Jungle К настоящему моменту IBM публикует только свои цифры продаж систем на базе POWER, и графики выглядят достаточно удручающе. Из-за санкций IBM не может продавать POWER-системы в КНР напрямую, а Inspur Business Machines — может. Из $8 млрд продаж Inspur примерно 10-12% может приходиться на системы с процессорами POWER, а это от $800 до $960 млн, и эти цифры сопоставимы с продажами серверов самой IBM. Иными словами, платформа POWER, скорее всего, отнюдь не находится в процессе вымирания. Более того, после неудачных 2016 и 2017 годов объёмы продаж таких серверов могли, как минимум, вернуться к показателям 2015 года. Также вполне вероятно, что и Google производит для себя серверы на базе POWER — соответствующие предложения появились в Google Cloud уже достаточно давно. Похожее решение есть и в Microsoft Azure.

29.01.2021 [17:17], Андрей Галадей

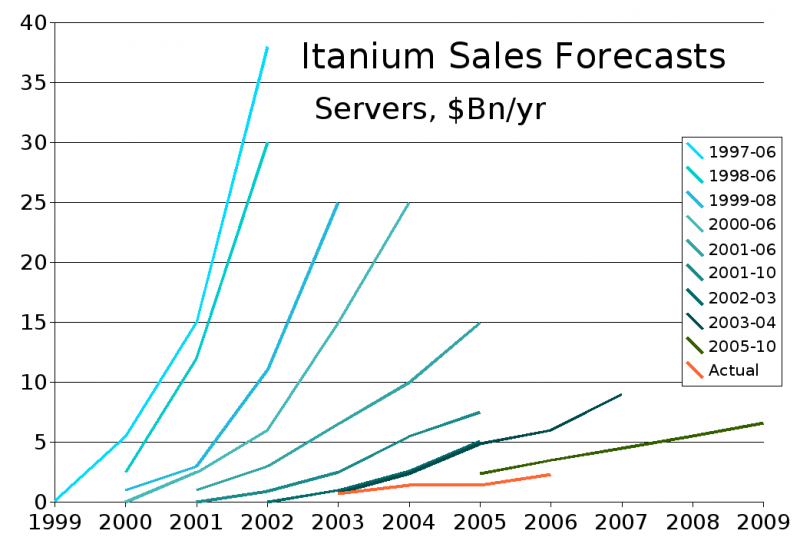

Itanium забыт и заброшен: Линус Торвальдс констатировал смерть архитектурыОдной из проблем и в то же время достоинств Linux является поддержка многих старых архитектур процессоров. Это увеличивает размеры ядра и усложняет сопровождение. Но теперь, похоже, на одну архитектуру станет меньше. В ядре Linux 5.11, как выяснилось, оказалась нарушена поддержка Itanium IA-64. После исправления выяснилось, что это не единственная проблема такого рода, однако истинную причину выяснить не удалось из-за отсутствия доступа к «железу». Так что Линус Торвальдс (Linus Torvalds) в итоге принял решение пометить данную архитектуру как orphaned, то есть заброшенную, и прямо заявил, что она мертва. А это первый шаг к полному исключению её из ядра, как это уже случилось с другим продуктом Intel — Xeon Phi.

Изображения: wikipedia.org Два последних крупных игрока на рынке Itanium-систем — сама Intel и её клиент HPE — уже давно забросили поддержку этой архитектуры в Linux, да и энтузиасты к ней охладели. И это объяснимо. Последнее поколение Itanium 9700 Kittson вышло в 2017 году, а приём заказов на них прекратился год назад. Поставки формально будут свёрнуты 29 июля 2021 года, но эти CPU с высокой степенью вероятности практически никто не закупил хоть в сколько-то значимых объёмах. В дистрибутивах же поддержку процессоров убрали давно. Red Hat не поддерживает чипы с RHEL 5, SUSE перестала поддерживать после SUSE Linux 11. Так что теперь поддержка будет осуществляться лишь теми компаниями, которые явно заинтересованы в этом. Разумеется, если такие остались. В своё время спор между Oracle и HPE подорвал репутацию платформы. Впрочем, Linux не является единственным вариантом — поддержка HP-UX, наследника классических UNIX, версии 11i v3 для ряда продуктов HPE будет осуществляться до 31 декабря 2025. Аналогичная ситуация сложилась и вокруг SPARC c Solaris, так как большую часть разработчиков обоих продуктов Oracle уволила ещё в 2017 году. Oracle обязалась сопровождать Solaris 11 максимум до 2034 года. В частности, на днях она выпустила патч безопасности для sudo и восстановила некоторые старые материалы. Однако Solaris 12 мы вряд ли когда-либо увидим. Сейчас компании гораздо более интересны облака, Linux и Arm-процессоры Ampere.

21.01.2021 [16:44], Сергей Карасёв

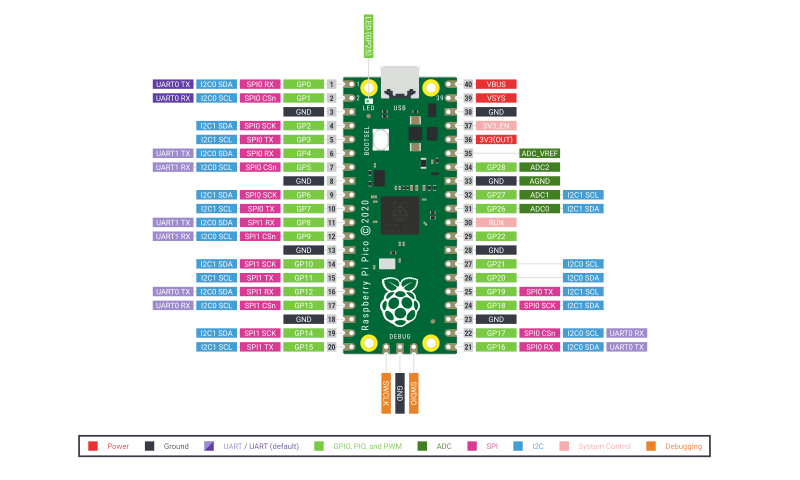

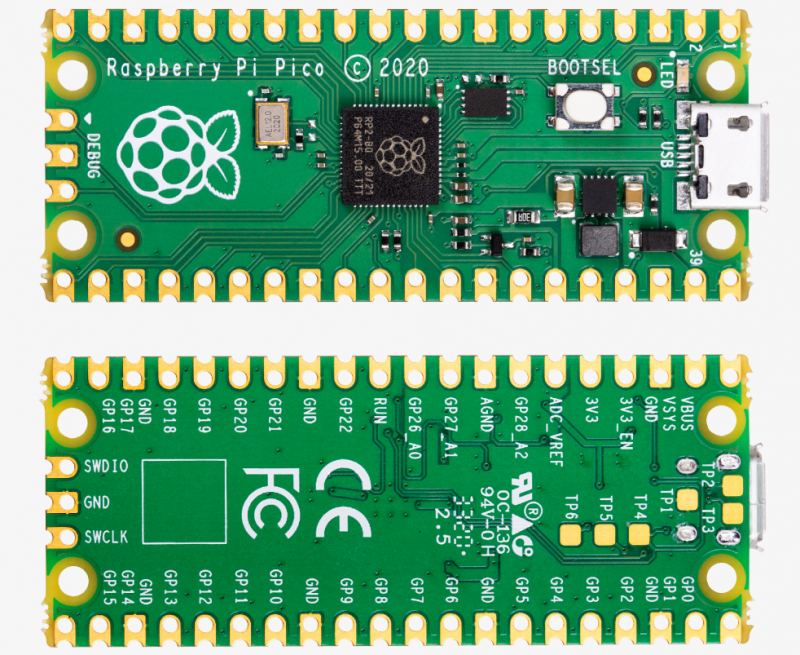

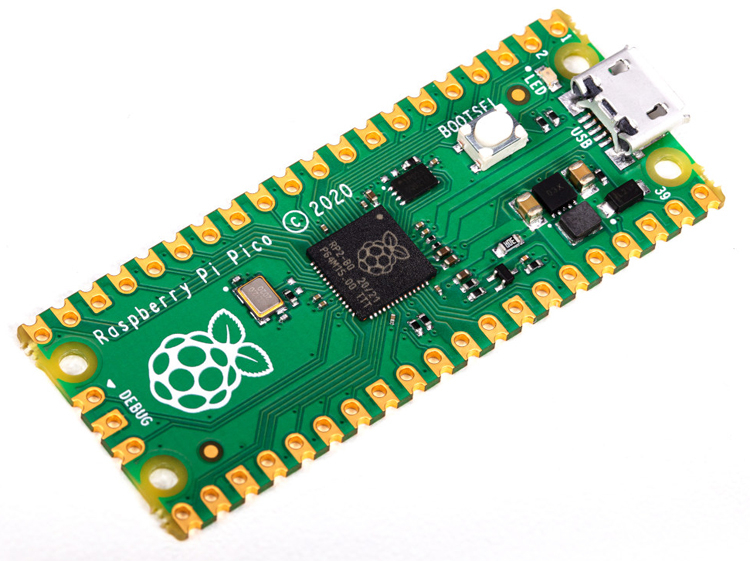

Плата Raspberry Pi Pico с микроконтроллером RP2040 оценена всего в $4Организация Raspberry Pi Foundation объявила о выпуске своего первого микроконтроллера: плата под названием Raspberry Pi Pico выполнена на основе микрочипа собственной разработки RP2040. В состав RP2040 входят два ядра Cortex M0+ с базовой тактовой частотой 48 МГц и возможностью повышения до 133 МГц. Предусмотрены 264 Кбайт памяти SRAM. Корпус: QFN56 с размерами 7 × 7 мм.  Собственно мини-плата Raspberry Pi Pico имеет габариты 51 × 21 мм. Она оснащена единственным разъёмом Micro-USB 1.1, который служит как для подачи питания, так и для загрузки прошивок в формате UF2. Имеется массив из 30 GPIO-контактов, позволяющий задействовать интерфейсы 2 × UART, 2 × I2C, 2 × SPI (всего до 16 Мбайт QSPI Flash с XIP), а также 16 PWM-каналов. Кроме того, упомянут температурный датчик и 4 ADC-канала. Микроконтроллер Raspberry Pi Pico может применяться в учебных целях, а также для создания тех или иных устройств для Интернета вещей, промышленной сферы и пр. Для упрощения работы имеются средства разработки на MicroPython и C/C++. Цена Raspberry Pi Pico с 2 Мбайт QSPI Flash составляет всего 4 доллара США. Любопытно, что чип RP2040 также использоуетсяя в изделиях сторонних производителей. Свои решения на этой платформе уже представили Arduino, Adafruit, Sparkfun и Pimoroni. Они могут применяться для сбора различных данных, задач машинного обучения и пр.

15.01.2021 [13:51], Владимир Мироненко

В Китае представили подводный дата-центр Highlander на манер Microsoft Project NatickВ минувшее воскресенье в китайском порту Гаолань в особой экономической зоне Чжухай провинции Гуандун состоялась официальная церемония запуска первого в стране подводного дата-центра (UDC). UDC был разработан компанией Beijing Highlander Digital Technology Co, которая специализируется на разработке и производстве судовой электронной аппаратуры и систем, и крупнейшей судостроительной компанией Китая Guangzhou Shipyard International Co. По словам вице-президента Highlander Сюй Тань (Xu Tan), строительство подводного дата-центра было завершено в конце прошлого года. В настоящее время крупные центры обработки данных в основном строятся для использования на суше. Как правило они занимают большую территорию, а их высокие требования к охлаждению означают, что они потребляют много энергии и водных ресурсов. В свою очередь, UDC использует большое количество проточной морской воды для охлаждения электроники через теплообменник, что позволяет сократить расход энергии по сравнению с традиционными методами охлаждения.  К тому же размещение UDC у прибрежных городов позволяет сократить расстояние между потребителями и вычислительными мощностями. Эта концепция была впервые предложена компанией Microsoft в проекте Project Natick, которая в течение двух лет эксплуатировала ЦОД с 12 стойками в прибрежных водах Шотландии. «UDC занимает очень мало места на берегу, не имеет градирен и не потребляет пресную воду. Он не только поддерживает экологическую деятельность, такую как выращивание и разведение водных организмов, но также поддерживает другую промышленную деятельность, такую как морская ветроэнергетика и эксплуатация нефтяных платформ», — отметила Сюй.  Highlander сообщила о планах построить в течение следующих пяти лет серию подводных центров обработки данных в прибрежных водах, включая порт Хайнань (Hainan Free Trade Port, FTP), регион Большого залива Гуандун-Гонконг-Макао (GBA), дельту реки Янцзы и экономическую зону Bohai Rim Economic Circle (BREC).  В настоящее время она участвует в выборе места установки кабельных коммуникаций и подготовке к вводу в эксплуатацию дата-центра для тестирования, которое продлится с июня 2021 года по май 2022 года. На этом этапе проект будет представлен правительственным организациям, научно-исследовательским и финансовым учреждениям и полностью коммерциализирован во второй половине 2023 года. В рамках реализации проекта в порту Хайнань Highlander подписала контракт с компаниями China Mobile, Lenovo, China Communications Service Construction и Qi'anxin Technology Group.

13.01.2021 [19:03], Игорь Осколков

Qualcomm поглощает Nuvia, разработчика серверных Arm-процессоровQualcomm Incorporated объявила, что её дочерняя компания Qualcomm Technologies, Inc. заключила окончательное соглашение о приобретении NUVIA примерно за $1,4 млрд. Решения компании должны дополнить экосистему Snapdragon, включающую GPU, ИИ-движки, DSP и мультимедийные ускорители. Сделка ждёт одобрения со стороны регуляторов. Любопытно, что Qualcomm говорит об использовании решений NUVIA во флагманских смартфонах, ноутбуках следующего поколения, системах автопилотирования и приборных панелях авто, а также для сетевой инфраструктуры и подключённых устройств. Однако NUVIA разрабатывала SoC Orion c Arm-процессором Phoenix собственного дизайна, которая ориентирована на совершенно другой сегмент — на облачных провайдеров и гиперскейлеров. Компания обещала, что её чипы будут быстрее и энергоэффективнее AMD EPYC и Intel Xeon. Осенью она получила дополнительные $240 млн для производства первых чипов.

Источник изображений: NUVIA У двух крупных игроков, Qualcomm и Broadcom, с серверными Arm-процессорами не заладилось. Первая забросила Centriq, а наследие проекта Vulcan второй в результате череды слияний и поглощений оказалось в руках Marvell, которая этими же руками проект, судя по всему, и похоронила. Так что на этом рынке к концу 2020 года осталось только два заметных игрока: Ampere, уже представившая свои чипы (очень неплохие, надо сказать), и подающие надежды NUVIA. Из альтернатив остаются Amazon Graviton2, который доступен только в облаке AWS, и Kunpeng от Huawei, которая находится под санкциями США и будущее её несколько туманно. Qualcomm, судя по сегодняшнему релизу, пока не очень заинтересована в развитии серверных Arm-процессоров. Вероятно, она надеется, что NUVIA поможет ей догнать Apple — Qualcomm традиционно отставала от последней в выводе на рынок SoC на базе новых архитектур Arm. Среди основателей NUVIA числится Джерард Уильямс III (Gerard Williams III), который почти десять лет руководил разработкой Arm-чипов в Apple, был научным сотрудником Arm и ведущим дизайнером Texas Instruments. В конце 2019 года Apple подала к нему иск. Двое других основателей NUVIA имеют не менее солидный послужной список: Ману Гулати (Manu Gulati) и Джон Бруно (John Bruno) в разное время работали в AMD, Apple и Google, в том числе в должности архитектора. К компании также присоединились бывший вице-президент Intel по маркетингу Джон Карвилл (Jon Carvill), работавший в Facebook✴, Qualcomm, Globalfoundries, AMD и ATI, а также Энтони Скарпино (Anthony Scarpino), проработавший 24 года в ATI и AMD. |

|