Лента новостей

|

16.05.2022 [23:41], Алексей Степин

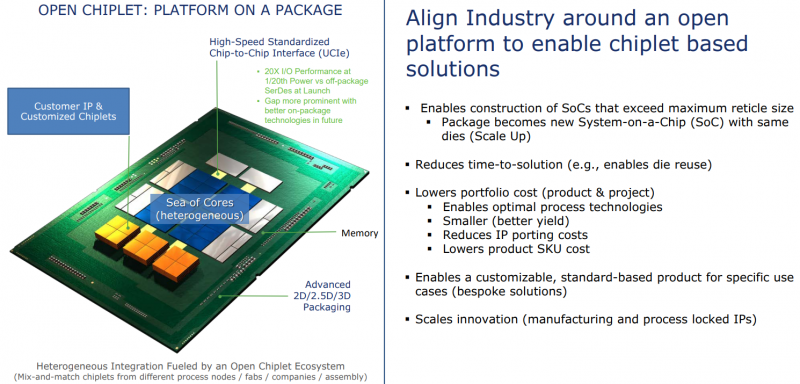

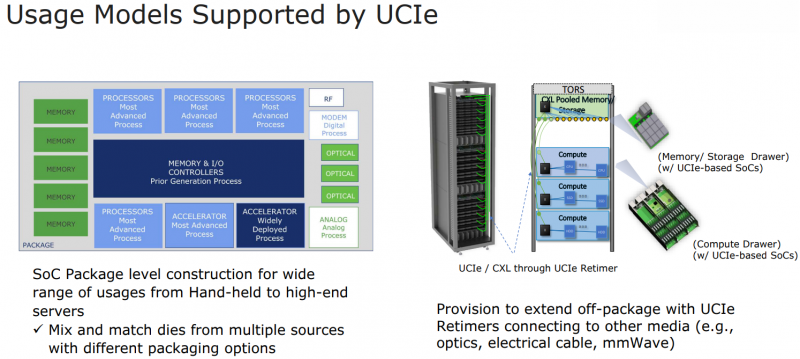

Intel: UCIe объединит разнородные чиплеты внутри одной упаковки и за её пределамиШина PCI Express давно стала стандартом де-факто: она не требует много контактов, её производительность в пересчёте на линию уже достигла ≈4 Гбайт/с (32 ГТ/с) в версии PCIe 5.0, а использование стека CXL сделает PCI Express поистине универсальной. Но для соединения чиплетов или межпроцессорной коммуникации эта шина в текущем её виде подходит не лучшим образом. Но использование проприетарных технологий существенно ограничивает потенциал чиплетных решений, и для преодоления этого ограничения в марте этого года 10-ю крупными компаниями-разработчиками, включая AMD, Qualcomm, TSMC, Arm и Samsung, был основан новый стандарт Universal Chiplet Interconnect Express (UCIe). Уже первая реализация UCIe должна превзойти PCI Express во многих аспектах: если линия PCIe 5.0 представляет собой четыре физических контакта с пропускной способностью 32 ГТ/с, то UCIe позволит передавать по единственному контакту до 12 Гбит/с, а затем планка будет повышена до 16 Гбит/с. При этом энергопотребление у UCIe ниже, а эффективность — выше. На равном с PCIe расстоянии новый стандарт может быть вчетверо производительнее при том же количестве проводников. В перспективе эта цифра может быть увеличена до 10–20 раз, то есть, узким местом между чиплетами UCIe явно не станет. Более того, новый интерконнект не только изначально совместим с CXL, но и гораздо лучше приспособлен к задачам дезагрегации. Иными словами, быстрая связь напрямую между чиплетами возможна не только в одной упаковке или внутри узла, но и за его пределами. Весьма заинтересована в новом стандарте Intel, которая планирует использовать UCIe таким образом, что в процессорах нового поколения ядра x86 смогут соседствовать с Arm или RISC-V. При этом планируется обеспечить совместимость UCIe с технологиями упаковки Intel EMIB и TSMC CoWoS, заодно добавив поддержку других шин, в том числе Arm AMBA, а также возможность легкой конвертации в проприетарные протоколы других разработчиков. В настоящее время Intel уже есть несколько примеров использования UCIe. Так, в одном из вариантов с помощью новой шины к процессорным ядрам подключаются ускорители и блок управления, а упаковка EMIB используется для подключения чипа к дезагрегированной памяти DDR5 и линиям PCI Express.

10.05.2022 [22:46], Игорь Осколков

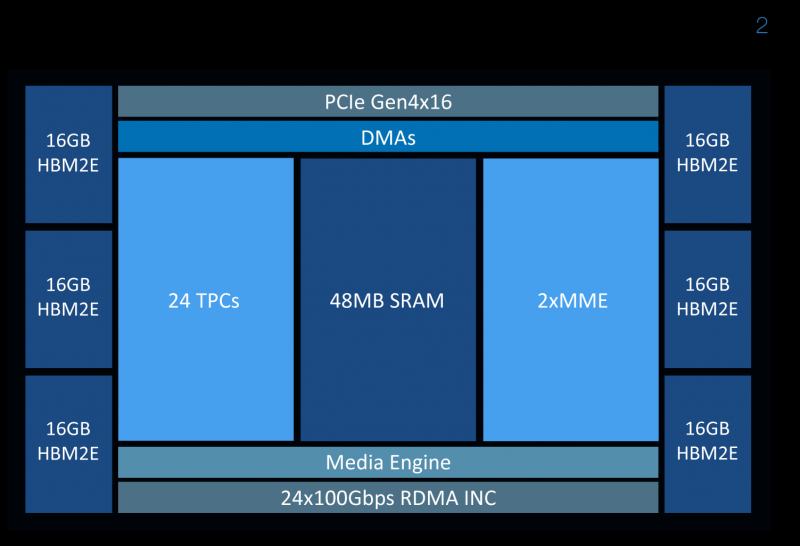

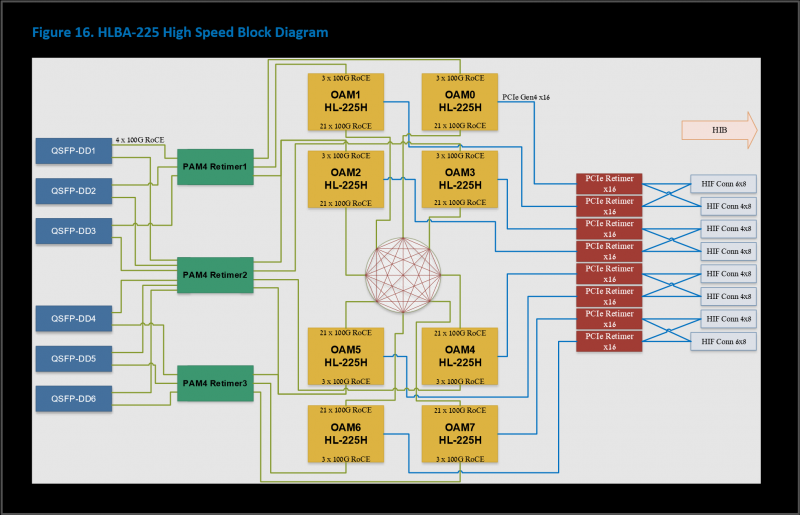

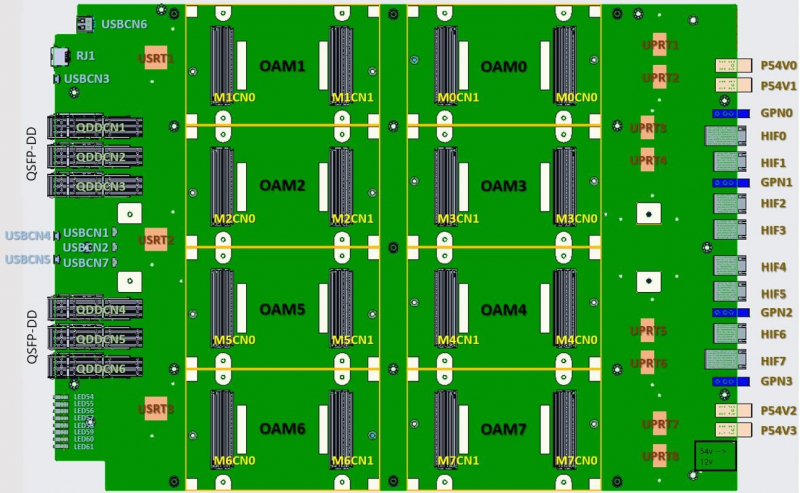

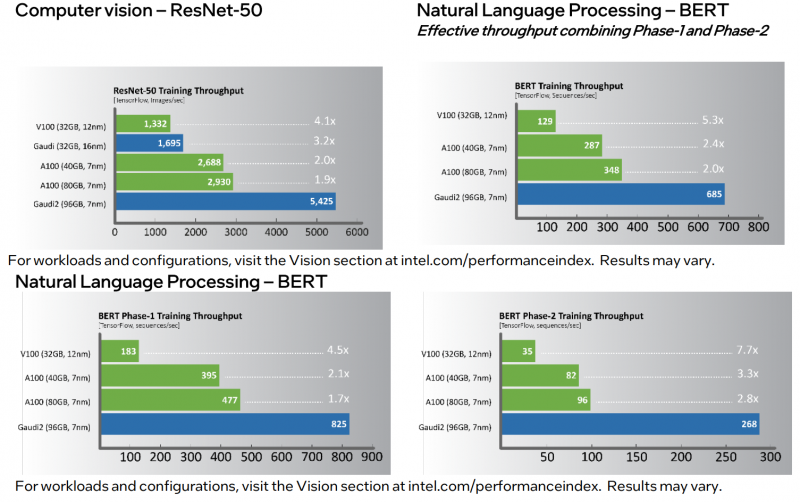

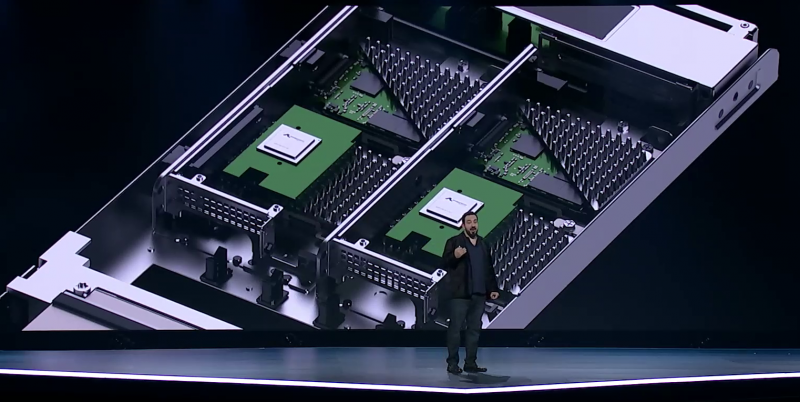

Intel анонсировала ИИ-ускорители Habana Gaudi2 и GrecoНа мероприятии Intel Vision было анонсировано второе поколение ИИ-ускорителей Habana: Gaudi2 для задач глубокого обучения и Greco для инференс-систем. Оба чипа теперь производятся с использованием 7-нм, а не 16-нм техпроцесса, но это далеко не единственное улучшение. Gaudi2 выпускается в форм-факторе OAM и имеет TDP 600 Вт. Это почти вдвое больше 350 Вт, которые были у Gaudi, но второе поколение чипов значительно отличается от первого. Так, объём набортной памяти увеличился втрое, т.е. до 96 Гбайт, и теперь это HBM2e, так что в итоге и пропускная способность выросла с 1 до 2,45 Тбайт/с. Объём SRAM вырос вдвое, до 48 Мбайт. Дополняют память DMA-движки, способные преобразовывать данные в нужную форму на лету. В Gaudi2 имеется два основных типа вычислительных блоков: Matrix Multiplication Engine (MME) и Tensor Processor Core (TPC). MME, как видно из названия, предназначен для ускорения перемножения матриц. TPC же являются программируемыми VLIW-блоками для работы с SIMD-операциями. TPC поддерживают все популярные форматы данных: FP32, BF16, FP16, FP8, а также INT32, INT16 и INT8. Есть и аппаратные декодеры HEVC, H.264, VP9 и JPEG. Особенностью Gaudi2 является возможность параллельной работы MME и TPC. Это, по словам создателей, значительно ускоряет процесс обучения моделей. Фирменное ПО SynapseAI поддерживает интеграцию с TensorFlow и PyTorch, а также предлагает инструменты для переноса и оптимизации готовых моделей и разработки новых, SDK для TPC, утилиты для мониторинга и оркестрации и т.д. Впрочем, до богатства программной экосистемы как у той же NVIDIA пока далеко. Интерфейсная часть новинок включает PCIe 4.0 x16 и сразу 24 (ранее было только 10) 100GbE-каналов с RDMA ROcE v2, которые используются для связи ускорителей между собой как в пределах одного узла (по 3 канала каждый-с-каждым), так и между узлами. Intel предлагает плату HLBA-225 (OCP UBB) с восемью Gaudi2 на борту и готовую ИИ-платформу, всё так же на базе серверов Supermicro X12, но уже с новыми платами, и СХД DDN AI400X2. Наконец, самое интересное — сравнение производительности. В ряде популярных нагрузок новинка оказывается быстрее NVIDIA A100 (80 Гбайт) в 1,7–2,8 раз. На первый взгляд результат впечатляющий. Однако A100 далеко не новы. Более того, в III квартале этого года ожидается выход ускорителей H100, которые, по словам NVIDIA, будут в среднем от трёх до шести раз быстрее A100, а благодаря новым функциям прирост в скорости обучения может быть и девятикратным. Ну и в целом H100 являются более универсальными решениями. Gaudi2 уже доступны клиентам Habana, а несколько тысяч ускорителей используются самой Intel для дальнейшей оптимизации ПО и разработки чипов Gaudi3. Greco будут доступны во втором полугодии, а их массовое производство намечено на I квартал 2023 года, так что информации о них пока немного. Например, сообщается, что ускорители стали намного менее прожорливыми по сравнению с Goya и снизили TDP с 200 до 75 Вт. Это позволило упаковать их в стандартную HHHL-карту расширения с интерфейсом PCIe 4.0 x8. Объём набортной памяти всё так же равен 16 Гбайт, но переход от DDR4 к LPDDR5 позволил впятеро повысить пропускную способность — с 40 до 204 Гбайт/с. Зато у самого чипа теперь 128 Мбайт SRAM, а не 40 как у Goya. Он поддерживает форматы BF16, FP16, (U)INT8 и (U)INT4. На борту имеются кодеки HEVC, H.264, JPEG и P-JPEG. Для работы с Greco предлагается тот же стек SynapseAI. Сравнения производительности новинки с другими инференс-решениями компания не предоставила.  Впрочем, оба решения Habana выглядят несколько запоздалыми. В отставании на ИИ-фронте, вероятно, отчасти «виновата» неудачная ставка на решения Nervana — на смену так и не вышедшим ускорителям NNP-T для обучения пришли как раз решения Habana, да и новых инференс-чипов NNP-I ждать не стоит. Тем не менее, судьба Habana даже внутри Intel не выглядит безоблачной, поскольку её решениям придётся конкурировать с серверными ускорителями Xe, а в случае инференс-систем даже с Xeon.

02.05.2022 [01:08], Владимир Мироненко

AWS представила инстансы I4i с Intel Xeon Ice Lake-SP и NVMe-накопителями Nitro SSD собственной разработкиAWS представила инстансы I4i со сверхбыстрым хранилищем. Новинки используют Intel Xeon Ice Lake-SP и NVMe-накопители Nitro SSD, разработанные самой Amazon. I4i обеспечивают снижение задержки операций ввода-вывода до 60 % (разброс тоже ниже на 75 %) по сравнению с инстансами I3, а также до 30 % лучшее соотношение цены и производительности. Благодаря использованию сразу нескольких компонентов Nitro, все физические ресурсы узлов доступны инстансам практически полностью. I4i «предназначены для минимизации задержки и максимизации количества транзакций в секунду (TPS) для рабочих нагрузок, которым требуется очень быстрый доступ к наборам данных среднего размера в локальном хранилище. Сюда входят транзакционные базы данных, такие как MySQL, Oracle DB и Microsoft SQL Server, а также базы данных NoSQL: MongoDB, Couchbase, Aerospike, Redis и т.д.». Они также подходят для рабочих нагрузок, требующих высокую производительность вычислений в пересчёте на Тбайт хранилища, таких как аналитика данных и поисковые системы.

Узлы с Nitro SSD (Изображение: AWS) У всех новинок частота всех ядер в турборежиме составляет 3,5 ГГц; есть поддержка AVX-512 и Intel Total Memory Encryption. Для особо ресурсоёмких задач предлагается инстанс I4i.32xlarge: 128 vCPU, 1 Тбайт RAM (с NUMA), сетевое подключение 75 Гбит/с, 40-Гбит/с доступ к EBS-томам и восемь локальных Nitro SSD суммарной ёмкостью 30 Тбайт. Nitro SSD имеют продвинутую прошивку, отвечающую за реализацию многих функций, включая телеметрию и диагностику на лету, а также управление хранилищем на уровне инстанса для повышения надёжности и обеспечения стабильного уровня производительности. Инстансы I4i уже доступны в регионах AWS US East (Северная Виргиния), US East (Огайо), US West (Орегон) и Европа (Ирландия) по запросу и в качестве спотовых и зарезервированных. Доступны планы Savings, а также выделенные инстансы и выделенные хосты. Клиентам рекомендуется использовать последние AMI, включающие текущие драйверы ENA и поддержку NVMe 1.4.

29.04.2022 [21:35], Руслан Авдеев

Новые дата-центры Meta✴ для метавселенной будут построены из «зелёного» бетона, созданного с помощью ИИКомпания Meta✴ приступила к расширению кампуса дата-центров DeKalb в штате Иллинойс (США), которые, как предполагается, будут применяться для дальнейшего развития метавселенной. Для того, чтобы разработать материал для новых построек, Meta✴ прибегла к помощи искусственного интеллекта — специально подобранные «зелёные» компоненты позволят частично заменить традиционный бетон. Цемент является основой множества современных строительных материалов, применяемых в промышленных масштабах — по имеющейся статистике на его производство приходится порядка 8 % всех углеродных выбросов в мире. Для того, чтобы создать более приемлемую для экологии альтернативу, Meta✴ объединила усилия с Университетом Иллинойса в Урбане-Шампейне (UIUC), Массачусетским технологическим институтом (MIT) и IBM.

Источник изображения: tech.fb.com При участии системы искусственного интеллекта была обработана база данных со сведениями о характеристиках и компонентах бетонов. В результате проведённой работы была подобрана смесь летучей золы и шлака, способная частично заменить классический цемент. Полученные данные были переданы поставщику бетона — компании Ozinga, которая оптимизировала смесь исходя из своего опыта и доступности материалов, сохранив при этом необходимую прочность. Новый «зелёный» бетон, по оценкам Meta✴, обеспечивает на 40 % меньший углеродный выброс при создании. Помимо двух уже строящихся зданий для кампуса будут построены ещё три с использованием новых технологий. По имеющимся сведениям, новую смесь уже применили при строительстве второстепенных объектов. Общая площадь зданий ЦОД составит более 222 тыс. м2.

Источник изображения: tech.fb.com Как и многие штаты, Иллинойс предложил в 2019 году налоговые льготы на ЦОД-оборудование для привлечения операторов. Meta✴ так и не воспользовалась данными преимуществами, но от послаблений при расчётах налога на собственность не отказалась. После введения объектов в эксплуатацию новые ЦОД не только будут способствовать расширению метавселенной, но и обеспечат работой более 200 человек. На момент первого анонса проекта Meta✴ обещала, что кампус будет использовать 100 % возобновляемой энергии, а строения получат золотой сертификат Leadership in Energy and Environmental Design (LEED) за экологическую безопасность конструкции. Общий объёмы инвестиций в кампус в Иллинойсе составят более $1 млрд. Ранее сообщалась, что Meta✴ активно наращивает инвестиции в строительство ЦОД и сетевую инфраструктуру по всему миру.

28.04.2022 [22:54], Алексей Степин

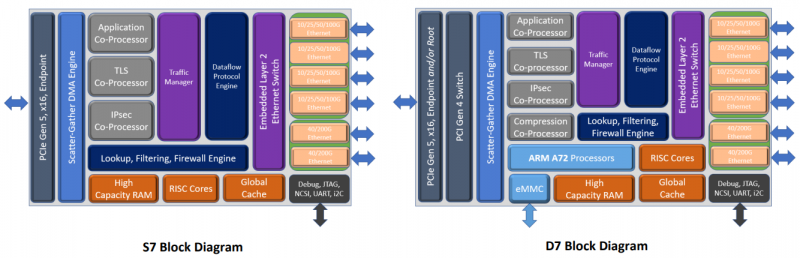

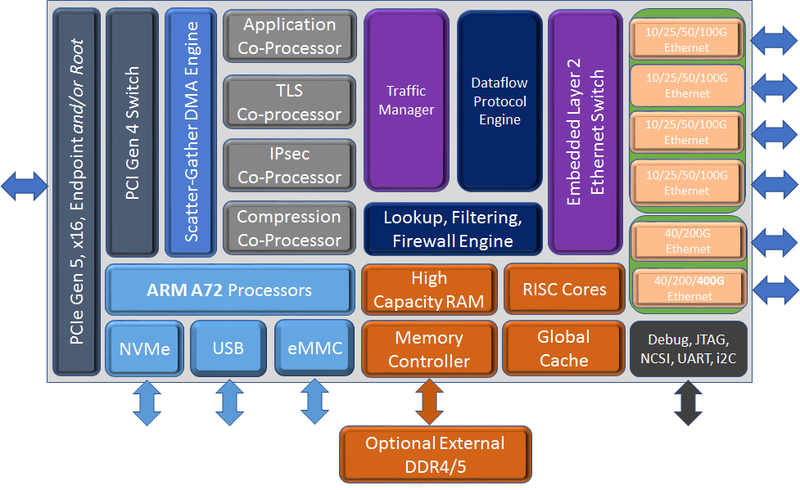

Chelsio представила седьмое поколение сетевых чипов Terminator: 400GbE и PCIe 5.0 x16Компания Chelsio Communications анонсировала седьмое поколение своих сетевых процессоров Terminator с поддержкой 400GbE. От предшественников T7 отличает более развитая вычислительная часть общего назначения, включающая в себя до 8 ядер Arm Cortex-A72, так что их уже можно назвать DPU. Всего представлено пять вариантов 5 чипов (T7, N7, D7, S74 и S72), которые различаются между собой набором движков и ускорителей. Референсная платформа T7 будет доступна в мае, первых же адаптеров на базе новых DPU следует ожидать в III квартале 2022 года. Для задач сжатия, дедупликации или криптографии есть отдельные сопроцессоры. Никуда не делся и привычный для серии Unified Wire встроенный L2-коммутатор. Для подключения к хосту T7 теперь использует шину PCIe 5.0 x16, причём он же содержит и root-комплекс. Более того, имеется и набортный коммутатор+мост PCIe 4.0, и NVMe-интерфейс, и даже поддержка эмуляции NVMe. Всё это, к примеру, позволяет легко и быстро создать NVMe-oF хранилище или мост NVMe-NVMe для компрессии и шифрования данных на лету. Новинка предлагает ускорение работы RoCEv2 и iWARP, FCoE и NVMe/TCP, iSCSI и iSER, а также RAID5/6. Сетевая часть поддерживает разгрузку Open vSwitch и Virt-IO.

Блок-схема старшего варианта T7 (Изображения: Chelsio Communcations) Впрочем, поддержки P4 тут нет — Chelsio продолжает использовать собственные движки для обработки трафика. Но наработки, сделанные для серий T5 и T6, будет проще перенести на новое поколение чипов. Кроме того, появилась и практически обязательная нынче «глубокая» телеметрия всего проходящего через DPU трафика для повышения управляемости и его защиты. Если и этого окажется мало, то к T7 (и D7) можно напрямую подключить FPGA, а набортную память расширить банками DDR4/5. В пресс-релизе также отмечается, что T7 сможет стать достойной заменой InfiniBand в HРC-системах. Вариант D7 наиболее близок к T7, но предлагает только 200GbE-подключение, лишён некоторых функций и второстепенных интерфейсов, да и в целом рассчитан на создание СХД. N7, напротив, лишён Arm-ядер и всех функций для работы с хранилищами, нет у него и PCIe-коммутатора и моста. Предлагает он только 200GbE-интерфейсы. Наконец, чипы серии S7 лишены целого ряда второстепенных функций и предоставляют только 100/200GbE-подключение. Они относятся скорее к SmartNIC, поскольку начисто лишены Arm-ядер и некоторых функций. Но зато они и недороги. Кроме того, в седьмом поколении Termintator появилась возможность обойтись без набортной DRAM с сохранением всей функциональности. Так что использование памяти хоста позволит дополнительно снизить стоимость конечных решений, которые будут создавать OEM-производители. Сами чипы производятся с использованием техпроцесса TSMC 12-нм FFC, так что даже у старшей версии чипов типовое энергопотребление не превышает 22 Вт.

26.04.2022 [18:53], Руслан Авдеев

Китай ускоряет внедрение IPv6 на фоне стремительного прогресса 5G-сетей и облаков, но не оставляет надежды распространить по миру свои собственные стандарты связиЦентральная администрация киберпространства КНР поделилась планами ускоренного внедрения протокола IPv6 на фоне повсеместного распространения облачных сервисов, устройств интернета вещей и 5G-сетей. Власти страны анонсировали целый ряд амбициозных целей на 2022 год. Известно, что КНР планирует полностью перейти на IPv6 к 2030 году. Так, до конца года планируется получить 700 млн активных пользователей IPv6 (при населении более 1,4 млрд человек) и 180 млн IPv6-подключений устройств Интернета вещей, причём к этому моменту 13 % трафика стационарных сетей связи и 45 % мобильного трафика тоже должно быть переведено на новый протокол. 85 % государственных, а также ключевых коммерческих онлайн-сервисов тоже должны будут освоить IPv6. Наконец, этот протокол должен быть активирован по умолчанию во всех новых домашних роутерах. Правительство также намерено поощрять перевод на IPv6 облачных платформ, стриминговых сервисов и целый ряд ключевых отраслей вроде финансового сектора и сельского хозяйства. Отчасти это вынужденная мера, поскольку телекоммуникационный сектор страны остро нуждается в новых инструментах в связи с постоянным и довольно стремительным ростом, которому способствуют общие план по цифровизации Китая. Только в I квартале 2022 года, по данным Министерства промышленности и информатизации КНР, доходы облачных сервисов выросли на 138,1 % в сравнении с аналогичным периодом прошлого года, а секторы Big Data и IoT — на 59,1 % и 23,9 % соответственно. Очевидного прогресса страна достигла и в строительстве базовых станций 5G. К концу марта их число в КНР достигло 1,56 млн единиц, из них 134 тыс. были построены в первые три месяца года.

Источник изображения: Huawei В этих условиях распространение IPv6 имеет критически важное значение. Новый план китайских властей предусматривает «активное участие нации» в формировании не только местных, но и международных стандартов для интернета будущего. В Китае намерены продвигать новый стандарт New IP вместо привычного стека TCP/IP. Huawei предложила его Международному союзу электросвязи (ITU), хотя разработкой соответствующих стандартов занимаются преимущественно IETF и IEEE. Впрочем, инициатива прохладно встречена этими международными институтами, поскольку новый протокол не гарантируерует обратной совместимости и фактически дублирует работы, уже проводимые IEEE и IETF. Cisco утверждает, что существующие стандарты вполне соответствуют китайским запросам. Кроме того, использование имеющихся решений позволит избежать прецедента продавливания Китаем стандарта при посредничестве ITU, который в норме не имеет к этому процессу никакого отношения.

16.04.2022 [23:54], Алексей Степин

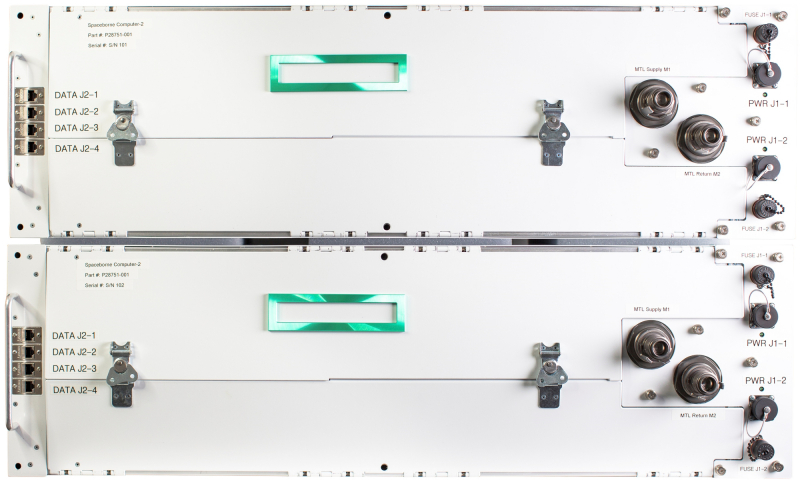

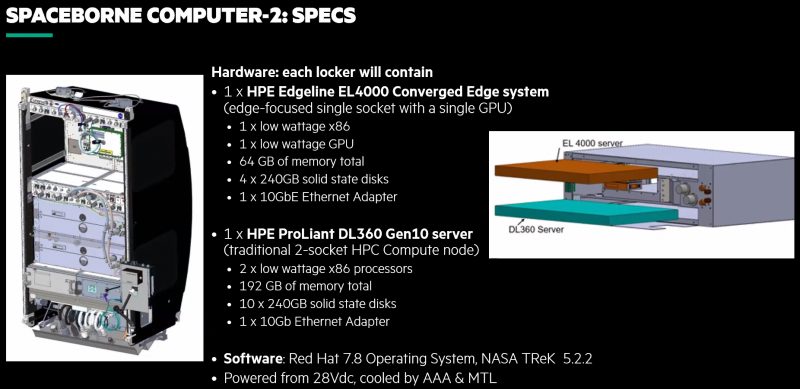

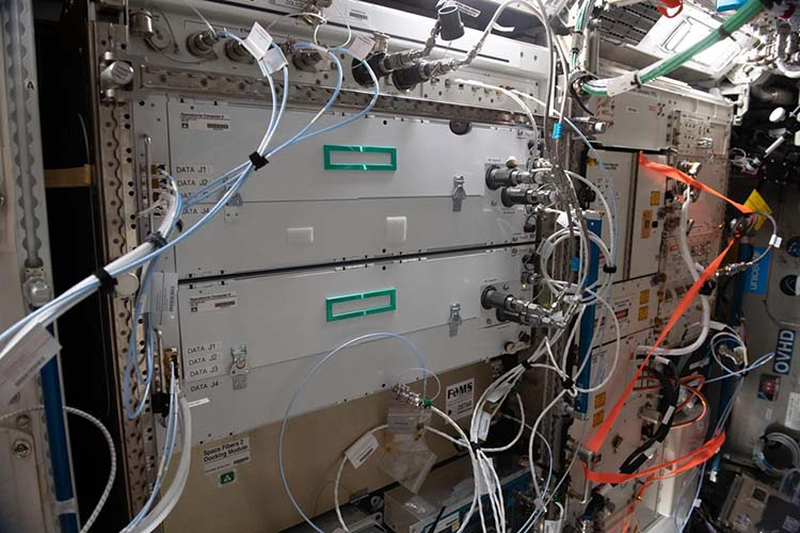

Космический суперкомпьютер HPE Spaceborne-2 успешно завершил 24 эксперимента на МКСПериферийные вычисления подразумевают работу достаточно мощных серверов в нестандартных условиях. Казалось бы, 400 километров — не такое уж большое расстояние. Но если это высота орбиты космической станции, то более «периферийное» место найти будет сложно. А ведь если человечество планирует и далее осваивать космос, оно неизбежно столкнётся и с проблемами, свойственными космическим ЦОД. Первый космический суперкомпьютер, как его окрестили создатели из HPE, появился в 2017 году и успешно проработал на орбите 615 дней. Инженеры учли выявленные особенности работы такой системы на орбите и в прошлом году отправили на МКС Spaceborne-2 (SBC-2), который стал вдвое производительнее предшественника. Хотя SBC-2 по земным меркам и невелик и состоит всего из двух вычислительных узлов (HPE Edgeline EL4000 и HPE ProLiant DL360 Gen10, совокупно чуть более 2 Тфлопс), это самая мощная компьютерная система, когда-либо работавшая в космосе. К тому же, это единственная космическая вычислительная система, оснащённая ИИ-ускорителем NVIDIA T4.

HPE Spaceborne-2 (Изображения: HPE) Теперь же HPE сообщает, что эта машина меньше чем за год помогла в проведении 24 важных научных экспериментов. Всё благодаря достаточно высокой производительности. Одним из первых стал стал анализ генов — обработка данных непосредственно на орбите позволила снизить объём передаваемой информации с 1,8 Гбайт до 92 Кбайт. Но это далеко не единственный результат. Так, ИИ-ускорители были задействованы для визуального анализа микроскопических повреждений скафандров, используемых для выхода в открытый космос. Они же помогли в обработке данных наблюдения за крупными погодными изменениями и природными катаклизмами. Также был проведён анализ поведения металлических частиц при 3D-печати в невесомости, проверена возможность работы 5G-сетей космических условиях, ускорены расчёты требуемых объёмов топлива для кораблей и т.д. Ряд проблем ещё предстоит решить: в частности, в условиях повышенной космической радиации существенно быстрее выходят из строя SSD, что естественно для технологии, основанной на «ловушках заряда». По всей видимости, для дальнего космоса целесообразнее будет использовать накопители на базе иной энергонезависимой памяти. Впрочем, при освоении Луны или Марса полагаться на земные ЦОД тоже будет трудно, а значит, достаточно мощные вычислительные ресурсы придётся везти с собой.

08.04.2022 [19:22], Руслан Авдеев

Японский ЦОД, охлаждаемый талой снежной водой, запустил ферму для разведения угрейНеобычное решение реализовали на японском острове Хоккайдо. Избыточное тепло дата-центра, использующего для охлаждения талую снежную воду, теперь будут использовать на подшефной ферме, разводящей угрей. Идея использования лишнего тепла для выращивания продуктов питания не нова. Например, в Норвегии компания Green Mountain использует нагретую оборудованием ЦОД воду для разведения лобстеров и форели. Пока ЦОД White Data Center (WDC) в городе Бибае импортировал мальков угрей и местный персонал будет выращивать их в расположенных на территории ёмкостях. Сопутствующим продуктом станут и грибы — на выращивание тех и других уходит относительно немного времени.

Источник изображения: k10legs/pixabay.com В ноябре ЦОД организовал саму ферму при поддержке городских властей. В ёмкостях круглый год будет поддерживаться оптимальная температура, в них планируется поселить до 300 000 угрей, которые будут расти в течение семи месяцев, пока не достигнут «коммерческого» веса в 250 г. Такая рыба станет продаваться по всей стране для организации школьного питания. Это будут первые угри, выращенные на Хоккайдо. Местная серверная инфраструктура охлаждается талой водой из снега, собираемого зимой и используемого круглый год. После того, как оборудование ЦОД охлаждается, нагретая вода поступает в ёмкости рыбной фермы. Ранее оператором ЦОД выступал город Бибай — зимой здесь выпадает много снега. Охлаждение талой водой вычислительного оборудования впервые предложили ещё в 2008 году, а в 2010 реализовали пилотный проект. С 2014 по 2019 годы Бибай эксплуатировал ЦОД White Data Center, доказывая работоспособность предложенной концепции. Конструкция позволяла экономить до 20 % электроэнергии и с апреля 2021 года ЦОД является коммерческим проектом, выкупленным одним из партнёров — компанией Kyodo News Digital. Ожидается, что проект будет обеспечивать нулевой углеродный выброс.

Источник изображения: Datacenter Dynamics Пока обслуживается 20 стоек с серверами, в текущем году планируется открытие второго ЦОД на 200 стоек. По словам руководства WDC для следующего ЦОД уже сейчас ведутся эксперименты по выращиванию овощей, рыбы и других морепродуктов с помощью избыточного тепла. Идея использовать для охлаждения талую воду пришлась по душе и другим бизнесам — недалеко аналогичный проект реализовала Kyocera, схожие технологии используются даже на юге Японии, где климат мягче.

07.04.2022 [17:30], Руслан Авдеев

Интернет по трубам: Южный Йоркшир протестирует прокладку оптоволокна в водопроводахНекоторые части Южного Йоркшира (Великобритания) могут получить широкополосный оптоволоконный доступ в интернет благодаря экспериментальной технологии прокладки кабелей в водопроводных трубах. Проект продолжительностью два года позволит оценить жизнеспособность технологии с возможным подключением в дальнейшем большего числа домохозяйств. Реализация будет проводиться при участии местной водопроводной компании Yorkshire Water совместно с инженерами из Arcadis и при содействии Университета Стратклайда. По данным Министерства культуры, средств массовой информации и спорта потенциально можно будет обеспечить быстрой связью до 8500 домов и предприятий. В ходе санкционированных правительством технологических испытаний будет проложено 17 км кабеля по водопроводным трубам.

Источник изображения: Tama66/pixabay.com Проект является частью £4-млн плана по обеспечению качественной телефонной и интернет-связью жителей труднодоступных мест — прокладкой сетей должны заняться сами телекоммуникационные операторы. Предполагается, что использование оптоволокна в водопроводных трубах в сочетании со специальными сенсорами также поможет местным коммунальным службам быстрее обнаруживать места утечек и прорывов. Однако для начала придётся провести оценку всех нюансов внедрения технологии, включая как экономическую целесообразность подобных сервисов, так и правовые аспекты, а также безопасность эксплуатации. Стадия исследований уже начата и будет продолжаться до 31 мая следующего года, после чего начнутся реальные испытания в течение 12 месяцев. Параллельно будет разрабатываться план по более широкому распространению технологии, а в случае успеха тестирования аналогичные решения начнут реализовать и в других частях Великобритании. В частности, это позволит придать импульс плану Project Gigabit, который предусматривает высокоскоростное подключение к Сети миллионов людей и компаний в сельской местности, пока не имеющих качественной связи. Особенно это касается мест, в которые провайдеры считают нецелесообразным прокладывать сети традиционными способами, буквально «раскапывая дороги».

05.04.2022 [18:25], Игорь Осколков

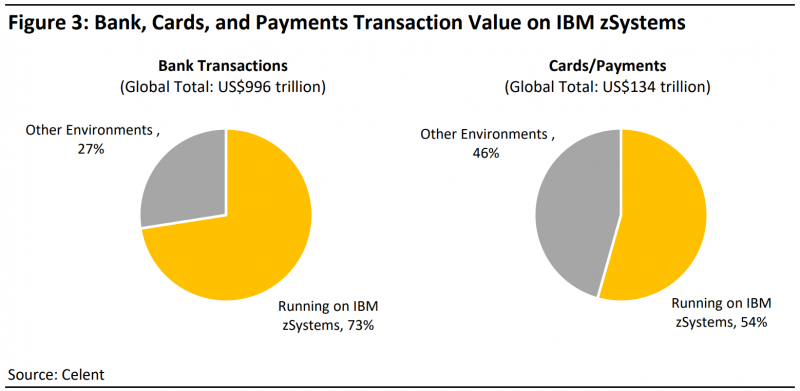

IBM анонсировала мейнфреймы z16: ИИ, постквантовое шифрование и гибридные облакаIBM, как и обещала ранее, анонсировала новое семейство мейнфреймов z16, которые придут на смены представленным осенью 2019 года системам z15. z16 станут доступны в конце мая текущего года, и IBM надеется, что новая серия повторит успех z15, которая активно закупалась банками и другими финансовыми учреждениями. Основой z16 станут процессоры Telum (8 ядер, 5+ ГГц, 256 Мбайт L2-кеш) с возможностью объединения в одной системе до 32 CPU, которые во многом определяют возможности мейнфреймов. Telum, по словам IBM, в среднем на 40 % производительнее предшественников (в пересчёте на сокет), но ключевым изменением стало появление в составе CPU интегрированного, независимо работающего ИИ-ускорителя. Благодаря наличию такого движка появилась возможность интеллектуального детектирования на лету фрода и прочих подозрительных финансовых операций. Он же позволит ускорить работу некоторых задач в области страхования, кредитования, здравоохранения, трейдинга, ритейла, федеративного обучения и т.д. В отчёте Celent, подготовленном по запросу IBM, отмечается, что 45 из 50 крупнейших банков мира используют мейнфреймы серии z, которые обслуживают 73 % банковских транзакций (по сумме, а не по количеству) и 54 % платежей, в том числе по картам. По словам разработчиков, новинки могут ежесуточно обрабатывать до 300 млрд инференс-запросов с миллисекундной задержкой. То есть на таких задачах у них до 20 раз лучше время отклика и до 19 раз выше пропускная способность по сравнению с x86-серверами, отмечает глава Moor Insights & Strategy. Достигается это в том числе благодаря тому, что данные не приходится постоянно перемещать между CPU и каким-либо внешним ускорителем, а ИИ-движок в Telum работает независимо. Ещё одним важным нововведением стала поддержка алгоритмов постквантовой криптографии, в данном случае это криптография на решётках. Для этих задач IBM выпустила аппаратный модуль Crypto Express 8S (CEX8S), который предлагает и классические алгоритмы. Компания отмечает важность повышения защиты данных, поскольку даже если их невозможно расшифровать в случае утечки прямо сейчас, это вовсе не значит, что они потеряют ценность через пять-десять лет. Наконец, IBM пообещала улучшить интеграцию с гибридными облаками. Соответствующие работы уже давно ведутся для z/OS и Red Hat Enterprise Linux, а также платформы OpenShift. Ранее компания представила IBM Z and Cloud Modernization Stack, который включает z/OS Connect, z/OS Cloud Broker, Wazi aaS, Wazi Code, Wazi Analyze и другие инструменты и сервисы для интеграции мейнфреймов в облачную инфраструктуру и разработки новых приложений. |

|