Лента новостей

|

15.03.2024 [16:42], Андрей Крупин

Sitronics Group представила новый релиз платформы виртуализацииКомпания Sitronics Group сообщила о выпуске обновлённой платформы виртуализации собственной разработки. Созданный Sitronics Group программный комплекс построен на базе гипервизора KVM, включает единую среду доступа, а также инструменты для создания и управления виртуальными машинами, хранилищем и сетями. Решение поддерживает работу с различными гостевыми операционными системами, оснащено средствами мониторинга производительности и состояния виртуальных машин, а также их компонентов. Платформа зарегистрирована в реестре российского программного обеспечения и полностью подходит для задач импортозамещения.

Источник изображения: sitronics.com В обновлённой версии продукта переработаны ролевая модель доступа и управления системой, пользовательский интерфейс, добавлена возможность создания и управления виртуальными сетями в режиме распределённого виртуального коммутатора. Благодаря последней функции IT-администраторы могут получать, распределять, добавлять или выводить входящие порты хостов, создавать и распределять виртуальную сеть между виртуальными машинами, сохранять и управлять конфигурациями сетей, подсетей, групп портов, адресов и маршрутизаторов, назначать и настраивать виртуальные коммутаторы в рамках отдельных вычислительных кластеров, чтобы создать отказоустойчивое сетевое соединение для виртуальных машин и хранилищ. Ещё одним нововведением стала возможность гибкого управления снимками системы, включая их объединение, копирование и удаление. Данный инструментарий позволяет управлять состоянием виртуальных машин в определённой временной точке не только с помощью встроенных средств резервного копирования.

15.03.2024 [16:22], Руслан Авдеев

Oracle Cloud запустит облачный регион в МароккоКомпания Oracle развернёт облачный регион в Марокко. По данным Datacenter Dynamics, проект будет реализован при сотрудничестве с оператором ЦОД N+One, облачная инфраструктура гиперскейлера разместится в одном из дата-центров компании. Всего Oracle намерена увеличить свой парк ЦОД на 100 шт. Oracle открыла свой первый облачный регион в Африке (Йоханнесбург, Южная Африка) в 2022 году, а в феврале 2024 анонсировала планы создания региона в Найроби (Кении). Проект в Марокко пока не отображается в списке ожидаемых локаций на сайте самой компании. Тем не менее, он уже утверждён. Сотрудничество с N+One даёт Oracle определённый «иммунитет» — размещение облака на мощностях компании обеспечит IT-гиганту соблюдение марокканских требований к суверенитету данных. Как заявляют в N+One, соглашение позволит обеспечить безопасность информации и достичь соответствия местным правовым нормам, включая т.н. Закон № 05-20, определяющий требования к информационным системам, их защите и уровню обслуживания. В компании добавляют, что сотрудничество с Oracle стало гарантией уверенности в будущем и драйвером роста N+One. Недавно N+One анонсировала планы по расширению двух ЦОД в провинциях Нуасер и Сеттат, ёмкость которых к концу года вырастет на 2 МВт. Всего в Марокко у компании будет уже 8 МВт ёмкостей. В дальнейшем N+One намерена построить три дата-центра в Дакаре (Сенегал), также рассматривается возможность строительства ЦОД в Нигерии. В 2023 году африканская частная инвестиционная компания African Infrastructure Investment Managers (AIIM) выделила N+One $90 млн на расширение кампусов.

15.03.2024 [16:13], Сергей Карасёв

Производителей электроники в РФ обяжут отчитываться о закупках отечественных компонентовМинистерство промышленности и торговли РФ (Минпромторг), по сообщению газеты «Ведомости», подготовило изменения в постановление правительства от 17 июля 2015 года №719, которое устанавливает критерии отнесения продукции к произведенной на территории России. Ведомство предлагает включить требование, в соответствии с которым производители электроники будут обязаны отчитываться о закупках отечественных компонентов. Постановление №719 предусматривает начисление баллов за применение в выпускаемой продукции отечественных комплектующих. От количества таких баллов зависит включение электроники в реестр Минпромторга и получение преференций на госзакупках.

Источник изображения: pixabay.com Однако в России фиксируются случаи, когда производитель указывает страной происхождения товара Россию, а при производстве фактически использует иностранные компоненты. Иными словами, в реестр могут вноситься изделия с отечественными компонентами из небольшой тестовой партии, после чего заказчикам поставляются товары с иностранными компонентами. В соответствии с новой инициативой Минпромторга производители должны будут отчитываться в Государственной информационной системе промышленности (ГИСП) о количестве приобретенных российских комплектующих и объёме произведенной продукции. В случае выявления расхождений, когда объём выпущенного товара значительно превосходит количество закупленных российских компонентов, Минпромторг совместно с Торгово-промышленной палатой (ТПП) будет осуществлять выездную проверку «для верификации производственных мощностей предприятия». Такой механизм, как ожидается, поможет в выявлении недобросовестных производителей электроники.

15.03.2024 [16:12], Руслан Авдеев

Тепло французского дата-центра Data4 направят на выращивание водорослей для захвата углекислого газаФранцузский оператор дата-центров Data4 совместно с Университетом Париж-Сакле (University of Paris-Saclay) работает над созданием прототипа установки, позволяющей использовать «мусорное» тепло ЦОД для генерации возобновляемой энергии. По данным Computer Weekly, получать её будут не напрямую, а с соблюдением «зелёной» повестки — из выращиваемой биомассы. В последнее время операторы нередко используют тепло ЦОД для обогрева бассейнов или теплиц и, например, разведения рыб и отопления домов. Но Data4 с партнёрами ищут альтернативу в формате «циркулярной экономики». Уже подписано соглашение о сотрудничестве, в рамках которого будут проводиться эксперименты с переработкой углекислого газа путём выращивания водорослей. Исследование показало, что захват CO2 в этом случае может быть в 20 раз эффективнее, чем у деревьев. Полученная биомасса будет применяться для источников «циркулярной» энергии, а также производства продуктов для различных отраслей промышленности. Новый проект, по словам организаторов, является ответом на необходимость утилизации тепла дата-центров. Прототип решения успешно функционирует, так что оператор намерен вывести его на индустриальный уровень. Проект, как ожидается, поможет улучшить продовольственную и энергетическую безопасность региона. Однако это потребует системного подхода и сотрудничества всех игроков в регионе Эссон, где действует Data4.

Источник изображения: Zach Dyson/unsplash.com Попытки конвертировать отходы в топливо и полезные продукты предпринимаются регулярно. В декабре 2023 года появилась новость о намерении Microsoft обеспечить питание ЦОД в Сан-Хосе, используя биогаз.

15.03.2024 [11:54], Сергей Карасёв

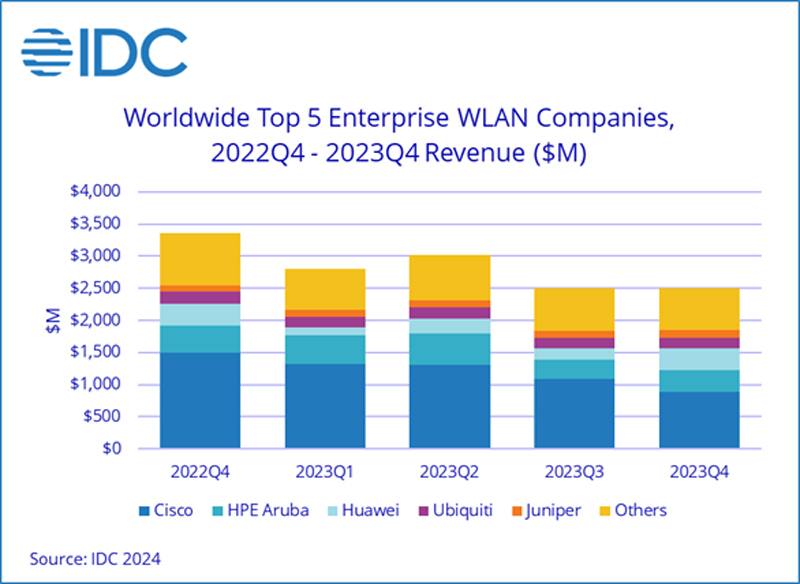

Объём мирового рынка корпоративного WLAN-оборудования приблизился к $11 млрдКомпания International Data Corporation (IDC) опубликовала результаты исследования глобального рынка корпоративного оборудования для беспроводных локальных сетей (WLAN) по итогам 2023 года. Выручка достигла $10,8 млрд, что на 7,6 % больше по сравнению с 2022-м. Отмечается, что в I половине 2023-го продажи корпоративных WLAN-продуктов подскочили на 43,3 % по сравнению с аналогичным периодом 2022 года. Однако во II полугодии выручка снизилась на 16,6 % в годовом исчислении. Такая ситуация объясняется тем, что клиенты, получив оборудование WLAN, приступили к модернизации своих сетей, а количество новых заказов снизилось. Потребительский сегмент WLAN в 2023 году сократился на 12,8 % по сравнению с 2022-м. При этом устройства стандарта Wi-Fi 6 обеспечили приблизительно 64,1 % всей выручки, Wi-Fi 5 — около 26,5 %. Внедрение Wi-Fi 6E в потребительском сегменте находится на начальной стадии.

Источник изображения: IDC В корпоративном секторе продажи точек доступа Dependent Access Point стандарта Wi-Fi 6E между III и IV кварталами 2023 года увеличились в денежном выражении на 11,7 %. Такие решения обеспечили 22,6 % продаж в деньгах и около 10,0 % в штуках. На изделия Wi-Fi 6 пришлось 72,8 % поставок в денежном выражении и 77,5 % в натуральном. Крупнейшими производителями WLAN-решений на корпоративном рынке в 2023 году стали Cisco (42,6 % в денежном выражении), HPE Aruba Networking (14,6 %), Huawei (8,0 %), Ubiquiti (6,1 %), CommScope (4,4 %) и Juniper Networks (4,1 %). С географической точки зрения продажи WLAN-оборудования в США в 2023 году увеличились на 20,6 % по сравнению с предыдущим годом, в Канаде — на 14,5 %. В Азиатско-Тихоокеанском регионе (исключая Японию и Китай) зафиксирован рост на 6,2 %, в Европе, на Ближнем Востоке и в Африке (EMEA) — на 1,6 %, в Латинской Америке — на 25,1 %. В Китае продажи упали на 17,5 % в годовом исчислении.

15.03.2024 [08:35], Сергей Карасёв

TrueConf представила технологию распределённых видеоконференций для снижения нагрузки на аппаратные ресурсы и каналы связиРоссийская компания TrueConf анонсировала технологию «распределённых конференций», которая, как утверждается, на сегодняшний день не имеет аналогов на рынке. Система даёт возможность значительно снизить нагрузку на сетевые каналы и CPU серверов в инфраструктуре организаций, а также увеличить количество активных участников виртуальных встреч. Технология позволяет распределять нагрузку между серверами видеоконференцсвязи (ВКС) заказчиков. Система выполнена на базе автономного транспортного протокола, разработанного специалистами TrueConf. Сумма инвестиций в проект превысила 100 млн руб. Технология станет доступна пользователям TrueConf Enterprise 1.6. Эта платформа подходит для крупных компаний с большим количеством филиалов и сотрудников. Обычно TrueConf Enterprise объединяет несколько географически распределённых автономных ВКС-систем, каждая из которых обеспечивает сотрудников мессенджером, видеоконференцсвязью и инструментами для совместной работы. При этом возможно бесшовное взаимодействие с помощью корпоративной адресной книги. При организации конференции, в которой принимают участие пользователи нескольких автономных систем TrueConf, все абоненты подключаются напрямую к системе организатора. В результате, создаётся большая нагрузка на сетевой канал и сервер, на котором развёрнута ВКС-система инициатора виртуальной встречи. С новой технологией распределённых видеоконференций нагрузка распределяется между всеми задействованными ВКС-серверами. Теперь абоненты автоматически подключаются к тем системам, на которых они авторизованы, а обмен данными происходит только между ВКС-системами. Таким образом, сокращается потребность в ресурсах, а нагрузка на каналы связи между филиалами может быть снижена в 10 раз. Например, при одновременном участии 2500 сотрудников в параллельно идущих конференциях нагрузка на каналы связи в обычном режиме могла бы достигать примерно 2 Гбит/c. Технология распределённых конференций в таком случае позволяет уменьшить показатель до 250 Мбит/с. Число активных участников конференций при этом может составлять 2000 и более.

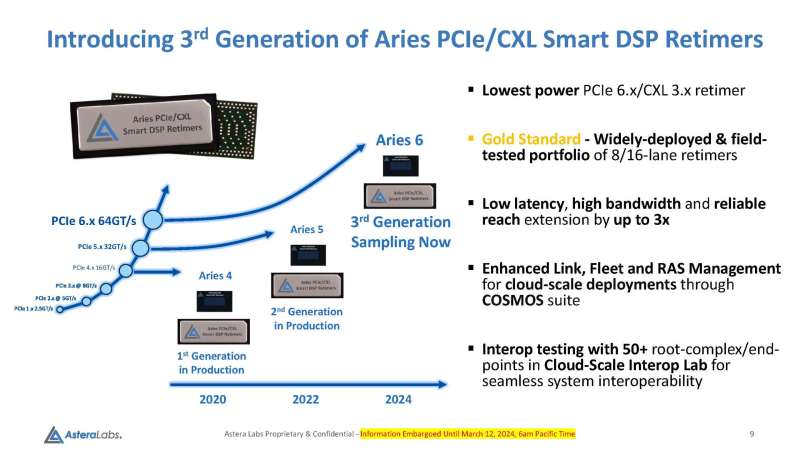

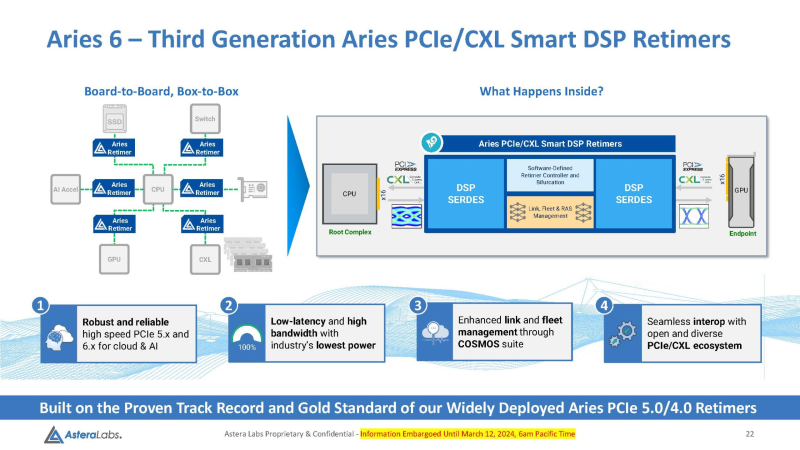

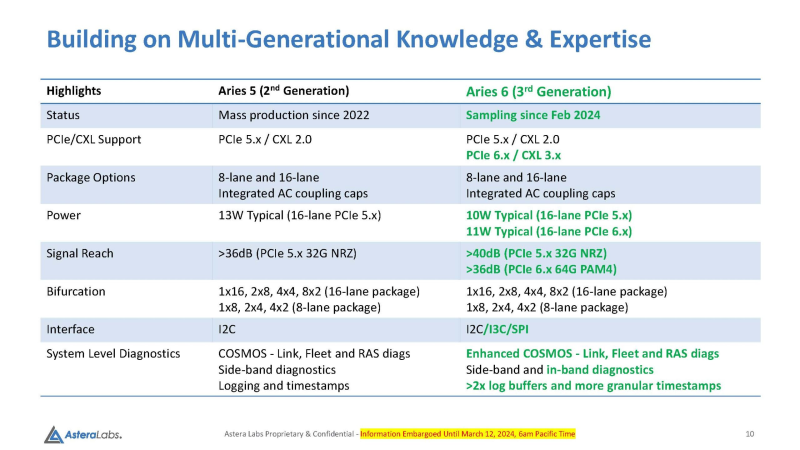

14.03.2024 [23:45], Алексей Степин

Войны ретаймеров: Astera Labs анонсировала чипы Aries 6 для PCIe 6.0Практически сразу после анонса чипов Broadcom Vantage 5 и 6 Astera представила свой вариант ретаймеров для инфраструктуры PCIe следующего поколения — серию чипов Aries 6, передаёт ServeTheHome. Высокий интерес к ретаймерам вызван теми возможностями, что открывает PCI Express 6.0 как в плане скоростей, так и в плане функциональности (CXL). А переход на новое поколение шины необходим для дальнейшего развития набирающего популярность генеративного ИИ. По мере роста скоростей PCI Express обострялась и проблема длины проводников на печатной плате, при которой сигнал достаточно устойчив и вписывается в окно требуемых характеристик. Если при переходе от PCIe 3.0 к 4.0 удалось обойтись сравнительно малой кровью, то для PCIe 5.0 уже потребовались более сложная схемотехника и более продвинутые ретаймеры. PCIe 6.0 же накладывает ещё более жёсткие требования к целостности сигнала. Платформы GPU-кластеров и СХД компактнее не становятся, так что требуемая длина проводников на печатных платах растёт, а вместе с ней растёт и важность ретаймеров, поскольку без них согласовать высокоскоростной сигнал PCIe 6.0 становится невозможно. Таким системам требуется сразу несколько подобных чипов, причём стоимость каждого из них достигает $20, так что суммарная стоимость этих компонентов на уровне целого ЦОД весьма внушительна. Новые чипы Aries 6 относятся к третьему поколению «умных» DSP-ретаймеров. Они представлены в вариантах с 8 и 16 линиями PCIe 6.0 и позволяют в три раза увеличить длину соответствующего соединения на плате, говорит Astera Labs. При этом новинки поддерживают CXL 3.x и предоставляют расширенные средства диагностики и управления COSMOS. Энергопотребление в режиме PCIe 6.0 при этом заявлено меньше, чем у Broadcom Vantage 6 — 11 Вт против 13 Вт у конкурента. Aries 6 уже протестированы на совместимость с полсотней разнообразных PCIe-соединений, включая root-комплексы и конечные устройства. И если Broadcom пока только говорит о ретаймерах для PCIe 6.0, а появление первого «кремния» Vantage 6 запланировано лишь на следующий год, то Astera Labs начала поставки образцов Aries 6 ещё в феврале. Похоже, Broadcom будет нелегко развернуться на этом рынке.

14.03.2024 [22:51], Руслан Авдеев

Microsoft тоже не будет «штрафовать» пользователей за уход из облака AzureКомпания Microsoft вслед за AWS и Google Cloud объявила об отмене «штрафов» за уход из облачного сервиса Azure, передаёт The Register. В Microsoft заявляют, что поддерживают выбор клиентов, каким бы он ни был, так что теперь компания гарантирует бесплатный отказ от использования сервисов Azure с выгрузкой данных из облака Microsoft при переходе к другому провайдеру или их переносе на собственные серверы. Примечательно, что такая лояльность к выбору уходящих клиентов наверняка связана с европейским Законом о данных, который упрощает переход клиентов между конкурентам. Новые правила должны заработать в сентябре 2025 года. Случаи с подобными «штрафами» сейчас пристально изучает и британское Управление по конкуренции и рынкам (CMA). Также есть мнение, что новые правила могут быть связаны не только и не столько с ЕС и Великобританией, сколько с некоторыми требованиями в США, особенно если это касается сотрудничества с военными ведомствами. Первой, кто поспешил продемонстрировать свою готовность идти навстречу клиентам и законам, стала Google — компания предложила возможность «бесплатного» ухода из облака ещё в январе, правда, только для клиентов, отказывающихся от аккаунта в Google Cloud Platform. Аналогичный анонс сделала на прошлой неделе AWS, подчеркнув, что подобных условий не выдвигает. Зато это делает Microsoft. Для того, чтобы уйти из Azure, потребуется отказ от всех подписок, связанных с аккаунтом, после переноса данных. По мнению экспертов, в таких анонсах больше маркетинга для новых клиентов или некоторых госзаказчиков, чем реальной пользы для текущих пользователей, поскольку полностью покидает облако лишь малая доля аудитории. В случаях, когда данные выгружаются для резервирования или с иной целью, плата за выгрузку всё равно берётся. Фактически возможна ситуация, когда желание воспользоваться новым сервисом у другого провайдера приводит либо к переносу существенной части (но не всех) нагрузок к нему или к отказу от перехода вообще.

14.03.2024 [19:02], Сергей Карасёв

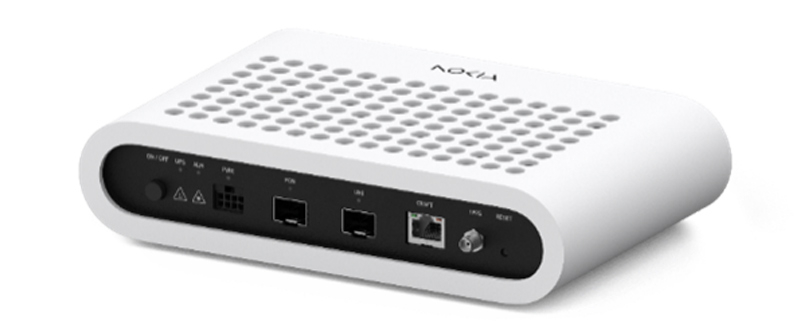

Nokia представила симметричный модем 25G PONКомпания Nokia анонсировала симметричный оптоволоконный модем 25G PON (модель U-010Y-A), предназначенный для создания сетей связи с высокой пропускной способностью. Поддерживается симметричная пропускная способность 25 Гбит/с. Устройство может монтироваться в помещениях или на открытых пространствах при условии использования специального защитного кожуха. По заявлениям Nokia, новое решение 25G PON позволяет операторам модернизировать существующую сеть GPON или XGS PON для обеспечения скорости 10 Гбит/с и более. Благодаря высокой пропускной способности возможно использование ресурсоёмких приложений нового поколения, связанных с ИИ, машинным обучением и пр. Устройство выполнено в прочном компактном корпусе.

Источник изображения: Nokia Реализована функция синхронизации частоты и времени. Модем может использоваться для подключения сотовых станций для передачи мобильного трафика по сети PON в режиме plug-and-play. Модем дополняет расширяющийся ассортимент решений Nokia 25G PON, который включает в себя OLT Lightspan FX/DF/MF, а также первый в отрасли герметичный оптоволоконный узел доступа 25G PON, предназначенный для операторов. Для новинки заявлена возможность сосуществования с GPON, XGS-PON и 50G PON. Отмечается, что на сегодняшний день Nokia поставила более 1 млн портов 25G PON. Технологию внедряют такие компании, как Google Fiber, EPB, Vodafone Qatar и OGI. Более 30 операторов по всему миру тестируют 25G PON для различных сценариев использования.

14.03.2024 [18:50], Сергей Карасёв

Netgear представила точку доступа WBE750 стандарта Wi-Fi 7 для нагруженных сетейКомпания Netgear анонсировала точку доступа Cloud Managed WiFi 7 Access Point (модель WBE750), предназначенную для высоконагруженных корпоративных сетей. Новинка, как отражено в названии, соответствует стандарту Wi-Fi 7 с возможностью работы в трёх частотных диапазонах — 2,4, 5 и 6 ГГц. Устройство заключено в корпус с габаритами 172 × 172 × 44 мм, а масса составляет 0,94 кг. Возможен монтаж на стену или потолок. Площадь покрытия достигает 280 м2. Реализована возможность централизованного управления через облачную платформу. Точка доступа допускает одновременное обслуживание до 600 клиентов. Говорится о поддержке OFDM/OFDMA, MU-MIMO, OWE, WPA2/WPA3-PSK, WPA2/WPA3-Enterprise. Заявленная канальная скорость передачи данных в диапазоне 2,4 ГГц достигает 1147 Мбит/с, в полосе 5 ГГц — 5765 Мбит/с, 6 ГГц — 11 530 Мбит/с. Предусмотрен сетевой порт 10GbE с технологией PoE++. Отмечается, что в устройстве применена антенная система с уникальной конструкцией, оптимизированной для одновременной работы во всех диапазонах (2,4/5/6 ГГц). Каждая антенна настраивается индивидуально, что обеспечивает наилучшее подключение в любой частотной полосе. На точку доступа предоставляется пятилетняя гарантия. Приобрести новинку можно по ориентировочной цене $700. |

|