Лента новостей

|

10.08.2024 [23:28], Руслан Авдеев

ЦОД с газопроводом: энергокомпании США обсуждают с операторами дата-центров поставки голубого топливаАмериканские энергокомпании US Energy Transfer и Williams Cos. обсуждают с операторами дата-центров возможность строительства трубопроводов для поставки газа непосредственно на территорию кампусов для питания электростанций. По данным Datacenter Dynamics, бум ИИ ведёт к росту спроса на энергию и многие видят в получении энергии на месте возможное решение проблемы. По словам представителя Energy Transfer, общавшегося с отраслевыми экспертами, компания обсуждает возможности с ЦОД разных масштабов. Многие из них весьма положительно относятся к самой идее генерировать электричество на месте. Сейчас компания расширяет уже существующие электростанции и изучает возможность подключения к газовым магистралям новых. Williams Cos. также отмечает рост спроса и, как сообщают в компании, пытаются найти решение в ответ на многочисленные запросы. В частности речь идёт о юго-восточной части США и центре атлантического побережья страны. В число регионов попал и штат Вирджиния, на территории которого расположено огромное количество ЦОД, уже страдающих от дефицита электроэнергии.

Источник изображения: Quinten de Graaf/unsplash.com Местный поставщик электричества Dominion Energy в докладе за 2023 год сообщил, что принадлежащая ему распределяющая компания Virginia Power продавала 24 % всего поставляемого здесь электричества именно дата-центрам в минувшем году, в 2022 году рост составлял 21 %. Компания объявила, что потребление индивидуальных объектов выросло с приблизительно 30 МВт до 60–90 МВт, а аппетиты кампусов могут составлять от 300 МВт до нескольких гигаватт. В январе 2024 года PJM Interconnection отметила, что ожидает роста энергопотребления в зонах своей ответственности почти на 40 % в следующие 15 лет, одним из ключевых драйверов роста должны стать дата-центры. С увеличением ограничений для сетей электропередач выработка энергии на месте может стать единственным средством получения одобрения на строительство новых ЦОД. Нечто подобное уже происходит и в Ирландии. В результате фактического моратория на строительство дата-центров в районе Дублин, некоторые ЦОД выразили намерение подключиться к газовым магистралям вместо попыток присоединения к энергосети. С тех пор Ирландия уже начала реализовывать политику частного энергоснабжения, позволяя компаниям строить собственную энерготранспортную инфраструктуру во избежание проблем с энергоснабжением в других сферах, использующих сети общего пользования.

10.08.2024 [22:58], Сергей Карасёв

CoreWeave активно нанимает топ-менеджеров Google, Oracle и AWS для развития ИИ ЦОДКомпания CoreWeave, предоставляющая облачные услуги для ИИ-задач, по сообщению Datacenter Dynamics, приняла на работу сразу нескольких топ-менеджеров, которые ранее занимали различные руководящие должности в Google, Oracle и AWS. Ожидается, что они помогут CoreWeave в развитии направления дата-центров. В частности, CoreWeave назначила старшим вице-президентом по проектированию Чена Голдберга (Chen Goldberg). До этого он в течение восьми лет работал в Google, в том числе в качестве генерального директора и вице-президента по развитию Kubernetes и направления бессерверных вычислений. Кроме того, в CoreWeave в качестве главного операционного директора пришёл Сачин Джайн (Sachin Jain). Ранее он трудился в Oracle, отвечая за инфраструктуру ИИ, снабжение ЦОД и управление группами IaaS в рамках облачной платформы Oracle Cloud Infrastructure (OCI). Кроме того, в течение примерно четырёх лет Джайн занимал пост вице-президента Google Cloud, руководя планированием мощностей и оптимизацией ресурсов.

Источник изображения: CoreWeave В середине марта 2024 года CoreWeave назначила нового финансового директора: им стал Нитин Агравал (Nitin Agrawal), до этого занимавший должность вице-президента по финансам в Google Cloud. А позднее CoreWeave объявила о том, что на пост её продуктового директора назначен Четан Капур (Chetan Kapoor), ранее исполнявший обязанности директора по управлению продуктами в подразделении AWS EC2. CoreWeave активно развивает бизнес, в том числе в сфере дата-центров. В мае нынешнего года компания сообщила о намерении вложить £1 млрд в ИИ ЦОД в Великобритании. Ещё $2,2 млрд будет инвестировано в аналогичные проекты в материковой Европе. За последние два года CoreWeave привлекла приблизительно $12 млрд, в том числе в виде долгового финансирования. Средства направляются на развитие ЦОД и закупку необходимого оборудования.

10.08.2024 [12:01], Руслан Авдеев

Cisco второй раз за год уволит тысячи сотрудников и сосредоточится на ИИ и кибербезопасностиКомпания Cisco сократит тысячи сотрудников в ходе второго раунда увольнений. По данным Reuters, это связано с тем, что компания намерена сместить фокус внимания на области с высокими темпами роста, включая кибербезопасность и системы искусственного интеллекта (ИИ). Если в феврале Cisco уволила порядка 4 тыс. человек, то теперь, не исключено, под сокращение попадёт несколько больше. Вероятнее всего, компания объявит о непростых кадровых решениях уже в будущую среду в ходе очередного квартального отчёта. В своё время Reuters сообщила о февральских увольнениях ещё до того, как об этом объявила сама компания, поэтому её источники могут считаться довольно надёжными. При этом в июле 2023 года штат Cisco составлял 84,9 тыс человек. После сообщения Reuters об очередных сокращениях акции компании упали в цене приблизительно на 1 %, всего они подешевели за год более чем на 9 %. Сейчас компания страдает от малого спроса и проблем с цепочками поставок для своего основного бизнеса. Это заставляет её диверсифицировать бизнес — например, в марте закрыта сделка по покупке за $28 млрд компании Splunk, занимающейся обеспечением кибербезопасности. Покупка позволит снизить зависимость от «разовых» продаж, стимулируя бизнес, связанный с продажей технологических решений по подпискам. Кроме того, компания пытается интегрировать ИИ в свои продукты и в мае подтвердила намерение добиться в 2025 году продаж ИИ-решений на $1 млрд. В июне компания основала миллиардный фонд для инвестиций в ИИ-стартапы вроде Cohere, Mistral AI и Scale AI. На тот момент компания объявила, что за последние годы приобрела 20 связанных с ИИ компаний. Увольнения — последнее из событий такого рода в технологической индустрии, позволяющая сократить издержки в текущем году, чтобы компенсировать большие инвестиции в ИИ. Всего, по данным портала Layoffs.fyi, с начала года в 393 технокомпаниях уволили более 126 тыс. человек. Ранее в августе Dell объявила о сокращении более 10 % рабочей силы — около 12,5 тыс. человек, в основном из отделов продаж и маркетинга.

10.08.2024 [11:52], Сергей Карасёв

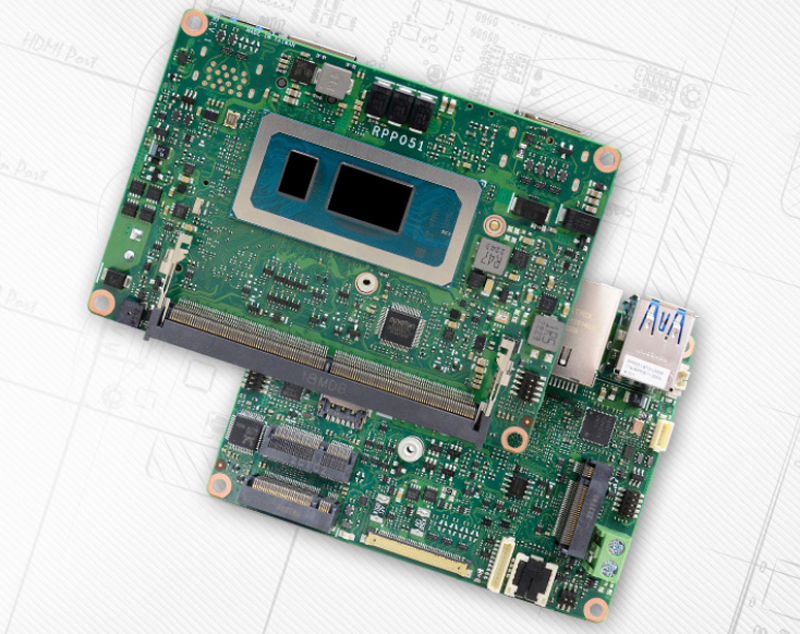

Одноплатный компьютер DFI RPP051 формата Pico-ITX получил чипы Intel Raptor Lake-UКомпания DFI пополнила ассортимент одноплатных компьютеров моделью RPP051 на аппаратной платформе Intel Raptor Lake-U (Core 13-го поколения). Новинка подходит для создания edge-оборудования и устройств Интернета вещей, рассчитанных на эксплуатацию в широком температурном диапазоне — от -30 до +80 °C. Изделие выполнено в форм-факторе Pico-ITX с размерами 100 × 72 мм. В зависимости от модификации используется чип U300E (1P + 4E; шесть потоков; до 4,3 ГГц). Core i3-1315UE (2P + 4E; восемь потоков; до 4,5 ГГц), Core i5-1345UE (2P + 8E; 12 потоков; до 4,6 ГГц) или Core i7-1365UE (2P + 8E; 12 потоков; до 4,9 ГГц). Есть один слот SO-DIMM для модуля DDR5-4800 ёмкостью до 32 Гбайт.

Источник изображения: DFI Решение DFI RPP051 располагает коннектором M.2 B key 3042/2242 (PCIe x2/USB 2.0/SATA 3.0) для SSD, разъёмом M.2 E key 2230 (PCIe x1/USB 2.0) для адаптера Wi-Fi/Bluetooth и коннектором M.2 B key 3042/2242 (PCIe x1/USB 3.2 Gen1/SATA 3.0) для модема 4G/5G (плюс слот для карты Nano SIM). В оснащение входят сетевой контроллер Intel I226IT/LM стандарта 2.5GbE и звуковой кодек Realtek ALC888S-VD2-GR. Предусмотрены два порта USB 3.2 Gen2, разъём DP++ (до 4096 × 2304 точки; 60 Гц) и гнездо RJ-45 для сетевого кабеля. Через коннекторы на плате можно задействовать два порта USB 2.0, последовательный порт RS-232/422/485, интерфейс eDP и пр. Питание (12 В) подаётся через 2-контактный коннектор. Заявлена совместимость с Windows 10 IoT Enterprise, Windows 11 и Linux. Цена одноплатного компьютера составляет $620, $891 и $1128 за версии с процессором Core i3-1315UE, Core i5-1345UE и Core i7-1365UE соответственно.

10.08.2024 [11:49], Владимир Мироненко

Уязвимость Sinkclose в процессорах AMD позволяет вывести из строя компьютер без возможности восстановленияЭнрике Ниссим (Enrique Nissim) и Кшиштоф Окупски (Krzysztof Okupski), исследователи из компании IOActive, занимающейся вопросами безопасности обнаружили уязвимость в чипах AMD, выпускаемых с 2006 года или, возможно, даже раньше, которая позволяет вредоносному ПО проникать настолько глубоко в систему, что во многих случая её проще выбросить, чем пытаться восстановить, пишет ресурс Wired. Получившая идентификатор CVE-2023-31315 с высоким уровнем опасности (CVSS 7,5) уязвимость была названа исследователями Sinkclose. Уязвимость позволяет злоумышленникам с привилегиями уровня ядра ОС (Ring 0) получать привилегии Ring -2 и устанавливать вредоносное ПО, которое очень сложно обнаружить. Благодаря Sinkclose злоумышленники могут изменять настройки одного из самых привилегированных режимов процессора AMD — SMM, предназначенного для обработки общесистемных функций, таких как управление питанием и контроль оборудования, даже если включена блокировка SMM. Эта уязвимость может использоваться для отключения функций безопасности и внедрения на устройство постоянного, практически необнаруживаемого вредоносного ПО. Ring -2 изолирован и невидим для ОС и гипервизора, поэтому любые вредоносные изменения, внесённые на этом уровне, не могут быть обнаружены или исправлены инструментами безопасности, работающими в ОС. Вредоносное ПО, известное как буткит, которое обходит антивирусные инструменты и потенциально невидимо для операционной системы, предоставляет хакеру полный доступ для вмешательства в работу компьютера и наблюдения за её активностью. По словам Окупски, единственный способ обнаружить и удалить вредоносное ПО, установленное с помощью SinkClose — это физическое подключение с помощью программатора SPI Flash и сканирование памяти на наличие вредоносного ПО. Полные сведения об уязвимости будут представлены исследователями на конференции DefCon в докладе «AMD Sinkclose: Universal Ring -2 Privilege Escalation». Исследователи говорят, что предупредили AMD об уязвимости в октябре прошлого года, и не сообщали о баге почти 10 месяцев, чтобы дать AMD больше времени для устранения проблемы. Комментируя сообщение исследователей, компания AMD указала в заявлении для Wired на сложность использования уязвимости в реальных сценариях, поскольку злоумышленникам требуется доступ на уровне ядра. В ответ исследователи заявили, что подобные уязвимости выявляются в Windows и Linux практически каждый месяц. Они отметили, что опытные хакеры, спонсируемые государством, которые могут воспользоваться Sinkclose, вероятно, уже обладают методами использования подобных уязвимостей. Как ожидают исследователи, для компьютеров с Windows патчи против Sinkclose будут интегрированы в обновления, которыми производители компьютеров поделятся с Microsoft. Исправления для серверов, встраиваемых систем и Linux-машин могут быть более пошаговыми и ручными; для Linux это будет частично зависеть от дистрибутива. AMD указала в заявлении, что уже приняла меры по смягчению последствий для своих процессоров EPYC и AMD Ryzen для настольных и мобильных систем, а дополнительные исправления для встроенных процессоров появятся позже. Согласно AMD, уязвимость имеется в следующих чипах:

UPD 11.08.2024: патчи не получат Ryzen 1000, 2000 и 3000, а также Threadripper 1000 и 2000. Не упомянуты и Ryzen 9000 с Ryzen AI 300, но в этих процессорах уязвимость наверняка устранена ещё до их выхода на рынок. UPD 21.08.2024: Ryzen 3000 всё-таки получит патчи против Sinkclose.

09.08.2024 [23:50], Владимир Мироненко

Купить, не покупая: IT-гиганты научились поглощать ИИ-стартапы, не привлекая внимания регуляторовСтартапы в сфере ИИ привлекли миллиарды долларов инвестиций в прошлом году в надежде, что вложения в скором времени окупятся. Однако этого не случилось и сейчас многим из них приходится бороться за выживание, обращаясь за помощью к крупным технологическим компаниям, пишет газета The Wall Street Journal. Так, стартап Character.AI объявил о сделке с Google по использованию его технологии, в рамках которой часть его персонала, а также соучредители Ноам Шазир (Noam Shazeer) и Даниэль Де Фрейтас (Daniel De Freitas) переходят в штат поискового гиганта. Также согласно условиям сделки Google выплатит стартапу лицензионный сбор в размере $2 млрд, что позволит рассчитаться с ранними инвесторами, сообщили люди, знакомые с этим вопросом. По словам источника WSJ, компании обсуждали возможность прямого приобретения, но пришли к выводу, что в этом случае без расследования регуляторов вряд ли обойдётся. Новый тип сделки, который фактически является приобретением, хотя формально к таковым не относится, позволяет обойти типичный процесс регулирования в то время, когда регулирующие органы ужесточают контроль деятельности крупных технологических компаний по расширению влияния на рынке генеративного ИИ. Аналогичную сделку заключил в июне стартап Adept AI с компанией Amazon, взявшей на себя обязательство нанять большую часть сотрудников стартапа и заплатить около $330 млн за лицензирование технологии, сообщили информированные источники WSJ. Этого было достаточно, чтобы вместе с оставшимися у Adept AI средствами расплатиться с инвесторами. Хотя сам стартап, который в прошлом году оценивался в $1 млрд, рассчитывал на более блестящее будущее. Adept привлёк чуть более $400 млн инвестиций, но затраты на создание его технологии превзошли ожидания ее основателей, сообщил информатор WSJ. Этой весной стартап обратился к ряду компаний, включая Microsoft и Salesforce, а в итоге заключил сделку с Amazon. Сейчас в Adept осталось около 25 сотрудников, и теперь стартап будет заниматься использованием и продажей существующих технологий без разработки новых. Аналогичную сделку провернула в марте Microsoft, приняв на работу почти всех сотрудников разработчика ИИ Inflection, чтобы открыть новое подразделение потребительского ИИ, и заплатив около $650 млн за лицензирование технологий. Впрочем, эта сделка уже заинтересовала британского регулятора. Инвесторы прогнозируют дальнейшие сделки по поглощению ИИ-стартапов, как реальные, так и фиктивные, поскольку сроки окупаемости ИИ-технологий оказались гораздо больше, чем они рассчитывали, и сейчас приходится думать о выживании. Спасение технологическим гигантом лучше, чем закрытие, но это далеко не нарушение статус-кво технологической отрасли, на которое делали ставку инвесторы, отметила WSJ. Вместо этого технологические гиганты ещё больше укрепили своё влияние на рынке ИИ. По словам источников WSJ в ИИ-отрасли, усиление мер администрации США по блокированию технологических слияний и поглощений стало одной из причин необычных сделок с Character, Adept и Inflection. Так называемые сделки acqui-hires, когда крупная компания покупает стартап в основном для найма его сотрудников, для Кремниевой долины не новость. Но найм ключевых сотрудников стартапа и получение его технологий в обмен на лицензионный сбор отличаются от этого типа сделки, позволяя компании получить желаемое без необходимости в одобрении регулятором. Впрочем, по словам источников, Федеральная торговая комиссия США (FTC) изучает как сделку Amazon с Adept, так и сделку Microsoft с Inflection с целью выяснить, не было ли у покупателя умысла избежать с помощью составленного таким образом соглашения одобрения правительства. В Великобритании у регуляторов вызвала вопросы инвестиция Amazon $4 млрд в ИИ-стартап Anthropic.

09.08.2024 [23:30], Сергей Карасёв

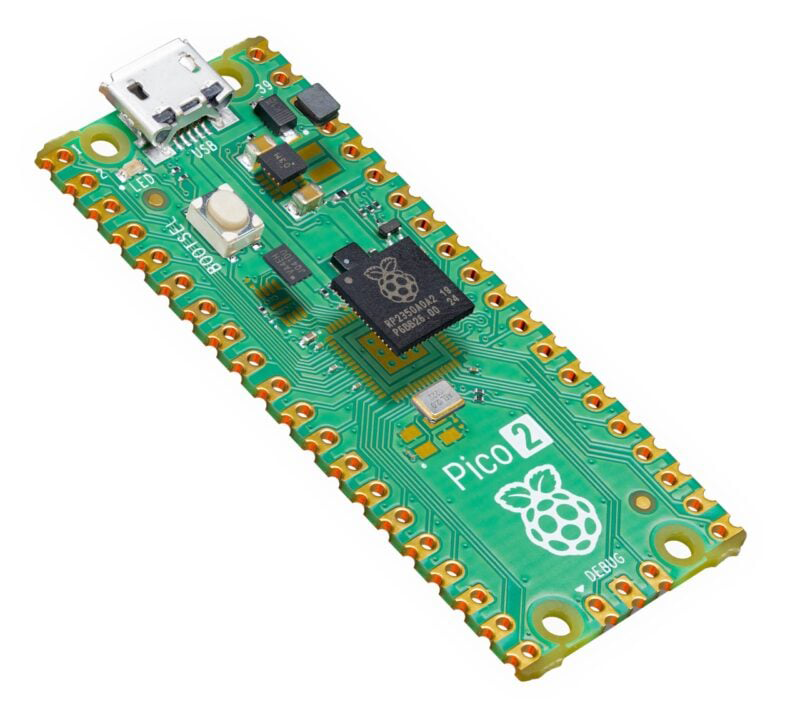

Представлена крошечная плата Raspberry Pi Pico 2 за $5 на чипе с ядрами RISC-V и ArmКомпания Raspberry Pi анонсировала микроплату Pico 2, в основу которого положен гибридный чип RP2350: это изделие объединяет ядра с архитектурой Arm и RISC-V. Для новинки заявлена обратная аппаратная и программная совместимость с более ранними представителями серии Pico. Оригинальная плата Raspberry Pi Pico дебютировала в январе 2021 года. Она получила микрочип собственной разработки RP2040, содержащий два ядра Cortex M0+ с базовой тактовой частотой 48 МГц и возможностью повышения до 133 МГц. Чип RP2350, в свою очередь, имеет более сложную конструкцию.

Источник изображения: Raspberry Pi В состав RP2350 входят по два ядра Arm Cortex-M33 и RISC-V Hazard3 (RV32I с расширениями): в обоих случаях тактовая частота составляет 150 МГц. Однако использовать эти кластеры сообща нельзя — одна из двух конфигураций выбирается при инициализации устройства. Правда, при выборе RISC-V не будут работать часть функций безопасности и FP64-ускорение. Чип существует в модификациях RP2350A (QFN-60; 7 × 7 мм; 30 × GPIO) и RP2350B (QFN-80; 10 × 10 мм; 48 × GPIO). Есть 520 Кбайт памяти SRAM в обоих вариантах исполнения. Плата Raspberry Pi Pico 2 располагает 4 Мбайт флеш-памяти QSPI и портом Micro-USB 1.1. Говорится о поддержке 2 × UART, 2 × SPI, 2 × I2C, 16 × PWM, 4 × ADC. Размеры новинки равны 51 × 21 мм. Напряжение питания — от 1,8 до 5,5 В. Диапазон рабочих температур простирается от -20 до +85 °C. Плата Raspberry Pi Pico 2 предлагается как по отдельности, так и в партиях из 480 штук. Изделие будет производиться как минимум до января 2040 года, то есть жизненный цикл составляет не менее 16 лет. Приобрести новинку можно по цене $5.

09.08.2024 [23:13], Владимир Мироненко

«Ростелеком» объединил экспертизу и разработки ряда дочерних компаний в единый коммерческий ИТ-кластер«Ростелеком» объявил о создании коммерческого ИТ-кластера, который объединяет опыт и передовые разработки дочерних ИТ-компаний. Портфель кластера содержит более 60 готовых ИТ-решений, касающихся широкого спектра задач цифровизации и повышения эффективности бизнес-процессов, включая облачные сервисы, средства разработки ПО, продукты для управления данными, виртуализация серверов и рабочих мест, динамическая инфраструктура, технологии ИИ и другие, говорится в пресс-релизе. Сообщается, что в состав коммерческого ИТ-кластера войдут компании: «Базис», «Беркут», «ТДата», «Спутник», «Айкумен ИБС», «ОС груп», «РТК ИТ плюс», «РТК Софт Лабс», а также продуктовые линейки «РТК ЦОД» (в том числе «Публичное облако») и экосистемы «Лукоморье». Руководителем подразделения назначен старший вице-президент по коммерческим ИТ-продуктам «Ростелекома», занимавший ранее должность вице-президента по ИТ-эксплуатации и инфраструктуре. Он заявил, что стратегическая цель коммерческого ИТ-кластера заключается в содействии цифровой трансформации бизнеса. По его словам, кластер предложит рынку доступ к проверенным технологиям, которые успешно зарекомендовали себя как внутри компании, так и у внешних заказчиков из разных отраслей. В дальнейшем кластер будет активно развиваться, в том числе за счёт сделок M&A, расширяя портфель ИТ-продуктов и услуг. «Формирование коммерческого ИТ-кластера — закономерный этап развития “Ростелекома” как технологического лидера и драйвера цифровой трансформации. Мы готовы предоставить накопленный опыт и экспертизу компаниям, стремящимся к оптимизации процессов, повышению конкурентоспособности и ускорению роста бизнеса за счет внедрения цифровых технологий», — заявил президент «Ростелекома».

09.08.2024 [22:50], Алексей Степин

Звание самого быстрого SSD перешло к Samsung PM1753На мероприятии FMS 2024 компания Samsung показала новые серверные SSD PM1753 и BM1743. Последний был ансонирован месяц назад, а на FMS был впервые показана модификация объёмом 128 Тбайт, ставшая достойным ответом решениям Solidigm, Pascari (Phison) и Western Digital.

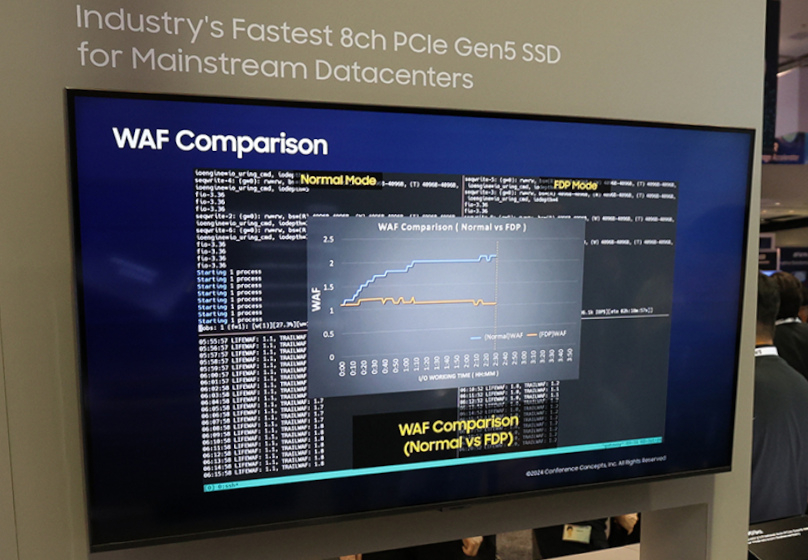

Источник изображений: Samsung Несмотря на использование QLC (v7 vNAND), у BM1743 достаточно высокие показатели производительности: линейные скорости чтения и записи составляют 7,5 Гбайт/с и 3,5 Гбайт/с соответственно. На случайных операциях SSD развивает 1,6 млн и 45 тыс IOPS. BM1743 использует форм-фактор U.2 и интерфейс PCIe 4.0, а с последними версиями прошивки он стал заметно экономичнее и потребляет в режиме простоя лишь около 2 Вт. Где-то в 2024–2026 гг. Samsung должна представить массовые решения объёмом 256 Тбайт, а в следующие за ним пару лет довести ёмкость и до 512 Тбайт. В последнем случае, как ожидается, накопители будут представлены исключительно в форм-факторе EDSFF E3.L. К 2035 году компания намеревается выпустить SSD объёмом 1 Пбайт. А вот Samsung PM1753 относится к совсем иному классу решений. Новинка ориентирована на ЦОД нового поколения с инфраструктурой PCI Express 5.0 и будет поставляться в форм-факторах U.2 и E3.S. Предельный объём здесь составляет 32 Тбайт, зато производительность благодаря 16-канальному контроллеру у него приличная: чтение 14,8 Гбайт/с, запись 11 Гбайт/с. Для случайных операций заявлены 3,4 млн и 600 тыс IOPS соответственно. Таким образом, меньше чем за месяц звание самого быстрого SSD перешло от Micron 9550 к Solidigm D7-PS1010, а теперь и к Samsung PM1753, если, конечно, не учитывать формальный рекорд Kioxia CM7-R ещё двухлетней давности. В основе PM1753 лежит девятое поколение TLC V-NAND, обеспечивающее повышенную в 1,6–1,7 раза энергоэффективность в сравнении с решениями предыдущего поколения. В простое PM1753, как обещается, будет потреблять лишь 4 Ватта. Естественно, новинки ориентированы на современные ИИ-инфраструктуры.  Интересны и Samsung PM9D3a, представленные в форм-факторах M.2, U.2 и E1.S/E3.S 1T. В первом случае ёмкость ограничена значением 4 Тбайт, более крупные форматы включают в себя модели объёмом до 32 Тбайт. Они используют 8-канальный контроллер с PCIe 5.0, обеспечивающий при записи до 50 тыс IOPS на каждый Тбайт. Производительность при случайном чтении у этой новинки достигает 1,8 млн IOPS, линейные скорости чтения и записи составляют 12 Гбайт/с и 7 Гбайт/с, соответственно. PM9D3a являются первыми накопителями Samsung с технологией Flexible Data Placement (FDP), которая позволяет группировать данные для совместной записи по команде хоста. Эти накопители отличаются высокой гибкостью конфигурирования, улучшенной энергоэффективностью, предсказуемой и настраиваемой производительностью, а также низким TCO. Поэтому нацелены они в первую очередь на гиперскейлеров.

09.08.2024 [17:07], Руслан Авдеев

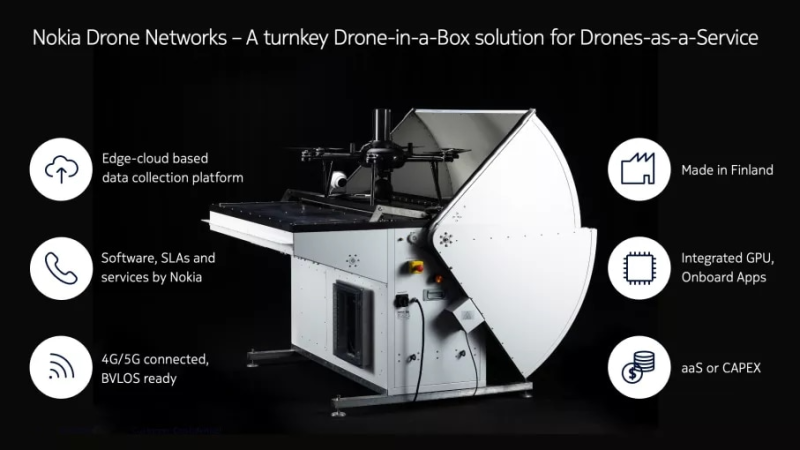

Дрон-как-сервис: Nokia и Swisscom опутают Швейцарию сетью БПЛА-систем с 4G/5G-подключениемNokia договорилась с телекоммуникационной компанией Swisscom Broadcast о формировании на территории Швейцарии сети Drones-as-a-Service из 300 БПЛА. Пресс-служба Nokia сообщает, что приоритетными пользователями станут экстренные службы страны, индустриальные предприятия и прочие структуры, которым потребуются оперативные воздушные наблюдения. Клиенты смогут заказывать полёты дронов без необходимости самостоятельно управлять ими. Сам телеком-оператор заявляет, что на первом этапе будет предлагать три сервиса. Один предназначен для экстренных служб, обязанных бороться с пожарами, преступлениями и т.п. Второй представляет собой службу для проверки инфраструктуры — линий электропередач, мостов, зданий и др., куда тяжело добраться или где человеку может угрожать опасность. Наконец, речь идёт о сервисе «защиты периметра» — БПЛА будут использовать для мониторинга общественных мест, мест лишения свободы, границ и даже военных объектов. В Nokia объявили, что каждый комплект «дрон в коробке» включает сам беспилотник индустриального класса, док-станцию, станцию наземного контроля, комплект видео- и инфракрасных камер, ПО и компоненты для обслуживания оборудования. Решение поддерживает 4G/5G-подключение к публичным и частным сетям. БПЛА сертифицированы для использования за пределами прямой видимости оператора (BVLOS). Весь парк дронов будет контролироваться из единого центра удалённого управления. Вероятно, всё это обойдётся недёшево — о цене проекта не сообщается, ответа нет и на запрос журналистов.

Источник изображения: Nokia Nokia — не новичок в сфере создания подобных БПЛА-сетей. Похожий вариант на базе 5G она уже представила в Бельгии совместно с технологической компанией Citymesh в прошлом году. Сеть состоит из 70 дронов, распределённых по 35 зонам быстрого реагирования и также предназначена для помощи в экстренных случаях. Видимо, проект реализовали достаточно успешно для того, чтобы в Швейцарии решили создать аналогичную сеть. |

|