Материалы по тегу: ии

|

04.12.2025 [12:21], Руслан Авдеев

Скромно, но со вкусом: Vultr при поддержке AMD построит за $1 млрд ИИ-кластер с 24 тыс. Instinct MI355XОблачный провайдер Vultr строит кластер мощностью 50 МВт из ИИ-ускорителей AMD в дата-центре в Огайо. Новый проект призван обеспечить дополнительные вычислительные мощности по сниженным ценам, сообщает Bloomberg. Поддерживаемая AMD компания намерена инвестировать в объект более $1 млрд, клиенты смогут обучать и эксплуатировать ИИ-модели. Ввод в эксплуатацию запланирован на I квартал 2026 года. Vultr входит в группу облачных провайдеров, желающих заработать на ажиотажном спросе на ИИ. Новый кластер гораздо меньше гигантских объектов Microsoft, Meta✴ и Google. При этом вычислительные мощности, по словам компании, будут предлагаться по более доступным тарифам. Облако Vultr, как правило, вдвое дешевле, чем предложения гиперскейлеров, сообщают в компании. Утверждается, что её 50-МВт ЦОД с 24 тыс. AMD Instinct MI355X сопоставим с некоторыми гигаваттными проектами по эффективности. Vultr одной из первых получила MI355X, а вскоре перейдёт на MI450. Кластер называют «беспрецедентным» для облачной компании такого масштаба, но для него пока нет готовых к подписанию соглашений клиентов, хотя активные переговоры уже ведутся. По имеющимся данным, действующие клиенты вроде Clarifai Inc. и LiquidMetal AI, а также биотехнологическая MindWalk Holdings уже пользуются сервисами Vultr на базе решений AMD. В общей сложности компания обслуживает «сотни тысяч» клиентов в 185 странах. Vultr была основана в 2014 году и многие годы предлагала доступ к решениям на базе CPU. В 2021 году Vultr начала закупать GPU. В последние пару лет ИИ-инфраструктура стала самой быстрорастущей частью бизнеса компании, т.ч. теперь она обеспечивает большую часть выручки. В 2026 году бизнес намерен уделять ИИ ещё больше внимания. В прошлом году компания привлекла $333 млн, в ходе раунда, возглавленного LuminArx Capital Management и AMD, её капитализация составила $3,5 млрд. В июне 2025 года дополнительно получены $329 млн кредитного финансирования, преимущественно от JPMorgan Chase, Bank of America и Wells Fargo. В эту сумму вошли $74 млн, обеспеченных активами компании, в т.ч. ИИ-ускорителями. Vultr значительно расширила кредитную линию для финансирования кластера AMD. Разрабатывающие ИИ-инфраструктуру компании всё чаще опасаются, что отрасль ожидает формирование пузыря. Также не исключается, что ИИ-ускорителя быстро обесценятся, что тоже способно привести рынок к кризису. В Vultr уверены, что ИИ-инфраструктура всё ещё остаётся «крайне неразвитой», даже если некоторые, чрезвычайно разросшиеся на этом рынке IT-гиганты, вероятно, потерпят неудачу. Что касается времени «обесценивания» технологий, Vultr уверена, что срок службы в шесть лет для ИИ-ускорителей — «разумная, консервативная оценка».

04.12.2025 [09:48], Владимир Мироненко

Частное ИИ-облако под ключ: Amazon представила AWS AI Factory для развёртывания в собственных ЦОД заказчиковAmazon представила AWS AI Factory — выделенную ИИ-инфраструктуру, включающую ускорители NVIDIA, чипы Trainium, а также сетевые решения, хранилища и базы данных AWS, которую можно развернуть в собственных ЦОД клиентов, обеспечивая их потребность в реализации суверенитета и соблюдении нормативных требований. «Клиенты могут использовать пространство своего существующего ЦОД, сетевое подключение и электроэнергию, в то время как AWS берет на себя все сложности развёртывания и управления интегрированной инфраструктурой», — пояснила компания. AWS отметила, что организации в регулируемых отраслях и государственном секторе при развёртывании своих масштабных проектов в сфере ИИ сталкиваются с проблемой их размещения в соответствующей требованиям инфраструктуре. Создание собственной ИИ-инфраструктуры требует значительных капиталовложений в покупку ускорителей, (до-)оснащение ЦОД и электроэнергию, а также сложных циклов закупок, выбора ИИ-модели для конкретного сценария использования и лицензирования моделей у разных поставщиков ИИ-технологий. Это требует много времени и усложняет эксплуатацию, отвлекая клиентов от основных бизнес-целей. AWS AI Factory позволяет решить эту проблему путём развёртывания готовой к использованию выделенной ИИ-инфраструктуры AWS в собственных дата-центрах клиентов. AWS AI Factory функционирует как частный облачный регион AWS, предоставляя безопасный доступ с низкой задержкой к вычислительным ресурсам, хранилищу данных, базам данных и ИИ-сервисам AWS для обучения и инференса ИИ-моделей. Кроме того, предоставляются управляемые сервисы, обеспечивающие доступ к ведущим базовым моделям без необходимости заключения отдельных контрактов с их поставщиками. Всё это помогает организациям соблюдать требования безопасности, суверенитета данных и нормам обработки и хранения данных, экономя усилия по развёртыванию и управлению инфраструктурой. Компания отметила, что AWS AI Factory разработаны в соответствии со строгими стандартами безопасности AWS, обеспечивая выполнение самых важных рабочих нагрузок на всех уровнях секретности: «Несекретно», «Конфиденциально», «Секретно» и «Совершенно секретно». AWS AI Factory — совместный проект AWS и NVIDIA, благодаря чему клиенты получат доступ к ПО NVIDIA и множеству приложений с ускорением на базе GPU. AWS Nitro и EC2 UltraClasters поддерживают платформы Grace Blackwell и Vera Rubin. AWS и NVIDIA также сотрудничают в рамках стратегического партнёрства с HUMAIN из Саудовской Аравии. AWS создаёт в Саудовской Аравии первую в своём роде «Зону искусственного интеллекта» (AI Zone) в кампусе HUMAIN, включающую до 150 тыс. ИИ-чипов, в том числе ускорители NVIDIA GB300 и Amazon Trainium, выделенную ИИ-инфраструктуру и ИИ-сервисы AWS.

03.12.2025 [20:51], Владимир Мироненко

HPE одной из первых начнёт выпускать интегрированные стоечные ИИ-платформы AMD Helios AI

amd

broadcom

epyc

hardware

hpc

hpe

instinct

juniper networks

mi400

ocp

ualink

venice

германия

ии

суперкомпьютер

AMD объявила о расширении сотрудничества с HPE, в рамках которого HPE станет одним из первых поставщиков стоечных систем AMD Helios AI, которые получат коммутаторы Juniper Networking (компания с недавних пор принадлежит HPE), разработанные совместно с Broadcom, и ПО для бесперебойного высокоскоростного подключения по Ethernet. AMD Helios AI — открытая полнофункциональная ИИ-платформа на базе архитектуры OCP Open Rack Wide (ORW), разработанная для крупномасштабных рабочих нагрузок и обеспечивающая FP4-производительность до 2,9 Эфлопс на стойку благодаря ускорителям AMD Instinct MI455X, процессорам EPYC Venice шестого поколения и DPU Pensando Vulcano, работающими под управлением открытой программной экосистемы ROCm для нагрузок ИИ и HPC. Как отметил The Register, сетевая архитектура этой системы будет представлять собой масштабируемую реализацию UALink over Ethernet (UALoE) и специализированным коммутатором Juniper Networks на базе сетевого чипа Broadcom Tomahawk 6 (102,4 Тбит/с). Система разработана для упрощения развёртывания крупномасштабных ИИ-кластеров, что позволяет сократить время разработки решений и повысить гибкость инфраструктуры. В отличие от NVIDIA, AMD не выпускает коммутаторы, предлагая открытую экосистему, так что HPE и другие компании могут интегрировать собственные сетевые решения. The Register полагает, что HPE и Broadcom решили не гнаться за отдельной аппаратной реализацией UALink, если данные можно передавать поверх Ethernet. «Это первое в отрасли масштабируемое решение, использующее Ethernet, стандартный Ethernet. Это означает, что оно полностью соответствует открытому стандарту и позволяет избежать привязки к проприетарному поставщику, использует проверенную сетевую технологию HPE Juniper для обеспечения масштабируемости и оптимальной производительности для рабочих нагрузок ИИ», — заявила HPE. HPE заявила, что это позволит её стоечной системе поддерживать трафик, необходимый для обучения модели с триллионами параметров, а также обеспечить высокую пропускную способность инференса. Стоечная система HPE будет включать 72 ускорителя AMD Instinct MI455X с 31 Тбайт HBM4 с агрегиированной пропускной способностью 1,4 Пбайт/с. Агрегированная скорость интерконнекта составит 260 Тбайт/с. Новинка будет доступна в 2026 году. AMD также сообщила, что Herder, новый суперкомпьютер для Центра высокопроизводительных вычислений в Штутгарте (HLRS) (Германия), получит Instinct MI430X и EPYC Venice. Он будет построена на платформе HPE Cray Supercomputing GX5000. Поставка Herder запланирована на II половину 2027 года, а ввод в эксплуатацию — к концу 2027 года. Herder заменит используемый центром суперкомпьютер Hunter.

03.12.2025 [17:56], Руслан Авдеев

Арифметика не сходится: без прорыва инвестиции в ИИ не окупятся «ни при каких обстоятельствах», заявил глава IBMПо словам генерального директора IBM Арвинда Кришны (Arvind Krishna), занимающиеся ИИ-проектами компании тратят миллиарды долларов в гонке за создание «общего искусственного интеллекта» (AGI), способного сравняться с человеком или заменить его. Но в экономической целесообразности таких проектов он сомневается, сообщает Business Insider. По его словам, расходы на ИИ-инфраструктуру постоянно растут, но компании, вероятно, «никаким образом» не смогут окупить такие затраты на дата-центры. По грубым оценкам бизнесмена, сегодня для дата-центра мощностью 1 ГВт требуется около $80 млрд. Если компания намерена построить дата-центры на 20–30 ГВт, её понадобится $1,5 трлн капиталовложений. При этом уже через пять лет ИИ-чипы в ЦОД потеряют актуальность, после чего будет необходимо всё «выбросить и заменить». Как заявил Кришна, если смотреть на инвестиции в сфере разработки AGI, то они составляют около 100 ГВт. При текущем уровне затрат на инфраструктуру общая стоимость гонки составит приблизительно $8 трлн. По словам Кришны, никакой прибыли ждать не приходится, поскольку только для выплаты процентов с $8 трлн кредитов потребуется около $800 млрд ежегодно. При этом без внешней финансовой и иной помощи не обойтись. В октябрьском послании к американским властям глава OpenAI Сэм Альтман (Sam Altman) рекомендовал США строить по 100 ГВт генерирующих мощностей в год, а сама OpenAI обязалась потратить около $1,4 трлн на различные сделки. Кришна не вполне согласен с Альтманом. Глава IBM вообще не уверен, что доступные сегодня технологии в принципе позволят создать AGI. Вероятность появления AGI без технологической революции Кришна оценил не более в чем 1 %. Простым масштабирование вычислительных мощностей, по-видимому, не обойтись. Скептически к идее ускорения создания AGI отнеслись и некоторые другие лидеры технологических компаний. Глава Salesforce Марк Бениофф (Marc Benioff) заявлял, что с «крайним подозрением» относится к продвижению AGI, сравнив процесс с гипнозом. Руководивший проектом Google Brain Эндрю Ын (Andrew Ng) говорил, что AGI «переоценен», а генеральный директор Mistral Артур Менш (Arthur Mensch) назвал AGI «маркетинговым ходом». По словам соучредителя OpenAI Ильи Суцкевера, эпоха масштабирования прошла, и даже стократное увеличение масштаба LLM не поможет сделать настоящий качественный скачок. Мир снова возвращается в эпоху исследований, только с очень большими компьютерами. Сам Кришна ничего против ИИ как такового не имеет. По его словам, ИИ-инструменты позволят предприятиям повысить эффективность, дав им триллионы долларов. Тем не менее, для AGI нужно больше технологий, чем просто современные LLM. Для его создания понадобится объединить LLM с «фундаментальными знаниями» (hard knowledge). Но даже в этом случае вероятность создания AGI можно отнести лишь к категории «возможно». Хотя оптимистичный прогноз NVIDIA снизил опасения по поводу возможного возникновения «пузыря» на рынке ИИ, о возможности его появления эксперты и участники отрасли высказывались неоднократно. При этом в ноябре The Wall Street Journal рассказал, что IT-гиганты вкладывают в отрасль всё больше средств, без оглядки на опасения.

03.12.2025 [13:40], Руслан Авдеев

ИИ-столбы: британский стартап Conflow Power разместит NVIDIA Jetson в уличных фонаряхБританский стартап Conflow Power Group намерен разместить ИИ-оборудование в уличных фонарях. Речь идёт об «умных» фонарях компании iLamp, которые дооснастят вычислительными модулями NVIDIA Jetson, сообщает Datacenter Dynamics. Базовый вариант модели сегодня обойдётся в £7,5 тыс. ($9,9 тыс.). Компания заявляет, что покупатели могли бы зарабатывать сами, требуя плату с ИИ-провайдеров за использование ИИ-оборудования. Ранее в 2025 году Conflow Power анонсировала проект iLamp — обычный фонарный столб, дополненный солнечными панелями и аккумуляторами. Кроме того, конструкция предусматривала поддержку 5G и Wi-Fi, модули управления дорожным движением, видеонаблюдение, датчики контроля окружающей среды и прочие компоненты. Для работы собственно iLamp требуется 80 Вт, но внешнее оборудование вроде Jetson сможет получать до 200–260 Вт.

Источник изображения: Conflow Power Group Conflow Power даже заявляет, что классические ЦОД можно заменить на iLamps, оснащённые модулями NVIDIA Jetson. Фактически речь идёт о создании распределённого дата-центра — экологически безопасного, не требующего водных ресурсов и с низкой задержкой, поскольку серверы находятся рядом с пользователями, говорит компания. По имеющимся данным, Conflow уже ведёт переговоры с несколькими компаниями и даже правительствами о внедрении новой технологии. Ранее в этом году бельгийский стартап Tonomia объявил о сотрудничестве с британским поставщиком ИИ-оборудования Panchaea для формирования eCloud — распределённой ИИ-платформы, размещаемой в системах солнечных панелей на автопарковках. Правда, eCloud предполагает использование более традиционных edge-серверов, а не Jetson AGX Thor или IGX Thor.

03.12.2025 [13:25], Сергей Карасёв

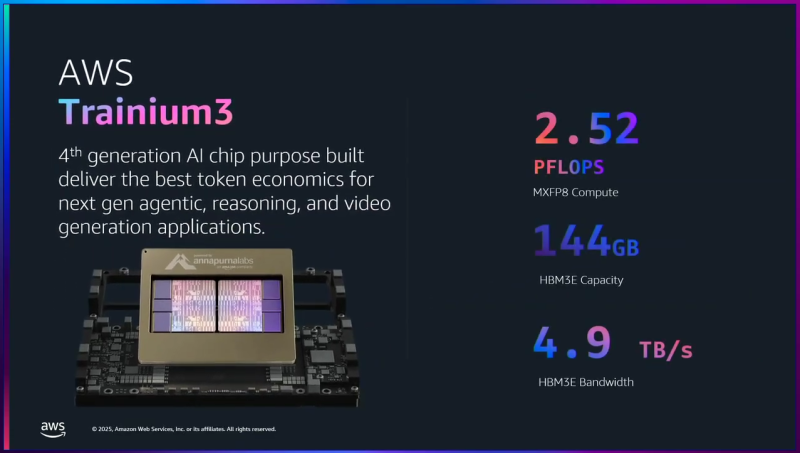

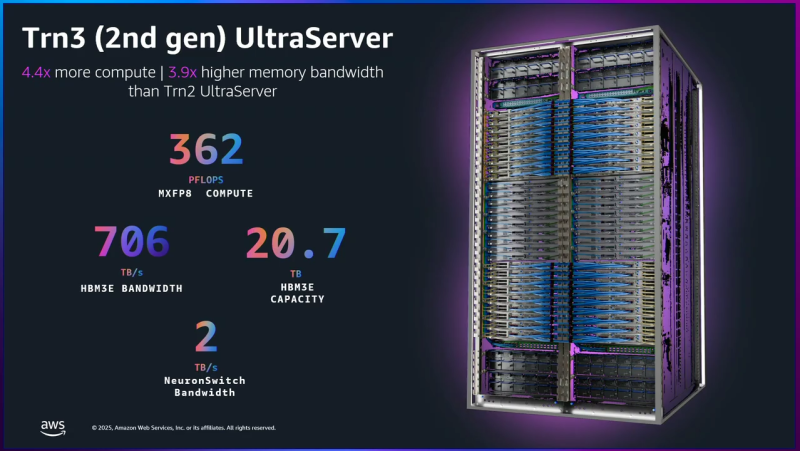

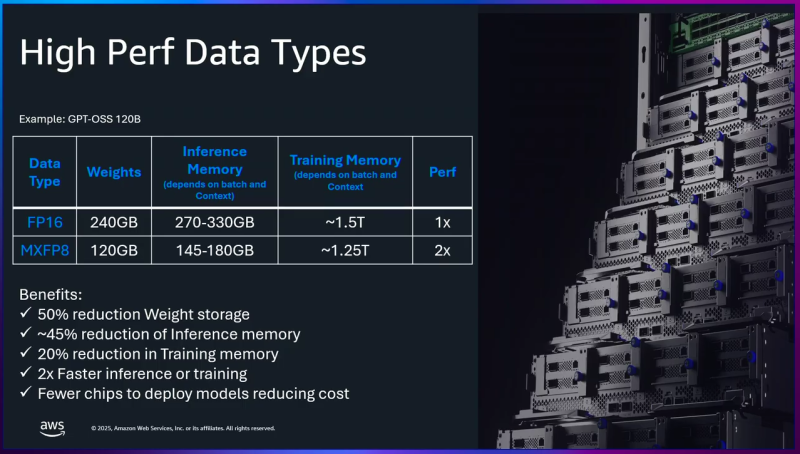

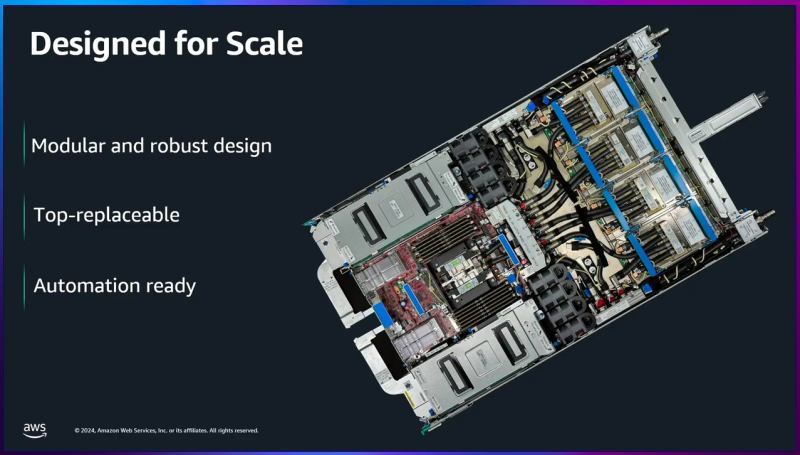

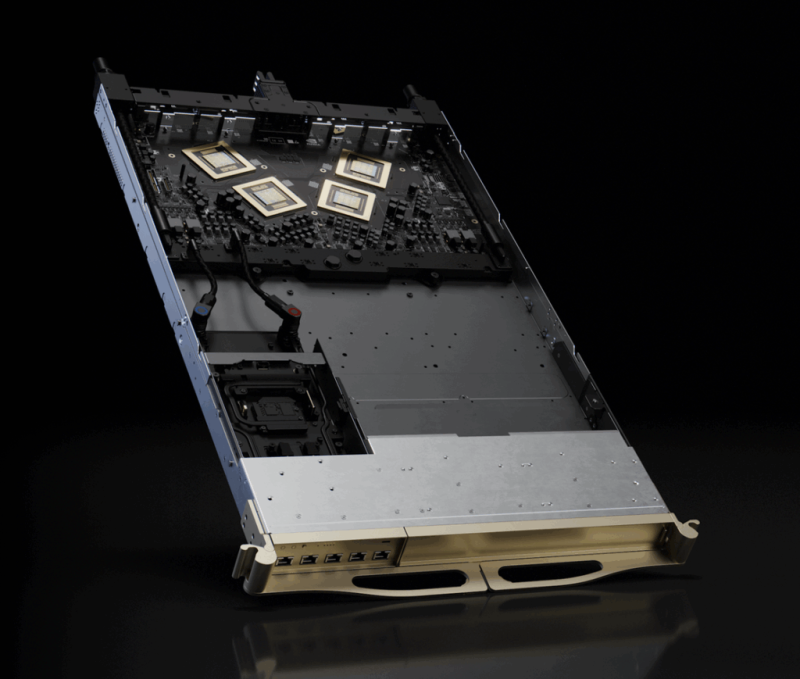

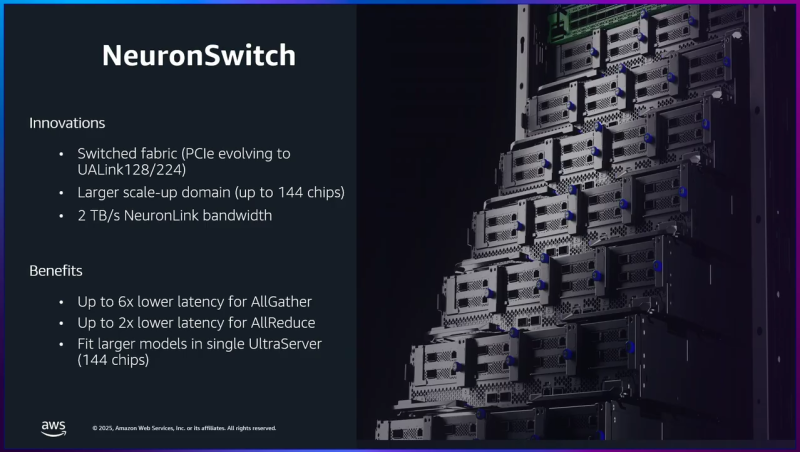

AWS представила ИИ-ускорители Trainium3: 144 Гбайт памяти HBM3E и 2,52 Пфлопс в режиме FP8Облачная платформа Amazon Web Services (AWS) анонсировала ускорители Trainium3 для задач ИИ, а также серверы Trainium3 UltraServer (Trn3 UltraServer). Эти машины, как утверждается, превосходят решения предыдущего поколения — Trainium2 UltraServer — в 4,4 раза по производительности, в 4 раза по энергоэффективности и почти в 4 раза по пропускной способности памяти. Чипы Trainium3 изготавливаются по 3-нм технологии TSMC. Они оснащены 144 Гбайт памяти HBM3E с пропускной способностью до 4,9 Тбайт/с. По сравнению с Trainium2 объём памяти увеличился в 1,5 раза, её пропускная способность — в 1,7 раза. Ранее сообщалось, что энергопотребление новых ускорителей может достигать 1 кВт. Изделие Trainium3 предназначено для высокоплотных и сложных параллельных рабочих нагрузок с использованием расширенных типов данных (MXFP8 и MXFP4). По утверждениям AWS, на операциях FP8 быстродействие достигает 2,52 Пфлопс. Для сравнения, AMD Instinct MI355X показывает результат в 10,1 Пфлопс, а чип поколения NVIDIA Blackwell — 9 Пфлопс. Как уточняет The Register, ускорители Trainium3 используют структурированную разрежённость (structured sparsity) формата 16:4, что фактически поднимает производительность в четыре раза — до 10 Пфлопс — на таких задачах, как обучение ИИ-моделей. Системы Trainium3 UltraServer объединяют 144 ускорителя Trainium3, которые соединены посредством интерконнекта NeuronSwitch-v1: эта технология, по оценкам AWS, увеличивает пропускную способность в два раза по сравнению с машинами UltraServer предыдущего поколения. Усовершенствованная сетевая архитектура Neuron Fabric сокращает задержки при передаче данных между чипами до менее чем 10 мкс. Каждая система Trainium3 UltraServer оперирует 20,7 Тбайт памяти HBM3E с общей пропускной способностью 706 Тбайт/с. Заявленная производительность достигает 362 Пфлопс в режиме FP8. Применённые в Trainium3 технологии, как заявляет AWS, дают возможность создавать приложения ИИ с практически мгновенным откликом. Платформа EC2 UltraClusters 3.0 позволяет объединять тысячи систем UltraServer, содержащих до 1 млн ускорителей Trainium, что в 10 раз больше, чем в случае изделий предыдущего поколения. При этом следующее поколение ускорителей Trainium4 получит интерконнект NVLink Fusion шестого поколения.

03.12.2025 [01:28], Владимир Мироненко

AWS «сдалась на милость» NVIDIA: анонсированы ИИ-ускорители Trainium4 с шиной NVLink FusionAWS готовит Arm-процессоры Graviton5, которые составят компанию ИИ-ускорителям Trainium4 с интерконнектом NVLink Fusion, фирменными EFA-адаптерам и DPU Nitro 6 с движком Nitro Isolation Engine. Но что более важно, все они будут «упакованы» в стойки стандарта NVIDIA MGX. Amazon и NVIDIA объявили о долгосрочном партнёрстве, в рамках которого ИИ-ускорители Trainium4 получит шину NVIDIA NVLink Fusion шестого поколения (по-видимому, 3,6 Тбайт/с в дуплексе), которая позволит создать стоечную платформу нового поколения, причём, что интересно, на базе архитектуры NVIDIA MGX, которая передана в OCP. Пикантность ситуации в том, что AWS годами практически игнорировала OCP, самостоятельно создавая стойки, их компоненты, включая СЖО, и архитектуру ИИ ЦОД в целом. Даже в нынешнем поколении стоек с GB300 NVL72 отказалась от референсного дизайна NVIDIA. NVIDIA же напирает на то, что для гиперскейлерам крайне трудно заниматься кастомными решениями — циклы разработки стоечной архитектуры занимают много времени, поскольку помимо проектирования специализированного ИИ-чипа, гиперскейлеры должны озаботиться вертикальным и горизонтальным масштабированием, интерконнектами, хранилищем, а также самой конструкцией стойки, включая лотки, охлаждение, питание и ПО.

Источник изображения: NVIDIA Вместе с тем управление цепочкой поставок отличается высокой сложностью, так как требуется обеспечить согласованную работу десятков поставщиков, ответственных за десятки тысяч компонентов. И даже одна задержка поставки или замена одного компонента может поставить под угрозу весь проект. Платформа NVIDIA если не устраняет целиком, то хотя бы смягчает эти проблемы, предлагая готовые стандартизированные решения, которые могут поставлять множество игроков рынка. По словам NVIDIA, в отличие от других подходов к масштабированию сетей, NVLink — проверенная и широко распространённая технология. В сочетании с фирменным ПО NVLink Switch обеспечивает увеличение производительности и дохода от ИИ-инференса до трёх раз, объединяя 72 ускорителя в одном домене. Пользователи, внедрившие NVLink Fusion, могут использовать любую часть платформы — каждый компонент может помочь им быстро масштабироваться для удовлетворения требований интенсивного инференса и обучения моделей агентного ИИ, говорит NVIDIA. Что касается самих ускорителей Trainium4, то в сравнении с Trainium3 они будут вшестеро быстрее в FP4-расчётах, втрое быстрее в FP8-вычислениях, а пропускная способность памяти будет увеличена вчетверо. Впрочем, пока собственные ускорители Amazon не всегда могут составить конкуренцию чипам NVIDIA. Любопытно и то, что в рассказе о Trainium3 компания отметила о переходе от PCIe к UALink в коммутаторах NeuronSwitch для фирменного интерконнекта NeuronLink, объединяющего до 144 чипов Trainium. Однако после крупных инвестиций NVIDIA в Synopsys развитие UALink как открытой альтернативы NVLink теперь под вопросом.

02.12.2025 [18:20], Сергей Карасёв

Российская ИИ-система Delta Sprut XL поддерживает до 25 GPU

delta computers

gpu

granite rapids

h200

hardware

intel

nvidia

ocp

rtx

sierra forest

xeon

ии

сделано в россии

сервер

Российская компания Delta Computers представила OCP-систему Delta Sprut XL, предназначенную для ресурсоёмких нагрузок, таких как обучение ИИ-моделей, инференс, научное моделирование и задачи HPC. В основу новинки положена аппаратная платформа Intel Xeon 6. CPU-секция допускает установку двух процессоров Sierra Forest-SP или Granite Rapids-SP с показателем TDP до 330 и 350 Вт соответственно: в первом случае могут быть задействованы в общей сложности до 288 E-ядер, во втором — до 172 P-ядер. Доступны 32 слота для модулей оперативной памяти DDR5-6400 RDIMM или DDR5-8000 MRDIMM суммарным объёмом до 8 Тбайт. Могут быть установлены четыре SFF-накопителя U.2 толщиной 15 мм с интерфейсом PCIe 5.0 (NVMe) или восемь таких SSD толщиной 7 мм. Кроме того, есть два коннектора M2.2280 (PCIe). Реализованы четыре слота PCIe 5.0 x16 для карт типоразмера HHHL и слот OCP 3.0 (PCIe 5.0). Присутствуют разъёмы USB 3.0 Type-A и miniDP, а также выделенный сетевой порт управления 1GbE. В системе Delta Sprut XL ускорители на базе GPU устанавливаются в отдельные модули. В общей сложности могут использоваться до 20 карт NVIDIA H200 или до 25 экземпляров NVIDIA RTX Pro 6000 Blackwell Server Edition. Каждый квартет NVIDIA H200 объединён при помощи NVLink. «Delta Computers представляет GPGPU-платформу, способную консолидировать до 20 ускорителей NVIDIA H200 в одном кластере. При этом необходимость использования InfiniBand или 400GbE появляется лишь в случае потребности у заказчика в ещё большем количестве ускорителей — при таком сценарии предусмотрены отдельные слоты расширения для объединения нескольких платформ Delta Sprut XL в единый кластер», — отмечает компания. Питание обеспечивается посредством централизованного шинопровода OCP на 12 или 48 В. Применено встроенное ПО Delta BMC, предназначенное для мониторинга (сбор телеметрии, отслеживание состояния платформы, её модулей и компонентов) и удалённого администрирования серверного оборудования. Эта прошивка включена в реестр Минцифры РФ и сертифицирована ФСТЭК.

02.12.2025 [12:41], Руслан Авдеев

Американский ИИ-стартап ищет деньги, чтобы снабдить китайцев чипами NVIDIA через ЯпониюБазирующийся в США стартап PaleBlueDot AI ищет, у кого бы занять $300 млн, чтобы купить ускорители NVIDIA и разместить их в токийском ЦОД — и всё это в интересах китайской медиакомпании RedNote (Xiaohongshu), сообщает Bloomberg. В своё время RedNote получила известность за пределами КНР благодаря временному запрету TikTok в Соединённых Штатах — тогда американцы начали массово регистрироваться в китайской соцсети. PaleBlueDot AI из Кремниевой долины обратилась к банкам и частным кредитным компаниям для получения финансирования. Сообщается, что JPMorgan Chase & Co. причастен к подготовке маркетинговых материалов для потенциальных заёмщиков, но от участия в самой сделке, вероятно, откажется. Источники утверждают, что сделка обсуждается, как минимум, в последние три месяца, хотя неизвестно, каков прогресс. По словам PaleBlueDot AI, «упомянутая информация не соответствует действительности», в JPMorgan от комментариев отказались, а NVIDIA и Xiaohongshu просто не ответили на запросы. PaleBlueDot AI позиционирует себя как посредника, предлагающего безопасные и экономически эффективные вычислительные решения. Примечательно, что у истоков компании и в её руководстве числятся бизнесмены китайского происхождения.

Источник изображения: zhang kaiyv/unsplash.com Планируемый заём наглядно демонстрирует, как именно намерены технологические компании обходить ограничения на продажу в Китай передовых ИИ-чипов, неоднократно ужесточавшиеся с 2022 года. Хотя китайские компании теперь не могут покупать оборудование напрямую, они могут вполне легально получать доступ к ЦОД в странах за пределами Китая. Буквально на днях сообщалось, что Alibaba и ByteDance стали обучать передовые ИИ-модели в дата-центрах Юго-Восточной Азии. Финансирование подобных проектов всегда воспринимается с осторожностью. Это связано с озабоченностью тем, что американские власти могут наложить дополнительные санкции. Хотя сама NVIDIA давно критикует политику полных запретов поставок ИИ-чипов в Китай, компания постоянно обещает, что будет строго придерживаться политики, предотвращающей попадание чипов «не в те руки». Впрочем, подход американских властей может измениться. По слухам, уже рассматривается возможность поставок в КНР относительно устаревших вариантов — NVIDIA H200.

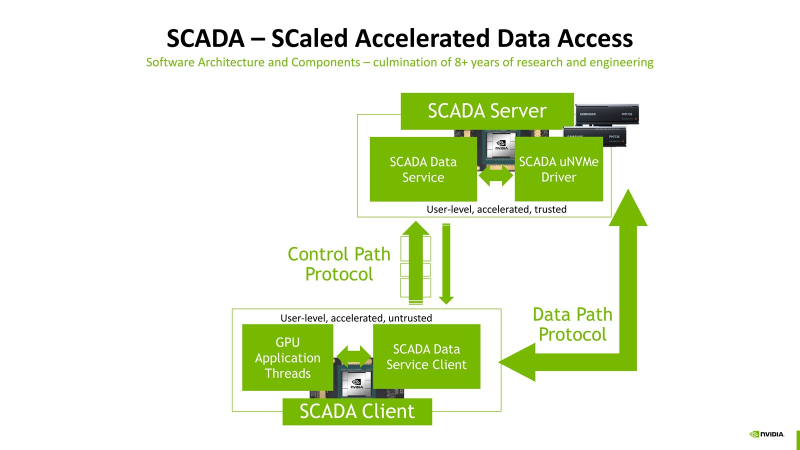

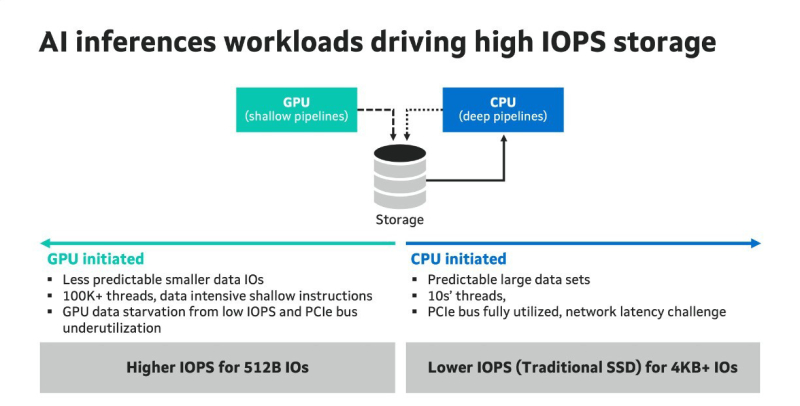

02.12.2025 [09:39], Владимир Мироненко

Миллионы IOPS, без посредников: NVIDIA SCADA позволит GPU напрямую брать данные у SSDNVIDIA разрабатывает SCADA (Scaled Accelerated Data Access, масштабируемый ускоренный доступ к данным) — новую IO-архитектуру, где GPU инициируют и управляют процессом работы с хранилищами, сообщил Blocks & Files. SCADA отличается от существующего протокола NVIDIA GPUDirect, который, упрощённо говоря, позволяет ускорить обмен данными с накопителями, напрямую связывая посредством RDMA память ускорителей и NVMe SSD. В этой схеме CPU хоть и не отвечает за саму передачу данных, но оркестрация процесса всё равно ложится на его плечи. SCADA же предлагает перенести на GPU и её. Обучение ИИ-моделей обычно требует передачи больших объёмов данных за сравнительно небольшой промежуток времени. При ИИ-инференсе осуществляется передача небольших IO-блоков (менее 4 Кбайт) во множестве потоков, а время на управление каждой передачей относительно велико. Исследование NVIDIA показало, что инициирование таких передач самим GPU сокращает время и ускоряет инференс. В результате была разработана схема SCADA. NVIDIA уже сотрудничает с партнёрами по экосистеме хранения данных с целью внедрения SCADA. Так, Marvell отмечает: «Потребность в ИИ-инфраструктуре побуждает компании, занимающиеся СХД, разрабатывать SSD, контроллеры, NAND-накопители и др. технологии, оптимизированные для поддержки GPU, с акцентом на более высокий показатель IOPS для ИИ-инференса. Это будет принципиально отличаться от технологий для накопителей, подключенных к CPU, где главными приоритетами являются задержка и ёмкость». По словам Marvell, в рамках SCADA ускорители используют семантику памяти при работе с накопителями. Однако сами SSD мало подходят для таких задач, поскольку не могут обеспечить необходимый уровень IOPS, когда во время инференса тысячи параллельных потоков запрашивают наборы данных размером менее 4 Кбайт. Это приводит к недоиспользованию шины PCIe, «голоданию» GPU и пустой трате циклов. В CPU-центричной архитектуре, которая подходит для обучения моделей, параллельных потоков данных десятки, а не тысячи, а блоки данных крупные — от SSD требуется высокие ёмкость и пропускная способность, а также малая задержка, поскольку свою задержку в рамках СХД также внесут PCIe и Ethernet. Внедрение PCIe 6.0 и PCIe 7.0, конечно, само по себе ускорит обмен данными, но контроллеры SSD также нуждаются в обновлении. Они должны уметь использовать возможности SCADA, иметь оптимальные схемы коррекции ошибок для малых блоков данных и быть мультипротокольными (PCIe, CXL, Ethernet). Компания Micron также участвует в разработке SCADA. В рамках SC25 Micron показала прототип SCADA-хранилища на базе платформы H3 Platform Falcon 6048 с PCIe 6.0 (44 × E1.S NVMe SSD + 6 × GPU/DPU/NIC), оснащённой 44 накопителями Micron 9650 (7,68 Тбайт, до 5,4 млн на случайном чтении 4K-блоками с глубиной очереди 512, PCIe 6.0), тремя коммутаторами Broadcom PEX90000 (144 линии PCIe 6.0 в каждом), одним процессором Intel Xeon (PCIe 5.0) и тремя ускорителями NVIDIA H100 (PCIe 5.0). Micron заявила, что система «демонстрирует линейное масштабирование производительности от 1 до 44 SSD», доходя до 230 млн IOPS, что довольно близко к теоретическому максимуму в 237,6 млн IOPS. «В сочетании с PCIe 6.0 и высокопроизводительными SSD архитектура [SCADA] обеспечивает доступ к данным в режиме реального времени для таких рабочих нагрузок, как векторные базы данных, графовые нейронные сети и крупномасштабные конвейеры инференса», — подытожила Micron. |

|