Материалы по тегу: а

|

04.04.2025 [08:44], Сергей Карасёв

Объём мирового рынка генеративного ИИ в 2024 году вырос более чем в четыре раза, но заработали на нём в основном поставщики оборудованияКомпания Gartner подвела итоги исследования глобального рынка генеративного ИИ (GenAI) в 2024 году: расходы достигли $364,96 млрд, что на 336,7 % больше по сравнению с предыдущим годом, когда объём отрасли оценивался в $83,57 млрд. Аналитики полагают, что в дальнейшем затраты продолжат увеличиваться, но темпы роста снизятся. Gartner учитывает поставки ИИ-серверов и различного оборудования, включая персональные компьютеры с поддержкой ИИ, а также расходы в сегменте ПО и услуг. Основную часть выручки приносят аппаратные решения. В частности, в 2024 году продажи серверов для задач ИИ, по оценкам, достигли $135,64 млрд — это на 154,7 % больше, чем годом ранее. Всевозможные устройства с функциями ИИ обеспечили $199,6 млрд с ростом на 845,5 % в годовом исчислении. В сегменте ПО отмечен рост на 255,1 % — до $19,16 млрд, тогда как услуги принесли $10,57 млрд, показав прибавку в 177,0 % по отношению к 2023-му. Аналитики Gartner прогнозируют, что в 2025 году затраты на мировом рынке GenAI увеличатся на 76,4 %, достигнув $643,86 млрд. Причём около 80 % от этой суммы придётся на оборудование. Ожидается, что продажи серверов в годовом исчислении поднимутся на 33,1 %, составив $180,62 млрд. Всевозможные устройства с ИИ принесут $398,32 млрд, показав рост на 99,5 %. В сегменте ПО прогнозируется прибавка в 93,9 % — до $37,16 млрд. Услуги обеспечат около $27,76 млрд с ростом на 162,6 % по сравнению с 2024 годом. В целом, аналитики полагают, что технологии ИИ станут неотъемлемой частью многих бизнес-операций и продуктов для корпоративного и потребительского секторов.

03.04.2025 [16:47], Руслан Авдеев

Google готовится к аренде ИИ-серверов с ускорителями NVIDIA Blackwell у CoreWeaveКомпания Google близка к тому, чтобы согласиться на сделку с CoreWeave. Предполагается, что гиперскейлер будет арендовать у последней серверы, оснащённые ускорителями серии NVIDIA Blackwell, сообщает The Information. Сделка находится на «поздних стадиях» согласования. Благодаря ей Google сможет получить доступ к большему количеству новейших ИИ-ускорителей. Об этом издание сообщает со ссылкой на два анонимных источника, знакомых с вопросом. Ещё два источника добавили, что Google уже пыталась договориться с конкурентами CoreWeave о доступе к свободным ускорителям — судя по всему, компании не хватает доступных вычислительных мощностей. Возможные партнёры пока не комментируют ситуацию. По информации Seeking Alpha, на момент закрытия торгов в среду акции CoreWeave выросли на 16 %, колебания курсов акций Google и NVIDIA оказались незначительными. По данным The Information, отдельно Google и CoreWeave ведут переговоры об аренде площадей в дата-центрах последней — там Google сможет разместить тензорные ускорители (TPU) собственной разработки, которые компания довольно успешно внедряет наряду с решениями NVIDIA.

Источник изображения: Microsoft Edge/unsplash.com Потенциальное соглашение косвенно свидетельствует о проблемах компаний, желающих пользоваться ускорителями NVIDIA, но не имеющих возможности удовлетворить спрос в полной мере. Уникальные отношения CoreWeave и NVIDIA и возможности оператора ЦОД предоставлять в распоряжение новые ИИ-мощности привлекают крупные облачные сервисы и ключевых ИИ-разработчиков вроде OpenAI и Meta✴. По данным Investing.com, за последние несколько дней крупные ИИ-структуры вроде xAI и OpenAI публично озвучивали необходимость увеличения доступных вычислительных ресурсов. Буквально на днях CoreWeave вышла на IPO — правда, планы развития компании могут оказаться под вопросом, поскольку средств привлечено меньше, чем ожидалось, а капитализация её оказалась значительно меньше, чем рассчитывалось. UPD 29.06.2025: Google действительно арендует ускорители у CoreWeave, но только для того, чтобы сдать их OpenAI. Вероятно, это часть более крупной сделки, в рамках которой OpenAI, по слухам, также начнёт использовать фирменные ускорители Google TPU.

03.04.2025 [16:42], Владимир Мироненко

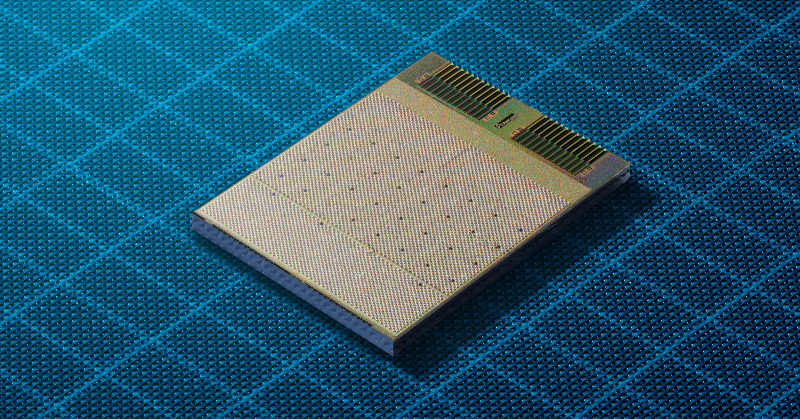

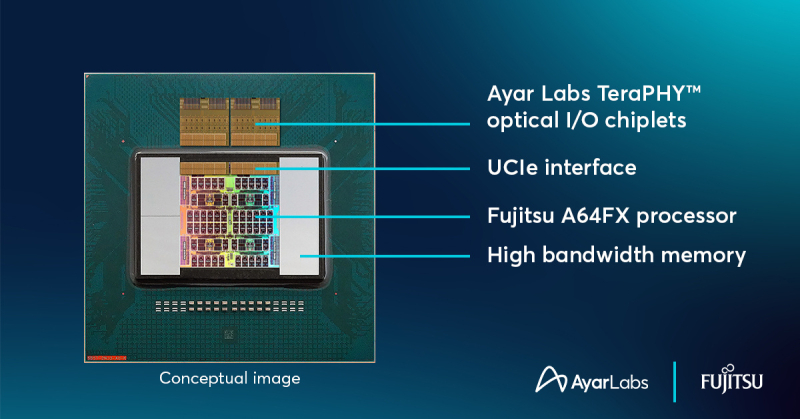

Ayar Labs анонсировала фотонный UCIe-чиплет TeraPHY с пропускной способностью 8 Тбит/сКомпания Ayar Labs, занимающаяся разработкой интерконнекта на базе кремниевой фотоники, анонсировала чиплет оптического I/O TeraPHY, способный обеспечить пропускную способность 8 Тбит/с и использующий оптический источник света SuperNova с поддержкой 16 длин волн. Чиплет поддерживает интерфейс Universal Chiplet Interconnect Express (UCIe), что означает возможность объединения в одном решении чиплетов от разных поставщиков. Ayar Labs отметила, что совместимость со стандартом UCIe позволяет создать более доступную и экономичную экосистему, которая упрощает внедрение передовых оптических технологий, необходимых для масштабирования рабочих ИИ-нагрузок и преодоления ограничений традиционных медных соединений. Ayar Labs сообщила, что объединила кремниевую фотонику с производственными процессами CMOS, чтобы обеспечить использование оптических соединений в форм-факторе чиплета в многочиповых корпусах. Это позволяет GPU и другим ускорителям взаимодействовать на широком диапазоне расстояний, от миллиметров до километров, при этом эффективно функционируя как единый гигантский ускоритель. Ранее компания совместно с Fujitsu показал концепт процессора A64FXс UCIe-чиплетом TeraPHY. Марк Уэйд (Mark Wade), генеральный директор и соучредитель Ayar Labs заявил, что в компании давно увидели потенциал совместно упакованной оптики (CPO), и поэтому занялись внедрением оптических решений в ИИ-приложениях. «Продолжая расширять границы оптических технологий, мы объединяем цепочку поставок, производство, а также процессы тестирования и проверки, необходимые клиентам для масштабного развёртывания этих решений», — подчеркнул он. Среди партнёров Ayar Labs крупнейшие компании отрасли, включая AMD, Intel, NVIDIA и TSMC. В последнем раунде финансирования, прошедшем в декабре прошлого года, компания привлекла $155 млн. Рыночная стоимость Ayar Labs, по оценкам, составляет $1 млрд.

03.04.2025 [15:26], Руслан Авдеев

В Пенсильвании построят газовую электростанцию мощностью 4,5 ГВт для ИИ ЦОД на месте заброшенной угольнойНа месте крупнейшей угольной электростанции Пенсильвании появится новая газовая станция мощностью 4,5 ГВт. Проект предполагает создание ЦОД для ИИ и HPC, а станцию должны ввести в эксплуатацию в 2027 году, сообщает The Register. За реализацию проекта отвечает Homer City Redevelopment (HCR). Потребуется порядка $10 млрд только на развитие энергетической инфраструктуры и подготовку площадки. Ещё миллиарды уйдут на строительство самого дата-центра. Электростанция и ЦОД будут находиться рядом друг с другом. Для преобразования угольных мощностей в газовые потребуется полная перестройка объекта. Зато можно будет использовать оставшуюся энергетическую инфраструктуру, включая линии электропередач и подстанции. HCR не рассказывает о будущих арендаторах, основное внимание уделяется подготовке дата-центра и энергетической инфраструктуре. Проект ориентирован на обеспечение работы ИИ-платформ и гиперскейлеров. Предусмотрено использование газовых турбин General Electric Vernova (GE Vernova), сообщает пресс-служба HCR. Установки предназначены для работы на природном газе, но в будущем их могут перевести и на водород. Впрочем, пока сроки поставок «зелёного» водорода — под вопросом. Хотя предполагается использование в генераторах природного газа, проект позиционируется как «низкоуглеродный», поскольку, по данным HCR, новая станция позволяет сократить выбросы парниковых газов на 60–65 % в сравнении с угольными мощностями, ранее работавшими там же.

Источник изображения: silas Tarus/unsplash.com Место выбрали не случайно. Территория бывшей угольной электростанции в Хомер-Сити (Homer City) уже имеет инфраструктуру, включая линии электропередач, подстанции и доступ к воде. Благодаря этому строительство и подключение к энергосистеме ускорятся и упростятся. Стройка, которую возглавит Kiewit Power Constructors, должна начаться уже в 2025 году, первые турбины планируют установить в 2026 году, а ввод в эксплуатацию намечен на 2027 год, как раз к появлению 600-кВт стоек NVIDIA Rubin Ultra NVL576. Новые электростанции для дата-центров — один из последних трендов в деле обеспечения энергией ИИ ЦОД. Meta✴ строит дата-центр для ИИ в Луизиане и совместно с Entergy готовят газовую электростанцию на 2,2 ГВт. Её также могут перевести на водород в будущем. Microsoft заключила соглашение с Constellation Energy о перезапуске реактора АЭС Three Mile Island. Amazon (AWS) приобрела кампус Cumulus Data в Пенсильвании, расположенный рядом с атомной электростанцией Susquehanna. Meta✴ и Oracle также активно изучают возможности ядерной энергетики. Первая рассчитывает приобрести до 4 ГВт атомной энергии к 2030-м годам, а Oracle намерена построить дата-центр на 1 ГВт с питанием от трёх малых модульных реакторов (SMR). Наконец, в марте появились новости о том, что и Crusoe, и Chevron получат газовые турбины GE Vernova для снабжения электричеством своих ЦОД, тоже по 4,5 ГВт — пока остаётся только догадываться, не идёт ли во всех случаях речь об одних и тех же турбинах. В конце марта сообщалось, что производители газовых генераторов с трудом справляются с заказами для ИИ ЦОД, но расширять производство опасаются из-за возможной низкой маржинальности проектов.

03.04.2025 [12:50], Руслан Авдеев

Ближневосточный след: Cerebras Systems развеяла сомнения регулятора CFIUS в благонадёжности перед выходом на IPOCerebras Systems, разрабатывающая ИИ-ускорители, объявила о решении основных проблем с Комитетом США по иностранным инвестициям (CFIUS) перед выходом на IPO. Главным предметом беспокойства CFIUS стала связь американского стартапа с компанией G42 из ОАЭ, сообщает The Register. На G42, согласно поданным данным о доходах, пришлось более 87 % выручки Cerebras в I половине 2024 года. При этом с середины 2023 года экспорт ИИ-ускорителей в страны Ближнего Востока строго регулируется США. От разработчиков чипов из США требуется получение экспортных лицензий для продажи товаров в регионе. В результате G42 финансировала строительство ИИ-суперкомпьютеров на основе чипов Cerebras на территории США, а общая сумма проектов составила порядка $900 млн. Компания планировала получать к ним удалённый доступ. В рамках IPO G42 также собиралась купить 22 млн акций Cerebras, что, вероятно, вызвало настороженность CFIUS. Ранее G42 уже привлекала внимание американских властей, опасающихся, что закупающая большие объёмы ускорителей на Ближнем Востоке компания может работать на Китай. В результате G42 была вынуждена разорвать связи с рядом партнёров, включая Huawei, рассчитывая «умиротворить» американских регуляторов и устранить препятствия для сотрудничества с Cerebras и Microsoft.

Источник изображения: Nimisha Mekala/unsplash.com В Cerebras заявили, что компания развеяла опасения CFIUS, внеся поправки в соглашение с G42 — последняя сможет приобретать только «неголосующие» акции, поэтому дальнейшая проверка, вероятно, не потребуется. Впрочем, стороны пока не дают дополнительных комментариев. Тем не менее, руководство Cerebras отметило в одной из социальных сетей, что при тесном сотрудничестве с G42 удалось достичь урегулирования с CFIUS. Новости появились менее чем через неделю после того, как ведущие СМИ сообщили, что дебют Cerebras на фондовом рынке был отложен из-за ожидания новых ключевых назначений в администрации США. Условия IPO пока не разглашаются, но ранее сообщалось, что компания намерена привлечь до $1 млрд, а её капитализация составит $7–8 млрд. G42 останется одним из ключевых клиентов Cerebras, но стартап очевидно ориентирован на диверсификацию клиентской базы благодаря платформе «инференс как сервис» и создание масштабной инфраструктуры в США, Канаде и Франции. К концу 2025 года стартап пообещал развернуть более тысячи ускорителей в шести новых ЦОД. Хотя на первый взгляд это не так много в сравнении сотнями тысяч ускорителей, внедряемых xAI и другими компаниями, стоит отметить, что чипы Cerebras размером с целую кремниевую пластину способны обеспечивать производительность до 125 Пфлопс (FP16) — приблизительно в 62 раза выше, чем у моделей серии NVIDIA H100, применяемых для создания суперкомпьютера Colossus с Мемфисе (Теннесси).

02.04.2025 [20:32], Владимир Мироненко

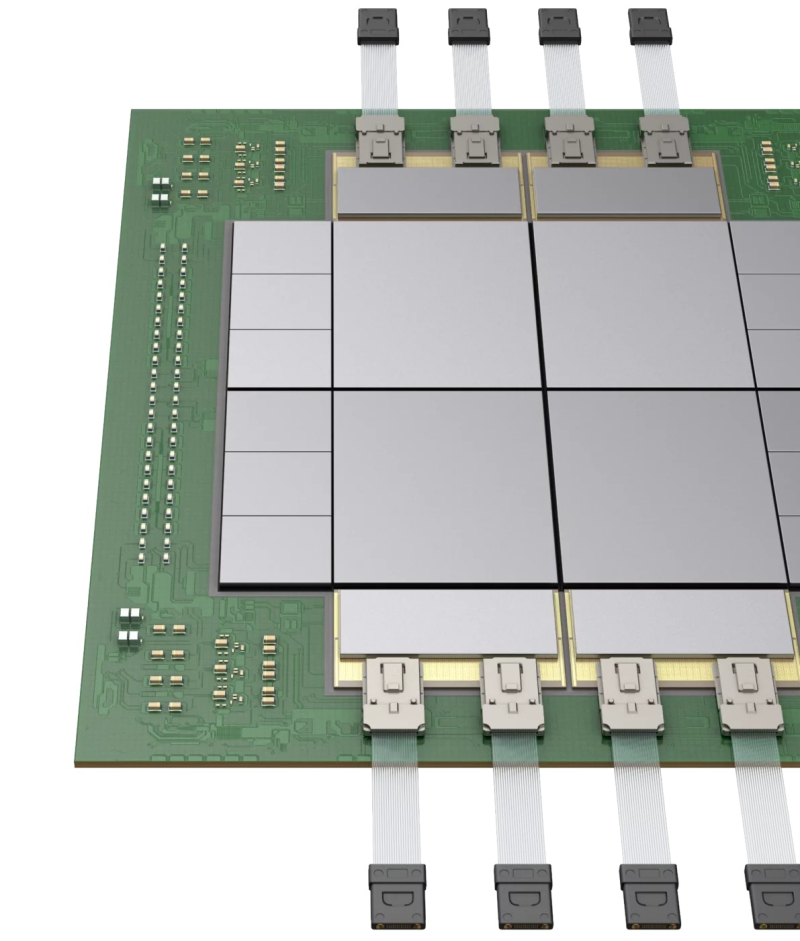

Lightmatter анонсировала оптический интерконнект CPO Passage L200 и фотонный 3D-суперчип Passage M1000Lightmatter анонсировала оптический интерконнект 3D co-packaged optics (CPO) Passage L200, разработанный для интеграции с новейшими дизайнами GPU и XPU, а также коммутаторами, предназначенный для обеспечения значительного увеличения скорости обработки ИИ-нагрузок в огромных кластерах из тысяч ускорителей, благодаря устранению узких мест в полосе пропускания интерконнекта. Семейство L200 3D CPO включает версии на 32 Тбит/с (L200) и 64 Тбит/с (L200X), что в 5–10 раз превышает возможности существующих решений. L200 позволяет размещать несколько GPU в одной упаковке, обеспечивая более 200 Тбит/с общей полосы пропускания I/O, что позволяет ускорить обучение и инференс ИИ-моделей до восьми раз.

Источник изображений: Lightmatter В обычных ЦОД ускорители соединены между собой с помощью массива сетевых коммутаторов, которые образуют многоуровневую иерархию. Эта архитектура создает слишком большую задержку, поскольку для того, чтобы один ускоритель мог взаимодействовать с другим, сигнал должен пройти через несколько коммутаторов. Как сообщил ранее в интервью ресурсу SiliconANGLE генеральный директор Lightmatter Ник Харрис (Nick Harris), Passage решает проблему громоздких сетевых соединений, интегрируя свою сверхплотную оптоволоконную технологию в чипы, чтобы улучшить пропускную способность в 100 раз по сравнению с лучшими решениями, используемыми сегодня. «Таким образом, вместо шести или семи слоев коммутации у вас есть два, и каждый GPU может подключаться к тысячам других», — пояснил он. Lightmatter назвала свою архитектуру интерконнекта «I/O без границ» (edgeless I/O) и заявила, что она может масштабировать пропускную способность по всей площади кристалла на GPU, в то время как традиционные кристаллы могут подключаться к другим кристаллам только на краю (shoreline). Интеграция Passage 3D позволяет размещать SerDes-блоки в любом месте кристалла, а не ограничиваться его краями, обеспечивая пропускную способность эквивалентную 40 подключаемых оптических трансиверов. Сообщается, что модульное решение 3D CPO использует стандартный совместимый интерфейс UCIe die-to-die (D2D) и упрощает масштабируемую архитектуру на основе чиплетов для бесшовной интеграции с XPU и коммутаторами следующего поколения. Компания заявила, что грядущий L200 CPO разработан для крупносерийного производства, и она тесно сотрудничает для его подготовки с партнёрами по производству полупроводников, такими как Global Foundries, ASE и Amkor, а также передовыми производителями CMOS. В серийное производство Lightmatter L200 и L200X поступят в следующем году. Lightmatter также анонсировала референсную платформу Passage M1000 — фотонный 3D-суперчип (3D Photonic Superchip), разработанный для XPU и коммутаторов следующего поколения. Passage M1000 обеспечивает рекордную общую оптическую пропускную способность на уровне 114 Тбит/с для самых требовательных приложений ИИ-инфраструктуры. M1000 площадью более 4000 мм² представляет собой многосетчатый активный фотонный интерпозер, который позволяет клиентам создавать свои собственные кастомные соединения с использованием кремниевой фотоники, обеспечивая подключение к множеству GPU в одной 3D-упаковке. Как сообщается, Passage M1000 позволяет преодолеть ограничение по подключению по краям, обеспечивая I/O практически в любом месте на своей поверхности для комплекса кристаллов, размещённых сверху. Интерпозере оснащён обширной и реконфигурируемой сетью волноводов, которая передает WDM-сигналы по всему M1000. Благодаря полностью интегрированному соединению с поддержкой 256 волокон с пропускной способностью 448 Гбит/с на волокно, M1000 обеспечивает на порядок более высокую пропускную способность в меньшем размере корпуса по сравнению с обычными структурами Co-Packaged Optics (CPO) и аналогичными предложениями. Поставки Passage M1000 начнутся этим летом. Среди инвесторов Lightmatter крупные технологические компании, такие как Alphabet и HPE. В последнем раунде финансирования, прошедшем в октябре 2024 года, Lightmatter привлекла $400 млн инвестиций, в результате чего сумма привлечённых компанией средств достигла $850 млн, а её рыночная стоимость теперь оценивается в $4,4 млрд.

02.04.2025 [18:06], Руслан Авдеев

Arm собиралась купить Alphawave ради передовой технологии SerDes для выпуска ИИ-чипов — теперь её хочет купить QualcommПринадлежащий SoftBank разработчик архитектурных решений для полупроводников — компания Arm недавно собиралась приобрести британскую Alphawave для получения критически важной технологии, необходимой для создания ИИ-ускорителей. Об этом сообщили Reuters три независимых источника, «знакомых с вопросом». Теперь над покупкой Alphawave раздумывает Qualcomm, уточняет SiliconAngle. Alphawave владеет интеллектуальной собственностью, связанной с полупроводниковыми технологиями, и даже обсуждала с инвестиционными банкирами возможность продажи — после того как Arm и другие потенциальные покупатели выразили интерес к приобретению компании. Однако, по данным двух источников, в итоге было решено отказаться от сделки. На фоне новостей акции Alphawave взлетели на 21 % — рекордный рост с сентября 2021 года. По данным на конец торгов в понедельник капитализация компании составила £707 млн ($914 млн), а цена акции — 93,5 пенса. Arm рассчитывала получить от Alphawave технологию создания SerDes-блоков, которые определяют скорость передачи данных на чип и с него. Эта технология критически важна для ИИ-систем, таких как ChatGPT, где тысячи чипов должны работать согласованно. Так, SerDes является ключевым преимуществом Broadcom, помогая компании привлекать клиентов вроде Google и OpenAI.

Источник изображения: Arm Arm с головным офисом в Великобритании на 90 % принадлежит японской SoftBank Group. Компания сама не разрабатывает чипы, а продаёт «основные строительные блоки» для их создания, а также прочую интеллектуальную собственность. Основные доходы Arm получает за счёт лицензионных отчислений от других бизнесов, а также роялти за каждый проданный чип, использующий её технологии. Недавно сообщалось, что она рассчитывает, что её архитектура займёт 50 % на рынке чипов для ЦОД уже к концу 2025 года. У AWS, Google Cloud и Microsoft Azure уже есть собственные серверные Arm-процесоры: Graviton, Axion и Cobalt 100. Конечно, компания стремилась повысить прибыль и выручку, в том числе не исключалась самостоятельная разработка чипов и прямая конкуренция с собственными клиентами. Планы покупки Alphawave частично раскрылись в декабре 2024 года в ходе судебной тяжбы с Qualcomm. Однако руководство Arm заявило, что речь шла об обычном обмене идеями между менеджерами. Тем не менее, в ходе того же процесса в феврале стало известно, что компания искала специалистов, способных вывести на рынок чип собственной разработки. Теперь же выяснилось, что Qualcomm сама не прочь приобрести Alphawave — компания должна сделать предложение до 29 апреля или полностью отказаться от сделки. У Arm нет столь передовой технологии SerDes, какой располагает Alphawave. Хотя подробностей немного, известно, что SerDes-блоки служат основой многомиллиардных полупроводниковых бизнесов Broadcom и Marvell Technology. По прогнозам Bernstein, соответствующий рынок к 2028 году вырастет до $60 млрд. NVIDIA также разработала собственный вариант SerDes и уже заявила о намерении продавать лицензии на него другим компаниям. Создание передовых решений в этой сфере критически важно для выпуска ИИ-чипов, способных выгодно отличаться от продукции конкурентов. При этом, по мнению экспертов, разработка SerDes с нуля требует специфических навыков и около двух лет. Покупка Alphawave смогла бы сэкономить Arm значительное количество времени и ресурсов.

02.04.2025 [12:19], Руслан Авдеев

AMD закрыла сделку по покупке ZT Systems за $4,9 млрдAMD вышла на новый уровень конкуренции с NVIDIA, объявив о завершении сделки по покупке компании ZT Systems, специализирующейся на выпуске серверов, в том числе высокопроизводительных решений для гиперскейлеров. Утверждается, что это позволит объединить «ведущие в индустрии системы» и «компетенции уровня стоек» с передовыми полупроводниковыми технологиями AMD, сообщает портал CRN. Также ожидается, что это приведёт к созданию нового класса комплексных ИИ-решений. В AMD заявили, что сделка стоимостью $4,9 млрд была завершена в понедельник. IT-гигант предложит для совместного бизнеса широкий ассортимент процессоров, ускорителей и сетевых чипов, чтобы вывести на рынок «новый класс ИИ-продуктов». ZT Systems предлагает универсальную вычислительную инфраструктуру, хотя именно производственное направление компании AMD продаст. Прошлым летом было объявлено, что покупка этой компании поможет AMD лучше конкурировать с ИИ-гигантом NVIDIA в сегменте ЦОД, особенно на рынке решений для крупных предприятий и гиперскейлеров.

Источник изображения: ZT Systems Хотя AMD значительно нарастила инвестиции в конкуренцию с продуктами NVIDIA и в последние годы активно развивает ускорители серии Instinct, а также ПО ROCm (Radeon Open Compute) — альтернативу NVIDIA CUDA, её выручка в сфере ИИ пока не сопоставима с показателями NVIDIA. В прошлом году чипы AMD Instinct принесли компании $5 млрд выручки, тогда как доход NVIDIA в бизнесе, связанном с ЦОД и ускорителями, составил $102,2 млрд. В AMD отказались давать прогноз по выручке от Instinct в 2025 году, в отличие от 2024 года. Вместо этого в компании заявили, что этот сегмент позволит получать десятки миллиардов долларов «в ближайшие годы». После завершения сделки команды разработчиков и поддержки ZT Systems будут работать совместно с подразделениями AMD, отвечающими за ЦОД и ИИ-проекты. Отмечается, что приобретение компании позволит партнёрам значительно сократить сроки разработки и внедрения ИИ-систем «кластерного уровня». В компании подчёркивают, что покупка ZT Systems — важный шаг в реализации стратегии AMD по разработке передовых решений для обучения ИИ-моделей и инференса, адаптированных под индивидуальные потребности клиентов. Новые решения будут базироваться на открытой экосистеме, объединяющей «открытое» ПО, корпоративные сетевые технологии, а теперь ещё и системы ZT Systems с их экспертизой в клиентской поддержке. В августе 2024 года ZT Systems оценивалась в $4,9 млрд. Согласно данным Комиссии по ценным бумагам и биржам США (SEC), сделка предусматривала передачу 8,3 млн обычных акций AMD и $3,4 млрд продавцам компании. В документе также указано, что AMD планирует передать им дополнительно 740 961 акцию и $300 млн после выполнения определённых условий. В феврале сообщалось, что выручка AMD в сегменте дата-центров бьёт рекорды, хотя акции компании на тот момент несколько упали в цене.

02.04.2025 [11:50], Руслан Авдеев

Царь-чипы с интегрированной фотоникой: Cerebras Systems и Ranovus выбраны DARPA для создания вычислительной платформы нового поколенияИИ-стартап Cerebras Systems выбран американским военно-техническим управлением DARPA для разработки высокопроизводительной вычислительной системы нового поколения. Cerebras объединит собственные ИИ-ускорители и фотонные CPO-интерконнекты Ranovus для обеспечения высокой производительности при малом энергопотреблении, сообщает пресс-центр Cerebras. Комбинация технологий двух компаний позволит обеспечить в реальном времени моделирование сложных физических процессов и выполнение масштабных ИИ-задач. С учётом успеха программы DARPA Digital RF Battlespace Emulator (DRBE), в рамках которой Cerebras уже разрабатывает передовой суперкомпьютер для радиочастотной эмуляции, именно Cerebras и Ranovus были выбраны для новой инициативы, позволяющей объединить вычислительные продукты Cerebras с первыми в отрасли фотонными интерконнектами Ranovus. Решение крайне актуальное, поскольку двумя ключевыми вопросами для современных вычислительных систем являются проблемы с памятью и обменом данных между ускорителями и иной серверной инфраструктурой — вычислительные потребности растут быстрее, чем возможности памяти или IO-систем ввода-вывода. Как утверждают в Cerebras, её WSE-чипы имеют в 7 тыс. раз большую пропускную способность, чем классические ускорители, что даёт самый быстрый в мире инференс и самое быстрое моделирование молекулярных процессов.

Источник изображения: Cerebras В рамках нового плана DARPA стартап Cerebras будет использовать интерконнект Ranovus, что позволит получить производительность, недоступную даже для крупнейших суперкомпьютерных кластеров современности. При этом энергопотребление будет значительно ниже, чем у самых современных решений с использованием коммутаторов. Последние являются одними из самых энергоёмких компонентов в современных ИИ-системах или суперкомпьютерах. Утверждается, что комбинация новых технологий двух компаний позволит искать решения самых сложных задач в реальном времени, будь то ИИ или сложное моделирование физических процессов, на недостижимом сегодня уровне. Подчёркивается, что оставаться впереди конкурентов — насущная необходимость для обороны США, а также местного коммерческого сектора. В частности, это открывает огромные возможности для работы ИИ в режиме реального времени — от обработки данных с сенсоров до симуляции боевых действий и управления боевыми или коммерческими роботами. В Ranovus заявили, что платформа Wafer-Scale Co-Packaged Optics в 100 раз производительнее аналогичных современных решений, что позволяет значительно повысить эффективность ИИ-кластеров, и значительно энергоэффективнее продуктов конкурентов. Партнёрство компаний позволит задать новый стандарт для суперкомпьютерной и ИИ-инфраструктуры, решая задачи роста спроса на передачу и обработку данных и давая возможность реализовать военное и коммерческое моделирование нового поколения. Помимо использования в целях американских военных, гигантские ИИ-чипы Cerebras применяются и оборонными ведомствами других стран. Так, весной 2024 года сообщалось, что продукты компании помогут натренировать ИИ для военных Германии.

02.04.2025 [10:31], Сергей Карасёв

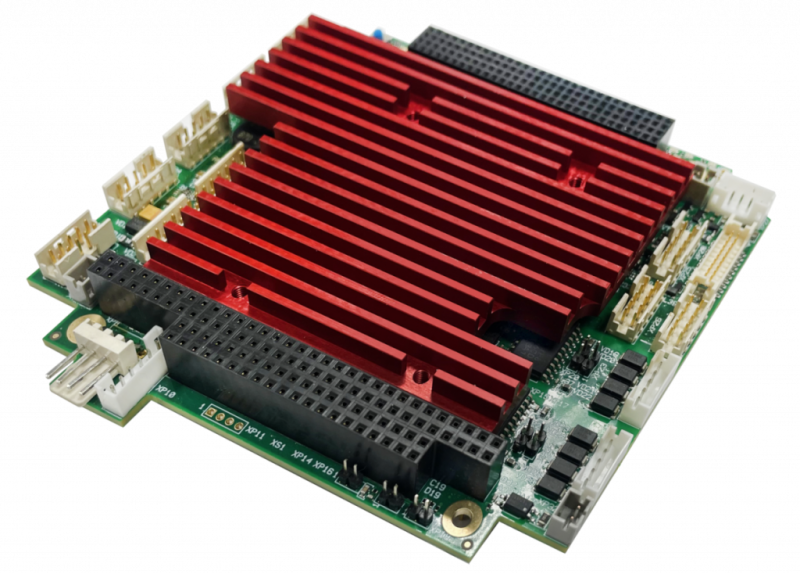

НПК «Атроник» выпустила одноплатный компьютер формата PC/104-Plus с чипом Vortex86 DX3Научно-производственная компания (НПК) «Атроник» представила встраиваемый одноплатный компьютер МЦП303 стандарта PC/104-Plus. Изделие, предназначенное для применения в промышленных системах управления, допускает эксплуатацию в широком температурном диапазоне, при высоких ударных и вибрационных нагрузках. Устройство выполнено на процессоре Vortex86DX3 с двумя ядрами, работающими на частоте 800 МГц. Объём памяти DDR3-533 SDRAM составляет 2 Гбайт, ёмкость встроенной флеш-памяти — до 64 Гбайт. Все эти компоненты напаяны на плате, что способствует повышению надёжности при работе в неблагоприятных условиях. Для вывода изображения могут быть задействованы интерфейсы D-Sub и LVDS (24 бит; до 1920 × 1440). Допускается подключение внешних устройств хранения данных через интерфейсы SATA и IDE (карта Compact Flash). Предусмотрены сетевые порты 1GbE и 100MbE, четыре последовательных порта, четыре порта USB 2.0 и восемь линий программируемого дискретного ввода-вывода, а также универсальный параллельный порт (LPT) с поддержкой режимов SPP/EPP и интерфейс PS/2 (клавиатура/мышь). Есть три сторожевых таймера (WDT): два внутренних с возможностью программного управления от 30,5 мкс до 512 с и внешний с фиксированным интервалом срабатывания 1,6 с. Габариты изделия составляют 115 × 102 × 24 мм, масса — 300 г. Диапазон рабочих температур простирается от -40 до +85 °C. Изделие выдерживает одиночные удары с пиковым ускорением до 150g. Среди прочего упомянуты часы реального времени, а также возможность сохранения настроек BIOS, установок системы и аварийных параметров в энергонезависимой памяти FRAM. Заявлена совместимость с программными платформами MS DOS, QNX, Windows, RTOS32 и Linux. |

|