Материалы по тегу: open source

|

10.02.2026 [16:42], Руслан Авдеев

В погоне за цифровым суверенитетом десятки стран обратились к открытому протоколу MatrixНа фоне растущего запроса на достижение цифрового суверенитета, открытый коммуникационный протокол Matrix получил второе дыхание и сегодня всё более востребован, сообщает The Register. Проект Matrix (и его коммерческое подразделение Element) существует многие годы. В 2014 году подразделение Matrix отделилось от телеком-провайдера Amdocs. В рамках Matrix действует некоммерческий фонд Matrix.org, стоящий за протоколом Matrix, а также отвечающая за клиентское приложение Element (ранее Vector и, позже, Riot). Коммерческое предприятие Element.io представляет не только клиентское ПО, но и серверное ПО, совместимое с протоколом Matrix. Помимо бесплатных версий с открытым кодом предлагаются коммерческие варианты Element Pro и Element Server Suite Pro. Matrix — открытый протокол, поэтому его используют многие сторонние приложения, поэтому нет необходимости использовать исключительно приложения Element для общения. По данным The Register, на фоне роста спроса ЕС на цифровой суверенитет, дела у Matrix идут весьма хорошо и, по словам одного из учредителей, «интерес растёт». Сегодня Matrix ведёт переговоры приблизительно с 35 странами о создании инфраструктуры связи на базе open source решений, причём инициативу, по словам разработчиков, поддерживает и ООН. Сообщается, что организация использовала Matrix в качестве основы для собственного решения для связи, независимого от любых стран и хостинг-провайдеров.

Источник изображения: Element Протокол используется и Международным уголовным судом (МУС), активно пытающимся отказаться от инструментов американского происхождения после того, как США ввели санкции против его членов, нарушившие работу электронной почты и др. МУС переходит на пакет OpenDesk вместо Microsoft Office, а в самом пакете есть Element. За внедрение отвечает немецкая ZenDiS (Zentrum für Digitale Souveränität der Öffentlichen Verwaltung — Центр цифрового суверенитета государственного управления). Протокол продвигается и в других странах, в многочисленных организациях Евросоюза. На мероприятии Ubuntu Summit в 2024 году анонсирована версия протокола Matrix 2.0, а официально её представили в конце того же года. Среди новых функций — ускоренная синхронизация и запуск клиента, многопользовательский видео- или VoIP-чат через Element Call. Хотя официальную спецификацию ещё не публиковали, новая версия протокола уже используется. Например, по умолчанию современным мобильным клиентом для Matrix 2.0 является Element X. Отличительная особенность протокола в том, что очень многие используют его, даже не слышав о нём, поскольку протокол интегрирован в инструменты и приложения с другими именами. Хотя технология, возможно, так и останется нишевой в сравнении с решениями крупных компаний с большими рекламными бюджетами, но это не означает, что она не имеет значения.

21.01.2026 [17:07], Руслан Авдеев

Глава Anthropic: продажа H200 в Китай равнозначна поставкам ядерного оружия Северной КорееГенеральный директор Anthropic Дарио Амодеи (Dario Amodei) недоволен тем, что США разрешили NVIDIA продавать китайским компаниям передовые ИИ-ускорители. Он сравнил это решение с раздачей ядерного оружия противникам, сообщает The Register. По словам Амодея, выступившего на Международном экономическом форуме в Давосе, руководители китайских компаний заявляют, что эмбарго на поставку американских чипов сдерживает их развитие. Он заявил, что продавать эти чипы — большая ошибка. Ранее США разрешили поставки ускорителей NVIDIA H200 китайским покупателям с пошлиной 25 %. Теперь слово за китайскими властями, которым ещё предстоит разрешить такие сделки. Anthropic желает, чтобы экспорт ИИ-технологий, наоборот, ужесточился — это заметно контрастирует с позициями NVIDIA и AMD, которые предупреждают, что запреты на экспорт только способствуют развитию ИИ-технологий в КНР. При этом на Китай приходится около половины исследователей в области искусственного интеллекта. Ранее Anthropic утверждала, что США и так лидируют в сфере ИИ-полупроводников, а экспортный контроль, на фоне того, что вычислительные мощности чипов удваиваются каждые два года, замедляет развитие Китая и укрепляет лидерство США. Компания уверена, что США на годы опережают Китай в способности выпускать передовые чипы. Доступ к американским разработкам позволит китайским создателям ПО вроде DeepSeek оказаться в лучшей позиции для конкуренции с Западом. При этом, как сообщает The Register, многие из наиболее производительных китайских LLM относятся к open source, поэтому их может использовать любой желающий, не опасаясь того, что данные его компании попадут в обучающий датасет, тогда как LLM американских компаний в основном «скрыты» за API, а сами компании расплывчато обещают не использовать пользовательские данные для обучения своих ИИ. При этом суды полны исков пользователей, связанных с нарушением прав на интеллектуальную собственность.

Источник изображения: CDC/unspalsh.com Слова Амодеи о том, что китайские разработчики LLM угрожают американскому бизнесу, слегка сгущают краски, но всё может действительно измениться, если китайские компании смогут импортировать передовые ускорители из США. Пока же, по словам бизнесмена, ИИ из КНР производителен только «на бумаге», а системы якобы специально оптимизируют для бенчмарков. Так или иначе, корпоративные пользователи действительно имеют немного вариантов, если желают получить доступ к хорошим открытым моделям — они в основном из Китая. Сама Anthropic называет главными конкурентами не стартапы из КНР, а OpenAI, Google и, чуть реже, другие американские компании. Anthropic пока не выкладывала ни одну из своих флагманских моделей в открытый доступ, но участвовала в нескольких совместных проектах с избранными клиентами, самым значимым из которых является AWS. Амодеи подчеркнул, что его продукты почти ни разу не проиграли в борьбе за контракт ИИ-модели из Поднебесной. Ключевое слово — «почти». Это означает, что китайским разработчикам всё-таки удавалось одержать верх несмотря на сложную ситуацию, в которой они находятся из-за экспортных ограничений. Компания последовательно критикует инициативы, способные обеспечить сотрудничество Запада с Китаем и даже не приветствует взаимодействие с другими мировыми игроками. Так, летом 2025 года сообщалось, что она намерена привлечь инвестиции с Ближнего Востока, но только потому, что избежать работы с регионом не удастся. В 2024 году Anthropic даже отказалась от инвестиций из Саудовской Аравии по соображениям «национальной безопасности».

20.01.2026 [17:15], Сергей Карасёв

«Базальт СПО» приглашает на XXI ежегодную конференцию «Свободное программное обеспечение в высшей школе»«Базальт СПО» совместно с Институтом программных систем им. А.К. Айламазяна РАН проводит XXI Ежегодную конференцию «Свободное программное обеспечение в высшей школе» (OSEDUCONF). Мероприятие пройдёт 6–8 февраля 2026 года в г. Переславле-Залесском на базе ИПС РАН. Ведущие учёные, педагоги, разработчики и администраторы расскажут об опыте внедрения СПО и организации образовательного процесса, создания благоприятных условий для вовлечения студентов в реальные проекты разработки свободных программных продуктов. Оргкомитет принимает заявки на доклады по следующим темам:

Сроки подачи заявок Для слушателей:

Участие бесплатное. Онлайн-трансляция конференции будет доступна на VK Видео и странице конференции. Зарегистрироваться на конференцию и ознакомиться с информацией о форматах и шаблонах тезисов можно на сайте. По вопросам, связанным с докладами, тезисами, программой конференции, регистрацией, размещением, трансфером можно обратиться к организаторам по электронной почте conference@lists.altlinux.org.

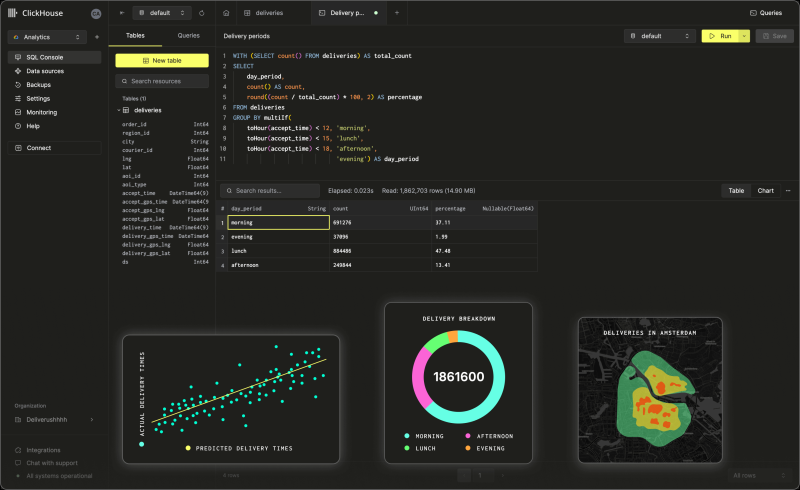

17.01.2026 [23:37], Владимир Мироненко

Капитализация ClickHouse после очередного раунда финансирования достигла $15 млрдClickHouse, разработчик колоночной СУБД с открытым исходным кодом, отделившийся более четырёх лет назад от Yandex NV, сообщил об успешном завершении раунда финансирования серии D, в ходе которого он привлёк $400 млн при оценке рыночной стоимости в $15 млрд. В предыдущем раунде, прошедшем в мае, оценка рыночной стоимости компании составила $6,35 млрд. Раунд возглавила инвестиционная группа Dragoneer Investment Group при участии Bessemer Venture Partners, GIC, Index Ventures, Khosla Ventures, Lightspeed Venture Partners, консультантов T. Rowe Price Associates и WCM Investment Management. Соучредитель и генеральный директор ClickHouse Аарон Кац (Aaron Katz) сообщил агентству Bloomberg, что компания планирует использовать полученные средства для ускорения разработки продукта, а также для увеличения продаж и маркетинга. ClickHouse отметила, что финансирование было получено на фоне продолжительного периода устойчивого роста компании. Её годовой регулярный доход (ARR) вырос более чем на 250 % в годовом исчислении. В настоящее время у её полностью управляемого сервиса ClickHouse Cloud насчитывается более 3 тыс. клиентов, включая Meta✴, Cursor, Sony и Tesla. Кац заявил, что ClickHouse была создана для обеспечения исключительной производительности и экономичности при работе с самыми требовательными рабочими нагрузками по обработке данных. Сейчас компания занимается внедрением унифицированной поддержой транзакционных и аналитических рабочих нагрузок, чего давно не хватало, а также наблюдаемостью (observability) LLM, чтобы разработчики ИИ-приложений могли оценивать качество результатов и поведение ИИ-моделей по мере их развёртывания. «Дополнительное финансирование в сочетании с продолжающимся развитием продукта позволяет нам предоставлять лидирующую платформу для сбора данных и мониторинга LLM в эпоху ИИ», — подчеркнул гендиректор ClickHouse. Инвестиционная компания Dragoneer отметила, что по мере того, как ИИ-системы переходят от экспериментов к продуктовому развёртыванию, требования, предъявляемые к базовой инфраструктуре обработки данных, возрастают, и всё большую ценность приобретают инфраструктурные платформы, которые обеспечивают крупномасштабные производственные нагрузки с большим объёмом данных: «По мере того, как модели становятся более функциональными, узкое место перемещается в инфраструктуру данных. ClickHouse выделяется тем, что обеспечивает производительность, экономичность и надёжность, необходимые для ИИ-систем, работающих в больших масштабах». ClickHouse также сообщила о приобретении стартапа Langfuse GmbH, разрабатывающего открытый инструмент для мониторинга LLM. Как сообщает SiliconANGLE, компании используют ПО Langfuse для отслеживания задержки и использования инфраструктуры своих приложений, работающих на основе LLM, что упрощает выявление первопричины сбоев и поиска решения. Эта сделка позволит ClickHouse улучшить интеграцию двух платформ. ClickHouse заявила, что цель состоит в том, чтобы сделать свою СУБД более конкурентоспособной среди разработчиков ИИ-приложений.

14.01.2026 [17:14], Руслан Авдеев

Евросоюз делает ставку open source, чтобы избавиться от зависимости от IT-гигантов из США

open source

software

евросоюз

импортозамещение

информационная безопасность

конфиденциальность

разработка

сша

Еврокомиссия начала новый раунд консультаций, связанный с открытым ПО, которое, как предполагается, это поможет местным разработчикам снизить зависимость от платформ американских IT-гигантов и перейти к созданию собственных open source альтернатив, сообщает The Register. В документе Call for Evidence Брюссель заявляет, что привычка ЕС полагаться на «неевропейских» (фактически американских) техногигантов стала «стратегической обузой», ограничивающей выбор, ослабляющей возможность конкурировать и создающей риски в цепочках поставок во всех сферах, от облачных сервисов до критической инфраструктуры. Консультации, которые продлятся до 3 февраля — первые шаги в рамках разработки официальной стратегии формирования «европейских открытых цифровых экосистем» (European Open Digital Ecosystems), благодаря которым open source будет рассматриваться как ключевой элемент инфраструктуры, а не просто дополнение, которое «неплохо было бы иметь». По данным Еврокомиссии, зависимость от зарубежных вендоров усложняет для Евросоюза контроль собственного цифрового стека, потенциально угрожает безопасности и надёжности в важных секторах. Open source даёт возможность избавиться от зависимости и лежит в основе обширного портфолио высококачественных и безопасных цифровых решений, которые можно использовать как жизнеспособные альтернативы проприетарным платформам.

Источник изображения: Shahadat Rahman/unsplash.com Как заявляют в Еврокомиссии, сильный и развитый сектор open source может внести эффективный вклад в инновации Евросоюза и ускорить стандартизацию, усиливая конкурентоспособность объединения для сохранения его суверенитета. Кроме того, это обеспечит экономическое процветание, надёжность и будет способствовать распространению влияния во всём мире. Отдельные техноэнтузиасты, стартапы, малые и средние бизнесы вносят значительный вклад, выводя продукты open source на рынок. По расчётам самой Еврокомиссии, 70–90 % современного ПО полагается на open source компоненты, т.е. фактически ПО с открытым исходными кодом лежит в основе цифровой экономики всего мира. В Брюсселе считают, что ЕС вносит в этот процесс значительный вклад, хотя коммерческую и стратегическую выгоду нередко в итоге получают крупные технологические компании, расположенные в других регионах. Для того, чтобы избежать этого, Еврокомиссия намерена обозначить новый подход к open source и пересмотреть свою стратегию, в основном сконцентрированную на том, как структуры ЕС используют и обмениваются кодом в рамках объединения. Теперь Евросоюз намерен обращаться с open source как с экономическим и политическим активом, напрямую связанным с суверенитетом, конкурентоспособностью и кибербезопасностью. Во многом вопрос касается решений, связанных с облачными и ИИ-сервисами, безопасностью, открытой аппаратной составляющей и промышленным ПО, в том числе приложений для автомобилей и др. На этот раз Еврокомиссия будет акцентировать внимание на масштабировании и внедрении такого ПО вместо очередных экспериментальных проектов.

Источник изображения: James Harrison/unsplash.com В Брюсселе признают, что только финансовые вливания не способны обеспечить решение проблемы. ЕС поддерживал программные проекты самой разной направленности, но лишь единицы из них смогли пережить стадию грантов и выжить на рынке. Теперь заявляется, что для масштабирования проекта недостаточно поддержки open source только с помощью программ поддержки исследований и инноваций. Критически важно поддерживать развивающиеся сообщества разработчиков и бизнесов в их намерениях масштабировать проекты. Комиссия изложила возможные меры, включая стимулы для публичных и частных пользователей для участия в развитии базовых проектов, поддержку бизнесов ЕС в сфере open source и помощь стартапам, рискующим не преуспеть в период роста. Также открытый код представлен как инструмент оптимизации прозрачности цепочек поставок и упрощения поиска уязвимостей. При этом ПО с открытым кодом тесно связано с могущественными технологическими платформами, поскольку американские техногиганты активно монетизируют общедоступный мировой код. Даже принадлежащая с некоторых пор Microsoft платформа GitHub предупредила, что устойчивость инфраструктуры open source под вопросом — с таким же мнением осенью выступали крупные открытые проекты в рамках Open Source Security Foundation (OpenSSF).

16.12.2025 [01:05], Владимир Мироненко

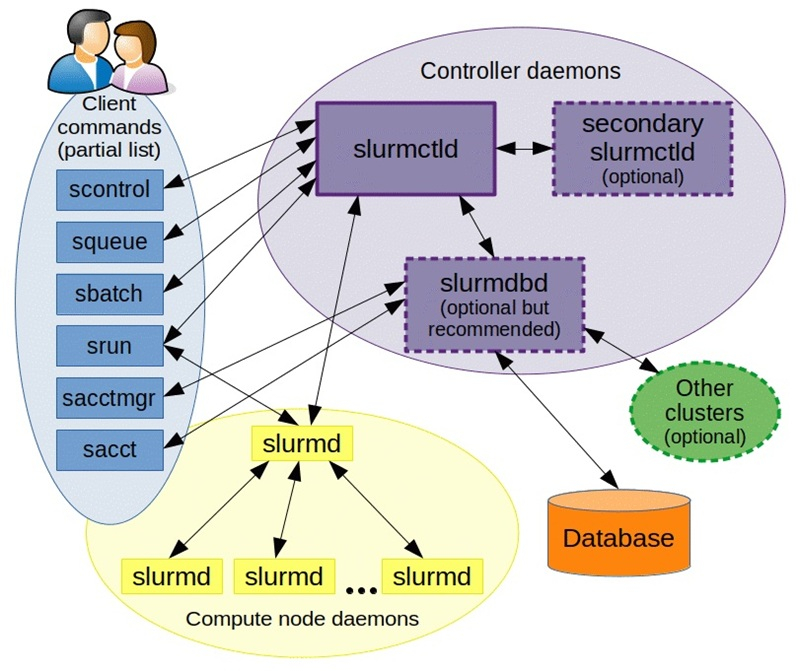

NVIDIA купила разработчика Slurm, пообещав не забрасывать open source решениеNVIDIA объявила о приобретении SchedMD — ведущего разработчика открытой системы оркестрации Slurm для высокопроизводительных вычислений (HPC) и ИИ. Финансовые условия сделки не разглашаются. Созданная SchedMD система Slurm обеспечивает планирование и управление большими вычислительными задачами в ЦОД, позволяя уменьшить количество ошибок, ускорить вывод продукции на рынок и снизить затраты. Как сообщает NVIDIA, сделка поможет укрепить экосистему ПО с открытым исходным кодом и стимулировать инновации в области ИИ для исследователей, разработчиков и предприятий. Компания отметила, что рабочие нагрузки HPC и ИИ включают сложные вычисления с выполнением параллельных задач на кластерах, для чего требуется организация очередей, планирование и распределение вычислительных ресурсов. По мере увеличения размеров и мощности кластеров HPC и ИИ задача эффективного использования ресурсов становится критически важной.

Источник изображения: SchedMD SchedMD была основана в 2010 году разработчиками ПО Slurm Моррисом «Мо» Джеттом (Morris «Moe» Jette) и Дэнни Оублом (Danny Auble) в Ливерморе (Livermore, штат Калифорния). В настоящее время персонал компании насчитывает 40 человек. Сейчас Slurm — ведущий менеджер рабочих нагрузок и планировщик заданий по масштабируемости, пропускной способности и управлению сложными политиками, который используется более чем в половине из десяти и ста лучших систем в списке TOP500 суперкомпьютеров. NVIDIA сообщила, что сотрудничает с SchedMD более десяти лет и продолжит инвестировать в разработку Slurm, чтобы сохранить его поизиции как ведущего планировщика с открытым исходным кодом для HPC и ИИ. NVIDIA обеспечит доступ SchedMD к новым системам, чтобы клиенты могли запускать гетерогенные кластеры с использованием последних инноваций Slurm. Также NVIDIA пообещала и далее поддерживать open source ПО, вкладываться в разработку Slurm и обучение. NVIDIA делает ставку на технологии с открытым исходным кодом и наращивает инвестиции в ИИ-экосистему, чтобы противостоять растущей конкуренции, отметил ресурс Reuters. В конце прошлого года NVIDIA завершила приобретение стартапа Run:ai, разрабатывающего ПО для управления рабочими нагрузками ИИ и оркестрации на базе Kubernetes. А в 2022 году она купила фирму Bright Computing, ещё одного известного разработчика инструментов оркестрации и управления кластерами.

12.12.2025 [17:21], Руслан Авдеев

Никаких закладок: NVIDIA анонсировала новое ПО для мониторинга и продления жизни ИИ-ускорителей в ЦОД

dcim

nvidia

open source

software

амортизация

ии

мониторинг

охлаждение

цод

электропитание

энергоэффективность

NVIDIA разрабатывает новое открытое ПО, благодаря которому операторы ЦОД смогут получать более подробные данные о тепловом состоянии и иных параметрах работы ИИ-ускорителей. Предполагается, что это поможет решать проблемы, связанные с перегревом оборудования и его надёжностью, увеличив его срок службы и производительность. NVIDIA отдельно подчёркивает, что телеметрия собирается только в режиме чтения без слежки за оборудованием, а в ПО нет «аварийных выключателей» и бэкдоров. Да и в целом использование новинки опционально. ПО обеспечивает операторам ЦОД доступ к мониторингу потребления энергии, загрузки, пропускной способности памяти и других ключевых параметров в масштабах всего парка ускорителей. Это помогает выявлять на ранних стадиях риски и проблемные компоненты и условия работы, отслеживать использование ИИ-ускорителей, их конфигурации и ошибки. Детализированная телеметрия становится всё важнее для планирования и управления масштабными инфраструктурами, говорит компания. ПО позволит:

Такой мониторинг особенно важен на фоне недавнего отчёта учёных Принстонского университета, в котором сообщается, что интенсивные тепловые и электрические нагрузки способны сократить срок службы ИИ-чипов до года-двух, хотя обычно предполагается, что они способны стабильно проработать до трёх лет. Современные ускорители потребляют 700 Вт и более, а высокоплотные системы — от 6 кВт. Из-за этого формируются зоны перегрева, происходят колебания энергопотребления и растёт риск деградации интерконнектов в высокоплотных стойках. Телеметрия, позволяющая оценить потребление энергии в реальном времени, состояние интерконнектов, систем воздушного охлаждения и др. позволяет перейти от реактивного мониторинга к проактивному проектированию. Рабочие нагрузки можно размещать с учётом теплового режима, быстрее внедрять СЖО или гибридные системы охлаждения, оптимизировать работу сетей с уменьшением тепловыделения. Также ПО может помочь операторам ЦОД выявлять скрытые ошибки, вызванные несоответствием версий прошивки или драйверов. Благодаря этому можно повысить общую стабильность парка ускорителей. Кроме того, без задержек передаваемые данные об ошибках и состоянии компонентов могут значительно сократить среднее время восстановления работы и упростить анализ причин сбоев. Соответствующие данные могут влиять на решения о тратах на инфраструктуру и стратегию её развития на уровне предприятия.

Источник изображения: NVIDIA Как заявляют в Gartner, современный ИИ представляет собой «энергоёмкого и сильно нагревающегося монстра», разрушающего экономику и принципы работы ЦОД. В результате, предприятиям нужны специальные инструменты мониторинга и управления для того, чтобы ситуация не вышла из-под контроля. В ближайшие годы использование подобных решений, вероятно, станет обязательным. Кроме того, прозрачность на уровне всего парка оборудования становится необходимой для обоснования роста бюджетов на ИИ-инфраструктуру. По словам экспертов, такие программные инструменты позволяют оптимизировать капитальные и операционные затраты на ЦОД и инфраструктуру, запланированные на ближайшие годы. «Каждый доллар и каждый ватт» должны быть учтены при эффективном использовании ресурсов.

02.12.2025 [09:06], Андрей Крупин

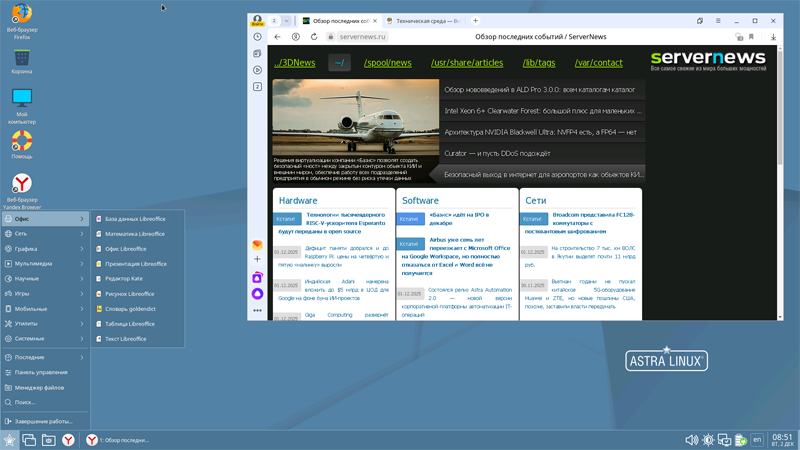

ОС Astra Linux для рабочих станций дополнилась новым репозиторием и двумя уровнями технической поддержки«Группа Астра» сообщила об изменениях в условиях технической поддержки операционной системы Astra Linux для рабочих станций. Разработчиком введены новые уровни поддержки для коммерческих компаний среднего и малого бизнеса — «Базовый» и «Расширенный». Также в рамках поддержки теперь доступен репозиторий Neo с актуальными стабильными версиями open-source ПО и оперативными обновлениями. Репозиторий Neo представляет собой сервис поставки востребованного и актуального свободного ПО, инструментов администрирования и разработки, доступный в рамках технической поддержки всех уровней. Все включаемые в репозиторий open-source версии софта и программные компоненты проходят проверку на известные вирусы, тестируются на совместимость с операционной системой Astra Linux. Обладатели активных сертификатов технической поддержки всех уровней могут создавать запрос на добавление в репозиторий новых программных компонентов.  «Мы провели серию интервью с клиентами и выяснили, что требования к технической поддержке у корпораций и компаний сегмента СМБ существенно различаются. Для среднего и малого бизнеса часть услуг оказалась неактуальна, — поясняют в «Группе Астра». — На основе выявленных ключевых потребностей мы разработали два новых уровня технической поддержки — «Базовый» и «Расширенный», которые подходят сегменту среднего бизнеса как по составу услуг, так и по стоимости. Оба уровня включают возможность перехода на очередные обновления Astra Linux и, наряду с уровнями «Стандартный» и «Привилегированный», предоставляют клиентам право запрашивать добавление необходимого программного обеспечения и инструментов администрирования в Neo-репозиторий». Нововведения также коснулись компаний среднего и малого бизнеса. Согласно лицензионному соглашению, под понятие СМБ попадают коммерческие организации, не являющиеся частью холдинговой структуры, со среднесписочной численностью до 2,5 тыс. работников. По данным «Группы Астра», в 2025 году количество таких коммерческих заказчиков ОС Astra Linux в десктопной редакции увеличилось на 32,8 %.

24.11.2025 [15:14], Сергей Карасёв

Технологии тысячеядерного RISC-V-ускорителя Esperanto будут переданы в open sourceСтартап Ainekko, специализирующийся на разработке аппаратных и программных решений в сфере ИИ, по сообщению EE Times, приобрёл интеллектуальную собственность и некоторые активы компании Esperanto Technologies. Речь идёт о дизайне чипов, программных инструментах и фреймворке. Фирма Esperanto, основанная в 2014 году, специализировалась на создании высокопроизводительных ускорителей с архитектурой RISC-V для задач НРС и ИИ. В частности, было представлено изделие ET-SoC-1, объединившее 1088 энергоэффективных ядер ET-Minion и четыре высокопроизводительных ядра ET-Maxion. Основной сферой применения чипа был заявлен инференс для рекомендательных систем, в том числе на периферии. Однако в июле нынешнего года стало известно, что Esperanto сворачивает деятельность и ищет покупателя на свои разработки — ключевых инженеров переманили крупные компании. А продать чипы Meta✴, в чём, по-видимому, и заключался изначальный план, не удалось. Как рассказала соучредитель Ainekko Таня Дадашева (Tanya Dadasheva), её компания работает с чипами Esperanto в течение примерно полугода. Изначально компания планировала использовать чипы Esperanto для запуска своего софтверного стека. В частности, удалось перенести llama.cpp up и tinygrad. Когда стало понятно, что Esperanto вряд ли выживет, было принято решение выкупить разработки стартапа. Во всяком случае, это лучше, чем просто закрыть компанию, оставив её заказчиков ни с чем, как поступила AMD с Untether AI.

Источник изображения: Esperanto Ainekko планирует передать сообществу open source технологии Esperanto, связанные с многоядерной архитектурой RISC-V, включая RTL, референсные проекты и инструменты разработки. Предполагается, что решения Esperanto будут востребованы прежде всего в области периферийных устройств, где большое значение имеет энергоэффективность. Архитектура Esperanto, как утверждается, подходит для таких задач, как робототехника и дроны, системы безопасности, встраиваемое оборудование с ИИ-функциями и пр. Второй соучредитель Ainekko Роман Шапошник (Roman Shaposhnik) добавляет, что многоядерная архитектура Esperanto подходит не только для разработки ИИ-чипов, но и для создания «универсальной вычислительной платформы». Сама Ainekko намерена выпустить чип с восемью ядрами Esperanto и 16 Мбайт памяти MRAM, разработанной стартапом Veevx. Отмечается, что соучредитель и генеральный директор Veevx, ветеран Broadcom Даг Смит (Doug Smith), является ещё одним сооснователем Ainekko. В дальнейшие планы входит разработка процессора с 256 ядрами: по производительности он будет сопоставим с чипом Broadcom BCM2712 (4 × 64-бит Arm Cortex-A76), лежащим в основе Raspberry Pi 5, но оптимизирован для инференса.

10.11.2025 [12:05], Сергей Карасёв

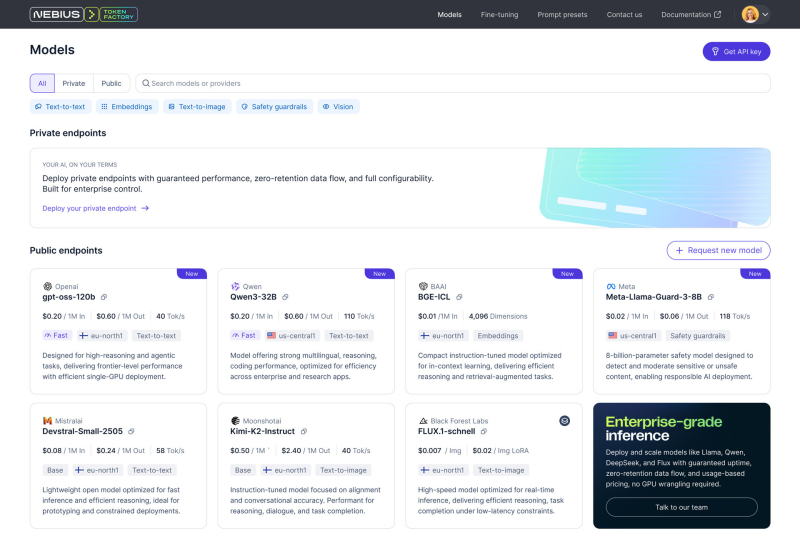

Фабрика токенов: Nebius, бывшая Yandex NV, запустила платформу Token Factory для инференса на базе открытых ИИ-моделейКомпания Nebius (бывшая материнская структура «Яндекса») представила платформу Nebius Token Factory для инференса: она позволяет разворачивать и оптимизировать открытые и кастомизированные ИИ-модели в больших масштабах с высоким уровнем надёжности и необходимым контролем. Nebius отмечает, что применение закрытых ИИ-моделей может создавать трудности при масштабировании. С другой стороны, открытые и кастомизированные модели позволяют устранить эти ограничения, но управление ими и обеспечение безопасности остаются технически сложными и ресурсоёмкими задачами для большинства команд. Платформа Nebius Token Factory призвана решить существующие проблемы: она сочетает гибкость открытых моделей с управляемостью, производительностью и экономичностью, которые необходимы организациям для реализации масштабных проектов в сфере ИИ. Nebius Token Factory базируется на комплексной ИИ-инфраструктуре Nebius. Новая платформа объединяет высокопроизводительный инференс, пост-обучение и управление доступом. Обеспечивается поддержка более 40 open source моделей, включая новейшие версии Deep Seek, Llama, OpenAI и Qwen. Среди ключевых преимуществ Nebius Token Factory заявлены соответствие требованиям корпоративной безопасности (HIPAA, ISO 27001 и ISO 27799), предсказуемая задержка (менее 1 с), автоматическое масштабирование пропускной способности и доступность на уровне 99,9 %. Инференс выполняется в дата-центрах на территории Европы и США без сохранения данных на серверах Nebius. Задействована облачная экосистема Nebius AI Cloud 3.0 Aether, что, как утверждается, обеспечивает безопасность корпоративного уровня, проактивный мониторинг и стабильную производительность. Отмечается, что Nebius Token Factory может применяться для решения широкого спектра ИИ-задач: от интеллектуальных чат-ботов, помощников по написанию программного кода и генерации с дополненной выборкой (RAG) до высокопроизводительного поиска, анализа документов и автоматизированной поддержки клиентов. Интегрированные инструменты тонкой настройки и дистилляции позволяют компаниям адаптировать большие открытые модели к собственным данным. При этом достигается сокращение затрат на инференс до 70 %. Оптимизированные модели затем можно быстро разворачивать без ручной настройки инфраструктуры. |

|