Материалы по тегу: ocp

|

03.12.2025 [20:51], Владимир Мироненко

HPE одной из первых начнёт выпускать интегрированные стоечные ИИ-платформы AMD Helios AI

amd

broadcom

epyc

hardware

hpc

hpe

instinct

juniper networks

mi400

ocp

ualink

venice

германия

ии

суперкомпьютер

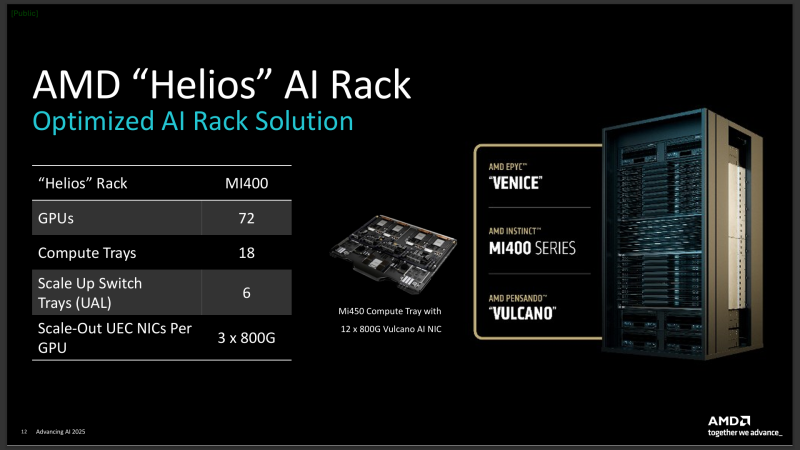

AMD объявила о расширении сотрудничества с HPE, в рамках которого HPE станет одним из первых поставщиков стоечных систем AMD Helios AI, которые получат коммутаторы Juniper Networking (компания с недавних пор принадлежит HPE), разработанные совместно с Broadcom, и ПО для бесперебойного высокоскоростного подключения по Ethernet. AMD Helios AI — открытая полнофункциональная ИИ-платформа на базе архитектуры OCP Open Rack Wide (ORW), разработанная для крупномасштабных рабочих нагрузок и обеспечивающая FP4-производительность до 2,9 Эфлопс на стойку благодаря ускорителям AMD Instinct MI455X, процессорам EPYC Venice шестого поколения и DPU Pensando Vulcano, работающими под управлением открытой программной экосистемы ROCm для нагрузок ИИ и HPC. Как отметил The Register, сетевая архитектура этой системы будет представлять собой масштабируемую реализацию UALink over Ethernet (UALoE) и специализированным коммутатором Juniper Networks на базе сетевого чипа Broadcom Tomahawk 6 (102,4 Тбит/с). Система разработана для упрощения развёртывания крупномасштабных ИИ-кластеров, что позволяет сократить время разработки решений и повысить гибкость инфраструктуры. В отличие от NVIDIA, AMD не выпускает коммутаторы, предлагая открытую экосистему, так что HPE и другие компании могут интегрировать собственные сетевые решения. The Register полагает, что HPE и Broadcom решили не гнаться за отдельной аппаратной реализацией UALink, если данные можно передавать поверх Ethernet. «Это первое в отрасли масштабируемое решение, использующее Ethernet, стандартный Ethernet. Это означает, что оно полностью соответствует открытому стандарту и позволяет избежать привязки к проприетарному поставщику, использует проверенную сетевую технологию HPE Juniper для обеспечения масштабируемости и оптимальной производительности для рабочих нагрузок ИИ», — заявила HPE. HPE заявила, что это позволит её стоечной системе поддерживать трафик, необходимый для обучения модели с триллионами параметров, а также обеспечить высокую пропускную способность инференса. Стоечная система HPE будет включать 72 ускорителя AMD Instinct MI455X с 31 Тбайт HBM4 с агрегиированной пропускной способностью 1,4 Пбайт/с. Агрегированная скорость интерконнекта составит 260 Тбайт/с. Новинка будет доступна в 2026 году. AMD также сообщила, что Herder, новый суперкомпьютер для Центра высокопроизводительных вычислений в Штутгарте (HLRS) (Германия), получит Instinct MI430X и EPYC Venice. Он будет построена на платформе HPE Cray Supercomputing GX5000. Поставка Herder запланирована на II половину 2027 года, а ввод в эксплуатацию — к концу 2027 года. Herder заменит используемый центром суперкомпьютер Hunter.

02.12.2025 [18:20], Сергей Карасёв

Российская ИИ-система Delta Sprut XL поддерживает до 25 GPU

delta computers

gpu

granite rapids

h200

hardware

intel

nvidia

ocp

rtx

sierra forest

xeon

ии

сделано в россии

сервер

Российская компания Delta Computers представила OCP-систему Delta Sprut XL, предназначенную для ресурсоёмких нагрузок, таких как обучение ИИ-моделей, инференс, научное моделирование и задачи HPC. В основу новинки положена аппаратная платформа Intel Xeon 6. CPU-секция допускает установку двух процессоров Sierra Forest-SP или Granite Rapids-SP с показателем TDP до 330 и 350 Вт соответственно: в первом случае могут быть задействованы в общей сложности до 288 E-ядер, во втором — до 172 P-ядер. Доступны 32 слота для модулей оперативной памяти DDR5-6400 RDIMM или DDR5-8000 MRDIMM суммарным объёмом до 8 Тбайт. Могут быть установлены четыре SFF-накопителя U.2 толщиной 15 мм с интерфейсом PCIe 5.0 (NVMe) или восемь таких SSD толщиной 7 мм. Кроме того, есть два коннектора M2.2280 (PCIe). Реализованы четыре слота PCIe 5.0 x16 для карт типоразмера HHHL и слот OCP 3.0 (PCIe 5.0). Присутствуют разъёмы USB 3.0 Type-A и miniDP, а также выделенный сетевой порт управления 1GbE. В системе Delta Sprut XL ускорители на базе GPU устанавливаются в отдельные модули. В общей сложности могут использоваться до 20 карт NVIDIA H200 или до 25 экземпляров NVIDIA RTX Pro 6000 Blackwell Server Edition. Каждый квартет NVIDIA H200 объединён при помощи NVLink. «Delta Computers представляет GPGPU-платформу, способную консолидировать до 20 ускорителей NVIDIA H200 в одном кластере. При этом необходимость использования InfiniBand или 400GbE появляется лишь в случае потребности у заказчика в ещё большем количестве ускорителей — при таком сценарии предусмотрены отдельные слоты расширения для объединения нескольких платформ Delta Sprut XL в единый кластер», — отмечает компания. Питание обеспечивается посредством централизованного шинопровода OCP на 12 или 48 В. Применено встроенное ПО Delta BMC, предназначенное для мониторинга (сбор телеметрии, отслеживание состояния платформы, её модулей и компонентов) и удалённого администрирования серверного оборудования. Эта прошивка включена в реестр Минцифры РФ и сертифицирована ФСТЭК.

25.11.2025 [17:23], Сергей Карасёв

JBOG-массив OpenYard HG402 допускает установку восьми GPUРоссийский разработчик и производитель серверного оборудования OpenYard анонсировал JBOG-массив HG402, предназначенный для решения ресурсоёмких вычислительных задач, связанных в том числе с машинным обучением и приложениями ИИ. Новинка выполнена в форм-факторе 4OU в соответствии со стандартом OpenRack v2.2. Доступны восемь слотов для установки карт с интерфейсом PCIe 4.0 x16. Производитель говорит о совместимости с такими картами, как NVIDIA GeForce RTX 4080 и RTX 5090 (с собственными радиаторами OpenYard), а также NVIDIA A100 и H100. Для подключения массивов к хосту используются кабели MCIO (PCIe 4.0). При этом один хост может задействовать до четырёх GPU. Таким образом, ресурсы массива могут использоваться одновременно двумя серверами.

Источник изображения: OpenYard Среди преимуществ решения OpenYard HG402 разработчик называет возможность применения ускорителей потребительского уровня для инференса, оптимизированное охлаждение, а также управление через систему OYBMC. Обеспечивается быстрая замена GPU и вентиляторов; при этом для обслуживания массива не требуются инструменты. Ранее компания OpenYard представила GPU-сервер HN203I, построенный на аппаратной платформе Intel. Устройство допускает установку двух процессоров Xeon 6700E (Sierra Forest-SP) или Xeon 6500P/6700P (Granite Rapids-SP), до 8 Тбайт оперативной памяти DDR5, десяти SFF-накопителей (NVMe) с возможностью горячей замены и четырёх LFF-устройств с интерфейсом SATA/SAS. Есть восемь слотов PCIe 5.0 x16 MCIO и три слота PCIe 5.0 x4 MCIO, а также разъём OCP 3.0 (PCIe 5.0 x16).

12.11.2025 [23:23], Владимир Мироненко

От ИИ ЦОД до роботов: AMD анонсировала долгосрочную стратегию роста

amd

cpu

dpu

epyc

hardware

instinct

mi400

mi500

ocp

pensando systems

ualink

ultra ethernet

venice

verano

xilinx

ии

ускоритель

финансы

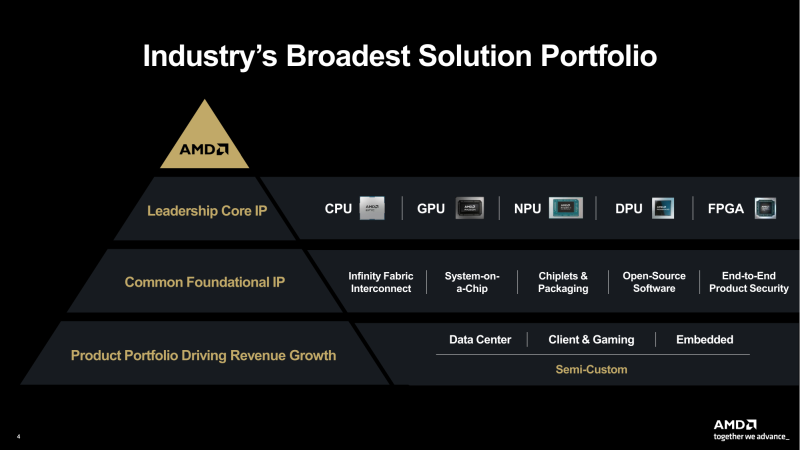

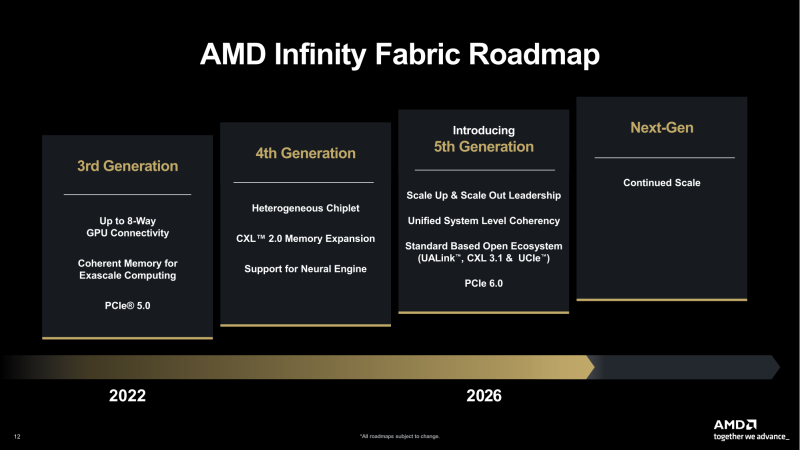

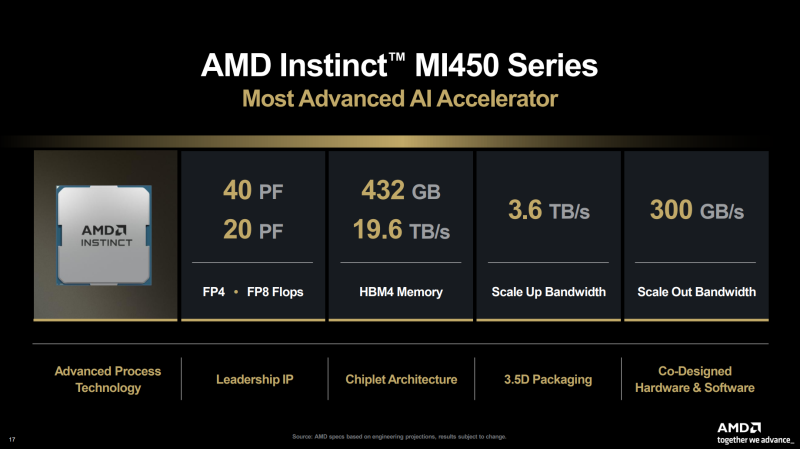

AMD представила на мероприятии Financial Analyst Day 2025 план по достижению лидерства на рынке вычислительных технологий объёмом $1 трлн. Долгосрочная стратегия роста AMD построена на четырех столпах: лидерство в сфере ЦОД, повышение производительности ИИ, открытое ПО и расширение присутствия на рынках встраиваемых и полукастомных кремниевых решений. AMD ожидает, что только её бизнес в сфере ЦОД будет приносить более $100 млрд годовой выручки, с увеличением совокупного среднегодового темпа роста (CAGR) до более чем 60 %, при этом CAGR дохода от ИИ-решений увеличится до более чем 80 %. Генеральный директор AMD Лиза Су (Lisa Su) заявила, что следующий этап будет основан на унифицированной вычислительной платформе AMD, объединяющей процессоры EPYC, ускорители Instinct, сетевые решения Pensando и ПО ROCm. Новый план развития AMD призван обеспечить ей конкуренцию с NVIDIA и Intel на корпоративных рынках и в борьбе за заказы гиперскейлеров. Ускорители серии Instinct MI350, уже развёрнутые Oracle (ещё 50 тыс. MI450 будут развёрнуты во II половине 2026 г.), являются самыми популярными ускорителями AMD на сегодняшний день. Следующей платформой станет серия MI450, которая будет запущена вместе со стоечной платформой Helios в III квартале 2026 года. Helios обеспечит пропускную способность интерконнекта 3,6 Тбайт/с на каждый ускоритель и до 72 ускорителей на стойку с совокупной пропускной способностью 260 Тбайт/с, соединённых между собой посредством UALink и Ultra Ethernet (UEC). Система поддерживает разделяемую память между ускорителями, что обеспечивает обучение крупномасштабных моделей с бесперебойным доступом к памяти и отказоустойчивой сетью с шестью плоскостями. AMD характеризует Helios как свою первую ИИ-платформу стоечного масштаба — полностью интегрированную систему с открытой архитектурой, которая объединяет вычислительные мощности, ускорение, сетевые технологии и ПО в единую структуру. В отличие от традиционных серверных кластеров, Helios реализует всю стойку как единый высокопроизводительный вычислительный домен. Каждая стойка объединяет процессоры AMD EPYC Venice, CDNA5-ускорители Instinct MI450X (будет и вариант MI430X с полноценными FP64-блоками) и 400G/800G-карты Pensando Vulcano, связанные Infinity Fabric пятого поколения (PCIe 6.0, CXL 3.1, UCIe) и UALink. Эта архитектура минимизирует накладные расходы на перемещение данных, увеличивает пропускную способность между ускорителями и обеспечивает эффективность класса экзафлопсных вычислений в компактном корпусе. Helios фактически представляет собой проект AMD для ИИ-фабрики будущего с возможностью модульного расширения, позволяя объединять сотни стоек в одну систему в ЦОД. В 2027 году AMD планирует выпустить ускорители серии MI500 и процессоры EPYC Verano, продолжая тем самым ежегодный цикл совместной разработки процессоров, ускорителей и сетей. AMD заявила, что EPYC Venice, намеченные к выпуску в 2026 году, будут обладать лучшими в отрасли показателями плотности (1,3x по количеству потоков в сравнении с текущими решениями) и энергоэффективности (1,7x). Они пополнятся оптимизированными для ИИ наборами инструкций для обработки инференса и выполнения вычислений общего назначения. Указанные компоненты станут основой ИИ-фабрики, способной масштабироваться от одной стойки до глобально распределённых кластеров. Исполнительный вице-президент AMD Форрест Норрод (Forrest Norrod) подчеркнул в своём выступлении, что производительность ИИ всё больше зависит от сети. Сетевые карты AMD Pensando Pollara и Vulcano для ИИ образуют связующую ткань архитектуры Helios. Сетевая карта Pollara 400 обеспечивает пропускную способность 400 Гбит/с, а готовящаяся к выходу сетевая карта Vulcano удвоит её до 800 Гбит/с, обеспечивая связь Ultra Ethernet между крупными кластерами ускорителей. AMD представила четырёхуровневую архитектуру сети для масштабных ИИ-инфраструктур. Front-End часть обслуживает пользователей, хранилище и приложения. Она опирается на DPU Pensando и P4-движки, отвечающие за разгрузку сетевых функций, функции безопасности и шифрования, и работу с СХД. Вертикальное масштабирование в пределах стойки обеспечивает 3,6-Тбайт/с подключение на каждый GPU. Горизонтальное масштабирование реализуется благодаря UEC — внутренние тесты показали снижение затрат на коммутацию до 58 % по сравнению с традиционными сетями типа Fat-Tree. Наконец, Scale-Across (пространственное масштабирование) позволит объединить географически распределённые ЦОД в кластеры с интеллектуальным управлением трафиком и адаптивной балансировкой нагрузки. AMD отметила, что открытый программный стек ROCm (Radeon open compute) по-прежнему лежит в основе её стратегии в области ИИ-платформ. По сравнению с прошлым годом число его загрузок выросло в десять раз и теперь на HuggingFace поддерживается более 2 млн моделей. ROCm интегрируется с ведущими фреймворками, включая PyTorch, TensorFlow, JAX, Triton, vLLM, ComfyUI и Ollama, и поддерживает проекты с открытым исходным кодом, такие как Unsloth. AMD также расширила своё видение «физического ИИ», когда вычисления выходят за рамки облака и охватывают роботов, транспортные средства и промышленные системы. Подразделение встраиваемых систем, усиленное приобретением Xilinx в 2022 году, превратилось из бизнеса, ориентированного на FPGA, в многоплатформенный двигатель роста, охватывающий адаптивные системы на кристалле (SoC), встраиваемые x86-процессоры и заказные кремниевые решения. По словам компании, с 2022 года решения в этой области принесли более $50 млрд. AMD рассчитывает превысить 70 % доли рынка адаптивных вычислений. Говоря о перспективах, компания отметила, что ЦОД остаются основным драйвером роста, но наряду с этим она будет диверсифицировать свою деятельность по всем сегментам. Финансовые цели AMD включают:

06.11.2025 [14:09], Сергей Карасёв

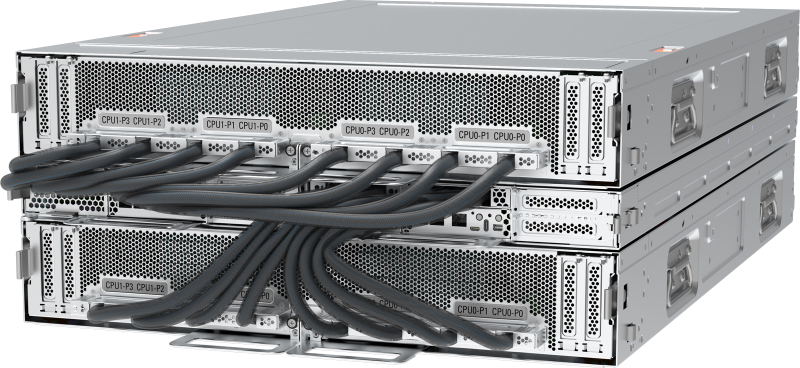

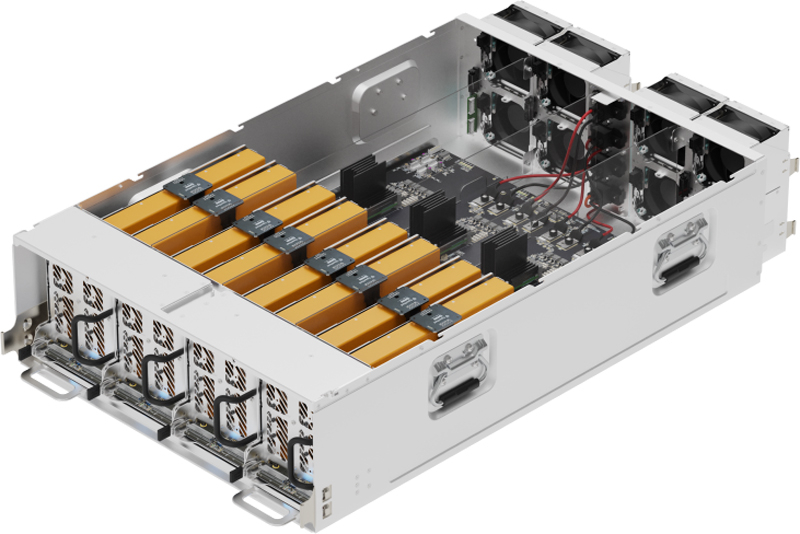

Новая фаза роста: глава AMD Лиза Су рассказала о прогрессе в разработке ИИ-систем следующего поколенияПрезидент и генеральный директор AMD Лиза Су (Lisa Su), по сообщению The Register, рассказала о прогрессе компании в сфере разработки продуктов следующего поколения для дата-центров, ориентированных на ИИ-нагрузки. Речь идёт, в частности, об ускорителях на базе GPU и мощных серверных стойках Helios. О разработке Helios (на изображении) было впервые объявлено в июне нынешнего года. Это стойка двойной ширины, которая будет оснащаться серверными модулями с процессорами AMD EPYC Venice с ядрами Zen 6 и ускорителями Instinct MI400. Кроме того, упомянуты сетевые адаптеры Pensando. Чипы Venice (EPYC шестого поколения) будут производиться с использованием 2-нм техпроцесса TSMC.

Источник изображения: AMD «Разработка наших GPU серии MI400 и стоечного решения Helios идёт быстрыми темпами, чему способствует тесное сотрудничество с гиперскейлерами, ИИ-компаниями, а также OEM- и ODM-партнёрами. Это позволит начать широкомасштабное развёртывание систем в следующем году», — сообщила Су. По её словам, решающую роль в разработке Helios играют специалисты компании ZT Systems, которую AMD купила весной нынешнего года за $4,9 млрд. Производственное подразделение этой фирмы недавно было продано поставщику услуг по выпуску электроники Sanmina за $3 млрд. Процессоры EPYC Venice, ускорители Instinct MI400 и стоечные решения Helios дебютируют в 2026 году. Лиза Су подчёркивает, что бизнес AMD в области ИИ-решений для ЦОД вступает в «следующую фазу роста». При этом наблюдается повышение интереса к будущим продуктам со стороны потенциальных заказчиков. Глава AMD отмечает, что для изделий Instinct MI450 готовятся различные варианты исполнения. При этом фиксируется значительный интерес именно «к полноценному стоечному решению».

30.10.2025 [13:51], Владимир Мироненко

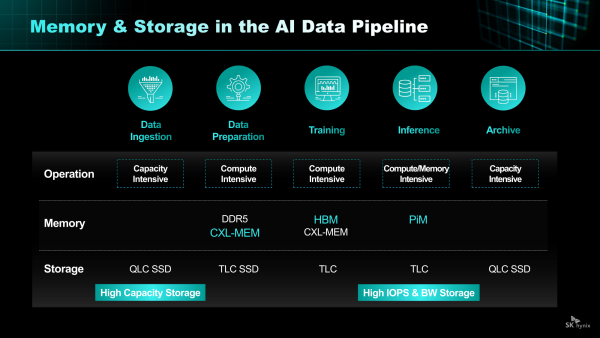

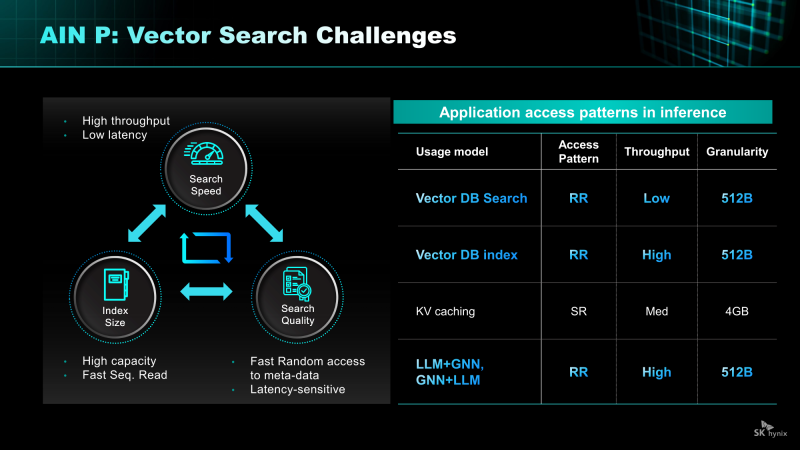

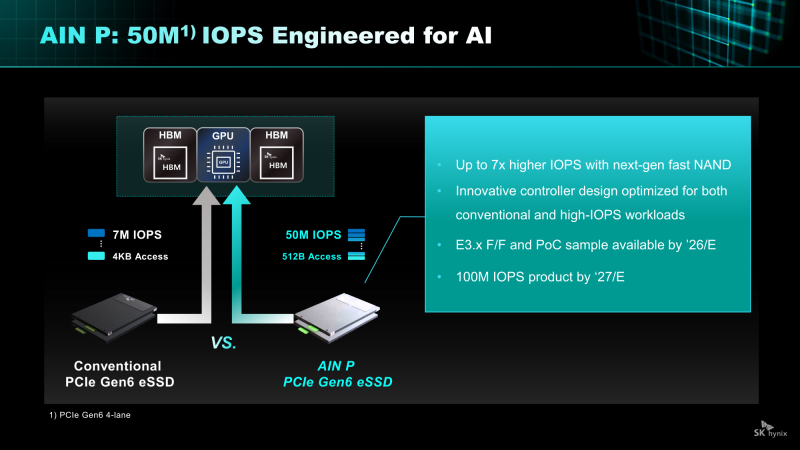

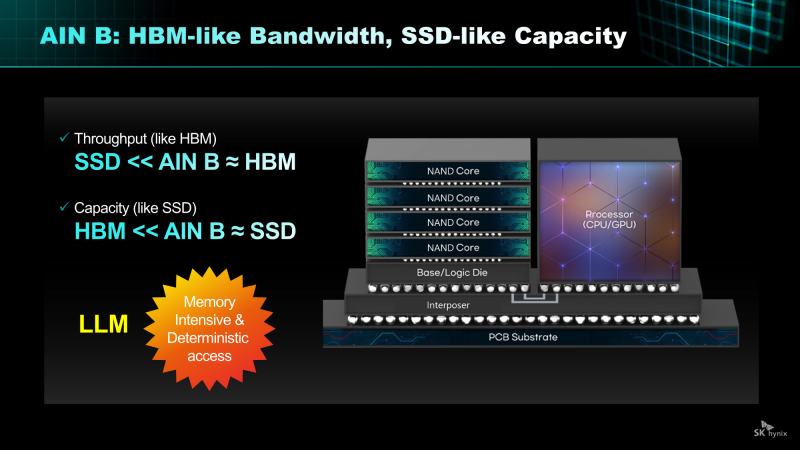

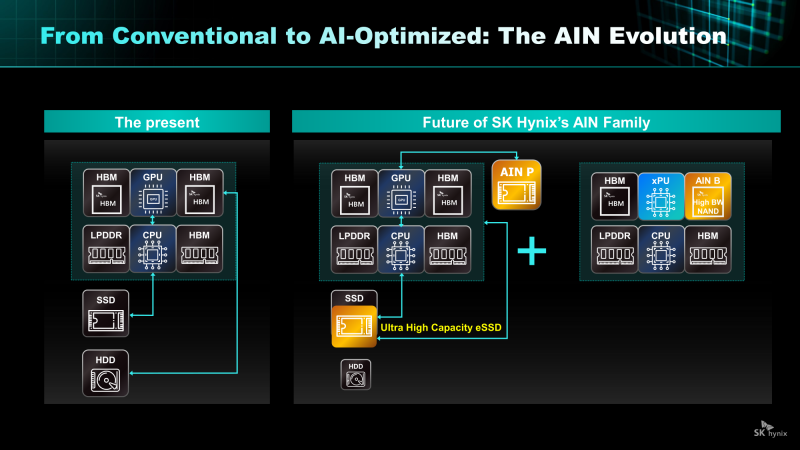

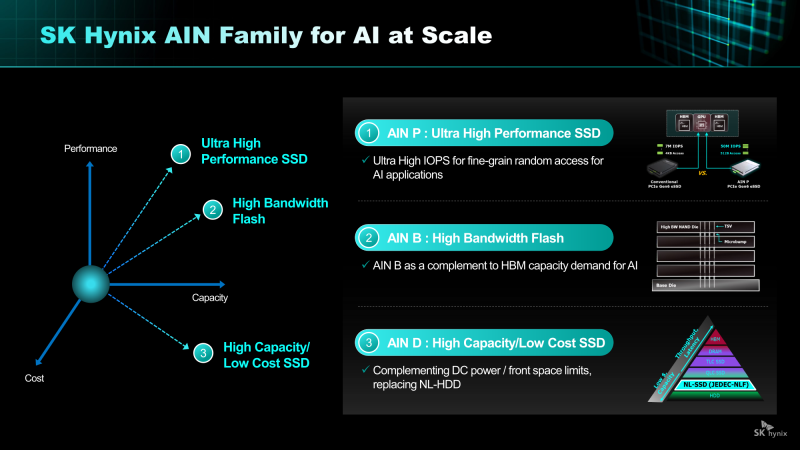

От Nearline SSD до HBF: SK hynix анонсировала NAND-решения AIN для ИИ-платформКомпания SK hynix представила стратегию развития решений хранения на базе NAND нового поколения. SK hynix заявила, что в связи с быстрым ростом рынка ИИ-инференса спрос на хранилища на базе NAND, способных быстро и эффективно обрабатывать большие объёмы данных, стремительно растёт. Для удовлетворения этого спроса компания разрабатывает серию решений AIN (AI-NAND), оптимизированных для ИИ. Семейство будет включать решения AIN P, AIN B и AIN D, оптимизированные по производительности, пропускной способности и плотности соответственно. AIN P (Performance) — это решение для эффективной обработки больших объёмов данных, генерируемых в рамках масштабных рабочих нагрузок ИИ-инференса. Продукт значительно повышает скорость обработки и энергоэффективность, минимизируя узкие места между хранилищем и ИИ-операциями. SK hynix разрабатывает NAND-память и контроллеры с новыми возможностями и планирует выпустить образцы к концу 2026 года. Как пишет Blocks & Files, накопитель AIN P, как ожидается, получит поддержку PCIe 6.0 и обеспечит 50 млн IOPS на 512-байт блоках, тогда как сейчас производительность случайного чтения и записи с 4-Кбайт блоками составляет порядка 7 млн IOPS у накопителей PCIe 6.0. То есть AIN P будет в семь раз быстрее, чем нынешние корпоративные PCIe 6.0 SSD, и, по заявлению SK hynix, достичь 100 млн IOPS можно будет уже в 2027 году. Такой SSD будет выполнен в форм-факторе EDSFF E3.x и оснащён контроллером, предназначенным для выполнения как обычных рабочих нагрузок, так и с высоким показателем IOPS. AIN D (Density) — это высокоплотное решение Nearline (NL) SSD для хранения больших объёмов данных с низкими энергопотреблением и стоимостью, подходящее для хранения ИИ-данных. Компания стремится увеличить плотность QLC SSD с Тбайт до Пбайт, создав решение среднего уровня, сочетающее в себе скорость SSD и экономичность HDD. AIN D от SK hynix как раз предназначен для замены жёстких дисков. Компания также упоминает некий стандарт JEDEC-NLF (Near Line Flash?), который пока не существует. При этом SK hynix пока не упоминает PLC NAND и не приводит данные о ёмкости AIN D. AIN B (Bandwidth) — это HBF-память с увеличенной за счёт вертикального размещения нескольких модулей NAND пропускной способностью. Ключевым в данном случае является сочетание структуры стекирования HBM с высокой плотностью и экономичностью флеш-памяти NAND. AIN B предложит большую ёмкость, чем HBM, примерно на уровне ёмкости SSD. AIN B может увеличить эффективную ёмкость памяти GPU и, таким образом, устранить необходимость покупки/аренды дополнительных GPU для увеличения ёмкости HBM, например, для хранения содержимого KV-кеша. Компания рассматривает различные стратегии развития AIN B, например, совместное использование с HBM для повышения общей ёмкости системы, поскольку стек HBF может быть совмещён со стеком HBM на одном интерпозере. SK hynix и Sandisk работают над продвижением стандарта HBF. Они провели в рамках 2025 OCP Global Summit мероприятие HBF Night, посвящённое этому вопросу. Рании компании подписали меморандум о стандартизации HBF в целях расширения технологической экосистемы. «Благодаря OCP Global Summit и HBF Night мы смогли продемонстрировать настоящее и будущее SK hynix как глобального поставщика решений памяти, процветающего на быстро развивающемся ИИ-рынке», — заявила SK hynix, добавив, что на рынке устройств хранения данных на базе NAND следующего поколения SK hynix будет тесно сотрудничать с клиентами и партнёрами, чтобы стать ключевым игроком.

28.10.2025 [08:43], Сергей Карасёв

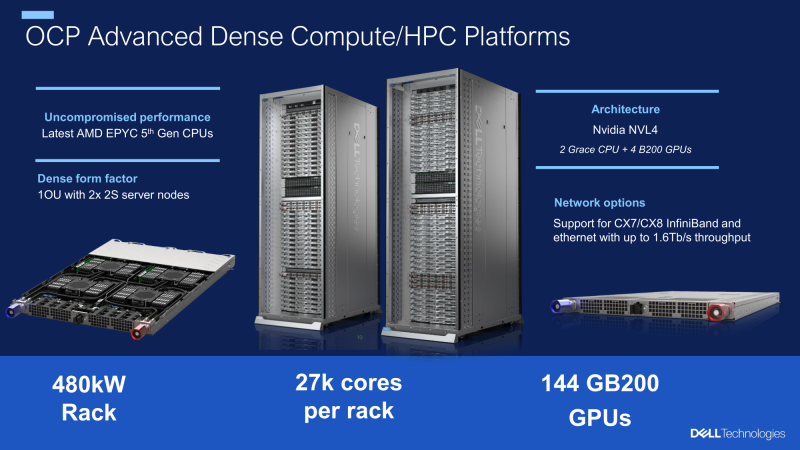

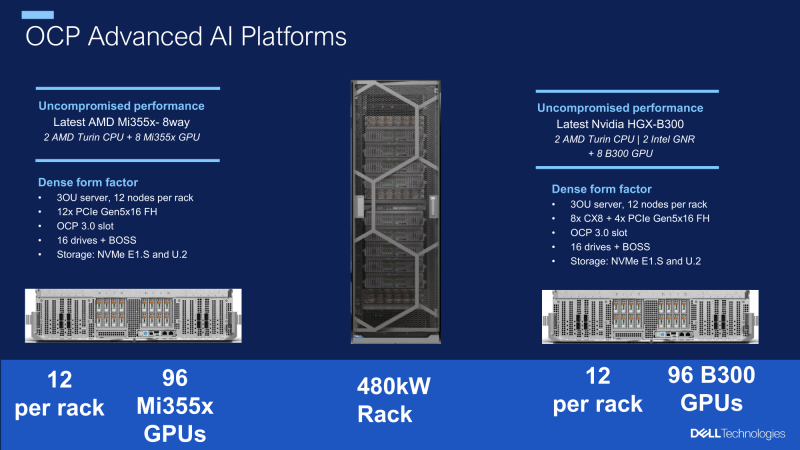

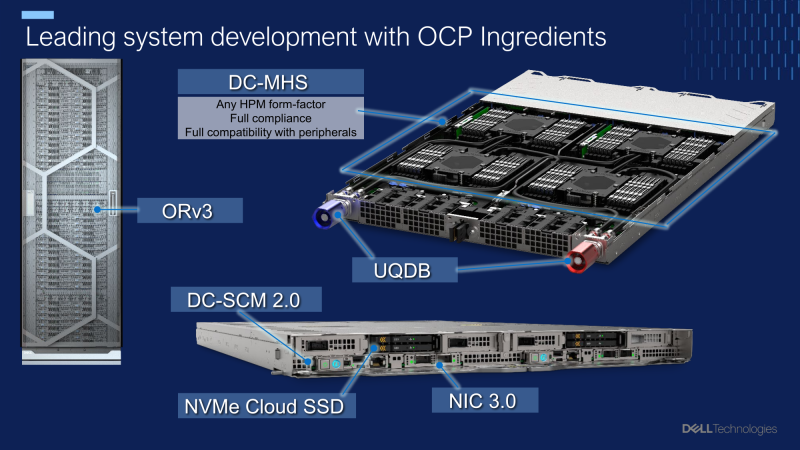

Dell разработала модульные OCP-стойки мощностью 480 кВт для ИИ-системКомпания Dell в ходе мероприятия 2025 OCP Global Summit рассказала о разработке передовых систем для ресурсоёмких нагрузок ИИ и HPC. Речь идёт, в частности, о полностью модульных архитектурах на базе открытых спецификаций, оптимизированных для жидкостного охлаждения. Ихаб Тарази (Ihab Tarazi), главный технический директор и старший вице-президент Dell Technologies, сообщил, что компания установила сотни тысяч GPU-ускорителей в кластерах, использующих оборудование на основе стандарта OCP ORv3. Благодаря достижениям в области водоблоков, термоинтерфейсов, блоков распределения охлаждающей жидкости (CDU) и быстроразъёмных коллекторов упрощается развёртывание масштабных ИИ-платформ, насчитывающих десятки тысяч GPU. Кроме того, Dell совместно с Национальной лабораторией имени Лоуренса в Беркли (LBNL) при Министерстве энергетики США (DoE) разработала модульную OCP-стойку мощностью 480 кВт с возможностью дальнейшего масштабирования до 1 МВт. Решение, ориентированное на экстремальные нагрузки ИИ, допускает установку высокопроизводительных серверов, насчитывающих в общей сложности до 27 тыс. CPU-ядер и до 144 ускорителей NVIDIA GB200. В перспективе также могут использоваться чипы AMD и NVIDIA следующего поколения, такие как Instinct MI450 и Vera Rubin. По словам Тарази, аналогичная архитектура стоек применяется в рамках суперкомпьютерной программы Техасского университета в Остине (UT Austin) и при развёртывании суверенных облаков. В целом, модульный подход обеспечивает возможность независимой модернизации вычислительных ресурсов, хранилищ и сетевых компонентов, сокращая время обновления инфраструктуры с нескольких лет до нескольких недель. Инновации в сфере СЖО повышают надёжность и удобство обслуживания платформ в рамках масштабных ИИ-кластеров.

21.10.2025 [16:14], Руслан Авдеев

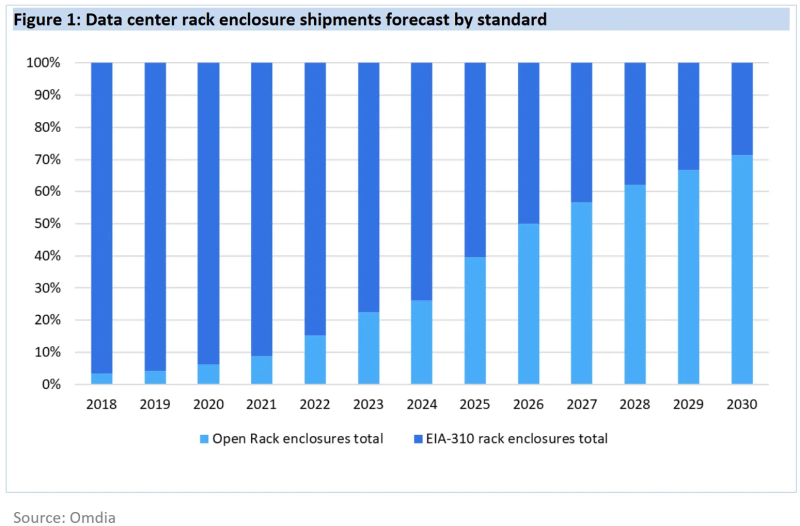

К 2030 году 21″ OCP-стойки станут доминирующим стандартом в ЦОДДата-центры намерены стандартизировать использование более крупных 21″ стоек вместо обычных 19″ к 2030 году. По данным Omdia, гиперскейлеры и производители серверов полностью поддерживают такой переход, а корпоративные ЦОД всё ещё будут придерживаться старого типоразмера, сообщает The Register. По некоторым данным, 19″ стойки (EIA-310) ведут свою «родословную» от релейных шкафов на железных дорогах — там подобный стандарт появился ещё до того, как его приняли телефонные компании, а позже и IT-индустрия. Meta✴ (Facebook✴) ещё в 2012 году столкнулась с ограничениями старого формата и основала OCP для того, чтобы организовать разработку и принятие более эффективных индустриальных стандартов. По прогнозам аналитиков, на более крупный формат, продвигаемый OCP, к концу десятилетия придётся более 70 % поставок, поскольку он активно внедряется крупными вендорами вроде Dell и HPE — одними из лидеров в гонке по выпуску ИИ-оборудования. По данным Omdia, на сегодня все крупнейшие сервис-провайдеры, включая Microsoft, Amazon, Meta✴, Google, ByteDance, Huawei и Oracle уже перешли на использование 21″ стоек в своих ЦОД. Так, Huawei ещё в 2019 году объявила, что её дата-центры будут опираться на 21″ стандарт.

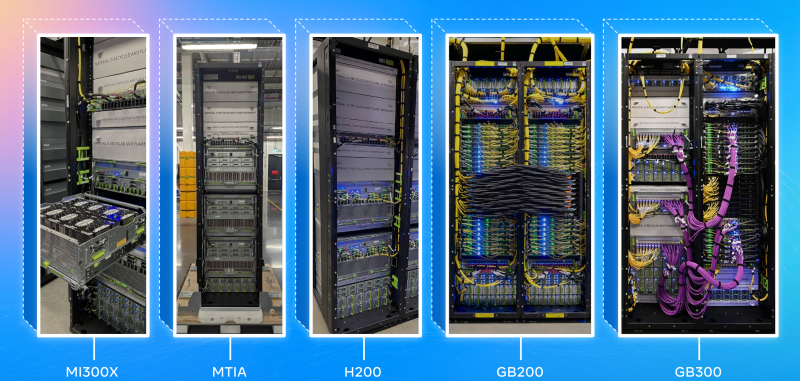

Источник изображения: Meta✴ Преимуществами более крупных стоек является лучшая циркуляция воздуха и возможность устанавливать более крупные массивы вентиляторов, что улучшает охлаждение. Кроме того, такие стойки допускают установку более крупных модулей питания и трубок СЖО, что важно для ИИ-серверов. При этом сохраняется совместимость с 19″ решениями. В Omdia ожидают, что полностью укомплектованные стойки вроде NVIDIA DGX GB200 NVL72 станут фактическим стандартом. Кроме того, Dell и HPE продвигают предложенную OCP модульную серверную архитектуру Data Center Modular Hardware System (DC-MHS), которая позволяет по отдельности обновлять IO-модули и остальное «железо». Omdia прогнозирует, что на долю ИИ-серверов будет приходиться всё большая часть расходов на серверы в целом. Уже в 2024 году речь шла о 66 %, причём ключевые игроки рынка, включая гиперскейлеров и облачных ИИ-провайдеров, поддерживают именно 21″ стандарт, поэтому победа OCP над другими стандартами стала лишь вопросом времени.

16.10.2025 [16:44], Сергей Карасёв

Pegatron представила ИИ-сервер AS501-4A1-16I1 с СЖО и 16 ускорителями AMD Instinct MI355XPegatron анонсировала высокопроизводительный сервер AS501-4A1-16I1 с СЖО для задач НРС, а также ресурсоёмких приложений ИИ, включая инференс и обучение больших языковых моделей. Устройство выполнено в форм-факторе 5OU на аппаратной платформе AMD. До восьми серверов AS501-4A1-16I1 могут быть установлены в стойку RA5100-128I1. Это позволяет сформировать ИИ-систему высокой плотности, насчитывающую до 32 процессоров EPYC 9005 и до 128 ускорителей Instinct MI355X. Конструкция системы включает два CPU-узла и два лотка GPU. Каждая из CPU-секций допускает установку двух процессоров AMD EPYC 9005 Turin с показателем TDP до 500 Вт и 24 модулей оперативной памяти DDR5-6400 RDIMM. Таким образом, в общей сложности могут быть задействованы четыре чипа EPYC и 48 модулей ОЗУ. В свою очередь, каждый из GPU-лотков оснащается восемью ускорителями AMD Instinct MI355X, которые несут на борту 288 Гбайт памяти HBM3E с пропускной способностью до 8 Тбайт/с. В общей сложности реализованы 12 слотов PCIe 5.0 x16 FHHL, в которые установлены десять однопортовых сетевых адаптеров 400GbE и два двухпортовых адаптера 10GbE В оснащение входят контроллер Aspeed AST2600, два сетевых порта 1GbE (RJ45), выделенный сетевой порт управления (RJ45), последовательный порт (разъём Micro-USB), интерфейсы USB 2.0 Type-C и Mini-DP. В дополнение к СЖО имеются десять вентиляторов охлаждения. Применяется шина питания ORv3 на 48 В DC.

16.10.2025 [13:39], Руслан Авдеев

Унификация, стандартизация, совместимость: Google призвала создавать взаимозаменяемые компоненты для ИИ ЦОДВ ходе мероприятия OCP Summit компания Google выступила с общеотраслевой инициативой «переосмысления» архитектуры ЦОД, оптимизированных для эпохи ИИ. В рамках сообщества Open Compute Project (OCP) предлагается создать рабочее направление по разработке «гибких, взаимозаменяемых ЦОД», сообщает пресс-служба компании. Google подчеркнула, что скорость внедрения и неоднородность ИИ-технологий растёт, что затрудняет создание общей системы, проектирования, развёртывания и обслуживания ЦОД. Представленный Google проект предусматривает создание модульных, совместимых друг с другом решений для ЦОД, позволяющих легко адаптироваться к стремительному развитию ИИ и изменению рабочих нагрузок. Говорится о «начале революции» в сфере ИИ — мир радикально изменился и необходимо создавать дата-центры, способные меняться не менее быстро. По данным компании, за последние 24 месяца использование ИИ-ускорителей внутри Google увеличилось в 15 раз, объём хранилищ для машинного обучения Hyperdisk ML — в 37 раз, а количество обработанных токенов — до двух квадрлн/мес. В Google сравнивают исследователей ИИ с исследователями космоса, а участников OCP, строителей инфраструктуры — со строителями ракет. Сама инфраструктура компании, как утверждается, поддерживает ИИ-трансформацию на всех уровнях экосистемы, от пользовательских приложений (на основе Gemini) до корпоративных сервисов и научных изысканий в самых разных областях. Особое внимание уделяется обеспечению взаимозаменяемости и гибкости: модульные компоненты, спроектированные различными участниками отрасли, должны быть совместимы с компонентами и системами других поколений и вендоров, причём принципы унификации должны применяться ко всем компонентам ЦОД, включая электропитание, охлаждение, вычислительное оборудование, сетевые технологии и др. Стратегия самой Google строится вокруг т.н. ИИ-гиперкомпьютера — комплексной архитектуры, в которой все компоненты от чипов до электросетей разработаны с учётом общих особенностей системы для обеспечения максимальной эффективности. Благодаря использованию собственных TPU, оптических коммутаторов и СЖО, компания добилась роста энергоэффективности и снижения затрат в 10–100 раз за последние 10 лет. Google уже развернула мегаваттами инфраструктуры с жидкостным охлаждением. Компания вместе с партнёрами организовала в рамках OCP рабочую группу, целью которой является создание единых стандартов обеспечения модульности и совместимости компонентов, а также общих интерфейсов в области вычислений, сетей, хранилищ, безопасности и устойчивости. В частности, участники OCP договорились о разработке гибких систем электропитания для современных ЦОД. Речь идёт о стандартизации 400-В архитектур и модульных системах Mt. Diablo с использованием твердотельных преобразователей. Также ведутся работы в сфере микросетей и аккумуляторных хранилищ. Всё вместе это позволит сглаживать пики потребления энергии, характерные для обучения ИИ, а в перспективе и возвращать излишки энергии обратно в энергосети. Охлаждение также переосмысливается в эпоху ИИ. В начале 2025 года OCP представлено современное решение для жидкостного охлаждения Project Deschutes. Теперь оно получит широкое распространение среди вендоров, включая поставщиков жидкостного охлаждения вроде Boyd, CoolerMaster, Delta, Envicool, Nidec, nVent и Vertiv. Сообщество работает над унификацией интерфейсов охлаждения, новых теплообменников. Важную роль играет стандартизация компонентов и интерфейсов в колокейшн- и сторонних ЦОД. Наконец, Google подчёркивает необходимость унификации физических стандартов: высоты, ширины, глубины и даже грузоподъёмности стоек; ширины и планировки проходов, интерфейсов стоечного и сетевого оборудования. Также требуются единые стандарты для телеметрии и мехатроники, которые лягут в основу строительства и эксплуатации дата-центров следующего поколения. Совместно с партнёрами по OCP ведутся работы над стандартизацией интеграции телеметрии для сторонних дата-центров. Помимо физической инфраструктуры, по словам Google, необходимо внедрение открытых стандартов для обеспечения масштабируемости и безопасности систем:

Для измерения воздействия на окружающую среду предложена методология измерения потребления энергии, воды и подсчёта выбросов в ходе ИИ-нагрузок. В частности, с их помощью выяснилось, что медианный промпт Gemini тратит менее 5 капель воды и электричество в объёме, достаточном для просмотра телевизора в течение менее девяти секунд. Эти методы подсчёта касаются и других, совместных с OCP проектов, включая выпуск экобезопасного бетона, чистой резервной энергии и др. Google приглашает принять участие в инициативе OCP Open Data Center for AI Strategic для разработки общих стандартов. Наконец, сообщество OCP призвали работать над проектами «ИИ для ИИ» — использованием искусственного интеллекта для разработки ИИ-систем следующего поколения. Так, проект AlphaChip предусматривает использование ИИ для размещения компонентов чипов, что уже позволило улучшить показатели мощности, производительности и др., одновременно сократив время проектирования. Предполагается, что создание ИИ систем с помощью ИИ, от полупроводников до программного обеспечения, позволит достигнуть нового уровня эффективности технологий. |

|