Материалы по тегу: llm

|

05.10.2024 [15:36], Владимир Мироненко

Accenture сформировала подразделение NVIDIA Business Group и обучит 30 тысяч сотрудников полному стеку ИИ-технологий NVIDIAГлобальная консалтинговая компания Accenture и NVIDIA объявили о расширении партнёрства, в рамках которого Accenture создала новую бизнес-группу Accenture NVIDIA Business Group с целью помочь предприятиям быстро внедрить и масштабировать ИИ-решения. Также будет проведено обучение 30 тыс. сотрудников Accenture по всему миру полному набору ИИ-технологий NVIDIA. Это одна из крупнейших сделок на рынке. Новая структура Accenture сосредоточится на стимулировании корпоративного внедрения так называемых «агентных систем ИИ», используя преимущества ключевых программных платформ NVIDIA. Как сообщает ресурс CRN, директор по ИИ Accenture Лань Гуань (Lan Guan) заявил на встрече с журналистами, что агентные системы включают в себя «армию ИИ-агентов», которые работают вместе с людьми, чтобы «принимать решения и точно выполнять задачи даже в самых сложных рабочих процессах». Согласно пресс-релизу, агентные системы — это прорыв в области генеративного ИИ. Они могут автономно действовать в соответствии с намерениями пользователя, создавать новые рабочие процессы и предпринимать действия с учётом окружения, что может целиком реорганизовать бизнес-процессы или отдельные функции. По словам Гуаня, в отличие от чат-ботов, таких как ChatGPT, ИИ-агенты не требуют запросов и подсказок от людей и не предназначены для автоматизации уже существующих бизнес-шагов. В своей работе Accenture NVIDIA Business Group будет полагаться на собственную платформу AI Refinery, которая использует полный стек NVIDIA AI, включая NVIDIA AI Foundry, AI Enterprise и Omniverse для продвижения таких направлений, как реорганизация процессов, моделирование на основе ИИ и суверенный ИИ. AI Foundry помогает в разработке кастомных ИИ-моделей, предоставляя доступ к базовым моделям, фреймворкам и инструментам. AI Enterprise предлагает микросервисы и инструменты для разработки, оптимизации и развёртывания приложений ИИ. Наконец, Omniverse ориентирована на создание цифровых двойников производственных процессов и т.п. Accenture также заявила, что открывает сеть инженерных ИИ-центров в Сингапуре, Токио, Малаге и Лондоне, которые помогут ей во внедрении агентных систем ИИ. Эти центры станут частью Центра передового ИИ Accenture (Center for Advanced AI) в дополнение существующим филиалам в Маунтин-Вью и Бангалоре, и будут сосредоточены на подборе и тюнинге базовых моделей с последующим крупномасштабном инференсом. Кроме того, Accenture предложит NVIDIA NIM Agent Blueprints, шаблоны ИИ-приложений NIM Agent Blueprints для типовых бизнес-задач. В частности, Accenture подготовит Blueprint для моделирования производств с использованием парка роботов, который объединяет NVIDIA Omniverse, Isaac и Metropolis. Accenture планирует использовать эти новые возможности в Eclipse Automation, принадлежащей её компании по автоматизации производств. Это позволит вполовину ускорить подготовку проектов и почти на треть сократить время развёртывания. Следует отметить, что на прошлой неделе Accenture сообщила о том, что в 2024 финансовом году, закончившемся 31 августа, у неё было на $3 млрд новых заказов на генеративный ИИ, $1 млрд из которых пришёлся на IV квартал. Для NVIDIA партнёрство с Accenture является частью реализации плана по расширению влияния на глобальных системных интеграторов (GSI) и другие многонациональные компании, которые имеют значительное влияние на предприятиях. Например, Infosys год назад заявила, что обучит и сертифицирует в рамках партнёрства с NVIDIA 50 тыс. сотрудников, которые изучат особенности аппаратных и программных ИИ-решений NVIDIA.

11.09.2024 [18:07], Сергей Карасёв

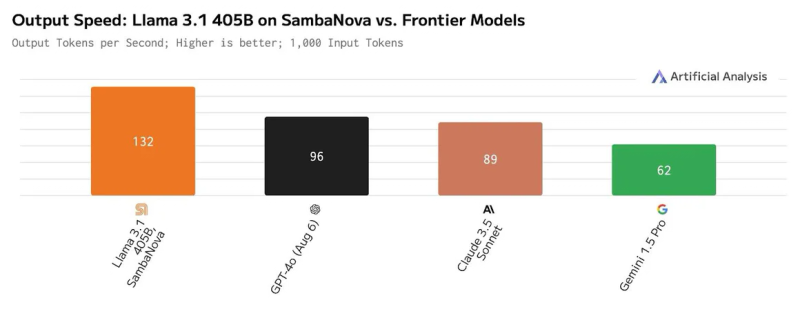

SambaNova запустила «самую быструю в мире» облачную платформу для ИИ-инференсаКомпания SambaNova Systems объявила о запуске облачного сервиса SambaNova Cloud: утверждается, что на сегодняшний день это самая быстрая в мире платформа для ИИ-инференса. Она ориентирована на работу с большими языковыми моделями Llama 3.1 405B и Llama 3.1 70B, насчитывающими соответственно 405 и 70 млрд параметров. В основу сервиса положены ИИ-чипы собственной разработки SN40L. Эти изделия состоят из двух крупных чиплетов, оперирующих 520 Мбайт SRAM-кеша, 1,5 Тбайт DDR5 DRAM, а также 64 Гбайт высокоскоростной памяти HBM3. Утверждается, что восьмипроцессорная система на базе SN40L способна запускать и обслуживать ИИ-модели с 5 трлн параметров и глубиной запроса более 256к. Платформа SambaNova Cloud, по заявлениям разработчиков, демонстрирует производительность до 132 токенов в секунду при работе с Llama 3.1 405B и до 461 токена в секунду при использовании Llama 3.1 70B. Для сравнения, по оценкам Artificial Analysis, даже самые мощные системы на базе GPU могут обслуживать модель Llama 3.1 405B только со скоростью 72 токена в секунду, а большинство из них намного медленнее. Подчёркивается, что SambaNova Cloud демонстрирует рекордную скорость при сохранении полной 16-битной точности. Однако без компромиссов всё же не обошлось: модель работает не в полном контекстном окне в 128k, а при 8k. Доступ к SambaNova Cloud предоставляется по трём схемам — Free, Developer и Enterprise. Первая предусматривает бесплатное базовое использование через API. Схема для разработчиков Developer (появится к концу 2024 года) позволяет работать с моделями Llama 3.1 8B, 70B и 405B с более высокими лимитами. Наконец, план Enterprise предлагает корпоративным клиентам возможность масштабирования для поддержки ресурсоёмких рабочих нагрузок. Ранее Cerebras Systems тоже объявила о запуске «самой мощной в мире» ИИ-платформы для инференса, а Groq ещё в прошлом году говорила о преимуществах своих решений и тоже переключилась на создание облачных сервисов. Впрочем, в бенчмарках MLPerf Inference по-прежнему бессменно лидируют решения NVIDIA.

09.09.2024 [16:00], Владимир Мироненко

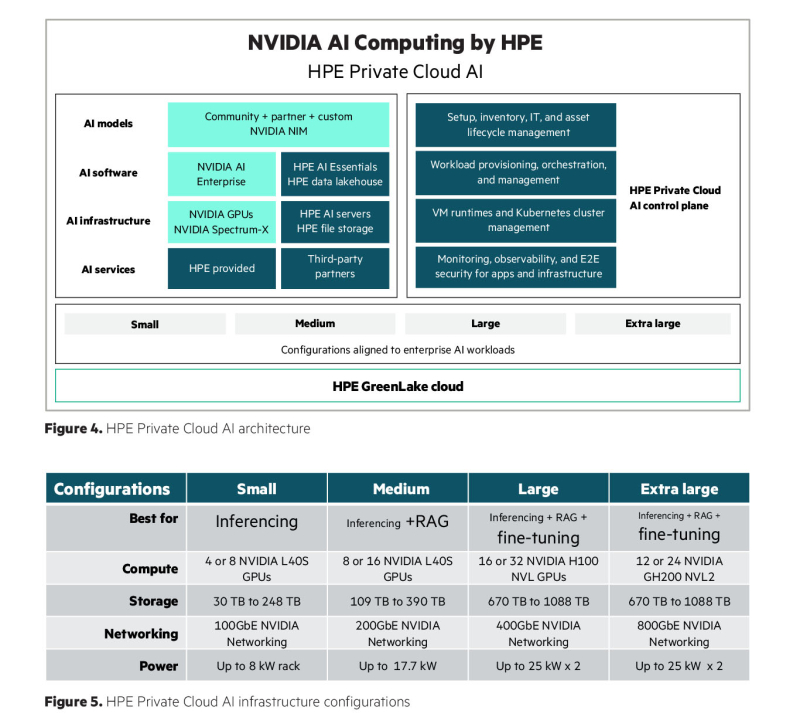

Корпоративная ИИ-платформа под ключ: HPE и NVIDIA объявила о доступности HPE Private Cloud AI(HPE) объявила о доступности входящей в портфель NVIDIA AI Computing by HPE программно-аппаратной платформы HPE Private Cloud AI на базе GreenLake, разработанной совместно с NVIDIA для создания и запуска корпоративных приложений генеративного ИИ. По словам компании, ключевым отличием HPE Private Cloud AI являются решения для автоматизации и оптимизации приложений ИИ, позволяющие предприятию сократить сроки запуска виртуальных помощников с нескольких месяцев до мгновений. К числу таких решений («ускорителей» в терминологии HPE) относится виртуальный помощник на базе генеративного ИИ, который поможет разработчикам быстро создавать интерактивные чат-боты, отвечающие на вопросы на естественном языке, на основе собственных данных организации и открытых больших языковых моделей (LLM). Компании смогут с их помощью настраивать свои приложения ИИ для различных целей, таких как техническая поддержка, формирование коммерческих предложений, создание маркетингового контента и многое другое. Виртуального помощника можно усовершенствовать, добавив в будущем голосовой ввод, возможность работы с изображениями и многокомпонентную поддержку, обеспечивая более продвинутую генерацию контента и работу в режиме многозадачности. Как утверждает HPE, будущие пакеты решений будут включать в себя широко используемые приложения ИИ для вертикальных отраслей, включая финансовые услуги, здравоохранение, розничную торговлю, энергетику и государственный сектор. Они будут основаны на NVIDIA NIM Agent Blueprints, эталонных вариантах ИИ-решений, которые предприятия смогут постоянно совершенствовать на основе собственных данных и отзывов клиентов. «Предприятия ищут ускоренные, настраиваемые инструменты ИИ, подходящие для конкретных вариантов использования с учётом их специфики, — говорит Джастин Бойтано (Justin Boitano), вице-президент по корпоративным программным продуктам ИИ в NVIDIA. — NVIDIA NIM Agent Blueprints позволяет приложениям ИИ, разработанным с помощью HPE Private Cloud AI, совершенствоваться с использованием обратной связи от живых пользователей, улучшая модели в рамках непрерывного цикла обучения». «Ускорители» HPE — это настраиваемые модульные low-code или no-code приложения, использующие микросервисы NVIDIA NIM. Эти проверенные и воспроизводимые решения упрощают развёртывание приложений ИИ, которое обычно включает приобретение новых навыков, принятие сложных рабочих нагрузок, а также интеграцию и настройку агентов, нескольких микросервисов, векторных баз данных, хранилищ данных, разрозненных источников данных, систем управления пользователями, масштабируемых серверов инференса, наборов данных, моделей ИИ и других ИТ-ресурсов. HPE также объявила о запуске партнёрской программы Unleash AI, разработанной для поддержки обширной экосистемы ведущих организаций-партнёров. Unleash AI является частью Technology Partner Program, входящей в инициативу HPE Partner Ready, которая дополнит HPE Private Cloud AI. Новая программа будет включать поставщиков на всех уровнях — от данных, моделей и приложений технологического стека до системных интеграторов и поставщиков услуг консалтинга, проектирования, внедрения и управления комплексными решениями для клиентов на основе ИИ. Решения партнёров, в том числе основанные на NVIDIA NIM Agent Blueprints, будут курироваться и предварительно проверяться для работы в HPE Private Cloud AI. Эта программа дополнит новую стратегию партнёрства в области ИИ, которую HPE объявила в сотрудничестве с NVIDIA.

09.09.2024 [12:10], Руслан Авдеев

LLM в комплекте: Red Hat выпустила платформу RHEL AI для работы с генеративным ИИRed Hat объявила о запуске платформы Red Hat Enterprise Linux AI (RHEL AI) для создания генеративных ИИ-решений в облачных средах. По данным Silicon Angle, анонсированный три месяца назад пакет ПО сделали общедоступным в ходе мероприятия Red Hat Summit. Ранее анонсированный пакет включает семейство открытых языковых моделей IBM Granite, а также инструмент настройки моделей InstructLab, разработанный самой RedHat. Всё это объединили в образ RHEL для развёртывания в гибридных облаках и на локальных площадках. В компании сообщили, что RHEL AI упростит и удешевит разработку компактных и недорогих моделей. Затраты на обучение моделей могут быть очень высокими, в Red Hat сообщают, что на создание некоторых передовых моделей уходит до $200 млн. И это только на обучение, без учёта стоимости самих данных и настройки, критически важной для выполнения специальных задач каждой конкретной компании. В Red Hat уверяют, что будущее за небольшими генеративными ИИ-моделями, большинство которых будет open source.

Источник изображения: Red Hat В компании рассчитывают, что RHEL AI станет основной платформой для создания «бюджетных» и открытых решений. По умолчанию предоставляется библиотека бесплатных LLM Granite общего назначения. InstructLab поможет в тонкой настройке моделей без обширных навыков, связанными с наукой о данных. А интеграция с Red Hat OpenShift AI упростит обучение, настройку и обслуживание моделей. RHEL AI позволит разворачивать генеративный ИИ в непосредственной близости от баз данных и хранилищ компаний. RHEL AI оптимизирован для развёртывания на новейших серверах Dell PowerEdge и обеспечивает все возможности, предоставляемые подпиской Red Hat, в т.ч. круглосуточную поддержку, расширенную поддержку жизненного цикла моделей и, например, правовую защиту Open Source Assurance. Поскольку RHEL AI фактически является расширением Red Hat Enterprise Linux, дистрибутив можно использовать и на любом другом оборудовании, в том числе в облаках. Решение уже доступно у AWS и IBM Cloud, в Google Cloud и Azure появится возможность использовать его позже в этом году. В IBM Cloud ожидается появление предложения «как услуги» — по подписке в самом облаке, но только в следующем году. Ранее сообщалось, что для запуска RHEL AI требуются весьма производительные сертифицированные системы с ускорителями, имеющими минимум 320 Гбайт памяти и хранилище от 200 Гбайт. Среди протестированных указаны серверы Dell с четырьмя NVIDIA H100, Lenovo с восемью AMD Instinct MI300X, а также инстансы IBM Cloud GX3. Вскоре обещана поддержка инстансов AWS EC2 P5 с NVIDIA H100 и ускорителей Intel.

28.08.2024 [00:10], Владимир Мироненко

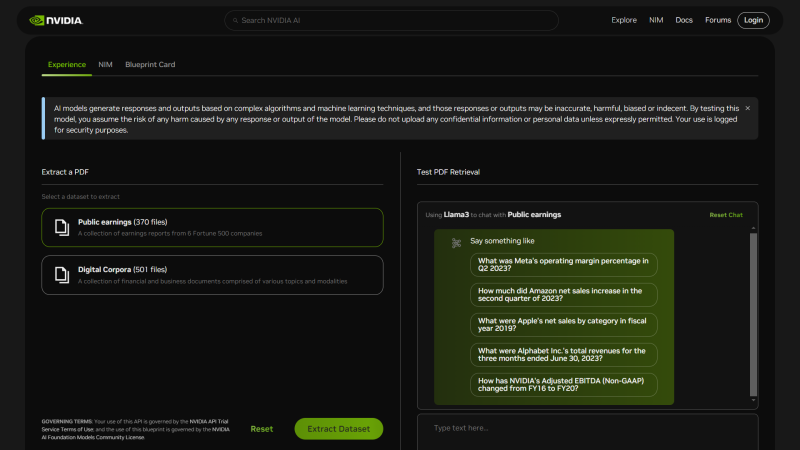

NVIDIA представила шаблоны ИИ-приложений NIM Agent Blueprints для типовых бизнес-задачNVIDIA анонсировала NIM Agent Blueprints, каталог предварительно обученных, настраиваемых программных решений, предоставляющий разработчикам набор инструментов для создания и развёртывания приложений генеративного ИИ для типовых вариантов использования, таких как аватары для обслуживания клиентов, RAG, виртуальный скрининг для разработки лекарственных препаратов и т.д. Предлагая бесплатные шаблоны для частых бизнес-задач, компания помогает разработчикам ускорить создание и вывод на рынок ИИ-приложений. NIM Agent Blueprints включает примеры приложений, созданных с помощью NVIDIA NeMo, NVIDIA NIM и микросервисов партнёров, примеры кода, документацию по настройке и Helm Chart'ы для быстрого развёртывания. Предприятия могут модифицировать NIM Agent Blueprints, используя свои бизнес-данные, и запускать приложения генеративного ИИ в ЦОД и облаках (в том числе в рамках NVIDIA AI Enterprise), постоянно совершенствуя их благодаря обратной связи. На текущий момент NIM Agent Blueprints предлагают готовые рабочие процессы (workflow) для систем обслуживания клиентов, для скрининга с целью автоматизированного поиска необходимых соединений при разработке лекарств и для мультимодального извлечения данных из PDF для RAG, что позволит обрабатывать огромные объёмы бизнес-данных для получения более точных ответов, благодаря чему ИИ-агенты чат-боты службы станут экспертами по темам компании. С примерами можно ознакомиться здесь. Каталог NVIDIA NIM Agent Blueprints вскоре станет доступен у глобальных системных интеграторов и поставщиков технологических решений, включая Accenture, Deloitte, SoftServe и World Wide Technology (WWT). А такие компании как Cisco, Dell, HPE и Lenovo предложат полнофункциональную ИИ-инфраструктуру с ускорителями NVIDIA для развёртывания NIM Agent Blueprints. NVIDIA пообещала, что ежемесячно будут выпускаться дополнительные шаблоны для различных бизнес-кейсов.

27.08.2024 [12:08], Сергей Карасёв

Стартап FuriosaAI представил эффективный ИИ-ускоритель RNGD для LLM и мультимодальных моделейЮжнокорейский стартап FuriosaAI на мероприятии анонсировал специализированный чип RNGD (произносится как «Renegade»), который позиционируется в качестве альтернативы ускорителям NVIDIA. Новинка предназначена для работы с большими языковыми моделями (LLM) и мультимодальным ИИ. FuriosaAI основана в 2017 году тремя инженерами, ранее работавшими в AMD, Qualcomm и Samsung. Своё первое решение компания выпустила в 2021 году: чип Warboy представляет собой высокопроизводительный ЦОД-ускоритель, специально разработанный для рабочих нагрузок компьютерного зрения. Новое изделие RNGD, как утверждает FuriosaAI, является результатом многолетних инноваций. Чип изготавливается по 5-нм техпроцессу TSMC. ИИ-ускоритель на базе RNGD выполнен в виде карты расширения PCIe 5.0 x16. Он наделён 48 Гбайт памяти HBM3 с пропускной способностью до 1,5 Тбайт/с и 256 Мбайт памяти SRAM (384 Тбайт/с). Показатель TDP находится на уровне 150 Вт, что позволяет использовать устройство в системах с воздушным охлаждением. Для сравнения: у некоторых ускорителей на базе GPU величина TDP достигает 1000 Вт и более. Утверждается, что RNGD обеспечивает производительность до 512 Тфлопс в режиме FP8 и до 256 Тфлопс в режиме BF16. Быстродействие INT8/INT4 достигает 512/1024 TOPS. Карта позволяет эффективно запускать открытые LLM, такие как Llama 3.1 8B. Говорится, что один PCIe-ускоритель RNGD обеспечивает пропускную способность от 2000 до 3000 токенов в секунду (в зависимости от длины контекста) для моделей с примерно 10 млрд параметров. В системе можно объединить до восьми карт для работы с моделями, насчитывающими около 100 млрд параметров. RNGD основан на архитектуре свёртки тензора (Tensor Contraction Processor, TCP), которая, как отмечается, обеспечивает оптимальный баланс между эффективностью, программируемостью и производительностью. Программный стек состоит из компрессора моделей, сервисного фреймворка, среды выполнения, компилятора, профилировщика, отладчика и набора API для простоты программирования и развёртывания. Говорится, что чипы RNGD можно настроить для выполнения практически любой рабочей нагрузки LLM или мультимодального ИИ.

25.08.2024 [13:10], Сергей Карасёв

Не только ускорители NVIDIA: разметка данных становится одной из основных причин роста стоимости ИИ-моделейСоздание и обучение мощных ИИ-моделей может обходиться компаниям в сотни миллионов и миллиарды долларов в год. Например, OpenAI в 2024-м намерена потратить на эти цели до $7 млрд. Основная часть затрат приходится на аппаратные ресурсы, включая дорогостоящие ускорители NVIDIA. Но, как сообщает Fortune, существует ещё одна важная статья расходов, которая зачастую упускается из виду — необходимость качественной маркировки данных. Между тем именно эта работа требует всё больших финансовых вложений. Разметка (или маркировка) — процесс идентификации необработанных данных (изображений, текстовых файлов, видео и пр.) и добавления одной или нескольких значимых и информативных меток для обеспечения контекста. Это необходимо для того, чтобы ИИ-модель могла обучаться на таких массивах информации. Разметка данных требуется для различных сценариев использования, включая машинное зрение, обработку естественного языка и распознавание речи. Разметка уже давно используется, например, при разработке ИИ-моделей для беспилотных автомобилей. Камера фиксирует изображения людей, уличных знаков, транспортных средств и светофоров, а комментаторы-люди помечают снимки такими тегами, как «пешеход», «грузовик» или «знак остановки». Это трудоёмкий и кропотливый процесс, который отнимает много времени и требует значительных финансовых вложений. После выпуска ChatGPT в 2022 году OpenAI подверглась широкой критике за аутсорсинг такой работы: компания наняла кенийских работников менее чем за $2/час. Нынешние универсальные большие языковые модели (LLM) проходят обучение с подкреплением на основе отзывов (RLHF). В ходе процедуры люди предоставляют качественную обратную связь или ранжируют то, что генерирует ИИ-модель. Такой подход приводит к значительному увеличению затрат. Ещё одна причина роста расходов при маркировке данных — желание компаний включить в процесс обучения корпоративную информацию, такую как сведения о клиентах или внутренние корпоративные документы. Кроме того, маркировка данных экспертного уровня в таких областях, как юриспруденция, финансы и здравоохранение требует привлечения высококвалифицированных специалистов, оплата труда которых стоит весьма дорого. Поэтому некоторые разработчики перекладывают задачи по разметке данных на сторонние компании, например, Scale AI, которая недавно получила финансирование в размере $1 млрд. Алекс Ратнер (Alex Ratner), генеральный директор стартапа по маркировке данных Snorkel AI, говорит, что корпоративные клиенты могут тратить миллионы долларов на маркировку и обработку информации. Такие операции в некоторых случаях отнимают до 80% времени и бюджета на ИИ. Причём для сохранения актуальности со временем данные должны периодически дополняться и обрабатываться заново. Таким образом, разметка, наряду с необходимостью применения дорогостоящего оборудования, становится одной из основных статей расходов при обучении ИИ-моделей. Некоторые компании снижают затраты, используя синтетические данные — то есть данные, сгенерированные самим ИИ. Последние инновации в области ИИ сделали генерацию синтетических данных эффективной и быстрой, что в ряде случаев позволяет отказаться от применения массивов реальной информации. Однако в некоторых случаях это грозит «самоповторами».

23.08.2024 [16:00], Владимир Мироненко

Китайские компании нашли лазейку в законах США для доступа к передовым ИИ-ускорителям и моделям в облаках AWS и AzureГосударственные китайские организации используют облачные сервисы Amazon, Microsoft и их конкурентов для доступа к передовым американским чипам и технологиям ИИ, пишет Reuters со ссылкой на тендерную документацию, размещённую в общедоступных китайских базах данных. О попытках китайских компаний получить доступ к ИИ-ускорителям на территории США в условиях запрета на их поставки в Китай сообщалось и ранее. Правительство США ограничивает экспорт высокопроизводительных чипов ИИ в КНР в течение последних двух лет в связи с потенциальной возможностью их использования для укрепления военного потенциала Поднебесной. Однако предоставление доступа к таким чипам или передовым ИИ-моделям в облаках не является нарушением законодательства США, которым регулируется в данном случае только экспорт или передача товара, ПО или технологии, отметило Reuters. Согласно 50 тендерным документам, с которыми ознакомилось агентство, по крайней мере 11 китайских организаций пытались получить доступ к подпадающим под ограничение технологиям США или облачным сервисам. В четырёх случаях Amazon Web Services (AWS) явно названа поставщиком облачных услуг, хотя компании получили доступ к облачным услугам через посредников, а не напрямую у AWS. Таким образом, не только китайские компании обходят ограничения, но и американские компании извлекают выгоду из растущего в Китае спроса на вычислительные мощности. «AWS соблюдает все применимые законы США, включая торговые законы, в отношении предоставления услуг AWS внутри и за пределами Китая», — заявил представитель облачного бизнеса Amazon. По данным Synergy Research Group, AWS контролирует почти треть мирового рынка облачной инфраструктуры. А согласно данным исследовательской компании IDC, AWS является в Китае шестым по величине поставщиком облачных услуг. «Эта лазейка беспокоит меня уже годы, и нам давно пора её устранить», — заявил агентству Reuters председатель Комитета по иностранным делам Палаты представителей США Майкл Маккол (Michael McCaul), имея в виду удалённый облачный доступ иностранных субъектов к передовым вычислительным решениям США. В апреле в Конгресс США был внесён законопроект, дающий Министерству торговли полномочия регулировать удалённый доступ к технологиям США, но пока неясно, будет ли он принят и когда. В январе Министерство торговли США также предложило изменения в законодательства с требованием к сервисам облачных вычислений проверять пользователей крупных моделей ИИ и сообщать регулирующим органам об обучения крупных моделей ИИ, способных на «злонамеренную киберактивность». Поправки также дают ведомству право налагать запрет на доступ тех или иных клиентов. Но этот документ всё ещё находится в стадии доработки. Китайские организации также стремятся получить доступ к облачным сервисам Microsoft. Например, в апреле Сычуаньский университет указал в тендерной документации, что он создаёт платформу генеративного ИИ и закупает 40 млн токенов Microsoft Azure OpenAI. В мае токены поставила компания Sichuan Province Xuedong Technology Co Ltd. В связи с этим OpenAI сообщила Reuters, что её собственные сервисы не поддерживаются в Китае, а сервисы Azure OpenAI работает в соответствии с политикой Microsoft. Наконец, Институт перспективных исследований Сучжоуского университета науки и технологий Китая (USTC) сообщил в тендерной документации в марте этого года, что хотел бы арендовать 500 облачных серверов с восемью ускорителями NVIDIA A100 в каждом. Согласно апрельским документам, тендер был выполнен компанией Hefei Advanced Computing Center Operation Management Co Ltd, но в них не был указан поставщик облачных услуг, и Reuters не удалось его идентифицировать. USTC был добавлен Минторгом США в чёрный список Entity List в мае этого года из-за получения доступа к американской технологии квантовых вычислений, которая могла бы использоваться военно-промышленным комплексом Китая и помочь в развитии ядерной программы. Согласно тендерным документам, Amazon предоставляет китайским организациям доступ не только к передовым ИИ-чипам, но и к передовым моделям ИИ, таким как Claude от Anthropic, к которым они не могут получить доступ иным образом, пишет Reuters. Да и сама AWS в сообщениях на китайском языке подчёркивает возможность опробовать «модели ИИ мирового класса» и упоминает китайскую игровую фирму Source Technology как одного из своих клиентов, использующих Claude. После того как Reuters обратилось к Amazon за разъяснением, компания добавила в десятки постов на своих китаеязычных каналах примечание о том, что некоторые из услуг недоступны в китайских облачных регионах. Она также удалила несколько рекламных постов, включая пост об Source Technology.

21.08.2024 [11:23], Сергей Карасёв

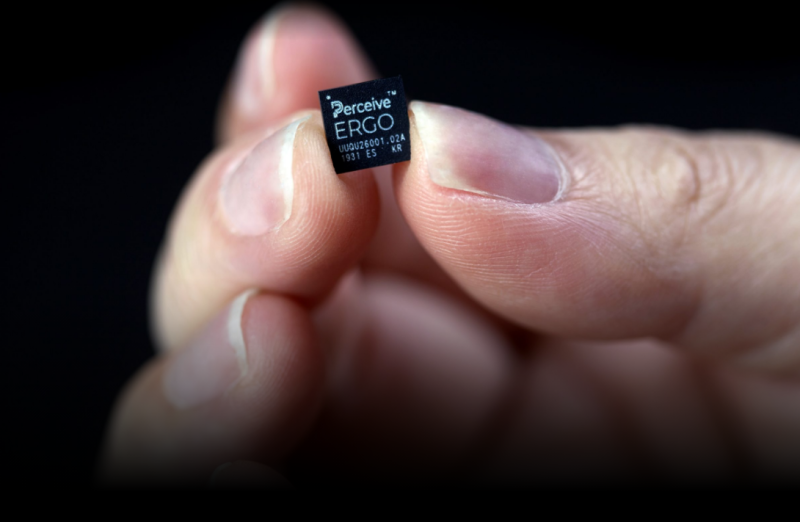

Amazon купила разработчика ИИ-чипов Perceive за $80 млн для развития LLM на периферииКомпания Xperi объявила о заключении соглашения по продаже своего подразделения Perceive, которое занимается разработкой специализированных ИИ-чипов. Покупателем является Amazon, сумма сделки составляет $80 млн в виде денежных средств. Завершить поглощение планируется до конца 2024 года. Perceive со штаб-квартирой в Сан-Хосе (Калифорния, США) создаёт ИИ-решения для работы с большими языковыми моделями (LLM) на периферийных устройствах. Такое оборудование обычно обладает ограниченными возможностями в плане вычислительных ресурсов, средств подключения и хранения данных. Чипы Perceive проектируются с учетом особенностей edge-платформ. В частности, Perceive разработала процессор Ergo AI. Утверждается, что он позволяет запускать «нейронные сети ЦОД-класса» даже на устройствах с самыми жёсткими требованиями к энергопотреблению. Это могут быть системы конференц-связи и носимые гаджеты. Отмечается, что Ergo AI может поддерживать самые разные ИИ-нагрузки — от классификации и обнаружения объектов до обработки аудиосигналов и языка. Как именно Amazon намерена использовать решения Perceive, не уточняется. Но известно, что Amazon приобретает разработчика ИИ-чипов через своё подразделение Devices & Services, в которое входят голосовой помощник Alexa, интеллектуальные колонки и устройства серий Echo и Fire TV. Ожидается, что сделка не потребует одобрения со стороны регулирующих органов. После поглощения большинство из 44 сотрудников Perceive присоединятся к Amazon. Perceive, которую возглавляют со-генеральные директоры Мурали Дхаран (Murali Dharan) и Стив Тейг (Steve Teig), имеет сотрудников в США, Канаде, Ирландии, Румынии и Эстонии. Лаборатория Perceive в Бойсе (Айдахо, США) продолжит функционировать. Нужно отметить, что подразделение Amazon Web Services (AWS) уже не один год разрабатывает собственные аппаратные решения для ИИ-задач и облачных платформ. Это, в частности, чипы семейства Graviton и ИИ-ускорители Trainium. В конце 2023 года дебютировало изделие Graviton4 с 96 ядрами Arm для широкого спектра нагрузок. К выпуску готовится мощный ускоритель Trainium 3, энергопотребление которого может достигать 1000 Вт.

16.08.2024 [16:56], Руслан Авдеев

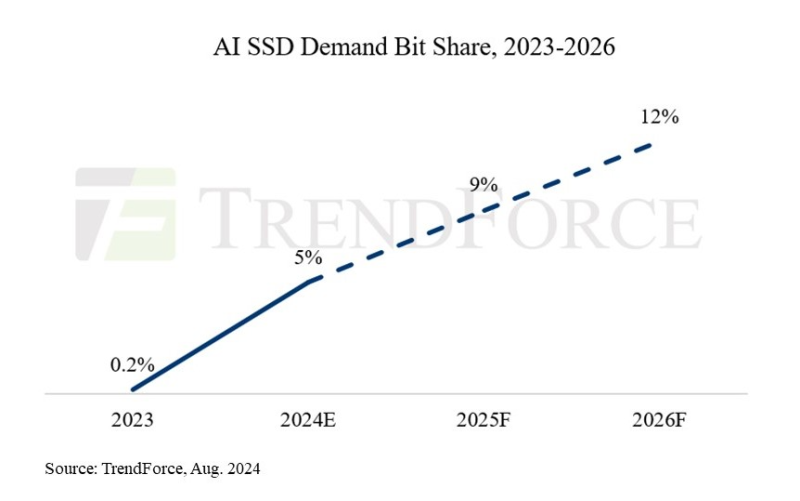

Закупочная ёмкость SSD для ИИ-нагрузок превысит 45 Эбайт в 2024 годуСпрос на ИИ-системы и соответствующие серверы привёл к росту заказов на SSD корпоративного класса в последние два квартала. По данным TrendForce, производители компонентов для твердотельных накопителей налаживают производственные процессы, готовясь к массовому выпуску накопителей нового поколения, которые появятся на рынке в 2025. Увеличение заказов корпоративных SSD от пользователей ИИ-серверов привело к росту контрактных цен на эту категорию товаров на более чем 80 % с IV квартала 2023 года по III квартал 2024. При этом SSD играют ключевую роль в развитии ИИ, поскольку только они годятся для эффективной работы с моделями. Помимо собственно хранения данных модели они также нужны для создания контрольных точек во время обучения, чтобы в случае сбоев можно было быстро «откатить» модель и возобновить обучение. Благодаря высокой скорости записи и чтения, а также повышенной надёжности в сравнении с HDD, для тренировки моделей обычно выбирают TLC-накопители ёмкостью 4–8 Тбайт. Эффективность RAG и больших языковых моделей (LLM), особенно для генерации медиаконтента, зависят и от ёмкости, и от производительности накопителей, поэтому для инференса более предпочтительны TLC/QLC-накопители ёмкостью от 16 Тбайт. Со II квартала 2024 года спрос на SSD для ИИ-серверов ёмкостью больше 16 Тбайт значительно вырос. С повышением доступности ускорителей NVIDIA H100/H20/H200 клиенты начали наращивать спрос и на TLC SSD на 4 и 8 Тбайт. В агентстве считают, что закупочная ёмкость SSD для в 2024 году превысит 45 Эбайт, а в следующие несколько лет спрос на серверные SSD будет увеличиваться более чем на 60 % ежегодно. В частности, на SSD для ИИ-нагрузок потенциально уйдёт до 9 % всей NAND-памяти в 2025, тогда как в 2024 году этот показатель, как ожидается, составит 5 %. |

|